2.安装Spark与Python练习

一、Spark安装

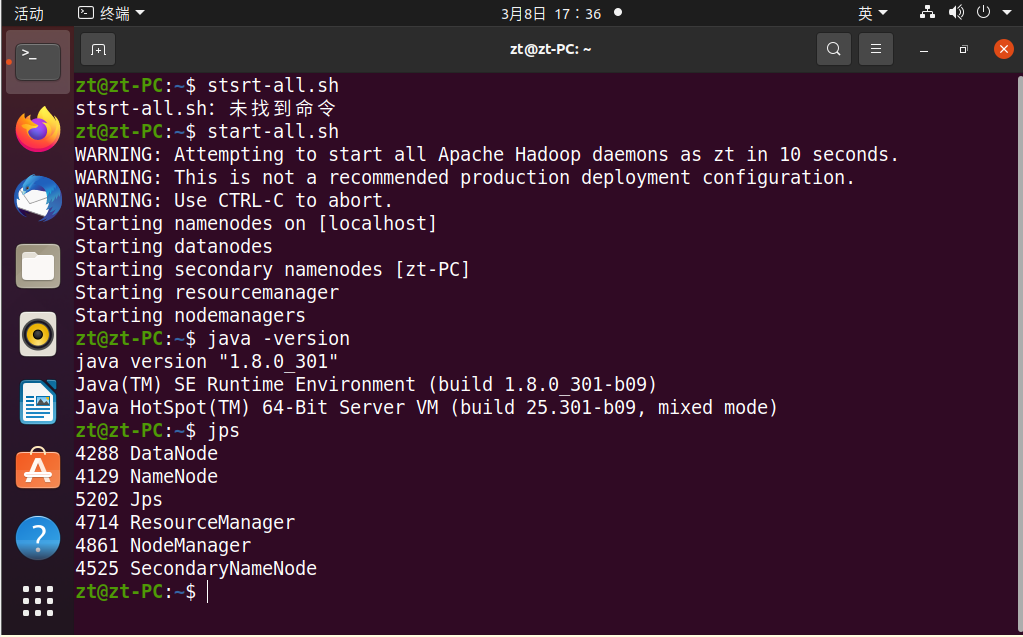

1.检查基础环境hadoop,jdk

2.下载spark

3.解压,文件夹重命名、权限

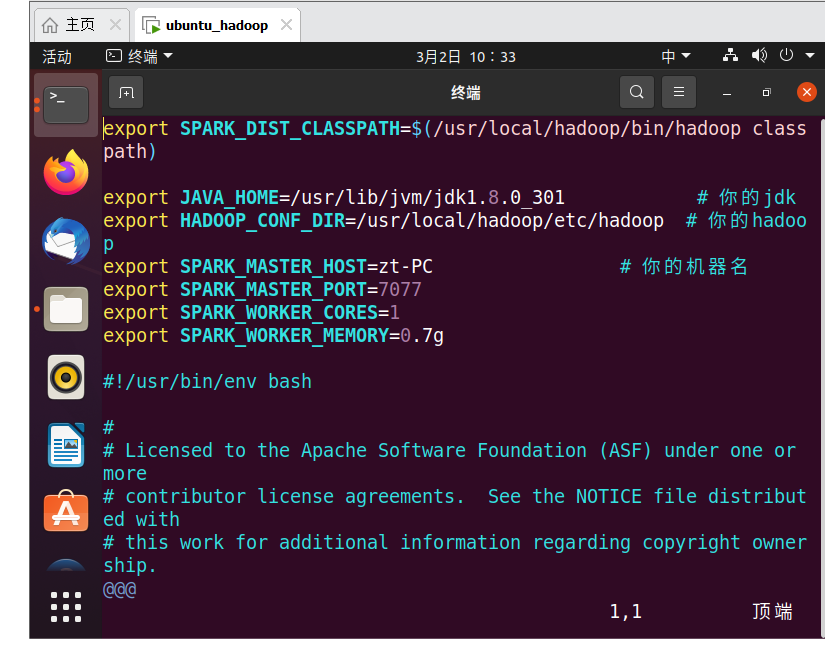

4.配置文件

编辑配置文件,在文件中加上

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

保存配置文件后,就可以启动、运行Spark了

若需要使用HDFS中的文件,则使用spark前要启动Hadoop

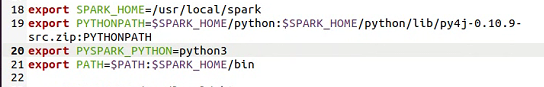

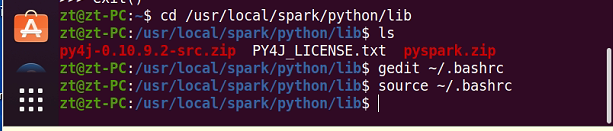

5.环境变量

在~/.bashrc文件中加入一下代码

export SPARK_HOME=/usr/local/spark

export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.9.2-src.zip:PYTHONPATH

export PYSPARK_PYTHON=python3

export PATH=$PATH:$SPARK_HOME/bin

运行:

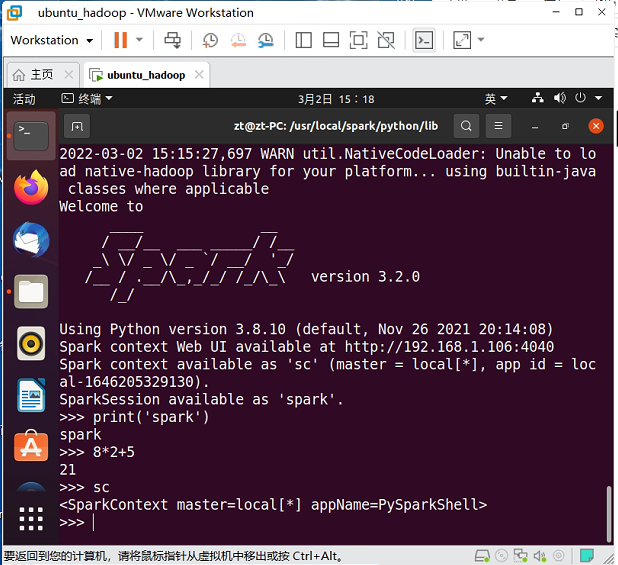

6.试运行Python

启动spark,运行Python测试:

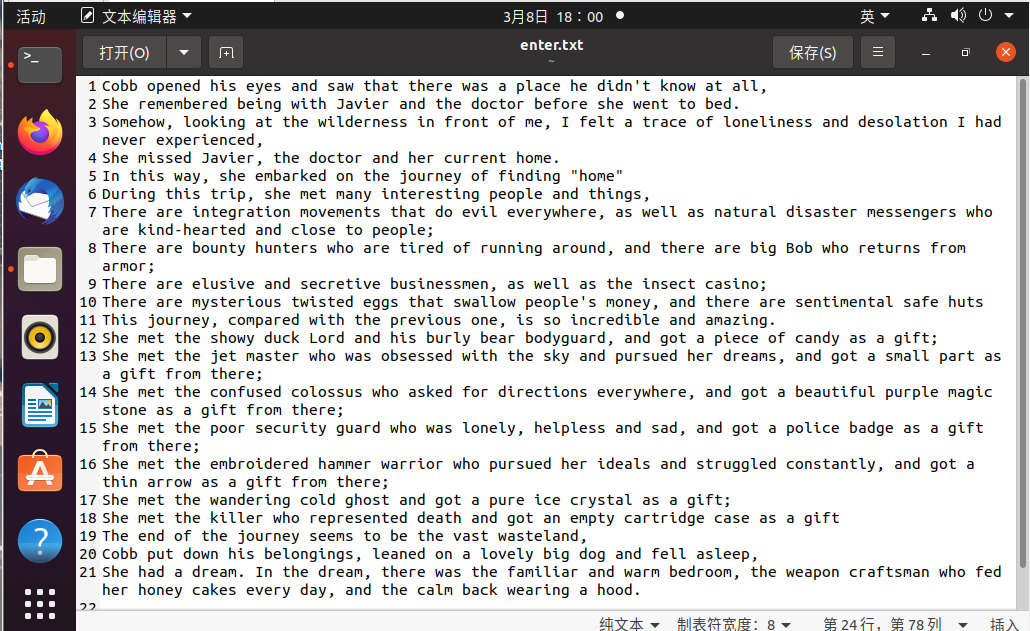

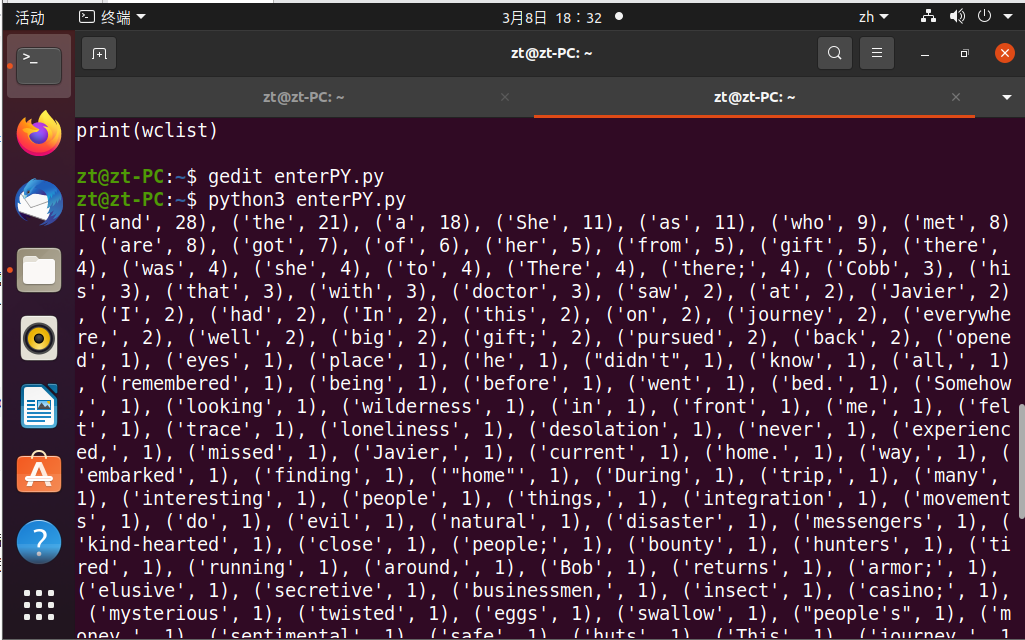

二、Python编程练习:英文文本的词频统计

1.准备文件:

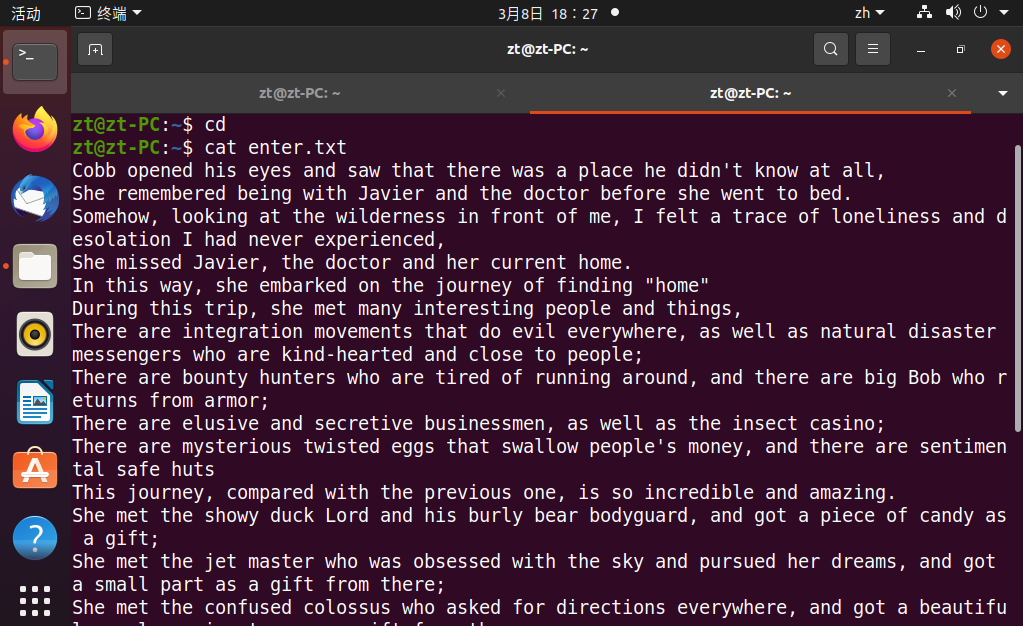

2.读文件:

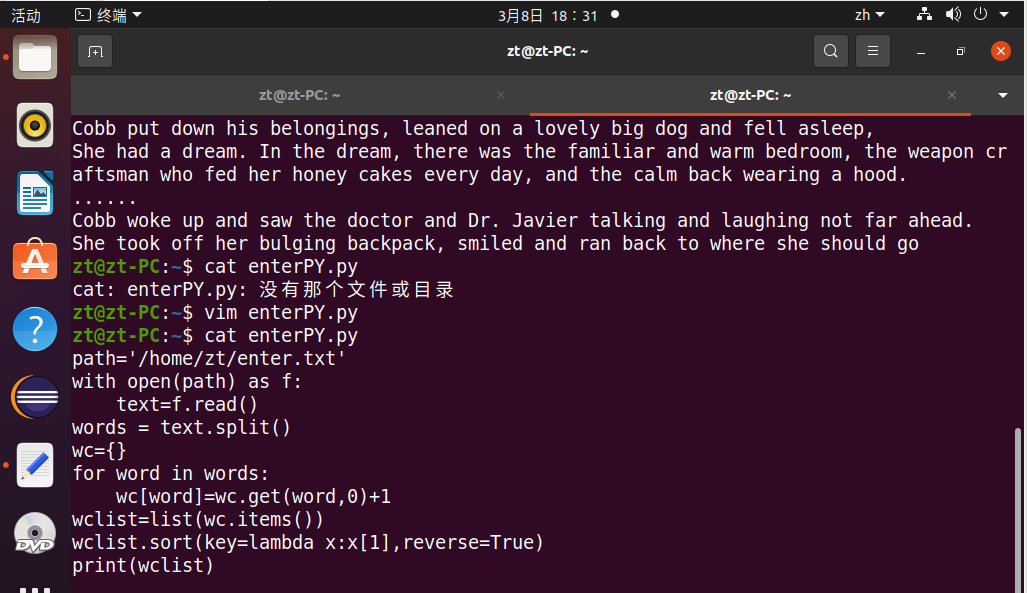

3.编写Python文件:

4.运行结果

浙公网安备 33010602011771号

浙公网安备 33010602011771号