详细介绍:基于虚拟染色的病理切片进行癌症分类,准确率可达到95.9%,在统计学上逼近真实染色的金标准,两小时可处理100张切片

小罗碎碎念

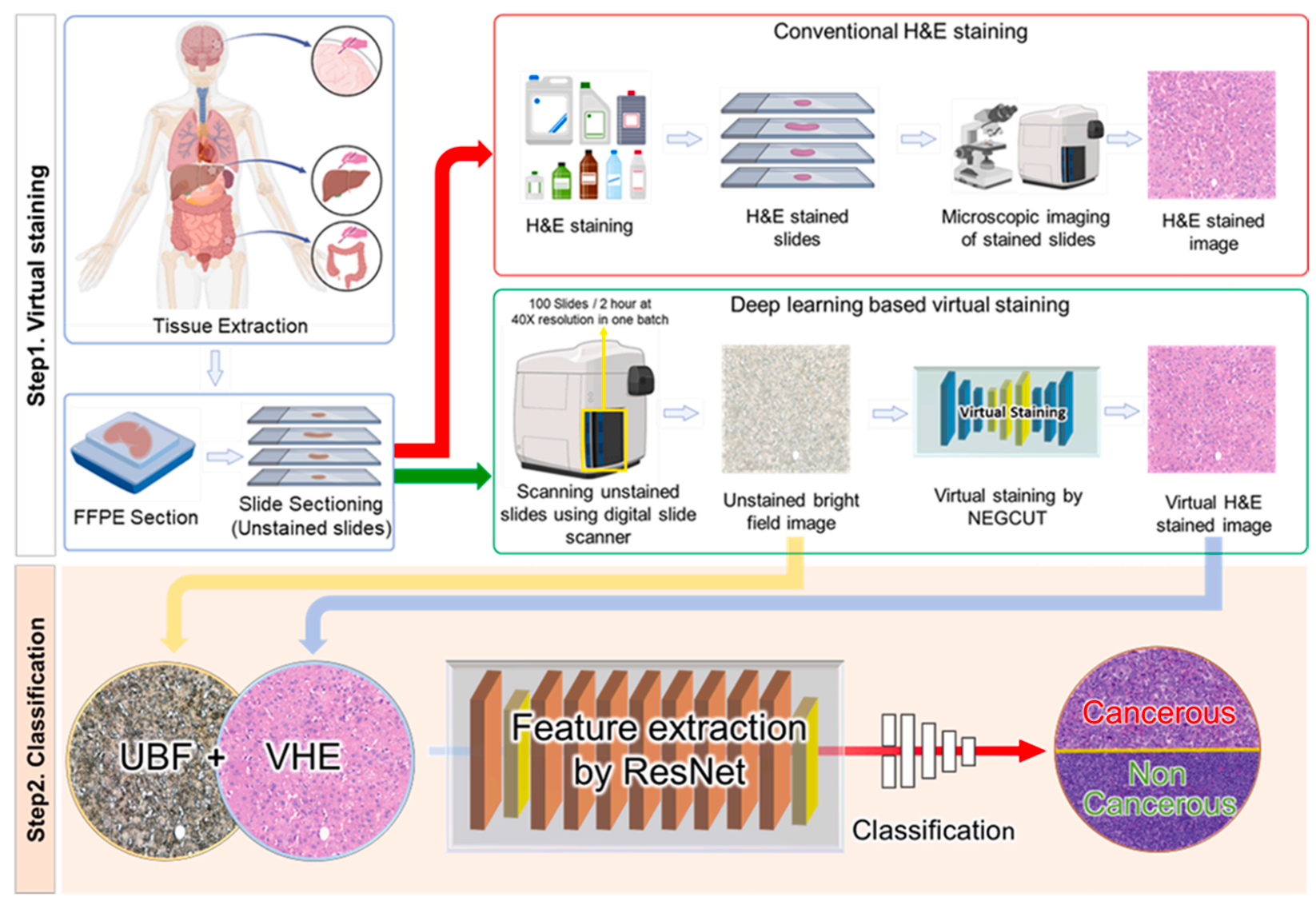

这项发表于《Medical Image Analysis》的研究针对传统组织病理学中H&E 染色耗时、不可逆且破坏样本完整性的痛点,提出了一种结合高通量数字切片扫描仪与深度学习的无标记虚拟染色及分类框架 。

不同于以往依赖特殊显微镜的实验室级方案,该研究直接利用临床通用的数字切片扫描仪批量获取福尔马林固定石蜡包埋(FFPE)组织的未染色明场(UBF)图像,旨在解决现有无标记成像手艺在成像速度和临床兼容性上的瓶颈。

该方案的核心价值在于建立了一套完全自动化的工作流,既能建立大规模、低成本的快速诊断,又能完整保留组织样本以供后续的免疫组化或分子分析使用 。

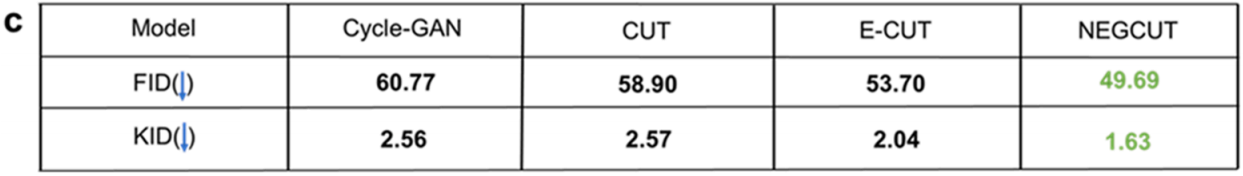

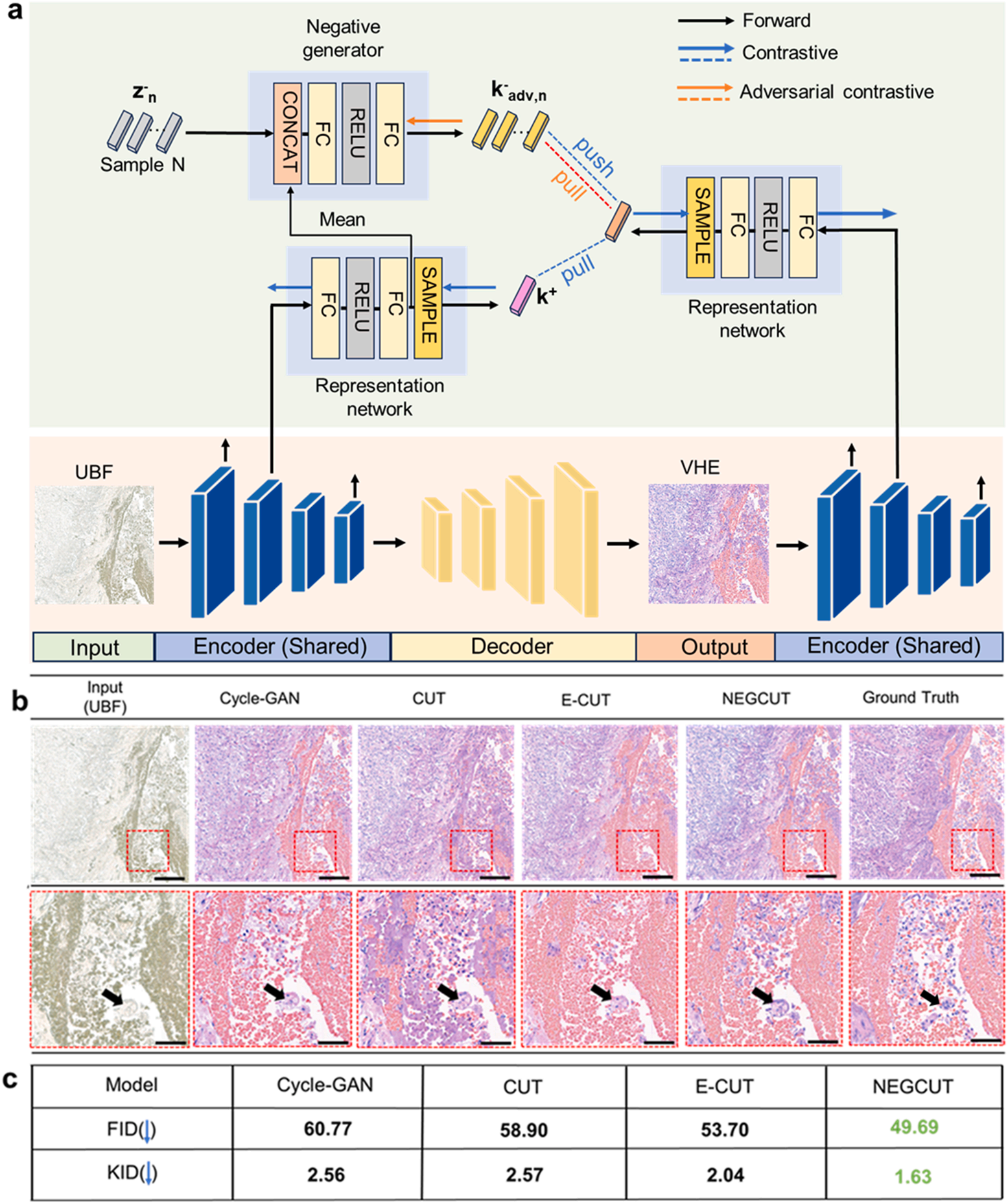

在算法技术上,作者创新性地提出了NEGCUT模型用于虚拟染色,该模型通过引入对抗生成的“硬负样本”(Instance-wise Hard Negative Examples)来改进对比学习机制,使网络学习更精细的形态学特征。

实验表明,NEGCUT 在保留细胞核边界和染色质纹理等高频细节方面,显著优于 CycleGAN 和 CUT 等基线模型,取得了更低的 FID(49.69)和 KID(1.63)分数。

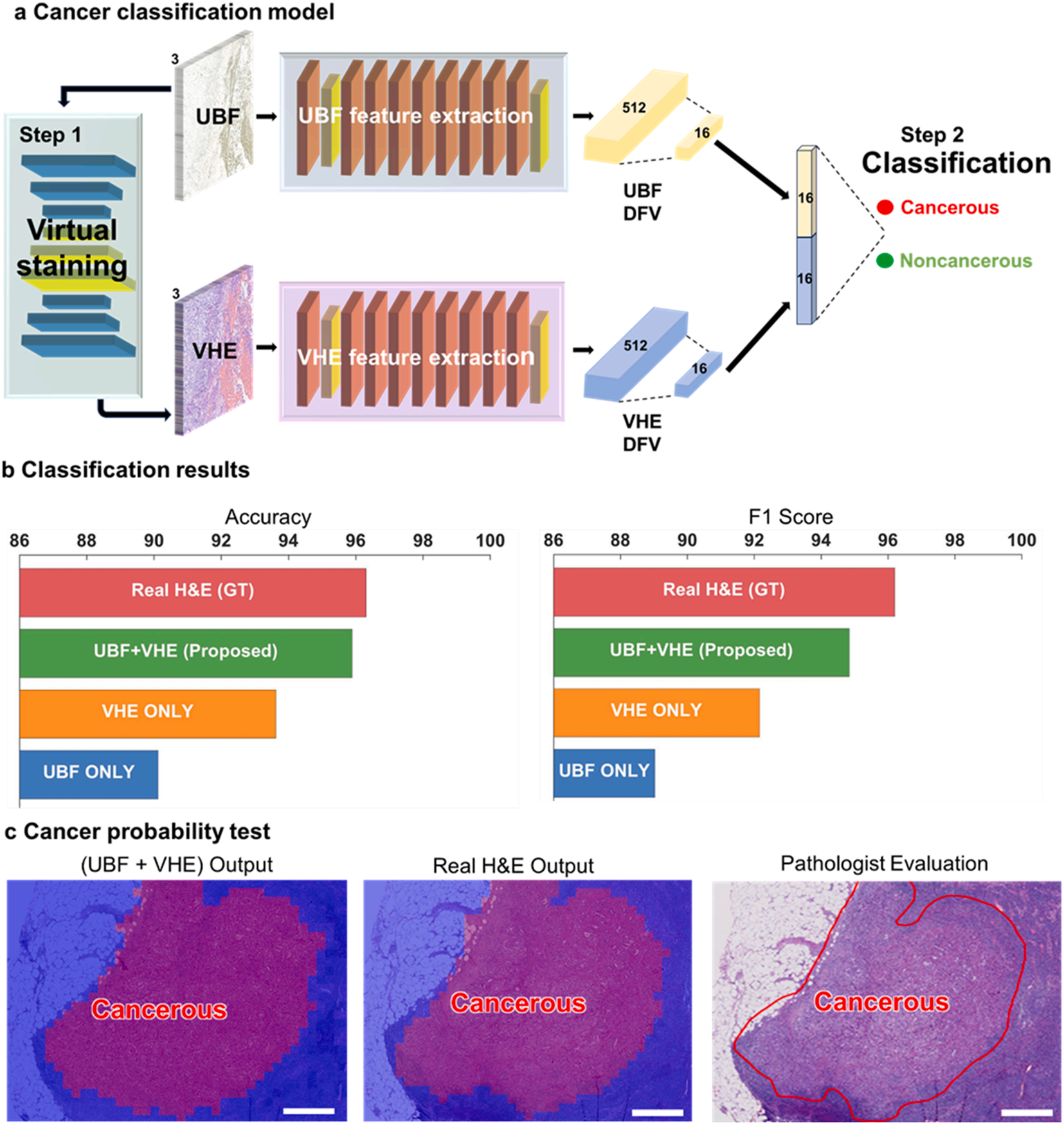

研究设计了一种基于 ResNet 的双分支特征融合网络,同时利用原始 UBF 图像的结构信息和虚拟 H&E 图像的增强特征进行癌症分类,达到了95.9%的准确率,在统计学上与基于真实化学染色的金标准(96.3%)几乎无异。

它能够在大约两小时内利用标准商用扫描仪达成 100 张切片的批处理,推理速度远快于传统人工染色流程。

这意味着无标记虚拟染色病理技术不再局限于小规模实验,而是具备了在真实高通量临床环境中落地应用的能力,为未来搭建全数字化、无化学污染的智能病理诊断提供了强有力的技巧支撑。

开源情况

核心模型NEGCUT代码:

https://github.com/WeilunWang/NEGCUT

癌症分类模型代码:

https://github.com/Santanu07784/UBF_VHE_Classification

模型权重和部分信息:

https://doi.org/10.5281/zenodo.17377691

医学AI交流群

目前小罗全*台关注量120,000+,交流群总成员3000+,大部分来自国内外顶尖院校/医院,期待您的加入!!

由于*期入群推销人员较多,已开启入群验证,扫码添加我的联系方式,备注姓名-单位-科室/专业,即可邀您入群。

团队介绍

一支以国内外硕博为主的科研团队,覆盖影像组学、病理组学以及基因组学等医学AI主流研究领域。就是罗小罗团队

980余个医学图像公开数据集查询架构,最新的医工交叉前沿论坛回放等你来探索!

团队的宗旨是汇聚国内外顶尖人才,构建医学AI生态,推动医学AI从实验室走向临床,期待您的加入!

病理AI一站式分析软件

我们团队针对刚入门病理AI领域的同学/老师,开发了一个一站式软件,可能让大家避免复杂的命令行执行;

为了更好的让大家掌握软件的使用,我们还配备了详细的使用教程和配套的课程。假如想要了解细节,可以查看下列推送。

如果有需要,可以扫码咨询!

一、病理诊断的困境:传统染色与技能瓶颈

自诞生以来,H&E染色一直是病理医生的“火眼金睛”,清晰的色彩对比让病变形态无所遁形。但化学染色程序通常是不可逆的,使得染色的组织切片无法用于后续分析。

因此,通常的做法是预先从同一组织块上切下多个切片,留作免疫染色、分子研究或其他辅助检测之用,既浪费样本又增加工作量。

此外,组织学染色工作流程耗时、成本高且劳动强度大,需要专门的试剂、基础设施以及熟练的技术人员来执行复杂而精确的代码。

以往的无标记成像科技

明场显微镜(BF)、光学相干断层扫描(OCT)等:成像快却对比度不足,就像看一张模糊的黑白照片,难以分辨细胞核的细微结构;

OCT、光声显微镜(PAM)等:虽能捕捉结构或分子信息,却缺乏H&E染色的色彩丰富度,病理医生无法直接用于诊断。

即便部分技术结合了深度学习,也存在致命短板——要么依赖繁琐的配对数据训练,要么只能单张切片处理,难以适配临床高通量需求。

二、技术革新:NEGCUT+数字扫描的深度协同

2-1:基础硬件

数字切片扫描仪作为基础硬件,彻底摆脱了传统显微镜的单张处理限制。

能以40倍放大倍率批量扫描切片,单次可处理100张,全程仅需约2小时,且无需专业人员值守。

直接采集未染色明场(UBF)图像,完整保留组织原始状态,为后续分子检测、特殊染色等多重分析预留了可能。

这种硬件优势,让高通量病理诊断有了实现的基础。

2-2:算法层面

NEGCUT模型解决了无配对数据下虚拟染色的核心难题——如何让生成的虚拟H&E(VHE)图像既逼真又保留关键形态。

与传统模型随机选取“负样本”不同,NEGCUT会主动生成“硬负样本”

就像让学生在学习时专门攻克易混淆的难题,模型通过对抗性生成与真实组织形态高度相似但存在细微差异的样本,迫使自己精准捕捉细胞核轮廓、染色质分布等关键特征。

采用三重损失函数

- adversarial loss 对抗损失(保证图像逼真度)

(l adv (X,Y)=EY∼PY[(1−D(Y))2]+EX∼PX[D(G(X))2])(1) \left( {{l}_{\text{ adv }}\left( {X,Y}\right) = {\mathrm{E}}_{\mathrm{Y} \sim {\mathrm{P}}_{\mathrm{Y}}}\left\lbrack {\left( 1 - D\left( Y\right) \right) }^{2}\right\rbrack + {\mathrm{E}}_{\mathrm{X} \sim {\mathrm{P}}_{\mathrm{X}}}\left\lbrack {D{\left( G\left( X\right) \right) }^{2}}\right\rbrack }\right) \tag{1}(l adv (X,Y)=EY∼PY[(1−D(Y))2]+EX∼PX[D(G(X))2])(1)

- adversarial contrastive loss(强化形态细节)

lAdCont(X,Y)=EX∼X∑l=1L∑s=1Sl−log(exp(ql,s⋅kl,s+/τ)exp(ql,s⋅kl,s+/τ)+∑n=1Nexp(ql,s⋅kadv,l,s,n−/τ)) \begin{equation}\tag{3} \mathrm{l}_{\text{AdCont}}(X,Y) = \mathbb{E}_{X \sim X} \sum_{l=1}^{L} \sum_{s=1}^{S_l} -\log\left( \frac{\exp\left( q_{l,s} \cdot \mathbf{k}_{l,s}^{+} / \tau \right)}{\exp\left( q_{l,s} \cdot \mathbf{k}_{l,s}^{+} / \tau \right) + \sum_{n=1}^{N} \exp\left( q_{l,s} \cdot \mathbf{k}_{\text{adv}, l,s,n}^{-} / \tau \right)} \right) \end{equation}lAdCont(X,Y)=EX∼Xl=1∑Ls=1∑Sl−logexp(ql,s⋅kl,s+/τ)+∑n=1Nexp(ql,s⋅kadv,l,s,n−/τ)exp(ql,s⋅kl,s+/τ)(3)

- diversity loss(避免输出单一)

l div (X)=−∥N(H(X),z1)−N(H(X),z2)∥1(4) {l}_{\text{ div }}\left( X\right) = - {\begin{Vmatrix}N\left( H\left( X\right) ,{z}_{1}\right) - N\left( H\left( X\right) ,{z}_{2}\right) \end{Vmatrix}}_{1} \tag{4}l div (X)=−N(H(X),z1)−N(H(X),z2)1(4)

最终生成的VHE图像在弗雷歇 inception 距离(FID)上达到49.69,核 inception 距离(KID)仅1.63,显著优于CycleGAN、CUT等主流模型,完成了对传统H&E染色的高度复刻。

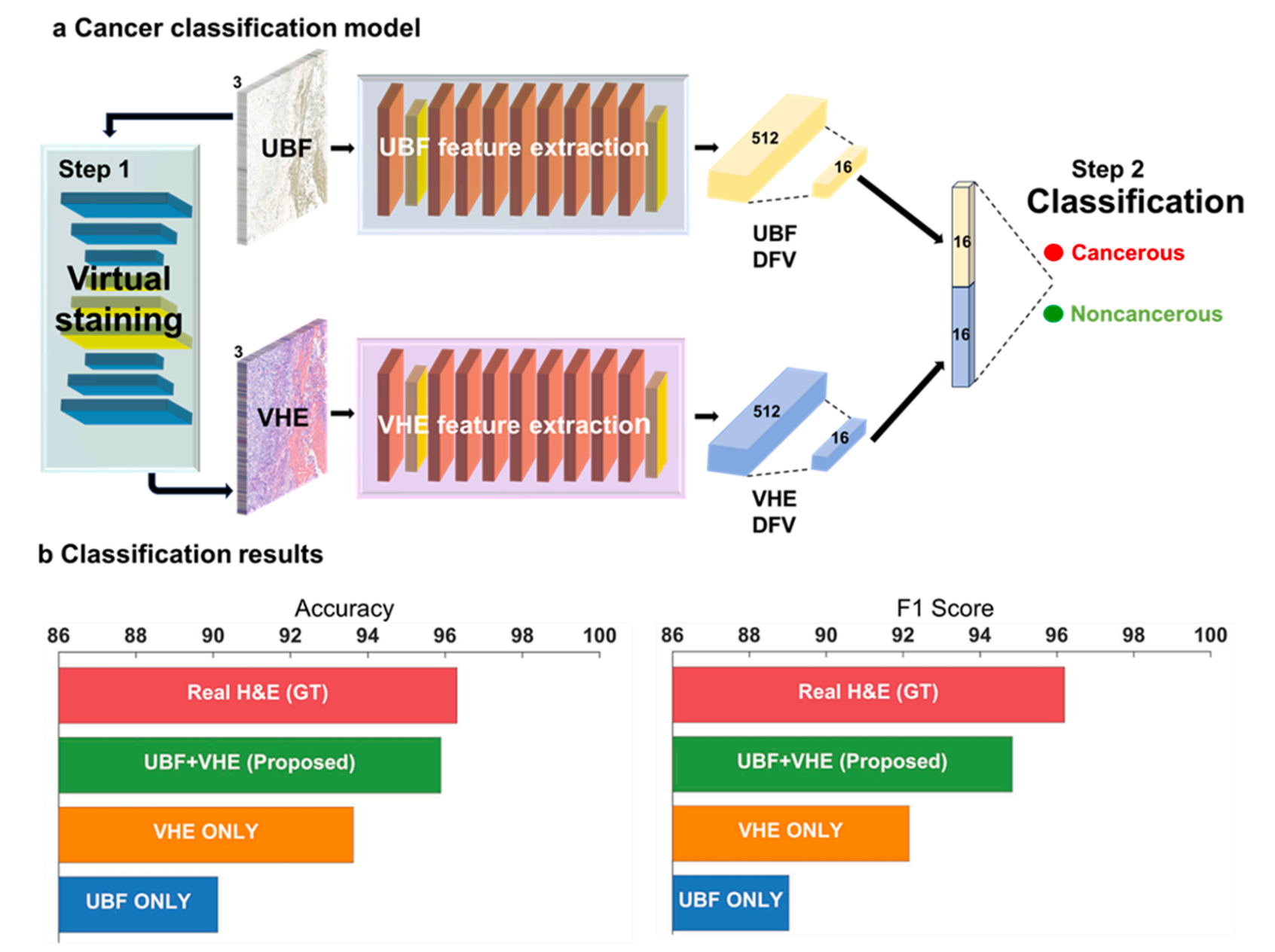

基于残差网络(ResNet)的双模态分类模型

它同时接收UBF和VHE图像,分别提取512维特征并压缩融合,最终实现癌症的二元分类。

这种“双重视角”就像两位专家协同诊断,UBF图像提供组织整体结构信息,VHE图像强化细胞细节特征,让分类更精准。

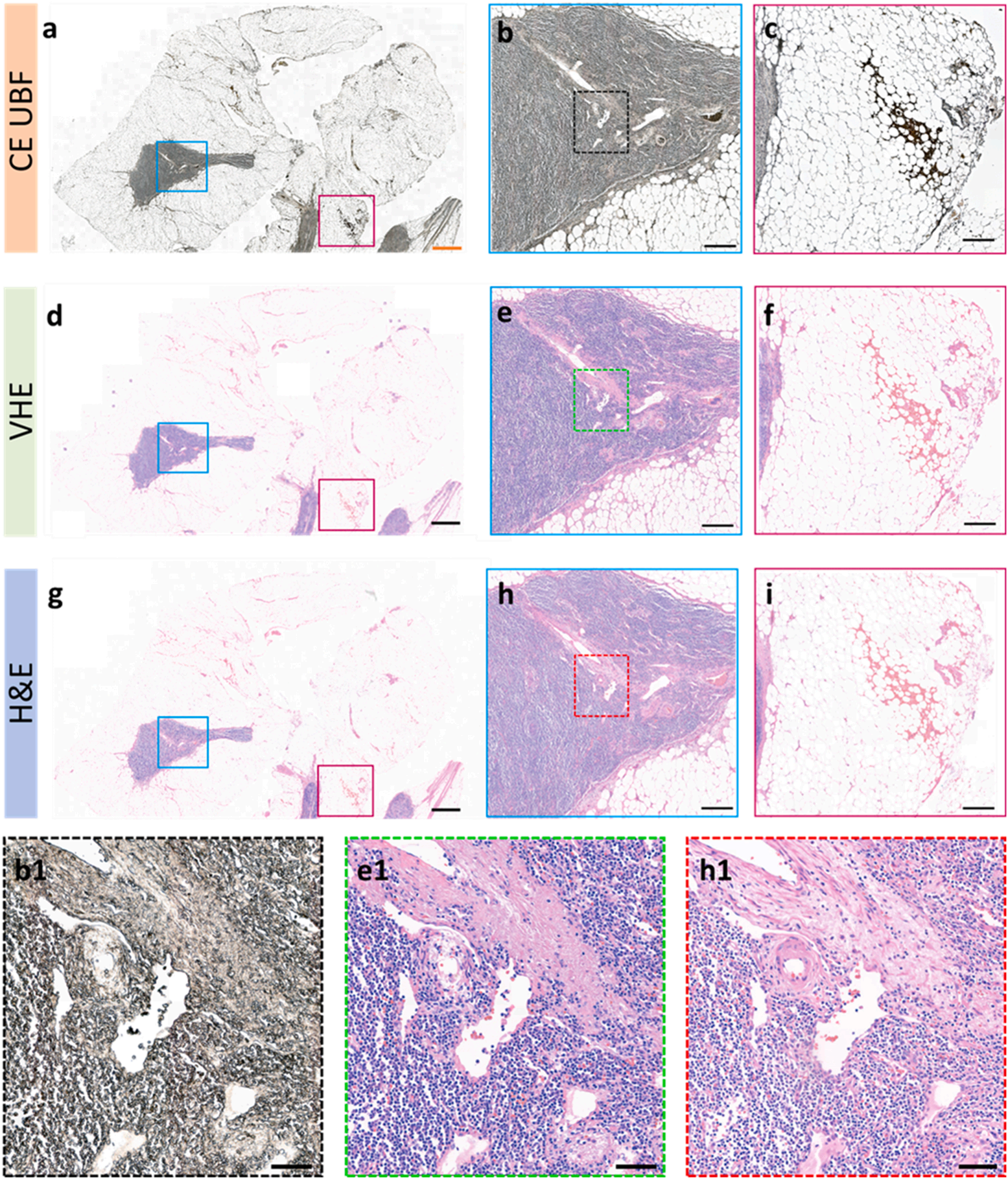

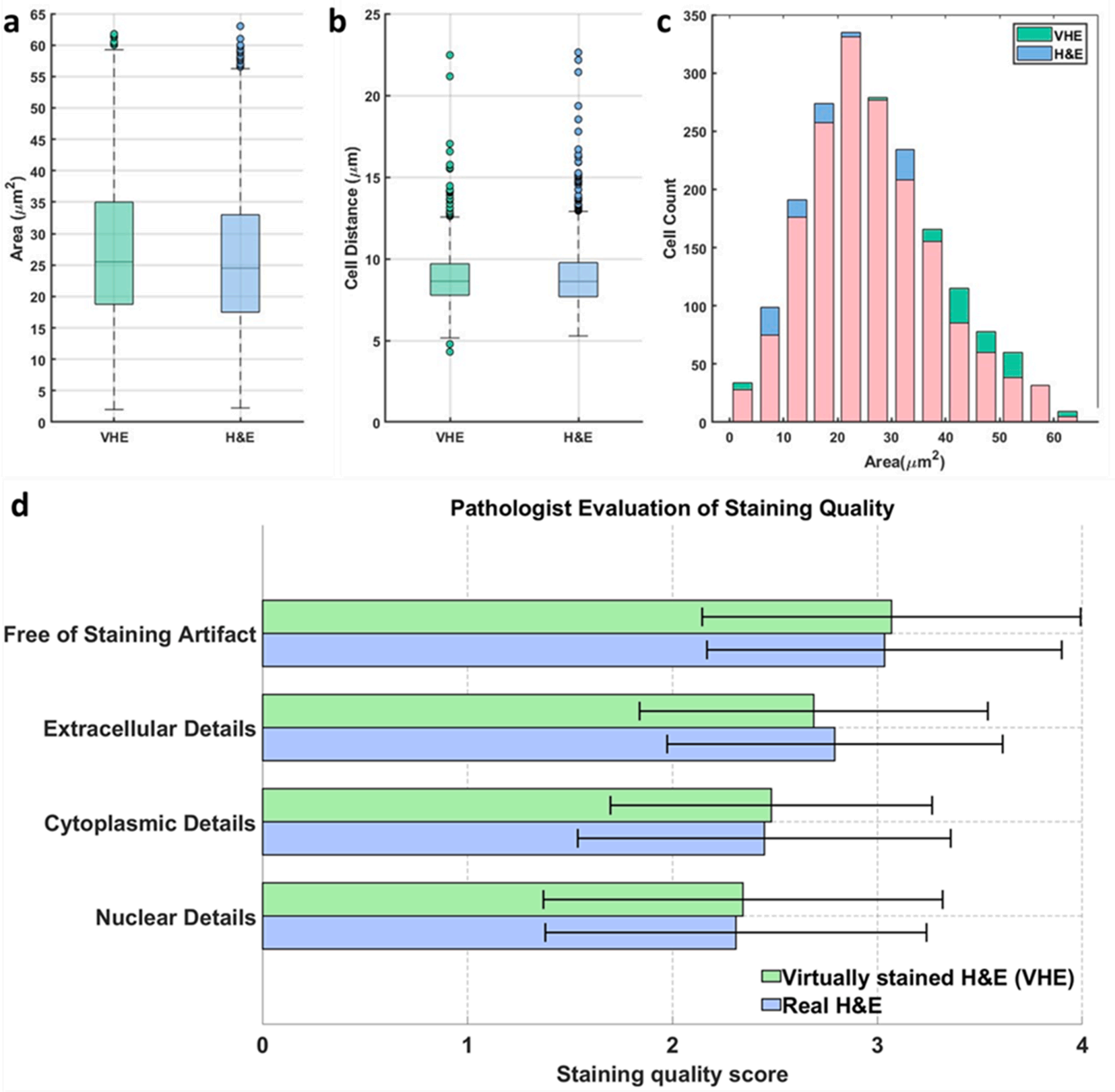

三、多重验证:从形态保真到临床认可

一项技巧能否落地,必须经过严苛的科学验证。NEGCUT框架通过了形态学定量分析、病理医生盲评、癌症分类准确性的三重考验,充分证明了其临床可靠性。

形态学验证

研究团队用QuPath软件对比VHE与真实H&E图像的关键指标:

淋巴结组织的VHE图像细胞核横截面积均值为27.10μm²,与H&E图像的25.91μm²几乎一致

细胞核间距均值8.79μm,仅与真实值8.90μm相差0.11μm

单位区域细胞核数量1820个,与真实值1813个*乎持*

此种精准的形态复刻,表明病理医生依赖的核心诊断依据完全得以保留。

盲评实验

研究人员将10组(含淋巴结、肝脏、大脑组织)VHE与H&E图像随机打乱,病理医生在未知来源的情况下,从细胞核细节、细胞质细节、细胞外结构、无染色伪影四个维度,以1-4分制评分。

结果显示,VHE图像在所有维度的评分均与H&E图像不相上下,其中“无染色伪影”一项评分甚至略高,这是因为虚拟染色完全避免了化学试剂带来的污染或染色不均问题。

癌症分类

双模态模型(UBF+VHE)达到95.9%的准确率,F1分数94.84%,仅略低于基于真实H&E图像的模型(准确率96.31%)。

而单独采用UBF或VHE图像的模型,准确率分别为90.12%和93.62%,充分证明了双模态融合的优势。

通过Grad-CAM手艺可视化发现,模型的判断依据与病理医生高度一致。

聚焦于细胞核拥挤、轮廓不规则等恶性特征区域,让“AI诊断”不再是难以解释的“黑箱”。

四、临床价值:高通量、低成本的病理诊断新范式

NEGCUT框架的落地,为病理诊断带来了全方位的价值革新。

效率上

虚拟染色单张切片仅需2-4分钟,远快于传统染色的20-30分钟;数字切片扫描仪单次处理100张切片的速度,更是传统手工操作无法企及的,彻底解决了高通量筛查的效率瓶颈。

成本上

虚拟染色无需化学试剂、无需专业染色技师,大幅降低了单切片的诊断成本。

对比传统技术,特殊染色如Masson三色染色需2-3小时、成本16-35美元,免疫组化(IHC)染色需1-2天、成本35-100美元。

而NEGCUT框架仅需少量计算资源,长期应用可节省50%以上的诊断成本。

无标记特性让组织样本得以完整保留

传统染色后的切片无法进行后续分子检测,而UBF图像扫描后,组织切片可继续用于免疫组化、空间转录组学等深度分析,尤其适合珍贵临床样本的多维研究。

此外,框架兼容不同品牌的数字切片扫描仪,凭借简单的PNG格式标准化,即可完成跨设备应用,无需医院更换现有硬件,大幅降低了临床转化门槛。

参考文献

已发表于《Medical Image Analysis》2026年第108卷(DOI: 10.1016/j.media.2025.103865),核心模型NEGCUT代码开源于https://github.com/WeilunWang/NEGCUT,癌症分类模型代码可通过https://github.com/Santanu07784/UBF_VHE_Classification获取。随着技术的持续迭代,NEGCUT框架有望成为数字病理的标准配置,让高通量、低成本、精准化的病理诊断惠及全球更多医疗机构。

浙公网安备 33010602011771号

浙公网安备 33010602011771号