实用指南:基于mediapipe深度学习的虚拟画板系统python源码

目录

1.前言

虚拟画板系统基于计算机视觉与深度学习技术,依据摄像头捕获用户手部动作,利用 MediaPipe框架实现手部关键点检测与手势识别,进而将手部运动转化为虚拟画笔操作。系统主要流程包括:图像采集→手部关键点检测→手势语义解析→坐标映射→绘图逻辑执行。

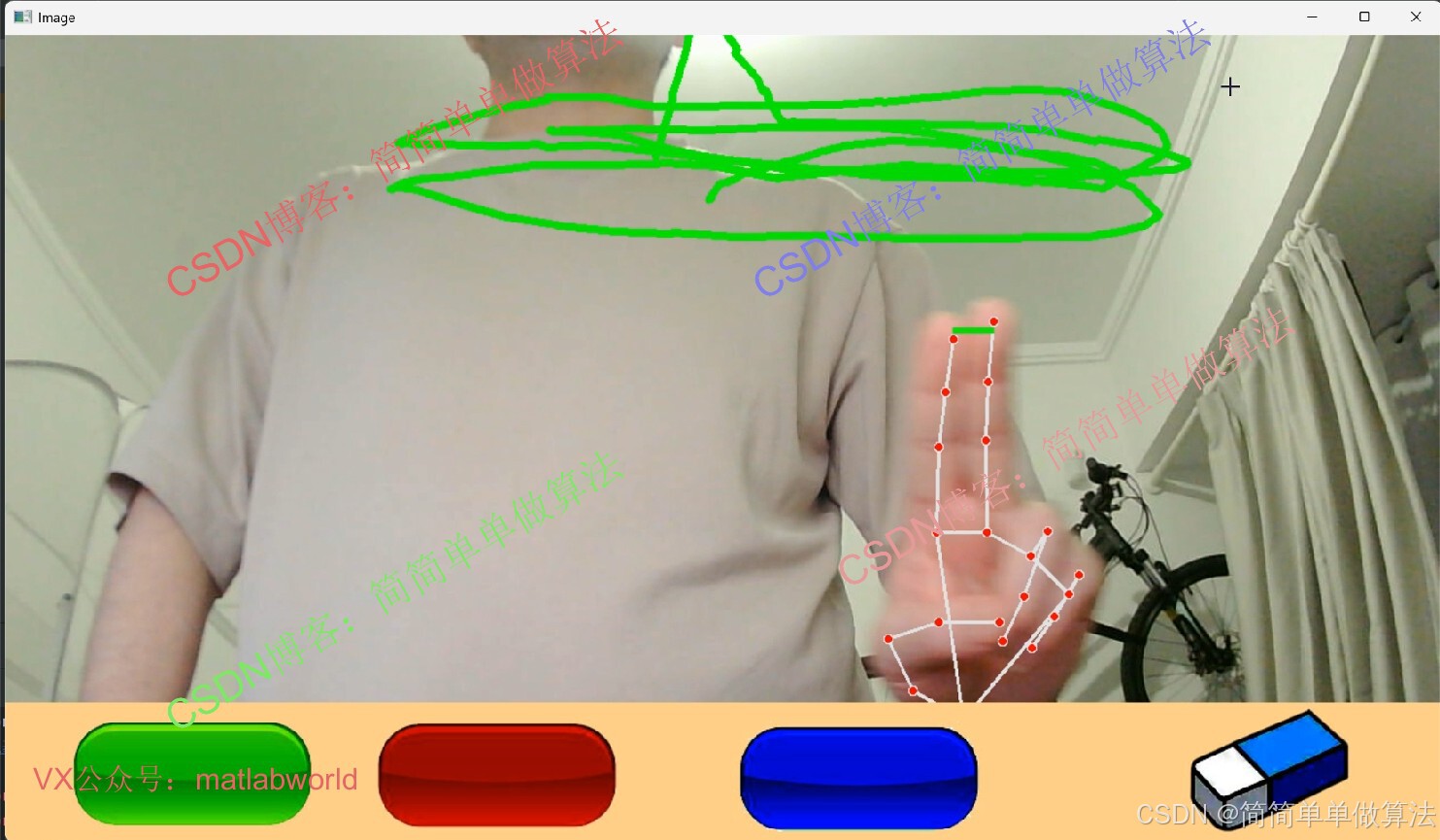

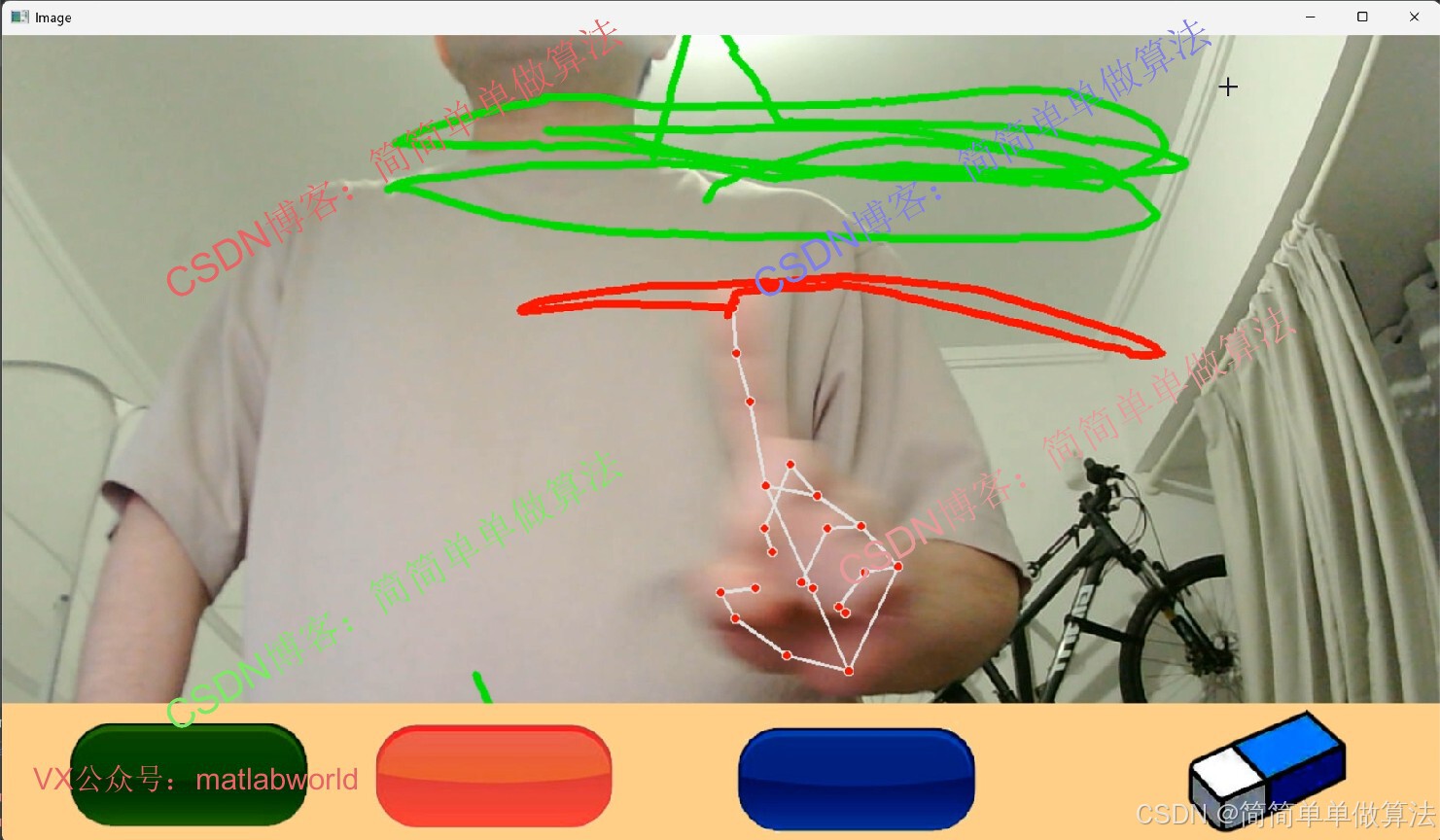

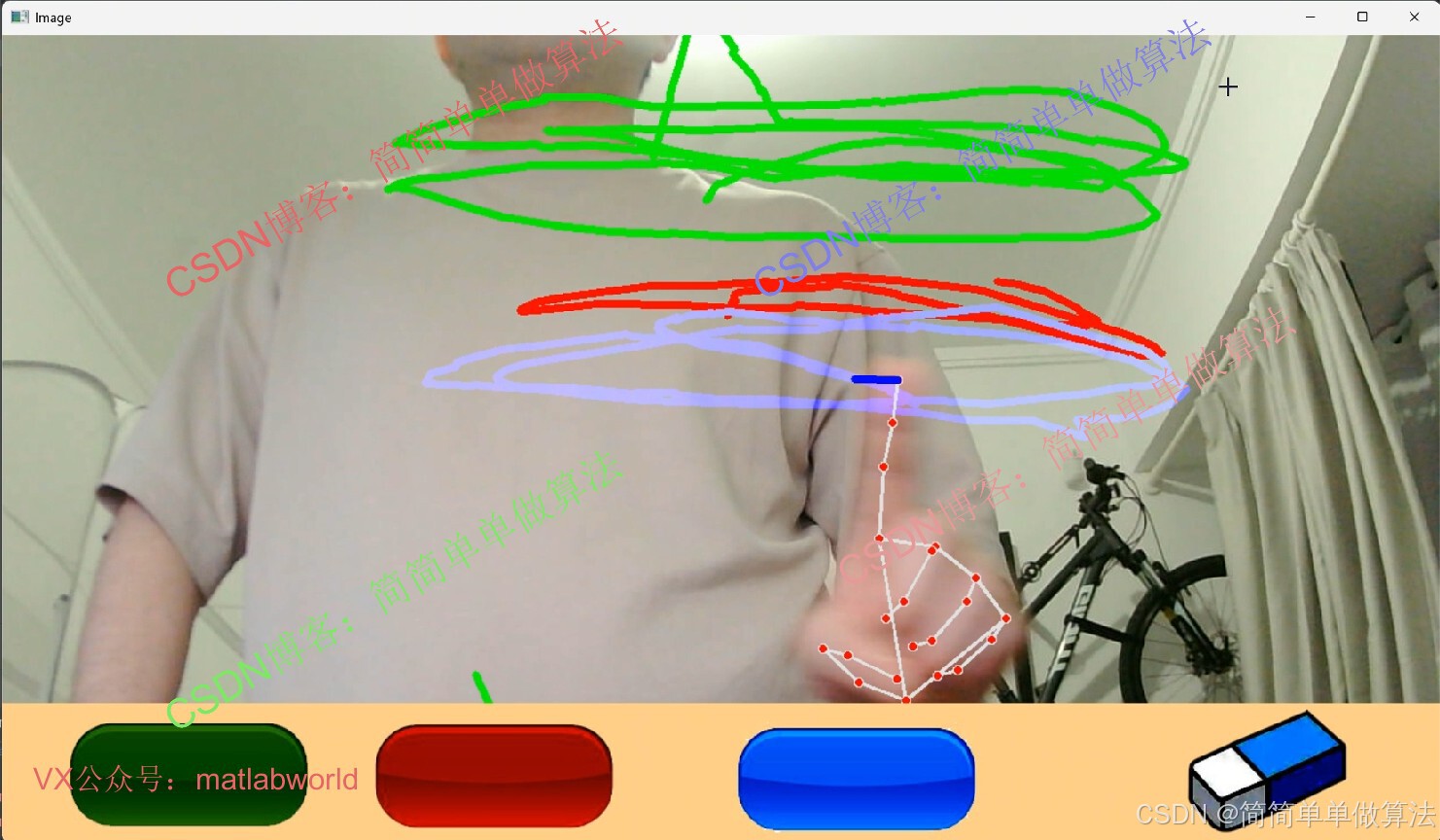

2.算法运行效果图预览

(完整程序运行后无水印)

3.算法运行软件版本

人工智能算法python程序运行环境安装步骤整理_本地ai 运行 python-CSDN博客

4.部分核心代码

- def findHands(self,img,draw=True):

- imgRGB=cv2.cvtColor(img,cv2.COLOR_BGR2RGB)

- self.results=hands.process(imgRGB)

-

- if self.results.multi_hand_landmarks:

- #getthe informationofeach hand

- forhandLmsin self.results.multi_hand_landmarks:

- if draw:

- self.mpDraw.draw_landmarks(img,handLms,self.mpHands.HAND_CONNECTIONS)

- return img

-

- def findPosition(self,img,handNo=0,draw=True):

- self.lmList=[]

- if self.results.multi_hand_landmarks:

- myHand=self.results.multi_hand_landmarks[handNo]

- for id,lm inenumerate(myHand.landmark):

-

- h,w,c=img.shape

- cx,cy=int(lm.x*w),int(lm.y*h)

-

- self.lmList.append([id,cx,cy])

- if draw:

- cv2.circle(img,(cx,cy),8,(255,0,0),cv2.FILLED)

- return self.lmList

-

- 0Y_007

5.算法仿真参数

# 指尖检测器,设置检测置信度为0.8

# 初始化摄像头

cap=cv2.VideoCapture(0)

cap.set(3,1280)

cap.set(4,720)pens=5#画笔宽度

erasers=100#橡皮宽度

6.算法理论概述

虚拟画板系统基于计算机视觉与深度学习手艺,通过摄像头捕获用户手部动作,利用 MediaPipe框架搭建手部关键点检测与手势识别,进而将手部运动转化为虚拟画笔管理。系统核心流程包括:图像采集→手部关键点检测→手势语义解析→坐标映射→绘图逻辑执行。

MediaPipe 的Hands模型采用轻量级卷积神经网络(CNN),结合姿态估计(Pose Estimation)与关键点检测(Keypoint Detection)技术,实现实时手部跟踪。模型结构包含:

轻量化主干网络:如 MobileNetV3,用于提取图像特征;

关键点回归头:输出 21 个手部关键点(如指尖、指节)的二维坐标与置信度,坐标值通过归一化处理(范围 [0,1])映射到图像尺寸。

通过分析手部关键点的相对位置关系,定义不同手势语义。例如:

画笔模式:单指(如食指)抬起,其余手指弯曲;

橡皮/画笔选择:两个手指同时伸开,则表示开始选择画笔颜色或者橡皮模式

7.参考文献

[1]陈吴东.基于深度学习的动态手势检测与识别算法研究[J].现代信息科技, 2025(8).

[2]范羽,梁梓康,徐明坤,等.基于MediaPipe手势识别的聋哑人交流架构设计[J].轻工科技, 2024, 40(5):99-102.

[3]孟杰,杨鹏程,杨朝,等.基于Mediapipe的幻影成像装置自然手势交互平台设计[J].国外电子测量技术, 2023, 42(3):116-122.DOI:10.19652/j.cnki.femt.2204392.

8.算法完整工具工程

OOOOO

OOO

O

浙公网安备 33010602011771号

浙公网安备 33010602011771号