机器学习

机器学习的定义

机器学习是一门研究如何让计算机系统不依赖于显式的、人工编写的指令,而是通过从数据(有限数据)中自动学习出规律(即模型),并利用这些规律对新的情况做出预测或决策的学科,其核心是从有限数据得出一般规律从而去预测那些未知的数据

机器学习不是简单的拟合样本

无机器学习的程序是先有规律再输入数据,而机器学习是先输入一部分样本数据和结果得到规律再投入新的数据,机器学习不是单纯的拟合问题,其目的是从有限的观测数据中得到一般的规律,即这个规律可能不一定是样本中最符合的但可能会是整体数据中符合的规律,因为样本毕竟数量有限,如果太符合样本的规律反而容易失去一般性,这就是过拟合了

机器学习和概率论密不可分,怎么抽样,抽什么样的样本才能使得机器学习得到的规律最有,这需要用到概率的知识

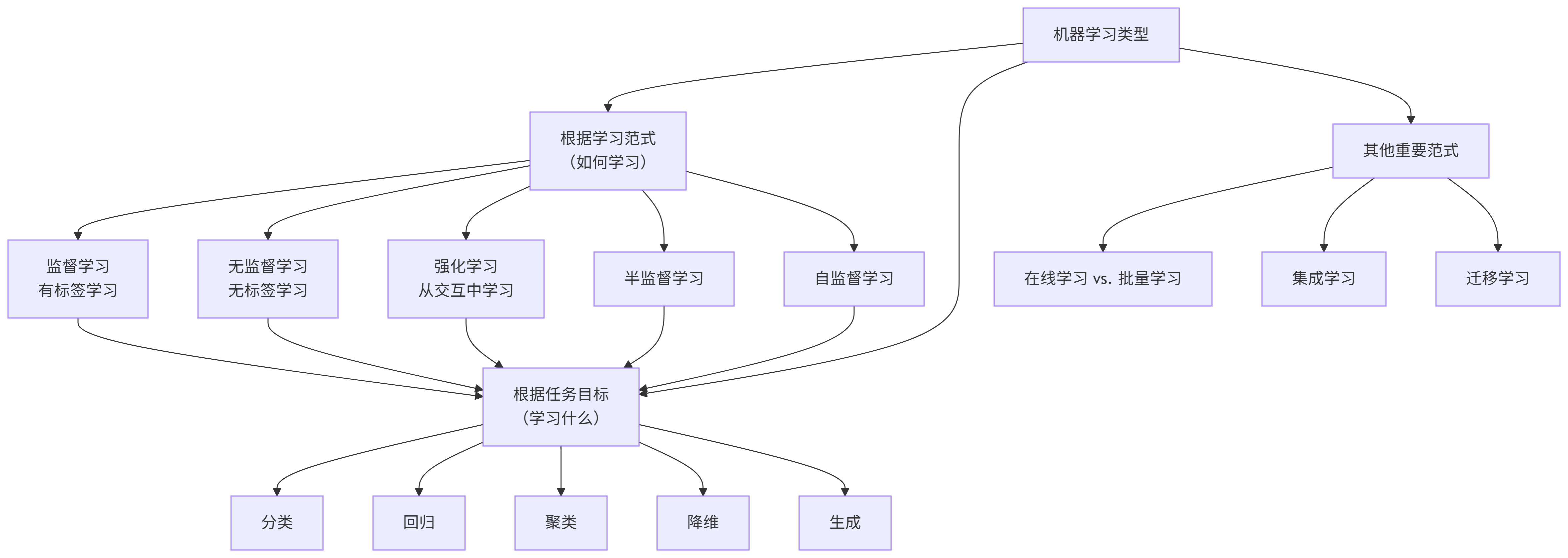

机器学习的类型

1. 根据学习范式(如何学习)划分

这是最核心的分类方式,体现了模型从数据中学习的不同模式。

| 类型 | 核心思想 | 数据要求 | 典型算法 | 在机器人领域的例子 |

|---|---|---|---|---|

| 监督学习 | 模型从有标签的数据中学习输入到输出的映射关系。 | 需要大量带标签的数据。 | 线性回归、逻辑回归、决策树、SVM、神经网络 | 物体识别(输入图像,输出标签如“杯子”)、抓取位姿预测(输入点云,输出抓取坐标和角度) |

| 无监督学习 | 在无标签的数据中发现内在结构或模式。 | 只需要数据,无需标签。 | K-Means、DBSCAN、PCA、自编码器 | 物体聚类:将看到的未知物体按形状自动分组。异常检测:从正常传感器数据中发现异常模式。 |

| 强化学习 | 智能体通过与环境交互获得的奖励信号来学习最优策略。 | 不需要标签,需要奖励函数和环境。 | Q-Learning、DDPG、PPO | 机器人行走:通过成功前进(正奖励)和摔倒(负奖励)学习步态。机械臂抓取:通过成功抓取(奖励)学习控制策略。 |

| 半监督学习 | 结合少量有标签数据和大量无标签数据进行学习。 | 少量标签+大量无标签数据。 | 标签传播、基于图的算法 | 使用大量未标注的传感器数据和少量人工标注的关键帧,来学习环境模型。 |

| 自监督学习 | 一种特殊的无监督学习,从数据本身自动生成标签来学习表示。 | 只需要数据本身。 | SimCLR、MoCo、BERT | 通过预测视频的下一帧或遮挡图像的一部分,让模型学习图像和环境的深度表示,为下游任务(如定位)打好基础。 |

2. 根据任务目标(学习什么)划分

这种分类方式关注模型要解决的具体问题类型。

| 任务类型 | 目标 | 输出类型 | 典型算法 |

|---|---|---|---|

| 分类 | 将输入数据划分到预定义的离散类别中。 | 离散的类别标签(如:猫/狗/鼠) | 逻辑回归、SVM、决策树、CNN |

| 回归 | 预测一个连续的数值。 | 连续的数值(如:房价、温度) | 线性回归、决策树、神经网络 |

| 聚类 | 将数据分成不同的组,组内样本相似,组间样本不同。 | 簇的标签(无预定义类别) | K-Means、层次聚类、DBSCAN |

| 降维 | 将高维数据压缩到低维空间,同时保留其主要特征。 | 低维度的表示 | PCA、t-SNE、自编码器 |

| 生成 | 学习数据的分布,并生成新的、类似的数据样本。 | 新的数据样本(如图像、文本) | GAN、VAE、Diffusion Model |

3. 其他重要范式

| 范式 | 核心思想 | 特点 |

|---|---|---|

| 在线学习 | 模型增量式地学习,数据依次流入并实时更新模型。 | 适应数据流的变化,计算高效。 |

| 批量学习 | 模型在全部数据集上一次性训练完成。 | 计算开销大,无法实时更新。 |

| 集成学习 | 结合多个弱模型的预测结果,以获得更好的整体性能。 | “三个臭皮匠,顶个诸葛亮”。如随机森林、XGBoost。 |

| 迁移学习 | 将一个任务上训练好的模型(知识和参数)迁移到另一个相关任务上。 | 解决新任务数据少、训练慢的问题。如在ImageNet上预训练的CNN模型用于机器人视觉任务。 |

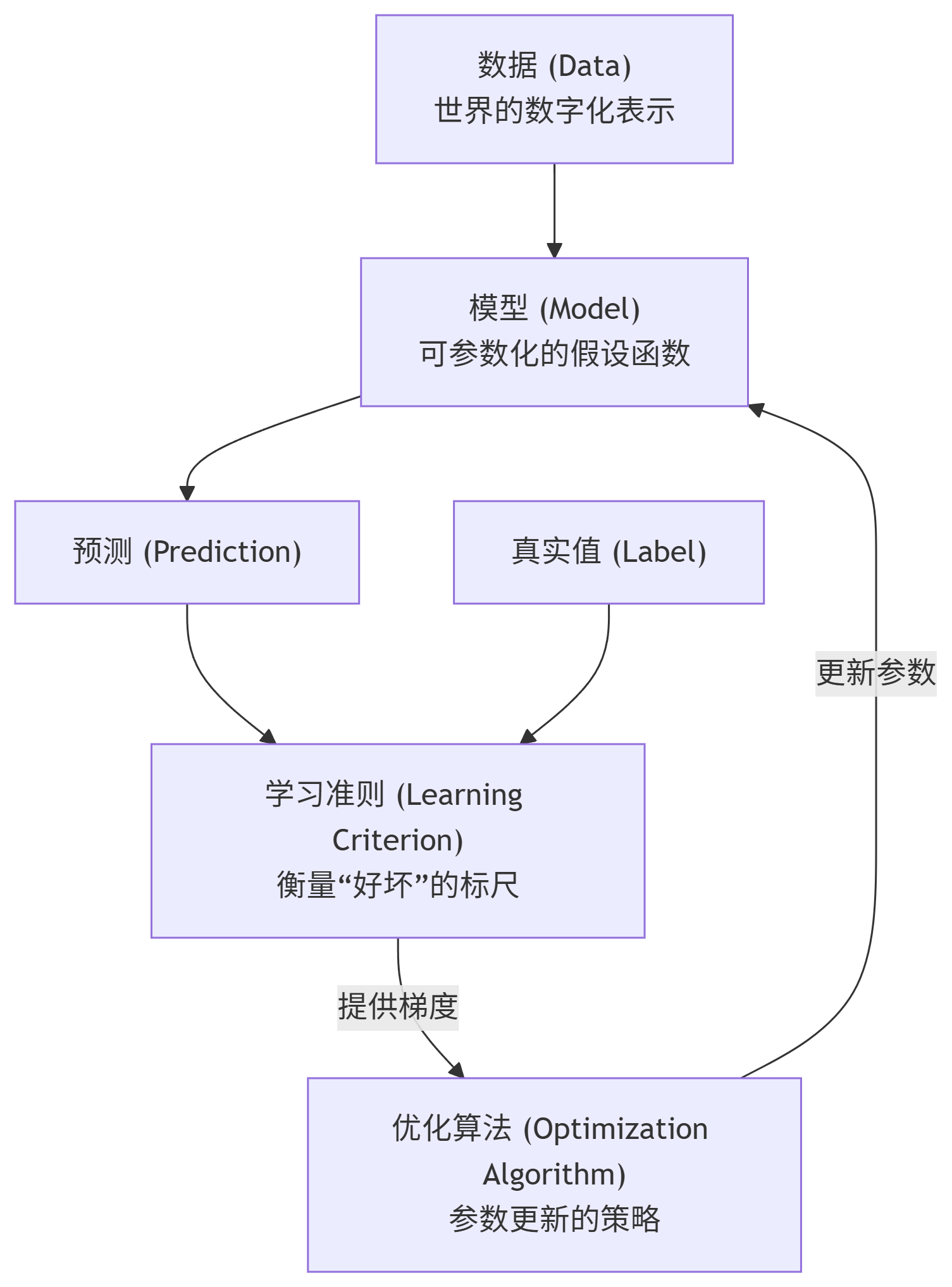

机器学习的要素

机器学习有四大要素数据、模型、学习准则和优化算法

数据:机器学习的燃料和原材料,是模型从中学习规律的事实基础。

模型:一个可调参数的函数,用于从输入数据映射到预测输出,是待学习的核心对象。

学习准则:衡量模型预测好坏的评判标准(损失函数),将学习问题转化为一个优化目标。

优化算法:自动调整模型参数以最小化损失函数的数学方法,是驱动模型学习的引擎。

一个好的模型应该在所有取值上都与真实映射函数一致,为了模型更加准确这里需要引入一个概念叫做损失函数

损失函数

损失函数是一个非负实数函数,用来量化模型预测和真实标签之间的差异

通过损失函数,我们可以知晓现有模型是否为最优的,通过寻找参数缩小二者的误差来得到最优的模型,这样机器学习问题就转换为了最优化问题

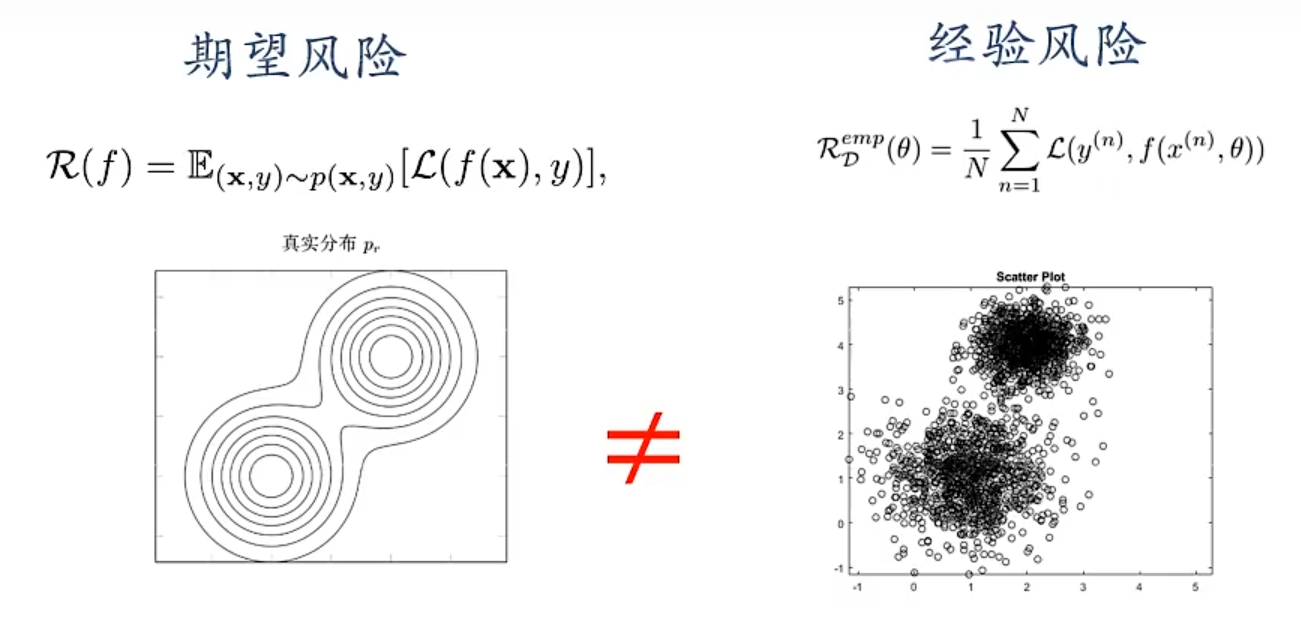

风险

经验风险:模型在已知训练数据上的平均损失。它是我们实际能计算的、优化的目标

期望风险:模型在整个真实数据分布上的平均损失。它是我们理想中希望最小化的、但无法直接计算的终极目标

机器学习的根本目标,就是使经验风险最小化(ERM)的结果,能够尽可能地接近期望风险最小化

损失函数是衡量“单个预测”好坏的尺子,而风险是衡量“整个模型”好坏的指标。风险是损失函数在特定数据分布上的平均值

最优化算法之梯度下降法

梯度下降法是一种通过迭代计算目标函数(如损失函数)的梯度并沿其反方向更新参数,以寻找该函数最小值的一阶优化算法

梯度下降法有四个组成部分,目标函数(需要被最小化的函数)、梯度(目标函数对每个参数的偏导数所组成的向量)、学习率(每次参数更新时的步长大小)、参数更新规则(根据梯度信息调整参数的数学公式)

函数值沿梯度方向增加最多,沿着梯度反方向减少最多,沿梯度垂直方向函数值不变

随机梯度下降法

随机梯度下降是梯度下降法的一种高效变体,其核心在于:每次迭代仅随机使用一个训练样本来计算梯度并立即更新模型参数,从而极大地提高训练速度,并能够跳出局部最优,在随机梯度算法上继续优化有小批量随机梯度算法(Mini-Batch),原本梯度下降算法是取所有样本的均值而随机梯度下降算法只取了一个样本,我们使用折中方案即采用一部分的样本来计算梯度并更新参数

过拟合:拟合是指机器学习模型在训练数据上表现得太好,以至于“死记硬背”下了训练数据的细节和噪声,反而导致其在未见过的数据上表现糟糕的现象,过拟合问题往往是由于训练数据少和噪声等原因造成的,过拟合是机器学习中的常见病,是模型“记忆力”胜过“理解力”的表现,根本原因是经验风险最小化原则导致的

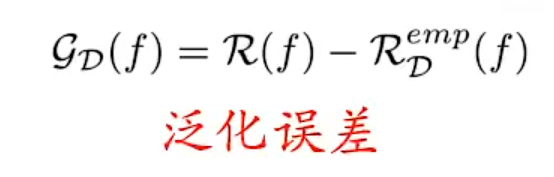

泛化

泛化误差是指机器学习模型在从未见过的新数据上的预测误差。它衡量的是模型脱离“练习题”(训练数据)后,解决“新考题”(真实世界数据)的真实能力,即其泛化能力,也就是说通过训练之后得到的模型在处理新数据时准确率是否达标,泛化误差即期望风险和经验风险之间的误差

正则化

正则化是一种通过向模型的损失函数中添加一个“惩罚项”,来故意约束模型复杂度,防止模型过度学习训练数据中的噪声和细节,从而提升其泛化能力的技术,所有损害优化的方法都是正则化,一般正则化有两个操作一个是增加优化约束另一个是干扰优化过程

浙公网安备 33010602011771号

浙公网安备 33010602011771号