第二次作业:卷积神经网络 part 2

第二次作业:卷积神经网络 part 2

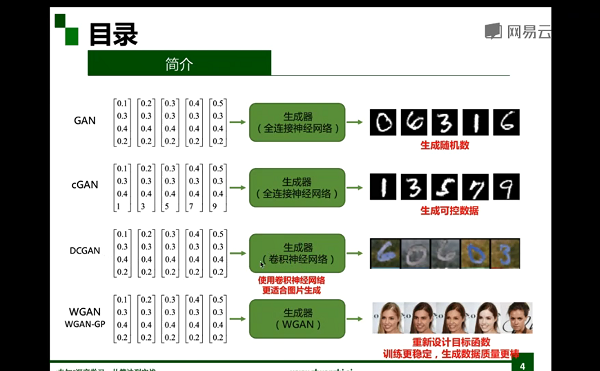

生成式对抗网络简介

-

生成式对抗网络的应用

图像着色、图像超像素、背景模糊、人脸生成、人脸定制、卡通图像生成、文本生成图片、字体变换、分格变换、图像修复、帧预测

-

生成式对抗网络及其衍生网络

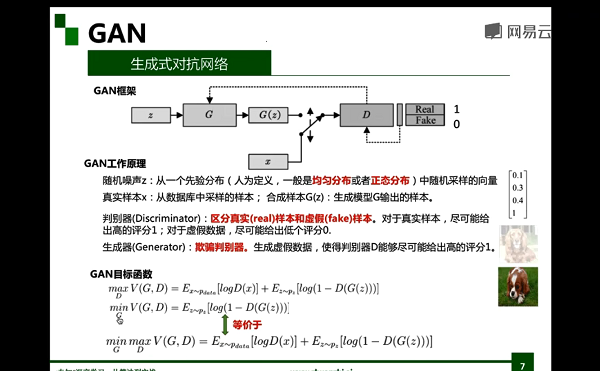

生成式对抗网络

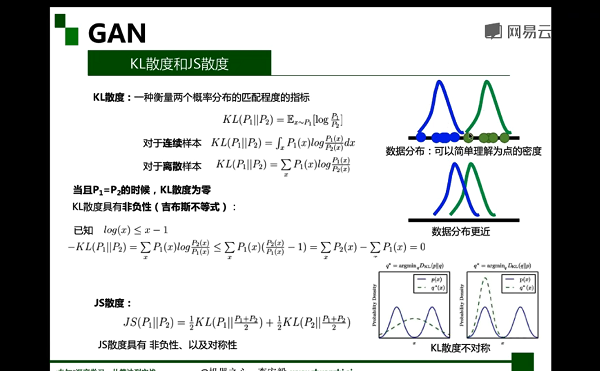

GAN:生成式对抗网络通过对抗训练,间接计算出散度(JS),使得模型可以优化。

生成式对抗网络由判别器和生成器组成:

- 判别器(Discriminator):区分真实(real)样本和虚假(fake)样本。对于真实样本,尽可能给出高的评分1;对于虚假数据,尽可能给出低个评分0。

- 生成器(Generator):欺骗判别器。生成虚假数据,使得判别器D能够尽可能给出高的评分1。

框架和目标函数

生成式对抗网络的生成算法

-

随机初始化生成器和判别器

-

交替训练判别器D和生成器G,直到收敛

-

步骤1∶固定生成器G,训练判别器D区分真实图像与合成图像。赋予真实图像高分,赋予合成图像低分。

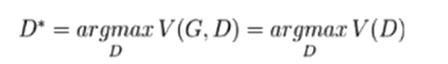

生成器固定,最优判别器如下:

-

- 步骤2∶固定判别器D,训练生成器G欺骗判别器D。更新生成器的参数,使其合成的图片被生成器D赋予高分。固定判别器,最优化生成器如下:

从概率角度分析GAN

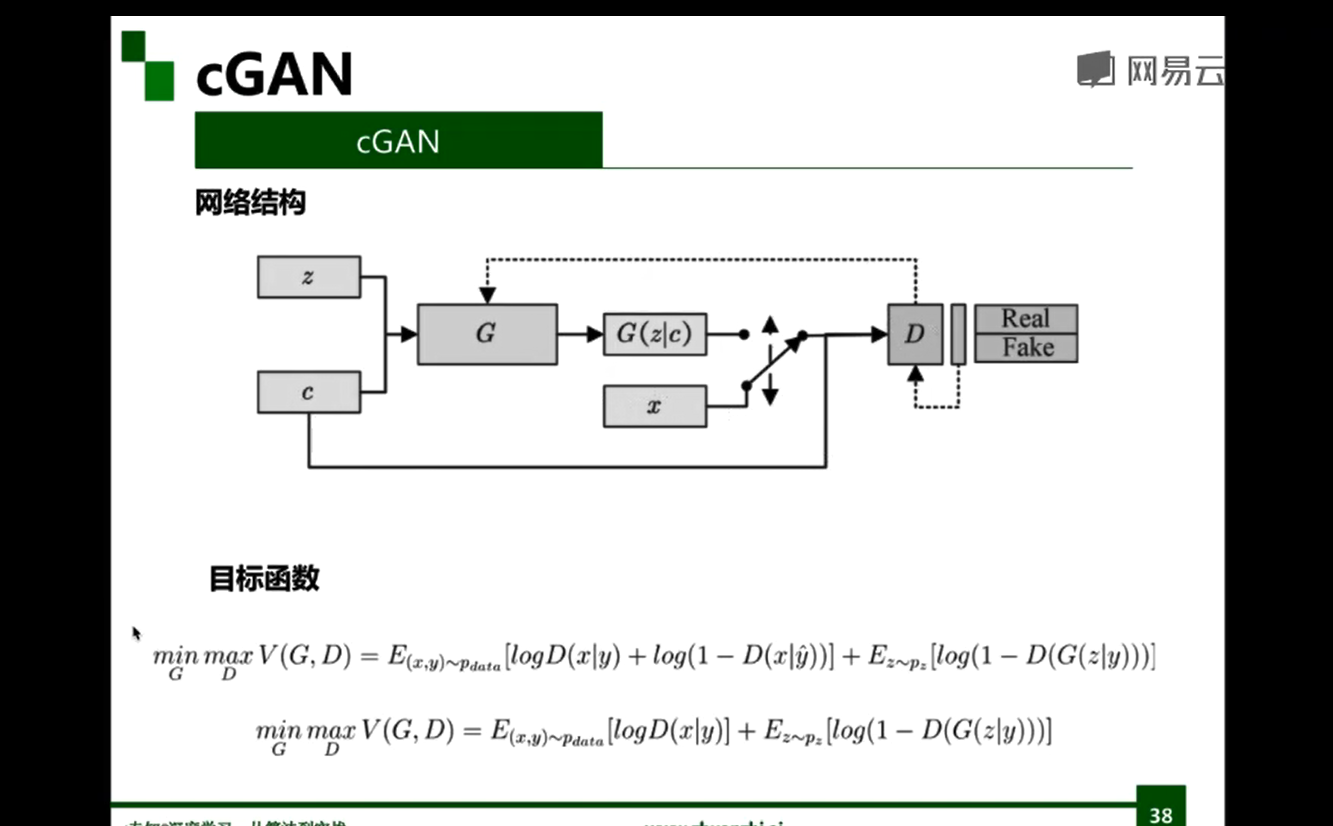

CGAN模型

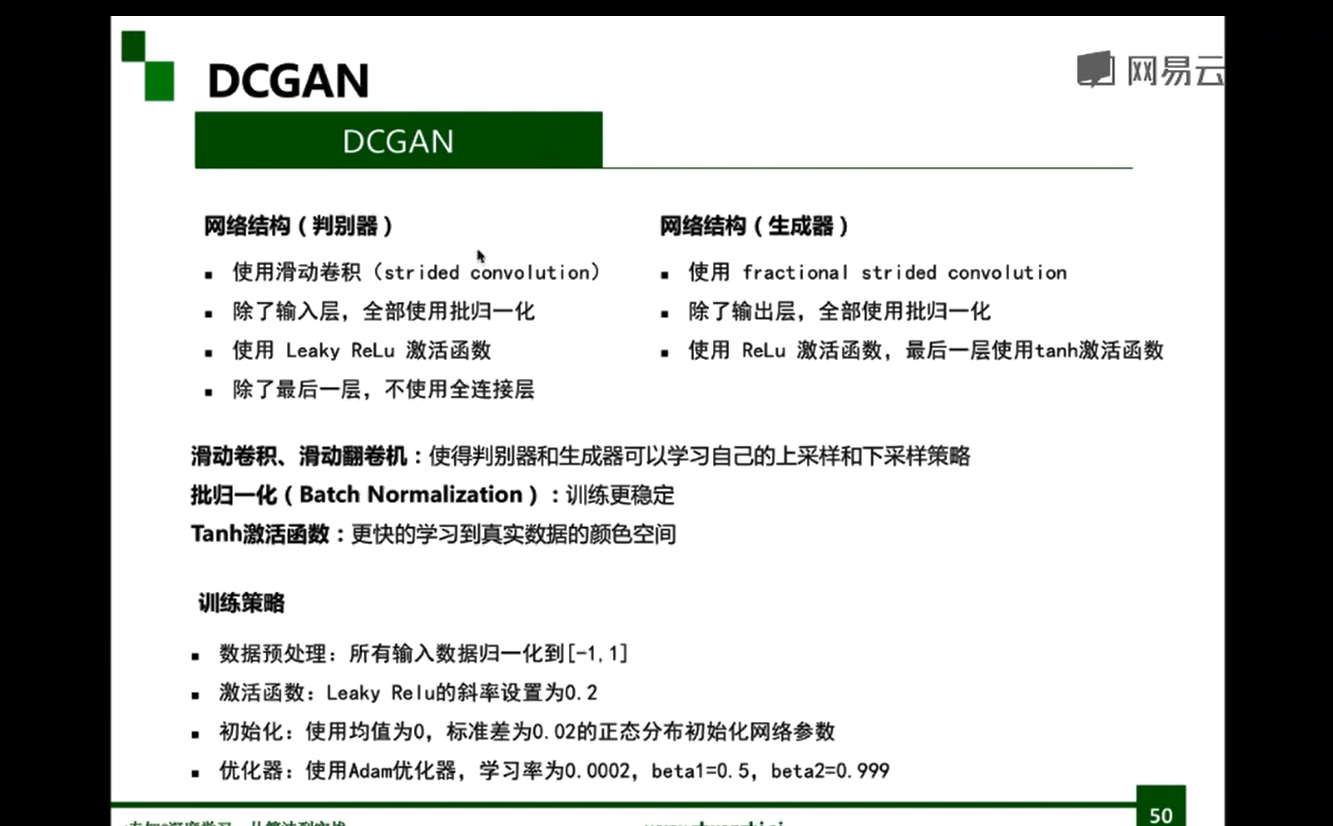

DCGAN

原始GAN,使用全连接网络作为判别器和生成器,不利于建模图像信息,参数量大,需要大量的计算资源,难以优化。DCGAN,使用卷积神经网络作为判别器和生成器,通过大量的工程实践,经验性地提出一系列的网络结构和优化策略,来有效的建模图。

代码部分

GAN代码

模型定义:

import torch.nn as nn

z_dim = 32

hidden_dim = 128

# 定义生成器

net_G = nn.Sequential(

nn.Linear(z_dim,hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, 2))

# 定义判别器

net_D = nn.Sequential(

nn.Linear(2,hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim,1),

nn.Sigmoid())

# 网络放到 GPU 上

net_G = net_G.to(device)

net_D = net_D.to(device)

# 定义网络的优化器

optimizer_G = torch.optim.Adam(net_G.parameters(),lr=0.0001)

optimizer_D = torch.optim.Adam(net_D.parameters(),lr=0.0001)

模型训练:

batch_size = 50

nb_epochs = 1000

loss_D_epoch = []

loss_G_epoch = []

for e in range(nb_epochs):

np.random.shuffle(X)

real_samples = torch.from_numpy(X).type(torch.FloatTensor)

loss_G = 0

loss_D = 0

for t, real_batch in enumerate(real_samples.split(batch_size)):

# 固定生成器G,改进判别器D

# 使用normal_()函数生成一组随机噪声,输入G得到一组样本

z = torch.empty(batch_size,z_dim).normal_().to(device)

fake_batch = net_G(z)

# 将真、假样本分别输入判别器,得到结果

D_scores_on_real = net_D(real_batch.to(device))

D_scores_on_fake = net_D(fake_batch)

# 优化过程中,假样本的score会越来越小,真样本的score会越来越大,下面 loss 的定义刚好符合这一规律,

# 要保证loss越来越小,真样本的score前面要加负号

# 要保证loss越来越小,假样本的score前面是正号(负负得正)

loss = -torch.mean(torch.log(1-D_scores_on_fake) + torch.log(D_scores_on_real))

# 梯度清零

optimizer_D.zero_grad()

# 反向传播优化

loss.backward()

# 更新全部参数

optimizer_D.step()

loss_D += loss

# 固定判别器,改进生成器

# 生成一组随机噪声,输入生成器得到一组假样本

z = torch.empty(batch_size,z_dim).normal_().to(device)

fake_batch = net_G(z)

# 假样本输入判别器得到 score

D_scores_on_fake = net_D(fake_batch)

# 我们希望假样本能够骗过生成器,得到较高的分数,下面的 loss 定义也符合这一规律

# 要保证 loss 越来越小,假样本的前面要加负号

loss = -torch.mean(torch.log(D_scores_on_fake))

optimizer_G.zero_grad()

loss.backward()

optimizer_G.step()

loss_G += loss

if e % 50 ==0:

print(f'\n Epoch {e} , D loss: {loss_D}, G loss: {loss_G}')

loss_D_epoch.append(loss_D)

loss_G_epoch.append(loss_G)

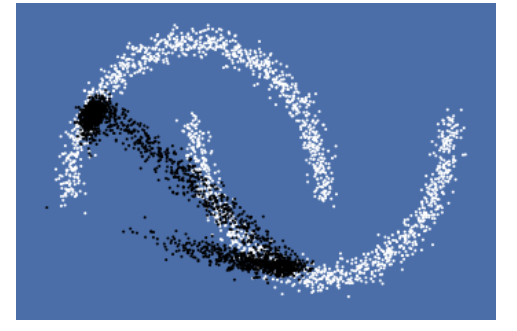

训练结果:

Epoch 950 , D loss: 37.79318618774414, G loss: 44.89418411254883

展示结果:

z = torch.empty(n_samples,z_dim).normal_().to(device)

fake_samples = net_G(z)

fake_data = fake_samples.cpu().data.numpy()

fig, ax = plt.subplots(1, 1, facecolor='#4B6EA9')

all_data = np.concatenate((X,fake_data),axis=0)

Y2 = np.concatenate((np.ones(n_samples),np.zeros(n_samples)))

plot_data(ax, all_data, Y2)

plt.show()

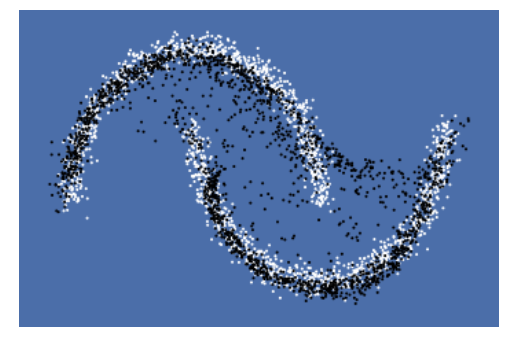

此时的learning_rate为0.0001,batch_size为50,将learning_rate改为0.001,batch_size改为250,后的运行结果为:

Epoch 950 , D loss: 10.98704719543457, G loss: 5.513564586639404

从图中可以看出,生成结果比之前好。

CGAN

判别器与生成器模型:

class Discriminator(nn.Module):

'''全连接判别器,用于1x28x28的MNIST数据,输出是数据和类别'''

def __init__(self):

super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(28*28+10, 512),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(512, 256),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(256, 1),

nn.Sigmoid()

)

def forward(self, x, c):

x = x.view(x.size(0), -1)

validity = self.model(torch.cat([x, c], -1))

return validity

class Generator(nn.Module):

'''全连接生成器,用于1x28x28的MNIST数据,输入是噪声和类别'''

def __init__(self, z_dim):

super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Linear(z_dim+10, 128),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(128, 256),

nn.BatchNorm1d(256, 0.8),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(256, 512),

nn.BatchNorm1d(512, 0.8),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(in_features=512, out_features=28*28),

nn.Tanh()

)

def forward(self, z, c):

x = self.model(torch.cat([z, c], dim=1))

x = x.view(-1, 1, 28, 28)

return x

# 开始训练,一共训练total_epochs

for epoch in range(total_epochs):

# torch.nn.Module.train() 指的是模型启用 BatchNormalization 和 Dropout

# torch.nn.Module.eval() 指的是模型不启用 BatchNormalization 和 Dropout

# 因此,train()一般在训练时用到, eval() 一般在测试时用到

generator = generator.train()

# 训练一个epoch

for i, data in enumerate(dataloader):

# 加载真实数据

real_images, real_labels = data

real_images = real_images.to(device)

# 把对应的标签转化成 one-hot 类型

tmp = torch.FloatTensor(real_labels.size(0), 10).zero_()

real_labels = tmp.scatter_(dim=1, index=torch.LongTensor(real_labels.view(-1, 1)), value=1)

real_labels = real_labels.to(device)

# 生成数据

# 用正态分布中采样batch_size个随机噪声

z = torch.randn([batch_size, z_dim]).to(device)

# 生成 batch_size 个 ont-hot 标签

c = torch.FloatTensor(batch_size, 10).zero_()

c = c.scatter_(dim=1, index=torch.LongTensor(np.random.choice(10, batch_size).reshape([batch_size, 1])), value=1)

c = c.to(device)

# 生成数据

fake_images = generator(z,c)

# 计算判别器损失,并优化判别器

real_loss = bce(discriminator(real_images, real_labels), ones)

fake_loss = bce(discriminator(fake_images.detach(), c), zeros)

d_loss = real_loss + fake_loss

d_optimizer.zero_grad()

d_loss.backward()

d_optimizer.step()

# 计算生成器损失,并优化生成器

g_loss = bce(discriminator(fake_images, c), ones)

g_optimizer.zero_grad()

g_loss.backward()

g_optimizer.step()

# 输出损失

print("[Epoch %d/%d] [D loss: %f] [G loss: %f]" % (epoch, total_epochs, d_loss.item(), g_loss.item()))

训练结果:

[Epoch 149/150] [D loss: 0.000129] [G loss: 21.908524]

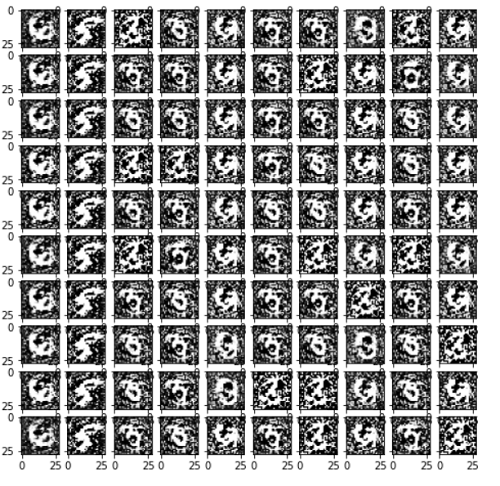

结果展示:

#用于生成效果图

# 生成100个随机噪声向量

fixed_z = torch.randn([100, z_dim]).to(device)

# 生成100个one_hot向量,每类10个

fixed_c = torch.FloatTensor(100, 10).zero_()

fixed_c = fixed_c.scatter_(dim=1, index=torch.LongTensor(np.array(np.arange(0, 10).tolist()*10).reshape([100, 1])), value=1)

fixed_c = fixed_c.to(device)

generator = generator.eval()

fixed_fake_images = generator(fixed_z, fixed_c)

plt.figure(figsize=(8, 8))

for j in range(10):

for i in range(10):

img = fixed_fake_images[j*10+i, 0, :, :].detach().cpu().numpy()

img = img.reshape([28, 28])

plt.subplot(10, 10, j*10+i+1)

plt.imshow(img, 'gray')

此时的epoch为150

DCGAN

class D_dcgan(nn.Module):

'''滑动卷积判别器'''

def __init__(self):

super(D_dcgan, self).__init__()

self.conv = nn.Sequential(

# 第一个滑动卷积层,不使用BN,LRelu激活函数

nn.Conv2d(in_channels=1, out_channels=16, kernel_size=3, stride=2, padding=1),

nn.LeakyReLU(0.2, inplace=True),

# 第二个滑动卷积层,包含BN,LRelu激活函数

nn.Conv2d(in_channels=16, out_channels=32, kernel_size=3, stride=2, padding=1),

nn.BatchNorm2d(32),

nn.LeakyReLU(0.2, inplace=True),

# 第三个滑动卷积层,包含BN,LRelu激活函数

nn.Conv2d(in_channels=32, out_channels=64, kernel_size=3, stride=2, padding=1),

nn.BatchNorm2d(64),

nn.LeakyReLU(0.2, inplace=True),

# 第四个滑动卷积层,包含BN,LRelu激活函数

nn.Conv2d(in_channels=64, out_channels=128, kernel_size=4, stride=1),

nn.BatchNorm2d(128),

nn.LeakyReLU(0.2, inplace=True)

)

# 全连接层+Sigmoid激活函数

self.linear = nn.Sequential(nn.Linear(in_features=128, out_features=1), nn.Sigmoid())

def forward(self, x):

x = self.conv(x)

x = x.view(x.size(0), -1)

validity = self.linear(x)

return validity

class G_dcgan(nn.Module):

'''反滑动卷积生成器'''

def __init__(self, z_dim):

super(G_dcgan, self).__init__()

self.z_dim = z_dim

# 第一层:把输入线性变换成256x4x4的矩阵,并在这个基础上做反卷机操作

self.linear = nn.Linear(self.z_dim, 4*4*256)

self.model = nn.Sequential(

# 第二层:bn+relu

nn.ConvTranspose2d(in_channels=256, out_channels=128, kernel_size=3, stride=2, padding=0),

nn.BatchNorm2d(128),

nn.ReLU(inplace=True),

# 第三层:bn+relu

nn.ConvTranspose2d(in_channels=128, out_channels=64, kernel_size=3, stride=2, padding=1),

nn.BatchNorm2d(64),

nn.ReLU(inplace=True),

# 第四层:不使用BN,使用tanh激活函数

nn.ConvTranspose2d(in_channels=64, out_channels=1, kernel_size=4, stride=2, padding=2),

nn.Tanh()

)

def forward(self, z):

# 把随机噪声经过线性变换,resize成256x4x4的大小

x = self.linear(z)

x = x.view([x.size(0), 256, 4, 4])

# 生成图片

x = self.model(x)

return x

训练结果:

[Epoch 29/30] [D loss: 0.014453] [G loss: 5.469985]

结果展示:

浙公网安备 33010602011771号

浙公网安备 33010602011771号