第二次作业:卷积神经网络 part 1

【第一部分】 视频学习心得及问题总结

一:深层网络的局部极小值是非凸的激活函数导致的吗?如果是,为何不用凸激活函数?

1.深层网络的局部极小值主要是多个隐层复合所致。

2.ReLu就是凸激活函数,但多个凸激活函数的复合也不一定是凸的:比如f(x)=exp(-x)在x>0时凸,但f(f(x))就是非凸的。

3.局部极小值会随着隐层的增加会成倍的增加。

二:逐层预训练真的是为了找到更好的局部极小值吗?

1.深度网络参数太多,梯度下降在非常高维空间进行,很难得到在所有维度上都是局部最小的的局部极小值。

2.大多数情况下参数落在在鞍点处:某些维度上是最低点,在某些维度上最高点→增加扰动很容易跳出鞍点。

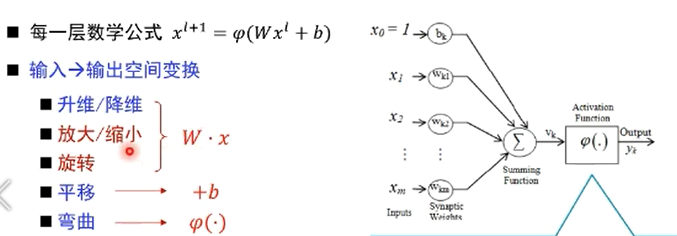

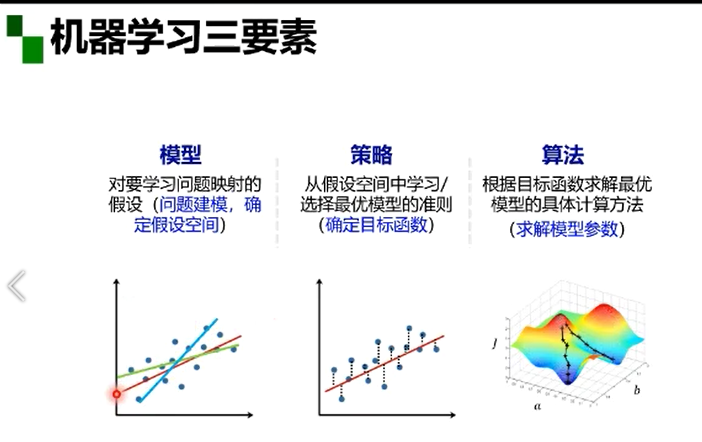

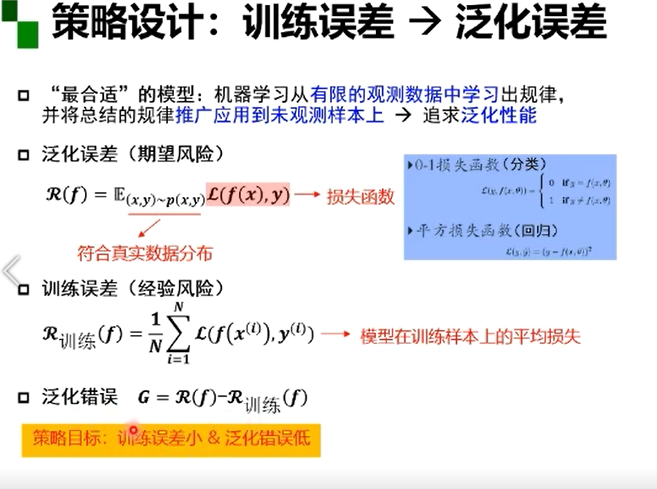

机器学习三要素:模型、策略、算法

概率/函数形式的统一

“最优”的策略设计

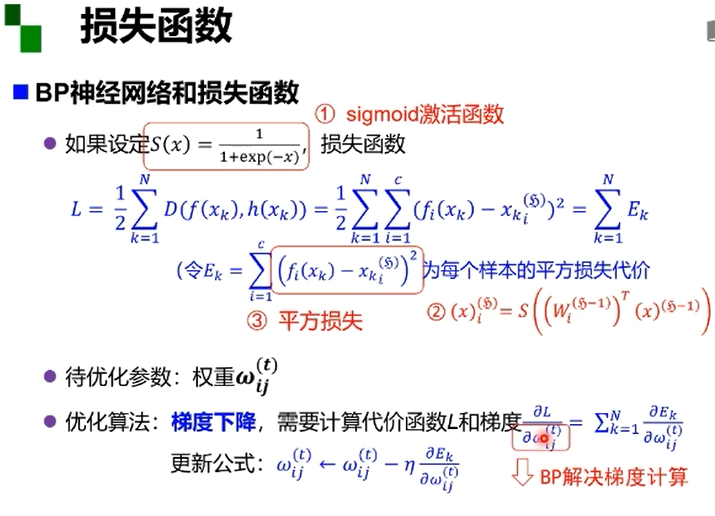

损失函数

数据点分度的角度:表示数据需要的最小的基的数量→数据分布模式越容易被捕捉,即需要的基越少,秩就越小。

若矩阵表达的是结构化信息,如图像、用户-物品表等,各行之间存在一定的相关性,一般是低秩。

较大奇异值包含了矩阵的主要信息。

低秩近似的意义:保留决定数据分布的最主要的模式/方向(丢弃的肯能是噪声或者其他不关键的信息)。

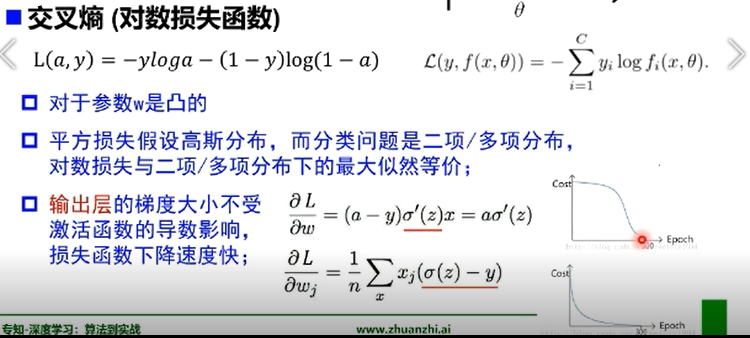

逻辑回归也可以直接采用对数损失函数用过经验风险最小化求参:

经验风险最小化策略与极大似然优化得到的模型参数是一致的。

PAC给出了实际训练学习器的目标:

从合理数量的训练数据通过合理计算量学习到可靠的知识

合理数量训练数据:数据集大小;

合理计算量:学习训练时间

可靠的只是:概率的置信度,近似的误差上界

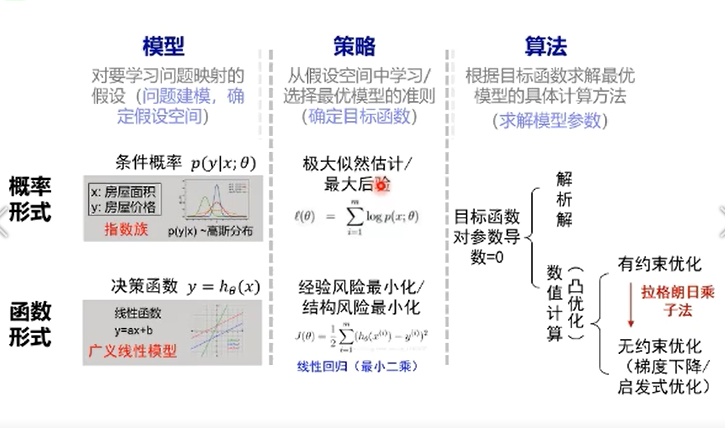

欠拟合vs过拟合

→欠拟合:训练集的一般性质尚未被学习器学好(训练误差大)

→过拟合:学习器把训练集特点当做样本的一般特点(训练误差小,测试误差大)

欠拟合、过拟合解决方案

欠拟合:1.提高模型复杂度(决策树:扩展分支 神经网络:增加训练轮数)

过拟合:1.降低模型复杂度(优化目标加正则项 决策树:剪枝 神经网络:early stop、dropout)

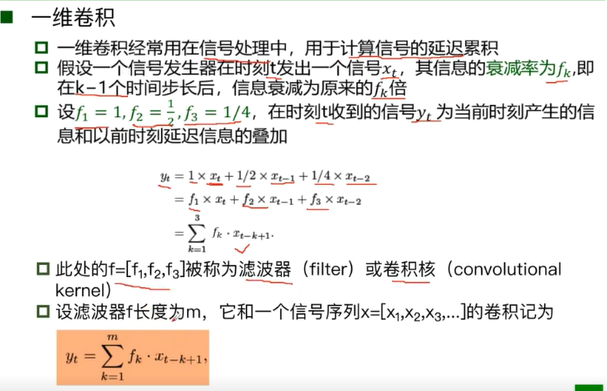

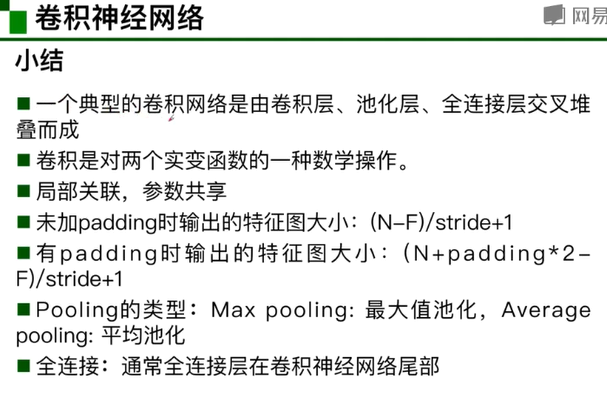

卷积神经网络部分:

深度学习三部曲:1.搭建神经网络结构。2.找到一个合适的损失函数3.找到一个合适的优化函数

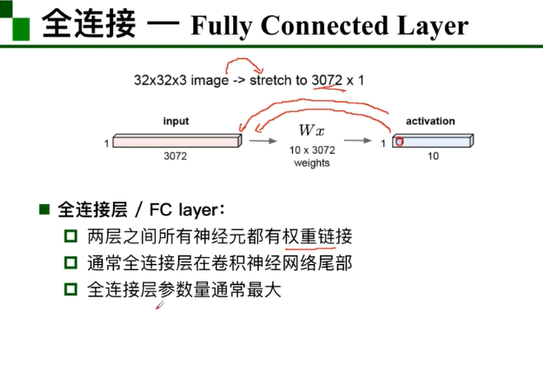

全连接网络处理图像问题:参数太多:权重矩阵的参数太多→过拟合

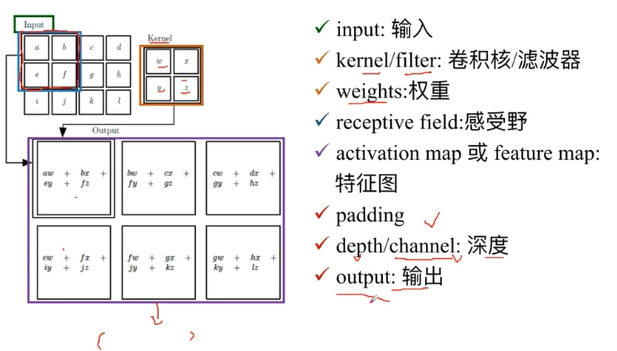

卷积神经网络的解决方式:局部关联,参数共享

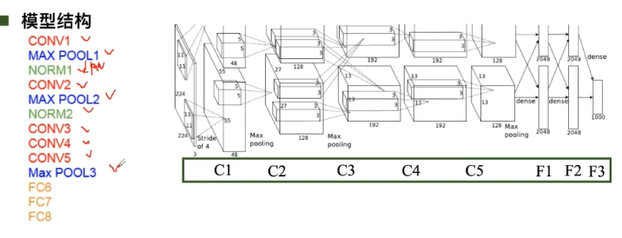

卷积神经网络低矮型结构--AlexNet

用ReLU函数的有点事解决了梯度消失的问题(在正区间),计算速度特别快,只需判断输入是否大于0,收敛速度远快于sigmoid

DropOut(随机失活)训练时随即关闭部分神经元测试时整合所有神经元

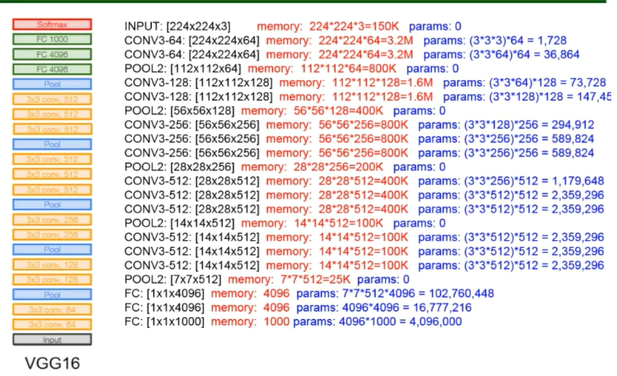

卷积神经网络典型结构-VGG

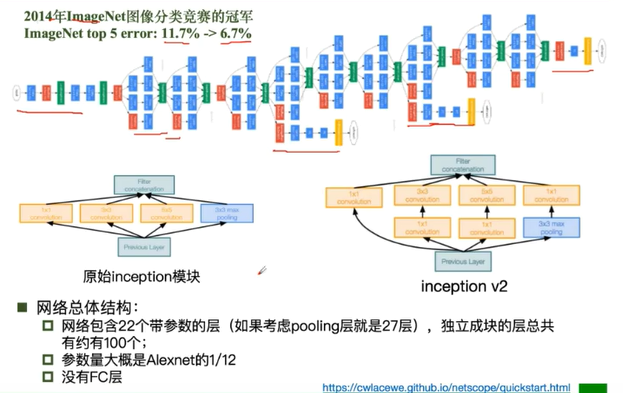

卷积神经网络典型结构-GoogleNet

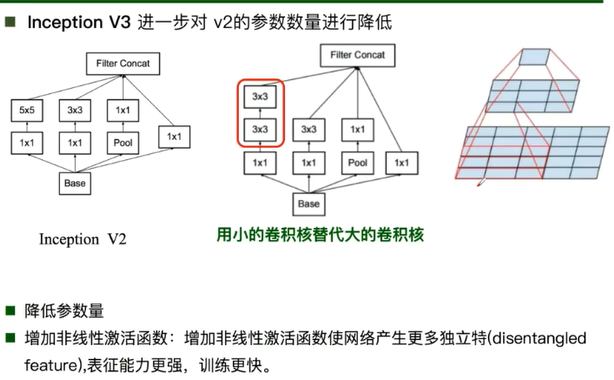

GoogleNet:Inception v2

GoogleNet:Inception v3

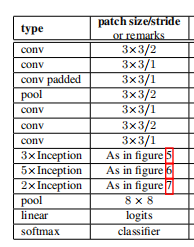

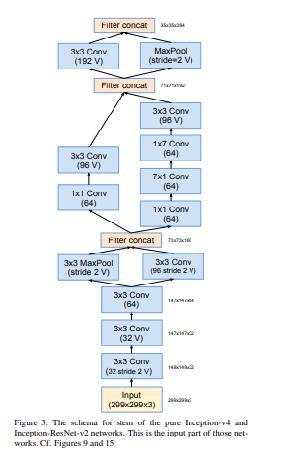

Stem部分(steam network):卷积-池化-卷积-卷积-池化

输出:没有额外的全连接层(除了最后的类别输出层)

辅助分类器:解决由于模型深度过深导致的梯度消失的问题

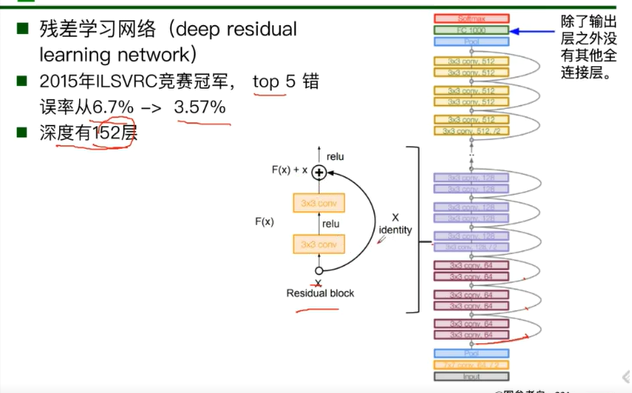

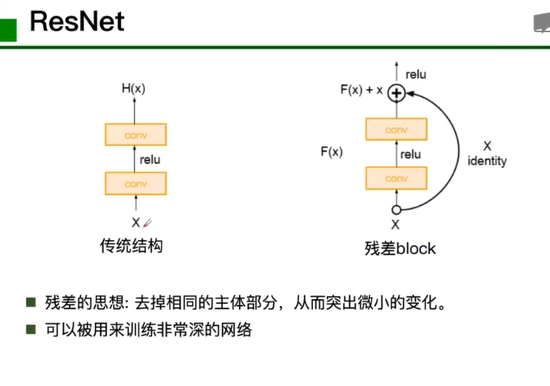

ResNet

【第二部分】 代码练习

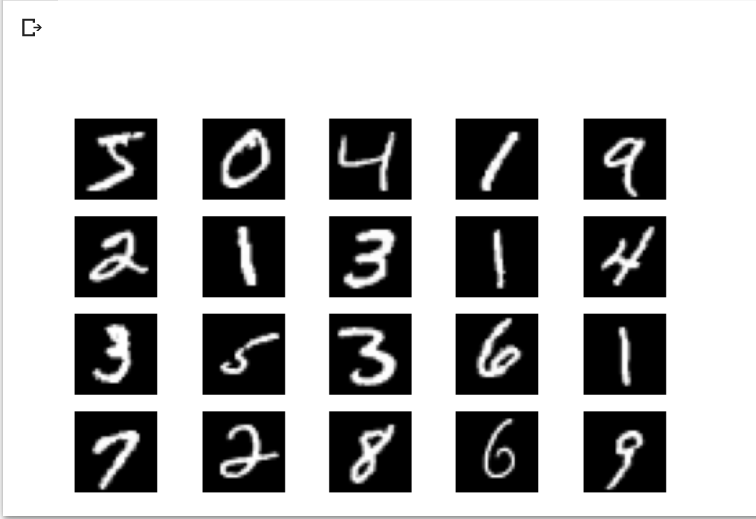

● MNIST 数据集分类

import torch import torch.nn as nn import torch.nn.functional as F import torch.optim as optim from torchvision import datasets, transforms import matplotlib.pyplot as plt import numpy # 一个函数,用来计算模型中有多少参数 def get_n_params(model): np=0 for p in list(model.parameters()): np += p.nelement() return np # 使用GPU训练,可以在菜单 "代码执行工具" -> "更改运行时类型" 里进行设置 device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

input_size = 28*28 # MNIST上的图像尺寸是 28x28 output_size = 10 # 类别为 0 到 9 的数字,因此为十类 train_loader = torch.utils.data.DataLoader( datasets.MNIST('./data', train=True, download=True, transform=transforms.Compose( [transforms.ToTensor(), transforms.Normalize((0.1307,), (0.3081,))])), batch_size=64, shuffle=True) test_loader = torch.utils.data.DataLoader( datasets.MNIST('./data', train=False, transform=transforms.Compose([ transforms.ToTensor(), transforms.Normalize((0.1307,), (0.3081,))])), batch_size=1000, shuffle=True)

plt.figure(figsize=(8, 5)) for i in range(20): plt.subplot(4, 5, i + 1) image, _ = train_loader.dataset.__getitem__(i) plt.imshow(image.squeeze().numpy(),'gray') plt.axis('off');

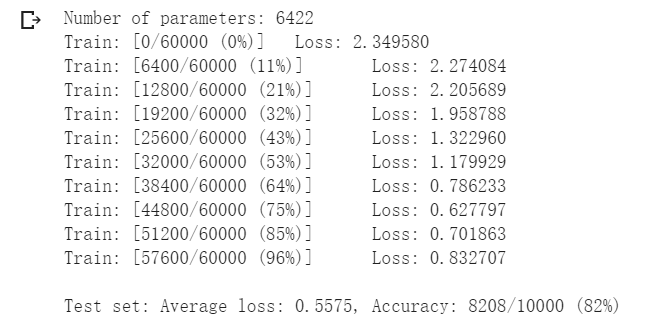

# 训练函数 def train(model): model.train() # 主里从train_loader里,64个样本一个batch为单位提取样本进行训练 for batch_idx, (data, target) in enumerate(train_loader): # 把数据送到GPU中 data, target = data.to(device), target.to(device) optimizer.zero_grad() output = model(data) loss = F.nll_loss(output, target) loss.backward() optimizer.step() if batch_idx % 100 == 0: print('Train: [{}/{} ({:.0f}%)]\tLoss: {:.6f}'.format( batch_idx * len(data), len(train_loader.dataset), 100. * batch_idx / len(train_loader), loss.item())) def test(model): model.eval() test_loss = 0 correct = 0 for data, target in test_loader: # 把数据送到GPU中 data, target = data.to(device), target.to(device) # 把数据送入模型,得到预测结果 output = model(data) # 计算本次batch的损失,并加到 test_loss 中 test_loss += F.nll_loss(output, target, reduction='sum').item() # get the index of the max log-probability,最后一层输出10个数, # 值最大的那个即对应着分类结果,然后把分类结果保存在 pred 里 pred = output.data.max(1, keepdim=True)[1] # 将 pred 与 target 相比,得到正确预测结果的数量,并加到 correct 中 # 这里需要注意一下 view_as ,意思是把 target 变成维度和 pred 一样的意思 correct += pred.eq(target.data.view_as(pred)).cpu().sum().item() test_loss /= len(test_loader.dataset) accuracy = 100. * correct / len(test_loader.dataset) print('\nTest set: Average loss: {:.4f}, Accuracy: {}/{} ({:.0f}%)\n'.format( test_loss, correct, len(test_loader.dataset), accuracy))

n_hidden = 8 # number of hidden units model_fnn = FC2Layer(input_size, n_hidden, output_size) model_fnn.to(device) optimizer = optim.SGD(model_fnn.parameters(), lr=0.01, momentum=0.5) print('Number of parameters: {}'.format(get_n_params(model_fnn))) train(model_fnn) test(model_fnn)

perm = torch.randperm(784) plt.figure(figsize=(8, 4)) for i in range(10): image, _ = train_loader.dataset.__getitem__(i) # permute pixels image_perm = image.view(-1, 28*28).clone() image_perm = image_perm[:, perm] image_perm = image_perm.view(-1, 1, 28, 28) plt.subplot(4, 5, i + 1) plt.imshow(image.squeeze().numpy(), 'gray') plt.axis('off') plt.subplot(4, 5, i + 11) plt.imshow(image_perm.squeeze().numpy(), 'gray') plt.axis('off')

perm = torch.randperm(784) n_features = 6 # number of feature maps model_cnn = CNN(input_size, n_features, output_size) model_cnn.to(device) optimizer = optim.SGD(model_cnn.parameters(), lr=0.01, momentum=0.5) print('Number of parameters: {}'.format(get_n_params(model_cnn))) train_perm(model_cnn, perm) test_perm(model_cnn, perm)

● CIFAR10 数据集分类

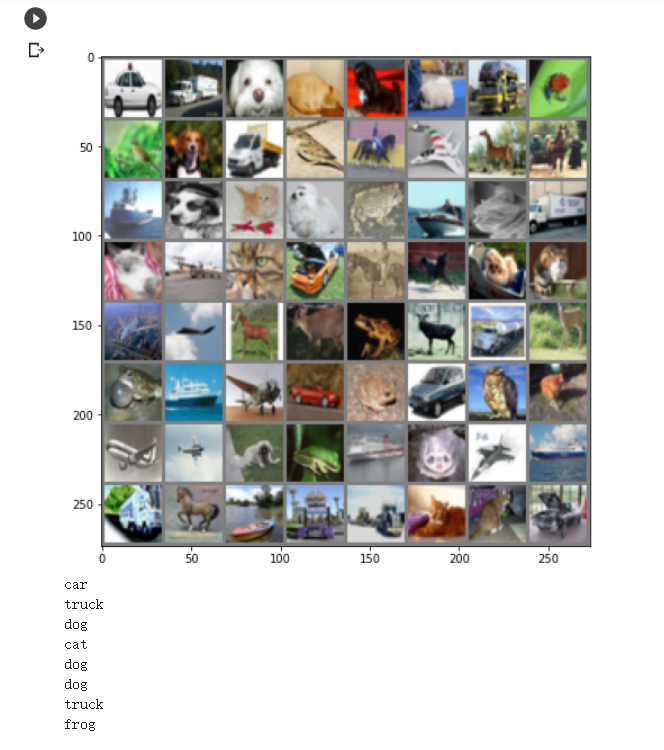

def imshow(img): plt.figure(figsize=(8,8)) img = img / 2 + 0.5 # 转换到 [0,1] 之间 npimg = img.numpy() plt.imshow(np.transpose(npimg, (1, 2, 0))) plt.show() # 得到一组图像 images, labels = iter(trainloader).next() # 展示图像 imshow(torchvision.utils.make_grid(images)) # 展示第一行图像的标签 for j in range(8): print(classes[labels[j]])

class Net(nn.Module): def __init__(self): super(Net, self).__init__() self.conv1 = nn.Conv2d(3, 6, 5) self.pool = nn.MaxPool2d(2, 2) self.conv2 = nn.Conv2d(6, 16, 5) self.fc1 = nn.Linear(16 * 5 * 5, 120) self.fc2 = nn.Linear(120, 84) self.fc3 = nn.Linear(84, 10) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = self.pool(F.relu(self.conv2(x))) x = x.view(-1, 16 * 5 * 5) x = F.relu(self.fc1(x)) x = F.relu(self.fc2(x)) x = self.fc3(x) return x # 网络放到GPU上 net = Net().to(device) criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(net.parameters(), lr=0.001)

for epoch in range(10): # 重复多轮训练 for i, (inputs, labels) in enumerate(trainloader): inputs = inputs.to(device) labels = labels.to(device) # 优化器梯度归零 optimizer.zero_grad() # 正向传播 + 反向传播 + 优化 outputs = net(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() # 输出统计信息 if i % 100 == 0: print('Epoch: %d Minibatch: %5d loss: %.3f' %(epoch + 1, i + 1, loss.item())) print('Finished Training')

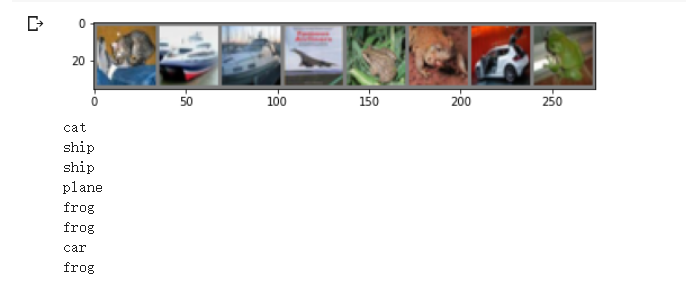

# 得到一组图像 images, labels = iter(testloader).next() # 展示图像 imshow(torchvision.utils.make_grid(images)) # 展示图像的标签 for j in range(8): print(classes[labels[j]])

outputs = net(images.to(device)) _, predicted = torch.max(outputs, 1) # 展示预测的结果 for j in range(8): print(classes[predicted[j]])

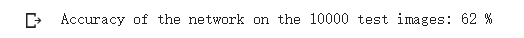

correct = 0 total = 0 for data in testloader: images, labels = data images, labels = images.to(device), labels.to(device) outputs = net(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item() print('Accuracy of the network on the 10000 test images: %d %%' % ( 100 * correct / total))

● 使用 VGG16 对 CIFAR10 分类

class VGG(nn.Module): def __int__(self): super(VGG, self).__init__() self.cfg = [64, 'M', 128, 'M', 256, 256, 'M', 512, 512, 'M', 512, 512, 'M'] self.features = self.make_layers(self.cfg) self.classifier = nn.Linear(512, 10) def forward(self, x): out = self.features(x) out = out.view(out.size(0), -1) out = self.classifier(out) return out def make_layers(self, cfg): layers = [] in_channels = 3 for x in cfg: if x == 'M': layers += [nn.MaxPool2d(kernel_size=2, stride=2)] else: layers += [nn.Conv2d(in_channels, x, kernel_size=3, padding=1), nn.BatchNorm2d(x), nn.ReLU(inplace=True)] in_channels = x layers += [nn.AvgPool2d(kernel_size=1, stride=1)] return nn.Sequential(*layers)

# 网络放到GPU上 net = VGG().to(device) criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(net.parameters(), lr=0.001)

correct = 0 total = 0 for data in testloader: images, labels = data images, labels = images.to(device), labels.to(device) outputs = net(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item() print('Accuracy of the network on the 10000 test images: %.2f %%' % ( 100 * correct / total))

![]()

由此可见从用VGG16可以将精度从62%提高到84.77%

使用VGG模型迁移学习进行猫狗大战

import numpy as np import matplotlib.pyplot as plt import os import torch import torch.nn as nn import torchvision from torchvision import models,transforms,datasets import time import json # 判断是否存在GPU设备 device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu") print('Using gpu: %s ' % torch.cuda.is_available())

normalize = transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) vgg_format = transforms.Compose([ transforms.CenterCrop(224), transforms.ToTensor(), normalize, ]) data_dir = './dogscats' dsets = {x: datasets.ImageFolder(os.path.join(data_dir, x), vgg_format) for x in ['train', 'valid']} dset_sizes = {x: len(dsets[x]) for x in ['train', 'valid']} dset_classes = dsets['train'].classes

loader_train = torch.utils.data.DataLoader(dsets['train'], batch_size=64, shuffle=True, num_workers=6) loader_valid = torch.utils.data.DataLoader(dsets['valid'], batch_size=5, shuffle=False, num_workers=6) ''' valid 数据一共有2000张图,每个batch是5张,因此,下面进行遍历一共会输出到 400 同时,把第一个 batch 保存到 inputs_try, labels_try,分别查看 ''' count = 1 for data in loader_valid: print(count, end='\n') if count == 1: inputs_try,labels_try = data count +=1 print(labels_try) print(inputs_try.shape)

# 显示图片的小程序 def imshow(inp, title=None): # Imshow for Tensor. inp = inp.numpy().transpose((1, 2, 0)) mean = np.array([0.485, 0.456, 0.406]) std = np.array([0.229, 0.224, 0.225]) inp = np.clip(std * inp + mean, 0,1) plt.imshow(inp) if title is not None: plt.title(title) plt.pause(0.001) # pause a bit so that plots are updated

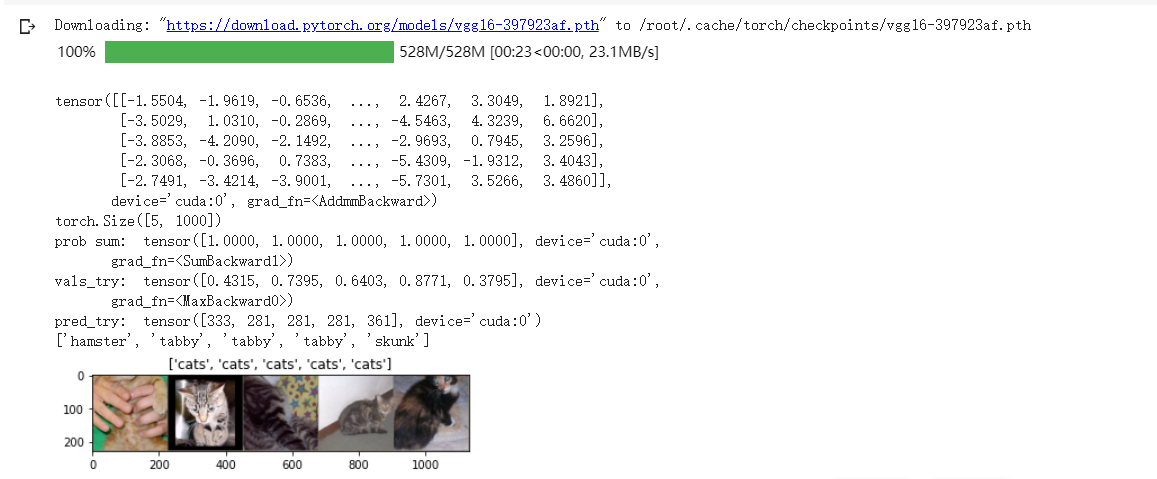

model_vgg = models.vgg16(pretrained=True) with open('./imagenet_class_index.json') as f: class_dict = json.load(f) dic_imagenet = [class_dict[str(i)][1] for i in range(len(class_dict))] inputs_try , labels_try = inputs_try.to(device), labels_try.to(device) model_vgg = model_vgg.to(device) outputs_try = model_vgg(inputs_try) print(outputs_try) print(outputs_try.shape) ''' 可以看到结果为5行,1000列的数据,每一列代表对每一种目标识别的结果。 但是我也可以观察到,结果非常奇葩,有负数,有正数, 为了将VGG网络输出的结果转化为对每一类的预测概率,我们把结果输入到 Softmax 函数 ''' m_softm = nn.Softmax(dim=1) probs = m_softm(outputs_try) vals_try,pred_try = torch.max(probs,dim=1) print( 'prob sum: ', torch.sum(probs,1)) print( 'vals_try: ', vals_try) print( 'pred_try: ', pred_try) print([dic_imagenet[i] for i in pred_try.data]) imshow(torchvision.utils.make_grid(inputs_try.data.cpu()), title=[dset_classes[x] for x in labels_try.data.cpu()])

''' 第一步:创建损失函数和优化器 损失函数 NLLLoss() 的 输入 是一个对数概率向量和一个目标标签. 它不会为我们计算对数概率,适合最后一层是log_softmax()的网络. ''' criterion = nn.NLLLoss() # 学习率 lr = 0.001 # 随机梯度下降 optimizer_vgg = torch.optim.SGD(model_vgg_new.classifier[6].parameters(),lr = lr) ''' 第二步:训练模型 ''' def train_model(model,dataloader,size,epochs=1,optimizer=None): model.train() for epoch in range(epochs): running_loss = 0.0 running_corrects = 0 count = 0 for inputs,classes in dataloader: inputs = inputs.to(device) classes = classes.to(device) outputs = model(inputs) loss = criterion(outputs,classes) optimizer = optimizer optimizer.zero_grad() loss.backward() optimizer.step() _,preds = torch.max(outputs.data,1) # statistics running_loss += loss.data.item() running_corrects += torch.sum(preds == classes.data) count += len(inputs) print('Training: No. ', count, ' process ... total: ', size) epoch_loss = running_loss / size epoch_acc = running_corrects.data.item() / size print('Loss: {:.4f} Acc: {:.4f}'.format( epoch_loss, epoch_acc)) # 模型训练 train_model(model_vgg_new,loader_train,size=dset_sizes['train'], epochs=1, optimizer=optimizer_vgg)

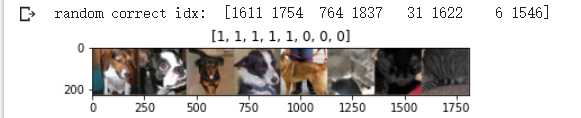

# 单次可视化显示的图片个数 n_view = 8 correct = np.where(predictions==all_classes)[0] from numpy.random import random, permutation idx = permutation(correct)[:n_view] print('random correct idx: ', idx) loader_correct = torch.utils.data.DataLoader([dsets['valid'][x] for x in idx], batch_size = n_view,shuffle=True) for data in loader_correct: inputs_cor,labels_cor = data # Make a grid from batch out = torchvision.utils.make_grid(inputs_cor) imshow(out, title=[l.item() for l in labels_cor])

GoogLeNet(从Inception V1 到 V4的演进)

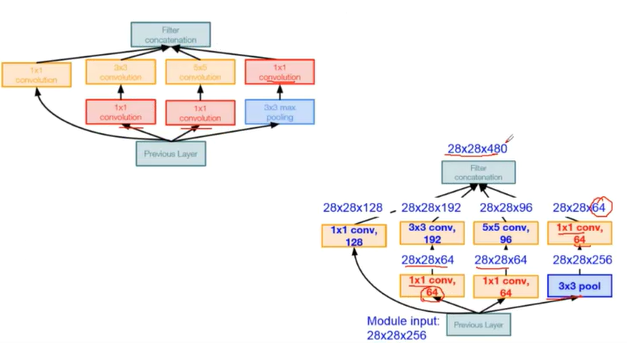

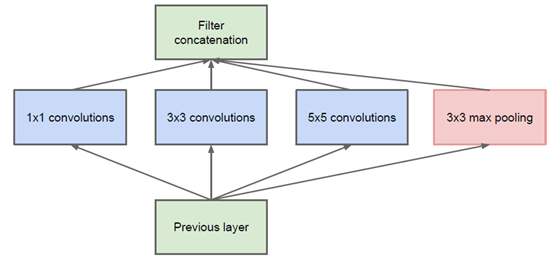

一、Inception V1

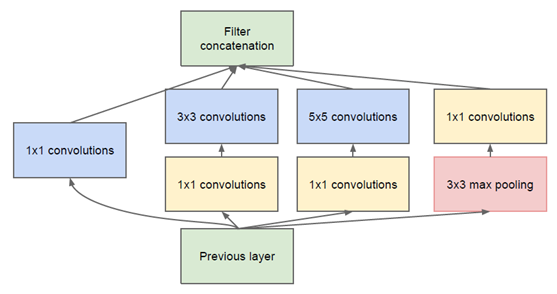

1、最原始Inception的基本结构

原始结构是将输入分别进行1x1卷积、3x3卷积、5x5卷积,3x3池化,然后将这4个结果在通道数目上拼接。通过多个卷积核提取图像不同尺度的信息,最后进行融合,可以得到图像更好的表征。每个卷积层后面都有非线性激活函数。

假设输入是(64,64,32),从左到右卷积核的数目分别是32、128、128,则最终结果是(64,64,32+128+128+32)。Inception结构没有改变输入特征图的大小,只改变了通道数目。卷积、池化都进行了padding来确保特征图大小一致。

对上述Inception结构进行改进:

添加了1×1卷积用来降维

Inception还使用global average pooling代替了全连接层。用GAP替代FC全连接层,有两个有点:一是GAP在特征图与最终的分类间转换更加简单自然;二是不像FC层需要大量训练调优的参数,降低了空间参数会使模型更加好,抗过拟合效果更佳。

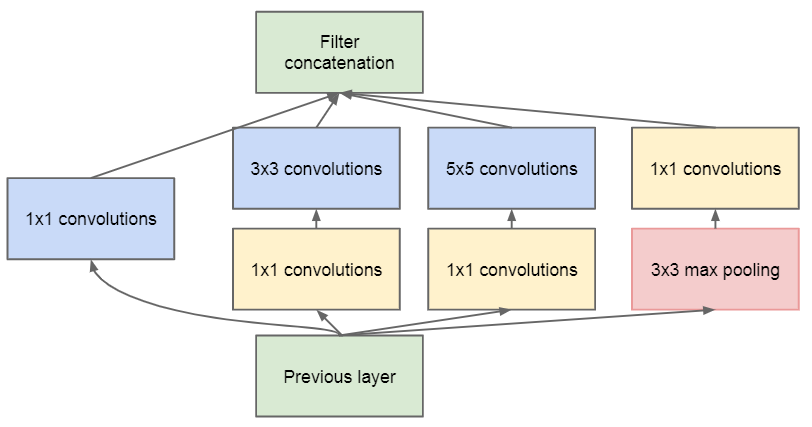

Inception v2

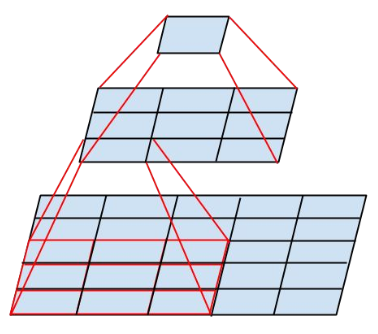

大尺寸的卷积核具有更大的感受野,同时也具有更多的参数。通过两个3×3 3×3的卷积代替5×5 5×5的大卷积,在感受野不变的情况下减少参数量。

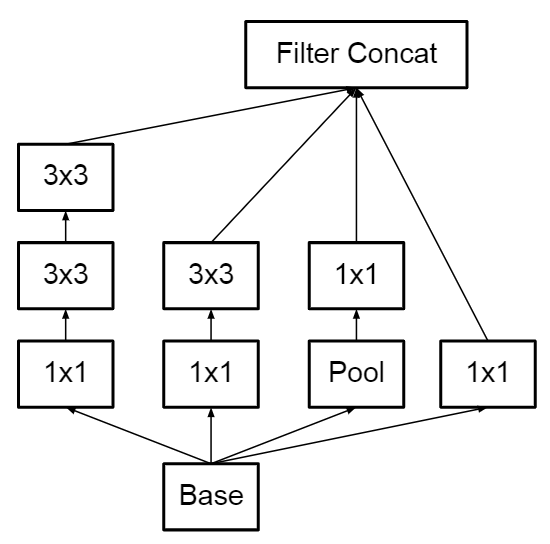

Inception v3

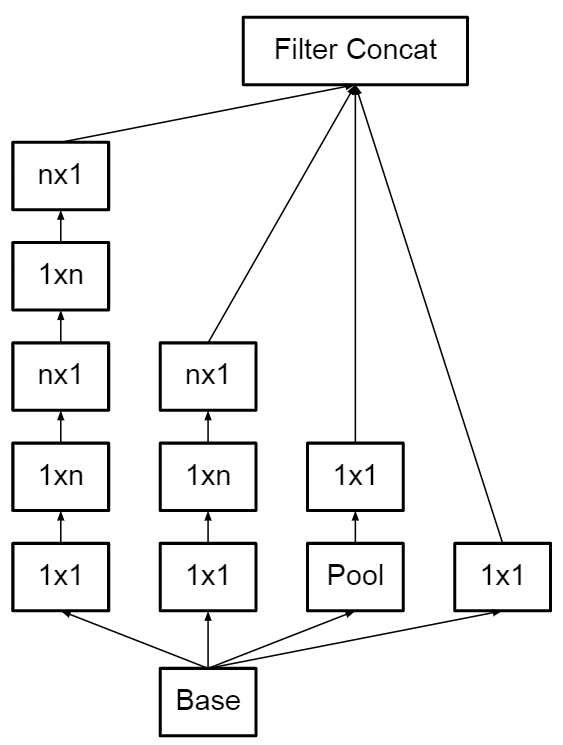

Inception V4 结构如图所示:

googLeNet Inception V4

引入了残差连接的方式。大大改善了梯度消失问题,大大加深了网络深度。还提升了训练速度和灵活性。

MobileNets

它将标准卷积分解为深度卷积和1x1的卷积,1x1的卷积称为点卷积

原来的计算复杂度模型为

其中DK×DKDK×DK为卷积核大小,MM为输入通道数,NN为输出通道数,DF×DFDF×DF为特征图大小

经过分解后的计算复杂模型为

这可以成倍降低模型计算复杂度

浙公网安备 33010602011771号

浙公网安备 33010602011771号