随笔分类 - 深度学习&机器学习&机器学习

摘要:# 正则化: **正则化:凡是能够减少泛化误差,而不是减少训练误差的方法就是正则化方法,也就是说能够减少过拟合的方法。** 在训练参数化机器学习模型时,权重衰减(weight decay)是广泛使用的正则化的技术之一,它通常也被 称为L2正则化。 # 权重衰减 在神经网络中我们有参数w和b,w是权重

阅读全文

posted @ 2023-08-09 11:18

lipu123

摘要:# 训练误差和泛化误差 - **训练误差:模型在训练数据上的误差** - **泛化误差:模型在新数据上的误差** 例子:根据摸考成绩来预测未来考试分数 - 在过去的考试中表现很好(训练误差)不代表未来考试一定会好(泛化误差) - 学生A通过背书在摸考中拿到很好成绩 - 学生B知道答案后面的原因 类似

阅读全文

posted @ 2023-08-06 16:34

lipu123

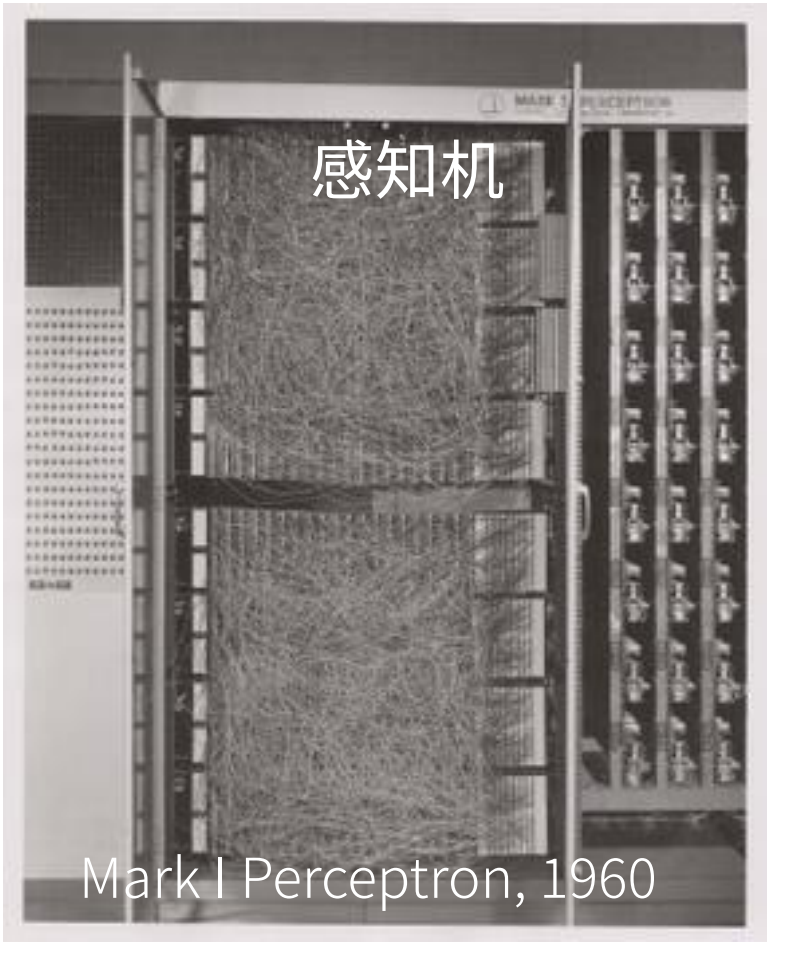

摘要:# 感知机 早期1960年的感知机,每一根线就是一个权重。  给定输入x,权重w,和偏移b,感知机输出:

阅读全文

posted @ 2023-08-05 22:26

lipu123

摘要:# 分类问题 ## 什么是分类问题 回归 vs 分类 ·回归估计一个连续值 ·分类预测一个离散类别 例如:

阅读全文

posted @ 2023-08-05 11:06

lipu123

摘要:# 线性回归 - 一个简化模型 假设1:影响房价的关键因素是卧室个数,卫生间个数和居住面积,记为$x_1,x_2,x_3$ 假设2:成交价是关键因素的加权和$y=w_1*x1+w_2*x_2+w_3*x_3+b$ ## 线性模型 - 给定n维输入 $x=[x_1,x_2,....x_n]^T$ -

阅读全文

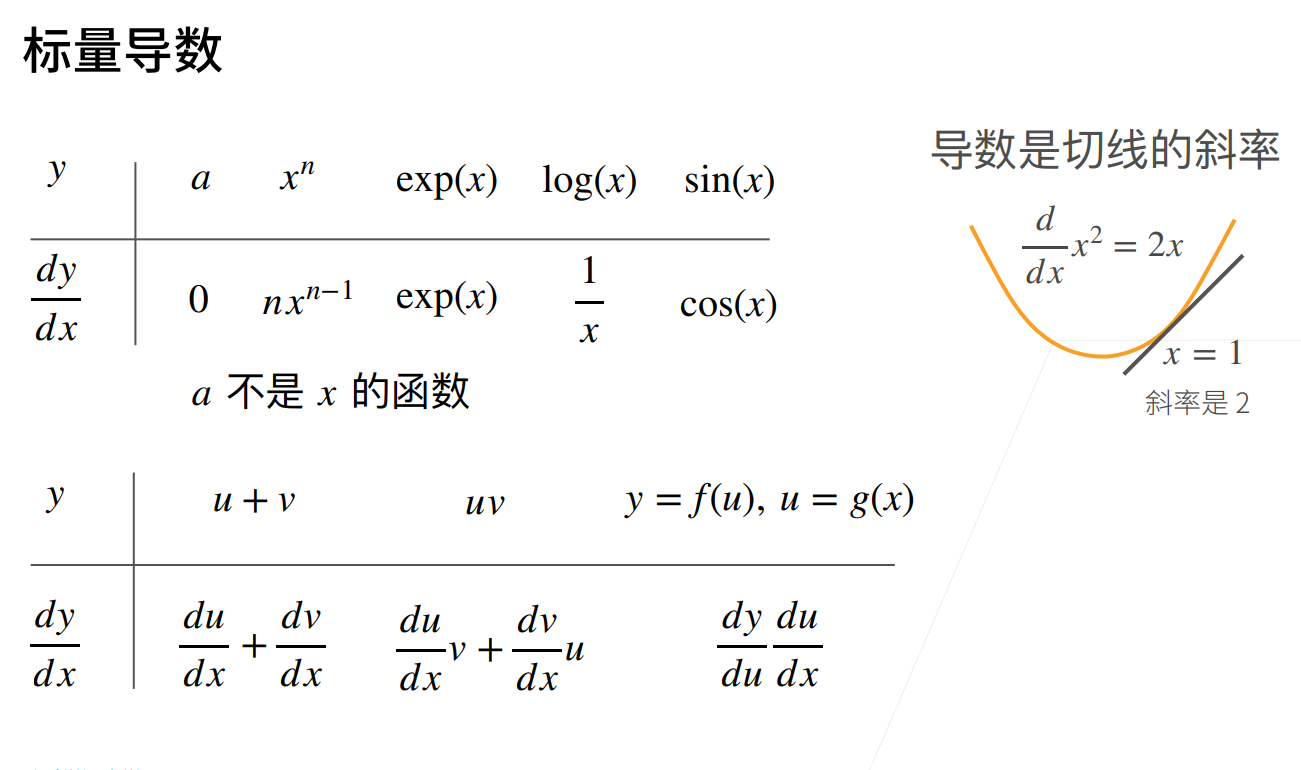

摘要:# 1 标量的导数  # 2 亚导数 比如说$y=|x|$这个函数在x=0的时候时不可导的。当x>0,其到

阅读全文

摘要:Tensor advanced operation ▪ Where ▪ Gather # where 返回的最终的tensor中的每一个值有可能来着A,也有可能来自B。 >torch.where(condition,A,B)->tensor 满足condition条件则该位置为A[..],否则为B[

阅读全文

摘要:statistics ▪ norm (范数) ▪ mean,sum (平均值,求和) ▪ prod (累乘) ▪ max, min, argmin, argmax ▪ kthvalue, topk(第k大) # norm(范式) 这里面有一范式和二范式。 一范式: $$||x||_1=\sum_k|

阅读全文

摘要:Math operation ▪ Add/minus/multiply/divide(加减乘除) ▪ Matmul(矩阵相乘) ▪ Pow(次方) ▪ Sqrt/rsqrt(次方根) ▪ Round() add/minus/multiply/divide 这个使用的时候可以直接使用运算符"+,-,*

阅读全文

posted @ 2023-07-31 14:50

lipu123

摘要:Merge or split ▪ Cat(合并) ▪ Stack(合并) ▪ Split(拆分) ▪ Chunk(拆分) # 合并 ## cat 这个就是合并两个tensor 比如说有两个班级的成绩单,一个是1-4班的,一个是5-9班的,我们现在需要合并这两份成绩单。 ▪ Statistics ab

阅读全文

摘要:Broadcasting是一种没有copy数据的expand Key idea: - 不过两个维度不相同,在前面插入维度1 - 扩张维度1到相同的维度 例如:Feature maps:[4,32,14,14] Bias:[32,1,1]=>[1,32,1,1]=>[4,32,14,14] A:[32

阅读全文

摘要:▪ View/reshape(这个是维度的变化) ▪ Squeeze/unsqueeze(维度的增加/减少) ▪ Transpose/t/permute(维度交换) ▪ Expand/repeat(维度的扩展) # view/reshape 这两个API,都是通用的a.reshape()和a.vie

阅读全文

摘要:# indexing ``` a=torch.randn(4,3,28,28) a[0].shape # torch.Size([3, 28, 28]) a[0,0].shape # torch.Size([28, 28]) a[0,0,2,4] # tensor(0.6574) ``` # sel

阅读全文

摘要:# Import from numpy >torch.from_numpy(data) ``` a=np.array([2,3.3]) a #array([2. , 3.3]) torch.from_numpy(a) #tensor([2.0000, 3.3000], dtype=torch.flo

阅读全文

摘要:python和pytorch中的类型对比: 我们可以发现pytorch中每中类型后面都有一个Tensor。 只接受数值型输入; * 而 NLP 里的词语,

阅读全文

摘要:本文将使用 Tensorflow 中包含的 Fashion MNIST 数据集。该数据集在训练集中包含 60,000 张灰度图像,在测试集中包含 10,000 张图像。 每张图片代表属于 10 个类别之一的单品(“T 恤/上衣”、“裤子”、“套头衫”等)。 因此这是一个多类分类问题。 首先我们需要安

阅读全文

摘要:# 1 贝叶斯优化的基本原理 贝叶斯优化方法是当前超参数优化领域的SOTA手段,可以被认为是当前最为先进的优化框架,它可以被应用于AutoML的各大领域,不止限于超参数搜索HPO的领域,更是可以被用于神经网络架构搜索NAS以及元学习等先进的领域。现代几乎所有在效率和效果上取得优异成果的超参数优化方法

阅读全文

摘要:# 1 枚举网格搜索(Exhaustive Grid Search) ## 1.1 基本原理 在所有超参数优化的算法当中,枚举网格搜索是最为基础和经典的方法。在搜索开始之前,我们需要人工将每个超参数的备选值一一列出,多个不同超参数的不同取值之间排列组合,最终将组成一个参数空间(parameter s

阅读全文

摘要:# 1 堆叠法Stacking ## 1.1 堆叠法的基本思想 堆叠法Stacking是近年来模型融合领域最为热门的方法,它不仅是竞赛冠军队最常采用的融合方法之一,也是工业中实际落地人工智能时会考虑的方案之一。作为强学习器的融合方法,Stacking集**模型效果好、可解释性强、适用复杂数据**三大

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号