2.安装Spark与Python练习

一、安装Spark

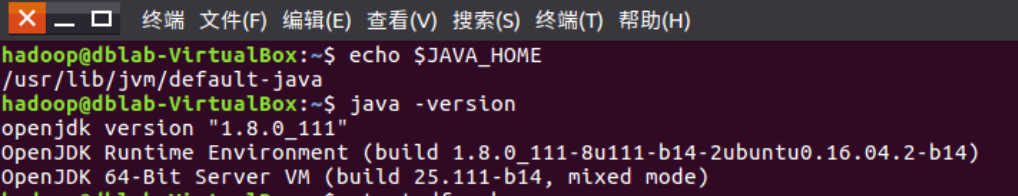

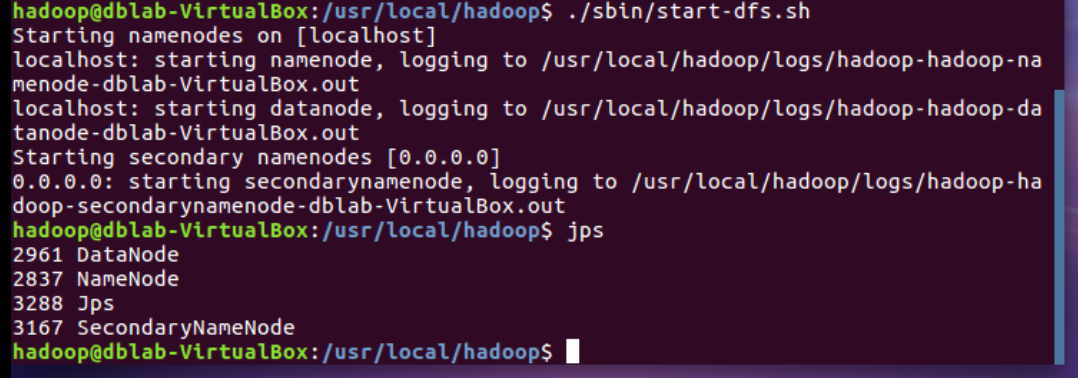

- 检查基础环境hadoop,jdk

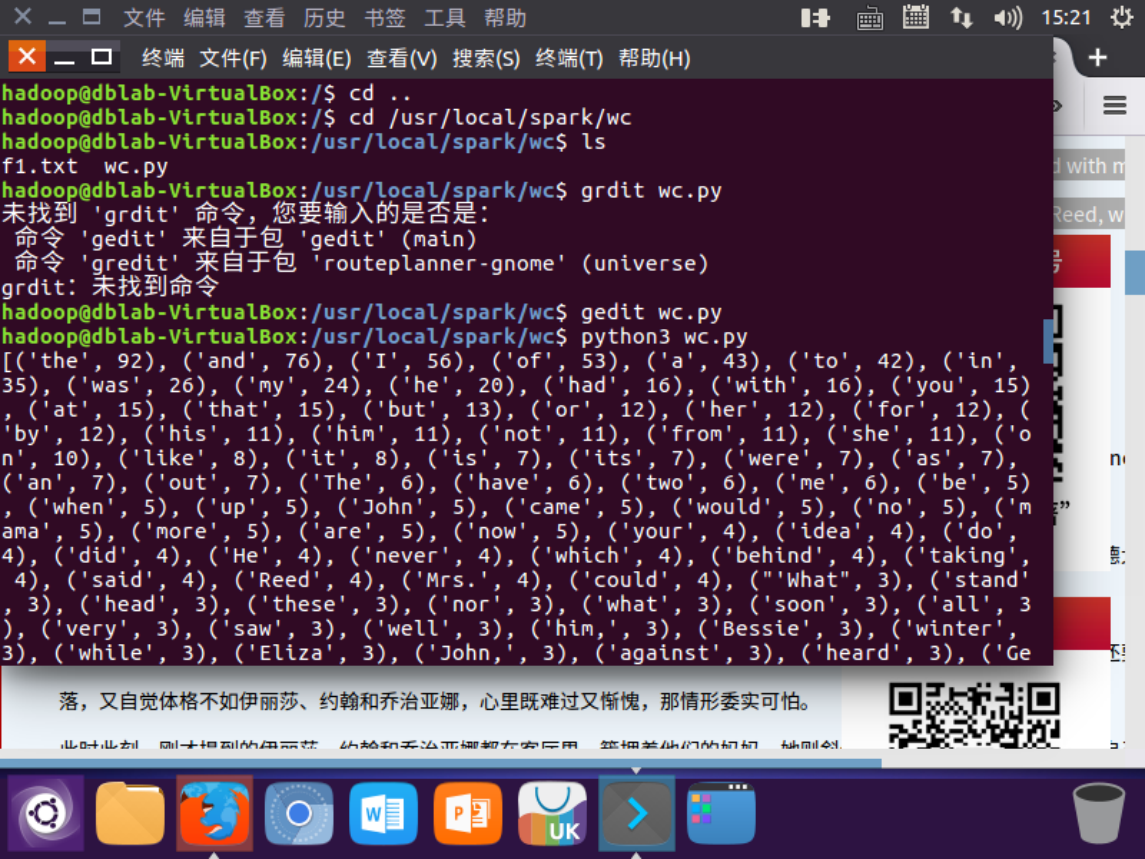

![]()

![]()

- 下载spark

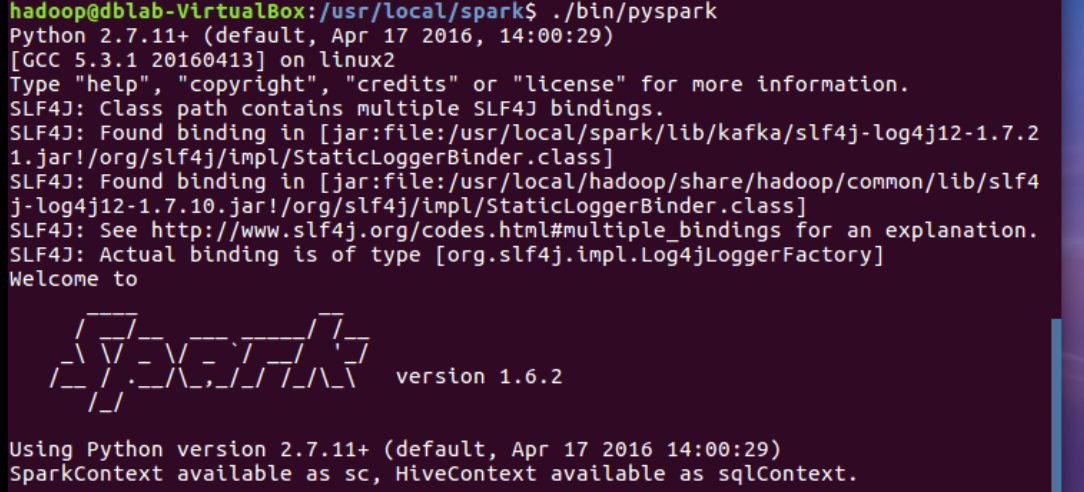

![]()

- 解压,文件夹重命名、权限(已安装没有图)

- 配置文件(已安装没有图)

- 环境变量(已安装没有图)

6.试运行Python代码

二、Python编程练习:英文文本的词频统计

思想

- 准备文本文件

- 读文件

- 预处理:大小写,标点符号,停用词

- 分词

- 统计每个单词出现的次数

- 按词频大小排序

- 结果写文件

1 path='/usr/local/spark/wc/f1.txt'

2 with open(path) as f:

3 text=f.read()

4 words = text.split()

5 wc={}

6 for word in words:

7 wc[word]=wc.get(word,0)+1

8 wclist=list(wc.items())

9 wclist.sort(key=lambda x:x[1],reverse=True)

10 print(wclist)

浙公网安备 33010602011771号

浙公网安备 33010602011771号