![]()

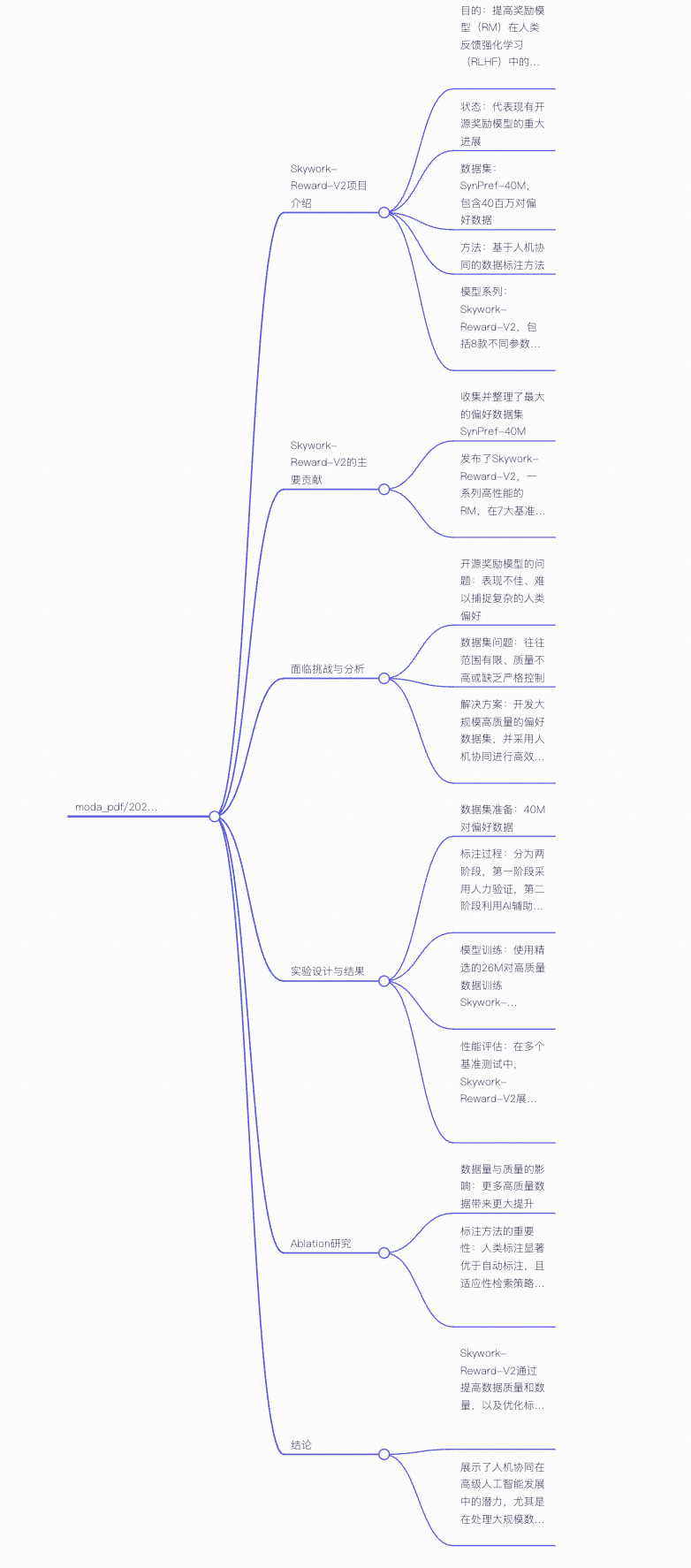

在强化学习从人类反馈(RLHF)中,奖励模型(RMs)至关重要,它决定了模型对人类偏好的捕捉和对齐程度。但当下最先进的开源奖励模型,在多数现有评估基准上表现欠佳,难以有效捕捉人类偏好中细微、复杂的部分。即便运用先进训练技术,性能提升也不明显。经分析,问题主要源于偏好数据集的局限性,像覆盖范围狭窄、标签合成方式机械、缺乏严格质量控制等。例如,很多现有数据集仅聚焦特定类型任务或对话,面对多维度、多层次反馈时能力有限,还容易在特定基准任务上过拟合,泛化到新任务或场景时表现不佳。

- 构建流程:创建了名为 SynPref-40M 的大规模偏好数据集,包含 4000 万对偏好对。采用两阶段数据策划流程。

- 第一阶段:人类引导的小规模高质量偏好构建:先构建未经验证的初始偏好池,借助大语言模型(LLM)生成与偏好相关的辅助属性,如任务类型、客观性、争议性等。人工标注者依据严格验证协议,借助外部工具与先进大语言模型,对部分数据精细审核,构建出小规模高质量 “金标准” 数据集,作为后续数据生成与模型评估依据。随后,以金标准数据偏好标签为引导,结合 LLM 大规模生成高质量 “银标准” 数据实现数据量扩展。此过程中还进行多轮迭代优化,每一轮训练奖励模型,依据其在金标准数据上的表现识别薄弱环节,检索相似样本利用多模型一致性机制自动标注,进一步扩展和增强银标准数据,有效提升奖励模型对偏好的理解与判别能力。比如,标注员在标注时会依据详细的任务类别、客观性和争议性等指标,就像在判断一道菜时,要考虑它属于什么菜系、口味是否有明确标准、不同人对其接受度差异等。

- 第二阶段:全自动大规模偏好数据扩展:获得初步高质量模型后,此阶段转向自动化大规模数据扩展,不再依赖人工审核。采用训练完成的奖励模型执行一致性过滤,若某个样本标签与当前最优模型预测不一致,或模型置信度较低,则调用 LLM 重新自动标注;若样本标签与 “金模型”(仅使用人工数据训练的模型)预测一致,且获得当前模型或 LLM 支持,则可直接通过筛选。通过该机制从原始 4000 万样本中筛选出 2600 万条精选数据,极大减少人工标注负担,实现偏好数据规模与质量的良好平衡。

- 数据集特点:该数据集在覆盖多维度偏好方面优势显著,为后续模型训练提供丰富、高质量数据支撑,是模型性能提升的重要基础。

基于 Llama3 和 Qwen3 系列等不同基础模型,训练 8 个参数规模从 0.6B 至 8B 的奖励模型,不同规模模型可满足不同场景和需求,构建起不同能力层次的模型梯队。

- Bradley - Terry 方法:采用经典的 Bradley-Terry 方法,通过大量 “A 比 B 好” 的比较数据,让模型学会给不同质量回答打分,处理比较和排序问题,以此训练模型对偏好的判断能力。

- 参数调整:在训练过程中,针对不同模型规模精细调整学习率、批次大小等关键参数。例如,对于较小规模模型,适当降低学习率,防止模型在训练中过快收敛到局部最优解;对于较大规模模型,可适当增大批次大小,利用更多数据信息加速模型收敛,提高训练效率和效果。

- 评估基准:基于七个主流奖励模型基准进行评估,包括 RewardBench v1/v2、PPE Preference & Correctness、RMB、RM - Bench、JudgeBench 等,这些基准从不同维度、场景全面评估模型性能。

- 对比模型:与多个顶尖开源奖励模型、生成式奖励模型以及闭源模型(如 OpenAI 的 o 系列模型)等进行对比,充分验证 Skywork - Reward - V2 系列模型的优势。

- 基准测试表现:Skywork - Reward - V2 系列模型在七个主流奖励模型基准上全面超越其他模型,取得开源奖励模型最佳成绩。例如,在通用偏好评估基准(如 RewardBench)上,优于多个参数更大的模型(如 70B)及最新的生成型奖励模型;在客观正确性评估方面(如 JudgeBench 和 PPE Correctness),虽整体略逊少数专注推理与编程的闭源模型(如 OpenAI 的 o 系列),但在知识密集型任务中表现突出,超越所有其他开源模型。

- 多维度能力评测:在符合人类偏好、客观正确性、安全性、抗风格偏差及 Best - of - N 扩展能力等多维度能力评测中表现优异。在 Best - of - N 评测中,在帮助性和无害性指标上优于 GPT - 4o 等强基线;在 JudgeBench 上,知识类任务显著领先顶尖推理模型;在抵抗风格偏差的 RM - Bench 测试中也有出色表现,展现模型良好泛化能力与实用性。

- 消融实验结果:通过数据消融实验和方法消融实验,验证性能提升不仅源于数据规模,更依赖高质量的人工与 AI 协同策划。证明人类注释、LLM 指导注释及严格注释协议对模型性能提升的关键作用。例如,去除多模型一致性机制后,模型性能明显下降,表明该机制在提升数据质量和模型性能方面不可或缺。

构建大规模高质量偏好数据集 SynPref - 40M,创新的人机协同两阶段数据策划管线,提升数据规模同时保证质量,为奖励模型训练提供全新优质数据资源。

训练出性能优异的 Skywork - Reward - V2 系列奖励模型,在多个主流基准测试中全面领先,为开源奖励模型发展树立新标杆,展示通过优化数据和训练策略可显著提升模型性能。

提出的人机协同数据处理方法,充分发挥人类和 AI 优势,为其他相关领域数据处理和模型训练提供新思路和方法借鉴。

- 模型规模仍相对有限,限制模型在某些复杂任务和大规模数据处理上的性能进一步提升。

- 自动化阶段虽高效,但可能遗漏部分复杂人类偏好,对极端情况或特殊场景偏好捕捉不够完善。

- 利用更大规模模型,进一步提升模型性能和泛化能力,探索更高效模型架构和训练算法,优化模型对复杂偏好的理解和判断。

- 深入研究人类偏好本质,探索更精细偏好标签体系,结合多模态数据(如语音、图像等)进行多模态偏好建模,提升模型对人类偏好理解的全面性和准确性。

- 改进自动化策划阶段,引入更先进技术和策略,增强对复杂、特殊偏好的覆盖度和捕捉能力,提高数据筛选质量和效率 。

附录:

https://arxiv.org/pdf/2507.01352

![image]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号