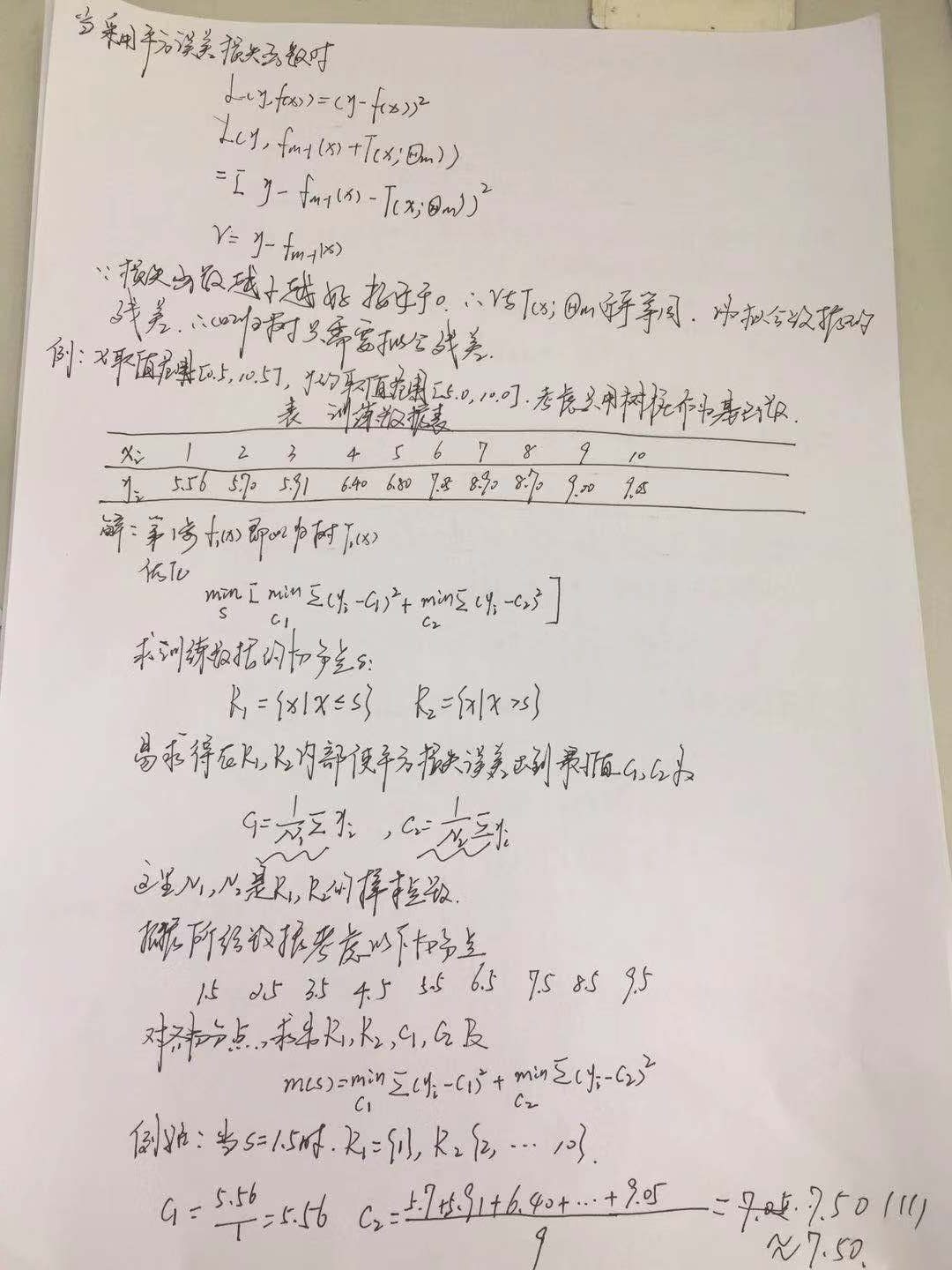

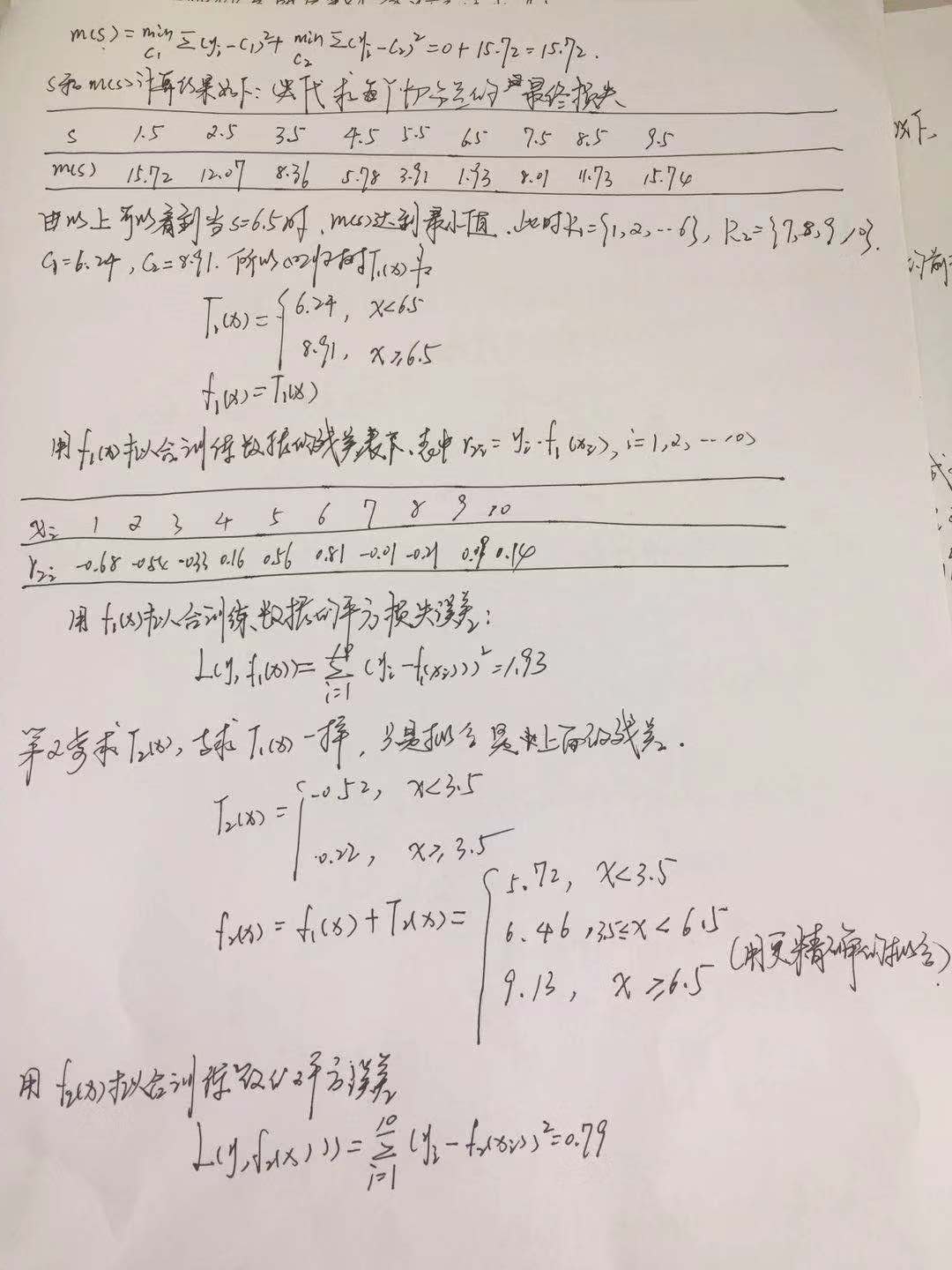

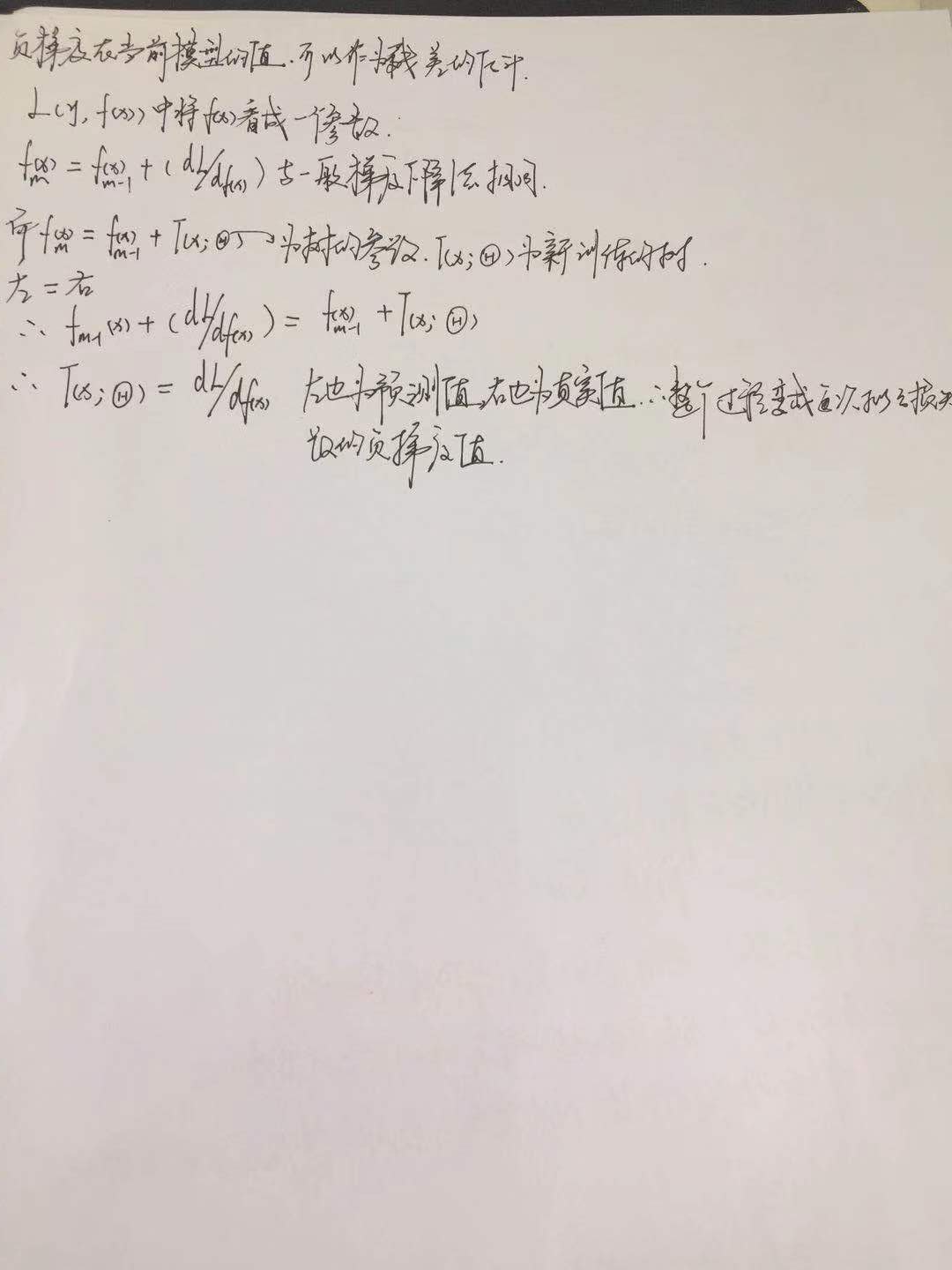

gbdt在回归方面的基本原理以及实例并且可以做分类

对书法的热爱,和编译器打数学公式很艰难,就这样的正例自己学过的东西,明天更新gbdt在分类方面的应用。

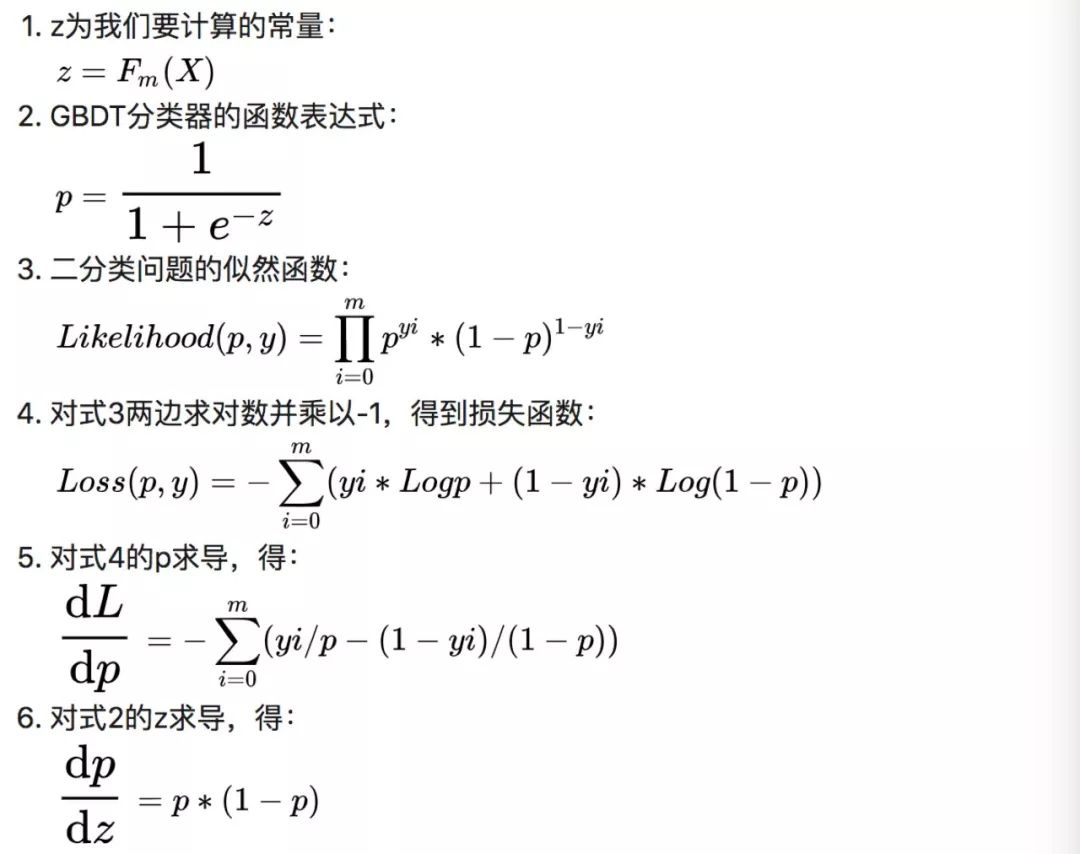

结论,如果要用一个常量来预测y,用log(sum(y)/sum(1-y))是一个最佳的选择。

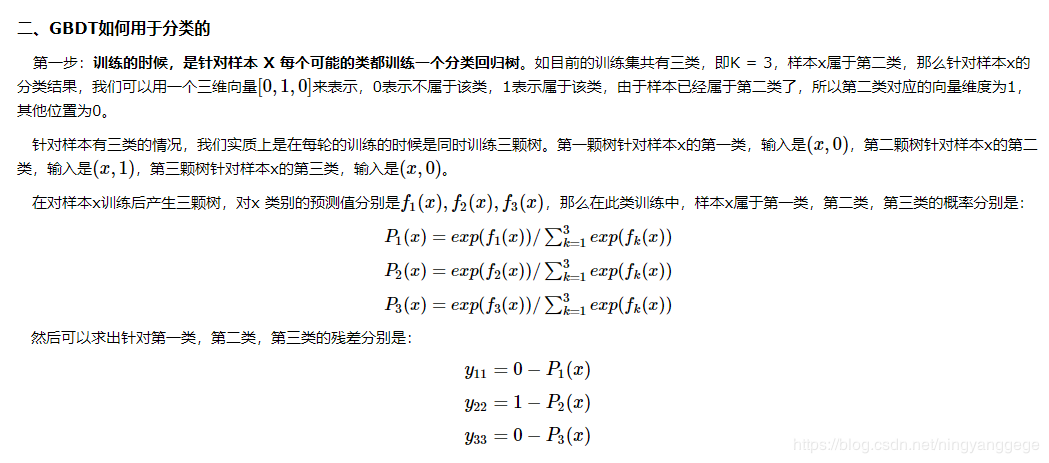

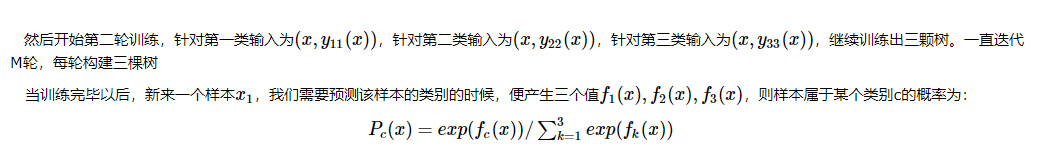

本人理解:多分类变成多个二分类,比如说当前类别A,训练集的标签为属于A的为1,其他为0,该值为连续值(概率),基于这所有的样本生成一棵树;结果为对类别A的预测值f(x);然后B标签,C标签同理可得;然后通过softmax层处理下得到属于各个类别的概率值;这里每一轮迭代都会和类别数目相同的树;每一棵树针对一个类别进行学习并输出对应的分数,然后就n个类别的分数,经过softmax层变成概率值;

本文来自博客园,作者:limingqi,转载请注明原文链接:https://www.cnblogs.com/limingqi/p/11726869.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号