中文词频统计与词云生成

作业要求来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2822

1. 下载一长篇中文小说。

2. 从文件读取待分析文本。

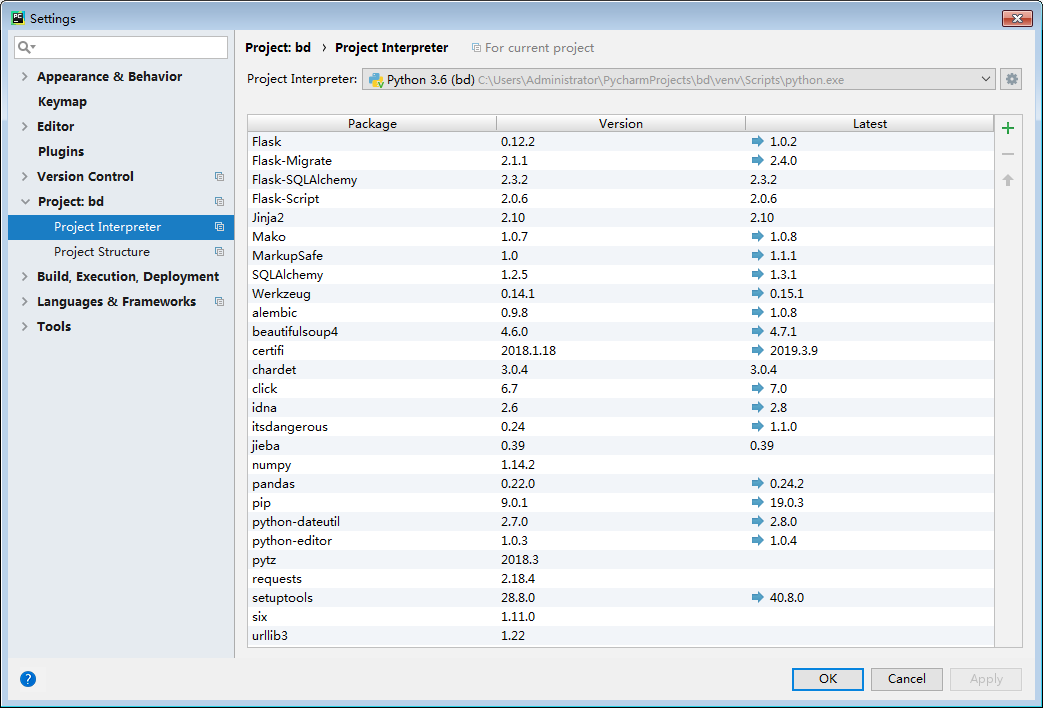

3. 安装并使用jieba进行中文分词。

pip install jieba

import jieba

jieba.lcut(text)

4. 更新词库,加入所分析对象的专业词汇。

jieba.add_word('天罡北斗阵') #逐个添加

jieba.load_userdict(word_dict) #词库文本文件

参考词库下载地址:https://pinyin.sogou.com/dict/

转换代码:scel_to_text

jieba.add_word('梁秋')

jieba.add_word('黄同')

jieba.add_word('白白')

jieba.add_word('苏小礼')

jieba.add_word('黄纯')

5. 生成词频统计

wordSet=set(words)

for w in wordSet:

if len(w)>1:

wordDict[w] = words.count(w)

6. 排序

wordList = list(wordDict.items()) wordList.sort(key=lambda x: x[1], reverse=True)

7. 排除语法型词汇,代词、冠词、连词等停用词。

ci=['我们','你们','他们','自己','没有','什么','可是','先生'] for c in ci: txt = txt.replace(c, "")

8. 输出词频最大TOP20,把结果存放到文件里

for i in range(20):

print(wordList[i])

9. 生成词云。

浙公网安备 33010602011771号

浙公网安备 33010602011771号