[OpenCV] 线性 / 非线性 滤波核心api函数

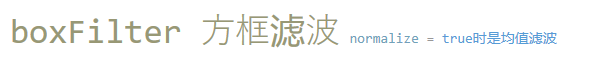

CV_EXPORTS_W void boxFilter( InputArray src, OutputArray dst, int ddepth, Size ksize, Point anchor = Point(-1,-1), bool normalize = true, int borderType = BORDER_DEFAULT ); 第一个参数,InputArray类型的src,输入图像,即源图像,填Mat类的对象即可。该函数对通道是独立处理的,且可以处理任意通道数的图片。但需要注意,待处理的图片深度应该是CV_8U、CV_16U、CV_16S、CV_32F、CV_64F之一。 第二个参数:OutputArray类型的dst,即目标图像,需要和源图片有一样的尺寸和类型。 第三个参数:int类型的ddepth,输出图像的深度““-1“代表使用原图深度,即src.depth()。 第四个参数,Size类型的ksize,内核的大小。一般用Size(wh)的写法来表示内核的大小(其中,w为像素宽度,h为像素高度)。例如,Size(3,3)表示3x3的核大小;Size(5,5)就表示5x5的核大小。 第五个参数:Point类型的anchor,表示锚点(即被平滑的那个点),注意它有默认值Point(-1,-1)。如果这个点坐标是负值的话,就表示取核的中心为锚点,所以默认值Point(-1,-1)表示这个锚点在核的中心。 第六个参数:bool类型的normalize,默认值为true,一个标识符,表示内核是哲被其区域归一化(normalized)了。 第七个参数:int类型的borderType,用于推断图像外部像素的某种边界模式。有默认值BORDER_DEFAULT,我们一般不去管它。

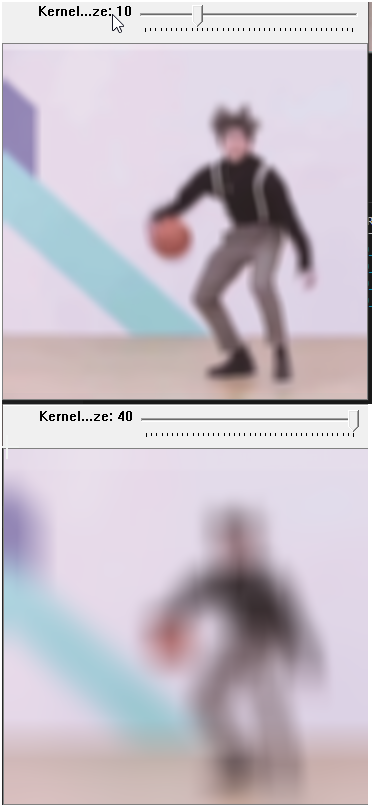

CV_EXPORTS_W void blur( InputArray src, OutputArray dst, Size ksize, Point anchor = Point(-1,-1), int borderType = BORDER_DEFAULT ); 第一个参数,InputArray类型的src,输入图像,即源图像,填Mat类的对象即可。该函数对通道是独立处理的,且可以处理任意通道数的图片。但需要注意,待处理的图片深度应该为CV_8U、CV_16U、CV_16S、CV_32F、CV_64F之一。 第二个参数:OutputArray类型的dst,即目标图像,需要和源图片有一样的尺寸和类型。比如可以用Mat::Clone,以源图片为模板,来初始化得到如假包换的目标图。 第三个参数:Size类型(对Size类型稍后有讲解)的ksize,内核的大小。一般用Size(wh)的写法来表示内核的大小(其中w为像素宽度,h为像素高度)。例如,Size(3,3)表示3x3的核大小,Size(5,5)就表示5x5的核大小。第四个参数:Point类型的anchor,表示锚点(即被平滑的那个点),注意它有默认值Point(-1,-1)。如果这个点坐标是负值的话,就表示取核的中心为锚点,所以默认值Point(-1,-1)表示这个锚点在核的中心。 第五个参数:int类型的borderType,用于推断图像外部像素的某种边界模式。有默认值BORDER_DEFAULT,我们一般不去管它。

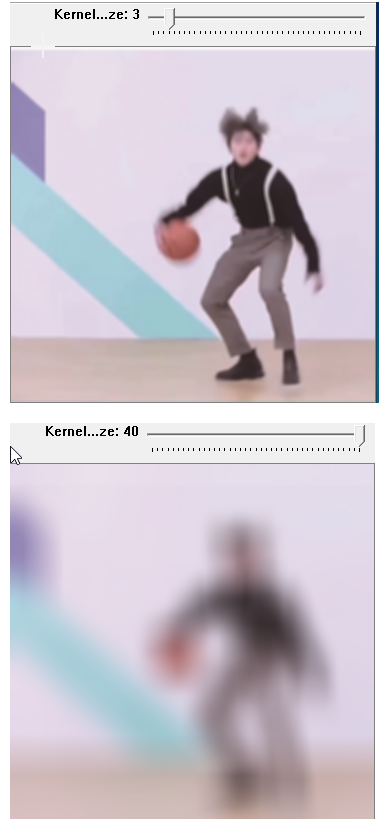

CV_EXPORTS_W void GaussianBlur( InputArray src, OutputArray dst, Size ksize, double sigmaX, double sigmaY = 0, int borderType = BORDER_DEFAULT ); 第一个参数:InputArray类型的src,输入图像,即源图像,填Mat类的对象即可。它可以是单独的任意通道数的图片。但需要注意,图片深度应该为CV_8U、CV_16U、CV_168S、CV_32F、CV_64F之一。 第二个参数:OutputArray类型的dst,即目标图像,需要和源图片有一样的尺寸和类型。比如可以用Mat::Clone,以源图片为模板,来初始化得到如假包换的目标图。 第三个参数:Size类型的ksize高斯内核的大小。其中ksize.width和ksize.height可以不同,但它们都必须为正数和奇数,也可以为零。它们都是由sigma计算而来的。 第四个参数:double类型的sigmaX,表示高斯核函数在X方向的的标准偏差。 五个参数:double类型的sigmaY,表示高斯核函数在Y方向的的标准偏差。若sigmaY为零,就将它设为sigmaX,如果sigmaX和sigmaY都是0,那么就由ksize.width和ksize.height计算出来。为了结果的正确性着想,最好是把第三个参数Size、第四个参数sigmaX和第五个参数sigmaY全部指定到。 第六个参数:int类型的borderType,用于推断图像外部像素的某种边界模式。注意它有默认值BORDER_DEFAULT。

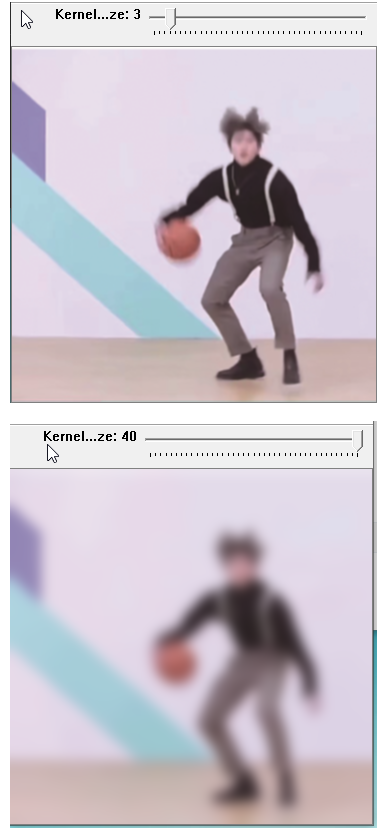

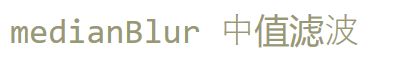

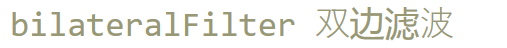

CV_EXPORTS_W void medianBlur( InputArray src, OutputArray dst, int ksize ); 第一个参数,InputArray类型的sre,函数的输入参数,填1、3或者4通道的Mat类型的图像。当ksize为3或者5的时候,图像深度需为CV_8U、CV_16U、CV_32F其中之一,而对于较大孔径尺寸的图片,它只能是CV_8U。 第二个参数:OutputArray类型的dst,即目标图像,函数的输出参数,需要和源图片有一样的尺寸和类型。我们可以用Mat::Clone,以源图片为模板,来初始化得到如假包换的目标图。 第三个参数:int类型的ksize,孔径的线性尺寸(aperturelinearsize),注意这个参数必须是大于1的奇数,比如:3、5、7、9......

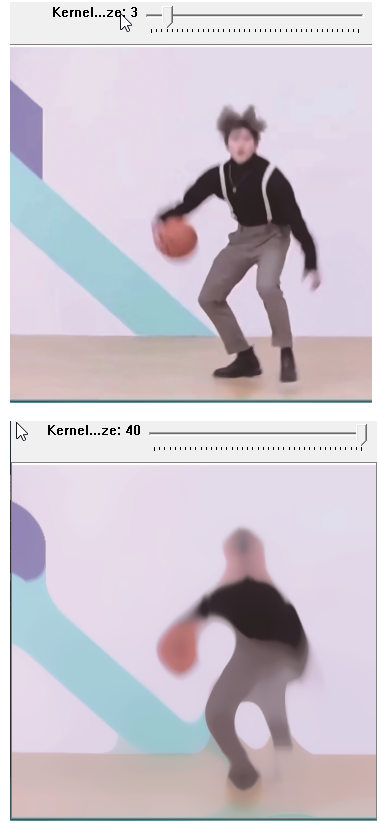

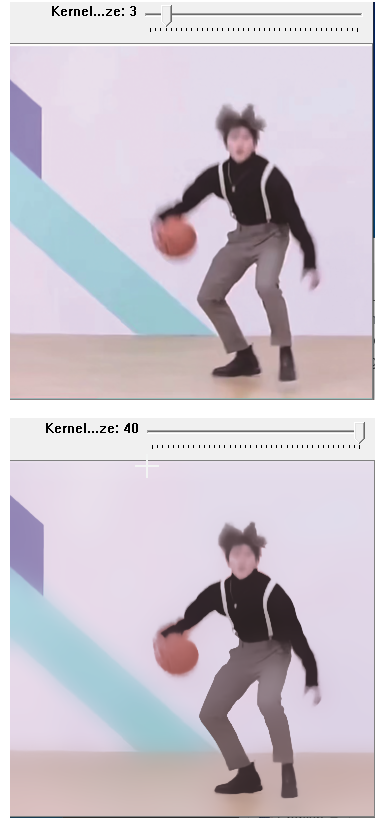

CV_EXPORTS_W void bilateralFilter( InputArray src, OutputArray dst, int d, double sigmaColor, double sigmaSpace, int borderType = BORDER_DEFAULT ); 第一个参数,InputArray类型的src,输入图像,即源图像,需要为8位或者浮点型单通道、三通道的图像。 第二个参数:OutputArray类型的dst,即目标图像,需要和源图片有一样的尺寸和类型。 第三个参数:int类型的d,表示在过滤过程中每个像素邻域的直径。如果这个值被设为非正数,那么OpenCV会从第五个参数sigmaSpace来计算出它。 第四个参数:double类型的sigmaColor,颜色空间滤波器的sigma值。这个参数的值越大,就表明该像素邻域内有越宽广的颜色会被混合到一起,产生较大的半相等颜色区域。 第五个参数:double类型的sigmaSpace,坐标空间中滤波器的sigma值,坐标空间的标注方差。它的数值越大,意味着越远的像素会相互影响,从而使更大的区域中足够相似的颜色获取相同的颜色。当d>0时,d指定了邻域大小且与sigmaSpace无关。否则,d正比于sigmaSpace。 第六个参数:int类型的borderType,用于推断图像外部像素的某种边界模式。注意它有默认值BORDER_DEFAULT。

code block:

#include "opencv2/opencv.hpp" #include <iostream> using namespace cv; using namespace std; #define MAX_KERNEL_SIZE 40 Mat g_srcImage, g_dstImage1 ,g_dstImage2, g_dstImage3,g_dstImage4,g_dstImage5; int g_nBoxfilterValue = 3; int g_nBlurValue = 3; int g_nGaussianBlurValue =3 ; int g_medianBlurValue = 3; int g_bliateralFilterValue = 3; string boxFilter_window = "Box Filter"; string blurFilter_window = "Blur Filter"; string GaussianBlur_window = "Gaussian Filter"; string scrollbar_title = "Kernel size"; string medianBlur_window = "Median Blur"; string bilateralFilter_window = "Bialteral Filter" ; static void callback_boxfilter(int ,void *); static void callback_blur(int ,void *); static void callback_GaussianBlur(int ,void *); static void callback_medianBlur(int,void *); static void callback_BialteralFilter(int, void *); int main( ) { string pic_path = "pathname"; string src_window = "Source Pic"; g_srcImage = imread(pic_path,1); if(!g_srcImage.data) { cout << "No data in this picture" << endl;return 0;} g_dstImage1 = g_srcImage.clone(); g_dstImage2 = g_srcImage.clone(); g_dstImage3 = g_srcImage.clone(); g_dstImage4 = g_srcImage.clone(); g_dstImage5 = g_srcImage.clone(); /*show src picture*/ namedWindow(src_window,1); imshow(src_window,g_srcImage); //box filter namedWindow(boxFilter_window,1); createTrackbar(scrollbar_title,boxFilter_window,&g_nBoxfilterValue,MAX_KERNEL_SIZE,callback_boxfilter); callback_boxfilter(g_nBoxfilterValue,0); imshow(boxFilter_window,g_dstImage1); //Blur filter namedWindow(blurFilter_window,1); createTrackbar(scrollbar_title,blurFilter_window,&g_nBlurValue,MAX_KERNEL_SIZE,callback_blur); callback_blur(g_nBlurValue,0); imshow(blurFilter_window,g_dstImage2); //Guassian filter namedWindow(GaussianBlur_window,1); createTrackbar(scrollbar_title,GaussianBlur_window,&g_nGaussianBlurValue,MAX_KERNEL_SIZE,callback_GaussianBlur); callback_GaussianBlur(g_nGaussianBlurValue,0); imshow(GaussianBlur_window,g_dstImage3); //median blur namedWindow(medianBlur_window,1); createTrackbar(scrollbar_title,medianBlur_window,&g_medianBlurValue,MAX_KERNEL_SIZE,callback_medianBlur); callback_medianBlur(g_medianBlurValue,0); imshow(medianBlur_window,g_dstImage4); //bilateralFilter namedWindow(bilateralFilter_window,1); createTrackbar(scrollbar_title,bilateralFilter_window,&g_bliateralFilterValue,MAX_KERNEL_SIZE,callback_BialteralFilter); callback_BialteralFilter(g_bliateralFilterValue,0); imshow(bilateralFilter_window,g_dstImage5); while(char(waitKey(1)) != 'q') {} return 0; } static void callback_boxfilter(int ,void *){ boxFilter(g_srcImage,g_dstImage1,-1,Size(g_nBoxfilterValue+1,g_nBoxfilterValue+1)); imshow(boxFilter_window,g_dstImage1); } static void callback_blur(int ,void *){ blur(g_srcImage,g_dstImage2,Size(g_nBlurValue+1,g_nBlurValue+1)); imshow(blurFilter_window,g_dstImage2); } static void callback_GaussianBlur(int ,void *){ g_nGaussianBlurValue = g_nGaussianBlurValue &-1 ; if(g_nGaussianBlurValue>40) {g_nGaussianBlurValue -=2;} //cout << g_nGaussianBlurValue <<endl; if(g_nGaussianBlurValue%2 == 1){GaussianBlur(g_srcImage,g_dstImage3,Size(g_nGaussianBlurValue,g_nGaussianBlurValue),0,0);} imshow(GaussianBlur_window,g_dstImage3); } static void callback_medianBlur(int,void *){ g_medianBlurValue = g_medianBlurValue &-1 ; if(g_medianBlurValue>40) {g_medianBlurValue -=2;} if(g_medianBlurValue%2 == 1) medianBlur(g_srcImage,g_dstImage4,g_medianBlurValue); imshow(medianBlur_window,g_dstImage4); } static void callback_BialteralFilter(int , void *){ bilateralFilter(g_srcImage,g_dstImage5,g_bliateralFilterValue,g_bliateralFilterValue*2,g_bliateralFilterValue/2); imshow(bilateralFilter_window,g_dstImage5); }

浙公网安备 33010602011771号

浙公网安备 33010602011771号