待学习的问题

Twemproxy

cdn

zabbix 二次开发

iptables

nosql ssdb

阿里云

keepalived

php

nginx

top

网络 路由知识等

DNS

搭建DNS服务器 就不用每个人配置hosts

chroot

防火墙

netstat -anp |grep listen 的用法

telnet

抓包

网络

ossfs

shell的原理问题

inotify原理

rsync原理

ftp原理

两台服务器之间进行大文件同步Linux 软件

Linux系统部分和网络部分要玩的好

cdn与nginx 可以去阿里云的官方资料学习到很多知识

阿里云

nginx + lua开发

面向站长和网站管理员的Web缓存加速指南

DNS的攻击与防护

DNS的攻击与防护

DDOS攻击

DNS做负载

redis

hash算法,函数,一致性hash

阿里云oss与机器硬盘的区别(读写IO等性能)

隧道技术

数据链路层

CIDR block

VPN

NAT网关

VNC 技术

openssl加密

RESTful API接口

回源

大的问题:

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

1:需求:两台服务器之间实现线上数据实时同步,数据文件比较大

想到的方案: 1)使用rsync+inotify进行实时同步,刚开始的时候不能进行同步,因为只有文件改变了才会进行同步,那么最开始的已有的那一大份数据就只有拷贝或rsync权利,在这拷贝的过程中又不断的有新数据产生,怎么保证数据实时同步呢

在传输的过程中文件由于各种原因损坏如何解决,综合考虑可靠性不高 2)使用lsyncd,传输速率是挺快,但是数据文件的完整性不能保证

未来的方案:自己开发,但是现在自己这水平也知道,短时间不能弄出来,长时间也不一定能,但是还是会当做一个项目去做,但这都是异想天开的想法了。

现实需要解决的问题: 那么,有没有其他的方案供参考呢,在网上看了很多资料,基本上是rsync+inotify,不想用这种,线上数据是要用的,不能开玩笑的,公司还在初始阶段,待会儿线上访问不了,公司就~~~~

想到的方案: 1)使用rsync+inotify进行实时同步,刚开始的时候不能进行同步,因为只有文件改变了才会进行同步,那么最开始的已有的那一大份数据就只有拷贝或rsync权利,在这拷贝的过程中又不断的有新数据产生,怎么保证数据实时同步呢

在传输的过程中文件由于各种原因损坏如何解决,综合考虑可靠性不高 2)使用lsyncd,传输速率是挺快,但是数据文件的完整性不能保证

未来的方案:自己开发,但是现在自己这水平也知道,短时间不能弄出来,长时间也不一定能,但是还是会当做一个项目去做,但这都是异想天开的想法了。

现实需要解决的问题: 那么,有没有其他的方案供参考呢,在网上看了很多资料,基本上是rsync+inotify,不想用这种,线上数据是要用的,不能开玩笑的,公司还在初始阶段,待会儿线上访问不了,公司就~~~~

实现两台服务器之间大批量文件的同步,实时的方案(除了rsync,inotify,lrsync)??? 这个可以自己开发一款软件出来,那就厉害了

heartbeat + drbd

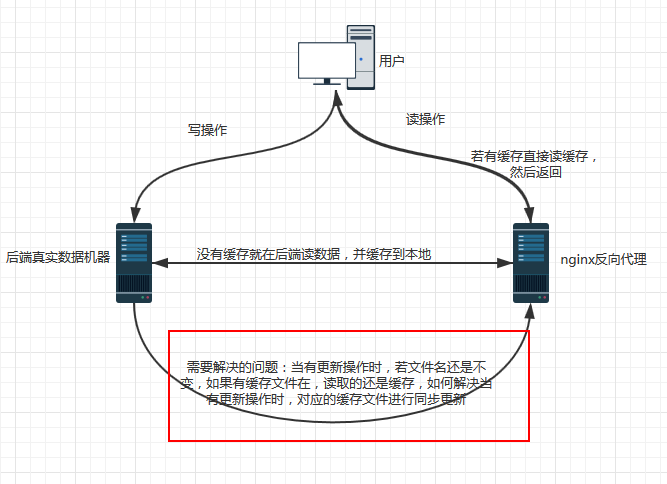

2:现有需求:需要nginx反向代理的时候做缓存

想到的办法:用proxy store

遇到的问题:当真实的数据机有数据更新的时候,如何让缓存及时更新?

我自己的想法:

1)自己写脚本监控是否有更新,有就把更新同步到缓存的目录文件

2)nginx有没有自身的机制可以做到,但是感觉没有,用proxy_cache的话,缓存的目录结构与原文件结构不一样,缓存不用清除,就是想有新的更新的时候能及时更新就行

想到的办法:用proxy store

遇到的问题:当真实的数据机有数据更新的时候,如何让缓存及时更新?

我自己的想法:

1)自己写脚本监控是否有更新,有就把更新同步到缓存的目录文件

2)nginx有没有自身的机制可以做到,但是感觉没有,用proxy_cache的话,缓存的目录结构与原文件结构不一样,缓存不用清除,就是想有新的更新的时候能及时更新就行

3)通过代码触发,当有更新操作触发的时候,获取请求URL,获得对应的文件夹及名称,然后执行删除缓存服务器的对应的文件夹及文件

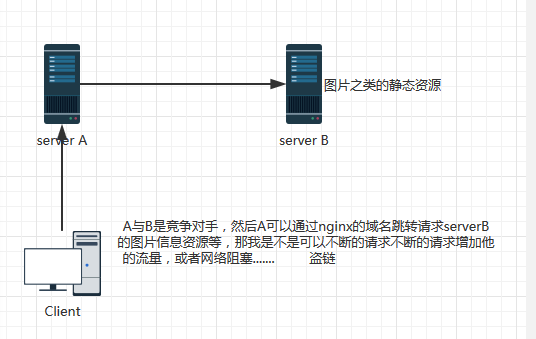

3:安全问题(盗链与防盗链) 突然觉得自己挺坏的 哈哈 想搞破坏

4:ssdb主从同步:

主A

从B

机器C

操作步骤:

1):停止从B,把数据拷贝到机器C

2):启动机器C的从进程,停掉

3):启动机器B的从进程,停掉

4):再启动机器C的从进程

问题:

如何找回在步骤2与步骤3之间的中间被同步的数据

作者:李先生

-------------------------------------------

个性签名:在平凡中坚持前行,总有一天会遇见不一样的自己!

如果觉得这篇文章对你有小小的帮助的话,记得在右下角点个“推荐”哦,博主在此感谢!

万水千山总是情,打赏一分行不行,所以如果你心情还比较高兴,也是可以扫码打赏博主,哈哈哈(っ•̀ω•́)っ✎⁾⁾!

微信公众号 微信打赏 支付宝打赏

posted on 2017-11-02 20:53 Captain_Li 阅读(467) 评论(1) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号