《机器学习》第一次作业——第一至三章学习记录和心得

第一章、模式识别基本概念

1.什么是模式识别

模式识别划分为“分类”和“回归”两种形式

分类(Classification)

输出量是离散的类别表达,即输出待识别模式所属的类别二类/多类分类

回归(Regression)

输出量是连续的信号表达(回归值),输出量维度:单个/多个维度

回归是分类的基础:离散的类别值是由回归值做判别决策得到的。

模式识别

根据已有知识的表达,针对待识别模式,判别决策其所属的类别或者预测其对应的回归值。

模式识别本质上是一种推理(inference)过程。

2.模式识别的数学表达

数学解释

模式识别可以看做一种函数映射f(x),将待识别模式x从输入空间映射到输出空间。函数f(x)是关于已有知识的表达。

注:f(x)可能是可解析表达的,也可能是不可解析表达的,其输出值可能是确定值也可能是概率值

输入空间

原始输入数据x所在的空间。

空间维度:输入数据的维度。

输出空间

输出的类别/回归值y所在的空间。

空间维度:1维、类别的个数(>2)、回归值的维度。

模型

关于已有知识的一种表达方式,即函数f(x)。

模型通过机器学习得到。

3.特征向量的相关性

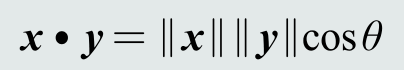

点积

能够度量特征向量两两之间的相关性即识别模式之间是否相似。

可以表征两个特征向量的共线性,即方向上的相似程度。

点积为0,说明两个向量是正交的(orthogonal)。

投影

向量x到y的投影(projection)︰将向量x垂直投射到向量y方向上的长度(标量)。

投影的含义:向量x分解到向量y方向上的程度。能够分解的越多,说明两个向量方向上越相似。

残差向量

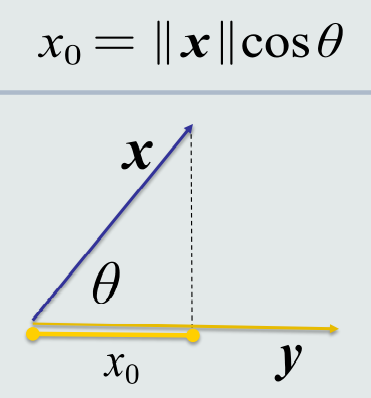

特征向量的欧氏距离

两个特征向量之间的欧式距离:表征两个向量之间的相似程度(综合考虑方向和模长)。

4.机器学习基本概念

训练样本

每个训练样本,都是通过采样得到的一个模式,即输入特征空间中的一个向量;通常是高维度(即𝑝很大),例如一幅图像。

训练样本可以认为是尚未加工的原始知识,模型则是经过学习(即加工整理归纳等)后的真正知识表达。

假设所有训练样本满足独立同分布。

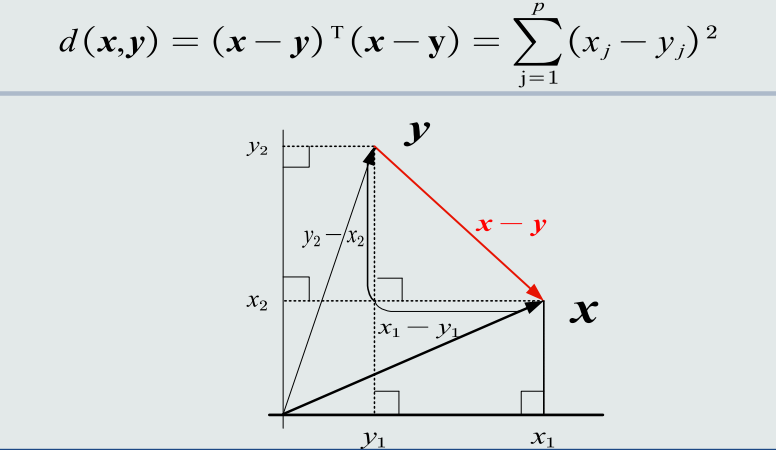

线性模型

非线性模型

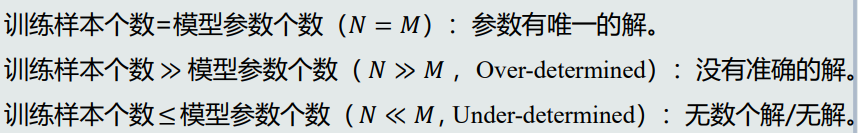

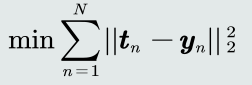

针对没有准确解的情况,我们使用目标函数(代价函数,损失函数)来优化解

针对无数解的情况,我们还需要在目标函数中加入能够体现对于参数解的约束条件,据此从无数个解中选出最优的一个解。

通过优化算法得出最优解,优化算法的目的是最小化或最大化目标函数

由上图可以看出,机器学习为模式识别提供模型,机器学习是学习的过程,模式识别的应用的过程

真值和标签

每个样本都有其对应的真正的输出值即为真值,在分类任务中真值称为标签,标注是对每个样本标出真值的过程,目前主要通过人工的方式来个样本进行标注

监督式学习(最常见)

训练样本及其输出真值都给定情况下的机器学习算法。

通常使用最小化训练误差作为目标函数进行优化。

无监督式学习

只给定训练样本、没有给输出真值情况下的机器学习算法。

无监督式学习算法的难度远高于监督式算法。

根据训练样本之间的相似程度来进行决策。

典型应用:聚类、图像分割

半监督式学习

既有标注的训练样本、又有未标注的训练样本情况下的学习算法。

典型应用:网络流数据

强化学习

机器自行探索决策、真值滞后反馈的过程。

典型应用:Alpha Go、CNN

5.模型的泛化能力

泛化能力就是学习算法对新模式的决策能力

训练得到的模型不仅要对训练样本具有决策能力,也要对新的(训练过程中未看见)的模式具有决策能力。

一个好的学习算法既能对现有模式做出好的识别,也能对其他模式做出好的识别。

训练集

模型训练所用的样本数据。集合中的每个样本称作训练样本。

测试集

测试模型性能所用的样本数据。集合中的每个样本称作测试样本。

测试样本也是假设从样本真实分布中独立同分布(iid)采样得到的。

测试集和训练集是互斥的,但假设是同分布的。

误差

误差(error):模型(机器)给出的预测/决策输出与真值输出之间的差异。

训练误差(training error):模型在训练集上的误差。

测试误差(test error):模型在测试集上的误差。它反映了模型的泛化能力,也称作泛化误差。

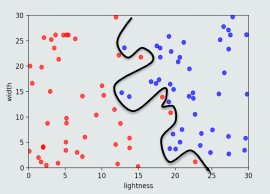

过拟合

模型训练阶段表现很好,但是在测试阶段表现很差。

模型过于拟合训练数据。

提高泛化能力思路:不要过度训练。

方法:

选择复杂度适合的模型(tradeoff):模型选择。

例如在多项式拟合中要选择合适的多项式阶数,能够减小误差。

正则化(regularization) :在目标函数中加入正则项。

通过调节正则系数,降低过拟合的程度

调节超参数

需要依据泛化误差,但又不能基于测试集。所以,从训练集中划分出一个验证集(validation set),基于验证集调整选择超参数。

6.评估方法与性能指标

留出法

随机划分:将数据集随机分为两组:训练集和测试集。利用训练集训练模型,然后利用测试集评估模型的量化指标。

取统计值:为了克服单次随机划分带来的偏差,将上述随机划分进行若干次,取量化指标的平均值(以及方差、最大值等)作为最终的性能量化评估结果。

K折交叉验证

将数据集分割成K个子集,从其中选取单个子集作为测试集,其他K-1个子集作为训练集。

交叉验证重复K次,使得每个子集都被测试一次;将K次的评估值取平均,作为最终的量化评估结果。

留一验证

K折交叉验证的特例,即让K=样本数N

每次只取数据集中的一个样本做测试集,剩余的做训练集。

每个样本测试一次,取所有评估值的平均值作为最终评估结果。

性能衡量指标

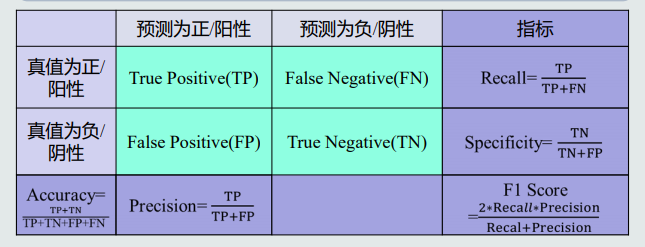

二类分类:真阳性(TP),假阳性(FP),真阴性(TN),假阴性(FN)

多类分类:依次以单个类作为正类,其余为负类。

准确度(Accuracy)

将阳性和阴性综合起来度量识别正确的程度。

精度(Precision)

预测为阳性样本的准确程度。在信息检索领域,也称作查准率。

召回率(Recall)

也称作敏感度(sensitivity),全部阳性样本中被预测为阳性的比例。在信息检索领域也称作查全率。

精度高、同时召回率也高,说明模型性能越好。

但是,在有些情况下,精度和召回率是矛盾的。

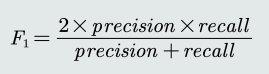

F-Score

通过加权平均,同时考虑精度和召回率的性能衡量指标

设置a=1,得到F1-Score

曲线度量

可以设置若干个关于输出值的阈值,不同的阈值可以代表不同的应用任务,得到多个评估值,从而可以在指标空间画出一条曲线,从而得到评估指标的期望表征。

PR曲线

横轴:召回率(recall)

纵轴:精度(precision)

理想性能:右上角(1,1)处。

PR曲线越往右上凸,说明模型的性能越好。

绘制方法:

①根据模型的预测数值,对样本进行从高到低排序,排在前面的样本是正例的可能性更高。

②按此顺序逐个样本作为正例进行预测(或设置阈值截断正例和负

例),则每次可以计算一个召回率和精度。

③将这些值连成(拟合)一条曲线

ROC曲线

横轴:False positive rate (FPR),度量所有阴性样本中被错误识别为阳性的比率。FPR=1-specificity。

纵轴:True positive rate (TPR),即recall。度量所有阳性样本被识别为阳性的比例。

理想性能:左上角(0,1)处。

ROC曲线越往左上凸,说明模型的性能越好。

对角线:随机识别的ROC曲线。

绘制方法:与PR曲线相似。

两者比较

ROC曲线:对于各类别之间样本分布比例不敏感,因为FPR和TPR各自只跟真值为负或真值为正的样本相关。

PR曲线:对于各类别样本分布比例敏感,因为precision同时和真值正负的样本都相关。

曲线下方面积AUC

曲线下方面积(Area under the Curve, AUC):将曲线度量所表达的信息浓缩到一个标量表达。

AUC = 1:是完美分类器,

0.5 < AUC < 1:优于随机猜测。这个模型妥善设定阈值的话,能有预测价值。

AUC = 0.5:跟随机猜测一样,模型没有预测价值。

AUC < 0.5:比随机猜测还差。

第二章、基于距离的分类器

1.基于距离分类的基本概念

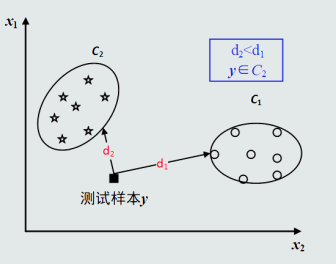

基于距离的决策

把测试样本到每个类之间的距离作为决策模型,将测试样本判定为与其距离最近的类。

该技术是初级的模式识别技术,是其它识别决策技术的基础。

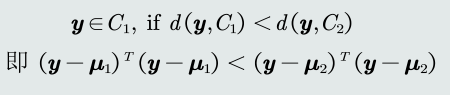

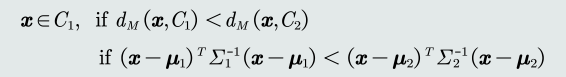

判别公式

类的原型

用来代表这个类的一个模式或者一组量,便于计算该类和测试样本之间的距离。

可以使用该类中所有训练样本的均值作为类的原型,均值是对类中所有训练样本代表误差最小的一种表达方式。

最近邻

从一类的训练样本中,选取与测试样本距离最近的一个训练样本,作为该类的原型。类的原型取决于测试样本。

缺陷

对类的表达误差较大。

对噪声和异常样本比较敏感。

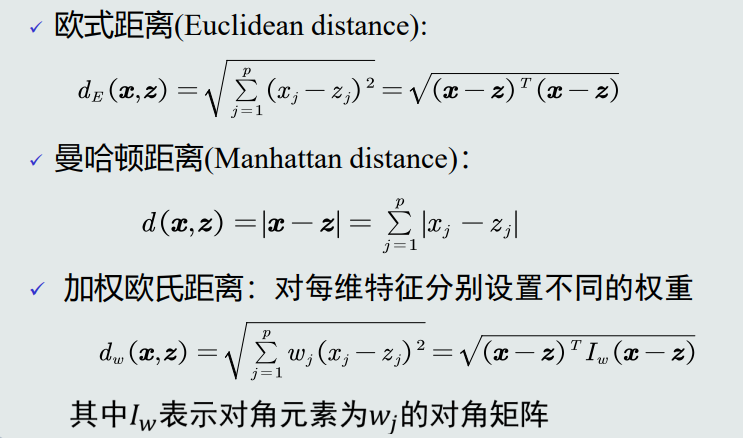

常见距离度量

MED分类器

最小欧式距离分类器(Minimum Euclidean Distance Classifier)

距离衡量:欧氏距离

类的原型:均值

二分类问题中,它的边界决策方程是:

在高维空间中,该决策边界是一个超平面,且该平面垂直且二分连接两个类原型的线。

MED分类器采用欧氏距离作为距离度量,没有考虑特征变化的不同及特征之间的相关性。这个时候我们要进行特征白化。

2.特征白化

目的

将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性。

将特征转换分为两步:先去除特征之间的相关性(解耦, Decoupling),然后再对特征进行尺度变换(白化, Whitening),使每维特征的方差相等。

3.MICD分类器

最小类内距离分类器(Minimum Intra-class Distance Classifier),基于马氏距离的分类器。

距离度量:马氏距离

类的原型:均值

判别公式

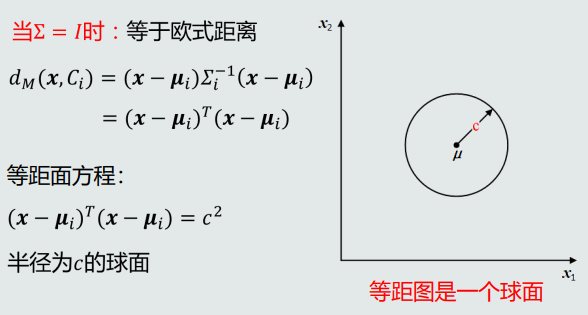

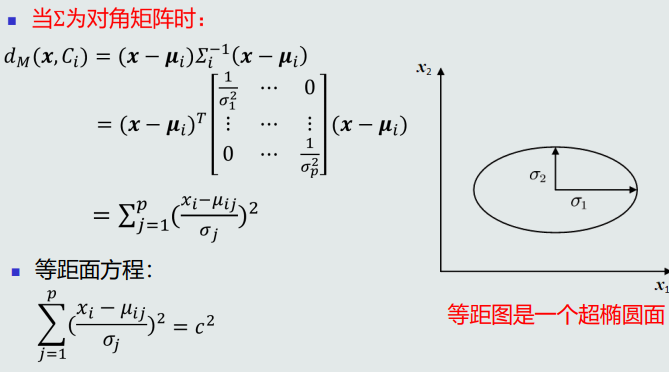

马氏距离的属性

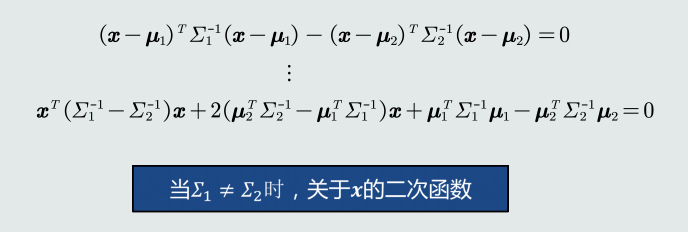

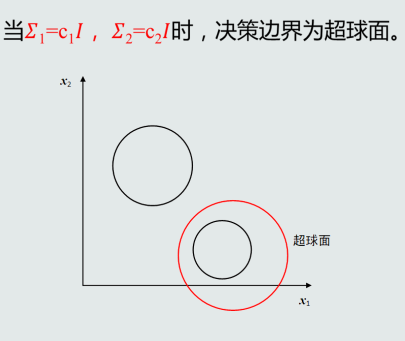

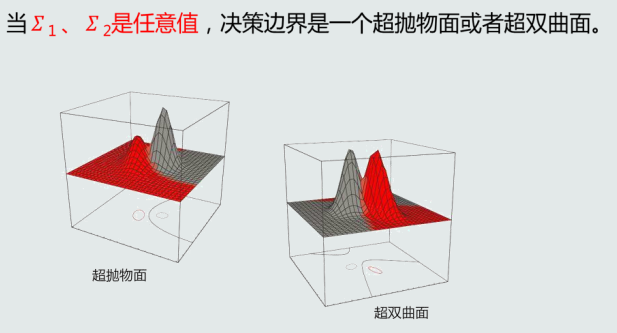

MICD分类器的决策边界

对于二类分类而言,MICD分类器的决策边界位于到两个类的距离相等的面上,即:

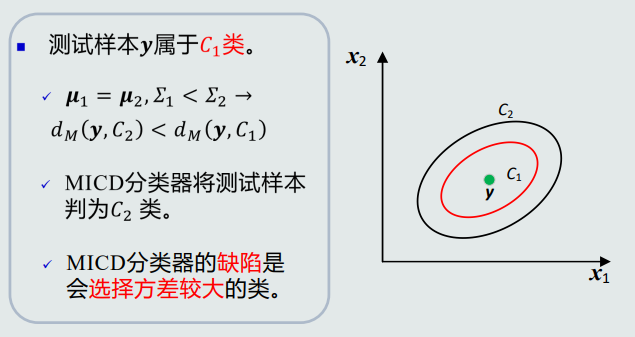

MICD分类器的问题

第三章、贝叶斯决策与学习

1.贝叶斯决策与MAP分类器

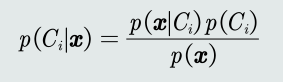

后验概率

该条件概率称作后验概率,表达给定模式𝒙属于类𝐶𝑖可能性。

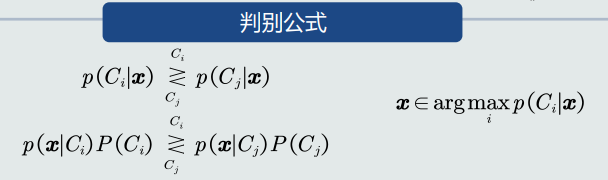

决策方法:

后验概率计算公式:

其中

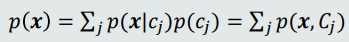

表示所有类别样本x的边缘概率

MAP分类器

最大后验概率(Maximum posterior probability,MAP)分类器:将测试样本决策分类给后验概率最大的那个类。

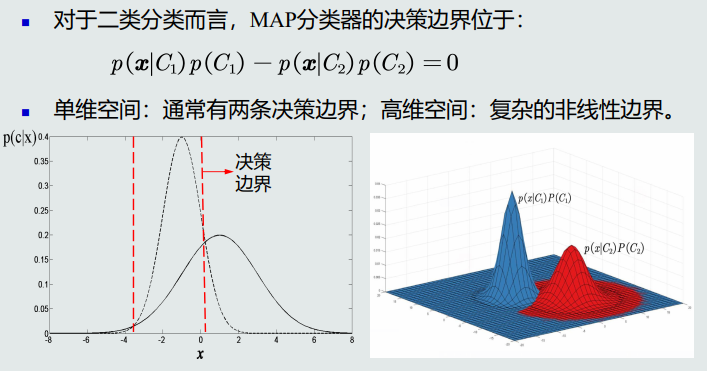

决策边界

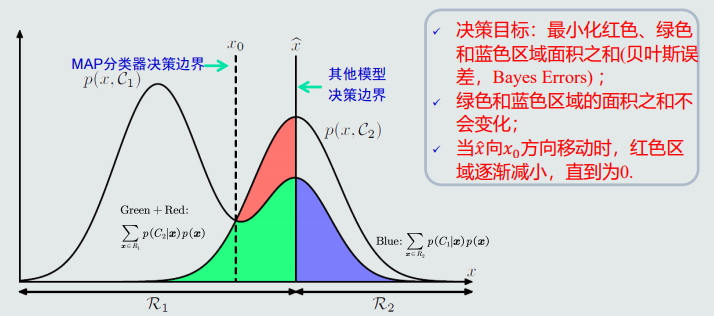

MAP分类器决策目标:最小化概率误差,即分类误差最小化。

给定所有测试样本,MAP分类器选择后验概率最大的类,等于最小化平均概率误差,即最小化决策误差。

2.高斯观测概率

3.决策风险

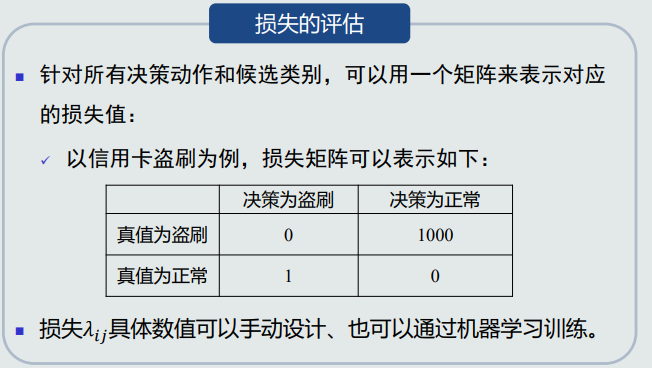

贝叶斯决策可能出现错误判断,从而带来决策风险,不同的错误判断会带来不同的风险,定义损失(loss)来表示风险程度

浙公网安备 33010602011771号

浙公网安备 33010602011771号