Netty 核心组件介绍

Netty 框架

1. Netty 的核心组件与工作原理

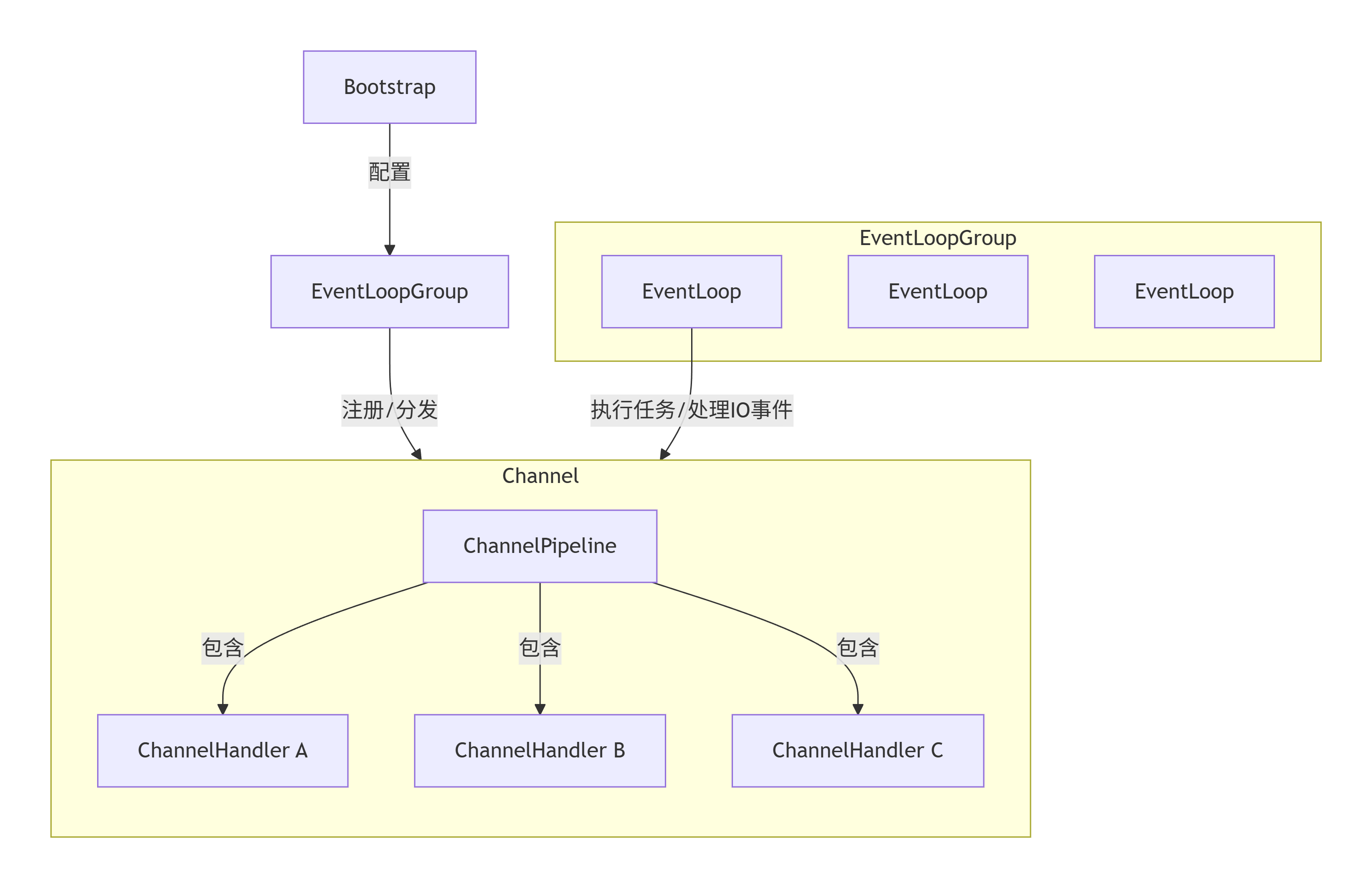

Netty的核心组件的工作原理如下:

1.1. Channel & ChannelFuture

-

Channel: 是Netty对网络连接(如Socket)的抽象。它代表了到一个实体(如一个硬件设备、一个文件、一个网络套接字)的开放连接。所有的I/O操作都是通过Channel进行的。

-

ChannelFuture: 由于Netty的所有I/O操作都是异步的,当你执行一个操作(如写入数据)时,它会立即返回一个ChannelFuture。你可以通过这个Future来注册监听器,在操作完成、成功或失败时得到通知。这是“异步非阻塞”编程模型的基础。

1.2. EventLoop & EventLoopGroup

这是Netty的心脏,负责处理连接的生命周期中发生的事件。

- EventLoop: 一个EventLoop绑定了一个单一的线程,在其整个生命周期中处理所有分配给它的I/O事件和任务。它的核心运行模式如下:

while (!isTerminated()) {

// 1. 处理IO事件 (Selector.select)

// 2. 处理任务队列中的普通任务和定时任务

}

“一个EventLoop一生只服务于一个Thread” 的设计,从根本上避免了多线程环境下的并发问题,实现了无锁化串行设计,极大提升了性能。

-

EventLoopGroup: 包含多个EventLoop,可以看作是一个EventLoop的池子。它负责分配EventLoop给新创建的Channel。在服务器端,通常有两个Group:

-

BossGroup: 通常只有一个EventLoop,负责接收客户端的连接(Accept事件)。

-

WorkerGroup: 包含多个EventLoop,负责处理已被接受的连接的读写(Read/Write事件)。

-

1.3. ChannelPipeline & ChannelHandler

ChannelPipeline 和 ChannelHandler 是 Netty 的灵魂,是其可扩展性的核心:

-

ChannelPipeline: 可以看作是一个拦截流经Channel的所有入站和出站事件的责任链。每个新的Channel都会被分配一个唯一的ChannelPipeline。

-

ChannelHandler: 是处理入站和出站事件的实际逻辑单元。它被插入到ChannelPipeline中,形成一个处理链。

-

ChannelInboundHandler: 处理入站事件,例如:连接激活、数据读取、异常发生、连接关闭。

-

ChannelOutboundHandler: 处理出站事件,例如:打开连接、绑定端口、写入数据、刷新数据。

-

2. Netty 处理网络数据

2.1. Netty如何解决TCP粘包问题

因为 TCP 是一个面向数据流的通信协议,它没有消息边界。发送方如果连续发送的多个数据包,在接收方可能被合并成一个大的包(粘包),或者被拆分成多个小包(半包)。这样就会出现TCP粘包或者半包问题。

Netty的解决方案:

-

固定长度解码器:FixedLengthFrameDecoder

-

行分隔符解码器:LineBasedFrameDecoder

-

分隔符解码器:DelimiterBasedFrameDecoder

-

长度域解码器:LengthFieldBasedFrameDecoder (最通用、最常用)

通过在 Pipeline 中添加合适的解码器,Netty 可以自动帮你完成拆包,保证你的 ChannelHandler 每次收到的都是一个完整的应用层数据包。

2.2. 内存管理(ByteBuf)

Netty 提供了自己的一套字节容器 —— ByteBuf,以替代 JDK 的 ByteBuffer。

ByteBuf 的核心优势:

-

池化: 通过ByteBufAllocator可以创建池化的ByteBuf,显著减少GC压力和内存分配开销。

-

灵活的扩展: 支持自动扩容。

-

读写索引分离: 不需要像ByteBuffer一样调用flip()来切换读写模式。

-

零拷贝: 支持复合缓冲区(CompositeByteBuf)和文件传输(FileRegion),减少不必要的内存拷贝。

2.2.1. ByteBuf 的实现类详解

ByteBuf 提供了一些较为丰富的实现类:

-

逻辑上主要分为两种:HeapByteBuf 和 DirectByteBuf;

其中,HeapByteBuf 由 Java Heap 管理,内部实现直接采用

byte[] array,而DirectByteBuf使用是堆外内存,Direct 应是采用 Direct I/O 之意,内部实现使用java.nio.DirectByteBuffer。 -

实现机制则分为两种:PooledByteBuf 和 UnpooledByteBuf;

其中,UnpooledByteBuf 实现就是普通的 ByteBuf,而

除了这些之外,Netty 还实现了一些 ByteBuf 的派生类,如:DerivedByteBuf、ReadOnlyByteBuf、DuplicatedByteBuf 以及 SlicedByteBuf。

-

DerivedByteBuf的实现采用装饰器模式对原有的ByteBuf进行了一些封装; -

ReadOnlyByteBuf是某个ByteBuf的只读引用; -

DuplicatedByteBuf是某个ByteBuf对象的引用; -

SlicedByteBuf是某个ByteBuf的部分内容。

2.2.2. ByteBuf的实现机制

2.2.2.1. Pooled

Netty 4.x 版本开发了 Pooled Buffer,实现了一个高性能的 buffer 池,分配策略则是结合了 buddy allocation 和 slab allocation 的jemalloc变种,代码在io.netty.buffer.PoolArena中。

它具备以下优势:

-

频繁分配、释放buffer时减少了GC压力;

-

在初始化新buffer时减少内存带宽消耗(初始化时不可避免的要给buffer数组赋初始值);

-

及时的释放direct buffer。

2.2.2.2. Reference Count

ByteBuf 的生命周期管理引入了 Reference Count 的机制,感觉让我回到了CPP时代。可以通过简单的继承 SimpleChannelInboundHandler 实现自动释放reference count。

2.2.2.3. Zero Copy

传统的zero-copy是IO传输过程中,数据无需中内核态到用户态、用户态到内核态的数据拷贝,减少拷贝次数。而Netty的zero-copy则是完全在用户态,或者说传输层的zero-copy机制,通过在用户态减少不必要的内存拷贝和上下文切换的优化技术,高效地管理数据,提升了性能。

由于协议传输过程中,通常会有拆包、合并包的过程,一般的做法就是System.arrayCopy了,但是 Netty 通过 ByteBuf.slice 以及 Unpooled.wrappedBuffer 等方法拆分、合并 Buffer 无需拷贝数据。

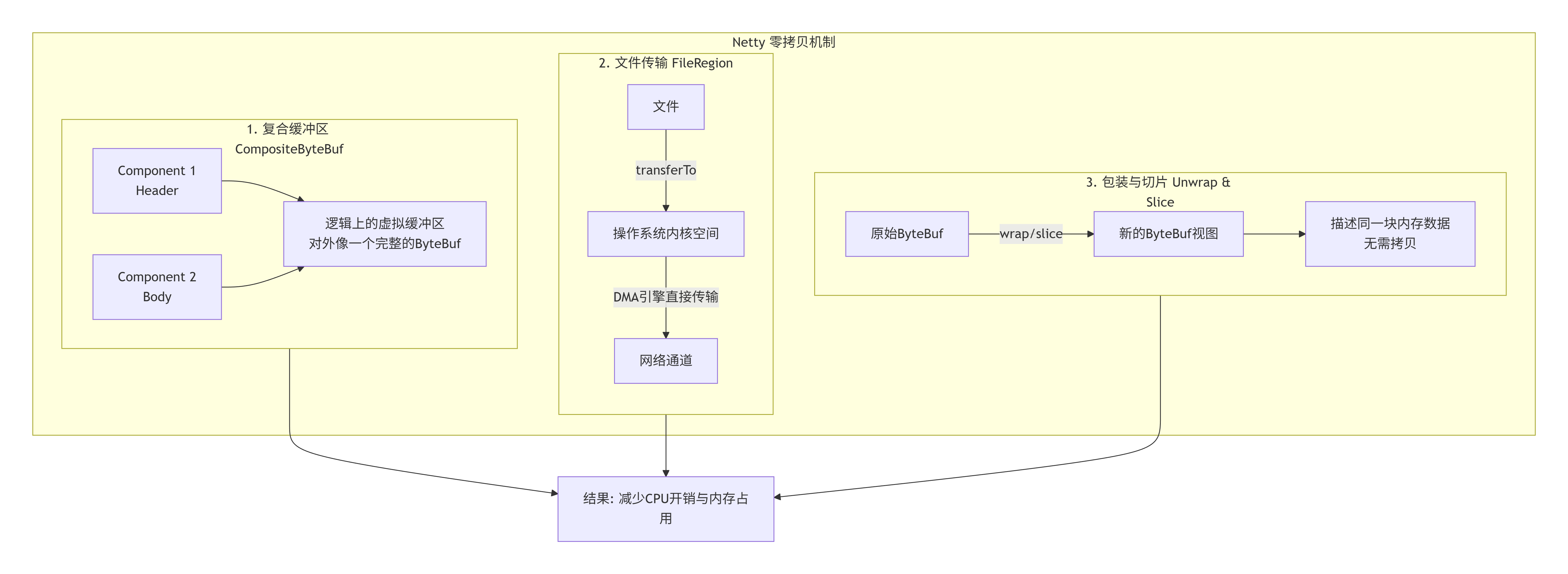

Netty零拷贝的三种形式:

-

1. 复合缓冲区(CompositeByteBuf)

-

解决的问题: 在传统方式中,如果需要将多个ByteBuf(例如协议头和消息体)合并成一个完整的缓冲区,通常需要创建一个新的、更大的ByteBuf,然后将所有部分的数据逐个拷贝进去。

-

Netty的解决方案: CompositeByteBuf是一个虚拟的、逻辑上的缓冲区容器。它内部维护了一个由多个ByteBuf组成的列表,对外却表现得像一个单一的ByteBuf。

-

如何实现“零拷贝”: 它并不进行实际的数据拷贝,而只是通过组合引用的方式,将多个物理上分散的ByteBuf在逻辑上组装起来。当你对其进行读取操作时,它会自动按顺序从各个组件中获取数据。

-

代码示例:

ByteBuf header = ...; // 协议头

ByteBuf body = ...; // 消息体

// 传统方式:需要拷贝

// ByteBuf allData = Unpooled.buffer(header.readableBytes() + body.readableBytes());

// allData.writeBytes(header);

// allData.writeBytes(body);

// Netty零拷贝方式:无需拷贝

CompositeByteBuf compositeByteBuf = Unpooled.compositeBuffer();

compositeByteBuf.addComponents(true, header, body); // true表示自动增加写索引

如上图A1所示,CompositeByteBuf(V)只是逻辑上组合了C1和C2,数据本身仍在原有位置。

-

2. 文件传输(FileRegion)

-

解决的问题: 将文件内容发送到网络。

-

传统方式: FileInputStream -> 读取到JVM堆内/堆外字节数组 -> 将字节数组写入SocketOutputStream。这个过程涉及多次用户态与内核态的上下文切换和数据拷贝。

-

Netty的解决方案: 使用FileRegion。

-

如何实现“零拷贝”: 它利用了操作系统提供的FileChannel.transferTo()方法。该方法可以将文件数据直接从文件系统缓存(PageCache)通过DMA(直接内存访问)引擎传输到网络通道。数据完全不需要经过用户态(JVM内存),如图A2所示。

-

代码示例:

File file = ...;

FileInputStream fis = new FileInputStream(file);

FileChannel channel = fis.getChannel();

// 创建FileRegion, 指定文件和起始位置、长度

FileRegion region = new DefaultFileRegion(channel, 0, file.length());

// 直接写入Channel, Netty会利用transferTo进行高效传输

channelHandlerContext.writeAndFlush(region);

-

3. 包装与切片(Unwrap & Slice)

-

解决的问题: 当你需要操作一个庞大ByteBuf中的一小部分,或者将字节数组、ByteBuffer等包装成ByteBuf时,不希望发生数据拷贝。

-

Netty的解决方案:

-

切片(Slice): ByteBuf.slice()方法可以创建一个新的ByteBuf,它与原始ByteBuf共享底层存储,但拥有独立的读写索引,仅能看到原始Buf的一个子区域。

-

包装(Wrap): Unpooled.wrappedBuffer()方法可以将一个或多个byte[]、ByteBuf或ByteBuffer“包装”成一个新的ByteBuf视图。

-

-

如何实现“零拷贝”: 如图A3所示,这些操作都不复制底层数据,新生成的ByteBuf只是持有对原始数据的一个引用或视图。任何对切片或包装后的ByteBuf的修改,都会反映到原始的ByteBuf上。

-

代码示例:

ByteBuf originalBuf = ...;

// 切片:获取从索引10开始,长度为50的子区域,无需拷贝

ByteBuf slicedBuf = originalBuf.slice(10, 50);

// 包装:将字节数组包装成ByteBuf,无需拷贝

byte[] bytes = "Hello, Netty!".getBytes();

ByteBuf wrappedBuf = Unpooled.wrappedBuffer(bytes);

Netty的零拷贝机制,其核心思想是 “操作数据视图,而非拷贝数据本身” 。通过复合缓冲区、文件传输和包装/切片这三大技术,它有效地:

-

减少内存拷贝: 尤其是当处理大块数据时,避免了昂贵的CPU拷贝操作。

-

降低内存占用: 减少了不必要的中间缓冲区创建,降低了堆内和堆外内存的消耗。

-

提升性能: 更低的CPU占用和更少的内存分配/GC压力,直接转化为更高的网络吞吐量和更低的延迟。

2.3. Channel 和 Pipeline

参考:

浙公网安备 33010602011771号

浙公网安备 33010602011771号