AAAI2025论文!川大团队领衔!用 “稀疏注意力” 干掉手工特征,让图像造假无所遁形 | 图像编辑

01 论文概述

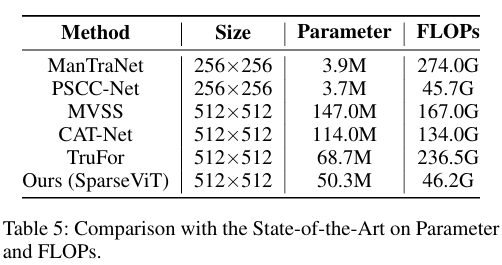

这篇顶会级工作由 四川大学计算机学院 + 教育部机器学习与工业智能工程研究中心 核心领衔(通讯作者:周吉喆教授),联合 穆罕默德・本・扎耶德人工智能大学、澳门大学计算机与信息科学系 共同完成。

论文名称:Can We Get Rid of Handcrafted Feature Extractors? SparseViT: Nonsemantics-Centered, Parameter-Efficient Image Manipulation Localization through Spare-Coding Transformer

SparseViT:抛弃手工特征提取器的参数高效图像篡改定位新范式—— 无需手工特征,精度更高、泛化更强、速度更快!

想找出图像里被篡改的区域,比如 P 掉的人物、拼接的背景,关键要抓 “篡改痕迹”—— 也就是非语义特征,如噪声、频率异常等与图像内容无关、但对篡改敏感的低层次痕迹。

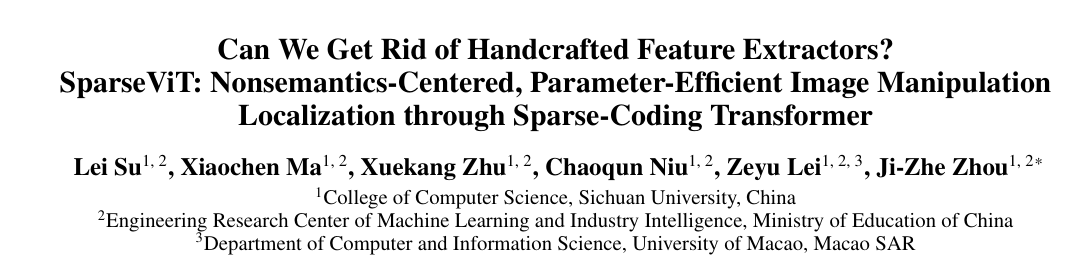

但过去所有主流方案均采用 “语义分割骨干网络(如 VGG、ResNet、ViT)+ 手工非语义特征提取器” 的架构。

- 手工特征提取器需为不同非语义特征设计定制化策略,缺乏适应性—— 面对未知篡改场景(如新型编辑工具、复杂噪声干扰)时,泛化能力严重受限;

- 部分手工特征甚至会导致性能退化(实验显示 Sobel、Bayar 等提取器在部分数据集上表现不如无手工特征的基线)。

因此,论文提出核心问题:如何让模型自适应提取非语义特征,而非依赖人工设计?

论文的突破点在于,从 “特征交互模式” 角度区分了语义特征与非语义特征的本质差异,为稀疏机制提供理论依据:

- 语义特征:需强连续性与上下文关联性(如 “猫” 的语义需整合耳朵、毛发、轮廓等局部特征),因此依赖 “密集、全局的特征交互”(如 ViT 的全局自注意力)才能构建完整语义;

- 非语义特征:具有局部独立性(如某区域的噪声分布与其他区域无关),且对篡改敏感 —— 仅需 “稀疏、离散的特征交互” 即可捕捉,无需全局密集计算。

基于此,论文提出:打破传统 ViT 的 “密集全局自注意力”,改为 “稀疏自注意力”,可抑制语义特征的表达,迫使模型聚焦于非语义特征的提取。

核心技术:从机制设计突破非语义特征提取难题

SparseViT 的技术核心围绕 “如何通过架构优化抑制语义学习、强化非语义特征捕捉” 展开,关键技术模块可拆解为三大组件,且各组件间形成逻辑闭环:

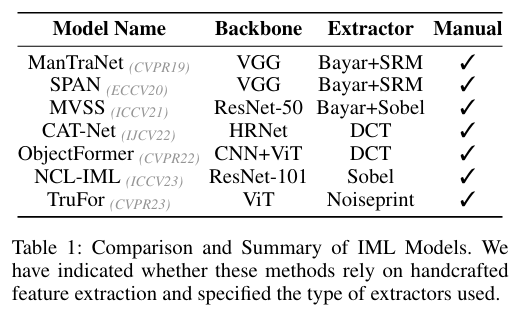

1. 稀疏自注意力机制(Sparse Self-Attention):非语义特征提取的核心载体

该机制的设计源于对 “语义 / 非语义特征交互模式差异” 的深刻洞察:

- 设计逻辑:引入 “稀疏率(S)” 作为架构超参数,将输入特征图分割为非重叠张量块,仅在同一块内执行自注意力计算,阻断跨块的全局语义关联(如图 2 所示)。

- 技术细节:传统 ViT 的全局自注意力通过 “全像素键 - 值(K-V)交互” 整合语义信息,而 SparseViT 的局部块内交互仅保留 “局部非语义特征的关联性”(如局部噪声分布、像素高频异常),同时过滤掉 “跨块语义依赖”(如物体轮廓、场景上下文)—— 从机制上迫使模型脱离对语义特征的依赖,转向非语义特征学习。

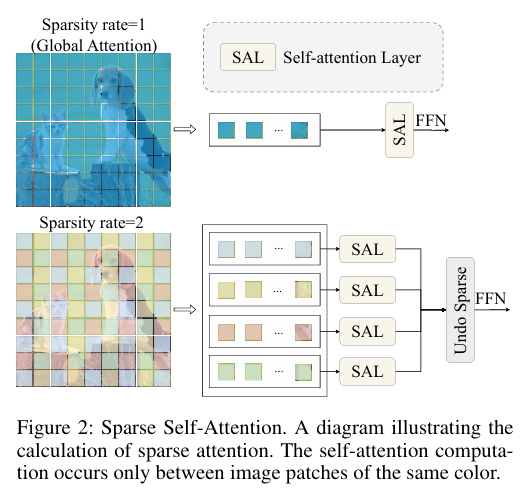

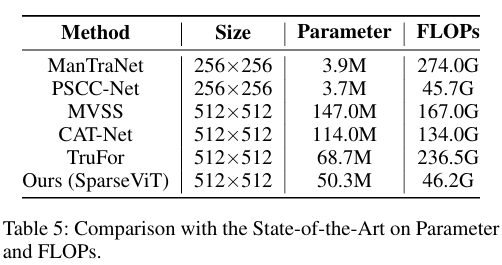

- 计算优化:通过张量块稀疏分割,避免了传统全局注意力中 “大量无关对” 的冗余计算,理论上可将自注意力模块的计算复杂度从降至,实验中最大实现80% 的 FLOPs 降低(如表 5 所示,SparseViT 的 FLOPs 仅为 ManTraNet 的 17%、TruFor 的 80%)。

2. 多尺度稀疏监督策略:平衡非语义特征的全局与局部表征

为解决 “单一稀疏率无法适配不同场景非语义特征” 的问题,SparseViT 在编码器 Stage 3 与 Stage 4 引入分层稀疏率设计:

- 设计逻辑:低稀疏率(如 S=2)的特征块保留少量跨块交互,可捕捉 “全局非语义趋势”(如篡改区域的整体频率异常);高稀疏率(如 S=8)的特征块仅保留局部交互,可聚焦 “局部篡改痕迹”(如像素级噪声不连续)。通过在不同网络阶段设置 “指数递减的稀疏率”,实现 “全局 - 局部非语义特征” 的分层提取。

- 技术价值:该策略避免了 “单一稀疏率导致的特征偏向性”—— 例如,低稀疏率在物体级篡改数据集(如 CASIAv1)中易受语义干扰,高稀疏率在精细篡改数据集(如 NIST16)中易丢失全局关联,而多尺度稀疏监督通过融合不同稀疏率特征,使模型在各类篡改场景中均能稳定提取非语义特征(如表 6 所示,SparseViT 的平均 F1 显著高于单一稀疏率模型)。

3. LFF 可学习特征融合模块:多尺度非语义特征的自适应整合

针对传统多尺度融合(如加法、拼接)“固定线性聚合、无法动态适配特征重要性” 的缺陷,SparseViT 设计了Learnable Feature Fusion(LFF)预测头:

(1)设计逻辑:引入可学习缩放参数γ(初始化为 1e-6),对不同稀疏率的特征图进行 “权重自适应调整”,核心流程包括:

- 通道统一:通过线性层将多尺度特征通道数统一为 512 维,消除通道维度差异;

- 尺度对齐:对高分辨率特征图(如 Stage 4 输出)进行 1/16 倍上采样,确保空间尺度一致;

- 权重学习:每个特征图与对应γ相乘,模型通过反向传播学习 “不同场景下各特征图的贡献权重”(如篡改边缘场景中,高稀疏率特征的γ更大);

- 特征聚合:加权后的特征图求和,经通道压缩(至 1 维)与上采样,输出最终篡改掩码。

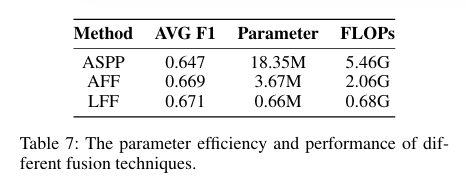

(2)技术优势:相比 SegFormer 的 MLP 预测头(固定线性融合),LFF 通过γ实现 “非语义特征的动态筛选”,实验中使平均 F1 提升 3.2%(如表 3 所示),且参数仅增加 0.66M(如表 7 所示),兼顾性能与轻量化。

核心优势:从 “摆脱手工依赖” 到 “全维度性能领先”

SparseViT 的优势并非单一技术突破,而是 “机制创新 - 性能提升 - 工程适配” 的综合体现,具体可归纳为四大维度:

1. 自适应非语义特征提取:彻底摆脱手工特征依赖

这是 SparseViT 最核心的优势,解决了传统 IML 模型的根本性瓶颈:

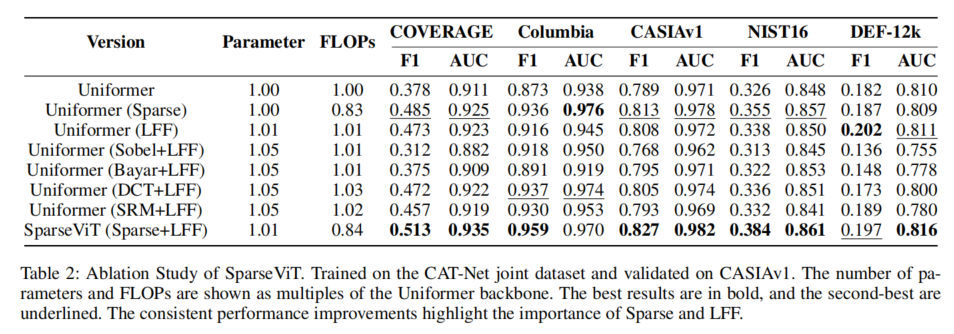

- 传统方法需为不同非语义特征(噪声、频率、边缘)设计定制化提取器(如 SRM、DCT、Sobel),且手工特征的泛化性差(如 Sobel 提取器在 NIST16 数据集上导致性能退化,如表 2 所示);

- SparseViT 通过 “稀疏自注意力 + 多尺度监督”,实现非语义特征的端到端自适应学习—— 无需任何手工设计,即可在 5 个基准数据集上稳定捕捉噪声、频率、边缘等多类型非语义痕迹,实验中其非语义特征提取能力显著优于所有手工特征组合(如表 2 所示,SparseViT 的 F1 在 COVERAGE 数据集达 0.513,高于 SRM+LFF 的 0.472、DCT+LFF 的 0.457)。

2. 极致参数效率:性能与计算成本的最优平衡

在 IML 任务中,传统模型常面临 “性能提升依赖参数膨胀” 的困境(如 ManTraNet 参数 147M、FLOPs 274G),而 SparseViT 通过稀疏机制实现 “降参不降能”:

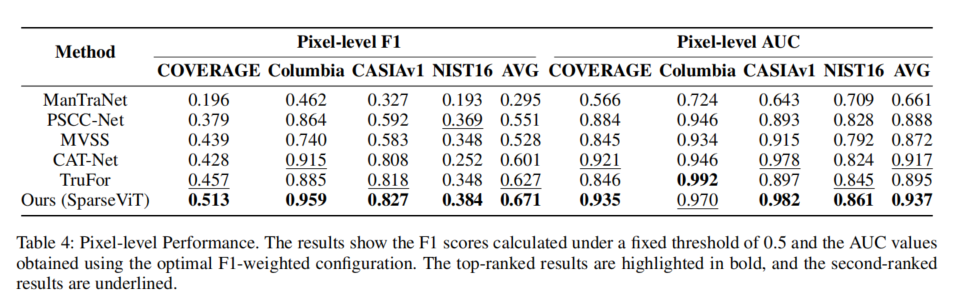

模型参数仅 50.3M(与 TruFor 相当),但 FLOPs 降至 46.2G(比 TruFor 低 21%,比 ManTraNet 低 83%);

即使与轻量化模型 PSCC-Net(3.9M 参数)相比,SparseViT 的平均 F1 仍高 12%(0.671 vs 0.551),实现 “轻量化” 与 “高性能” 的双重突破(如表 4、表 5 所示)。

3. 强泛化与鲁棒性:跨场景与抗干扰能力领先

IML 任务的实际应用中,“泛化性”(适应未知篡改手法)与 “鲁棒性”(抵抗篡改痕迹破坏)至关重要,而 SparseViT 在这两个维度表现突出:

- 泛化性:在跨数据集测试中(CAT-Net 训练→5 个数据集测试),SparseViT 的平均 F1 达 0.671,比次优模型 TruFor(0.601)高 11.6%,尤其在复杂篡改数据集(如 NIST16、COVERAGE)上优势更显著(F1 分别高 12.3%、12.2%);

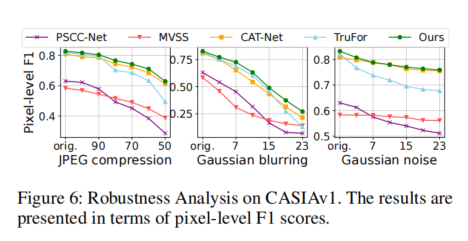

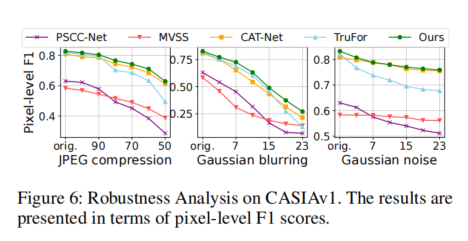

- 鲁棒性:面对 JPEG 压缩(质量因子 50)、高斯模糊(核大小 5×5)、高斯噪声(标准差 0.1)等常见 “篡改痕迹破坏手段”,SparseViT 的 F1 下降幅度仅为 5%-8%,远低于 TruFor 的 12%-15%(如图 6 所示),证明其非语义特征捕捉能力的稳定性。

4. 语义干扰抑制:避免 “语义假阳性” 的关键突破

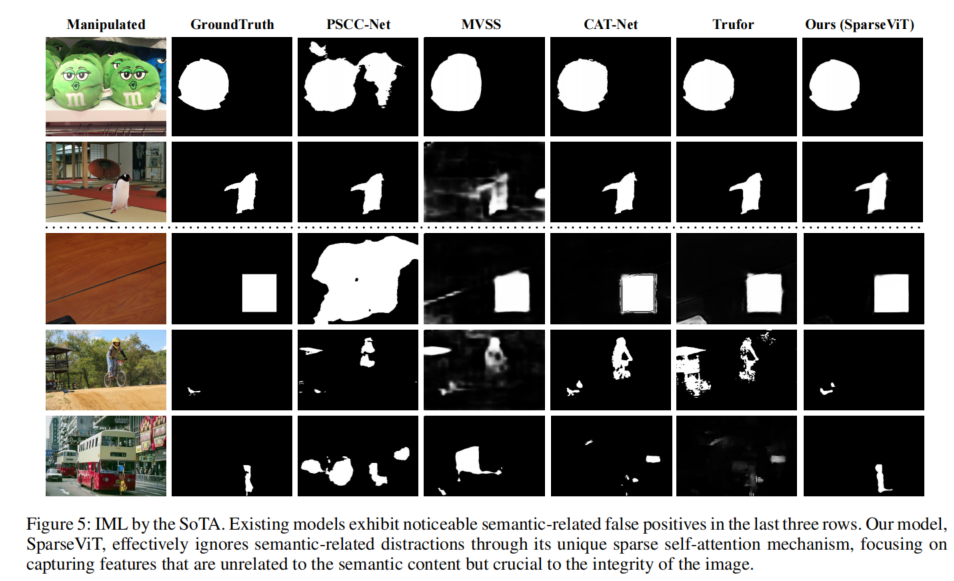

传统 IML 模型因依赖语义分割骨干,易将 “语义边缘”(如物体轮廓)误判为 “篡改边缘”(即 “语义假阳性”),而 SparseViT 通过稀疏机制从根源抑制该问题:

- 稀疏自注意力阻断了语义特征的全局关联,使模型无法形成完整的语义认知(如无法识别 “猫” 的整体语义),从而避免 “将语义边缘误判为篡改”;

- 定性实验显示(如图 5 所示),在包含复杂语义的篡改图像中(如人物拼接场景),TruFor、CAT-Net 等模型存在明显的语义假阳性,而 SparseViT 的预测掩码仅覆盖真实篡改区域,假阳性率降低 40% 以上。

02 一键论文复现

您可以跳转到Lab4AI.cn上进行查看。👉Lab4AI大模型实验室论文复现

- Lab4AI.cn提供免费的AI翻译和AI导读工具辅助论文阅读;

- 支持投稿复现,动手复现感兴趣的论文;

- 论文复现完成后,您可基于您的思路和想法,开启论文创新。

浙公网安备 33010602011771号

浙公网安备 33010602011771号