分布式微服务项目随手笔记

1 无论是使用数组还是 List

是的,在 Spring Boot 中,无论是使用数组还是 List 集合,Spring 的 HTTP 消息转换器都能够处理并映射复杂的 JSON 数据。这得益于 Spring 框架使用的 Jackson 库(或其他可配置的 JSON 处理库),它能够智能地将 JSON 数据绑定到 Java 对象上。

考虑到您提供的复杂 JSON 数据,您可以根据需要在您的 Spring Boot 应用程序中定义相应的 Java 类,并使用数组或 List 集合来接收嵌套的数组数据。Spring Boot 会自动处理 JSON 到 Java 对象的映射,不管目标类型是数组还是 List。

例如,假设您有以下的 JSON 结构:

{

"baseAttrs": [

{"attrId": 1, "attrValues": "非触摸屏", "showDesc": 1},

{"attrId": 2, "attrValues": "LED显示", "showDesc": 1}

],

"skus": [

{

"attr": [

{"attrId": 11, "attrName": "面积~~", "attrValue": "100*100"},

{"attrId": 15, "attrName": "颜色", "attrValue": "黑色"}

],

"skuName": "海信电视-01 100*100 黑色"

}

]

}

您可以定义相应的 Java 类来接收这个 JSON 数据,如下:

public class Product {

private List<BaseAttr> baseAttrs;

private Sku[] skus;

// getters and setters

}

public class BaseAttr {

private int attrId;

private String attrValues;

private int showDesc;

// getters and setters

}

public class Sku {

private List<Attr> attr;

private String skuName;

// getters and setters

}

public class Attr {

private int attrId;

private String attrName;

private String attrValue;

// getters and setters

}

在这个例子中,baseAttrs 使用了 List 集合,而 skus 使用了数组。这展示了在同一个对象中同时使用 List 和数组是完全可行的。Spring Boot 在处理 POST 请求并将 JSON 数据映射到这些 Java 对象时,会自动根据定义的类型(数组或 List)来处理数据。

因此,不论是选择使用数组还是 List,只要确保您的 Java 类结构与前端发送的 JSON 数据结构相匹配,Spring Boot 都能够正确地映射这些数据。

@RequestBody 注解在 Spring Framework 中用于将 HTTP 请求体的内容绑定到控制器方法的参数上。当使用此注解时,Spring 的 HTTP 消息转换器会自动将请求体中的内容(通常是 JSON 或 XML)解析并映射到指定的 Java 对象上。这个过程是自动的,依赖于 Spring Boot 配置的消息转换器,通常是基于 Jackson 或 Gson 库进行 JSON 数据的序列化和反序列化。

这里是一个更精确且全面的描述:

@RequestBody 注解主要用于处理 HTTP POST 和 PUT 请求,它告诉 Spring 框架的调度器,方法参数应该被绑定到 Web 请求的体部。这个注解使得控制器能够接收复杂类型的数据结构(如自定义的 Java 对象),而非仅仅是请求参数或路径变量。Spring 框架通过使用配置的 HTTP 消息转换器自动地将请求体内容转换为相应的 Java 类型,从而简化了数据绑定的过程。转换过程不仅限于 JSON,还支持其他格式如 XML,但具体支持哪些格式取决于应用程序上下文中配置的消息转换器。

使用 List 集合的控制器接口示例

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RestController;

import java.util.List;

@RestController

public class ProductController {

@PostMapping("/products")

public String addProducts(@RequestBody List<Product> products) {

// 处理接收到的产品列表

return "Products added";

}

}

使用数组的控制器接口示例

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class ProductController {

@PostMapping("/products")

public String addProducts(@RequestBody Product[] products) {

// 处理接收到的产品数组

return "Products added";

}

}

在这两个示例中,无论是接收一个 List 集合还是一个数组,@RequestBody 注解都能够确保请求体中的数据被正确地解析并映射到相应的 Java 对象上。选择使用哪一种数据结构取决于你的具体需求和偏好。

2 前端使用json数组发出数据,后端可以使用数组或者List集合进行接收

是的,前端发送的 JSON 数据的形式可以对应到后端的不同实体类结构上,无论这些结构是数组还是 List 集合。关键是后端定义的实体类(或数据传输对象DTO)需要能够与前端发送的 JSON 数据结构相匹配。Spring Boot 的 @RequestBody 注解和背后的消息转换机制负责将接收到的 JSON 数据映射到相应的 Java 类型上。

这意味着:

-

如果前端发送的是一个 JSON 对象数组(即 JSON 中的一个数组),后端可以选择将这个数组映射到 Java 中的数组类型或是一个

List集合。选择哪一个主要取决于后端处理数据的需求和偏好。 -

如果后端期望的是一个

List集合,你只需在控制器方法的参数中使用List类型。Spring 将自动将 JSON 数组转换成相应的List集合。 -

相似地,如果后端期望的是数组类型,那么在控制器方法的参数中直接使用数组类型即可。Spring 同样能够处理这种映射。

示例说明

假设前端发送如下格式的 JSON 数组:

[

{

"name": "产品A",

"price": 100

},

{

"name": "产品B",

"price": 200

}

]

后端可以使用以下任一方式接收数据:

使用 List 集合的控制器方法

@PostMapping("/addProducts")

public ResponseEntity<?> addProducts(@RequestBody List<Product> products) {

// 这里处理产品列表

return ResponseEntity.ok("Received products");

}

使用数组的控制器方法

@PostMapping("/addProducts")

public ResponseEntity<?> addProducts(@RequestBody Product[] products) {

// 这里处理产品数组

return ResponseEntity.ok("Received products");

}

在这两种情况下,只要 Product 类的属性与前端发送的 JSON 数据中的键匹配,Spring 都能够正确地将数据映射到 Java 对象上。

因此,确实,前端使用 JSON 数组发出数据时,后端可以灵活选择使用数组或者 List 集合进行接收,主要确保数据结构之间能夠对应上即可。

3 前端发送的 JSON 中包含"skus": [](一个空数组)或者没有发送skus字段的区别

如果后端是这样声明变量的:

private List<Skus> skus;

并且没有在类的构造函数中或者直接在声明时对 skus 进行初始化,那么接收到的行为将取决于前端发送的 JSON 数据:

-

如果前端发送的 JSON 中包含

"skus": [](一个空数组),那么skus会被初始化为一个空的List。在这种情况下,skus.size()为0,表明列表中没有元素。 -

如果前端发送的 JSON 中根本没有

skus字段,那么skus属性将保持为null,除非你在某处(比如在类的构造函数中或者在声明时)显式地对它进行了初始化。

为了确保 skus 不会是 null,从而避免潜在的 NullPointerException,推荐在声明时就对其进行初始化,如下所示:

private List<Skus> skus = new ArrayList<>();

这样做的好处是,无论前端是否发送 skus 字段,或者该字段是否为空数组,后端处理时都不需要担心 skus 为 null 的情况,可以直接使用 skus 进行操作(如遍历、添加元素等),这会使代码更加简洁和健壮。

对于实际开发中,通常建议对于此类可能由前端发送的集合类型的属性,在后端声明时进行初始化,这样可以减少在使用这些属性时需要进行 null 检查的情况,使得代码更加清晰易读。

4

1 登录到Linux的指令

#进入目录 D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7

#在该目录下进入到cmd命令台输入vagrant up 开启Linux虚拟机系统

#启动Linux虚拟机

vagrant up

#关闭Linux虚拟机

vagrant halt

#进入目录 D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7

#在该目录下进入到cmd命令台输入vagrant ssh 登录到Linux系统

#使用ssh连接到Linux虚拟机 默认用户名是vagrant

vagrant ssh

#退出ssh连接

exit

D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7>vagrant init centos/7

==> vagrant: A new version of Vagrant is available: 2.4.1 (installed version: 2.2.18)!

==> vagrant: To upgrade visit: https://www.vagrantup.com/downloads.html

A `Vagrantfile` has been placed in this directory. You are now

ready to `vagrant up` your first virtual environment! Please read

the comments in the Vagrantfile as well as documentation on

`vagrantup.com` for more information on using Vagrant.

D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7>vagrant up

Bringing machine 'default' up with 'virtualbox' provider...

==> default: Box 'centos/7' could not be found. Attempting to find and install...

default: Box Provider: virtualbox

default: Box Version: >= 0

==> default: Loading metadata for box 'centos/7'

default: URL: https://vagrantcloud.com/centos/7

==> default: Adding box 'centos/7' (v2004.01) for provider: virtualbox

default: Downloading: https://vagrantcloud.com/centos/boxes/7/versions/2004.01/providers/virtualbox/unknown/vagrant.

box

Download redirected to host: cloud.centos.org

default:

default: Calculating and comparing box checksum...

==> default: Successfully added box 'centos/7' (v2004.01) for 'virtualbox'!

==> default: Importing base box 'centos/7'...

==> default: Matching MAC address for NAT networking...

==> default: Checking if box 'centos/7' version '2004.01' is up to date...

==> default: Setting the name of the VM: vbcentos7_default_1707581882874_11921

==> default: Clearing any previously set network interfaces...

==> default: Preparing network interfaces based on configuration...

default: Adapter 1: nat

==> default: Forwarding ports...

default: 22 (guest) => 2222 (host) (adapter 1)

==> default: Booting VM...

==> default: Waiting for machine to boot. This may take a few minutes...

default: SSH address: 127.0.0.1:2222

default: SSH username: vagrant

default: SSH auth method: private key

default:

default: Vagrant insecure key detected. Vagrant will automatically replace

default: this with a newly generated keypair for better security.

default:

default: Inserting generated public key within guest...

default: Removing insecure key from the guest if it's present...

default: Key inserted! Disconnecting and reconnecting using new SSH key...

==> default: Machine booted and ready!

==> default: Checking for guest additions in VM...

default: No guest additions were detected on the base box for this VM! Guest

default: additions are required for forwarded ports, shared folders, host only

default: networking, and more. If SSH fails on this machine, please install

default: the guest additions and repackage the box to continue.

default:

default: This is not an error message; everything may continue to work properly,

default: in which case you may ignore this message.

==> default: Rsyncing folder: /cygdrive/d/Java_developer_tools/DistributedMicroservicesProject/vbcentos7/ => /vagrant

D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7>vagrant ssh

[vagrant@localhost ~]$ pwd

/home/vagrant

[vagrant@localhost ~]$ ls

[vagrant@localhost ~]$ cd /

[vagrant@localhost /]$ ls

bin dev home lib64 mnt proc run srv sys usr var

boot etc lib media opt root sbin swapfile tmp vagrant

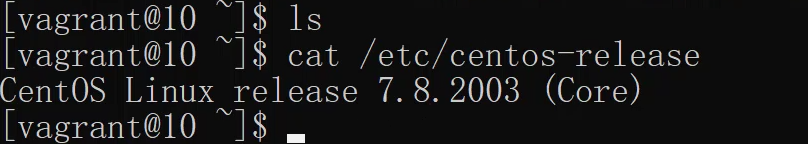

[vagrant@localhost /]$ cat /etc/centos-release

CentOS Linux release 7.8.2003 (Core)

[vagrant@localhost /]$ exit

logout

Connection to 127.0.0.1 closed.

D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7>

查看当前版本CentOS Linux 版本 cat /etc/centos-release

要关闭使用 Vagrant 启动的 CentOS 7 虚拟机,您可以使用 vagrant halt 命令。这个命令会优雅地关闭虚拟机,确保所有的进程都正确地停止,并且虚拟机状态被安全地保存。

在您的项目目录(在这个例子中是 D:\Java_developer_tools\DistributedMicroservicesProject\vbcentos7)下打开命令行界面,然后运行以下命令:

vagrant halt

如果您想要暂时挂起虚拟机(保存其当前状态以便可以快速恢复),可以使用 vagrant suspend。要重新启动被挂起或停止的虚拟机,可以使用 vagrant up。 若要彻底删除虚拟机(包括其所有的文件和状态),可以使用 vagrant destroy。请注意,vagrant destroy 命令会移除虚拟机,如果你再次需要它,将必须重新创建和配置。

2 禁用Hyper-V

禁用Hyper-V可以通过几种不同的方法完成,具体取决于您使用的Windows版本。下面是一些常用的方法:

通过Windows功能禁用

-

在搜索栏输入“Windows功能”,然后选择“打开或关闭Windows功能”。

-

在弹出的窗口中,找到“Hyper-V”,取消选中旁边的复选框。

-

点击“确定”按钮,然后根据提示重启计算机。

通过命令提示符禁用

-

以管理员身份打开命令提示符。可以在搜索栏输入“cmd”,然后右键“命令提示符”,选择“以管理员身份运行”。

-

在命令提示符窗口中,输入以下命令来禁用Hyper-V:

dism.exe /Online /Disable-Feature:Microsoft-Hyper-V

-

按照提示重启计算机以完成更改。

通过PowerShell禁用

-

以管理员身份打开PowerShell。可以在搜索栏输入“PowerShell”,然后右键“Windows PowerShell”,选择“以管理员身份运行”。

-

在PowerShell窗口中,输入以下命令来禁用Hyper-V:

Disable-WindowsOptionalFeature -Online -FeatureName Microsoft-Hyper-V-All

-

按照提示重启计算机以完成更改。

注意事项

-

禁用Hyper-V后,任何依赖于Hyper-V的功能或服务(如Windows沙盒、Windows子系统 for Linux 2 (WSL2))可能无法正常工作。

-

如果您的计算机上安装了其他虚拟化软件(如VirtualBox或VMware),禁用Hyper-V可能有助于解决兼容性问题。

-

在某些情况下,特别是在Windows 10或Windows 11上,您可能还需要禁用与虚拟化相关的其他功能,如虚拟机平台和Windows Hypervisor Platform。

在完成这些步骤之后,Hyper-V应该被禁用,您可以尝试重新使用VirtualBox或其他虚拟化软件。如果您决定在将来重新启用Hyper-V,只需按照上述步骤操作,但选择启用Hyper-V功能即可。

3 禁用Hyper-V会影响其他虚拟软件的启动吗?比如VMware

禁用Hyper-V对其他虚拟化软件(如VMware Workstation或Oracle VM VirtualBox)的影响取决于具体的虚拟化技术和软件版本。以下是一些可能的影响和考虑因素:

VMware Workstation

-

正面影响:禁用Hyper-V通常对VMware Workstation是有益的,尤其是在早期版本中。因为Hyper-V是一种类型1虚拟化技术,而VMware Workstation是类型2,两者同时运行可能会引起冲突。禁用Hyper-V可以提高VMware的性能和兼容性。

-

启用VT-x/EPT或AMD-V/RVI:禁用Hyper-V后,确保在BIOS/UEFI设置中启用了VT-x(对于Intel处理器)或AMD-V(对于AMD处理器)及其扩展(如EPT或RVI),这对于VMware正常工作是必要的。

Oracle VM VirtualBox

-

正面影响:对于VirtualBox,禁用Hyper-V也往往有好处。尽管VirtualBox从5.0版本开始提供了对Hyper-V作为后备执行引擎的支持,但这可能会降低性能。完全禁用Hyper-V可以让VirtualBox直接利用硬件虚拟化,从而提高性能。

-

版本兼容性:确保您使用的VirtualBox版本最优化地支持您的操作系统,尤其是在没有Hyper-V的情况下。

其他虚拟化软件

-

对于其他虚拟化软件,如QEMU、KVM(在Linux上)等,禁用Hyper-V不会直接影响它们的运行。这些软件通常使用不同的虚拟化技术,与Hyper-V的兼容性问题较少。

注意事项

-

操作系统功能:禁用Hyper-V可能会影响依赖于Hyper-V的Windows功能,如Windows沙箱和Windows子系统 for Linux(WSL 2)。这些功能需要Hyper-V来运行。

-

性能考虑:在某些情况下,如果您的工作或开发环境不依赖于Hyper-V特定的功能,禁用Hyper-V可能会带来性能上的提升。

-

软件版本:在禁用Hyper-V之前,请检查您所使用的虚拟化软件的文档,以确认其对Hyper-V的支持情况以及不使用Hyper-V时的推荐配置。

总的来说,禁用Hyper-V通常对使用VMware Workstation或VirtualBox等其他虚拟化软件有积极影响,特别是在解决兼容性问题和提高性能方面。然而,做出改变之前,请考虑任何依赖于Hyper-V的功能或服务。

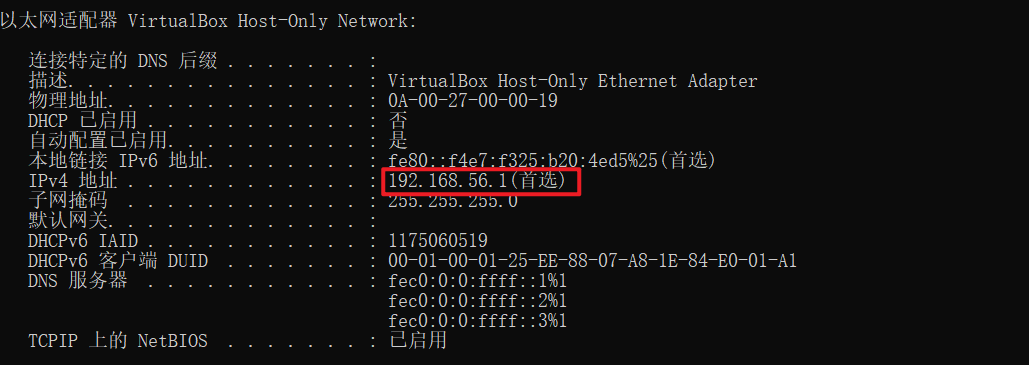

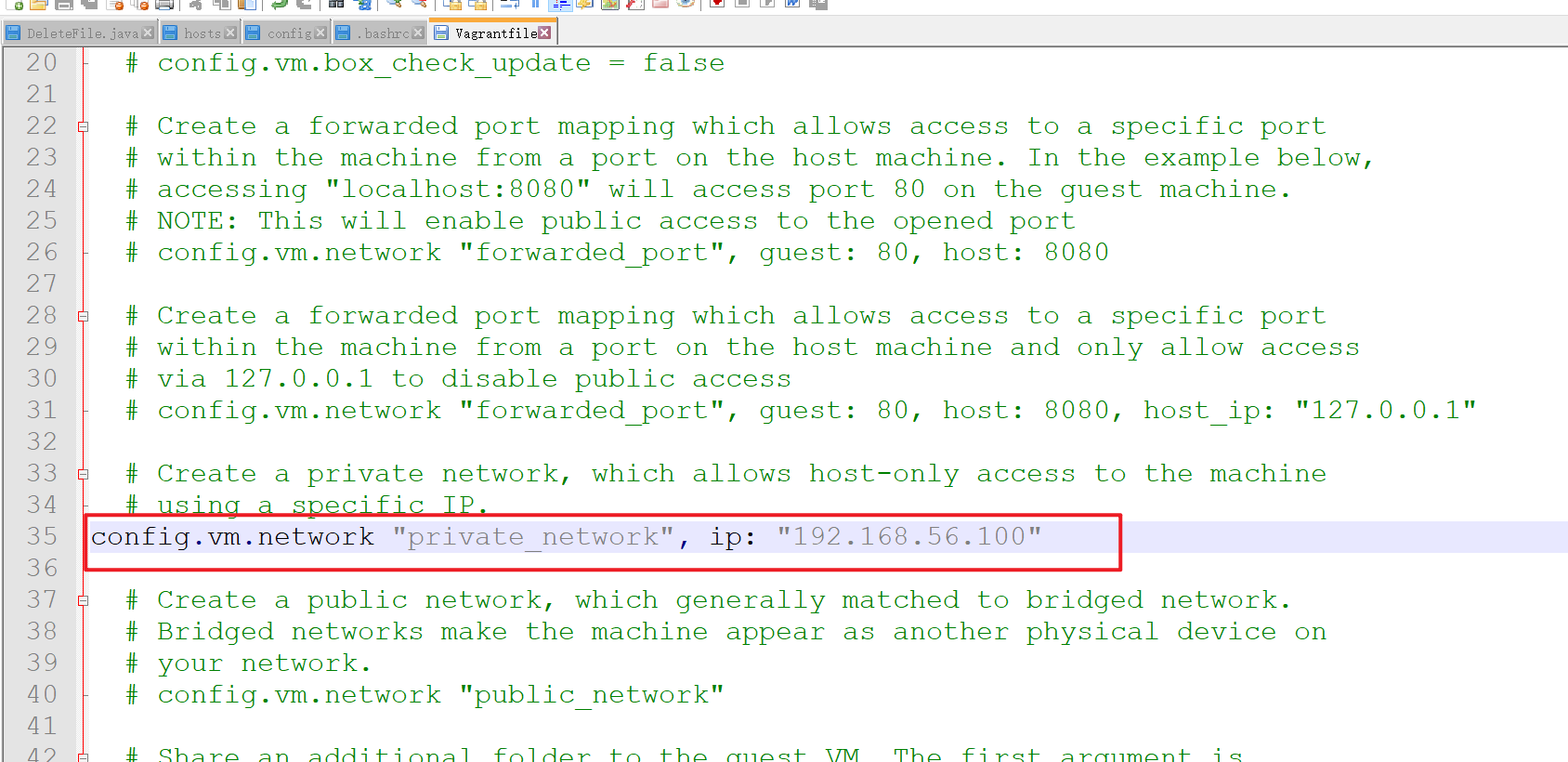

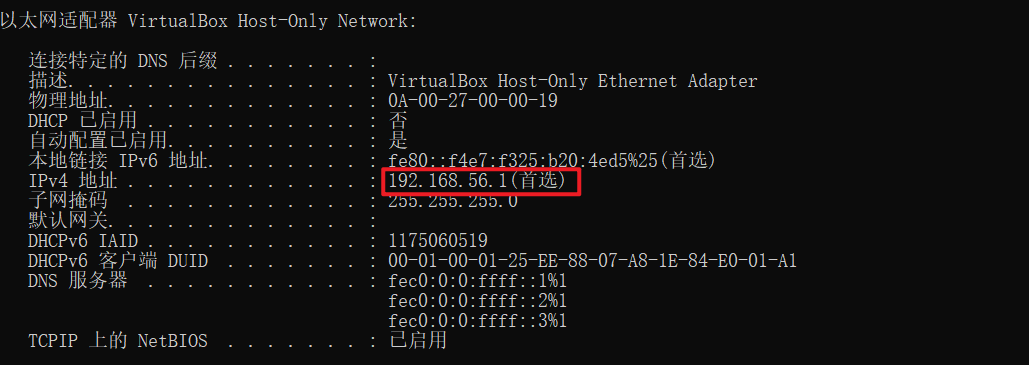

4 宿主机和Linux网络互通

windows宿主机在VirtualBox虚拟网络里的IP地址如下:192.168.56.1

使用命令行命令ipconfig /all

#windows真实的上网ip

192.168.0.13

#windows宿主机在VirtualBox虚拟网络里的IP

192.168.0.13

#vagrant配置的CentOS7.8 Linux 的ip

192.168.56.100

#重新加载vagrant配置文件

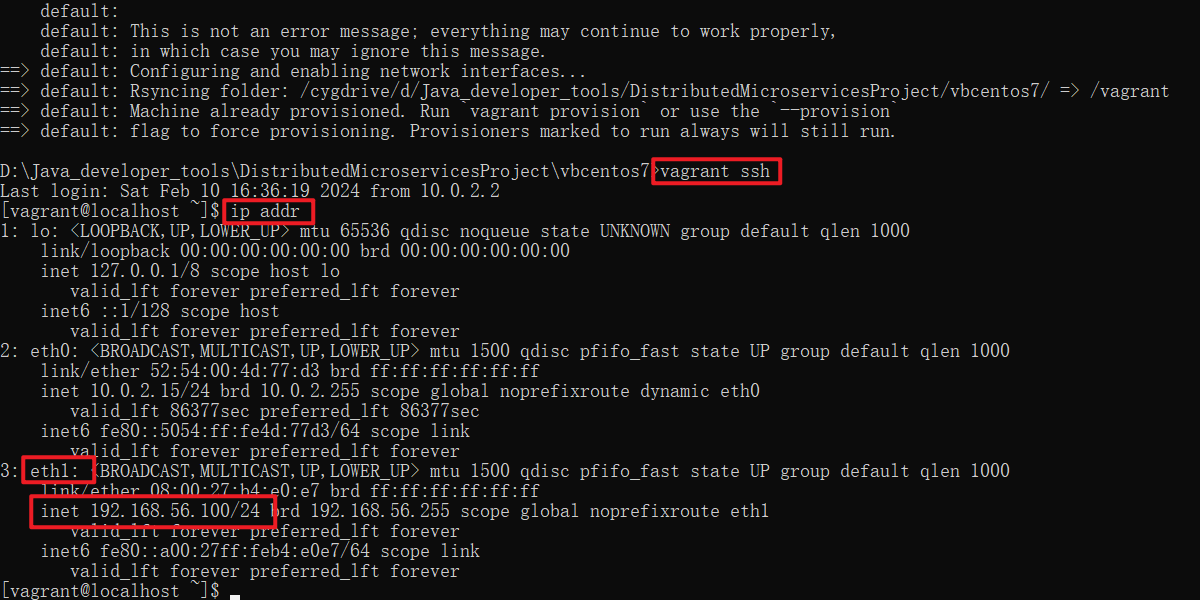

vagrant reload

#登录到Linux

vagrant ssh

#查看当前ip(注意ifconfig此时用不了,需要安装netTools)

ip addr

查看修改后的Linux虚拟机IP:

宿主机ping Linux虚拟机test1:

C:\Users\yangd>ping 192.168.56.100

正在 Ping 192.168.56.100 具有 32 字节的数据:

来自 192.168.56.100 的回复: 字节=32 时间<1ms TTL=255

来自 192.168.56.100 的回复: 字节=32 时间<1ms TTL=64

来自 192.168.56.100 的回复: 字节=32 时间<1ms TTL=64

来自 192.168.56.100 的回复: 字节=32 时间<1ms TTL=64

192.168.56.100 的 Ping 统计信息:

数据包: 已发送 = 4,已接收 = 4,丢失 = 0 (0% 丢失),

往返行程的估计时间(以毫秒为单位):

最短 = 0ms,最长 = 0ms,平均 = 0ms

C:\Users\yangd>

Linux虚拟机ping windows宿主机在VirtualBox虚拟网络里的IP:192.168.56.1 test2:

[vagrant@localhost ~]$ ping 192.168.56.1

PING 192.168.56.1 (192.168.56.1) 56(84) bytes of data.

64 bytes from 192.168.56.1: icmp_seq=1 ttl=128 time=0.232 ms

64 bytes from 192.168.56.1: icmp_seq=2 ttl=128 time=0.208 ms

64 bytes from 192.168.56.1: icmp_seq=3 ttl=128 time=0.221 ms

64 bytes from 192.168.56.1: icmp_seq=4 ttl=128 time=0.207 ms

^C

--- 192.168.56.1 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3016ms

rtt min/avg/max/mdev = 0.207/0.217/0.232/0.010 ms

[vagrant@localhost ~]$

Linux虚拟机ping 宿主机 实际上网地址 test3: 测试虚拟机能否访问外部网络

[vagrant@localhost ~]$ ping 192.168.0.13

PING 192.168.0.13 (192.168.0.13) 56(84) bytes of data.

64 bytes from 192.168.0.13: icmp_seq=1 ttl=127 time=0.444 ms

64 bytes from 192.168.0.13: icmp_seq=2 ttl=127 time=0.426 ms

64 bytes from 192.168.0.13: icmp_seq=3 ttl=127 time=0.474 ms

64 bytes from 192.168.0.13: icmp_seq=4 ttl=127 time=0.423 ms

^C

--- 192.168.0.13 ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3026ms

rtt min/avg/max/mdev = 0.423/0.441/0.474/0.032 ms

[vagrant@localhost ~]$

--------------------------------------------------------

[vagrant@localhost ~]$ ping www.baidu.com

PING www.baidu.com (198.18.0.78) 56(84) bytes of data.

64 bytes from 198.18.0.78 (198.18.0.78): icmp_seq=1 ttl=63 time=0.451 ms

64 bytes from 198.18.0.78 (198.18.0.78): icmp_seq=2 ttl=63 time=0.489 ms

64 bytes from 198.18.0.78 (198.18.0.78): icmp_seq=3 ttl=63 time=0.495 ms

64 bytes from 198.18.0.78 (198.18.0.78): icmp_seq=4 ttl=63 time=0.482 ms

^C

--- www.baidu.com ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3003ms

rtt min/avg/max/mdev = 0.451/0.479/0.495/0.022 ms

[vagrant@localhost ~]$

5 如何使用yum安装netTools,使得Linux可以使用ifconfig命令呢?

要在基于Red Hat的Linux发行版(如RHEL, CentOS, Fedora等)上安装net-tools包(这个包包含了ifconfig命令),你可以使用yum(在较旧的版本中)或dnf(在较新的版本中,如Fedora和RHEL 8及以上版本)包管理器。以下是使用yum安装net-tools的步骤:

-

打开终端。

-

输入以下命令来安装

net-tools:sudo yum install net-tools

-

这条命令会提示你输入管理员密码,输入后按回车继续。

-

系统可能会询问你是否确认下载和安装,输入

y然后按回车确认。

-

安装完成后,你就可以使用ifconfig命令来查看网络接口的配置了。只需在终端中输入:

ifconfig

如果你的系统使用的是dnf包管理器(如在Fedora或RHEL 8及以上版本),安装命令略有不同:

sudo dnf install net-tools

以上步骤适用于大多数基于Red Hat的Linux发行版。如果你使用的是基于Debian的发行版(如Ubuntu),则需要使用apt包管理器来安装net-tools:

sudo apt-get update

sudo apt-get install net-tools

这些命令将确保你的系统能够使用ifconfig命令来管理和查看网络接口。

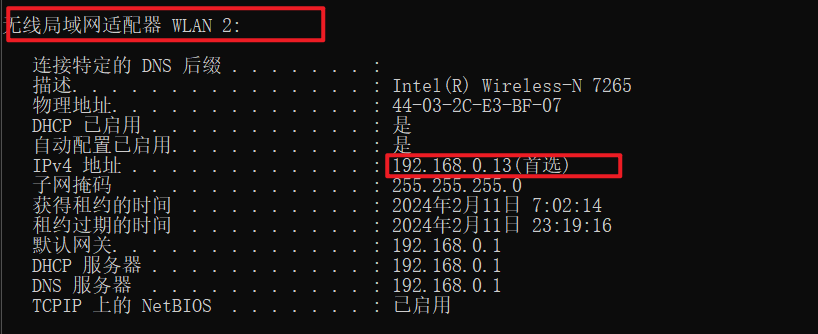

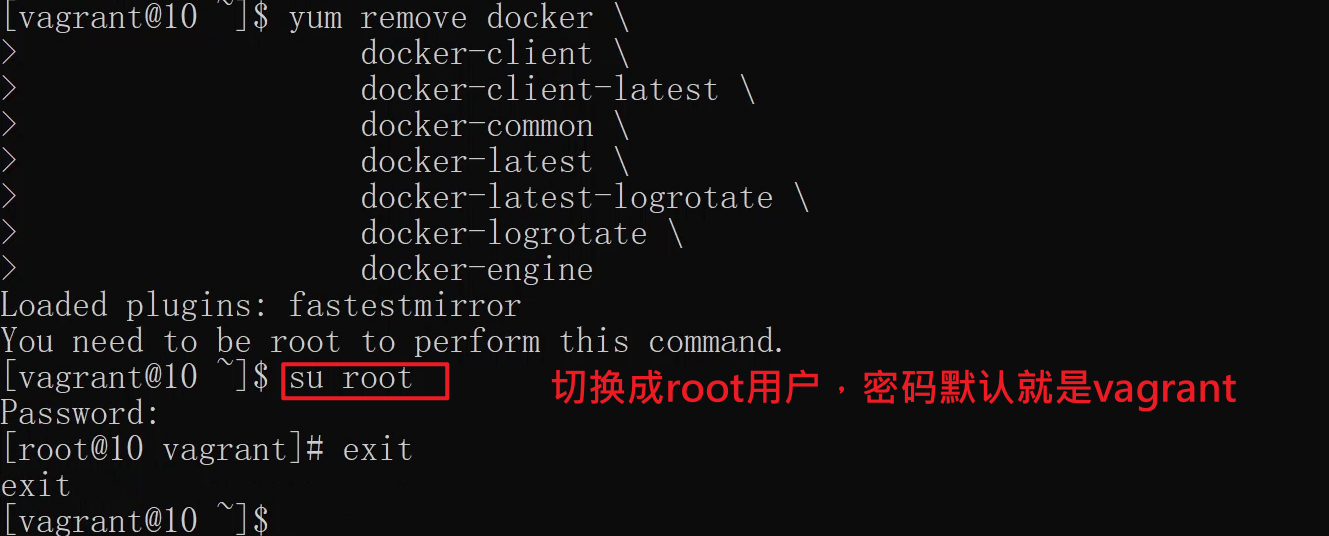

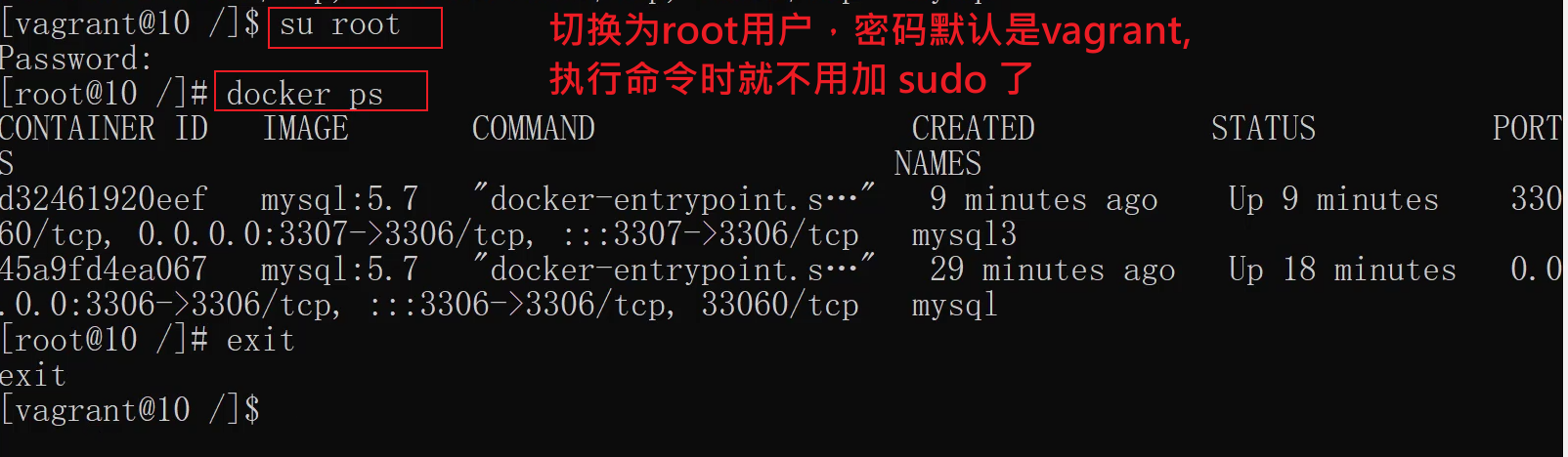

6 vagrant ssh登录后要切换成root用户,密码默认就是vagrant

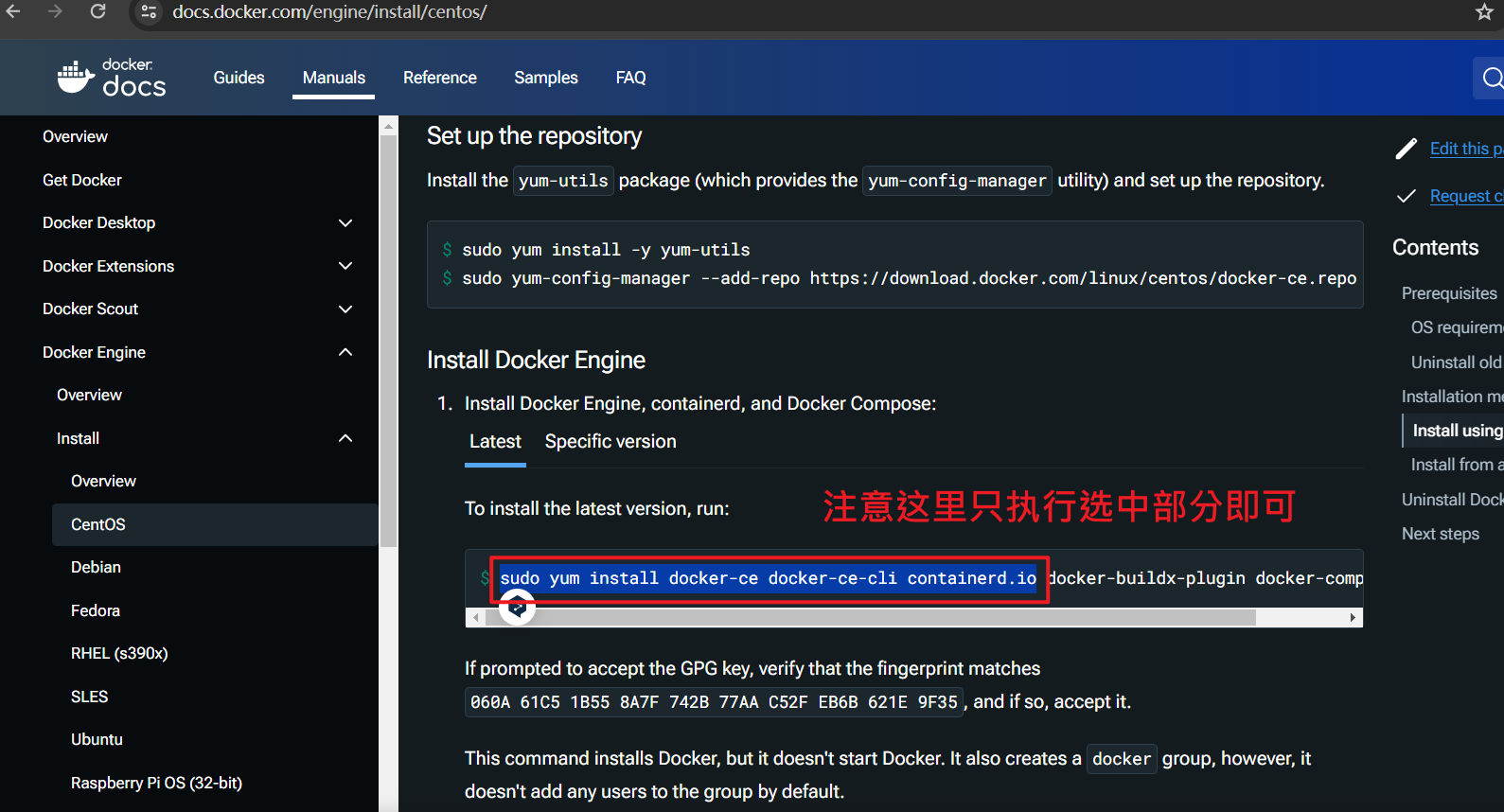

7 启动docker

#安装docker

https://docs.docker.com/engine/install/centos/

#安装命令执行$号后面的

$ sudo yum remove docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-engine

$ sudo yum install -y yum-utils

$ sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker- ce.repo

$ sudo yum install docker-ce docker-ce-cli containerd.io

安装完成

----------------------------------------------------

#启动docker

[vagrant@localhost ~]$ sudo systemctl start docker

#查看当前版本

[vagrant@localhost ~]$ docker -v

Docker version 25.0.3, build 4debf41

#查看当前安装的有哪些镜像

[vagrant@localhost ~]$ sudo docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

#设置docker自启动

[vagrant@localhost ~]$ sudo systemctl enable docker

Created symlink from /etc/systemd/system/multi-user.target.wants/docker.service to /usr/lib/systemd/system/docker.service.

[vagrant@localhost ~]$

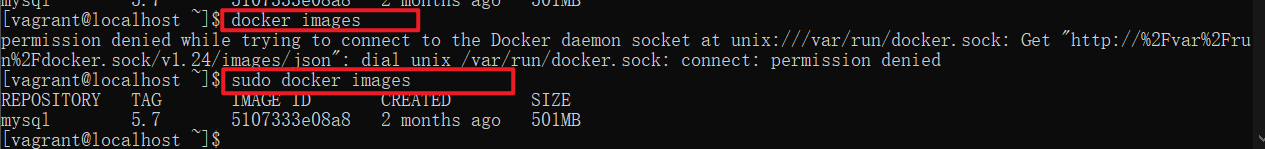

执行命令前面要加sudo ,否则执行失败,因为这里需要管理员权限

配置阿里云容器 镜像加速,作用是让我们用docker拉取国外docker镜像速度变快

https://cr.console.aliyun.com/cn-hangzhou/instances/mirrors

我这里没有配置!!

8 如何修改容器内部默认的3306端口呢?对于MySQL,这通常是3306。我想让它改变,如何做

要修改MySQL容器内部使用的默认端口(通常是3306)到另一个端口,你需要调整MySQL的配置文件。在Docker容器中,这通常意味着你需要采取以下步骤:

1. 创建自定义的MySQL配置文件

首先,创建一个自定义的MySQL配置文件,比如my.cnf(或者任何你想命名的文件),在该文件中指定新的端口配置。例如,如果你想将MySQL的端口改为3307,你的配置文件内容可能如下:

[mysqld]

port=3307

2. 使用Dockerfile创建自定义MySQL镜像

接下来,创建一个Dockerfile来构建一个包含你自定义配置的MySQL镜像。你的Dockerfile可能看起来像这样:

FROM mysql:latest

COPY my.cnf /etc/mysql/my.cnf

这个Dockerfile基于官方的MySQL镜像,将你的自定义配置文件复制到容器内适当的位置(/etc/mysql/my.cnf是MySQL的标准配置文件路径之一)。

3. 构建自定义MySQL镜像

在包含Dockerfile和my.cnf文件的目录下运行以下命令来构建你的自定义镜像:

docker build -t my-custom-mysql .

4. 运行你的自定义MySQL容器

最后,使用你的自定义镜像启动MySQL容器,并映射到新的端口。如果你将MySQL内部端口更改为3307,你也可能希望将容器的3307端口映射到宿主机的某个端口(这里以3307为例):

docker run -p 3307:3307 --name my-mysql -e MYSQL_ROOT_PASSWORD=my-secret-pw my-custom-mysql

注意

-

确保在

my.cnf配置文件中指定的端口与docker run命令中的端口映射相匹配。 -

修改容器内部服务的端口可能需要你调整任何依赖于这个服务的应用配置,以确保它们连接到正确的端口。

-

如果你还需要修改其他MySQL配置,可以在

my.cnf文件中添加这些配置项。

通过这种方式,你可以控制容器内部MySQL实例使用的端口,以及如何将其映射到宿主机上。

9 这里你提出的自定义端口的mysql镜像方式,是需要根据官方镜像重新复制一份新的镜像对吗?

是的,按照我之前描述的步骤,你会基于官方的MySQL镜像创建一个新的自定义镜像。这个过程涉及到创建一个包含你自定义配置(如端口号变更)的配置文件,然后通过编写一个Dockerfile来指定在构建自定义镜像时将这个配置文件复制到镜像内的正确位置。这样做的目的是为了让MySQL在容器启动时使用这个自定义配置,从而监听在一个非默认端口上。

这个过程实质上是创建了一个新的镜像,它在官方MySQL镜像的基础上添加了你的自定义配置。虽然这个新镜像包含了官方镜像的所有内容,但它会根据你提供的配置文件在启动时使用不同的设置(如不同的端口号)。

这种方法的好处是提供了灵活性和控制力,允许你根据需要调整MySQL的配置,而不仅仅是端口号。例如,你可以调整缓存大小、字符集或任何其他MySQL支持的配置选项。此外,通过创建自定义镜像,你可以确保你的配置更改会被版本控制和重用,这对于维护多个环境或需要在团队中共享配置的情况特别有用。

要注意的是,每当官方MySQL镜像更新时,你可能需要重新构建你的自定义镜像以获取最新的安全修复和功能更新。这是管理自定义Docker镜像时的一个常见考虑因素。

10 拉取mysql镜像并启动

#需要执行的命令

sudo docker pull mysql:5.7

sudo docker images

#下面这个老韩给的代码不好使

sudo docker run -p 3306:3306 --name mysql \

-v /mydata/mysql/log:/var/log/mysql \

-v /mydata/mysql/data:/var/lib/mysql \

-v /mydata/mysql/conf:/etc/mysql \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7

#下面这个好使

sudo docker run -p 3306:3306 --name mysql -v /mydata/mysql/log:/var/log/mysql -v /mydata/mysql/data:

/var/lib/mysql -v /mydata/mysql/conf:/etc/mysql/conf.d -e MYSQL_ROOT_PASSWORD=root -d mysql:5.7

#下面这个好使,是上面这个调整格式后的代码,区别就是加了一层目录`/conf.d`,目录没有会自动创建

sudo docker run -p 3306:3306 --name mysql \

-v /mydata/mysql/log:/var/log/mysql \

-v /mydata/mysql/data:/var/lib/mysql \

-v /mydata/mysql/conf:/etc/mysql/conf.d \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7

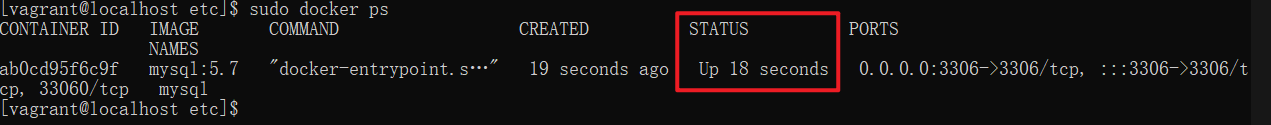

#查看mysql容器是否启动成功,即看STATUS是否显示为UP

sudo docker ps

#启动mysql容器 下面这里的mysql 注意代表的是容器的名称!!

sudo docker start mysql

#重启mysql容器

sudo docker restart mysql

#停止mysql容器

sudo docker stop mysql

# 进入到mysql镜像(独立的Linux环境)的命令

sudo docker exec -it mysql /bin/bash

# 从Docker守护进程中删除一个名为 `mysql` 的容器。

sudo docker rm mysql

------------------------------------------------

#过程演示

[vagrant@localhost ~]$ sudo docker pull mysql:5.7

5.7: Pulling from library/mysql

20e4dcae4c69: Pull complete

1c56c3d4ce74: Pull complete

e9f03a1c24ce: Pull complete

68c3898c2015: Pull complete

6b95a940e7b6: Pull complete

90986bb8de6e: Pull complete

ae71319cb779: Pull complete

ffc89e9dfd88: Pull complete

43d05e938198: Pull complete

064b2d298fba: Pull complete

df9a4d85569b: Pull complete

Digest: sha256:4bc6bc963e6d8443453676cae56536f4b8156d78bae03c0145cbe47c2aad73bb

Status: Downloaded newer image for mysql:5.7

docker.io/library/mysql:5.7

[vagrant@localhost ~]$ docker images

permission denied while trying to connect to the Docker daemon socket at unix:///var/run/docker.sock: Get "http://%2Fvar%2Fru

n%2Fdocker.sock/v1.24/images/json": dial unix /var/run/docker.sock: connect: permission denied

[vagrant@localhost ~]$ sudo docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

mysql 5.7 5107333e08a8 2 months ago 501MB

[vagrant@localhost ~]$ docker images

permission denied while trying to connect to the Docker daemon socket at unix:///var/run/docker.sock: Get "http://%2Fvar%2Fru

n%2Fdocker.sock/v1.24/images/json": dial unix /var/run/docker.sock: connect: permission denied

[vagrant@localhost ~]$ sudo docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

mysql 5.7 5107333e08a8 2 months ago 501MB

#下面老韩给的代码不好使

[vagrant@localhost ~]$ sudo docker run -p 3306:3306 --name mysql \

> -v /mydata/mysql/log:/var/log/mysql \

> -v /mydata/mysql/data:/var/lib/mysql \

> -v /mydata/mysql/conf:/etc/mysql \

> -e MYSQL_ROOT_PASSWORD=root \

> -d mysql:5.7

6bf06073853939b6fc870258547e61a40a6d6ec02975df3f76cfc0bf98fbb1e6

[vagrant@localhost ~]$

[vagrant@localhost ~]$ sudo docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

#使用下面的代码好使,猜测mysql5.7 更新后目录结构改变了

[vagrant@localhost etc]$ sudo docker run -p 3306:3306 --name mysql -v /mydata/mysql/log:/var/log/mysql -v /mydata/mysql/data:

/var/lib/mysql -v /mydata/mysql/conf:/etc/mysql/conf.d -e MYSQL_ROOT_PASSWORD=root -d mysql:5.7

ab0cd95f6c9f883f34c2c0fb93f80e27e9bb1ce8e81e44bf235e7d43fb3b5bb4

[vagrant@localhost etc]$ sudo docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS

NAMES

ab0cd95f6c9f mysql:5.7 "docker-entrypoint.s…" 19 seconds ago Up 18 seconds 0.0.0.0:3306->3306/tcp, :::3306->3306/t

cp, 33060/tcp mysql

[vagrant@localhost etc]$

# 进入到mysql镜像(独立的Linux环境)的命令

[vagrant@localhost etc]$ sudo docker exec -it mysql /bin/bash

bash-4.2# ls

bin dev entrypoint.sh home lib64 mnt proc run srv tmp var

boot docker-entrypoint-initdb.d etc lib media opt root sbin sys usr

bash-4.2# cd /

bash-4.2# ls

bin dev entrypoint.sh home lib64 mnt proc run srv tmp var

boot docker-entrypoint-initdb.d etc lib media opt root sbin sys usr

bash-4.2# mysql -u root -p

Enter password:

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 2

Server version: 5.7.44 MySQL Community Server (GPL)

Copyright (c) 2000, 2023, Oracle and/or its affiliates.

Oracle is a registered trademark of Oracle Corporation and/or its

affiliates. Other names may be trademarks of their respective

owners.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| sys |

+--------------------+

4 rows in set (0.00 sec)

mysql> exit;

Bye

#当前登录的用户是root

bash-4.2# whoami

root

bash-4.2#

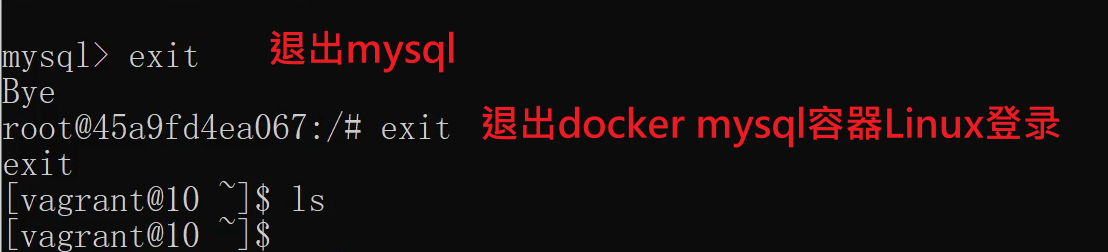

#退出docker容器 mysql镜像的内部Linux系统 `exit`

bash-4.2# exit

exit

[vagrant@localhost etc]$

启动成功如下

11 Docker mysql容器常用命令

#下面这个好使,是上面这个调整格式后的代码,区别就是加了一层目录`/conf.d`,目录没有会自动创建

sudo docker run -p 3306:3306 --name mysql \

-v /mydata/mysql/log:/var/log/mysql \

-v /mydata/mysql/data:/var/lib/mysql \

-v /mydata/mysql/conf:/etc/mysql/conf.d \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7

#同一个mysql5.7镜像可以支持运行多个mysql容器

sudo docker run -p 3307:3306 --name mysql2 \

-v /mydata2/mysql/log:/var/log/mysql \

-v /mydata2/mysql/data:/var/lib/mysql \

-v /mydata2/mysql/conf:/etc/mysql/conf.d \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7

#查看mysql容器是否启动成功,即看STATUS是否显示为UP

sudo docker ps

#启动mysql容器 下面这里的mysql 注意代表的是容器的名称!!

sudo docker start mysql

#重启mysql容器

sudo docker restart mysql

#停止mysql容器

sudo docker stop mysql

# 进入到mysql镜像(独立的Linux环境)的命令,这里的`mysql`,是容器名称

sudo docker exec -it mysql /bin/bash

# 从Docker守护进程中删除一个名为 `mysql` 的容器。

sudo docker rm mysql

12 vagrant ssh登录Linux后切换为root用户,密码默认是vagrant,执行命令时就不用加 sudo 了

13 同一个mysql5.7镜像可以支持运行多个mysql容器

[vagrant@localhost ~]$ sudo docker run -p 3307:3306 --name mysql2 \

> -v /mydata2/mysql/log:/var/log/mysql \

> -v /mydata2/mysql/data:/var/lib/mysql \

> -v /mydata2/mysql/conf:/etc/mysql/conf.d \

> -e MYSQL_ROOT_PASSWORD=root \

> -d mysql:5.7

640aefa27b71113d2b82bdfbb54d9c8dafb5bc8b946ff009c19be352e189e65e

[vagrant@localhost ~]$ sudo docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

640aefa27b71 mysql:5.7 "docker-entrypoint.s…" 12 seconds ago Up 10 seconds 33060/tcp, 0.0.0.0:3307->3306/tcp, :::3307->3306/tcp mysql2

ab0cd95f6c9f mysql:5.7 "docker-entrypoint.s…" 58 minutes ago Up 17 minutes 0.0.0.0:3306->3306/tcp, :::3306->3306/tcp, 33060/tcp mysql

[vagrant@localhost ~]$ sudo docker stop mysql2

mysql2

[vagrant@localhost ~]$ sudo docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

ab0cd95f6c9f mysql:5.7 "docker-entrypoint.s…" 59 minutes ago Up 18 minutes 0.0.0.0:3306->3306/tcp, :::3306->3306/tcp, 33060/tcp mysql

[vagrant@localhost ~]$

14 Docker 删除名为 mysql 的容器,命令 sudo docker rm mysql

命令 sudo docker rm mysql 用于从Docker守护进程中删除一个名为 mysql 的容器。这里的各个部分含义如下:

-

sudo: 由于Docker守护进程通常需要超级用户权限来执行操作,sudo命令确保了当前命令以超级用户(或root用户)的权限运行。这可以确保命令有足够的权限对Docker守护进程进行容器的删除操作。 -

docker: 这是执行Docker命令行工具的调用命令,用于与Docker守护进程进行交互。 -

rm: 这是Docker命令行工具的一个子命令,用于删除一个或多个容器。使用rm命令时,你需要指定要删除的容器的名称或ID。 -

mysql: 这是要删除的Docker容器的名称。在这个例子中,容器名称为mysql。你也可以使用容器的ID代替名称来指定要删除的容器。

执行 sudo docker rm mysql 命令时,Docker会尝试删除名为 mysql 的容器。如果容器正在运行,这个命令会失败,因为默认情况下,Docker不允许删除正在运行的容器。如果你想强制删除一个正在运行的容器,可以使用 -f 或 --force 选项,如 sudo docker rm -f mysql。

请注意,在删除容器之前,确保你已经备份了容器内任何重要的数据或配置,因为一旦容器被删除,所有与容器相关的数据和配置都将丢失。

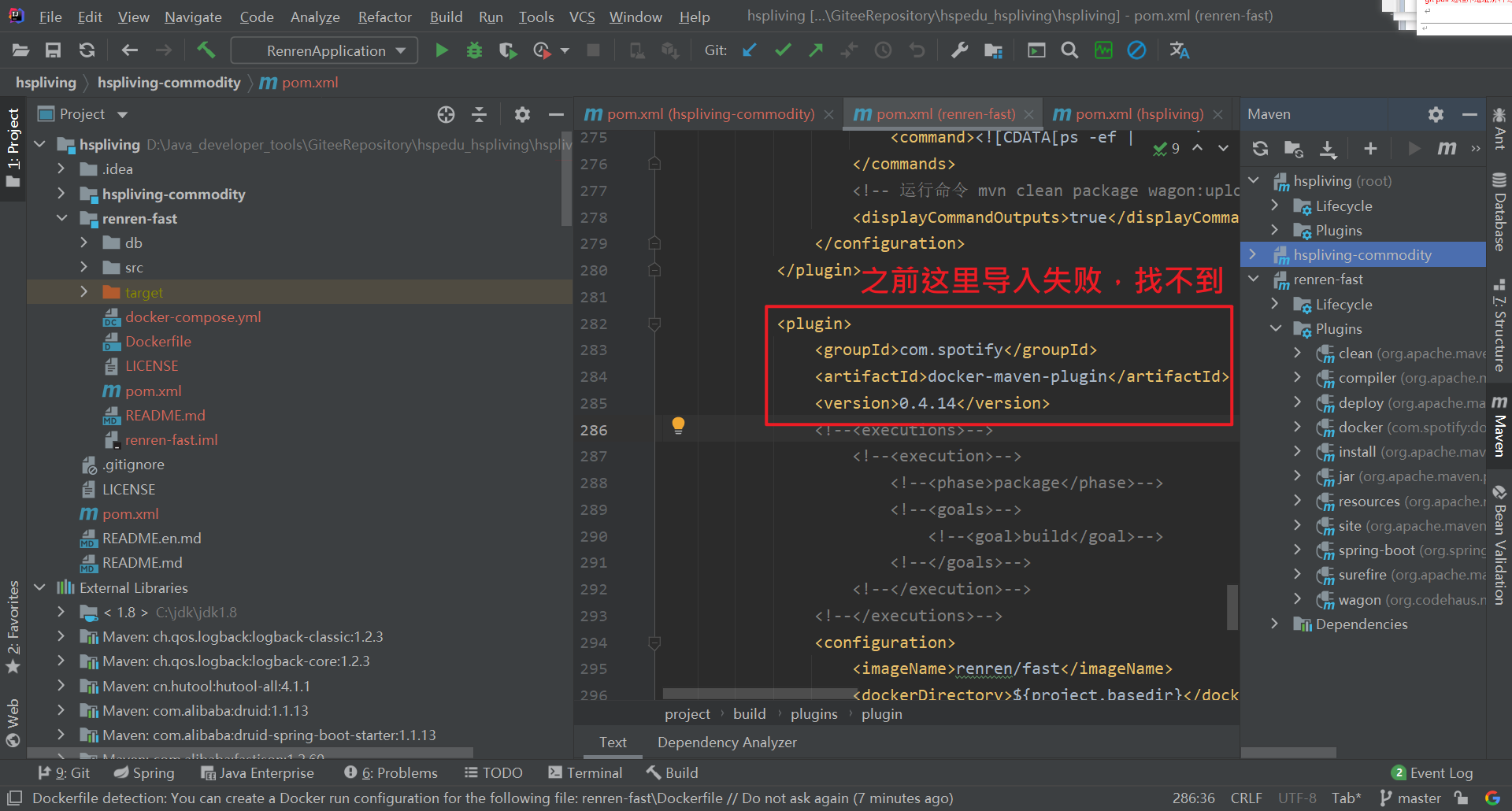

15 后端环境搭建

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.hspedu.hspliving</groupId>

<artifactId>hspliving-commodity</artifactId>

<version>1.0-SNAPSHOT</version>

<!--导入springboot 父工程-规定写法-->

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.8.RELEASE</version>

<!--<relativePath/> <!– lookup parent from repository –>-->

</parent>

<name>hspliving-commodity</name>

<description>顺平(家居生活)-商品模块</description>

<properties>

<java.version>1.8</java.version>

<spring-cloud.version>2020.0.5</spring-cloud.version>

</properties>

<!--引入相关的依赖-->

<dependencies>

<!--导入web项目场景启动器: 会自动导入和web开发相关的所有依赖[库/jar]

后面老师还会说spring-boot-starter-web 到底引入哪些相关依赖

web项目场景启动器,这里是真正的引入了依赖

starter-web 版本不需要指定 在父工程已经指定好了

-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!--引入test starter -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<!--只在test模块生效-->

<scope>test</scope>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

</project>

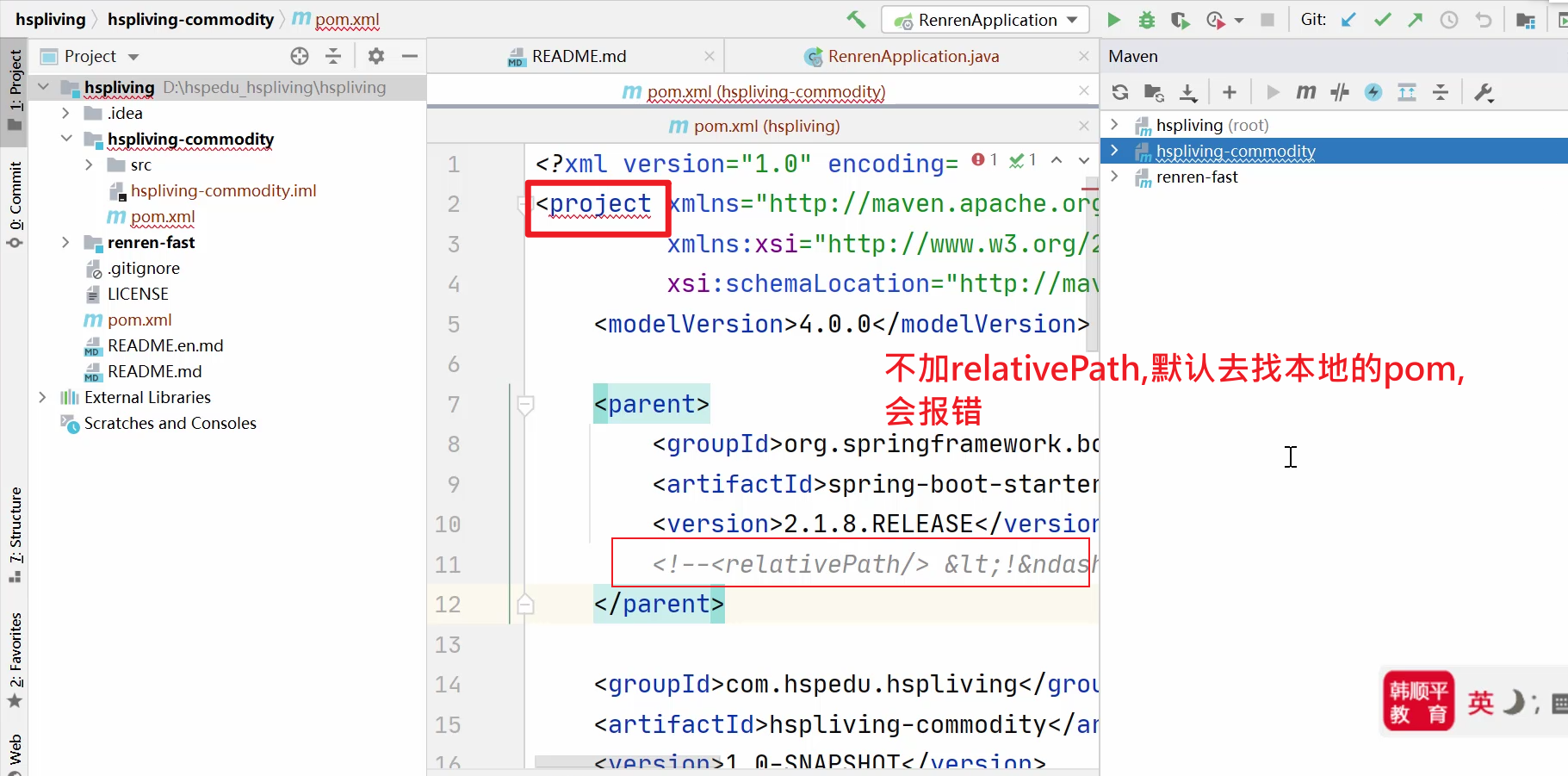

16 解释Maven relativePath元素标签

在Maven项目中,relativePath元素通常用于<parent>标签内,指定父POM(Project Object Model)文件的位置。Maven是一个项目管理和构建自动化工具,它使用POM文件(pom.xml)来管理项目的构建、依赖、插件等。

当一个Maven项目是另一个项目的子项目时,子项目的POM文件中会包含对父项目的引用。这个引用通过<parent>标签来实现,其中包含父项目的groupId、artifactId、version,以及可选的relativePath元素。relativePath元素用于指定父POM文件相对于子项目POM文件的路径。

作用

-

默认行为:如果不指定

relativePath,Maven默认会查找子项目目录的../pom.xml作为父POM。这是因为默认的relativePath值是../pom.xml,假设父项目和子项目在文件系统中是相邻的目录结构。 -

自定义位置:通过显式设置

relativePath,你可以指定一个不同的位置来查找父POM。这在父项目不位于默认位置时非常有用。 -

避免查找:如果设置

<relativePath/>(即空的relativePath元素),Maven将不会在文件系统中查找父POM。这在父POM仅通过Maven仓库可用时很有帮助,而不是通过文件系统的相对路径。

示例

<parent>

<groupId>com.example</groupId>

<artifactId>parent-project</artifactId>

<version>1.0.0</version>

<relativePath>../parent-project/pom.xml</relativePath> <!-- 自定义父POM位置 -->

</parent>

在这个例子中,relativePath指向一个自定义的路径,其中父项目的pom.xml文件位于子项目的../parent-project/目录下。如果父项目的POM文件不在标准位置,或者你希望从一个特定位置引用父POM,这种方式非常有用。

总之,relativePath在Maven项目中是一个灵活的元素,它允许开发者指定父项目POM文件的位置,无论是在本地文件系统中还是在远程仓库中。这有助于维护项目间的层次结构和依赖关系。

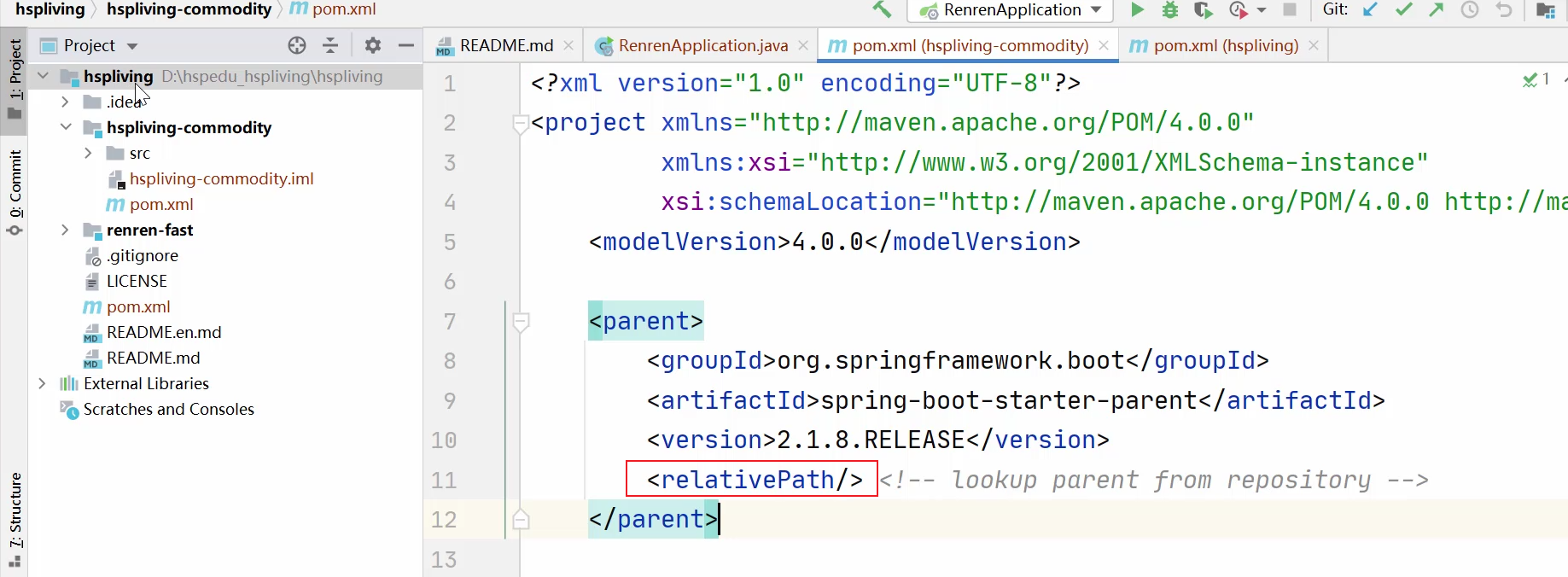

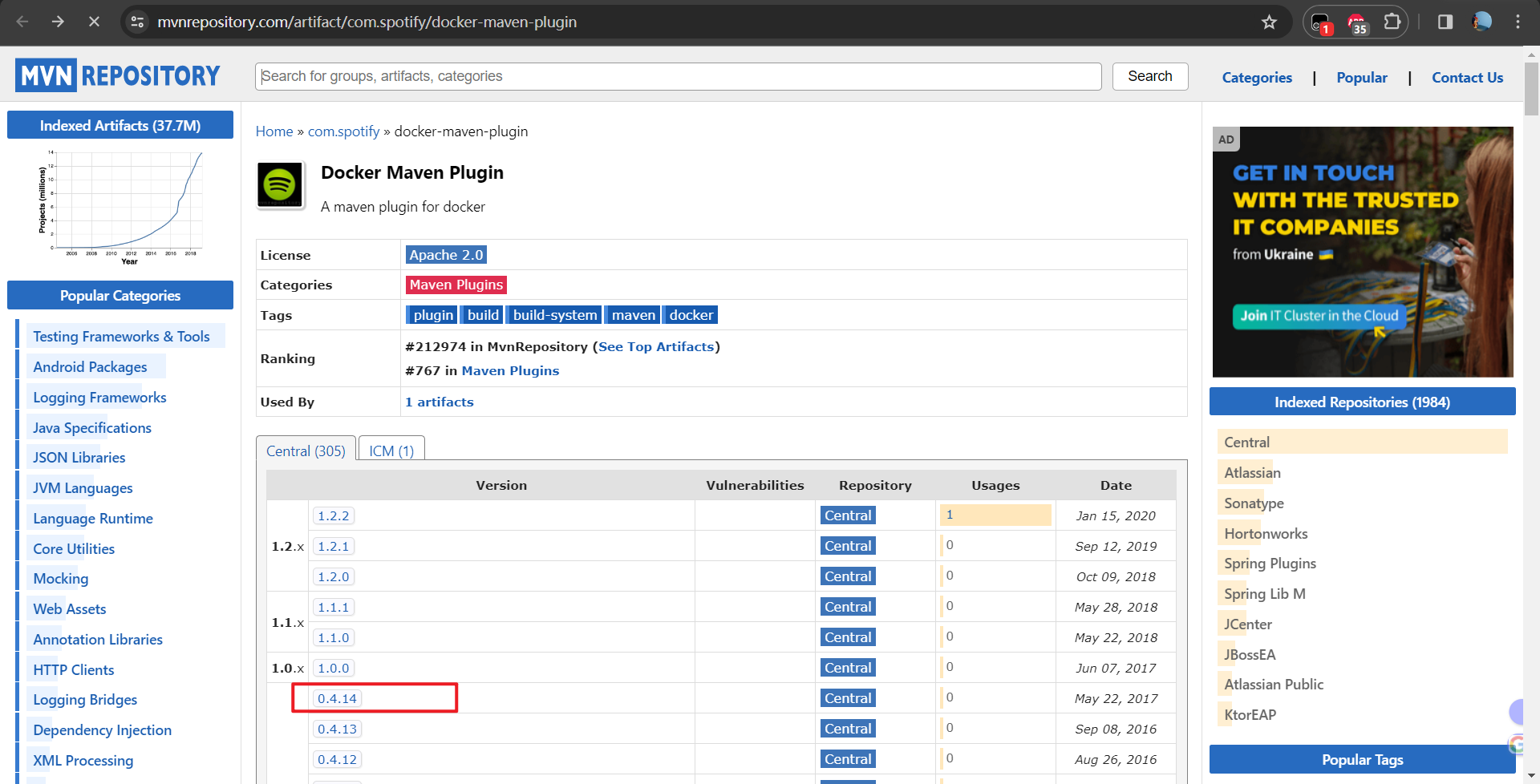

17 中央仓库明明有对应的jar包,但是刷新maven,导入失败 “Plugin 'com.spotify:docker-maven-plugin:0.4.14' not found”

多刷新几次!!!

18 @MapperScan 和 @Mapper 什么时候可以不写的说明

// 如果Dao类上没有写@Mapper注解,则这里需要加上@MapperScan注解,指定要扫描的dao包

// ,如果dao包中的Mapper类上写了@Mapper注解,则这里可以不写

// @MapperScan("com.hspedu.hspliving.commodity.dao")

@SpringBootApplication

public class HsplivingCommodityApplication {

public static void main(String[] args) {

//

SpringApplication.run(HsplivingCommodityApplication.class,args);

}

}

19 java: -source 1.5 中不支持 diamond 运算符

(即钻石符合'<>'报错)(请使用 -source 7 或更高版本以启用 diamond 运算符)

<properties>

<java.version>1.8</java.version>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

</properties>

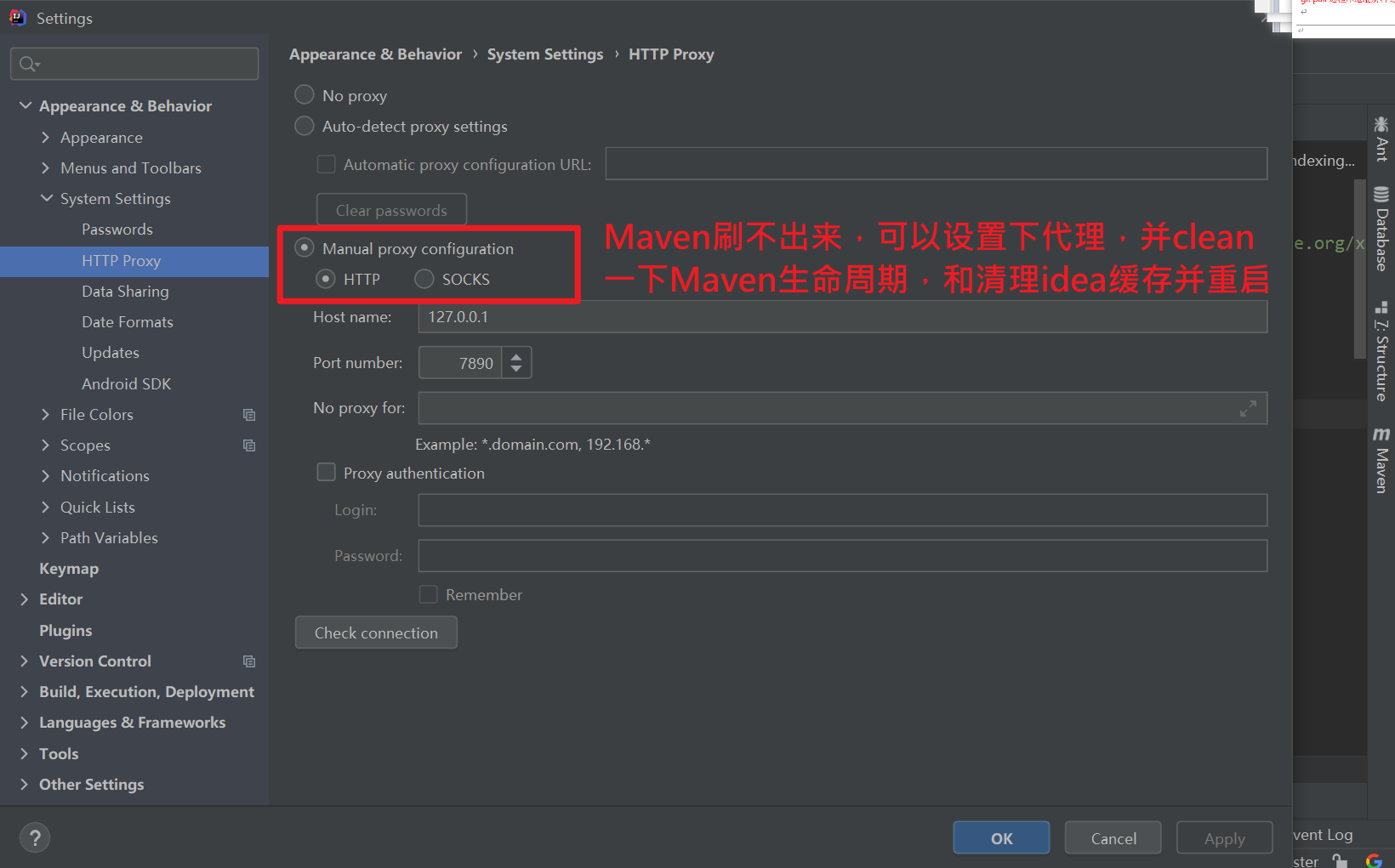

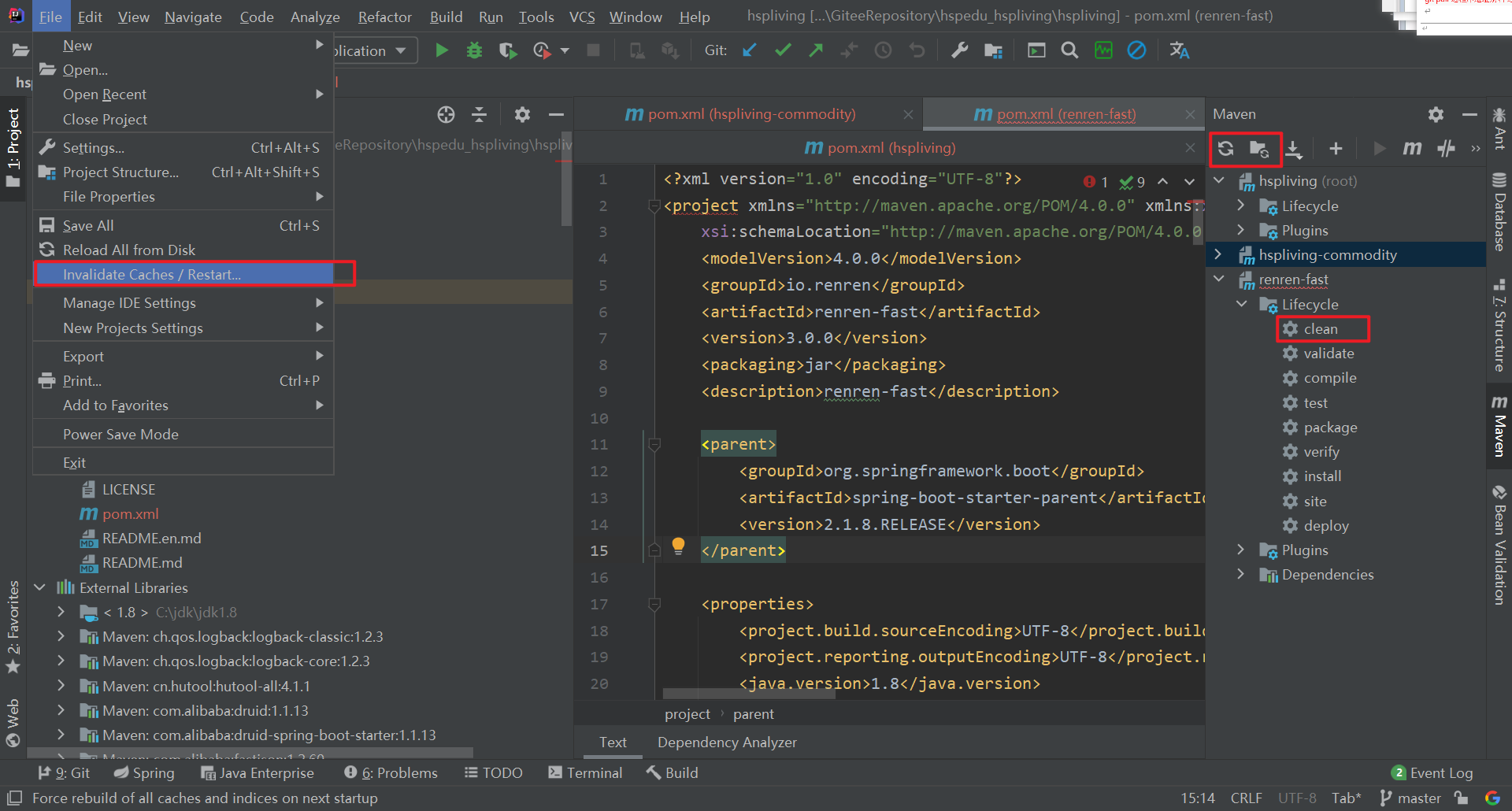

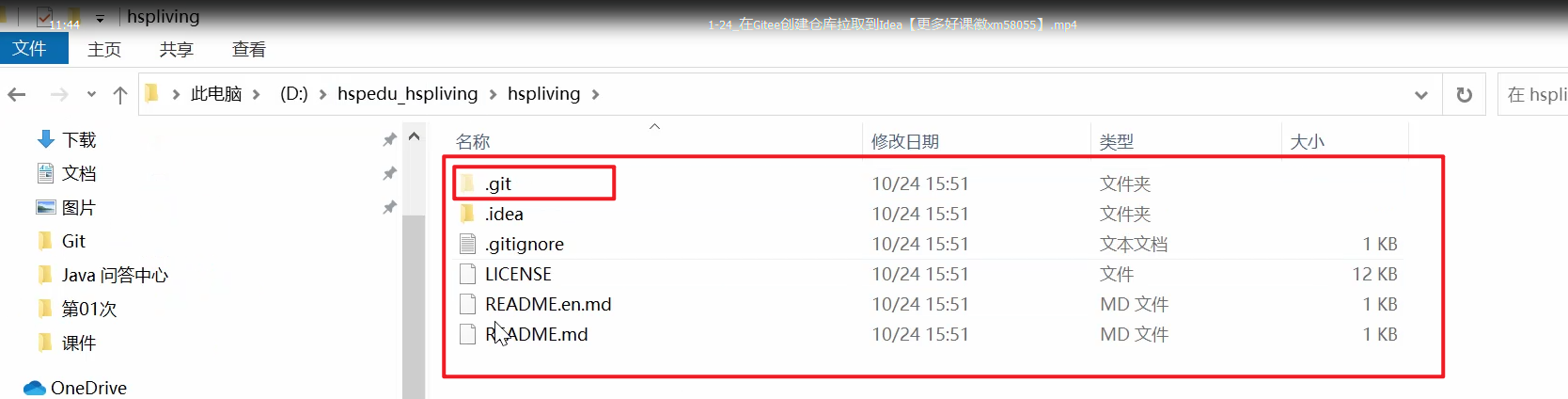

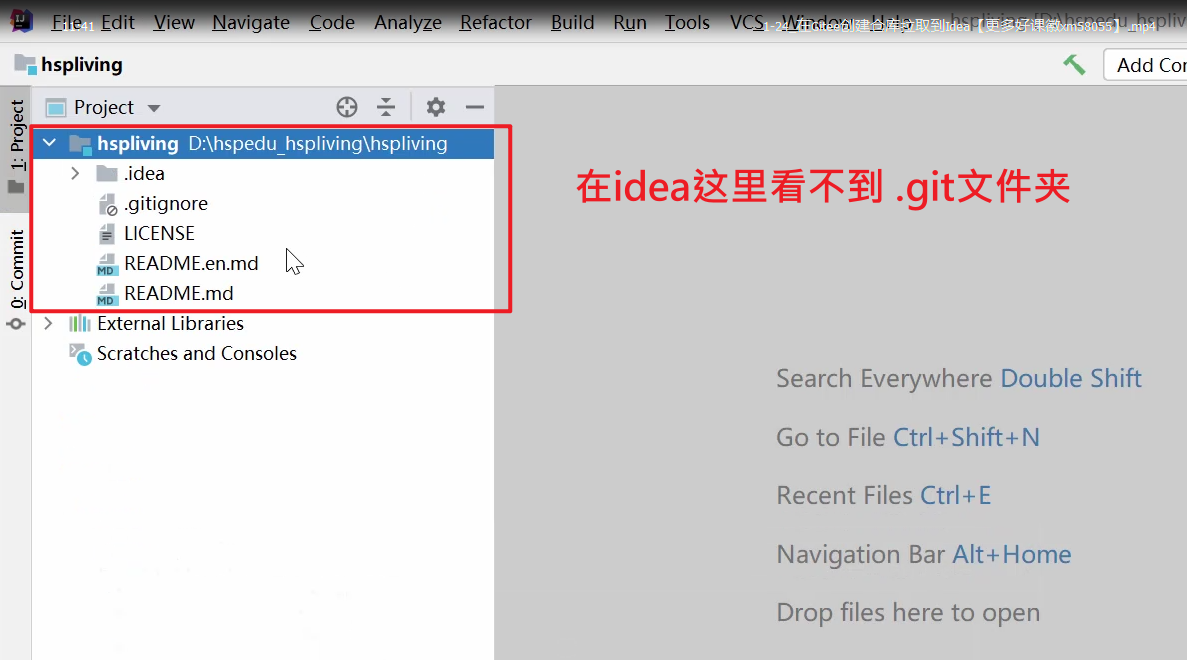

20 使用idea打开包含.git文件夹的项目,在idea视图界面看不到.git文件夹

在 IntelliJ IDEA 中,默认情况下 .git 文件夹是被隐藏的,这是因为 .git 文件夹包含了 Git 版本控制的所有元数据,而这些信息通常不需要在项目的日常开发过程中直接查看。IDEA 提供了其他方式来查看和管理 Git 版本控制信息,例如通过 VCS 操作或 Git 面板。

如果你希望在 IntelliJ IDEA 中查看 .git 文件夹,可以通过修改设置来实现:

-

打开 IntelliJ IDEA 并且打开你的项目。

-

从菜单栏选择 “File” -> “Settings” (对于 macOS,是 “IntelliJ IDEA” -> “Preferences”)。

-

在设置窗口中,展开 “Editor” 部分,然后选择 “File Types”。

-

在 “Ignored Files and Folders” 部分,你会看到默认情况下

.git被列在忽略的文件和文件夹列表中。 -

从这个列表中删除

.git条目。这将使得.git文件夹在项目视图中可见。 -

点击 “Apply” 然后 “OK” 来保存你的更改。

请注意,即使这样做可以使 .git 文件夹在项目浏览器中可见,但一般不推荐这样做,因为这可能会导致意外修改到版本控制系统的内部文件。如果你需要进行版本控制操作,建议使用 IntelliJ IDEA 提供的 Git 工具和菜单选项来执行这些操作,而不是直接修改 .git 文件夹中的文件。

21 lambda表达式在Java中确实依赖于函数式接口

是的,lambda表达式在Java中确实依赖于函数式接口。函数式接口是只有一个抽象方法的接口(尽管它们可以有多个默认或静态方法)。Lambda表达式提供了一种简洁的方式来实现这些接口的抽象方法,而无需显式地定义一个实现类。

当你写一个lambda表达式时,Java编译器会根据上下文推断出这个表达式应该匹配的函数式接口。这个过程称为“目标类型推断”。Lambda表达式的语法允许你省略参数类型,这些类型会从它们的上下文环境中被推断出来,具体来说,就是根据所赋值的函数式接口的类型。

例如,在以下场景中:

-

当你使用

filter方法时,期望的参数是Predicate<T>类型,这是一个函数式接口。因此,提供给filter方法的lambda表达式会被视为Predicate的实现。 -

当你使用

map方法时,期望的参数是Function<T, R>类型,这同样是一个函数式接口。因此,提供给map方法的lambda表达式会被视为Function的实现。

如果你尝试将一个lambda表达式赋值给一个非函数式接口的类型,或者试图将它用在不是明确期待一个函数式接口实例的上下文中,你将得到一个编译错误。因此,lambda表达式的使用确实是依赖于函数式接口的。这种设计使得lambda表达式在Java中既强大又灵活,同时保持了类型安全。

22 @FunctionalInterface public interface Comparator<T> { 并不是只有一个抽象方法啊? int compare(T o1, T o2); boolean equals(Object obj);

你提出了一个很好的问题,它触及了函数式接口定义中的一个细微之处。

根据Java的定义,一个函数式接口是指仅有一个抽象方法的接口。但这里的“抽象方法”指的是那些还没有被实现的方法。在函数式接口的定义中,Object类的公共方法不被视为抽象方法,即使它们在接口中被重新声明。

对于Comparator<T>接口,它定义了如下的方法:

-

int compare(T o1, T o2);- 这是一个抽象方法,因为Comparator接口期望你提供这个方法的实现,用来定义两个对象的比较逻辑。 -

boolean equals(Object obj);- 这个方法实际上是从java.lang.Object类继承的。在Java中,所有类都隐式继承自Object类,因此equals(Object obj)方法实际上是一个已经被实现的方法(所有对象都有这个方法)。即使在接口中重新声明equals,它也不被视为接口的抽象方法,因此它不违反函数式接口的单一抽象方法规则。

正因为如此,Comparator<T>仍然符合函数式接口的定义,并且可以安全地用@FunctionalInterface注解标记。这也意味着你可以使用lambda表达式来创建Comparator的实例,因为它只有一个需要实现的抽象方法compare(T o1, T o2)。这个细节是Java函数式接口概念中一个重要而微妙的部分。

23 如何查看电脑是否开启了双通道模式?

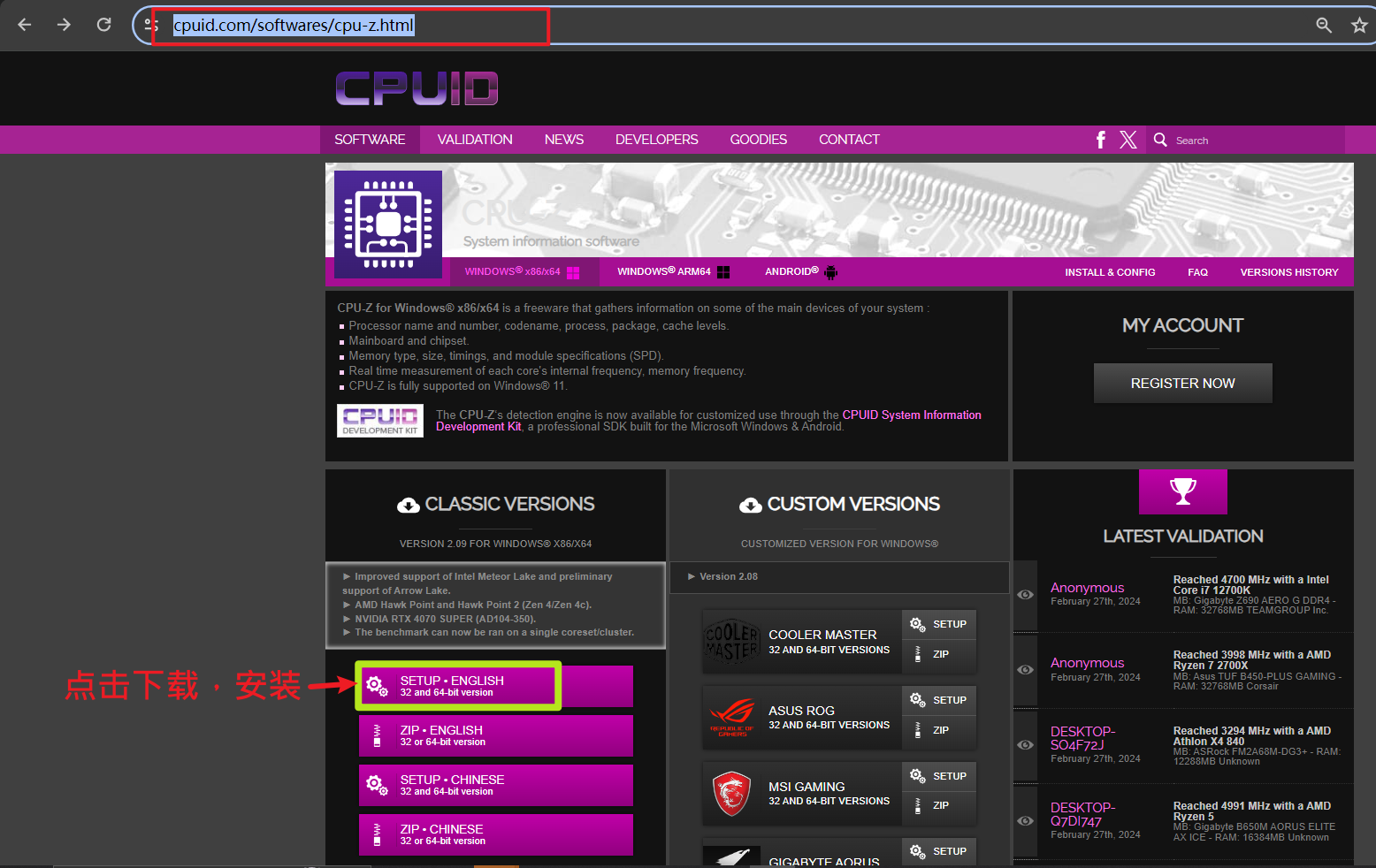

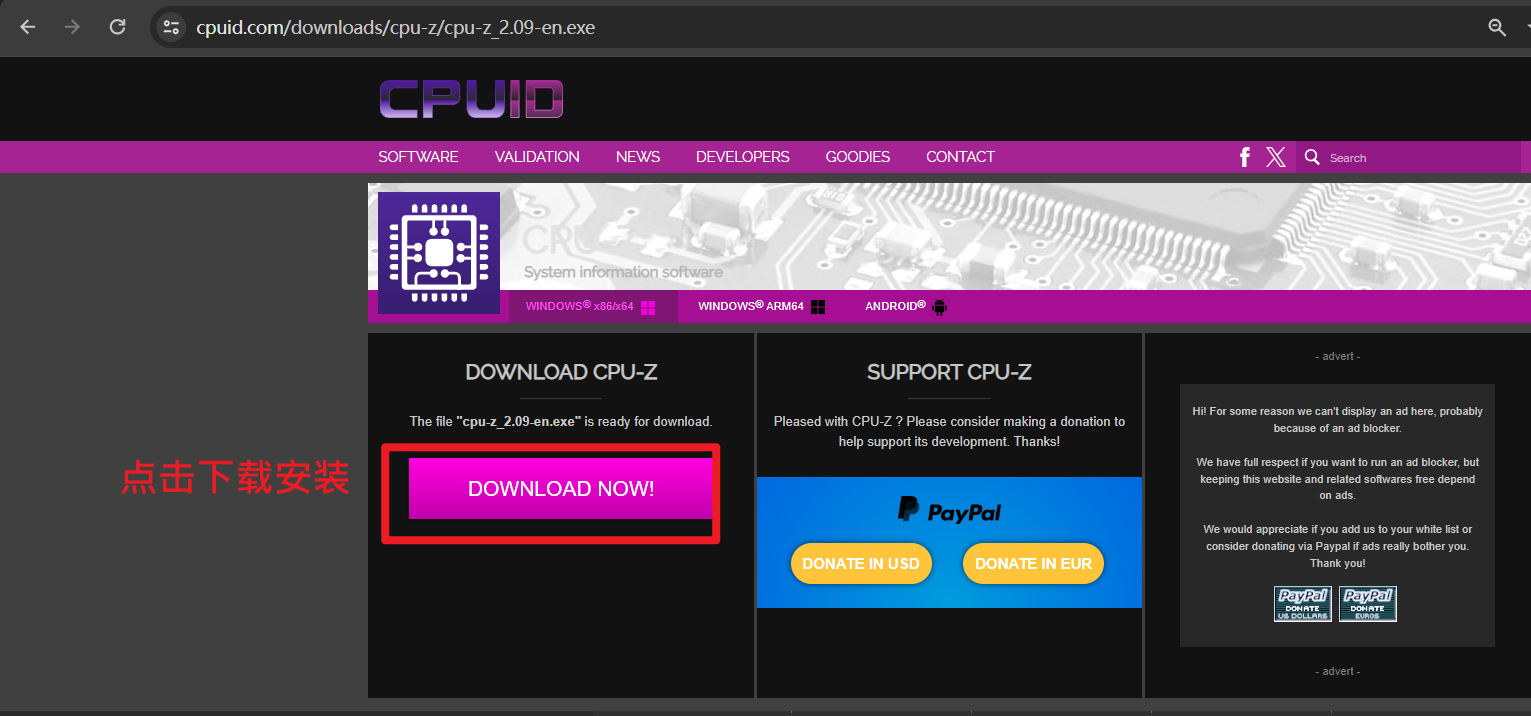

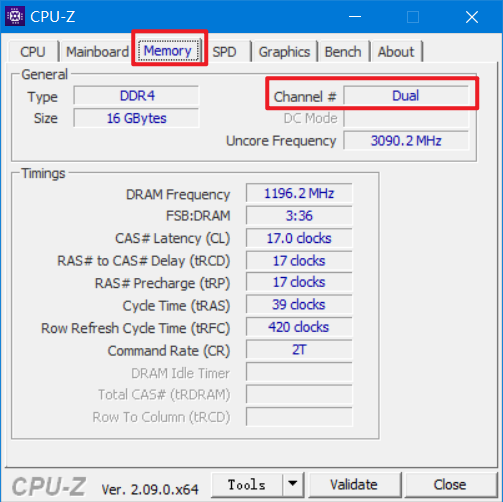

要检查您的电脑是否开启了双通道模式,您可以按照以下几种方法进行:

-

通过BIOS设置查看: 进入您的电脑BIOS设置界面(通常在启动时按F2、F10、DEL或ESC键)。在BIOS设置中,通常可以在内存设置或系统状态部分找到是否启用了双通道模式的信息。

-

使用CPU-Z工具: CPU-Z是一款免费的系统信息软件,能够提供有关您的CPU、主板、内存等硬件的详细信息。

-

下载并安装CPU-Z。

-

![image-20240227175315520]()

-

![image-20240227175350507]()

-

运行CPU-Z,然后点击顶部的“Memory”标签。

-

在“Channels #”行,它会显示“Single”(单通道)或“Dual”(双通道)。如果这里显示“Dual”,则表示您的电脑已经开启了双通道模式。

![image-20240227175037214]()

-

-

通过任务管理器: 在某些操作系统中,如Windows 10或更高版本,您可以通过任务管理器检查内存的配置。

-

右键点击Windows任务栏上的开始按钮,选择“任务管理器”。

-

转到“性能”标签,然后选择“内存”。

-

在内存部分,查看它是否提及“通道”信息。不过,请注意,并不是所有版本的Windows都会在这里显示双通道信息。

-

-

查看主板手册: 主板手册通常会指出如何安装内存以启用双通道模式。虽然这不是直接检查是否启用双通道的方法,但它可以帮助您确认内存是否正确安装以支持双通道。

-

系统信息软件: 使用系统信息查看软件,如Speccy或其他类似工具,这些软件能提供包括内存配置在内的详细系统信息。

根据您的电脑配置和所使用的操作系统,其中一些方法可能比其他方法更适合您的情况。通常情况下,使用CPU-Z是最简单直接的方式。

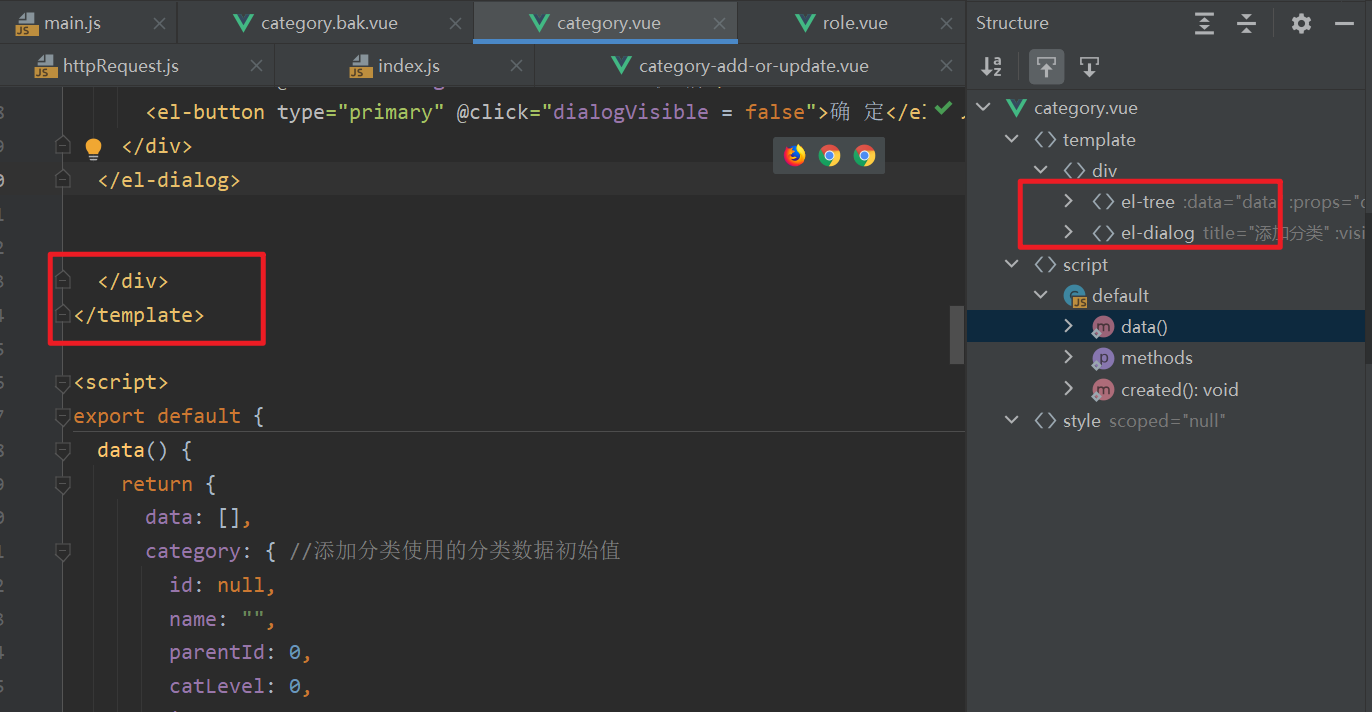

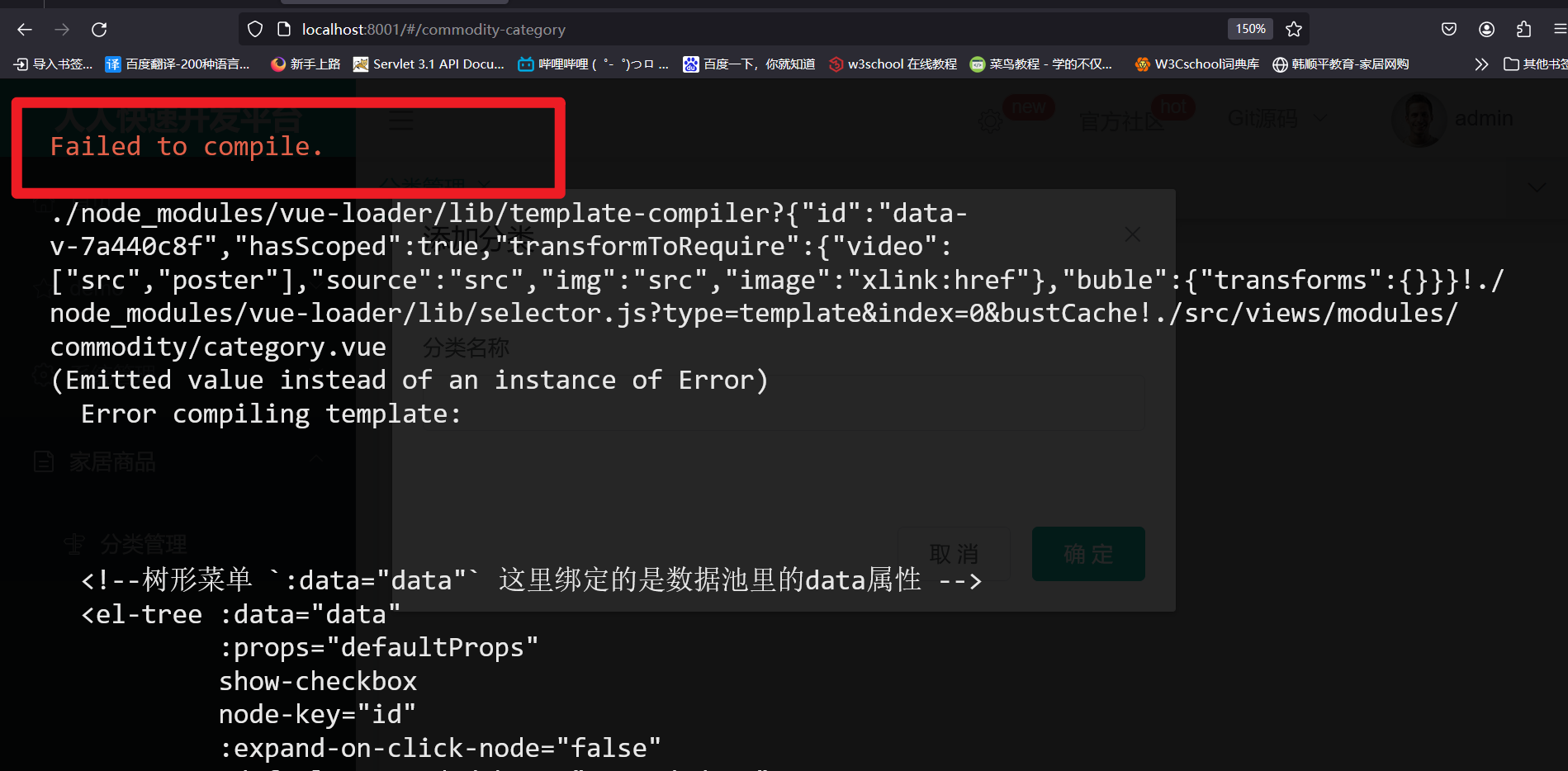

24 Vue中template中含有了 两个element控件, 因此需要使用 div将 el-tree和el-dialog包起来否则vue会报编译错误

25 useSSL=false和true的区别

SSL(Secure Sockets Layer 安全套接字协议),在mysql进行连接的时候,如果mysql的版本是5.7之后的版本必须要加上useSSL=false,mysql5.7以及之前的版本则不用进行添加useSSL=false,会默认为false,一般情况下都是使用useSSL=false,尤其是在将项目部署到linux上时,一定要使用useSSL=false!!!,useSSL=true是进行安全验证,一般通过证书或者令牌什么的,useSSL=false就是通过账号密码进行连接,通常使用useSSL=false!!!

26 前端使用axios向后端发送数据的携带参数的形式(对象解构和对象简写)

updateCategory(){

//1. 注意: 这里我们只是提交需要修改的字段信息,没有提交的字段,在

// 数据库中不会被修改(保持原来的值.. 我们可以观察sql语句)

//2. var {id, name, icon, proUnit} = this.category 进行对象解构

var {id, name, icon, proUnit} = this.category

//调用后端程序的接口/API, 发出修改请求

//发送请求,到后端程序去获取分类信息(实时数据,DB获取)

this.$http({

// 解读这里的url是获取后端分级菜单列表的url地址,即获取带层级的商品分类表`commodity_category`所有数据

url: `http://localhost:9090/commodity/category/update`,

method: 'post',

// 下面的adornData()方法中的`{id, name, icon, proUnit}`是一个新创建的对象

// ,同时使用到了对象的简写

data: this.$http.adornData({id, name, icon, proUnit}, false)

}).then(({data}) => { //这里的{data} 是对象解构,解构了上面url请求后端返回来的数据,

// responseData对象的data属性

//输出

console.log("updateCategory()方法 .then(({data}) 返回的data= ", data);

//返回需要展示的数据 data.data.data

//如果使用{data}, 得到的要展示的数据使用 data.data 即可,因为解构了一层

//取消显示对话框

// this.dialogVisible = false

//刷新分类列表 绑定数据

this.getCategories();

// console.log(" 删除的节点的父节点分类对应的id",node.parent.data.id)

// console.log(" 删除的节点的父节点node.parent",node.parent)

//设置需要展开的菜单 删除的节点的父节点分类对应的id

// node 即为当前点击的节点

// this.expandedKey = [this.category.parentId]

})

},

-

解构赋值:

var {id, name, icon, proUnit} = this.category;这行代码执行了一个操作:从

this.category对象中解构出id,name,icon, 和proUnit四个属性,并创建了四个同名的局部变量。如果this.category中包含这些属性,那么这些局部变量将被赋予相应的值。 -

在

adornData方法中使用: 当你在调用this.$http.adornData({id, name, icon, proUnit}, false)时,实际上是在创建一个新的对象,并将之前解构得到的变量作为该对象的属性值。

这里的 {id, name, icon, proUnit} 是对象字面量的简写语法,等同于:

{

id: id,

name: name,

icon: icon,

proUnit: proUnit

}

这种简写形式基于ES6的属性名简写特性,如果对象的属性名和变量名(变量存储着要赋给属性的值)相同,则可以省略冒号和值部分,直接写一个名字即可。

因此,解构赋值在这里的作用如下:

-

首先,它从

this.category中提取了必要的属性。 -

然后,通过在

adornData方法中使用这些同名变量,你实际上构建了一个新的对象,这个新对象拥有与this.category中相同的属性名和对应的值。 -

最后,这个新构建的对象被传递给

adornData方法,并最终被用于 HTTP 请求的数据部分。

这个过程并非多余,而是一种常见的实践,用于明确地选择要发送的数据字段,尤其在不想发送整个 this.category 对象或者 this.category 包含一些不应该发送的额外属性时。这样可以确保只有需要的数据被发送到服务器,同时还清楚地文档化了 API 调用所使用的数据字段。

27 Vue.js 中,ref 是一个特殊的属性

在 Vue.js 中,ref 是一个特殊的属性,当它用在 HTML 元素上时,可以用来给元素或子组件注册引用信息。引用(refs)提供了一种方式来直接访问 DOM 元素或子组件的实例。

在你的代码片段中:

<el-tree

:data="data"

show-checkbox

default-expand-all

node-key="id"

ref="tree"

highlight-current

:props="defaultProps">

</el-tree>

ref="tree" 这一行的意思是,你正在为 <el-tree> 组件创建一个引用(reference),并将这个引用命名为 "tree"。在 Vue 组件内部,你可以通过 this.$refs.tree 来访问这个 <el-tree> 组件的实例。这意味着你可以直接调用组件的方法,访问其数据和属性,甚至操作其子 DOM。

例如,如果 el-tree 组件有一个方法叫做 getCheckedNodes(),你可以在父组件中这样调用它:

let checkedNodes = this.$refs.tree.getCheckedNodes();

这样,你就可以获取到树形控件中被选中的节点数组。

使用 ref 是一种非常强大的功能,因为它允许你直接操作子组件,但它也应该谨慎使用,因为过度依赖 ref 可能会使得你的应用更难以维护。它违背了 Vue 数据驱动的设计原则,因此,在可以通过数据和方法实现的情况下,尽量避免使用 ref。然而,对于某些特定场景,如需要直接操作 DOM 或调用子组件的方法,ref 是非常有用的。

28 var ids = [] //注意这里是一个数组,后端delete接口使用数组进行接收的

//先收集选中的分类的ids 和 分类名

var ids = [] //注意这里是一个数组,后端delete接口使用数组进行接收的

var categoryNames = []

for (var i = 0; i < checkedNodes.length; i++) {

ids.push(checkedNodes[i].id)

categoryNames.push(checkedNodes[i].name)

}

//可以给出提示,如果用户选择确定,就调用后端程序接口,完成批量删除(逻辑删除)

/*

this.$confirm 在这段代码中并不是一个 axios 对象,而是一个由 Element UI 提供的方法,用于显示确认对话框。这是 Element UI 的一部分,一个基于 Vue 的桌面端组件库。$confirm 方法用于弹出一个模态对话框,询问用户是否确定执行某个操作,并且它返回一个 Promise 对象。

在 JavaScript 中,Promise 对象用于表示未来某个将要完成(或失败)的异步操作的结果。当 this.$confirm 被调用时,它会显示一个带有确定和取消按钮的对话框。如果用户点击“确定”,Promise 将会被“解决”(resolve),执行 .then() 里的回调函数;如果用户点击“取消”,Promise 将会被“拒绝”(reject),执行 .catch() 里的回调函数。

因此,当你看到 this.$confirm(...).then(...).catch(...) 这样的代码,它并不是说 $confirm 是一个 axios 请求,而是说 $confirm 返回的是一个可以链式调用 .then() 和 .catch() 方法的 Promise 对象。这样的设计让你可以编写代码来处理用户点击对话框中按钮后的逻辑。

*/

this.$confirm(`是否批量删除【${categoryNames}】菜单?`, '提示', {

confirmButtonText: '确定',

cancelButtonText: '取消',

type: 'warning'

}).then(() => {

//如果点击`确定` 进行批量删除操作

this.$http({

// 解读这里的url是获取后端分级菜单列表的url地址,即获取带层级的商品分类表`commodity_category`所有数据

url: 'http://localhost:9090/commodity/category/delete',

method: 'post',

//发出请求时携带的数据,参考 src/views/modules/sys/role.vue:158

data: this.$http.adornData(ids, false)

}).then(({data}) => {

@RequestMapping("/delete")

// @RequiresPermissions("commodity:category:delete")

public R delete(@RequestBody Long[] ids){

categoryService.removeByIds(Arrays.asList(ids));

return R.ok();

}

在这段代码中,@RequestBody Long[] ids 表示后端(假设使用的是Spring框架或类似的Java后端应用程序)期待从前端接收的数据是一个数组,该数组的元素类型为 Long。这里的 @RequestBody 注解表示请求的主体部分(即,发送的数据)应直接映射到参数 ids 上。

当前端发送数据给后端时,应该以 JSON 格式发送这个数组。虽然我们称之为“JSON数组”,其实它仍然是 JSON 格式,因为 JSON 支持数组类型的数据。

举个例子,如果你想通过前端发送 ID 为 1, 2, 和 3 的数组给后端,发送的数据格式应该类似于:

[1, 2, 3]

这是一个标准的 JSON 格式表示的数组。前端在发送这个数据时,通常会使用一个 AJAX 请求或使用现代前端框架(如 Axios、Fetch API 等)的 HTTP 客户端,设置 Content-Type 为 application/json,并将上述数组作为请求的主体部分发送。

简而言之,前端发送的是一个 JSON 格式的数组,而后端通过 @RequestBody Long[] ids 接收这个数组,并将其解析为 Java 中的一个 Long 类型数组。

29 三元运算符整体赋值给一个变量var ids

<el-button v-if="isAuth('commodity:brand:delete')" type="danger" @click="deleteHandle()" :disabled="dataListSelections.length <= 0">批量删除</el-button>

<el-button type="text" size="small" @click="deleteHandle(scope.row.id)">删除</el-button>

// 删除

deleteHandle (id) {

var ids = id ? [id] : this.dataListSelections.map(item => {

return item.id

})

this.$confirm(`确定对[id=${ids.join(',')}]进行[${id ? '删除' : '批量删除'}]操作?`, '提示', {

confirmButtonText: '确定',

cancelButtonText: '取消',

type: 'warning'

}).then(() => {

this.$http({

// url: this.$http.adornUrl('/commodity/brand/delete'),

url: 'http://localhost:9090/commodity/brand/delete',

method: 'post',

data: this.$http.adornData(ids, false)

}).then(({data}) => {

if (data && data.code === 0) {

this.$message({

message: '操作成功',

type: 'success',

duration: 1500,

onClose: () => {

this.getDataList()

}

})

} else {

this.$message.error(data.msg)

}

})

})

}

}

}

解释点击删除和批量删除时 var ids = id ? [id] : this.dataListSelections.map(item => {

return item.id

}) 这里的意思

这段代码是用于处理一个 Vue.js 组件中的删除操作的,既支持单个删除也支持批量删除。具体到 var ids = id ? [id] : this.dataListSelections.map(item => { return item.id }) 这行代码的作用,我们可以拆分来看:

-

id ? [id] : ...:这部分是一个三元运算符,用于判断id参数是否存在。如果调用deleteHandle函数时提供了一个id参数,则ids会被赋值为一个只包含这个id的数组([id])。这种情况通常对应于单个删除操作,也就是用户点击了某个特定条目旁边的删除按钮。 -

... : this.dataListSelections.map(item => { return item.id }):如果没有提供id参数(即批量删除情况),这部分代码会执行。这里,this.dataListSelections应该是一个数组,包含了用户在列表中选择的所有条目。.map(item => { return item.id })是一个将这些条目映射成一个新数组的操作,新数组只包含这些条目的id。这样,ids就会被赋值为一个包含所有选中条目id的数组。

总结起来,这行代码的意思是:如果提供了 id 参数,则将 ids 设置为仅包含该 id 的数组;如果没有提供 id(意味着用户想进行批量删除),则将 ids 设置为所有选中条目的 id 组成的数组。这样设置后,无论是单个删除还是批量删除,接下来的代码都可以统一处理这个 ids 数组进行删除操作。

var ids = id 可以当作三元运算符的判断条件吗?这不是一个变量的声明吗?this.dataListSelections 为什么应该是一个数组?

你的问题很合理,让我逐一解答:

-

三元运算符中的

var ids = id误解:实际上,在你的代码示例中,“var ids = id ? [id] : ...”这一行并不是将“var ids = id”作为三元运算符的条件。这里的“var ids”是变量声明,而三元运算符的判断条件仅仅是“id”。这个表达式的意思是:“如果id不为空(或者说,id存在),则ids变量将被赋值为一个包含id的数组(即[id]);如果id为空,则执行冒号后面的表达式。”这里的误解可能来源于格式问题,正常的理解应该是基于id是否存在来赋值ids。 -

this.dataListSelections为何假定为数组:在 Vue.js 或类似的现代 JavaScript 框架中,dataListSelections这样的命名约定通常用于表示列表中被用户选择(或选中)的条目集合。从命名规范和使用场景来看,this.dataListSelections被理解为一个数组是因为你通常会期望在这样的集合中包含多个条目 —— 特别是在实现批量删除功能时。因此,在这个上下文中,假设this.dataListSelections是一个数组是出于对它如何被使用的常规理解。this.dataListSelections.map(item => item.id)这段代码进一步支持了它是数组的假设,因为.map()是一个数组方法,用于遍历数组并对每个元素执行一个转换函数(在这里,是取出每个元素的id属性),然后返回结果的新数组。

所以,综上所述,var ids = id ? [id] : this.dataListSelections.map(item => item.id); 这行代码是完全合理的,其中利用了三元运算符来决定 ids 的值,并且合理地假设了 this.dataListSelections 是一个数组。

如何理解,基于 id 是否存在来赋值 ids ?这里的格式请详细说明

当我们谈到基于 id 是否存在来赋值 ids,实际上我们是在描述一个条件判断过程,这个过程使用了 JavaScript 中的三元运算符(ternary operator)。三元运算符有三个部分,格式为:

condition ? expression1 : expression2;

这里的“condition”是一个条件表达式,它会被计算并转换为一个布尔值(true 或 false)。如果条件为真 (true),则执行并返回 expression1 的结果;如果条件为假 (false),则执行并返回 expression2 的结果。

在你的代码示例中:

var ids = id ? [id] : this.dataListSelections.map(item => item.id);

-

condition:

id这里的条件是id。在 JavaScript 中,一个变量可以直接作为条件,其真假由变量的真值性("truthiness")决定。如果id有一个非假("falsy")值(如非零的数字、非空的字符串、非空对象等),那么它被认为是真(true)。如果id是假值(如0、null、undefined、空字符串''等),它被认为是假(false)。 -

expression1:

[id]如果id存在(即id被评估为真),则三元运算符的结果是[id]。这意味着ids将被赋值为一个只包含一个元素(即id的值)的数组。 -

expression2:

this.dataListSelections.map(item => item.id)如果id不存在(即id被评估为假),则表达式的结果是执行this.dataListSelections.map(item => item.id)的结果。这是将this.dataListSelections数组中的每个元素(预期为一个对象)映射成一个新数组,新数组中的每个元素都是原始元素的id属性。换句话说,如果没有提供特定的id,ids将被赋值为一个包含所有选中项的id的数组。

这种格式非常适合于根据某个条件选择不同的操作或值,正如在你的代码中,基于是否提供了特定的 id 来决定是删除单个条目还是批量删除多个条目。

这里的关键点 id ? [id] : this.dataListSelections.map(item => item.id); 是一个整体,根据id是否存在来判断用哪种形式来个ids变量赋值,这样理解对吗

是的,你的理解是正确的。

在表达式 id ? [id] : this.dataListSelections.map(item => item.id); 中,整体结构是根据 id 是否存在(即 id 是否有一个“真值”),来决定 ids 变量的赋值方式。这里使用的是一个三元运算符,它是JavaScript中的条件运算符,用于基于条件表达式的真值性来选择两个表达式中的一个。

-

如果

id存在(即id是非空、非零等,被判断为“真”),那么ids将被赋值为一个只包含此id的数组(即[id])。 -

如果

id不存在(即id是 null、undefined、0、空字符串等,被判断为“假”),那么ids将被赋值为另一个数组,该数组由this.dataListSelections中所有元素的id组成,此过程通过调用.map(item => item.id)来实现。

因此,整体上这是一个基于 id 的存在与否来对 ids 进行条件赋值的逻辑表达式。

30 在 Vue.js 中,特别是在使用 el-table(Element UI的表格组件)时,以下是关于数据渲染和更新机制的总结

问题描述,在Vue的代码中没有看到新增后

el-table表格新生成的行的dom元素的挂载操作

在 Vue.js 中,特别是在使用 el-table(Element UI的表格组件)时,以下是关于数据渲染和更新机制的总结点:

-

数据绑定与自动渲染: 在 Vue.js 中,通过使用

:data="dataList"(或等价的v-bind:data="dataList"),将dataList数组绑定到el-table的数据源。这意味着el-table会根据dataList数组中的数据自动渲染表格行。当dataList更新时(例如,从服务器获取新数据后),el-table会自动检测到数据变化,并重新渲染表格以反映最新的数据。 -

响应式系统: Vue.js 的响应式系统能够追踪依赖于其数据的 DOM 元素。当数据变化时,Vue.js 会自动更新相应的 DOM。因此,在 Vue.js 中,开发者通常不需要直接操作 DOM 或手动更新视图。只需更新数据,Vue 就会处理视图的变更。

-

声明式渲染: Vue.js 使用声明式渲染的概念,让开发者通过声明数据如何被渲染为 UI,而不是通过直接操作 DOM 来显示数据。这使得代码更简洁、更易于理解和维护。

-

组件和事件: 在 Vue.js 的项目中,如添加或修改数据的操作通常在组件中进行。例如,在你提供的代码中,

<add-or-update>组件可能用于新增或编辑表格数据。完成操作后,可以通过事件(如@refreshDataList)通知父组件刷新数据列表。这样的组件化和事件机制使得数据管理和界面更新变得更加模块化和可维护。 -

无需手动挂载DOM: 在 Vue.js 中,并不需要手动挂载新的DOM元素来显示更新的数据。Vue 的数据绑定和组件系统允许开发者通过简单地更新状态或数据来自动更新视图,无需直接与DOM交互。

总结来说,在使用 Vue.js 和 Element UI (如 el-table) 时,开发者通过更新组件的状态或数据来驱动视图的变化,而不是通过直接操作 DOM。这样的模式大大简化了前端开发,使得代码更加简洁,更容易维护。

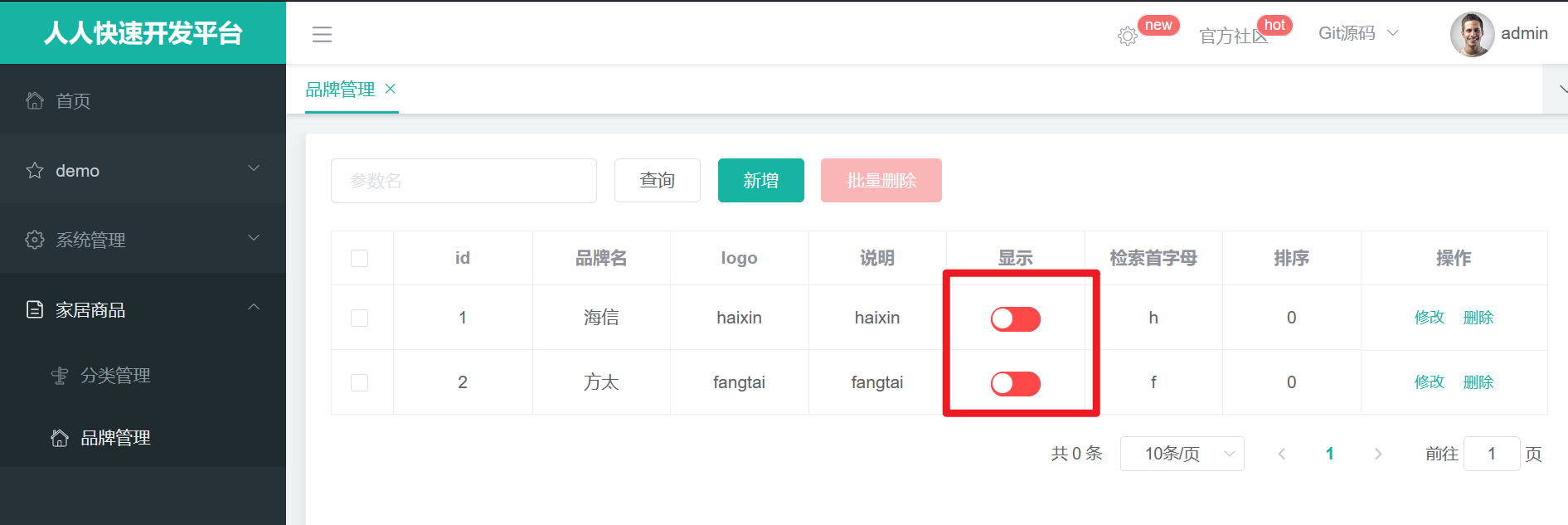

31 Element UI Switch组件,el-switch的状态发生改变后,active-value="1"和inactive-value="0"的值会给到v-model="scope.row.isshow"绑定的值上面吗?是的

<el-switch

v-model="scope.row.isshow"

@change="changeIsShow(scope.row)"

active-value="1"

inactive-value="0"

active-color="#13ce66"

inactive-color="#ff4949">

</el-switch>

这里el-switch的状态发生改变后,active-value="1"和inactive-value="0"的值会给到v-model="scope.row.isshow"绑定的值上面吗?

是的,你的理解是正确的。在你提供的 Vue 代码片段中,el-switch 组件使用了 v-model 指令绑定到 scope.row.isshow。这意味着当开关的状态改变时,scope.row.isshow 的值会自动更新。

el-switch 组件有两个重要的属性:active-value 和 inactive-value。

-

active-value定义了当开关处于激活状态时对应的值,在你的代码中设置为"1"。 -

inactive-value定义了当开关处于非激活状态时对应的值,在你的代码中设置为"0"。

当用户点击开关改变它的状态时,如果开关被激活,scope.row.isshow 将被设置为 "1"(active-value 的值)。如果开关被关闭,scope.row.isshow 将被设置为 "0"(inactive-value 的值)。

此外,@change 事件用于监听状态的改变,并执行 changeIsShow(scope.row) 方法。这意味着每当开关的状态改变时,不仅 scope.row.isshow 的值会更新,还会调用 changeIsShow 方法,并传递当前行的数据 scope.row 作为参数。这样,你可以在 changeIsShow 方法内部执行进一步的操作,如同步更新到服务器等。

32 关于 el-switch 控件的类型不匹配问题

<el-switch

v-model="scope.row.isshow"

@change="changeIsShow(scope.row)"

:active-value="1"

:inactive-value="0"

active-color="#13ce66"

inactive-color="#ff4949">

</el-switch>

<el-switch

v-model="scope.row.isshow"

@change="changeIsShow(scope.row)"

active-value="1"

inactive-value="0"

active-color="#13ce66"

inactive-color="#ff4949">

</el-switch>

关于 el-switch 控件的类型不匹配问题,我们可以将其分为几个关键点来进行详细总结:

1. 数据类型的重要性:

-

后端数据类型:通常,后端可能会将状态值(如

isShow)以整数形式返回,比如 1 表示激活,0 表示非激活。 -

前端期望数据类型:在前端,特别是在 Vue 的

el-switch组件中,active-value和inactive-value可以设置为任意类型的值,通常为数字或字符串以匹配后端的数据。

2. 类型不匹配的问题:

-

不加冒号情况(字符串类型):如果不在

active-value和inactive-value前加冒号,Vue 会将这些值解释为字符串。例如,active-value="1"和inactive-value="0"会被解释为字符串 "1" 和 "0"。 -

加冒号情况(JavaScript 表达式):加上冒号,如

:active-value="1"和:inactive-value="0",Vue 解释这些值为 JavaScript 表达式,因此它们会被识别为数字 1 和 0。

3. 实际后果:

-

匹配错误:如果后端返回数字,但

el-switch的active-value和inactive-value被设置为字符串(因为没有加冒号),则会导致类型不匹配。由于 "1"(字符串)不等于 1(数字),el-switch不会按预期激活或关闭。 -

状态显示错误:这种类型不匹配会导致

el-switch无法正确显示其状态,导致界面显示与后端数据不一致的问题。通常,这会表现为el-switch总是显示为默认(通常是关闭)状态。

4. 解决方案:

-

确保类型一致:确保

el-switch组件的active-value和inactive-value与后端数据类型一致。如果后端使用数字,则前端也应使用数字(即在属性前加冒号)。 -

更新组件属性:在

el-switch组件中使用:active-value="1"和:inactive-value="0"(加上冒号),以确保这些值作为数字处理,从而与后端返回的整数值相匹配。

通过确保前后端数据类型的一致性,可以确保 el-switch 控件能够正确反映后端的状态数据,从而提高用户界面的准确性和用户体验。

下面是更加详细的讨论:

<el-switch v-model="scope.row.isshow" @change="changeIsShow(scope.row)" :active-value="1" :inactive-value="0" ,为什么这里的 :active-value="1" :inactive-value="0",需要加上冒号才绑定的是number类型的值呢?

在 Vue.js 中,当你在模板属性中使用 v-bind:(或其简写 :)时,它告诉 Vue 这个属性的值是一个 JavaScript 表达式而不是纯字符串。这意味着,Vue 将计算这个表达式的结果,并将结果用作属性的值。

在你的例子中:

-

:active-value="1":这里的冒号表示active-value的值应该被解释为 JavaScript 表达式,因此传递给active-value的是数字 1。 -

:inactive-value="0":同样,这里的冒号表示inactive-value的值应该被解释为 JavaScript 表达式,因此传递给inactive-value的是数字 0。

如果不加冒号:

-

active-value="1":没有冒号,Vue 会把这里的1解释为字符串 "1" 而不是数字。 -

inactive-value="0":同样,没有冒号,0会被解释为字符串 "0"。

因此,如果你想确保 el-switch 接收的 active-value 和 inactive-value 是数字类型而不是字符串,你应该使用冒号(:)来绑定这些属性值为 JavaScript 表达式。这在处理逻辑或数据类型严格的场景中尤其重要,确保数据类型的一致性可以避免不必要的逻辑错误。

如果没有加冒号,页面刷新后不能实时监测到后端数据库的数据,后端的数据isShow 是Integer类型的,页面刷新后不能实时监测到后端数据库的数据为什么呢?

如果在你的 Vue.js 项目中,el-switch 组件的 active-value 和 inactive-value 属性没有加冒号,这意味着这两个值被解释为字符串而不是数字。如果后端数据库中的 isShow 字段是 Integer 类型(即数字类型),那么在数据从后端传到前端时,会存在类型不匹配的问题。

具体来说,如果后端返回的 isShow 值是数字(比如 1 或 0),但是你的 el-switch 的 active-value 和 inactive-value 是字符串(因为没有加冒号,所以 "1" 和 "0" 被视为字符串),那么 Vue.js 在比较这些值时会发现它们不相等(因为 "1"(字符串)不等于 1(数字),"0"(字符串)不等于 0(数字))。结果,el-switch 的状态就不会正确反映后端数据库的数据。

这种类型不匹配会导致 el-switch 无法正确显示其状态,因为它无法识别实际的 isShow 值(数字)与期望的激活/非激活值(错误地设置为字符串)之间的匹配。这就是为什么页面刷新后无法实时反映后端数据库的数据状态。

为了解决这个问题,你需要确保 el-switch 组件的 active-value 和 inactive-value 与后端数据库中 isShow 字段的数据类型保持一致。如果后端是数字类型,那么就应该使用 :active-value="1" 和 :inactive-value="0"(加上冒号)来确保这些值也被视为数字,这样才能正确匹配并实时反映数据库的状态。

这种类型不匹配会导致 el-switch 无法正确显示其状态,因此我一刷新页面总是看到switch未激活状态对吗

是的,你的理解是正确的。如果存在类型不匹配,例如后端数据是整数类型(1 或 0),而 el-switch 组件的 active-value 和 inactive-value 属性因为未加冒号被错误地识别为字符串("1" 和 "0"),那么会导致 el-switch 无法正确匹配其状态。因为在 JavaScript 中,字符串 "1" 或 "0" 不等于数字 1 或 0。

这就意味着即使后端返回的 isShow 是 1(意味着应该激活开关),但由于 el-switch 期望的激活值是字符串 "1" 而不是数字 1,所以它不会将开关置为激活状态。相同的逻辑也适用于非激活状态。结果,不管后端数据怎样,你每次刷新页面时,el-switch 可能总是显示为未激活状态,因为它的实际值(整数)与期望值(字符串)不匹配。

为了解决这个问题,确保在使用 el-switch 组件时,其 active-value 和 inactive-value 的设置与后端数据的类型相匹配。如果后端是整数类型,那么应该在这些属性前加上冒号(如 :active-value="1" 和 :inactive-value="0"),确保它们被识别为 JavaScript 中的数字类型。这样做可以确保页面刷新时能正确显示 el-switch 的实际状态。

33 在 Vue.js 中,方法的对应关系是基于方法名而不是方法签名(即方法的参数)。因此 deleteHandle() 和 deleteHandle(scope.row.id,scope.row.name) 都和方法池中的 deleteHandle (id,name) {} 方法对应

<el-button v-if="isAuth('commodity:brand:delete')" type="danger" @click="deleteHandle()" :disabled="dataListSelections.length <= 0">批量删除</el-button>

<el-button type="text" size="small" @click="deleteHandle(scope.row.id,scope.row.name)">删除</el-button>

<script>

import AddOrUpdate from './brand-add-or-update'

export default {

data () {

return {

// 上面两个 deleteHandle() 和 deleteHandle(scope.row.id,scope.row.name) 都和下面方法池中的 deleteHandle (id,name) {} 方法对应

methods: {

deleteHandle (id,name) {

}

}

}

}

}

</script>

在 Vue.js 中,方法的对应关系是基于方法名而不是方法签名(即方法的参数)。这意味着无论你如何调用一个方法(不管是不带参数,还是带有不同的参数),只要方法名相同,就会调用到同一个方法定义。

在你提供的代码中,存在两种不同的 deleteHandle 方法调用方式:

-

批量删除:通过

deleteHandle()调用,没有提供任何参数。 -

单个删除:通过

deleteHandle(scope.row.id,scope.row.name)调用,提供了两个参数:id和name。

尽管调用方式不同,它们都指向下面方法池中的同一个方法定义:

deleteHandle (id, name) {

// 方法实现

}

这是因为 Vue.js 在处理事件绑定时只查看方法名称 deleteHandle,而不关心调用时使用了多少参数。在 JavaScript 中,函数参数是灵活的,意味着一个函数可以被调用时传递任意数量的参数,这不会引起错误。如果函数定义时包含参数,但在调用时没有提供相应的参数,这些参数只会被赋值为 undefined。

因此,无论是不带参数的 deleteHandle() 还是带有两个参数的 deleteHandle(scope.row.id,scope.row.name),它们都会映射到同一个 deleteHandle 方法上。在 deleteHandle 方法的实现中,可以通过检查参数 id 和 name 是否存在来区分是哪种调用情况,并相应地执行不同的逻辑处理:

-

如果

id和name都是undefined(或其他非期望值),那么可以认为是执行批量删除。 -

如果

id和name有具体的值,那么可以认为是执行针对特定项目的删除操作。

这种设计允许 deleteHandle 方法在不同场景下复用,简化代码并提高代码的可维护性。

这种设计允许 deleteHandle 方法通过不同的调用形式(有参数调用和无参数调用)来处理不同的删除场景(单个删除和批量删除)。方法内部的逻辑需要根据是否传入参数(以及参数的值)来执行相应的操作,这体现了 JavaScript 函数和 Vue 事件处理器的灵活性。

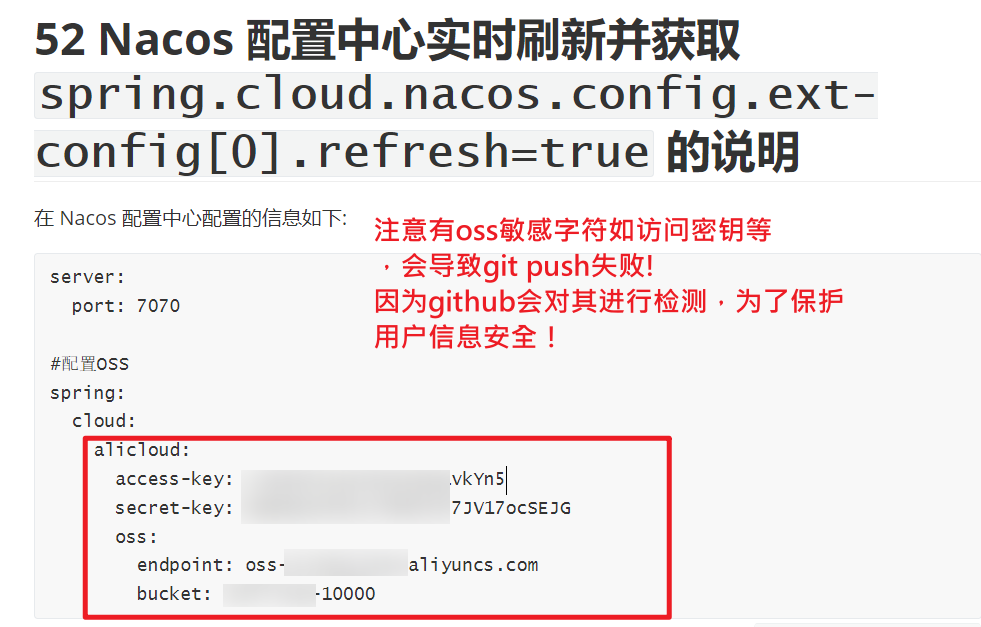

34 阿里云OSS名词说明

阿里云对象存储OSS(Object Storage Service)

RAM(Resource Access Management)是阿里云提供的资源访问控制服务。RAM Policy是基于用户的授权策略。通过设置RAM Policy,您可以集中管理您的用户(例如员工、系统或应用程序)以及控制用户可以访问您名下哪些资源的权限,例如限制您的用户只拥有对某一个Bucket的读权限。

35 Maven POM 文件插件:spring-boot-maven-plugin说明

@RestController

简介 @RestController 是 Spring Boot 中的注解,将 @Controller 和 @ResponseBody 注解组合在一起,用于处理请求并返回 JSON 格式的数据。

工作原理 @Controller:标识类为控制器,负责处理客户端请求。 * @ResponseBody:使方法直接将返回值写入 HTTP 响应体,而不是渲染为视图。 因此,如果在方法上使用 @RestController,Spring Boot 将自动将返回值转换为 JSON 格式并返回给前端。

Maven POM 文件插件:spring-boot-maven-plugin

该插件默认包含在父项目spring-boot-starter-parent中

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.8.RELEASE</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

需要手动在 pom 文件中导入插件 spring-boot-maven-plugin 的情景包括:

* 使用自定义版本:Maven 中央存储库中提供的 spring-boot-maven-plugin 版本可能不是所需的版本。手动导入插件允许指定所需的版本。

* 使用SNAPSHOT 版本:Maven 快照版本是仍在开发中的版本。它们不存储在中央存储库中,必须手动导入。

* 使用私有插件:如果 spring-boot-maven-plugin 放在私有存储库中,则必须手动导入该插件。

* 自定义插件配置:手动导入 spring-boot-maven-plugin 可以自定义插件的配置,例如执行目标或插件参数。

* 使用插件的多个版本:手动导入允许在同一项目中使用 spring-boot-maven-plugin 的多个版本,这对于使用插件的不同功能或解决与特定版本相关的兼容性问题非常有用。

* 使用父 POM:如果父 POM 没有导入 spring-boot-maven-plugin,则子 POM 需要手动导入它。

* 复杂的项目结构:在具有复杂项目结构的项目中,手动导入 spring-boot-maven-plugin 可以提供更好的控制和灵活性。

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build>

用途:将 Spring Boot 应用打包成可执行的 JAR 文件。

功能:

提供额外的配置选项,如设置主类和生成调试信息。

允许自定义插件配置。

总结

-

@RestController 可用于直接返回 JSON 格式的数据。

-

spring-boot-maven-plugin 插件用于打包 Spring Boot 应用,并提供自定义配置选项。

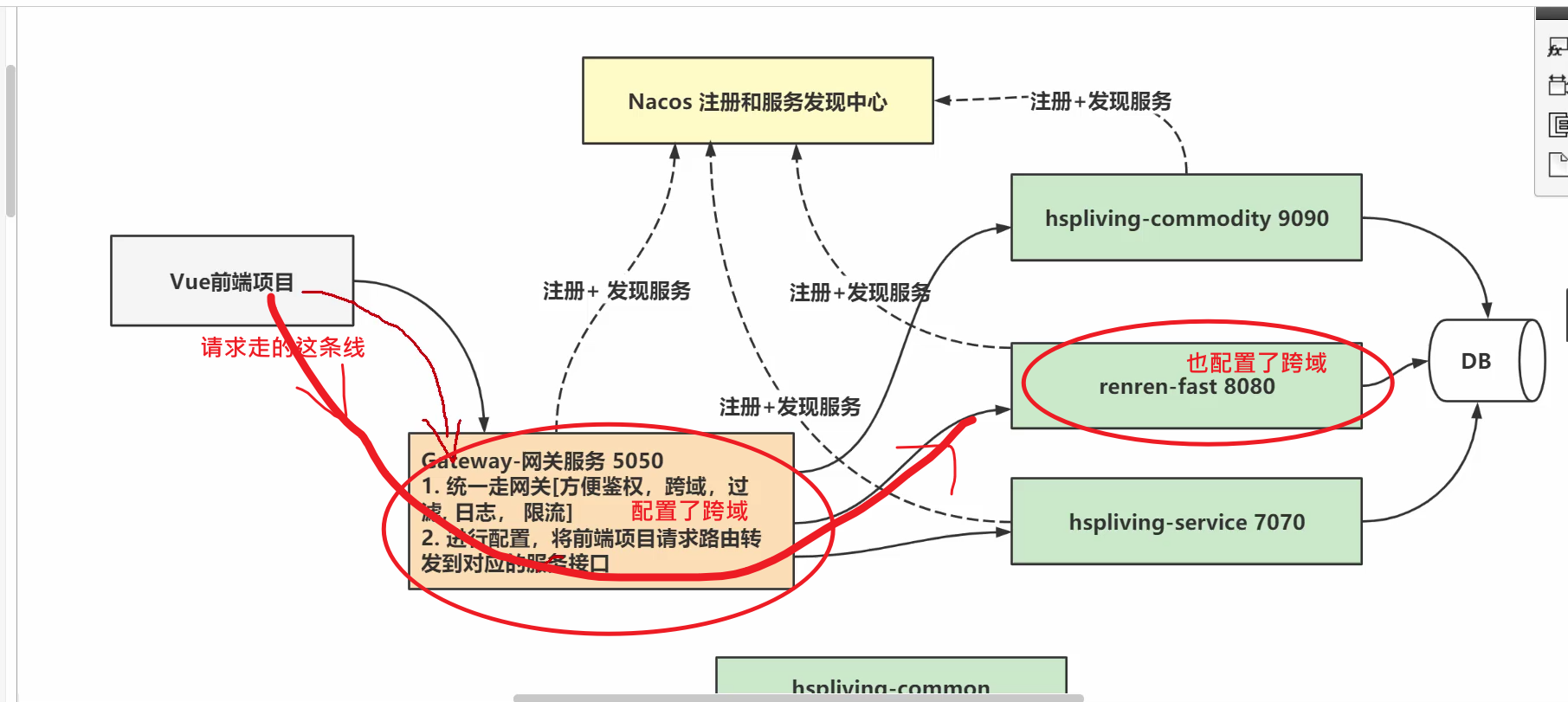

36 cors 前端中一般是跨域问题吗?

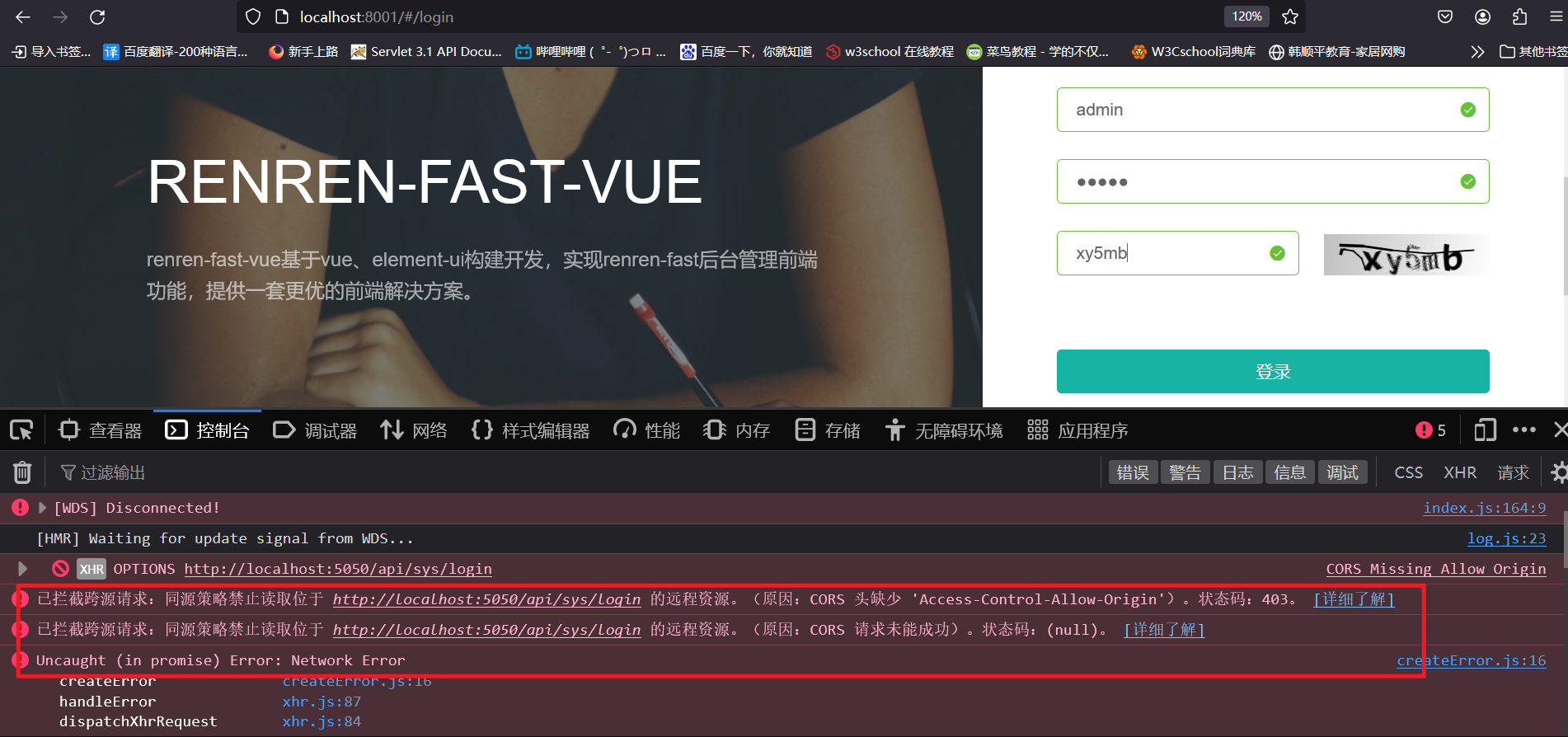

是的,CORS(Cross-Origin Resource Sharing,跨来源资源共享)问题通常出现在前端开发中,尤其是当你的网页尝试从不同源(域名、协议或端口)的服务器上请求资源时。浏览器出于安全考虑,默认禁止跨源 HTTP 请求,这就是所谓的"同源策略"。

当你尝试从前端代码(如 JavaScript)中访问另一个源(域名、协议或端口不同)的资源时,如果对方的服务器没有返回适当的 CORS 头来允许请求,浏览器就会拦截这个请求,导致跨域问题。

为了解决这个问题,资源的提供者需要在服务器上设置适当的 CORS 响应头,比如 Access-Control-Allow-Origin,来明确允许某些域名进行资源访问。如果你控制着资源的服务器,你可以通过配置这些响应头来解决跨域问题。如果你不控制资源服务器,你可能需要联系服务器的管理员,或者寻找其他方法来获取数据,例如使用JSONP(如果支持的话),或者通过你自己的服务器中转请求。

37 HTTP协议中,OPTIONS请求方法的作用

在HTTP协议中,OPTIONS请求方法的作用是发现服务器支持哪些HTTP方法。当你看到浏览器在发起实际的POST或GET请求之前发送OPTIONS请求时,这通常与CORS(跨来源资源共享)有关。

在处理跨域HTTP请求时,浏览器会首先发送一个OPTIONS请求到服务器,这个过程被称为“预检请求”(preflight request)。这个请求用于确认服务器是否允许来自不同源的通信。预检请求的回应中,服务器将返回允许的方法(如GET、POST、PUT),允许的头信息,以及是否允许发送cookies等信息。

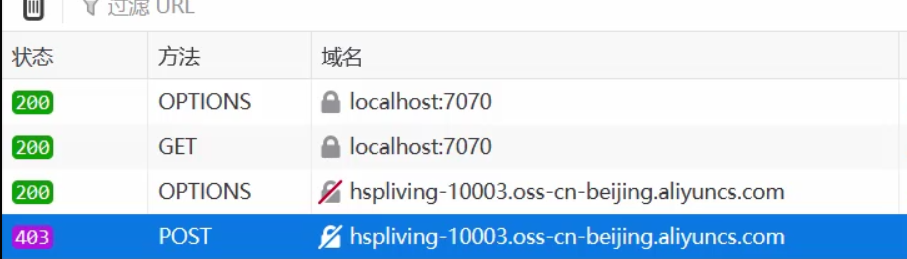

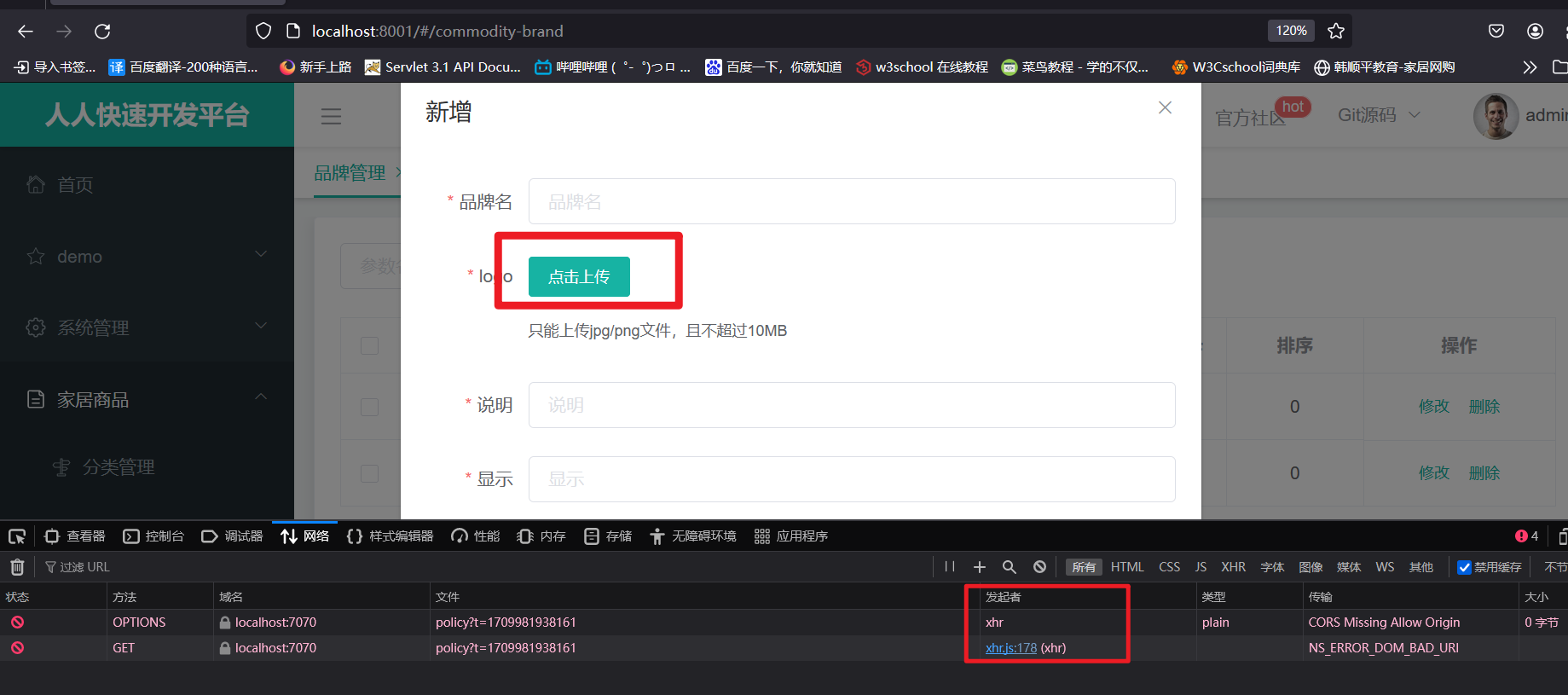

在你的情况下,对于从localhost发起的跨域POST请求,浏览器首先使用OPTIONS方法向服务器发送了一个预检请求。如果服务器的响应表明它接受来自这个源的POST请求,那么浏览器随后将发送实际的POST请求。在你提供的图像中,我们可以看到两个OPTIONS请求都成功了(返回了200状态码),意味着预检请求通过了。然而,紧随其后的POST请求返回了403状态码,意味着服务器拒绝了这个请求。这个403错误可能是由服务器端的权限设置引起的,而不是CORS问题。

38 "发起者"栏显示的“xhr”指的是XMLHttpRequest。

在你提供的截图中,"发起者"栏显示的“xhr”指的是XMLHttpRequest。XMLHttpRequest(XHR)是一种浏览器内置的API,用于在浏览器和服务器之间异步交换数据。这意味着可以在不重新加载整个页面的情况下,更新网页的一部分。

在现代web开发中,XHR广泛用于前端JavaScript代码中,以实现异步通信。例如,当你在网页上填写表单并提交时,JavaScript可以使用XHR向服务器发送数据,并处理服务器的响应,然后根据这些响应更新网页,而无需加载新页面。

在你的截图中,有两个请求(一个OPTIONS请求和一个GET请求)都标记为由“xhr”发起,这意味着这些请求是通过XMLHttpRequest对象生成的。这通常是在处理AJAX(Asynchronous JavaScript and XML)请求时发生的情况。而且,根据截图,这两个请求似乎都遇到了问题,OPTIONS请求由于缺少CORS(跨源资源共享)响应头而失败,而GET请求因为URL问题(NS_ERROR_DOM_BAD_URI)而失败。

39 SingleUpload组件会更新dataForm.logo字段为阿里云OSS中存储的文件的URL。是那几行代码体现的?

位置:

D:\Java_developer_tools\DistributedMicroservicesProject\hspedu_hspliving\renren-fast-vue\src\components\upload\singleUpload.vue

在提供的代码中,SingleUpload 组件更新 dataForm.logo 字段为阿里云OSS中存储的文件的URL是通过下面这几行代码体现的:

handleUploadSuccess(res, file) {

console.log("上传ok...")

this.showFileList = true;

this.fileList.pop();

this.fileList.push({

name: file.name,

url: this.dataObj.host + '/' + this.dataObj.key.replace("${filename}", file.name)

});

this.emitInput(this.fileList[0].url);

}

这段代码位于 SingleUpload 组件的 handleUploadSuccess 方法内。当文件成功上传到阿里云OSS后,这个方法会被调用。方法中做了以下几个操作:

-

设置

showFileList为true以显示上传的文件列表。 -

从

fileList中移除上一个文件的信息(如果有的话),然后添加当前上传成功的文件信息。这个文件信息包括文件的名称(file.name)和URL。这里的URL是通过连接dataObj.host(阿里云OSS的域名)和由dataObj.key(文件在OSS中的路径)构成的。dataObj.key.replace("${filename}", file.name)替换操作确保文件名正确嵌入路径中。 -

通过

this.emitInput(this.fileList[0].url)调用,将上传成功的文件的URL更新到dataForm.logo。这是因为emitInput方法通过this.$emit('input', val)向父组件发送了新的logo URL,这通常会更新父组件中绑定的dataForm.logo值。

总之,dataForm.logo 字段的更新是通过组件的事件传播机制实现的:SingleUpload 组件处理文件上传,并在上传成功后通过内部事件将新的文件URL传达给父组件,父组件随后更新其数据模型中的对应字段。

40 解释 emitInput 方法通过 this.$emit('input', val) 向父组件发送了新的logo URL,这通常会更新父组件中绑定的 dataForm.logo 值 和 组件的事件传播机制

在Vue.js中,子组件可以使用this.$emit方法向其父组件发送事件。这是组件之间进行通信的常见方式之一,尤其是用于自定义事件的传播。这种机制允许子组件向上通知其父组件某些事件的发生,比如数据的改变或用户的操作,而不需要直接操作父组件的数据。

在你提供的代码中,emitInput方法的作用是在SingleUpload组件内部使用,当文件上传成功并且需要更新父组件中与之绑定的数据时调用。这里的val是指上传成功后文件在阿里云OSS上的URL。具体的方法实现可能如下所示:

emitInput(val) {

this.$emit('input', val);

}

这个方法通过this.$emit('input', val)向父组件发出一个名为input的事件,并传递新的logo URL作为事件的参数。在Vue.js中,input事件通常与v-model指令结合使用,用于创建自定义组件的双向数据绑定。当父组件监听到这个input事件时,它会更新与v-model绑定的数据属性,也就是在这个场景中的dataForm.logo。

例如,如果父组件使用了SingleUpload组件如下:

<single-upload v-model="dataForm.logo"></single-upload>

这里,父组件通过v-model将dataForm.logo绑定到SingleUpload组件。在Vue中,v-model在自定义组件上的用法本质上是一个语法糖,它等价于:

<single-upload :value="dataForm.logo" @input="value => { dataForm.logo = value }"></single-upload>

这意味着当SingleUpload组件发出input事件并传递新的URL时,父组件的dataForm.logo属性会自动更新为该URL。这就是Vue中组件事件传播机制的一个实例,它使得父子组件间的数据传递变得既简洁又高效。

40 Vue插槽机制实例

1 根据当前行的图片url,取出图片,进行展示 scope.row.logo

<el-table

:data="dataList"

border

v-loading="dataListLoading"

@selection-change="selectionChangeHandle"

style="width: 100%;">

<el-table-column

type="selection"

header-align="center"

align="center"

width="50">

</el-table-column>

<el-table-column

prop="id"

header-align="center"

align="center"

label="id">

</el-table-column>

<el-table-column

prop="name"

header-align="center"

align="center"

label="品牌名">

</el-table-column>

<el-table-column

prop="logo"

header-align="center"

align="center"

label="logo">

<!--使用插槽机制,给表格的列插入 template,显示logo图片-->

<template slot-scope="scope">

<img :src="scope.row.logo">

</template>

</el-table-column>

2 根据当前行scope.row,取出当前行的 isshow 的值scope.row.isshow

<el-table

:data="dataList"

border

v-loading="dataListLoading"

@selection-change="selectionChangeHandle"

style="width: 100%;">

<el-table-column

type="selection"

header-align="center"

align="center"

width="50">

</el-table-column>

<el-table-column

prop="id"

header-align="center"

align="center"

label="id">

</el-table-column>

<el-table-column

prop="name"

header-align="center"

align="center"

label="品牌名">

</el-table-column>

<el-table-column

prop="logo"

header-align="center"

align="center"

label="logo">

<!--使用插槽机制,给表格的列插入 template,显示logo图片-->

<template slot-scope="scope">

<img :src="scope.row.logo">

</template>

</el-table-column>

<el-table-column

prop="description"

header-align="center"

align="center"

label="说明">

</el-table-column>

<el-table-column

prop="isshow"

header-align="center"

align="center"

label="显示">

<!--引入自定义的内容,使用template和插槽机制

1. 使用插槽机制,给表格的列加入一个 template , 这可以参考 ElementUI-Table 表格-自定义列模板的代码

2. 在 template 中替换成 el-switch 控件,参考 ElementUI-Switch 开关-基本用法

3. v-model="scope.row.isshow" 动态绑定当前行的 isshow 的值

4. active-color / inactive-color 是激活和未激活的颜色

5. active-value="1" 激活状态的值,和数据库表isShow字段对应

6. inactive-value="0" 未激活状态的值,和数据库表isShow字段对应

7. @change="changeIsShow(scope.row)" 当switch控件状态切换时,会触发changeIsShow(scope.row)

,而且我们把 当前行数据scope.row传递到该方法

-->

<template slot-scope="scope">

<!--引入el-switch

绑定v-model到一个Boolean类型的变量。可以使用active-color属性与inactive-color属性来设置开关的背景色。

scope.row.isshow 通过插槽机制获取到当前行,然后再获取到isshow

el-switch 组件使用了 v-model 指令绑定到 scope.row.isshow。这意味着当开关的状态改变时,

scope.row.isshow 的值会自动更新。

el-switch 组件有两个重要的属性:active-value 和 inactive-value。

active-value 定义了当开关处于激活状态时对应的值,在你的代码中设置为 "1"。

inactive-value 定义了当开关处于非激活状态时对应的值,在你的代码中设置为 "0"。

当用户点击开关改变它的状态时,如果开关被激活,scope.row.isshow 将被设置为 "1"

(active-value 的值)。如果开关被关闭,scope.row.isshow 将被设置为 "0"

(inactive-value 的值)。

注意:

:active-value="1":这里的冒号表示 active-value 的值应该被解释为 JavaScript 表达式,因此传递给 active-value 的是数字 1。

:inactive-value="0":同样,这里的冒号表示 inactive-value 的值应该被解释为 JavaScript 表达式,因此传递给 inactive-value 的是数字 0。

如果不加冒号:

active-value="1":没有冒号,Vue 会把这里的 1 解释为字符串 "1" 而不是数字。

inactive-value="0":同样,没有冒号,0 会被解释为字符串 "0"。

-->

<el-switch

v-model="scope.row.isshow"

@change="changeIsShow(scope.row)"

:active-value="1"

:inactive-value="0"

active-color="#13ce66"

inactive-color="#ff4949">

</el-switch>

</template>

</el-table-column>

<el-table-column

prop="firstLetter"

header-align="center"

align="center"

label="检索首字母">

</el-table-column>

<el-table-column

prop="sort"

header-align="center"

align="center"

label="排序">

</el-table-column>

<el-table-column

fixed="right"

header-align="center"

align="center"

width="150"

label="操作">

<template slot-scope="scope">

<el-button type="text" size="small" @click="addOrUpdateHandle(scope.row.id)">修改</el-button>

<!-- <el-button type="text" size="small" @click="deleteHandle(scope.row.id)">删除</el-button>-->

<el-button type="text" size="small" @click="deleteHandle(scope.row.id,scope.row.name)">删除</el-button>

</template>

</el-table-column>

</el-table>

42 图片的css样式只设置宽度style="width: 80px",图片就会按照比例进行缩小

<!--使用插槽机制,给表格的列插入 template,显示logo图片

style="width: 80px", 这里图片的样式只设置宽度,图片就会按照比例进行缩小展示

不需要再指定图片的高度,否则图片有可能会变形

-->

<template slot-scope="scope">

<img :src="scope.row.logo" style="width: 80px">

</template>

43 网关Gateway的 lb://

在 Spring Cloud Gateway 中,lb:// 是一种特殊的 URI 前缀,用于启用客户端负载均衡。当你在路由配置中使用 uri: lb://some-service 时,它告诉 Spring Cloud Gateway 使用 Spring Cloud 的负载均衡机制来解析服务实例并进行请求转发。

具体来说,lb://member-service-provider 中的 lb 表示“负载均衡(Load Balancer)”,member-service-provider 是注册到 Eureka 或其他服务发现平台的服务名称。这意味着当网关收到一个请求,它会通过服务发现获取 member-service-provider 的所有可用实例,然后根据配置的负载均衡策略(如轮询、随机等)选择一个实例,并将请求转发到该实例上。

这种机制允许你的微服务架构动态扩展,因为网关会根据服务实例的当前可用性和负载情况来转发请求,而不是写死到一个具体的服务实例上。这也是微服务架构中常见的做法,用于实现服务的高可用和负载均衡。

44 使用 lb:// 与使用 http:// 在 Spring Cloud Gateway 中主要有以下区别:

lb://(负载均衡):

-

服务发现与负载均衡:当你在路由配置中使用

lb://前缀,这表明你想要使用 Spring Cloud 的负载均衡机制。这意味着网关将通过服务发现机制(如Eureka、Consul等)查询服务名对应的所有可用实例,并根据负载均衡策略选择一个实例来转发请求。 -

动态路由:使用

lb://使得路由更加动态和灵活。你不需要知道后端服务的具体实例地址,也不需要手动更改配置以指向新的服务实例。如果服务实例的地址更改,或者添加了更多的实例,网关能够自动适应这些变化。 -

服务抽象:使用

lb://实现了对后端服务的抽象,你只需要知道服务的名称。这有助于解耦服务消费者和提供者,也使得服务的迁移和伸缩更加方便。

http://(直接路由):

-

静态路由:使用

http://前缀时,你需要指定具体的服务实例地址。这种方式更静态,如果后端服务的地址改变,你需要手动更新网关的配置。 -

无服务发现:与

lb://不同,使用http://不会涉及服务发现和负载均衡。请求会被直接发送到指定的地址,无论这个地址背后是单个服务实例还是一个负载均衡器。 -

直接控制:虽然这种方式灵活性较低,但它允许你直接控制请求应该转发到哪里,有时在调试或特定场景下可能会很有用。

总结来说,lb:// 提供了基于服务名的动态路由能力,适合于微服务架构中服务实例动态变化的环境。而 http:// 提供了基于具体地址的静态路由能力,可能适合于后端服务位置固定不变或不使用服务发现机制的环境。在实际应用中,选择哪种方式取决于你的具体需求和架构设计。

45 通过 lb:// 转发的请求仍然是 HTTP 请求。

是的,最终通过 lb:// 转发的请求仍然是 HTTP 请求。

在 Spring Cloud Gateway 中,使用 lb:// 是为了启用负载均衡功能,这个过程是透明的。当你在路由配置中使用 lb:// 时,这意味着你希望网关先通过服务发现机制找到对应服务的所有可用实例,然后根据负载均衡策略选择一个实例,并对这个选择的实例发起 HTTP 请求。

这个流程如下:

-

服务发现:当网关接收到一个包含

lb://的请求时,它会查询服务注册中心(如Eureka、Consul等)以获取指定服务的所有活跃实例。 -

负载均衡:然后,根据配置的负载均衡策略(如轮询、随机等),网关选择一个实例。

-

请求转发:最后,网关将原始请求转发到选定的服务实例上。这个请求是一个普通的 HTTP 请求,只是它的目标地址是由网关动态选定的服务实例地址。

因此,尽管 lb:// 在请求的URI中指代的是一种服务发现和负载均衡的机制,但实际上请求仍然是通过 HTTP 协议发送的。在 Spring Cloud Gateway 处理这类请求时,lb:// 只是用来告知网关需要进行服务发现和负载均衡,最终发出的仍然是 HTTP 或 HTTPS 请求。

46 执行 Maven 的 clean 命令会删除所有编译的类和构建产物,而 package 命令会重新编译代码并打包,这就相当于强制刷新了整个构建和输出过程,因此通常能够解决修改了代码但未生效问题。

47 如果同时引入了Gateway和web-starter报错:

Spring MVC found on classpath, which is incompatible with Spring Cloud Gateway at this time. Please remove spring-boot-starter-web dependency.

<!--

1. gateway本身不需要 spring-boot-starter-web

2. 所以不用引入 spring-boot-starter-web,如果引入spring-boot-starter-web,启动时会报告冲突

-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

<!--<version>Greenwich.SR3</version>-->

<!--Greenwich.SR3 实际上是一个 Spring Cloud 的版本号

,它不直接对应于 Spring Cloud Gateway 的任何版本。-->

</dependency>

<!--导入web项目场景启动器: 会自动导入和web开发相关的所有依赖[库/jar]

后面老师还会说spring-boot-starter-web 到底引入哪些相关依赖

web项目场景启动器,这里是真正的引入了依赖

starter-web 版本不需要指定 在父工程已经指定好了

-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

C:\jdk\jdk1.8\bin\java.exe -XX:TieredStopAtLevel=1 -noverify -Dspring.output.ansi.enabled=always -Dcom.sun.management.jmxremote -Dspring.jmx.enabled=true -Dspring.liveBeansView.mbeanDomain -Dspring.application.admin.enabled=true "-javaagent:D:\Java_developer_tools\developer_tools_IDEA\IntelliJ IDEA 2020.2.1\lib\idea_rt.jar=55878:D:\Java_developer_tools\developer_tools_IDEA\IntelliJ IDEA 2020.2.1\bin" -Dfile.encoding=UTF-8 -classpath C:\jdk\jdk1.8\jre\lib\charsets.jar;C:\jdk\jdk1.8\jre\lib\deploy.jar;C:\jdk\jdk1.8\jre\lib\ext\access-bridge-64.jar;C:\jdk\jdk1.8\jre\lib\ext\cldrdata.jar;C:\jdk\jdk1.8\jre\lib\ext\dnsns.jar;C:\jdk\jdk1.8\jre\lib\ext\jaccess.jar;C:\jdk\jdk1.8\jre\lib\ext\jfxrt.jar;C:\jdk\jdk1.8\jre\lib\ext\localedata.jar;C:\jdk\jdk1.8\jre\lib\ext\nashorn.jar;C:\jdk\jdk1.8\jre\lib\ext\sunec.jar;C:\jdk\jdk1.8\jre\lib\ext\sunjce_provider.jar;C:\jdk\jdk1.8\jre\lib\ext\sunmscapi.jar;C:\jdk\jdk1.8\jre\lib\ext\sunpkcs11.jar;C:\jdk\jdk1.8\jre\lib\ext\zipfs.jar;C:\jdk\jdk1.8\jre\lib\javaws.jar;C:\jdk\jdk1.8\jre\lib\jce.jar;C:\jdk\jdk1.8\jre\lib\jfr.jar;C:\jdk\jdk1.8\jre\lib\jfxswt.jar;C:\jdk\jdk1.8\jre\lib\jsse.jar;C:\jdk\jdk1.8\jre\lib\management-agent.jar;C:\jdk\jdk1.8\jre\lib\plugin.jar;C:\jdk\jdk1.8\jre\lib\resources.jar;C:\jdk\jdk1.8\jre\lib\rt.jar;D:\Java_developer_tools\DistributedMicroservicesProject\hspedu_hspliving\hspliving\hspliving-gateway\target\classes;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-starter-gateway\2.1.3.RELEASE\spring-cloud-starter-gateway-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-starter\2.1.3.RELEASE\spring-cloud-starter-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-context\2.1.3.RELEASE\spring-cloud-context-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\security\spring-security-crypto\5.1.6.RELEASE\spring-security-crypto-5.1.6.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-commons\2.1.3.RELEASE\spring-cloud-commons-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\security\spring-security-rsa\1.0.7.RELEASE\spring-security-rsa-1.0.7.RELEASE.jar;C:\Users\yangd\.m2\repository\org\bouncycastle\bcpkix-jdk15on\1.60\bcpkix-jdk15on-1.60.jar;C:\Users\yangd\.m2\repository\org\bouncycastle\bcprov-jdk15on\1.60\bcprov-jdk15on-1.60.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-gateway-core\2.1.3.RELEASE\spring-cloud-gateway-core-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\io\projectreactor\addons\reactor-extra\3.2.3.RELEASE\reactor-extra-3.2.3.RELEASE.jar;C:\Users\yangd\.m2\repository\io\projectreactor\reactor-core\3.2.12.RELEASE\reactor-core-3.2.12.RELEASE.jar;C:\Users\yangd\.m2\repository\org\reactivestreams\reactive-streams\1.0.3\reactive-streams-1.0.3.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-webflux\2.1.8.RELEASE\spring-boot-starter-webflux-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-reactor-netty\2.1.8.RELEASE\spring-boot-starter-reactor-netty-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\io\projectreactor\netty\reactor-netty\0.8.11.RELEASE\reactor-netty-0.8.11.RELEASE.jar;C:\Users\yangd\.m2\repository\io\netty\netty-codec-http\4.1.39.Final\netty-codec-http-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-common\4.1.39.Final\netty-common-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-buffer\4.1.39.Final\netty-buffer-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-transport\4.1.39.Final\netty-transport-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-resolver\4.1.39.Final\netty-resolver-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-codec\4.1.39.Final\netty-codec-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-codec-http2\4.1.39.Final\netty-codec-http2-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-handler\4.1.39.Final\netty-handler-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-handler-proxy\4.1.39.Final\netty-handler-proxy-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-codec-socks\4.1.39.Final\netty-codec-socks-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\io\netty\netty-transport-native-epoll\4.1.39.Final\netty-transport-native-epoll-4.1.39.Final-linux-x86_64.jar;C:\Users\yangd\.m2\repository\io\netty\netty-transport-native-unix-common\4.1.39.Final\netty-transport-native-unix-common-4.1.39.Final.jar;C:\Users\yangd\.m2\repository\org\glassfish\javax.el\3.0.0\javax.el-3.0.0.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-webflux\5.1.9.RELEASE\spring-webflux-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\synchronoss\cloud\nio-multipart-parser\1.1.0\nio-multipart-parser-1.1.0.jar;C:\Users\yangd\.m2\repository\org\synchronoss\cloud\nio-stream-storage\1.1.3\nio-stream-storage-1.1.3.jar;D:\Java_developer_tools\DistributedMicroservicesProject\hspedu_hspliving\hspliving\hspliving-common\target\classes;C:\Users\yangd\.m2\repository\com\alibaba\cloud\spring-cloud-starter-alibaba-nacos-discovery\2.1.0.RELEASE\spring-cloud-starter-alibaba-nacos-discovery-2.1.0.RELEASE.jar;C:\Users\yangd\.m2\repository\com\alibaba\cloud\spring-cloud-alibaba-nacos-discovery\2.1.0.RELEASE\spring-cloud-alibaba-nacos-discovery-2.1.0.RELEASE.jar;C:\Users\yangd\.m2\repository\com\alibaba\nacos\nacos-client\1.1.1\nacos-client-1.1.1.jar;C:\Users\yangd\.m2\repository\com\alibaba\nacos\nacos-common\1.1.1\nacos-common-1.1.1.jar;C:\Users\yangd\.m2\repository\commons-io\commons-io\2.2\commons-io-2.2.jar;C:\Users\yangd\.m2\repository\org\apache\commons\commons-lang3\3.8.1\commons-lang3-3.8.1.jar;C:\Users\yangd\.m2\repository\com\alibaba\nacos\nacos-api\1.1.1\nacos-api-1.1.1.jar;C:\Users\yangd\.m2\repository\com\alibaba\fastjson\1.2.47\fastjson-1.2.47.jar;C:\Users\yangd\.m2\repository\com\google\guava\guava\19.0\guava-19.0.jar;C:\Users\yangd\.m2\repository\commons-codec\commons-codec\1.11\commons-codec-1.11.jar;C:\Users\yangd\.m2\repository\io\prometheus\simpleclient\0.5.0\simpleclient-0.5.0.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-starter-netflix-ribbon\2.1.3.RELEASE\spring-cloud-starter-netflix-ribbon-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-netflix-ribbon\2.1.3.RELEASE\spring-cloud-netflix-ribbon-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-netflix-archaius\2.1.3.RELEASE\spring-cloud-netflix-archaius-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\cloud\spring-cloud-starter-netflix-archaius\2.1.3.RELEASE\spring-cloud-starter-netflix-archaius-2.1.3.RELEASE.jar;C:\Users\yangd\.m2\repository\com\netflix\archaius\archaius-core\0.7.6\archaius-core-0.7.6.jar;C:\Users\yangd\.m2\repository\com\google\code\findbugs\jsr305\3.0.1\jsr305-3.0.1.jar;C:\Users\yangd\.m2\repository\commons-configuration\commons-configuration\1.8\commons-configuration-1.8.jar;C:\Users\yangd\.m2\repository\com\netflix\ribbon\ribbon\2.3.0\ribbon-2.3.0.jar;C:\Users\yangd\.m2\repository\com\netflix\ribbon\ribbon-transport\2.3.0\ribbon-transport-2.3.0.jar;C:\Users\yangd\.m2\repository\io\reactivex\rxnetty-contexts\0.4.9\rxnetty-contexts-0.4.9.jar;C:\Users\yangd\.m2\repository\io\reactivex\rxnetty-servo\0.4.9\rxnetty-servo-0.4.9.jar;C:\Users\yangd\.m2\repository\com\netflix\hystrix\hystrix-core\1.5.18\hystrix-core-1.5.18.jar;C:\Users\yangd\.m2\repository\org\hdrhistogram\HdrHistogram\2.1.9\HdrHistogram-2.1.9.jar;C:\Users\yangd\.m2\repository\javax\inject\javax.inject\1\javax.inject-1.jar;C:\Users\yangd\.m2\repository\io\reactivex\rxnetty\0.4.9\rxnetty-0.4.9.jar;C:\Users\yangd\.m2\repository\com\netflix\ribbon\ribbon-core\2.3.0\ribbon-core-2.3.0.jar;C:\Users\yangd\.m2\repository\com\netflix\ribbon\ribbon-httpclient\2.3.0\ribbon-httpclient-2.3.0.jar;C:\Users\yangd\.m2\repository\commons-collections\commons-collections\3.2.2\commons-collections-3.2.2.jar;C:\Users\yangd\.m2\repository\org\apache\httpcomponents\httpclient\4.5.9\httpclient-4.5.9.jar;C:\Users\yangd\.m2\repository\com\sun\jersey\jersey-client\1.19.1\jersey-client-1.19.1.jar;C:\Users\yangd\.m2\repository\com\sun\jersey\jersey-core\1.19.1\jersey-core-1.19.1.jar;C:\Users\yangd\.m2\repository\javax\ws\rs\jsr311-api\1.1.1\jsr311-api-1.1.1.jar;C:\Users\yangd\.m2\repository\com\sun\jersey\contribs\jersey-apache-client4\1.19.1\jersey-apache-client4-1.19.1.jar;C:\Users\yangd\.m2\repository\com\netflix\servo\servo-core\0.12.21\servo-core-0.12.21.jar;C:\Users\yangd\.m2\repository\com\netflix\netflix-commons\netflix-commons-util\0.3.0\netflix-commons-util-0.3.0.jar;C:\Users\yangd\.m2\repository\com\netflix\ribbon\ribbon-loadbalancer\2.3.0\ribbon-loadbalancer-2.3.0.jar;C:\Users\yangd\.m2\repository\com\netflix\netflix-commons\netflix-statistics\0.1.1\netflix-statistics-0.1.1.jar;C:\Users\yangd\.m2\repository\io\reactivex\rxjava\1.3.8\rxjava-1.3.8.jar;C:\Users\yangd\.m2\repository\mysql\mysql-connector-java\8.0.17\mysql-connector-java-8.0.17.jar;C:\Users\yangd\.m2\repository\org\projectlombok\lombok\1.18.8\lombok-1.18.8.jar;C:\Users\yangd\.m2\repository\org\apache\httpcomponents\httpcore\4.4.12\httpcore-4.4.12.jar;C:\Users\yangd\.m2\repository\commons-lang\commons-lang\2.6\commons-lang-2.6.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-web\2.1.8.RELEASE\spring-boot-starter-web-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter\2.1.8.RELEASE\spring-boot-starter-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot\2.1.8.RELEASE\spring-boot-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-autoconfigure\2.1.8.RELEASE\spring-boot-autoconfigure-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-logging\2.1.8.RELEASE\spring-boot-starter-logging-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\ch\qos\logback\logback-classic\1.2.3\logback-classic-1.2.3.jar;C:\Users\yangd\.m2\repository\ch\qos\logback\logback-core\1.2.3\logback-core-1.2.3.jar;C:\Users\yangd\.m2\repository\org\apache\logging\log4j\log4j-to-slf4j\2.11.2\log4j-to-slf4j-2.11.2.jar;C:\Users\yangd\.m2\repository\org\apache\logging\log4j\log4j-api\2.11.2\log4j-api-2.11.2.jar;C:\Users\yangd\.m2\repository\org\slf4j\jul-to-slf4j\1.7.28\jul-to-slf4j-1.7.28.jar;C:\Users\yangd\.m2\repository\javax\annotation\javax.annotation-api\1.3.2\javax.annotation-api-1.3.2.jar;C:\Users\yangd\.m2\repository\org\yaml\snakeyaml\1.23\snakeyaml-1.23.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-json\2.1.8.RELEASE\spring-boot-starter-json-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\core\jackson-databind\2.9.9.3\jackson-databind-2.9.9.3.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\core\jackson-annotations\2.9.0\jackson-annotations-2.9.0.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\core\jackson-core\2.9.9\jackson-core-2.9.9.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\datatype\jackson-datatype-jdk8\2.9.9\jackson-datatype-jdk8-2.9.9.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\datatype\jackson-datatype-jsr310\2.9.9\jackson-datatype-jsr310-2.9.9.jar;C:\Users\yangd\.m2\repository\com\fasterxml\jackson\module\jackson-module-parameter-names\2.9.9\jackson-module-parameter-names-2.9.9.jar;C:\Users\yangd\.m2\repository\org\springframework\boot\spring-boot-starter-tomcat\2.1.8.RELEASE\spring-boot-starter-tomcat-2.1.8.RELEASE.jar;C:\Users\yangd\.m2\repository\org\apache\tomcat\embed\tomcat-embed-core\9.0.24\tomcat-embed-core-9.0.24.jar;C:\Users\yangd\.m2\repository\org\apache\tomcat\embed\tomcat-embed-el\9.0.24\tomcat-embed-el-9.0.24.jar;C:\Users\yangd\.m2\repository\org\apache\tomcat\embed\tomcat-embed-websocket\9.0.24\tomcat-embed-websocket-9.0.24.jar;C:\Users\yangd\.m2\repository\org\hibernate\validator\hibernate-validator\6.0.17.Final\hibernate-validator-6.0.17.Final.jar;C:\Users\yangd\.m2\repository\javax\validation\validation-api\2.0.1.Final\validation-api-2.0.1.Final.jar;C:\Users\yangd\.m2\repository\org\jboss\logging\jboss-logging\3.3.3.Final\jboss-logging-3.3.3.Final.jar;C:\Users\yangd\.m2\repository\com\fasterxml\classmate\1.4.0\classmate-1.4.0.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-web\5.1.9.RELEASE\spring-web-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-beans\5.1.9.RELEASE\spring-beans-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-webmvc\5.1.9.RELEASE\spring-webmvc-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-aop\5.1.9.RELEASE\spring-aop-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-context\5.1.9.RELEASE\spring-context-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-expression\5.1.9.RELEASE\spring-expression-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\slf4j\slf4j-api\1.7.28\slf4j-api-1.7.28.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-core\5.1.9.RELEASE\spring-core-5.1.9.RELEASE.jar;C:\Users\yangd\.m2\repository\org\springframework\spring-jcl\5.1.9.RELEASE\spring-jcl-5.1.9.RELEASE.jar com.hspedu.hspliving.gateway.HsplivingGatewayApplication

2024-03-11 23:51:51.453 INFO 19940 --- [ main] trationDelegate$BeanPostProcessorChecker : Bean 'org.springframework.cloud.autoconfigure.ConfigurationPropertiesRebinderAutoConfiguration' of type [org.springframework.cloud.autoconfigure.ConfigurationPropertiesRebinderAutoConfiguration$$EnhancerBySpringCGLIB$$bf9326d3] is not eligible for getting processed by all BeanPostProcessors (for example: not eligible for auto-proxying)

. ____ _ __ _ _

/\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \

( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \

\\/ ___)| |_)| | | | | || (_| | ) ) ) )

' |____| .__|_| |_|_| |_\__, | / / / /

=========|_|==============|___/=/_/_/_/

:: Spring Boot :: (v2.1.8.RELEASE)

2024-03-11 23:51:53.522 INFO 19940 --- [ main] c.h.h.g.HsplivingGatewayApplication : No active profile set, falling back to default profiles: default