『n8n』接入本地部署的 DeepSeek

点赞 + 关注 + 收藏 = 学会了

整理了一个n8n小专栏,有兴趣的工友可以关注一下 👉 《n8n修炼手册》

在 AI 自动化场景中,n8n 搭配本地 DeepSeek 大模型,既能保障数据隐私,又能实现灵活的自动化交互。跟着本文步骤走,半小时就能搞定 DeepSeek 私有化部署并接入到 n8n 中使用。

核心工具说明

- DeepSeek:我们要用到的本地大模型,擅长对话、创作、推理,本地部署后无需联网调用外部API。

- Ollama:简化本地大模型部署的工具,自动处理环境依赖和模型加载。

- n8n:工作流自动化平台,通过可视化界面拖拽节点,就能实现“触发条件→调用模型→获取结果”的全流程。

本地部署DeepSeek

这一步核心是让DeepSeek在你电脑上“跑起来”,全程用工具自动完成,无需手动配置环境。

安装Ollama

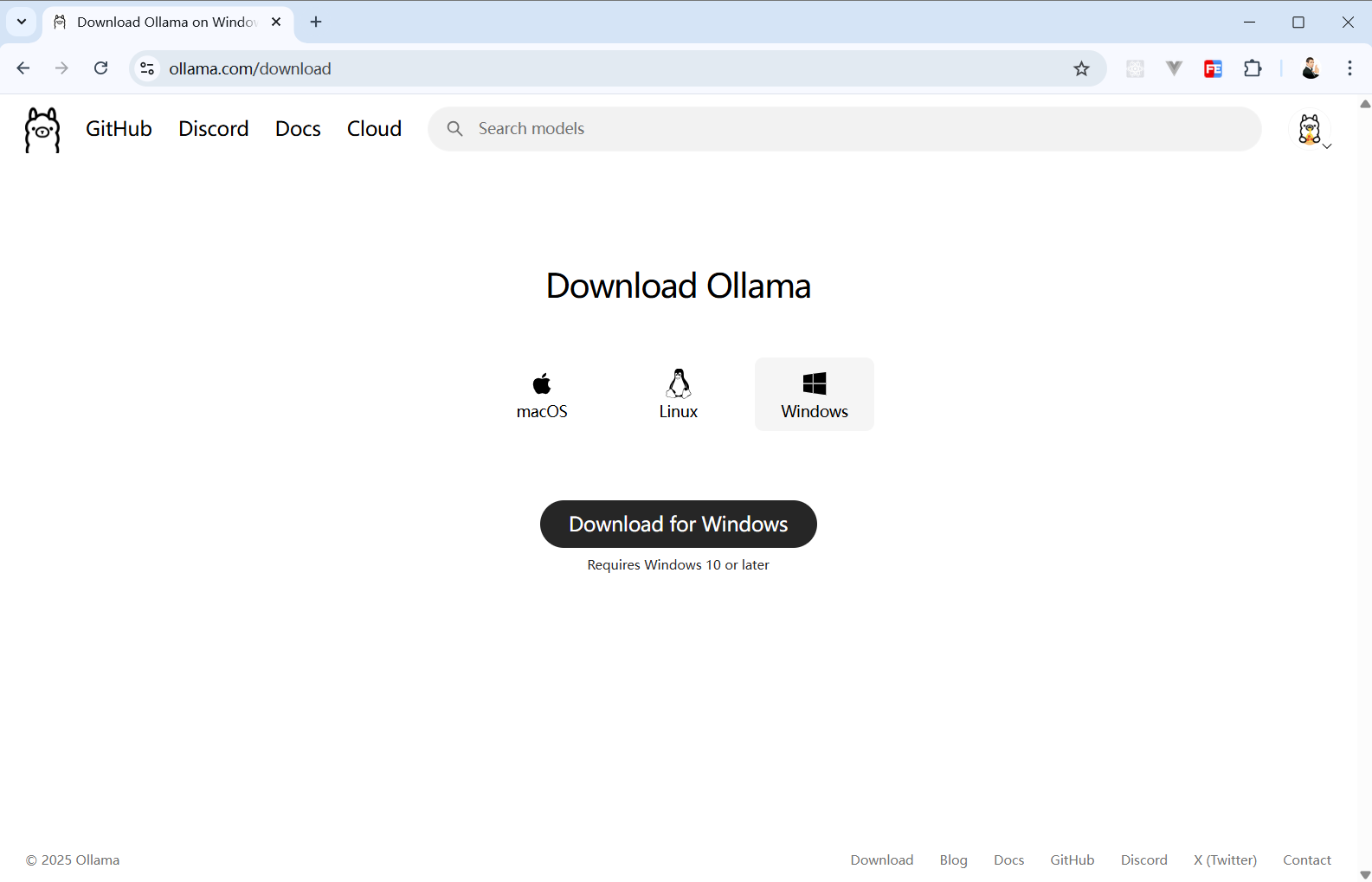

打开 Ollama 官网,切换到客户端下载页面👉 https://ollama.com/download

根据你使用的系统下载对应版本的安装包。

安装完成后,打开终端(Windows按Win+R输cmd),输入 ollama list,若终端无报错(即使无模型列表),说明安装成功。

下载并启动DeepSeek模型

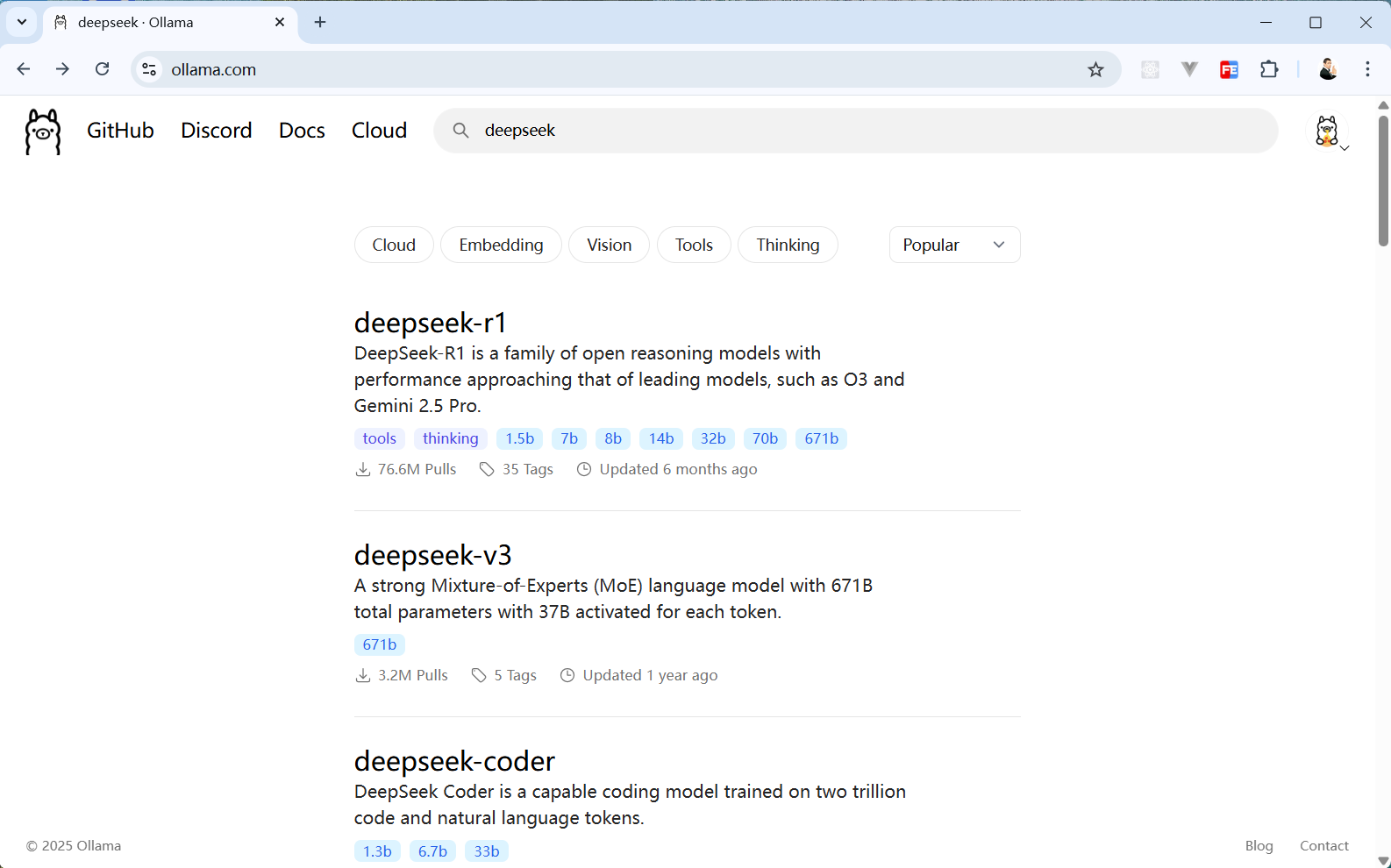

在 Ollama 官网搜索 DeepSeek,可以看到一堆搜索结果。

我电脑配置不是很高,但运行小尺寸 deepseek-r1 是没问题的,你可以根据自己的喜好和电脑配置选择一个心仪的模型。

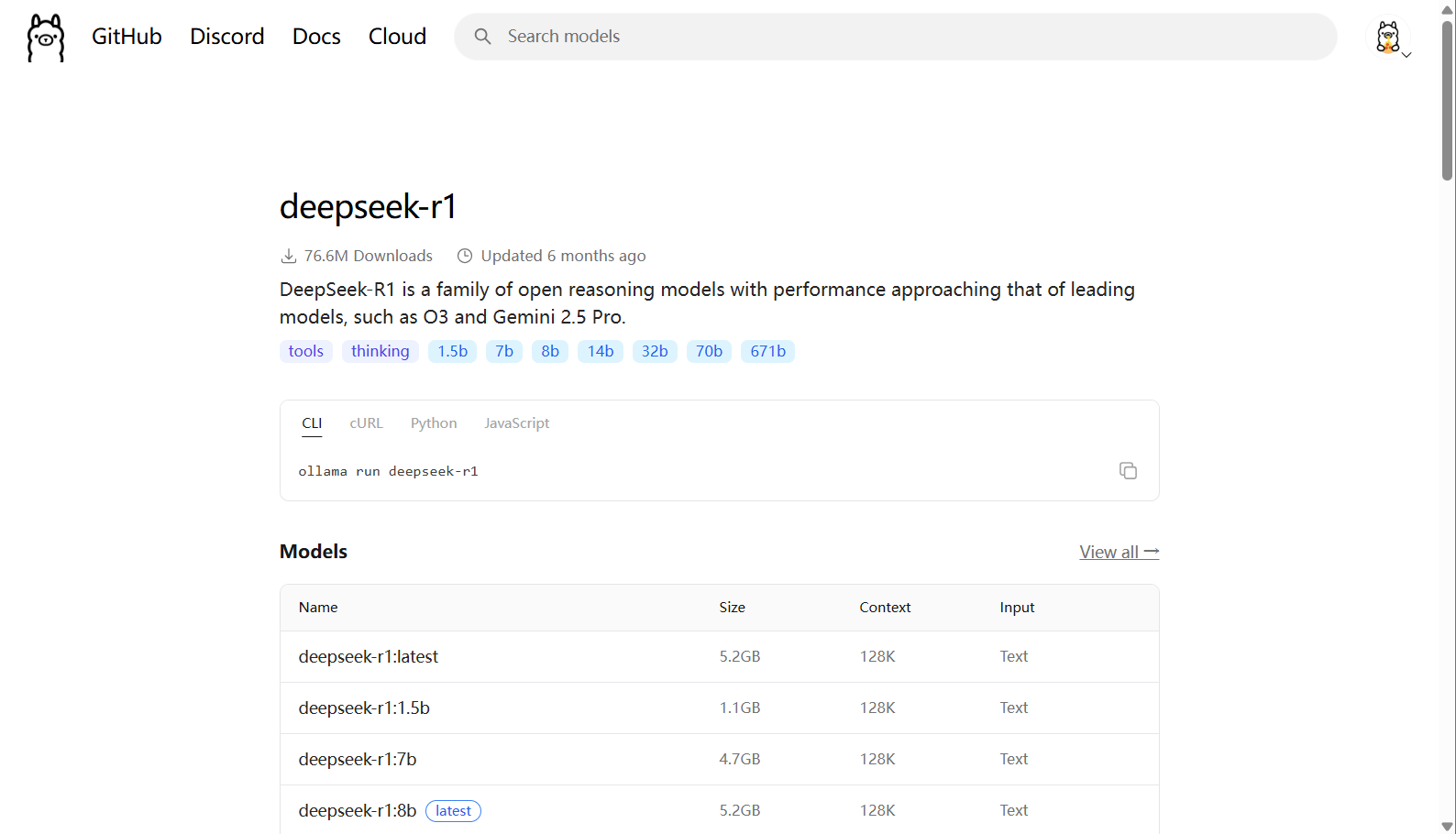

点击 deepseek-r1 可以看到这个模型又有几个不同参数规模的版本。我这次使用的是 8b 这个规模的模型。

从 Ollama 网站上可以很直观的看到模型的下载命令。

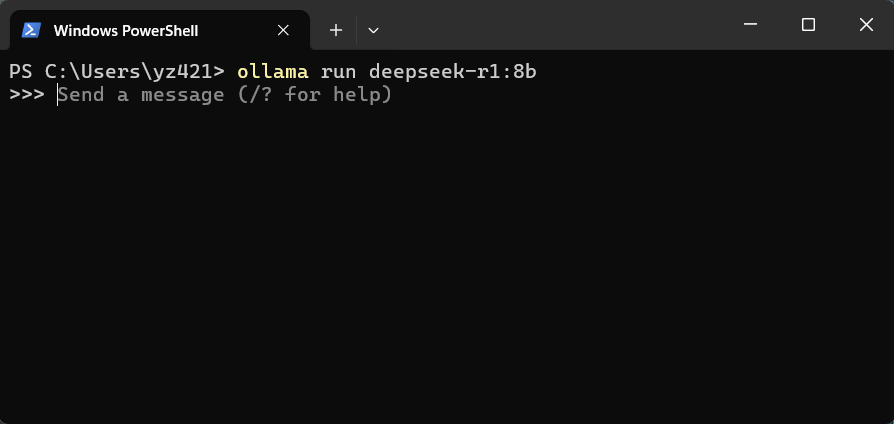

打开终端输入下面这条命令就开始下载并自动运行 deepseek-r1:8b 这个模型。

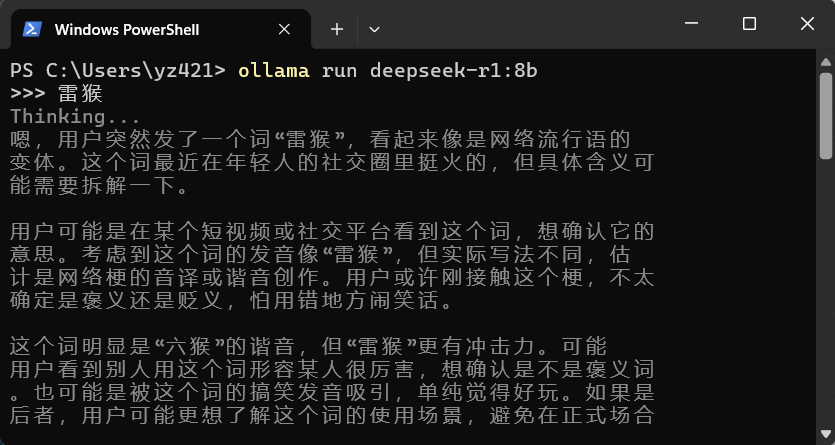

ollama run deepseek-r1:8b

你想下载其他规模的模型,只需要调整上面这条命令冒号后面的参数规模即可。

如果你的电脑没有独立显卡,又或者你是在 NAS 上运行的话,建议使用 1.5b 这个规模的模型。

模型下载成功后就会自动运行,如果没抱错的话就会看到上图内容 >>> Send a message (/? for help)。

此时在终端可以和大模型聊天了。

ollama run xxx 这条命令是会自动下载并运行指定的模型,如果你只想下载,不想它自动运行的话,可以使用这条命令 ollama pull xxx。

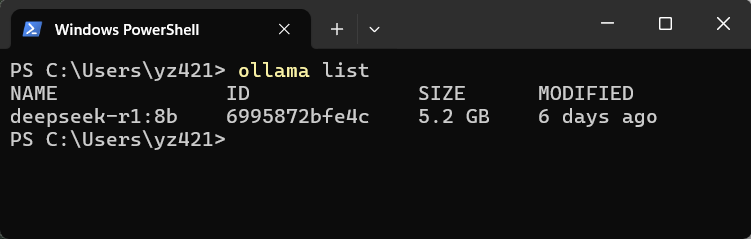

模型下载成功后,可以使用 ollama list 查看当前电脑下载过的所有模型。

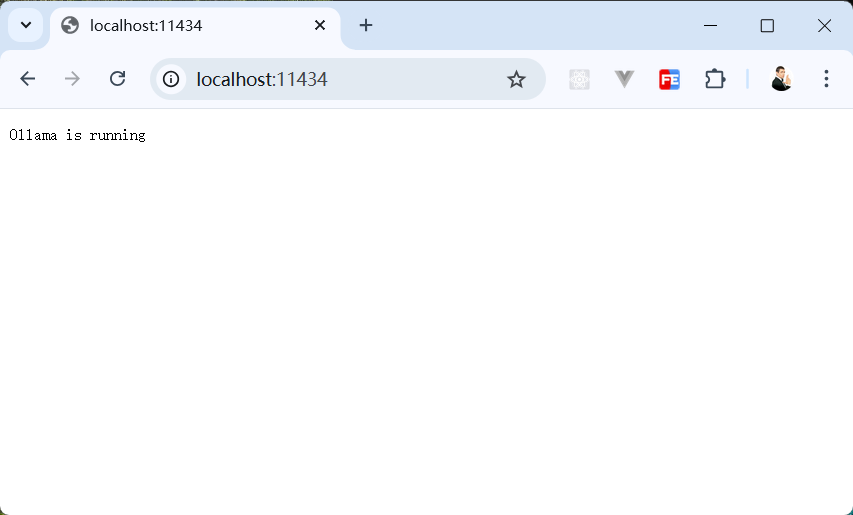

模型运行成功后,我们在浏览器打开 localhost:11434 ,如果看到浏览器页面出现 Ollama is running 证明运行成功。

n8n 接入 DeepSeek

安装 n8n

如果你还没安装 n8n,可以按你的需求跟着以下文章操作:

- 在电脑安装 n8n:『n8n』环境搭建

- 在 NAS 上安装 n8n:『NAS』不止娱乐,NAS也是生产力,在绿联部署AI工作流工具-n8n

创建工作流

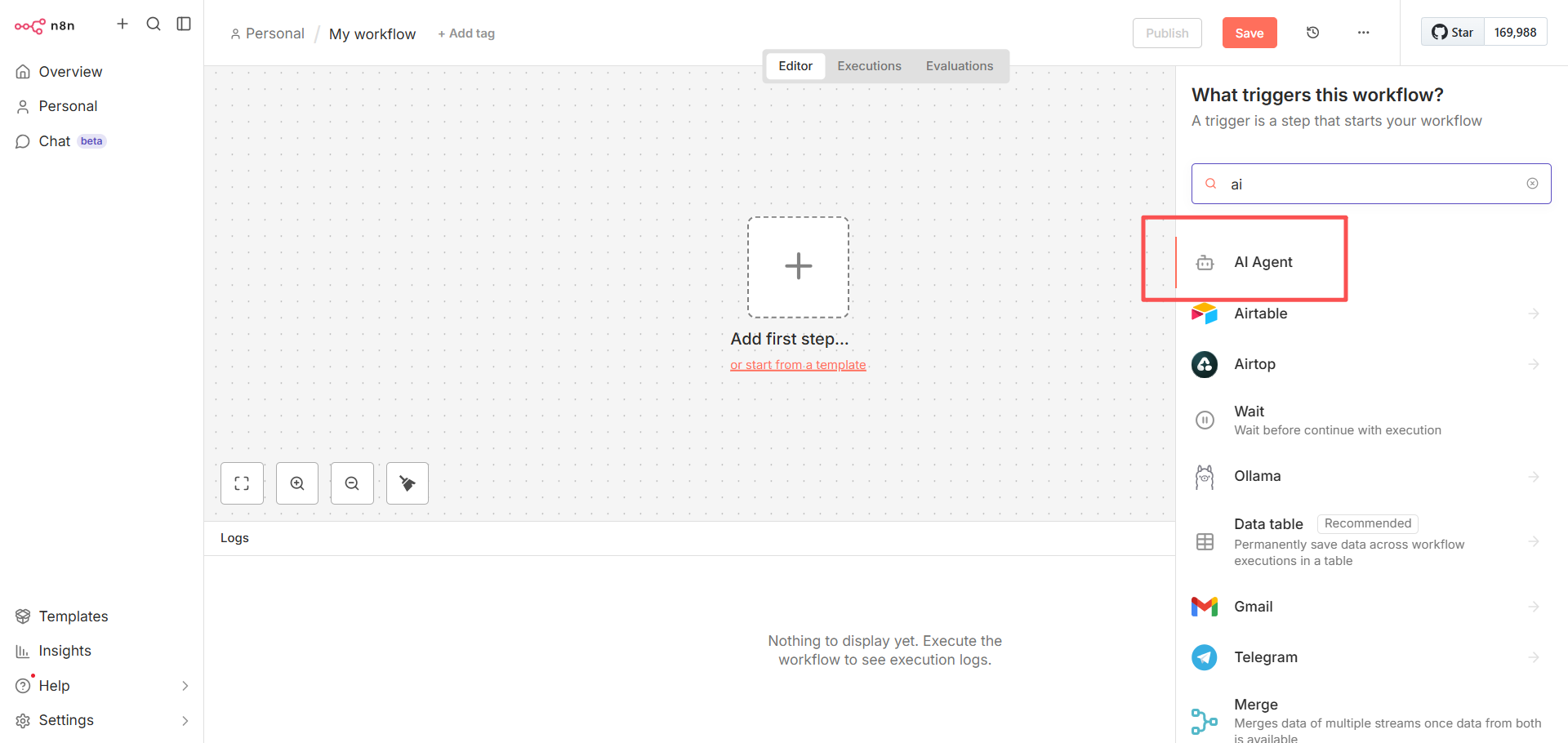

n8n 安装成功后,在浏览器输入 n8n 的访问地址,创建一个工作流。

http://localhost:5678

点击画布中间的加号,在节点面板搜索 ai ,创建一个 AI Agent 节点。

创建 AI Agent 节点

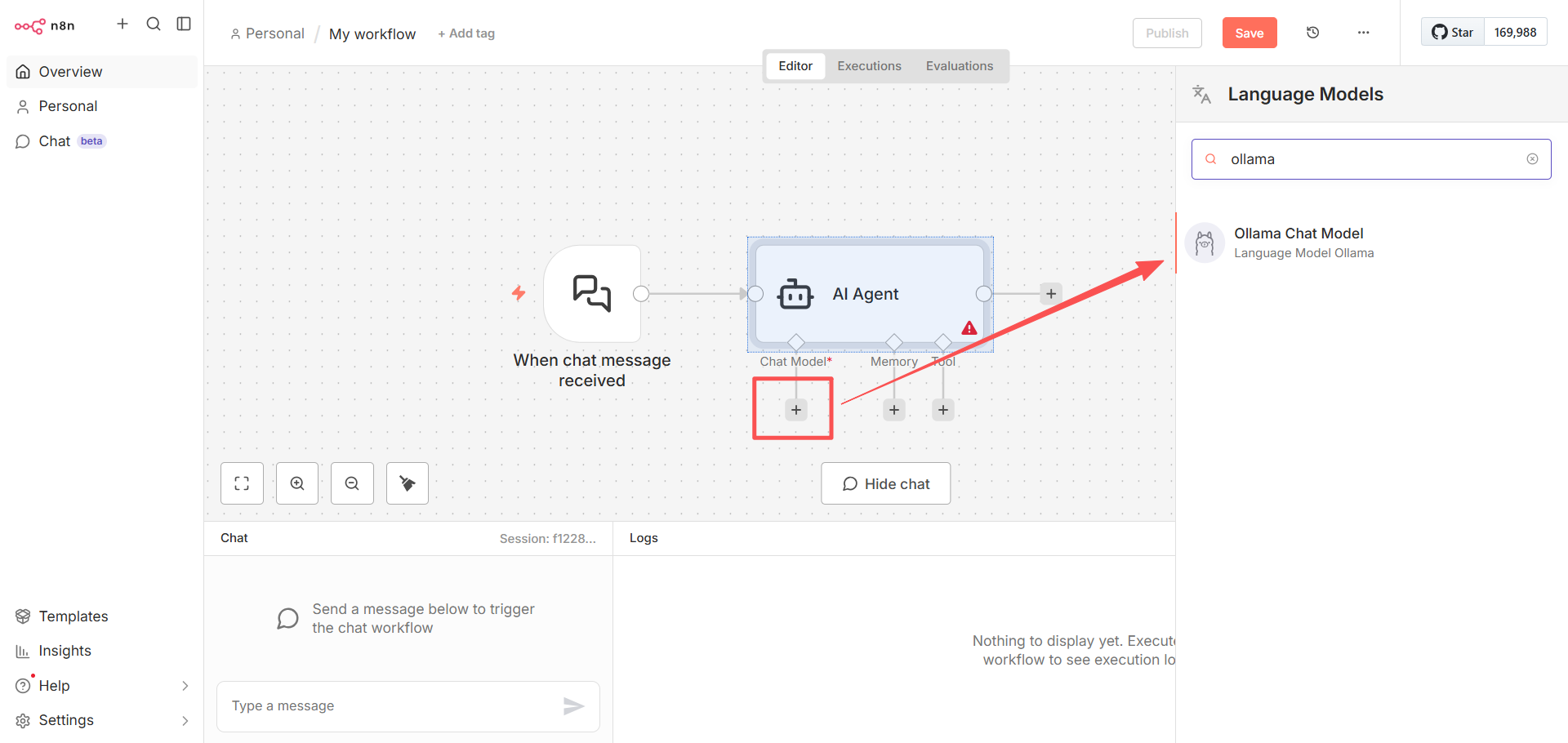

点击 AI Agent 下方 Chat Model 的加号,搜索 ollama,选择 Ollama Chat Model 节点。

连接 Ollama

如果你没配置过 Ollama,首次配置会出现下图这种情况。

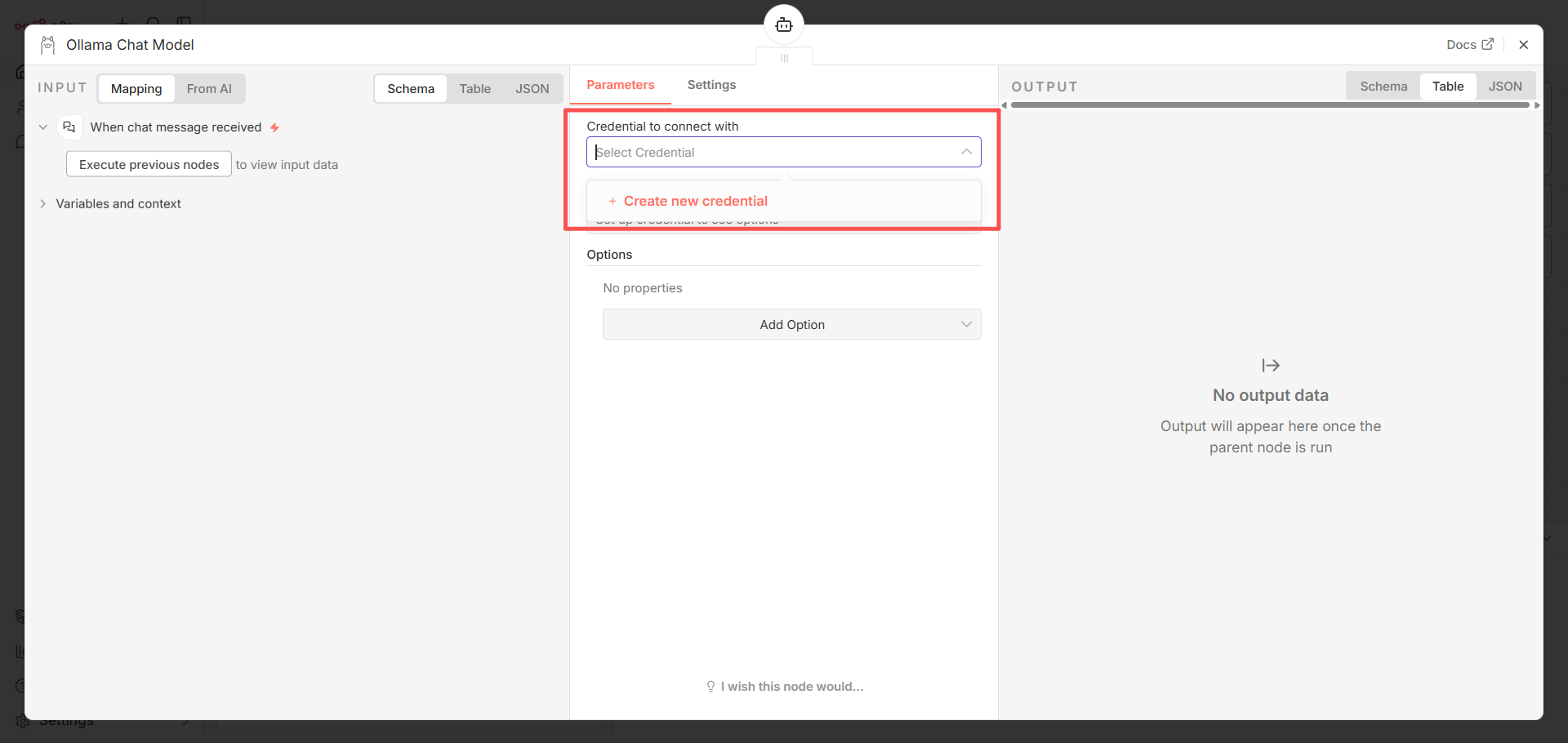

点击 Credential to connect with 这项,选择 Create new credential。

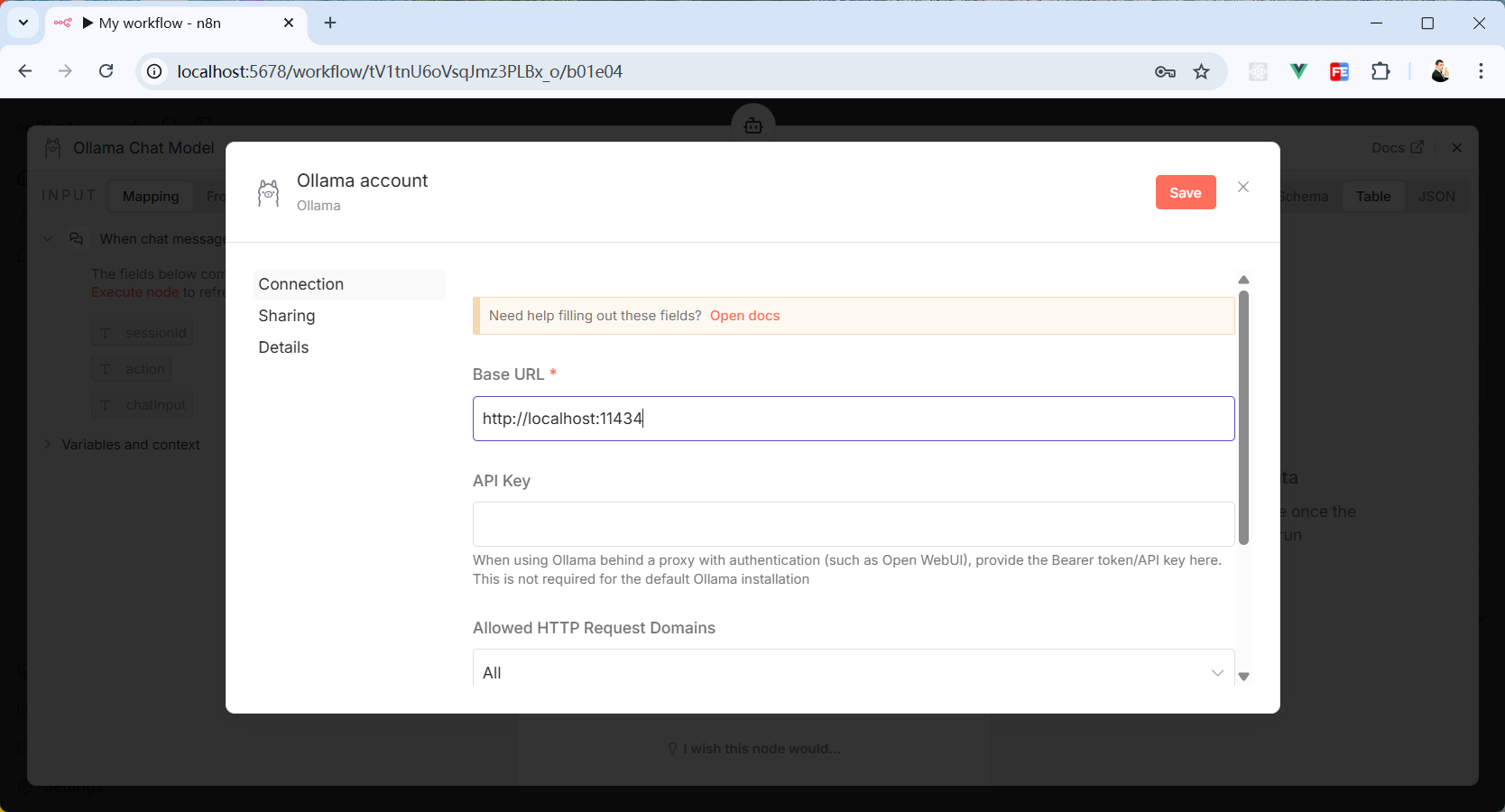

在 Base URL 里输入 Ollama 开放出来的地址(前面已经运行 Ollama了)。

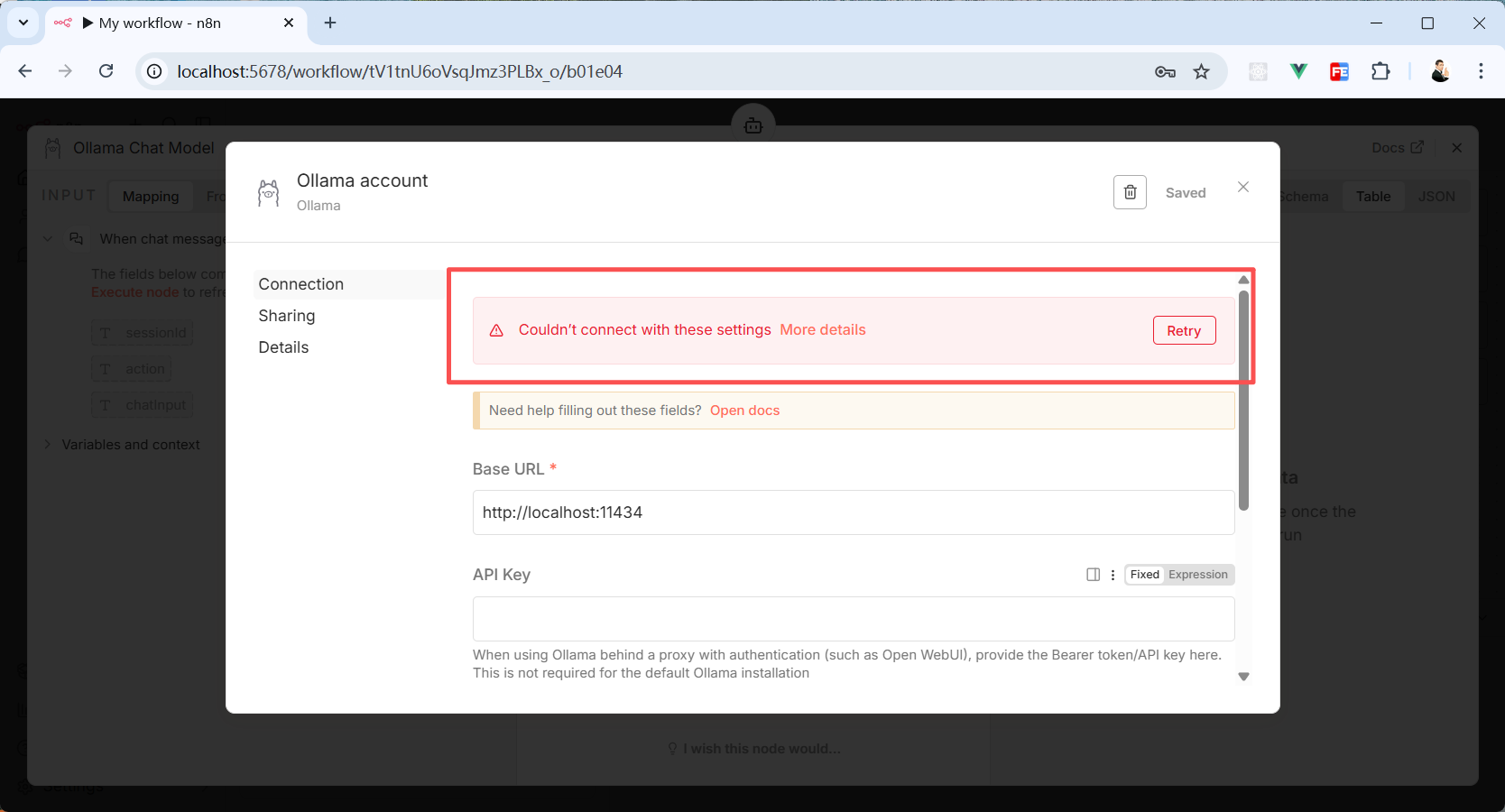

点击弹窗右上角的“Save”按钮会发现报错了。意思是连不上 Ollama。

很奇怪对吧。

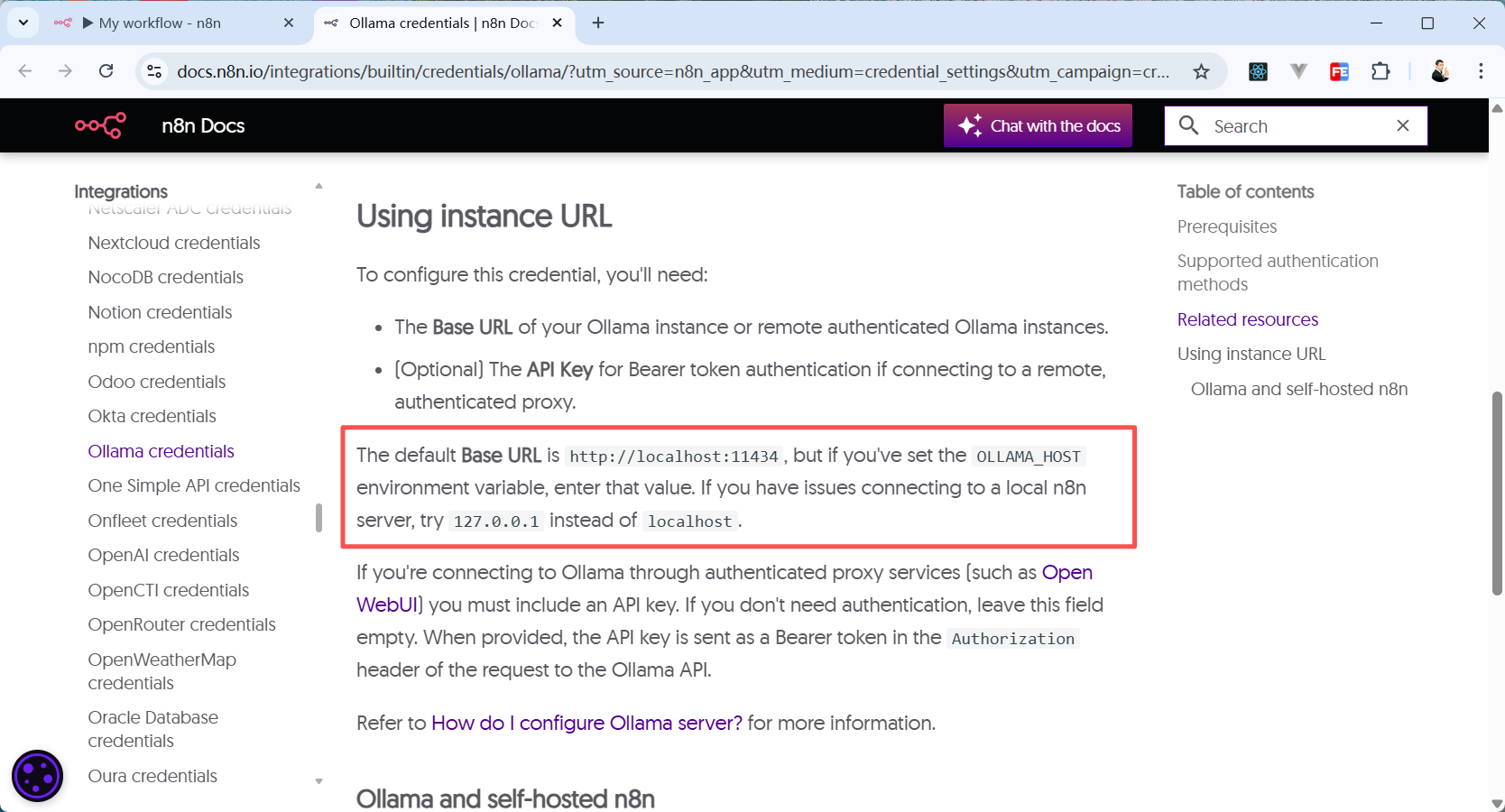

打开红框报错信息下方橙色方块里的文档(Open docs)可以看到,n8n 官方文档叫我们试试使用 127.0.0.1 代替原来的 localhost。

试试就试试。

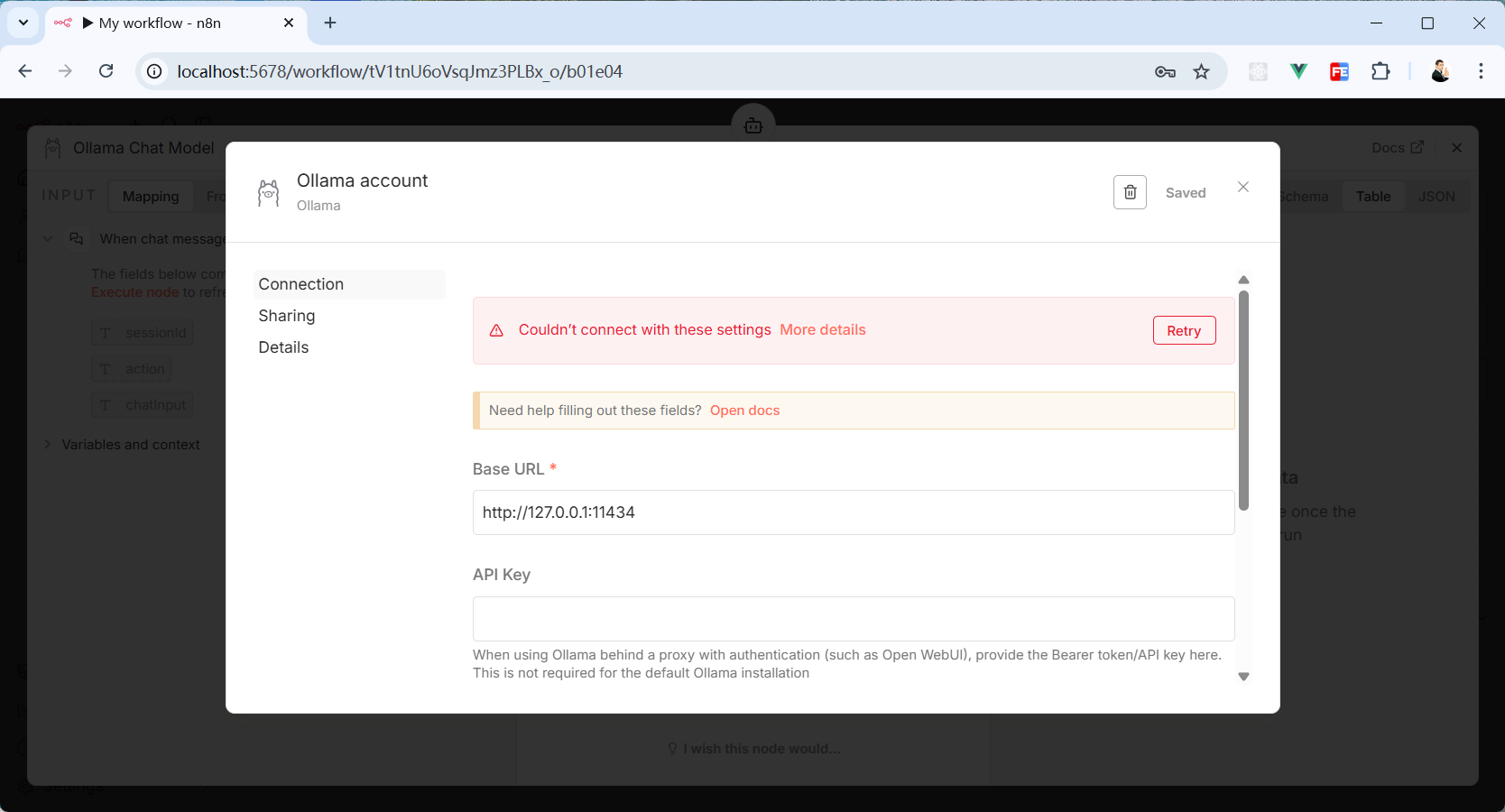

改成 127.0.0.1 后还是不行!

别慌,这是因为我们使用 Docker 安装 n8n 导致的。

Docker 会给容器创建一个子网,然后通过 Docker 和主机连接。这样能将 Docker 的运行环境和主机隔离开来,防止环境之间造成的冲突。

你可以将你的 Docker 给 n8n 创建的 IP 填入到 Base URL 里。

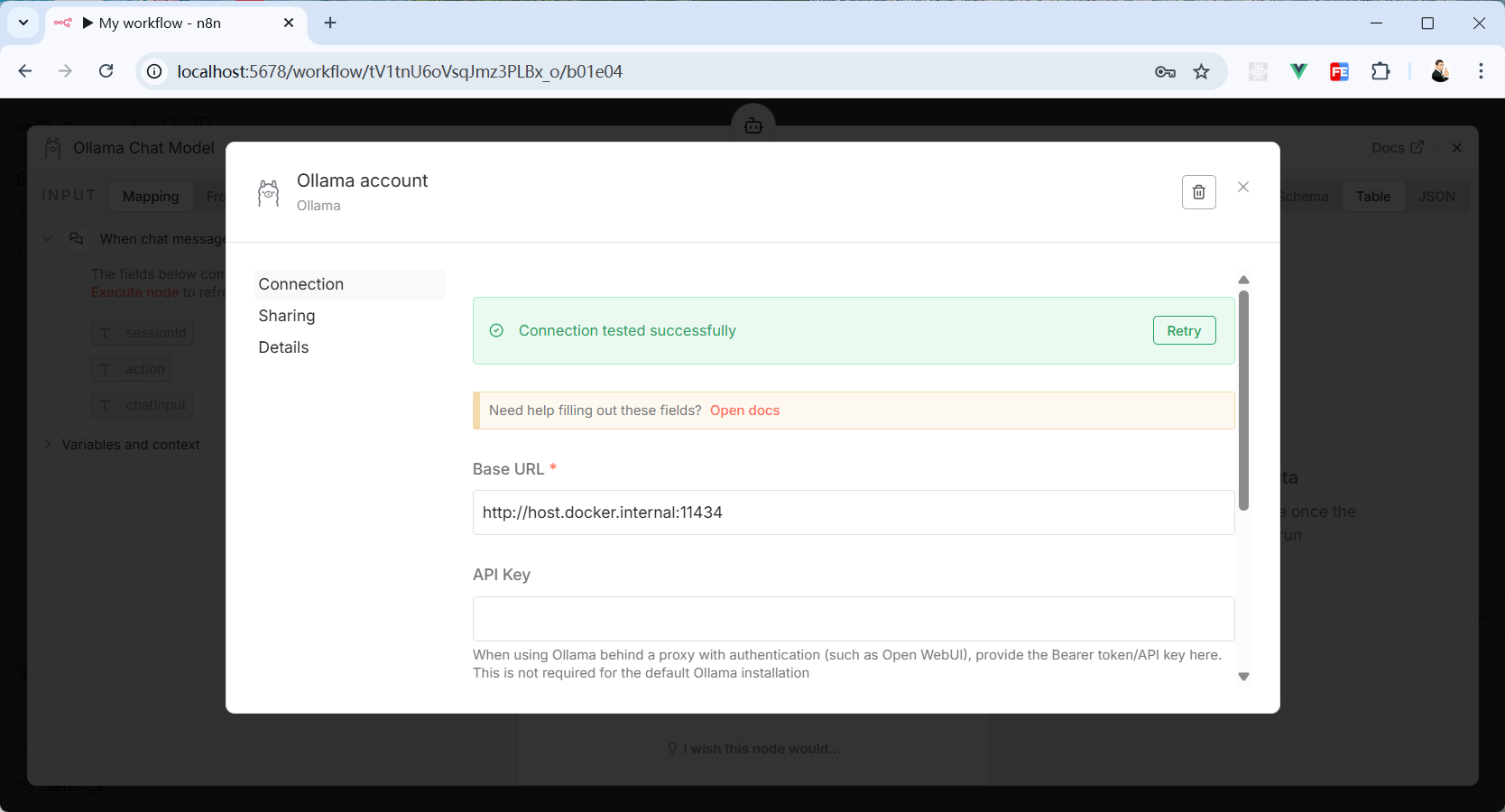

如果你使用的是 Windows 电脑,也可以直接用 host.docker.internal 替换掉原本的 localhost。

替换成 host.docker.internal 再次点击保存,就可以看到“Connection tested successfully”的提示,证明 n8n 与 Ollama 连接成功了。

配置 DeepSeek 模型

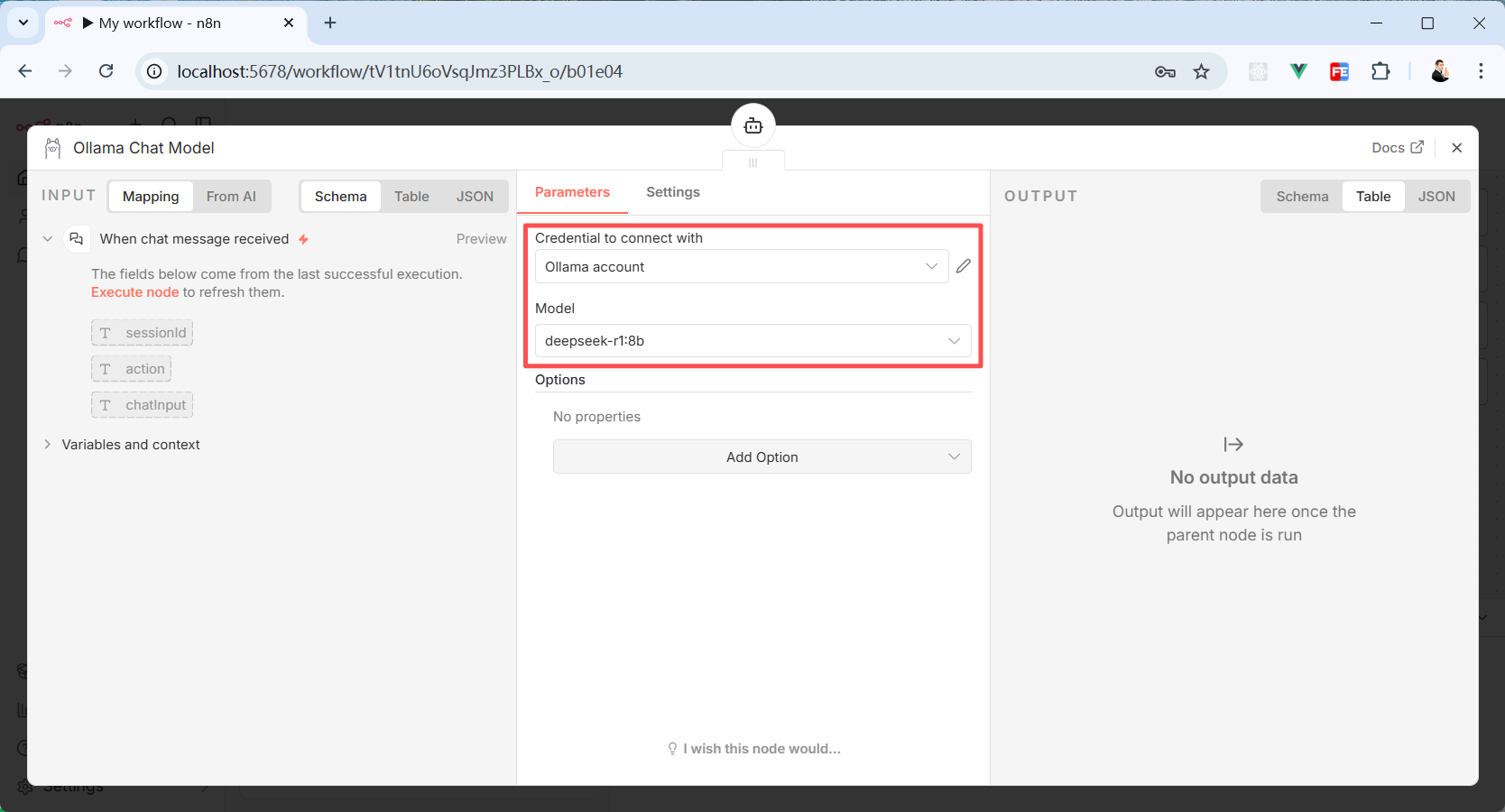

连接 Ollama 成功后,其他配置不需要修改。

关掉“Ollama account”弹窗,回到“Ollama Chat Model”配置页面。

Credential to connect with 这项选择刚刚连接上的 Ollama account。

Model 选择 deepseek-r1:8b。

然后关掉“Ollama Chat Model”弹窗。

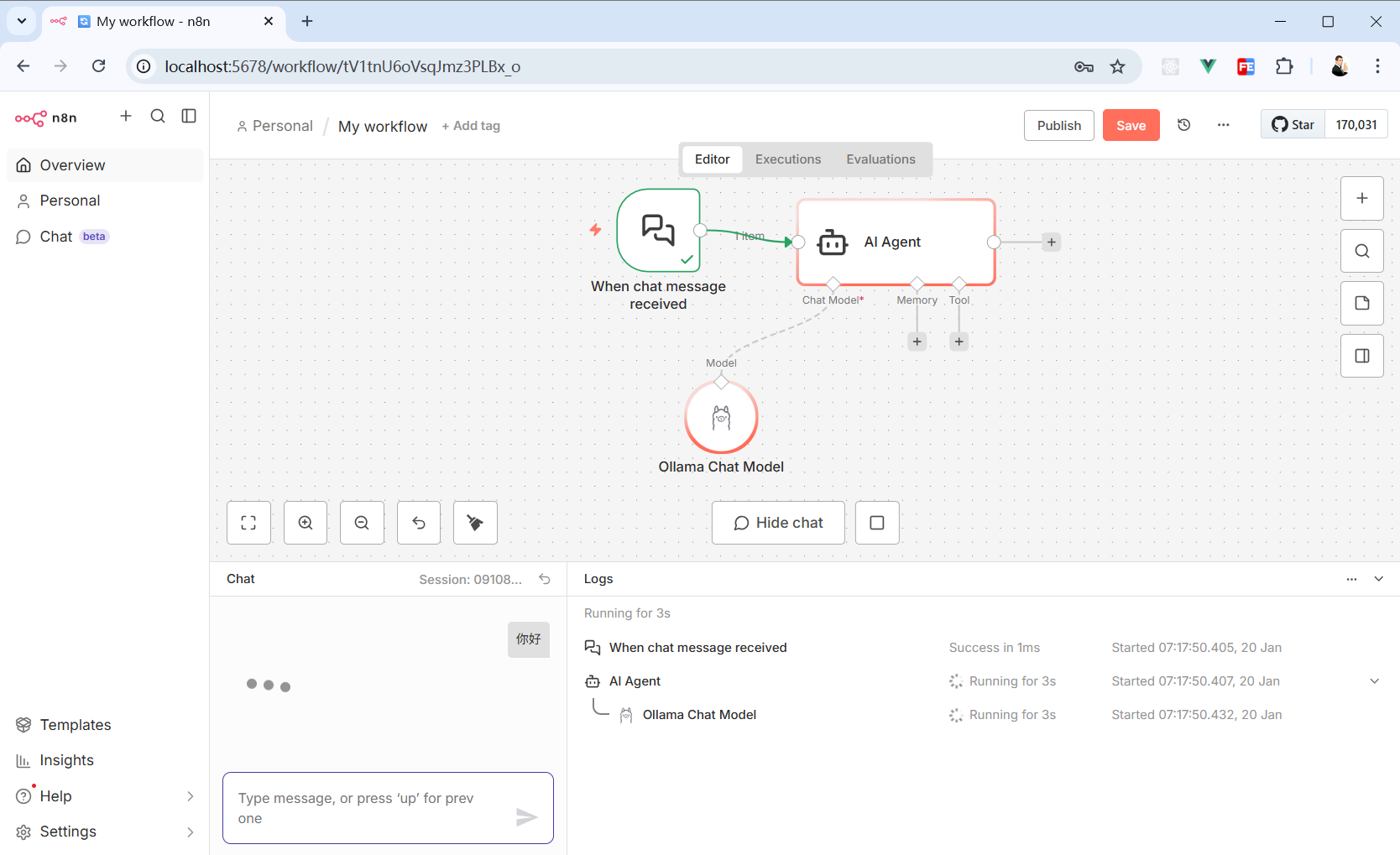

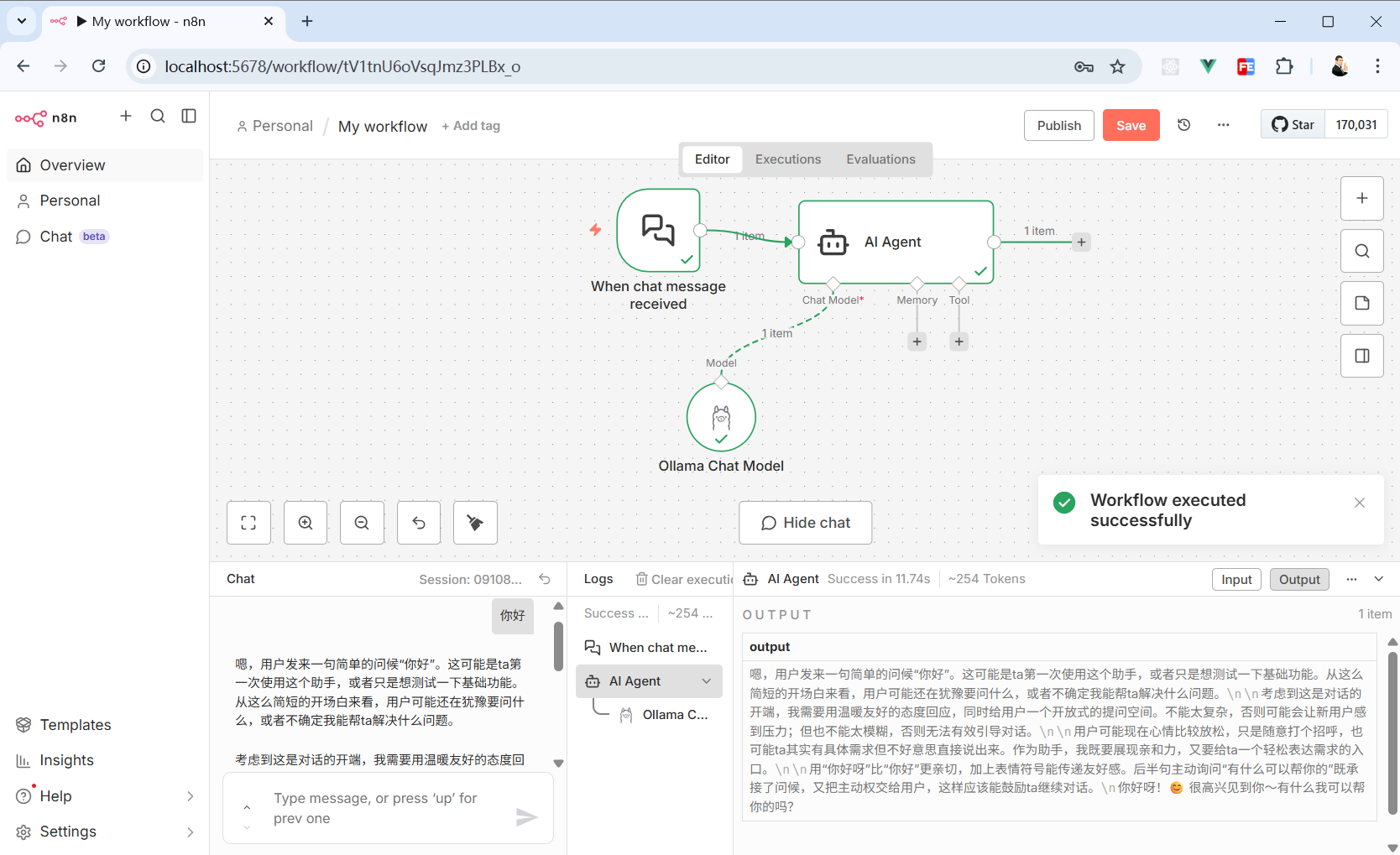

点击这个工作流的第一个节点“Chat Trigger”就会在页面底部弹出一个聊天窗。

随便输入点内容,这个工作流就会开始工作了。“Chat Trigger”就会将接收到的信息传给“AI Agent”处理。

“AI Agent”接收到信息后,会将信息传给配置好的模型,本例用的是 Ollama 里运行的 DeepSeek。

等待几秒后,DeepSeek 就会将处理好的结果返回给“AI Agent”。

因为在这个工作流中,“AI Agent”并没有下一个节点,所以 DeepSeek 将处理完的数据返回给“AI Agent”就结束了。

管理凭证

如果按照本文标题的要求,本文写到这里就已经结束了。

但我还想再介绍一下 n8n 中另一种接入 DeepSeek 的方法。

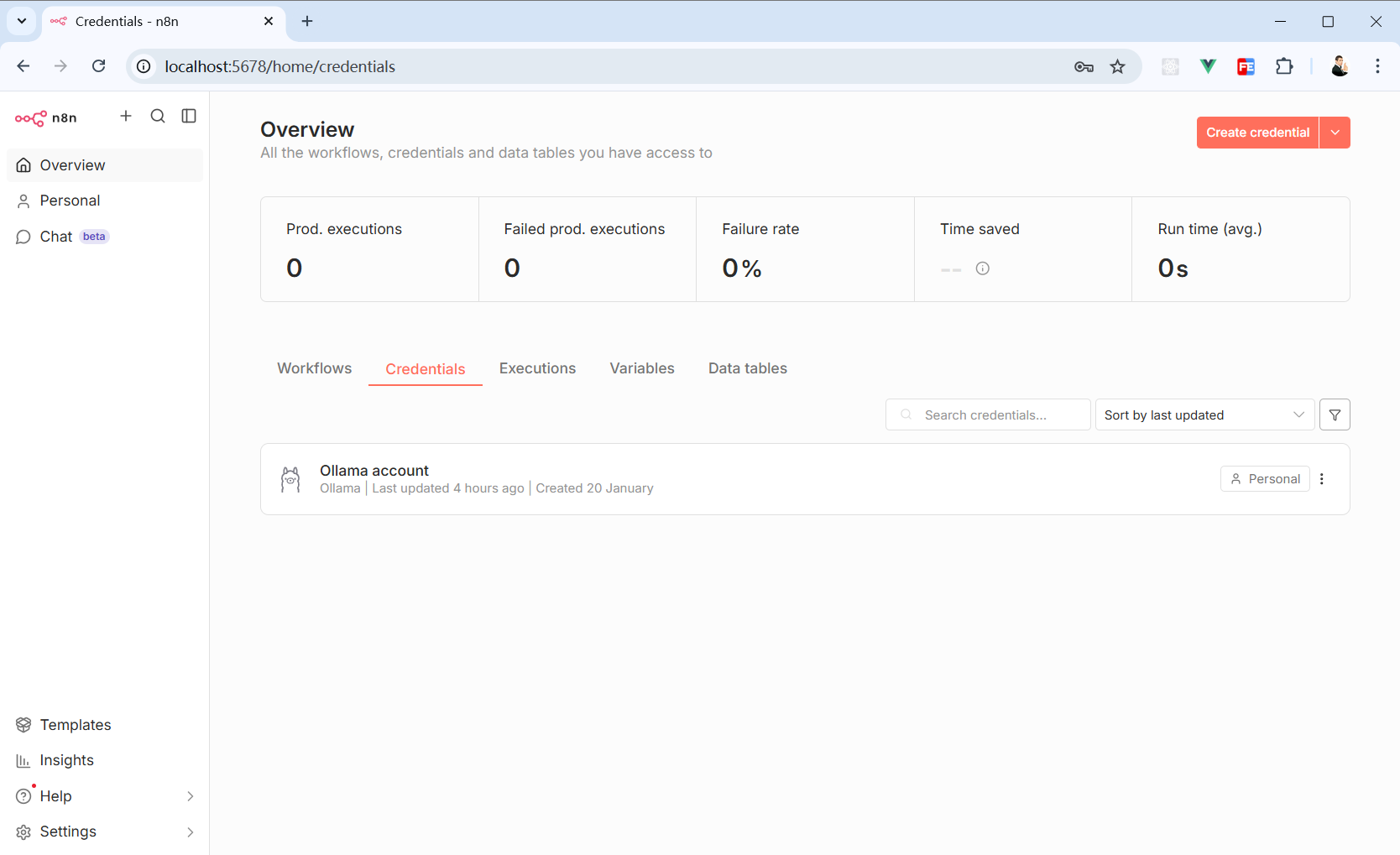

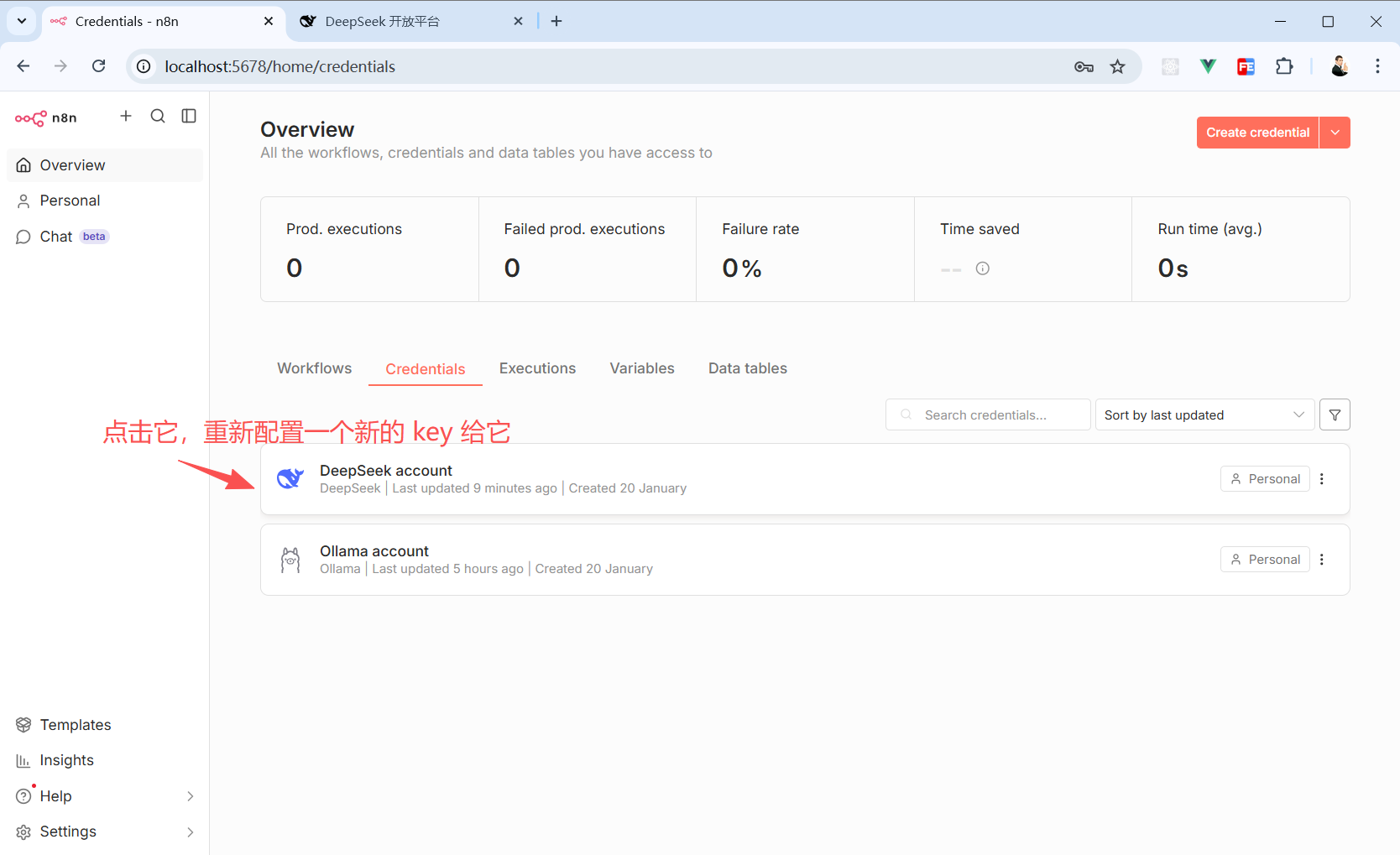

在“Overview”页面,切换到”Credentials“面板可以看到前面的操作中接入的”Ollama“凭证。

”Credentials“面板就是用来管理我们创建的各种凭证d。

在”Credentials“面板里,可以通过右上角橙色按钮(Create credential)创建其他凭证。

某些凭证过期了我们也可以在”Credentials“面板里快速调整。

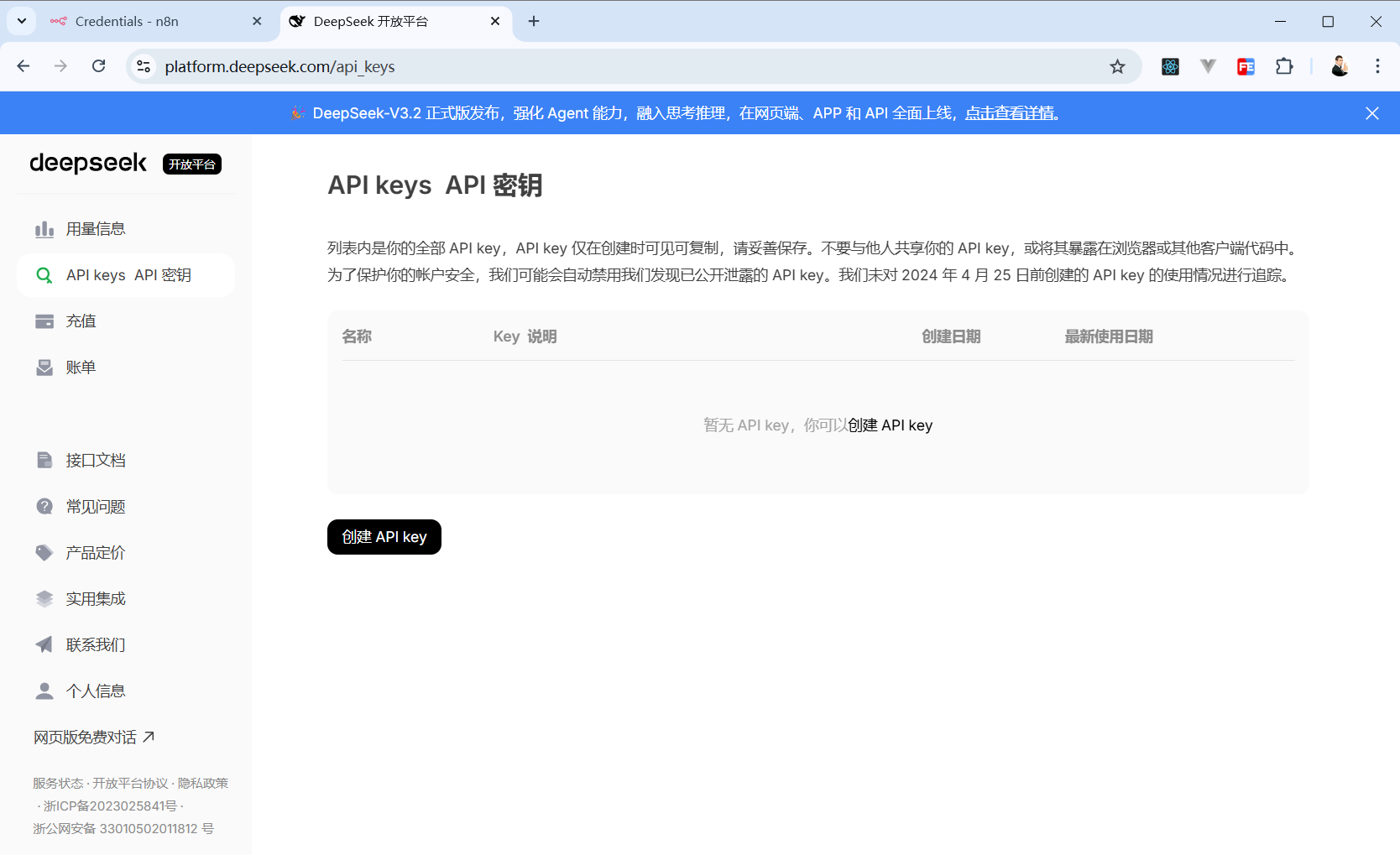

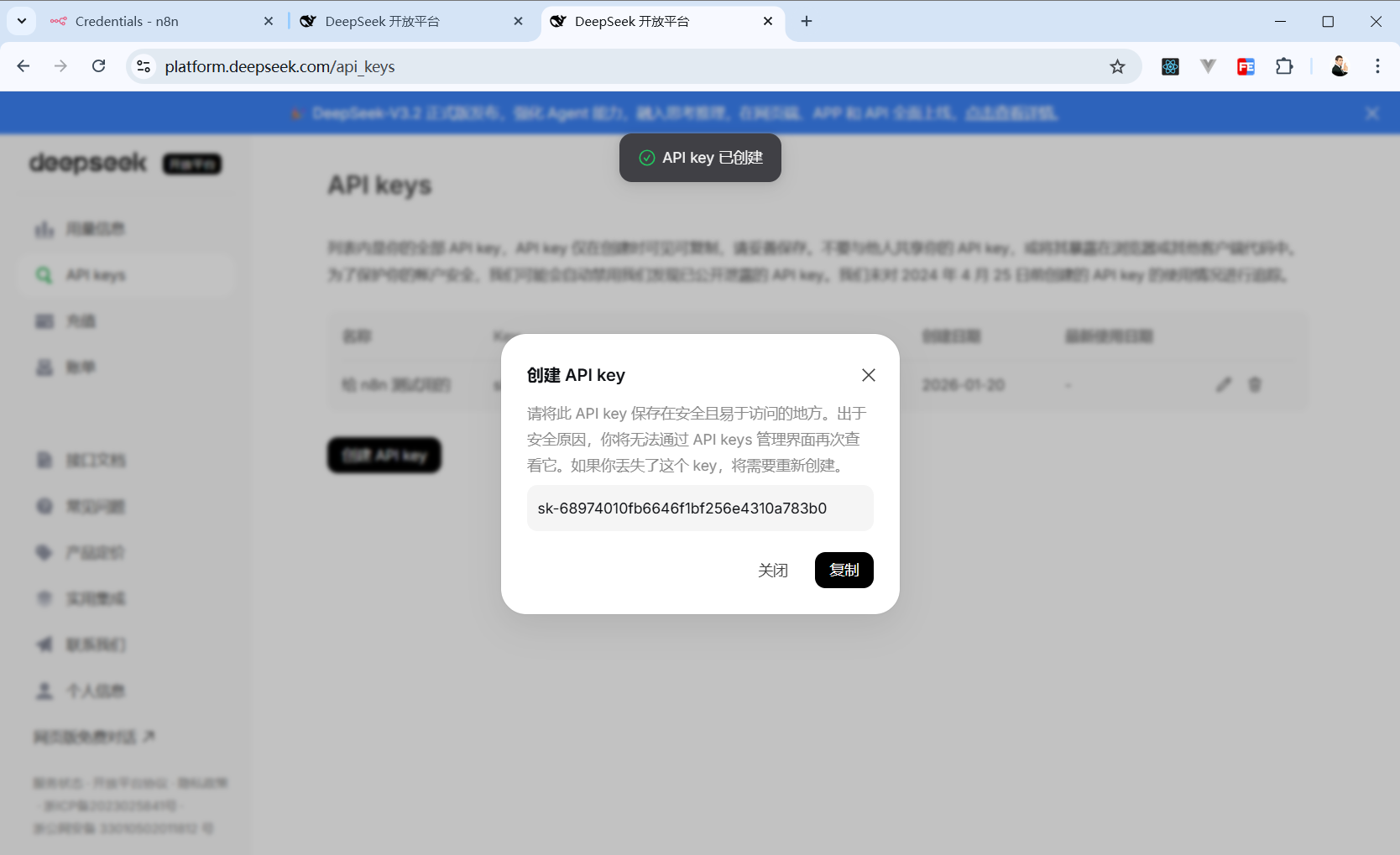

举个例子,如果我们想接入 DeepSeek 官方提供的服务,可以到 DeepSeek API 开放平台(https://platform.deepseek.com/)申请一个 API key。

点击黑色按钮(创建 API key),输入这个 key 的名字(建议输入你要用这个功能的项目或者功能名称)。

然后 DeepSeek 就会返回一个 key 给你,这个 key 你要找个地方保存好,因为它只展示1次,关闭这个弹窗后你就无法在 DeepSeek 后台里找回它了。

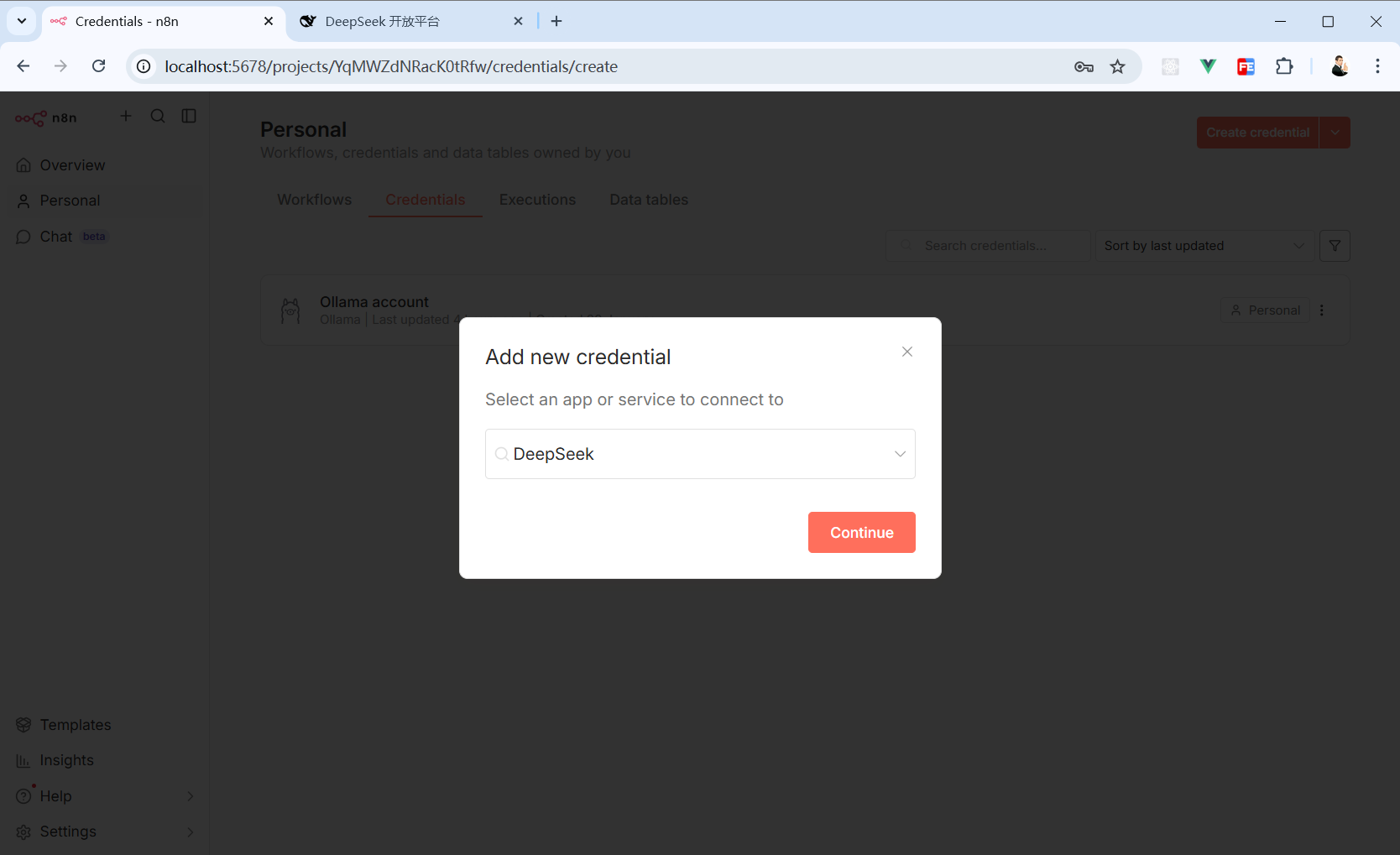

回到 n8n 的”Credentials“面板,点击右上角橙色按钮(Create credential)创建凭证。

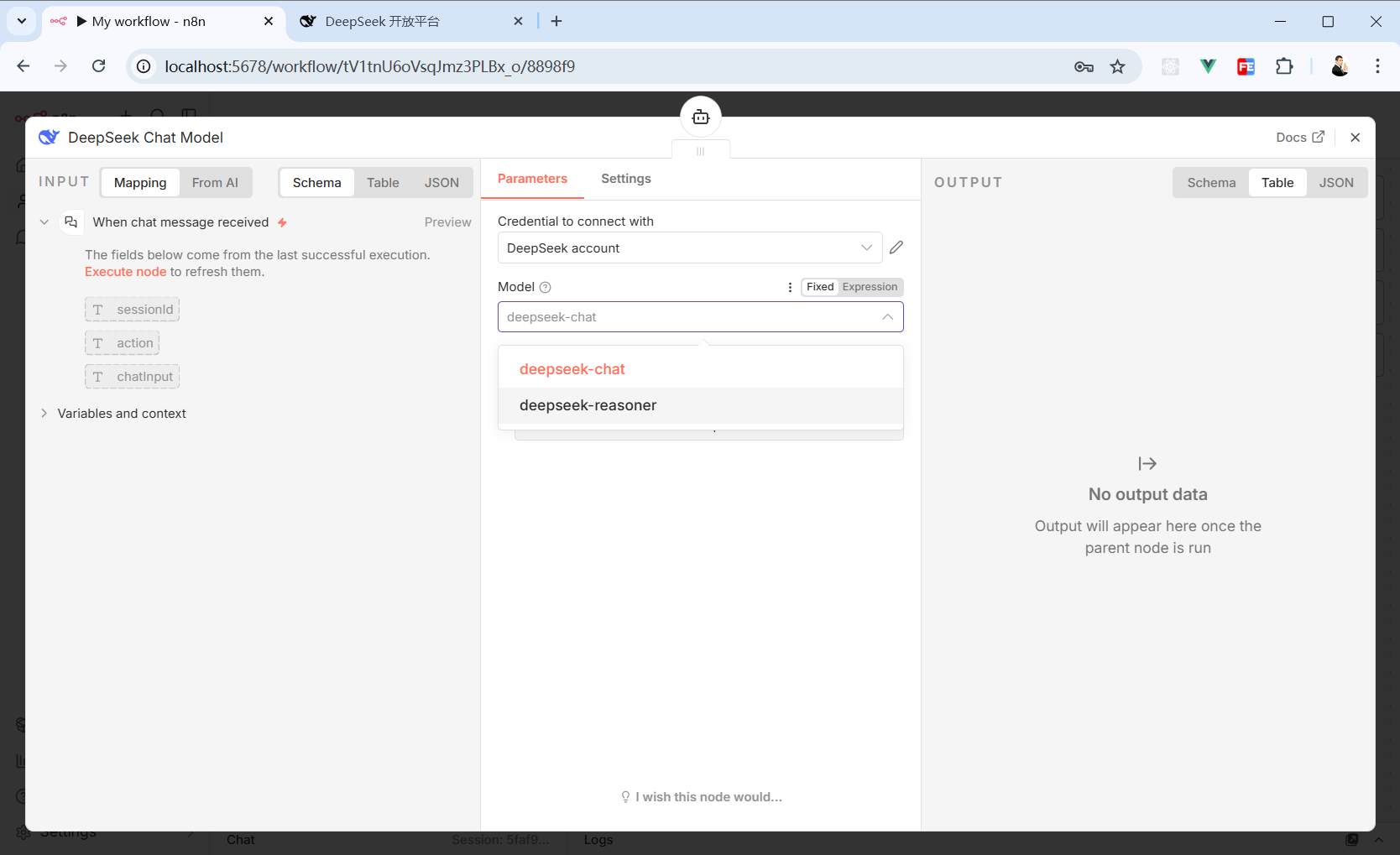

选择“DeepSeek”,然后按“Continue”按钮。

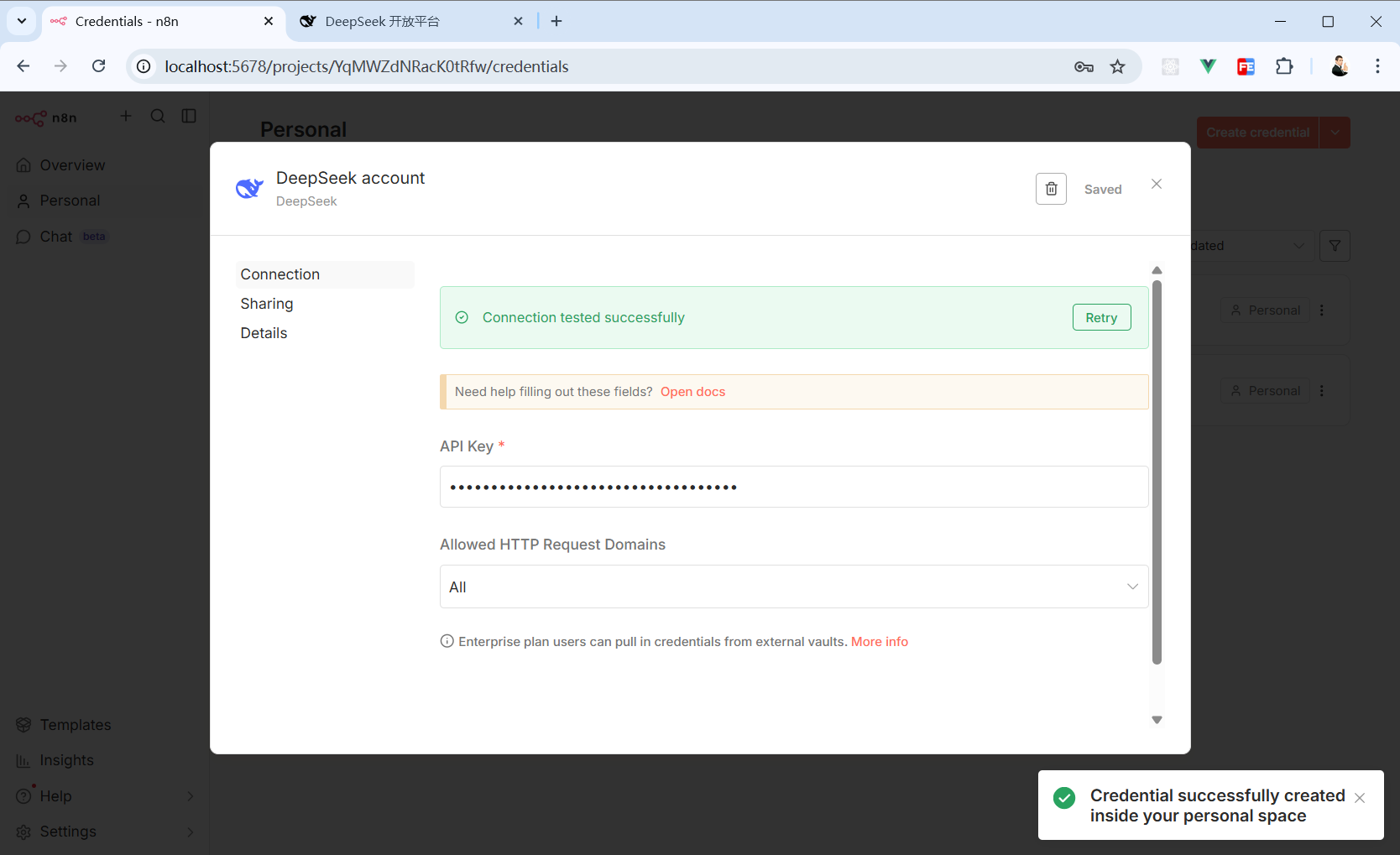

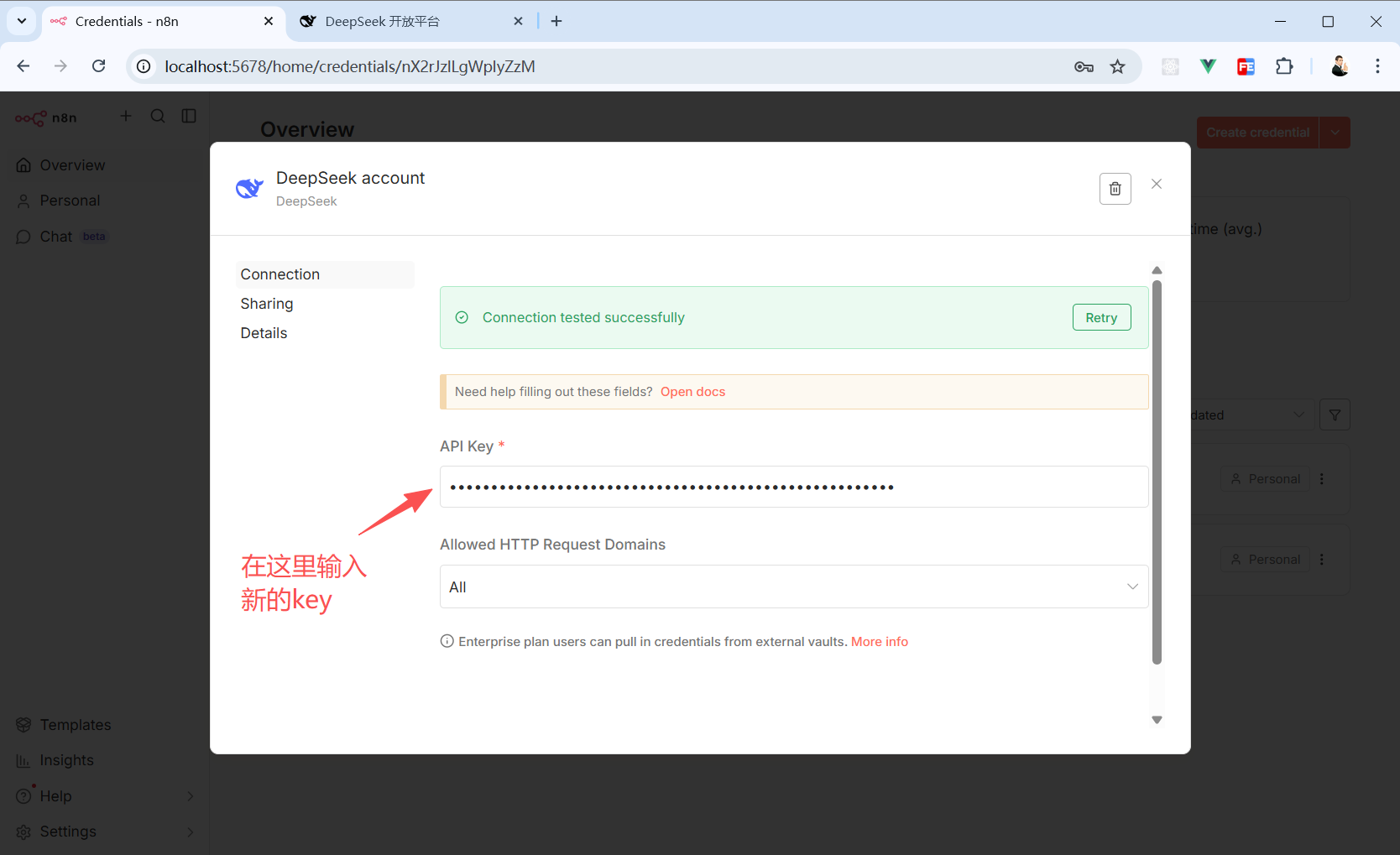

将刚刚在 DeepSeek 后台创建的那个 key 粘贴进来,然后点击弹窗右上角的”Save“按钮。

如果 key 没问题的话就会看到这个绿色的成功提示。

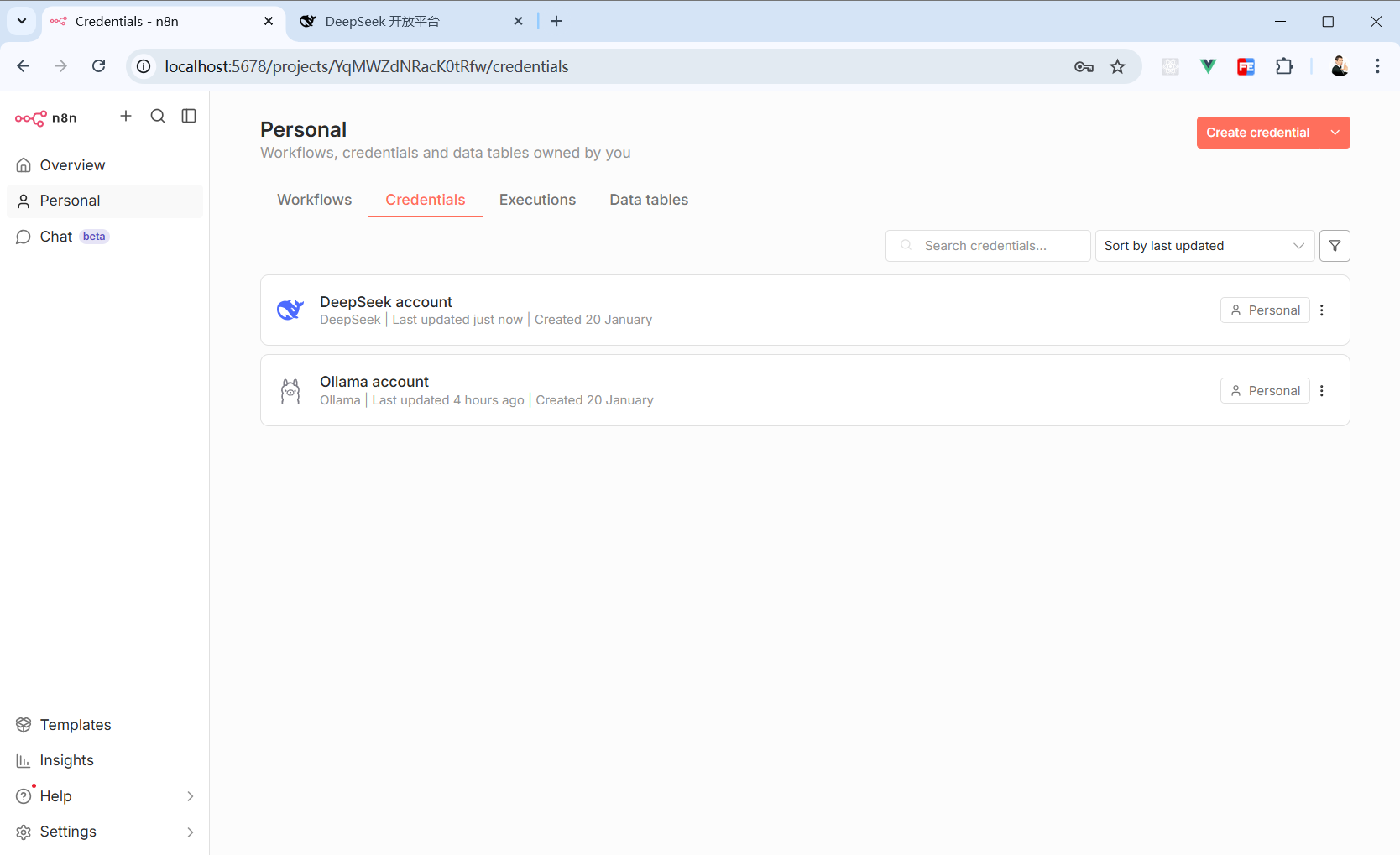

回到”Credentials“面板就能看到我们刚刚创建的 DeepSeek 凭证。

然后在工作流中就可以使用 DeepSeek 提供的服务了。

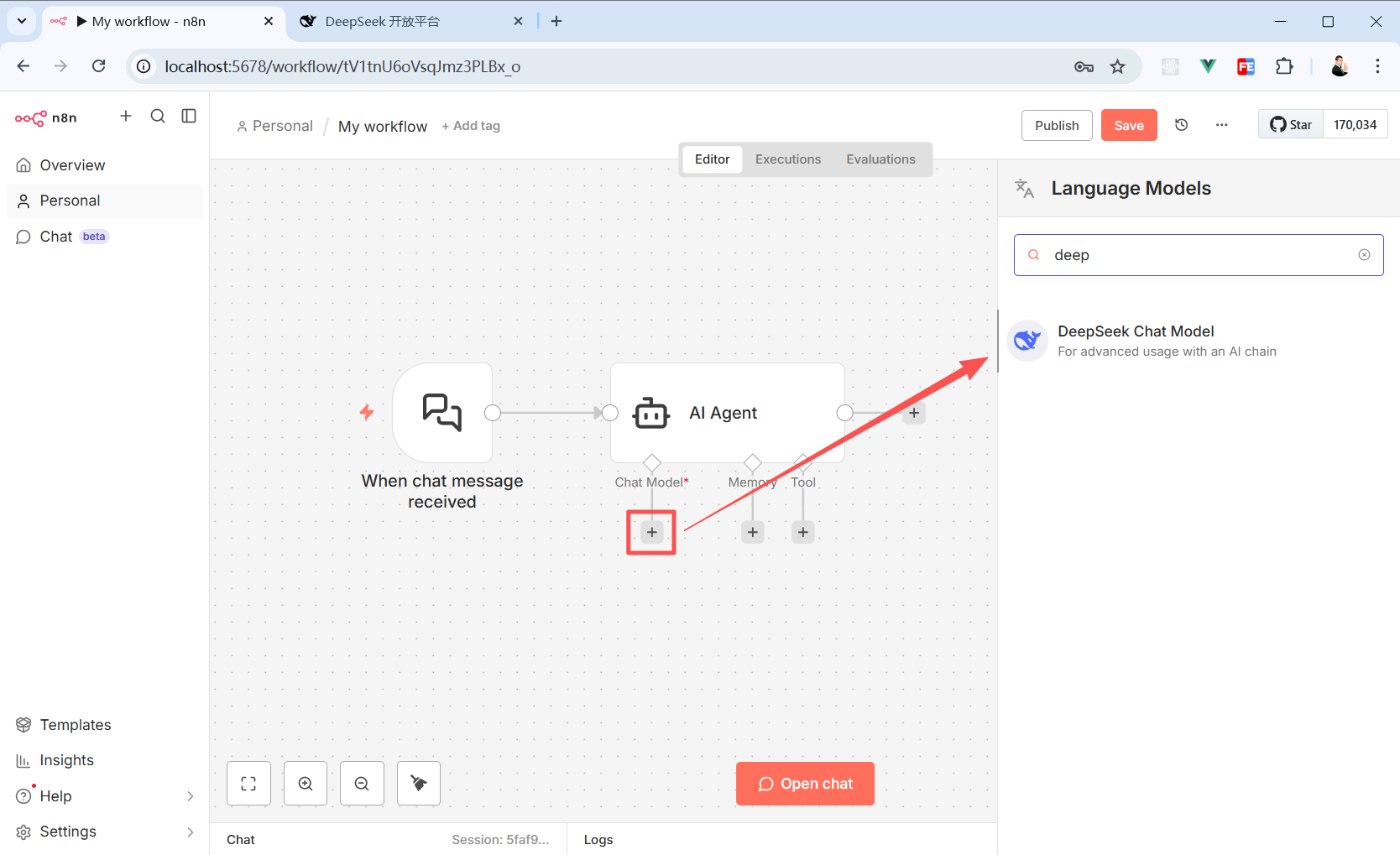

接入的大模型这里搜索 DeepSeek Chat Model。

选择 DeepSeek 提供的模型,之后就可以开心玩耍了。

但实际工作中,我还是习惯直接在工作流里创建凭证。

⚠️最后提醒一下!!!

不管是在 DeepSeek 还是在其他大模型供应商那里创建的 API key,

不要泄露给其他人!!!

不要泄露给其他人!!!

不要泄露给其他人!!!

一旦发现 key 泄露了,立刻去官网删掉这个 key,再重新创建一个 key 回到 n8n 的”Credentials“面板调整。

不需要删掉原来创建的凭证,点开它,重新配置一个新的 key 即可。

如果删掉的话,你用到该凭证的所有工作流都会失效,到时候一个个工作流重新配置就更麻烦了。

以上就是本文的全部内容啦,想了解更多n8n玩法欢迎关注《n8n修炼手册》👏

如果你有 NAS,我非常建议你在 NAS 上部署一套 n8n,搞搞副业也好,帮你完成工作任务也好 《『NAS』不止娱乐,NAS也是生产力,在绿联部署AI工作流工具-n8n》

点赞 + 关注 + 收藏 = 学会了

浙公网安备 33010602011771号

浙公网安备 33010602011771号