『NAS』在绿联部署DeepSeek,接入n8n工作流-ollama

点赞 + 关注 + 收藏 = 学会了

整理了一个NAS小专栏,有兴趣的工友可以关注一下 👉 《NAS邪修》

在《『NAS』不止娱乐,NAS也有生产力,在绿联部署AI工作流工具-n8n》里讲解了如何在绿联NAS里部署 n8n,但如果没有 AI 能力加入,n8n 就只是一个木头。

现在的 AI 服务虽然不贵,但对于一些小任务,或者在学习阶段的工友来说,在本地运行大模型肯定更有性价比的,毕竟可以随便用嘛。

本文就讲讲在绿联NAS里如何使用 Docker 部署一个 DeepSeek,并接入到 n8n 中。

我用的设备是「绿联DXP4800Plus」,插了2条固态硬盘,Docker 就装在固态硬盘的存储池里。内存是设备自带的 16G,没有外加内存条。

在动手安装 DeepSeek 之前,需要了解几个东西。

- AI 大模型

- ollama

- n8n

AI 大模型好理解,2026年了,能刷到本文的人应该多少知道什么是大模型。AI 大模型就是用海量数据训练出来的、能理解和生成文字、图像等多种内容,还能胜任聊天、写代码、生成图片和视频等不同任务的智能模型。

Ollama 是一款能让你在自己电脑上轻松安装、运行和管理各类 AI 大模型的轻量级工具。我们可以用 Ollama 下载 DeepSeek,并提供给 n8n 使用。

n8n 是一款能让你用拖拽方式连接各类应用、服务和 AI 工具,实现自动化任务流程的无代码 / 低代码工具。

在动手安装之前我再啰嗦两句。我个人是建议在 NAS 上安装 n8n 帮我定时定候工作的,比如我在「雷猴世界」这个号发布的一些游戏资讯就是靠 n8n 实现的,根据我的要求去判断哪些内容值得发布。

但我不建议在 NAS 上运行参数量大的模型,一来 NAS 不一定跑得起来,二来影响 NAS 的传统工作(备份照片、下载片子等功能)。

巨大的模型还是租服务商吧,起码出了问题可以骂客服嘛(🐶狗头保命)

安装 Ollama

打开 Docker,没有的话就去应用中心下载。

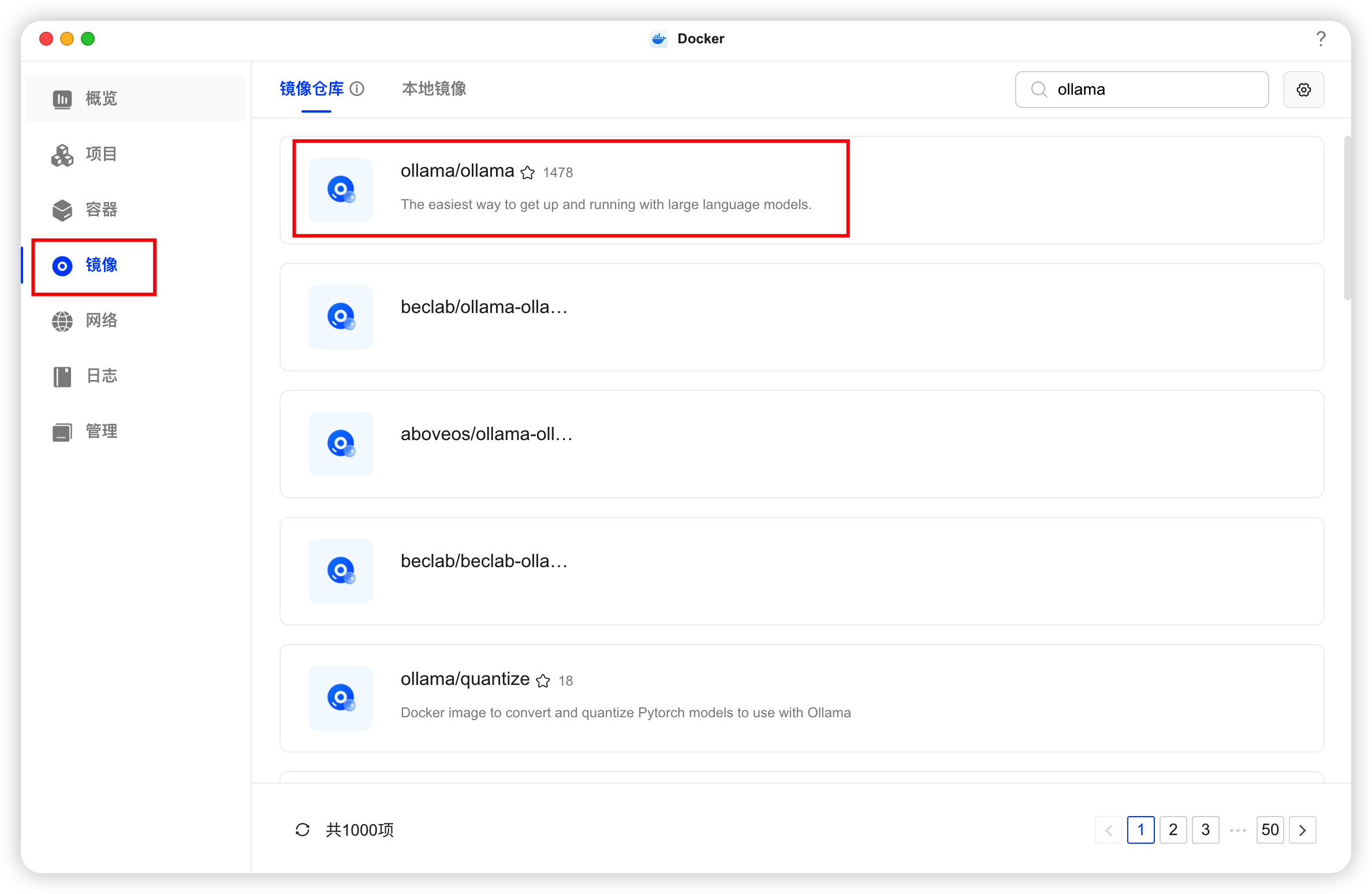

切换到“镜像”页面,搜索 ollama,下载红框那个 ollama/ollama。

这个镜像有点大,下载速度比较慢,慢慢等吧。

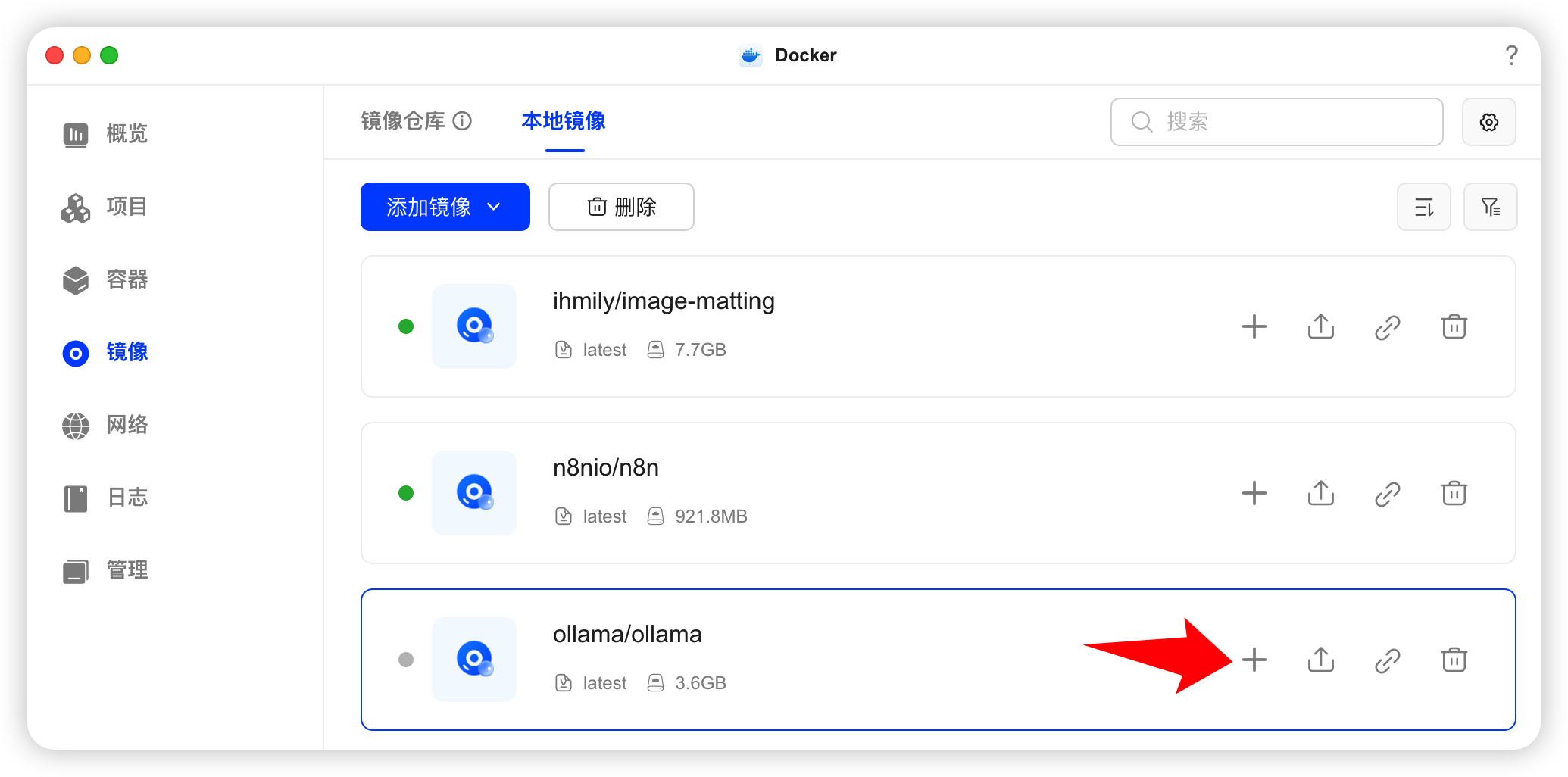

下载成功后,切换到“本地镜像”,点击 ollama/ollama 这项的加号。

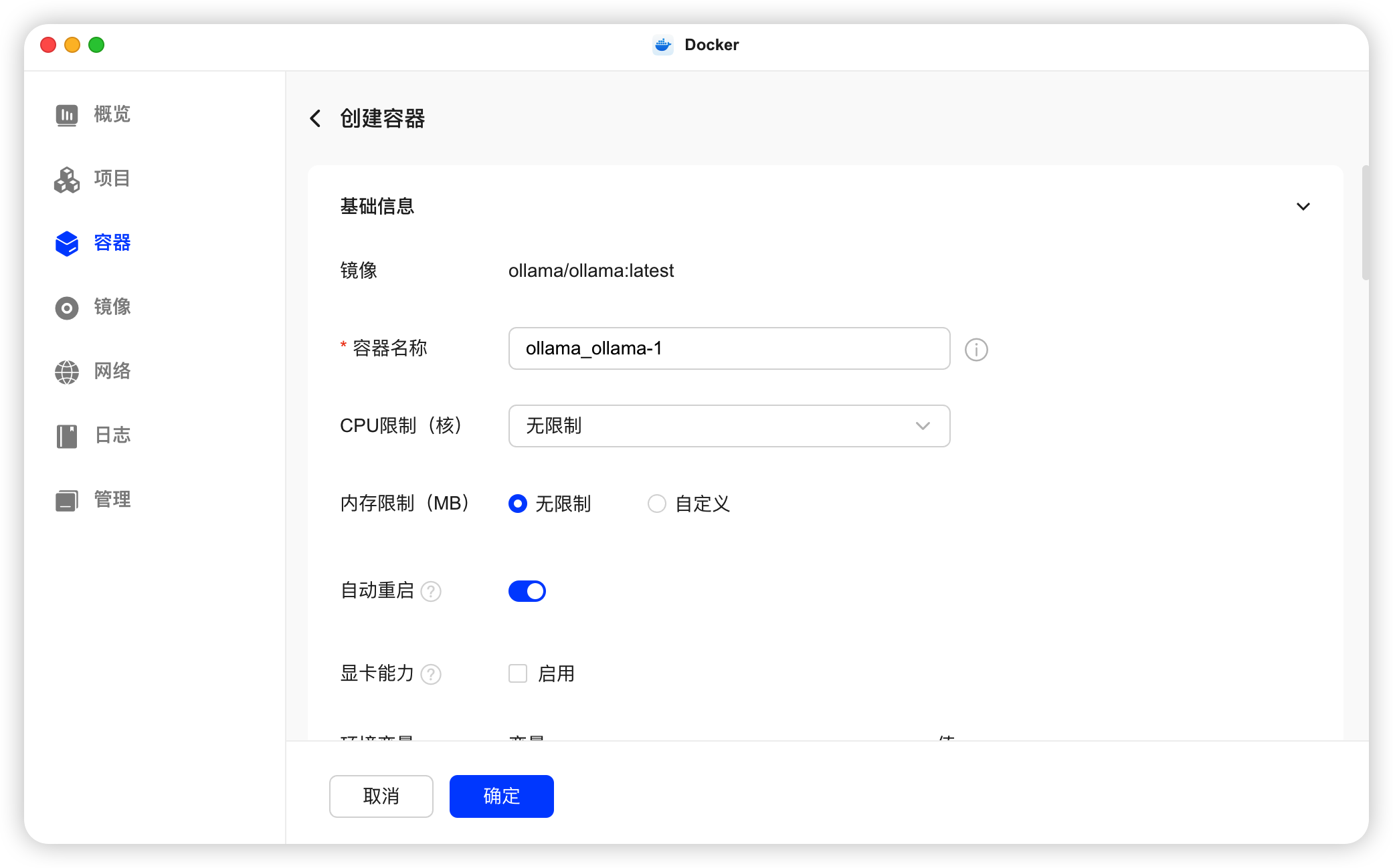

创建容器,勾选“自动重启”。其他选项可以不改,但要继续往下拉,看看 Ollama 这个容器使用了哪个端口(可以自己改端口)。

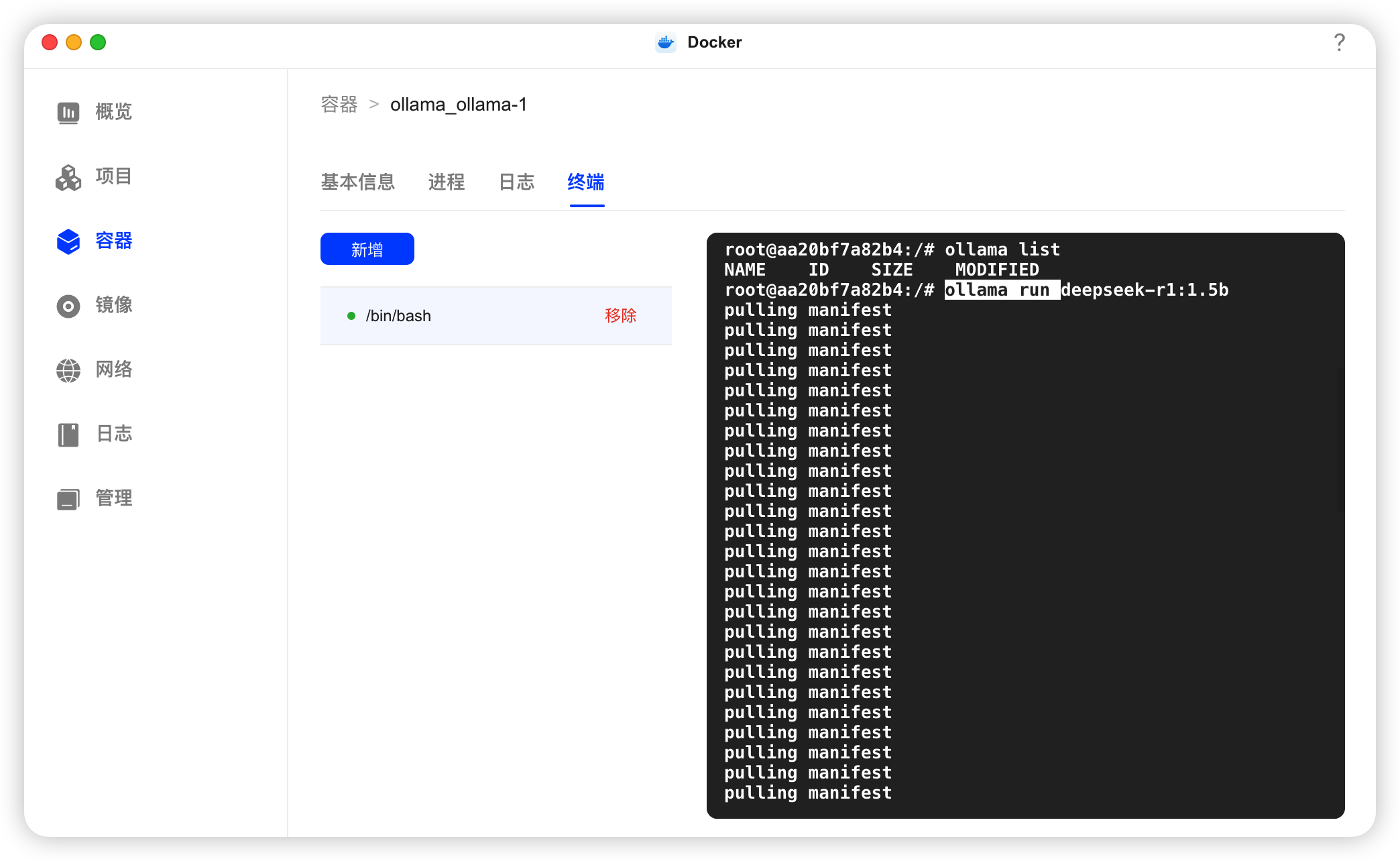

运行成功后,在“容器”面板选中 ollama,切换到“终端”面板。

输入 ollama list,如果出现 NAME ID SIZE MODIFIED 这几个单词证明运行成功。

这个命令的意思是查看当前 Ollama 里下载了哪些大模型。它返回的结果其实是一个表格,刚刚看到的那几个单词是表头。

如果你第一次安装 Ollama,输入 ollama list 是看不到任何模型的。

下载 DeepSeek

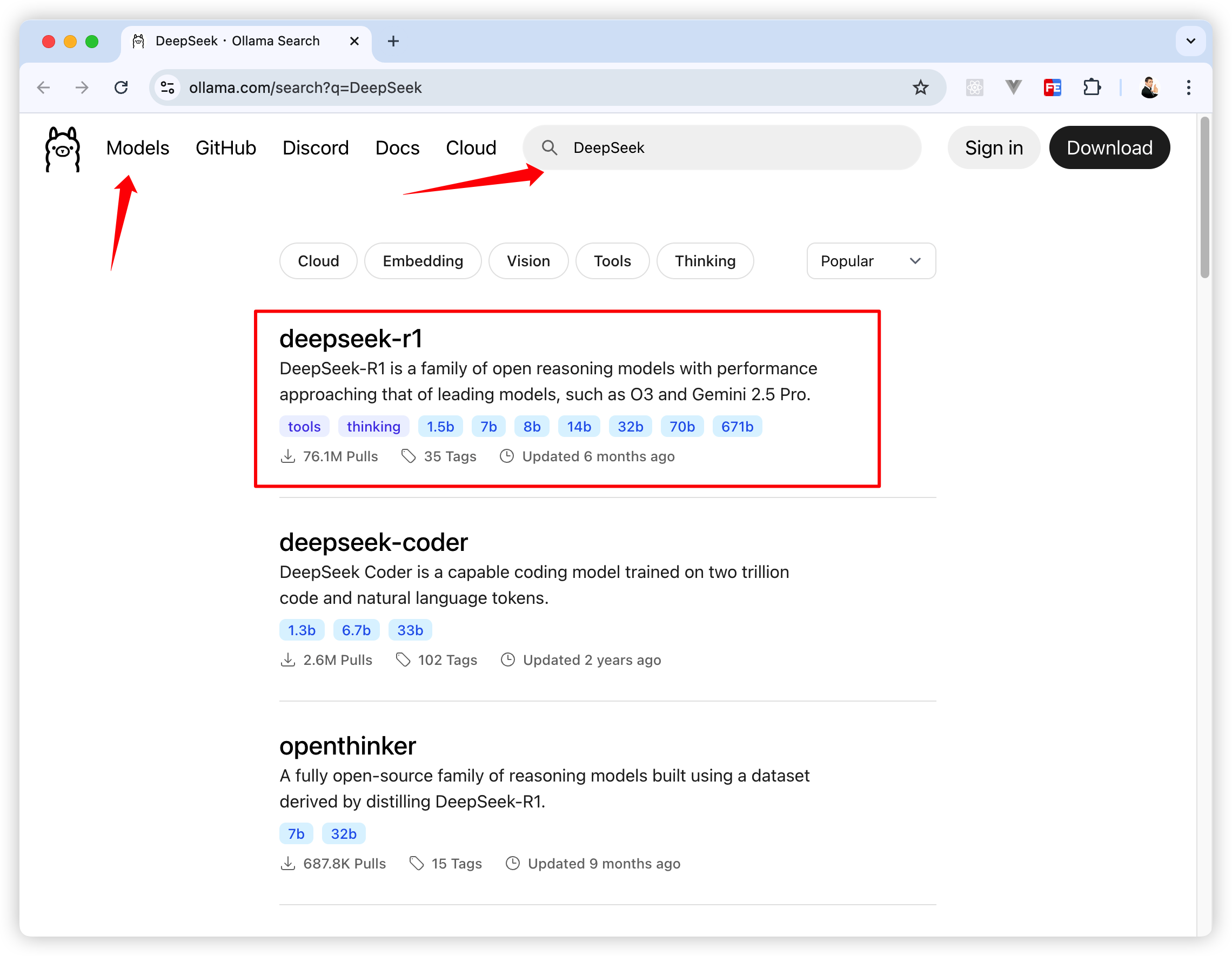

接着打开 Ollama 官网 👉 https://ollama.com/search

点击 Models 跳转到搜索模型页。

搜索“DeepSeek”,我这次要下载的是 deepseek-r1。

你也可以在 Models 里看看其他模型。

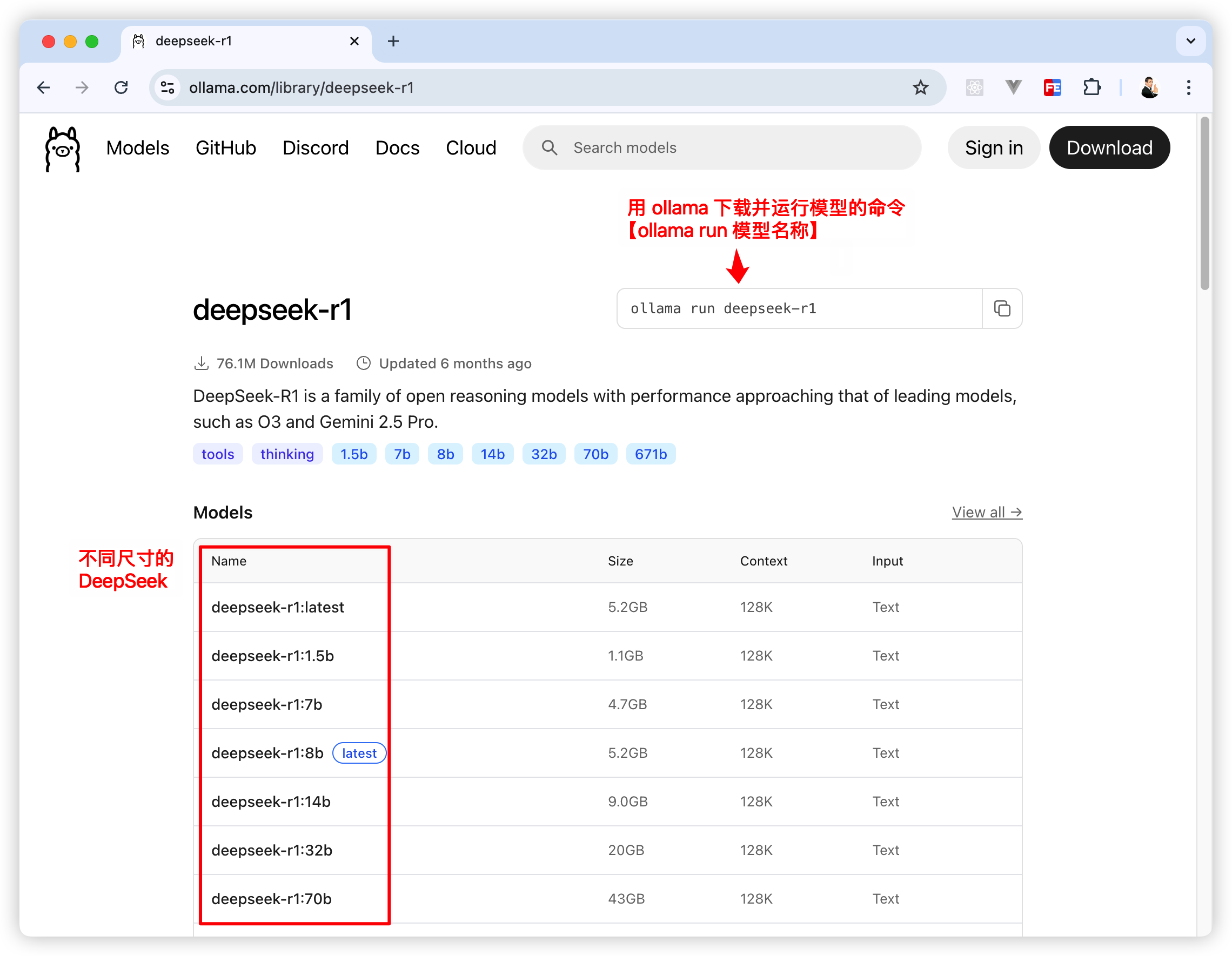

在 deepseek-r1 的搜索结果页面里可以看到用 Ollama 下载模型的命令,以及各种参数规模的模型。

本文使用的是 1.5b 这个规模量的 DeepSeek,再大规模的模型我的 NAS 跑不动。

在 Docker 的“容器 - 终端”面板,输入下面这句命令就可以下载并运行 1.5b 的 DeepSeek 大模型。

ollama run deepseek-r1:1.5b

如果你只想下载模型,不想运行它,可以将 run 改为 pull。

ollama pull deepseek-r1:1.5b

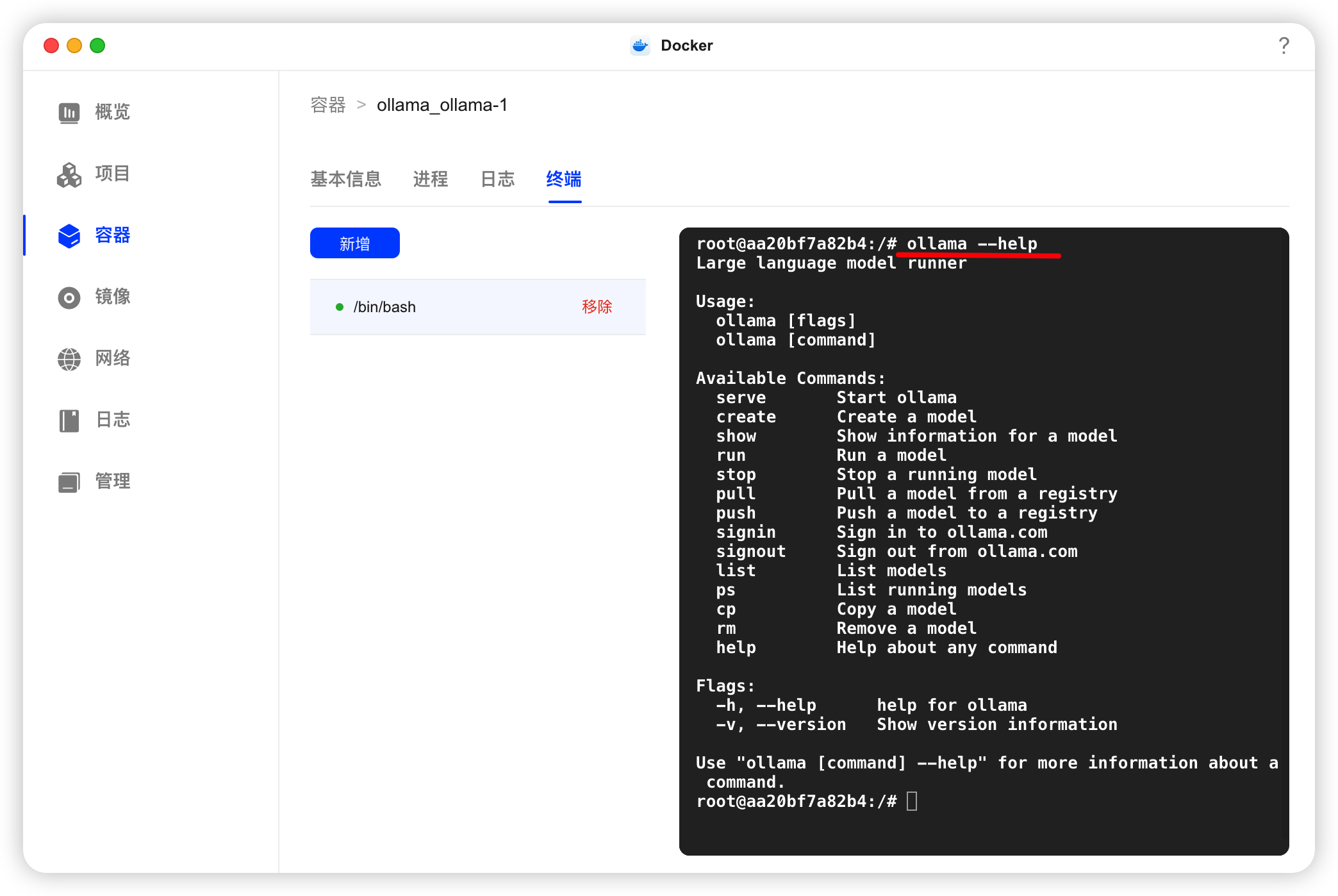

想了解 Ollama 还有哪些命令可以用,在终端输入 ollama --help 就能看到了。

n8n 接入 Ollama

本文不讲 n8n 如何使用,只介绍在绿联 NAS 上如何用 n8n 接入 Ollama,并使用 DeepSeek 模型。

想了解 n8n 怎么玩出花样,欢迎关注 《n8n修炼手册》👏

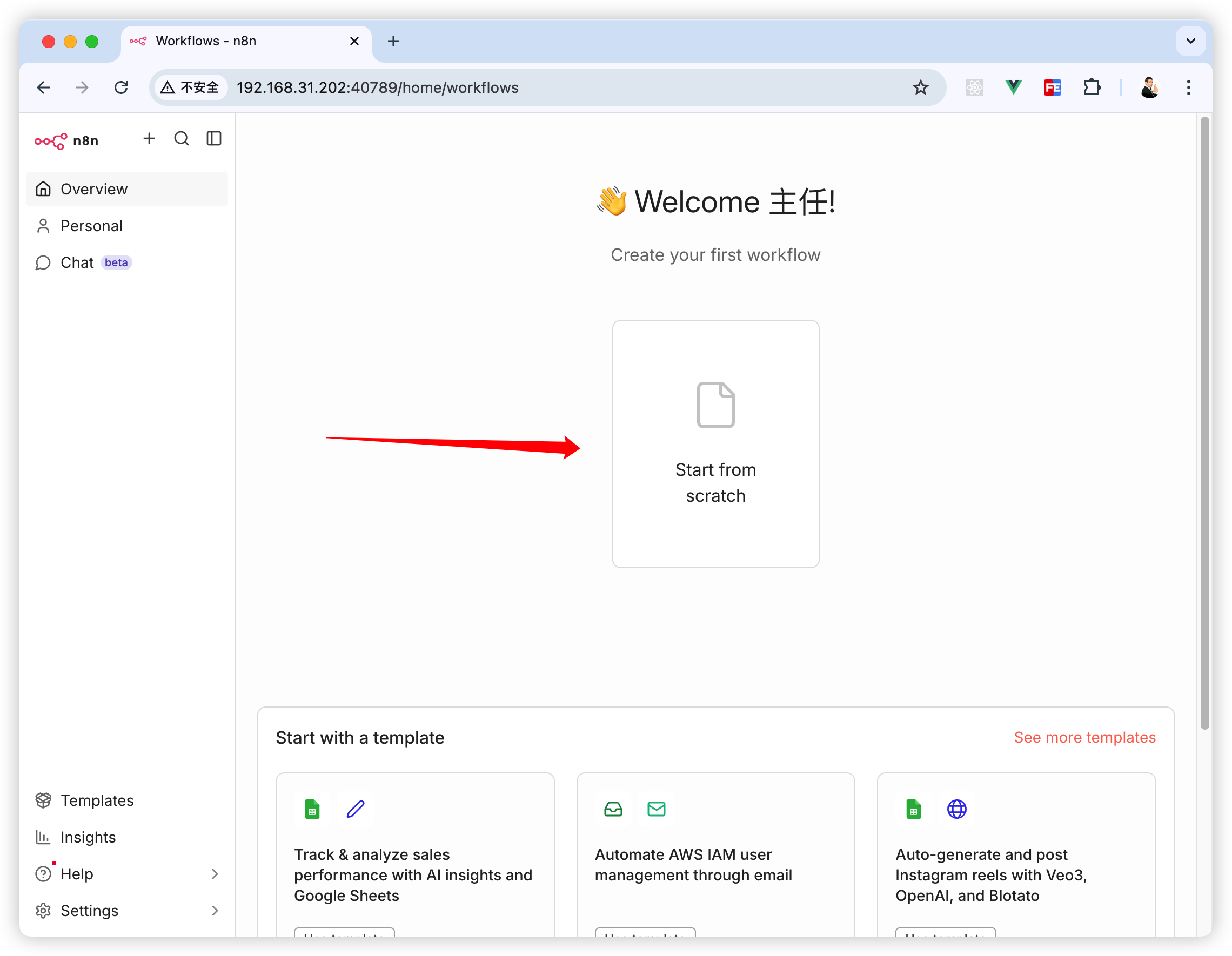

在浏览器输入你在 NAS 部署的 n8n 地址,创建一个工作流。

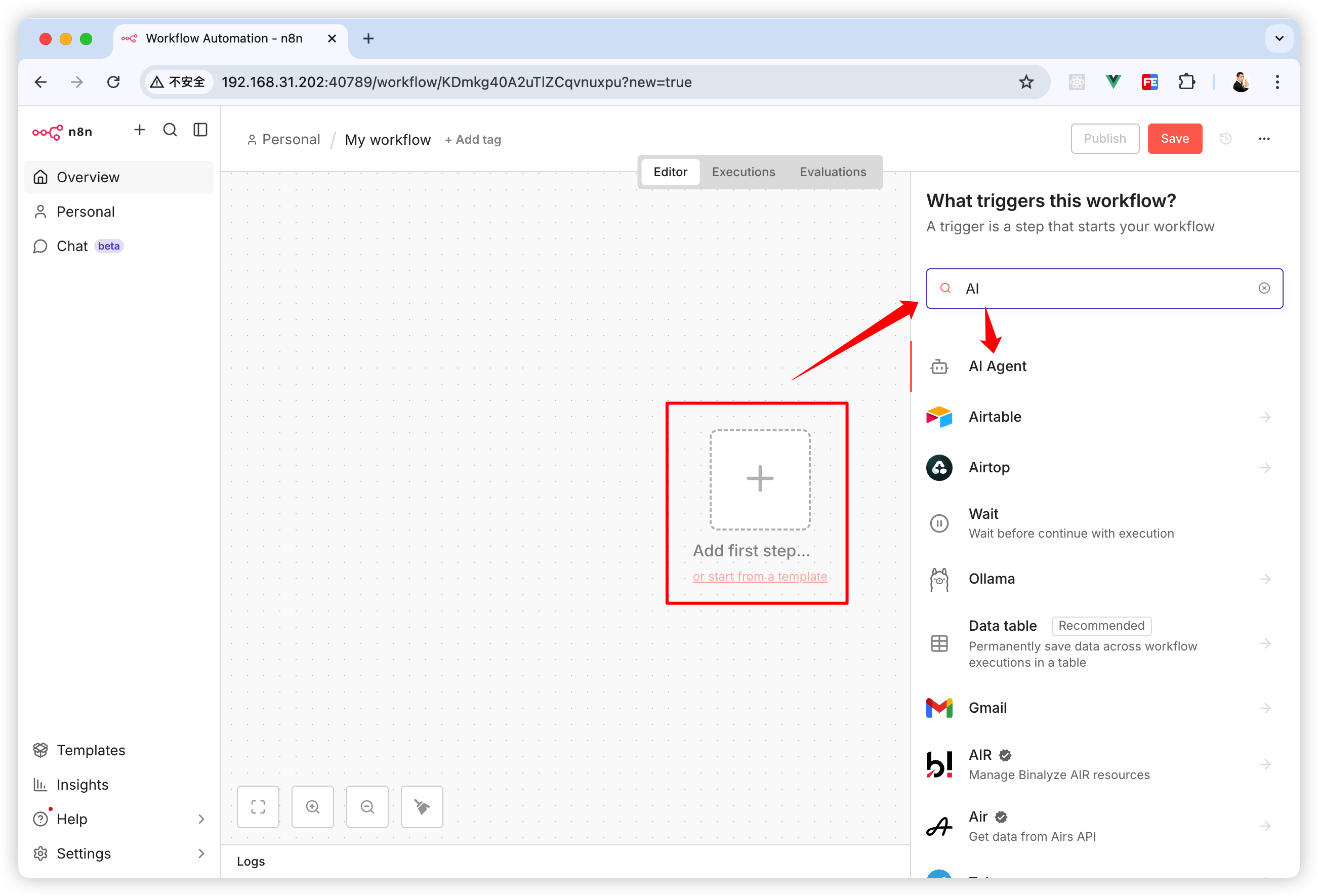

点击画布中间的加号,或者按下键盘的 Tab 键。搜索“AI”,然后选择“AI Agent”。

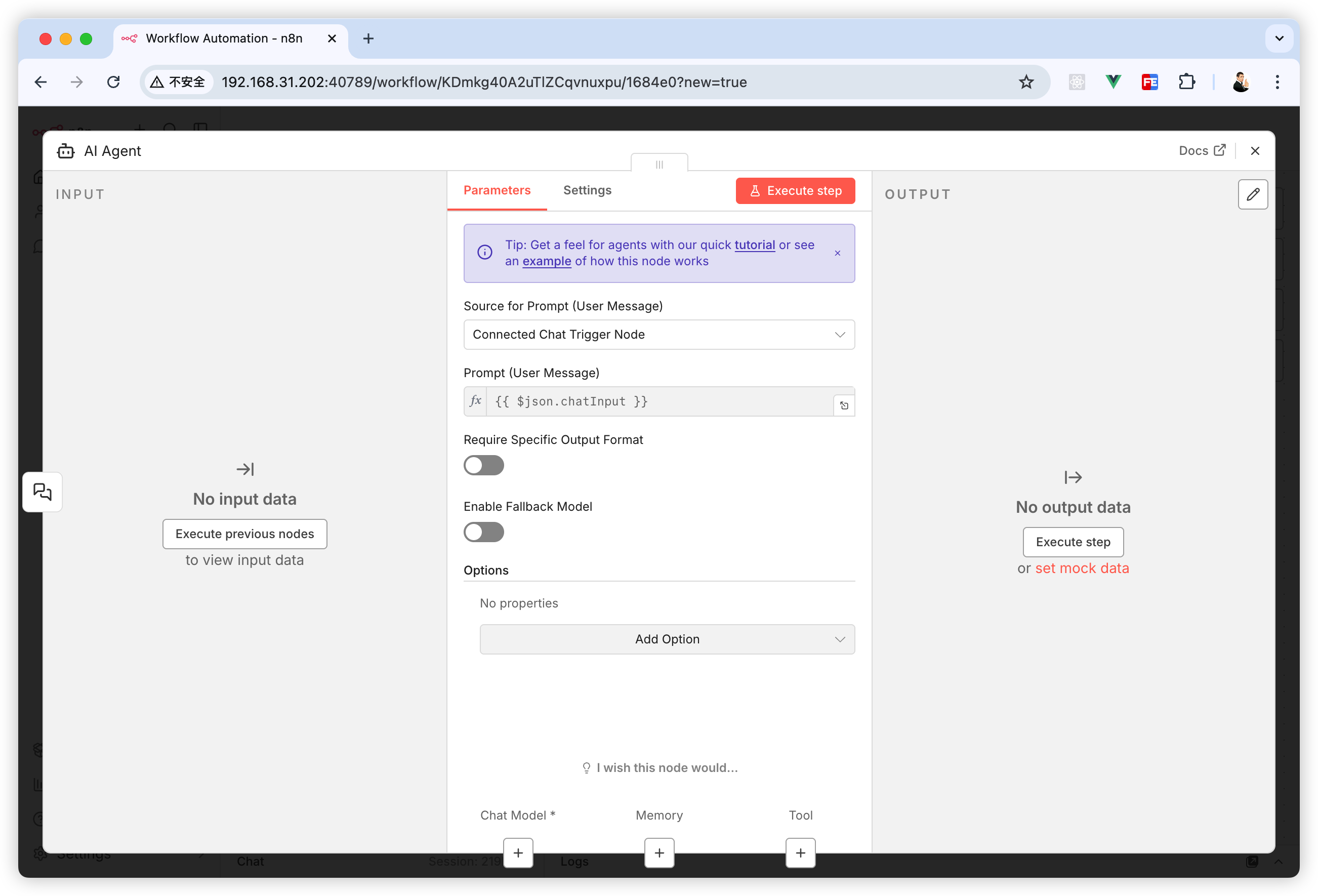

点击“AI Agent”后会弹出这个弹窗,先关掉它。

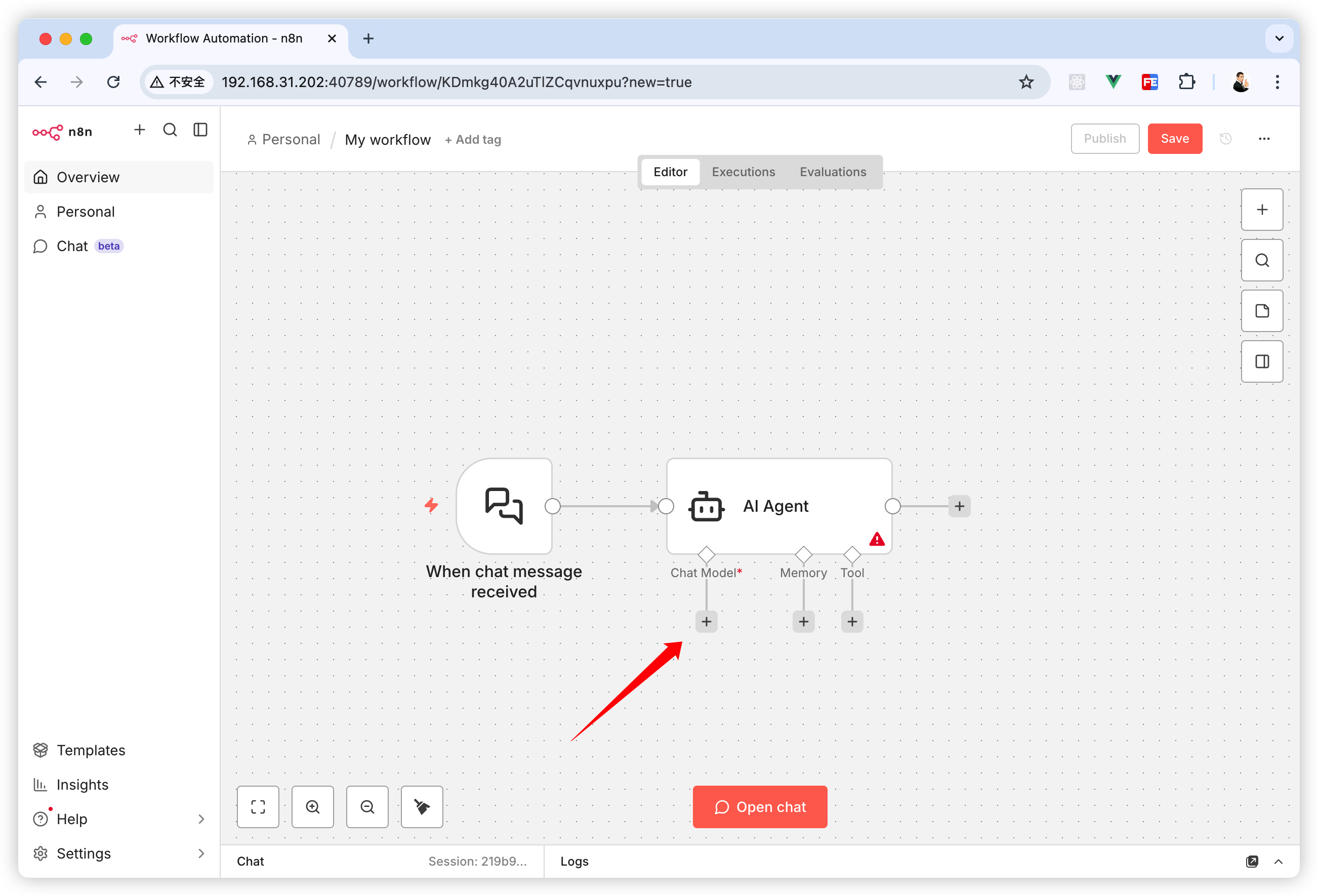

关掉弹窗后会回到画布界面,此时就看到一个聊天机器人的工作流,我们点击“Chat Model”的这个加号。

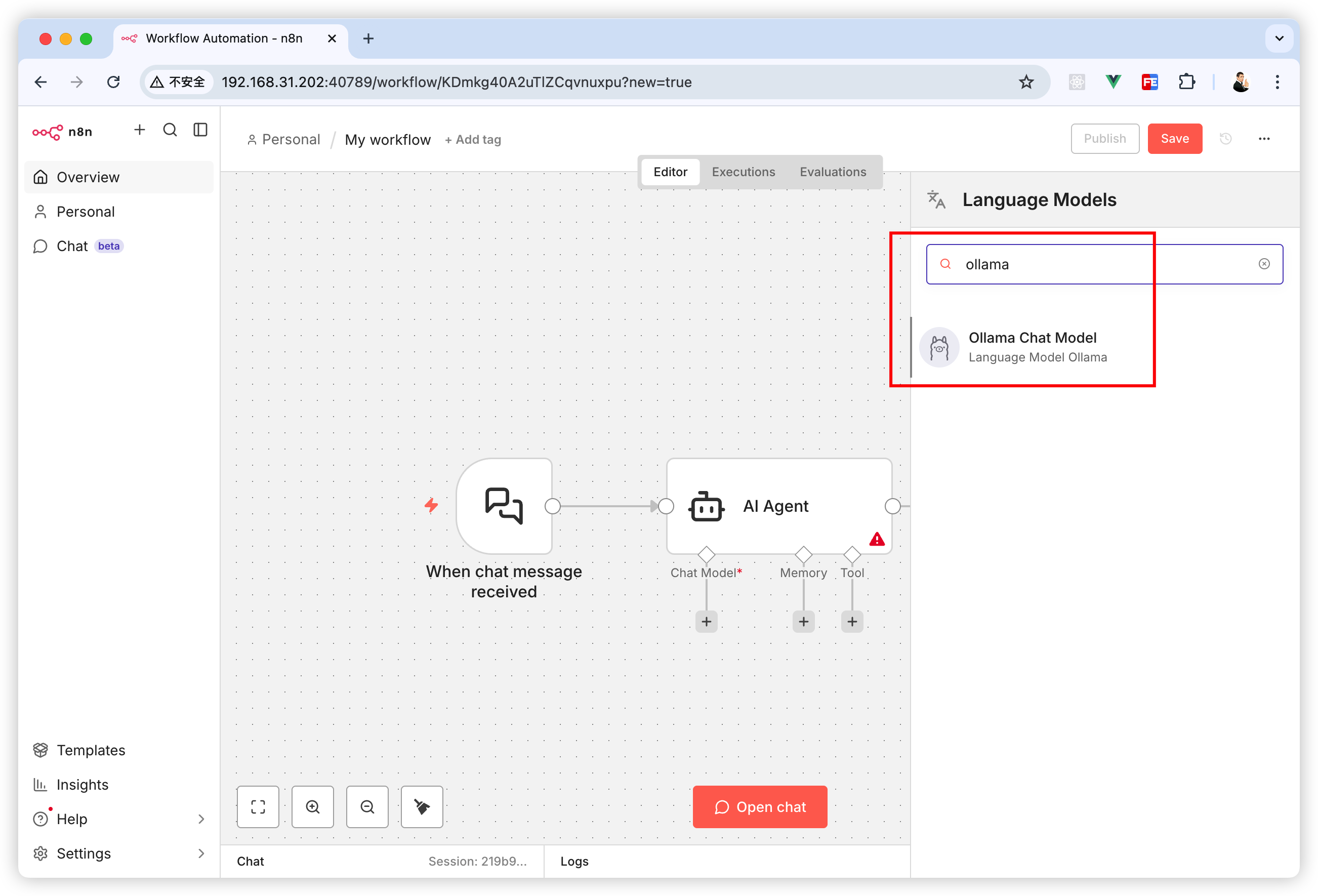

然后搜索 ollama。

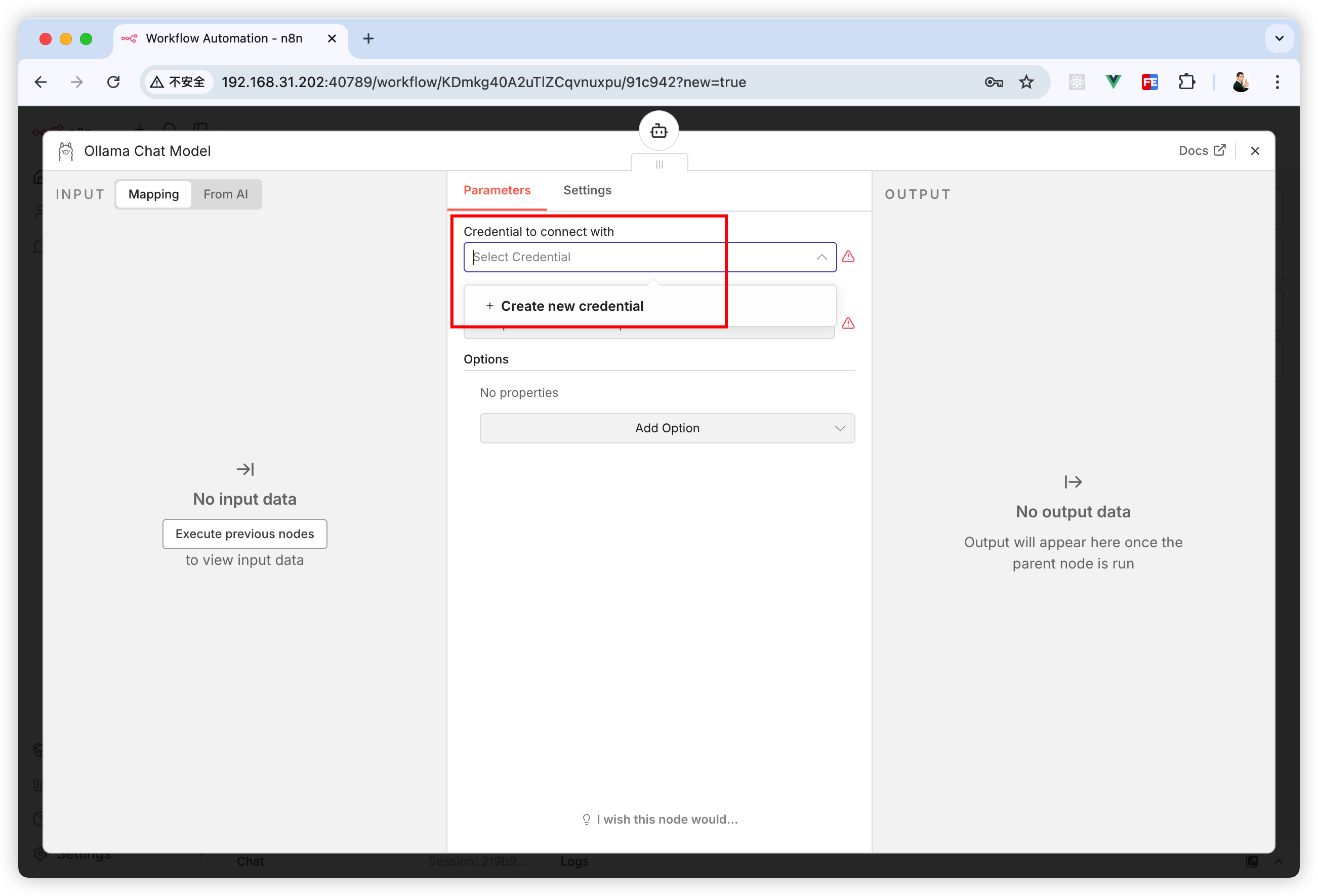

点击“Credential to connect with”项的“Create new credential”。

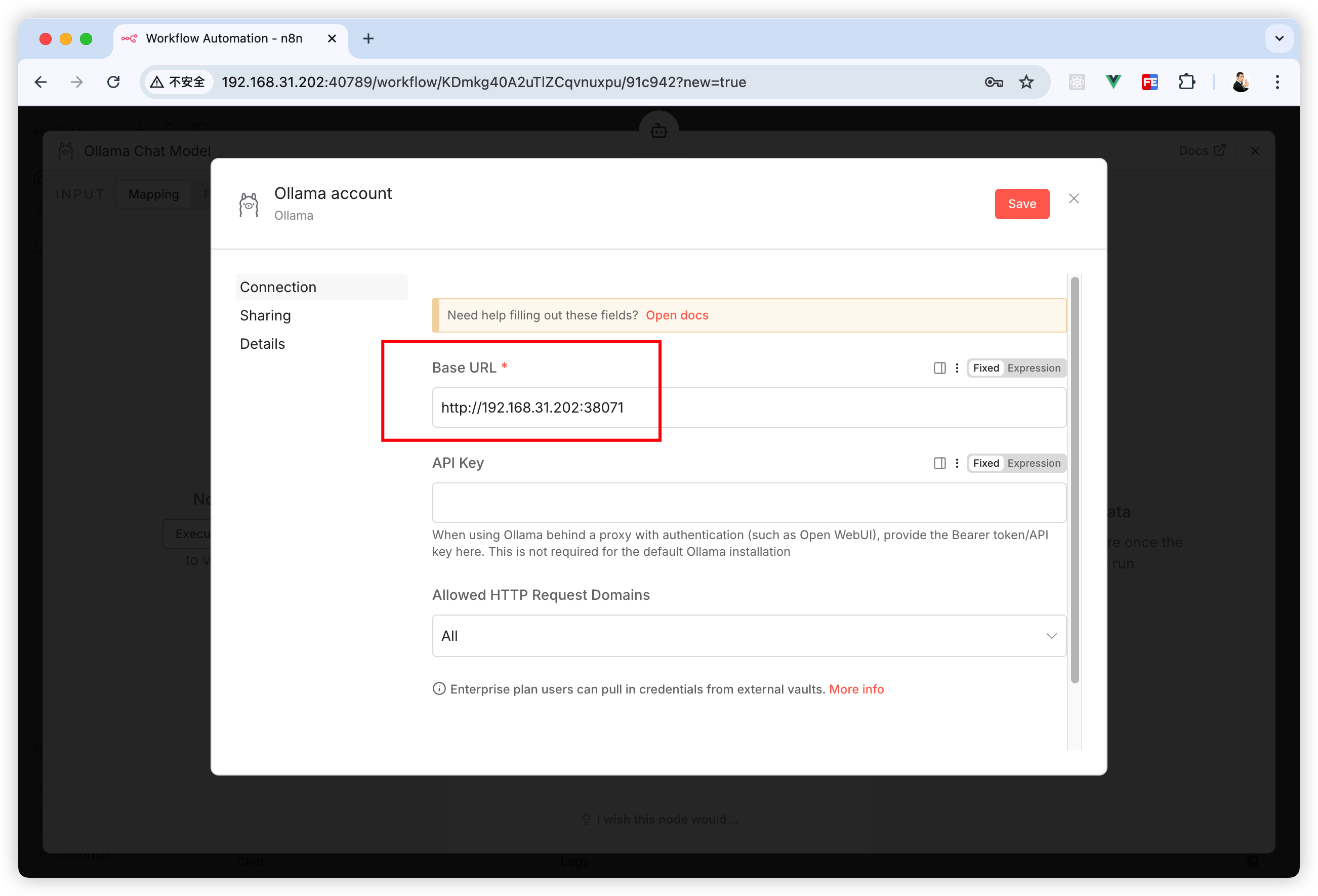

在“Base URL”里输入你部署好的 Ollama 的地址(NAS的IP + 部署好的 ollama 的端口)。

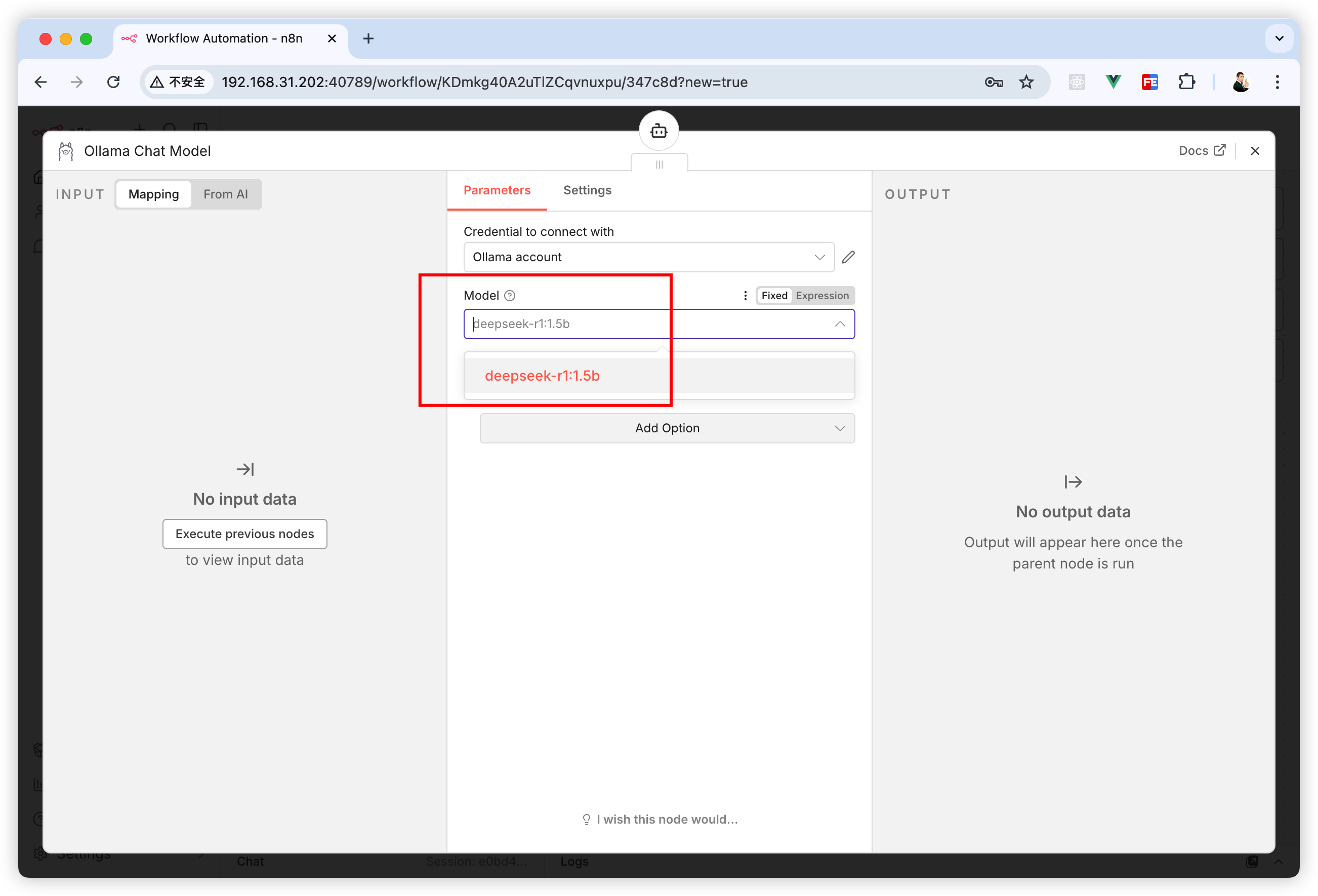

在“Model”项选择刚刚在 Ollama 下载好的 deepseek-r1:1.5b 这个模型。

然后关掉这个弹窗。

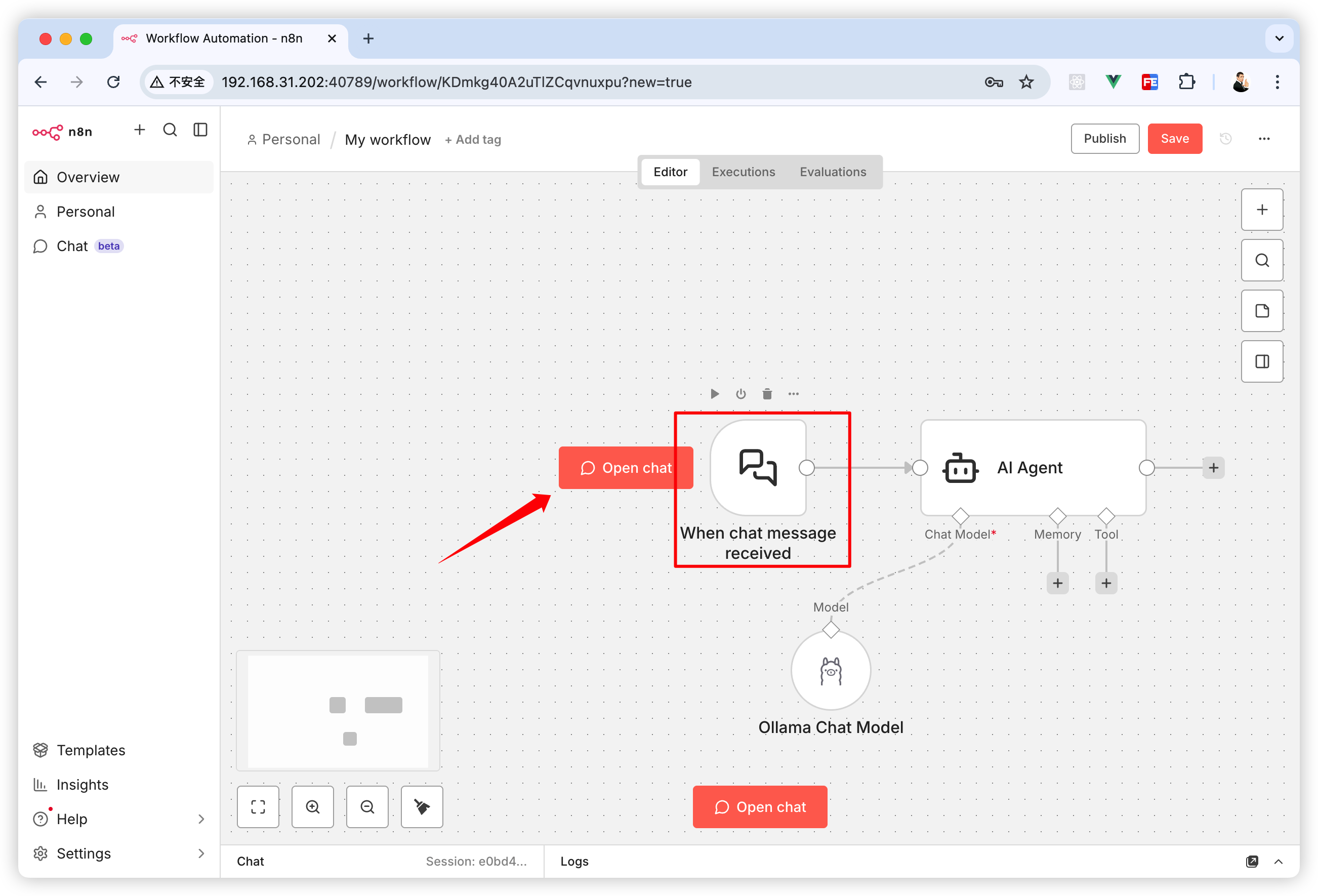

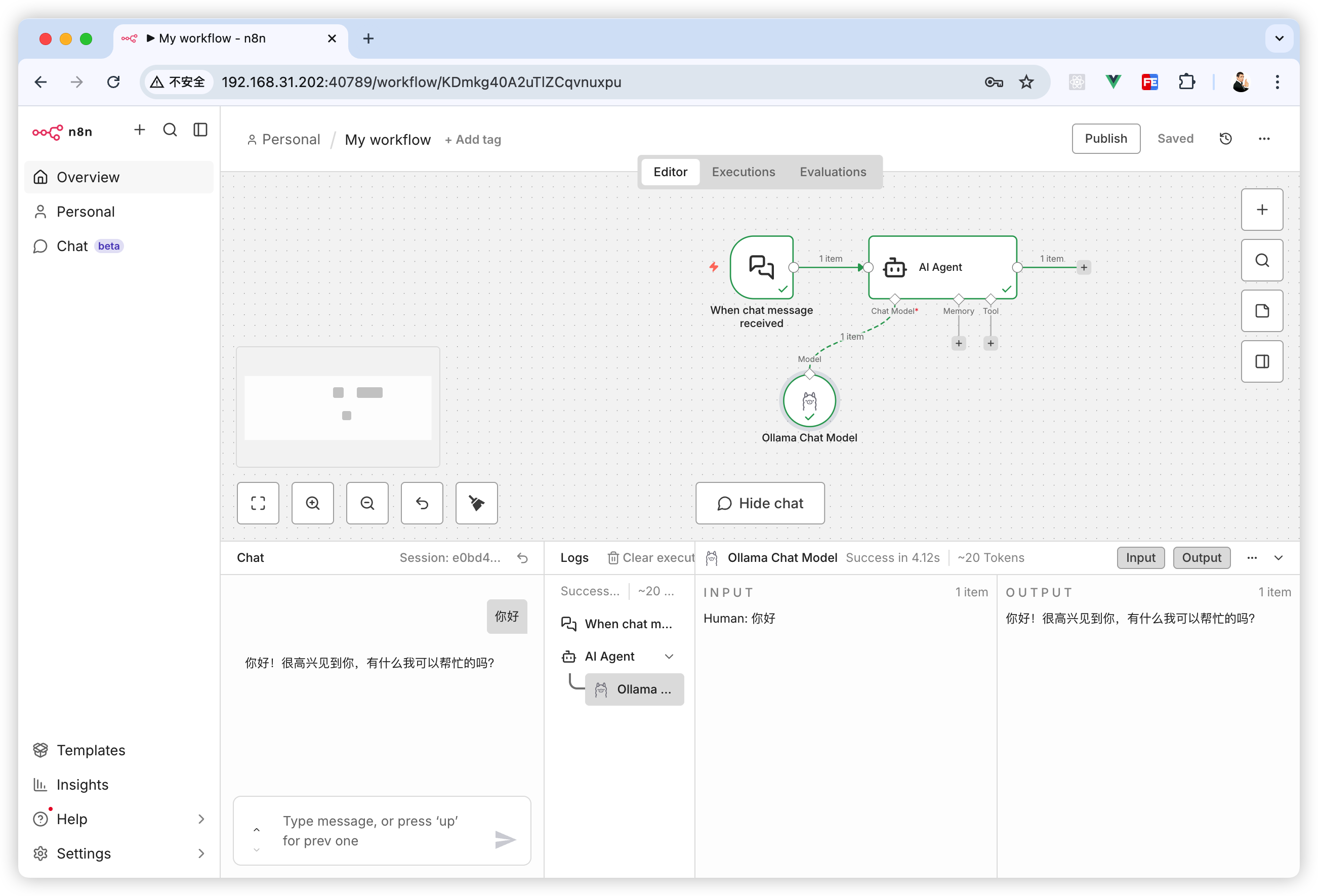

关掉弹窗后回到工作流画布面板就能看到“AI Agent”这个节点的“Chat Model”连上了 Ollama。

然后把鼠标移动到“When chat message received”这个节点上,就会在旁边出现一个“Open chat”按钮。点击这个按钮会在页面下方出现一个聊天窗口

在“Chat”面板输入点内容,就可以在控制台看到这个工作流的各个节点的工作过程。

走到这步算是完成本文的任务了。本文这个案例并不是一个完整的工作流,甚至可以说这个工作流是没什么用的。

但我们已经知道怎么在 n8n 接入本地模型了,想用 n8n 实现一些自动化任务,可以关注我新开的坑👉 《n8n修炼手册》👏

以上就是本文的全部内容啦,想了解更多NAS玩法可以关注《NAS邪修》

点赞 + 关注 + 收藏 = 学会了

浙公网安备 33010602011771号

浙公网安备 33010602011771号