hudi编译

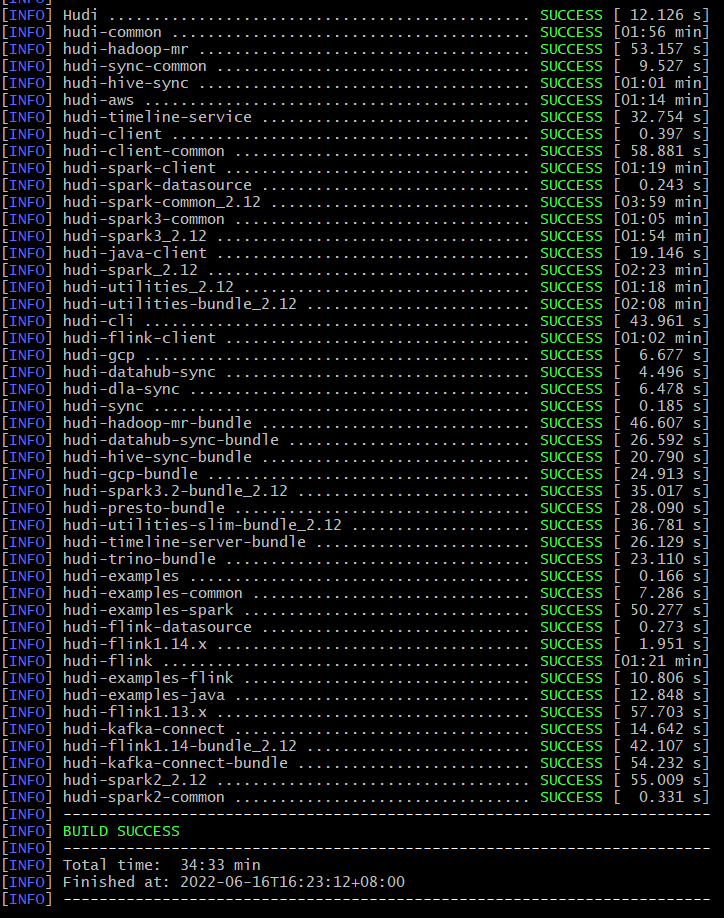

hudi0.11.0+spark3.2

mvn clean install -DskipTests -Dspark3.2 -Dscala-2.12

- 编译产物在packaging下的hudi-spark-bundle目录

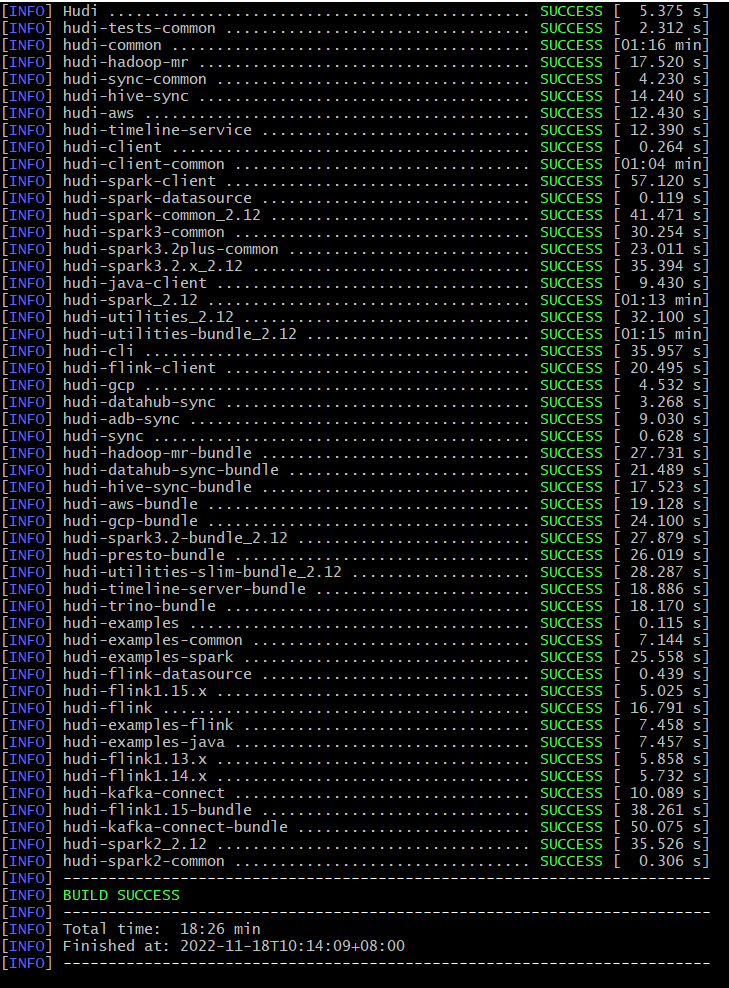

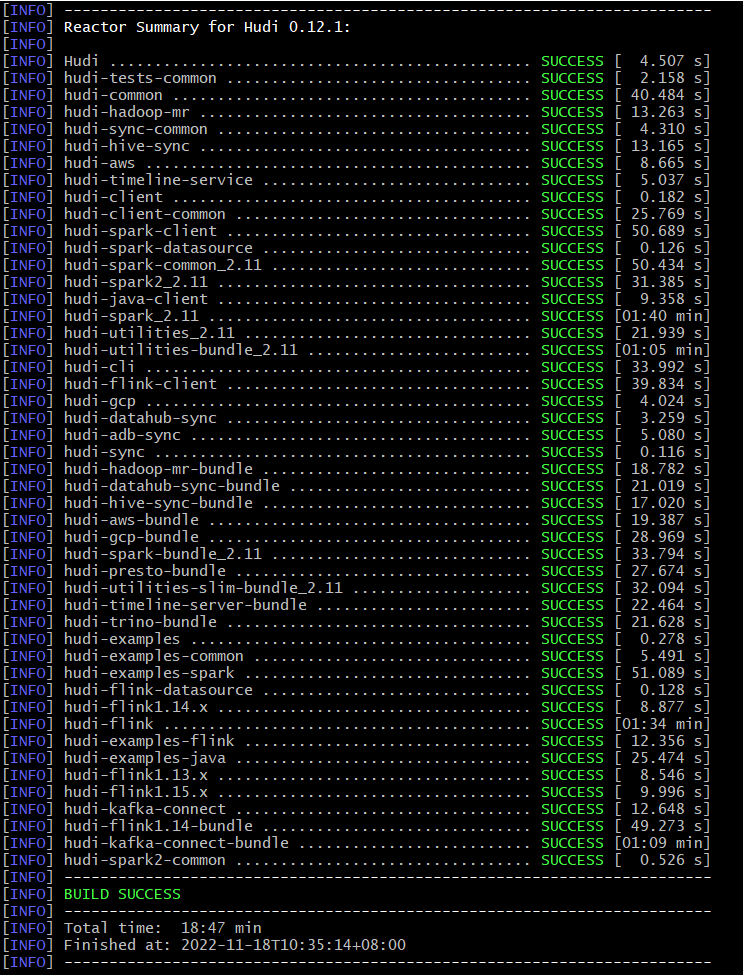

hudi0.12.1+spark3.2

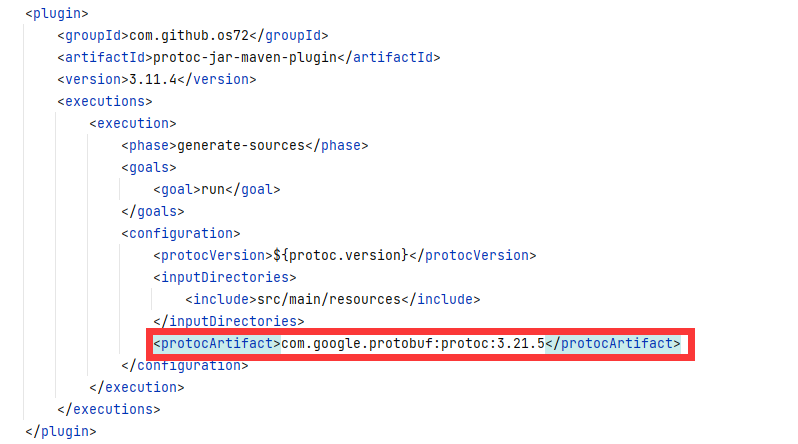

- pom配置修改

方式一:

父pom文件修改:proto版本从3.21.5改为3.11.4

<!-- <proto.version>3.21.5</proto.version>-->

<!-- <protoc.version>3.21.5</protoc.version>-->

<proto.version>3.11.4</proto.version>

<protoc.version>3.11.4</protoc.version>

方式二:

修改hudi-kafka-connect 中 pom文件,

添加:<protocArtifact>com.google.protobuf:protoc:3.21.5</protocArtifact>

- 打包

mvn clean install -DskipTests -Dspark3.2 -Dscala-2.12

- 编译产物在packaging下的hudi-spark-bundle目录

hudi0.12.1+flink1.14.0

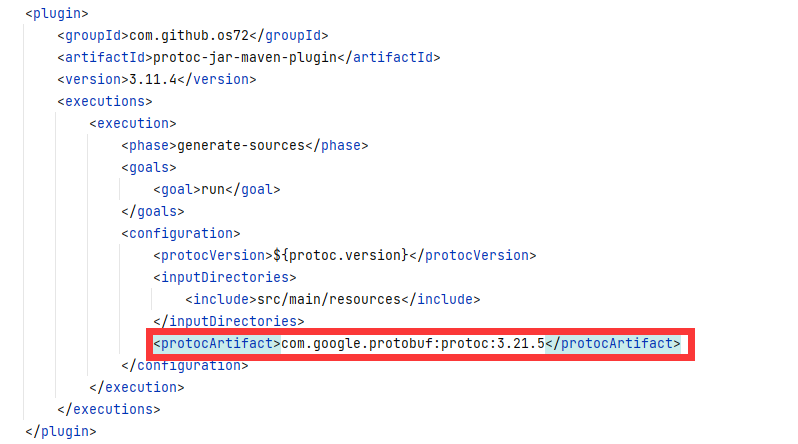

- pom配置修改

方式一:

父pom文件修改:proto版本从3.21.5改为3.11.4

<!-- <proto.version>3.21.5</proto.version>-->

<!-- <protoc.version>3.21.5</protoc.version>-->

<proto.version>3.11.4</proto.version>

<protoc.version>3.11.4</protoc.version>

方式二:

修改hudi-kafka-connect 中 pom文件,

添加:<protocArtifact>com.google.protobuf:protoc:3.21.5</protocArtifact>

- 打包

mvn clean install -DskipTests -Dflink1.14

- 编译产物在packaging下的hudi-flink-bundle目录

包含hive jar

mvn clean install -DskipTests -Drat.skip=true -Pflink-bundle-shade-hive2 -Dflink1.14

注:使用hudi hms catalog时,需按如上方式打jar包,否则会缺少hive相关类

参考

- https://github.com/apache/hudi/issues/6724

- [HUDI-4193] Upgrade Protobuf to 3.21.5 by slachiewicz · Pull Request #5784 · apache/hudi

- Hudi master 0.13.0-SNAPSHOT Win10 打包异常解决

- Error extracting protoc for version 3.5.1 · Issue #68 · os72/protoc-jar-maven-plugin

- [SUPPORT] flink hudi some class not found · Issue #4825 · apache/hudi

浙公网安备 33010602011771号

浙公网安备 33010602011771号