elasticsearch中ik分词器的安装和基本使用

es中ik分词器的分词效果不甚理想,所以我们可以使用ik分词器使分词效果更好

安装

1.ik分词器的下载

网址:https://github.com/medcl/elasticsearch-analysis-ik/releases

切结我们的ik分词器的版本需要和es的版本保持一致!我个人使用的7.9.3的版本,然后将对应的zip下载了下来

- ik分词器的安装

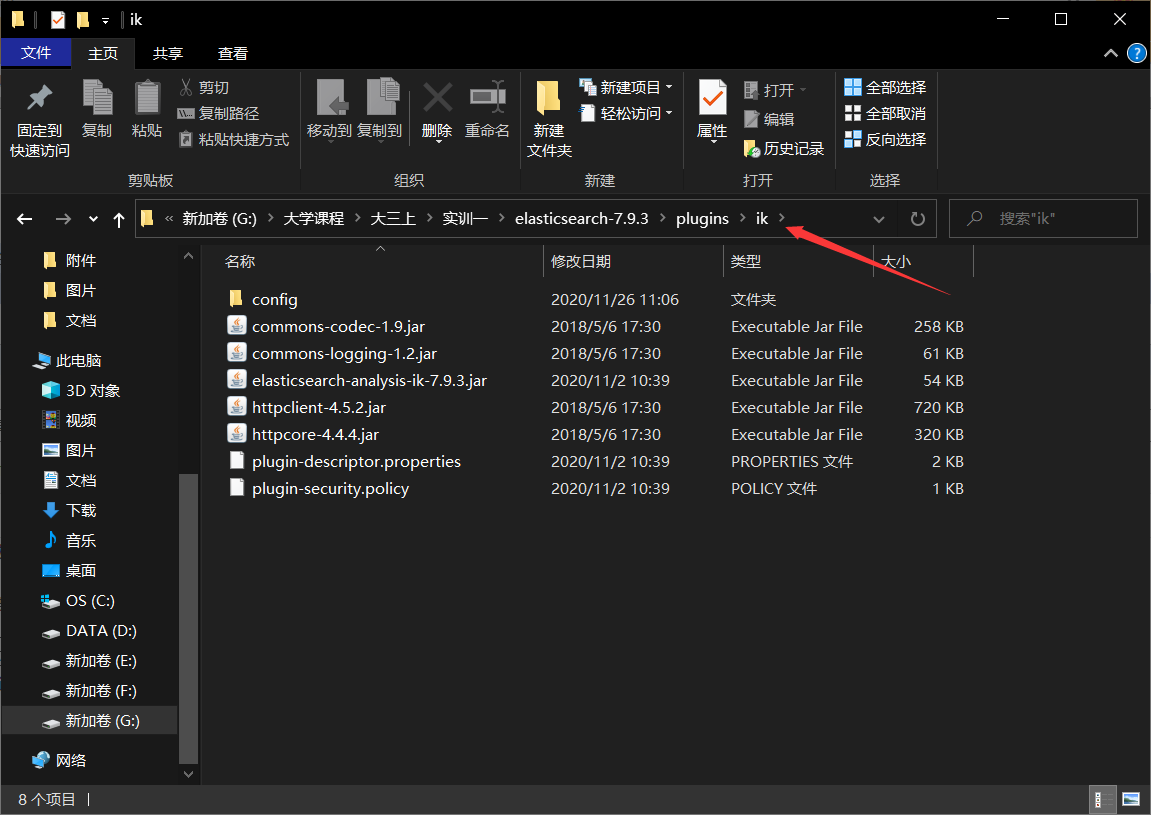

然后将下载下来的zip进行解压,并将解压出来的文件夹移动到 es的安装目录/plugin/ik 下

具体如图

3.重启es,否则ik分词器不生效

4.接下来正常使用就可以啦

两种模式

ik分词器有ik_max_word和ik_smart两张模式

ik_max_word会将文本做最细粒度的拆分

ik_smart会做最粗粒度的拆分

停用词

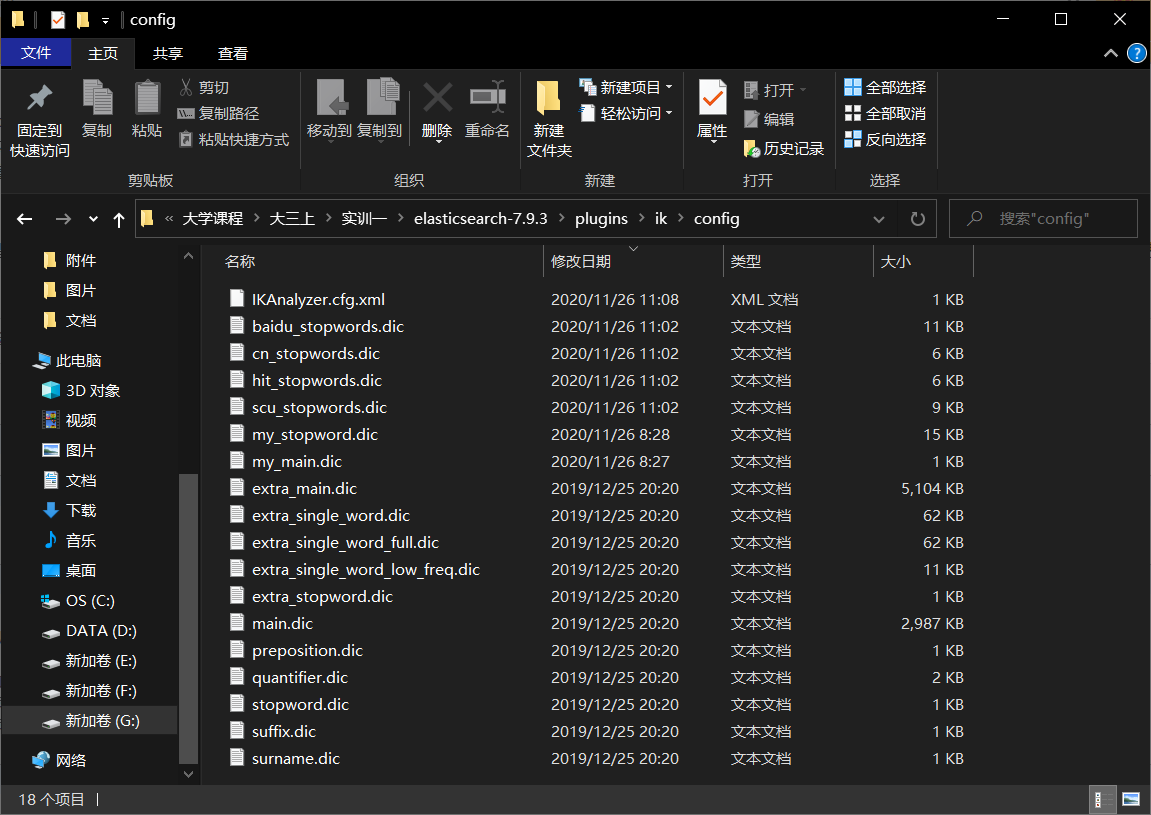

在使用的时候,尤其是对中文进行分词,会有很多无意义的词,例如我,你这种,对于统计会有较大的影响(尤其是统计词频),这个时候我们可以给ik分词器加入停用词表,争取最大程度让分出来的词有实际意义

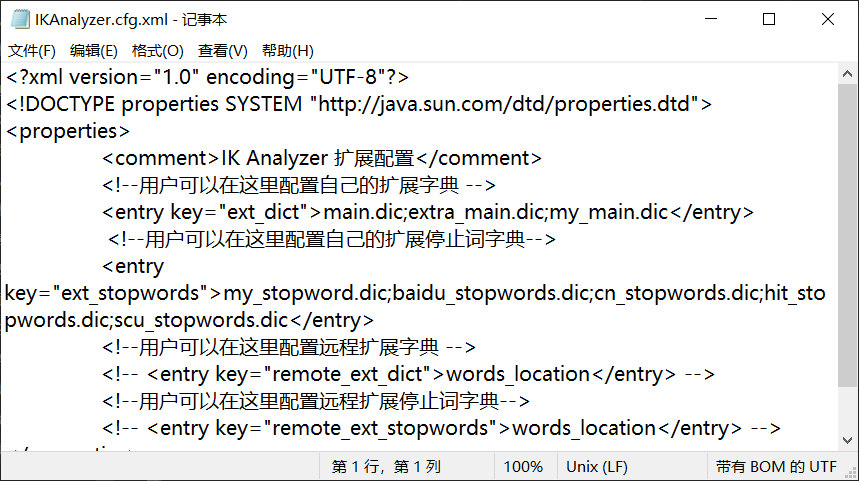

后缀为dic的文件都是我的词表(我也不知道为什么会这么多,战术耸肩),然后编辑IKAnalyzer.cfg.xml这个文件,将词表插入进去就可以了,然后重启es

附一个中文常用停用词表的库:https://github.com/goto456/stopwords

当然也可以自己写一个停用词表了,效果更好,就是会比较花时间

浙公网安备 33010602011771号

浙公网安备 33010602011771号