神经网络和Transformer基础

一、矩阵乘法

A * M = B。 其中,A表示原矩阵,是原空间的一组向量(数据点); M表示空间变换规则; B表示转换后新空间的一组向量(数据点)

举例: 比如 1*2的向量,和矩阵2*3进行相乘,结果是1*3。说明向量(数据点)还是1个,数据维度从2升成3,从2维平面向量(数据点),变换到了3维立体空间的向量(数据点)

如何理解

- 空间变换(升/降): 表示将向量(数据点)进行空间变换到新的空间去,类似升维、降唯效果。

- 线性变换:点变换都是通过一次方程,变换后至少一些特性不变: 向量(数据点)数不变; 各向量间的长度比例不多(都等比拉升/压缩)等。

二、神经网络

三、Transformer

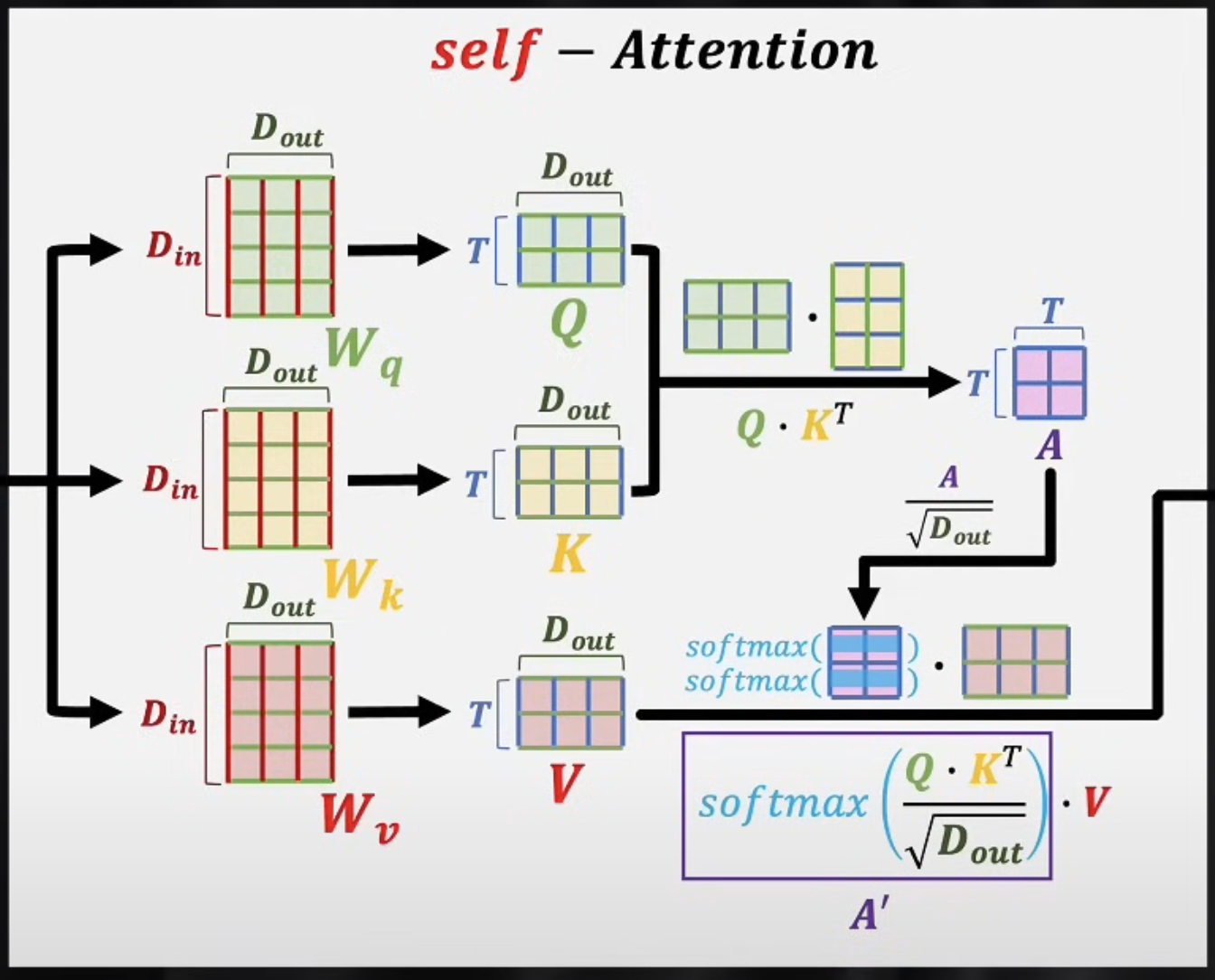

- 自注意力机制

自注意力功能简要说: 就是把输入一组词向量(多个词,数学形式是矩阵)进行训练和矩阵运算,得到Q、K、V这3个矩阵。 其中Q、K、V逻辑上分别理解成设定语义、表达语义和客观词典语义; 然后Q、K运算得到A`,A`就相当于是主观修正;A`和V计算,即主观修正矩阵和客观词典语义运算,得到这句话的真实语义。

浙公网安备 33010602011771号

浙公网安备 33010602011771号