LSTM TIME AND FREQUENCY RECURRENCE FOR AUTOMATIC SPEECH RECOGNITION

1 摘要

长短期记忆(LSTM)递归神经网络(RNN)最近显示出比深层前馈神经网络(DNN)有明显的性能改进。这些模型的一个关键方面是使用时间递归,并与改善梯度消失问题的门控结构相结合。受人类光谱图阅读的启发,在本文中我们提出了对LSTM的扩展,在频率和时间上进行递归。该模型首先扫描频带以生成频谱信息的摘要,然后将输出层激活作为传统时间LSTM(T-LSTM)的输入。在微软的短信息听写任务中评估,所提出的模型比T-LSTM获得了3.6%的相对单词错误率的降低。

本文的主要贡献是提出了一个两级网络,第一级沿频率轴进行递归,第二级进行时间递归。我们称其为频率-时间LSTM或F-T-LSTM。在第2节中,我们简要介绍了LSTM,然后在第3节中提出了结合频率LSTM和时间LSTM的建议模型。在第4节中,我们将提出的方法与卷积LSTM DNN(CLDNN)[16]和多维RNN[17][18]相区别。第5节对该算法进行了实验评估。我们在第6节中总结了我们的研究并得出结论。

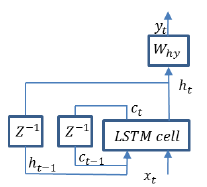

2 LSTM-RNN

RNN与前馈DNN的根本区别在于,RNN不在固定的帧窗口上操作;相反,它保持着一个隐藏的状态向量,在看到每个时间段后递归地更新。内部状态编码了从话语开始到最后一次输入的全部历史,因此,与固定窗口的DNN相比,它有可能模拟更长的跨度效应。换句话说,RNN是一个动态系统,比执行静态输入-输出转换的DNN更通用。内部状态的包含使RNN能够表示和学习长距离的顺序依赖。

然而,当错误信号通过时间反传播时,简单的RNN存在梯度消失问题。这个问题在LSTM-RNN中通过使用以下四个部分得到很好的处理。

记忆单元:这些单元存储了网络的时间状态。

输入闸门:这些闸门调节进入细胞的输入激活。

输出门:这些门调节细胞的输出激活。

遗忘门:这些门可以适应性地重置细胞的记忆。

在LSTM-RNNs中,除了过去的隐层输出𝒉𝑡-1,过去的记忆激活𝒄𝑡-1也是LSTM单元的输入。

3 FREQUENCY-TIME LSTM-RNN

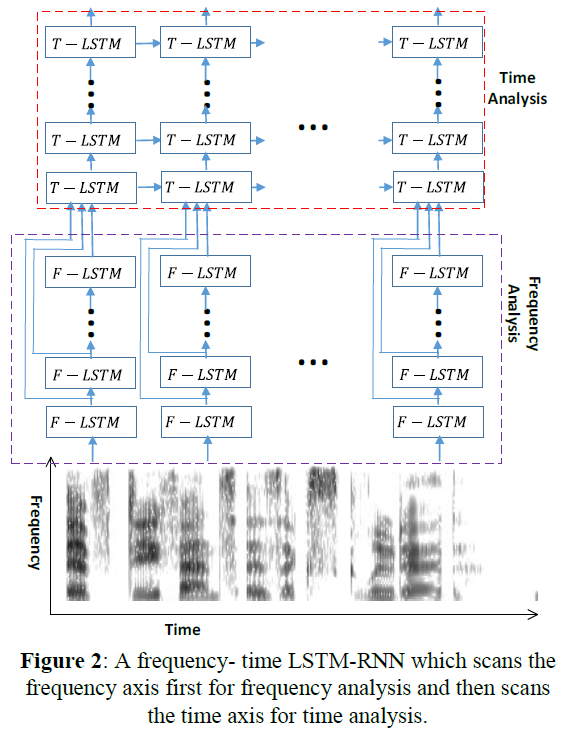

在本节中,我们提出了一种频率-时间LSTM(F-TLSTM)。它结合了频率LSTM和时间LSTM。我们首先使用频率LSTM(FLSTM)来扫描频段,这样,频率变化的信息由FLSTM的输出来总结。F-LSTM的表述与T-LSTM的表述相同,只是指数j现在代表的是频率步数而不是时间步数。然后,我们可以从所有的F-LSTM步骤中获取输出,并使用所有F-LSTM步骤的输出,并将其作为T-LSTM的输入,以传统的方式进行时间分析。

图 一个频率-时间LSTM-RNN,它首先扫描频率轴,进行频率分析,然后再扫描时间轴进行时间分析。

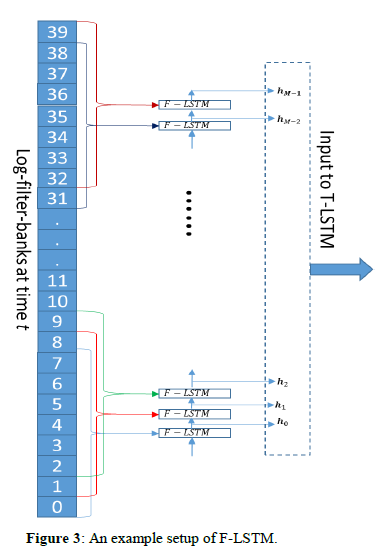

下图显示了我们实验中使用的F-LSTM的设置实例。每一帧的输入由当前时间t的40维对数过滤库值组成。我们将40个对数过滤库通道分为33个重叠的块,每个块包含8个对数过滤库。这导致相邻块之间有7个对数过滤库的重叠(C=7)。因此,第一个F-LSTM单元接受8个输入:从0到7的对数过滤库,第二个F-LSTM单元接受从1到8的对数过滤库,以此类推。第m个F-LSTM单元产生的输出𝒉𝑚,将被传递到第m+1个F-LSTM单元。最后,𝒉𝑚,𝑚=0...𝑀-1(本例中M=33)将被串联起来作为T-LSTM的输入。

在本文中,我们提出了一个FT-LSTM架构,它同时扫描时间轴和频率轴来模拟频谱图的演变模式。F-T-LSTM首先使用一个F-LSTM来执行一个频率递归,总结出频率上的模式。然后将其送入T-LSTM。所提出的F-T-LSTM在一个短信息听写任务上比传统的T-LSTM获得了3.6%的相对误码率的降低。我们表明,只要F-LSTM的存储单元数量合理,F-T-LSTM就能取得良好的性能。我们还评估了叠加多个帧作为F-LSTM的输入的影响,发现最好的办法是简单地一次呈现一个帧

浙公网安备 33010602011771号

浙公网安备 33010602011771号