本地部署 DeepSeek+VS Code,搭建本地大模型

一、安装Ollama

Ollama是一个用于在本地计算机上运行大型语言模型的命令行工具,允许用户下载并本地运行像Llama 2、Code Llama和其他模型,并支持自定义和创建自己的模型。

Ollama官网下载:https://ollama.com/download,根据自己的系统下载对应文件。

在安装Ollama时,虽然默认情况下会安装在C盘,但你可以通过以下步骤选择自定义的安装路径:

- 使用CMD命令行窗口,定位到OllamaSetup.exe所在目录(假设

OllamaSetup.exe在E:\Downloads目录下),然后执行如下命令:

OllamaSetup.exe /DIR="D:\Your\Path"

将D:\Your\Path替换为你希望的安装路径

比如:

E:\Downloads>OllamaSetup.exe /DIR="D:\Program Files\Ollama"

回车后,安装程序将按照你指定的路径进行安装。

上述步骤完成后,我们可以打开CMD,输入 ollama -v 命令,如果出现版本号说明安装成功了。

二、下载Deepseek

DeepSeek 团队已经证明,较大模型的推理模式可以提炼成更小的模型,与通过 RL 在小型模型上发现的推理模式相比,性能更好。

以下是使用 DeepSeek-R1 生成的推理数据对研究界广泛使用的几个密集模型进行微调而创建的模型。评估结果表明,蒸馏的较小密集模型在基准上表现非常出色。

去Ollama官网,点击顶部的Models链接,选择deepseek-r1模型,根据电脑硬件条件选择不同的属性,一般1.5b就可以,电脑性能好的可以选8b。

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

然后复制上面所选命令,打开CMD命令工具,注意这里需定位到你安装Ollama的目录中,否则默认在C盘。

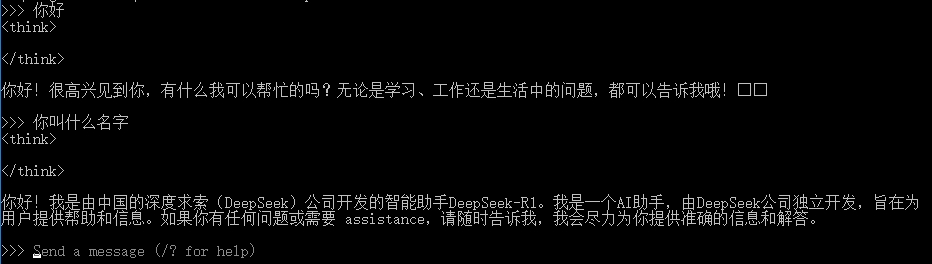

在DeepSeek下载完成后,我们就可以在CMD中输入内容进行对话了,如输入:你好。

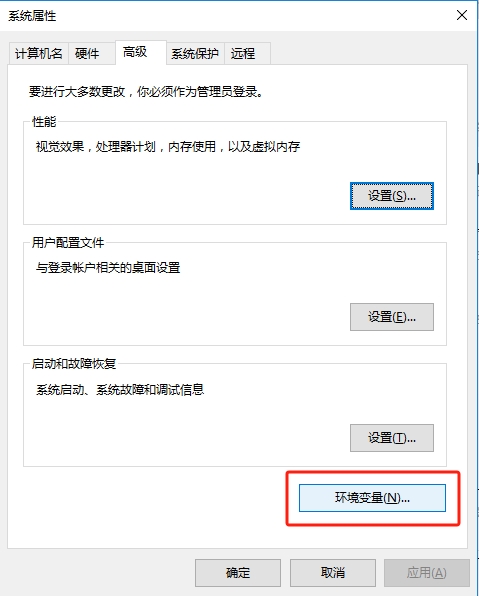

也可以修改大模型存储位置:

进入系统高级设置,选择环境变量

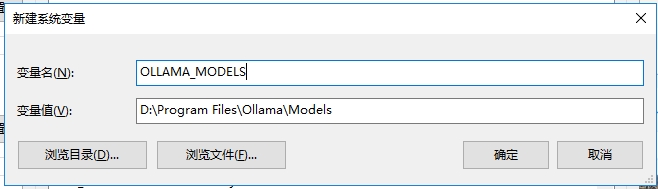

在用户变量中点击新建按钮,变量名为OLLAMA_MODELS,变量值为D:\Program Files\Ollama\Models,其中的变量值就是大模型下载存储的目录位置,最后点击确定即可,如下图:

还可以下载自动补全模型(deepseek-coder)

1.3 billion parameter model

ollama run deepseek-coder

6.7 billion parameter model

ollama run deepseek-coder:6.7b

33 billion parameter model

ollama run deepseek-coder:33b

三、在VSCode中部署Deepseek

打开VSCode,去插件商场搜索Continue,并安装。

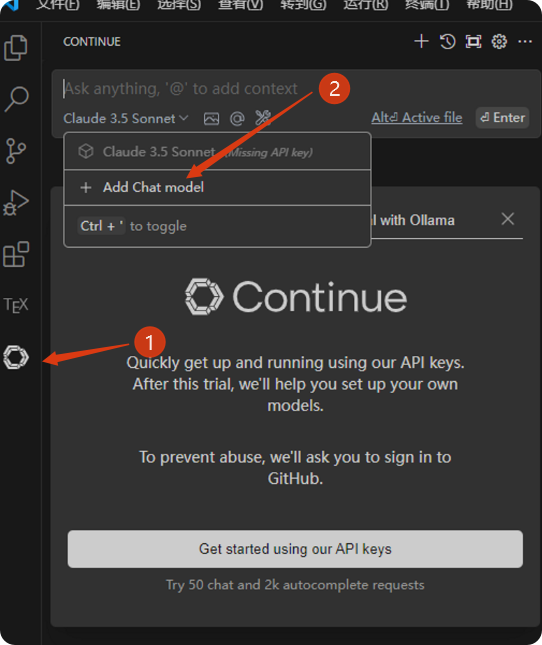

安装完成后,点击右侧图标,添加新的大语言模型

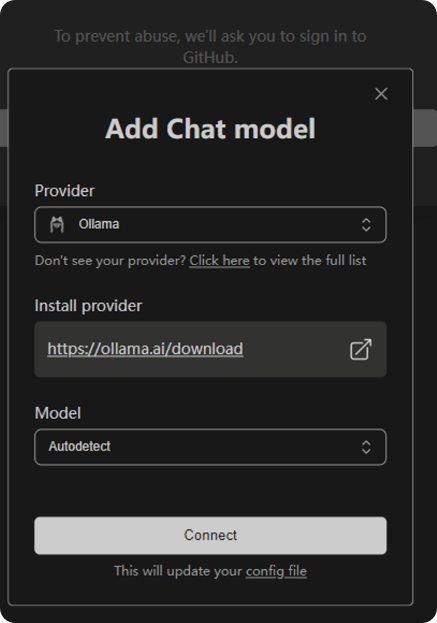

Continue支持很多厂商,我们选择Ollama

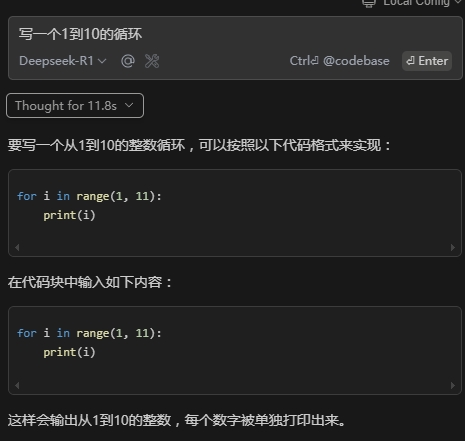

添加完成后就可以使用了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号