EFAK分布式安装记录

1.下载EFAK,解压到指定目录。

2.在/etc/profile文件中添加配置:

export KE_HOME=/usr/local/kafka-eagle

export PATH=$KE_HOME/bin:$PATH

3.在kafka每个节点的kafka-server-start.sh文件中的上部添加jmx port:

export JMX_PORT=9999

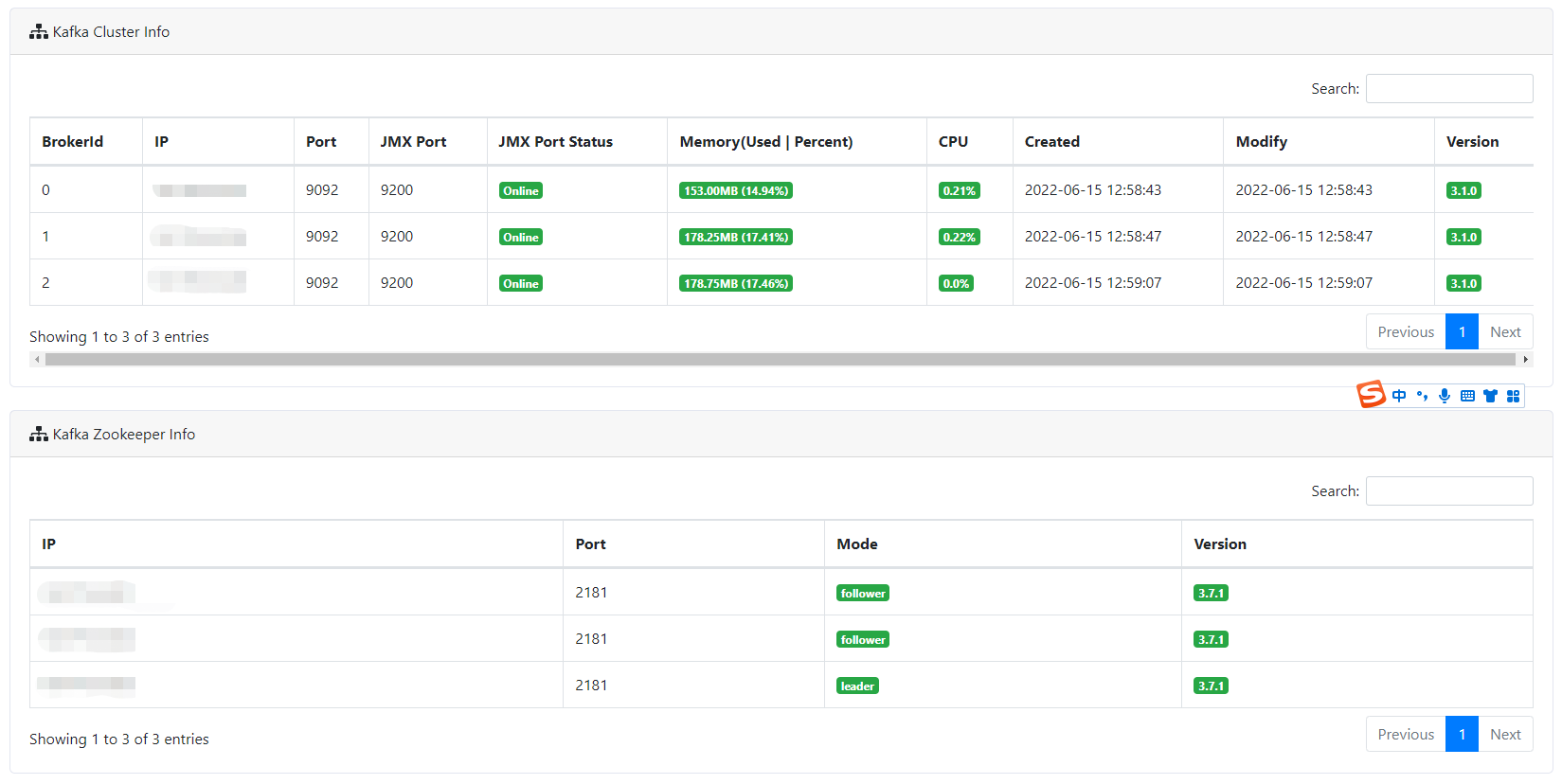

官方推荐9999端口,我设置的端口为9200,设置好后,efak会自动找到该端口(我本来添加9999端口,但启动报错,说9999被占,所以改用9200端口)。

4.进入conf文件夹,修改配置文件为:

efak.zk.cluster.alias=cluster1 #Kafka使用的Zookeeper集群别名,多个集群用逗号分隔。 cluster1.zk.list=x.x.x.x:2181,x.x.x.x:2181,x.x.x.x:2181 #zookeeper.connect地址 cluster1.efak.offset.storage=kafka #存储消费信息的类型,一般在0.9版本之前,消费信息会默认存储在Zookeeper中,在0.10版本之后,消费者信息默认存储在 Kafka中,存储类型需要设置为kafka。 efak.metrics.retain=15 #性能监控数据保存天数 efak.driver=com.mysql.cj.jdbc.Driver #链接mysql8.0驱动,低版本数据库需修改 efak.username= #mysql数据库用户名 efak.password= #mysql数据库密码

注意:必须为每一个节点的efak设置好本地的数据库(本地数据库必须要存在,目前还不清楚是否能共用mysql)或者db文件路径,否则UI会出现显示异常。

5.修改work文件,注意只填写datanode的IP,不能填写master的IP.

6.使用命令:ke.sh cluster start/stop/restart/status几个命令进行各种操作。

补充:kafka开启jmx步骤:

参考:kafka efak监控工具 - 苍山落暮 - 博客园 (cnblogs.com)

1.在kafka的bin文件夹中,编辑:kafak-server-start.sh文件,其中添加jmx端口(或者按步骤2也行):

if [ "x$KAFKA_HEAP_OPTS" = "x" ]; then export KAFKA_HEAP_OPTS="-Xmx1G -Xms1G" export JMX_PORT="9200" fi

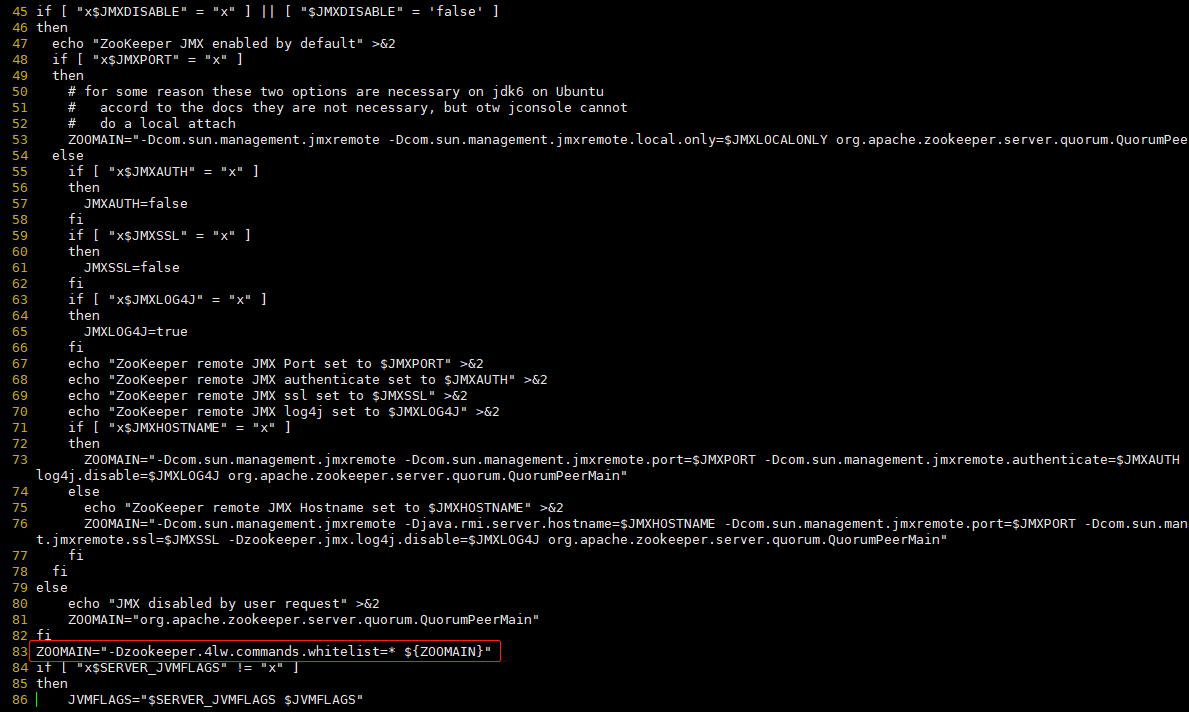

然后,打开zookeeper的bin文件夹下的zkServer.sh文件,将其中的ZOOMAIN判断条件后重写ZOOMAIN:

ZOOMAIN="-Dzookeeper.4lw.commands.whitelist=* ${ZOOMAIN}"

保存后,将zookeeper的zkServer.sh文件和kafka的kafak-server-start.sh文件通过scp *** root@****:/usr/local/***到其他节点。然后重写启动zookeeper和kafka,并重写启动efak,展示一切正常。

注意:

1.每个节点都要有数据库(如果配置数据库),也可以共用一个数据库(已和作者确认)。

2.work只填写datanode节点,不要写master节点,否则页面会出现2个master,其中一个显示datanode,一个显示master,而去掉后一切正常。

浙公网安备 33010602011771号

浙公网安备 33010602011771号