为什么降AI总失败?90%的人不知道这3个检测平台差异

我用了一款「好评如潮」的降AI工具,结果知网从85%降到了12%,开心地提交了。

然后学校用维普一查,AI率52%。直接被打回来了。

后来我才搞明白:知网、维普、万方的检测算法完全不同,用针对知网优化的工具去对付维普,当然不行。这就是为什么很多人降AI总失败的原因。

三大平台的检测逻辑完全不同

很多人以为知网、维普、万方只是名字不同,检测原理应该差不多。其实它们的底层算法和侧重点完全不一样。

知网:最严格,看语义逻辑

知网用的是AIGC检测算法3.0版本,主要依托自己的学术数据库。它不只是看你用了什么词,更会分析句子之间的逻辑关系。

AI写的东西有个特点:逻辑太顺了。每段都是「首先」「其次」「综上所述」,句子之间衔接得天衣无缝。这种「惯性表达」是知网重点检测的对象。

知网用红色标记AI特征显著的内容,检测结果最严格,准确率据说有98.6%。大多数985/211高校用知网。

维普:对句式工整度敏感

维普的检测算法和知网不同,它基于AI大模型反向演算,对「句式工整度」特别敏感。

如果你的论文句子长度太均匀、每段都是三四句话、结构太规整,维普很容易标红。它用蓝色标记疑似AI内容。

维普的计费方式是按篇计费,5万字符以下都算一篇,对长论文来说可能更划算。本科论文用维普的比较多。

万方:相对宽松,但在升级

万方从语言模式和语义逻辑两个角度分析,红色表示AI生成可能性大于85%。

相比知网和维普,万方的判定标准相对宽松一些,但2025年底也升级了算法。它的特点是能精确定位AI段落,告诉你具体哪些地方有问题。

万方按字符数计费,研究生论文和理工科专业用得比较多。

同一篇论文,三个平台结果差多少?

我用同一篇DeepSeek生成的论文做了测试:

| 平台 | AI率 | 特点 |

|---|---|---|

| 知网 | 95% | 最严格 |

| 维普 | 87% | 中等 |

| 万方 | 82% | 相对宽松 |

差异最大的时候可以相差10-20个百分点。所以你在一个平台降到达标,换个平台可能直接翻车。

为什么用了工具还是失败?

原因一:工具只针对单一平台优化

市面上很多降AI工具是专门针对知网优化的。它们了解知网的检测逻辑,能有效降低知网的AI率,但对维普、万方的算法不熟悉。

比如知网看重逻辑连贯性,工具就打乱句子之间的逻辑。但维普看重句式多样性,光打乱逻辑没用,句式还是太整齐照样被标红。

原因二:没确认学校用什么平台

很多人默认学校用知网,结果学校其实用的是维普或万方。选错工具,白花钱。

建议在处理论文之前,先向导师或教务处确认学校用的是哪个检测平台。

原因三:免费工具只是同义词替换

纯同义词替换的免费工具,表面上句子变了,但AI的「指纹特征」还在。检测系统现在越来越聪明,能识别这种低级的改写。

我有个同学用了免费工具,AI率从70%涨到了78%,因为机器改得太明显了。

怎么选对工具?

最简单的方法:选支持多平台的工具。

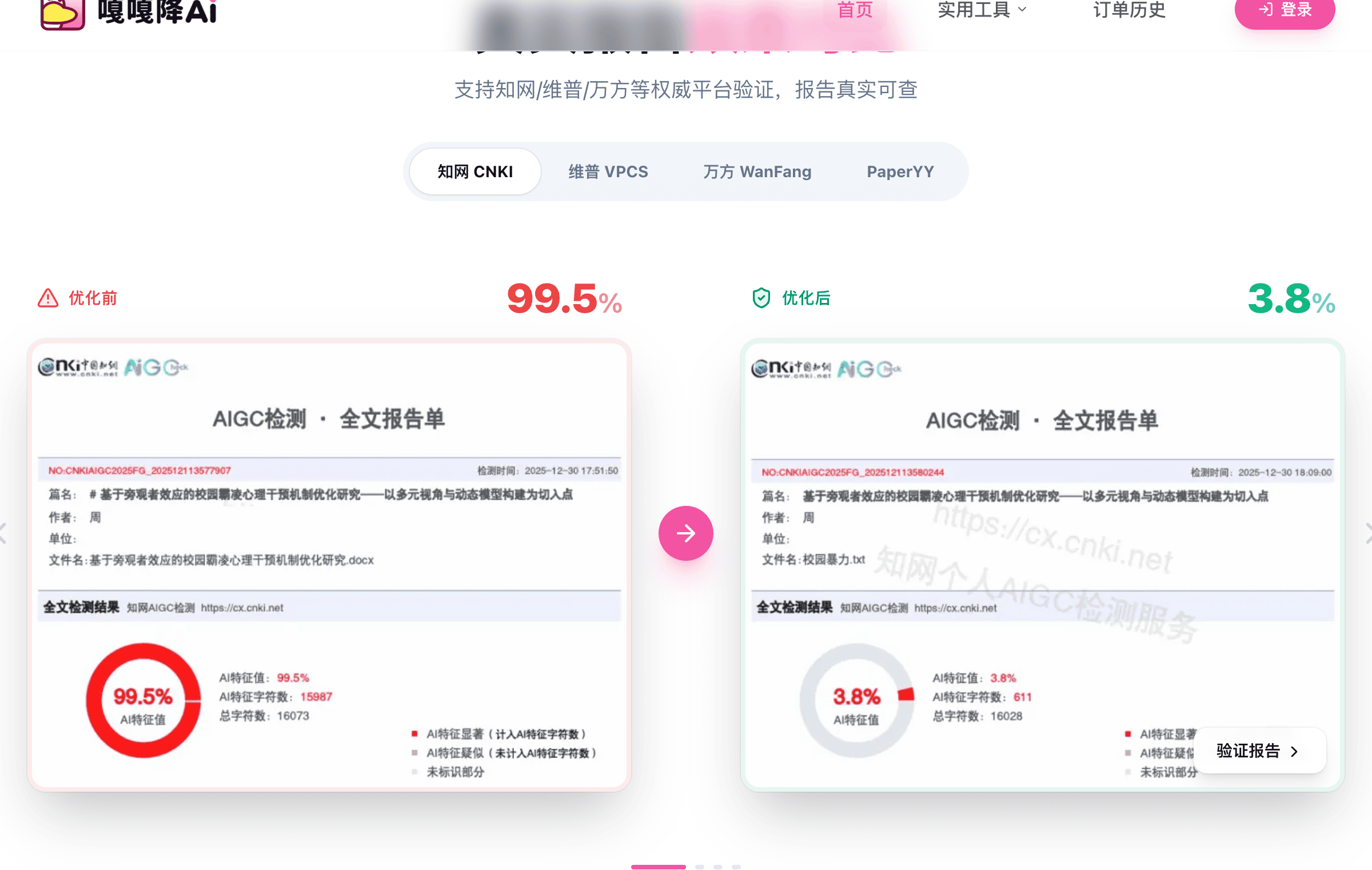

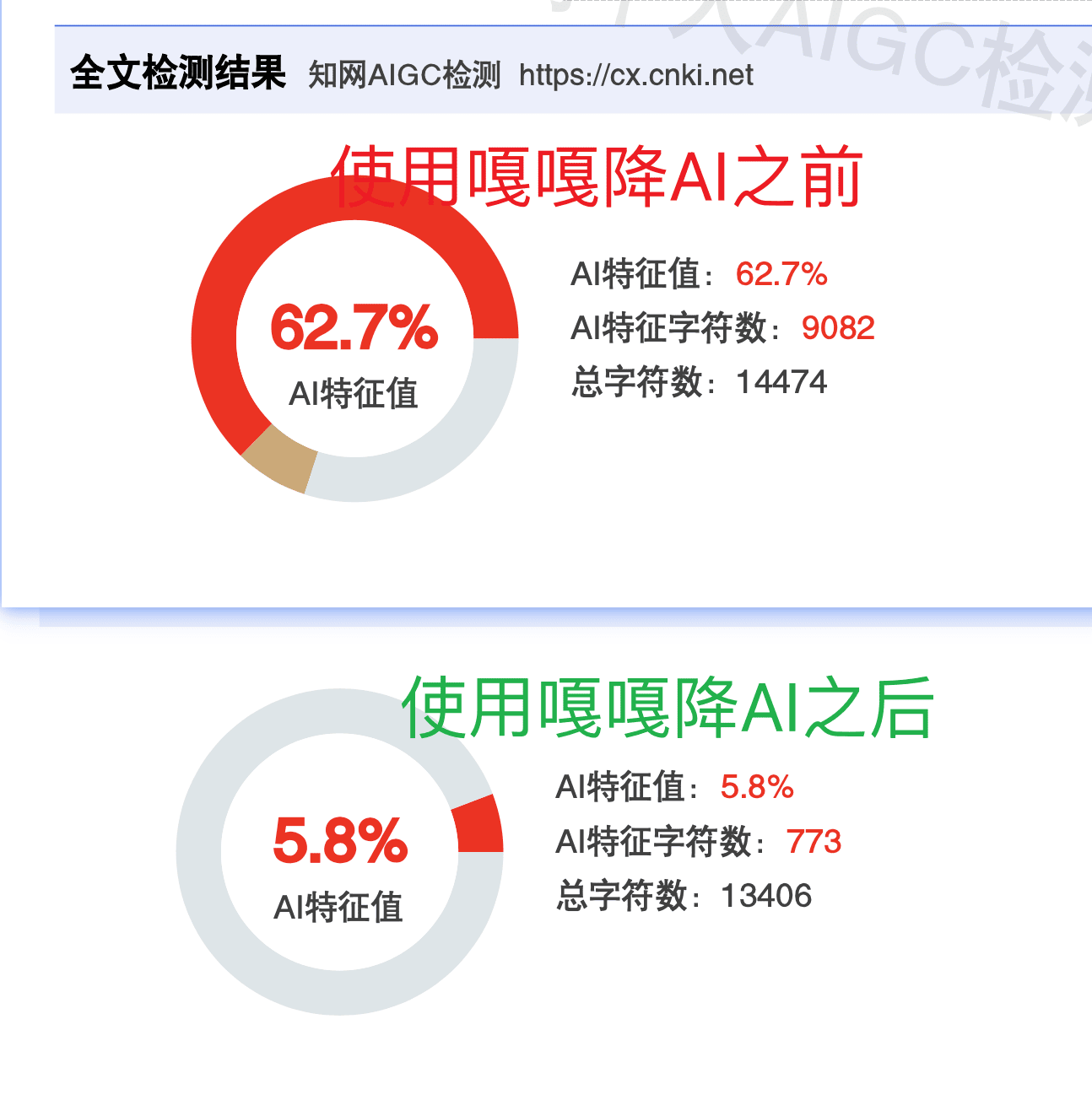

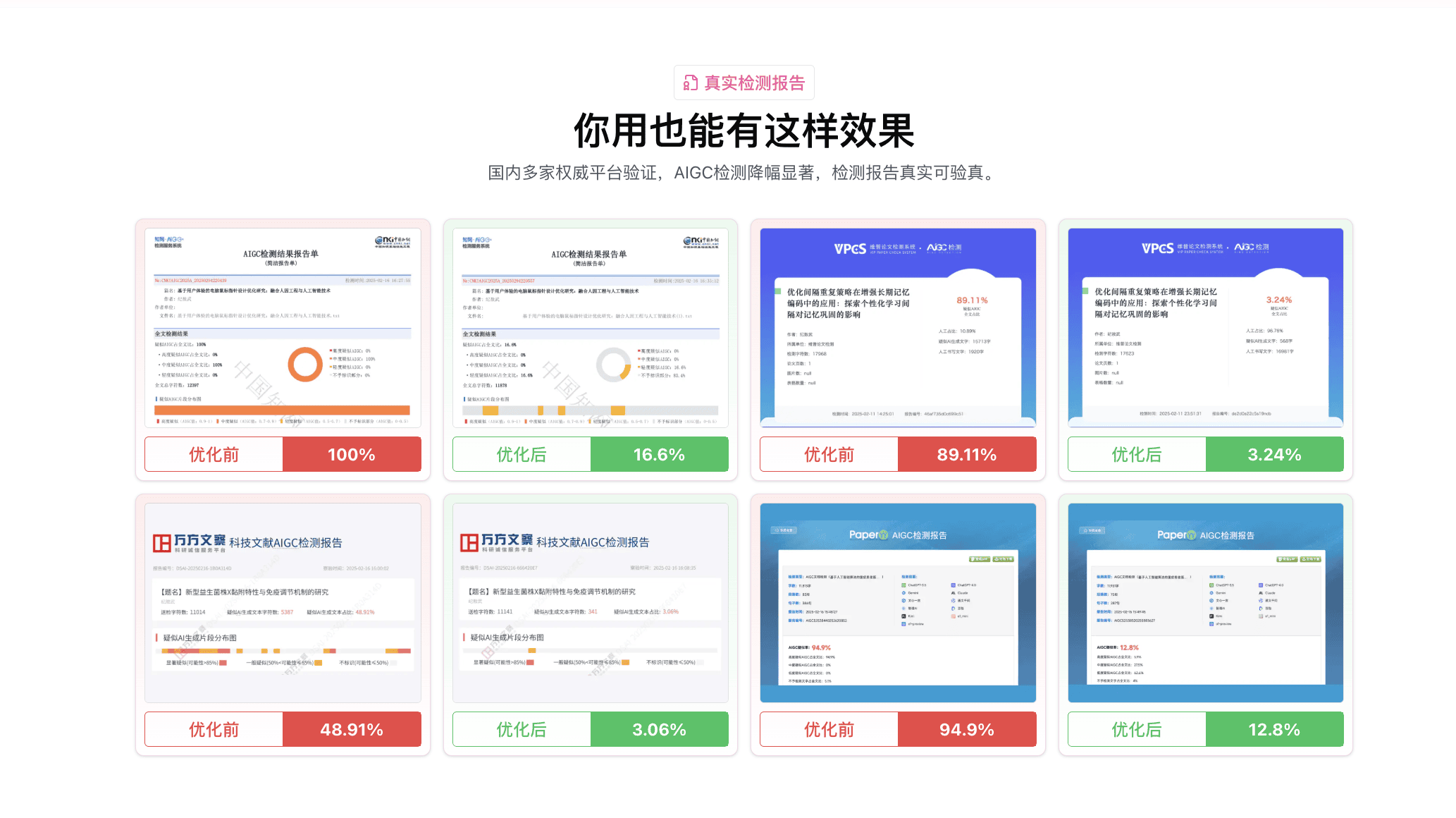

嘎嘎降AI(www.aigcleaner.com)支持9大检测平台,包括知网、维普、万方、Turnitin等。它的双引擎技术不是针对单一平台优化,而是从句子结构层面改写,所以在不同平台都能有效。

我实测的结果:

| 平台 | 处理前 | 处理后 |

|---|---|---|

| 知网 | 95% | 8% |

| 维普 | 87% | 11% |

| 万方 | 82% | 9% |

三个平台都达标了,没有翻车。

如果你学校只用知网,而且要求特别严格(AI率<15%),可以考虑比话降AI(www.bihuapass.com),它专门针对知网优化,效果最好。但如果不确定学校用什么平台,或者要投多个期刊,还是选嘎嘎降AI更保险。

处理前先确认这两件事

第一,确认学校用的检测平台。 问导师或教务处,不要自己猜。大多数985/211用知网,部分学校用维普或万方,留学生论文多用Turnitin。

第二,用学校指定的平台检测一次。 不要用其他免费平台的结果来判断。免费平台的算法和主流平台差异很大,可能在免费平台是40%,在知网只有20%。

总结:降AI失败的最大原因是没搞清楚检测平台的差异。知网、维普、万方算法完全不同,同一篇论文结果可能差10-20个百分点。选工具之前先确认学校用什么平台,或者直接用支持多平台的嘎嘎降AI,避免翻车。

相关工具链接:

- 嘎嘎降AI:www.aigcleaner.com

- 比话降AI:www.bihuapass.com

浙公网安备 33010602011771号

浙公网安备 33010602011771号