知网vs维普AIGC检测:同一篇论文结果差多少?

同一篇论文,知网检测15%,维普检测42%。

我当时看到结果直接懵了。差了快30个百分点,这到底该信哪个?

后来我把这篇论文又测了万方,结果是28%。三个平台,三个完全不同的数字。

这篇文章就来聊聊知网和维普AIGC检测到底差在哪,帮你搞清楚应该怎么选、怎么应对。

实测数据:同一篇论文差多少?

我拿我们实验室5篇论文做了测试,结果如下:

| 论文 | 知网AI率 | 维普AI率 | 差值 |

|---|---|---|---|

| 论文A | 15% | 42% | +27% |

| 论文B | 8% | 31% | +23% |

| 论文C | 22% | 38% | +16% |

| 论文D | 35% | 52% | +17% |

| 论文E | 12% | 29% | +17% |

平均下来,维普比知网高了约20个百分点。

这个差距不是个例。我在网上看到有同学反馈知网0%、维普46%的极端案例。也有反过来的情况,但总体上维普检测结果偏高的情况更常见。

为什么差这么多?

两个平台的检测算法完全不同。

知网的检测逻辑

知网用的是"知识增强AIGC检测技术",从语言模式和语义逻辑两条链路检测。

简单说,知网重点看的是你的逻辑惯性。如果你的论文论证过程太"丝滑",逻辑链条太完整,就容易被判定为AI生成。

知网对规范性学术表达的容忍度相对较高。你用学术写作的套路,比如"研究表明""结果显示"这些表述,知网不太敏感。

维普的检测逻辑

维普用的是"传统NLP+机器学习"的方式,重点检测句式工整度。

维普会统计你文章的词汇多样性(Type-Token Ratio),如果词汇太重复、太单一,就会被标记。它还维护了一个AI句式模板库,比如"首先...其次...最后"这种结构,一旦匹配到太多模板就会报警。

所以如果你的论文结构很工整、用了很多连接词,维普就容易给高分。

结果稳定性对比

还有一个问题:同一篇论文连续检测两次,结果可能不一样。

我试过同一篇论文间隔一天检测两次:

| 平台 | 第一次 | 第二次 | 波动 |

|---|---|---|---|

| 知网 | 15% | 17% | +2% |

| 维普 | 42% | 38% | -4% |

知网的波动范围大概在2%-5%,维普的波动范围大概在3%-8%。

这说明维普的结果稳定性略差一些。建议在正式提交前多检测几次,不要只看一次结果就下结论。

哪个更严格?

从数据上看,维普明显更严格。但"严格"不等于"准确"。

维普对句式结构敏感,但对语义理解较浅。有些明明是人写的内容,只是因为用了常见的表达模板,就被判定为AI生成。

知网的检测更偏向语义层面,会考虑上下文的逻辑关系,相对来说误判率更低。

但这不是绝对的。两个平台各有各的算法特点,没有哪个一定更"对"。关键是看你学校要求用哪个平台,以那个为准。

应该用哪个平台检测?

一个原则:学校要求用哪个,就以哪个为准。

如果学校没有明确要求,建议两个都测一下。知网过了不代表维普能过,反过来也一样。

我的做法是:先用维普测(因为更严格),如果维普能过,知网基本没问题。

怎么同时应对两个平台?

既然两个平台算法不同,那是不是要针对性地处理两次?

不用那么麻烦。

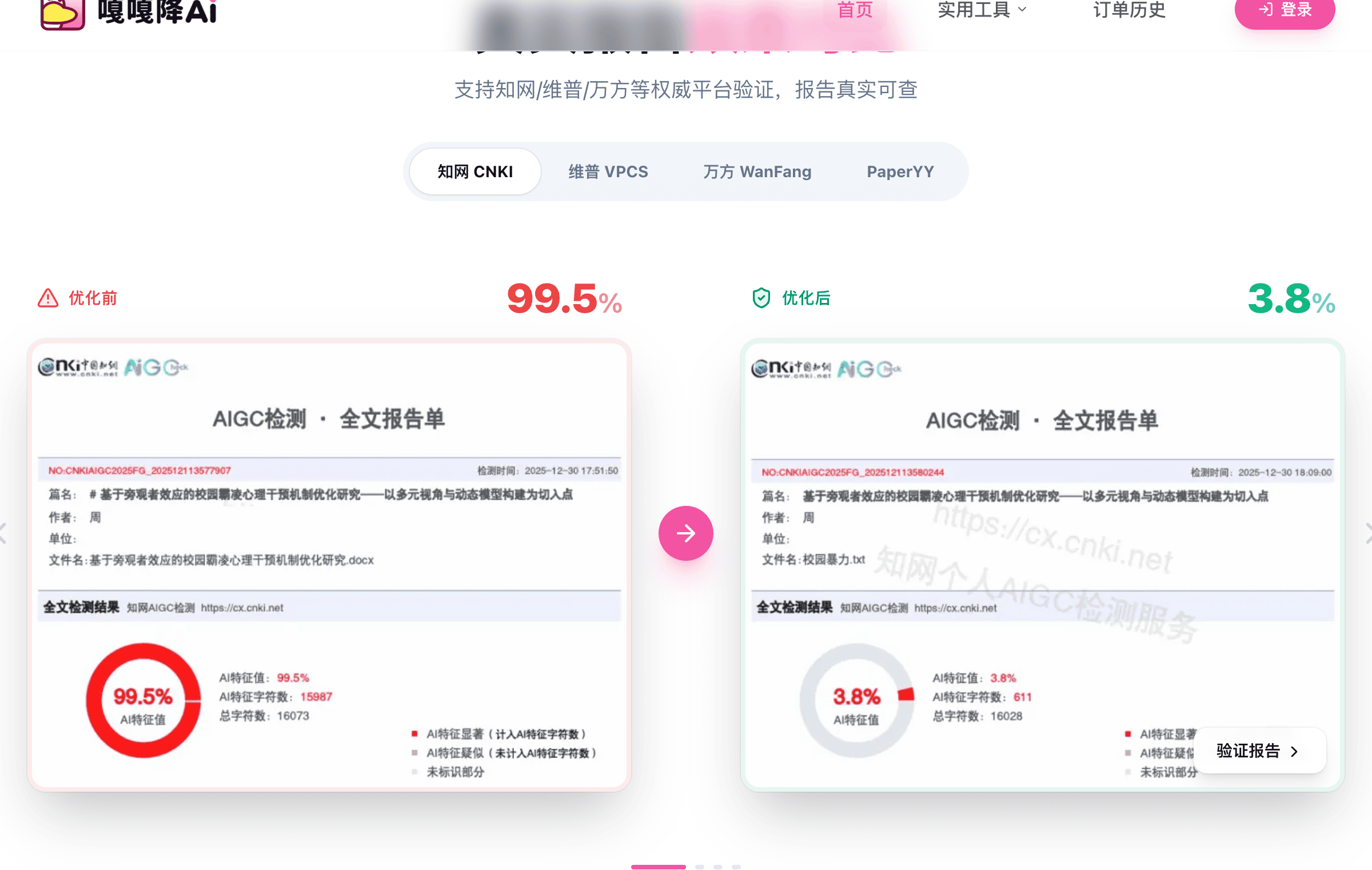

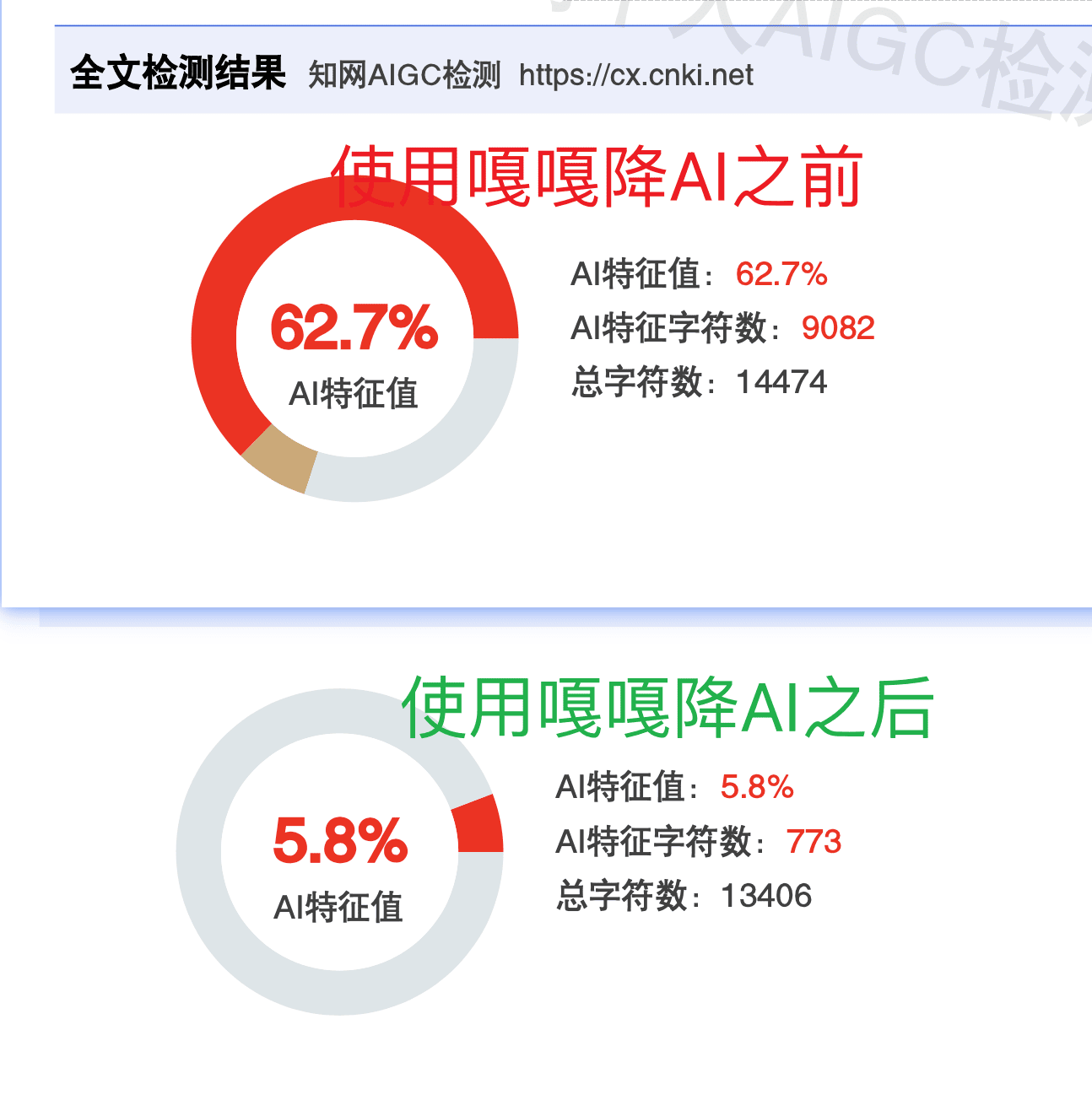

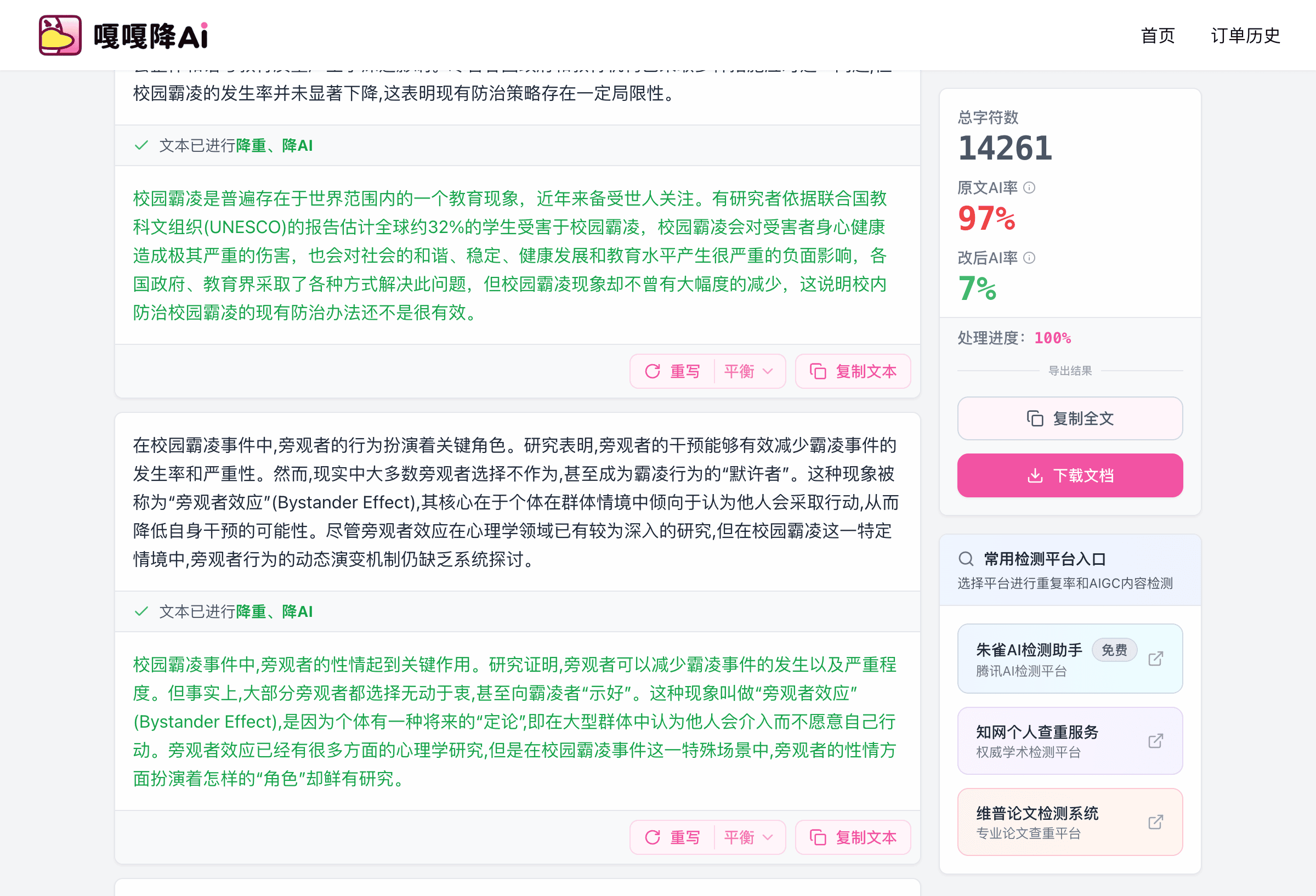

选一个支持多平台的降AI工具就行。比如嘎嘎降AI(www.aigcleaner.com),它会同时适配知网、维普、万方等9个平台的检测算法。处理一次,多个平台都能过。

4.8元/千字,达标率99.26%。我那篇知网15%、维普42%的论文,用它处理之后,知网降到了5%,维普降到了12%,都在安全线以内。

如果你的学校要求特别严格,比如知网必须低于10%,可以用比话降AI(www.bihuapass.com)。8元/千字,承诺知网AI率降不到15%以下就全额退款。

工具对比

| 工具 | 价格 | 支持平台 | 特点 | 链接 |

|---|---|---|---|---|

| 嘎嘎降AI | 4.8元/千字 | 知网/维普/万方等9个 | 多平台适配、性价比高 | www.aigcleaner.com |

| 比话降AI | 8元/千字 | 知网优化 | 不达标退款、效果最稳 | www.bihuapass.com |

常见问题

知网和维普结果差很多,应该信哪个?

信学校要求的那个。如果学校没说,建议以更严格的(通常是维普)为参考,确保两边都能过。

为什么我自己写的论文维普AI率也很高?

因为维普对句式结构敏感。如果你用了很多"首先""其次""最后"这种连接词,或者段落结构很工整,就容易被误判。可以适当打乱一下结构,减少连接词使用。

用了降AI工具,两个平台结果还是差很多怎么办?

正常的。工具只能把AI率降下来,不能让两个平台结果完全一致(因为算法不同)。只要两边都在安全线以内就行。

多测几次结果不一样正常吗?

正常。平台算法在持续更新,结果有小幅波动。建议多测几次取平均值,不要只看一次。

工具链接汇总:

- 嘎嘎降AI:https://www.aigcleaner.com

- 比话降AI:https://www.bihuapass.com/

浙公网安备 33010602011771号

浙公网安备 33010602011771号