Second-order Attention Network for Single Image Super-Resolution【阅读笔记】

Second-order Attention Network for Single Image Super-Resolution

论文地址 [http://www4.comp.polyu.edu.hk/~cslzhang/paper/CVPR19-SAN.pdf]

问题提出

1)很多网络倾向于设计更深或者更宽的网络,而忽略了feature map的内部相关性

2)很多网络不能很好地利用初始LR图像中的信息,导致相对较低的performance。

3)一阶统计信息不能很好的支持网络的判别能力,有研究显示在深度网络中二阶信息比一阶信息更有用。

4)很多网络的non-local操作作用于整张图像,增加计算负担。

解决办法

为了解决这个问题,在本文中,我们提出了一个二级注意网络(SAN),用于更强大的特征表达和特征相关学习。

1.具体而言,开发了一种新颖的可训练二阶通道注意SOCA模块,以通过使用二阶特征统计量来自适应地重新缩放通道方式的特征,以进行更具判别性的表示

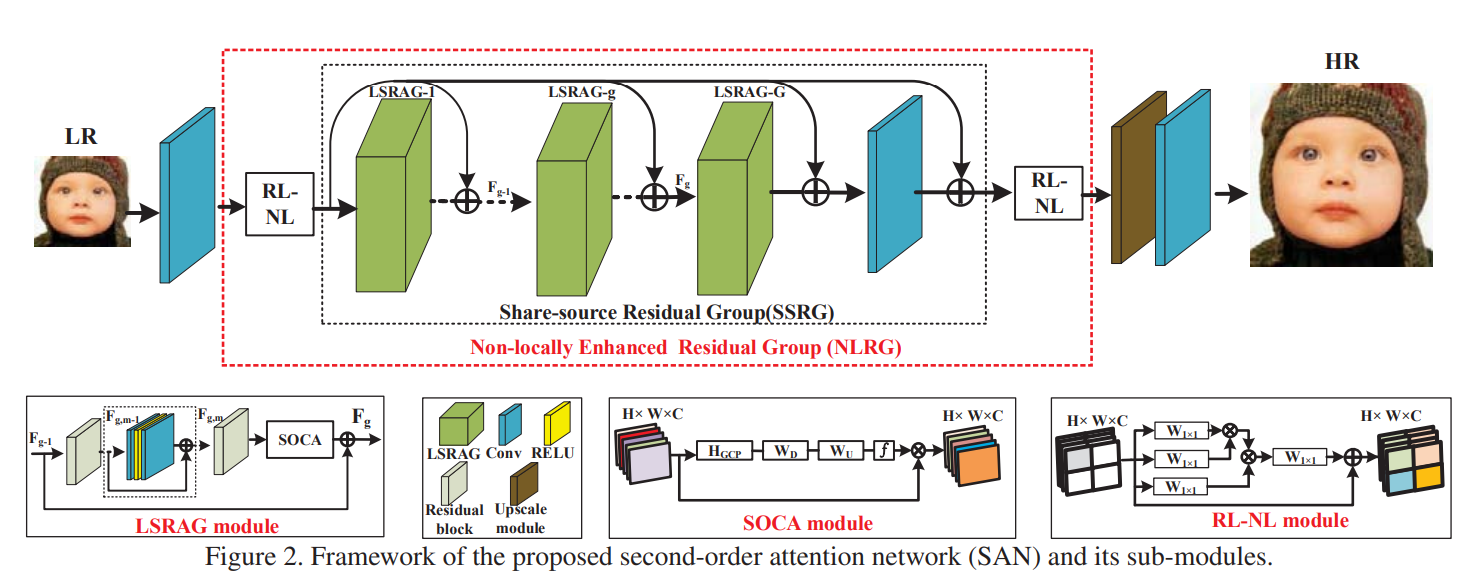

2.此外,还提出了一种非局部增强残差组(NLRG)结构,该结构不仅合并了非局部操作以捕获远程空间上下文信息,而且还包含重复的局部来源残差注意组(LSRAG)以学习越来越多的抽象特征表示。

总之,就是SAN是又SOCA(二阶通道注意力)和NLRG(非局部增强残差组),LSRAG(局部源残差注意组)构成。

介绍

基于插值的方法,基于模型的方法,基于学习的方法,前两种存在的问题:(1)这种方法通常涉及耗时的优化过程; (2)当图像统计信息与先验图像有偏差时,性能可能会迅速下降。

基于深度学习的方法,存在的问题:1)大多数基于CNN的SR方法没有充分利用原始LR图像中的信息,从而导致性能相对较低;

2)大多数现有的基于CNN的SR模型主要集中在设计更深或更广的网络以学习更多判别性高级特征,而很少利用中间层的固有特征相关性,从而阻碍了CNN的表示能力。

主要贡献:

1) 我们提出了一个深二阶注意力网络(SAN),以实现准确的图像SR。在公共数据集上进行的大量实验证明,无论是在定量还是视觉质量上,SAN都比最新技术具有优势。

2) 我们提出了二阶通道注意(SOCA)机制,通过考虑高于一阶的特征统计量来自适应地重新缩放特征。这种SOCA机制使我们的网络可以专注于更多的信息功能并增强判别性学习能力。此外,我们还利用协方差归一化的迭代方法来加快网络的训练速度。

3) 我们提出非局部增强残差组(NLRG)结构来构建深度网络,该网络将进一步结合非本地操作以捕获空间上下文信息,并共享源残差组结构以学习深度特征。此外,通过共享源跳过连接的共享源残差组结构可以允许绕过来自LR输入的更多信息,并简化对深层网络的训练。

相关工作

基于CNN的方法:最近,由于其强大的非线性表示能力,基于CNN的方法已在图像SR中得到了广泛研究。通常,此类方法将SR转换为图像到图像的回归问题,并直接学习从LR到HR的端到端映射。现有的大多数基于CNN的方法主要集中在设计更深或更宽的网络结构上[2,12,13,6,6,39,38]。例如,Dong等。 [2]首先介绍了用于图像SR的浅层三层卷积网络(SRCNN),该算法实现了令人印象深刻的性能。后来,金等。根据残差学习设计了超过16层的更深的VDSR [12]和DRCN [13]。为了进一步提高性能,Lim等人。 [20]通过堆叠修改后的残差块,提出了一种非常深入和广泛的网络EDSR。性能的显着提高表明表示深度在图像SR中起着关键作用。 MemNet [30]和RDN [39]等其他最近的工作都基于密集块[10]来形成深层网络,并专注于利用来自所有卷积层的所有分层功能。除了专注于增加网络深度之外,其他一些网络,例如NLRN [22]和RCAN [38],还通过考虑空间或通道维度中的特征相关性来提高性能。

注意机制。对人类感知的关注通常意味着人类视觉系统会自适应地处理视觉信息并关注显着区域[16]。近年来,一些试验已嵌入注意处理,以提高CNN在各种任务(例如图像和视频分类任务)中的性能[9,33]。Wang等。 [33]提出了非本地神经网络,将非本地操作纳入视频分类中的空间注意力。相反,胡等。 [9]提出SENet利用通道间关系来实现图像分类的显着性能提升。

最近,SENet被引入到深层的CNN中,以进一步提高SR性能[38]。但是,SENet仅探索一阶统计信息(例如,全局平均池),而忽略了高于一阶的统计信息,因此阻碍了网络的判别能力。具有更多高频信息的功能对于HR重建更具参考价值。为此,我们通过研究特征的二阶统计量提出了一个深层的二阶注意力网络(SAN)。

网络结构

主要包含四个部分:浅层特征提取,基于非局部增强残差组(NLRG)的深度特征提取,上采样模块和重建模块

Non-locally Enhanced Residual Group 基于非局部残差组的深度特征提取

NLRG是用来进行深层特征提取的。它由两部分组成,分别是(1)区域级别的非局部组件(region-level non-local(RL-NL)modules)和(2)资源共享残差组(share-source residual group(SSRG)structure)。RL-NL位于NLRG的开头和结尾,主要作用是更好地利用LR特征中的上下文信息和HR特征中的自相似性。SSRG位于NLRG的中间,主要作用是提取更好的feature map。

位于中间部分的SSRG组件由G个带有share-source skip connection(SSC)的资源共享残差注意力组(local-source residual attention groups,LSRAG)构成。这里的“共享”体现在:所有的skip connection都来自于相同的input,即SSRG组件的input。共享跳跃连接的目的不仅在于更好地训练深度网络,还能更好地传递LR图像中的低频信息,让网络更集中注意力去学习高频信息。每个LSRAG由M个简单的残差块(residual blocks)和一条局部跳跃连接组成,并以二阶通道注意力(second-order channel attention,SOCA)组件结尾。SOCA的目的是利用二阶梯度统计来自适应的调整不同通道feature map的权重。

协方差归一化:

位于LSRAG结尾的SOCA是本文的亮点和重点所在。由于一阶统计信息阻碍了网络的判别能力,并且有研究显示在深度网络中二阶信息比一阶信息更有用,所以文章采用二阶通道注意力,这是和以往通道注意力不同的地方。文中先计算了feature maps的协方差矩阵,然后将协方差矩阵进行特征值分解,最后将协方差归一化,转化为特征值的1/2次幂。这样便得到了归一化的协方差矩阵,这个归一化的协方差矩阵就代表了不同通道特征的相关性。最后将归一化的协方差矩阵的每层进行全局平均池化操作,得到每层的channel descriptor。得到每层的channel descriptor后,再进行的操作就跟之前的注意力网络一样了,即先通过gating function得到最终的权重,再乘上SOCA组件input时的feature map,得到最后加权的feature maps。这里的通道注意力跟以往不同的是,它利用了feature map各元素的协相关信息。以往的通道注意力都是将每层feature map的所有值相加再求平均,作为这一层feature map的代表。此外,由于GPU不能很好的支持特征值分解,文中使用了加速的迭代方法获得归一化的矩阵,具体还需要看代码。

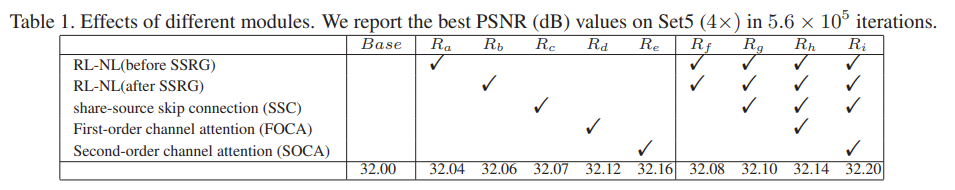

Ablation Study

浙公网安备 33010602011771号

浙公网安备 33010602011771号