比较LLM的function calling,Agent 和MCP

比较

| 对比维度 | MCP(Model Context Protocol) | Function Calling | Agent(智能体) |

|---|---|---|---|

| 定义 | 由 Anthropic 推出的开放协议,标准化 LLM 与外部数据源、工具的通信接口

|

LLM 调用外部函数的机制,通过 JSON 参数规范模型与外部系统的交互

|

自主运行的智能系统,通过分析、决策和执行实现目标,可调用工具和规划任务

|

| 核心功能 | - 提供标准化工具调用接口 - 动态上下文管理 - 跨平台/多数据源集成 |

- 单次函数调用 - 参数解析与执行 - 轻量化任务扩展 |

- 多步骤任务规划 - 自主决策与反思 - 多工具协作 |

| 技术特点 | - 客户端-服务器架构(Host/Client/Server) - 支持 REST/gRPC 通信 - 工具描述与权限控制 |

- 基于 JSON Schema 定义函数参数 - 依赖 LLM 生成调用指令 - 需手动实现执行逻辑 |

- 结合 RAG、ReAct 等框架 - 长期记忆与状态管理 - 多模态交互能力 |

| 典型应用场景 | - 跨平台工具集成(如同时访问本地文件 + Jira API) - 敏感数据隔离(医疗/金融场景) |

- 简单功能扩展(如天气查询、计算器) - 封闭环境应用(内部知识库) |

- 复杂任务自动化(代码生成、数据分析) - 拟人化交互(客服、教育辅导) |

| 优点 | - 标准化协议,降低集成成本 - 支持动态上下文切换 - 多厂商 LLM 兼容 |

- 开发简单快速 - 轻量级交互 - 深度绑定特定 LLM(如 GPT-4) |

- 高度自主性 - 复杂任务处理能力 - 可扩展性强 |

| 局限性 | - 架构复杂,部署成本高 - 依赖协议生态成熟度 |

- 功能单一 - 缺乏动态上下文管理 - 跨平台适配性差 |

- 资源消耗大 - 多步推理可能出错 - 工具调用依赖外部系统稳定性 |

补充说明:

-

MCP 与 Function Calling 的关系

MCP 可视为 Function Calling 的扩展协议,通过标准化接口解耦工具调用与具体 LLM,解决跨平台和动态上下文问题 -

实现逻辑

- MCP:采用客户端-服务器架构,通过MCP Server统一管理工具调用和数据访问,LLM只需遵循协议发送请求,无需关注底层实现细节

。 - Function Calling:要求开发者预先定义函数签名,LLM直接生成调用指令,应用负责执行。这种方式与特定模型强绑定,扩展性受限

- MCP:采用客户端-服务器架构,通过MCP Server统一管理工具调用和数据访问,LLM只需遵循协议发送请求,无需关注底层实现细节

-

技术关系

- 互补性:MCP协议可以封装Function Calling作为其底层执行方式之一,但并非必须依赖

。

示例:MCP Server通过Python脚本调用OpenAI的Function Calling接口,但其他工具可能直接操作本地资源。 - 独立性:实验表明,即使LLM不支持Function Calling(如DeepSeek Re),也能通过MCP实现工具调用

,说明二者在技术实现上解耦。

4. 选择建议

- 优先MCP:需集成多数据源、跨平台协作或长期维护的场景(如企业级Agent开发)

。 - 优先Function Calling:轻量级、单任务且对延迟敏感的场景(如实时翻译)

- 互补性:MCP协议可以封装Function Calling作为其底层执行方式之一,但并非必须依赖

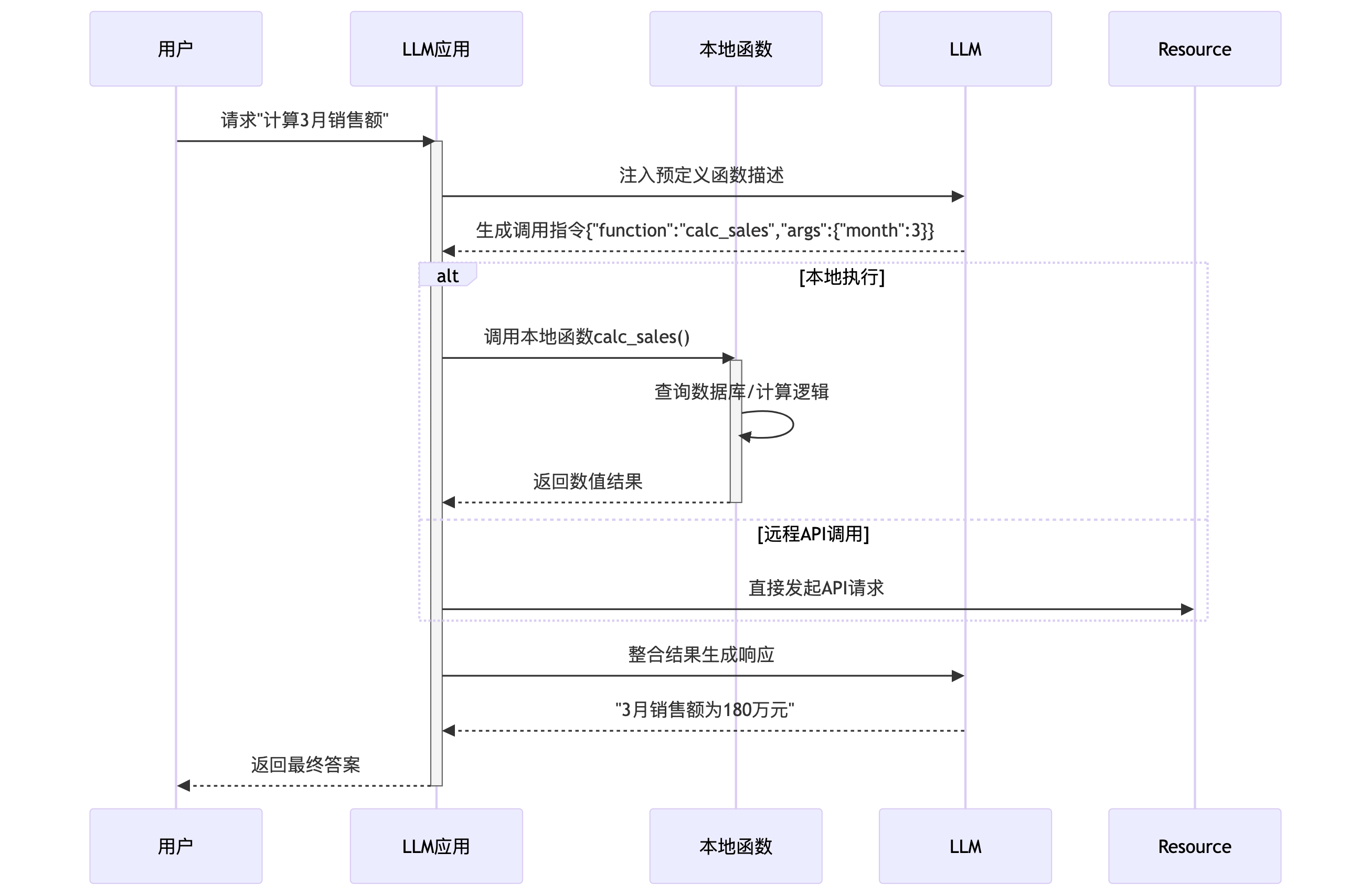

functioncalling的执行过程

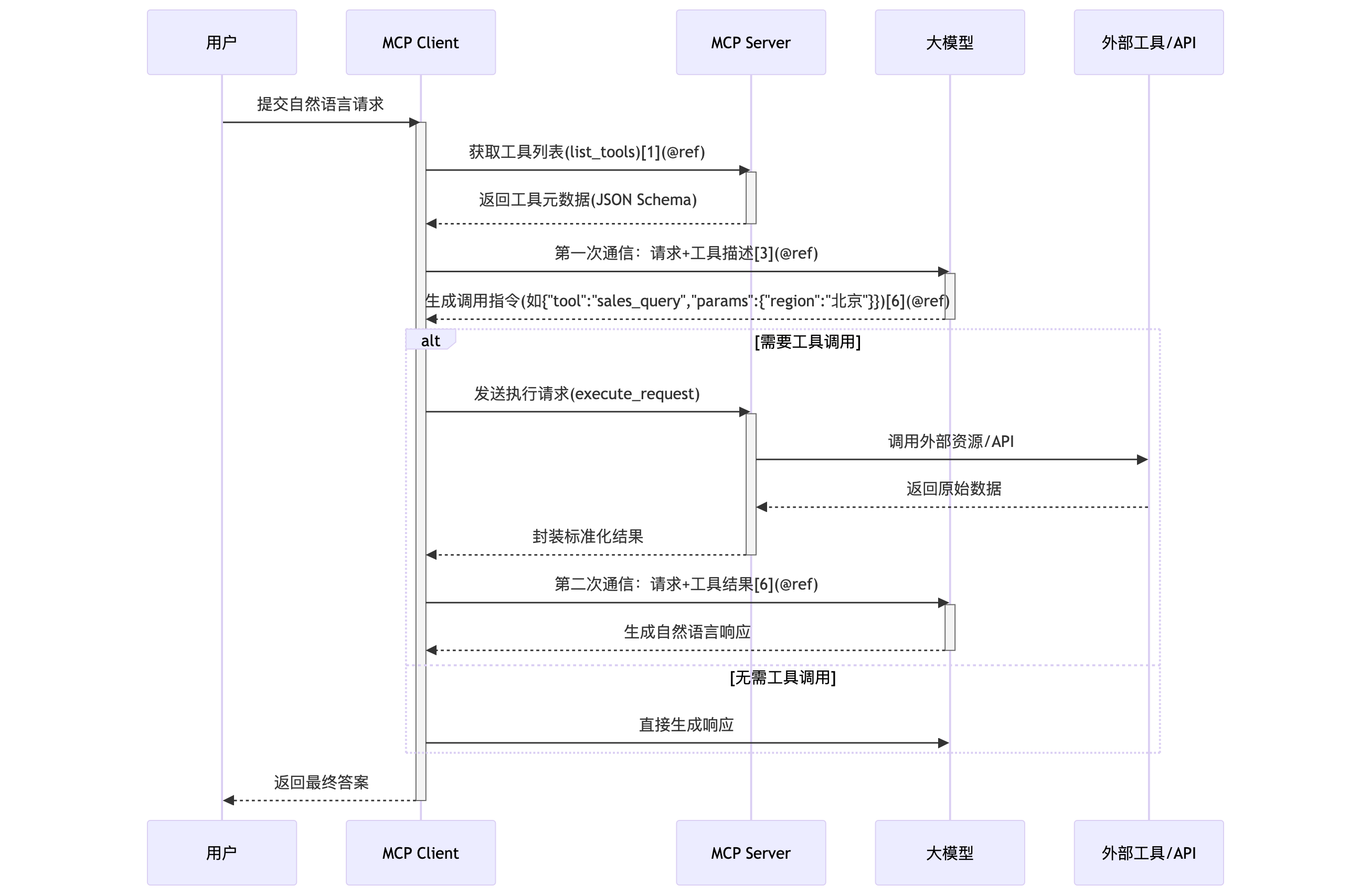

MCP 的执行过程

MCP

关键设计特性

-

动态工具发现

MCP Client在每次会话前自动获取最新工具列表,无需预先硬编码函数签名(对比传统Function Calling) -

权限隔离机制

- 敏感工具调用需用户二次确认(如文件删除操作)

- 本地资源访问限制在沙箱环境(如仅允许

/data/sales目录)

- 敏感工具调用需用户二次确认(如文件删除操作)

浙公网安备 33010602011771号

浙公网安备 33010602011771号