Hadoop集群肯定还是要在linux下使用好些,但是对于想尝鲜的开发者或者上层应用开发来说,在windows下搭建一个单节点的应用也是蛮有必要的,当然只作为开发测试环境^_^。

一、环境准备

1、JDK安装

2、Hadoop安装包(官网下载)

3、hadooponwindows-master(可使配置更简洁)

二、安装配置

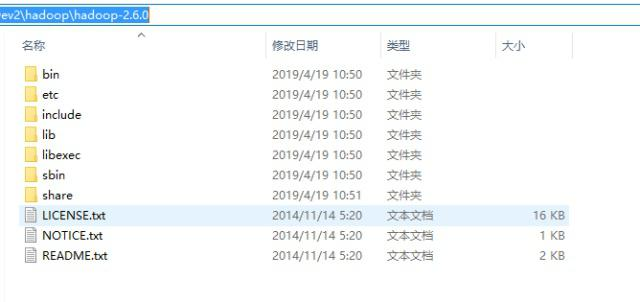

1、以管理员身份解压Hadoop安装包,

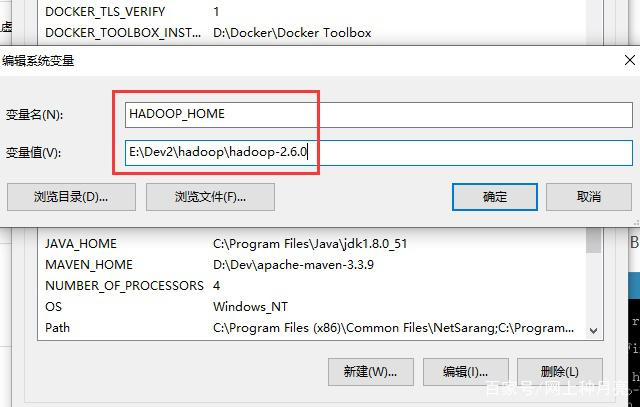

2、配置Hadoop环境变量,

我的电脑 --> 属性 --> 高级系统设置 --> 高级 --> 环境变量,新建HADOOP_HOME,然后将%HADOOP_HOME%\bin添加到Path中。

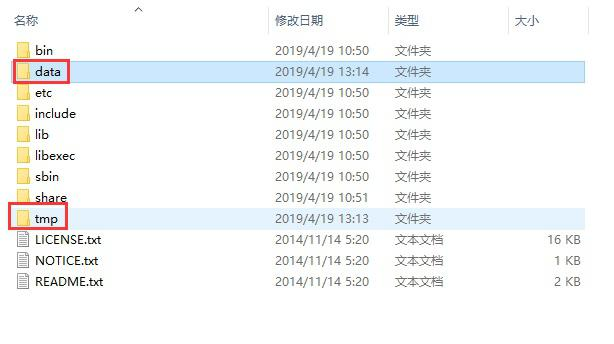

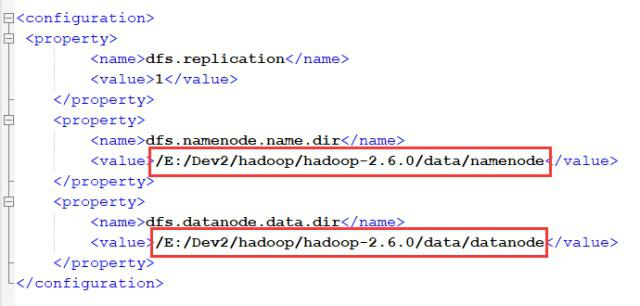

3、新建data(下面建俩子文件夹namenode和datanode)和tmp目录,

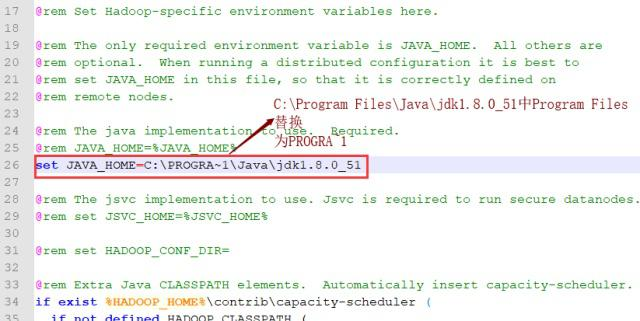

4、修改启动类 hadoop-env.cmd,

主要是设置JAVA_HOME的路径,我的文件目录在 E:\Dev2\hadoop\hadoop-2.6.0\etc\hadoop,(这里注意一下:如果jdk路径中有“Program Files”,则将Program Files改为 PROGRA~1,否则会报错)

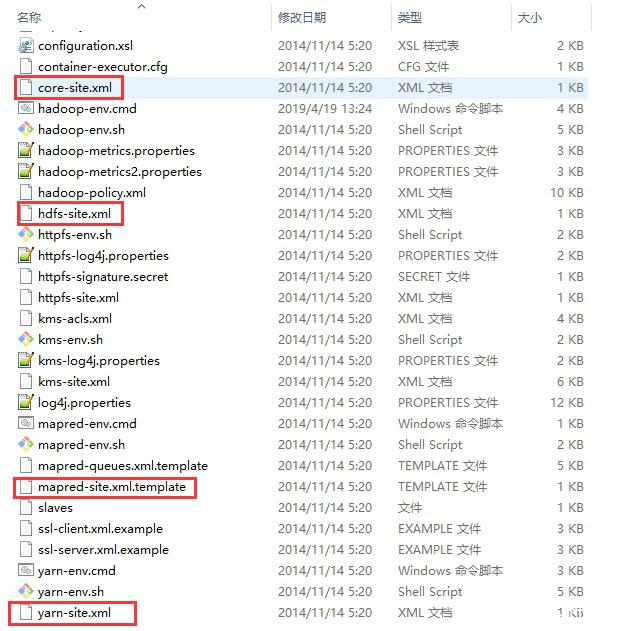

5、修改配置文件(core-site.xml,hdfs-site.xml,mapred-site.xml,yarn-site.xml)

核心操作就在这四个配置文件上面了,(如果下载了hadooponwindows-master,解压后可以直接覆盖bin和etc目录,然后只修改这四个文件夹中的路径信息就可以了)

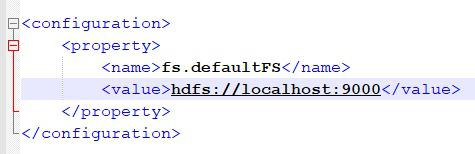

(1)core-site.xml

(2)hdfs-site.xml

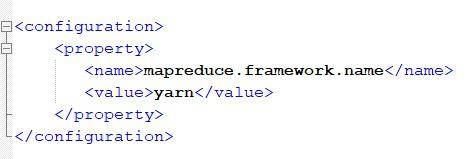

(3)mapred-site.xml

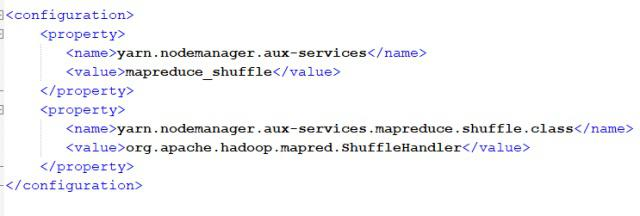

(4)yarn-site.xml

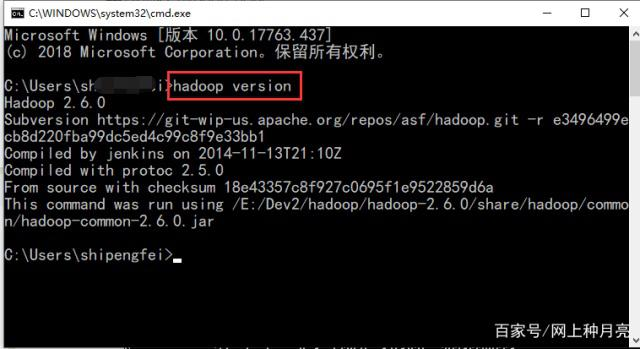

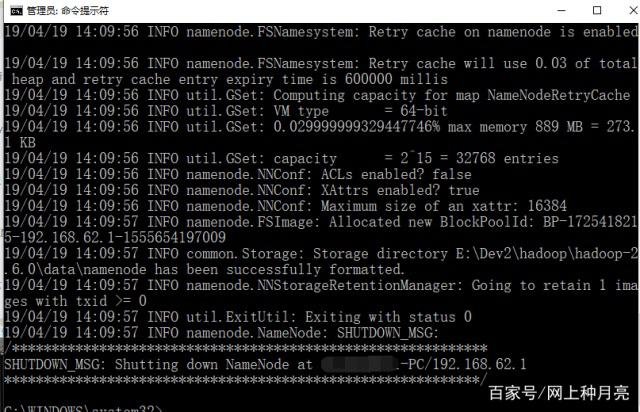

6、启动格式化HDFS

首先,hadoop version,查看是否能正常运行,

然后,执行 hdfs namenode -format

格式化之后,namenode文件里会生成一个current文件,则格式化成功。

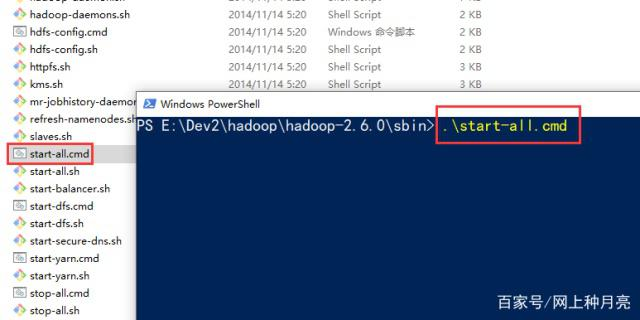

三、Hadoop启动

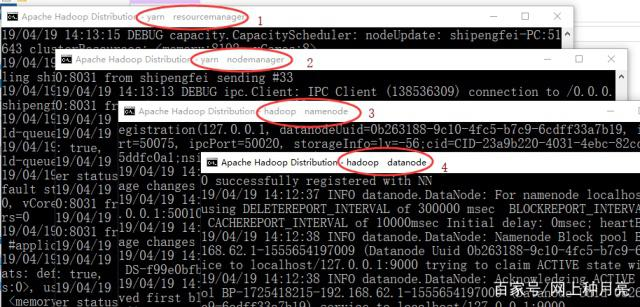

在cmd中执行 start-all.cmd 命令,启动Hadoop,路径:E:\Dev2\hadoop\hadoop-2.6.0\sbin。

运行成功后,会出现四个窗口,分别是:yarn-resourcemanager、yarn-nodemanager、hadoop-namenode、hadoop-datanode。

如上,则恭喜,启动成功。

四、HDFS操作测试

安装好了Hadoop环境,接下来我们就敲下hadoop命令,上传几个文件操作实战一下。

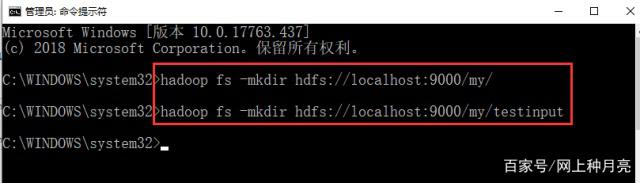

1、创建目录

hadoop fs -mkdir hdfs://localhost:9000/my/

hadoop fs -mkdir hdfs://localhost:9000/my/testinput

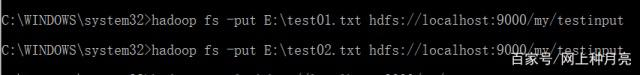

2、上传文件

hadoop fs -put E:\test01.txt hdfs://localhost:9000/my/testinput

hadoop fs -put E:\test02.txt hdfs://localhost:9000/my/testinput

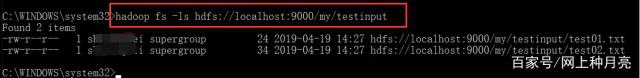

3、查询文件

hadoop fs -ls hdfs://localhost:9000/my/testinput

查询到我们刚刚上传的文件啦,恭喜,测试成功。

五、管理页面

Hadoop自带了web UI管理页面,

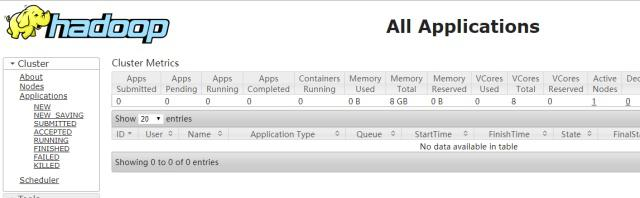

1、资源管理(localhost:8088)

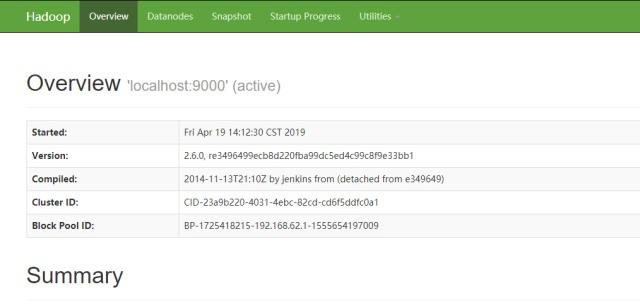

2、节点管理(localhost:50070)

总体来说Hadoop在windows下的安装还是比较简单的,只要按部就班就可以了。

转载于:https://baijiahao.baidu.com/s?id=1631225218387105313&wfr=spider&for=pc

浙公网安备 33010602011771号

浙公网安备 33010602011771号