Transformers系列学习【chart 0】hugging face使用

Transformers系列学习【chart 0 】hugging face使用

1 hugging face模型下载

1.1通用步骤

-

登录你的

hugging face账号 -

找到你需要下载的模型【我这里以

openai/gpt-oss-120b为例】 -

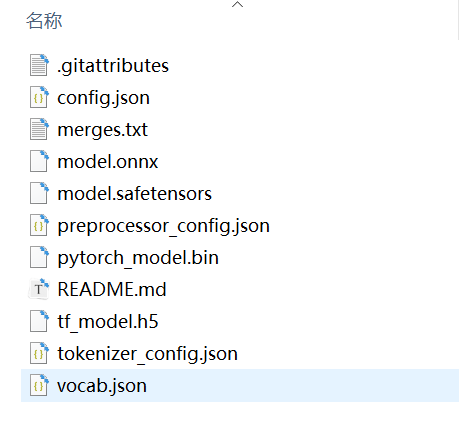

点击“文件及版本”,选择你需要的版本【这里以默认为例】

![image-20250827230800841]()

-

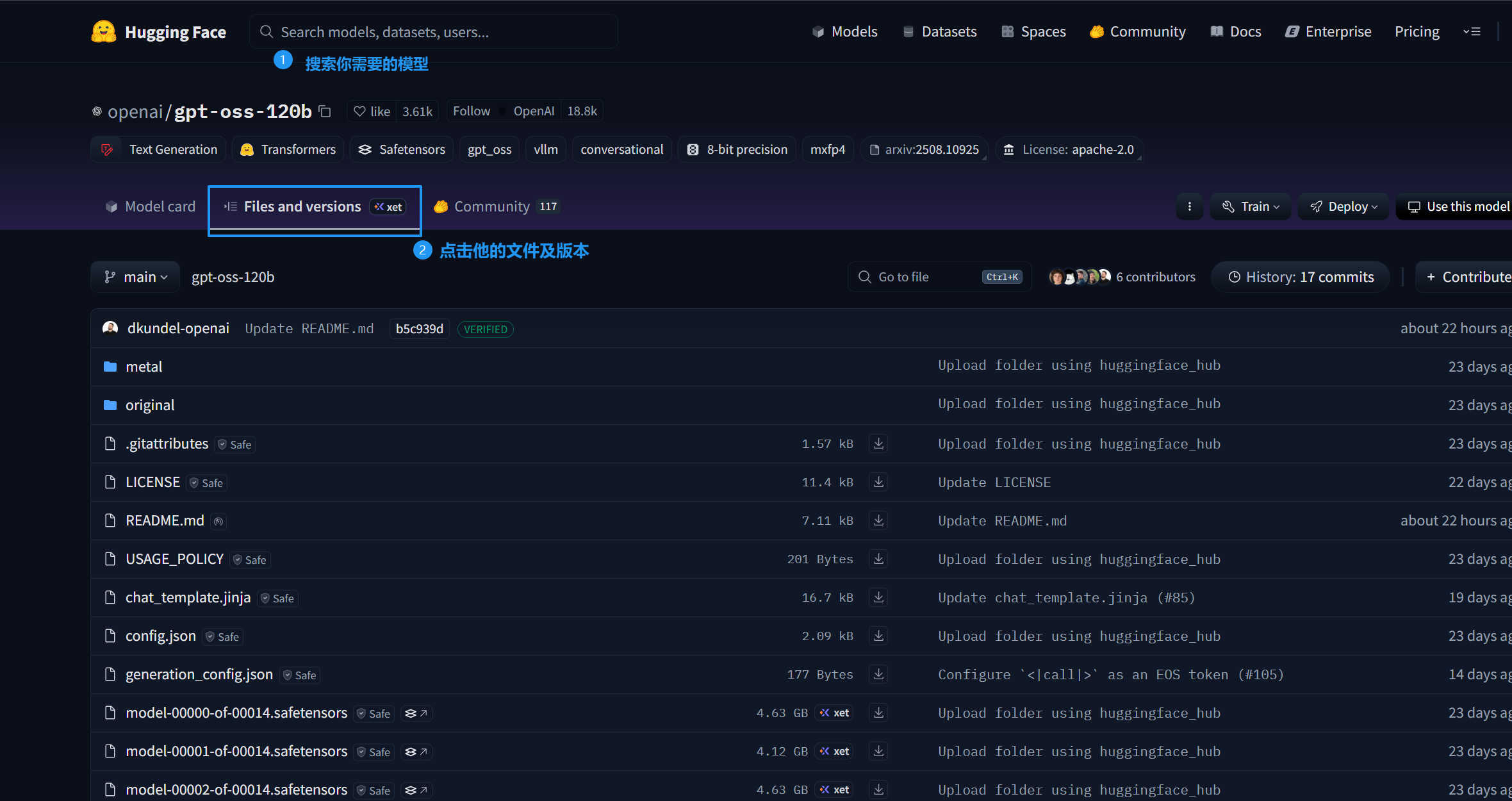

点击克隆仓库

![image-20250827231048570]()

-

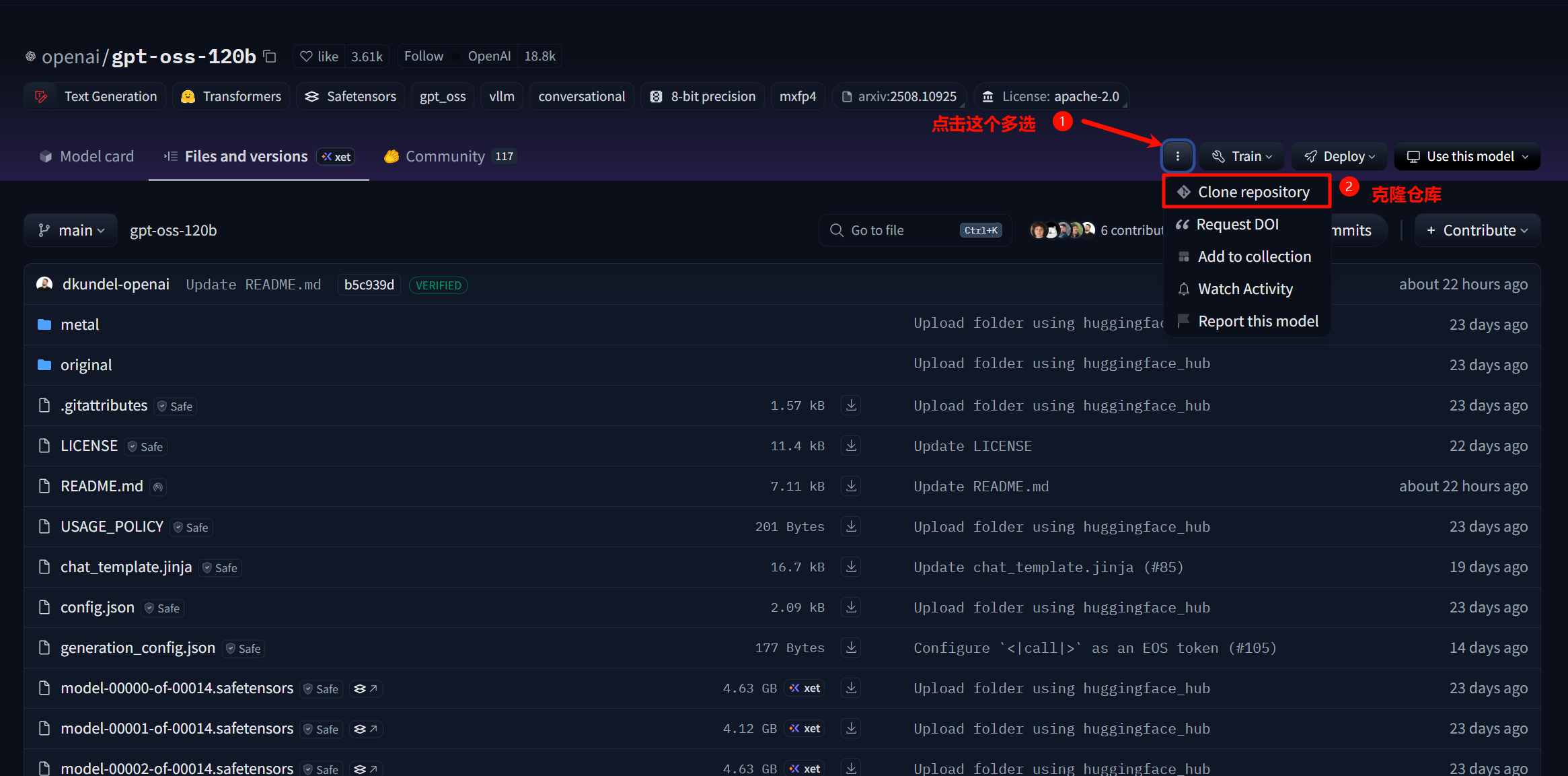

查看可选克隆方式:

![image-20250827231339129]()

在克隆方式上,你能看到有两种方式可以提供克隆,一个是透过git,一个是通过命令(

CLI)来下载,我们接下来说明这两个下载方式:

1.2 【方法一】使用命令行下载(CIL)(推荐)

-

进入你的python虚拟环境(推荐)没有的话直接用本地环境也行

-

安装

hf依赖pip install -U "huggingface_hub[cli]"![PixPin_2025-09-07_20-26-11]()

-

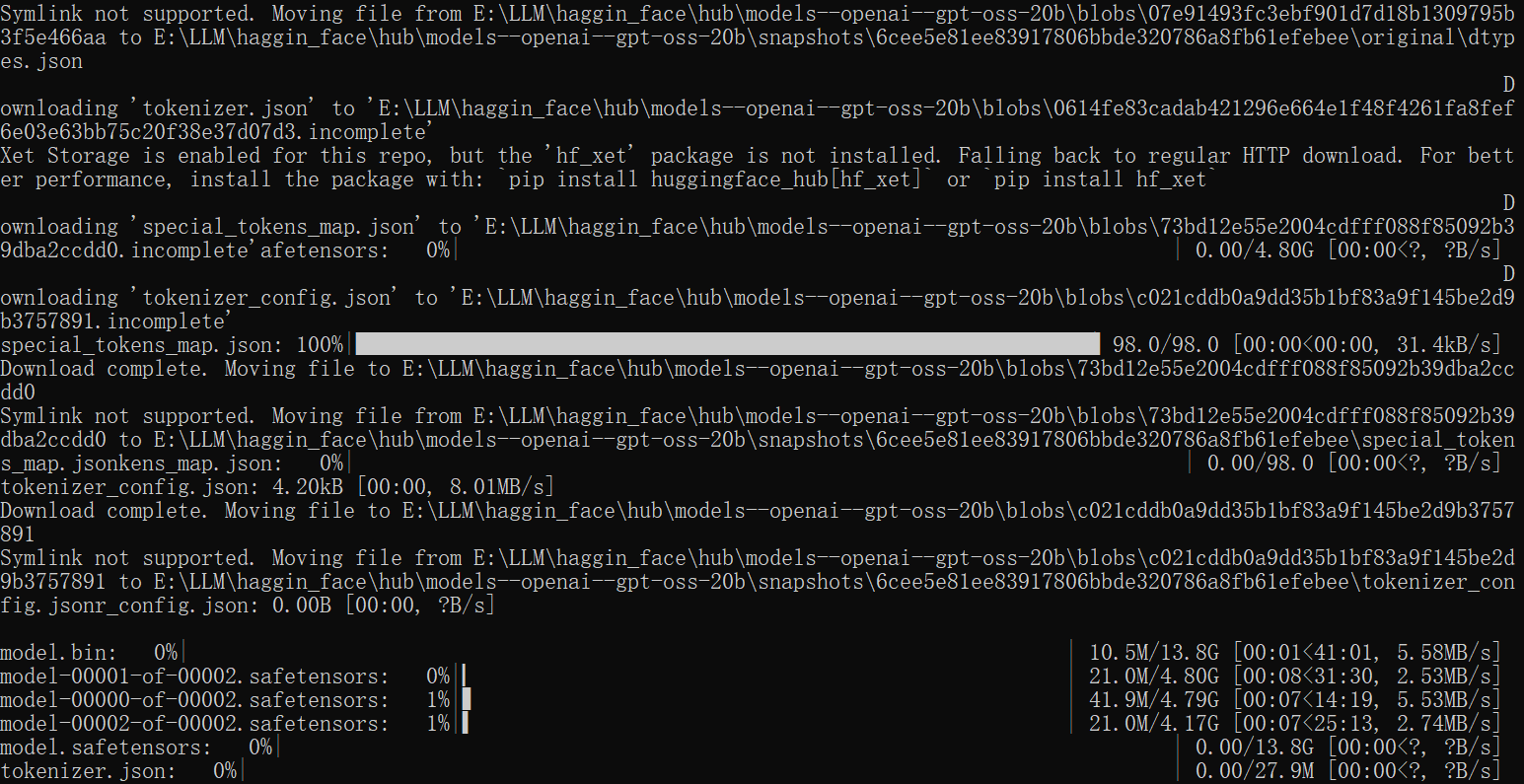

复制下载连接即可,非常快【基本取决于你的带宽】

![image-20250907204909090]()

然后根据下载的信息去hub文件夹查找下载的文件就好了,这样子就能离线部署了。

1.3 【方法二】 使用git命令克隆

-

下载git【有则跳过】

- 参考这个博客 Git 详细安装教程

- 或者直接根据提示下载 git-lfs官网

-

根据命令直接下载就好【但是网速较差】

1.4 部分模型的参考使用方式

由于hg-face上涉及到众多模型,具体见你选定的模型的示例代码,然后将AutoProcessor.from_pretrained 的导入选择从本地文件夹导入。

注意,模型路径 一般来说 是模型的文件夹路径,里面包含模型的所有文件:

from transformers import AutoProcessor, AutoModel

from datasets import load_dataset

model_dir_path = r'E:\modules\xxx' #YOUR MODEL PATH

processor = AutoProcessor.from_pretrained(model_dir_path, apply_ocr=False)

model = AutoModel.from_pretrained(model_dir_path)

dataset = load_dataset("data/xxx", split="train") #OFFICAL CODE

example = dataset[0]

image = example["image"]

words = example["tokens"]

boxes = example["bboxes"]

encoding = processor(image, words, boxes=boxes, return_tensors="pt")

outputs = model(**encoding)

last_hidden_states = outputs.last_hidden_state

浙公网安备 33010602011771号

浙公网安备 33010602011771号