ELK 教程 - 高效发现、分析和可视化你的数据

【注】本文译自:https://www.edureka.co/blog/elk-stack-tutorial/

随着越来越多的 IT 基础设施转身云计算,对公共云安全工具和日志分析平台的需求也在迅速增加。不管组织的规模有多大,每天都会生成大量的数据。这些数据中有相当一部分是由公司的 Web 服务器日志组成的。日志是最重要的信息来源之一, 但往往被忽视。每个日志文件都包含一些宝贵的信息,这些信息大多是非结构化的,没有任何意义。如果不对此日志数据进行详尽的分析,那么企业可能会忽视其周围的机会和威胁。这是日志分析工具非常有用的地方。ELK Stack 或 Elastic Stack 是完整的日志分析解决方案,它有助于深入搜索、分析和可视化不同机器生成的日志。通过本教程,我将为您提供相关见解。

首先,让我们列出要讨论的主题:

- 什么是 ELK Stack?

- ELK Stack 架构

- ELK Stack 安装

- Elasticsearch 教程

- Logstash 教程

- Kibana 教程

本教程将帮助您一起理解 Elasticsearch、Logstash 和 Kibana 的基础知识,并帮助您在 ELK Stack 中打下坚实的基础。

首先让我们来了解什么是 ELK Stack。

什么是 ELK Stack?

众所周知的 ELK Stack 最近被更名为 Elastic Stack。它是三个开源工具的强大集合:Elasticsearch、Logstash 和 Kibana。

这三种不同的产品最常一起用于不同 IT 环境中的日志分析。使用 ELK Stack,您可以执行集中式日志记录,这有助于识别 Web 服务器或应用程序的问题。它使您可以在一个地方搜索所有日志,并通过在特定时间范围内关联多个服务器的日志来识别跨多个服务器的问题。

现在让我们详细讨论这些工具。

Logstash

Logstash 是数据收集管道工具。它是 ELK Stack 的第一个组件,它收集数据输入并将其输入到 Elasticsearch。它可以一次从不同来源收集各种类型的数据,并立即提供以备将来使用。

Logstash 是数据收集管道工具。它是 ELK Stack 的第一个组件,它收集数据输入并将其输入到 Elasticsearch。它可以一次从不同来源收集各种类型的数据,并立即提供以备将来使用。

Elasticsearch

Elasticsearch 是基于 Lucene 搜索引擎的 NoSQL 数据库,并使用 RESTful API 构建。它是一个高度灵活的分布式搜索和分析引擎。此外,它通过水平可伸缩性提供了简单的部署、最大的可靠性和易于管理的功能。它提供高级查询以执行详细分析,并集中存储所有数据以快速搜索文档。

Elasticsearch 是基于 Lucene 搜索引擎的 NoSQL 数据库,并使用 RESTful API 构建。它是一个高度灵活的分布式搜索和分析引擎。此外,它通过水平可伸缩性提供了简单的部署、最大的可靠性和易于管理的功能。它提供高级查询以执行详细分析,并集中存储所有数据以快速搜索文档。

Kibana

Kibana 是一种数据可视化工具。它用于可视化 Elasticsearch 文档,并帮助开发人员立即对其进行深入了解。Kibana 仪表板提供了各种交互式图表、地理空间数据、时间线和图表,以可视化使用 Elasticsearch 完成的复杂查询。使用 Kibana,您可以根据自己的特定需求创建和保存自定义图形。

Kibana 是一种数据可视化工具。它用于可视化 Elasticsearch 文档,并帮助开发人员立即对其进行深入了解。Kibana 仪表板提供了各种交互式图表、地理空间数据、时间线和图表,以可视化使用 Elasticsearch 完成的复杂查询。使用 Kibana,您可以根据自己的特定需求创建和保存自定义图形。

下一部分将讨论 ELK Stack 架构以及其中的数据流向。

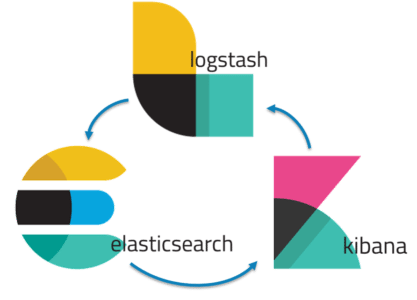

ELK Stack 架构

以下是 ELK Stack 的架构,显示了 ELK 中日志流的正确顺序。在此,Logstash 会根据提供的过滤条件来收集和处理从各种来源生成的日志。然后,Logstash 将这些日志通过管道传输到 Elasticsearch,然后 Elasticsearch 分析和搜索数据。最后,使用 Kibana,可以根据要求对日志进行可视化和管理。

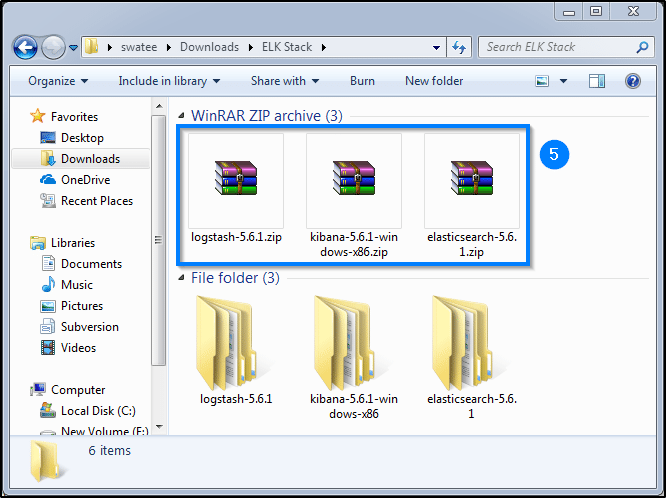

ELK Stack 安装

第 I 步:打开 https://www.elastic.co/downloads。

第 II 步:选择并下载 Elasticsearch。

第 III 步:选择并下载 Kibana。

第 IV 步:选择并下载 Logstash。

第 V 步:解压缩所有三个文件以获取对应文件夹的文件。

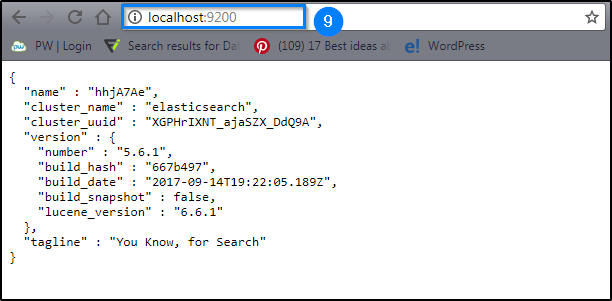

安装 Elasticsearch

第 VI 步:现在打开 elasticsearch 文件夹并转到 bin 文件夹。

第 VII 步:双击 elasticsearch.bat 文件以启动 elasticsearch 服务器。

第 VIII 步:等待 elasticsearch 服务器启动。

第 IX 步:要检查服务器是否已启动,请转到浏览器并键入 localhost:9200。

安装 Kibana

第 X 步:现在打开 kibana 文件夹 并转到 bin 文件夹。

第 XI 步:双击 kibana.bat 文件以启动 kibana 服务器。

第 XII 步:等待 kibana 服务器启动。

第 XIII 步:要检查服务器是否已启动,请转到浏览器并键入 localhost:5601。

安装 Logstash

第 XIV 步:现在打开 logstash 文件夹。

第 XV 步:要测试您的 logstash 安装,请打开命令提示符,然后转到 logstash 文件夹。现在输入:

binlogstash -e 'input { stdin { } } output { stdout {} }'

第 XVI 步:等待,直到命令提示符上显示“ Pipeline main started”出现在命令提示符下。

第 XVII 步:现在,在命令提示符下输入一条消息,然后按 Enter 键。

第 XVIII 步:Logstash 将时间戳和 IP 地址信息附加到消息中,并将其显示在命令提示符下。

既然我们完成了安装,那么现在让我们更深入地研究这些工具。让我们从 Elasticsearch 开始。

Elasticsearch

如前所述,Elasticsearch 是一个高度可扩展的搜索引擎,它运行在基于 Java 的 Lucene 引擎之上。它基本上是一个 NoSQL 数据库。这意味着它将以非结构化格式存储数据,并且无法对任何类型的交易执行 SQL 查询。换句话说,它将数据存储在文档中,而不是表和模式中。为了获得更好的图像,请检查下表,该表显示了与数据库相比在 Elasticsearch 中的内容。

现在让我们熟悉 Elasticsearch 的基本概念。

使用Elasticsearch时,需要遵循三个主要步骤:

- 索引

- 映射

- 搜索

让我们一个一个详细地谈谈。

索引

索引编制是添加数据 Elasticsearch 的过程。之所以称为“索引”,是因为将数据输入到 Elasticsearch 中后,它将被放入 Apache Lucene 索引中。然后,Elasticsearch 使用这些 Lucene 索引来存储和检索数据。索引编制与 CRUD 操作的创建和更新过程相似。 索引方案由 名称/类型/id 组成,其中名称和类型是必填字段。 如果您不提供任何 ID,Elasticsearch 将自己提供一个 ID。 然后,将整个查询附加到 HTTP PUT 请求中,最终 URL 如下:PUT name/type/id 与 HTTP 有效负载一起,还将发送包含字段和值的 JSON 文档。

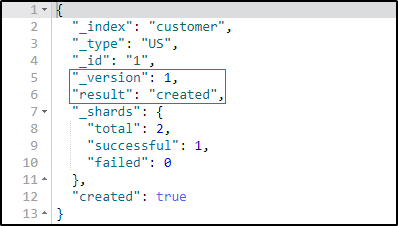

以下是创建一个美国客户的文档的示例,该文档及其字段中的详细信息。

PUT /customer/US/1

{

"ID": 101,

"FName": "James",

"LName": "Butt",

"Email": "jbutt@gmail.com",

"City": "New Orleans",

"Type": "VIP"

}

它会给你以下输出:

这里显示文档已创建并添加到索引中。

现在,如果您尝试在不更改标识的情况下更改字段详细信息,Elasticsearch 将使用当前详细信息覆盖现有文档。

PUT /customer/US/1

{

"ID": 101,

"FName": "James",

"LName": "Butt",

"Email": "jbutt@yahoo.com",

"City": "Los Angeles",

"Type": "VVIP"

}

这里显示文档已经更新了索引的新细节。

映射

映射是设置索引模式的过程。通过映射,您可以告诉 Elasticsearch 你的模式中属性的数据类型。如果在预索引时未针对特定对象进行映射,则 Elasticsearch 将动态地将泛型类型添加到该字段。但是这些泛型类型是非常基本的,大多数时候都不能满足查询的期望。

现在让我们尝试映射查询。

PUT /customer/

{

"mappings": {

"US": {

"properties": {

"ID": {

"type": "long"

},

"FName": {

"type": "text"

},

"LName": {

"type": "text"

},

"Email": {

"type": "text"

},

"City": {

"type": "text"

},

"Type": {

"type": "text"

}

}

}

}

}

当您执行查询时,您将获得这种类型的输出。

搜索

具有特定索引和类型的一般搜索查询如下:

POST index/type/_search

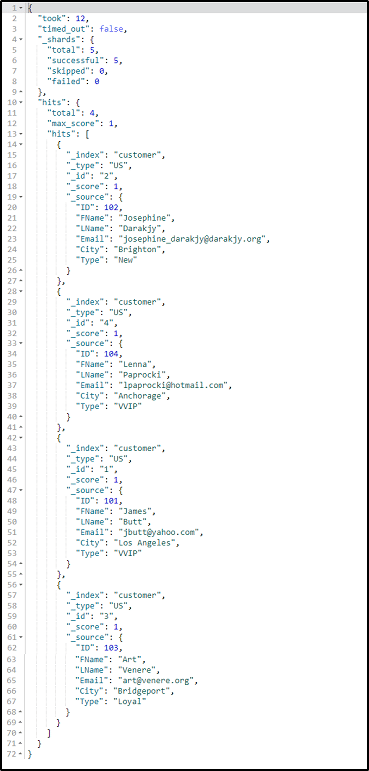

现在,让我们尝试搜索“customer”索引中存在的所有客户的详细信息。

POST /customer/US/_search

当您执行此查询时,将生成以下结果:

但是,当您要搜索特定结果时,Elasticsearch 提供了三种方法:

使用查询

使用查询,您可以搜索一些特定的文档或条目。例如,让我们对属于“ VVIP”类别的客户执行搜索查询。

POST /customer/US/_search

{

"query": {

"match": {

"Type": "VVIP"

}

}

}

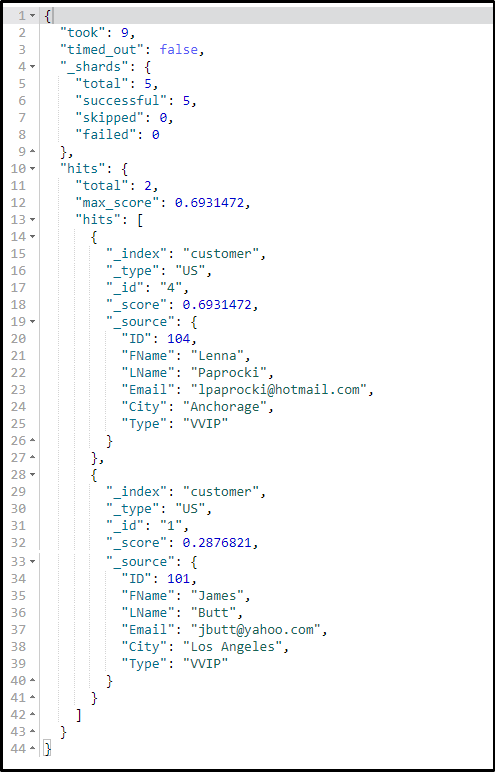

使用过滤器

使用过滤器,您可以进一步缩小搜索范围。以下是搜索 ID 为“ 101”的 VVIP 客户的示例:

POST /customer/_search

{

"query": {

"match": {

"Type": "VVIP"

}

},

"post_filter": {

"match": {

"ID": 101

}

}

}

如果执行此查询,则会得到以下结果:

使用聚合

聚合是一个框架,可帮助通过搜索查询聚合数据。小型聚合可以结合在一起,以构建所提供数据的复杂摘要。让我们执行一个简单的汇总,以检查索引中有多少类型的客户:

POST /customer/_search

{

"size": 0,

"aggs": {

"Cust_Types": {

"terms": {

"field": "Type.keyword"

}

}

}

}

现在让我们看看如何从索引中检索数据集。

获取数据

要检查索引中包含的文档列表,您只需要发送以下格式的 HTTP GET 请求:

GET index/type/id

让我们尝试检索“ id”等于 2 的客户的详细信息:

GET /customer/US/2

成功执行后,它将为您提供以下类型的结果。

使用 Elasticsearch,您不仅可以浏览数据,还可以删除或删除文档。

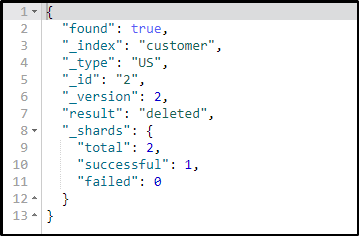

删除数据

使用删除约定,您可以轻松地从索引中删除不需要的数据并释放内存空间。要删除任何文档,您需要以以下格式发送 HTTP DELETE 请求:

DELETE index/type/id.

现在让我们尝试删除 ID 为 2 的客户的详细信息。

DELETE /customer/US/2

执行此查询时,您将获得以下类型的结果。

至此,我们讲解了使用 Elasticsearch 的 CRUD 操作的基础知识,了解这些基本操作将帮助您执行不同类型的搜索。

现在让我们开始学习 ELK Stack 的下一个工具 Logstash。

Logstash

正如我已经讨论的那样,Logstash 是一种管道工具,通常用于收集和转发日志或事件。它是一个开源数据收集引擎,可以动态集成来自各种来源的数据并将其标准化到指定的目标位置。

使用多个输入,过滤器和输出插件,Logstash 可以轻松转换各种事件。至少,Logstash 需要在其配置文件中指定的输入和输出插件来执行转换。以下是 Logstash 配置文件的结构:

input {

...

}

filter {

...

}

output {

...

}

如您所见,整个配置文件分为三个部分,每个部分都包含一个或多个插件的配置选项。这三个部分是:

- input(输入)

- filter (过滤)

- output (输出)

您也可以在配置文件中应用多个过滤器。在这种情况下,其应用程序顺序将与配置文件中的规范顺序相同。

现在,让我们尝试配置 CSV 文件格式的美国客户数据集文件。

file {

path => "E:/ELK/data/US_Customer_List.csv"

start_position => "beginning"

sincedb_path => "/dev/null"

}

}

filter {

csv {

separator => ","

columns => ["Cust_ID", "Cust_Fname", "Cust_Lname", "Cust_Email", "Cust_City", "Cust_Type"]

}

mutate {

convert => ["Cust_ID", "integer"]

}

}

output {

elasticsearch {

hosts => "localhost"

index => "customers"

document_type => "US_Based_Cust"

}

stdout {}

}

要将这个 CSV 文件数据插入 elasticsearch 中,您必须通知 Logstash 服务器。

为此,请执行以下步骤:

- 打开命令提示符

- 进入 Logstash 的 bin 目录

- 输入:logstash –f X:/foldername/config_filename.config 然后按回车。一旦您的 logstash 服务器启动并运行,它将开始将文件中的数据传输到Elasticsearch 中。

![]()

如果要检查是否成功插入了数据,请转到 Sense 插件并键入:GET /customers/

它会为您提供已创建的文档数。

现在,如果要可视化此数据,则必须使用 ELK Stack 的最后一个工具,即Kibana。因此,在本教程的下一部分中,我将讨论 Kibana 及其使用方式,以可视化您的数据。

Kibana

如前所述,Kibana 是一个开源的可视化和分析工具。它有助于可视化 Logstash 管道传输并存储到 Elasticsearch 中的数据。您可以使用 Kibana 来搜索,查看此存储的数据并与之交互,然后在各种图表,表格和地图中对其进行可视化。Kibana 的基于浏览器的界面简化了海量数据并反映了 Elasticsearch 查询中的实时变化。此外,您还可以轻松创建、自定义、保存和共享仪表板。

一旦您了解了如何与 Elasticsearch 和 Logstash 一起使用,学习 Kibana 就不是什么大事了。在本教程的这一部分,我将向您介绍为了对数据进行分析所需的各种功能。

管理页面

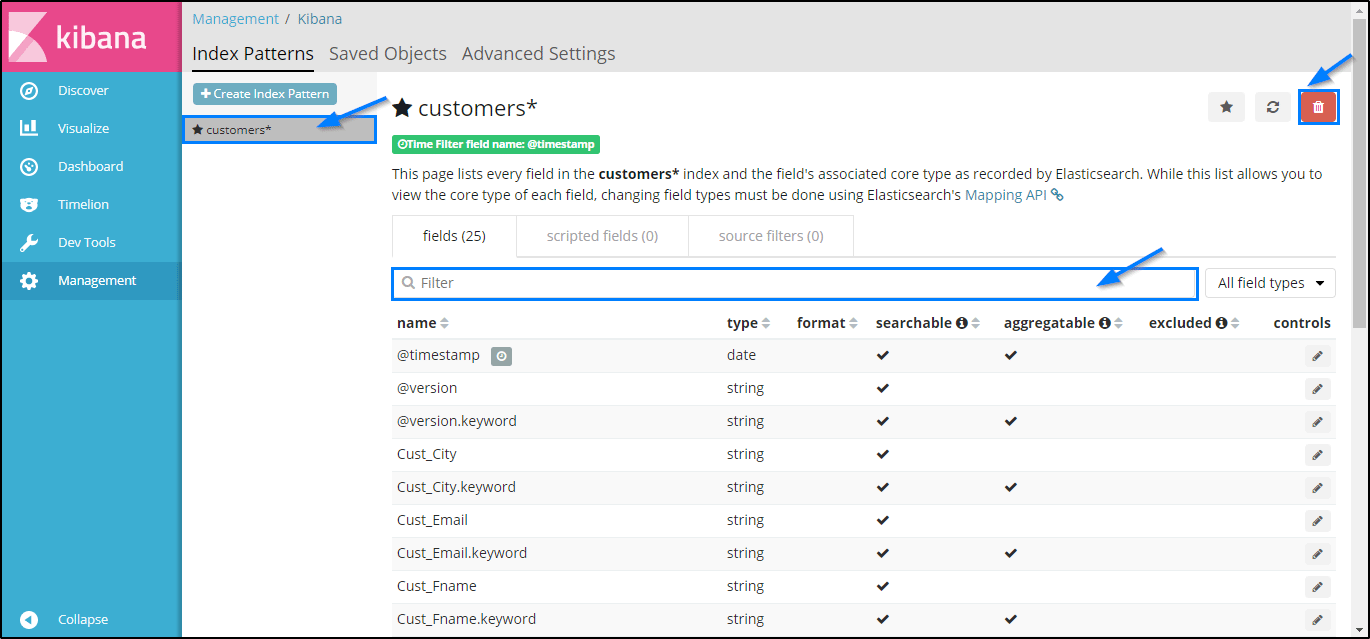

在这里,您必须执行 Kibana 的运行时配置。 在此页面中,您需要指定一些搜索内容。请参见以下示例,在该示例中,我已经配置了“customer”索引的条目。

如您所见,在“索引模式(Index Patterns)”字段中,您需要指定要使用的索引。确保在“时间过滤器字段名称”中将其选择为@timestamp。然后,您可以继续并单击创建以创建索引。如果索引创建成功,您将看到以下页面类型:

在这里,您可以根据需要从下拉列表中选择不同的过滤器。此外,要释放内存,您还可以删除特定的索引。

发现页面

通过“发现”页面,您可以访问存在于每个与所选索引模式匹配的每个索引的文档。 您可以轻松地交互和浏览Kibana服务器上存在的所有数据。 此外,您可以查看文档中存在的数据并对其进行搜索查询。 下面你可以看到,我正在搜索来自“洛杉矶”的“ VIP”客户。

因此,如您所见,我们只有一位来自洛杉矶的VIP客户。

可视化页面

可视化页面使您可以可视化以图表、条形图、饼图等形式显示在 Elasticsearch 索引中的数据。您甚至可以在此处构建仪表板,这些仪表板将基于 Elasticsearch查询显示相关的可视化效果。通常,使用一系列 Elasticsearch 聚合查询来提取和处理数据。当您转到“可视化”页面并搜索保存的可视化时,或者可以创建一个新的可视化。

您可以以任何形式汇总数据。为了方便用户,提供了不同类型的可视化选项。

让我向您展示如何根据用户类型可视化美国客户数据。

要执行可视化,请按照以下步骤操作:

- 选择可视化类型。 [这里我用的是饼图]

- 在汇总字段中,从下拉列表中选择“术语(term)”。

- 在“字段(field)”中,选择要执行搜索的字段类型。

- 您还可以指定可视化的顺序和大小。

- 现在单击执行按钮以生成饼图。

仪表盘页面

“仪表板”页面显示已保存的可视化的集合。在这里,您可以添加新的可视化效果,也可以使用任何保存的可视化效果。

Timelion 页面

Timelion 是一个时间序列数据可视化工具,它将完全独立的数据源整合到一个界面中。 它由一种单行表达语言驱动,可用于检索时间序列数据,执行计算以简化复杂问题并可视化结果。

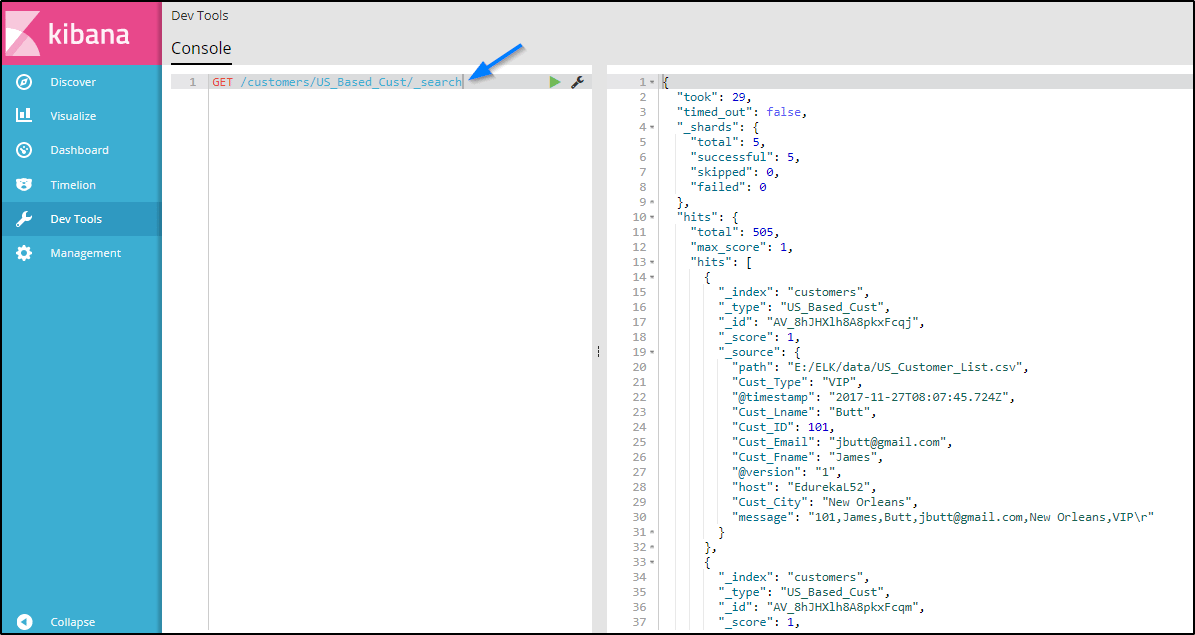

开发工具页面

Kibana 的“开发工具”页面包含诸如“ Beta Sense”插件之类的开发工具,可用于与 Elasticsearch 中存在的数据进行交互。它通常被称为 Kibana 的控制台。以下是一个示例,其中我使用了 Kibana 的 Sense 插件来搜索类型为“ US_based_cust”的“客户(customers)”索引:

本文到此结束。现在,您可以使用 Logstash、Elasticsearch 和 Kibana 对任何数据执行各种搜索和分析。

浙公网安备 33010602011771号

浙公网安备 33010602011771号