14年的RCNN主要是一个观点:迁移学习

分析的原文

用来做目标检测和语义分割的神经网络。

观点:缺乏大量的标注数据时(maybe数据库小),比较好的可行的手段是,进行神经网络的迁移学习,采用在其他大型数据集训练过后的神经网络,然后在小规模特定的数据集中进行 fine-tune 微调。

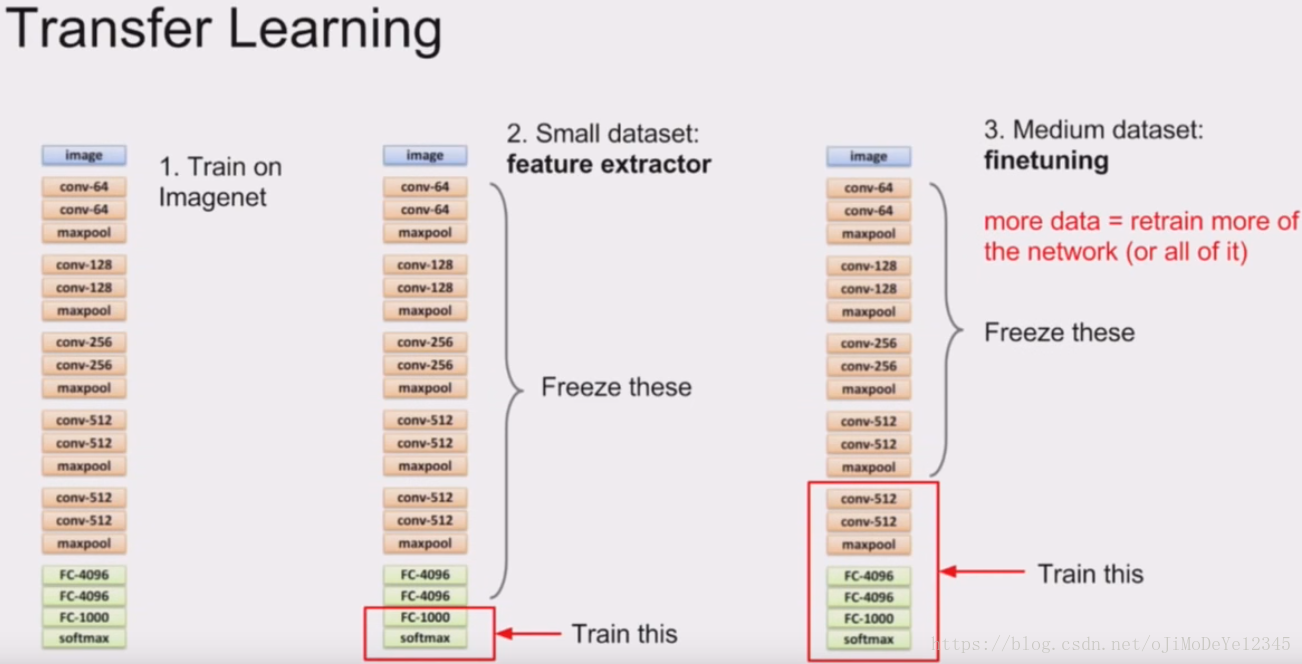

迁移学习:将一个问题A(有好多数据量)上训练好的模型通过简单的调整使其适应一个新的问题B(数据量小)

调整的过程:可以选择保留前几层卷积层的权重,以保留低级特征的提取;也可以保留全部的模型,只根据新的任务改变其fc层

Alex上课课件↓Alex讲到,对于在ImageNet上训练过的pre-trained model,其参数可以用来初始化别的任务:

- 数据量小的新任务。可以把前面的大部分层参数freeze,保留前面的卷积层和部分卷积层,以获取在ImageNet上得到的提取特征的能力,作为特征提取器,而只训练最后一层的全连接层。

- 数据量中等的新任务。则需要更多的可变的层来拟合新任务的数据,freeze前面的层,训练后面更多的层去拟合新数据。

但实际来说,什么是小和大往往没有定量的描述,我觉得还是需要根据pretrain模型时的数据和新问题的数据之间的多样性复杂程度来评估。

浙公网安备 33010602011771号

浙公网安备 33010602011771号