深度学习中的交叉熵

熵:是信息量的期望值,它是一个随机变量的确定性的度量。

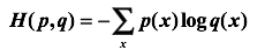

交叉熵:

刻画的是两个概率分布之间的距离,或可以说它刻画的是通过概率分布 q来表达概率分布p的困难程度。p代表正确答案,q代表预测值,交叉熵越小,两个概率分布越接近。

那么,在神经网络中怎样把前向传播得到的结果也变成概率分布呢?

Softmax回归就是一个非常有用的方法。假设原始的神经网络的输出为 y1,y2,...,yn,那么经过Softmax回归处理之后的输出为:

这样就把神经网络的输出也变成了一个概率分布,从而可以通过交叉熵来计算预测的概率分布和真实答案的概率分布之间的距离了。

参考:https://blog.csdn.net/weixin_37567451/article/details/80895309

浙公网安备 33010602011771号

浙公网安备 33010602011771号