Kafka环境搭建

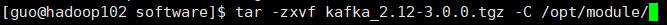

1.将软件包kafka_2.12-3.0.0.tgz上传到/opt/software/目录下,解压到/opt/module/目录下

tar -zxvf kafka_2.12-3.0.0.tgz -C /opt/module/

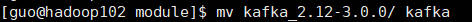

2.修改解压后的文件名称

mv kafka_2.12-3.0.0/ kafka

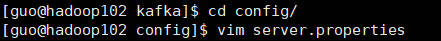

3.进入到/opt/module/kafka 目录,修改配置文件

cd config/

vim server.properties

找到log.dirs,并修改成下面代码

log.dirs=/opt/module/kafka/datas

找到zookeeper.connect,并修改成下面代码

zookeeper.connect=hadoop102:2181,hadoop103:2181,hadoop104:2181/kafka

分发安装包

xsync kafka/

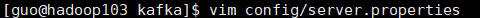

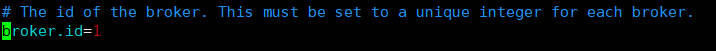

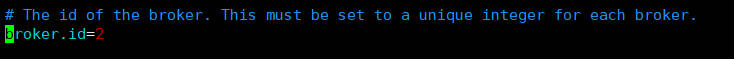

4.分别在 hadoop103 和 hadoop104 上修改配置文件/opt/module/kafka/config/server.properties中的 broker.id=1、broker.id=2。broker.id 不得重复,整个集群中唯一。

vim config/server.properties

vim config/server.properties

配置环境变量,在/etc/profile.d/my_env.sh 文件中增加 kafka 环境变量配置

sudo vim /etc/profile.d/my_env.sh

#KAFKA_HOME export KAFKA_HOME=/opt/module/kafka export PATH=$PATH:$KAFKA_HOME/bin

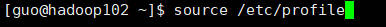

刷新一下环境变量。

source /etc/profile

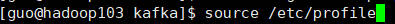

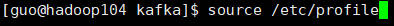

分发环境变量文件到其他节点,并 source。 (home后面跟的是用户名文件夹)

sudo /home/guo/bin/xsync /etc/profile.d/my_env.sh

hadoop103,hadoop104刷新一下环境变量。

source /etc/profile

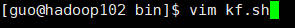

5.编写kafka集群启停脚本

在/home/atguigu/bin 目录下创建文件 kf.sh 脚本文件

vim kf.sh

#! /bin/bash case $1 in "start"){ for i in hadoop102 hadoop103 hadoop104 do echo " --------启动 $i Kafka-------" ssh $i "/opt/module/kafka/bin/kafka-server-start.sh - daemon /opt/module/kafka/config/server.properties" done };; "stop"){ for i in hadoop102 hadoop103 hadoop104 do echo " --------停止 $i Kafka-------" ssh $i "/opt/module/kafka/bin/kafka-server-stop.sh " done };; esac

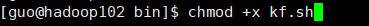

添加执行权限

chmod +x kf.sh

6.启动集群

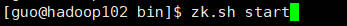

先启动 Zookeeper 集群,然后启动 Kafka。

zk.sh start

kf.sh start

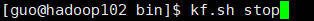

停止集群

kf.sh stop

注意:停止 Kafka 集群时,一定要等 Kafka 所有节点进程全部停止后再停止 Zookeeper集群。因为 Zookeeper 集群当中记录着 Kafka 集群相关信息,Zookeeper 集群一旦先停止,Kafka 集群就没有办法再获取停止进程的信息,只能手动杀死 Kafka 进程了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号