数据预处理

大数据的特征

1、容量大

2、多样化

3、价值大

4、速度快

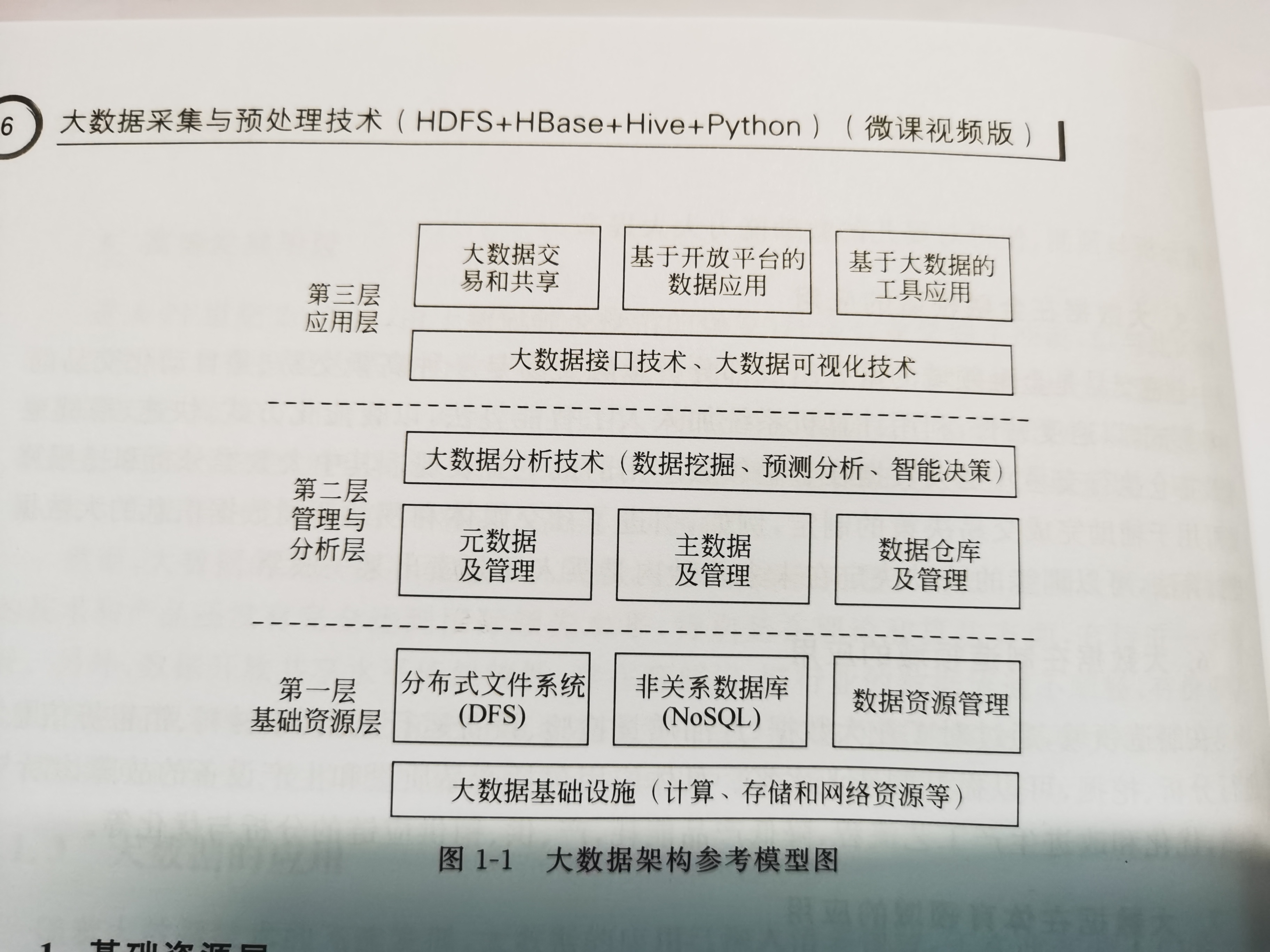

大数据的层次结构

大数据关键技术

1、数据采集与预处理技术

2、数据存储与管理技术

3、数据分析与挖掘技术

4、数据可视化技术

5、数据安全和隐私保护技术

大数据支撑技术

1、云计算

2、物联网

3、机器学习

大数据的思维方式

1、全样而非抽样

2、效率而非精确

3、相关而非因果

4、以数据为中心

5、我为人人,人人为我

传统数据采集的关键技术

1、采样

2、量化

3、编码

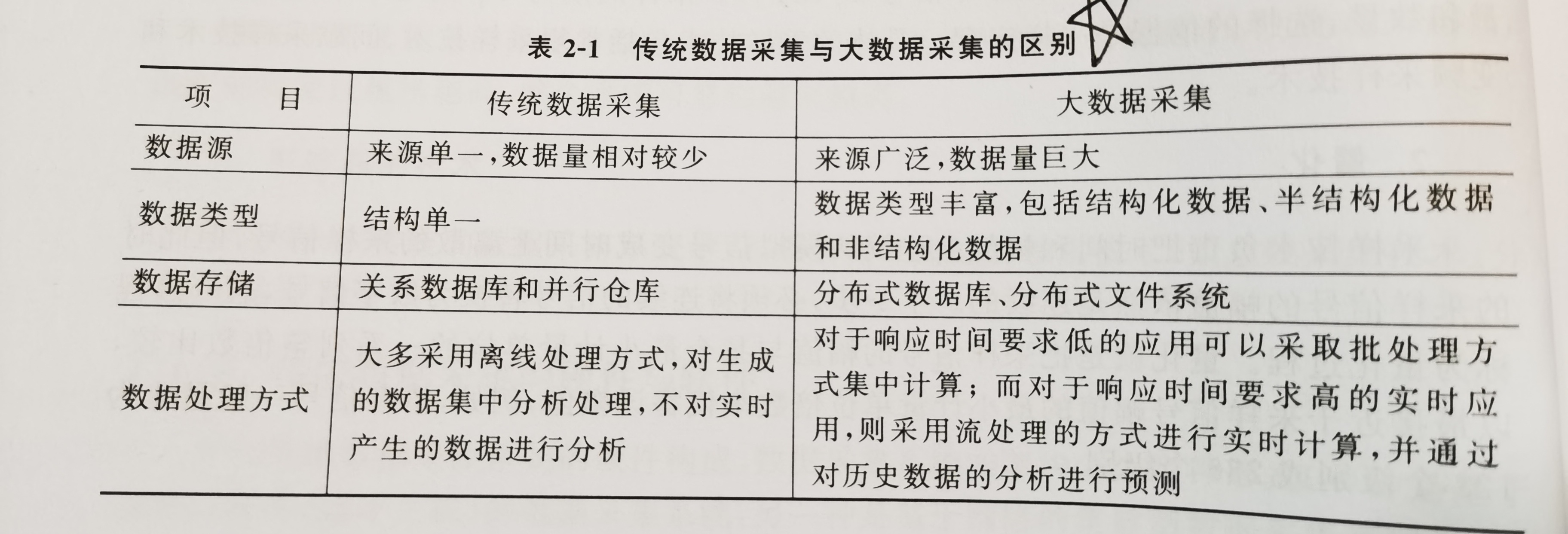

传统数据采集与大数据采集的区别

大数据采集的基本方法

1、系统日志文件采集

2、利用ETL工具采集

3、互联网数据采集

系统日志分类

1、用户行为日志

2、业务变更日志

3、系统运行日志

系统日志收集方法

1、Web API模式

2、服务代理模式

3、LC客户端模式

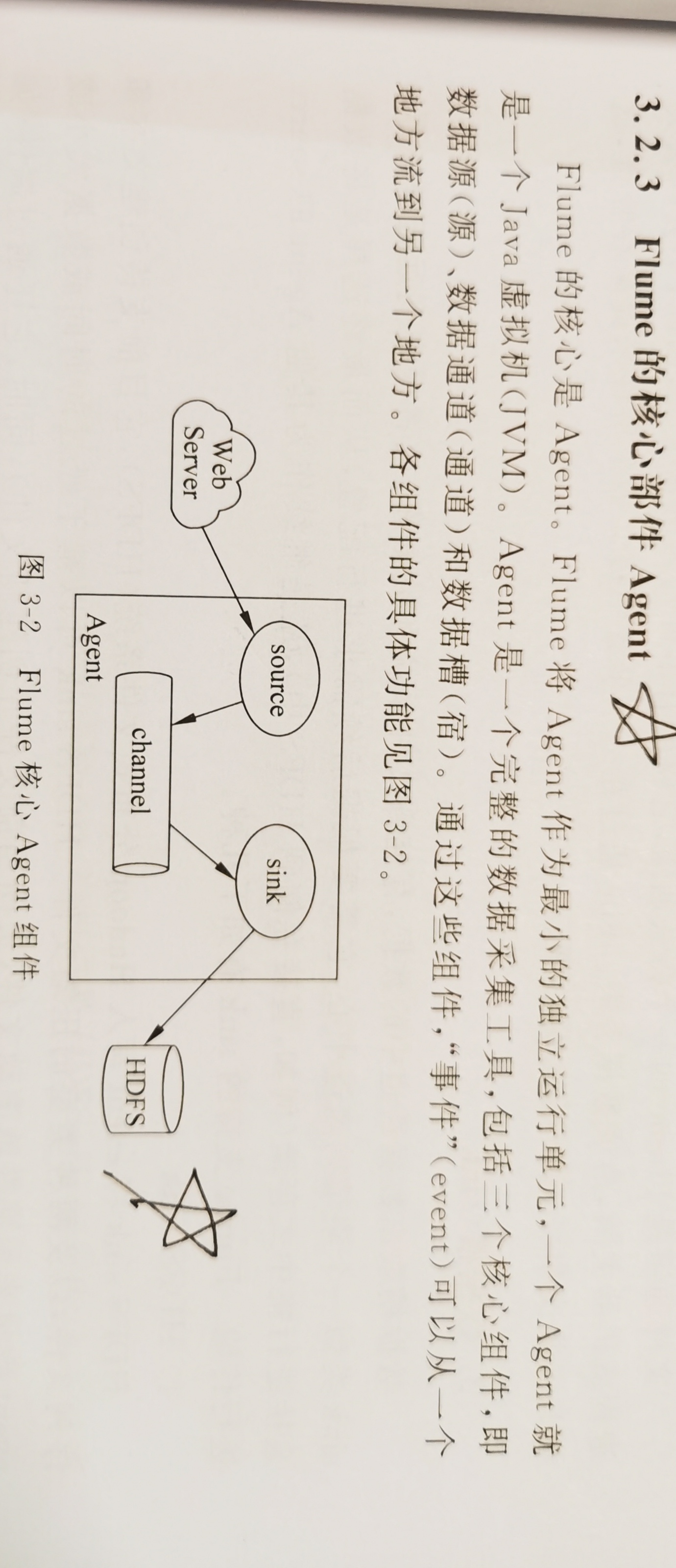

Flume的核心部件

1、数据源

2、数据通道

3、数据槽

Log Parser组成部分

1、目标输入

2、类SQL语句引擎

3、结果输出

大数据的迁移流程

1、数据准备

2、迁移实施

3、数据校验

大数据迁移任务类型

1、结构迁移

2、全量数据迁移

3、增量数据迁移

数据迁移相关技术

1、基于存储的数据迁移

基于同构存储的数据迁移

基于异构存储的数据迁移

2、基于主机逻辑卷的数据迁移

使用逻辑卷更换主机

使用主机逻辑卷镜像更换存储

3、基于数据库的数据迁移

同构数据库数据迁移

异构数据库的数据迁移

4、基于服务器虚拟化的数据迁移

物理机向虚拟机迁移

虚拟机的迁移

ETL数据迁移技术

抽取、转换、加载

ETL的实现模式

1、触发器模式

2、增量字段

3、全量同步

4、日志对比

网络爬虫的爬行策略

1、深度优先策略

2、广度优先策略

3、局部Page Rank策略

4、OPIC策略

5、大站优先策略

6、反向链接数策略

7、最佳优先搜索策略

robots协议的作用

robots协议是一种用来告诉搜索引擎哪些页面可以被抓取,哪些页面不能被抓取的协议。它是一种基于道德规范的约定,而不是强制执行的命令。网站可以通过在根目录下创建一个robots.txt文件来编写robots协议,指定不同的搜索引擎机器人(User-agent)和禁止访问的目录或文件(Disallow)。

robots协议的作用有以下几点:

- 保护网站的数据和敏感信息,避免被恶意抓取或泄露。

- 节省服务器的带宽和资源,屏蔽一些不需要被收录的大文件,如图片,音乐,视频等。

- 优化搜索引擎的抓取效率,避免重复或无效的页面被抓取,提高网站的收录质量。

- 设置网站地图(Sitemap)的链接,方便引导搜索引擎机器人爬取网站的内容。

python爬虫技术

200 成功

404 页面丢失

数据对象与属性类型

1、标称容量

2、二元属性

3、序数属性

4、数值属性

5、离散属性与连续属性

数据清洗的任务

1、解决数据的完整性

2、解决数据的一致性

3、数据的准确性和时效性

数据清洗的一般性系统框架

1、准备阶段

2、检测阶段

3、定位阶段

4、修正阶段

5、验证阶段

数据归约处理的结果应符合以下要求:

(1)数据量少,使数据挖掘算法学习速度更快;

(2)更高的数据分析和挖掘的处理精度,以便从大量的数据中分析总结得出模型;

(3)数据挖掘处理结果简单,便于使用;

(4)较少的特征,以便在下一轮数据采集中,去掉多余的或不需要的特征,减少工作量。

一般的数据归约算法应具备以下特点:

(1)可测试性。利用归约后的数据集,可以准确地确定近似结果的质量。

(2)可识别性。在数据挖掘程序应用之前,进行数据归约算法运行过程中,很容易确定近似结果的质量。

(3)统一性。计算结果的质量是时间和输入数据质量的非递减函数,因为算法往往是迭代的。

(4)一致性。计算结果的质量与计算时间和输入数据的质量有关。

(5)收益递减。归约方案在计算初期可有较大改进,但随时间递减。

(6)可中断性。算法可以随时被停下来,并给出所需的答案。

(7)优先权。算法可以被暂停,并以最小的开销重新开始。

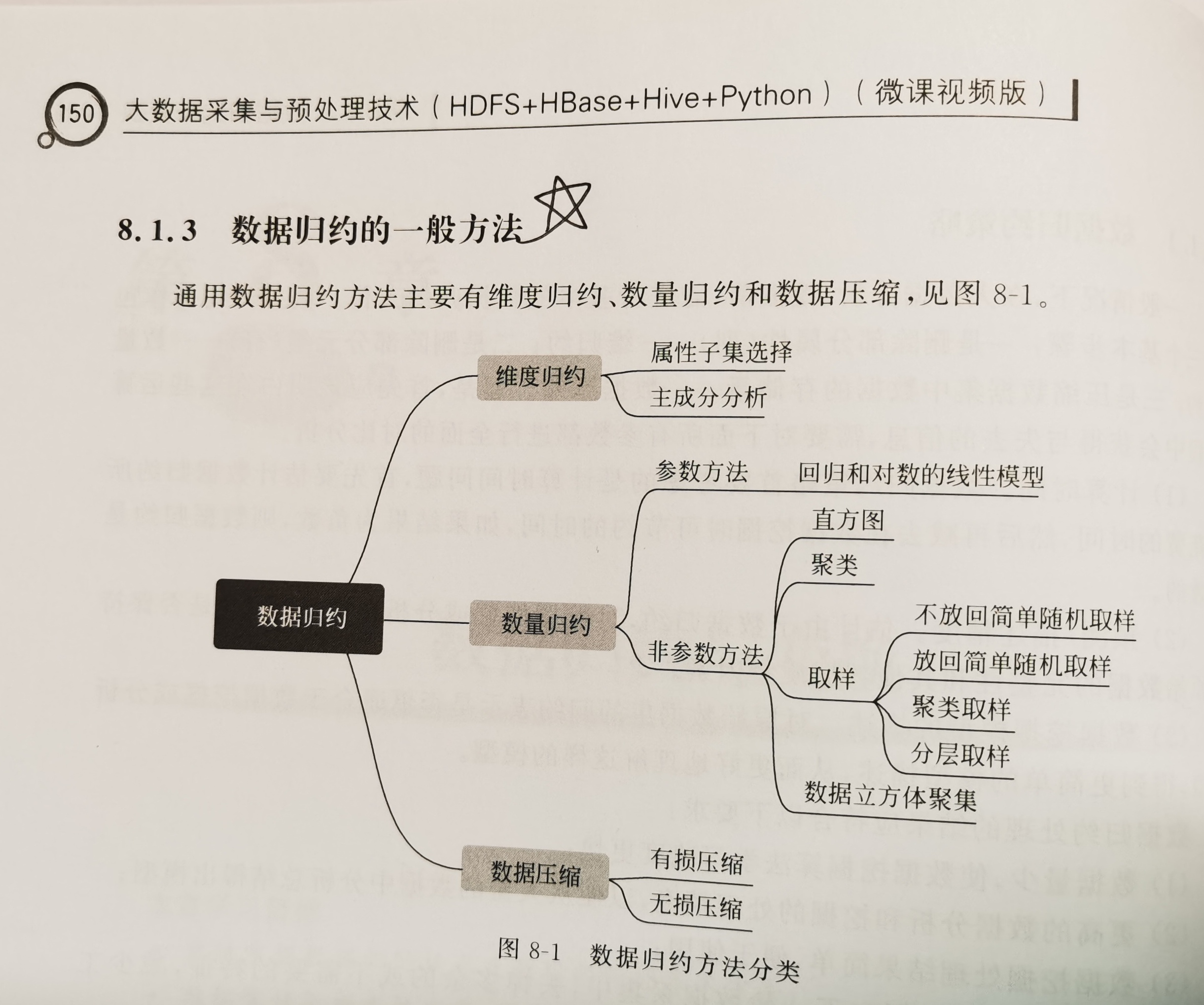

数据归约的一般方法

浙公网安备 33010602011771号

浙公网安备 33010602011771号