5.RDD操作综合实例

一、词频统计

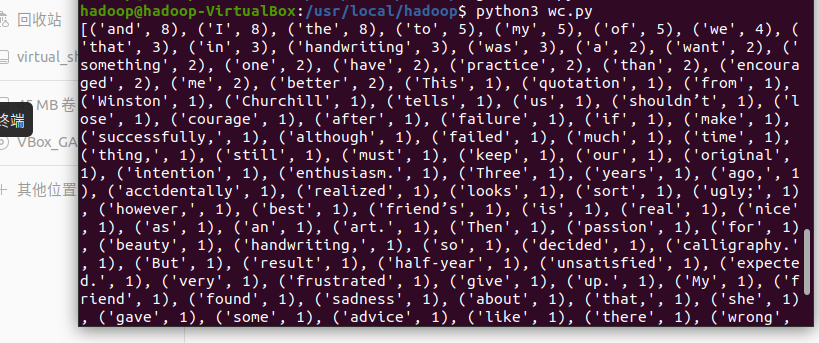

A. 分步骤实现

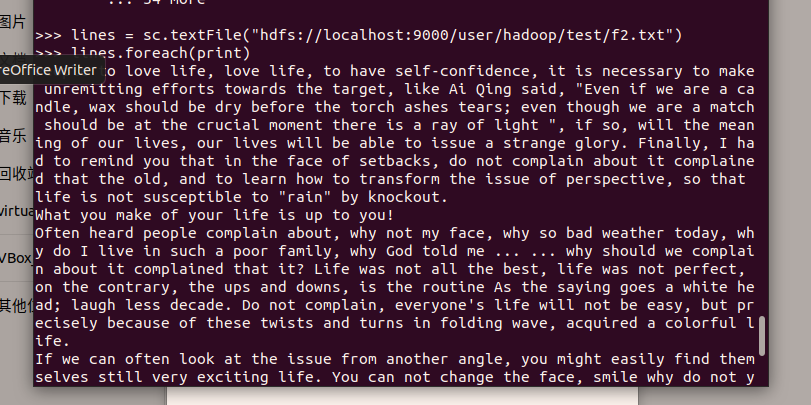

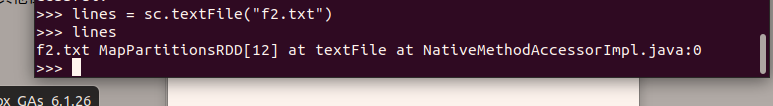

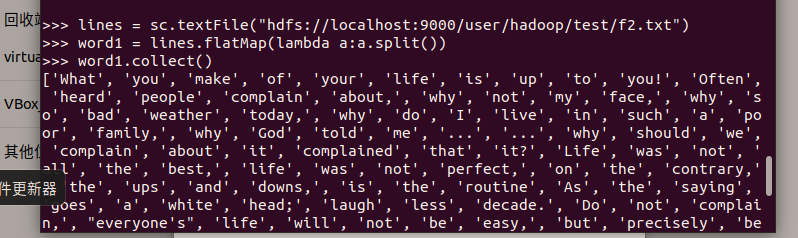

1. 准备文件读文件创建RDD

1.下载小说或长篇新闻稿

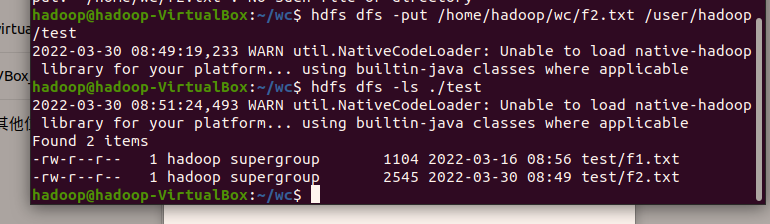

2.上传到hdfs上

2. 准备文件读文件创建RDD

3.分词

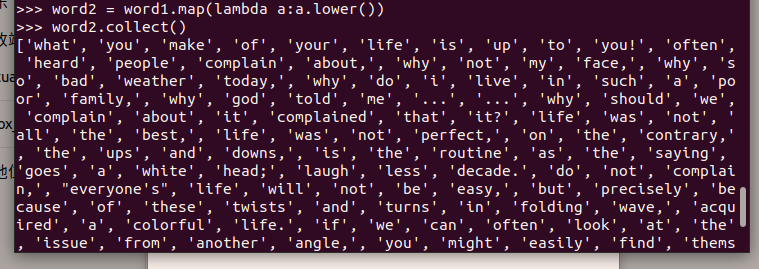

4.排除大小写lower(),map()

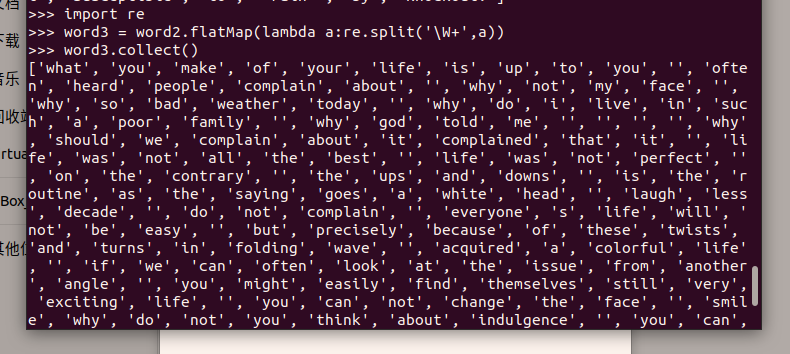

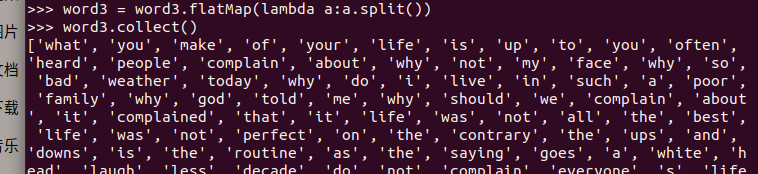

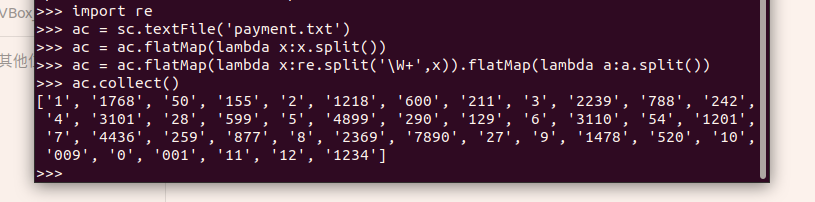

4.1.标点符号re.split(pattern,str),flatMap()

去掉无用数据:

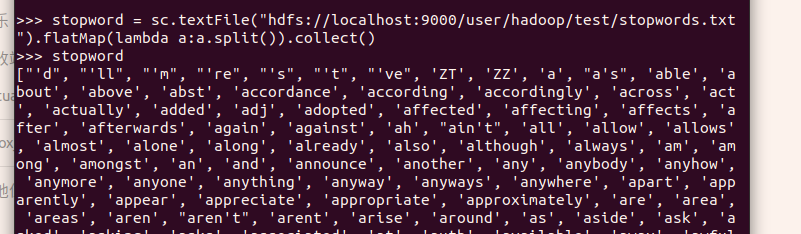

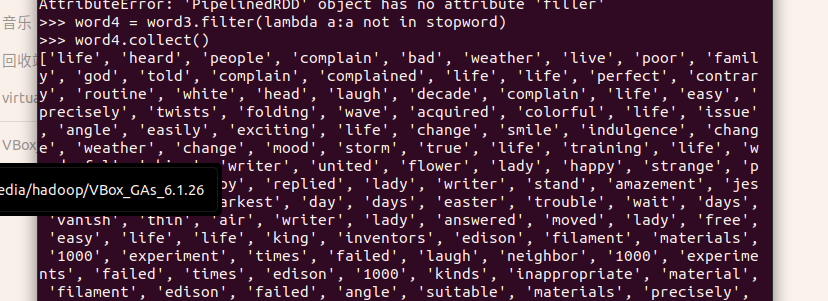

4.2.停用词,可网盘下载stopwords.txt,filter()

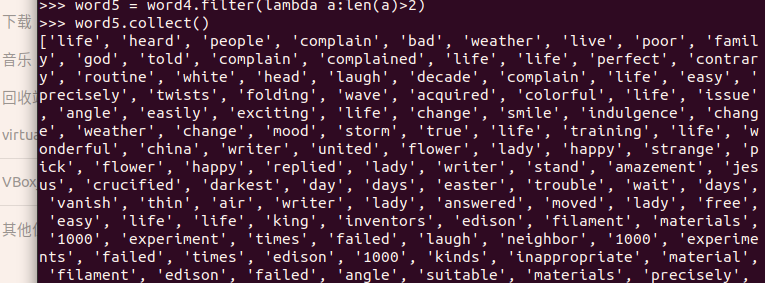

4.3.长度小于2的词filter()

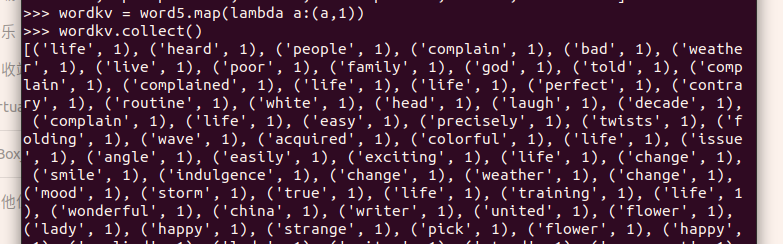

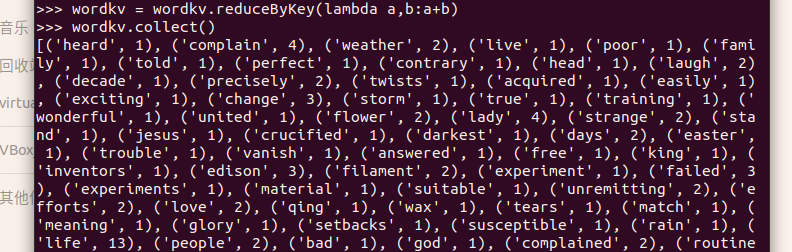

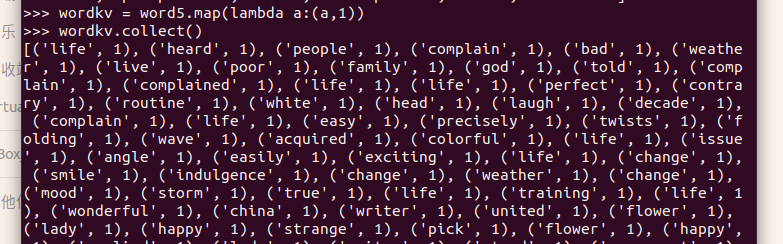

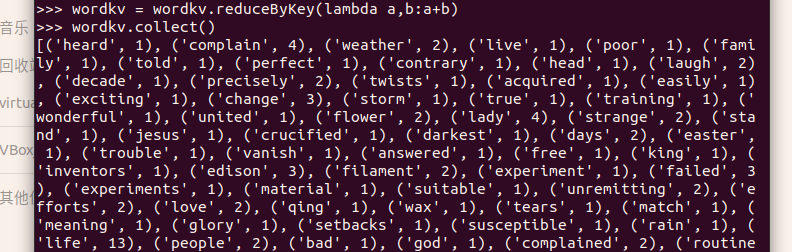

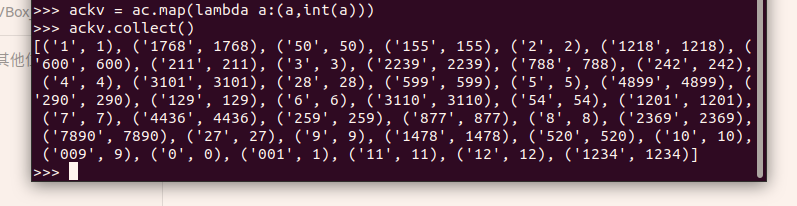

5.统计词频

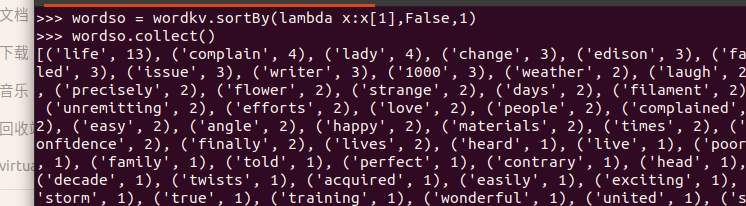

6.按词频排序

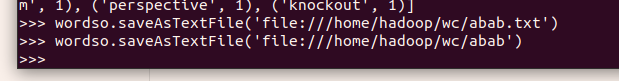

7.输出到文件

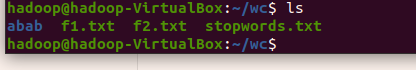

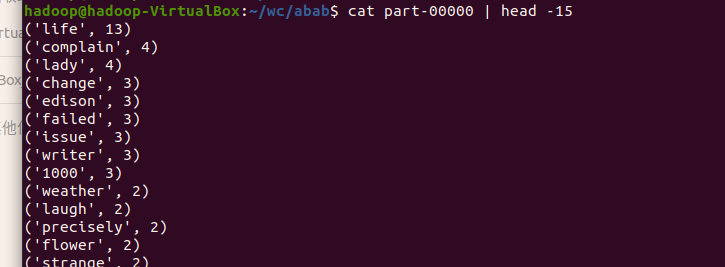

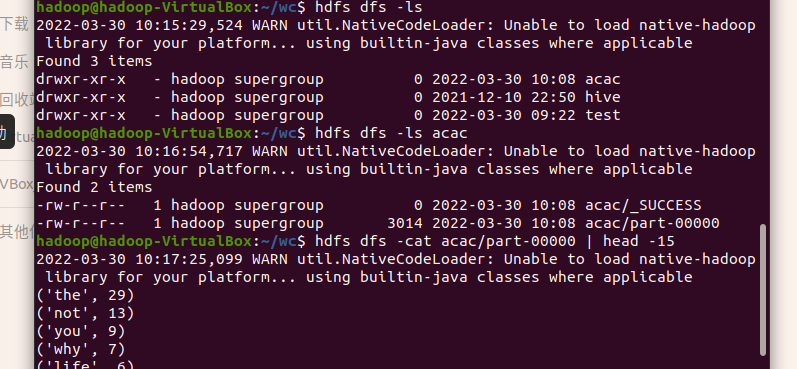

8.查看结果

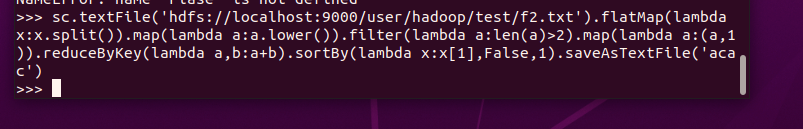

B. 一句话实现:文件入文件出

C. 和作业2的“二、Python编程练习:英文文本的词频统计 ”进行比较,理解Spark编程的特点。

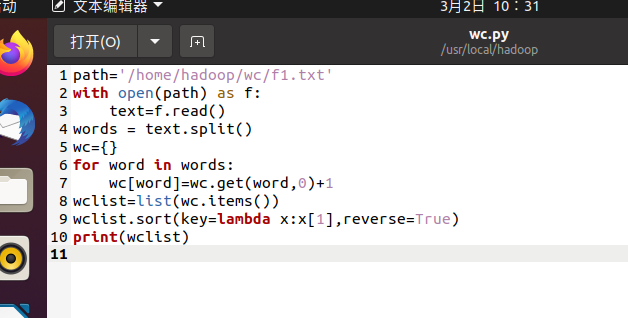

作业二的词频统计:

作业五的词频统计:

在Spark中有着区块数的概念,可以多个任务同时进行,而python是按顺序进行的,所以spark主要是对分布式的数据进行处理,而python是对单数据进行处理。

因此直观的感受是Spark要快捷方便的多

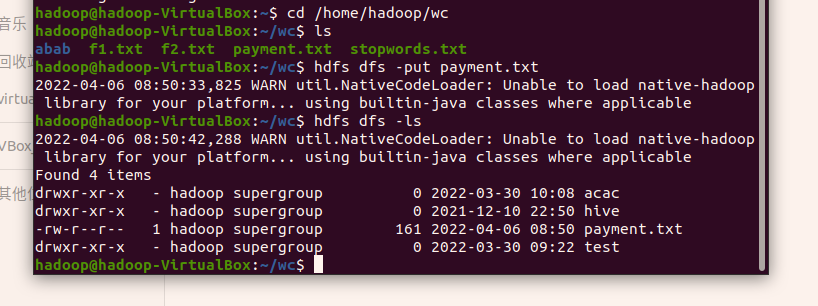

二、求TOP值

1. 丢弃不合规范的行:

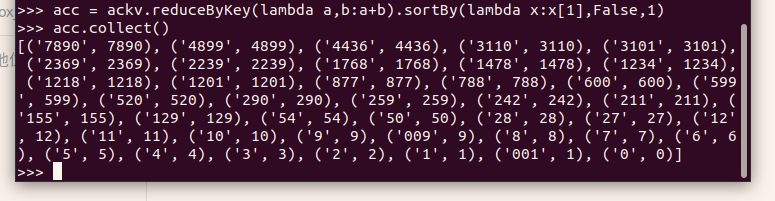

2. 按支付金额排序:

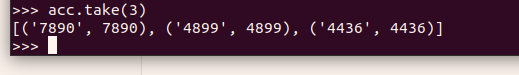

3. 取出Top3:

浙公网安备 33010602011771号

浙公网安备 33010602011771号