1. python3.10 对应的NLP相关库的安装

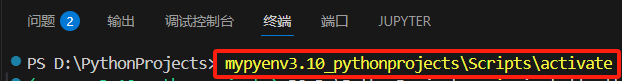

1. 进入虚拟环境

mypyenv3.10_pythonprojects\Scripts\activate

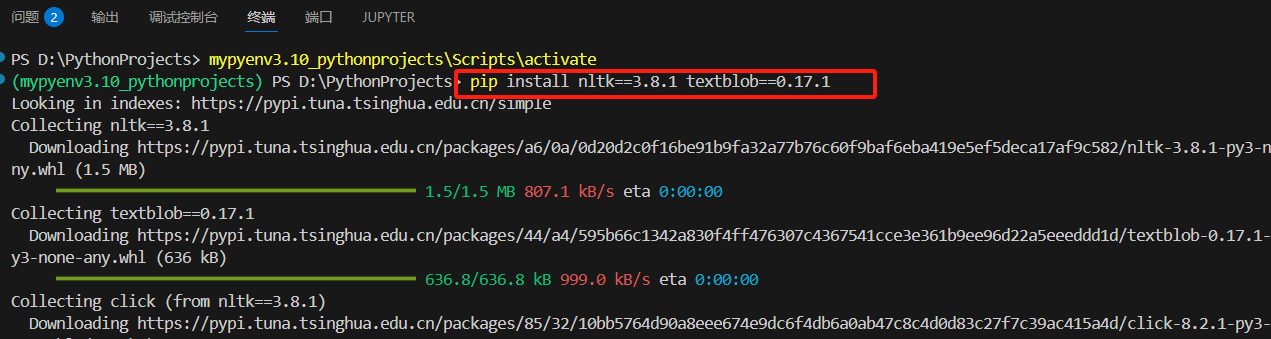

2. NLTK (自然语言工具包)

基本文本处理库

pip install nltk==3.8.1 textblob==0.17.1

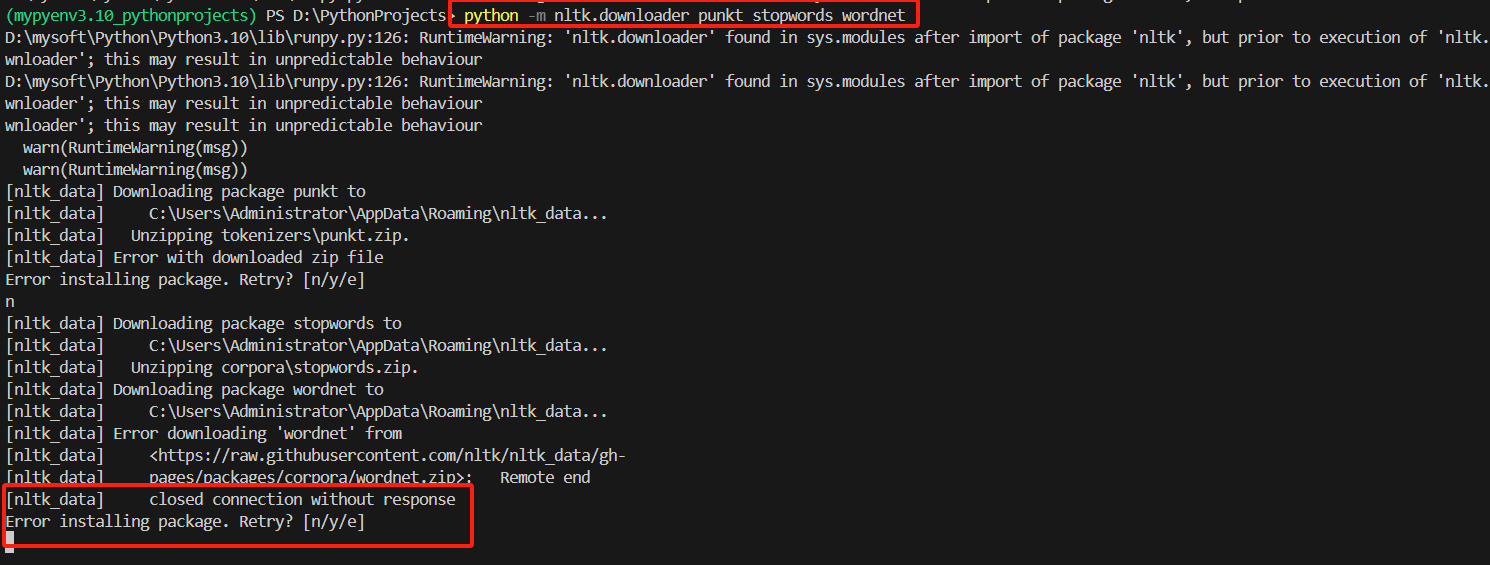

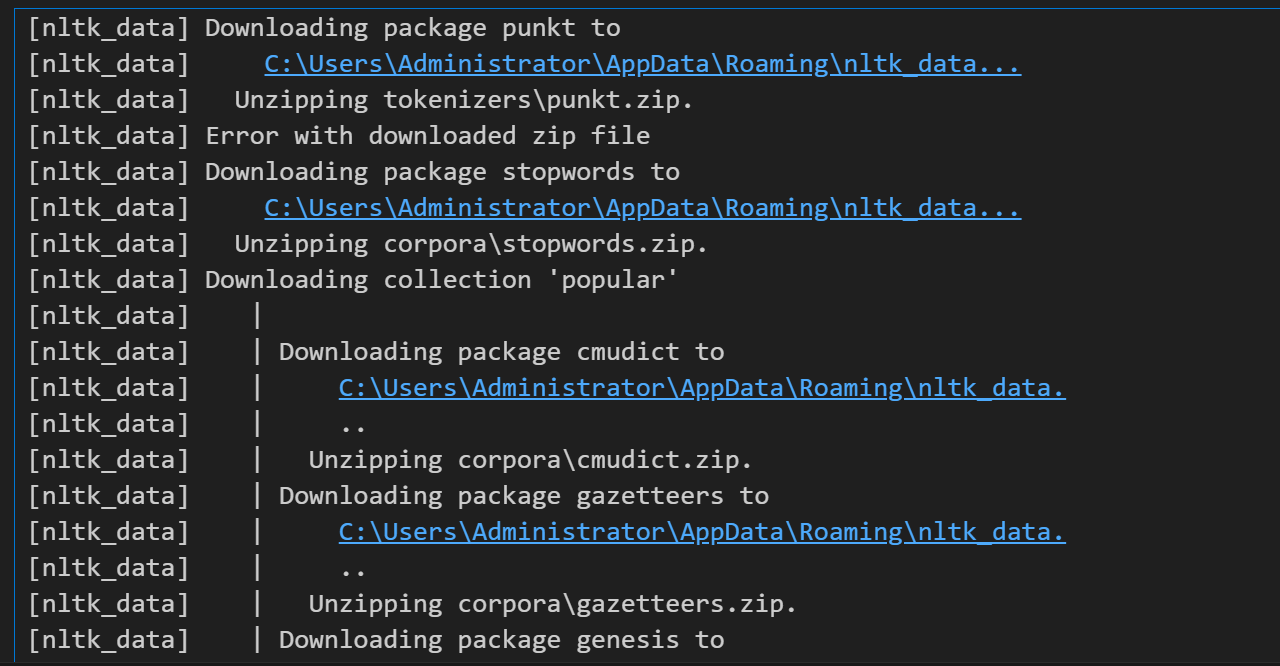

通过Python 模块运行 NLTK 的下载工具,下载punkt、stopwords、wordnet 库

-

1 punkt- 功能:句子和词语的分割模型(如英语的分句、分词规则)。

- 用途:

- 将文本拆分成句子(如

sent_tokenize()) - 将句子拆分成单词(如

word_tokenize())

- 将文本拆分成句子(如

- 示例:

from nltk.tokenize import word_tokenize print(word_tokenize("Hello, world!")) # 输出:['Hello', ',', 'world', '!']

-

2.stopwords- 功能:预定义的停用词列表(如英语中的 "the", "is", "and" 等高频但无实际语义的词语)。

- 用途:

- 文本清洗时过滤无意义词汇

- 提升文本分析的效率(如情感分析、主题建模)

- 示例:

from nltk.corpus import stopwords stop_words = set(stopwords.words('english')) print([w for w in ["this", "is", "a", "test"] if w not in stop_words]) # 输出:['test']

-

3 wordnet- 功能:英语词汇语义数据库,提供词汇的同义词、反义词、词形关联等语义关系。

- 用途:

- 词形还原(如将 "running" 还原为 "run")

- 词义消歧、文本扩展(同义词替换)

- 示例:

from nltk.stem import WordNetLemmatizer lemmatizer = WordNetLemmatizer() print(lemmatizer.lemmatize("running", pos="v")) # 输出:'run'

在终端运行

python -m nltk.downloader punkt stopwords wordnet

容易报错

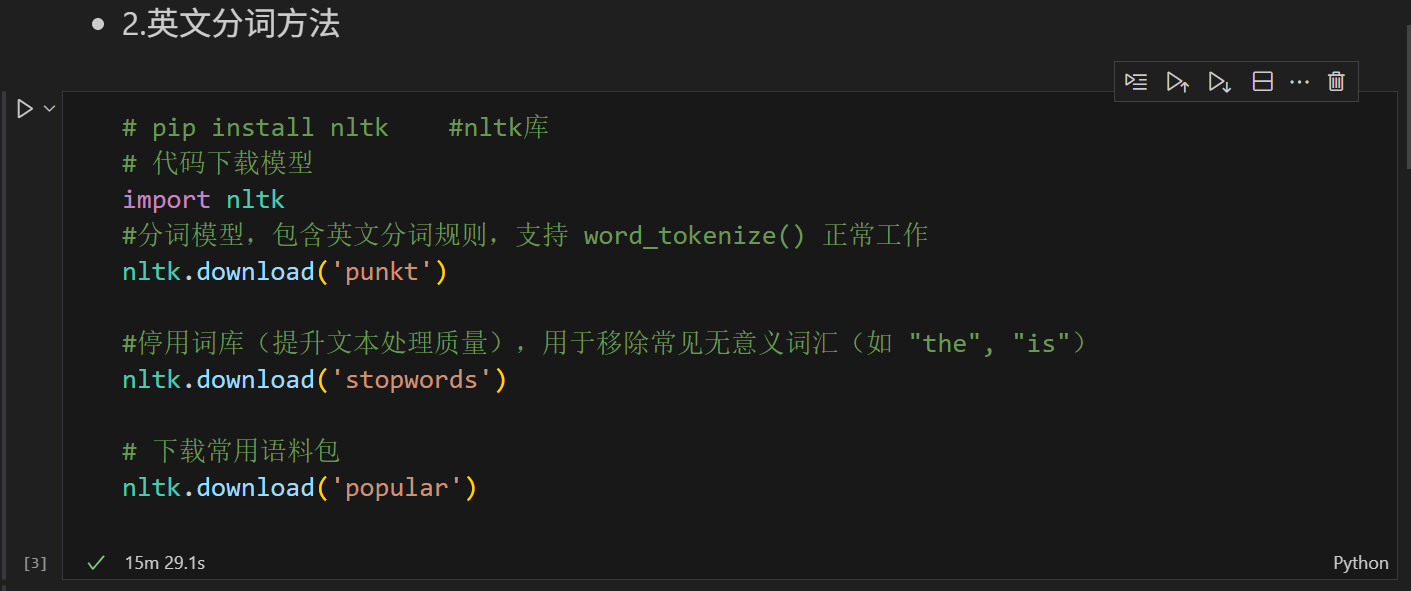

✅ 方法 1:通过代码下载(推荐)

在 Python 中运行:

默认的下载路径:C:\Users\Administrator\AppData\Roaming\nltk_data

import nltk

nltk.download('punkt') # 下载分词器

nltk.download('stopwords') # 可选:停用词

nltk.download('wordnet') # 可选:词形还原

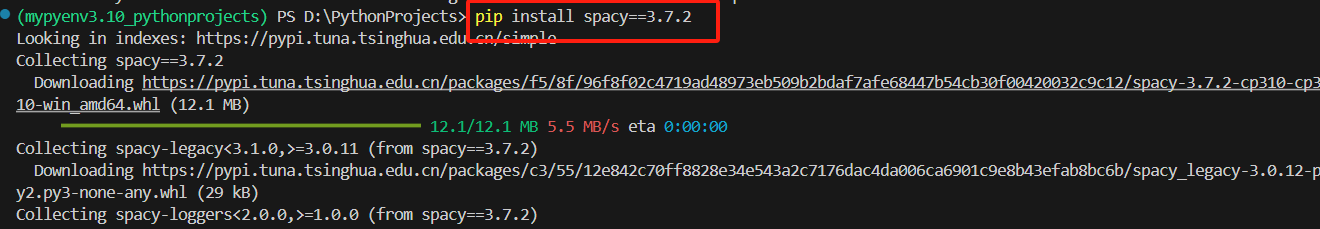

3. spaCy (工业级NLP)

pip install spacy==3.7.2

# 英文模型

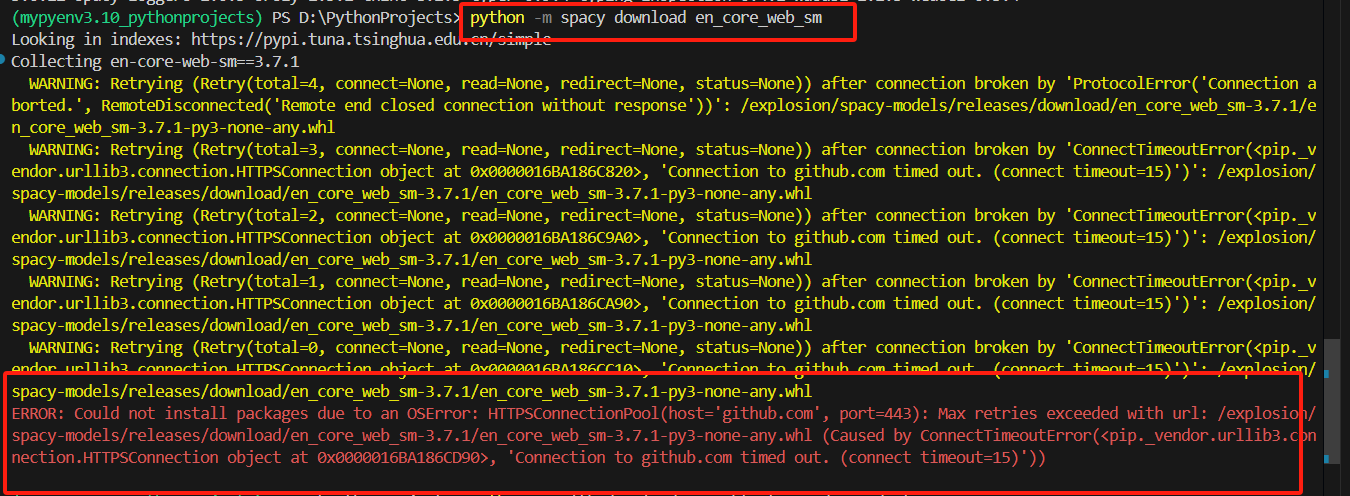

python -m spacy download en_core_web_sm

# 中文模型

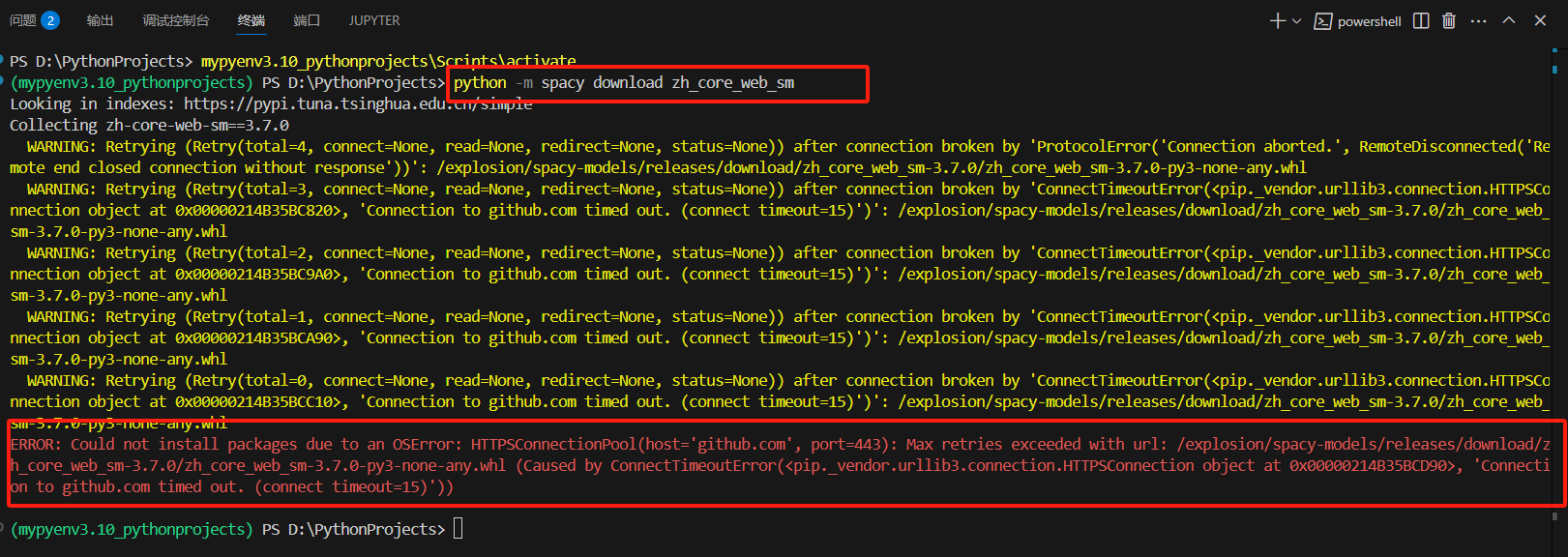

python -m spacy download zh_core_web_sm

# 英文模型 python -m spacy download en_core_web_sm

出现以上报错,解决方案如下

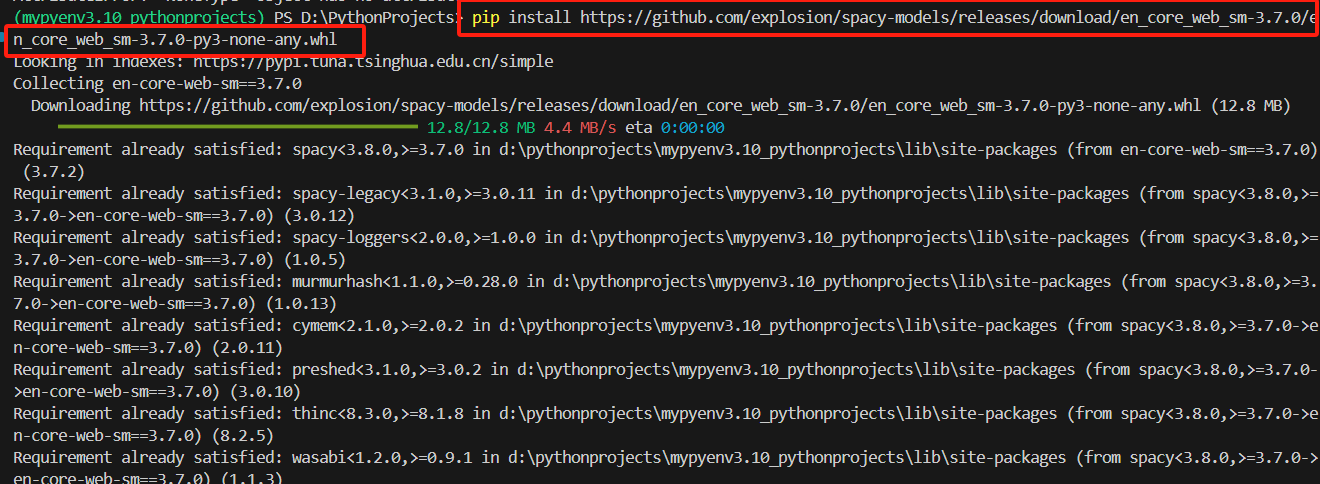

pip install https://github.com/explosion/spacy-models/releases/download/en_core_web_sm-3.7.0/en_core_web_sm-3.7.0-py3-none-any.whl

# 中文模型 python -m spacy download zh_core_web_sm

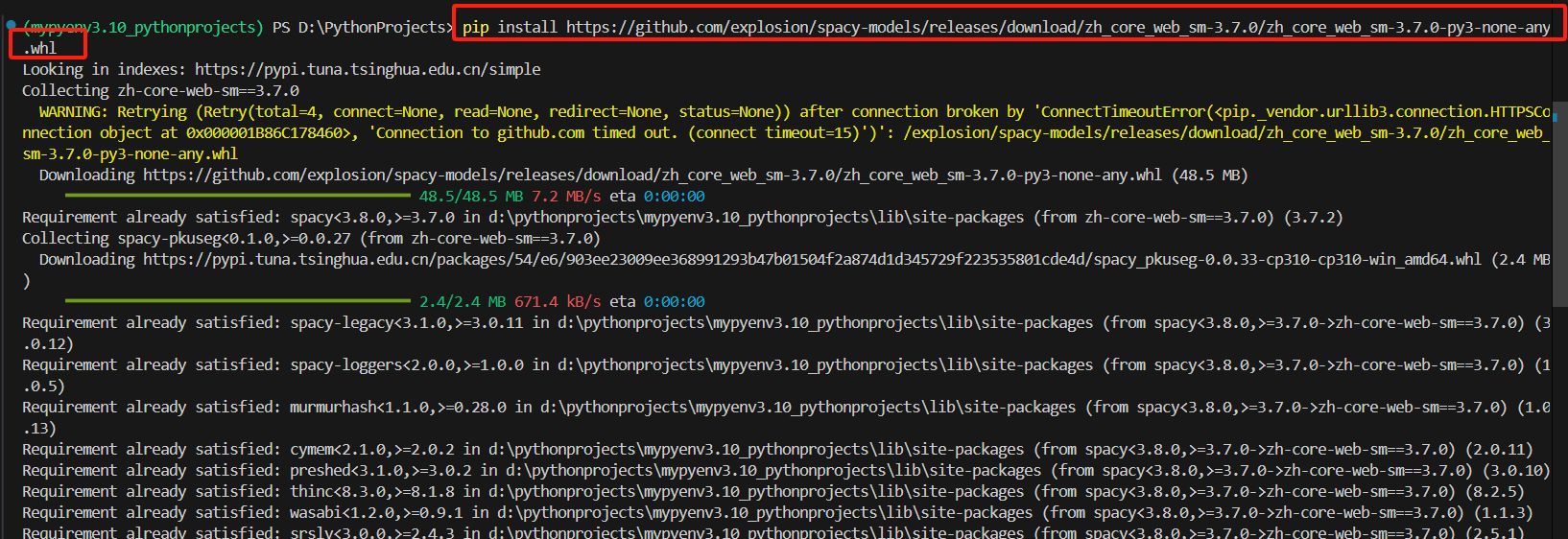

出现以上报错,解决方案如下

pip install https://github.com/explosion/spacy-models/releases/download/zh_core_web_sm-3.7.0/zh_core_web_sm-3.7.0-py3-none-any.whl

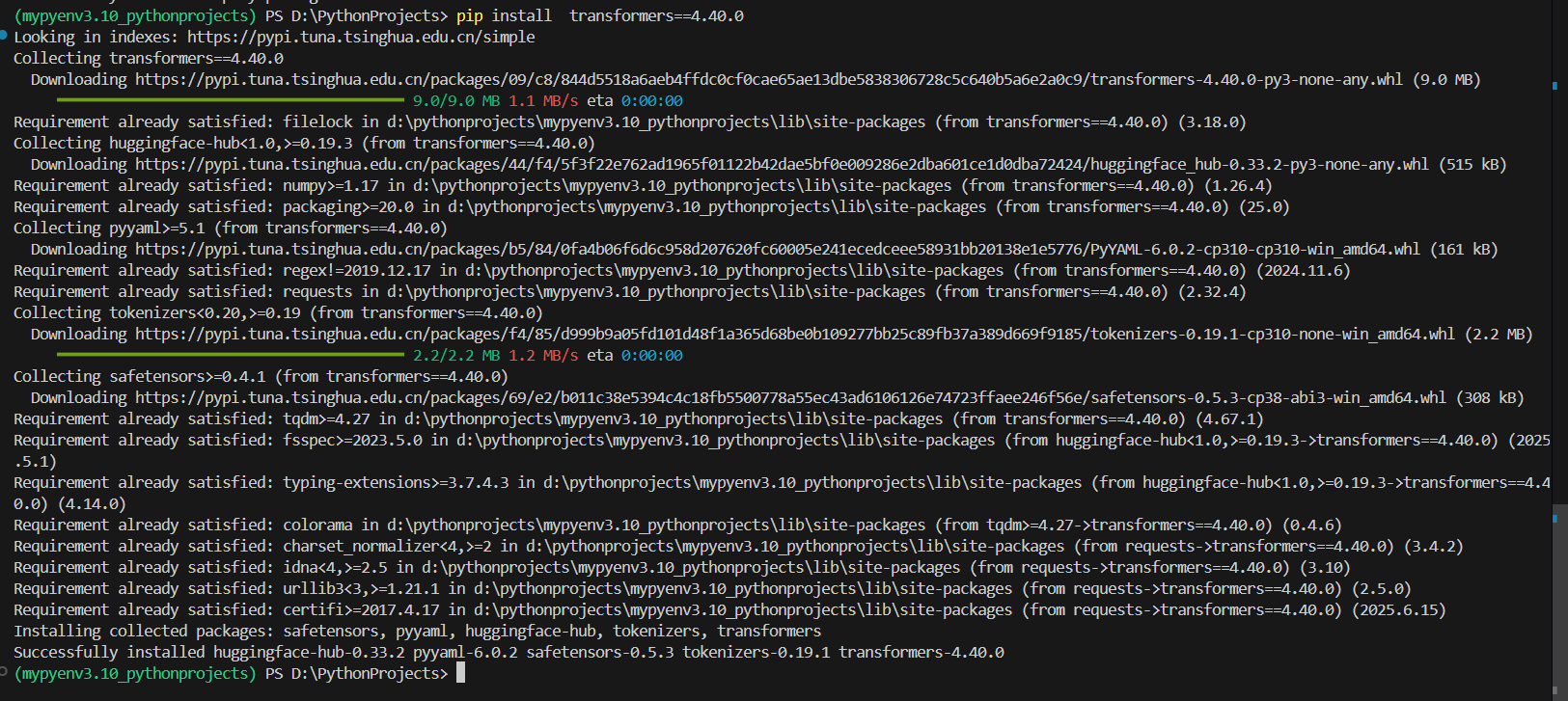

4.Transformers (Hugging Face)

pip install transformers==4.40.0

- 推荐模型:

bert-base-chinese,chinese-llama-2-7b

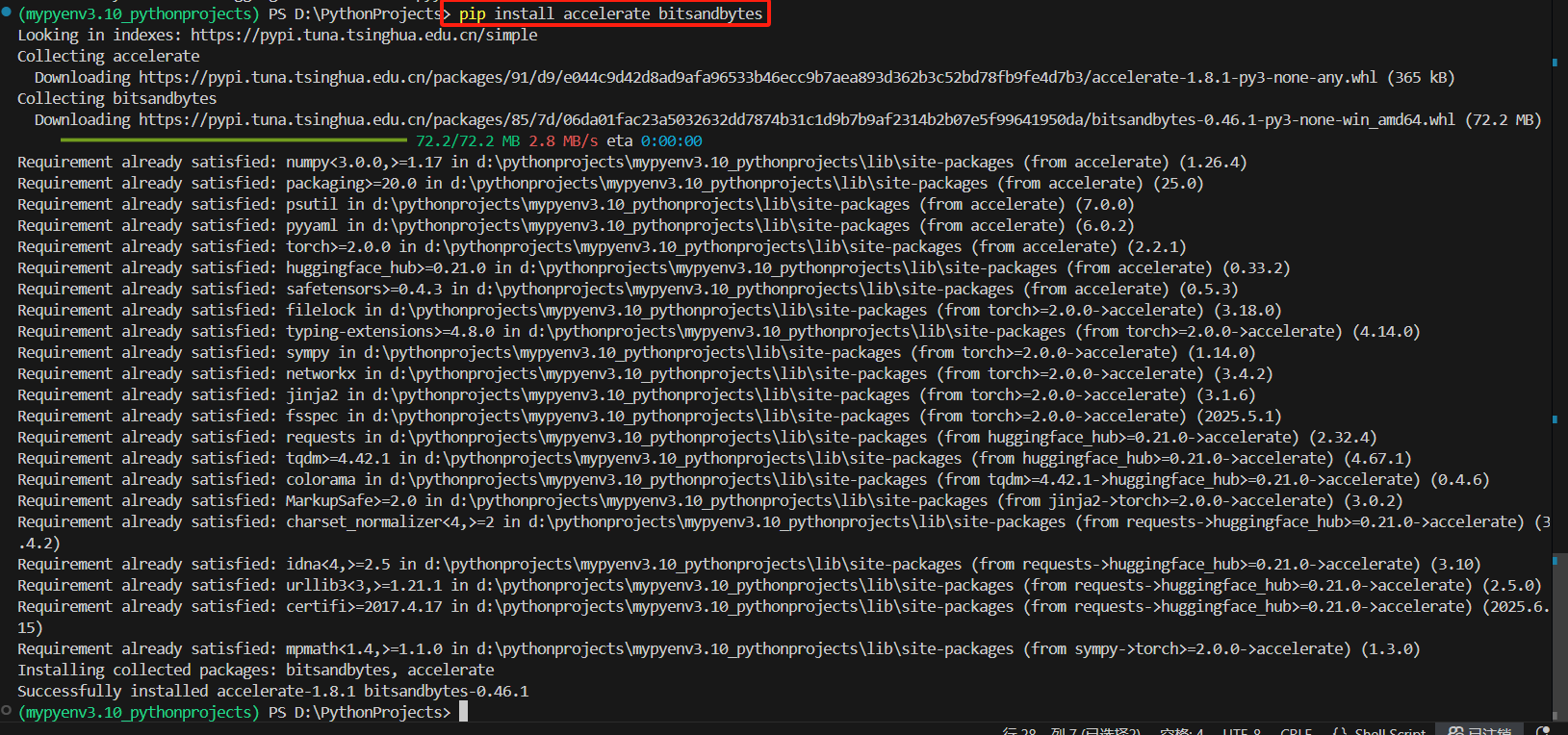

# 可选:安装加速库 pip install accelerate bitsandbytes

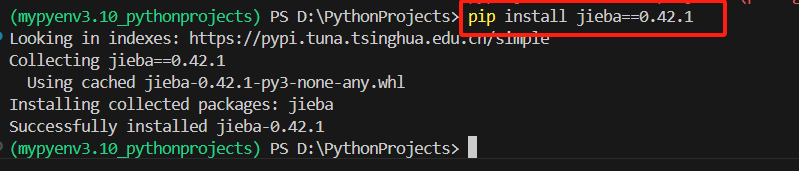

5. 中文处理专项

# 中文处理必备 pip install jieba==0.42.1

# 结巴分词 jieba # 北大分词工具 pkuseg==0.0.25

6、兼容性警告处理

# 升级依赖库

pip install --upgrade 库1 库2

浙公网安备 33010602011771号

浙公网安备 33010602011771号