信息论之联合熵、边缘熵、条件熵、交叉熵

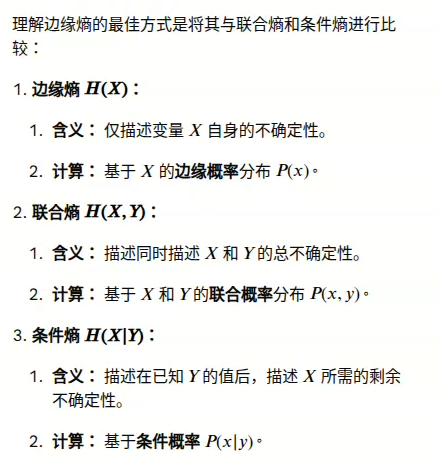

1. 边缘熵、联合熵及条件熵的概念

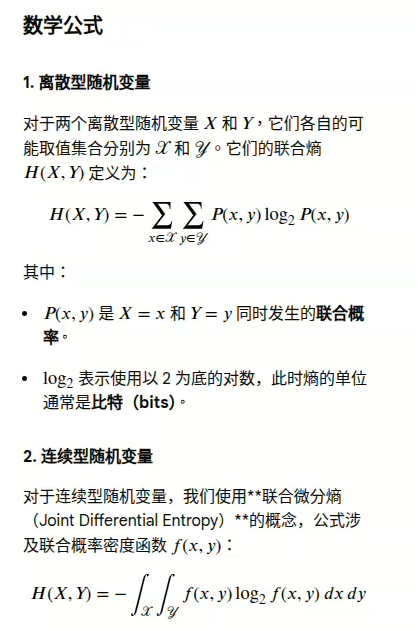

联合熵(Joint Entropy)是信息论中的一个重要概念,它衡量的是两个或多个随机变量作为一个整体的平均不确定性。

边缘熵(Marginal Entropy)是信息论中的一个概念,它指的是在多变量概率分布中,仅考虑单个随机变量时的熵值。

这编辑框不支持特殊数学符号,打字也困难,直接贴上书上的图片。

2. 联合熵与边缘熵、条件熵、互信息的关系

简单来说,熵𝐻(𝑋)衡量单个随机变量 𝑋 的信息量或不确定性。联合熵 𝐻 (𝑋,𝑌) 则衡量同时观察到变量𝑋和变量 𝑌 的值所带来的总不确定性或平均信息量。

例如,如果你要预测一个人的身高(变量 X)和体重(变量 Y):

- 预测身高有一定的不确定性 𝐻 ( 𝑋 )

- 预测体重有一定的不确定性 𝐻 ( 𝑌 )

- 同时预测身高和体重的组合(例如,“身高170cm且体重65kg”)的不确定性就是联合熵𝐻 (𝑋,𝑌)

总结

联合熵是衡量多个变量集体不确定性的度量,是理解和量化复杂数据关系的基础工具,在机器学习、自然语言处理和数据压缩等领域都有重要应用。

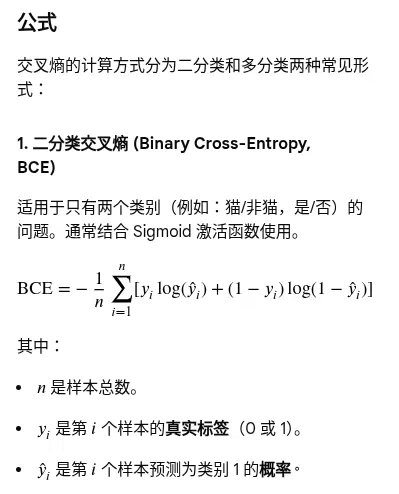

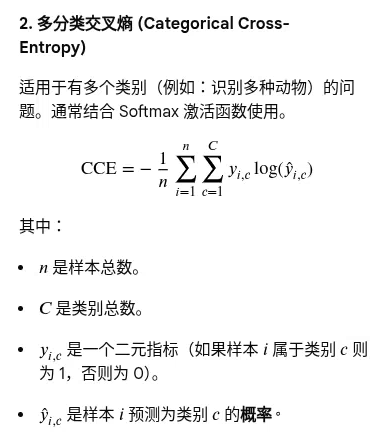

3. 交叉熵

交叉熵(Cross-Entropy)是信息论中的一个重要概念,在机器学习,尤其是分类任务中被广泛用作损失函数(Loss Function)。它主要用于衡量两个概率分布之间的差异。

核心定义与作用

在机器学习的背景下,交叉熵衡量的是:

- 真实概率分布(Target Distribution𝑃): 数据的真实标签或实际情况。

- 模型预测概率分布(Predicted Distribution Q): 模型预测出的属于各个类别的概率。

目标:训练模型时,我们希望模型的预测分布𝑄尽可能接近真实分布𝑃。最小化交叉熵损失,就是使模型学会准确地预测每个样本所属的类别概率。

为什么使用交叉熵作为损失函数?

- 衡量准确性: 交叉熵的值越小,表示两个概率分布越接近,模型的预测越准确。

- 梯度特性: 与均方误差(MSE)在分类问题中可能导致的梯度消失问题不同,交叉熵损失函数具有良好的数学特性,能提供稳定的梯度,有助于神经网络高效训练和收敛。

- 直观意义: 从信息论角度看,交叉熵可以理解为使用模型预测的分布对真实事件进行编码所需的平均信息量(比特数),信息量越少说明模型越高效、越准确。

摘自:《信息论》

浙公网安备 33010602011771号

浙公网安备 33010602011771号