信息论之互信息MI

互信息(Mutual Information,MI)是信息论中的一个核心概念,用于衡量两个随机变量之间相互依赖性的程度。简单来说,它告诉我们,了解一个变量的多少信息能帮助我们预测另一个变量。

1. 互信息的概念

互信息可以被看作是一个变量中包含的另一个变量的信息量。

- 如果两个变量完全独立:互信息为零。了解其中一个变量不会提供关于另一个变量的任何信息。

- 如果两个变量完全相关(例如,知道

𝑋 的值就能确定

𝑋 的值就能确定 𝑌 的值):互信息为最大值(等于其中一个变量的熵)。

𝑌 的值):互信息为最大值(等于其中一个变量的熵)。

互信息与相关系数(如皮尔逊相关系数)的主要区别在于:

- 相关系数主要衡量线性关系。

- 互信息可以衡量任何类型的关系,包括非线性关系。

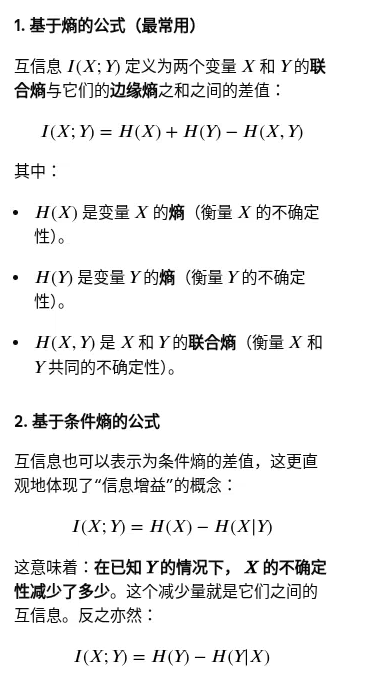

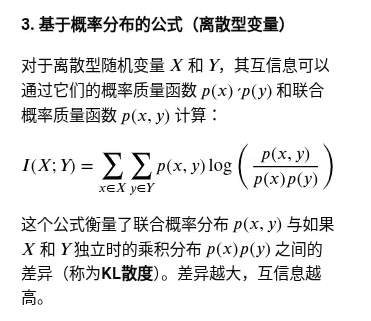

2. 互信息的数学公式

互信息 𝐼 (𝑋 ; 𝑌) 的数学定义有几种等价形式:

浙公网安备 33010602011771号

浙公网安备 33010602011771号