摘要:  在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

posted @ 2025-11-25 17:35

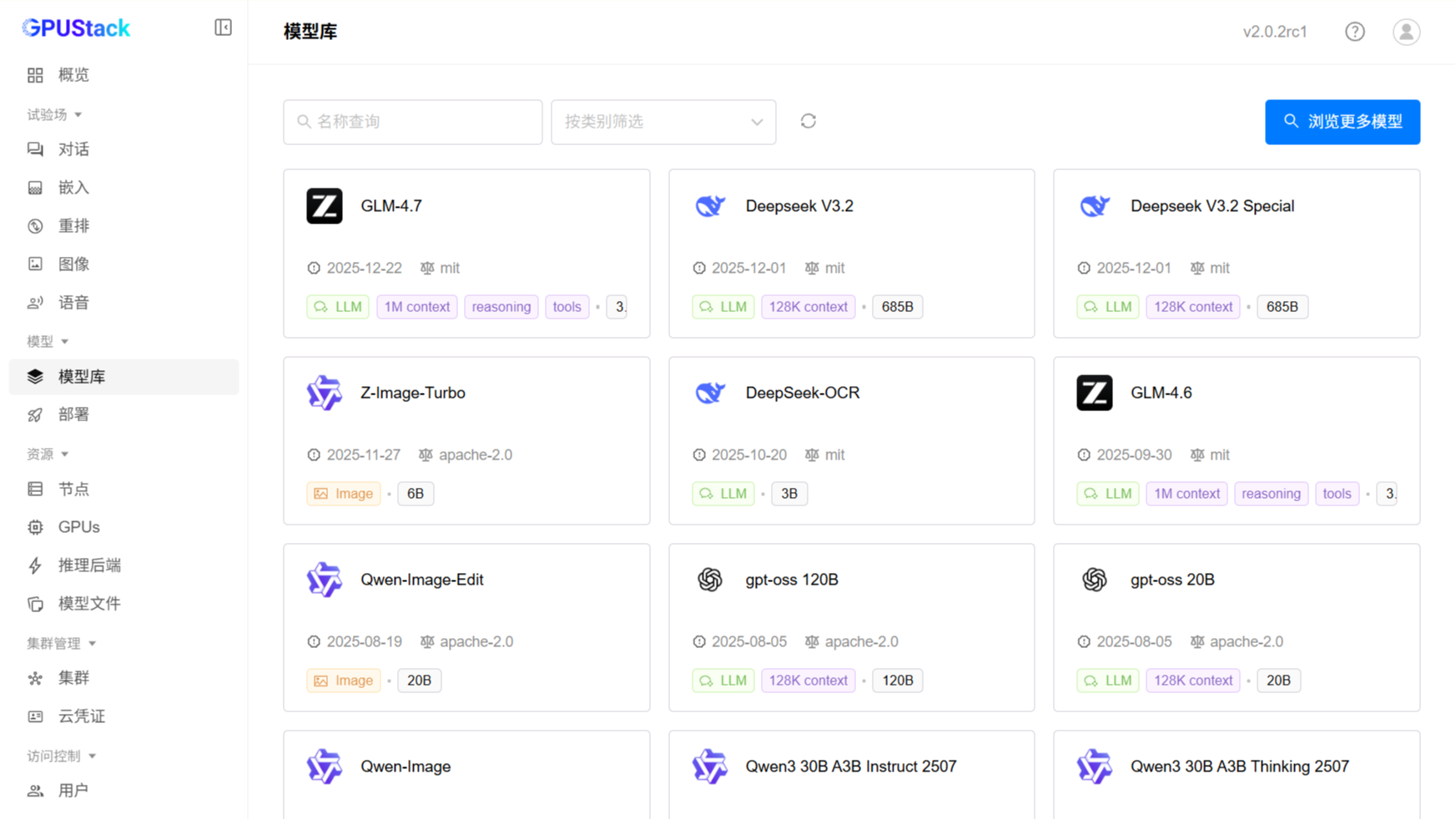

GPUStack

阅读(1268)

评论(0)

推荐(0)

在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

在大模型推理的下半场,GPUStack v2 不再是简单的模型服务平台,而是高性能推理生态的协调者与赋能者。 阅读全文

昇腾多机推理太复杂?易出错?试试 GPUStack 阅读全文

昇腾多机推理太复杂?易出错?试试 GPUStack 阅读全文

在 45 分钟内搭建 GPUStack 模型服务平台并运行生产级的 Qwen3 模型服务。 阅读全文

在 45 分钟内搭建 GPUStack 模型服务平台并运行生产级的 Qwen3 模型服务。 阅读全文

GPUStack 正式发布并开源,一个用于运行 LLM(大型语言模型)的开源 GPU 集群管理器。 阅读全文

GPUStack 正式发布并开源,一个用于运行 LLM(大型语言模型)的开源 GPU 集群管理器。 阅读全文

通过 n8n 接入 GPUStack 本地模型,构建一个自动抓取 RSS、生成摘要并邮件推送的 AI 资讯助手。全流程本地运行,零 API 成本,数据不出域,快速体验私有化 AI 自动化。 阅读全文

通过 n8n 接入 GPUStack 本地模型,构建一个自动抓取 RSS、生成摘要并邮件推送的 AI 资讯助手。全流程本地运行,零 API 成本,数据不出域,快速体验私有化 AI 自动化。 阅读全文

GPUStack v2 自定义后端功能实战!本文以 MinerU 为例,手把手教你快速接入并运行超强 PDF 解析工具,轻松构建私有化文档提取服务。 阅读全文

GPUStack v2 自定义后端功能实战!本文以 MinerU 为例,手把手教你快速接入并运行超强 PDF 解析工具,轻松构建私有化文档提取服务。 阅读全文

相比于未优化的 vLLM 基线,经过针对性调优的 DeepSeek-V3.2 在 NVIDIA H200 集群上实现了 57.8% 至 153.6% 的吞吐量提升。 阅读全文

相比于未优化的 vLLM 基线,经过针对性调优的 DeepSeek-V3.2 在 NVIDIA H200 集群上实现了 57.8% 至 153.6% 的吞吐量提升。 阅读全文

在 WSL2(Windows Subsystem for Linux) 中配置 NVIDIA GPU 并部署 GPUStack。 阅读全文

在 WSL2(Windows Subsystem for Linux) 中配置 NVIDIA GPU 并部署 GPUStack。 阅读全文

一键跑通 PaddleOCR-VL,极速体验行业顶尖的文档解析实力。 阅读全文

一键跑通 PaddleOCR-VL,极速体验行业顶尖的文档解析实力。 阅读全文

基于开源大模型服务平台 GPUStack 与自定义安装的 vLLM 版本完成 GPT OSS 系列模型的生产部署推理。并对比 Ollama 与 vLLM 在生产并发场景下的吞吐性能差异。 阅读全文

基于开源大模型服务平台 GPUStack 与自定义安装的 vLLM 版本完成 GPT OSS 系列模型的生产部署推理。并对比 Ollama 与 vLLM 在生产并发场景下的吞吐性能差异。 阅读全文

GPUStack v0.7 提供了 70 余项功能优化与稳定性修复,涵盖推理加速与性能优化、开箱即用与用户交互、生产落地与多场景兼容性、运维运营能力等多个方面,进一步提升平台的可用性与工程稳定性,助力用户轻松构建高性能、可扩展的大模型服务体系! 阅读全文

GPUStack v0.7 提供了 70 余项功能优化与稳定性修复,涵盖推理加速与性能优化、开箱即用与用户交互、生产落地与多场景兼容性、运维运营能力等多个方面,进一步提升平台的可用性与工程稳定性,助力用户轻松构建高性能、可扩展的大模型服务体系! 阅读全文