- 传感器输入与VIO :系统接收实时的RGB-D图像流,并通过一个视觉惯性里程计(VIO)模块(如VINS-Fusion)来获取初始的相机位姿。

- 开放词汇实例识别 :利用YOLO-World, SAM, CLIP等强大的视觉基础模型,系统从每一帧图像中检测和分割出开放词汇的物体实例,并提取它们的语义特征。

- 3D-2D高斯物体关联/融合 :这是核心步骤之一。系统会将地图中已有的3D高斯物体,渲染到当前视角下,生成2D的物体掩码和特征。然后,通过一个几何与语义的联合相似度匹配,将当前帧检测到的2D物体与地图中的3D物体进行关联。

- 高斯初始化/实例特征生成 :对于匹配上的物体,信息进行融合;对于新出现的物体,则初始化一组新的高斯基元来表示它。同时,为每个物体的高斯基元赋予一个唯一的实例特征(Instance Feature),用于后续的正则化。

- 联合优化 :通过一个包含RGB损失、深度损失和创新的特征损失(Feature Loss)的联合损失函数,对高斯地图进行优化。

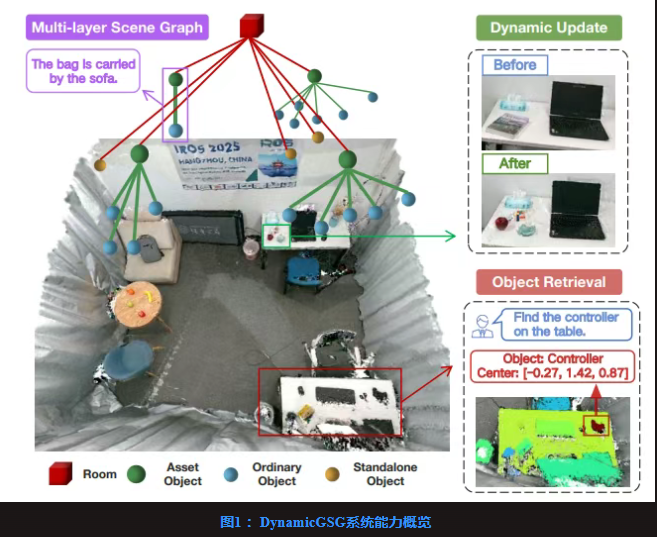

- 场景图构建与动态更新 :基于优化好的物体级高斯地图,利用大型视觉语言模型(LVLM)分析物体间的空间和语义关系,构建分层的场景图。在动态场景中,系统会检测变化并对高斯地图和场景图进行局部更新。

核心技术一

如何确保当前帧看到的“杯子A”,就是地图里那个“杯子A”?

图3 :3D-2D高斯物体关联

解读 :这个关联过程分为两步 :

- 几何相似度(Geometric Similarity) :计算当前检测到的2D物体掩码,与地图中3D物体渲染出的2D掩码之间的交并比(IoU)。

- 语义相似度(Semantic Similarity) :计算当前检测到的物体的CLIP特征,与地图中物体的CLIP特征之间的余弦相似度。

- 联合匹配 :通过加权求和这两种相似度,得到一个联合得分,从而实现更鲁棒的物体关联。

核心技术二

如何确保属于同一个物体的高斯基元“抱团”,而不侵入到邻近物体的区域?

公式 (11) :特征损失 (Feature Loss)

- 解读 :在传统的3DGS-SLAM中,监督信号只有RGB和Depth。DynamicGSG创新性地引入了第三个监督信号 :实例特征图(Instance Feature Map)。

- 系统为每一个物体实例(比如,

sofa_1)分配一个唯一的、固定的低维特征向量(可以理解为一个独特的“颜色”)。 - 在2D图像上,根据物体分割结果,可以得到一个“真值”实例特征图。

- 在渲染时,除了渲染RGB和Depth,系统还利用高斯基元上附带的实例特征,渲染出一个预测的实例特征图(公式5)。

- 的作用就是让渲染出的实例特征图与真值保持一致。这相当于一个强大的正则项,它强制要求“属于沙发的高斯们,你们渲染出来的特征必须都是沙发特征”,从而有效地防止了不同物体之间的边界模糊和“串色”问题。

图4 :特征损失消融实验的可视化

解读 :这张图直观地展示了特征损失的巨大作用。在没有特征损失时(w/o feature loss),渲染出的实例分割图(中间一行)中,不同物体(如沙发和靠垫)的边界处出现了大量颜色错误的像素,说明高斯基元的归属发生了混乱。而在加入特征损失后(DynamicGSG),渲染出的实例分割图(上一行)边界清晰,与真值(Ground truth)几乎一致。

实验成果与评估分析

DynamicGSG在语义分割、语言引导的对象检索和场景重建等多个任务上都取得了SOTA性能。

1. 3D开放词汇语义分割

表1 :Replica数据集上的3D语义分割性能

解读 :该表对比了不同方法在Replica数据集上的3D语义分割精度。

- 结果 :DynamicGSG在平均准确率(mAcc)和平均交并比(mIoU)两项核心指标上,都显著超越了所有基线方法。其mIoU达到了**31.06%**,远高于ConceptGraphs的25.57%。

- 结论 :这证明了其3D-2D联合关联策略和特征损失的有效性,能够实现更精确的物体实例分组。

2. 语言引导的对象检索

表2 :Replica数据集上的对象检索性能

解读 :这个实验评估了系统根据自然语言查询定位物体的能力。

- 结果 :在“描述性”查询中,利用DynamicGSG构建的层级场景图进行检索(HSG),其召回率(R@1达到0.71)远高于仅使用CLIP或LLM的基线方法。在更复杂的“功能性”(Affordance)和“否定性”(Negation)查询中,其性能同样领先。

- 定性分析(图5) :当查询“一个柜子上的咖啡壶”时,ConceptGraphs等方法由于无法理解“在...上”这种空间关系而失败,而DynamicGSG能够利用其层级场景图成功定位。

3. 动态场景更新

图6 :动态更新的可视化

表5 :真实世界动态更新成功率

解读 :这是最能体现DynamicGSG“动态”特性的实验。研究人员在真实实验室中手动改变场景(如拿走背包、移动桌子、交换书本位置等)。

- 结果 :系统能够可靠地检测到这些变化,并对高斯地图和场景图进行相应的局部更新。总体成功率达到了88.8%(表5)。例如,在(a)中,系统成功检测到背包和垃圾桶的消失,并从地图中移除了它们。在(b)中,系统检测到桌子和其上所有物品的整体移动。

- 结论 :这证明了DynamicGSG leveraging 3DGS的快速渲染和训练能力,使其能够有效地、实时地适应真实世界的动态变化。

总结

DynamicGSG的出现,是场景理解领域的一个重要里程碑。它成功地将现代计算机视觉的两大支柱——强大的视觉基础模型和高效的3D高斯溅射——与机器人学中经典的场景图概念进行了深度融合,并赋予了其前所未有的动态适应能力。

通过创新的3D-2D联合关联策略和实例特征损失,DynamicGSG解决了在3DGS上进行精确物体级分割和分组的核心难题。更重要的是,它利用3DGS的显式和高效特性,真正实现了一个能够与物理世界保持同步的“活地图”,让机器人不仅能“看懂”世界,更能“看清”世界的变化。这项工作为机器人在复杂、动态、长时程的人类环境中执行任务,铺平了坚实的道路。

文章地址:https://arxiv.org/pdf/2502.15309敬请期待我们的下一篇文章!欢迎加入我们关于SLAM&大模型&Agent&具身智能学术交流群。

点击订阅公众号 | 前沿机器人学术成果每日更新

SLAM专栏第53篇文章 | 欢迎点赞推荐关注

SLAM专栏- SplaTAM:一种融合3D高斯溅射,实时构建高保真三维世界的方法

- TAMBRIDGE :一种桥接传统与现代,实现鲁棒、实时、高保真SLAM的方法

- GS-SDF :一种融合激光雷达与神经SDF,实现几何一致性高斯溅射渲染的方法

- LiGSM :一种融合激光雷达与高斯溅射,实现高精度与鲁棒建图的方法

- DQO-MAP :一种融合对偶二次曲面与高斯溅射,实现多物体实时位姿估计与重建的方法

注:本公众号发布的内容仅用于信息传递与知识分享,不保证绝对准确,也不构成专业建议。因使用内容造成的任何损失,我们概不负责。 若公众号含外部链接,链接内容及运营不受我们控制,由此产生的风险和损失,读者自行承担。此外,原创内容版权归本号所有。因不可抗力、技术故障等致内容异常,本号同样免责。阅读即视为同意本声明,如有侵权,联系删除。

浙公网安备 33010602011771号

浙公网安备 33010602011771号