DeepSeekMath-V2解读

1. 总结

DeepSeekMath-V2 是 DeepSeek-AI 开发的、面向自验证数学推理的大语言模型,它针对传统基于最终答案奖励的强化学习(RL)在数学推理中存在 “正确答案不代表正确推理” 及 “无法适用于定理证明” 的局限,通过训练LLM-based 验证器(含元验证机制以减少虚假问题标注)和以验证器为奖励模型的证明生成器,构建 “验证器优化生成器、生成器产生难验证样本反哺验证器” 的协同循环,并借助规模化验证计算实现自动标注;该模型在竞赛中表现优异,在 IMO 2025、CMO 2024 获金牌级成绩,Putnam 2024 取得 118/120(超人类最高分 90),证明自验证数学推理是可行方向。

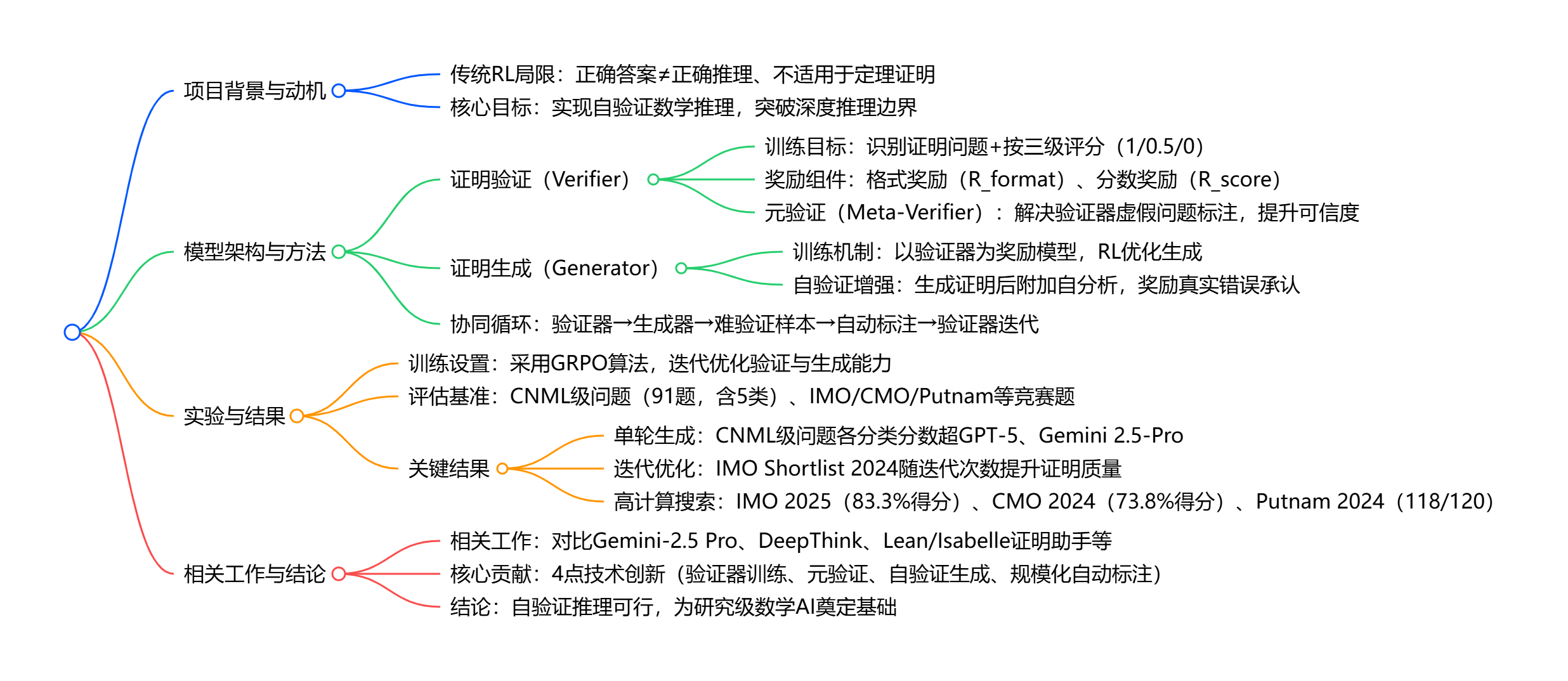

2. 思维导图(mindmap)

3. 详细总结

一、项目背景与核心动机

传统大语言模型(LLMs)在数学推理中多采用 “基于最终答案奖励的强化学习(RL)”,虽能让模型在 AIME、HMMT 等侧重最终答案的竞赛中达到饱和性能,但存在两大根本性局限:

- 推理正确性与答案正确性脱节:模型可能通过错误逻辑或偶然误差得到正确答案,无法保证推理过程严谨;

- 不适用于定理证明任务:定理证明需严格分步推导,无需数值答案,最终答案奖励机制完全失效。

为突破上述局限,DeepSeek-AI 提出自验证数学推理方向,目标是让模型具备验证推理过程完整性与严谨性的能力,尤其适用于无已知解的开放问题,最终开发出 DeepSeekMath-V2 模型。

二、核心方法:验证器 - 生成器协同框架

2.1 证明验证器(Verifier)训练

验证器的核心功能是:给定问题X和证明Y,识别证明中的问题并按三级标准评分(1 = 完全正确、0.5 = 逻辑正确但有 minor 错误 / 遗漏、0 = 根本性错误)。

-

初始训练数据构建(冷启动):

- 从 AoPS 竞赛平台爬取 17,503 道题$ D_p $,优先选择数学奥林匹克、团队选拔测试及 2010 年后需证明的题目;

- 用 DeepSeek-V3.2-Exp-Thinking 生成候选证明,并通过多轮迭代优化提升严谨性;

- 随机抽样不同类型(代数、数论等)证明,由数学专家按评分标准标注,形成初始数据集 \(D_v = \{(X_i, Y_i, s_i)\}\) \(s_i\)为标注分数)。

-

RL 训练目标:基于 DeepSeek-V3.2-Exp-SFT(已在数学与代码推理数据上微调),结合两类奖励:

- 格式奖励\(R_{format}\):检查输出是否包含 “Here is my evaluation of the solution:” 及 “Based on my evaluation, the final overall score should be:”+boxed 分数;

- 分数奖励\(R_{score}\):基于预测分数\(s_i'\)与标注分数\(s_i\)的接近度。

-

元验证(Meta-Verification)机制:

为解决验证器 “预测正确分数但虚构问题” 的漏洞,引入元验证器评估验证器的分析质量:- 由专家按元验证标准\(I_{mv}\)标注验证器分析的质量,形成数据集\(D_{mv} = \{(X_i, Y_i, V_i, ms_i)\}\) 其中\(V_i\)为验证器分析,\(ms_i\)为质量分数;

- 训练元验证器\(\pi_{\eta}\),输出验证器分析的问题及质量分数;

- 将元验证分数\(R_{meta}\)融入验证器奖励函数,最终验证器在\(D_v\)验证集上的分析质量分从 0.85 提升至 0.96,且分数预测准确率不变。

2.2 证明生成器(Generator)训练

生成器以验证器为奖励模型,核心目标是生成高质量证明,并具备自我验证能力。

- 基础 RL 训练:目标函数为\(\max_{\theta} \mathbb{E}_{Y \sim \pi_{\theta}(\cdot|X)} [R_Y]\),其中\(R_Y\)是验证器对证明Y的评分。

- 自验证增强:

- 训练中要求生成器输出证明Y后,附加按验证器标准\(I_v\)撰写的自分析Z,并预测自评分\(s'\);

- 奖励函数结合 4 部分:格式奖励\(R_{format}(Y,Z)\)、证明评分(\(R_Y = s\))、自分析的元验证分数(\(R_{meta}(Z) = ms\)、自评分与真实评分的接近度(\(R_{score}(s',s)\)),权重设置为\(\alpha=0.76\)、\(\beta=0.24\);

- 奖励机制引导:鼓励真实承认错误、生成正确证明并准确识别其严谨性、主动排查并解决证明问题。

2.3 验证器 - 生成器协同循环

通过 “规模化验证计算” 维持两者差距,实现迭代提升:

- 生成器变强后产生 “难验证证明”,成为验证器的训练素材;

- 自动化标注流程(替代人工):

- 对每个证明生成n份独立验证分析;

- 对评分 0/0.5 的分析,生成m份元验证评估,多数确认则分析有效;

- 取最低有效评分作为证明标签,无问题则标 1,疑难问题转人工;

- 最终两训练迭代中,该流程完全替代人工标注,且标签与专家判断高度一致。

2.4 通俗理解:

DeepSeekMath-V2的整个体系由三部分构成:

- Proof Generator(证明生成器)

- Proof Verifier(证明验证器)

- Meta-Verifier(元验证器,验证器的验证器)

其中,生成器负责生成证明过程和答案。

验证器负责对生成器生成的结果进行验证,输出三种评分:

- 0 分:证明无效,有逻辑错误

- 0.5 分:部分合理,但存在缺陷

- 1 分:证明严谨完整

但是,仅通过验证器来评分是不够的,可能存在两个问题:

- 验证器乱判:胡乱指出并不存在的错误

- 验证器错判:把正确证明误判为错误

于是,通过引入元验证器,用来检查的验证器的判断是否可靠。

它会检查:

- 验证器找出的错误真的存在吗?

- 验证器打 0/0.5/1 的评分是否合理?

- 验证器是否在过度拟合生成器的风格?

这有点像是人类社会的“审核机制”:

学生(Generator) → 老师(Verifier) → 教研组长(Meta-Verifier)

整个训练流程如下:

- Generator 生成一份证明

- Verifier 提出所有问题

- Generator 依据 Verifier 的反馈修复证明

- Meta-Verifier 检查 Verifier 是否正确

- 综合奖励用于反向训练两个模型

其中,对于生成器构建额外的奖励机制:

- 忠实地承认错误比错误地声称正确性更能获得奖励

- 最高的奖励来自于提供正确的证明并准确地认识到其严格性

- 在最终响应之前识别并解决尽可能多的问题,才能拿到尽可能多的奖励

三、实验设置与关键结果

3.1 训练与评估基础信息

| 类别 | 关键细节 |

|---|---|

| 训练算法 | Group Relative Policy Optimization(GRPO,Shao et al., 2024) |

| 模型基础 | 基于 DeepSeek-V3.2-Exp-Base 开发 |

| 评估基准 | 1. CNML 级问题(91 题:代数 13、几何 24、数论 19、组合 24、不等式 11);

|

| 评估方式 | 单轮生成(8 份样本 + 8 份验证分析投票)、迭代优化(32 个独立线程)、高计算搜索(64 份初始样本 + 16 轮迭代) |

3.2 核心实验结果

- CNML 级问题单轮生成:DeepSeekMath-V2 在所有 5 个分类(代数、几何、数论、组合、不等式)的平均证明分数均超过 GPT-5-Thinking-High 和 Gemini 2.5-Pro,展现跨领域优势;

- IMO Shortlist 2024 迭代优化:

- 随迭代次数(1→8)增加,Pass@1(单线程最终分数)显著提升;

- Best@32(32 线程最优分数)远高于 Pass@1,证明生成器能准确评估自身证明质量并引导优化;

- 高难度竞赛表现:

竞赛 解题情况 得分 / 表现 IMO 2025 6 题中解决 5 题(P2、P3、P4、P5 等) 83.3%,金牌级 CMO 2024 6 题中解决 4 题(P2、P4、P5、P6),1 题获部分分数 73.8%,金牌级 Putnam 2024 12 题中 11 题完全解决,1 题有 minor 错误 118/120,超人类最高分 90 IMO-ProofBench 基础集分数超 DeepMind 的 DeepThink(IMO Gold) 进阶集与后者竞争力相当,超其他基线 -

四、相关工作与结论

4.1 相关工作对比

- 传统推理模型:OpenAI、Guo et al.(2025)的模型虽饱和 AIME 等基准,但依赖最终答案奖励,无法应对定理证明;

- 自验证相关模型:Gemini 2.5-Pro 具备基础自验证能力,DeepMind 的 DeepThink(Luong and Lockhart, 2025)获 IMO 2025 金牌,证明 LLM 验证复杂证明可行;

- 形式化证明助手:Lean、Isabelle 需形式化语言,AlphaProof(2024)获 IMO 2024 银牌但计算成本高,而 DeepSeekMath-V2 聚焦自然语言证明,更贴近人类推理习惯。

4.2 核心贡献与结论

- 核心技术贡献:

- 训练出准确且可信的 LLM-based 数学证明验证器;

- 引入元验证机制,大幅减少验证器的虚假问题标注;

- 通过自验证奖励,引导生成器主动优化证明质量;

- 规模化验证计算实现难验证证明的自动标注,支撑验证器迭代。

- 结论:自验证数学推理是可行方向,DeepSeekMath-V2 在顶级数学竞赛中的表现证明 LLMs 可具备复杂推理的自我评估能力,为开发研究级数学 AI 系统奠定基础。

4. 关键问题

问题 1:DeepSeekMath-V2 如何解决传统基于最终答案奖励的 RL 在数学推理中的核心局限?

答案:传统 RL 的核心局限是 “正确答案不代表正确推理” 和 “不适用于定理证明”,DeepSeekMath-V2 通过三方面解决:

- 转向过程验证:放弃单一最终答案奖励,训练验证器评估证明过程的严谨性(按 1/0.5/0 三级评分),确保推理与答案一致;

- 适配定理证明:验证器以 “分步推导的完整性” 为评估核心,无需依赖数值答案,完美适配定理证明任务;

- 自验证闭环:让生成器具备自我验证能力(生成证明后附加自分析),并通过奖励机制鼓励真实承认错误、主动优化推理过程,而非依赖外部反馈,从根本上摆脱对 “已知答案” 的依赖。

问题 2:元验证机制在 DeepSeekMath-V2 的验证器训练中起到什么作用?如何实现?

答案:元验证机制的核心作用是解决验证器 “预测正确分数但虚构证明问题” 的漏洞,提升验证器的可信度,具体实现分三步:

- 构建元验证数据集:先训练初始验证器,再由数学专家按元验证标准(\(I_{mv}\))标注验证器分析的质量,形成\(D_{mv} = \{(X_i, Y_i, V_i, ms_i)\}\),其中\(ms_i\)为验证器分析的质量分数);

- 训练元验证器:元验证器\(\pi_{\eta}\)输入问题X、证明Y和验证器分析V,输出验证器分析中的问题及质量分数,训练目标与验证器一致(含格式、分数奖励);

- 融入验证器奖励:将元验证器给出的质量分数(\(R_{meta}\))加入验证器的 RL 奖励函数,最终使验证器在\(D_v\)验证集上的分析质量分从 0.85 提升至 0.96,同时保持分数预测准确率不变,有效消除虚假问题标注。

问题 3:DeepSeekMath-V2 在 Putnam 2024 竞赛中取得 118/120(超人类最高分 90)的关键技术支撑是什么?

答案:该成绩依赖三大关键技术支撑,形成 “高质量生成 + 严谨验证 + 高效迭代” 的闭环:

- 验证器 - 生成器协同优化:生成器以验证器为奖励模型,通过 RL 学习生成符合严谨性标准的证明;同时生成器产生的 “难验证证明” 反哺验证器,通过规模化计算自动标注,提升验证器能力,两者形成正向循环;

- 自验证引导的迭代 refinement:生成器不仅生成证明,还需按验证器标准进行自分析,奖励机制鼓励其主动排查错误(如承认未解决的问题),而非盲目输出 “伪正确” 证明,确保每轮生成都向严谨性靠近;

- 高计算搜索策略:对难题采用 “64 份初始证明样本 + 64 份验证分析” 初始化候选池,每轮筛选 64 个最高分证明,各配对 8 份问题分析以生成优化证明,迭代 16 轮或直至证明通过所有 64 次验证,通过大规模并行计算覆盖更多证明路径,找到最优解,而人类难以在有限时间内完成如此量级的推理尝试。

浙公网安备 33010602011771号

浙公网安备 33010602011771号