Logistic 回归与Softmax 回归

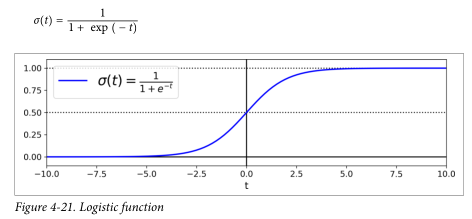

Logistic Regression(逻辑回归):用来预测样本属于两个类别0或者1的概率。

因为逻辑回归是Sigmoid函数,所以输出0到1之间的数字,这个值就是属于各自类别的概率。

若概率大于0.5,则认为该样本属于类别1,概率低于0.5则属于类别0

训练逻辑回归模型:

1. 铰链损失(Hinge Loss):主要用于支持向量机(SVM) 中;

2. 互熵损失 (Cross Entropy Loss,Softmax Loss ):用于Logistic 回归与Softmax 分类中;

3. 平方损失(Square Loss):主要是最小二乘法(OLS)中;

4. 指数损失(Exponential Loss) :主要用于Adaboost 集成学习算法中;

5. 其他损失(如0-1损失,绝对值损失)

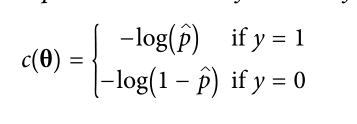

在二分类问题中,对于单一的样本,有如下损失函数

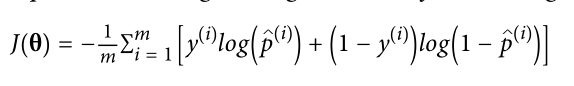

那么对于样本集,损失函数如下:

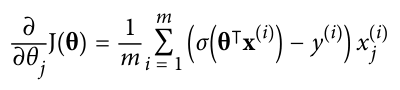

对于这个函数,可以使用梯度下降求解

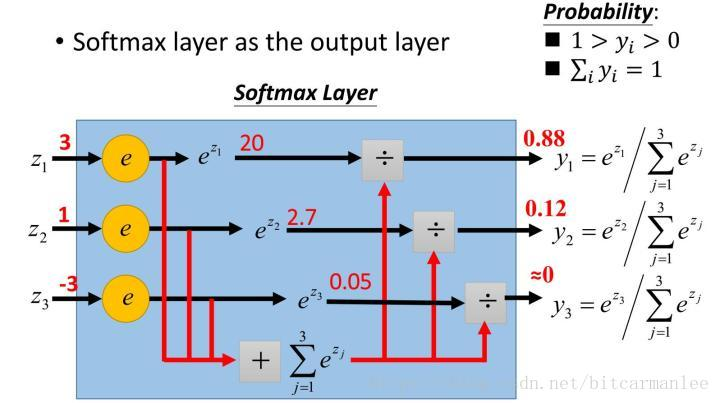

Softmax Regression:一次只能预测一个类,所以它只能用于互斥的类别,比如不同类型的植物。

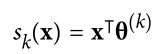

函数如下

(摘自网上)

注意:每个类都有自己专用的参数向量,k代表类别

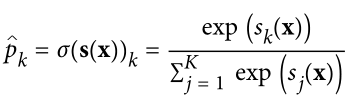

当计算完每个类别的分数后,就可以通过softmax函数通过得分来估计实例属于类k的概率。

Softmax回归分类器与Logistic回归分类器一样,预测估计概率最高的类

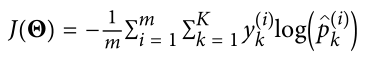

利用交叉熵损失函数训练Softmax Regression Classifier

从上式可知,当只有两个类(K = 2)时,这个代价函数等价于Logistic回归的代价函数

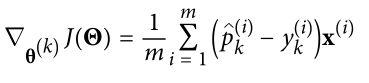

利用梯度下降最小化代价函数

浙公网安备 33010602011771号

浙公网安备 33010602011771号