续啃:编程指北 C++ (从 RAII开始的,RAII这一小节,学了将近两个月,RAII 的内容早在之前就主动追问豆包搞懂了,这节主要是自己无尽追问探索出很多其他知识,后来发现其实堪比精啃 CSAPP & APUE 等圣书)

关于 C++ RAII 思想机制详解:(这里之前自己主动探索过,根本不需要学啥,但自己又主动探索到了个其他东西,他妈的超级大超级大的血案,浪费了一个半月!!)(尸山血海异常痛苦~~~~(>_<)~~~~)(堪比赵云七进七出反复抽插底层涉及到完全不考的东西妈逼的钻研了将近两个月)(堪比精啃 CSAPP & APUE 等经典圣书!)

没想到一直牵扯出这么多知识点,所有涉及到此文搜的东西,搜不到就去上一篇的《编程指北 C++》里搜

作者原文:

资源获取即初始化( Resource Acquisition Is Initialization,简称RAII )是一种 C++ 编程技术,它将在使用前获取(分配的堆内存、执行线程、打开的套接字、打开的文件、锁定的互斥量、磁盘空间、数据库连接等有限资源)的资源的生命周期与某个对象的生命周期绑定在一起。

确保在控制对象的生命周期结束时,按照资源获取的相反顺序释放所有资源。

同样,如果资源获取失败(构造函数退出并带有异常),则按照初始化的相反顺序释放所有已完全构造的成员和基类子对象所获取的资源。

这利用了核心语言特性(对象生命周期、作用域退出、初始化顺序和堆栈展开),以消除资源泄漏并确保异常安全。

这段话我看个开头一句就知道自己会!之前代码涉及过!

RAll的原理

核心思想就是:利用栈上局部变量的自动析构来保证资源一定会被释放。

因为我们平常 C++ 编程过程中,经常会忘了释放资源,比如申请的堆内存忘了手动释放,那么就会导致内存泄露。

还有一些常见是程序遇到了异常,提前终止了,我们的资源也来不及释放。

但是变量的析构函数的调用是由编译器保证的一定会被执行,所以如果资源的获取和释放与对象的构造和析构绑定在一起,就不会有各种资源泄露问题。

RAII 类实现步骤:

设计一个类封装资源,资源可以是内存、文件、socket、锁等等一切

在构造函数中执行资源的初始化,比如申请内存、打开文件、申请锁

在析构函数中执行销毁操作,比如释放内存、关闭文件、释放锁

使用时声明一个该对象的类,一般在你希望的作用域声明即可,比如在函数开始,或者作为类的成员变量

先科普几个东西:

C 语言中用

fopen打开文件,fclose关闭,需手动管理:#include <stdio.h> int main() { FILE* fp = fopen("example.txt", "r"); // 打开文件,"r"为只读模式 if (fp == NULL) { // 必须检查是否打开成功 perror("Failed to open file"); return 1; } // 操作文件(如fread、fgets等) fclose(fp); // 必须手动关闭,否则资源泄漏 fp = NULL; // 避免野指针 return 0; }模式:

"r"(读)、"w"(写,覆盖)、"a"(追加)等。风险:若忘记

fclose或中途异常退出,会导致文件描述符泄漏,需手动保证配对调用,不如 C++ 的ifstream(RAII)安全。操作系统对进程能打开的文件描述符数量有限制,若反复打开文件却不关闭,会耗尽资源,后续fopen会失败(返回NULL)。程序退出后操作系统会回收资源,但长期运行的服务端程序就会有问题。例如:循环中反复

fopen而不fclose,很快会因 “打开文件数超限” 崩溃。这也是 C++ 的ifstream(RAII 自动关闭)比 C 的fopen更安全的核心原因。C++ 流对象(如

ifstream/ofstream)析构时自动调用close(),无需手动操作异常退出指程序未按正常流程结束,比如:

主动调用

exit()、abort()强制终止;发生未捕获的异常(C++)、段错误(如访问野指针)、除零错误等崩溃;

被外部信号终止(如

kill命令、Ctrl+C)。短期或单次运行的程序,异常退出后未释放的资源(如文件描述符)会被操作系统回收,看似 “不管也行”。但在长期运行的服务端程序中,若程序频繁异常退出(如偶发崩溃),每次退出前未释放的资源(即使 OS 会回收)可能导致瞬时资源占用峰值,影响系统稳定性;更关键的是:异常退出前,未

fclose的文件可能存在数据未刷新的问题(如写操作缓存未同步到磁盘),导致数据丢失。

fclose会先刷新缓冲区(确保数据写入文件),再释放文件描述符。而 RAII 机制(如

ifstream)在多数异常场景下会触发析构,确保资源释放和数据一致性,这也是服务端开发必须重视的原因。引出

ifstream:1、资源获取与释放:

fopen需手动调用fclose释放文件描述符,且必须保证配对(漏写或异常退出可能导致泄漏);

std::ifstream的myfile对象构造时打开文件(获取资源),析构时自动调用关闭逻辑(类似fclose,包括刷新缓存、释放描述符),无需手动干预,RAII 机制确保 “获取即管理,销毁即释放”。2、异常场景安全性:

若用

fopen后程序因异常(如崩溃、抛错)退出,fclose可能来不及执行,导致文件描述符泄漏或数据未刷新;

std::ifstream在对象生命周期结束时(即使异常退出触发栈解旋),析构函数一定会执行,避免上述问题。3、使用复杂度:

fopen需要手动检查返回值(是否为NULL)、管理关闭时机,逻辑冗余且易出错;

std::ifstream封装了打开 / 关闭细节,通过is_open()检查状态即可,代码更简洁,符合 C++ 封装思想。简单说:

fopen是 “手动挡”,需全程操控;std::ifstream是 “自动挡”,RAII 机制自动完成资源管理,更适合工程化开发(尤其服务端长期运行场景)。我艹!!突然发现这些之前自己主动探索过!!此文搜"AII。核心就是塞",妈逼的之前写成了

rall的大写,应该是raii的大写。这里说点其他的:

今天又学到个东西,相当高潮!!(实际花了大半个月!)

开始叙述:

由于作者给的代码好多封装的东西看不懂,先科普点自己查到的东西,主要就是针对

std::ifstream:

File类通过成员m_handle(std::ifstream对象)管理文件资源,构造时传入文件名并尝试打开(资源获取),析构时自动关闭文件(资源释放)。即使不手动调用

close(),File对象销毁时,m_handle的析构函数也会确保文件关闭,双层 RAII 嵌套(File依赖std::ifstream的 RAII)进一步保证安全性。然后运行作者代码报错了,发现

std::ifstream是输入文件流,用于读取文件,只尝试打开已存在的文件,若文件不存在则打开失败,不会自动创建新文件。如果需要 “文件不存在时自动创建”,应使用输出文件流

std::ofstream(或读写流std::fstream配合写入模式)C++ 流操作的模式与 C 语言

fopen的模式对应,比如:

std::ifstream默认对应fopen的"r"(只读,文件必须存在);

std::ofstream默认对应"w"(只写,文件不存在则创建,存在则清空);若需更灵活的模式(如追加、读写),可显式指定,例如:

std::fstream("file.txt", std::ios::in | std::ios::out)→ 对应"r+"(读写);

std::ofstream("file.txt", std::ios::app)→ 对应"a"(追加)。本质和

fopen的模式语义一致,只是 C++ 用枚举常量(std::ios::xxx)表示,更类型安全。先科普下涉及到的其他的一些东西,唉他妈烦,看到就要钻研弄懂:

关于

getline,死全家的狗逼豆包误人子弟!给我科普了这个:查看代码

#include <stdio.h> #include <stdlib.h> // 需用malloc/free int main() { char *line = NULL; // 存储读取的字符串(初始必须为NULL) size_t len = 0; // 缓冲区大小(初始设为0,会自动分配) ssize_t read; // 实际读取的字符数(含换行,不含结束符) // 从标准输入(键盘)读一行 read = getline(&line, &len, stdin); if (read != -1) printf("你输入了:%s", line); // 输出包含换行符 free(line); // 必须释放内存 }

getline:第 3 个参数(stdin)是从哪里读、第 1 个参数(&line)是存、第 2 个参数(&len)是记录存储结果用了多大空间(自动算好填进来)返回值:

成功:返回实际读取的字符数(包含换行符

\n,但不包含字符串结束符\0)。失败(如读到文件尾或出错):返回

-1。逐句分析:

#include <stdlib.h>:引入内存管理函数(比如free)的声明。

char *line = NULL;:定义一个指针,暂时不指向任何内存(后面由getline分配)。

size_t len = 0;:定义一个变量,记录line指向的内存块大小,初始为 0,函数会根据实际读取内容的长度,自动计算并更新len的值,让它等于当前缓冲区的实际大小(方便后续复用缓冲区时知道已有多大空间)。

ssize_t read;:定义一个变量,记录实际读到的字符数量(含换行)。

read = getline(&line, &len, stdin);:从键盘读一行内容到line,同时更新len为实际内存大小。

if (read != -1) {:判断是否成功读到内容(-1 表示失败)。

free(line);:释放getline给line分配的内存(必须做,否则内存泄漏)。实操过程:

你输入了

n个字节(包括空格、换行);函数自动找一块能放下

n+1个字节的内存(多 1 个存结束符\0);用

line指针指向这块内存(所以line会从NULL变成有效地址);把

n+1(实际占用的内存大小)存到len里。妈了个逼的!操.你妈!!结果这逼玩意是必须用纯 C 语言开发,且需要读取不确定长度的一行文本(比如处理用户输入的长句子、配置文件行等)才用的!

而且最主要的是狗逼豆包说错了!被我质疑出来的,上面这个代码只有 Linux 下可以,win 的 codeblock 编译报错。

C 是编程语言,有自己的标准库(ISO C),标准库里没有

getline。POSIX 是系统接口标准,Linux 等系统遵循它,在 C 语言的编译环境中额外加了

getline函数(属于 C 语言的 “扩展函数”,不是 C 标准自带)。即编译器扩展C++ 自己的标准库,自带

std::getlineACM 刷题中用的

getline是 C++ 标准库的std::getline,Windows 的 C 环境没有getline,Linux 的 C 环境有getline。回忆刷算法和以后大厂都是用 C++ 的

getline:C++ 的getline俩参数,从第一个参数读(一般是cin,即键盘),存到第二个参数(一个string变量)。#include <iostream> #include <string> using namespace std; int main() { string s; getline(cin, s); // 从cin读一行,直接放进s里 cout << s; // 输出s,完事 return 0; }不用管内存,不用记大小,

string会自动处理一切,C 的getline因为要手动管内存)C 的

getline返回字节数(含 \n),C++ 的std::getline返回流对象。准确说不是 C 的,是扩展。

然后再捋清楚几个东西(从底层到应用)

ios类(终极的最父类):最顶层的 “规则类”,这逼玩意跟苹果 IOS 完全不是一个东西

只负责 3 件事:定模式(

in/out等)、记状态(failbit等)、提供基础操作(open()/close())。不负责具体读写,只是给所有流类定标准,自身不包含

istream/ostream。

istream和ostream类:ios的直接子类,继承ios所有成员,没有stream都是加个i或者o各种前缀,另外那些人打游戏用的是 Steam

istream:继承ios的规则,新增读数据的方法(>>、getline()等,比如从键盘 / 文件读数据)。

ostream:继承ios的规则,新增写数据的方法(<<、write()等,比如往屏幕 / 文件写数据)。

ifstream/ofstream/fstream:文件专用流类继承

istream/ostream,把 “读 / 写方法” 绑定到文件上(比如ifstream用istream的>>从文件读)。

ifstream直接继承istream(是istream的子类,间接继承ios)。给istream增加 “操作文件” 的能力(专门读文件)。

ofstream直接继承ostream(是ostream的子类,间接继承ios)。给ostream增加 “操作文件” 的能力(专门写文件)。

iostream直接继承istream+ostream(同时是两者两者的子类)。整合读和写的功能(为第 4 层做基础)。

fstream类

地位:直接继承

iostream(是iostream的子类,间接继承istream/ostream/ios)。作用:给

iostream增加 “操作文件” 的能力(既能读又能写文件)。总结:

ios是顶层基类:

ios→istream(继承ios,负责 “读” 功能)→ifstream(继承istream,专门 “读文件”)同时:

ios→ostream(继承ios,负责 “写” 功能)→ofstream(继承ostream,专门 “写文件”)另外:

ios→istream和ostream(平级,都是ios的子类)→iostream→fstream(继承iostream,专门 “读写文件”,f是 file)注意:这里的

iostream同时继承istream和ostream,同时读 + 写功能,属缝合怪,没有自己的独立父类分支,而是把istream(读)和ostream(写)的功能 “缝合” 到一起,形成 “既能读又能写” 的基础类。fstream则是在这个 “缝合基础类” 上,再叠加 “文件操作能力”,所以能同时读写文件。关于使用:

可以直接初始化对象(直接定义实例)的类,都是绑定了具体输入输出设备的类,包括:

ifstream:直接初始化(绑定文件,用于读):ifstream fin("file.txt");初始化读文件对象

ofstream:直接初始化(绑定文件,用于写):ofstream fout("file.txt");初始化写文件对象

fstream:直接初始化(绑定文件,用于读写):fstream fs("file.txt");初始化读写文件对象

cin/cout:标准库已预定义的全局实例,分别绑定键盘 / 屏幕,是已经创建好的对象,直接用,而ifstream、ofstream、fstream是类,但你可以手动创建它们的实例(对象)来用,比如:ifstream fin;、fin ofstream fout;、fout fstream fs;不能 / 无需手动初始化对象的类:

ios/istream/ostream:纯基类,仅用于被继承,不直接绑定设备,手动初始化无意义(比如istream is;无法指定读哪里,没用)。

iostream:istream+ostream的派生类,同样不绑定具体设备,不可拿来初始化,也就是不能拿来创建对象,上面说的初始化就是创建对象,就是实例化,而fstream是它的子类,已绑定文件,用fstream即可。

继续巩固:

ofstream的对象(如fout)和cout都属于ostream家族,都能使用<<运算符进行输出(写操作),<<是ostream类重载的运算符,专门用于输出(写)操作,属于ostream类的成员功能。

ofstream是ostream的子类(继承关系),专门用于 “写文件”,可以创建对象(如ofstream fout;)。

cout是ostream类的全局对象(不是子类),由标准库预先创建,专门用于 “写屏幕”。

istream类的>>操作符用于读操作,ifstream的对象(如fin)继承自istream(读自文件),cin是istream类的全局对象(读自键盘),

cin >> x→ 从键盘读数据到x

fin >> x→ 从文件读数据到x

getline是istream类的成员函数,可用于istream家族的对象(包括cin和ifstream的对象):

getline(cin, str)→ 从键盘读一行到str

getline(fin, str)→ 从文件(fin关联的文件)读一行到str本质是专门为流式设计的“按行读”工具,和

>>一样属于读操作,只是更适合读取带空格的整行内容。

cin和cout:控制台流对象

cin是istream的实例(已经创建好的对象),专门用istream的>>从键盘读数据。

cout是ostream的实例,专门用ostream的<<往屏幕写数据。打个比方(仅结构,非比喻):

ios是 “地基”,istream/ostream是在地基上盖的 “房子”—— 房子用了地基的结构,但地基不包含房子本身。所以ios不 “包括”stream,stream是ios的 “继承者” 并扩展了功能。那

#include <iostream>是啥?这是一个头文件,作用是 “把

istream/ostream类的定义、cin/cout对象的声明” 加载到你的代码里。没有它,你写cin >> x或cout << x时,编译器不认识cin/cout和>>/<<,会报错。它间接包含了ios类的定义(因为istream/ostream继承ios,所以必须一起加载)。

为什么加

std::?因为这些类和对象都定义在std这个 “命名空间” 里(避免名字冲突)。嫌麻烦可以开头加

using namespace std;,之后直接写cout不用加std::。读字符串(用

getline)cin >>遇到空格会停,读整行必须用getline(cin, 变量)。你写

cout << "abc"时:cout是ostream的对象,继承了ios的规则;<<是ostream新增的写方法,负责把"abc"送到屏幕;整个过程遵循ios定的模式(默认out模式,允许写)。你写

cin >> age时:cin是istream的对象,继承了ios的规则;>>是istream新增的读方法,负责从键盘拿数据给age;遵循ios的in模式(允许读)。

>>从流中“读数据”,功能是将左侧流对象中的数据读取到右侧的变量中。

<<往流中“写数据”,功能是将右侧的数据发送到左侧的流对象中。

最常用的是

ifstream和ofstream:

ifstream读配置文件(比如服务启动参数、路由表)、读日志文件(分析历史数据):查看代码

ifstream fin("config.conf"); // 打开配置文件 if (!fin.is_open()) { // 必须判断是否打开成功(服务端必做) // 实际开发中会记录错误日志,然后退出服务 return -1; } string line; while (getline(fin, line)) { // 按行读配置 // 解析每行配置(比如"port=8080") } fin.close();

ofstream:写日志(服务运行状态、错误信息)、写临时文件(中间计算结果)。用法示例(写日志,追加模式):查看代码

// 追加模式(ios::app),每次写都加在文件末尾 ofstream fout("server.log", ios::app); if (!fout.is_open()) return -1; // 写日志(带时间戳,服务端常用格式) fout << "2025-11-15 10:00:00 [INFO] 服务启动成功" << endl; fout.close();偶尔使用

fstream,对文件进行读写混合操作(比如修改配置文件中的某个字段),fs.get(c)读取包括空格 / 换行的单个字符,>>跳过空白字符读取下一个有效字符(如字母、数字):查看代码

fstream fs("data.txt"); // 默认ios::in|ios::out(可读可写) if (!fs.is_open()) return -1; // 1. 先读:读取第3个字符(位置2) char c; fs.seekg(2); // 移动读指针到位置2 fs.get(c); // 读该位置的字符(这是“读”操作) cout << "读到的字符:" << c << endl; // 2. 再写:在位置5覆盖一个字符(这是“写”操作) fs.seekp(5); // 移动写指针到位置5 fs << 'x'; // 覆盖写 fs.close();以上这些是流啥的,然后继续说还有个东西就是模式,我反复追问,死全家的狗逼豆包给我解释了一天我都没懂,最后极致的追问然后自己总结完清晰易懂,豆包来了句“你的理解非常准确,核心点完全抓对了”操!就他妈不能自己主动这么说!!

这里反复追问真的浪费时间,但追问、和豆包配合的能力有了质的飞跃!!还是之前那句话,大模型现在就是个智障,整天被气死整天辱骂豆包,经常瞎编 C++规则,经常误人子弟,又墙头草无脑附和无脑道歉,但我如今会问、会分析、节省大量时间可以通过豆包来学知识,豆包回答专业问题错误肯定经常有,但如今学会了可以互相启发、合作,逐渐提问比如我只懂 1,提问深度 123,他解释 3 的时候有对有错,我学到 2 ,又重新根据 12 来提问,反复互相合作配合。这比没大模型的时候好多了!!如果不思考不追问嫌麻烦不是那块料一定会得出结论“豆包都是错的,自学用豆包就是扯淡”。再比如就是我问他,他回答让我明白些许,然后自己思考、捋顺,但经常里面夹杂着错误,我给他指出来,互相配合!

那些继承

ios的类是用来往屏幕或者文件读写的派生类,然后这个模式是是ios里写的,ios这个基类本身不能直接用,但可以ios::in这样用里面面模式,然后模式是对上面说的派生类读写的一种补充,或者说模式是给读写行为定规则,比如ofstream天生能写,但ios::trunc规定写之前清空,ios::app规定写只能追加到末尾,没有这些规则,写操作的行为就不明确。ios是抽象基类(不能直接创建对象),但它的成员(模式、状态标志、方法)通过 “继承” 被istream/ofstream等类 “拿过去用”,所以你操作ofstream时,本质是在间接用ios里的东西。继续深入:

ofstream的继承链是ios → ostream → ofstream,ios中的ios::in是一个模式常量(类似一个全局常量),所有继承ios的类(包括ostream)都能 “看到” 并ios::in使用它,但ostream的设计目标决定了它不会默认启用ios::in,也不实现任何读操作。能访问ios::in符号 ≠ 具备读资格,假设ios里定义了两个开关:class ios { public: static const int in = 1; // 读开关(符号) static const int out = 2; // 写开关(符号) int mode; // 当前启用的模式(默认0,啥都没开) };

ostream继承ios后,能看到in和out这两个符号,但它的构造函数里会主动设置mode = out(只开写开关):class ostream : public ios { public: ostream() { mode = out; // 主动启用写模式,不碰in } };

ofstream继承ostream后,直接用ostream设定的mode = out,也不会去改in:class ofstream : public ostream { // 继承了ostream的mode = out,不会启用in };这里的mode就是流内部记录 “当前启用了哪些模式” 的变量,和你打开文件时传入的模式参数(比如ios::out | ios::app)是一回事 ——打开文件时传入的模式,最终会赋值给这个mode变量,流的所有行为都以mode的值为准。当你写ofstream f("a.txt")时,背后发生的是:

ofstream调用父类ostream的构造函数;

ostream的构造函数会默认给mode赋值ios::out | ios::trunc(这就是 “主动设置”);最终

f的mode里只有out和trunc,没有in—— 所以无论ios里有没有in这个符号,f的mode里没它,就不具备读能力。如果手动传入模式,比如

ofstream f("a.txt", ios::out | ios::app),则:mode会被赋值为ios::out | ios::app(覆盖默认的trunc),但依然没有in。

ofstream并非主动拒绝in,而是设计时就没把in放进mode模式参数是是覆盖默认,每个流类都有自己的默认

mode,ofstream默认mode = ios::out | ios::trunc;当你手动传模式(如ios::out | ios::app),新的mode会完全替代默认值,而不是和默认值取并集。查看代码

ofstream f1("a.txt"); // 默认 mode = out | trunc(覆盖原文件) ofstream f2("a.txt", ios::app); // 实际 mode = out | app(追加,覆盖了默认的 trunc),ofstream 有个特殊规则:无论手动传入什么模式,ios::out 都会被强制包含

ios::out和<<是 “写操作” 的两个不同层面

ios::out:是权限开关(模式),作用是 “允许流进行写操作”。没有ios::out,流就没有写权限,任何写操作(包括<<)都无法执行。例如ofstream f("a.txt")能写,正是因为它默认带ios::out权限。

<<:是具体的写操作工具(运算符),作用是 “把数据实际写到流里”。它必须在有ios::out权限的前提下才能用,否则会失败。例如f << "hello"是用<<这个工具,把 “hello” 写到文件里,而这一切的前提是f有ios::out权限。简单说:

ios::out是 “允许写的资格”,<<是 “执行写的动作”—— 有资格才能动作用,动作用依赖资格存在。

ios作为基类,包含了所有流的通用功能(模式、状态等),但它本身不直接实现 “读” 或 “写” 的具体操作。

istream和ostream是ios的两个直接子类,分别专注于 “读” 和 “写”:

istream继承ios后,通过继承获得ios::in模式(允许读权限),然后在这个基础上,主动实现并重载了>>运算符,即只扩展实现了 “读” 相关的操作(如>>、getline()),不涉及 “写”。

ostream继承ios后,通过继承获得ios::out模式(允许写权限),然后在这个基础上,主动实现并重载了<<运算符,即只扩展实现了 “写” 相关的操作(如<<、write()),不涉及 “读”。那说一个,另一个同理:

getline(流成员函数)和>>运算符重载,来源和依赖完全一致:

来源相同:两者都是

istream类(继承自ios)中定义的 “读操作工具”——>>是运算符重载,getline是成员函数,都属于istream对 “读功能” 的具体实现。依赖相同:两者都必须基于

ios::in模式(读权限)才能工作 —— 没有ios::in,流对象不具备读权限,无论是>>还是getline都会失败(触发failbit)。操作对象相同:都作用于

istream及其子类对象(如ifstream、cin),本质是通过这些对象的读权限和底层接口完成数据读取。继续(有重复内容,但就像手机录解锁屏幕指纹一样,逐渐修正完善):

ofstream继承并直接使用ios中的这些核心内容:

模式常量:

默认使用

ios::out(写权限)和ios::trunc(写时清空文件),这两个是ios中定义的模式,决定了ofstream天生能写且默认覆盖文件。可手动添加

ios::app(追加)、ios::binary(二进制必须用这个,否则乱码)等ios模式,修改写行为。状态标志及判断方法:

使用

ios中的failbit、goodbit等状态标志,通过ofstream的fail()、good()等方法(继承自ios)判断写操作是否成功。基础方法:

继承

ios的open()、close()、is_open()等方法,用于打开 / 关闭文件、检查文件是否打开成功。简单说:

ofstream所有与 “写规则”“状态判断”“文件管理” 相关的底层支持,都来自ios。看几个常用的:

核心类:

ifstream(读文件)、ofstream(写文件)、fstream(读写文件)。继承关系:

ios←istream/ostream←ifstream/ofstream/fstream。常用模式(

ios中定义):ios::in(读权限)、ios::out(写权限)、ios::trunc(写时清空)、ios::app(写时追加)。类与模式的默认绑定:

ifstream默认带ios::in;

ofstream默认带ios::out | ios::trunc;

fstream默认带ios::in | ios::out。基础操作:

打开:

ifstream fin("a.txt")或fin.open("a.txt");判断打开成功:

if (!fin.is_open()) { /* 错误处理 */ };读:

getline(fin, line)或fin >> var;写:

fout << "text"或fout.write(buf, size);关闭:

fin.close()。状态判断(

ios方法):fin.good()(正常)、fin.fail()(失败)、fin.eof()(到文件尾)。C++ 中,流是 “数据传输的抽象”,所有数据的输入输出(比如从键盘读、往屏幕写、从文件读、往文件写)都被统一称为 “流操作”。

总结几个东西:

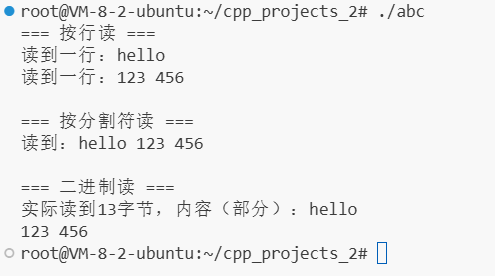

三大主要功能之一:打开文件(3 种方式)

查看代码

#include <fstream> #include <string> using namespace std; int main() { // 方式1:定义时直接打开(推荐,简单) ifstream fin("input.txt"); // 读文件,默认ios::in ofstream fout("output.txt"); // 写文件,默认ios::out|trunc // 方式2:先定义,后用open()打开(灵活,可动态指定文件名) fstream fs; string filename = "data.txt"; fs.open(filename, ios::in | ios::out); // 读写已有文件 // 方式3:指定特殊模式(追加/创建读写) ofstream fapp("log.txt", ios::app); // 追加模式(不清空,末尾加内容) fstream fcreate("newfile.txt", ios::out); // 创建并读写(无ios::in,文件不存在则创建) // 关键:打开后必须判断是否成功!(大厂必做,防止崩溃) if (!fin.is_open()) { // 实际开发中会打日志,这里简化用cout cout << "打开input.txt失败!可能文件不存在" << endl; return -1; } // ... 操作文件 ... // 关闭文件(虽然后台会自动关,但手动关是好习惯) fin.close(); fout.close(); fs.close(); }三大主要功能之二:读文件(3 种常用方式)

查看代码

/* input.txt里是 hello 123 456 */ #include <fstream> #include <iostream> #include <string> using namespace std; int main() { // 1. 定义ifstream对象fin,打开文件"input.txt" ifstream fin("input.txt"); // 等价于 ifstream fin; fin.open("input.txt"); // 必须判断文件是否打开成功(核心步骤,缺一不可) if (!fin.is_open()) { cout << "文件打开失败!可能原因:文件不存在或权限不足" << endl; return -1; // 打开失败就退出,避免后续操作崩溃 } // 2. 按行读取(方式1) cout << "=== 按行读 ===" << endl; string line; while (getline(fin, line)) { // getline成功读取一行时返回true,到文件尾返回false cout << "读到一行:" << line << endl; } // 注意:按行读完后,文件指针已经到末尾了,需要重置指针才能继续用其他方式读 fin.clear(); // 清除之前的"到文件尾"状态 fin.seekg(0, ios::beg); // 把读指针移回文件开头(ios::beg表示从文件开始算) // 3.· 按空格/换行分割读(方式2) cout << "\n=== 按分割符读 ===" << endl; string s; int a, b; fin >> s; // 读第一个单词"hello"(遇到空格停止) fin >> a; // 读整数123(遇到非数字停止,这里是换行) fin >> b; // 读整数456 cout << "读到:" << s << " " << a << " " << b << endl; // 再次重置指针,准备二进制读 fin.clear(); fin.seekg(0, ios::beg); // 4. 二进制方式读(方式3) cout << "\n=== 二进制读 ===" << endl; char buffer[1024] = {0};//很重要 fin.read(buffer, sizeof(buffer)); // 尝试读1024字节到buffer int bytes_read = fin.gcount(); // 获取实际读到的字节数(可能小于1024) cout << "实际读到" << bytes_read << "字节,内容(部分):" << buffer << endl; // 5. 关闭文件(虽然后台会自动关,但手动关是好习惯) fin.close(); }

解释代码:

clear()清除流的 “错误状态标志”(比如文件读完的eofbit、操作失败的failbit)。不清的话:

流会一直处于 “错误状态”,后续所有读写操作都会直接失败(比如读完文件后,不

clear()就无法重新读)。流有错误状态时,默认会停止读取(>>、read()等操作会失效)必须用

clear()重置状态,流才能恢复正常操作。只有当流处于 “错误状态”(比如读完文件触发

eofbit、操作失败触发failbit)时,才需要clear()重置。如果流状态正常(goodbit有效),clear()可调用可不调用,不影响后续操作。

fin.seekg(0, ios::beg)是移动文件的 “读指针” 到指定位置:

seekg:专门用于移动 “读指针” 的函数(g代表 get,读操作)。

0:偏移量(移动的字节数)。

ios::beg:偏移的基准位置(beg代表 beginning,文件开头)。合起来:把读指针移到 “从文件开头算起,偏移 0 字节” 的位置 → 也就是文件的最开头。作用:读完文件后,指针会停在末尾,用这句能把指针移回开头,重新读取文件内容。

cout << "\n=== 按分割符读 ===" << endl; string s; int a, b;:从

fin关联的文件(这里是input.txt)中读。

fin是ifstream对象,已通过ifstream fin("input.txt")绑定到input.txt文件。fin >> sfin >> a这些操作,本质是从fin对应的文件中,按空格 / 换行分割读取数据。简单说:>>左边是哪个流对象(这里是fin),就从哪个流(文件)读。

<<尖朝左,右数据向左流(写);>>尖朝右,左流向右变量(读)。死全家的豆包妈逼的连<<尖端朝左还是右都搞不清翻来覆去犯错误误人子弟!起初输出的最后一行是:

123 456 ////////////,是没是未初始化缓冲区的垃圾值,用char buffer[1024] = {0}初始化就好了。

豆包误人子弟误打误撞学到个东西:

Windows 换行符

\r\n在 Linux 下的残留(所以 txt 文件要用),ws是 C++ 标准库定义的输入操纵符,当用于fin >> ws时,会从输入流fin中连续提取所有空白字符(空格 、换行\n、制表符\t等),直到遇到第一个非空白字符为止。这些被提取的空白字符不会被存储,仅会被从流中移除。Windows 的文本文件,

\n会被转换成\r\n(回车 + 换行)。Linux 的文本文件,换行是\n

input.txt如果在 Windows 下创建,换行是\r\n。当 Linux 下的程序读这个文件时:

按行读(

getline)会正常处理\r\n,把hello world\r\n当成一行,输出没问题。但重置指针后按

>>读时,\r会被当成 “不可见的残留字符”。当程序读完hello后,下一个要读的是world\r\n123 456,>>遇到\r会认为是 “非数字字符”,导致读取123失败,a和b就被赋默认值 0。解决办法(针对跨系统文件):

让文件用 Linux 格式保存:在 VSCode 里打开

input.txt,右下角点 “CRLF”(Windows 格式),改成 “LF”(Linux 格式),保存后换行符会变成\n,问题直接消失代码里兼容两种格式:读数字前用

ignore()跳过可能的\r:fin >> s; // 读hello fin.ignore(1, '\r'); // 跳过可能的回车符 fin >> a; // 读123 fin.ignore(1, '\r'); // 再跳过可能的回车符 fin >> b; // 读456

关于

fin.ignore(numeric_limits<streamsize>::max(), '\n'):他是一个用于精准删除输入流中特定内容的操作,具体特性如下:它会从流的当前位置开始,连续删除字符,直到满足以下两个条件中的任意一个:

已删除的字符数达到

numeric_limits<streamsize>::max()(一个极大值,可视为 “无限”);遇到了第二个参数指定的字符(例如

'\n'),此时会连这个字符一起删除。第二个参数(

'\n')可以替换为任意字符。结合指针定位(seekg)可以去掉任意位置后的东西。

fin.ignore(...):从当前位置开始,跳过最多max()个字符,直到遇到指定分隔符(如'\n'),会连分隔符一起跳过。关于

fin >> ws:仅跳过流开头的所有空白(空格、换行等),不跳过非空白内容。区别:

fin >> sfin >> a这些操作,本质是从fin对应的文件中,按空格 / 换行分割读取数据。

读取

int时,会自动忽略整数前的所有空白字符(空格、换行、制表符等)

突然想起网络编程的那个 Linux 的系统调用的 read,哎,强迫症又去追问好久,狗逼豆包误人子弟真的痛苦,真的!!用豆包自学真的有种要习惯吃屎往下咽的感觉:

read函数的原型,定义在istream类中,是 C++ 标准库封装的流方法按流模式(文本 / 二进制)从流中读取指定字节数,原型

istream& read(char* s, streamsize n);,意思是返回值是istream&类型,表示该函数返回一个istream类对象的引用(即流对象本身),为了支持链式调用,比如fin.read(buf, 10).read(buf2, 5);,前一个read返回流对象fin,接着可以继续调用它的read方法。比如:

fin.read(buffer, size)

参数 1 :存哪?

参数 2 :要读几个字节?

返回值:

istream&(返回流对象本身,支持链式调用,虽然很少常用)。用

gcount()获取实际读取的字节数。如果要读 100 个,存的内存是 8,那只能读 8 个。

Linux 的

read是系统调用(用于网络编程的),直接操作文件描述符(整数),从内核缓冲区读取原始字节,语法:read(fd, buffer, size)。起初以为二者完全不是一个东西,但有关系且都读二进制:

查看代码

C++ 代码:ifstream.read(buffer, size); ↓ C++ 标准库:std::basic_istream::read() 方法(属于ios的) ↓ Linux 系统调用:read()(内核处理实际的文件 I/O)(<unistd.h>)然后开始逐渐深入说点东西:

C++ 的 read 是否也涉及到文件描述符?

1. 关于

read和文件描述符

C++ 的

ifstream::read:C++ 标准库提供的函数,属于用户态代码。不直接操作文件描述符。Linux 的

read():它是操作系统提供的系统调用,属于内核态接口。它必须通过文件描述符来操作文件、套接字等资源。核心关系:

ifstream::read内部会调用read()系统调用。你在 C++ 代码中创建ifstream对象时,标准库会请求操作系统打开文件,操作系统会创建一个file对象并返回一个文件描述符。ifstream对象会持有并管理这个文件描述符,当你调用read时,它会把这个文件描述符作为参数传递给底层的read()系统调用,从而完成实际的数据读取。一句话总结:C++ 的

read是包裹着系统调用read()的 “壳”,它负责管理文件描述符等细节,让你不用直接和内核打交道。2. 到底咋理解内核和内存

内核 (Kernel):

操作系统的核心,是硬件和软件之间的桥梁。

它管理着所有硬件资源(CPU、内存、磁盘、网卡等)。

它运行在内核态,拥有最高权限,可以直接访问硬件。

像

read()、write()、socket()这些系统调用,就是你的程序请求内核帮忙做事的 “接口”。内存 (Memory):

程序运行时存放数据和指令的地方,速度远快于磁盘。

为了安全和稳定,内核将内存划分为两部分:

内核空间 (Kernel Space):只有内核可以访问的区域,存放着内核代码和数据结构(比如文件描述符表、进程控制块等)。

用户空间 (User Space):普通应用程序(比如你的 C++ 程序)运行的区域。应用程序不能直接访问内核空间,也不能直接操作硬件。

我自己的理解(经过豆包肯定):操作系统运行在内核态也就是内存里内核空间,这里是总的最高权限的指挥中心,程序员的代码无法触碰操控这里,想操控必须用 read,然后这个 read 做一个跑腿的中间人去和指挥中心对接。

然后先知晓几个专业术语,以便于接下来深入抽插:页缓存(Page Cache):这是内核在内存(内核空间)中开辟的一块区域,专门用来临时存放从磁盘上读取的数据。目的是为了提高性能。

串联实际过程:你的 C++ 程序运行在用户空间。当它需要读取文件时,它不能自己去访问磁盘,必须通过

read()系统调用请求内核(运行在内核空间)帮忙。内核接收到请求后,会:

检查自己的缓冲区(页缓存,属于内核空间)。如果找到了(缓存命中),内核就直接从页缓存里把数据复制到你提供的用户空间的

buf里。这个过程很快,因为数据已经在内存里了。- 如果没找到(缓存未命中),内核就会发起一个磁盘 I/O 操作,真正去磁盘上把数据读取到内核的页缓存中。

然后,内核再把数据从内核空间复制到你的程序提供的用户空间内存(比如你的

buf数组)中。再继续梳理并深入:

内存分为:用户内存空间 & 内核内存空间

用户空间没有系统级缓存,缓存只在 kernel 空间(页缓存是核心)。

写个缓存数组是用户空间缓存

串联:

在read()系统调用的内核处理流程中,确实只涉及内核的页缓存,不直接涉及用户空间的缓存。让我来澄清一下这两者的关系:

内核的页缓存 (Page Cache):

位置: 内核空间。

管理: 由操作系统内核统一管理。

目的: 作为磁盘数据在内存中的高速缓存,避免频繁的磁盘 I/O,加速所有进程对文件的读取操作。

read()流程中如何工作: 当你调用read(),内核首先检查页缓存。如果数据在缓存里,就直接从缓存复制到你的用户缓冲区;如果不在,就去磁盘读,读完后先存入页缓存,再复制到你的用户缓冲区。用户的缓存 (比如你写的

my_buffer):

位置: 用户空间。

管理: 由你的应用程序自己管理。

目的: 为了你的应用程序自身的性能优化。

与

read()的关系: 它是read()调用的目的地,而不是read()流程的一部分。read()最终会把数据从内核空间(页缓存)复制到你指定的这个用户空间的缓存里。举一个完整的例子,把两者串起来:假设你的程序要读取一个很大的文件,并且需要多次访问其中的数据。在

read()系统调用中,必须提供一个用户空间的缓冲区(buf),否则内核不知道要把数据复制到哪里

场景一:不使用用户自己定义的长期存储的缓存

你的代码第一次调用

read(fd, buf, size)。内核检查页缓存,发现数据不在(缓存未命中)。内核发起磁盘 I/O,将数据读入页缓存。内核将数据从页缓存复制到你的buf(用户空间)。你的程序处理buf里的数据。过了一会儿,你的代码再次需要读取同一部分数据,于是再次调用read(fd, buf, size)。内核检查页缓存,发现数据已经在里面了(缓存命中)。内核直接将数据从页缓存复制到你的buf(用户空间)。 (这一步比第一次快得多,因为省去了磁盘 I/O)这里的

buf其实也是长期永久的用户缓冲,但我们把他叫做【用户空间的 I/O 缓冲区 (I/O Buffer)】因为你下次调用read他会被覆盖,所以有了场景二需要你及时处理,这个及时处理的地方就叫做【用户空间的缓存 (Cache)】

场景二:使用用户自己定义的长期存储缓存

你的代码声明了一个数组

char my_cache[1024];(这是额外的用户空间的缓存)。你的代码第一次调用read(fd, buf, size)后,又memcpy(my_cache, io_buf, 1024);,内部流程仍然是:内核检查页缓存 -> 读磁盘(如果需要) -> 填充页缓存 -> 复制到my_cache。现在,my_cache里已经有了文件的一部分数据。过了一会儿,你的程序需要访问这部分数据中的某一小段。你不需要再调用read()了。你直接在my_cache这个数组里查找和使用数据即可。

read()调用必须有一个 I/O 缓冲区(用户空间),用于接收数据。用户缓存是可选的,是你为了减少

read()调用次数、提高程序效率而额外设计的。提到 IO 缓存是泛指,可以指自己写的,也可以指标准库的缓存(只是程序员无法操作和感知这部分缓存)

然后还有个事,页缓存里没有从磁盘进货的时候,还有个磁盘缓存

关于谁快的问题:

内核空间的页缓存 (Page Cache):

速度: 非常快。因为它本身就是内存(RAM)的一部分。访问内存的速度是以纳秒(ns)为单位的。

为什么快: 因为数据已经在内存里了,CPU 可以直接通过内存地址访问,不需要涉及任何机械运动或慢速的外部设备。

磁盘 (Disk):

速度: 非常慢。相比内存,磁盘 I/O 的速度是以毫秒(ms)甚至秒(s)为单位的。

为什么慢: 传统硬盘(HDD)需要移动磁头和旋转磁盘来寻找和读取数据,这是物理运动,速度非常有限。即使是固态硬盘(SSD),虽然没有机械部件,但它的接口和内部控制器的速度也远低于内存。

核心结论:访问速度 内存 (页缓存) >> 磁盘

现在我们来解决你最困惑的问题:用户空间自己的缓存呢?比内核还快?

答案是:不,它不比内核的页缓存快,它们的访问速度是一样快的。

原因如下:

用户空间的缓存(比如你定义的

my_cache数组)和内核空间的页缓存(Page Cache)都位于同一个物理内存(RAM)中。CPU 访问内存的速度只取决于内存本身的硬件性能(如 DDR4, DDR5 等),而不取决于这块内存在逻辑上被划分给了用户空间还是内核空间。

那它们的区别是什么?

它们的区别在于管理方式和目的,而不在于物理访问速度。

管理方式:

内核的页缓存: 由操作系统内核统一、透明地管理。内核决定缓存哪些数据、缓存多大、以及什么时候把旧数据从缓存中淘汰出去(换出到磁盘)。

用户的缓存: 由你的应用程序代码完全控制。你决定缓存什么数据、缓存多久、以及如何组织这些数据。

目的:

内核的页缓存: 目的是减少磁盘 I/O。它对所有应用程序都有益。当你第一次读取一个文件时,数据从磁盘读到页缓存。当你(或其他程序)再次读取同一部分时,就可以直接从页缓存读取,避免了再次访问慢速的磁盘。

用户的缓存: 目的是减少系统调用和数据拷贝。当你已经把数据从内核的页缓存通过

read()系统调用复制到了你的用户空间缓冲区(buf)后,如果你还需要反复访问这些数据,你可以把它们存放在一个你自己管理的my_cache结构中。这样做的好处是,你不需要再一次次地调用read()(这涉及系统调用的开销),也不需要内核再一次次地把数据从页缓存复制到你的buf(这涉及内存拷贝的开销)。你可以直接在自己的my_cache里访问,虽然物理上还是访问内存,但省去了中间的许多步骤。总结速度对比:

最快: 访问你自己程序里的用户缓存 (

my_cache)。

因为:数据已经在你的程序地址空间里,CPU 可以直接访问,没有任何中间开销。

次快: 内核从页缓存复制数据到你的用户缓冲区 (

buf)。

因为:数据在内存里,但需要一次系统调用(

read())和一次内核态到用户态的数据拷贝。最慢: 内核从磁盘读取数据到页缓存,再复制到你的用户缓冲区。

因为:包含了最慢的磁盘 I/O 操作。

一个形象的比喻:

磁盘:是你家的仓库,很远,取东西要花很长时间(磁盘 I/O)。

内核的页缓存:是你家客厅的一个公共茶几。当你从仓库取来一样东西(第一次读文件),你先放在茶几上。下次再用这个东西(再次读同一部分),就不用跑仓库了,直接从茶几上拿,快多了。

用户的缓存:是你自己书房里的私人书桌。你从客厅的茶几上(页缓存)把东西拿过来(

read()),放在自己的书桌上(my_cache)。以后你在书房工作时,直接从自己的书桌上拿就好了,连去客厅的功夫都省了。所以,用户缓存并不比内核缓存 “快”,它只是让你在自己的 “地盘” 里取用数据更方便(省去了来回 “客厅” 的麻烦)。

感觉懂了些浅显的东西,但依旧有些混乱的东西,比如无论是否写长久用户那个cache,和是否内核写到页缓存有无关系?标准库的缓冲区又是咋回事?感觉还是有点朦胧:my_cache确实是用户空间的缓存,但它和标准库的缓冲区是两回事。

标准库的缓冲区:

是谁的:是 C/C++ 标准库(比如

stdio.h或<iostream>)内部创建和管理的。在哪里:在你的程序的用户空间内存里。

目的:为了减少系统调用

read()/write()的次数,从而提升 I/O 性能。你能看到吗:不能直接看到。它是标准库内部的一个数组或

char*指针。例子:当你使用

printf("hello")时,数据并不是立刻就通过系统调用写入终端,而是先被复制到stdout对应的标准库缓冲区里。当缓冲区满了或者你手动fflush(stdout)时,标准库才会调用write()系统调用,把缓冲区里的数据一次性写入内核。你自己写的

my_cache:

是谁的:是你(程序员)在你的代码里手动创建和管理的。

在哪里:也在你的程序的用户空间内存里。

目的:为了你自己程序的逻辑需求,比如重复访问某块数据,避免重复的计算或重复的

read()调用(以及随之而来的数据拷贝)。你能看到吗:当然能,它就是你定义的一个普通变量。

例子:你读取了一个配置文件到

my_cache数组里,然后你的程序在运行过程中需要多次访问配置里的某个值,你就可以直接从my_cache里读,而不需要再去文件里读了。总结一下:

标准库的缓冲区:是 “库” 帮你管理的,透明的,主要为了优化 I/O。

你自己的

my_cache:是 “你” 自己管理的,可见的,主要为了优化你自己的业务逻辑。它们都在用户空间,但一个是 “系统” 帮你弄的,一个是 “你自己” 弄的。

myfile是一个ifstream(输入文件流)对象,它已经通过open()或构造函数与某个实际文件关联,

ifstream的read()成员函数会返回myfile本身,你可以通过myfile.gcount()获取实际读取的字节数,或通过myfile.eof()/myfile.fail()判断是否读取失败 / 到达文件末尾。

myfile.read(buffer, 100)会从与myfile绑定的文件中读取最多 100 个字节,并存入你指定的buffer数组,这些我都懂,那【检查流的内部缓冲区:

ifstream对象不会立即调用read()系统调用。它会先检查自己的内部缓冲区(一块在用户空间分配的内存) 】这句话里的内部缓冲在哪里啊?我看不到是不是?完全内部的隐形的?对!这个 “内部缓冲区”是

ifstream对象内部的一块内存,是 C++ 标准库(iostream库)在你创建ifstream对象时(比如ifstream myfile("data.txt");)自动为你分配和管理的。它的特点就是:

对用户完全透明:你无法直接访问它,也看不到它的名字。它是

ifstream对象的一个私有成员变量。由标准库自动管理:当你调用

myfile.read()时,标准库内部的代码会决定是直接从这个内部缓冲区取数据,还是需要调用系统read()来填充它。目的是性能优化:如我们之前讨论的,它的存在是为了减少系统调用的次数。

假设

data.txt文件里有 1000 个字节。你写了如下代码:#include <fstream> #include <iostream> int main() { std::ifstream myfile("data.txt", std::ios::in); if (!myfile) { std::cerr << "Error opening file!" << std::endl; return 1; } char buffer[100]; // 第一次调用 read myfile.read(buffer, 100); std::cout << "First read: " << myfile.gcount() << " bytes read." << std::endl; // 第二次调用 read myfile.read(buffer, 100); std::cout << "Second read: " << myfile.gcount() << " bytes read." << std::endl; myfile.close(); return 0; }内部发生了什么?

std::ifstream myfile("data.txt");

系统创建了一个

ifstream对象myfile。作为创建过程的一部分,

myfile在用户空间里分配了一块内存作为它的内部缓冲区即标准库缓存(比如大小是 4096 字节)。你看不到这块内存,也不知道它的地址。

myfile.read(buffer, 100);(第一次调用)

myfile的内部代码检查自己的内部缓冲区。此时缓冲区是空的。因为缓冲区为空,

myfile会发起一次系统调用read(),从磁盘文件data.txt中读取一大块数据(比如 4096 字节),填充到自己的内部缓冲区。然后,

myfile从刚刚填满的内部缓冲区中,复制前 100 个字节到你提供的buffer数组中。现在,

myfile的内部缓冲区还剩 4096 - 100 = 3996 个字节的数据。

myfile.read(buffer, 100);(第二次调用)

myfile的内部代码再次检查自己的内部缓冲区。此时缓冲区里还有 3996 个字节的数据,足够满足你读取 100 个字节的需求。这次,它不会发起任何系统调用!

它直接从自己的内部缓冲区中,复制接下来的 100 个字节到你的

buffer数组中。现在,内部缓冲区还剩 3996 - 100 = 3896 个字节的数据。

起初我以为第二次要读的和第一次无关,但其实不是,

ifstream使用内部缓冲区时,它的策略是预读取,你的需求:读取 100 个字节。

ifstream的行为:它不会只去磁盘读取 100 个字节。为了效率,它会一次性读取一大块数据(比如 4096 字节)到它的内部缓冲区里。这个 “大块” 的大小通常是磁盘块的整数倍,或者是一个固定的优化值。因为磁盘 I/O 有固定开销(寻道、旋转、数据传输)。读取 100 字节和读取 4096 字节的固定开销几乎是一样的。所以,一次性多读一点,把后续可能用到的数据提前加载到内存里,可以极大地减少未来的磁盘 I/O 次数。第二次调用

read()时,只要你需要读取的字节数(比如 100 字节)小于或等于ifstream内部缓冲区中剩余的数据(比如 3996 字节),它就会直接从缓冲区复制数据给你,不会发起任何系统调用,也不会去访问磁盘。而超过 3996 字节,或者说缓存空了,就要去读了,这里具体咋理解?其实还有些细节:

缓存空了本质就是:根据当前文件偏移,要读取的数据不在缓存里,所以才需要从内核(标准库缓存)或磁盘(页缓存)读取,

第一次调用

read(fd, buf, 4096),会从文件的起始位置(偏移量 0)读取 4096 字节,然后文件指针自动移动到偏移量 4096 的位置。第二次调用

read(fd, buf, 4096),会从偏移量 4096 的位置开始读取下一个 4096 字节,然后文件指针移动到偏移量 8192 的位置。只有中间用

lseek(fd, 0, SEEK_SET);才是回到首位置读,但已经读过了呀,所以也就不需要再读内核突然思考王Y涵的腾讯天美游戏和 LinuxC++ 服务端开发 哪个难?

文件指针在哪,

read()就从哪开始读,是否读过数据,不比对,取决于 “当前指针位置 + 要读的字节范围” 之前是否被加载到页缓存。lseek这个函数,作用就是手动修改这个 “起始偏移” —— 它不读也不写文件,只改 “下一次操作的起点坐标”。结合4096就是读的跨度、范围然后我的问题是,如果读过了是不是就不进行系统调用了?豆包又引出了无穷无尽的知识点你妈逼的艹!

lseek只改文件指针,不读数据;要读数据仍需read系统调用,标准库会先查自身缓存,未命中才触发系统调用,由内核从页缓存或磁盘读取。

lseek移动的是内核的文件指针,不影响标准库缓存;fseek移动的是标准库的逻辑指针,并会清空标准库缓存使用

lseek系统调用查看代码

int fd = open("file.txt", O_RDONLY); // 打开文件,得到文件描述符 char buf[10]; read(fd, buf, 5); // 从偏移量0读取5个字节,内核偏移量变为5 lseek(fd, 0, SEEK_SET); // 【关键】将内核中的文件偏移量重置为0 read(fd, buf, 5); // 再次从偏移量0读取5个字节(会再次触发系统调用) close(fd);使用

fseek标准库函数查看代码

FILE *fp = fopen("file.txt", "r"); // 打开文件,得到 FILE 指针 char c; fgetc(fp); // 标准库会预读一块数据到缓存,比如4096字节 fseek(fp, 0, SEEK_SET); // 【关键】重置标准库的逻辑指针,并清空缓存 fgetc(fp); // 从标准库缓存中重新读取(可能会再次触发系统调用填充缓存) fclose(fp);标准库缓存就是像 C

stdio.h里fopen/fread/fwrite,C++ 的std::ifstream::read()这些函数自带的缓冲区,而内核的页缓存是read这种 Linux 的系统调用。

如果用

lseek+read:会触发系统调用。因为read是系统调用,它不经过标准库缓存,直接从内核的页缓存读,没有的话从磁盘读。lseek只是移动了内核的文件指针如果用

fseek+fread:不会触发系统调用(如果数据已在缓存中)。因为fread是标准库函数,它会先检查标准库的缓存。fseek会保证缓存中的数据是正确位置的

seek是 C 标准库中的函数,作用是:修改文件流(FILE*)的当前读写位置,并清空标准库缓存,确保后续fread/fgetc等操作从新位置开始读取(若新位置数据不在缓存,会触发系统调用加载数据到缓存)。

fseek必须搭配标准库的fread/fgetc,lseek必须搭配系统调用的read一句话说清绑定关系 + 核心差异:

fseek(标准库)→ 只能跟fread(标准库,走标准库缓存),会清缓存;lseek(内核)→ 只能跟read(系统调用,不走标准库缓存),不清缓存;俩函数没法用同一个 “read”,因为归属不同层级!验证(狗逼豆包他妈的给的是半成品代码,确实只是个助手,需要我修改,妈逼的自己不动脑修改,问他让他找毛病,就会给你胡扯说不到点上,能气死你)

想验证

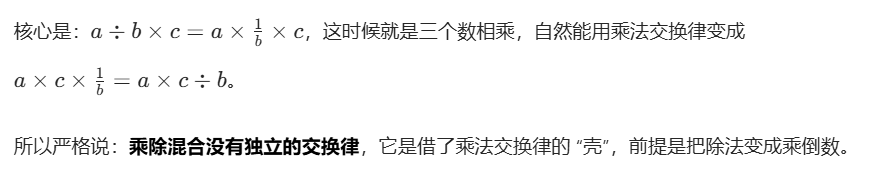

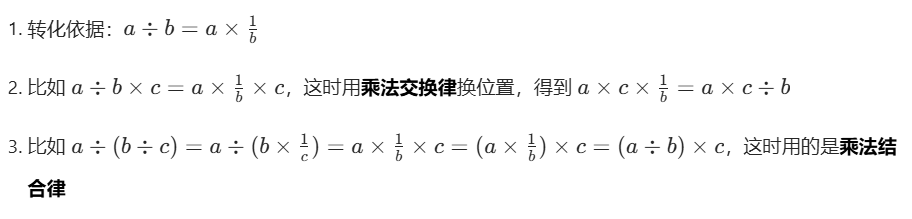

fseek会清理缓冲,结果stdin验证出问题了:查看代码

#include <stdio.h> #include <stdlib.h> int main() { char c1, c2; // 测试1:不使用 fseek,观察输入缓冲区残留 printf("=== 测试1:不清理输入缓冲 ===\n"); printf("请输入一个字符:"); scanf("%c", &c1); // 读取1个字符(比如输入 'a' 后按回车,缓冲区残留 '\n') printf("你输入的字符是:#%c#\n", c1); // 尝试读取下一个字符(会直接读取缓冲区残留的 '\n',无需手动输入) printf("尝试读取下一个字符无需输入:"); scanf("%c", &c2); printf("读取到的是#%c#\n", c2); int fseek_ret; fseek_ret = fseek(stdin, 0, SEEK_END); if (fseek_ret == 0) printf("fseek执行成功!\n"); else printf("fseek执行失败!(返回值:%d)\n", fseek_ret); // 测试2:使用 fseek 清空输入缓冲 printf("=== 测试2:用 fseek 清理输入缓冲 ===\n"); printf("请输入一个字符:"); scanf("%c", &c1); // 输入 'b' 后按回车,缓冲区残留 '\n' printf("你输入的字符是:#%c#\n", c1); // 关键:用 fseek 清空 stdin 输入缓冲(SEEK_CUR, 0 表示“当前位置不变”,仅触发缓冲清理) fseek_ret = fseek(stdin, 0, SEEK_CUR); if (fseek_ret == 0) printf("fseek执行成功!\n"); else printf("fseek执行失败!(返回值:%d)\n", fseek_ret); // 再次尝试读取下一个字符(此时缓冲区已清空,必须手动输入) printf("尝试读取下一个字符(需要手动输入):"); scanf("%c", &c2); printf("你输入的第二个字符是:#%c#\n", c2); } Linux的输出: === 测试1:不清理输入缓冲 === 请输入一个字符:abc 你输入的字符是:#a# 尝试读取下一个字符无需输入:读取到的是#b# fseek执行失败!(返回值:-1) === 测试2:用 fseek 清理输入缓冲 === 请输入一个字符:你输入的字符是:#c# fseek执行失败!(返回值:-1) 尝试读取下一个字符(需要手动输入):你输入的第二个字符是:# # 描述下:当我输入abc回车后,直接结束了 win 的 codeblock: === 测试1:不清理输入缓冲 === 请输入一个字符:abc 你输入的字符是:#a# 尝试读取下一个字符无需输入:读取到的是#b# fseek执行失败!(返回值:-1) === 测试2:用 fseek 清理输入缓冲 === 请输入一个字符:y 你输入的字符是:#y# fseek执行成功! 尝试读取下一个字符(需要手动输入):o 你输入的第二个字符是:#o# 描述下:我输入abc回车后,测试1结束,测试2需要我输入y,和oWindows 下:

这个失败的

fseek后,测试 2 的 c1 能手动输入,是因为 Windows 标准库有fseek 对 stdin 失败后重置缓冲读取状态的隐性处理,在测试 1 后、测试 2 前加一句printf("残留字符:%c", getchar());,就会卡那,等我输入,Windows 标准库在处理这个 “失败请求” 时,隐性清空了缓冲里的 'c'+'\n'(这是 Windows 独有的兼容行为,不管返回成功还是失败,这个 SEEK_END 操作会清缓冲);而且这说的清缓冲指的是:注意比如输入ab回车,终端行缓冲无论系统都是先存入终端缓冲,然后回车后就传给标准库缓冲,那么读了a,b剩下的回车就在标准库缓冲里,清的就是这个。也就是说这里win的实际返回

fseek(stdin, 0, SEEK_END)和fseek(stdin, 0, SEEK_CUR)都能清缓冲(所以后续输入会等你手动输),区别只在于返回值(SEEK_END 返 -1 失败,SEEK_CUR 返 0 成功);返回失败的会连带额隐形清下Linux 下:

没有这个隐性处理,测试 2 的 c1 直接读了残留,严格遵循 POSIX 标准和 C 标准,将键盘(stdin 对应的 IO 设备)定义为「不可定位的流式字符设备」,直接禁止 fseek 对这类设备执行任何操作

「不可定位」意味着 fseek 失去作用基础 ——fseek 的核心是 “移动读写位置”,但键盘输入是 “实时流式数据”(敲一个传一个,一直往下读,没有固定的字节地址,没法 “回到上一个字符”“跳到末尾”,不能跳也不能倒),Linux 内核和标准库直接拒绝给这种设备提供 “定位” 能力,自然也不会执行 fseek 附带的任何操作(比如清缓冲);

简单说:Linux 认为 “键盘输入就该是单向流式的,不能定位、不能回退”,所以从底层禁止了 fseek 对 stdin 的所有操作,自然清不了缓冲;而 Windows 是为了兼容,给

fseek(stdin, 0, SEEK_CUR)开了 “特例”,让它能清标准库缓冲 —— 本质是两个系统对 “键盘 IO 设备的功能定义” 不一样,Linux 坚守标准,Windows 做了兼容妥协。可是代码摆在这,我写博客删对话,把写完的给豆包让找错误,直到现在豆包还在反复的否定、反悔,无尽痛苦,真都不想研究这里了!

那么以上是踩的粪坑沼泽地,文件 IO 的缓存逻辑磁盘文件是 “可定位的块设备”(有固定字节地址,能跳着读 / 写),fseek/lseek 的设计初衷就是给这类设备用的,缓存逻辑(标准库缓存→内核页缓存→磁盘)也完全适配;而 stdin(键盘)是「不可定位的流式字符设备」(数据实时输入,没有固定地址,只能单向读),

强迫症纠结到这,该怎么收尾?不用觉得 “白研究”:你其实搞懂了两个关键知识点:

① 设备类型(可定位 / 不可定位)决定工具用法(fseek 能不能用);

② 系统兼容差异(Linux 守标准 / Windows 重兼容)对错误用法的影响;后续记住:清 stdin 缓存(处理输入残留),可以用 win 下 codeblock(w64devkit)亲测有效的

fflush(stdin)即全部清空,但 C 里没有这个,这是编译器扩展,w64devkits 虽说属 GCC 阵营但 GCC 原生没有fflush,即 Linux里用不好使,大厂都是循环

getchar()读残留(C 标准库函数,跨平台适配:本质是调用fgetc (stdin))只要是「文件流」(包括 stdin、磁盘文件、管道等)都能用,跨平台也靠谱!

C 语言(还有 Unix/Linux 等系统的设计思路)里:键盘(stdin)、屏幕(stdout)、打印机这些设备,本质上都被 “当作文件流” 来处理,不是说它们是 “磁盘上的文件”,而是系统把所有 “输入输出源” 都统一成了 “文件流” 的接口,这样代码写起来更通用

你以为的 “文件”:是磁盘上的物理文件(比如

test.txt),打开后得到FILE* fp,这是 “文件流”;其实的 “文件流”:

stdin:键盘对应的 “输入文件流”(系统默认打开,不用你写

fopen()),所以能直接用fgetc(stdin)(也就是getchar())读;stdout:屏幕对应的 “输出文件流”(系统默认打开),所以能直接用

fprintf(stdout, "xxx")(也就是printf("xxx"))写;好处:比如你写个函数

read_data(FILE* stream),既能传磁盘文件的fp读文件内容,也能传stdin读键盘输入 —— 代码不用改,通用性拉满!③fseek 是给文件用的,别用在键盘输入上,这才是对应场景的正确工具!

那么其实 stdin 的缓存是「终端行缓存」(敲回车才传给标准库缓存),这是 IO 缓存的一种场景;而大多数说的IO缓存是磁盘(标准库→页缓存→磁盘)

那些 C/C++ 都是用上层封装,额外加用户层的标准库缓存,底层仍依赖系统调用 + 内核页缓存!

Linux 纯 read 系统调用有内核层的页缓存,没有的是 C 标准库的用户层缓存

数据不在标准库缓存 → 触发系统调用从内核页缓存拿 → 页缓存也没有 → 内核从磁盘读数据填充页缓存,再逐级往上传

先呼应之前的关联:stdin 是指向 “键盘对应的 FILE 结构体” 的指针,键盘输入的字符(包括回车 '\n')会存在这个 FILE 结构体的 “输入缓冲” 里;

为什么 Linux 下 fseek 没用?

- FILE 结构体的功能是 “管理 IO 对象”,但不同 IO 对象(键盘 / 文件)支持的操作不一样:

- 如果你操作的是 “文件”(比如用 fopen 打开的文件),它的 FILE 结构体支持 fseek(移动读写位置、清理缓冲);

- 但 Linux 里的 “键盘” 是 “字符设备”,它的 FILE 结构体不支持 fseek—— 标准库没给这个 IO 对象(键盘)实现 fseek 的功能,所以你调用了也没用,输入缓冲里的 '\n' 还在;

fseek 是给 “文件” 这种 IO 对象设计的,“键盘”(stdin)在 Linux 下不支持这个操作,所以清不了缓冲。

总结:核心还是 “IO 对象决定 FILE 结构体支持的操作”—— 键盘这个 IO 对象,在 Linux 里不让 fseek 干活,所以代码里的 fseek 等于白写。

Windows下没问题,Linux下必须改用while ((getchar()) != '\n');否则输入ab+ 回车后,测试 1 的c1读a、c2读b,回车还留在缓冲里,测试 2 的c1根本不用重新输入;而

Windows中fseek(stdin, 0, SEEK_END)能真正清空缓冲,测试 2 会正常等你输入。行缓冲是终端输入时的核心机制:先暂存你敲的所有字符,按回车才把整行数据传给程序

Linux敲ab+ 回车后,整行字符先存在终端「行缓冲」,按回车才把这堆字符传给程序的「标准库缓冲」,fseek只清标准库缓冲、清不掉终端行缓冲的残留。

Windows终端也有行缓冲(你敲的字符仍需按回车才提交),但Windows把 “终端行缓冲” 和 “程序标准库缓冲” 做了关联 —— 用fseek清标准库缓冲时,会顺带清空终端的行缓冲

fseek是C标准库函数(C/C++通用),lseek是Linux/Unix专属的系统调用(不属于C标准,Windows要用_lseek替代)。

C只规定了fseek对文件的操作行为,完全没规定它对stdin(终端输入)的缓冲清理行为,这种跨平台差异,是因为不同系统对终端输入的缓冲管理逻辑不同,不是C的问题

while ((getchar()) != '\n');的逻辑特别简单:一直读缓冲里的字符,直到读到回车为止;只要读到回车,缓冲就被清空了,同时退出循环。

行缓冲(终端层面)→标准库缓冲(C 标准库层面)→页缓存(操作系统内核层面),是数据从键盘到程序的三层 “临时仓库”,各管一段、互不相关!具体拆重点:

行缓冲:终端(比如 Linux 的 bash)管的,只针对键盘输入 / 屏幕输出,特点是 “按回车才提交整行数据”,

fseek碰不到;标准库缓冲:C 标准库(

stdio.h)管的,是程序和内核之间的缓冲(比如printf/scanf用的),fseek只能清这个;页缓存:操作系统内核管的,是内核和硬盘之间的缓冲(比如读文件时先存硬盘数据到内存),和终端输入、

fseek完全没关系!简单说:你敲

ab+ 回车,先过「行缓冲」(终端暂存)→ 按回车传给「标准库缓冲」(程序暂存)→ 程序从这读数据;而「页缓存」是管文件读写的,和键盘输入根本不搭边总结:

你提供的

buffer:是你自己的内存,用于接收数据,你可以随意访问。

ifstream的内部缓冲区:是ifstream对象私有的、隐藏的内存,用于临时存放从文件读取的大量数据,以减少系统调用。它在幕后工作,你不需要也无法直接操作它。但上面写的没有写页缓存的事!现在再把这个加进来:

页缓存它工作在一个更低的、你看不见的层级。上面写的【内部发生了什么】要聚焦于应用程序层面(用户态)发生的事情。而页缓存的工作则发生在操作系统内核层面(内核态)。这两个缓存是协同工作的,共同构成了文件 I/O 的性能优化体系,那就不完整,从应用程序发起读取请求,到最终从磁盘获取数据,

第一层:应用程序层

std::ifstream的工作这正是你描述的过程:

myfile对象检查自己的内部缓冲区(一个位于用户态内存的、大小为 4096 字节的缓冲区)。发现缓冲区是空的。

myfile对象需要填充这个缓冲区,于是它向下层(操作系统内核)发起一个读取请求,这个请求最终会转化为一个系统调用,比如read()。到这里,应用程序的工作就暂时告一段落了,它把接力棒交给了操作系统内核。

第二层:操作系统内核层 (Kernel Space) - 页缓存 (Page Cache) 的工作

当内核收到

read()系统调用后,它会做以下事情:

检查页缓存 (Page Cache):

内核会首先检查自己管理的页缓存。页缓存是内核在内存中为所有打开的文件内容开辟的一块高速缓存区域。它缓存的是文件的 “页”(通常是 4KB 大小)。

内核会询问:“我有没有缓存

data.txt中,从文件起始位置开始的这 4096 字节的数据?”情况 A:页缓存未命中 (Cache Miss):

如果这是程序第一次读取这个文件,或者内核因为内存不足等原因已经把

data.txt的这部分内容从页缓存中淘汰了,那么内核的回答就是:“没有。”这时,真正的磁盘 I/O 发生了。 内核会向磁盘控制器发送指令,要求从

data.txt文件在磁盘上的物理位置读取相应的扇区数据。磁盘控制器将数据从磁盘读取到内存的内核地址空间中,具体来说,就是填充到页缓存的某个页面中。

现在,

data.txt的这 4096 字节数据就已经存在于页缓存中了。情况 B:页缓存命中 (Cache Hit):

如果内核之前已经读取过

data.txt的这部分内容,并且它还在页缓存里,那么内核的回答就是:“有!”这时,不会发生任何磁盘 I/O。

数据拷贝:

无论数据是刚刚从磁盘读到页缓存的(情况 A),还是早就已经在页缓存里了(情况 B),数据现在都已经在内核的页缓存中了。

接下来,内核会从页缓存中,把这 4096 字节的数据拷贝到

myfile对象在用户态申请的那个 4096 字节的内部缓冲区里。到这里,内核的工作完成,它把接力棒交还给应用程序。

第一层:应用程序层 (User Space) -

std::ifstream继续工作

myfile对象的内部缓冲区(位于用户态)现在已经被 4096 字节的数据填满了。

myfile对象从这个内部缓冲区中,复制前 100 个字节到你提供的buffer数组中。

myfile对象更新自己的状态,记录下内部缓冲区中还有 3996 字节的数据未被读取,并记住下一次应该从哪个位置开始读取。两次

read调用的完整图景

调用 标准库缓存 (应用层) 页缓存 (内核层) 磁盘 I/O 第一次 read(100)1. 检查内部缓冲区(空)。 2. 发起系统调用read(4096)填充它。3. 从填满的内部缓冲区复制 100 字节到用户buffer。1. 检查页缓存(无)。 2. 发起磁盘 I/O,将数据读入页缓存。3. 从页缓存复制 4096 字节到应用程序的内部缓冲区。发生 第二次 read(100)1. 检查内部缓冲区(有 3996 字节)。 2. 无需系统调用。3. 直接从内部缓冲区复制下一个 100 字节到用户buffer。完全不参与,因为数据已经在应用程序的缓存里了。 不发生 核心区别与联系

特性 标准库缓存 ( std::ifstreambuffer)页缓存 (Page Cache)

所有者 应用程序 / C++ 标准库 操作系统内核

作用域 仅对当前 std::ifstream对象可见对整个操作系统的所有进程可见(共享)

主要目的 减少系统调用的次数 减少磁盘 I/O 的次数

管理方式 由 std::ifstream对象自动管理由操作系统内核的内存管理和文件系统模块统一、智能地管理(包括缓存淘汰、预读等)

简单来说,它们是 “合作伙伴” 关系:

std::ifstream的内部缓存,通过一次读取一大块数据(4096 字节),来减少昂贵的系统调用次数。而操作系统的页缓存,则通过缓存磁盘文件的数据,来减少更昂贵的磁盘寻道和读取次数。当

std::ifstream向下请求 4096 字节时,内核会先看自己的页缓存里有没有,如果没有才会去麻烦磁盘。所以,你代码描述中的read()系统调用,它读取的 “一大块数据”,绝大多数情况下是从内存(页缓存)中读取的,而不是直接从磁盘读取的。你的提问非常棒,这表明你已经开始深入思考 I/O 背后的原理了。理解了这两层缓存,你对文件操作的性能优化就会有更深刻的认识。

1. 为什么系统调用昂贵珍贵宝贵?(便于回顾需要看这里的时候好搜索)

系统调用的成本主要在于 “上下文切换”(Context Switch)。

核心原因: 用户程序和操作系统内核运行在不同的 “特权级别”。用户程序不能直接访问硬件或内核内存,必须通过系统调用请求内核代劳。

切换过程:

CPU 从执行用户程序的指令,切换到执行内核代码。

保存当前用户程序的执行状态(寄存器、程序计数器等)。

加载内核的执行状态。

内核执行相应操作(比如读取文件)。

操作完成后,再切换回用户程序状态,恢复之前保存的寄存器和计数器。

开销所在: 这个切换过程涉及到 CPU 状态的保存和恢复、内存地址空间的切换,是一个复杂的硬件和软件协同操作,需要消耗大量 CPU 时钟周期。

系统调用贵就贵在 “用户态” 和 “内核态” 之间来回切换的开销。

2. 为什么磁盘 I/O 昂贵?

磁盘 I/O 的成本主要在于 “物理设备的机械运动”。

核心原因: 传统机械硬盘(HDD)的读写依赖于磁头在高速旋转的盘片上寻道。

操作过程:

寻道时间(Seek Time): 移动磁头臂到数据所在的磁道。这是最耗时的一步,通常需要几个毫秒(ms)。

旋转延迟(Rotational Latency): 等待盘片旋转,使目标扇区移动到磁头下方。这也需要几个毫秒。

数据传输时间(Transfer Time): 实际读取或写入数据。这一步相对较快。

开销对比:

一次内存访问的时间大约是 几纳秒(ns)。

一次磁盘 I/O 的时间大约是 几毫秒(ms)。

一毫秒等于一百万纳秒。也就是说,一次磁盘 I/O 的时间,CPU 可以执行上百万条指令。

磁盘 I/O 贵就贵在磁头寻道和盘片旋转的物理等待时间,这比电子信号在内存中的传输慢了上百万倍。

两者的关系

页缓存的目的,就是为了避免频繁的磁盘 I/O。用内存的高速访问,替代磁盘的慢速访问。

标准库缓存的目的,就是为了避免频繁的系统调用。用用户态内存的访问,替代需要上下文切换的内核调用。

所以,整个 I/O 流程的优化目标就是:尽量用最快的内存访问,来替代较慢的系统调用和最慢的磁盘 I/O。

页缓存:内核用的,一次多拿点磁盘数据放内存,减少「磁盘 I/O 次数」;

标准库缓存:应用 / 标准库用的,一次多从内核拿点数据放用户态内存,减少「系统调用次数」

C++ 中大部分高层读取函数(比如

std::ifstream的read()、get()、operator>>等),底层最终都会通过系统调用read()(Windows 上是ReadFile())来读取文件数据。它们的关系是:C++ 标准库函数 → C 标准库函数(如

fread)→ 系统调用(read)→ 内核(页缓存)→ 磁盘。标准库缓存 (Standard Library Cache)

read语句里用户每次读一个,那就老鼻子慢了,所以read标准库缓存比如 4096 就一下子从内核读了 4096,然后后续每次调用(这里的 “调用” 指的是你对标准库函数的调用,比如fgetc()或fread())都直接从内核给用户返回标准库缓存是应用程序(用户态)和内核(内核态)之间的一道缓冲。当标准库的缓存为空时,它会一次性调用

read()系统调用,从内核(内核可能从页缓存或磁盘读取)读取一大块数据(比如 4096 字节),存入自己的缓存中。工作流程:你调用

fgetc()(想读一个字符)。标准库检查自己的缓存。如果缓存里有数据,它直接从自己的缓存里取一个字符返回给你,不会调用read()系统调用。如果缓存空了,它才会调用read()系统调用,从内核读取一大块数据(比如 4096 字节)填满自己的缓存,然后再从缓存里取一个字符返回给你。核心目的: 减少系统调用的次数。因为系统调用(用户态切换到内核态)有开销,一次性多读点,存起来,后续的小读取就可以直接在用户态内存里完成,速度快得多。

页缓存 (Page Cache)

页缓存是内核用来缓存从磁盘读取的数据的地方。当内核收到一个

read()系统调用时,它会先检查页缓存:

如果数据在页缓存里,内核就直接从页缓存复制数据给标准库的缓存,不需要访问磁盘。

如果数据不在页缓存里,内核才会去磁盘读取数据,读取后先存入页缓存,然后再从页缓存复制给标准库的缓存。

内核与磁盘交互时,不是按字节,而是按页(Page)来读取的。一页的大小通常是 4KB。即使你只需要 1 个字节,内核也会把包含这 1 个字节的整个 4KB 数据块从磁盘读到页缓存里。

核心目的: 减少磁盘 I/O 的次数。因为磁盘 I/O(寻道、旋转、数据传输)的开销极大,比内存访问慢上几个数量级。把读过的数据暂时存在内存(页缓存)里,下次再读同一部分数据时,就可以直接从内存读取,速度极快。

总结一下整个流程(以

fgetc()为例)假设一个文件内容是 "ABCDEFG...",且所有缓存都是空的:

你调用

fgetc():

标准库缓存为空。

标准库就会调用

read(fd, stdio_buffer, 4096)系统调用。否则直接从缓存拿数据。内核处理

read()系统调用:

内核检查页缓存,发现数据不在。

内核向磁盘发出指令,读取包含文件开头的一个或多个数据块(比如 4KB)。

磁盘将数据块返回给内核。

内核将这些数据块存入页缓存。

内核从页缓存中复制请求的数据(这里是 4096 字节)到标准库的缓存 (

stdio_buffer)。标准库处理:

标准库的缓存 (

stdio_buffer) 现在有了 "ABCDEFG...(共 4096 字节)"。标准库从自己的缓存里取出第一个字符 'A' 返回给你。

你再次调用

fgetc():

标准库检查自己的缓存,里面还有 "BCDEFG..."。

直接从缓存里取出 'B' 返回给你。

没有调用任何系统调用,也没有访问磁盘。一句话概括:

标准库缓存:应用程序的 “小仓库”,避免频繁向内核 “要货”(减少系统调用)。

页缓存:内核的 “大仓库”,避免频繁向磁盘 “进货”(减少磁盘 I/O)。

Linux 的

read是系统调用,在<unistd.h>里,直接内核交互,无缓冲,返回字节数 / 0(EOF)/-1(错误)。

read()是系统调用:它是用户程序进入内核态,请求内核从文件(或其他文件描述符对应的对象)中读取数据的接口。内核缓冲区:Linux 内核为了提高 I/O 效率,会维护一个页缓存(Page Cache),这是一种内核级别的缓冲区。当你调用

read()时,内核会先检查数据是否已在页缓存中。如果在,就直接从缓存复制到你提供的用户态缓冲区(buffer参数指向的内存);如果不在,内核才会发起真正的磁盘 I/O 操作,将数据读入页缓存,然后再复制到你的用户态缓冲区。用户态缓冲区:

read()函数的buffer参数是一个指针,指向你在用户程序中分配的一块内存。这块内存是用户态的,用于接收从内核复制过来的数据。总结:

read()本身不是无缓冲的。它依赖于内核的页缓存来提升性能。人们通常说的 "无缓冲 I/O" 是指不使用标准库的缓冲区(比如 C 语言中

printf使用的stdout缓冲区)。read()作为系统调用,它绕过了标准库的缓冲机制,直接与内核交互。但它并没有绕过内核自身的缓冲机制。最后读的数据依旧要写到用户指定的用户态缓存比如buf里C 的 fread 是标准库函数:这个此文上下有说不再啰嗦了

C++

ios的read()标准库函数:istream成员函数,<iostream>,带缓冲,返回流对象,失败时fail()为true。这个主要是C++的标准库函数,底层是共享 C 标准库的用户态缓冲机制,而 C 的 fread 又是调用系统级的 read,只不过 C++ 的这个比 C 的多了些自动关闭文件啥的,打开读写文件功能都一样:

读取源头:先从「标准库缓冲区(用户态)」读取;若缓存中没有,标准库会调用 Linux 的

read()系统调用,从内核缓存(或磁盘)读取数据到标准库缓存,再返回给用户。- 核心点:经过标准库缓冲,减少系统调用次数。

ifstream::read()的两个参数:第一个是目标缓冲区指针(如char buf[]),用于存储读取到的数据;第二个是要读取的字节数(如1024),表示希望从文件中读取的字节长度。

fread:C 标准库,<cstdio>,按块读取,带缓冲,返回成功读取的块数。自动

close:C++ 流对象(如ifstream/ofstream)析构时自动调用close(),无需手动操作。“带不带缓冲” 核心是:数据传输 / 处理时是否先存入临时缓存区(而非直接实时交互),带缓冲 = 先存后处理(提升效率、减少 IO),不带 = 实时读写(低延迟、数据即时同步)

ifstream:

从

ios继承的基础方法(所有流通用):

状态相关:

clear()、good()、fail()、eof()等(管理状态标志)。模式 / 打开关闭:

open()、close()、is_open()等(控制文件打开关闭)。从

istream继承的 “读专用” 方法(输入流特有):

读取操作:

>>运算符(格式化读)、read()(二进制读)、getline()(按行读,严格说是全局函数但依赖istream)。指针移动:

seekg()(移动读指针,g对应 get)、tellg()(获取当前读指针位置)。辅助:

gcount()(获取最后一次读的字节数)。

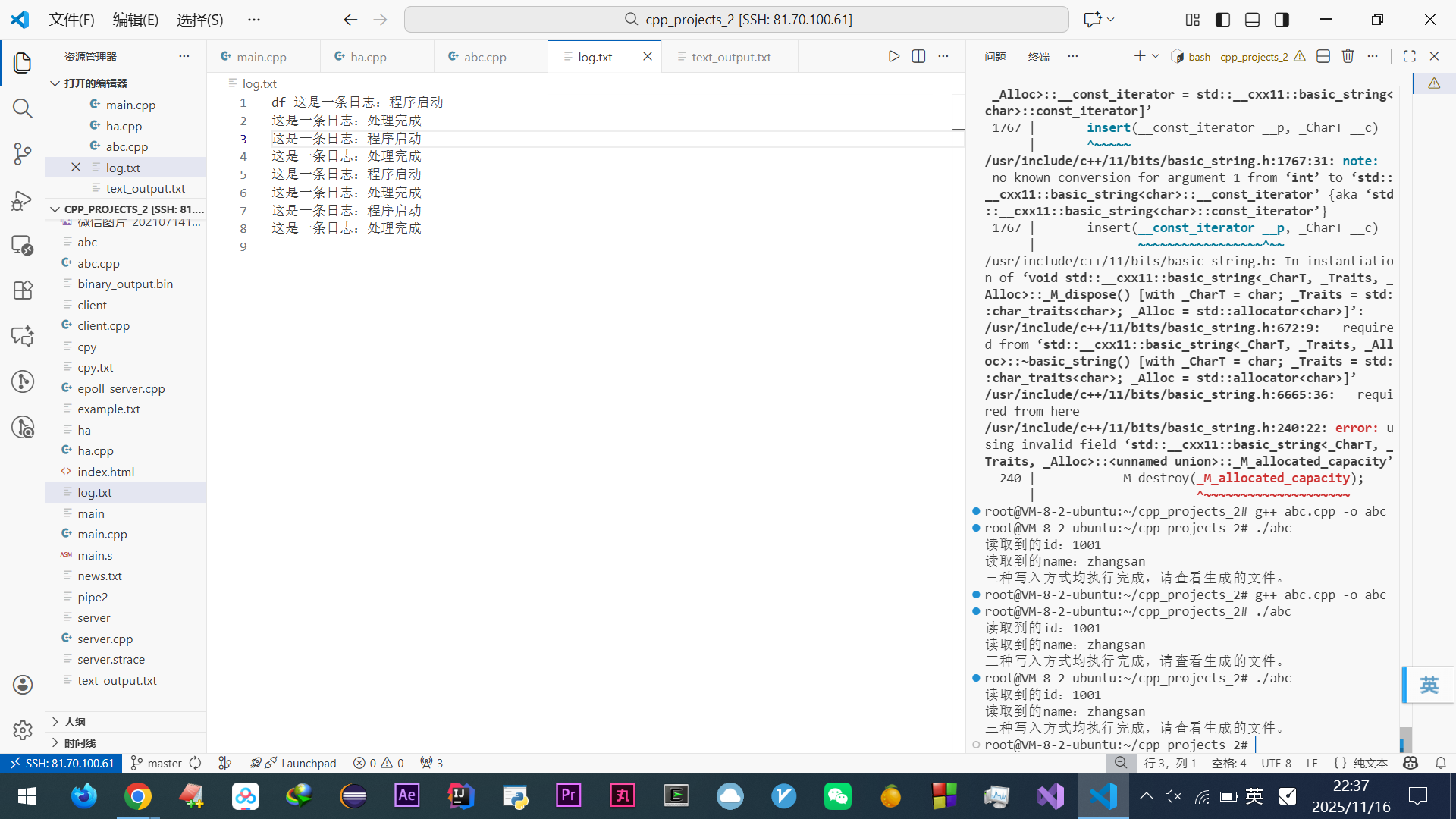

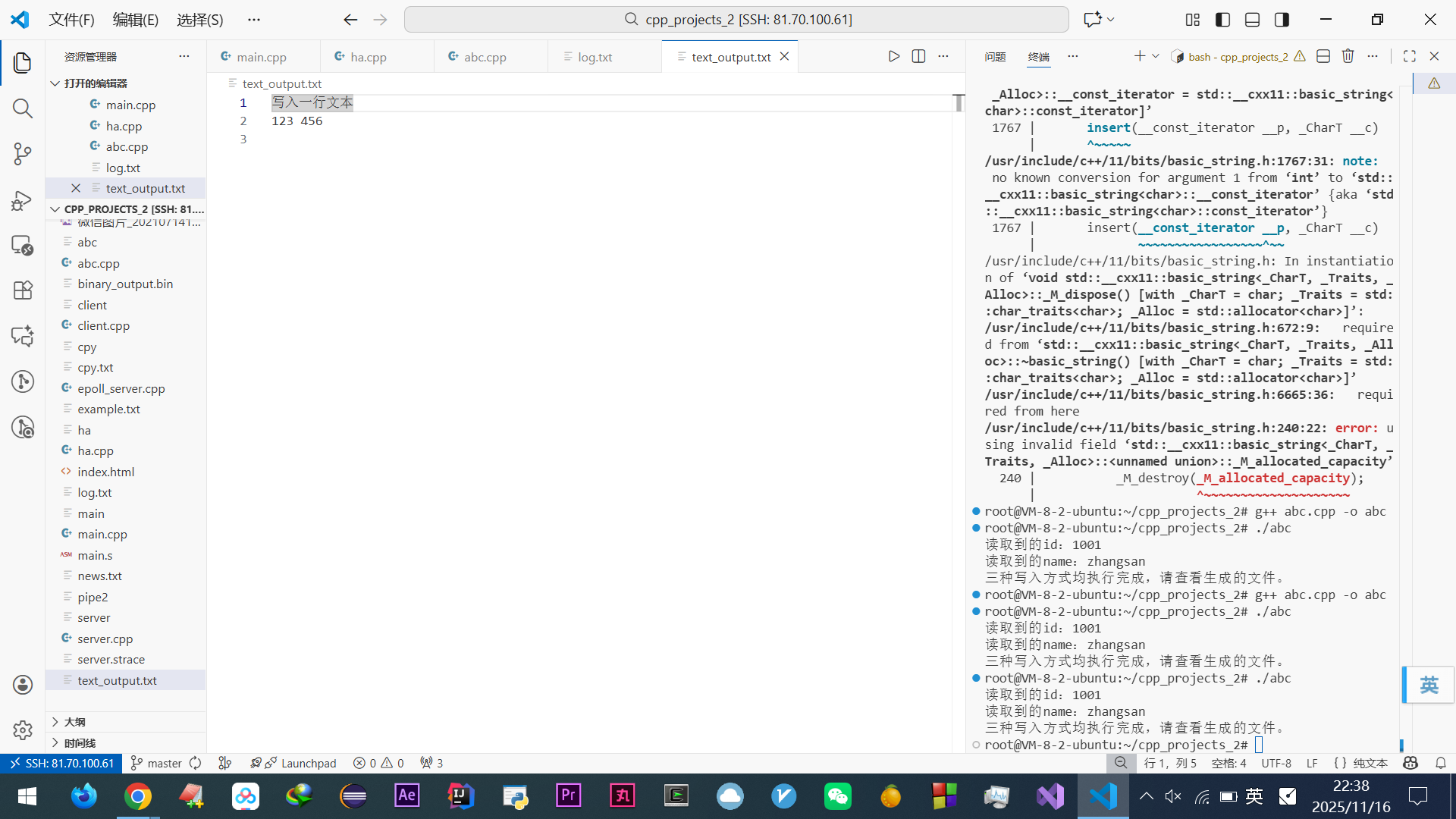

ifstream自身不新增方法,它的核心作用是 “将istream的读功能绑定到文件”,所有读写相关的逻辑都来自父类istream和ios。三大主要功能之三:写文件(3 种常用方式)

查看代码

#include <fstream> // 包含文件流操作所需类 #include <iostream> // 用于控制台输出(验证用) #include <cstring> // 用于字符串操作(给结构体赋值) using namespace std; // 定义示例结构体(二进制写入用) struct User { int id; // 整数类型(4字节) char name[20]; // 固定长度字符数组(20字节,避免指针问题) }; int main() { // -------------------------- // 方式1:按文本格式写入(自动处理格式) // -------------------------- ofstream fout_text("text_output.txt"); // 默认模式:ios::out | ios::trunc(创建+清空) if (!fout_text.is_open()) { cerr << "打开文本文件失败!" << endl; return -1; } // 类似cout的写法,自动处理换行和空格 fout_text << "写入一行文本" << endl; // 写入字符串并换行 fout_text << 123 << " " << 456 << endl; // 写入数字+空格,再换行 fout_text.close(); // 关闭文件 // -------------------------- // 方式2:写入二进制数据(结构体示例) // -------------------------- // 打开二进制文件,必须加ios::binary模式 ofstream fout_bin("binary_output.bin", ios::binary); if (!fout_bin.is_open()) { cerr << "打开二进制文件失败!" << endl; return -1; } // 初始化结构体 User u; u.id = 1001; strcpy(u.name, "zhangsan"); // 给字符数组赋值(注意长度不超过20) // 按字节写入整个结构体(共24字节:4+20) fout_bin.write((char*)&u, sizeof(u)); // (char*)&u:将结构体地址转为字节指针 fout_bin.close(); // 读取刚才写入的二进制文件 ifstream fin_bin("binary_output.bin", ios::binary); if (fin_bin.is_open()) { User read_u; fin_bin.read((char*)&read_u, sizeof(read_u)); cout << "读取到的id:" << read_u.id << endl; // 输出 1001 cout << "读取到的name:" << read_u.name << endl; // 输出 zhangsan fin_bin.close(); } // -------------------------- // 方式3:追加模式写入(日志场景常用) // -------------------------- // 打开文件时指定ios::app模式(追加) ofstream fout_app("log.txt", ios::out | ios::app); if (!fout_app.is_open()) { cerr << "打开日志文件失败!" << endl; return -1; } // 每次写入都会追加到文件末尾,不会覆盖原有内容 fout_app << "这是一条日志:程序启动" << endl; fout_app << "这是一条日志:处理完成" << endl; fout_app.close(); cout << "三种写入方式均执行完成,请查看生成的文件。" << endl; }

解释代码(还是挺好理解的):

cout是ostream类的实例,且是标准输出流的全局对象,定义在<iostream>头文件中,用于向标准输出设备(通常是屏幕)输出数据。核心区别:功能相似(都能写数据),但操作对象不同。

cout是ostream的实例,专门向标准输出设备(屏幕) 写数据;

ofstream的实例(如fout)是ostream的子类实例,专门向文件写数据。两者都继承了

ostream的写操作能力(比如都能用<<运算符),但操作的目标不同 —— 一个输出到屏幕,一个输出到文件,这是最核心的区别。

ofstream手动传模式时,ios::out会被强制包含,所以写ios::binary等价于ios::out | ios::binary,两种写法都对。

ifstream默认自带ios::in,即使不写,打开时也会强制包含in模式(必须文件存在才能读),所以直接写ifstream fin("file.txt")即可,无需显式加ios::in。

fout_bin.write((char*)&u, sizeof(u))是将结构体u的内存字节原样写入文件,拆解理解:

&u:取结构体变量u的内存地址(起始地址);

(char*)&u:将地址强制转为char*类型(按单个字节访问内存,确保能逐个字节读写);

sizeof(u):计算结构体u占用的总字节数(比如User结构体是 24 字节);整体:从

u的起始地址开始,读取sizeof(u)个字节,原样写入fout_bin关联的文件中。作用:二进制保存数据(保留内存原始布局),适合存储结构化数据(如协议包、结构体)

.bin只是文件后缀名(约定俗成的标识),不代表文件内容一定是二进制。

后缀

.bin通常用来标记 “二进制格式文件”(比如结构体数据、固件、二进制协议数据),方便人识别这不是文本文件。但本质上,文件内容是否为二进制,取决于写入时是否用

ios::binary模式且按原始字节存储,和后缀无关。哪怕后缀是.txt,只要用二进制模式写入非文本数据,它就是二进制文件(记事本打开乱码)。但我实践发现无论哪种都提示【此文件是二进制文件或使用了不受支持的文本编码,所以无法在文本编辑器中显示】简单说:

.bin是 “二进制文件” 的常用标签,但不是绝对标准,关键看内容和写入方式。关于那段“读取刚才写入的二进制文件”:

打开二进制文件

ifstream fin_bin("binary_output.bin", ios::binary);

用

ifstream打开文件binary_output.bin,指定ios::binary模式(二进制读取,保证字节不被转换)。因为

ifstream默认带ios::in(读模式),所以无需额外写,但必须确保文件存在。检查文件是否打开成功

if (fin_bin.is_open()) { ... }

这是必要的判断,避免文件不存在找到或权限问题导致的后续操作崩溃。

读取二进制数据到结构体

fin_bin.read((char*)&read_u, sizeof(read_u));

read()是二进制读取函数,第一个参数是 “接收数据的内存地址”(强制转char*是因为函数要求字节指针),第二个参数是 “要读取的字节数”(sizeof(read_u)即结构体总大小,比如前面的User是 24 字节)。作用:从文件中读取和结构体大小完全一致的字节,直接 “填” 到

read_u的内存里,还原出写入时的id和name。输出读取结果

read_u.id和read_u.name能直接正确输出,因为二进制读取完整还原了写入时的内存结构,没有丢失或转换任何字节。

read()函数本身是二进制读取操作,它的作用是从流中读取指定数量的原始字节,不做任何编码转换或格式解析(比如不会把字节转成字符、数字等),读取的就是内存中最原始的二进制数据。无论流是否打开了

ios::binary模式,read()都是按字节读取,但区别在于:

带

ios::binary时:字节完全原样读取,不处理换行符(比如 Windows 下的\r\n不会被转换为\n)。不带

ios::binary时(文本模式):系统可能会自动转换某些特殊字节(如换行符),导致读取的字节数和实际存储的不一致。因此,用

read()时几乎都要配合ios::binary模式,才能保证读取的字节和写入的完全一致(尤其是结构化数据、二进制文件)。Linux 系统调用

read()(不是 C++ 的read()成员函数)本质上也是二进制读取—— 它直接从文件描述符对应的文件中读取指定数量的原始字节(字节流),不做任何编码或格式转换,读取的是文件在磁盘上存储的原始二进制数据,比如用read(fd, buffer, n)时,buffer里得到的就是文件中连续的n个字节(无论这些字节是文本、图片还是结构体),和数据的具体格式无关。这一点和 C++ 中ifstream::read()配合ios::binary模式的行为一致:都是 “按字节原样搬运”,不解析内容,只处理原始二进制数据。不乱码本质是数据字节符合文本编码(如 ASCII)的可打印规则。

二进制写入(

ios::binary)的核心是按内存原始字节直接存储,不做任何编码转换(包括不转 ASCII),这些字节是给计算机程序读取的(比如后续用代码解析结构体)。

ios::binary模式的典型场景:

存储结构化数据(如结构体、协议包);

存储非文本文件(图片、音频、视频);

需要精确保留数据原始字节(比如加密数据、二进制协议)。

二进制写入的内容无论输出到什么后缀的文件(.txt、.bin 等),用记事本打开大概率乱码—— 因为记事本强制按文本编码(ASCII/UTF-8 等)解析字节,而二进制数据中包含大量不可打印的字节(如整数、浮点数的原始字节),自然显示乱码。

不是 “只能输出到二进制文件”,而是二进制数据本身不适合用文本编辑器查看,后缀名只是标识,关键是数据格式。即使后缀是

.txt,二进制内容用记事本打开还是乱码,必须用代码按原始结构(如结构体)读取才能正确解析。

二进制模式:原样读写字节,适合非文本数据(如结构体),无转换,不乱码。

文本模式:自动转换换行符、误判符,适合纯字符,非文本数据用会乱码。

所以读二进制写入的内容必须用 binary 模式。

三大主要功能之外的实战场景,大厂面试 / 工作常遇到的几个东西:

定位读写位置(随机访问,服务端处理大文件常用)

查看代码

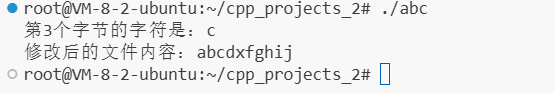

#include <fstream> #include <iostream> #include <string> using namespace std; int main() { // 1. 准备一个测试文件,先写入初始内容 ofstream finit("data.txt"); finit << "abcdefghij"; // 写入10个字符:a b c d e f g h i j(索引0-9) finit.close(); // 2. 用读写模式打开文件(ios::in | ios::out) fstream fs("data.txt", ios::in | ios::out); if (!fs.is_open()) { cout << "文件打开失败!" << endl; return -1; } // 3. 移动写指针到第5个字节(索引4),写入'x' fs.seekp(4, ios::beg); // 从开头偏移4字节(指向第5个字符'e') fs << "x"; // 覆盖'e'为'x',此时文件内容变为:a b c d x f g h i j // 4. 移动读指针到第3个字节(索引2),读取字符 fs.seekg(2, ios::beg); // 从开头偏移2字节(指向第3个字符'c') char c; fs >> c; // 读取'c' // 5. 输出结果 cout << "第3个字节的字符是:" << c << endl; // 输出:c // 6. 验证文件整体内容(读取全部内容打印) fs.seekg(0, ios::beg); // 读指针移回开头 string content; getline(fs, content); cout << "修改后的文件内容:" << content << endl; // 输出:abcdxfghij fs.close(); }

解释:

fs是流对象,fs << "x"是向该流关联的文件写入 "x"。不调用

seekp时,写指针默认在文件开头,fs << "x"会覆盖文件第一个字符。这里'x'、“x”都是一个字符x,只有abc字符串必须是双引号。

seekp用于移动输出(写)指针,指定下一次写入数据的位置;

seekg用于移动输入(读)指针,指定下一次读取数据的位置。两者参数相同(偏移量和起始位置),但分别控制读写操作的位置。如果读指针当前位置是 5 时,若再用

seekg(n, ios::cur)(从当前位置偏移),新位置就是 5 + n;若用ios::beg则从开头算(与当前位置无关),ios::end从结尾算

fstream fs("data.txt", ios::in | ios::out);这行是 “打开文件” 的操作,后续close针对这个的

if (!fs.is_open())只是判断,和打开无关。

fstream在定义时如果不写模式,默认就是ios::in | ios::out,所以这两种写法完全等价:fstream fs("data.txt"); // 不写模式,默认就是 ios::in | ios::out fstream fs("data.txt", ios::in | ios::out); // 显式写出模式,效果一样

必须文件预先存在(因为带

ios::in),否则打开失败;打开后不会清空文件原有内容(默认不带

ios::trunc);读写指针默认都在文件开头,写入时会从当前位置覆盖内容(比如原有

abc,写入d会变成dbc)。简单说:

fstream默认是 “读写已有文件,不清空,按位置覆盖”。实际开发中,显式写出模式更推荐,尤其是团队协作时 —— 别人一眼就能看出你要 “读写” 文件,避免误解(比如误以为默认模式是只写或只读)

三大主要功能之外的实战场景,大厂面试 / 工作常遇到的几个东西:

如何判断文件是否读完?

Q:有必须要学吗?豆包回答

A:这些基础文件流操作是大厂 Linux C++ 服务端开发基础岗的必备知识,必须掌握,服务端开发天天和 “数据持久化”“日志读写”“配置文件解析” 打交道,比如:

读取配置文件(如

server.conf)初始化服务参数;写日志文件(如

access.log)记录请求信息;临时文件处理(如缓存中间数据)。

这些场景本质都是文件读写,

ifstream/ofstream的基础操作(打开 / 判断成功 / 按行读 / 格式化写 / 关闭)是最常用的工具,面试和工作中一定会。查看代码

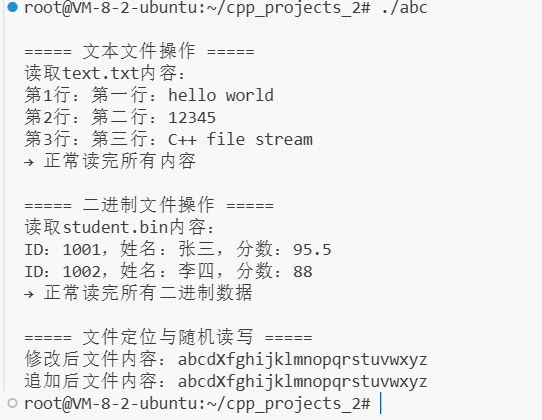

#include <fstream> // 文件流核心头文件 #include <iostream> // 控制台输入输出 #include <string> // 字符串处理 #include <cstring> // 字符数组操作(二进制读写用) using namespace std; // 演示文本文件读写(按行读写) void text_file_operation() { cout << "\n===== 文本文件操作 =====" << endl; // 1. 写文件(默认模式:ios::out | ios::trunc → 创建+清空) ofstream fout("text.txt"); if (!fout.is_open()) { // 必须检查打开是否成功 cerr << "创建text.txt失败!" << endl; return; } // 写入几行内容 fout << "第一行:hello world" << endl; fout << "第二行:12345" << endl; fout << "第三行:C++ file stream" << endl; fout.close(); // 写完关闭(好习惯) // 2. 读文件(默认模式:ios::in → 必须文件存在) ifstream fin("text.txt"); if (!fin.is_open()) { cerr << "打开text.txt失败!可能文件不存在" << endl; return; } // 按行读取并打印 string line; int line_num = 1; cout << "读取text.txt内容:" << endl; while (getline(fin, line)) { // 简洁写法:循环读直到结束 cout << "第" << line_num++ << "行:" << line << endl; } // 判断读取终止原因 if (fin.eof()) { cout << "→ 正常读完所有内容" << endl; } else if (fin.fail()) { cerr << "→ 读取过程出错!" << endl; } fin.close(); } // 演示二进制文件读写(适合存储结构体、二进制数据) void binary_file_operation() { cout << "\n===== 二进制文件操作 =====" << endl; // 定义一个结构体(模拟网络协议数据、用户信息等) struct Student { int id; char name[20]; // 固定长度,避免string的二进制兼容性问题 float score; }; // 1. 写二进制文件(必须加ios::binary模式) ofstream fbin_out("student.bin", ios::out | ios::binary); if (!fbin_out.is_open()) { cerr << "创建student.bin失败!" << endl; return; } // 写入两个学生数据 Student s1 = {1001, "张三", 95.5}; Student s2 = {1002, "李四", 88.0}; fbin_out.write((char*)&s1, sizeof(s1)); // 按字节写入 fbin_out.write((char*)&s2, sizeof(s2)); fbin_out.close(); // 2. 读二进制文件(必须加ios::binary模式) ifstream fbin_in("student.bin", ios::in | ios::binary); if (!fbin_in.is_open()) { cerr << "打开student.bin失败!" << endl; return; } // 读取并打印 Student temp; cout << "读取student.bin内容:" << endl; while (fbin_in.read((char*)&temp, sizeof(temp))) { // 循环读结构体 cout << "ID:" << temp.id << ",姓名:" << temp.name << ",分数:" << temp.score << endl; } // 判断读取终止原因 if (fbin_in.eof()) { cout << "→ 正常读完所有二进制数据" << endl; } else if (fbin_in.fail()) { cerr << "→ 二进制读取出错!" << endl; } fbin_in.close(); } int main() { text_file_operation(); // 文本文件读写 binary_file_operation(); // 二进制文件读写 }

先解释代码的作用:

服务端开发中:

文本操作的核心需求是 “人类可读写”:

配置文件(如

.conf.ini):人类可直接编辑(比如修改服务端口、超时时间),必须用文本格式。日志文件(如

.log):需要人类能直接查看(比如排查错误时 grep 关键词),文本格式最方便。协议交互(如 HTTP、JSON):基于文本的协议易读易调试,广泛用于跨系统通信。

二进制操作主要用于存储 / 传输结构化数据,核心优势:读写效率高、数据紧凑,适合对性能敏感的场景:

保存用户信息、游戏存档等结构化数据(用结构体直接读写,比文本解析快);

网络传输协议数据(二进制格式体积小、解析快,避免文本转义问题);

读写图片、音频等二进制文件(这类文件本身不是文本,必须用二进制模式)。

C++ 的

ifstream/ofstream/fstream(ios 派生类)析构时会自动关闭,C 语言的fopen打开的文件需手动用fclose关闭。细节

cout << "第" << line_num++ << "行:" << line << endl;,line_num++是后置自增,先输出当前line_num的值,再让它加 1(这个总拿不准)继续解释其他自己挖掘的东西:(以下所有的一切依旧是豆包误人子弟反复言之凿凿的瞎编各种规则,需要我反复质疑实践才行,狗逼豆包狗改不了吃屎!!死全家的垃圾玩意!每次学个最最最操.你妈简答的东西都得被豆包气个半死!!)(全世界除了我!没任何第二个人能做到通过傻逼狗逼豆包学习!!操.你妈没豆包真的无法进行,自己会思考很多东西,但有豆包,基本每天的犯错率高达 80%!!且回答 90% 都是垃圾信息,但可以用我的顶尖的追问质疑思考能力化解)(又他妈扯到了编译器版本啥的)

while (fin.good() && getline(fin, line))、while (getline(fin, line))(大厂常用)、while (getline(...) && !fin.fail())等价。

fin.good():检查流的状态是否 “完全正常”,即goodbit有效,无任何错误标志

返回

true:说明之前的操作没出错,可以继续读。返回

false:可能是已经读到末尾(eofbit),或发生错误(failbit/badbit),循环终止。

getline(fin, line):从文件流fin中读取一行内容到line变量。

成功读取一行时,返回

true,继续循环。失败时(比如已到文件尾,或读取出错),返回

false,循环终止。此文搜“字符,直到遇到指定分隔符”,其实

getline也是,原型为getline(istream& is, string& str, char delim),默认delim是 '\n'

fin.good()会提前排除 “已到文件末尾” 的情况,而getline(fin, line)“读到末尾”返回的也是失败。

!fin.fail()为真时,包含两种情况:流完全正常(goodbit),或仅到达文件末尾(eofbit且无错误)。

good()为真时,仅表示流完全正常(无任何错误标志,包括eofbit也不能有)。

二进制那里,出错的本质就是没完整读完一个结构体。

比如这里如果文本的来解读结构体,是没有字节边界的,只有连续字符(

1001张三95.5),全靠>>的 “类型规则” 拆分:

读

id(int):只取数字字符,遇到非数字(“张”)就停,没错读了1001读

name(char[]):没有 “字节限制”,只认空白字符当终止信号,“张三” 后面是 “95.5”(非空白),就一直读,直到文件结束,自然把score的字符也吞进去;读

score(float):已经没字符可读,只能是垃圾值。二进制:

1001、"张三"、95.5写的时候就分了 3 个块(id4 字节 +name20 字节 +score4 字节),然后读时按块取,各块不干扰。且name里的\0能识别有效字符结束,双重保障不读95.5;文本:读

char[]时,根本不把\0当终止信号!只认空格 / 换行,且写时不分块,把 3 个成员的字符全拼进一个连续块,读时无块边界,只能盲目一个内存块一直读,读name时,读文本用getline只认换行,用>>只认空格,所以哪怕name里有\0也跳过,继续读后面的95.5。千辛万苦的追问,豆起初始终不回答这个!!

这些结论很 JB 飘渺,况且狗逼豆包说的误人子弟自相矛盾,直接让豆包给个实验代码,自己运行后就嘎嘎透彻了,反而觉得上面这些结论是累赘,这个实验才是有价值的

查看代码

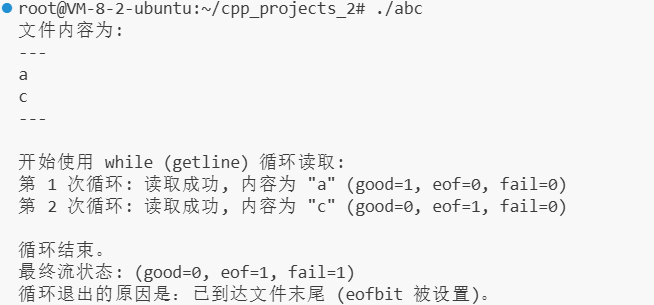

#include <fstream> #include <iostream> #include <string> using namespace std; void printState(ifstream& fin) { cout << "good=" << fin.good() << " eof=" << fin.eof() << " fail=" << fin.fail() << endl; } int main() { // 创建测试文件:内容为 "a\nb"(a换行b,无结尾换行) ofstream("test.txt") << "a\nc"; ifstream fin("test.txt"); string line; cout << "初始状态:"; printState(fin); cout << "读第一行:"; getline(fin, line); // 读"a" bool res1 = !fin.fail(); // 用 fail() 判断是否成功 cout << "res=" << res1 << " "; printState(fin); cout << "读第二行:"; getline(fin, line); // 读"b" bool res2 = !fin.fail(); cout << "res=" << res2 << " "; printState(fin); cout << "读第三行:"; getline(fin, line); // 到末尾,失败 bool res3 = !fin.fail(); cout << "res=" << res3 << " "; printState(fin); } 输出: root@VM-8-2-ubuntu:~/cpp_projects_2# ./abc 初始状态:good=1 eof=0 fail=0 读第一行:res=1 good=1 eof=0 fail=0 读第二行:res=1 good=0 eof=1 fail=0 读第三行:res=0 good=0 eof=1 fail=1 root@VM-8-2-ubuntu:~/cpp_projects_2#自己零零碎碎的总结是(经过豆包肯定):

注意,起初写的是

bool res1 = !getline(fin, line);但报错,getline返回的是流对象,不能直接赋值给bool变量,所以这么写了,其实也可以bool res = !getline(...).fail()。

good是读到什么东西,他后面没东西了,但这次读取完good就返回 0(这不是 “错误”,只是流不再完全正常),后续再读就是已经没东西的,必然依旧是 0,而getline等价!fail,读到什么东西,他后面没东西了,但这次读取完返回的依旧是 1。所有流状态成员(

eof()/good()/fail()等)的状态,都是在 当前读取操作完成后 才更新的。

所有 C++ 输入流操作(

>>、getline、read等),本质都是通过修改流的状态标志(eof/fail/good)来反馈结果,只是触发时机和getline有差异。再验证个>>查看代码

#include <fstream> #include <iostream> #include <string> using namespace std; void printState(ifstream& fin) { cout << "good=" << fin.good() << " eof=" << fin.eof() << " fail=" << fin.fail() << endl; } int main() { ofstream("test.txt") << "a\nb"; // 文件内容:a换行b(无结尾换行) ifstream fin("test.txt"); string line; cout << "初始状态:"; printState(fin); cout << "读第一个字符串:"; fin >> line; // 读"a"(跳过后续换行) bool res1 = !fin.fail(); cout << "res=" << res1 << " "; printState(fin); cout << "读第二个字符串:"; fin >> line; // 读"b" bool res2 = !fin.fail(); cout << "res=" << res2 << " "; printState(fin); cout << "读第三个字符串:"; fin >> line; // 无内容可读 bool res3 = !fin.fail(); cout << "res=" << res3 << " "; printState(fin); } 输出: root@VM-8-2-ubuntu:~/cpp_projects_2# ./abc 初始状态:good=1 eof=0 fail=0 读第一个字符串:res=1 good=1 eof=0 fail=0 读第二个字符串:res=1 good=0 eof=1 fail=0 读第三个字符串:res=0 good=0 eof=1 fail=1 root@VM-8-2-ubuntu:~/cpp_projects_2#

>>和getline的标志处理完全一样。

bad()是流的另一个状态标志,仅在 “流底层发生严重错误”(如硬件故障、文件被意外删除)时为 1,日常读写(末尾、正常失败啥的)都不会触发。good()的判断逻辑是eof=0 && fail=0 && bad=0。流对象(如

fin)被隐式转换为bool时,结果等价于!fail()这是 C++ 标准强制规定,getline(fin, line)返回fin,转换为bool就是!fin.fail():成功时fail()为 0,转换后为true;失败时fail()为 1,转换后为false。

eof()仅在 “尝试读取超出文件 / 流末尾”时返回true

fail()在读取失败时(比如读到文件末尾后还想继续读、读入数据类型不匹配等),返回true

getline不能直接cout输出有意义的结果

getline执行后,fin的fail()状态会被更新,if (getline(fin, line))本质上就是在判断!fin.fail(),底层绑定!fail(),getline会把读到的字符存进line里)。

流对象是 C++ 标准库中用于输入 / 输出操作的具体对象实例,比如:

ifstream fin("file.txt")定义的fin(文件输入流对象);

cin(标准输入流对象,对应键盘);

ofstream fout("out.txt")定义的fout(文件输出流对象)。

good()/eof()/fail()是它们的成员函数(直接属于这些对象),这些实例弄好以后,就可以用getline、运算符重载函数 >>、read()之类的函数来操作流对象的函数,调用后返回的就是这些对象本身,返回本身的意思是说,调用完之后,流里就有了数据,且查询功能good/eof/fail一并更新,但这里豆包指出了我的理解问题:“调用后返回的就是这些对象本身,返回本身的意思是说,调用完之后,流里就有了数据”—— 这里的 “返回本身” 和 “流里有数据” 无关。

返回流对象本身,单纯是函数设计的返回值形式(方便链式调用,比如

getline(fin, line).getline(fin, line2)),而 “流里有数据” 是操作(比如getline)的结果,两者是分开的:操作会让流的状态(good/eof/fail)更新,也会把数据读到变量(比如line)里,而返回流对象只是提供了一个 “继续操作该流” 的入口。

cout << a << b << c这种连续使用<<的写法叫 “链式调用”(连锁操作)。

这里其实我的思考是,俩代码都只是侧面验证,并没有直接输出

getline,而这个东西又无法直接输出,算了不研究了(邓钦泽,遇到了再说)

常用搭配(推荐):

二进制文件通常用

read()/write()(按字节操作,适合非文本数据);文本文件通常用

getline()或>>(按字符 / 行操作,适合人类可读的文本)。

辩论解析:

二进制文件不适合用

getline,原因是:getline的核心逻辑是 “从流中读取字符,直到遇到换行符\n为止”,这是针对文本文件的设计(文本中\n是明确的换行标记)。而二进制文件中,

\n可能只是普通字节(比如图片、视频数据中随机出现0x0A,即\n的 ASCII 码),此时getline会误判为 “行结束”,导致读取的数据被截断或错乱,因此,二进制文件应始终用read()按字节数读取。

read能读文本文件,但不推荐:read是按字节数强制读取(比如read(buffer, 100)读 100 字节),不管内容是不是文本,会原封不动读字节(包括换行符\n、空格等)。但文本文件的核心是 “按字符 / 行解析”,用getline或>>更方便(自动处理换行、空格分隔)。

getline按\n读完整行(包括中间空格)。

>>按空格 和\n等分隔符读(遇到分隔符就停,不是读完整行)。

read会从当前位置连续读取指定字节数(如read(buf, 1024)就读 1024 字节),不关心内容中的空格、换行等分隔符,纯粹按字节连续读。

if (fin.eof()):检查是否设置了eofbit标志(eof()是判断该标志的函数)。

如果

true:说明循环是因为 “读到文件末尾” 而终止,属于正常情况(比如文件内容全部读完)。

else if (fin.fail()):检查是否设置了failbit标志(fail()是判断该标志的函数)。

如果

true:说明读取过程中发生 “可恢复的错误”(比如用>>读数字时遇到字母,或文件突然被删除)。

文本的懂了,然后解读

while (fbin_in.read((char*)&temp, sizeof(temp))):

fbin_in是二进制输入流对象(如ifstream),read尝试从流中读取sizeof(temp)字节到temp地址((char*)&temp是类型转换,确保字节级操作)。

若读取成功(读到预期字节数),此时流状态为未失败(即依旧是看

!fail,不说正常是因为可能已触发eofbit),条件为真,继续循环;

read函数的返回值本质就是流对象,但作为循环条件时起作用的是其 bool 转换结果(即!fail()),流对象能作为条件是因为其内部重载了 bool 转换运算符,实际返回的是!fail()的结果,而非单纯 “返回对象本身” 这一形式

!fail()仅表示未发生失败(failbit和badbit未设置),但可能已设置eofbit(如最后一次读取恰好到文件尾且读满),这种情况不属于 “完全正常”,只是操作有效,不代表流无任何标志位(可能含 eofbit)。

若 读取失败(循环退出),分两种场景:

场景 1:因 “到达文件尾” 导致未读到

sizeof(temp)字节(如文件只剩 2 字节却要读 4 字节):此时同时设置eofbit和failbit,即eof()、fail()为真。注意如果文件尾恰好与

sizeof(temp)字节对齐(即最后一次读满),则eofbit会被设置但failbit不会,此时属于 “读取成功”。不属于该场景。

场景 2:因 “非文件尾原因” 导致未读到

sizeof(temp)字节(如文件损坏、权限不足、读取中断):仅设置failbit(或叠加badbit),eofbit为假;两种场景均因

fail()为真,导致条件为假,循环退出

哎!傻逼豆包啰里吧嗦我就给帖上了,兴许以后会用到,但其实脑海里有代码运行真他妈觉得废话连篇!

fail()为真时,说明设置了failbit(如格式错误:用>>读整数却遇到字母),这种错误可通过clear()清空标志后继续操作流(可恢复);而badbit(严重错误,如硬件故障)会让fail()也为真,但此时流无法恢复。

fail()为假时,才是 “无failbit且无badbit”,此时可能是good()(全正常)或仅eofbit置位(读到尾)。

!fail()返回 true(1) 时 = 既没有可恢复失败(failbit),也没有严重错误(badbit),也就是说fail如果为真,那么就是failbit或badbit至少有一个。“可恢复” 指的是操作失败但流还能继续用,比如:

用

>>读整数时遇到字母(格式错),fail()会触发,但可以清空错误标志后重新读其他内容;而

badbit是严重错误(如硬件故障),流彻底用不了,不可恢复。

!fail()排除的是这种 “可恢复的失败”,但文件尾(eofbit)不算失败,所以eof时!fail()为真,但流已经读到头了:

!fail()就像在说:“上次的操作还算顺利,没有出什么岔子”。但是,“顺利” 也包括 “顺利地读完了所有数据”。所以,当你read()到文件最后一个字节时,操作是顺利的(!fail()为true),但文件也确实读完了(eofbit被设置)。因此,光看!fail()为true,你无法确定接下来还能不能读到数据。你还需要检查eof()来确认是否已到文件末尾

总结:

good()是 “一切完美”(没到尾,没任何错);为真条件:仅当所有错误标志(包括 eof、fail、bad)都为假,是唯一 “完全正常” 的状态。

!fail()是 “没出大错”(可能到尾了,但没格式错、没硬件故障,还能接着用或正常结束);

fail()是 “出了可修复的错”(比如读错格式,清掉标志还能救);

bad()是 “彻底完蛋”(硬件故障,救不活了)。

注意后面还有说法!!这些只针对

getline、>>。

三大主要功能之外的实战场景,大厂面试 / 工作常遇到的几个东西:

如何处理大文件(避免内存爆炸)?

绝对不能一次性读入内存!必须 “分片读”

先搞懂核心问题:为啥不能 “一次性读大文件”?比如你要读一个 10GB 的电影文件:

如果你想 “一次性读完”,就得在内存里开一个 10GB 的空间装它;

但普通服务器 / 电脑的内存可能就 8GB/16GB,根本装不下,程序会直接崩溃(这就是 “内存爆炸”);

就像你搬 100 箱苹果,不能一次全抱在怀里(抱不动),得一次抱 2 箱,分 50 次搬 —— 这就是 “分片读”。

查看代码

// 1. 定义一个“搬运箱子”的大小:4KB(4096个字节) // 为啥是4KB?是系统和磁盘的“最佳搬运尺寸”,效率最高,不用纠结,照用就行 const int BUFFER_SIZE = 4096; // 2. 造一个“4KB的箱子”(内存里的一块空间),专门用来装每次读的文件片段 char buffer[BUFFER_SIZE]; // 3. 循环“搬箱子”:每次从大文件里读4KB到“箱子”里 // 直到“没的可搬”(读到文件末尾) while (fin.read(buffer, BUFFER_SIZE)) { // 4. 把“箱子”里的4KB数据,写到目标文件里(相当于把2箱苹果搬到目的地) fout.write(buffer, BUFFER_SIZE); } // 5. 处理“最后剩下的零头”:比如大文件是4097字节,最后一次只能读1字节 // gcount() 就是“最后一次实际搬了多少字节” int remaining = fin.gcount(); // 6. 如果有零头,就把零头也写进去(不然最后1字节会丢) if (remaining > 0) { fout.write(buffer, remaining); }然后先科普个东西 —— 代码规范,说大厂有用且后面完整代码就涉及到这个

@是Doxygen注释的标记,让工具自动提取注释生成规范文档

param是parameter(参数)的缩写,配合 @标记函数输入参数的含义和要求,格式:@param 参数名 描述(含要求)注释里的 “标签” 就是带

@的标记(比如@brief/@param),用来给注释分类,让人一眼分清 “功能”“参数”“返回值”。

//是短注释

/** ... */是 “长注释”,适合写函数 / 类的详细说明,里面的@xxx是约定好的标签写法,用来分类说明(比如 @brief 说功能、@param 说参数),可以被工具生文档,比如查看代码

/** * @brief 复制超大文件(支持任意大小,不爆内存) * 👉 解释:这行是函数的“一句话功能总结”,告诉别人这个函数最核心的作用——复制大文件,还不会让内存爆炸。 * * @param src_path 源文件路径(必须存在) * 👉 解释:@param 表示“函数的输入参数”,这里说的是: * - src_path 是参数名(代码里用这个名字接收用户输入的路径); * - 作用是“源文件的路径”(就是你要复制的那个文件,比如 /home/user/10GB.iso); * - 括号里是“使用要求”:这个文件必已经存在 * * @param dst_path 目标文件路径(存在则覆盖,不存在则创建) * 👉 解释:第二个输入参数: * - dst_path 是参数名; * - 作用是“复制后新文件的路径”(比如 /home/user/copy_10GB.iso); * - 使用要求:如果这个路径已经有同名文件,就直接覆盖它;如果没有,就自动创建一个新文件。 * * @return true:复制成功;false:复制失败(会打印错误原因) * 👉 解释:@return 表示“函数执行完后返回给调用者的结果”: * - 返回 true → 复制搞定了; * - 返回 false → 复制没成功(比如文件打不开、磁盘满了) */继续科普,

win的cmd实现win → linux:scp C:\Users\GerJCS岛\Desktop\图图.jpg root@81.70.100.61:/root/cpp_projects_2这是win → linux,倒过来顺序就是linux → win。

这个操作是从 Windows 直接向 Linux 服务器上传文件。你的 Windows 是客户端,Linux 服务器是接收端。为了让你能把文件放到 Linux 服务器上,服务器需要验证你的身份,所以你得输入服务器上

root用户的密码!Zzxc11位。由于我登陆

SSH的是root的目录下的,传的目标目录就是/root/cpp_projects_2,所以@前必须是root,写成~/cpp_projects_2也行,~自动绑定@前面那个用户名的家目录,顺序都是scp 源 目的,如果是别人电脑往我服务器传,依旧是如此。

Linux里实现win → Linux,由于不认识C盘符,所以具体是:scp GerJCS岛@192.168.43.86:/C/Users/GerJCS岛/Desktop/图图.jpg root@81.70.100.61:/root/cpp_projects_2

但报错了,第一中文名说找不到,第二 win 下执行的是 “Win 作为客户端 → 连 Linux 服务器”,只需要 Linux 开 SSH(22 端口)就行;但 Linux 端执行的是 “Linux 作为客户端 → 连 Win”,这就需要 Win 也开 SSH 服务(监听 22 端口),我貌似 win 没有,不强行搞了。

这个操作是从 Windows 电脑向 Linux 服务器拉取文件。此时,Linux 服务器变成了客户端,它需要连接到你的 Windows 电脑去获取文件。你的 Windows 电脑为了安全,会要求 Linux 服务器证明自己的身份,所以你需要输入 Windows 电脑上

GerJCS岛用户的密码。术语:

Linux 服务器主动从你的 Windows 电脑获取文件就是拉取,Windows 主动把文件传给 Linux 服务器就是推送。但输入密码这块,是谁主动发起操作,就输入 “对方”(目标端)的密码,和 “拉取 / 推送” 的说法无关,本质是 “客户端验证目标端的身份”。

且不管谁往谁传,双方都必须联网,联网的具体知识是:

关于win,不是必须联网才能看到 IP,但未联网时的 IP 基本没用,一般无法和外网通信,顶多系统会自动分配一个

169.254.x.x开头的私有 IP,任何169.254.x.x的都是没网的东西不用看,只能用于本地设备间的临时通信。只有当 Windows 连网,才能获取到能和外网交互的有效 IP,此时用 ipconfig 命令看到的 IPv4。关于腾讯云 Linux 服务器,它的公网 IP 是客观存在且绑定服务器的,不管联不联网都有,但是必须联网才能通信,才能用。

Q:老子发现

VScode可以拖,那你他妈给这scp不是多此一举脱裤子放屁了吗?A:直接拖文件到 Linux:只有 “本地设备和 Linux 在同一台电脑 / 同一局域网” 才管用,

scp主要是给真正的异地服务器啥的用到。开始说大文件的代码:

豆包说,大厂 Linux 服务端互相传东西是为了:

同步代码、配置(比如把开发好的程序传到测试 / 生产服务器);

共享数据(比如日志文件、用户数据在多台机器间流转);

分布式计算(把大任务拆给多台机器一起做,结果汇总)。

简单说:单台 Linux 干不了所有活,必须多台组队,传东西是组队的 “信息 / 资源纽带”。

Q:你意思大厂合并啥的还需要写段代码?

A:大厂合并数据、服务等场景,必须写代码(或用脚本)来自动化处理数据同步、服务调度、资源整合,不然靠人工根本搞不定大规模集群的协作。

Q:没有啥按钮合并?

A:在大厂的 Linux 服务端场景中,几乎没有 “一键合并” 的按钮,必须靠代码 / 脚本实现自动化,因为:

大厂的系统是 “定制化、分布式、大规模” 的,通用按钮满足不了复杂业务逻辑;

代码能精准控制合并的每一步(比如数据校验、并发处理、故障回滚),按钮做不到。

查看代码

真的好痛苦!总想求助王钰涵!求助鱼皮 帮帮我 我410元的硬座从乌鲁木齐到哈尔滨回家过年,坐72h的火车硬座都没求过人 求人不是我的性格! 我就要干死他们!!饿肚子都没想过求谁 如今这真的太痛苦了3天解决一个100%不考的各种细节!每天解决一个细节且都是无关紧要的哎 强迫症陷里面了!!感觉C++强迫症挖掘太多东西了!清晰知道自己在深渊!但就是无法出头 更加的对自己狠 王志文抬进考场 罗斯 中科院黄国平! 爸爸的病 我要逼自己更加砸时间!而不是求那些商人!!!!! 更加高效率,除了学习导管子可以不看手机 破而后立 强迫症考古回忆确认占实际学习的60% 垃圾豆包信息写博客占用80% 什么都查什么都学好奇无数琐碎钻研,占用90%的时间 且豆包回答每天 80%的错误率 90%的垃圾信息 看透他们99%的人 可我呢 我何时能出头?能显化? 我的春天在哪里 妈妈给我钱 爸爸两面手一次术,割肾造瘘,可我能做什么? 每天在家什么也做不了 只有我可以带来好消息 儿子出息之类的 我热。起码学就可以会 但爸爸的病,只能听天由命 爸爸妈妈的希望是我 儿我的希望。是让父母开心 虽然妈妈一直说,希望我做个平凡普通人 我年轻 吃烂的水果,吃便宜的吃的,我可以恢复 爸爸的病,无法改变。没法变好了 我c++真有那么难吗 现在学这个 scp这 打字都打累了 骂都骂累了 豆包大模型真的完全是幼儿园的水平 但我又能问谁? 我躺在烂泥粪坑里打滚的 僵死的臭虫抽搐 殿大头踩着头 磐不妄把头按在粪坑里 画彩璃 星神子 更加狠绝给自己鼓气 没水没卫生间只能大小便在屋子里,洗澡拿着淋浴器洗个60%,洗衣服洗个60%,上厕所排个60% 这一年多,成长最慢的是技术,成长最快的是挖掘天赋和心性磨练 考个公吧没本事成啥样 我考上深圳东北 但不去 证明自己 我大厂LinuxC++服务端开发 做技术的,技术出生 但你要知道我29去之前的经历阅历! 技术!对我来说,是我最不擅长的弱势弱点!!!我因为没办法要赚钱,才逼自己学程序员这些玩意。 我要多多的年薪 我不想考公务员 我想投资经商 跟政府谈生意,谈判 我想成为雷军马化腾马云那样的人 这些是我擅长的!! 我想做互联网的大厂高管管理! 国企体制内做技术,就是垃圾 考公就是温饱 想活着 最低要求 不去竞争晋升 真的很舒服 如果还活不下去 说明你真的很垃圾 在我眼里公务员就是最垃圾最没用的回到这个大文件代码,必须都搞到

VScode里,就是Linux上,这时候上面提前追问的就用上了,这里我选择直接导入吧,傻逼豆包给我扯东扯西,追问半天误人子弟,结果VScode除了拖拽就只能scp,根本没右键上传的按钮,打算拖拽上传,然后尝试运行并理解这个复制大文件的代码,因为大文件我最先想到的是视频,直接传了个

35M 的 mp4 文件,但出问题了艹,拖拽完等待 1h 都一直的跑马灯一样蓝色线在资源管理那跑,其他所有东西都卡住,结束没法结束,然后查说想中断要么左下角关闭远程,重新打开,这会确保之前所有的旧连接和任务都被彻底清理掉。或者调出进程杀进程,中断个东西这么麻烦!

这是因为

VSCode的Remote-SSH插件在图形化拖拽文件时,底层依赖的SSH协议本身有加密和网络开销,再加上大文件传输时的资源消耗,练完了scp现在又给我说大厂最常用的是rsync,支持断点续传但有报错,

rsync不允许源地址(GerJCS岛@...)和目标地址(root@...)同时是远程服务器,原来豆包搞错了我的意图,后来弄懂了,现在有个问题是,win用rsync会报错,具体原因是:先捋顺之前的scp,由于当你在 Linux 服务器上运行:

scp GerJCS岛@192.168.43.86:/C/Users/GerJCS岛/Desktop/图图.jpg ...这个命令的意思是:“

Linux服务器啊,请你去连接192.168.43.86这台机器,然后把它上面的/C/Users/.../图图.jpg文件复制过来。”但是,

192.168.43.86是你的Windows电脑。要让Linux服务器能成功连接并复制文件,需要满足几个条件,这也是你之前失败的原因:

Windows电脑需要开启一个 “文件传输服务”:就像你去别人家要拿东西,别人家得有人开门,并且允许你拿。这个 “开门” 的服务通常是SSH服务。你的Windows默认是关闭这个服务的,所以Linux服务器连不上。

Windows的防火墙需要放行:即使开了SSH服务,Windows的防火墙也可能会把 Linux 服务器的连接请求挡住。中文用户名和路径的问题:

GerJCS岛和图图.jpg中的中文,在Linux命令行环境下容易出现编码问题,导致命令无法正确解析路径。虽然可以通过一些方法解决,但这确实是一个常见的坑。但以上这些都根据经验没啥搞的意义,只是

linux无法,但我win可以完美实现,把Windows电脑上的文件传到Linux服务器,正确的方向是 从Windows主动发起传输,即“我的Windows电脑啊,请你把我本地的C:\...\图图.jpg文件,通过网络发送给81.70.100.61这台 Linux 服务器,并存放到它的/root/cpp_projects_2目录下。”

发起方是

Windows:Windows知道自己的文件在哪里。目标是

Linux:Windows通过网络连接到Linux服务器的SSH服务(这个服务Linux通常是默认开启的)。数据流向是

Windows -> Linux:这完全符合 “本地 -> 远程” 的逻辑。且腾讯云服务器

linux本身自带各种监听啥的(Windows默认没有SSH服务(无法被Linux主动连接读取文件),Linux默认开启 SSH 服务(可接收Windows推送)—— 这就是核心原因)哎这些行内代码都是一个一个手动加的

Q:研究这些跑偏吗?

A:不跑偏,有必要,但不用深钻 “封块” 细节 —— 面试核心考的是Linux 命令使用、远程传输逻辑、问题排查思路,你练的 “本地→云服务器传文件 + 服务器内复制” 刚好贴合这些基础考点。

重点:不用纠结 4G/6G 大文件封块(实际工作中

rsync/scp已自动处理),但要掌握:

rsync/scp基本用法(面试可能让写命令);传输卡死 / 失败的排查(如 SSH 连接、权限、路径问题);

服务器内复制用

scp/rsync的区别(如rsync增量同步更高效,只同步变化的)。这些都是服务端开发的日常基础操作,面试会隐含考察(比如问 “怎么把本地代码传到服务器”“大文件传输中断怎么办”),你的练习方向完全对。

Q:那我就想问一下子,我用scp传过去就完事,然后不用实际打开,是吗?那这玩意传有啥意义啊?既然你说不会在服务器上看视频,那一般好像也没有这么大几 G 的,正常大厂实际用的话,他是什么东西能传到 G 这个级别去来回复制?因为我理解就只有视频才能达到这么大。

A:正常!你的疑问很贴合实际 —— 大厂传 G 级文件,核心不是视频,而是服务端开发的核心工作物料,传完也不是 “打开看”,而是 “用起来”(运行、编译、存储等),具体说:

1. 大厂常传的 G 级文件(非视频)

代码 / 项目包:大型 C++ 服务端项目(如分布式系统、数据库内核),源码 + 依赖库压缩后可能达几 G;

数据文件:日志(如服务器天级 / 周级日志,GB 级很常见,用于排查问题)、数据库备份(MySQL/Redis 快照,动辄 10G+)、训练数据(AI 团队的模型训练样本,TB 级都有);

二进制包 / 镜像:编译后的服务程序(大型 C++ 二进制文件可能几 G)、Docker 镜像(复杂服务镜像常达数 G,用于部署);

中间件 / 工具包:如大数据组件(Hadoop、Spark)的安装包,或自定义工具集,多为 G 级。

2. 传这些文件的意义(不是 “看”,是 “用”)

部署服务:把编译好的 C++ 二进制包传到云服务器,启动后端服务(比如用户访问 APP 的接口服务);

数据同步:日志 / 数据库备份传到服务器,用于故障排查、数据恢复;

协作开发:把本地写好的大型项目代码传到服务器,进行远程编译、测试(避免本地环境不一致);

资源分发:把工具包 / 镜像传到多台服务器,统一部署集群(比如分布式服务的多节点)。

3. 关键结论(贴合你面试)

你练的 “本地→服务器传文件” 完全不跑偏 —— 这是服务端开发的日常操作;

不用纠结 “打开文件”:服务端传大文件的核心是 “使用”(运行、编译、存储),不是 “查看”;

面试可能问:“大文件传输中断怎么办?”“怎么高效同步多台服务器的文件?”(你练的

rsync就是答案),这些比 “传什么文件” 更重要。

但我

win用rsync报错了,因为scp和rsync都依赖SSH协议进行安全连接和数据传输。当你在Linux上执行scp时,Linux会尝试通过SSH连接到你的Windows电脑。如果Windows没有开启SSH服务来监听这个连接请求,那么连接就会失败(通常是 “Connection refused”)。它只意味着 “从

Linux拉取Windows文件” 这个操作不行。而 “从Windows推送文件到Linux” 这个操作是完全可行的,而win有scp但没有rsync,所以win用rsync报错,而linux有rsync但根本没法用因为win没开ssh那些,所以rsync咋都没法用,除非win装ssh那些开各种监听,然后在linux上用,或者win装rsync然后再win上用豆包给润色后:

SCP:Win自带scp.exe客户端,可以推送文件到开启了SSH服务的Linux。但Windows默认没有SSH服务,所以Linux无法用scp拉取Windows的文件

Rsync:Windows默认没有rsync命令。Linux虽然有rsync,但它同样依赖SSH来连接另一台机器。因此:

在

Windows上直接用rsync会报错(因为没有这个命令)。在

Linux上用rsync拉取Windows文件也会失败(因为Windows没有SSH服务)。Q:我不装影响我去大厂吗?

A:完全不影响!大厂面试和工作的核心逻辑是:你得懂 “

Windows→Linux推送文件” 的正确方式(这是你已经掌握的,比如用scp推送),且清楚 “为什么不用Linux反向拉取”(因为Windows没开SSH服务,没必要额外配置)—— 这就够了。

“装不装

rsync/ 开不开WindowsSSH” 是 “工具选择”,不是 “能力考察”:面试考察的是你对SSH协议、文件传输逻辑的理解(比如知道scp/rsync依赖SSH,知道推送 vs 拉取的区别),而不是 “你电脑有没有装某个工具”;大厂服务端开发的标准流程就是 “本地→服务器推送”:没人会在

Linux服务器上反向拉取本地Windows文件(效率低、需额外配置本地服务,不符合生产规范),你现在用scp从Windows推送到Linux,完全契合实际工作场景。Q:懂了但我发现,用拖拽卡死,各种无尽的卡死!然后想点这个

mp4删除或者右键删除依旧卡死,而scp或者rm -f秒之A:两个问题核心原因一致:

VSCode远程操作大文件(35M 对VSCode远程预览来说不算小)时,会触发 “文件元数据读取 / 预览尝试”,导致进程阻塞,界面卡死,命令行操作不受此影响,具体拆解:1、右键删除卡死,

rm -f秒删的原因

右键删除:是 VScode 图形界面的操作 —— 你右键时,VSCode 会先尝试读取视频文件的元数据(比如分辨率、时长、文件编码),甚至偷偷启动预览进程(但服务器无视频解码能力),这个过程直接卡住 VSCode 的界面线程,导致删除操作迟迟无法执行;

rm -f秒删:是 Linux 命令行操作 —— 直接跳过所有图形化预览 / 元数据读取,底层调用文件系统接口强制删除文件,不依赖 VS Code 界面进程,自然秒完成。2、拖文件卡死,

scp正常的原因

拖文件(本地拖到

VSCode远程窗口 / 远程窗口内拖动):同样触发VSCode的 “远程文件操作逻辑”—— 拖动时VSCode会同步读取文件数据、校验文件完整性,甚至尝试预加载文件内容(视频文件无法解析,导致进程阻塞),界面就卡死了;

scp正常:是纯命令行基于SSH协议传输 —— 只做 “数据传输”,不涉及任何图形化预览、元数据解析,直接和 Linux 服务器的文件系统交互,没有额外进程开销,所以不会卡。总结核心逻辑:

VS Code远程管理文件的 “图形化功能”(预览、右键操作、拖动),对视频这类 “无法解析的大文件” 兼容性极差,容易触发进程阻塞;而Linux原生命令行(rm -f、scp)不依赖图形化界面,直接操作文件系统,效率极高,所以不会出现卡死问题。后续远程操作大文件(尤其是视频、压缩包等非文本 / 图片文件),优先用命令行:删除用

rm -f 文件名,上传用scp,避免用VSCode图形界面的右键 / 拖动操作,直接绕开卡死问题。

至此基本科普完移动文件这个事,然后开始看代码,豆包给的代码

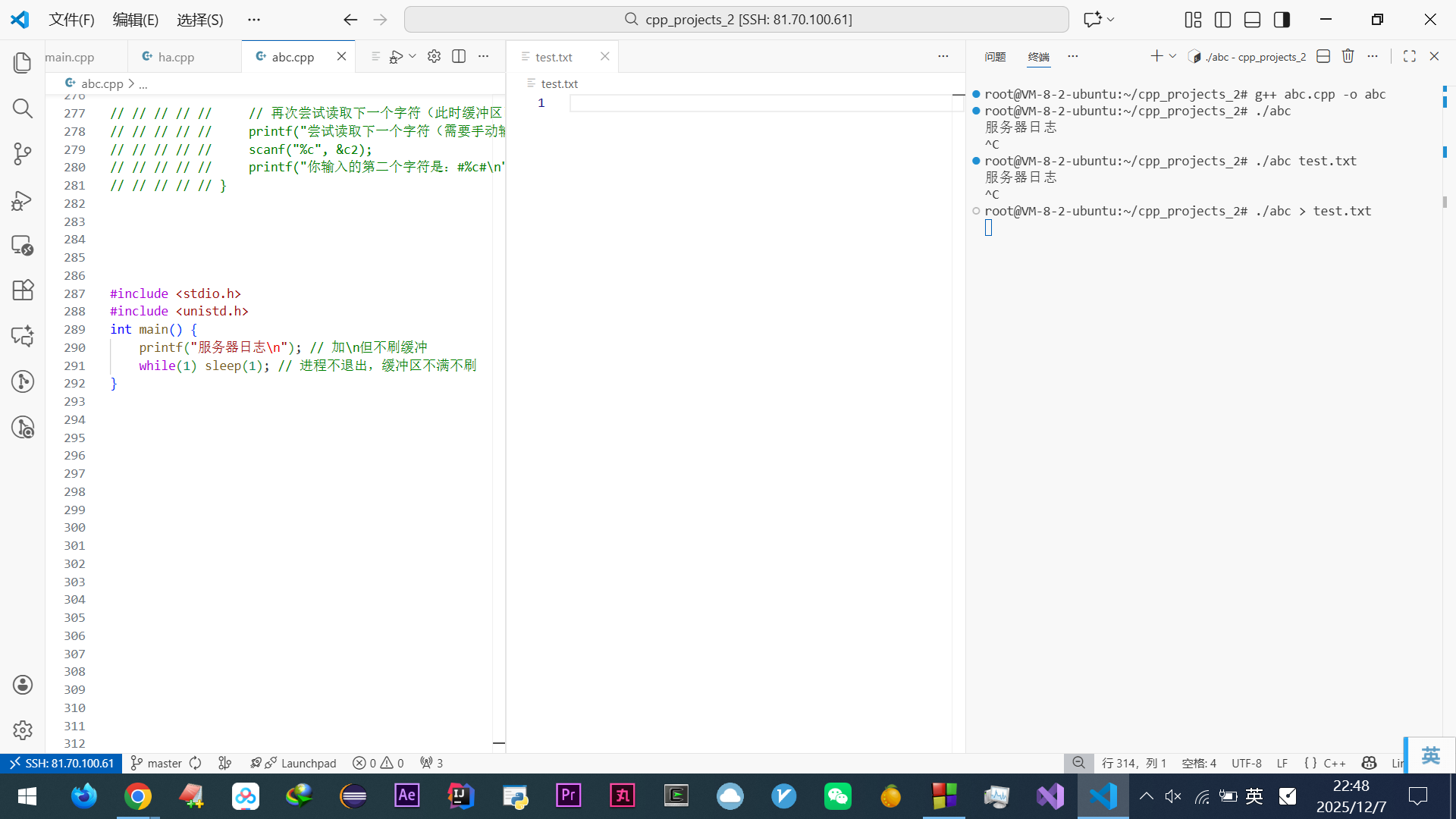

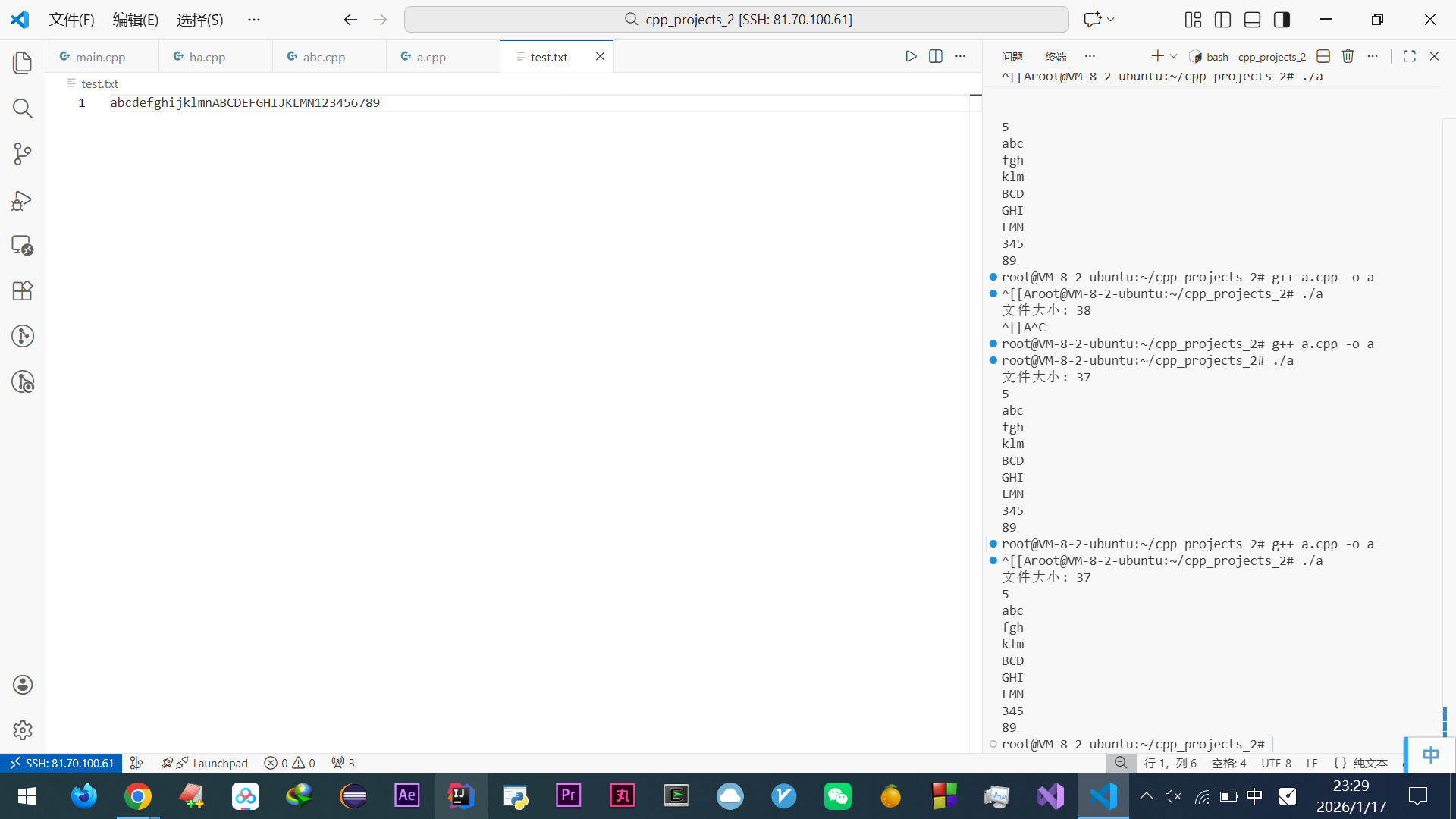

看图,起初运行报错了,原因:

~是一个 Shell 环境变量(在 Bash、Zsh 等终端中),它代表当前用户的主目录(Home Directory)。对于root用户,~就代表/root。这是内置路径替换规则(仅 Shell 会自动将其解析为用户主目录/home/用户名),当你在终端里执行命令时,Shell 会先对命令进行解析。它看到~,就会自动把它替换成/root。所以你实际执行的命令是ls /root/cpp_projects_2,这当然能找到文件。其他程序(包括 C++/Python 代码、系统命令)不会识别。当运行

./abc并输入~/cpp_projects_2/斜门.mp4时,程序接收到的是一个原始的字符串"~/cpp_projects_2/斜门.mp4"。C++ 的标准库(如fstream)并不知道~在 Shell 中的特殊含义,它会把这个路径当作字面量去解释。备注:这个

斜门.MP4是之前闲鱼给人做新年拜年视频红色大门啥的,做视频赚点钱用的。

至此实操完,证明豆包给的代码没问题(埋个坑,注意我只看提示就觉得成功了),开始学习代码:

注意至此我有大量思考,混淆了很多东西,其实很多东西本身就是混杂的,哎最后精通了,说下心路历程吧:

我起初思考是:(算是处理零头的功能引发的血案)

这个代码看似很正常没啥问题,但

while后处理零头没懂,豆包说是读到末尾会返回false,哪怕读到了东西,这就是所谓的零头,然后在读到末尾是返回false还是true咋都说不明白,反复听我口气反复变了 100 个版本,然后我回忆上面说过“所有 C++ 输入流操作(>>、getline、read等),本质都是通过修改流的状态标志(eof/fail/good)来反馈结果,只是触发时机和getline有差异”的那个实验,到末尾!fail位又是1,也就是到末尾是不会退出while的,这里却说到末尾会退出,需要处理零头,然后又扯出来

read和getline、>>不同,我就很疑惑觉得豆包错了,然后又说while会把!fail这个事,到末尾eof时,fail置1,可是之前又说

!fail是包括eof的,那我理解就是fail不包括末尾!也就是可恢复的不包括末尾!!现在豆包又说当

read()操作因为到达文件末尾(EOF)而无法读取请求的全部字节数时,它会设置eofbit。在大多数(如果不是全部)C++ 标准库实现中,设置eofbit也会同时设置failbit。因此,fail()返回true,operator bool()返回false,导致循环退出。也即是fail包括末尾可是却又和代码实际处理零头退出那吻合。咋感觉处处都是疑点?事实又证明了都是对的?

却又都互相矛盾?艹精分了!

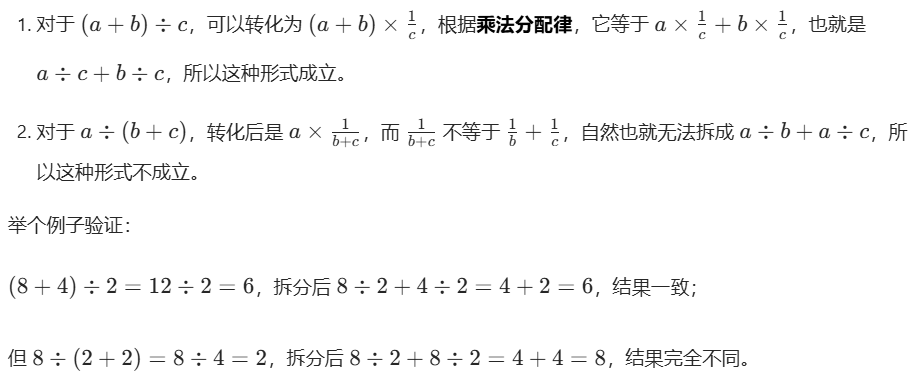

其实上面看似乱套的东西就是真实的脉络地图!!只不过太底层了!!深入说:

起初我理解

while里判断read、getline、>>都是!fail先手写证明几个东西

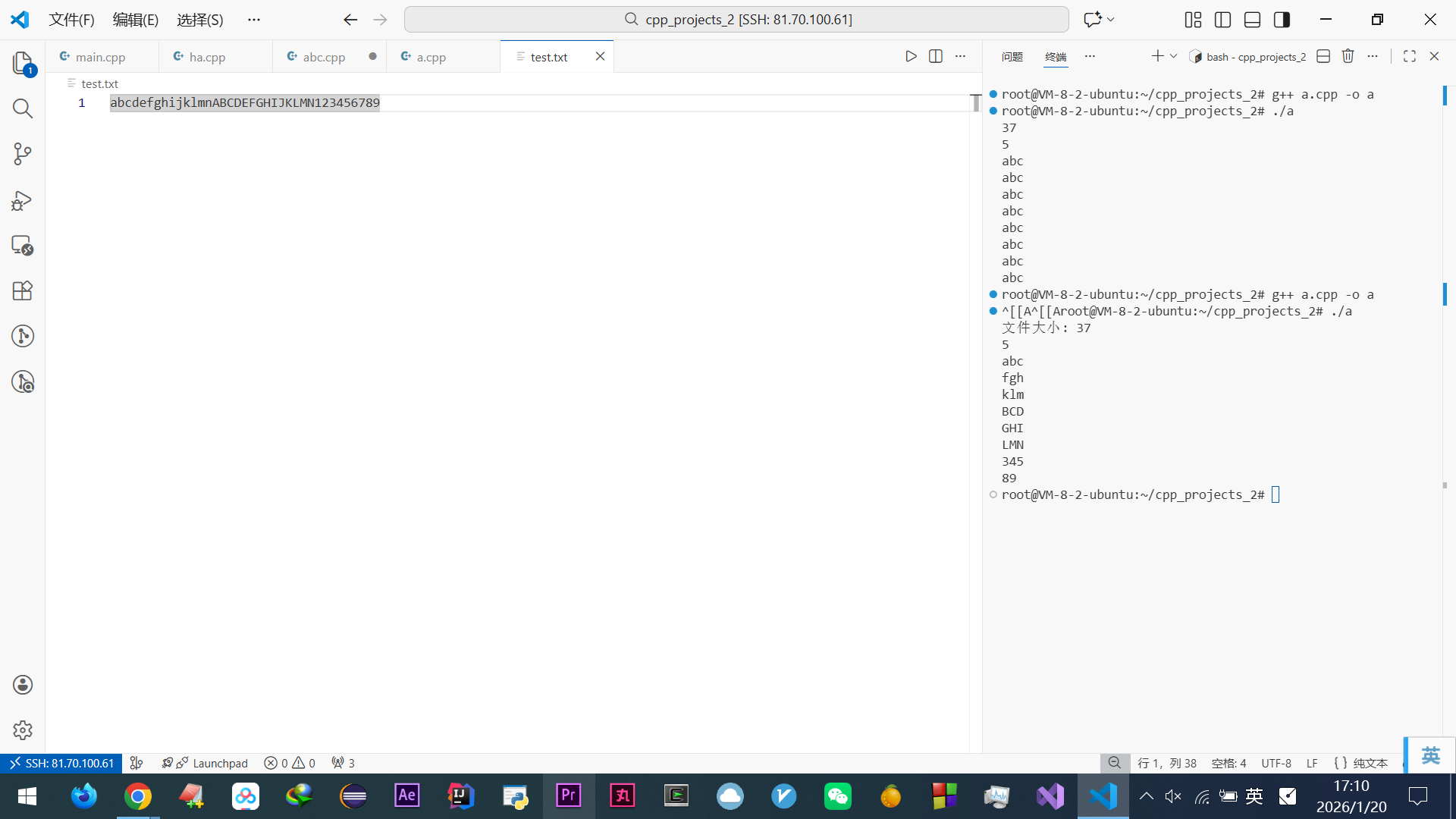

while(read..):查看代码

#include <iostream> #include <fstream> using namespace std; int main() { ofstream fout("test.txt"); for (int i = 0; i < 10; i++) fout.write("A", 1); fout.close(); ifstream fin("test.txt"); char buf[8]; int count = 0; // 循环读取,直到read()返回false while (fin.read(buf, 8)) { count++; cout << "第" << count << "次读取:" << fin.gcount() << "字节(" << (fin.gcount() == 8 ? "读满缓冲区" : "没读满缓冲区") << ")" << endl; } cout << "\n循环结束:read()返回false,最后一次实际读到的字节数:" << fin.gcount() << endl; fin.close(); } 输出: 第1次读取:8字节(读满缓冲区) 循环结束:read()返回false,最后一次实际读到的字节数:2手动手写

read:查看代码

#include <iostream> #include <fstream> using namespace std; // 用于打印流状态的函数 void printState(ifstream& fin) { cout << " (good=" << fin.good() << ", eof=" << fin.eof() << ", fail=" << fin.fail() << ")"; } int main() { ofstream fout("test.txt"); for (int i = 0; i < 10; i++) fout.write("A", 1); fout.close(); ifstream fin("test.txt"); char buf[8]; int count = 0; // 循环读取,直到read()返回false fin.read(buf, 8); count++; cout << "第" << count << "次读取:" << fin.gcount() << "字节(" << (fin.gcount() == 8 ? "读满缓冲区" : "没读满缓冲区") << ")" ; printState(fin); cout<<endl; fin.read(buf, 8); count++; cout << "第" << count << "次读取:" << fin.gcount() << "字节(" << (fin.gcount() == 8 ? "读满缓冲区" : "没读满缓冲区") << ")" ; printState(fin); cout<<endl; fin.close(); } 输出: root@VM-8-2-ubuntu:~/cpp_projects_2# ./abc 第1次读取:8字节(读满缓冲区) (good=1, eof=0, fail=0) 第2次读取:2字节(没读满缓冲区) (good=0, eof=1, fail=1)手动

getline:查看代码

#include <fstream> #include <iostream> #include <string> using namespace std; void printState(ifstream& fin) { cout << "good=" << fin.good() << " eof=" << fin.eof() << " fail=" << fin.fail() << endl; } int main() { // 创建测试文件:内容为 "a\nb"(a换行b,无结尾换行) ofstream("test.txt") << "a\nc"; ifstream fin("test.txt"); string line; cout << "初始状态:"; printState(fin); cout << "读第一行:"; getline(fin, line); // 读"a" bool res1 = !fin.fail(); // 用 fail() 判断是否成功 cout << "res=" << res1 << " "; printState(fin); cout << "读第二行:"; getline(fin, line); // 读"b" bool res2 = !fin.fail(); cout << "res=" << res2 << " "; printState(fin); cout << "读第三行:"; getline(fin, line); // 到末尾,失败 bool res3 = !fin.fail(); cout << "res=" << res3 << " "; printState(fin); } 输出: 初始状态:good=1 eof=0 fail=0 读第一行:res=1 good=1 eof=0 fail=0 读第二行:res=1 good=0 eof=1 fail=0 读第三行:res=0 good=0 eof=1 fail=1 root@VM-8-2-ubuntu:~/cpp_projects_2#

while(getline.. ):此文搜“累赘,这个”

发现加

while并没有改变任何,唯独差别就是

getline和>>读东西读到末尾,fail是 0

read读东西读到末尾,fail是 1底层逻辑是:

1.read()的行为(二进制 / 字节流读取):

成功条件:必须读取到 请求的全部字节数。

失败条件:

到达文件末尾(EOF),无法读满。

发生其他 I/O 错误。

failbit设置时机:只要没读满,即使读到了部分数据,也会设置failbit。循环表现:

while (fin.read(...))会在 读满时进入循环,在 未读满(如 EOF)或出错时退出循环。零头处理:正因为未读满时循环会退出,所以需要在循环外通过

fin.gcount()获取最后一次读取的实际字节数(零头)并处理。一句话总结

read():追求 “完美读满”,差一个字节都算失败。2.

getline()和>>的行为(格式化 / 行读取):

成功条件:成功读取到 至少一个有效字符(对于

getline()是读到换行符或 EOF 前的字符,对于>>是读到非空白字符)。失败条件:

到达文件末尾(EOF),一个字符也没有读到。

发生其他 I/O 错误。

输入的数据与期望的格式不符(主要针对

>>)。

failbit设置时机:只有在 完全没有读到任何有效数据 时,才会设置failbit。循环表现:

while (getline(fin, line))或while (fin >> var)会在 读到数据时进入循环,在 什么都读不到(EOF)或出错时退出循环。零头处理:不需要专门处理。因为即使在文件末尾读到了不完整的一行(没有换行符),

getline()也会认为读取成功,将内容存入字符串,并在下一次调用时才返回false这个区别是由它们的设计目标决定的:

read()是底层工具,用于精确控制字节流,适合二进制文件。它的契约是 “按要求读取”。

getline()和>>是高层工具,用于方便地处理人类可读的文本数据。它们的契约是 “尽力读取有意义的数据”。好,至此清晰的知道了

read、getline、>>差别,敲死结论了,然后再!fail到底包不包括eof这个要重新梳理,之前的写法都删掉了!!因为都学会再写博客没法写,不知道该从哪里写起,懂完12345,但基础可能是12,不知道具体该写2还是写3,怕写少了后面忘了想回顾,回顾不上,所以都是学一点写一点,之前写的while(getline...)里!fail是否包括eof不适合read,现在做终结解释!:

fail()是 C++ 输入流(istream)的一个成员函数,它返回一个bool值,用于判断上一次输入操作是否失败。核心定义:什么是 “失败”?

fail()返回true(表示失败)的情况是:

发生了可恢复的错误。这通常意味着输入操作因为某种原因没有按照预期完成,但流本身并未损坏,你可以尝试清除错误状态并继续操作。

具体来说,

fail()为true主要包括以下几种场景:

格式化输入不匹配:当你使用

>>操作符读取特定类型的数据,但输入流中的下一个数据无法被解析为该类型时。

例子:你用

int x; cin >> x;,但输入的是"abc"。

read()操作未读满请求的字节数:当你调用fin.read(buffer, N)试图读取N个字节,但由于到达文件末尾(EOF)或发生其他错误,实际读取的字节数小于N时。

注意:这是

read()函数的特殊行为,它对 “成功” 的要求是 “完全成功”。

getline()操作因流状态不佳而失败:如果在调用getline()之前,流已经处于fail或bad状态,那么getline()会失败。

但:如果

getline()成功读取了一行(即使这行是文件的最后一行),它不会设置failbit,即使eofbit被设置了。关键区别:

fail()vs.bad()vs.eof()为了更好地理解

fail(),必须将它与另外两个常用的状态判断函数区分开。C++ 流的状态由三个独立的标志位控制:failbit,badbit, 和eofbit。

函数 含义 标志位 错误类型 是否可恢复 fail()操作失败 failbit可恢复的逻辑错误 是 (通常用 clear())bad()流已损坏 badbit不可恢复的严重错误 否 eof()到达文件末尾 eofbit不是错误,只是一个状态 是 (意味着没有更多数据可读)

bad():这通常表示发生了更底层的、严重的错误,比如硬件故障、文件被意外关闭等。一旦badbit被设置,这个流基本上就报废了,很难恢复。

eof():这只表示 “文件末尾”(End Of File)。它本身不是一个错误,只是一个通知你 “没有更多数据了” 的状态。

fail()的行为总结

fail()为true:操作没有按预期完成(例如,类型不匹配、read()没读够)。这是一个可恢复的错误。

fail()为false:上一次操作成功完成,或者虽然到达了文件末尾(eof()为true),但操作本身(如getline()读取了最后一行)被认为是成功的。对你之前代码的解释

read()的例子:

第二次

read()只读到 2 字节,没满足请求的 8 字节。这被视为一次 “失败” 的

read操作,因此failbit被设置。所以

fin.fail()返回true。

getline()的例子:

第二次

getline()成功读取了最后一行 "c"。虽然到达了文件末尾(

eofbit为true),但getline()的任务(读取一行)成功完成了。因此

failbit不 被设置,fin.fail()返回false。只有当

getline()尝试在已经到达 EOF 的流上再次读取时,它才会失败,failbit才会被设置。

fail()在读取失败时(比如读到文件末尾后还想继续读、读入数据类型不匹配等),返回true对错?

场景一:读到文件末尾后还想继续读。

行为:第一次到达文件末尾时,

read()会设置eofbit。在 GCC/Clang 下,它还会设置failbit。

fail()返回值:true。结论:你的说法在这种情况下是 对 的。

场景二:读入数据类型不匹配(例如用

>>读一个整数,但文件里是字母)。

行为:

>>操作会失败,设置failbit。

fail()返回值:true。结论:你的说法在这种情况下是 对 的。

场景三:在到达文件末尾前,

read()未能读满请求的字节数(即你代码中读取 “零头” 的情况)。

行为:

read()会设置eofbit和failbit(GCC/Clang)。

fail()返回值:true。结论:你的说法在这种情况下是 对 的。

但是,存在一个反例,这是关键!

反例:

getline()成功读取到一行,但其末尾就是文件末尾。

行为:

getline()成功读取了数据,设置eofbit,但 不设置failbit。

fail()返回值:false。结论:虽然到达了文件末尾(

eofbit为true),但getline()认为这次读取操作是 成功 的,所以fail()返回false。你的说法在这种情况下是 错 的。总结:

fail()返回true表示 “操作失败”,但不同的 I/O 函数对 “成功” 的定义不同:

read():必须读取到 请求的全部字节数 才算 “完全成功”。如果因为 EOF 未能读满,也算一种 “失败”,所以设置failbit。

getline()/>>:只要成功读取到 至少一个有效数据单元(一行或一个符合类型的数据),就算 “成功”。即使这个数据单元恰好在文件末尾,也不算 “失败”,所以不设置failbit。因此,你的原始结论 “

fail ()在读取失败时返回 true” 是正确的,但你对 “读取失败” 的理解需要更精确:fail()只在操作本身逻辑上失败时返回true,而eofbit的设置与否并不直接等同于fail()的结果。关于

!fail()是否 “包含”eof的诡异理解。你感觉 “说包括也对,不包括也对”,这正是因为

read()和getline()的行为不同。结论:

对于

read()而言:!fail()不包括eof的情况。

一旦

read()因遇到eof而未读满,failbit就会被设置,fail()为true,!fail()为false。循环退出。对于

getline()而言:!fail()包括eof的情况。

getline()成功读取了包含EOF的一行后,failbit仍为false,!fail()为true。循环会继续执行一次。最终敲死的结论:

!fail()是否包含eof,取决于你使用的是哪个 I/O 函数。

使用

while (fin.read(...)):!fail()不包含eof。循环会在第一次遇到eof(并导致未读满)时退出。使用

while (getline(fin, line)):!fail()包含eof。循环会在成功读取了末尾的行之后,在下一次调用getline()时才退出。

!fail包括eof啥意思?我理解!fail是 0 或 1 啊?哪来的包括这个东西?

!fail()的结果要么是true(1),要么是false(0),它是一个布尔值,本身不可能 “包含” 另一个东西(比如eof)。人们说“

!fail()包括eof”,是一种 简化的、不严谨的说法,实际想表达的是:在很多场景下(比如用while (fin.read())时),当eof(文件末尾)发生时,!fail()的结果会变成false,导致循环退出 —— 看起来就像!fail()把eof的情况 “包含” 进来作为退出条件了。但本质上:

!fail()只由failbit和badbit决定(和eofbit本身无关);是某些函数(比如

read()在 GCC/Clang 中)在触发eofbit的同时,会顺带设置failbit,才让!fail()变成false的。这也就是之前疑惑的,内心OS:

fail和eof独立咋还能设置别人?本身就是while里多连带设置了下,然后read和getline本身也有差异?

fail和eof是独立状态位,但某些函数(如 GCC/Clang 下的read())会在触发eof时顺带设置fail;

read()与getline()的差异在于:前者未读满时设fail,后者读到有效数据(即使到末尾)不设fail;“

!fail包括eof” 是简化说法,本质是eof触发时可能连带让!fail为false,导致循环退出。终于懂了,不该骂豆包!看似很胡扯但 VScode 实际做实验就是如此!

read()与getline()/>>的核心差异(GCC/Clang 下)

操作 未读满 / 格式错误时 到达末尾(EOF)时 fail()是否包含 EOF?read()设置 failbit设置 eofbit+failbit是 getline()设置 failbit(格式错)设置 eofbit,不设failbit否 >>设置 failbit(格式错)设置 eofbit,不设failbit否 C++11+ 核心规则:

operator bool()仅返回!fail(),不检查eofbit;到达末尾仅设

eofbit时,fail()为false→ 循环本应继续;差异在编译器:GCC/Clang 未读满 + EOF 会额外设

failbit→ 循环退出;MSVC 不设 → 循环继续。

主流编译器:

GCC(GNU Compiler Collection):

我

win下的codeblock里装的w64devkit是 Linux 的 GCC 编译器的win版本VS Code 代码编辑器,不是编译器,远程的 Linux 服务器预装的 GCC,是 Ubuntu 默认编译器

MSVC:

Visual Studio C++自带,兼容

win的API用的Clang / LLVM:

Apple 的 Xcode 开发工具默认使用 Clang,也被 Google、Facebook 等大公司广泛采用

只有 GCC 和 Clang(LLVM)会有这 “读末尾零头设 failbit” 的特例,微软的 MSVC 是完全遵循 C++ 标准的:用 MSVC 编译你的代码(10 字节文件 + 8 字节缓冲区),循环会执行两次:第一次读 8 字节(进循环),第二次读 2 字节(仍进循环),第三次读 0 字节(退出循环),

gcount()分别返回 8、2、0,完全符合标准行为。简单说:MSVC 按标准来,GCC/Clang 搞了个特例,仅此而已。

老子跑去

VS的MSVC试验下,傻逼 VS 的自动补全,是给傻逼残废用的吗???操.你妈真的百利无一害狗逼玩意!!!想写啥阻碍你,给你乱加东西咋删删不掉。滚轮滑动总是滑到底不停但 VS 的 cpp 另存为控制台的 GBK936 会报错,因为源代码包含 GBK 不支持的字符,另存为 utf8 就控制台乱码,加

system("chcp 65001 > nul");临时让控制台为 utf8codeblock 也有乱码,解决方法此文搜“好了,不”,方法改 cpp 为 GBK ,估计 codeblock 整个链内部都是 GBK,可改 utf8,但 MSVC 的是 utf8 所以改 GBK 不行,然后运行必须和控制台的 gbk 一致,结果他妈的老子实践发现 VS 里也是一模一样!

豆包说 C++ 标准 (例如 C++17 29.7.4.3.1) 中对

read()的描述是,它会在以下情况下设置failbit:[...] If the function does not encounter end-of-file, it stores

ncharacters in the sequence whose first element is designated bys. Otherwise, it storesstd::min(n, gcount())characters [...]. The function then setsfailbitif the number of characters stored is less thannandeofbitis not set. [...]这段文字的意思是:

如果读取过程中没有遇到文件末尾(EOF),但读取的字节数小于

n,则设置failbit。如果读取过程中遇到了 EOF,导致读取的字节数小于

n,则不设置failbit。然而,主流编译器(GCC, Clang, MSVC)在实践中都选择了在遇到 EOF 且未读满时也设置

failbit。这种行为被认为更实用,因为它能更明确地表示 “读取操作未完全成功”。如果标准的字面意思被严格遵守,那么while (fin.read(...))循环会在文件末尾多读一次(因为failbit未设置,read()返回true),这通常不是开发者想要的行为。之前豆包说 VS 这类的会不同,但现在反而减轻负担了,上面有提到 MSVC 和 GCC 会不同的可以忽略了。

狗逼豆包总是犯错总需要把代码结果给他才能学习然后继续帮助我,不然的话总他妈一会就抽风给我说

read读到数据然后遇到末尾,!fail也是true,其实是假,然后fail是trueQ:这些属于啥知识?

A:C++、算法、网络、OS 是核心,但要成为一名合格的 Linux C++ 服务端开发工程师,还需要一些 “粘合剂” 知识,它们能让你把核心知识真正用起来。

文件操作的知识属于 Linux 系统编程(System Programming) 和 OS交叉的范畴。

除了文件 I/O,你还需要学习以下几个方面的知识:

Linux 系统编程 (System Programming)

进程管理:

fork,exec,wait,exit信号处理:

signal,sigaction进程间通信 (IPC):管道 (

pipe)、命名管道 (FIFO)、共享内存 (shmget,shmat)、消息队列 (msgget,msgsnd)、信号量 (semget,semop)线程与同步:

pthread库、互斥锁 (mutex)、条件变量 (condition variable)、读写锁文件 I/O:你问的这部分,包括

open,read,write,close,lseek等底层系统调用,以及fcntl设置文件状态标志(非阻塞等)。网络编程 (Network Programming)

这部分你提到了,但要更深入。

基础 Socket 编程:

socket,bind,listen,accept,connect,send,recvI/O 模型:阻塞、非阻塞、I/O 多路复用(

select,poll,epoll)高级网络技术:零拷贝(

sendfile)、TCP 粘包 / 拆包处理、定时器实现、防抖动 / 重连机制。工程工具与实践 (Engineering Tools & Practices)

构建系统:

CMake,Makefile版本控制:

Git调试工具:

gdb,strace,valgrind(内存检测)性能分析:

perf,gprof日志系统:熟悉常见的日志库(如

glog)和实践代码规范:遵循 Google C++ Style Guide 等

总结一下,除了你提到的,还需要重点学:Linux 系统编程、网络编程(深入)、工程工具。文件操作只是 Linux 系统编程 中的一个章节。

然后说了这么多,回顾之前代码本来是大文件,我就先入为主复制了个视频,由于无法打开,只想着显示成功就赶紧删掉不然卡死,然后心无旁骛研究代码,但现在看还是需要实际测试下,那就复制一个

txt里是这几行的文本文件,每次读 3 个字节,这样既能模拟大文件,分批次复制,还可以看最后复制的是否正确,先搞个source.txt,代码:查看代码