续:啃操作系统

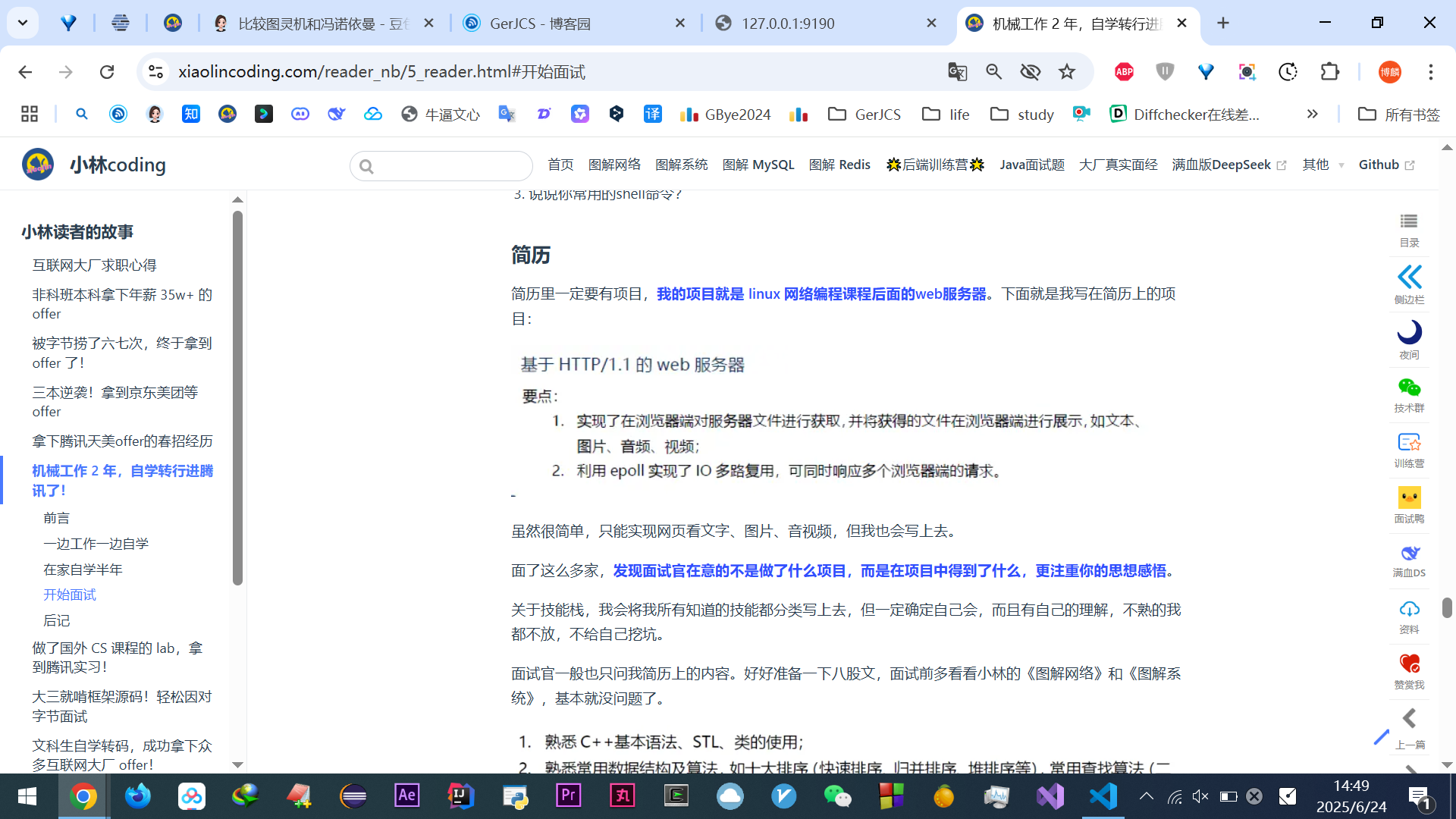

开始看小林编程 — 操作系统

硬件结构

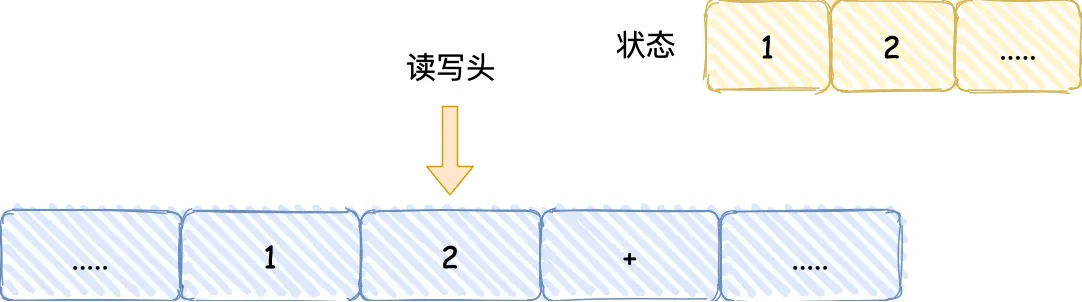

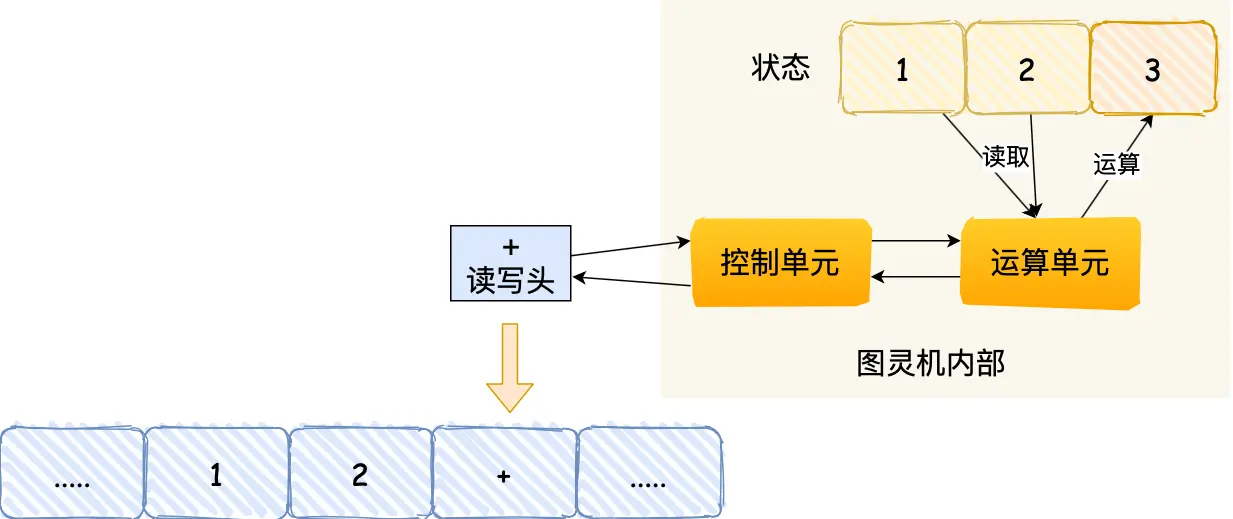

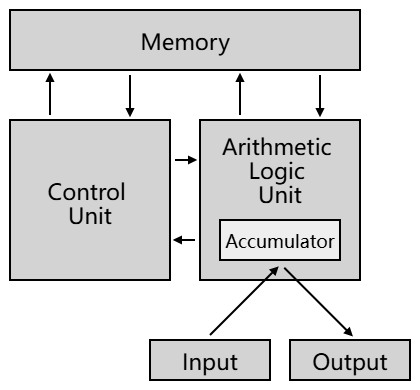

从图灵机(一个控制器、一条无限长的纸带、一个读写头组成,能模拟任何计算过程,还没有计算机的概念)开始说起,来了解程序执行的底层原理和进化过程

比如1+2咋执行的,图灵机有个读写头,数据是「1、2、+」这 3 个字符,图灵机实物里,就是3个格子,读一个就个「控制单元」,识别字符是数字还是运算符指令,发现是数字,就存入名叫“图灵机的状态”的存储设备里

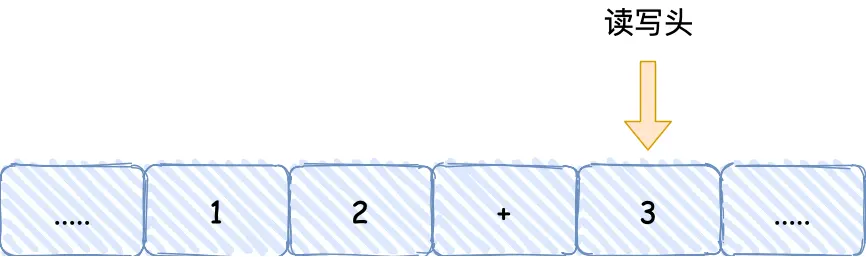

遇到“+”号后,给「控制单元」,它识别字符是运算符指令,通知「运算单元」工作:把状态中的 1 和 2 读取进来并计算,结果3返回给读写头,写到状态中

最后移动,把3这个结果写入下一个格子

后来冯诺依曼提出了计算机设计思想,定义计算机基本结构为 5 个部分,称为 冯诺依曼模型:

运算器、控制器、存储器、输入设备、输出设备

小知识:

-

中央处理器=CPU ,它是计算机的核心部件,里面有个用来暂存数据等的小容量高速存储部件寄存器,还有运算器和控制器

-

控制器=控制单元 ,负责指挥计算机各部件协调工作

-

存储器由众多存储单元组成,用来存储数据和程序,内存就属于存储器

-

运算器=逻辑运算单元 ,负责进行算术运算和逻辑运算

- 寄存器属于运算器和控制器的一部分,暂存数据&指令

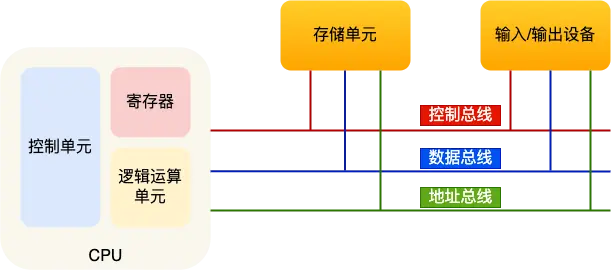

接下来说说:内存、中央处理器、总线、输入输出设备

内存:

线性存储,基本单位字节(byte),即8bit,一个字节就是一个内存地址

从0开始编号,自增,最后一个地址是内存总字节数-1

中央处理器CPU:

- 32 位 CPU 一次可以计算 4 个字节;

- 64 位 CPU 一次可以计算 8 个字节;

位是位宽,理解为人的能力,是CPU内部数据处理通道的量化表示方式

8位CPU一次只能计算1字节0~255范围内的数值,无法一次计算10000*50

CPU里有寄存器、控制单元、逻辑运算单元:

控制单元负责控制 CPU 工作

逻辑运算单元负责计算

寄存器种类很多,主要负责存储计算数据,内存距离CPU太远,计算速度没寄存器快

通用寄存器:存放需要进行运算的数据

程序计数器:存储CPU要执行指令的内存地址,指令在内存中

指令寄存器:当前正执行的指令

总线:

地址总线:用于指定 CPU 将要操作的内存地址

数据总线,用于读写内存的数据

控制总线,用于发送和接收信号(中断、设备复位啥的)

CPU读写内存数据:通过地址总线找内存地址,控制总线控制读or写命令,数据总线传输

输入/输出设备:

按下输入设备的键盘,跟CPU交互,控制总线,然后输出设备

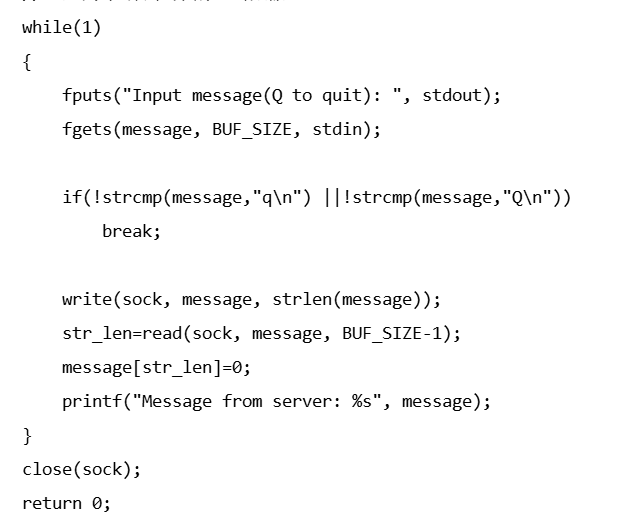

下一话题

线路位宽与CPU位宽:(有点像二进制毒奶牛问题)

这里透彻理解了位(这里小林+豆包追问很棒,之前考北邮的时候书里写的云里雾里):小林coding这段解释的看完太精华了,醍醐灌顶豁然开朗

CPU通过地址总线控制内存地址,具体底层逻辑是通过高电压和低电压(高1低0),CPU根据需要,将地址总线上的电压设置为高或低,来选择要操作的特定内存地址,

比如:只有一个地址总线,那每次就只能表示0和1两种地址,

具体是:

地址总线为高电压时,表示逻辑 “1”,此时 CPU 会去访问对应编号为 “1” 的存储单元,低的也同理

由于数据是一位一位串行的通过线路传输,下一个bit必须等到上一个bit传输完才能传输,所以通过增加线路来并行传输。所以当有2条地址总线,CPU就能操作的内存地址最大数量是00、01、10、11四个

以上是线路位宽

CPU 的位宽最好不要小于线路位宽,32 位 CPU 控制 40 位宽的地址总线和数据总线的话,工作起来就会非常复杂且麻烦

32 位的 CPU 最好和 32 位宽的线路搭配,因为 32 位 CPU 一次最多只能操作 32 位宽的地址总线和数据总线。

至此捋顺下几个之前很模糊的概念:

- 1位CPU意味着一次只能处理1位二进制数据,比如传输5,二进制是101,三位二进制数据,就需要3次

- 1 位宽地址总线就是只有 1 条地址线。因为地址信息以二进制表示,这条线上仅有高电平(代表 1 )和低电平(代表 0 )两种状态 ,所以只能表示 2 种不同地址

- 那么同理,32位CPU可以一次性书里32位大小的数字,严谨点说其实是指十进制化为二进制后的32位。同时再深入说下,32位CPU的计算机,指令是4字节,看似是往“满了占”,但实际是为了能与数据总线宽度匹配。这样在指令传输时,可一次传输一条完整指令,无需分割或多次传输,所以过长分隔过短能力没利用全,也与 CPU 一次能处理的二进制数据位数相契合,便于 CPU 对指令进行快速译码和执行,同时可以包含丰富指令集比如操作数操作码地址立即数啥的

- 64位电脑指的是电脑的硬件系统(如内存、总线等)以及操作系统等软件都要支持 64 位的运算和处理,CPU架构是64位的

- x64和x86是架构,x86就是32位,为啥不叫x32因为x86是英特尔的早期处理器名称末尾是86就广泛使用了,所以如果x64架构,那也就是64位计算机,他的CPU也是64位宽,也就是64位操作系统都是通的

- 64位CPU地址总线是48位

- 32位CPU地址总线是32位

如果32位CPU去加两个 64 位大小的数字,不能一次算出,需要把这 2 个 64 位的数字分成 2 个低位 32 位数字和 2 个高位 32 位数字来计算,先加个两个低位的 32 位数字,算出进位,然后加和两个高位的 32 位数字,最后再加上进位

而64位就可以一次性算出

一般很少算超过32位数字,所以不超过32位数字的时候,32跟64没啥区别,所以不能说64 位 CPU 性能比 32 位 CPU 高很多,只有当计算超过 32 位数字的情况下,64 位的优势才能体现出来

32 位 CPU 最大只能操作 4GB 内存,就算你装了 8 GB 内存条,也没用

而 64 位 CPU 寻址范围则很大,理论最大的寻址空间为 2^64

这他妈不比计算机顶配资源王道讲的好千百倍??当然也可能是七个烧饼理论

毕业后acm水平峰值 中学毕业后开始好奇万物 28开始青春期 开始发力 毕业6年后开始考研水平 孙法:你啥专业的啊?计算机里排序都不懂 1、11、2、27、5、8、99这样的 实在绝望 发现编程指北相见恨晚,很简单清晰的路线 而很多人评论说编程指北难上天了都 他们喜欢速成

注意:

计算机内存地址中二进制计数,所以将210数量级等效为1K

1 字节(Byte) = 8 位(bit)

1KB = 210Byte = 210B

1MB = 210KB

1GB = 210MB = 220KB = 230B

232Byte = 22*230B = 4*230B = 4GB

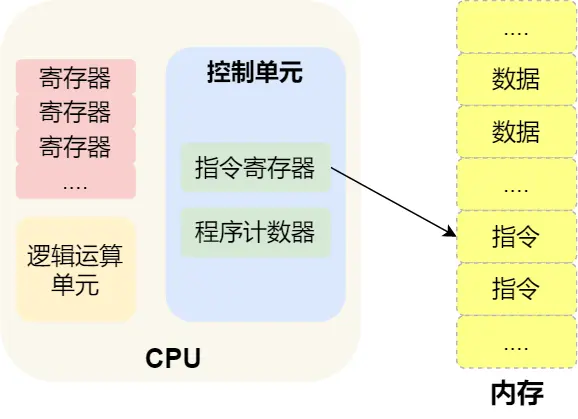

程序执行的基本过程:

最开始说了图灵执行过程,现在说冯诺依曼的

CPU就是负责一步步执行指令的

分析:

第一步:CPU读取程序计数器的值(指令的内存地址),CPU的控制单元操作地址总线指定好需要访问的内存地址,接着通知内存设备准备数据,通过数据总线将指令数据传给CPU,CPU收到内存传来的指令数据后,将指令数据存入指令寄存器

第二步:该访问下一条指令了,程序计数器自增,CPU位宽是32位的,指令就是4字节,需要4个内存地址存放,所以自增的值是4

第三步:CPU分析指令寄存器中的指令,确定指令的类型和参数,如果是计算类型的就给逻辑运算单元运算,如果是存储类型的就给控制单元执行

总结:一个程序执行时,CPU 根据程序计数器里的内存地址,从内存里面把需要执行的指令读取到指令寄存器里面执行,然后根据指令长度自增,开始顺序读取下一条指令

那么CPU从程序计数器读取指令、到执行、再到下一条指令,就叫指令周期

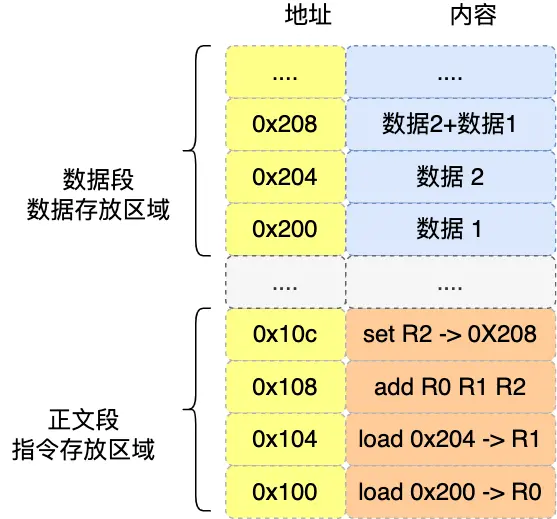

实战:32位CPU来模拟 a = 1 + 2 具体执行过程,

CPU不认识a = 1 + 2这个字符串,

先编译成汇编代码,

然后用汇编器翻译成机器码(01机器语言),至此a = 1 + 2这个字符串会有很多条计算机认识的计算机指令

好现在进一步模拟分析:(二进制位数多,所以用十六进制0x代替,一位十六进制恰好可以用4位二进制表示)

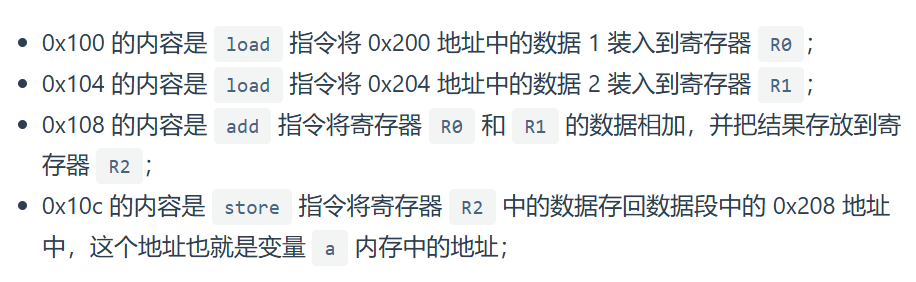

程序在编译的时候,编译器会把a = 1 + 2翻译成4条指令,存放到正文段中,0x100~0x10c

当运行的时候,通过分析代码发现1和2都是数据,内存会有专门的数据段区域来存放这些数据0x200和0x204

这里是32位CPU执行的,一条指令占32位大小,所以每条指令4字节。而数据大小是程序指定的比如int占4字节,char占1字节

指令:

自己追问豆包的一些东西:

汇编代码不像C/C++一样通用,比如x86架构的CPU就有一套复杂的指令集,寄存器啥的也不同。上面的指令是用简易汇编代码代替的,即ADD这种助记符就叫汇编代码,x86可能用ADD表示加,ARM架构是不同于x86架构和x64架构的另一种架构,ARM可能用HaHa表示加

这些汇编代码都会翻译成机器代码,也就这计算机指令,才能被计算机认识,所以实际上严谨点说指令应该是二进制机器码,CPU通过解析机器码来知道指令含义

所以总结就是比如C/C++代码会被编译成ADD这种汇编语言助记符的形式,然后再搞成机器代码即指令才行,比如x64架构把ADD汇编语言助记符弄成110010,而ARM架构把HaHa助记符弄成101,但都表示加,计算机处理的时候,各自的指令集中都被明确定义为执行加法操作,即计算机看到ARM架构的101知道是加,看到x86的110010知道也是加

所以不同架构的汇编语言不同,翻译成的指令也不同,即二进制也不同,但都表示一个意思

综上:

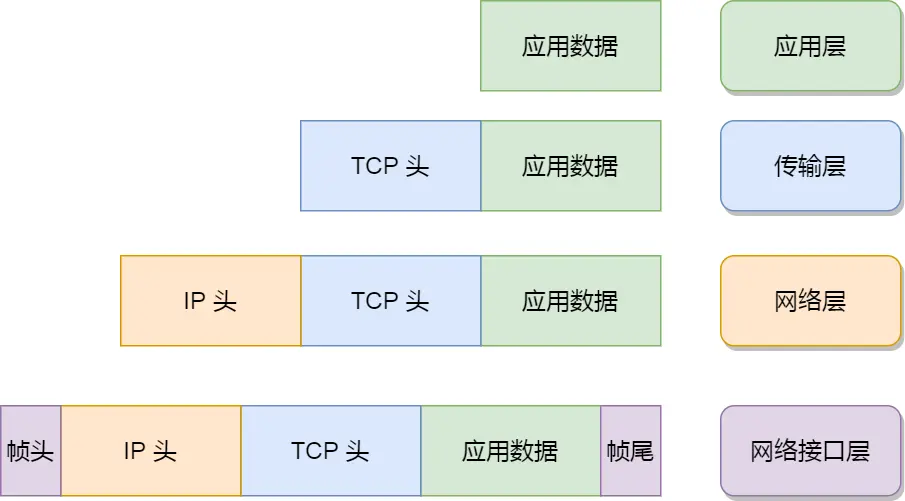

- cpp文件对#开头的指令预处理

- 编译,目的是转化为汇编代码

- 汇编:汇编器把汇编代码转成目标文件(.o ),它包含二进制机器代码,还有符号信息、重定位信息等,此时还不能直接运行

- 链接:链接器将一个或多个目标文件和库文件合并,解析外部引用,分配内存地址,生成可执行文件

- 加载与执行:操作系统把可执行文件加载到内存,准备执行环境,CPU 从主函数

main()开始执行指令

现在用最简单的MIPS指令集来简单深入说下

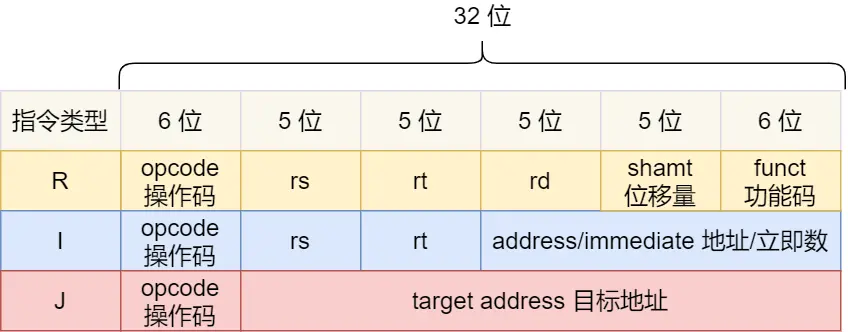

MIPS 的指令是一个 32 位的整数,

高 6 位代表操作码:这条指令是啥指令,

剩下的 26 位不同指令类型所表示的内容也就不相同,主要有三种类型R、I 和 J

R:算术/逻辑操作

I:数据传输、条件分支

J:跳转地址

现在把「add 指令将寄存器 R0 和 R1 的数据相加,并把结果放入到 R2」翻译成机器码

add属于R类型

- add对应的MIPS指令里的的操作码是

000000,以及最末尾的功能码是100000 - rs 代表第一个寄存器 R0 的编号,即

00000 - rt 代表第二个寄存器 R1 的编号,即

00001 - rd 代表目标的临时寄存器 R2 的编号,即

00010 - 不是位移,位移量

00000

拼在一起,是32位MIPS加法指令,十六进制表示机器码也是0x00011020

将高级语言转汇编代码的是编译器

将汇编代码转机器代码的是汇编器

现在的高级编译器在编译程序时候都会构造指令,叫指令的编码,CPU执行程序时候就会解析指令,叫指令的解码,现代CPU都流水线执行指令,拆分任务

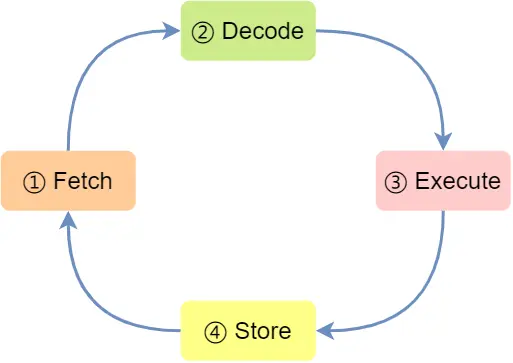

- CPU 通过程序计数器读取对应内存地址的指令,这个部分称为 Fetch(取得指令)

- CPU 对指令进行解码,这个部分称为 Decode(指令译码);

- CPU 执行指令,这个部分称为 Execution(执行指令);

- CPU 将计算结果存回寄存器或者将寄存器的值存入内存,这个部分称为 Store(数据回写)

这是上面提到的指令周期,CPU就是一个周期接着一个周期干活

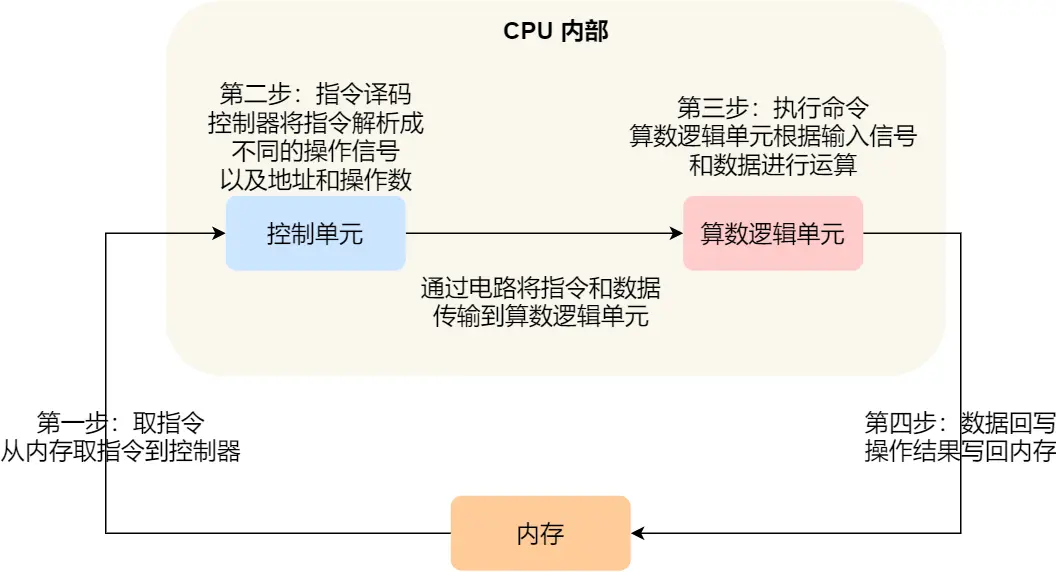

实际上不同阶段是由不同组件完成的

- 取指令过程:指令放在存储器里,控制器通过程序计数器和指令寄存器取出指令

- 控制器继续干活,让指令译码

- 指令执行:运算器的核心即算术逻辑单元ALU,来完成算术or逻辑操作。但如果是一个跳转就直接控制器里完成

指令类型:

数据传输: store/load 是寄存器与内存间数据传输的指令,mov 是将一个内存地址的数据移动到另一个内存地址的指令

运算类型:最多处理两个寄存器中的数据

跳转类型:通过修改程序计数器的值来达到跳转执行指令的过程,if-else

信号类型:中断trap

闲置类型:nop,执行后CPU会空转一个周期

指令的执行速度

CPU硬件参数:主频f,也叫时钟频率,单位是GHz,1GHz 的 CPU,指的是时钟频率是 1 G(1G=10亿=109),代表着 1 秒会产生 1G 次数的脉冲信号,即10亿个高低电平的变化,每一次脉冲信号高低电平的转换就是一个周期,称为时钟周期。

脉冲信号本身就是高低电平交替变化的信号

一个时钟周期内,CPU 仅能完成一个最基本的动作,时钟频率越高,时钟周期就越短,工作速度也就越快

指令完成需要多个时钟周期

那时钟周期时间T = 1/f

主频1Ghz,时钟周期时间,1Ghz = 109Hz,T = 10-9s,1纳秒即1ns = 10-9s,T是一纳秒

CPU耗时:

程序的CPU执行时间 = CPU时钟周期数 * 时钟周期时间

想CPU跑的快就缩短时钟周期时间,即提高CPU主频,但主频不好再提高了(摩尔定律说16-24个月集成电路的晶体管数就增加一倍但现在比较缓慢了),因此没法缩短时钟周期时间,那只能减少CPU时钟周期数量,他是指令数 x 每条指令的平均时钟周期数CPI

因此,程序的CPU执行时间 = (指令数 * CPI) * 时钟周期时间

指令数:执行程序所需要多少条指令,只能靠编译器优化

每条指令的平均时钟周期数 CPI:表示一条指令需要多少个时钟是周期数,CPU都是流水线技术(Pipeline),让CPU时钟周期数尽可能少

时钟周期时间:表示计算机主频,取决于计算机硬件,现在超频技术就是CPU内部的时钟调快,即主频,但散热压力也大容易崩溃

现在的厂商跑分就是这三方面入手

至此小结:

64位比32位CPU优势:

-

64位的一次可以计算超过32位的数字,32位的计算超过32位只能分多步,效率不高,但大部分应用程序很少会计算那么大的数字,所以只有运算大数字的时候64 位 CPU 的优势才能体现出来,否则和 32 位 CPU 的计算性能相差不大

-

64位CPU地址总线48位,64位CPU可以寻址更大的物理内存空间,248远超32CPU寻址能力

32是32位,寻址能力4G,即使加大到8G大小的物理内存也只能寻址到4G大小的地址

硬件的 64 位和 32 位指的是 CPU 的位宽

软件32和64区别?

64 位和 32 位软件,实际上代表指令是 64 位还是 32 位的

32 位的操作系统可以运行在 64 位的电脑上吗?64 位的操作系统可以运行在 32 位的电脑上吗?

- 如果 32 位指令在 64 位机器上执行,需要一套兼容机制,就可以做到兼容运行了

- 如果 64 位指令在 32 位机器上执行,就比较困难了,因为 32 位的寄存器存不下 64 位的指令

软件的 64 位和 32 位指的是指令的位宽。

综上,操作系统其实也是一种程序,我们也会看到操作系统会分成 32 位操作系统、64位操作系统,其代表意义就是操作系统中程序的指令是多少位,比如 64 位操作系统,指令也就是 64 位,因此不能装在 32 位机器上

以上是2.1内容,2.2~2.7跳过了,太JB细节了,感觉目前没必要

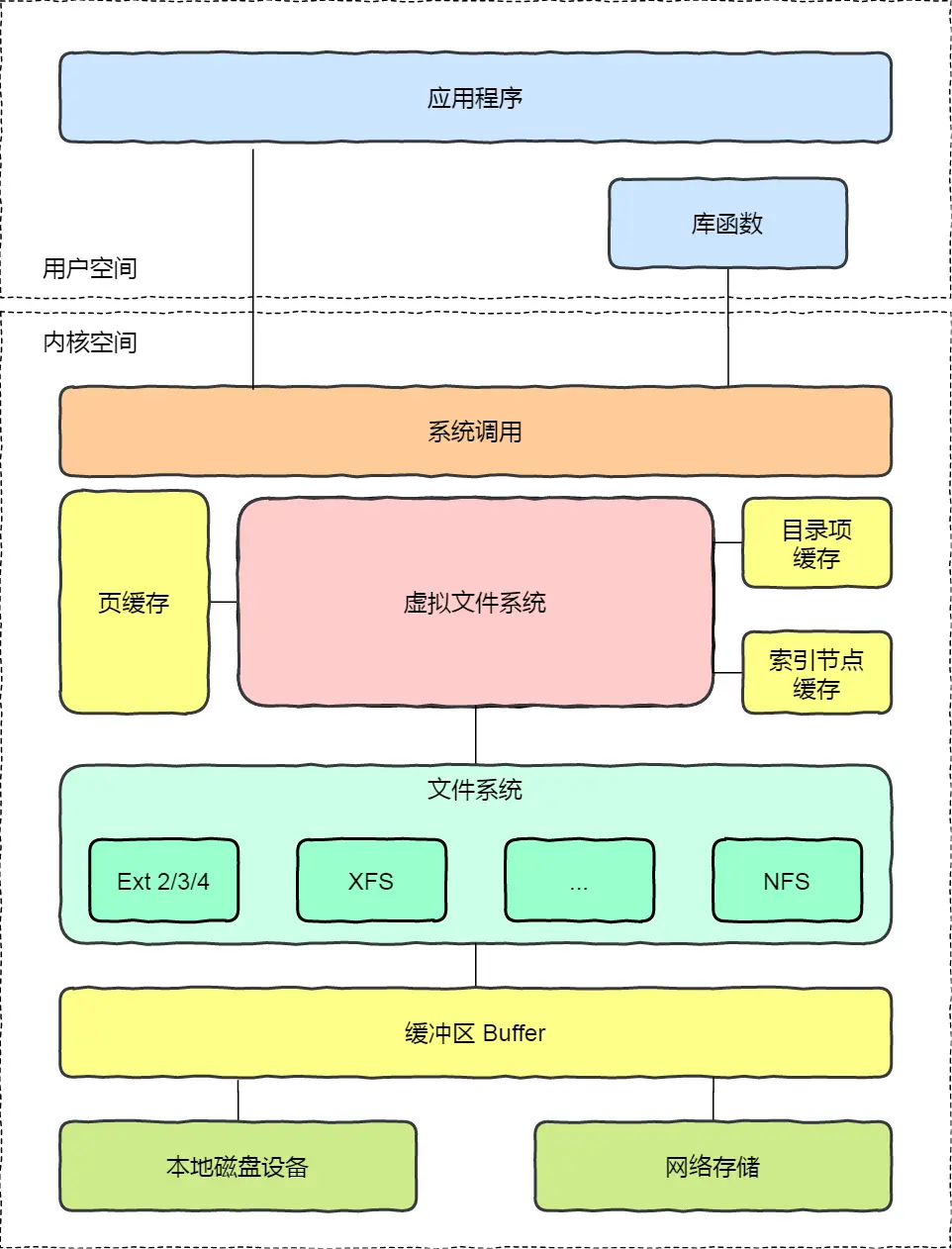

操作系统结构

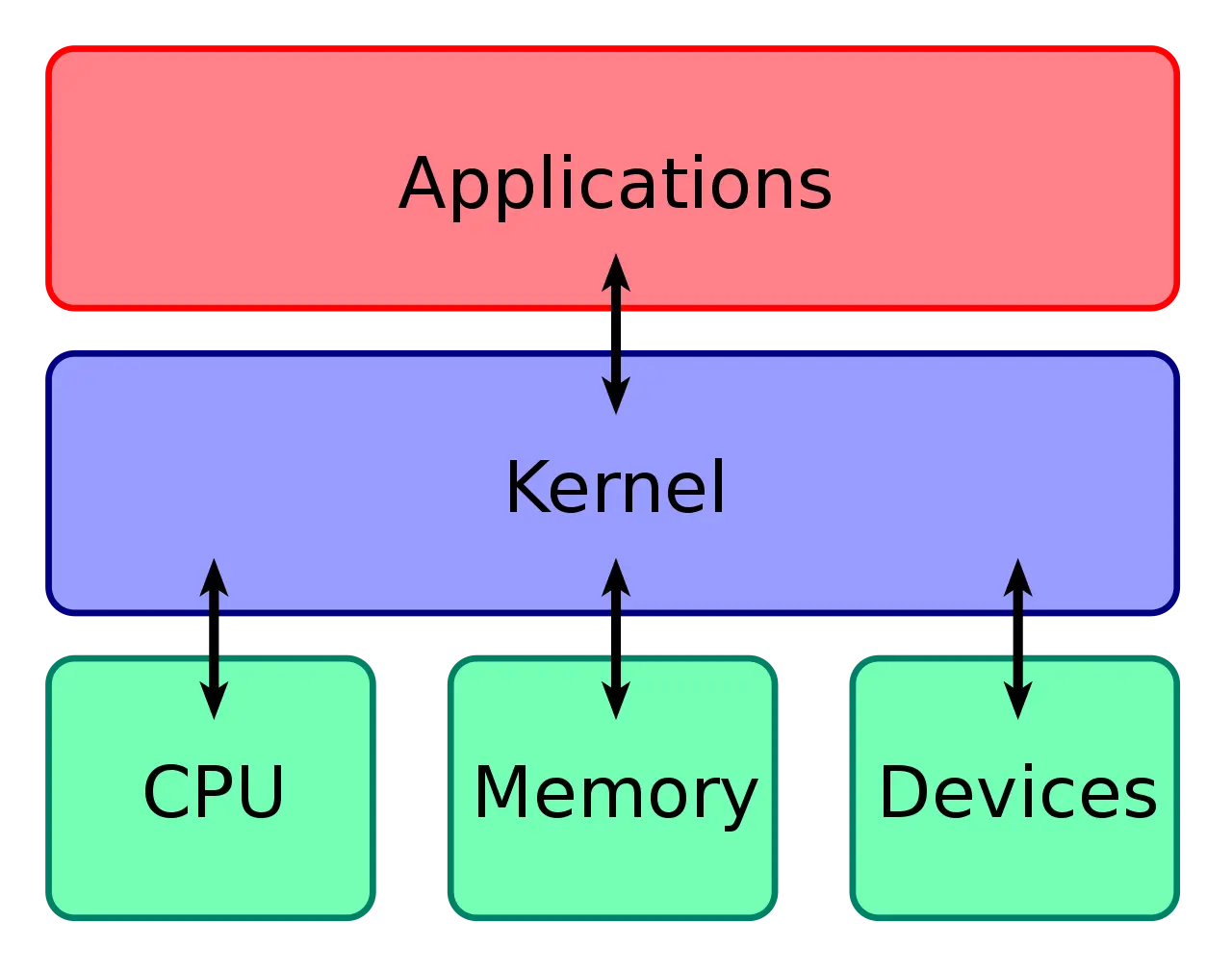

操作系统核心是内核

计算机由内存、cpu、硬盘等外部硬件设备组成,应用和这些硬件设备对接通信协议通过内核负责,用程序只需关心与内核交互

内核能力:

- 管理进程线程,决定哪个进程、线程使用 CPU,也就是进程调度的能力

- 管理内存,决定内存的分配和回收,也就是内存管理的能力

- 管理硬件设备,为进程与硬件设备之间提供通信能力,也就是硬件通信能力

- 提供系统调用,如果应用程序要运行更高权限运行的服务那么就需要有系统调用,它是用户程序与操作系统之间的接口

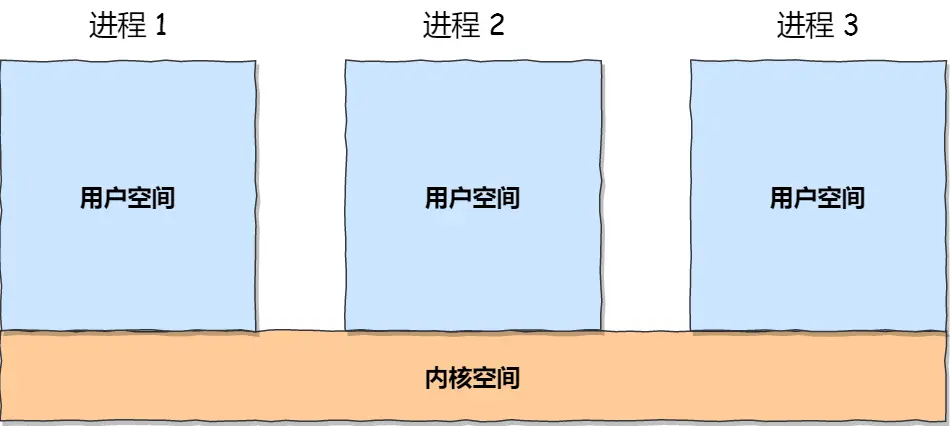

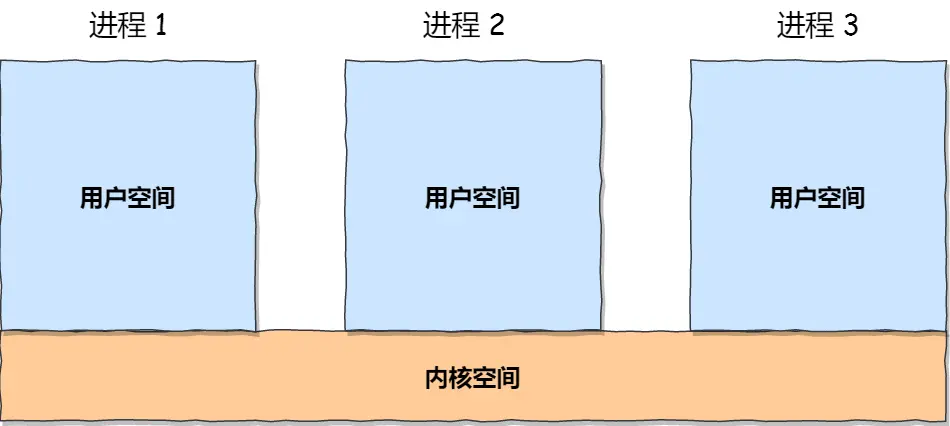

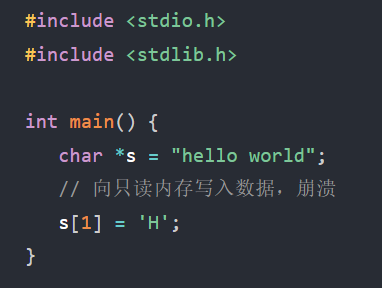

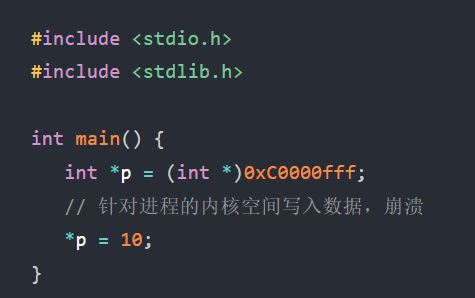

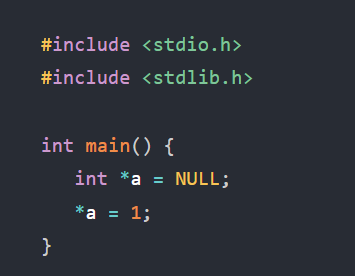

内存的内核空间和用户空间

用户空间的代码只能访问一个局部的内存空间,而内核空间的代码可以访问所有内存空间

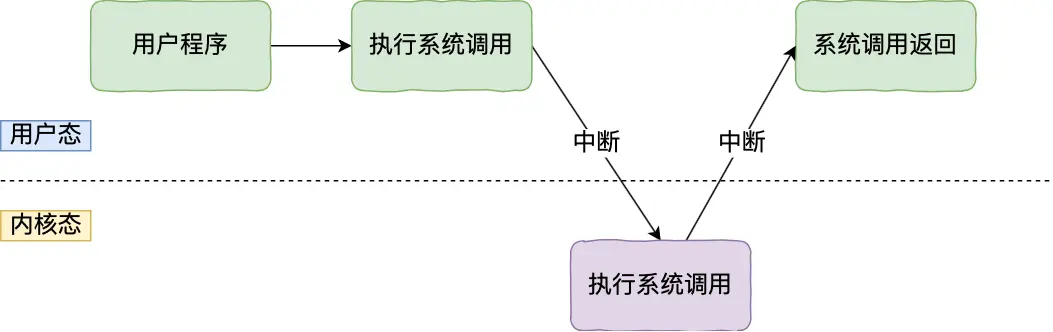

应用程序如果需要进入内核空间,就需要通过系统调用

用户通过应用程序发生系统调用时,会产生中断,CPU中断当前执行的用户程序,转而跳转到中断处理程序,也就是开始执行内核程序。内核处理完后,主动触发中断,把 CPU 执行权限交回给用户程序,回到用户态继续工作

Linux是22岁芬兰小伙子1991年写的,理念:

MultiTask多任务:

- 单核CPU每个任务一小段时间,来回切换宏观一段时间执行了多个任务,并发

- 多核CPU同时并行

SMP对称多处理:

每个 CPU 的地位是相等的,对资源的使用权限也是相同的,多个 CPU 共享同一个内存

ELF可执行文件链接格式:

略太高深了

Monolithic Kernel宏内核:

系统内核的所有模块,比如进程调度、内存管理、文件系统、设备驱动等,都运行在内核态

内存管理(比较重要,面试常问)

虚拟内存

小知识:

内存是临时的

硬盘是永久的

正文:

大学玩的单片机没有操作系统,每次写完代码,都要借助工具把程序烧录进去

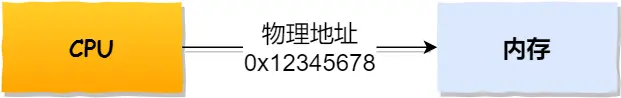

单片机的 CPU 是直接操作内存的「物理地址」

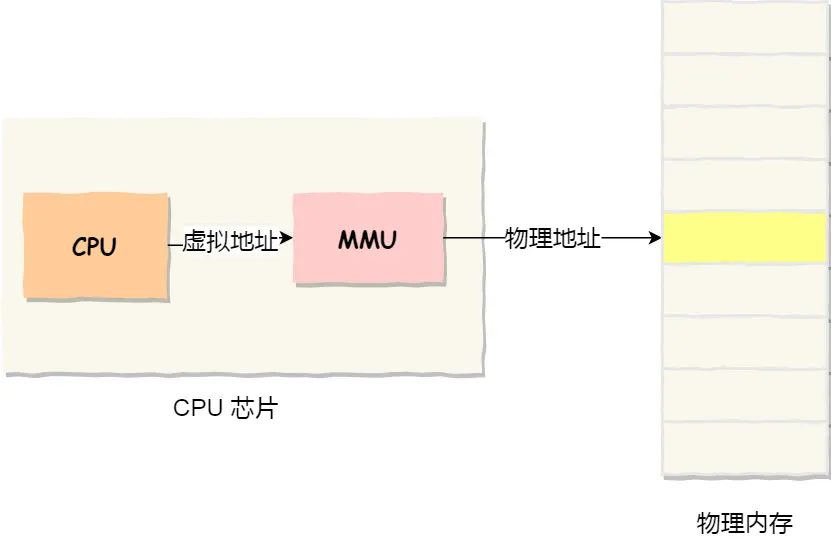

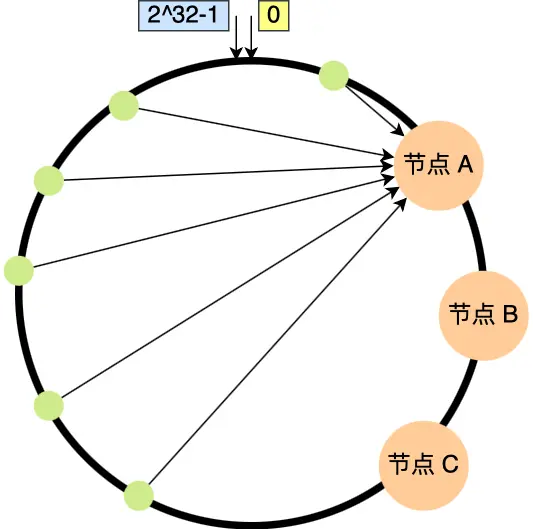

所以内存中同时运行两个程序是不可能的,A程序200位置写的值,将会擦掉B程序相同位置上的内容,引出操作系统,经过虚拟内存机制,为每个进程分配独立的虚拟地址,落实到底层执行时,操作系统控制CPU中的内存管理单元MMU里的映射关系,将进程使用的虚拟地址转换为物理地址

我们实际写代码的时候,编程语言对内存做抽象,结合os为进程分配的地理虚拟地址空间使用虚拟内存地址

实际存在硬件里面的空间地址叫物理内存地址

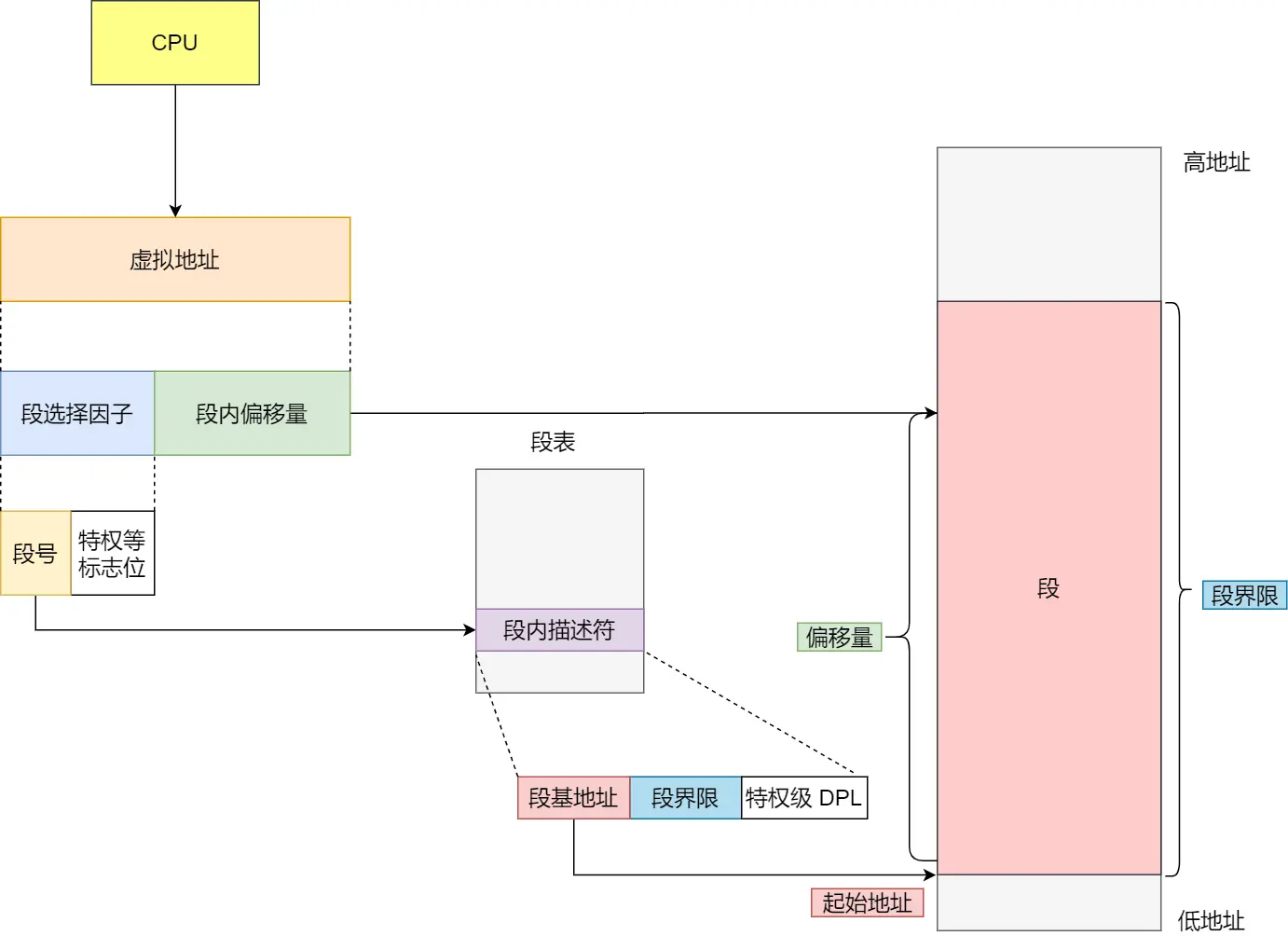

操作系统管理虚拟地址和物理地址之间的关系,用到两种方式:内存分段 & 内存分页

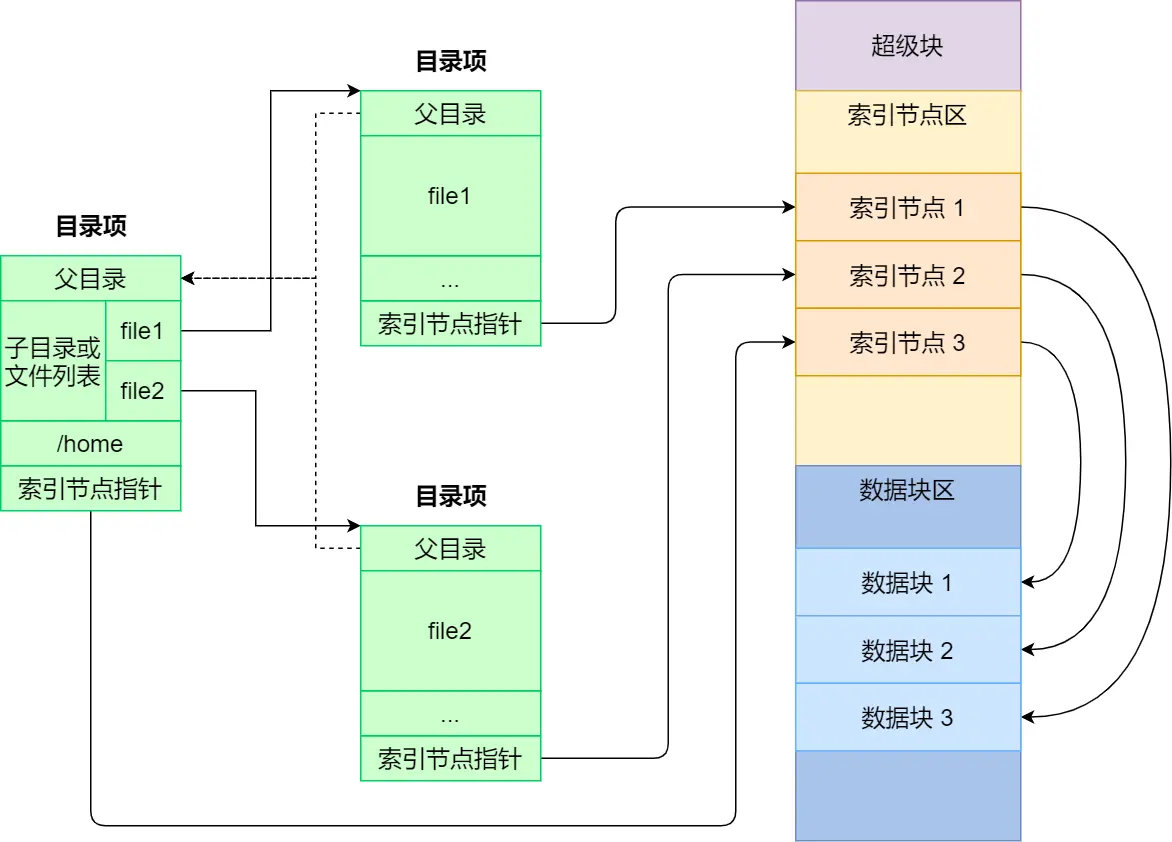

内存分段

理解这些先说几个前设知识:

知道了通过给进程分配虚拟地址,来映射到物理地址,

那虚拟地址可以看作进程自己视角看到的东西,就是他的全世界,

虚拟地址由段选择因子和段内偏移量组成,

- 段选择因子含段号,用于在段表中定位对应段,获取段基地址等信息

- 段内偏移量是在该段内的偏移距离 。二者搭配,通过段基地址 + 段内偏移量 ,得到物理地址

进程自己的世界 —— 虚拟地址空间,运行的时候认为自己有独立的:

- 代码段(存指令):

段选择因子找到代码段基地址,段内偏移量确定指令在代码段内位置,从而找到要执行的指令

- 数据段(存全局变量):

段选择因子定位数据段,段内偏移量确定变量等数据在段内位置,进而访问数据。

- 堆段(动态分配内存):

程序动态分配内存时,段选择因子找到堆段,段内偏移量确定分配内存块在堆段内位置

- 栈段(函数调用和局部变量存储):

函数调用等操作时,段选择因子确定栈段,段内偏移量确定栈帧等在栈段内位置

这些进程自己世界里的逻辑概念,

而内存中实际代码、数据、堆、栈是物理存储层面的。操作系统通过内存管理机制,将虚拟地址空间中的各个段映射到实际的内存物理地址上。多个进程的虚拟地址空间中的代码、数据等会分别映射到不同的物理内存区域,实现进程间的隔离和资源分配

代码、数据、堆、栈都是不同的段,都有对应该的段描述符,这些描述符组成了段表,段表也称作os给进程维护的数据结构,存于内存

进程在自己的虚拟空间中有代码、数据、堆、栈等结构。当进程运行时,其虚拟空间中的代码、数据、堆、栈等会通过内存管理机制被加载到内存的实际地址上,以实现进程的运行和数据存储

宏观流程:

操作系统为进程分配虚拟地址空间,

虚拟地址(存在于进程的地址空间中)结构上包含段选择因子和段内偏移量,从逻辑角度,把程序虚拟地址空间按用途划分成代码段、数据段、堆段、栈段这 4 个段,

CPU中的集成的内存管理单元 MMU根据段选择因子在内存中查找进程的段表(由操作系统维护,存于内存中),

通过段表获取段基地址,再结合段内偏移量计算出内存实际物理地址,从而访问内存中的数据

说完这些概念术语,为了进一步了解这些,我感觉依旧困惑重重,再追问一些东西

虚拟地址由段选择因子和段内偏移量组成,用于在进程的代码、数据、堆、栈等段中定位,不是每个段由段选择因子和段内偏移量组成。

与其误人子弟像傻逼一样描述成“虚拟地址由选择子+偏移量组成”,

不如说,把CPU里的段寄存器存的段选择子当作虚拟地址组成的一部分,另一个部分叫偏移量

虚拟地址只是一个索引不存数据

实际把物理地址逻辑分出100M来给进程A,100M里又逻辑上分出四个部分作为代码段 / 数据段 / 堆段 / 栈段四个部分,这里也是不存数据的,只是这四部分存的是索引,实际数据还是存在实际物理内存上的!!这里我之前一直以为虚拟地址也存数据,然后运行时候加载同步放/拷贝到实际内存上呢,但其实这100M是存索引的!!实际数据永远在内存中

为何搞了选择子,又有段表?

- 选择子:是一个较小的索引值,存于段寄存器中。由于段寄存器空间有限,使用选择子可以用较小的空间来快速定位到段描述符,提高地址转换速度

- 段表:存储进程各个段的详细信息,如段基地址、段界限、访问权限等。段表存于内存中,它可以存储大量的段描述信息。如果直接在段寄存器中存储所有段的详细信息,会占用大量的寄存器空间,不利于管理和扩展。选择子和段表结合,既快速访问,又能存储足够多的段信息

整体流程梳理:

- 进程内存分配:操作系统为进程分配一定大小的虚拟地址空间(如 100M),并在逻辑上划分成代码段、数据段、堆段、栈段等。全局变量存放在数据段

- 初始化:操作系统为进程的各个段分配段描述符,将描述符的索引值(段选择子)存入相应的段寄存器,同时把段表存入内存。

- 编译和链接:编译器和链接器确定全局变量等数据在段内的偏移量。

- 运行时访问:当进程要访问全局变量时,CPU 从段寄存器中取出选择子,结合指令中的偏移量形成虚拟地址。然后根据选择子在内存的段表中找到对应的段描述符,获取段基地址。段基地址加上偏移量得到线性地址,如果启用了分页机制,线性地址会通过 MMU 和页表进一步转换为物理地址,最终实现对物理内存中全局变量数据的访问

总结:

- 全局变量 a 的数据实际存储在物理内存地址上

- 段寄存器中存的是段选择子(段描述符的索引),而非数据段本身

- 段表存储在内存中,记录各段的基地址、大小等信息

- 访问 a 时:

- 用段选择子从段表中找到数据段基地址,结合偏移量得到虚拟地址对应的线性地址,最终访问物理内存中的 a 数据

核心:虚拟地址是 “指针”,数据永远存在物理内存中,通过地址转换机制映

至此发现这个图,对于我这种好钻研思考深入的人来说,相当的误导人了,但理论上这图又没任何错误!

GerJCS岛: 像考研 要么北邮 要么200分学不完 不存在垃圾学校哈工程这种 GerJCS岛: 也就是说他们这些人哪怕小林coding,可能这样就能理解,亦或是自欺欺人经不起深入追问,要么就是理解力逆天,但就这个图+这个讲解,没看出理解的有多透彻,我只有像上面自己追问豆包才懂的,才敢说了解了分段机制,可无数99.99%的大厂估计都不这么研究这些,可能也是自欺欺人背背了事,自己根本没搞懂真正各个逻辑,比如xx哪来的存哪了啥的。可能我理解力确认跟别人不同吧。 刷算法题就看出全网的博客其实挺垃圾的 田园管理 攀岩 管理 游泳 演讲都是背 不是即兴发挥 真正的攀岩 真正的演讲 GerJCS岛: 都太水了 GerJCS岛: 专利不屑一顾 GerJCS岛: acm GerJCS岛: 辩论

- 段选择子保存在段寄存器里,段选择子里面最重要的是段号,是段表的索引

- 虚拟地址中的段内偏移量应该位于 0 和段界限之间,如果段内偏移量是合法的,就将段基地址加上段内偏移量得到物理内存地址

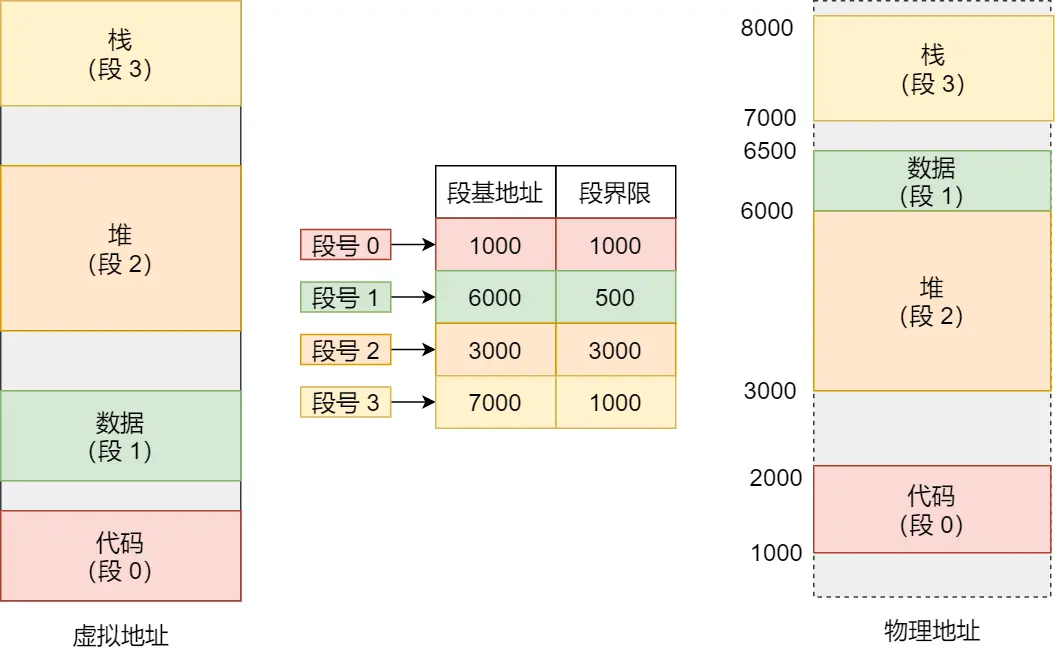

看完上面的追问,再继续看下面的图也就很容易懂了,如果想访问段3中偏移量500的数据,通过段表7000+500得到物理地址7500

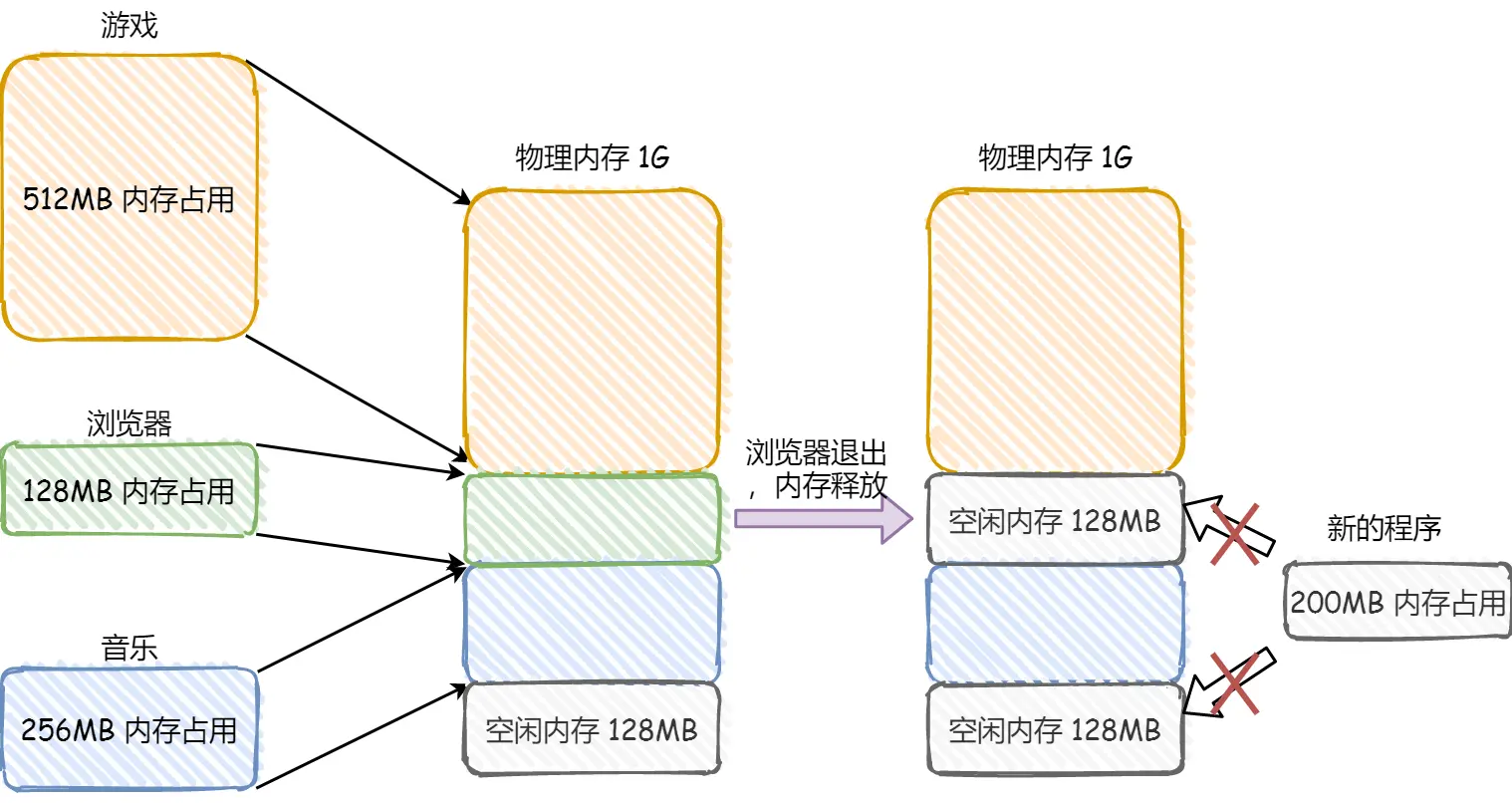

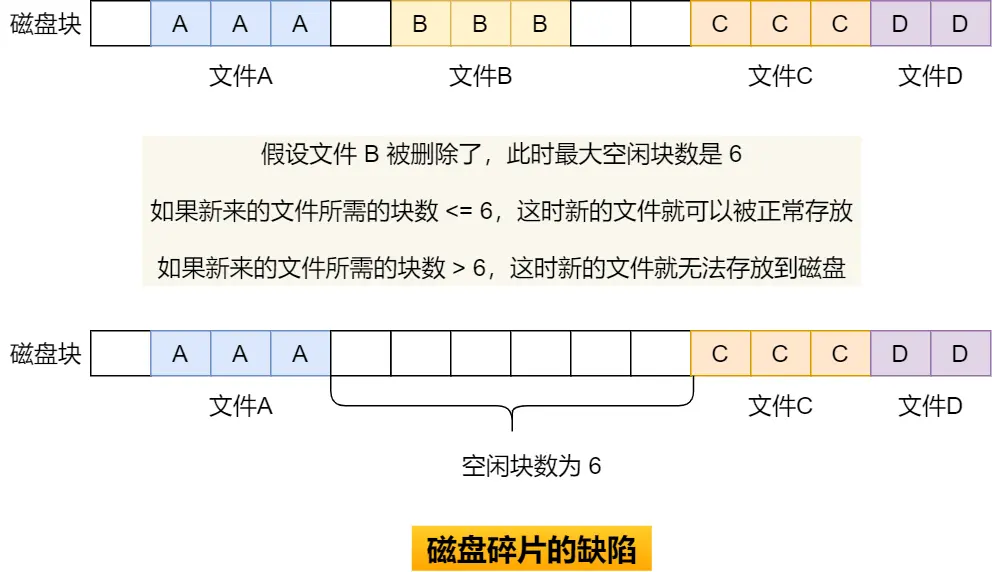

但分段会有 内存碎片 & 内存交换效率低 的问题

上面这个图发现,总共256MB但没法打开200MB的新程序

根据实际需要分配段,不会有内部内存碎片,但两个128MB是256,但打不开一个200的程序所以这俩128就叫外部内存碎片

解决外部碎片用内存交换

把音乐的256MB写到硬盘上,再从硬盘读回来到内存里,只不过读的时候紧挨着放512MB的下面

Linux里Swap空间就是用于交换的,硬盘访问速度慢,内存交换需要把一大段连续的内存数据写到硬盘上,数据过大会卡顿,所以引出内存分页

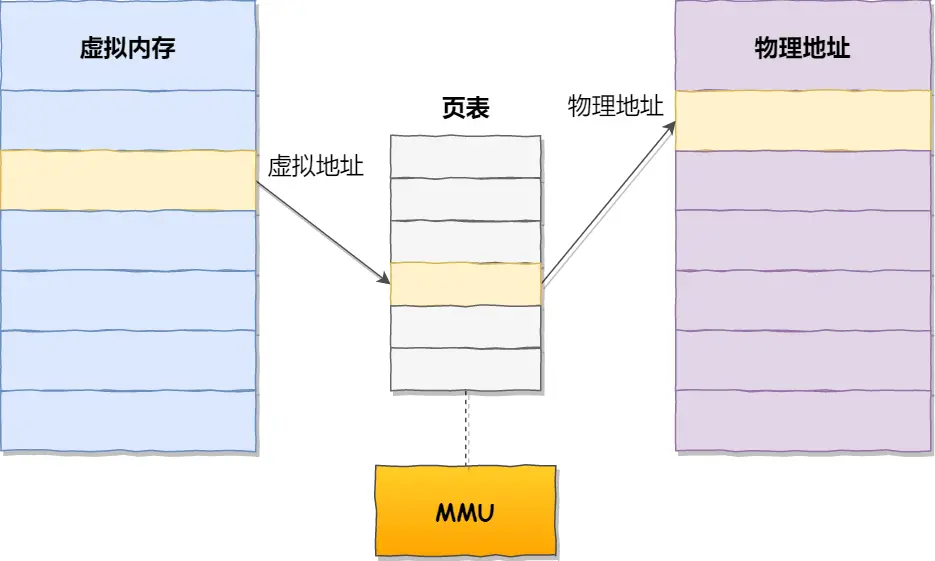

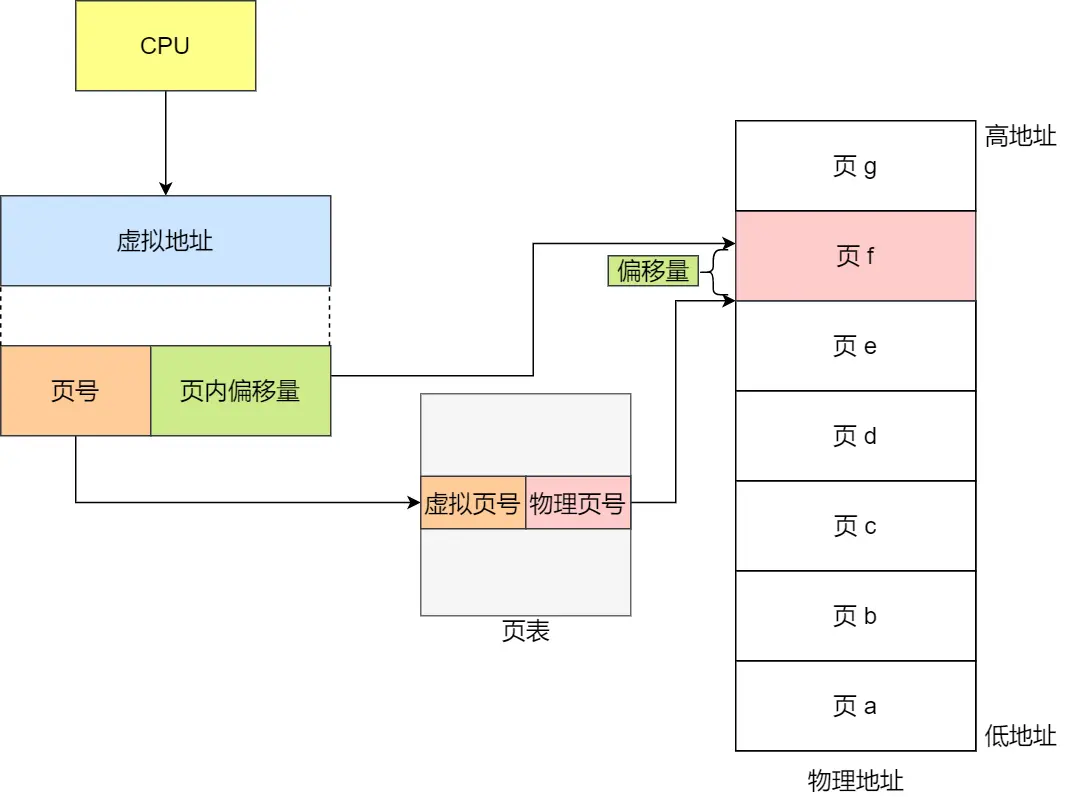

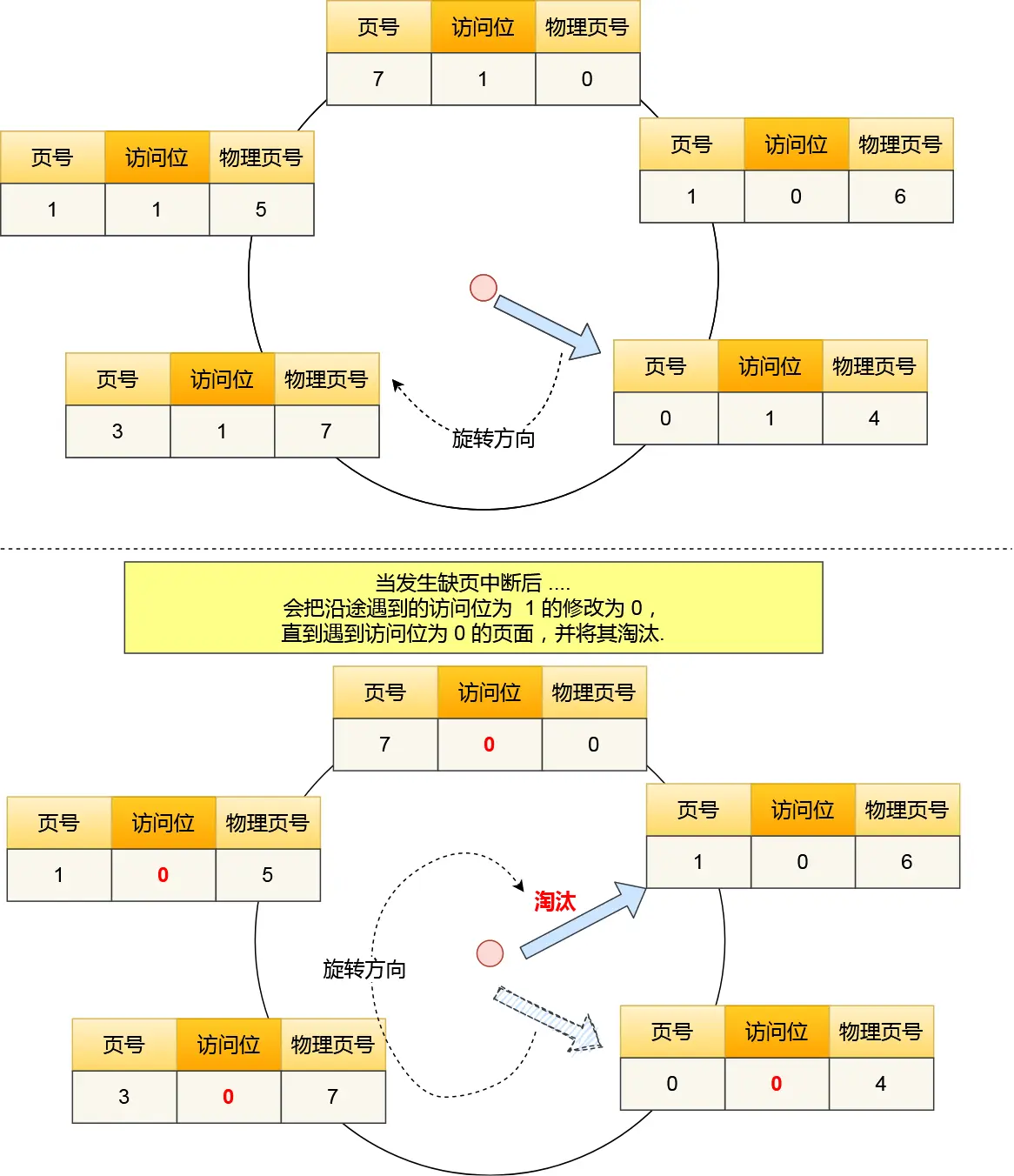

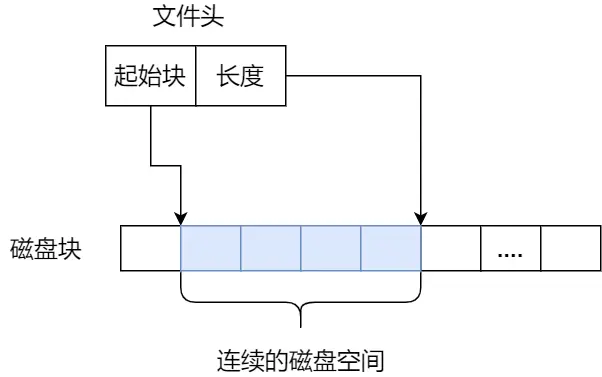

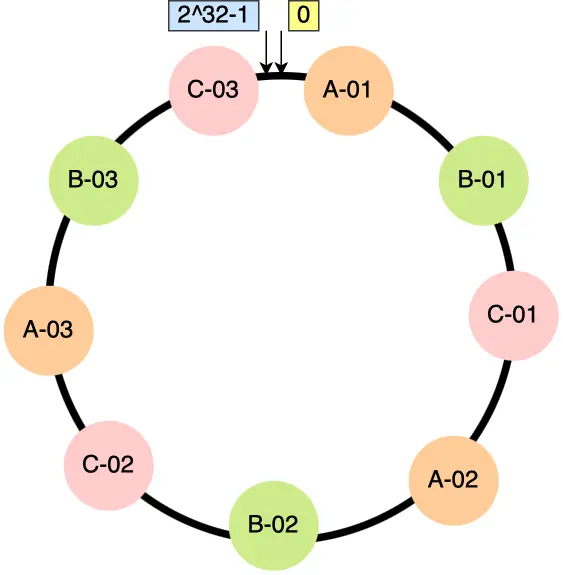

内存分页

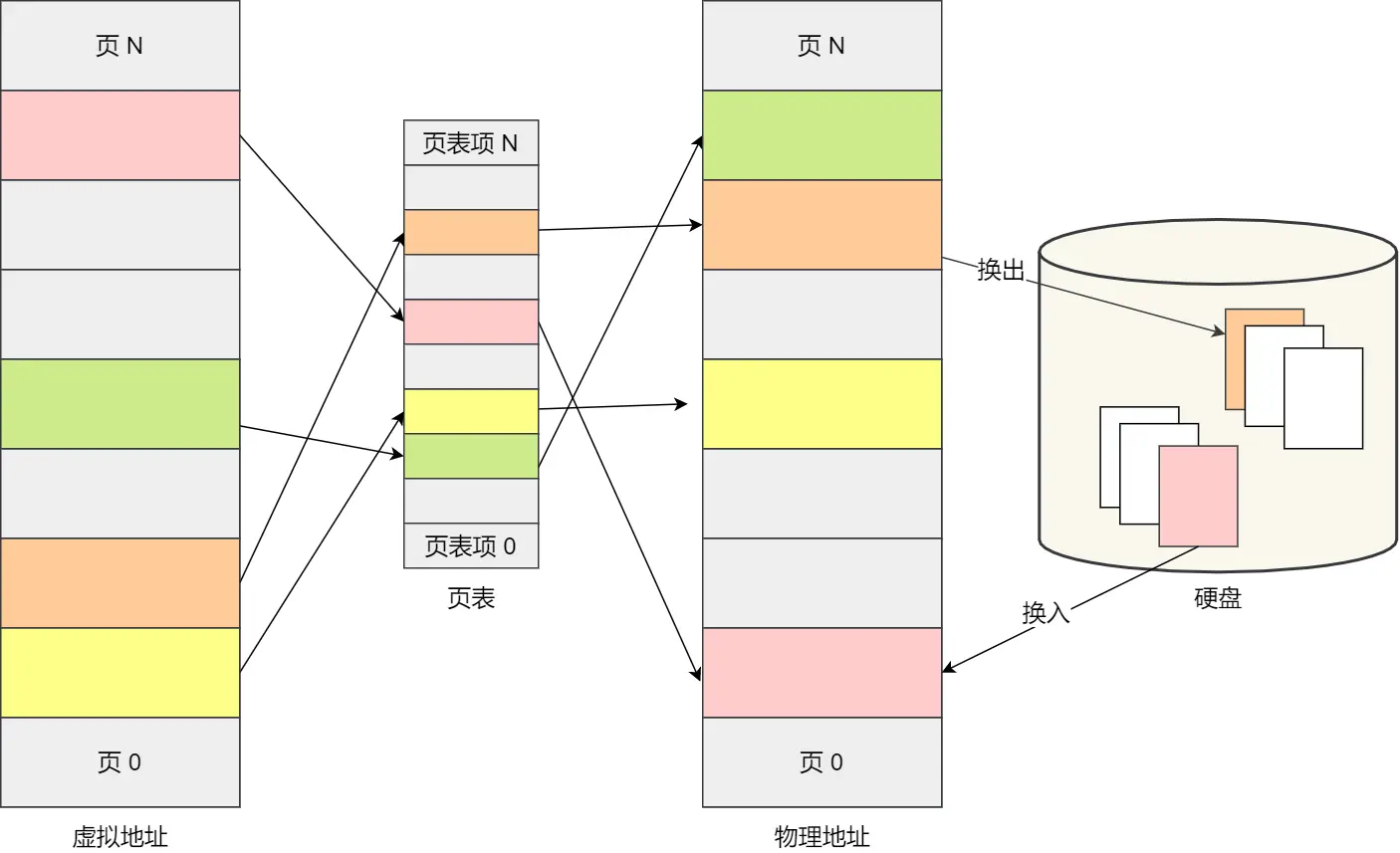

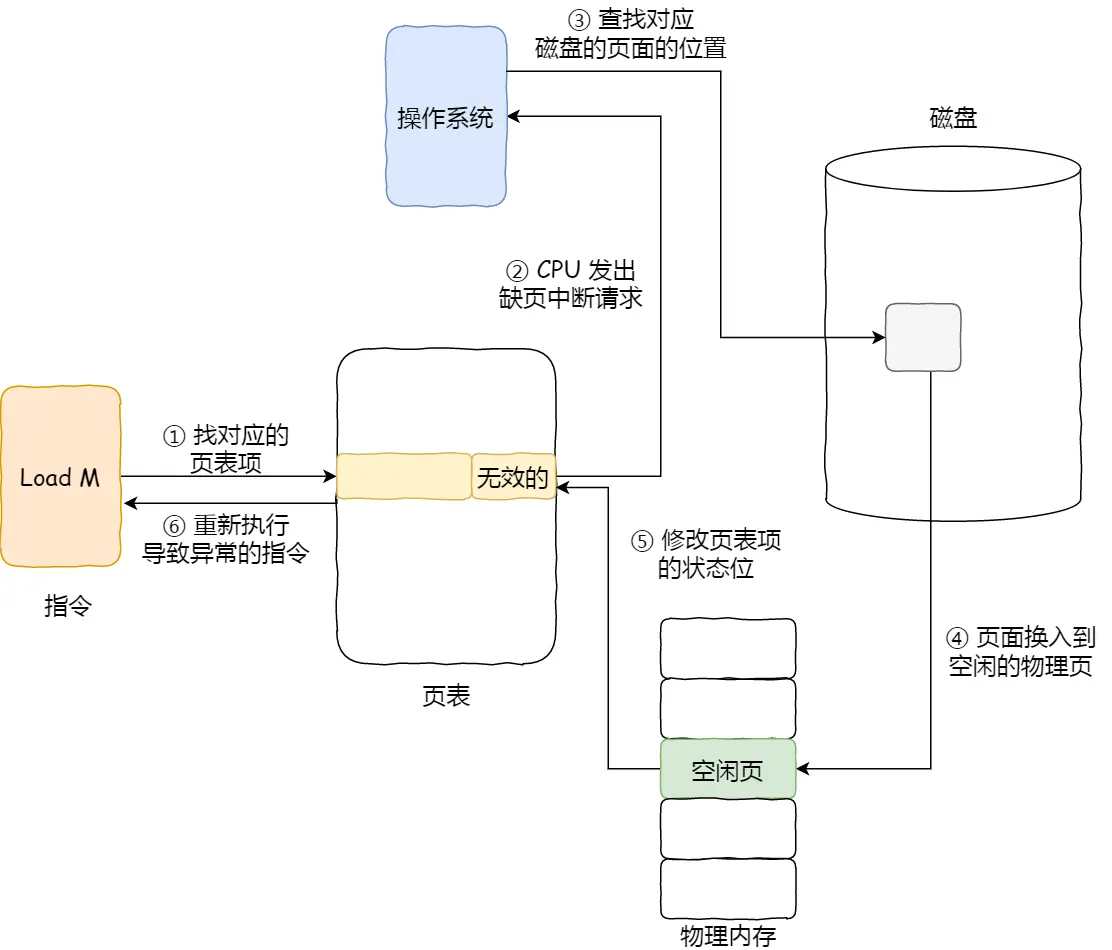

把整个虚拟和物理内存空间切成一段段固定尺寸的大小,这样一个连续并且尺寸固定的内存空间,我们叫页(Page),Linux下每页大小4KB

页表是存储在内存里的,内存管理单元 (MMU)用来将虚拟内存地址转换成物理地址

内存分页,页之间紧密排列,不会有外部碎片,但页固定4KB会有内部碎片

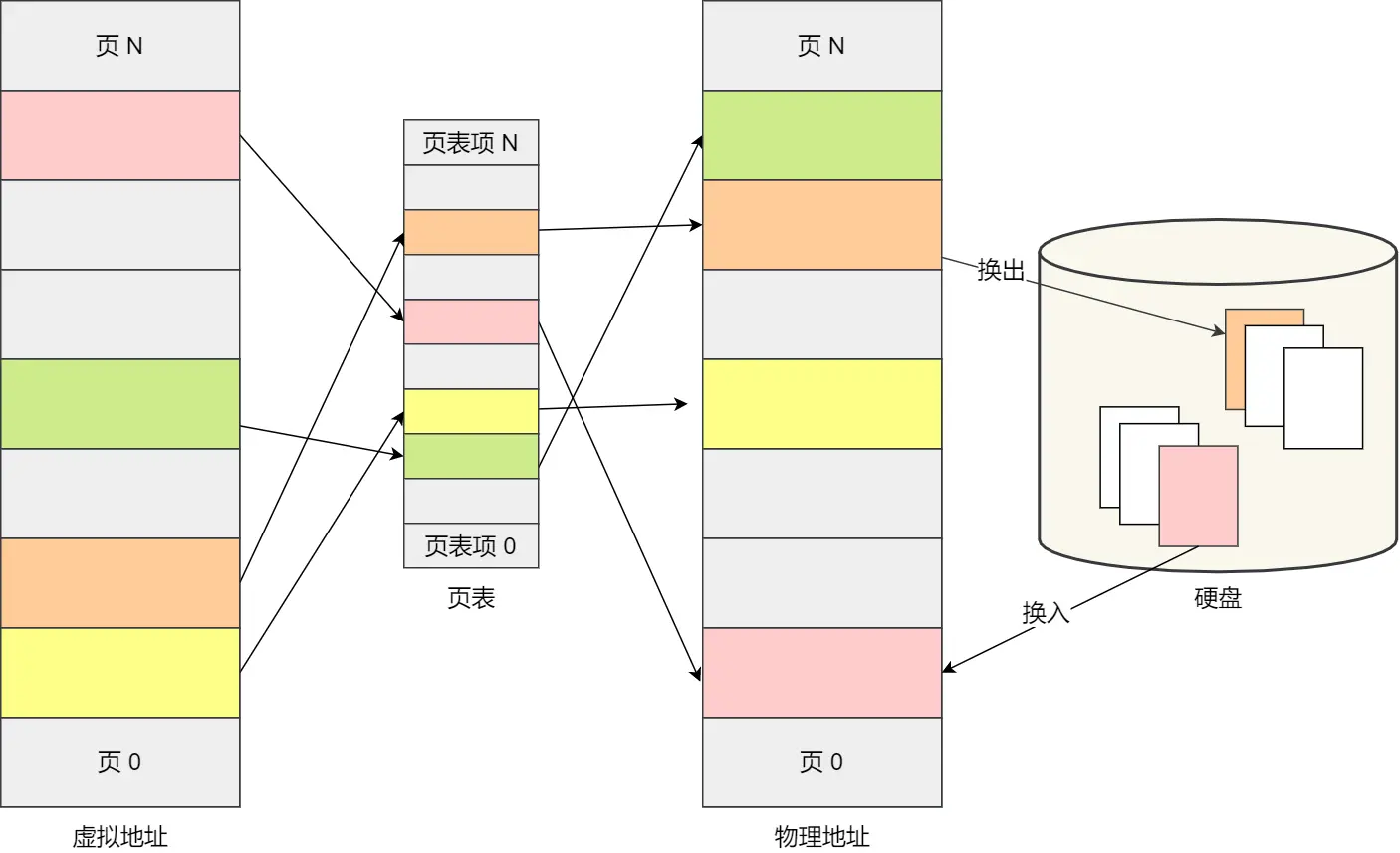

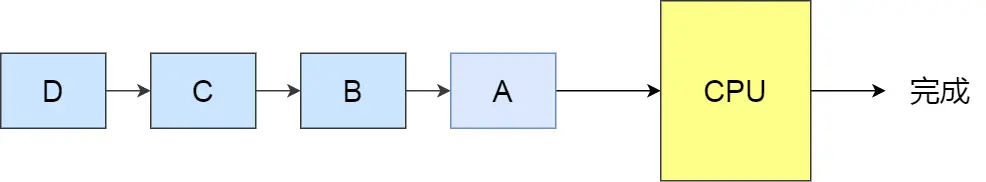

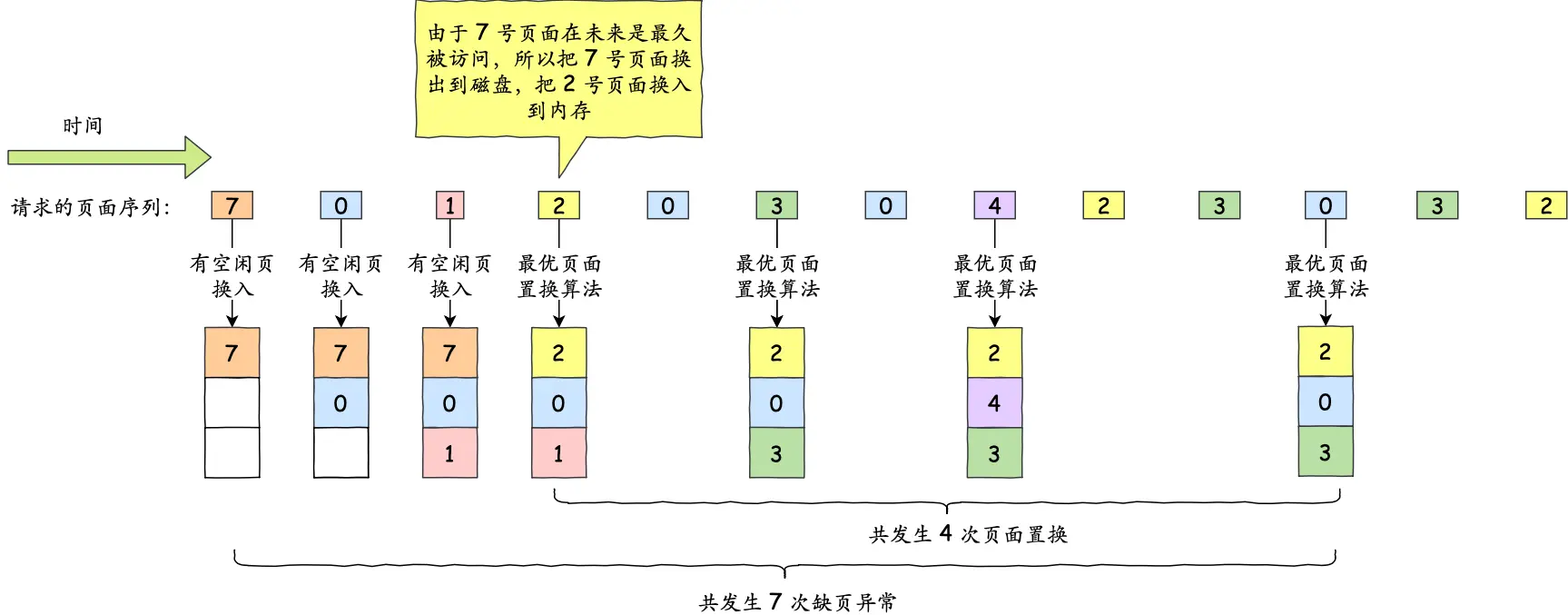

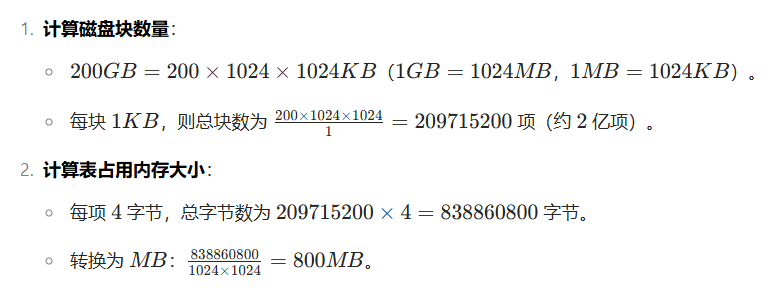

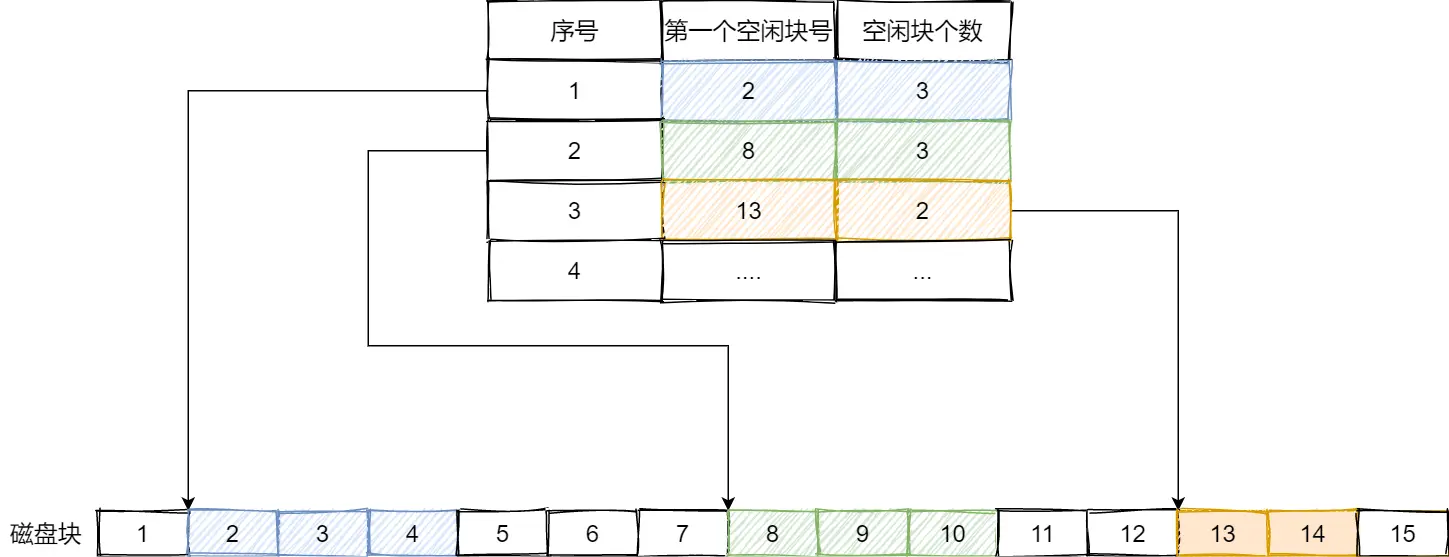

关于内存交换也是效率比较高的,如下图我为了好找,称呼为“swap图”

当内存不足的时候,由于没运行的程序不在内存中,不存在占用内存空间的情况 。而正在运行的程序占用内存,所以经过长期实践认定:

一段时间内,内存页面中的数据或程序代码没有被 CPU 访问,那他们马上再次被用到的可能性相对较低,能在不影响系统整体运行的前提下,腾出内存空间给更急需的进程

所以先换出到内存放到硬盘,然后需要的时候再换入

同样的,加载程序的时候,不再需要一次性都把程序加载到物理内存,只有在程序运行中,需要用到对应虚拟内存页里面的指令和数据时,再加载到物理内存里面去

分段为何难以像分页按需加载

例如一个大型代码段,即便只需其中一小部分功能,分段可能仍需加载较多关联内容,无法像分页那样灵活精准地 “用到啥加载啥”,按需加载的粒度和灵活性不足

内存交换释放的是实际物理内存

虚拟内存是逻辑地址空间,本身不存储真实数据。物理内存才是实际存放数据的地方。当内存不足时,系统将物理内存中 “最近没被使用” 的页面数据暂存到硬盘(换出),腾出物理内存给其他进程。虚拟内存通过页表记录映射关系,本身无 “释放空间” 操作,释放的是真实存放数据的物理内存空间,后续需要时再从硬盘换入到物理内存。

分段的大量数据块耗时磁盘IO久

关于交换内存为啥分页的小块效率高这块没搞懂(交换总量是一样的啊),但感觉涉及到实际发展规律没必要研究

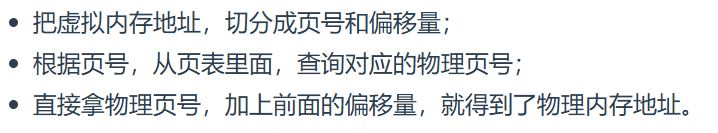

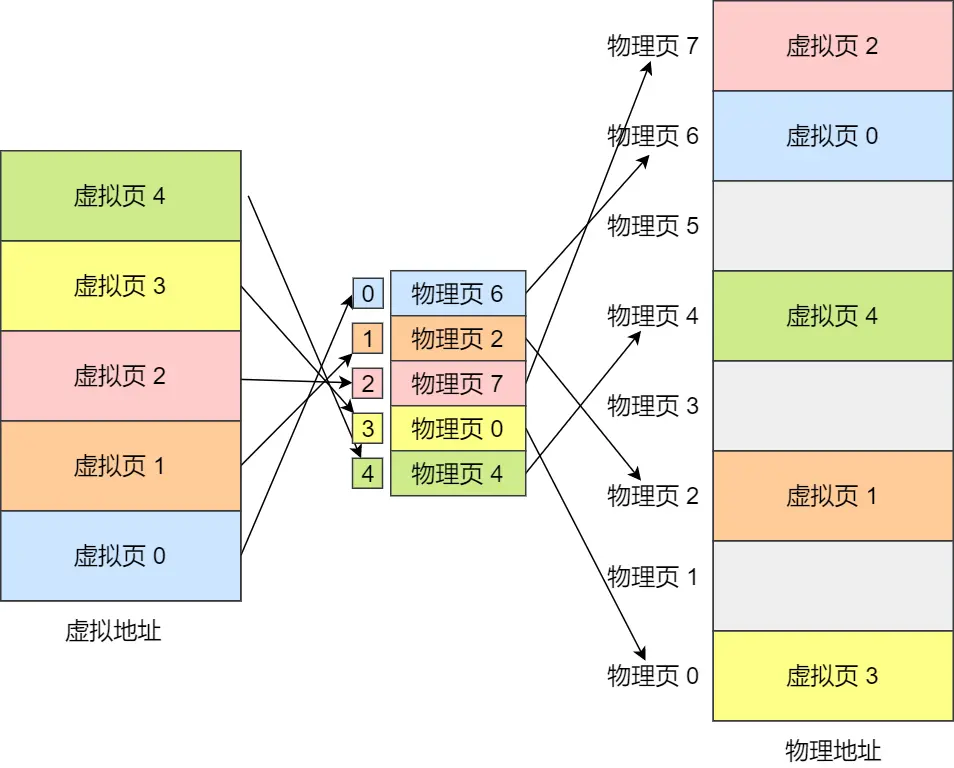

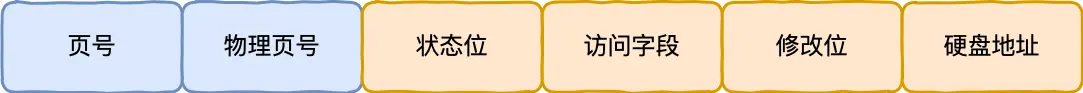

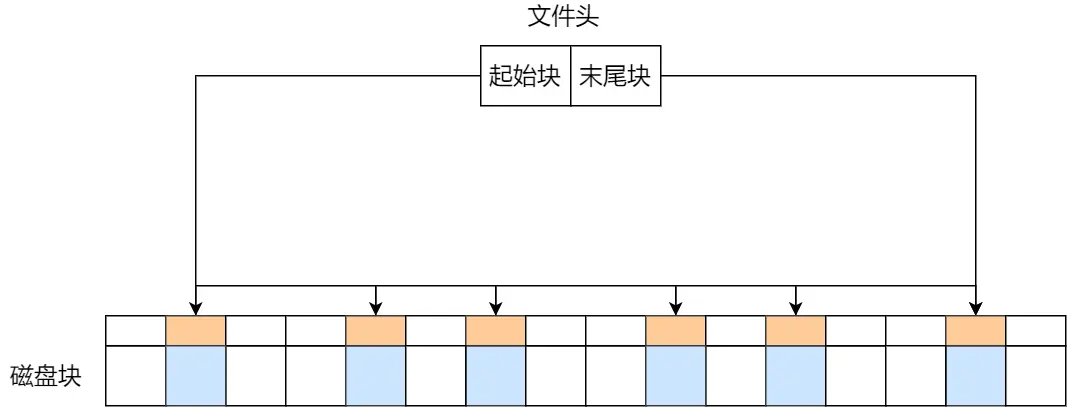

分页映射方法:

虚拟地址分为两部分,页号和页内偏移

页号作为页表的索引,页表包含物理页每页所在物理内存的基地址

(注意:图里的虚拟页0~4就是页,中间的是页表,物理页4就是一个页表项)

这块感觉需要追问弄清的疑问细节太多了,算了,咋说咋是吧,追问没个头,也没意义感觉

追问小知识:

-

32位下,注意32位CPU寻址能力范围是0~0xFFFFFFFF(4GB),所以虚拟地址就是4GB,但这个4GB也即是虚拟空间其实是没有实际空间大小的!类似一个人能搬动 10 块砖一次”这是他的 “搬砖能力范围”,映射到工地的时候的能力,而不是他随身携带 10 块砖

-

“虚拟地址空间有空间大小”=“地址编号的范围大小”

-

程序看到的是 “连续的地址编号”(比如 0 到 4GB),操作系统负责把这些编号 “翻译” 成真实的存储位置(物理内存或磁盘),4GB是给程序员的幻想

-

真实内存可以大于4GB,但用不上那么多,如果5G内存,多出的1G只能用于系统层面缓存内核啥的用户态程序无法调用,用户进程受限于 32 位虚拟地址空间,确实无法直接访问 > 4GB 的地址;

-

而如果少于4GB,比如2GB,这里就有意思了,比如32位寻址范围是4GB,内存2GB,此时程序员幻想自己可以操控4GB的空间,但其实,当需要操控2.1GB地址的时候,CPU其实是把不用的东西,放到了磁盘上,给内存腾地方!

- 32位CPU也是32位线路位宽

-

其实虚拟地址4GB,内存2GB,就类似开了家骗人的仓库,说是4GB,但其实只有2GB,你告诉我存超过2GB的时候,我可能把你最早存的放纸壳箱里

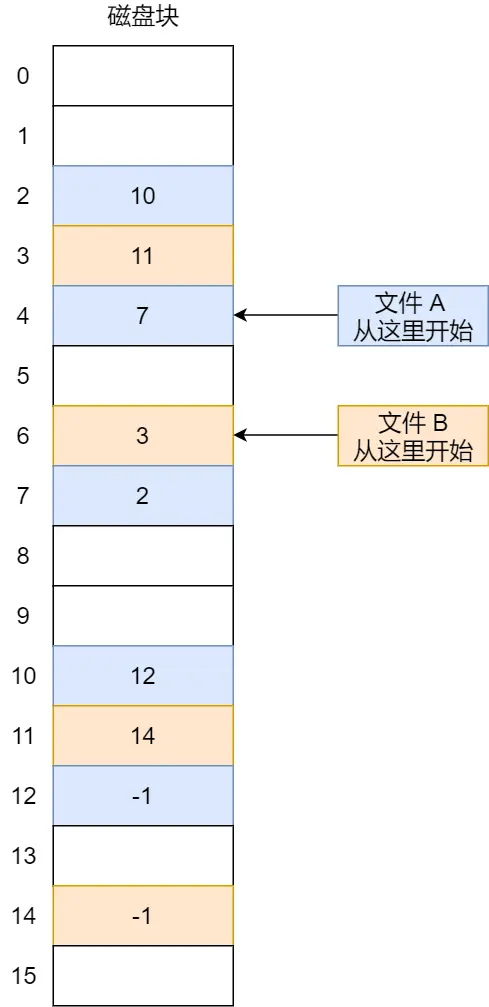

继续说分页,缺点:

假设,虚拟地址空间4GB,232

一页大小4KB,即212,

页数共约100万,即220个。(注意页表项是用来建立虚拟页和物理页映射关系的,一个虚拟页对应一个页表项 ,所以页数和页表项数量是相等的 ,页表项也是220个)

页表项4字节,

那整个4GB空间的映射就需要 4B * 220 = 4MB的内存来存储页表

(220=1MB)

至此说的都是单页表实现,

那100个进程就是100MB内存,比较大,别说64位了,引出多级页表

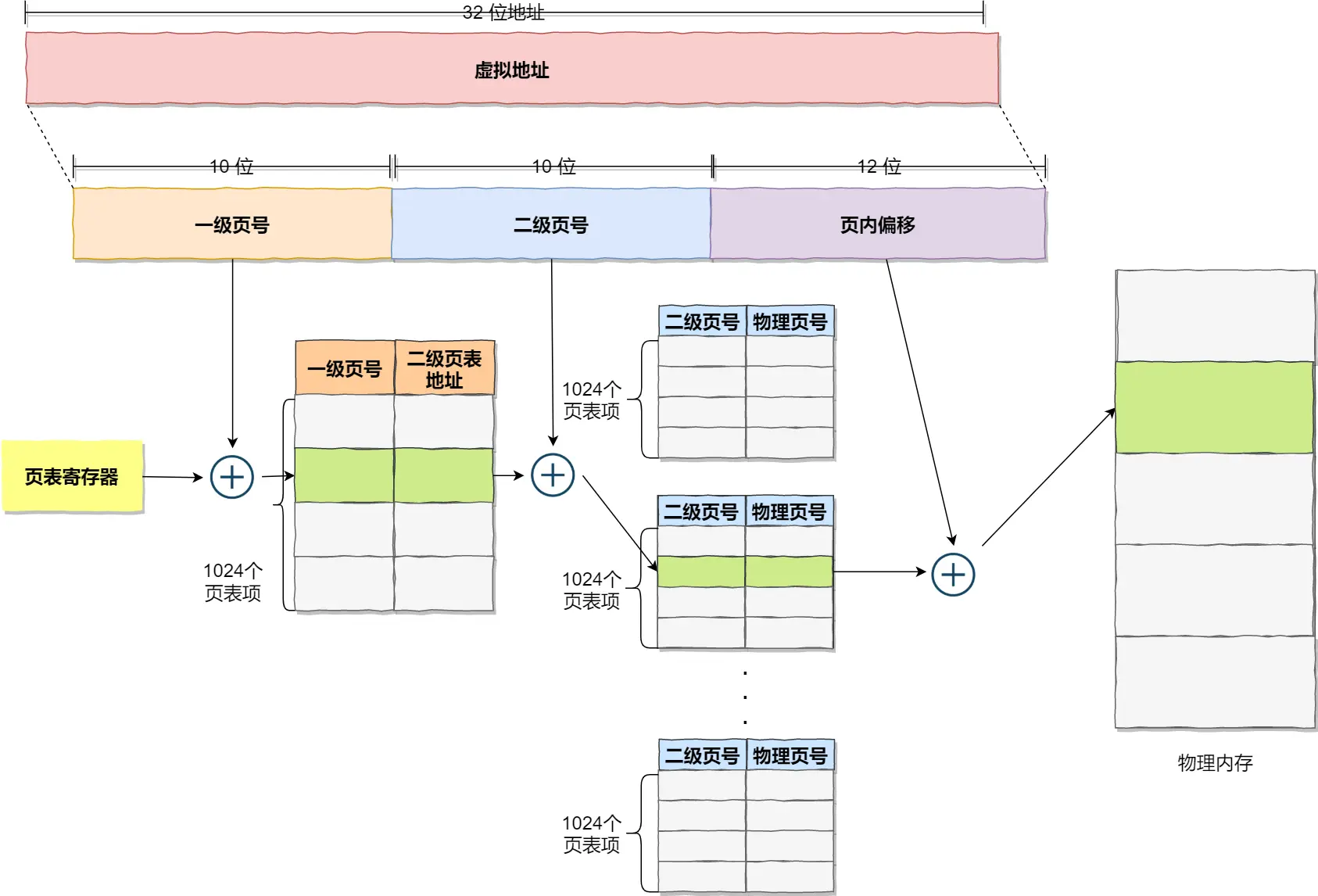

多级页表

虚拟内存意思是,每个进程视角都认为自己可以控制的空间大小,即每个进程都认为自己可以操控4GB的空间

单页表的实现方式,32位,一页4KB(212)环境下,一个进程的页表需要装下220个页表项,每个页表项4字节,每个页需要4MB空间,那把220个页表项再分页

一级页表:

固定是一页大小,默认4KB

二级页表:

4GB虚拟空间,页大小4KB,页数232 / 212 = 220个,即页表项映射

把一级页表分为210个二级页表,每个二级页表又有210个页表项,总共依旧是210 * 210 = 220个页表项,一个页表项4字节,总共220 * 4就是4MB

所以这样一来,之前单页是4MB,如今多级页表变成了4KB+ 4MB反而多了,但由于单页表是按虚拟地址顺序连续排列的,想实现对“未使用的虚拟地址空间对应的页表项不存储”很困难,而多级页表就可以用啥存啥,标号灵活

插一句虚拟地址的事,至此再次加深理解,

有句话叫“程序运行时按需加载部分页面到物理内存”,这句话实际意思是,根据虚拟地址去实际内存上分配数据,虚拟地址是没地址的,只是一个标记或者说记录,比如我在记事本上说,在仓库里用2个单元格的空间用来放被子,用6个单元格的空间用来放自行车,这里总共就出现了8个格子,实际也占用仓库(内存)8个空间,但这些分配指令是我记事本里记录的!记事本就是虚拟内存,一个索引!导向!

假设物理内存为 4GB,某程序虚拟地址空间为 4GB(32 位)。程序运行时按需加载部分页面到物理内存,如先占用 3GB 物理内存。此时若另一程序需 2GB 物理内存,物理内存仅剩 1GB,空间不足。操作系统通过局部性原理,检查发现原程序有 1GB 页面近期未使用,将这 1GB 页面换出到磁盘(虚拟内存)。此时物理内存腾出 1GB,加上剩余 1GB,共 2GB,满足新程序需求,解决了物理内存不足问题,使更多程序能正常运行

再深入了解:

进程,程序的虚拟地址空间4GB,再说下这是能力,

虚拟地址空间(如 4GB)是进程的 “理论寻址范围”,划分为固定大小的 虚拟页(如 4KB / 页),但并非一开始就为所有虚拟页创建页表项

页表项是页表中记录单个虚拟页状态的条目,就是存于内存页表上一条一条的

- 该虚拟页是否在物理内存中(有效 / 无效标记);

- 若有效,对应物理页号;若无效,可能对应磁盘上的地址(换出时)或未分配

页表按需激活:

- 进程刚启动时,页表中仅少数关键虚拟页(如程序入口、栈底)的页表项为 “有效”,映射到物理页;

- 其他虚拟页的页表项初始为 “无效”(未分配或指向磁盘),直到进程访问这些地址时,才通过 “缺页中断” 动态分配物理页并更新页表项为 “有效”

映射逻辑:

- 虚拟地址 → 页表项(查状态:若 “有效”,转物理地址;若 “无效”,触发缺页中断);

- 缺页中断时,操作系统:

分配物理页(若内存不足,比如需要1G但没地方了,操作系统就根据页表找到原程序中近期未使用的1GB物理页,(对应其页表项标记为 “有效” 但 “访问位” 未更新)。将这些物理页的数据写入磁盘,页表项从 “物理页号” 改为 “磁盘地址”,标记为 “无效”(表示该虚拟页数据已存于磁盘)。腾出的 1GB 物理内存分配给新程序,将数据从磁盘加载到物理页,更新当前虚拟页的页表项为 “有效”,新程序的页表项更新为对应的物理页号

类比:页表像一本 “地址字典”,初始时即进程创建时,大部分词条(页表项)是 “空白”(无效),只有用到某个虚拟地址时,才在字典里添加或修改词条(分配物理页,记录映射关系)

进程创建时:

- 页表结构(如多级页表的目录、页表基址等)被初始化,但具体页表项几乎全为 “无效”(仅必要的元数据有效)。

- 虚拟地址空间的 “格式”(如页大小、页表结构)固定,但内容(页表项)是空的或无效的。

程序运行时:

- 每访问一个未映射的虚拟地址,触发一次缺页中断,操作系统 “现开” 一个页表项映射到物理页(或换出旧页后映射)。

- 页表项从 “无效”→“有效”,或 “有效”→“无效”(换出时记录磁盘地址),完全按需动态调整

虚拟地址空间是 “理论范围”,页表项是 “动态映射的指针”—— 用多少、映射多少,初始全无效,用到时才激活或分配,无需预先占满内存

唉,我学个东西好费劲啊,必须追问豆包到这种程度才能理解,是福是祸。一无是处穷途末路~~~~(>_<)~~~~

再回到二级页表的事,但如果某个一级页表的页表项没有被用到,也就不需要创建这个页表项对应的二级页表了,即可以在需要时才创建二级页表

假设只有 20% 的一级页表项被用到了,那么页表占用的内存空间就只有 4KB(一级页表) + 20% * 4MB(二级页表)=0.804MB,这对比单级页表的 4MB 节约很多

假如虚拟地址在页表中找不到对应的页表项,计算机系统就不能工作了。所以页表一定要覆盖全部虚拟地址空间,不分级的页表就需要有 100 多万个页表项来映射,而二级分页则只需要 1024 个页表项,一级页表覆盖到了全部虚拟地址空间,二级页表在需要时创建

二级再推广就是多级页表,则页表占用内存空间更少了,依赖于局部性原理

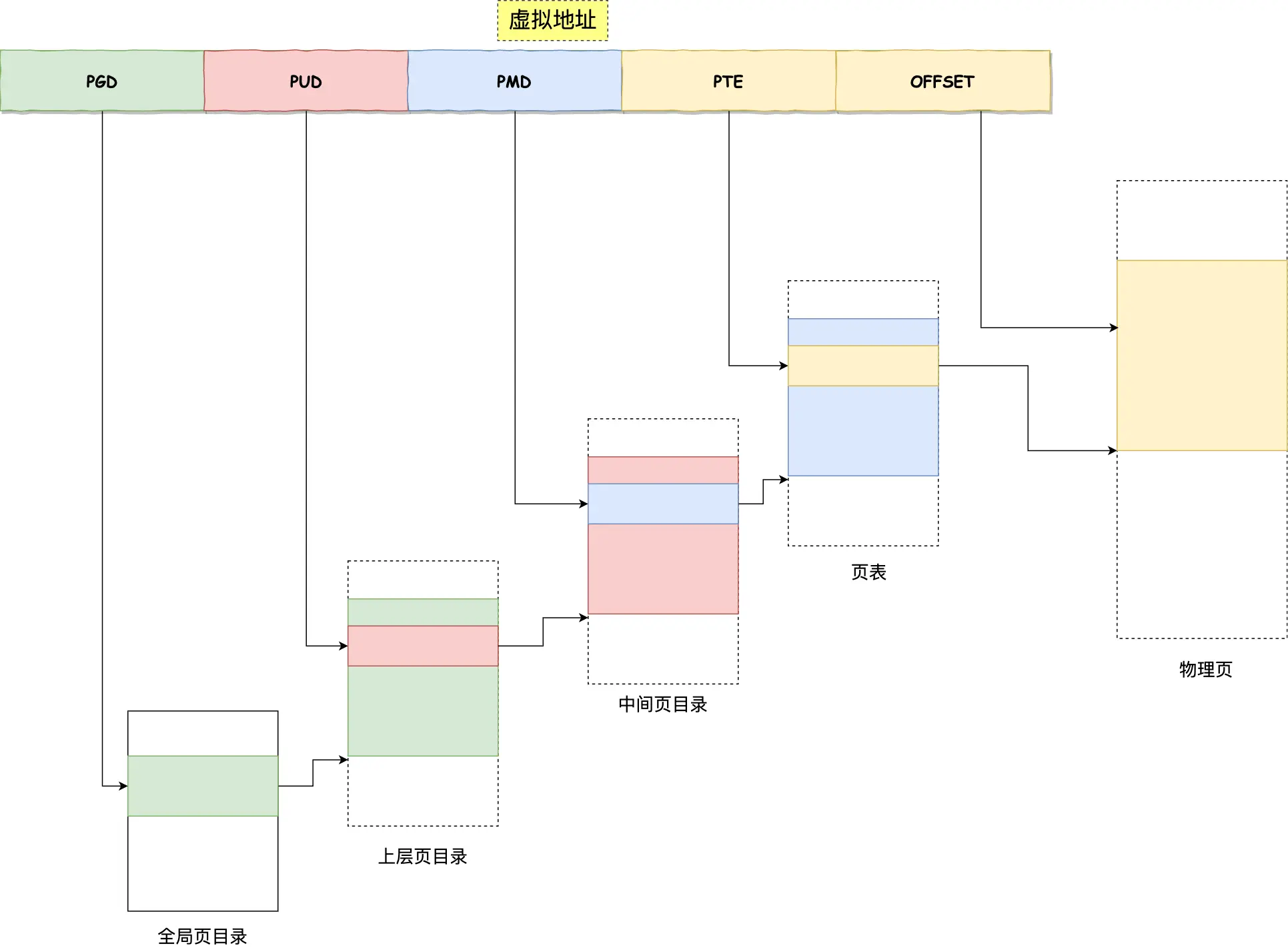

64位机会四级目录

- 全局页目录项 PGD

- 上层页目录项 PUD

- 中间页目录项 PMD

- 页表项 PTE

由于虚拟地址到物理地址的转化多了好几道工序,久经观察发现程序有局部性,一段时间就执行程序某一部分,所以把之前说的,CPU里不是有个用来完成地址转换的内存管理单元MMU嘛,现在把最常用的几个页表存到访问速度很快的硬件里,即在MMU里弄个TLB,专门存放程序常访问的页表项的Cache,TLB也叫页表缓存、转址旁路缓存、快表。CPU寻址先找TLB,没找到就是没命中,那就再找常规页表,TLB命中率很高

注意:os里,每个进程都有自己独立的页表,一个进程一个页表

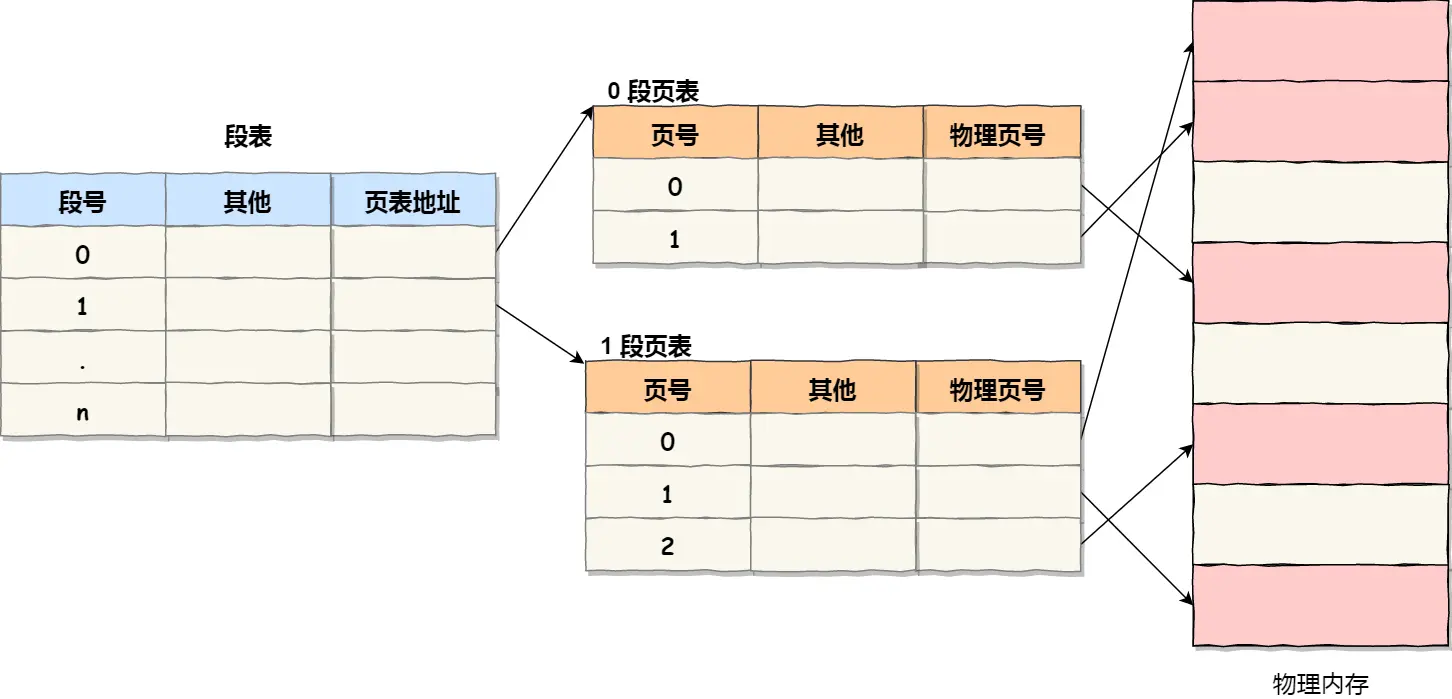

段页式内存管理

先将程序划分为多个有逻辑意义的段,也就是前面提到的分段机制

接着再把每个段划分为多个页,也就是对分段划分出来的连续空间,再划分固定大小的页

地址结构就由段号、段内页号和页内位移三部分组成

第一次访问段表,得到页表起始地址

第二次访问页表,得到物理页号

第三次将物理页号和页内位移组合,得到物理地址

软硬件结合来来实现段页式地址变换,增加硬件成本和系统开销,但提高内存利用率

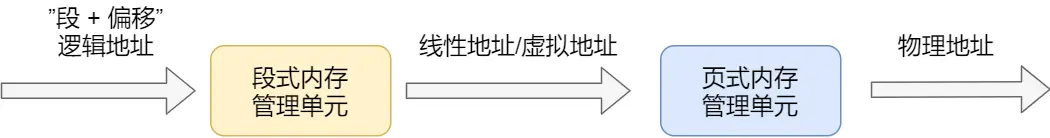

Linux内存管理

先说Intel发展史,起初是段式的,然后在此基础上加了页式的。

即

- 程序使用的都是逻辑地址

- 然后段式内存管理先将逻辑地址映射成线性地址即虚拟地址

- 然后再由页式内存管理将虚拟地址映射成物理地址

那Linux是页式内存管理,但不可避免涉及到段机制

主要是先有的intel处理器(CPU),后有的Linux,只能服从,但Linux实际上有自己的对策,他使得CPU的段式不起作用,即:

Linux 系统中的每个段都是从 0 地址开始的整个 4GB 虚拟空间(32 位环境下),也就是所有的段的起始地址都是一样的

这意味着,Linux 系统中的代码,包括操作系统本身的代码和应用程序代码,所面对的地址空间都是线性地址空间(虚拟地址),这种做法相当于屏蔽了处理器中的逻辑地址概念,段只被用于访问控制和内存保护

比喻:

假设把内存比作一栋大楼,每个房间是内存单元。段式管理像把大楼分成不同功能区域(办公区、仓库区等 ),页式管理像给每个房间编号方便查找。Intel 硬件要求先按区域(段)找,再按房间号(页)找。Linux 觉得这样麻烦,就把所有区域入口都设成一样,相当于只靠房间号(页)来找,而区域划分(段)只用来规定不同区域的使用规则(访问控制、保护 )

至此了解后再深入研究:

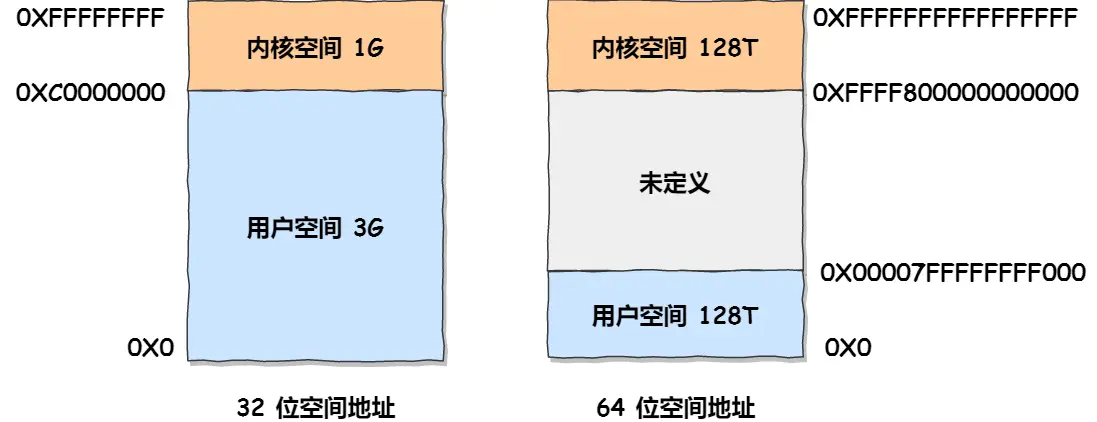

Linux 操作系统中,虚拟地址空间的内部又被分为内核空间和用户空间两部分

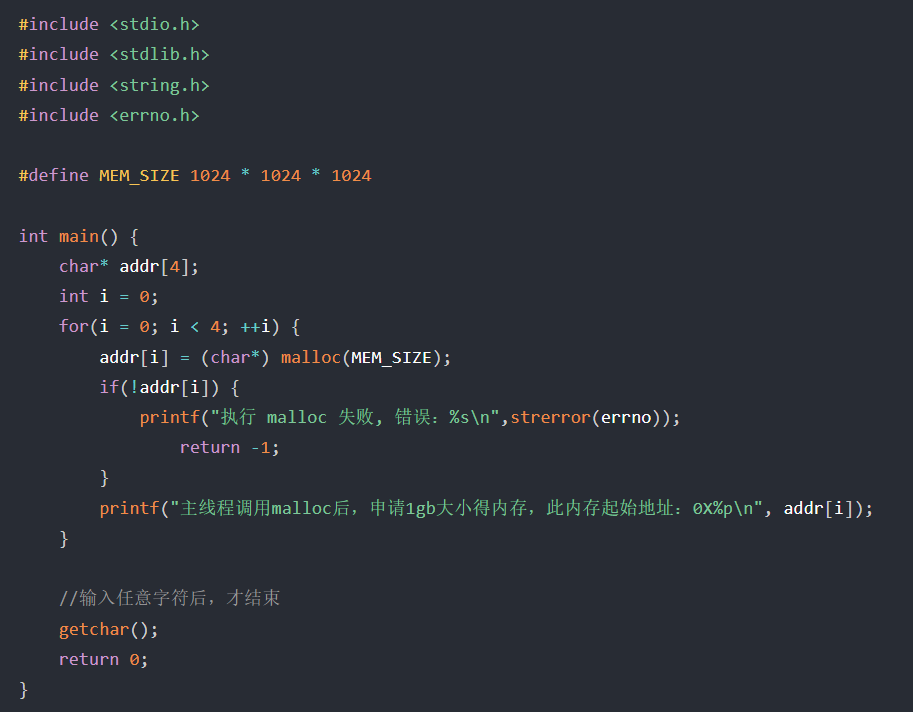

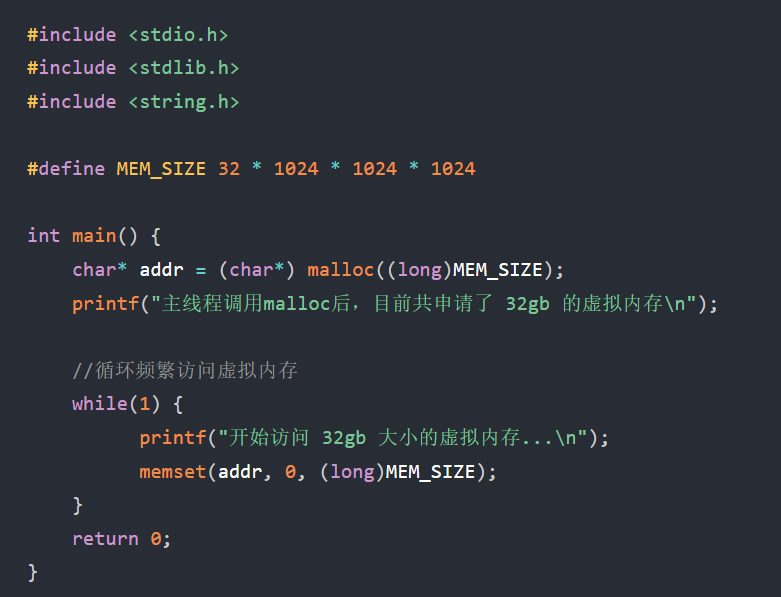

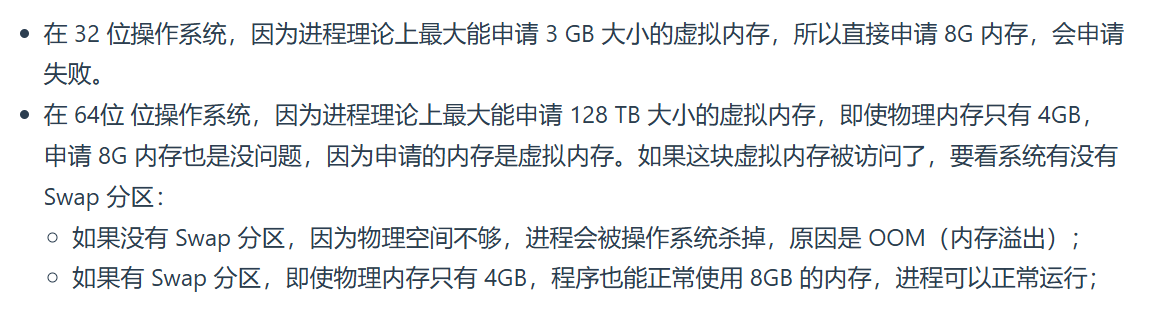

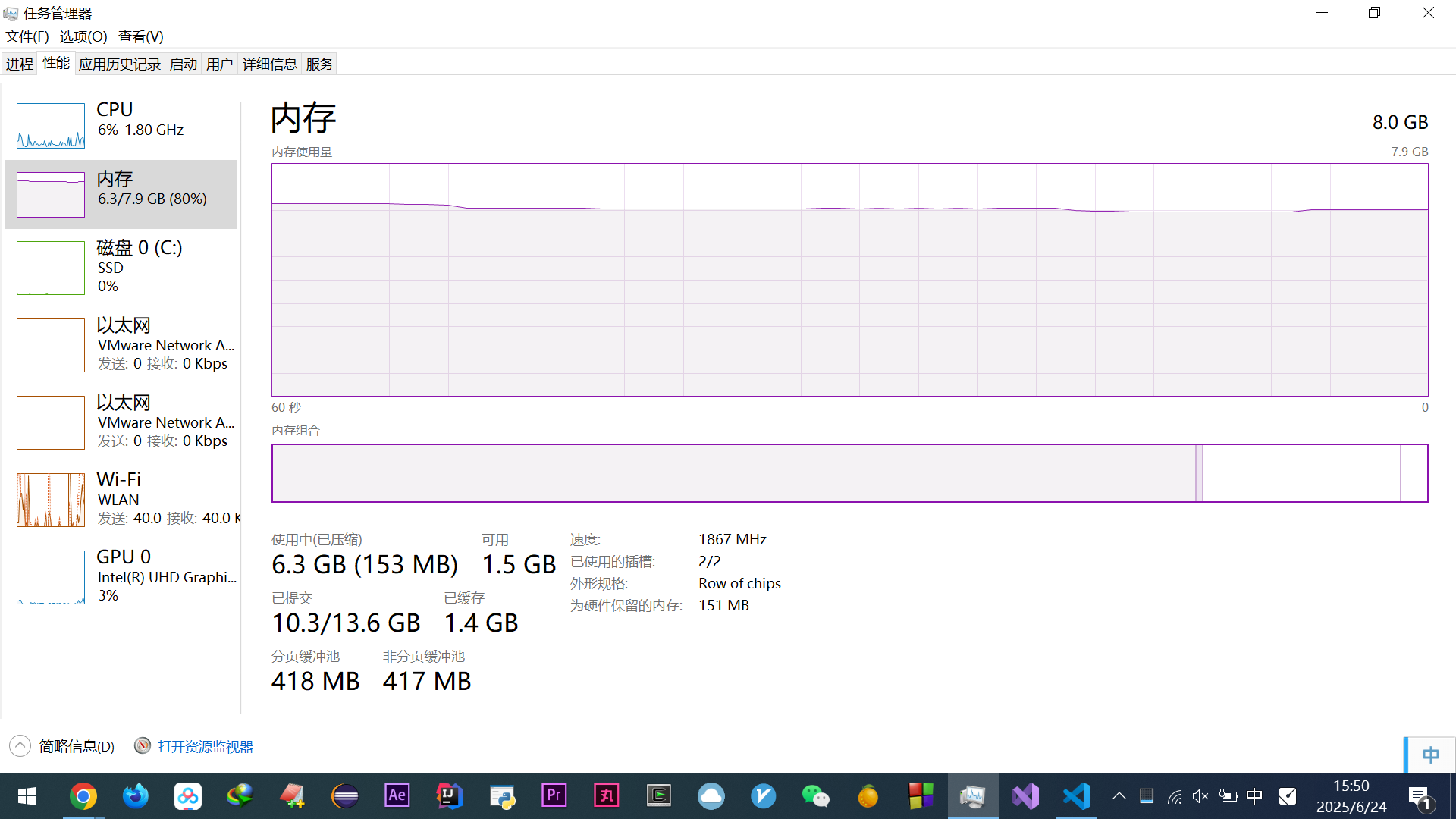

32位操作系统,进程最多只能申请 3 GB 大小的虚拟内存空间,申请 8GB 内存会失败

64位操作系统,进程可以申请 8GB 内存(进程申请内存是申请虚拟内存,只要不读写,也就是不去访问这个虚拟内存,就不会映射,操作系统就不会分配物理内存)

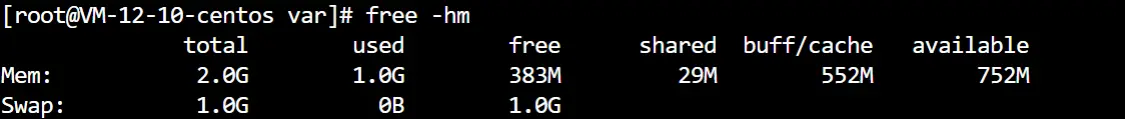

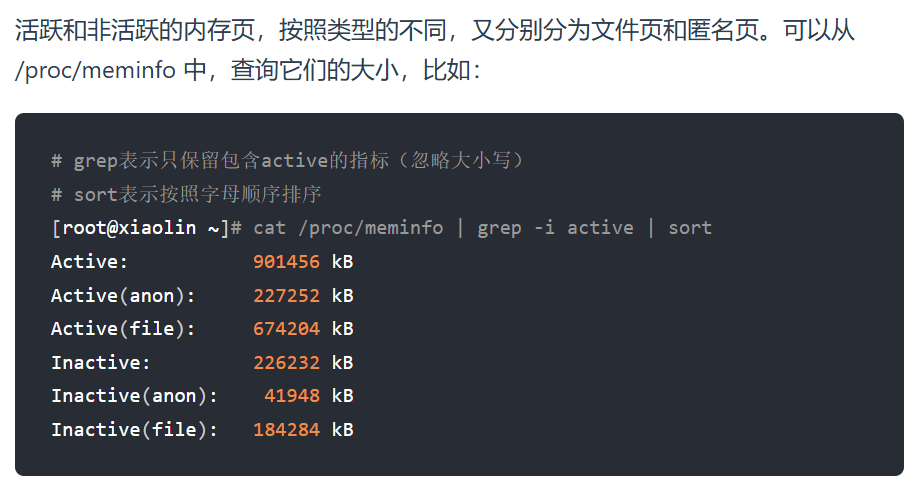

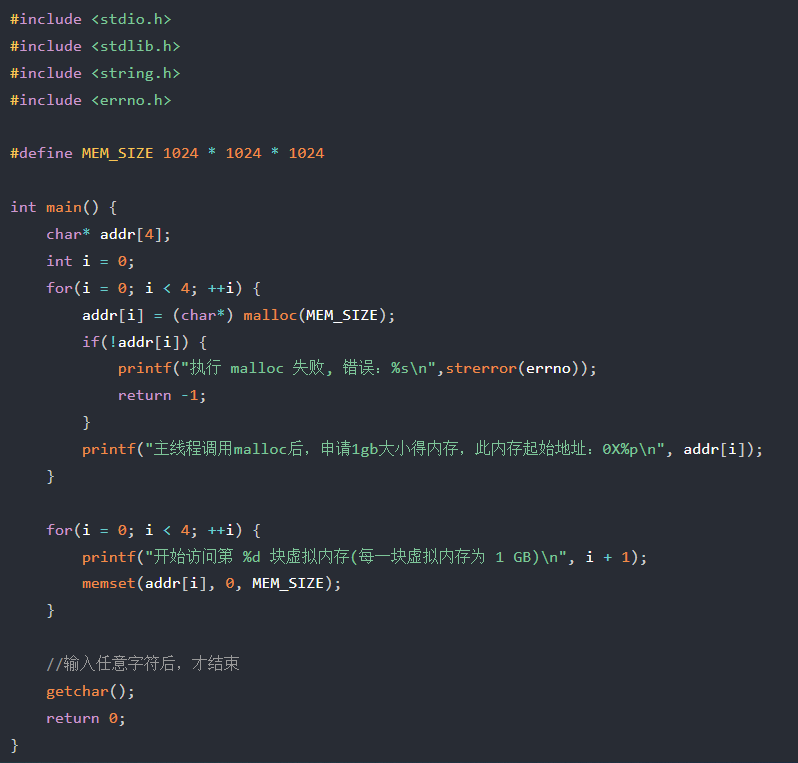

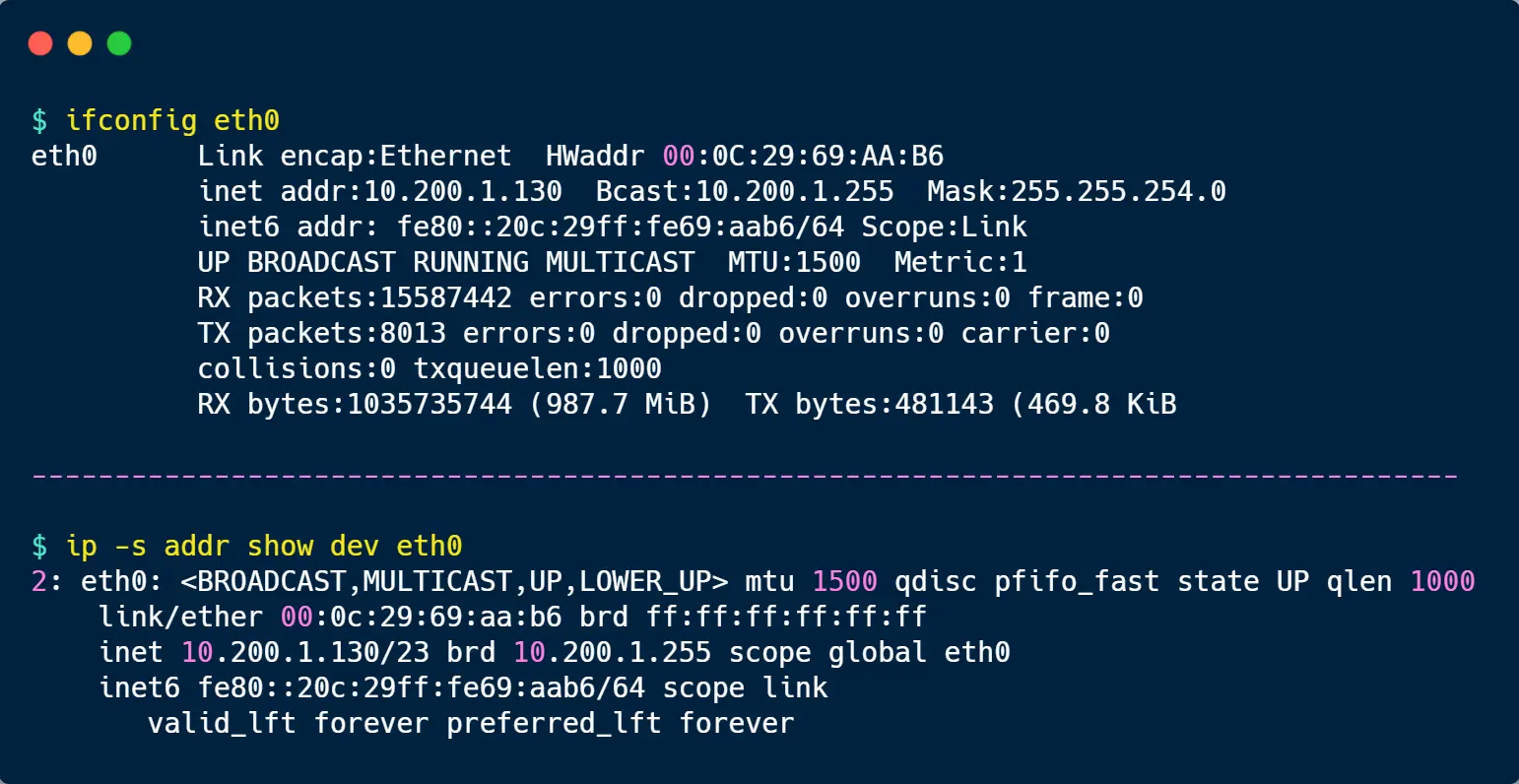

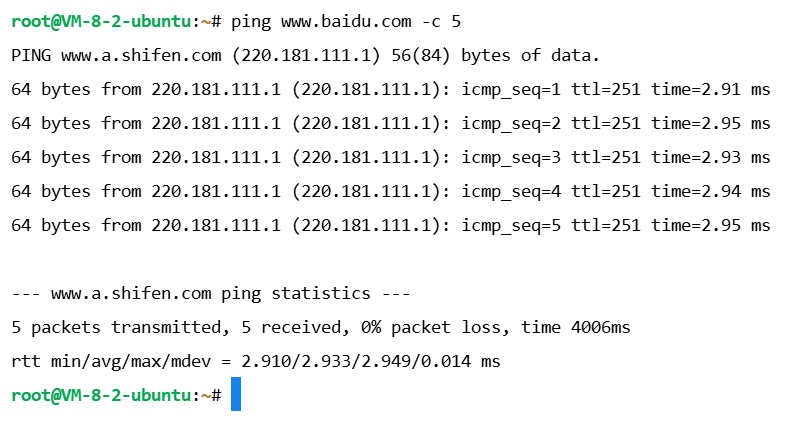

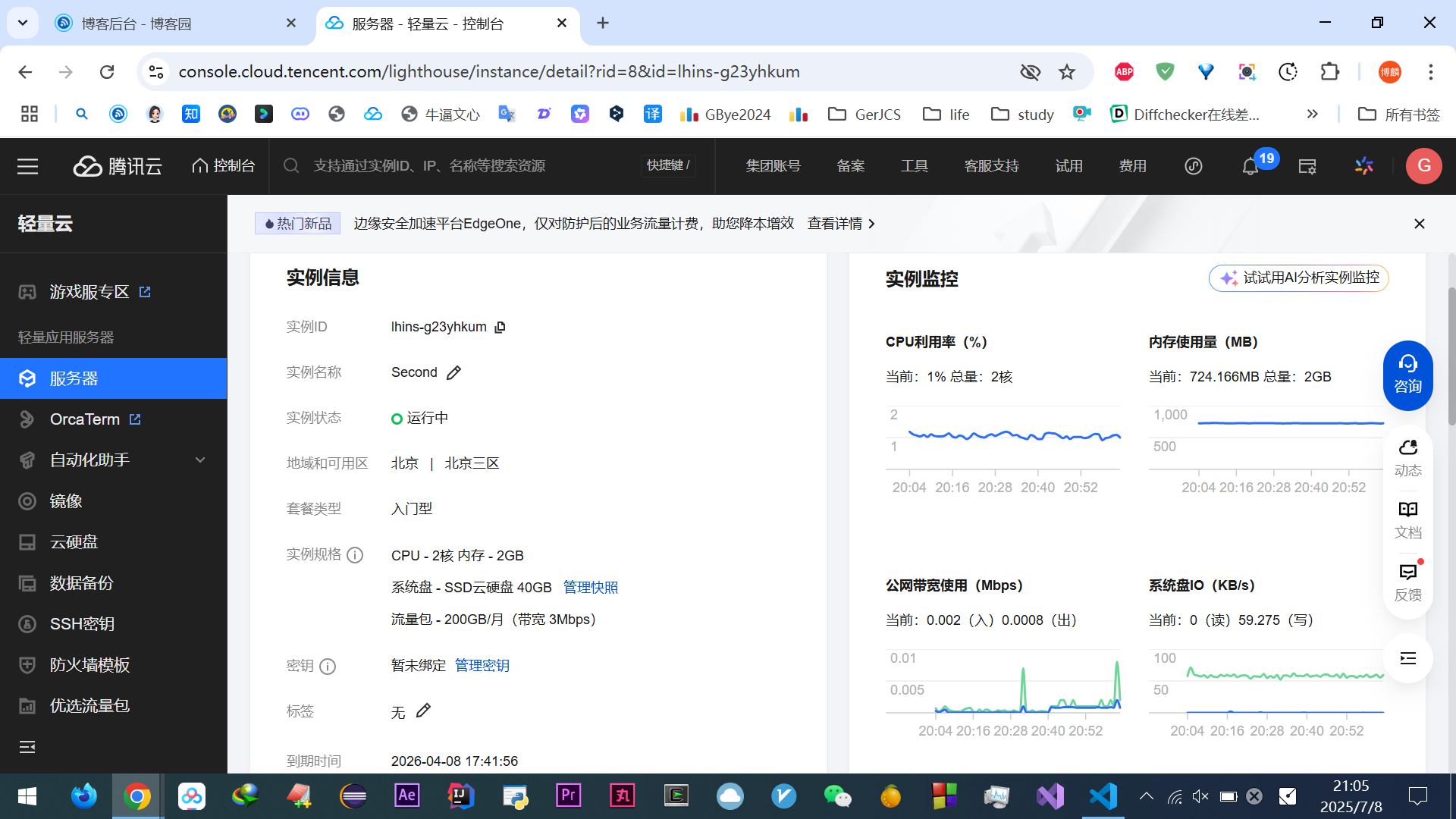

那么,free -m ,-m表示指定M为单位,1GB = 1024MB,2GB就是2048MB,这里就算2GB,因为各种硬件系统保留会导致2GB内存实际小于2GB

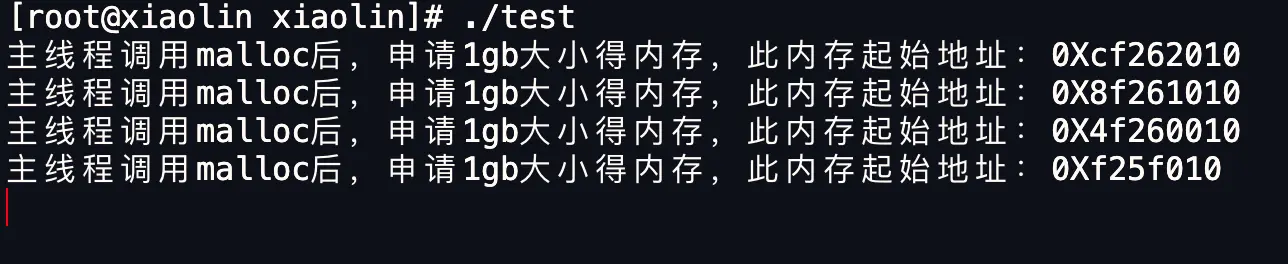

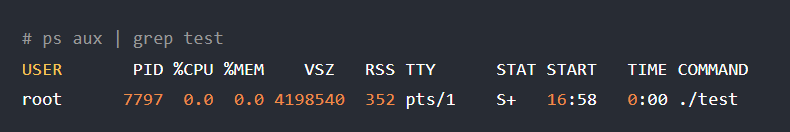

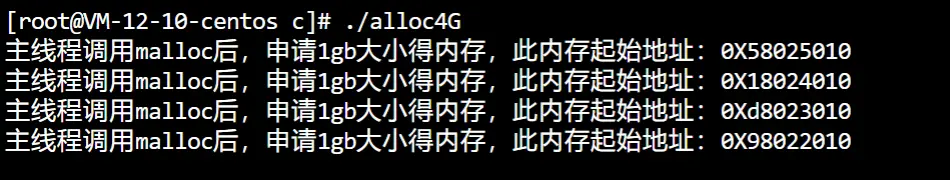

连续申请4次1GB内存,这里只是单纯分配了虚拟内存,并没有使用该虚拟内存,只有往申请的内存空间里写入数据(如strcpy(addr[i], "test"); ),或者读取其中的数据时,就算开始使用了

运行发现,只有2GB内存,但也正常分配了4GB的虚拟内存

ps命令指定KB为单位

VSZ:进程使用的虚拟内存大小,4198540KB 就是 4GB

RSS:进程使用的物理内存大小

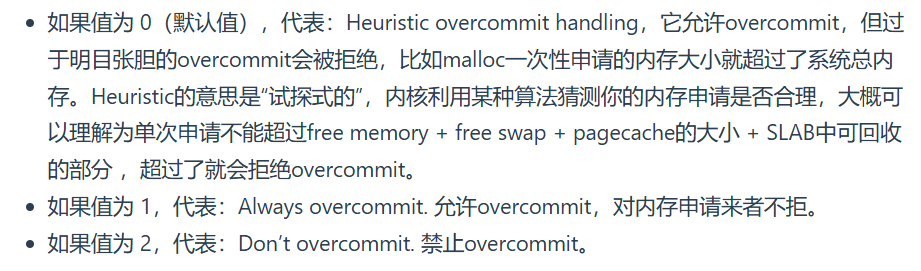

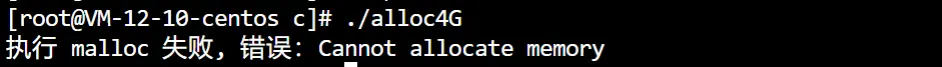

但需要用cat /proc/sys/vm/overcommit_memory查看参数overcommit_memory:

如果overcommit_memory是0,64位os就会申请失败,内核认为我们申请的内存太大了

设置为1就好了

但不同版本的内核有不同处理方法,有的0也可以申请4GB

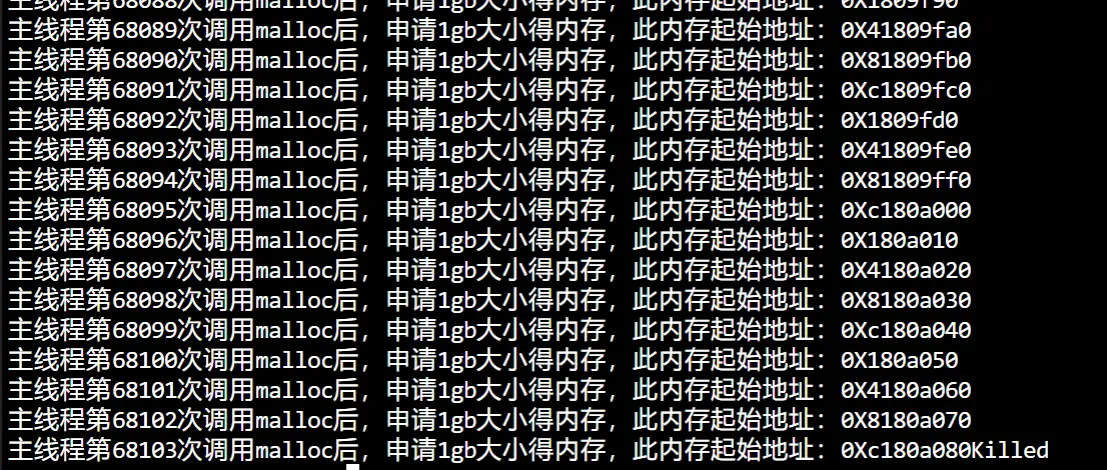

但注意64位的主机也不可以申请接近128T的虚拟内存,物理内存是2GB实验发现没到128T(大概66T)就被杀死了,这里是killed,不是 Cannot Allocate Memory,说明并不是内存申请有问题,而是触发 OOM 了

物理内存不够大,直接回收也没法供进程使用就会OOM,malloc虽然申请的是虚拟内存,只要不去访问就不会映射到物理内存,但申请虚拟内存的过程中,还是使用到了物理内存(比如内核保存虚拟内存的数据结构,也是占用物理内存的)

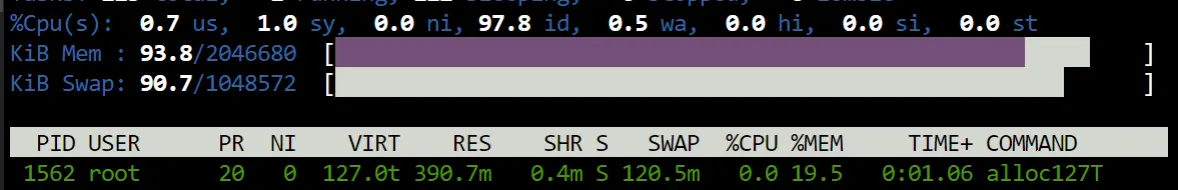

可以用top命令查看物理内存进度条

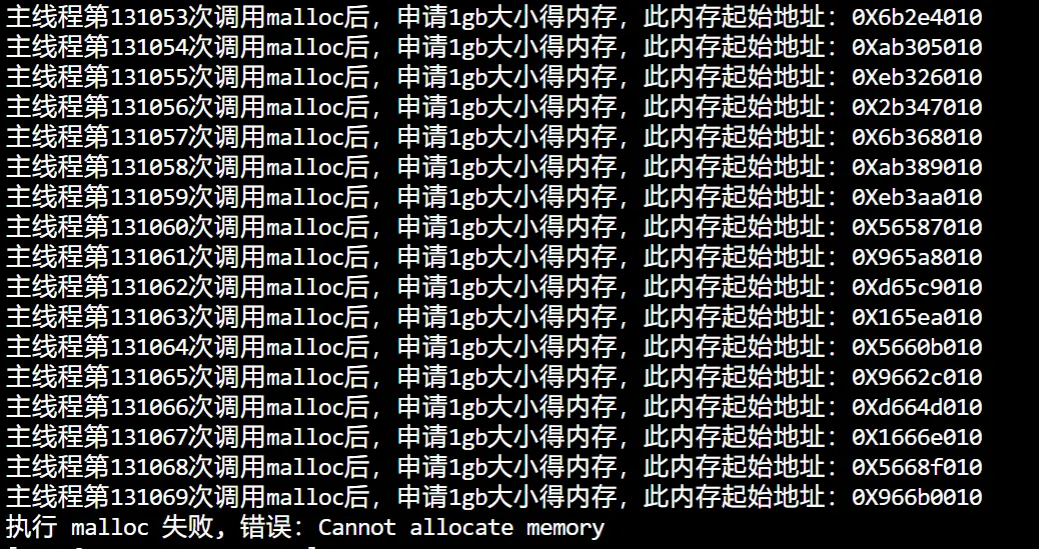

但2GB物理内存、64位操作系统,也可以申请128T虚拟内存

开启swap

发现确实达到了128T才 cannot 的

程序运行本身也需要申请虚拟空间

看个top分析图:

进程类似于临时的,只分给这个进程的不牵扯原本情况,进程结束就会归还390M

进程有独立的虚拟内存,但是每个虚拟内存中的内核地址,其实关联的都是相同的物理内存

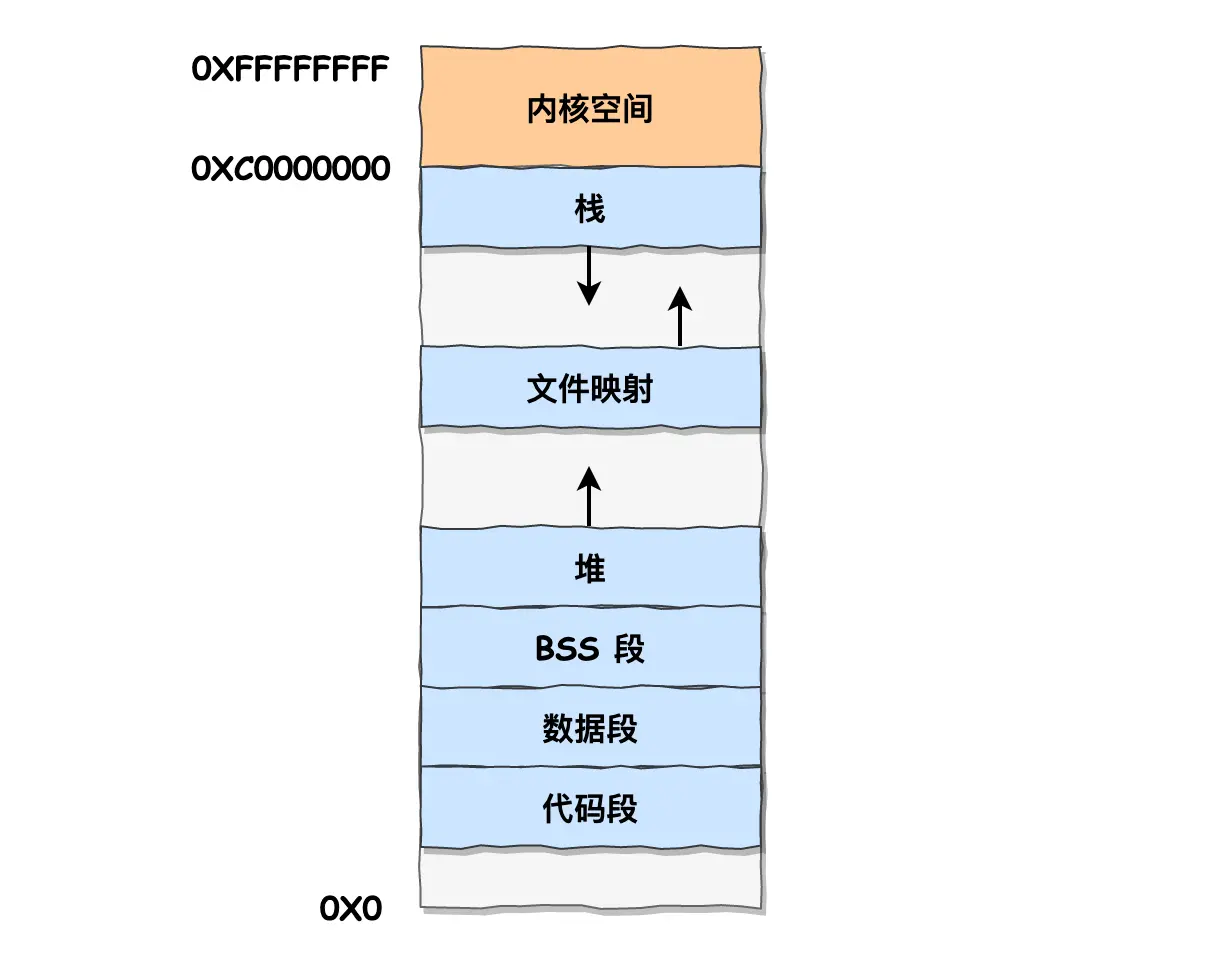

说下用户空间的分布,32位:

- 代码段:包括二进制可执行代码

- 数据段:包括已初始化的静态常量和全局变量;

- BSS 段:包括未初始化的静态变量和全局变量;

- 堆段:包括动态分配的内存,从低地址向上增长

- 文件映射段:包括动态库、共享内存等,从低地址开始向上增长

- 栈段:包括局部变量和函数调用的上下文等。栈的大小是固定的,一般是

8MB,当然系统也提供了参数,以便我们自定义大小; - 灰色是保留区,装不合法的小数值的,比如NULL空指针,即不可访问的内存保留区,防止程序因为出现 bug,导致读或写了一些小内存地址的数据,使得内存跑飞

跑飞:

即读写小内存地址会破坏正常运行数据或指令,致使程序流程错乱、崩溃,无法正常完成任务,

通过设置不可访问内存区域,程序无法对其进行读写,触发内存访问错误异常。操作系统捕获该异常后,可进行相应处理(如终止程序、记录错误日志等 )

这七个中,堆和文件映射段的内存是动态分配的,malloc()、mmap()

总结虚拟内存作用:

- 虚拟内存可以使得进程运行内存超过物理内存大小,虚拟内存是利用硬盘空间模拟内存,提供额外内存空间,因为程序运行符合局部性原理,CPU 访问内存会有很明显的重复访问的倾向性对于那些没有被经常使用到的内存,我们可以把它换出到物理内存之外,比如硬盘的swap区域

- 由于每个进程都有自己的页表,所以每个进程的虚拟内存空间就是相互独立的。解决地址冲突

- 页表里的页表项中除了物理地址之外,还有一些标记属性的比特,比如控制一个页的读写权限,标记该页是否存在等。在内存访问方面,操作系统提供了更好的安全性

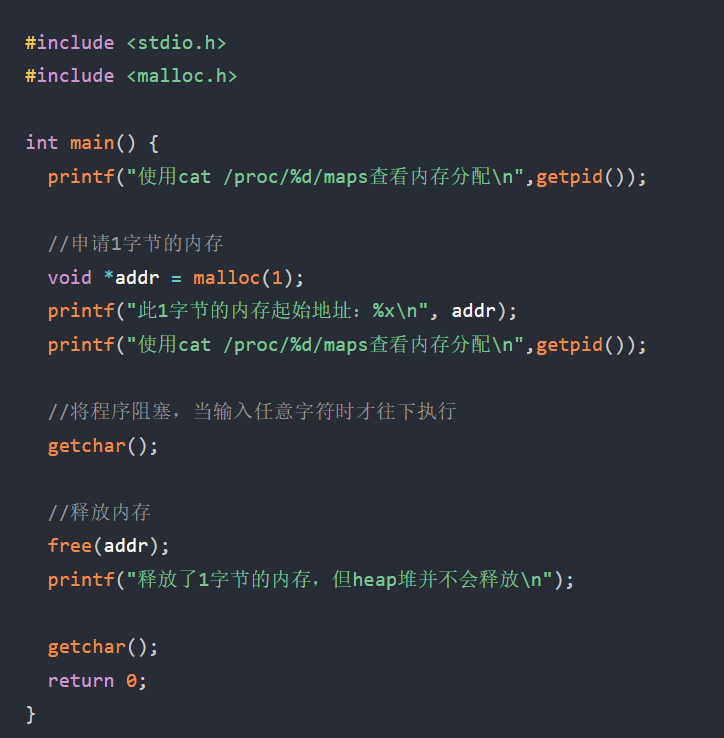

再来说下C库函数malloc(),两种方式申请内存

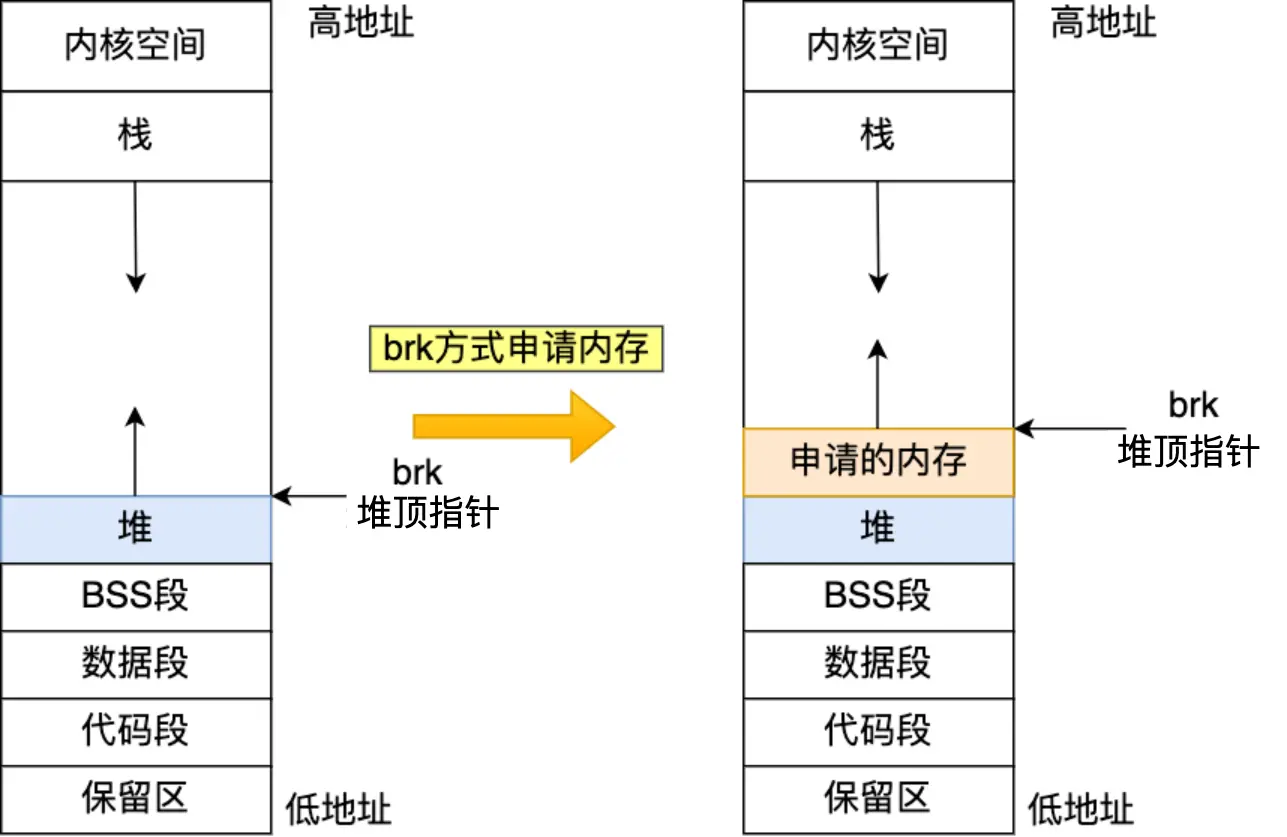

方式一、通过brk()系统调用从堆分配内存。将「堆顶」指针向高地址移动,获得新内存空间,如下:

malloc() 分配的是在虚拟内存的堆上分配内存空间,扩大堆范围,

没被访问的话不会映射物理内存,不占用物理内存,需要用到的时候即首次访问该虚拟内存区域时会触发缺页中断,此时操作系统才会分配物理内存,并在页表中建立虚拟地址与物理地址的映射关系

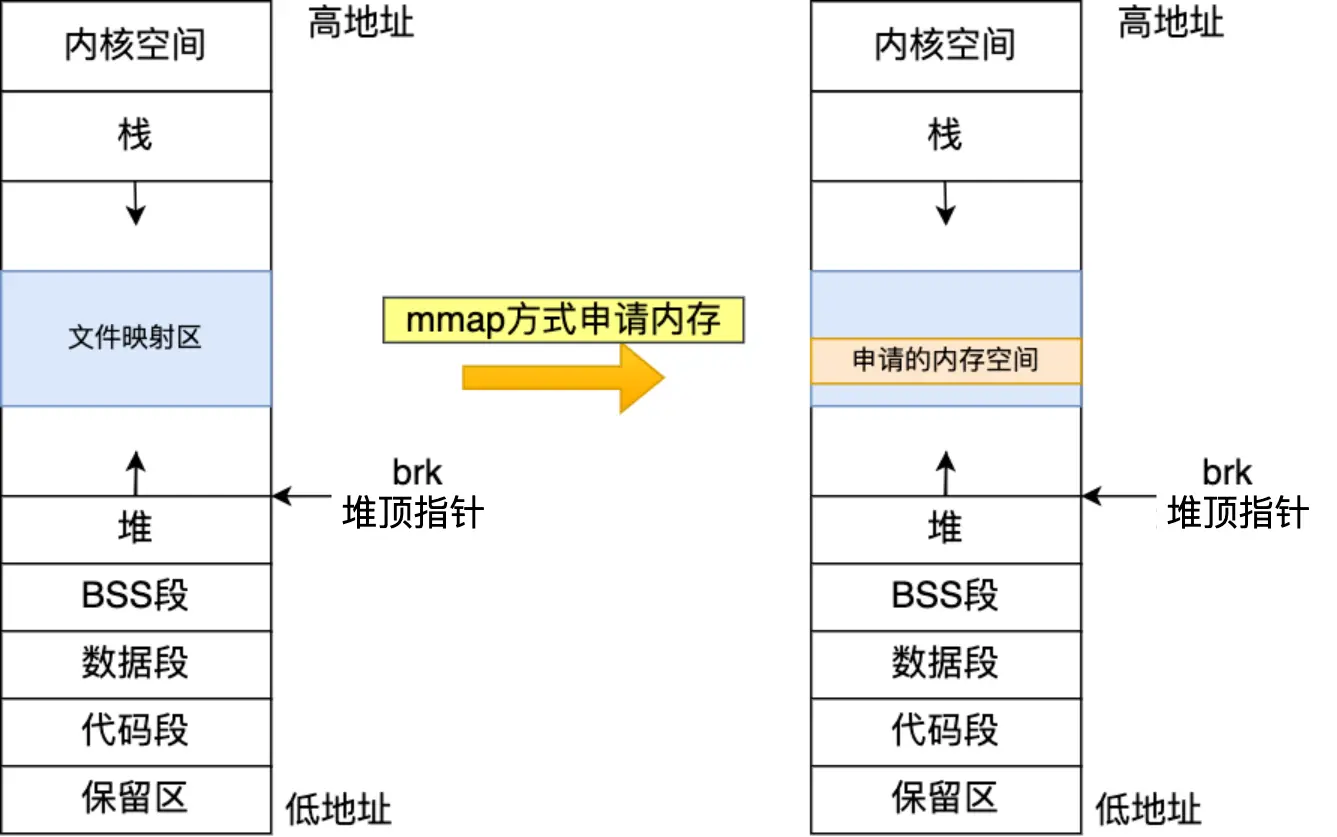

方式二、通过mmap()系统调用中的私有匿名映射,在文件映射区分配一块内存,也就是从文件映射区“偷”了一块内存

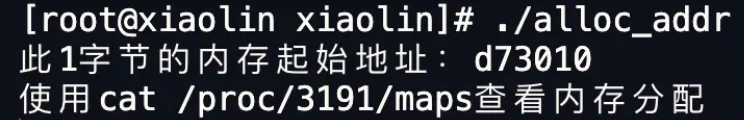

实操测验:

malloc(1):代码里第一个printf可以去掉

去掉第一个printf后:

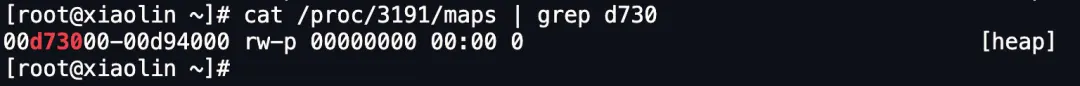

通过/proc/[pid]/maps 文件查看进程的虚拟地址空间的内存映射到内存的实际分布情况

grep d730 则对输出的内容进行过滤,只输出其中包含字符串 d730 的行,这里估计是小林提前看到了地址是d7300所以直接用这么了

00d73000-00d94000:表示内存地址范围132KB,即该进程此段内存的起始地址和结束地址。也说明了实际预分配132K字节的内存rw-p:权限标识,r代表可读,w代表可写,p代表私有(初始共享,修改时候用副本修改)00000000:偏移量

分配内存小于128KB,所以brk()向堆空间申请的内存,最右边有 [heap] 的堆标识

这里看到了,本意是想malloc(1)来分配1字节,但实际会根据malloc使用的内存管理器Ptmalloc2,预分配更大空间作为内存池,即实际预分配了 132K字节的内存(128KB是malloc决定采用brk还是mmap,此处brk说明小于128KB,但实际malloc分配时候会多分配一些来用作管理优化)

malloc(100)不一定是 100 倍 。实际分配大小没有固定倍数关系,可能仍在 128KB 以内

这是因为 malloc 为提高内存管理效率,会结合自身内存管理策略(内存池等机制)进行内存分配,并非严格按申请的最小量分配

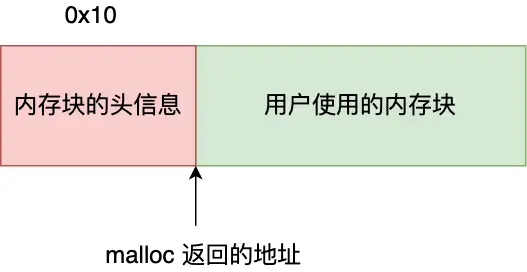

但程序里打印的内存起始地址是 d73010,而 maps 文件显示堆内存空间的起始地址是 d73000,为什么会多出来 0x10 (16字节)呢?这是给free用的,free()只传入一个内存地址,就知道要释放多大内存

执行 free() 函数时,free 会对传入进来的内存地址向左偏移 16 字节,然后从这个 16 字节的分析出当前的内存块的大小等信息,自然就知道要释放多大的内存了

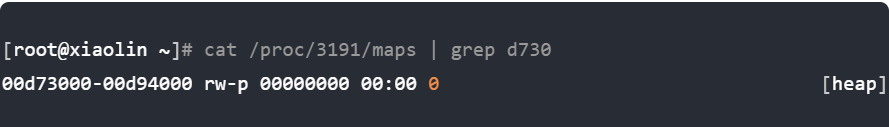

接下来再看下free释放内存的底层逻辑

继续执行,敲个回车,输出这行:

cat查看发现:

free堆内存依旧存在,没归还操作系统。这是因为与其把这 1 字节释放给操作系统,不如先缓存着放进 malloc 的内存池里,当进程再次申请 1 字节的内存时就可以直接复用,这样速度快了很多。(进程退出后,操作系统就会回收进程的所有资源)

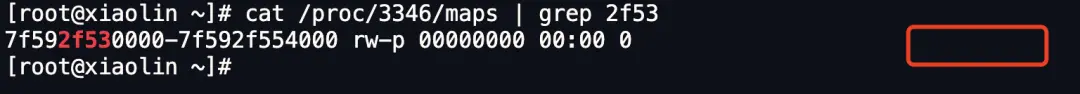

但如果mmap(),free释放内存后就会归还操作系统,即malloc(128*1024)

执行代码

没[heap],说明是通过 mmap 以匿名映射的方式从文件映射区分配的匿名内存

然后释放后再grep就不显示任何了

解释下内存池 及 完整底层工作逻辑顺序:

内存池类似仓库,减少去跟操作系统“进货”过程,brk()是堆上,空间连续的,直接预分配更大的内存池,释放时候依旧缓存在内存池,下次申请直接从内存池拿,因为内存块的虚拟地址与物理地址映射关系还存在,不仅减少了系统调用次数,也减少中断缺页次数,大大降低CPU消耗

不放入内存池那就要重新管os要内存,即

程序代码里写malloc,brk调用,运行时,根据代码和输入数据等决定怎么分配虚拟地址

执行到malloc代码的时候,底层是触发brk系统调用,进入内核态,内核调整虚拟内存堆指针上移,扩大范围

然后立马CPU就会去访问这个虚拟内存,发现虚拟内存没映射到物理内存,CPU产生缺页中断,将缺页中断交给内核的 Page Fault Handler缺页中断函数处理,然后映射物理内存,建立映射

mmap每次都归还,就是每次都会调用,然后每次mmap分配的虚拟地址都是缺页状态的,第一次访问该虚拟地址,会触发缺页中断,CPU消耗大

复用是好了,但如果一直不释放很多小块内存,导致碎片内存泄漏,valgrind无法检测,所以默认大块内存采用mmap

2025/0505

还有23小节

妈逼的看网站的一些提问截图,感觉加群很多问题都有讨论

当初学那些没时间观念,现在妈的除了os还要算法回顾,还要C++巩固,项目还没做艹了,网络也没回顾

计划:

到11号学完os

到18号学完C++ & 算法巩固

19开始做项目,把所有东西反复巩固25号结束

争取这个月结束学习,6月全力面试

0506没学,走不到图书馆了,再学人要死路上了睡觉导管

0507

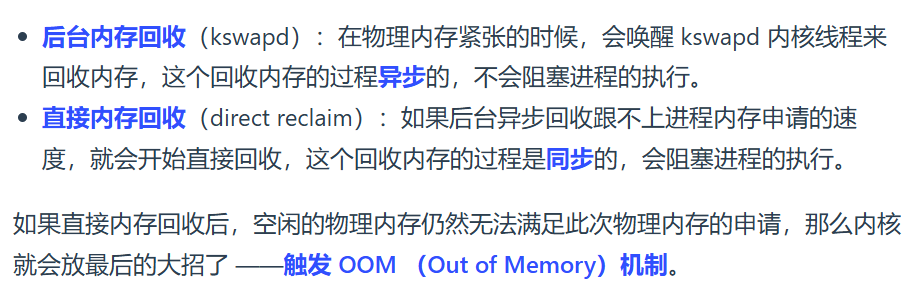

深入了解内存紧张发生啥

即上面说的“CPU产生缺页中断,将缺页中断交给内核的 Page Fault Handler缺页中断函数处理,然后映射物理内存,建立映射”,那如果物理内存不够,内核开始回收工作

OOM Killer会选择一个占用物理内存较高的进程,然后将其杀死,以便释放内存资源,如果物理内存依然不足,OOM Killer 会继续杀死占用物理内存较高的进程,直到释放足够的内存位置

哪些可以被回收?

文件页(File-backed Page):

内核缓存的磁盘数据(Buffer)和内核缓存的文件数据(Cache)都叫作文件页,其中大部分缓存数据未被修改或已同步到磁盘都称是“干净页”,都可以直接释放内存,以后有需要时,再从磁盘重新读取

而那些被应用程序修改过,并且暂时还没写入磁盘的数据(也就是脏页),就得先写入磁盘(涉及影响系统性能的磁盘IO操作),然后才能进行内存释放

即:

-

- 回收干净页的方式是直接释放内存(有后台和直接两种方式)

- 回收脏页的方式是先写回磁盘后再释放内存

内核缓存的磁盘数据(Buffer):把它想象成一个 “写数据中转站”。当要往磁盘写数据时,先把数据放到 Buffer 里 “攒一攒”,然后集中写到磁盘上

内核缓存的文件数据:看作 “读数据快速通道”。从磁盘读文件数据时,先把数据存到这里(内存中),下次再读这个文件时,直接从这里取,不用再去磁盘找

这里关于备份再说下,释放的是 内存里的缓存(临时副本),不是磁盘上的 真实数据(持久化存储),

-

- 干净页(未修改的缓存):直接释放内存,真实数据在磁盘,后续需要时从磁盘重新读入内存。

- 脏页(已修改的缓存):先把修改写入磁盘(保存真实数据),再释放内存,确保数据不丢失

匿名页(Anonymous Page):

没实际载体(比如堆栈数据,都没载体),通过 Linux 的 Swap 机制,Swap 会把不常访问的内存先写到磁盘中,然后释放,等用到再读入内存

至此对比理解,

- 文件页数据本身与磁盘文件直接关联(如从磁盘读取到内存的文件数据或待写入磁盘的缓冲数据),有明确的磁盘文件作为依托。即有明确的对应标记和联系。文件页通过文件系统的索引节点(inode)等结构与磁盘文件关联,内核借此知晓文件页对应磁盘上的具体文件及数据位置

- 堆栈数据平时存于内存,写入磁盘是内存紧张时的临时处理手段(仅为释放内存),并非其天然载体。即使写入磁盘,也不像文件页那样与某个磁盘文件有直接、固有的对应关系。即没有文件页那样与磁盘的特定标记记号,swap作为临时依托

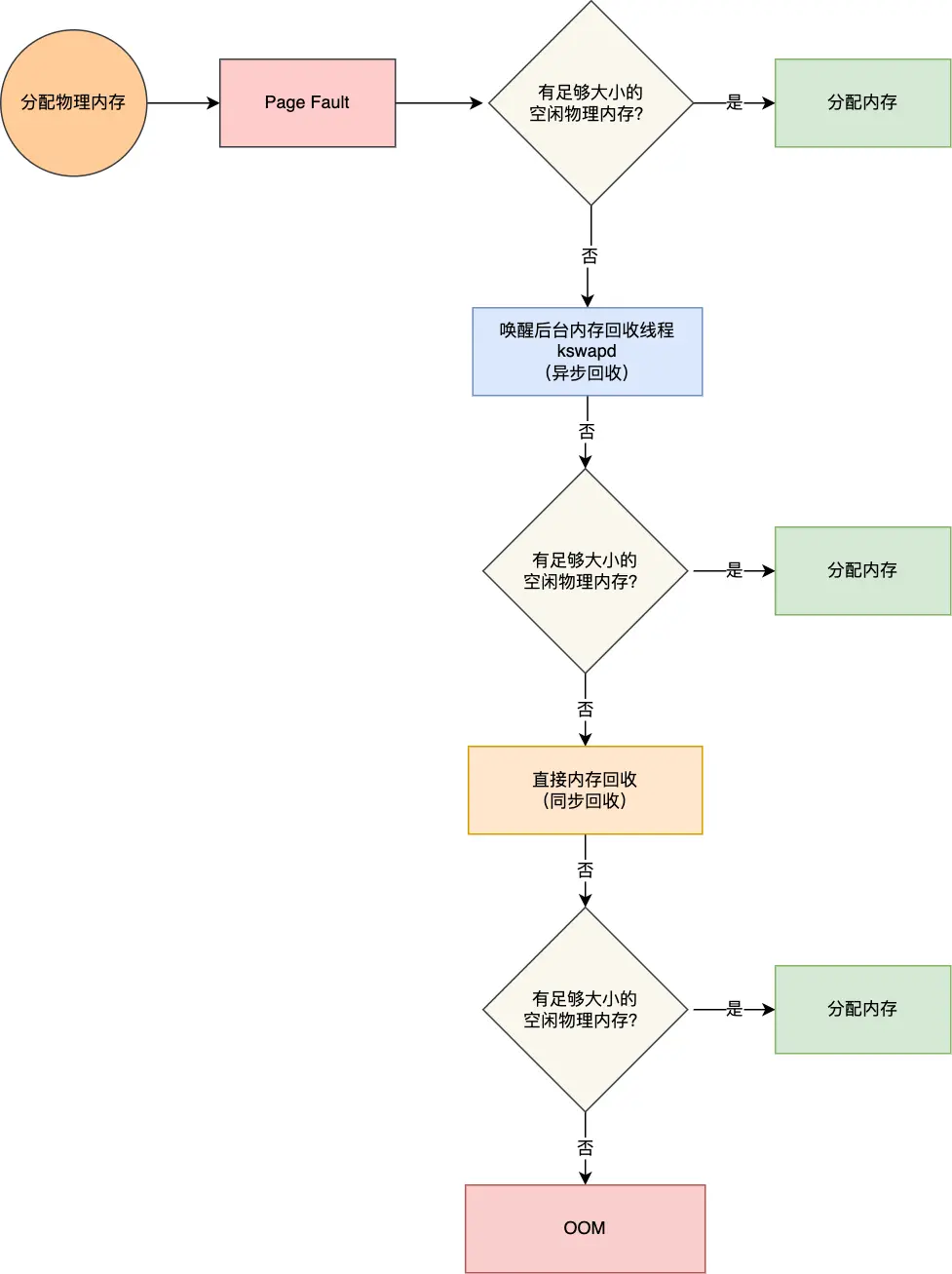

以上都基于LRU(优先回收不常访问的内存)算法,维护active_list 活跃内存页链表、inactive_list 不活跃内存页链表(很少被访问的内存页),越接近链表尾部,就表示内存页越不常访问

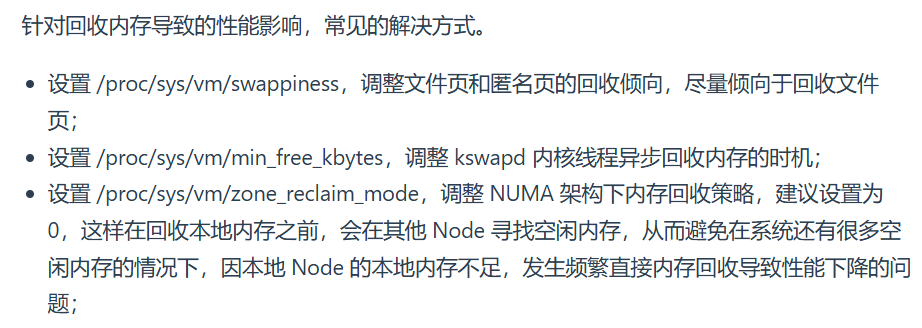

以上都涉及磁盘IO性能影响,咋解决?

解决方案一:调整回收倾向于文件页

匿名页swap换入换出比较差,文件页回收操作相对好点,Linux的/proc/sys/vm/swappiness调整匿名回收倾向,0~100,越大越用匿名,建议0

解决方案二:尽早触发kswapd内核线程异步回收

系统抖动指的是磁盘IO繁忙内存使用异常导致的各种问题

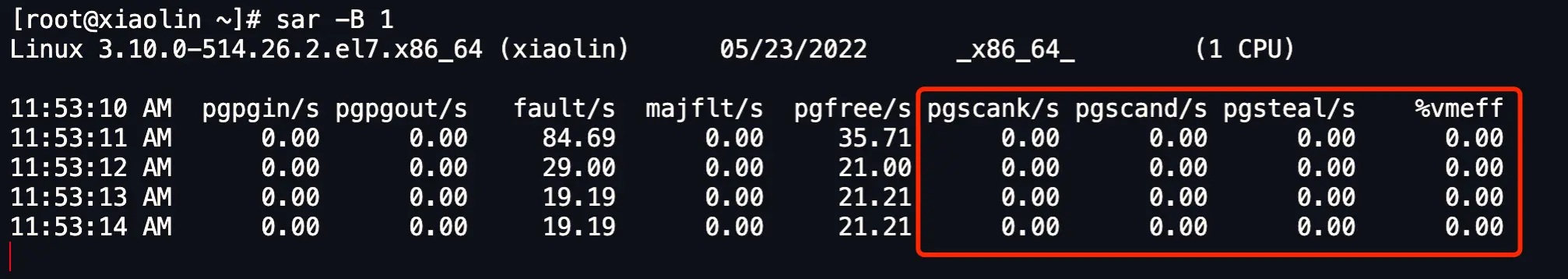

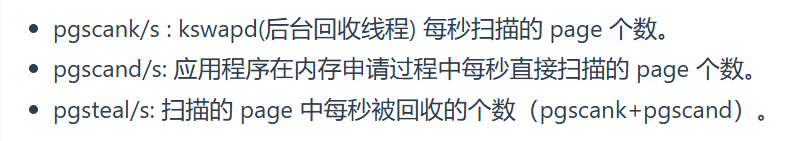

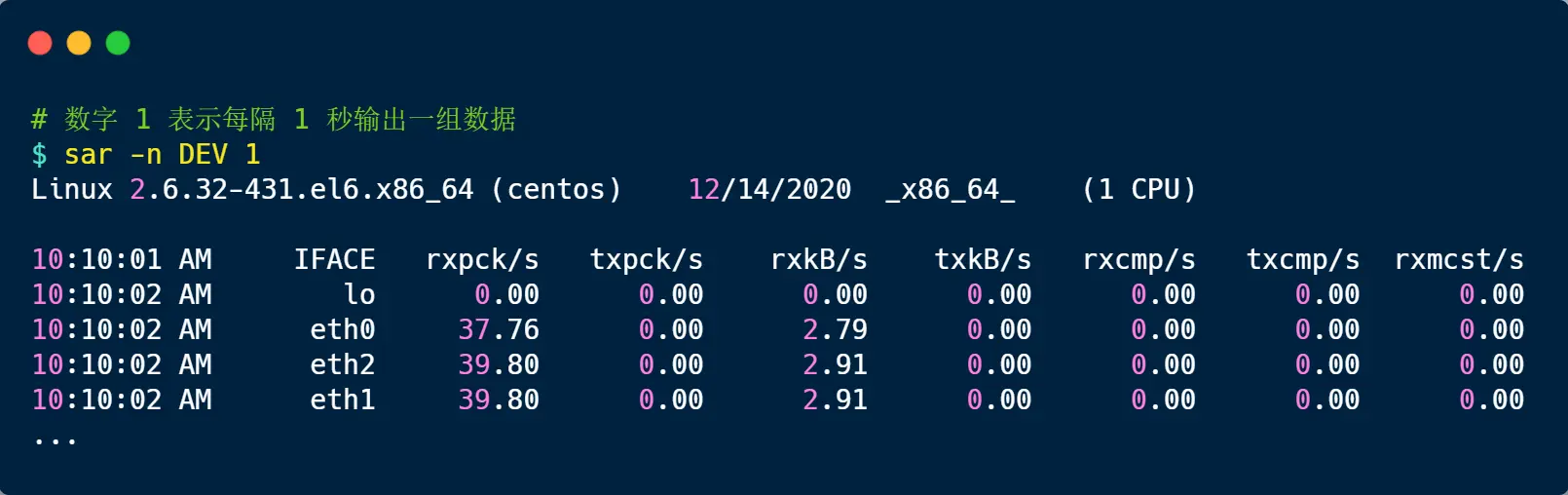

sar -B 1 观察,红框就是直接内存回收 和 后台内存回收 的指标

发生抖动就是因为pgscand 数值过大,即直接内存导致的,就尽早触发后台内存回收kswapd,

啥条件会触发?

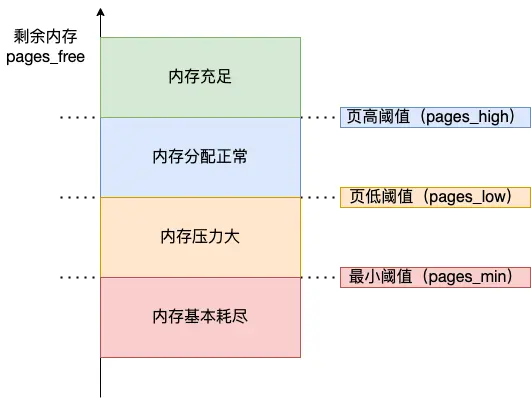

内核定义了三个内存阈值(也叫watermark水位),分成绿蓝橙红

kswapd会定期扫描内存使用情况,来进行内存回收工作

压力大到橙色时kswapd会异步执行回收,直到剩余的处于蓝色内

红色那就触发 直接内存回收

kswapd 的活动空间只有 pages_low 与 pages_min 之间的这段区域

蓝色不会唤醒kswapd

页低阈值(pages_low)可以通过内核选项 /proc/sys/vm/min_free_kbytes 间接设置

所以通过 sar - B 发现 pgscand很大,系统抖动,就增大min_free_kbytes 来及早地触发后台回收,然后继续观察 pgscand 是否会降为 0

比如极端点1KB,才处理直接回收,那一直用很久不会有事,然后剩1.5KB可能在处于橙色段,但后台回收不及时,又用内存,触发直接回收了。

所以增大min来让内核提早干活后台回收

过大min会浪费内存,极端是接近物理内存,应留给用程序内存太少会频繁导致OOM

如果关注延迟那就适当地增大 min_free_kbytes,如果关注内存的使用量那就适当地调小 min_free_kbytes

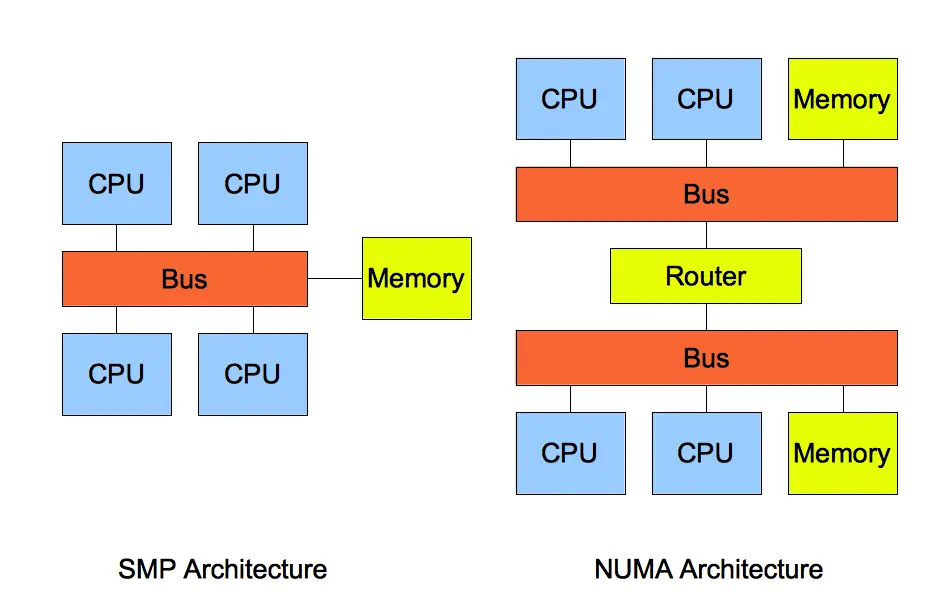

解决方案三:NUMA 架构下的内存回收策略

先说SMP架构,都是针对CPU的

SMP 指的是一种多个 CPU 处理器共享资源的电脑硬件架构,也就是说每个 CPU 地位平等,它们共享相同的物理资源,包括总线、内存、IO、操作系统等。每个 CPU 访问内存所用时间都是相同的,也叫一致存储访问结构(UMA)

但CPU处理器核数增多,多个 CPU 都通过一个总线访问内存,这样总线的带宽压力会越来越大,同时每个 CPU 可用带宽会减少

引出NUMA结构,非一致存储访问结构

把资源进行了分组,每一组用Node 来表示,一个 Node 能包含多个 CPU 和相连的本地内存(其他 Node 就叫远程)

每个 Node 有自己独立的资源,包括内存、IO 等,每个 Node 之间可以通过互联模块总线(QPI)进行通信

每个 Node 上的 CPU 都可以访问到整个系统中的所有内存,但访问远端 Node 的内存比访问本地内存要耗时很多

当内存不足时,系统可以从其他 Node 寻找空闲内存,也可以从本地内存中回收内存

/proc/sys/vm/zone_reclaim_mode 里有几种控制选项:

如果非0,当本地内存中的文件页有脏页时,可将其写回硬盘释放空间,或通过 swap 把部分数据换出到磁盘来回收内存,这种情况弄成0最好,

所以如果系统出现还有一半内存的时候,却发现系统频繁触发「直接内存回收」,导致了影响了系统性能,那可能是 zone_reclaim_mode 没有设置为 0 ,导致当本地内存不足的时候,只选择回收本地内存的方式,而不去使用其他 Node 的空闲内存

如何保护一个进程不被 OOM 杀掉呢?

当系统空闲内存不足,进程申请了一个很大的内存,直接回收无法弄出足够空闲内存,就会OOM,即内核就会根据算法选择一个进程杀掉,那咋选的?

通过oom_badness()把系统中可以被杀掉的进程扫描一遍,并对每个进程打分,得分最高的进程就会被首先杀掉

// points 代表打分的结果

// process_pages 代表进程已经使用的物理内存页面数

// oom_score_adj 代表 OOM 校准值(每个进程都有OOM 校准值 oom_score_adj,通过/proc/[pid]/oom_score_adj 配置,设置 -1000 到 1000 之)

// totalpages 代表系统总的可用页面数

points = process_pages + oom_score_adj * totalpages / 1000用「系统总的可用页面数」乘以 「OOM 校准值 oom_score_adj」再除以 1000,最后再加上进程已经使用的物理页面数,计算出来的值越大,那么这个进程被 OOMKill 的几率也就越大

校准值默认是0。最终得分跟进程自身消耗的内存有关,消耗的内存越大越容易被杀掉  最好将一些很重要的系统服务的 oom_score_adj 配置为 -1000,比如 sshd,因为这些系统服务一旦被杀掉,我们就很难再登陆进系统了

最好将一些很重要的系统服务的 oom_score_adj 配置为 -1000,比如 sshd,因为这些系统服务一旦被杀掉,我们就很难再登陆进系统了

总结:

再至此有了简单的粗浅了解,那先做个总结:

- 当物理内存不足时,文件页的回收(干净页直接释放、脏页写回磁盘再释放)是内存回收的常规操作,无论 Swap 是否开启都会进行,它是独立于 Swap 机制的内存管理行为

- 而对于匿名页就有说道了,现在说说匿名页的处理逻辑,之前也有提交,此文搜“swap图”

开始说swap处理逻辑:

swap机制优点:

- 应用程序实际可以使用的内存空间将远远超过系统的物理内存

- 硬盘空间的价格远比内存要低

因此这种方式无疑是经济实惠的,但频繁读写硬盘,会降低操作系统运行速率,这是swap弊端

Linux 中的 Swap 机制会在 内存不足 和 内存闲置 的场景下触发:

内存不足:当系统需要的内存超过了可用的物理内存时,内核会将内存中不常使用的内存页交换到磁盘上为当前进程让出内存,保证正在执行的进程的可用性,这个内存回收的过程是强制的直接内存回收,直接内存回收是同步的过程,会阻塞当前申请内存的进程

内存闲置:应用程序在启动阶段使用的大量内存在启动后往往都不会使用,通过后台运行的守护进程(kSwapd)可将只使用一次的内存,交换到磁盘上。

kSwapd 是 Linux 负责页面置换(Page replacement)的守护进程,它也是负责交换闲置内存的主要进程,它会在空闲内存低于一定水位时,回收内存页中的空闲内存保证系统中的其他进程可以尽快获得申请的内存。kSwapd 是后台进程,所以回收内存的过程是异步的,不会阻塞当前申请内存的进程

Linux开启Swap,俩招:Swap 分区 & Swap 文件

Swap 换入换出的是什么类型的内存?

内核缓存的文件数据,因为都有对应的磁盘文件,所以回收的时候,干净的不管,直接释放内存。脏的需要写回磁盘保证一致性

通过前面了解堆栈数据没实际载体,匿名页,防止再次访问找不到,但又需要把他们先腾出去,就需要swap分区来弄

做俩实验:

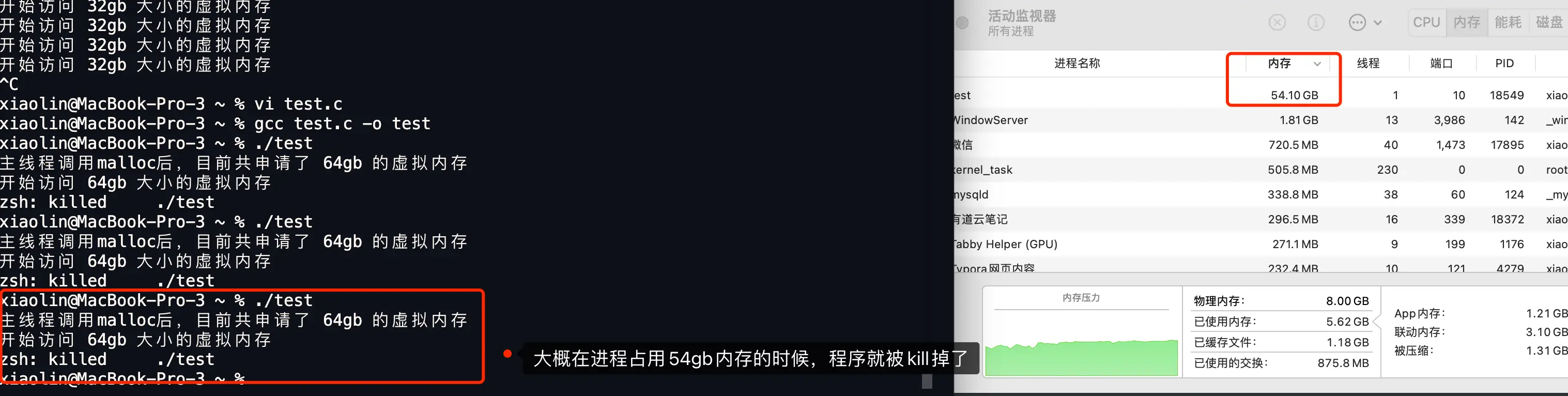

实验一:没开swap

64位操作系统,2GB物理内存,没swap分区

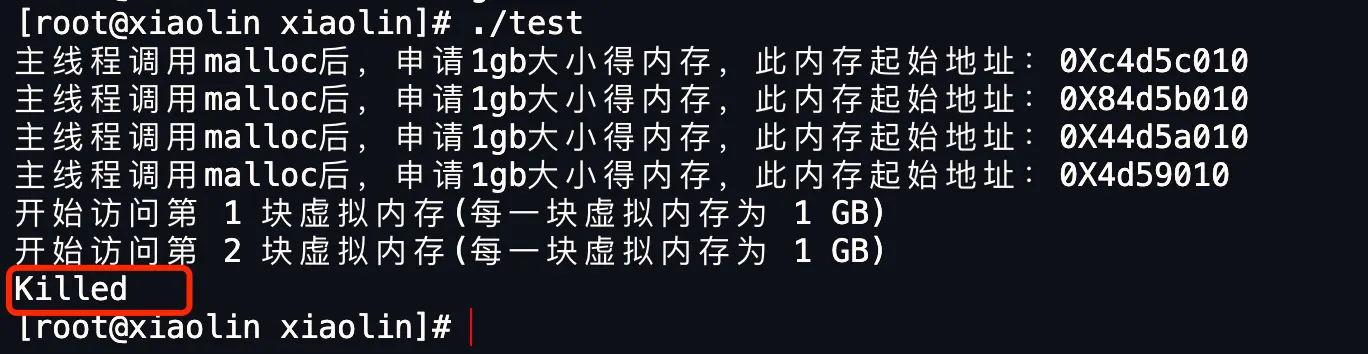

把之前的代码做改动,通过memset访问这个虚拟内存

之前我只知道,

int a[10];

memset(a, 0, sizeof(a));sizeof(a)memset本质是将 a[0] 到 a[9] 每个 int 元素的每个字节(4 字节,32 位)都填充为 0,最终实现所有元素值为 0。

a 是数组首地址,指向 10 个连续的 int 空间,每个 int 通常占 4 字节,共 40 字节,memset 会将这 40 字节全部置零

图里的for(i = 0; i < 4; ++i) { memset(addr[i], 0, MEM_SIZE); } ,memset(addr[i], 0, MEM_SIZE) 每次只能操作一个指针(如 addr[i])指向的 1GB 内存。通过 for 循环,依次对这 4 个独立的 1GB 内存块进行清零操作

有点二维数组的意思,但二维数组的元素在内存中是连续存储的,而这里 addr 的每个元素(指针)指向的内存块是独立分配、互不连续的,必须通过循环逐个处理

运行结果

在访问第二块虚拟内存,超了实际物理内存,进程test被系统杀掉了

通过查看 message 系统日志,可以发现该进程是被操作系统 OOM killer 机制杀掉了,日志里报错了 Out of memory,也就是发生 OOM(内存溢出错误)

至此感觉之前刷题懂了一些各种控制台报错

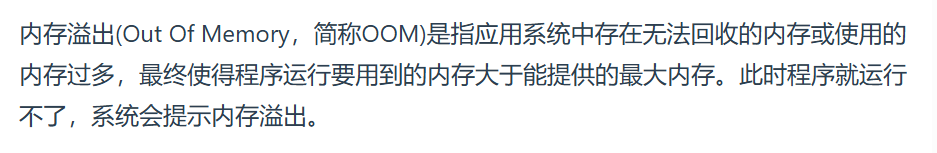

OOM

OOM(Out Of Memory)本身指内存溢出状态描述,即程序运行所需内存超过系统能提供的最大内存。发生 OOM 时,为避免系统崩溃,内核会触发 OOM Killer(内存溢出杀手)机制,这是系统对OOM的保护手段,选择性地杀掉占用内存多或关键程度低的进程来释放内存,以恢复系统稳定

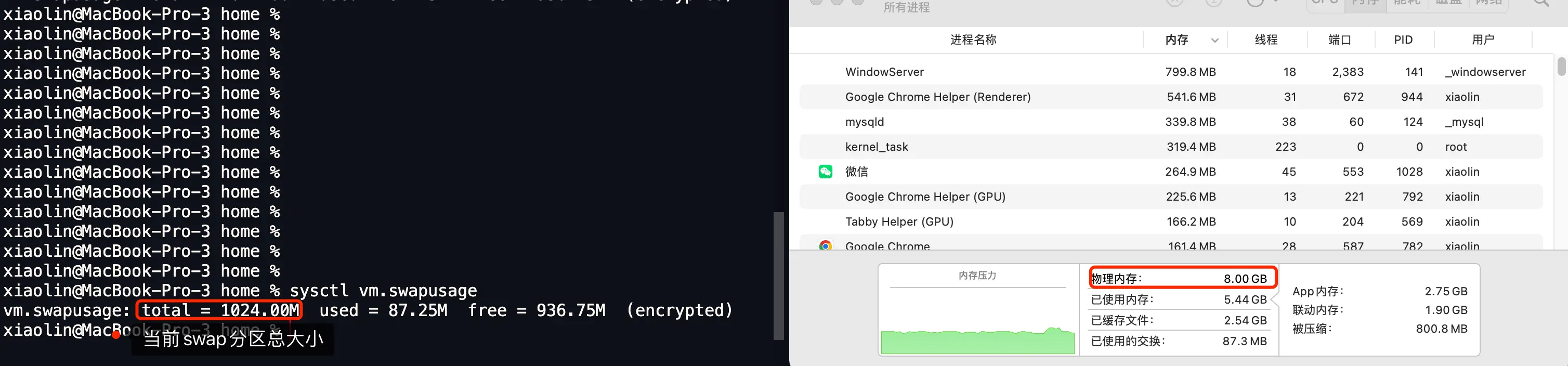

实验二:开了swap

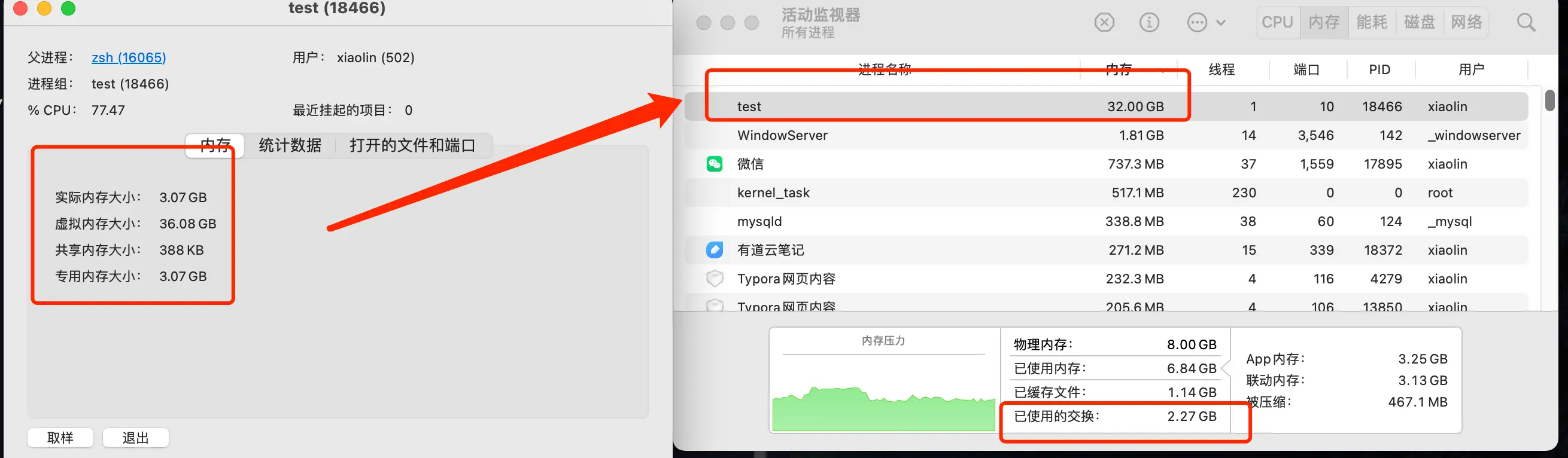

小林是mac book pro,64位操作系统,物理内存8GB

他swap分区没使用时候大小是0

使用了大小会增加支1GB

超过1GB,会增加到2GB,如此往复,这是macos

Linux分区固定,不会跟据使用情况自动增长

那现在改动代码,物理内存8GB,分配32GB虚拟内存后,whlie循环访问虚拟内存

运行结果:

发现即使8GB物理内存,申请并使用 32 GB 内存是没问题,程序正常运行,没OOM

进程内存显示32GB,这里不是物理内存,是已被访问过的虚拟内存大小,

只有实际访问某部分虚拟内存时,其对应数据才会被装入物理内存

哪怕换出到swap了,只要待过就算

系统已使用的 Swap 分区达到 2.3 GB。

发现磁盘IO也到了峰值

有了 Swap 分区,是不是意味着进程可以使用的内存是无上限的?

改成申请64GB内存时,进程申请完64GB虚拟内存,使用到 56GB 就 kill 掉了

当系统多次尝试回收内存,还是无法满足所需使用的内存大小,进程就会被系统 kill 掉了,意味着发生了OOM

对于这56GB的分析(整体梳理):

这个梳理起源于我一直认为,虽然有swap、虚拟内存的概念,但我觉得假设都访问的话,不管咋替换,56GB的数据就要实实在在的存起来,那swap+物理内存就要等于56GB,可为何这里8GB物理内存之外,swap才那么点,就算所谓的换出去,那换哪去了??下次要用的时候去哪找?

1.文件页(数据有磁盘原始备份,如程序文件、共享库、普通文件数据)

- 在物理内存中时:数据从磁盘加载到内存,内存中是磁盘数据的 “副本”。

- 换出时:直接从内存删除(无需存 Swap),因为磁盘上有原始数据。后续访问时,直接从磁盘重新读入内存,Swap 不参与。

- 核心:这类数据的 “最终来源” 是磁盘,不是 Swap,因此 不占用 Swap 空间。

2. 匿名页(数据无磁盘原始备份,如进程的堆 / 栈 / 未初始化数据)

- 在物理内存中时:数据是进程运行时动态生成的,磁盘无原始备份。

- 换出时:必须将数据写入 Swap(否则丢失),Swap 成为其临时存储位置。后续访问时,从 Swap 读回内存。

- 核心:这类数据换出时才占用 Swap,且 Swap 空间可被反复利用(旧匿名页换出后,Swap 空间可存新匿名页),无需为全部 56GB 预留空间。

那56GB 虚拟内存如何存储?

- 文件页占大部分(假设 50GB):数据在磁盘上,换出时直接从内存删除,不进 Swap,访问时从磁盘读。

- 匿名页占小部分(假设 6GB):换出时需要 Swap,若 Swap 只有 4GB,系统会动态换入换出(例如:先换出 2GB 旧匿名页到 Swap,再换入 2GB 新匿名页,Swap 空间循环使用)。

最终结论:

-

- 文件页依赖磁盘(非 Swap),换出时不占 Swap;

- 匿名页按需占用 Swap,空间可重复利用,无需存全部数据。

实际访问的 “虚拟内存大小” 由 物理内存 + Swap + 磁盘文件(非 Swap 部分) 共同支撑

磁盘文件是除了swap分区之外的那些存储空间

swap是Linux的概念

windows10的pagefile.sys隐藏文件

我的理解经过豆包肯定:

我理解:文件页数据直接来自磁盘,换出时不占 Swap,因其可从磁盘重新读取,也是磁盘文件的部分,初学者可大致认为:

物理内存、Swap、磁盘非 Swap 部分共同支撑虚拟内存访问,但这并非严格等式关系,只是从数据来源角度的简化理解,实际是通过复杂的内存管理机制(如映射、换入换出)动态支撑,而非简单 “相加”

扯了半天虚拟内存起的名字这么玄乎,其实无非就是把物理内存外,又把磁盘空间也算上了

物理内存+swap是访问匿名用的,磁盘文件是文件页用的 他们在访问的时候倒腾来倒腾去

虚拟内存是抽象的地址空间概念,通过 “映射” 机制让程序感知到连续的大内存。但虚拟内存管理涉及映射、分页、换入换出等复杂机制,并非简单将三者 “算在一起”

从数据来源和处理方式看,你的理解有直观的一面,但未触及虚拟内存 “抽象地址空间” 和 “动态映射管理” 的本质,严格来说并不准确

我再次理解经过豆包肯定:

所以我理解,就像扶老奶奶过马路一样,扶过来扶过去又回到了原地,但是走了2倍的马路宽度,这里就类似虚拟内存的概念,没位移但有路程,没占用实际物理内存,但虚拟内存却占用了,反过来说更好理解这个事,也就是说看似虚拟内存占用,但其实没占用物理内存

比如物理内存就1GB,swap就1GB:

如果都是匿名页,先访问1GB存入物理内存,再访问就把这1GB换到swap,这时候,物理内存可以再访问1GB。那至此访问了2GB,再访问无空间换出,就会受限。但如果访问的是相同数据,就可以直接从swap里拿数据到物理内存

如果都是文件页,假设A进程先访问1GB存入物理内存,B再访问就得把这1GB换出到磁盘,这时候,物理内存可以再访问1GB那么B进程就可以访问了。那至此访问了2GB。假设C进程再想访问同样内容,那么再把物理内存上的这1GB换出到磁盘,然后正式开始C进程的访问,即从磁盘载体中的读进来

发现,这里总共就是访问那1GB的东西,换来换去,但实际上已经访问了3GB了,为了理解虚拟内存换入换出机制,说一个不严谨但易于理解的总结就是,哪怕物理内存就1GB,swap就1GB,但如果只是访问文件页,可以访问无数次,夸张点100亿个T都行,因为只是次数,但系统资源(如磁盘 I/O、内存管理开销等)是有限的,大量文件页频繁换入换出会导致性能问题,所以只是一个比方,且系统对文件页也有缓存策略(如页缓存)并非每次都完全从磁盘读取,

总结:

PS:豆包下面的喇叭朗读真好听

太扯了,4.5(涉及到redis和mysql)/4.6/4.7略过太深了

进程管理(小林里没用的智障废话真鸡巴多)

豆包追问链接同

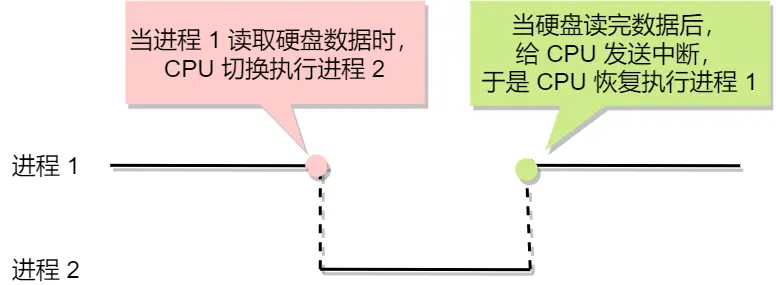

进程从硬盘读取数据,CPU不需要阻塞等待数据的返回,做其他的事,等硬盘数据返回了,CPU收到中断

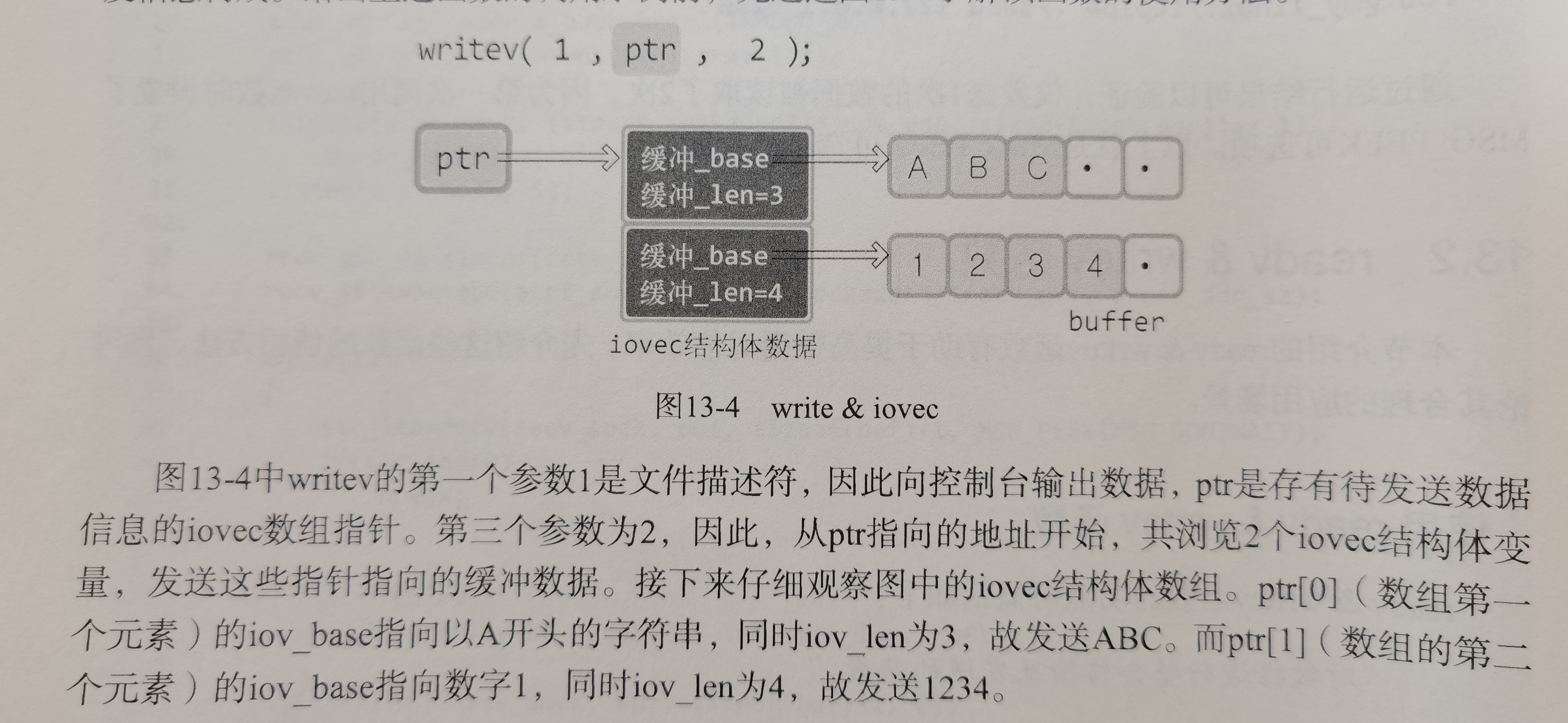

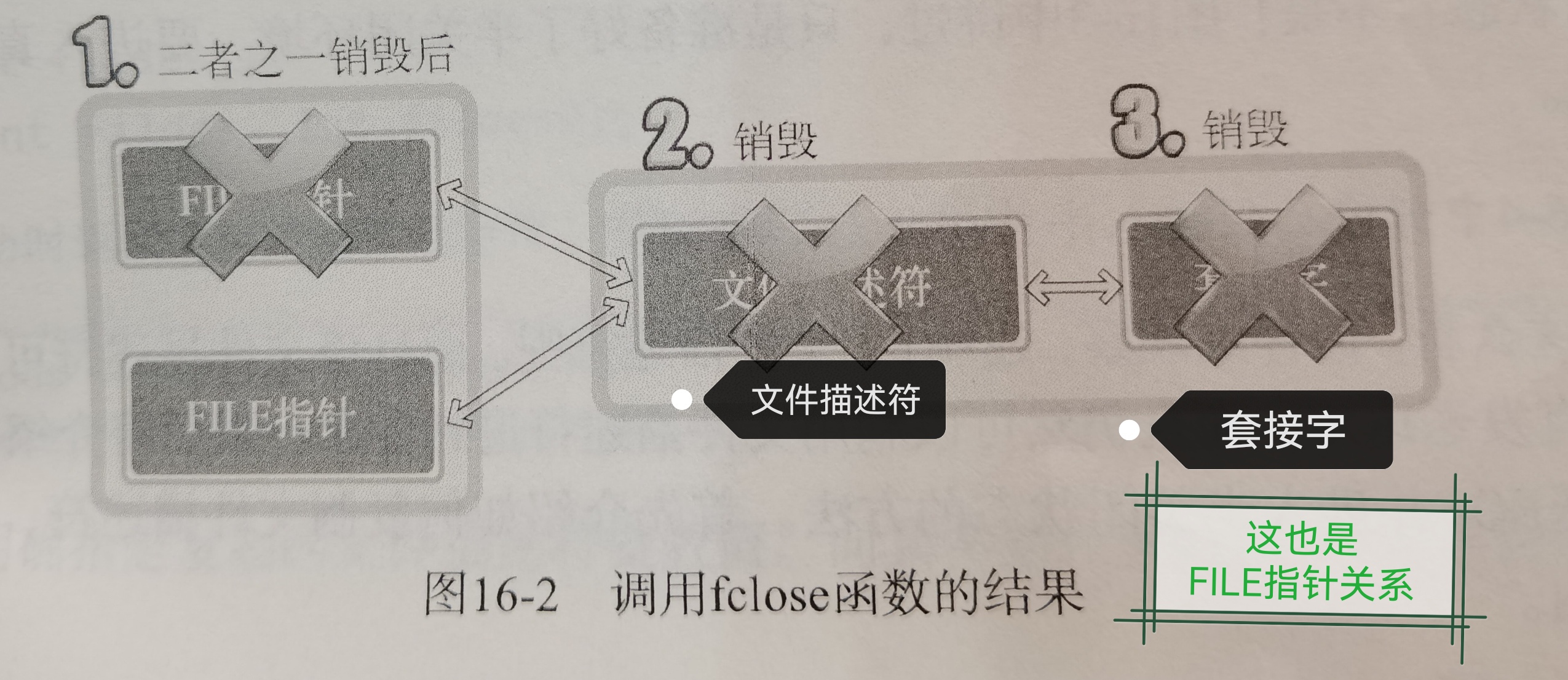

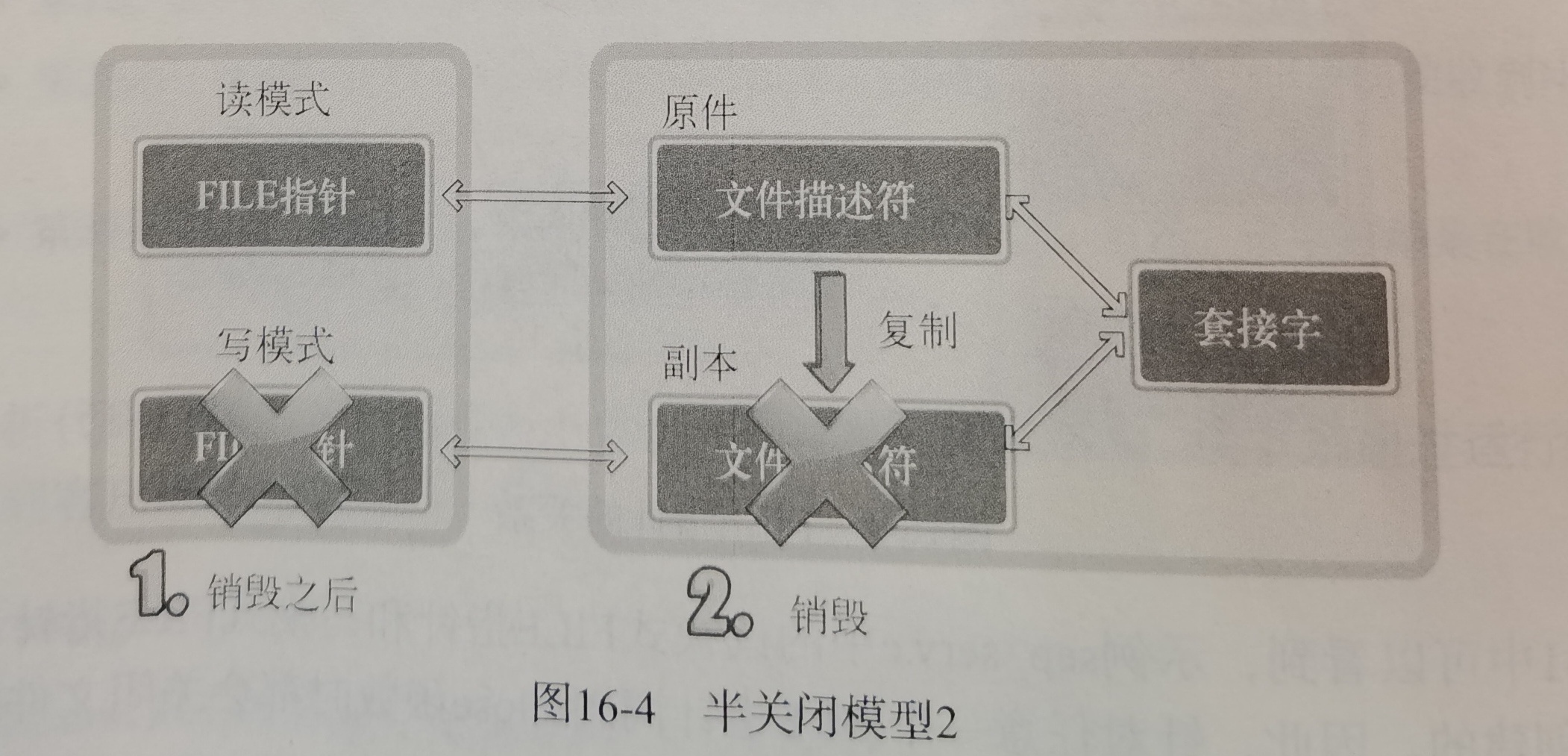

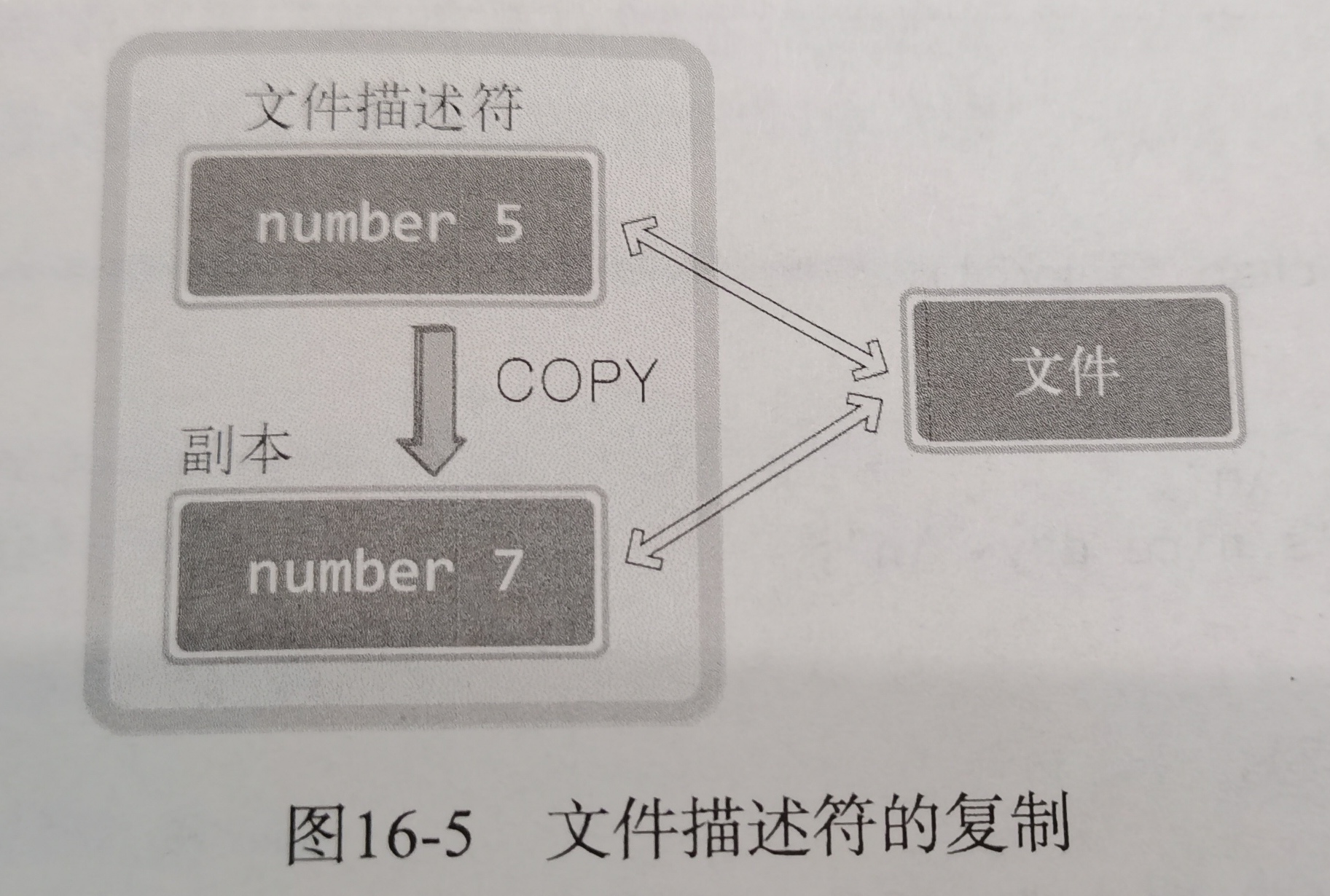

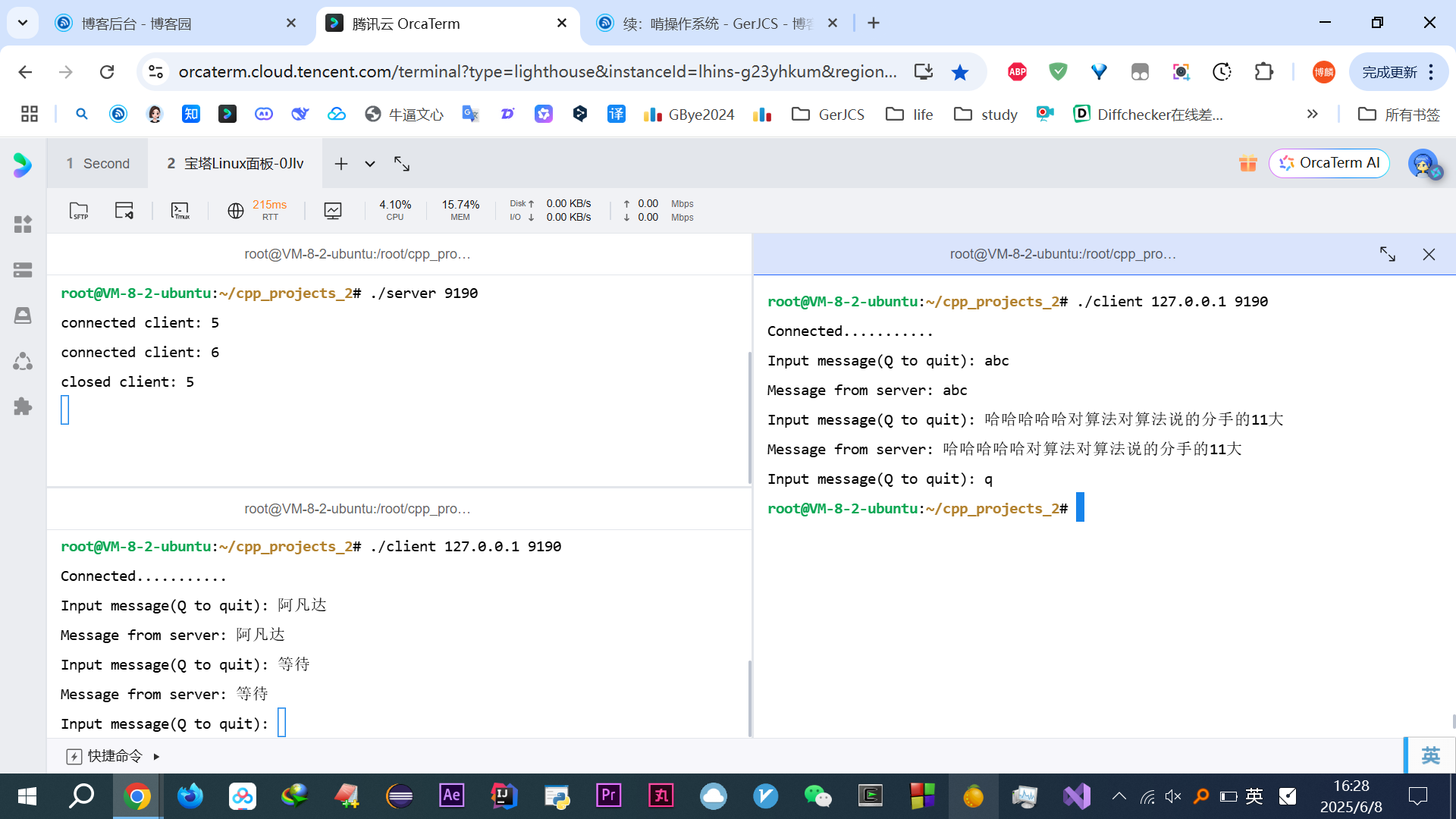

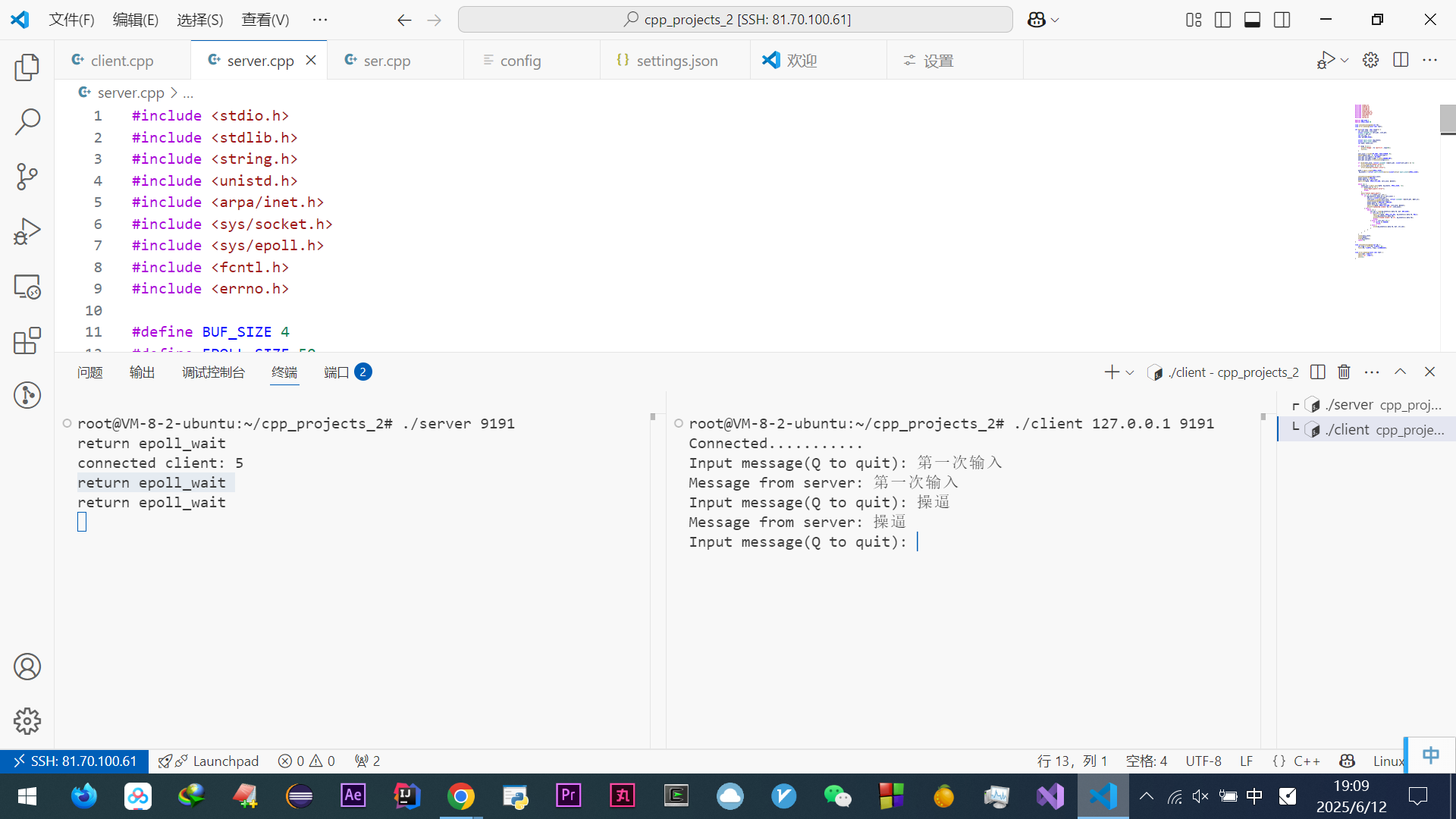

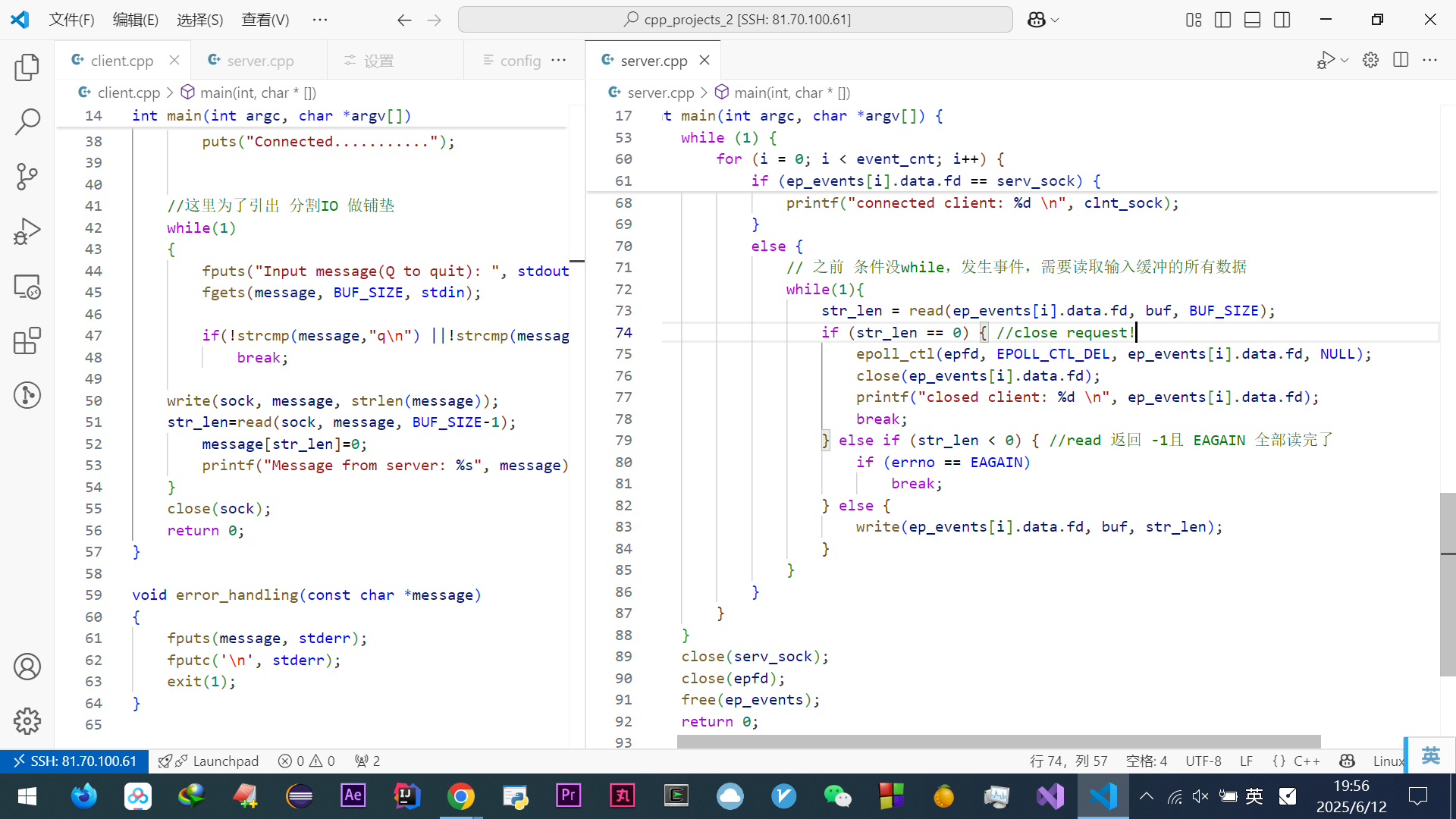

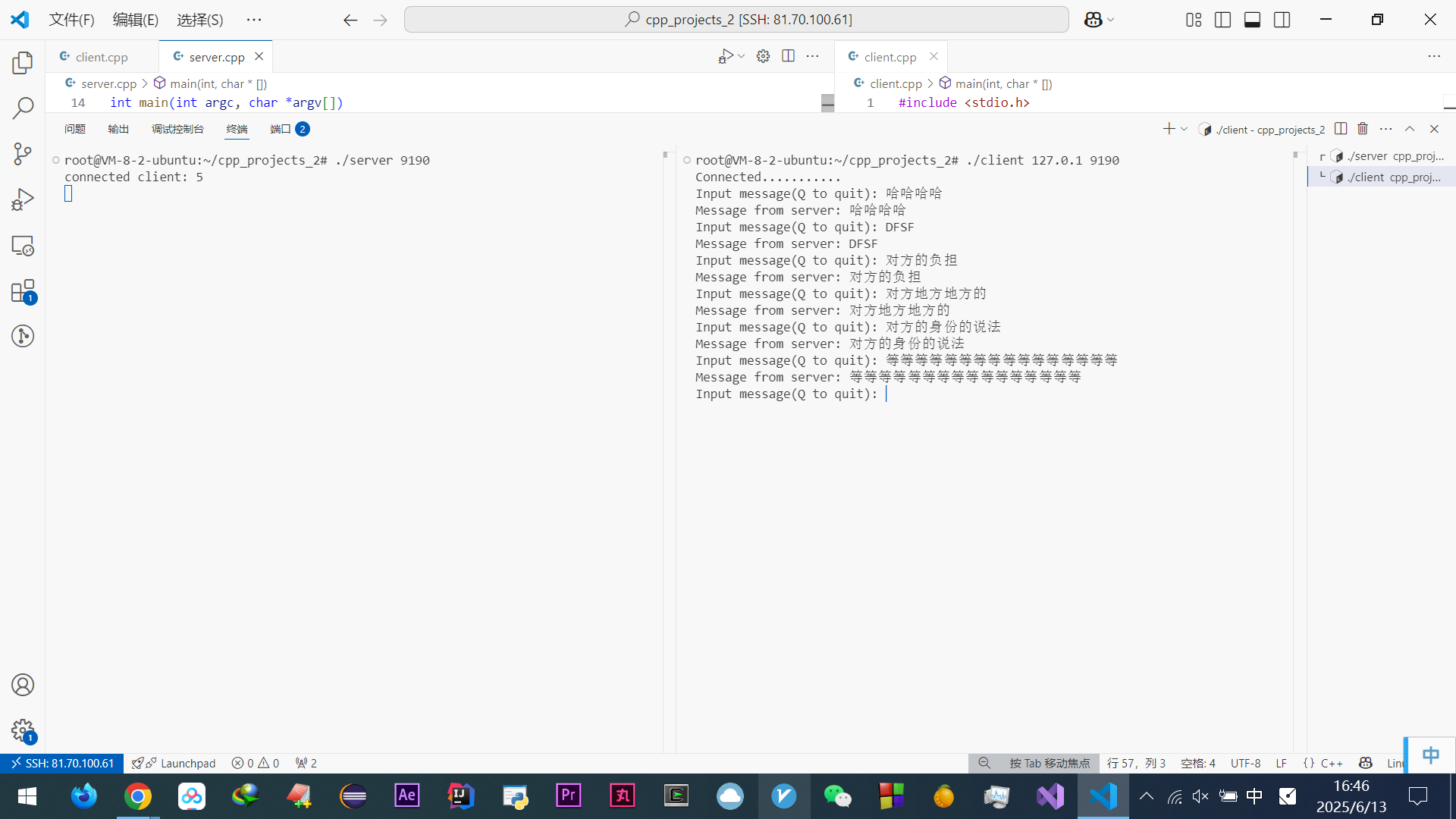

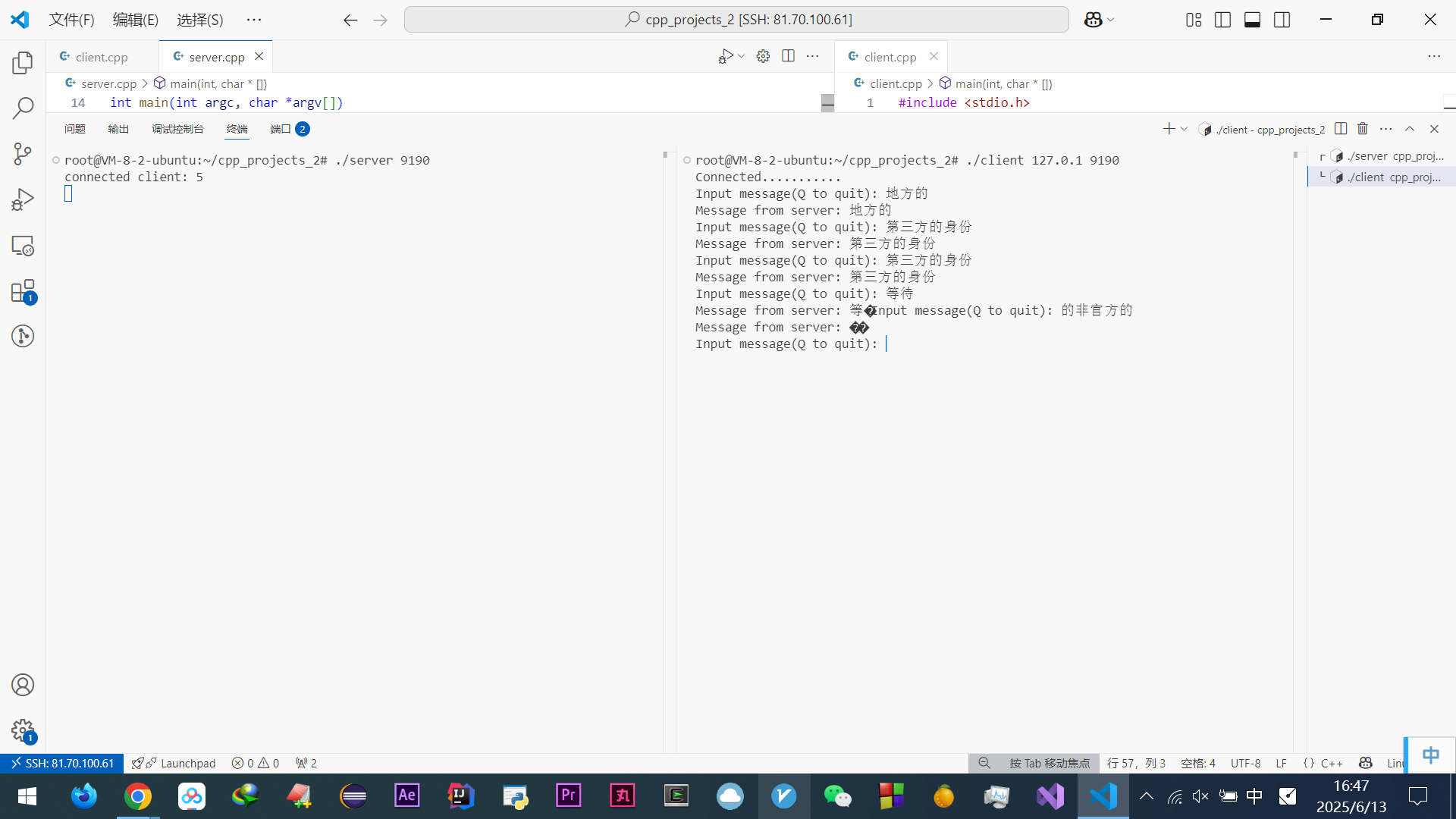

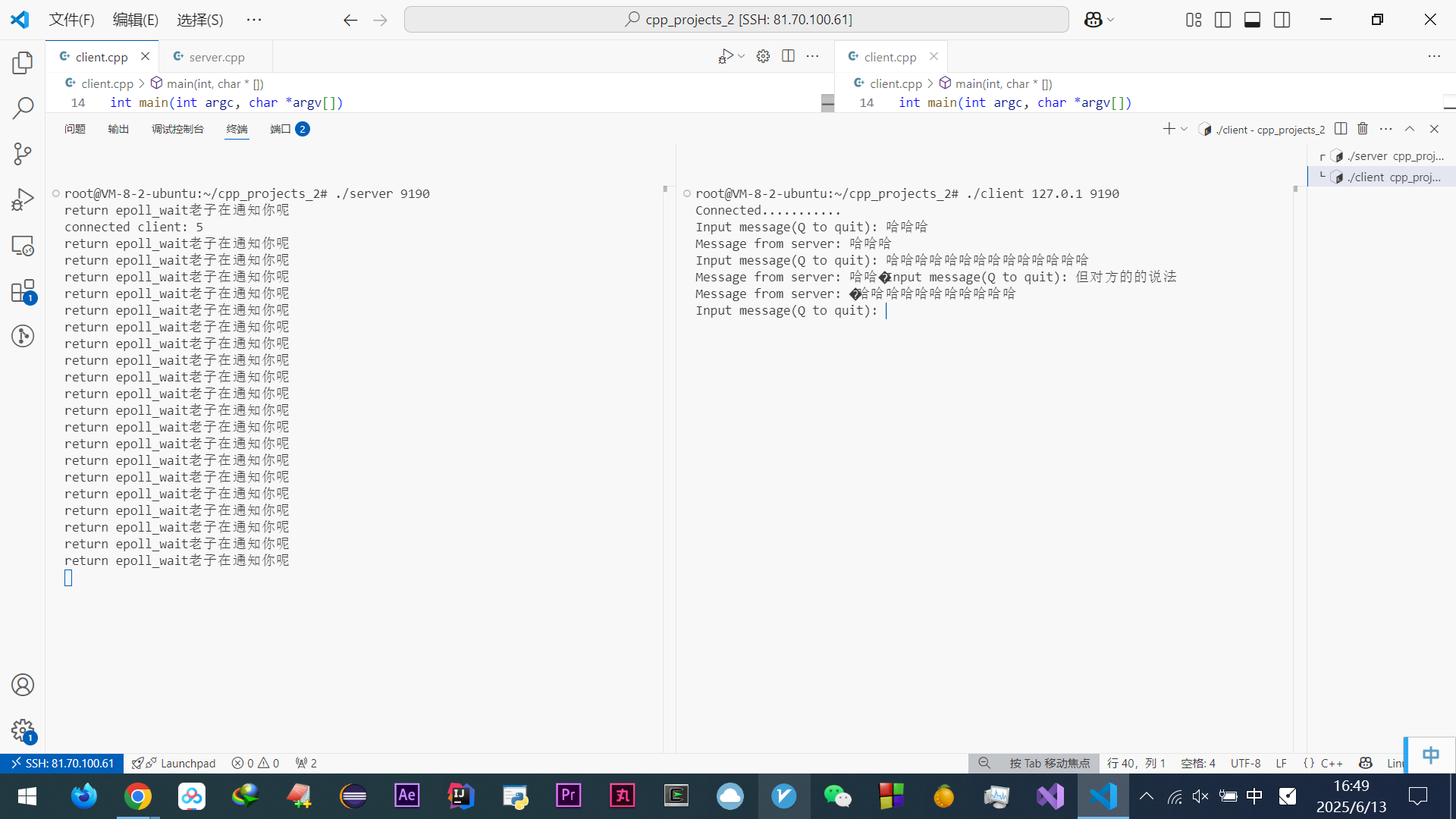

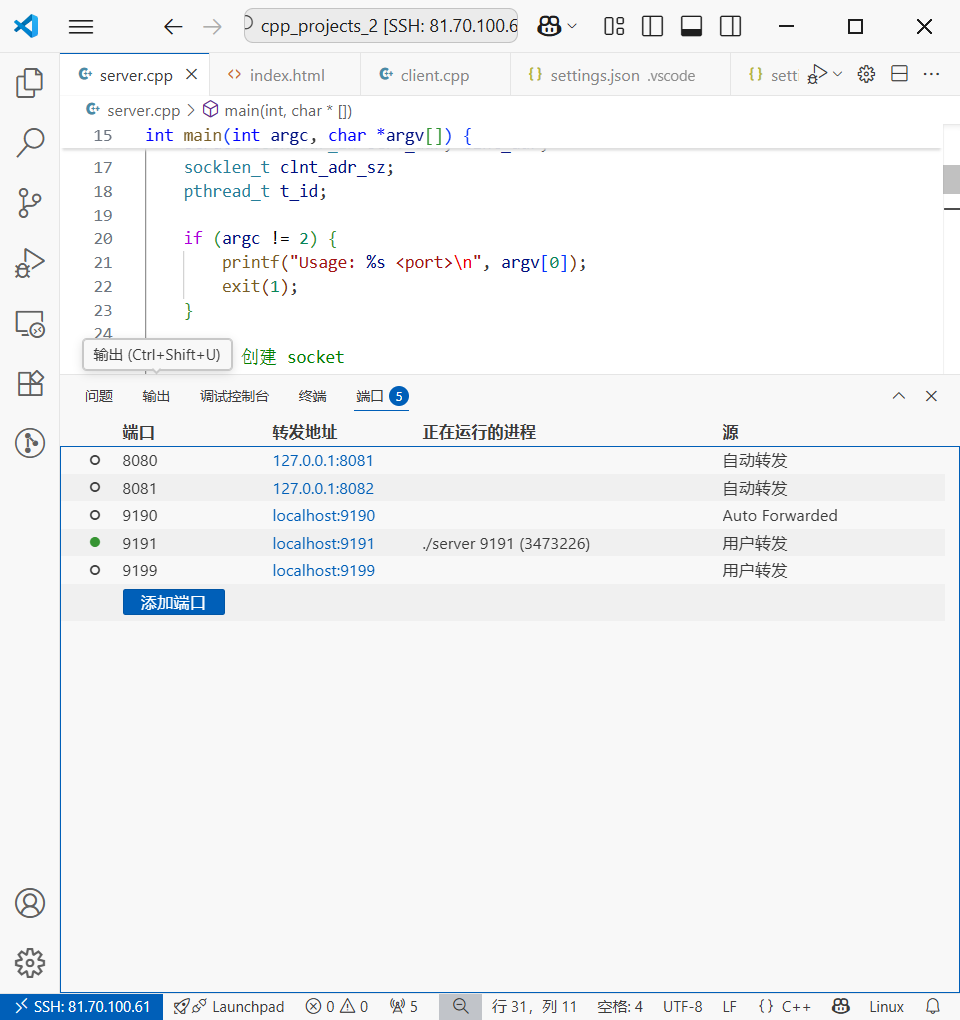

啃完尹圣雨TCPIP网络编程很多都会了

(好他妈烦他文章里的这些傻逼比喻啊~~~~(>_<)~~~~)

-

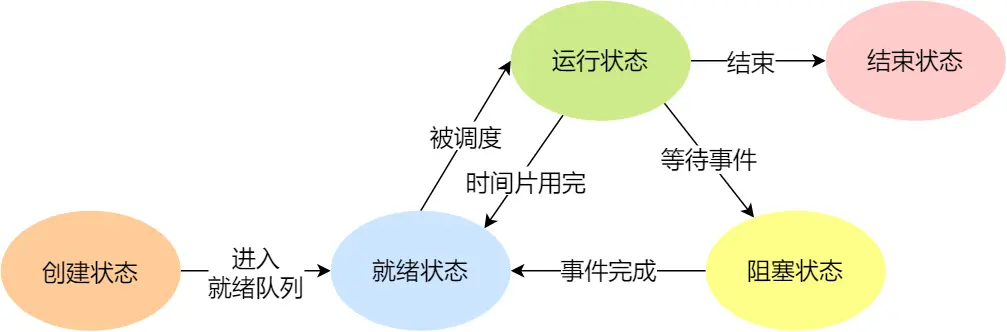

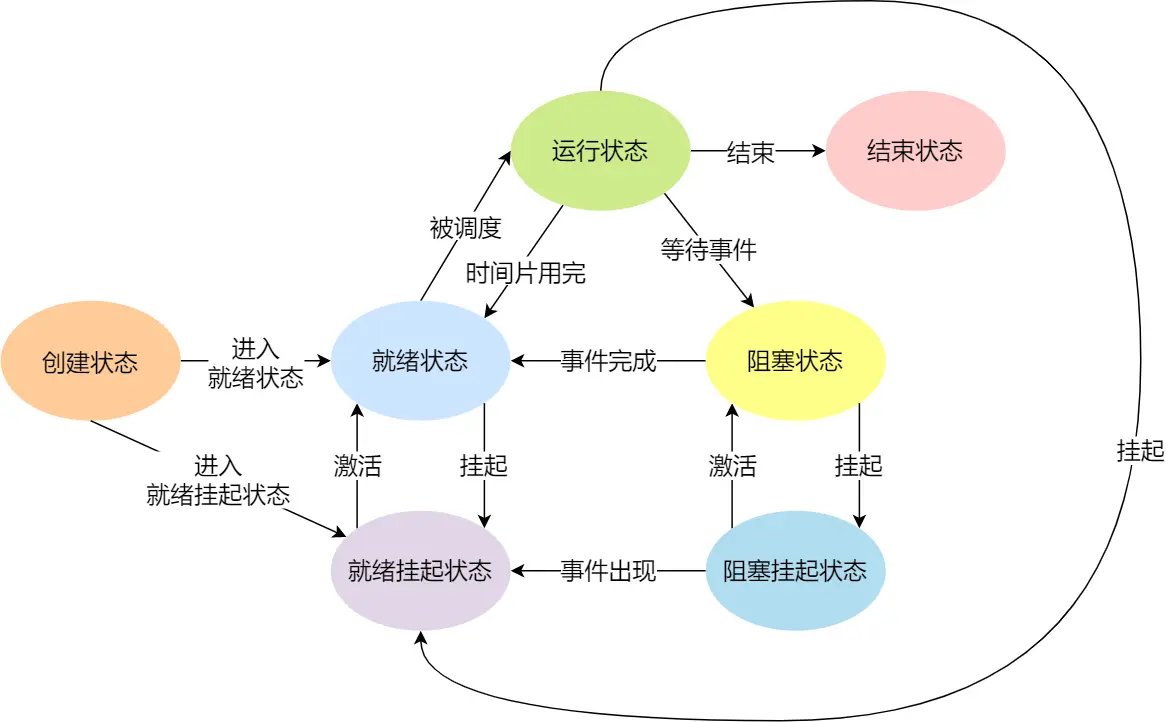

NULL -> 创建状态:一个新进程被创建时的第一个状态;

-

创建状态 -> 就绪状态:当进程被创建完成并初始化后,一切就绪准备运行时,变为就绪状态,这个过程是很快的

-

就绪态 -> 运行状态:处于就绪状态的进程被操作系统的进程调度器选中后,就分配给CPU正式运行该进程

-

运行状态 -> 结束状态:当进程已经运行完成或出错时,会被操作系统作结束状态处理

-

运行状态 -> 就绪状态:处于运行状态的进程在运行过程中,由于分配给它的运行时间片用完,操作系统会把该进程变为就绪态,接着从就绪态选中另外一个进程运行

-

运行状态 -> 阻塞状态:当进程请求某个事件且必须等待时,例如请求 I/O 事件

-

阻塞状态 -> 就绪状态:当进程要等待的事件完成时,它从阻塞状态变到就绪状态

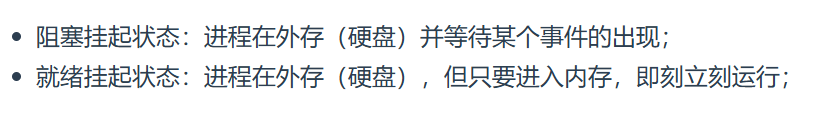

阻塞态是等待某事件返回,会占用物理内存空间,会换出到硬盘

内存不足会等到资源满足才可以进行,也会挂起

这时候,就用 挂起状态 表示换到磁盘上没占用内存空间的数据

挂起分两类:

开始逐渐深入了

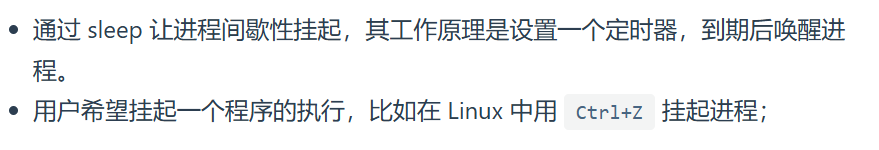

除了进程所使用的内存空间不在物理内存,还有俩情况是挂起:

扩大状态图:7种

进程的控制结构:

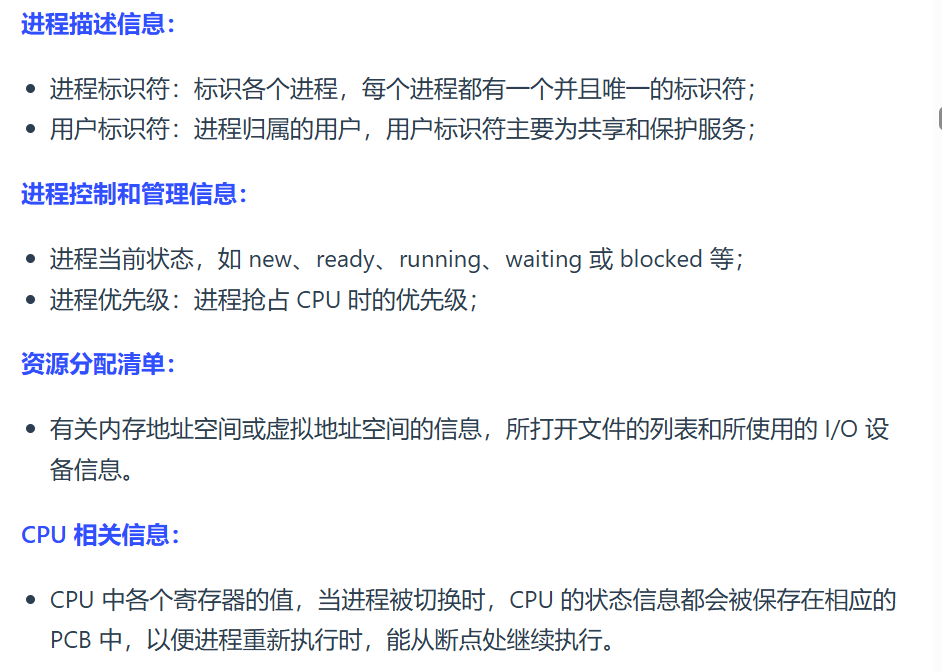

PCB(进程控制块):PCB 是操作系统用于管理进程的一种数据结构,操作系统通过PCB对进程进行控制和管理,调度程序根据PCB中的信息决定哪个进程的各种相关信息,是进程存在的唯一标志

PID(进程标识符):PID 是 PCB 的一部分,是 PCB 中用于唯一标识进程的一个字段。当操作系统创建一个新进程时,会为其分配一个唯一的 PID,并在相应的 PCB 中记录该 PID 以及其他与进程相关的信息

PCB包含:

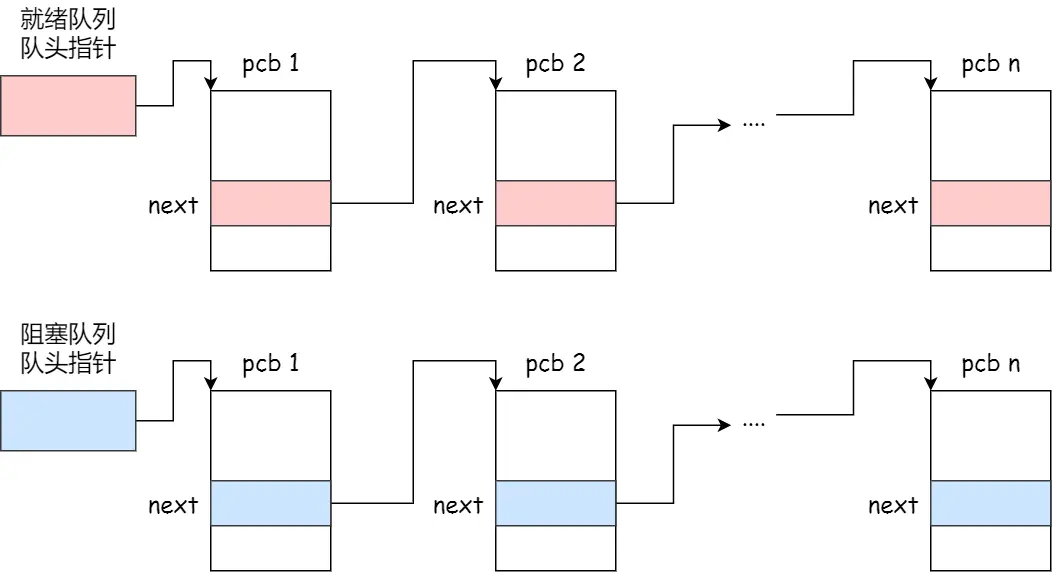

PCB咋组织进程的?

链表,把具有相同状态的进程链在一起,组成各种队列(就绪队列、阻塞队列)

运行队列在单核CPU系统中则只有一个运行指针,因为某一时刻只能运行一个程序

除了链表还有索引方式:

将同一状态的进程组织在一个索引表中,索引表项指向相应的 PCB,不同状态对应不同的索引表

进程的控制:

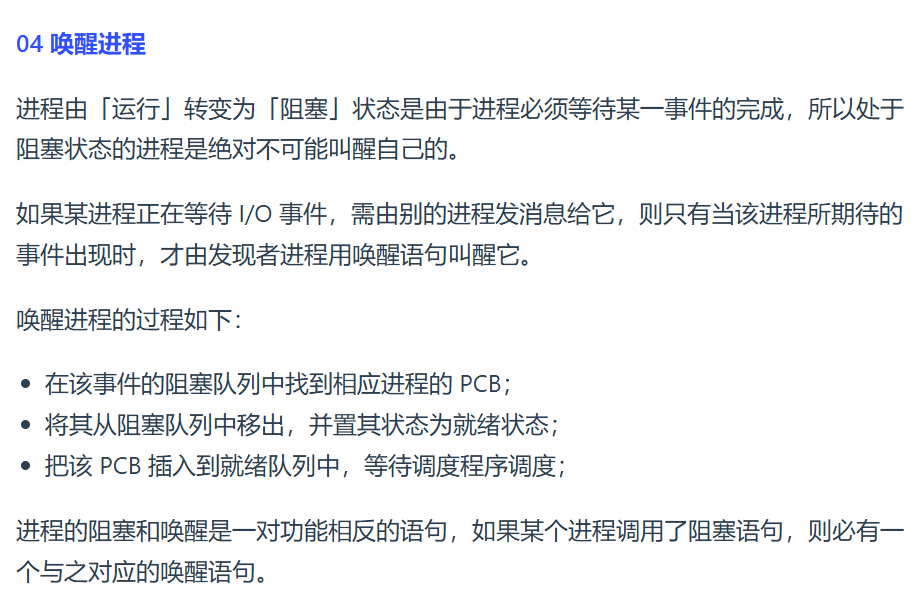

即进程的创建、终止、阻塞、唤醒的过程(勘误)

03 阻塞进程

03 阻塞进程

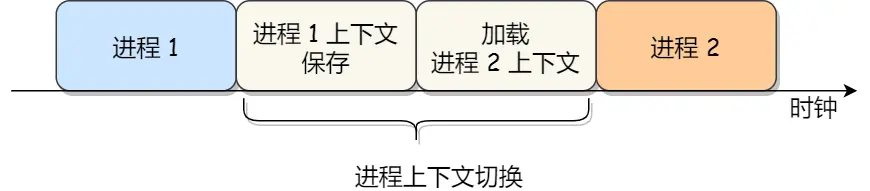

进程上下文切换

os帮CPU设置 CPU 寄存器 & 程序计数器

CPU寄存器:CPU内部小容量极快速的内存(缓存)

程序计数器:用来存储CPU正在执行、即将执行的下一条的指令位置

这俩是任何任务运行前,必须依赖的环境,即 CPU上下文

CPU上下文切换就是把前一个任务的CPU的上下文( CPU 寄存器 & 程序计数器 )存起来,加载新任务的上下文到新任务是寄存器和程序计数,再跳转到新任务的程序计数器所指的新位置,运行新任务

上下文信息都是由系统内核负责存储和管理的,当此任务再次被分配给 CPU 运行时,CPU会重新加载这些上下文,这样就能保证任务原来的状态不受影响,让任务看起来还是继续运行的

以上说的任务,是进程、线程、中断,所以,CPU 上下文切换分成:

进程上下文切换、线程上下文切换、中断上下文切换

关于中断的切换

我问豆包:

为啥会有中断上下文切换?中断不是一次就弄好的吗?

豆包回答:

当一个中断正在处理时,可能会发生另一个更高优先级的中断。此时,系统需要暂停当前中断处理,保存其上下文

再深入,切换的是啥?

进程是由内核管理和调度的,所以进程的切换只能发生在内核态

所以,进程的上下文切换不仅包含了虚拟内存、栈、全局变量等用户空间的资源,还包括了内核堆栈、寄存器等内核空间的资源

总结上下文切换哪些场景?

- 为了进程公平调度,CPU被划分为一段段的时间片,这些时间片再被轮流分配给各个进程当某个进程的时间片耗尽了,进程就从运行状态变为就绪状态。从就绪队列找一个进程执行

- 系统资源不足,被挂起,调度其他运行

- sleep挂起自己,也会重新调度

- 优先级更高的进程要执行,当前进程会挂起

- 硬中断,CPU进程会被挂起,转而执行内核中的中断服务程序

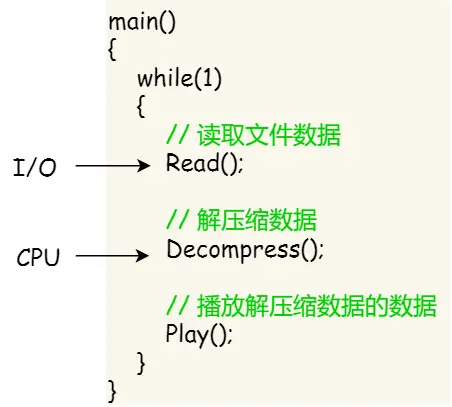

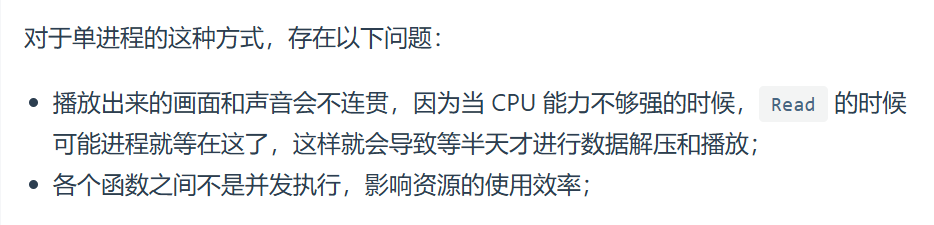

线程:

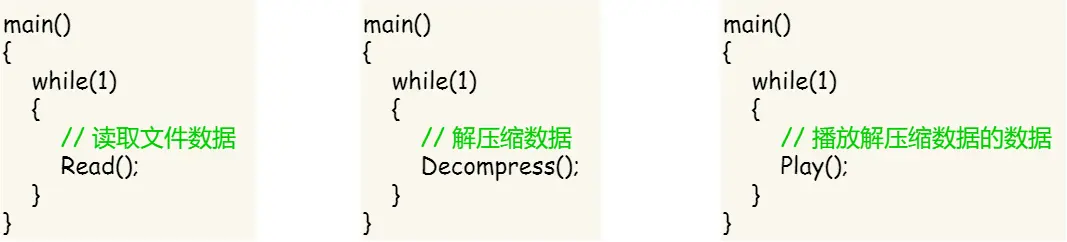

引出理由,假设播放器场景:

如果单进程实现:

存在的问题:

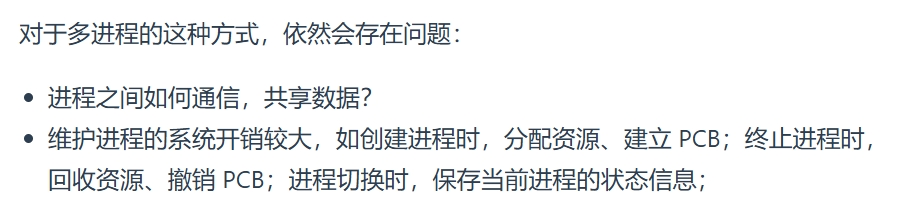

如果多进程实现:

存在的问题:

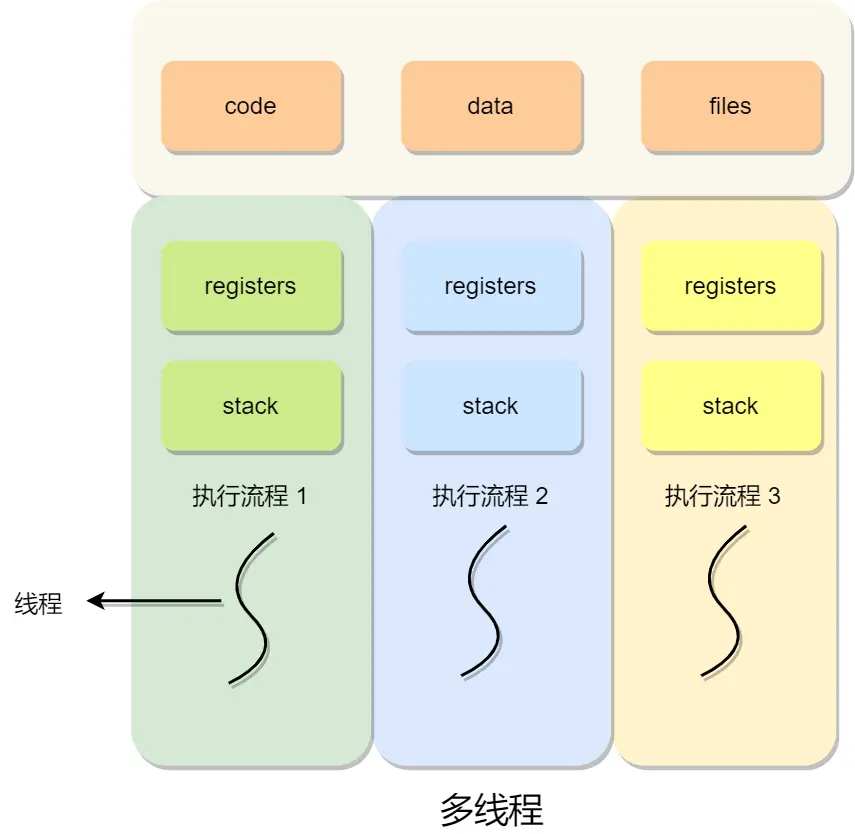

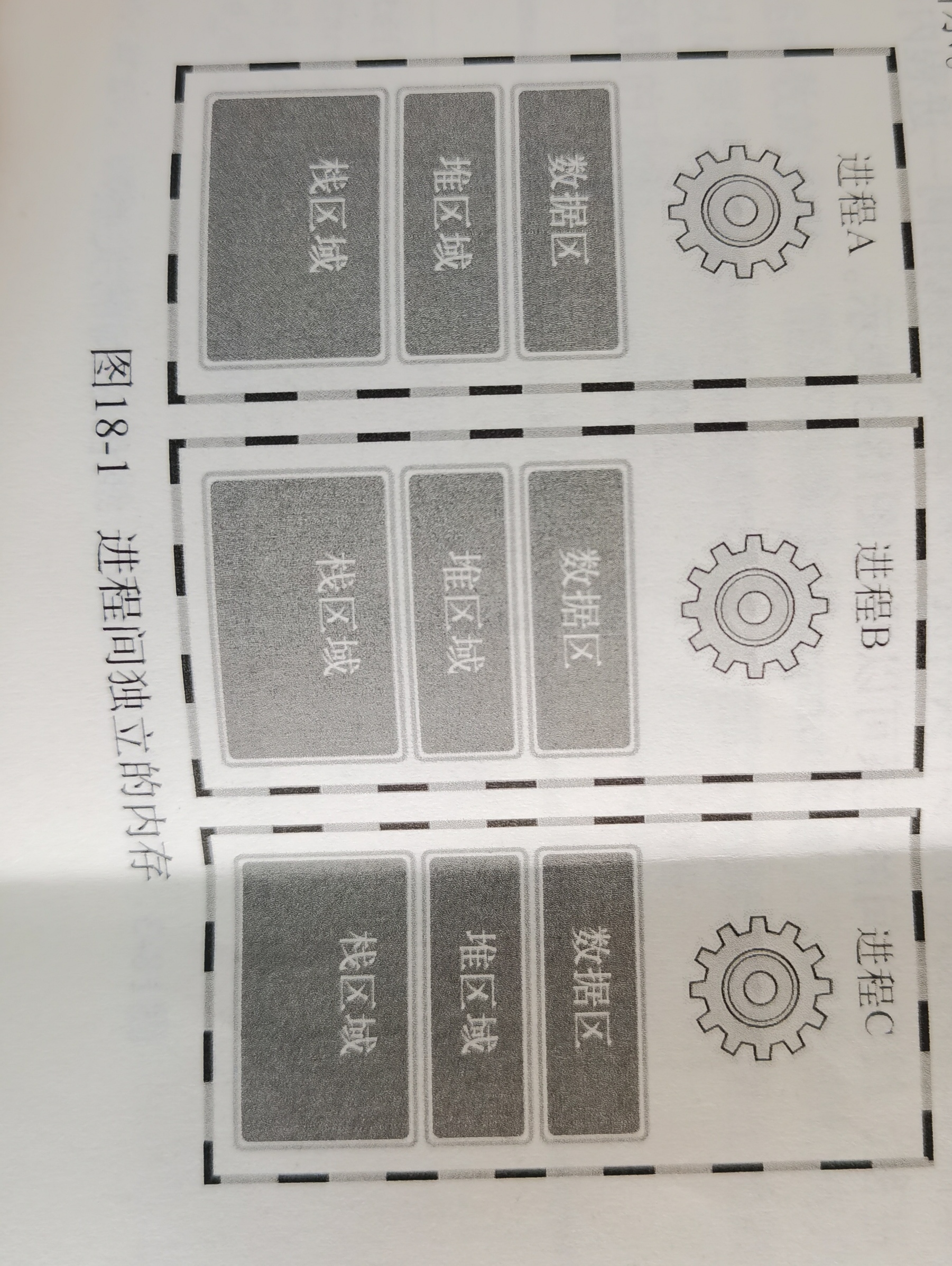

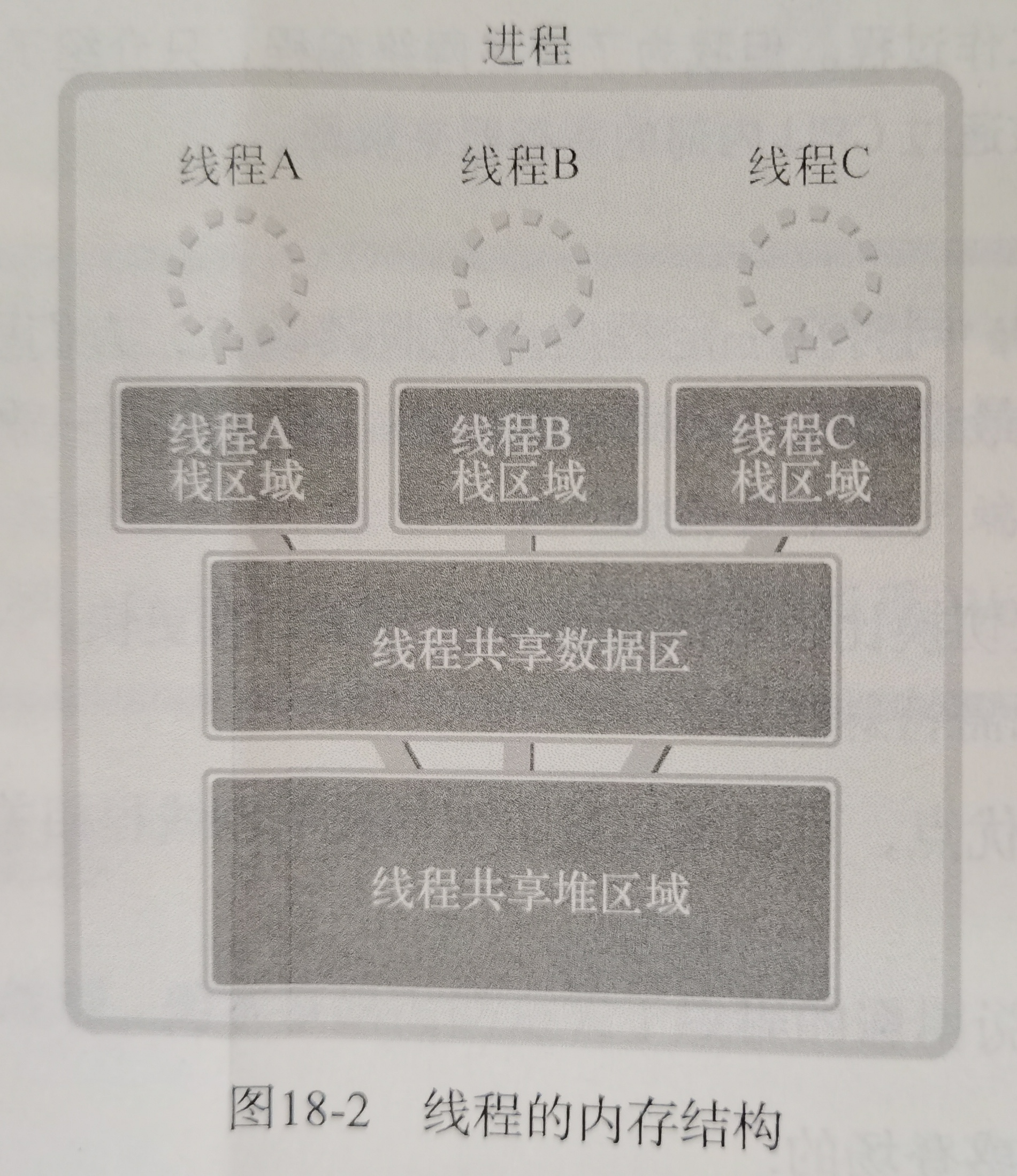

所以引出线程,线程之间可以并发运行且共享相同的地址空间

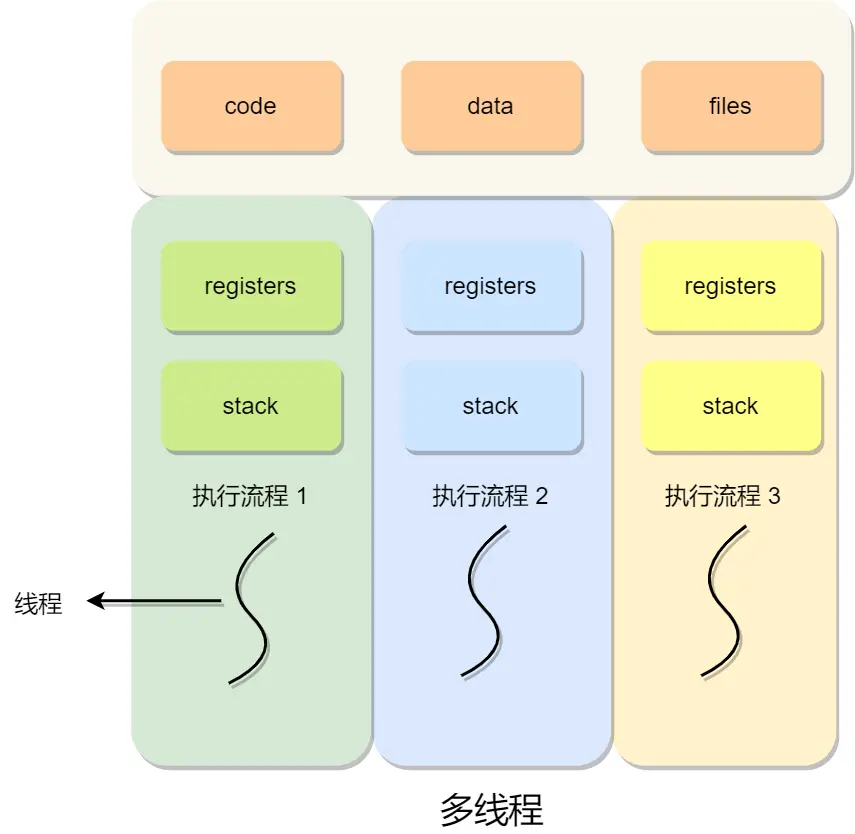

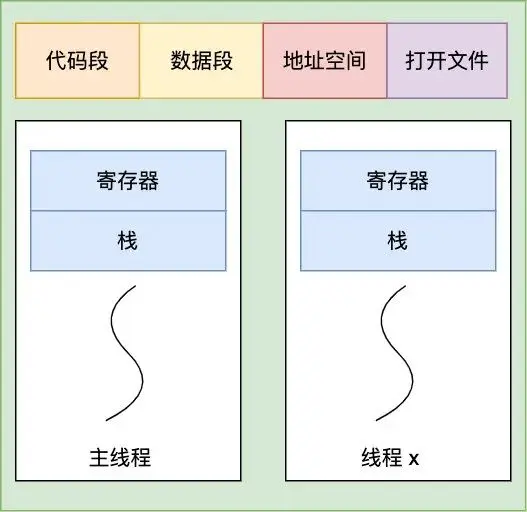

一进程内,多个线程共享代码段、数据段、打开的文件等资源,但每个线程各自都有一套独立的寄存器和栈,这样可以确保线程的控制流是相对独立的

(这种理念我想到了虚拟内存)

线程优点:

线程缺点:

(勘误,他这网站真有这么多人看吗?看的这些人也都是傻逼骗子选手扫一眼?

后悔了刷邝斌且给网上博客找bug改代码、后悔了啃垃圾菜鸟教程、后悔了啃TCPIP网络编程。如今我是不是我又tm看太细了?~~~~(>_<)~~~~)

- 当进程中的一个线程崩溃时,会导致其所属进程的所有线程崩溃(这里是针对C/C++ 语言,Java语言中的线程奔溃不会造成进程崩溃

游戏的用户设计,就不会多线程,否则一个用户挂了,影响其他同一个进程的线程

线程与进程的比较

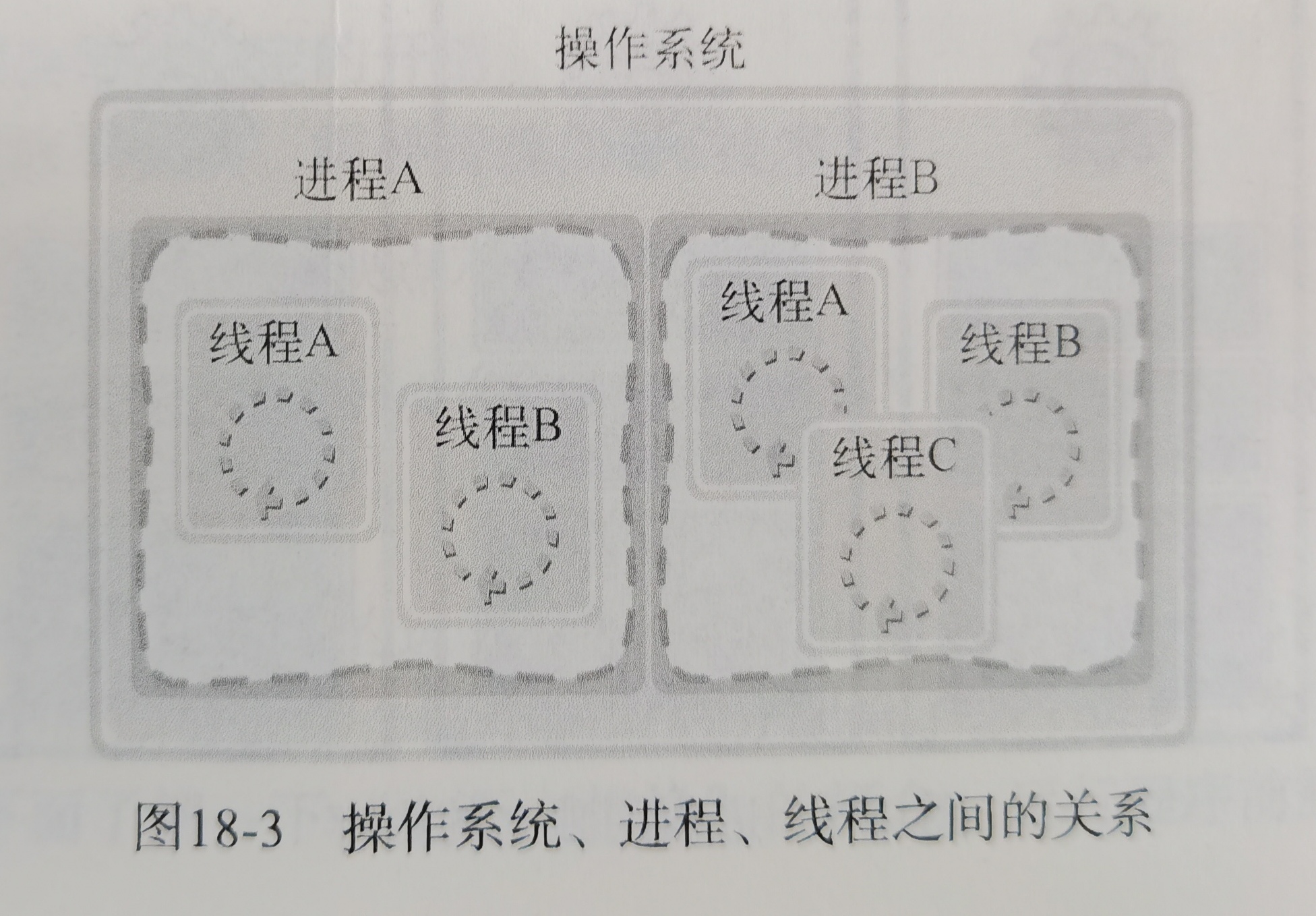

- 进程是资源(包括内存、打开的文件等)分配的单位,线程是 CPU 调度的单位;

- 进程拥有一个完整的资源平台,而线程只独享必不可少的资源,如寄存器和栈;

- 线程同样具有就绪、阻塞、执行三种基本状态,同样具有状态之间的转换关系;

- 线程能减少并发执行的时间开销:因为上下文需要保存恢复的数据的少

- 线程能减少并发执行的空间开销:因为共享内存空间

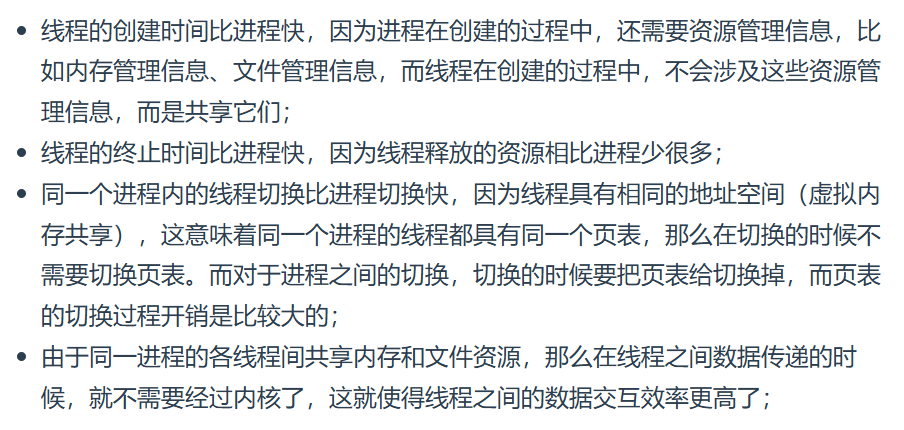

具体来说,开销少:

综上:

进程只是给线程提供了虚拟内存、全局变量等资源,操作系统的任务调度,实际上的调度对象是线程

- 当进程只有一个线程时,可以认为进程就等于线程

- 当进程拥有多个线程时,这些线程会共享相同的虚拟内存和全局变量等资源,这些资源在上下文切换时是不需要修改的,但线程自己的私有数据,比如栈和寄存器等,这些在上下文切换时也是需要保存

- 当两个线程不是属于同一个进程,则切换的过程就跟进程上下文切换一样

- 当两个线程是属于同一个进程,因为虚拟内存是共享的,所以在切换时,虚拟内存这些资源就保持不动,只需要切换线程的私有数据、寄存器等不共享的数据

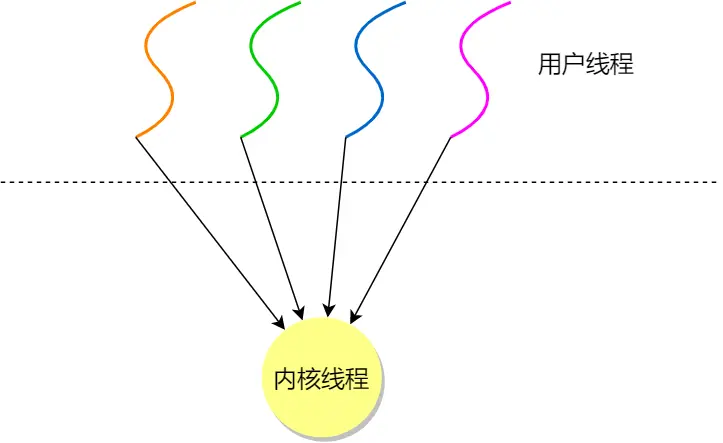

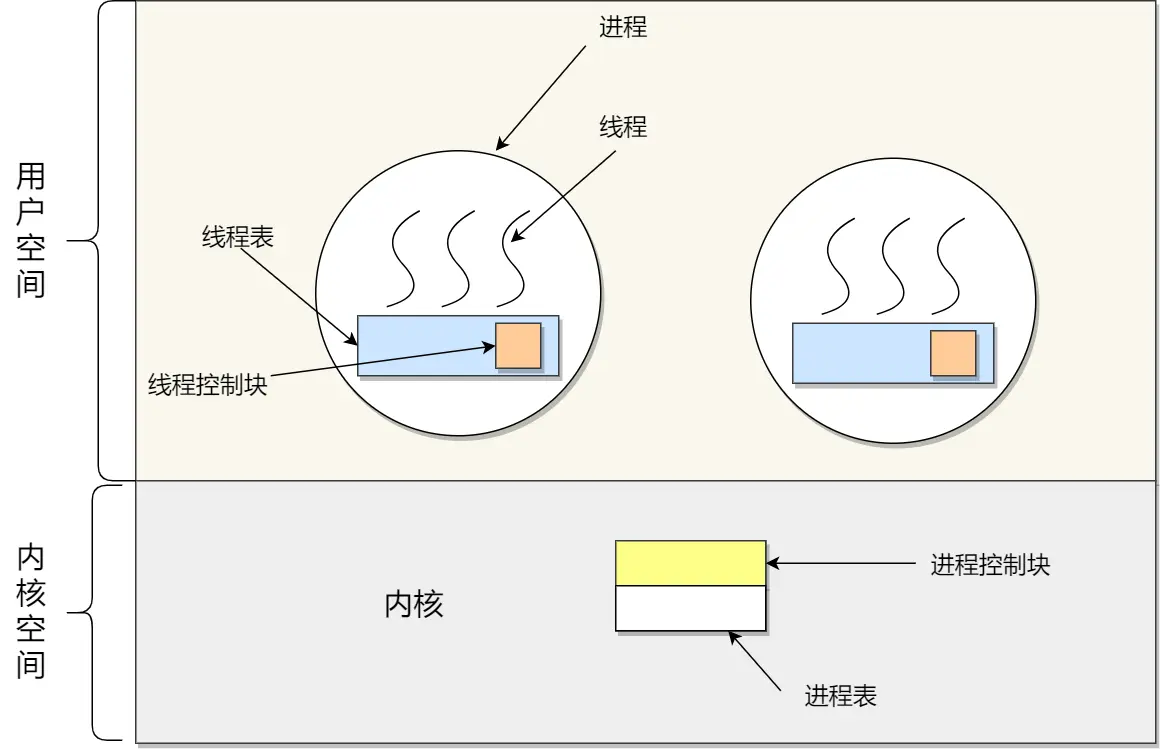

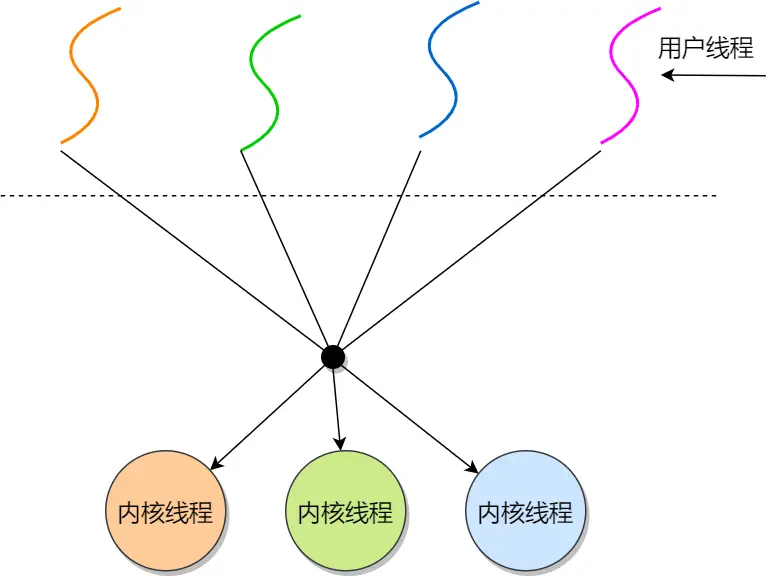

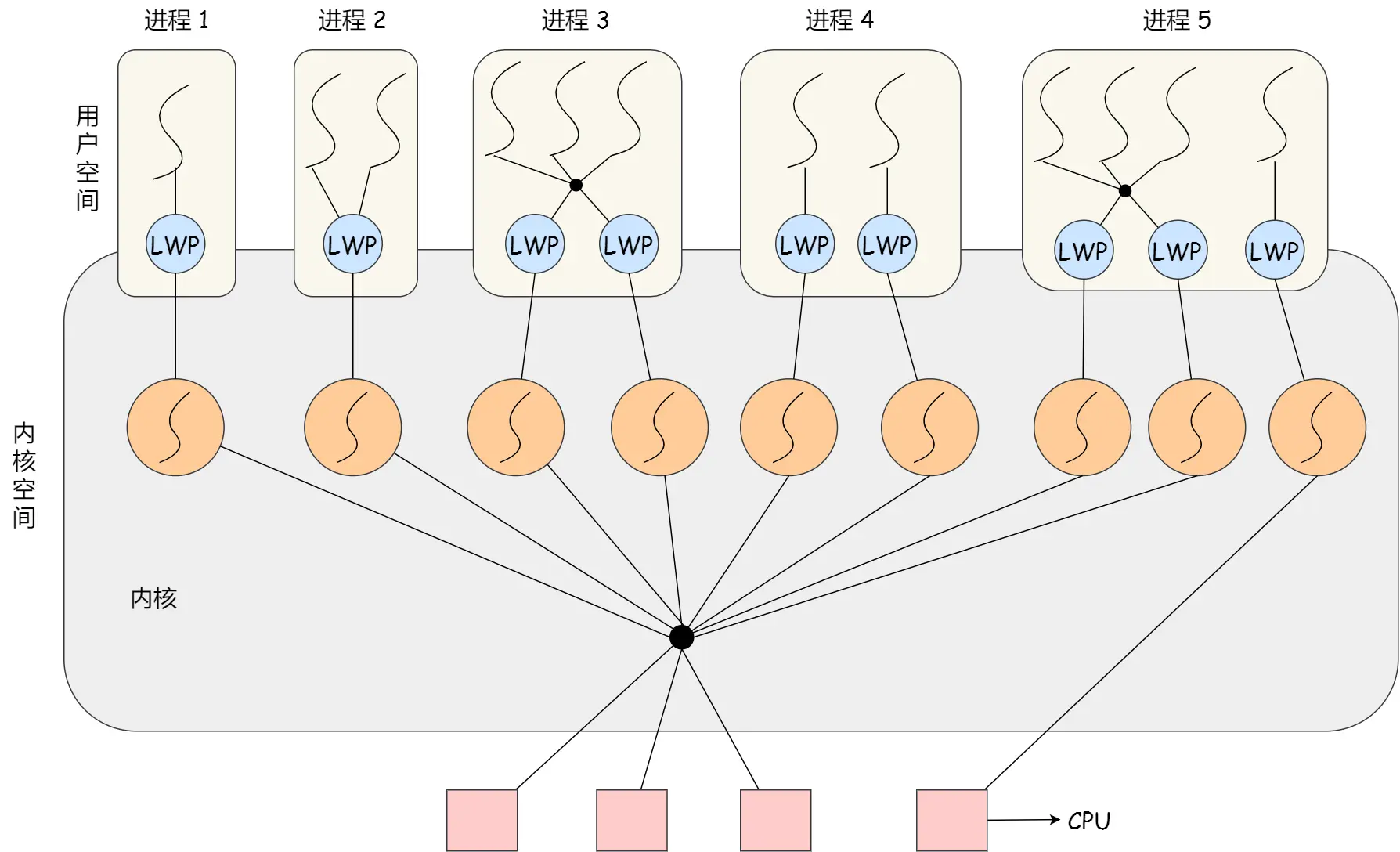

线程的三种实现方式:

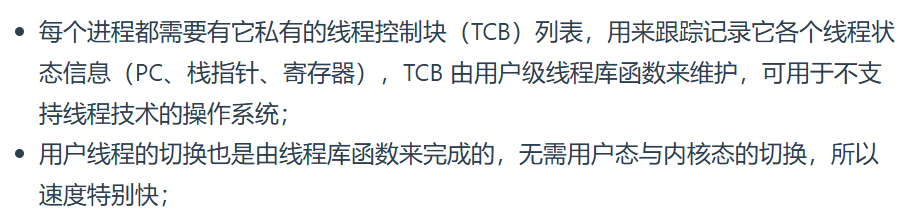

一、用户线程:

由用户态的线程库管理,在用户空间实现,多对一

线程控制块TCB在用户态的线程管理库里实现,os看不到TCB,只能看到PCB

用户线程的整个线程管理和调度,操作系统是不直接参与的,而是由用户级线程库函数来完成线程的管理,包括线程的创建、终止、同步和调度等

用户线程模型:

一个进程有多个线程

- 每个线程对应一个线程控制块TCB,用于记录线程状态、寄存器值等信息,TCB和线程一一对应

- 线程表记录进程中所有线程的相关信息(如线程 ID、线程控制块地址等 ),一个进程就只有一个线程表

优点:

缺点:

二、内核线程:

由内核管理,内核中实现,一对一

内核线程是由操作系统管理的,线程对应的 TCB 自然是放在操作系统里的,这样线程的创建、终止和管理都是由操作系统负责

内核线程模型:小林这傻逼画的很误人子弟,注意:内核线程没有用户空间。用户空间部分展示的是用户线程!

优点:

缺点:

由于在支持内核线程的操作系统中,由内核来维护进程和线程的上下文信息,如 PCB和TCB导致线程的创建、终止和切换都是通过系统调用的方式来进行,切换内核态返回内核态啥的,因此对于系统来说,系统开销比较大

三、轻量级进程:

在内核中来支持用户线程,多对多

轻量级进程(LWP),本质是进程,但支持线程特性,线程不像进程那样需要那么多状态信息,可以把 LWP 当作线程,只有最小的执行上下文和调度程序所需的统计信息

一个进程可以拥有一个或多个 LWP ,每个 LWP 与一个内核线程一一映射 ,由对应的内核线程提供支持,是由内核管理并像普通进程一样被调度

LWP模型:

发现LWP上也可以用用户线程

优缺点:

实际应用中常与用户线程配合,利用用户线程便于管理、开销小等优势,同时借助 LWP 与内核交互,实现高效的并发执行,所以按照这几个搭配用户线程的模式说

调度:

进程的代码、数据从磁盘加载到内存,执行时CPU从内存读取指令啥的,运算结果存回内存,或者与外部设备交互,进程是在CPU里执行的

操作系统给进程弄成某状态,让他是运行还是阻塞还是就绪,这个“弄”,就是调度程序

由于线程是操作系统的调度单位,这里却说调度进程,其实这里指的是只有主线程的进程,所以调度主线程就等于调度了整个进程,至于为何不干脆叫线程调度,主要是os书都这么叫

调度时机:

以上这些状态变化都会触发操作系统调度

另外,如果硬件时钟提供某个频率的周期性中断,那么可以根据如何处理时钟中断,把调度算法分两类:

调度原则:

原则一:运行的程序,发生IO请求的,就会阻塞等待硬盘返回数据,那CPU就停那了,利用率就不高,所以IO事件导致CPU空闲,调度程序需要从就绪队列中选择一个进程来运行

原则二:某个任务花费时间长,一直占用CPU,系统吞吐量(CPU 在单位时间内完成的进程数量)就会降低,要提高系统的吞吐率,调度程序要权衡长任务和短任务进程的运行完成数量。

原则三:进程开始到结束,包含两个时间,进程运行时间 & 进程等待时间,合在一起成为周转时间,周转时间越小越好,所以调度程序应该避免等待时间长而运行时间短的事情发生

原则四:处于就绪队列的进程,也不能等太久,等待的越短越好,所以就绪队列中进程的等待时间也是调度程序所需要考虑的原则。

原则五:鼠标键盘交互强的应用,响应时间也是调度程序需要考虑的原则,希望越快越好

综上:

- CPU 利用率:调度程序应确保 CPU 是始终匆忙的状态,这可提高 CPU 的利用率

- 系统吞吐量:吞吐量表示的是单位时间内 CPU 完成进程的数量,长作业的进程会占用较长的 CPU 资源,因此会降低吞吐量,相反,短作业的进程会提升系统吞吐量

- 周转时间:周转时间是进程运行+阻塞时间+等待时间的总和,一个进程的周转时间越小越好

- 等待时间:这个等待时间不是阻塞状态的时间,而是进程处于就绪队列的时间,等待的时间越长,用户越不满意

- 响应时间:用户提交请求到系统第一次产生响应所花费的时间,在交互式系统中,响应时间是衡量调度算法好坏的主要标准

调度算法:

由于多核CPU建立在单核CPU系统之上,更复杂,还需要考虑负载均衡缓存一致性啥的,所以先学单核CPU算法

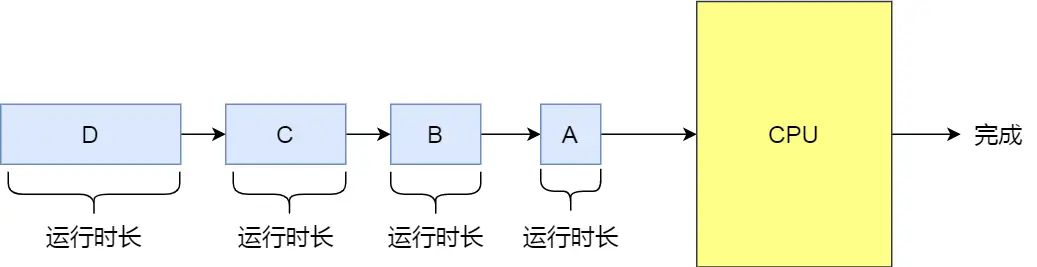

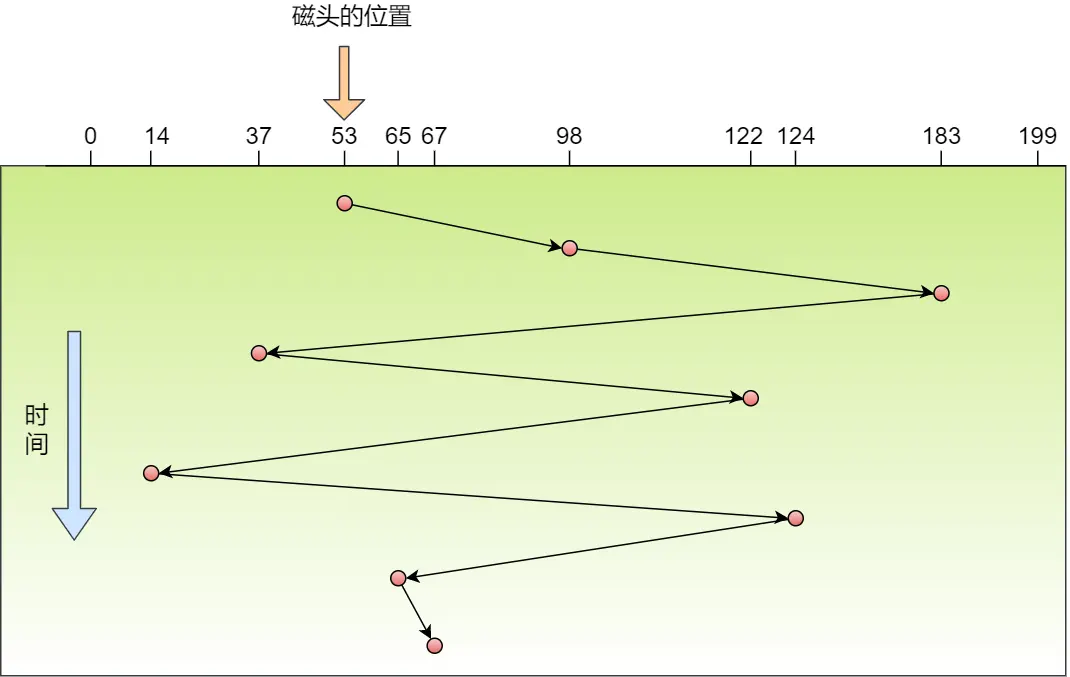

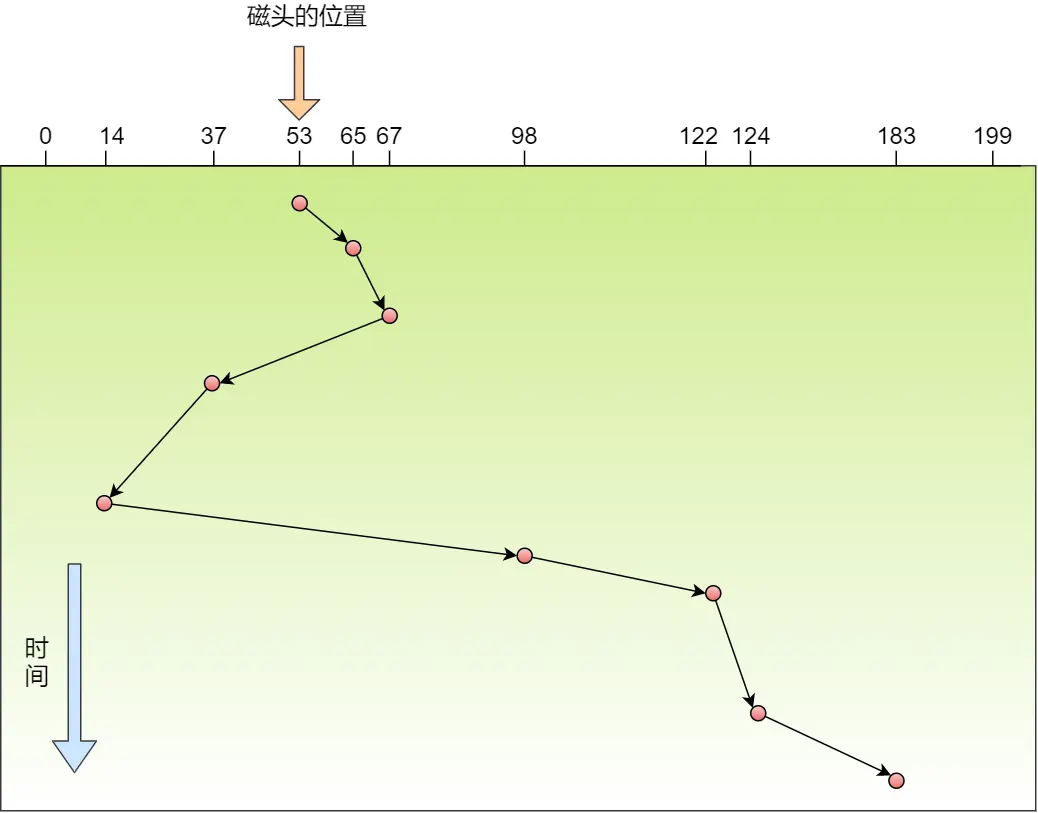

01 先来先服务调度算法

就是非抢占式的先来先服务(First Come First Serve, FCFS),每次从就绪队列选择最先进入队列的进程,然后一直运行,直到进程退出或被阻塞,才会继续从队列中选择第一个进程接着运行

当长作业先运行了,后面的短作业会持久等待,不利于短作业

长作业叫充分利用CPU,一直持续需要大量CPU时间做计算处理,所以适合于CPU繁忙型

I/O 繁忙型作业运行中常需进行 I/O 操作(如磁盘读写、网络通信 ),此时 CPU 空闲。采用 FCFS 时,即便 CPU 空闲,也只能等待该 I/O 作业完成 I/O 操作,无法及时调度其他作业,所以不适合IO繁忙型

02 最短作业优先调度算法

最短作业优先(Shortest Job First, SJF)

优先选择运行时间最短的进程来运行,这有助于提高系统的吞吐量

长作业长期得不到运行

以上我自己总结为,俩凑数的傻逼算法,方便记忆

03 高响应比优先调度算法

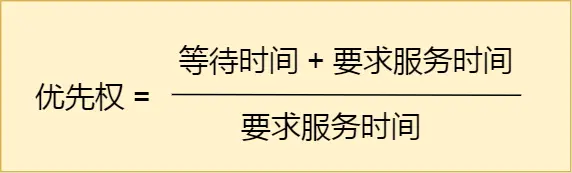

高响应比优先 (Highest Response Ratio Next, HRRN)

每次进行进程调度时,先计算「响应比优先级」,然后把「响应比优先级」最高的进程投入运行

既然有利于短作业:

- 如果两个进程的「等待时间」相同时,「要求的服务时间」越短,「响应比」就越高,短作业的进程容易被选中运行

又有利于长作业:

- 长作业要求服务时间长,等待越久,优先权越高,所以也不会冷落长作业

但这依旧是傻逼算法,纯纯凑数用的:

因为一个事实是!进程要求服务的时间是不可预知的,所以,高响应比优先调度算法是「理想型」的调度算法,现实中是实现不了的

04 时间片轮转调度算法(勘误,“将”字后是没写完,还是多了?傻逼小林写东西是用屁眼子写吗??妈逼的都啥啊?这里又一个勘误!我tm所有博客连错别字都不会有!)

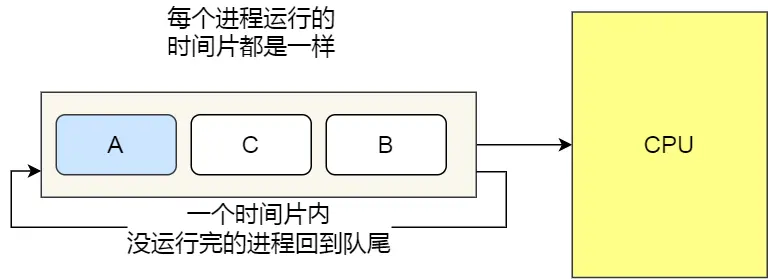

最古老、最简单、最公平且使用最广的算法就是时间片轮转(Round Robin, RR)

每个进程被分配一个时间段,称为时间片(Quantum),即允许该进程在该时间段中运行

- 如果时间片用完,进程还在运行,就把此进程从 CPU 释放出来,并把 CPU 分配给另外一个进程

- 如果该进程在时间片结束前阻塞或结束,则 CPU 立即进行切换

时间片长度的考量:

- 如果时间片设得太短会导致过多的进程上下文切换,降低了 CPU 效率

- 如果设得太长,比如有一个短作业可能就运行10ms,但依旧需要排队等那么久。相对的长作业执行时间长,等久点影响没那么大

时间片设为 20ms~50ms 通常是一个比较合理的折中值

从这开始脑子正常了,算法也不那么傻逼了

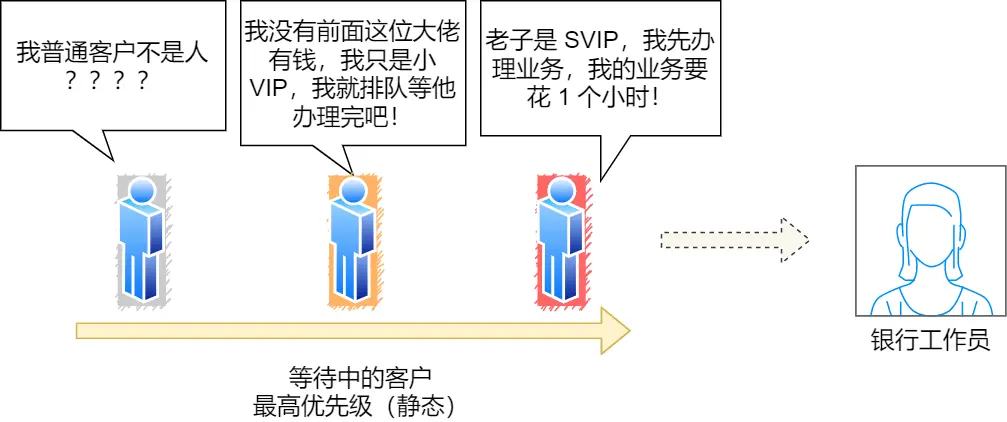

05 最高优先级调度算法

从就绪队列中选择最高优先级的进程进行运行,这称为最高优先级(Highest Priority First,HPF)

- 静态优先级:创建进程时候,就已经确定了优先级了,然后整个运行时间优先级都不变

- 动态优先级:动态调整,比如:

- 如果进程运行时间增加,则降低其优先级

- 如果进程等待时间(就绪队列的等待时间)增加,则升高其优先级

对于优先级高的,有两种处理方法:

- 非抢占式:当就绪队列中出现优先级高的进程,运行完当前进程,再选择优先级高的进程

- 抢占式:当就绪队列中出现优先级高的进程,当前进程挂起,调度优先级高的进程运行

缺点:优先级低的就惨了

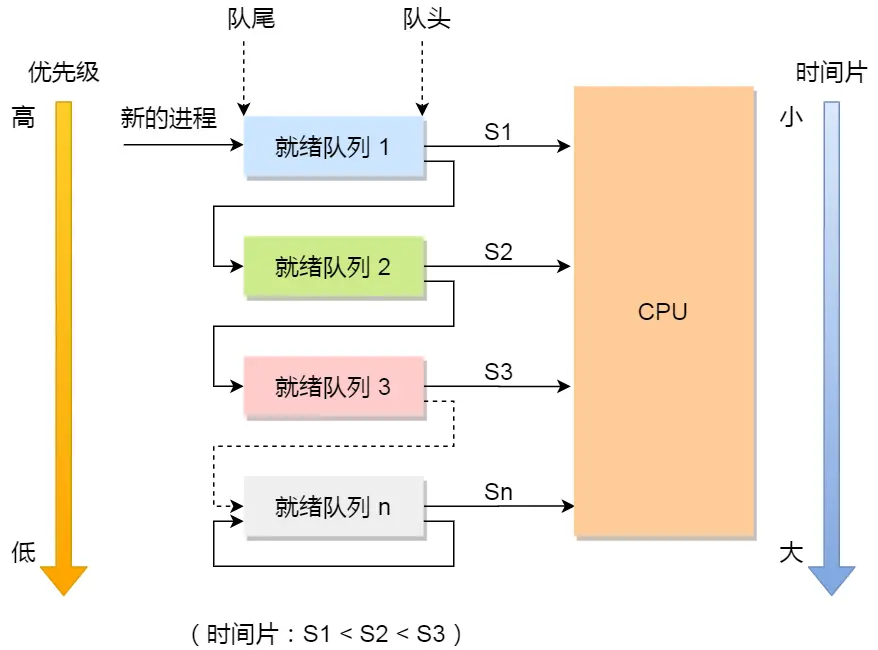

06 多级反馈队列调度算法

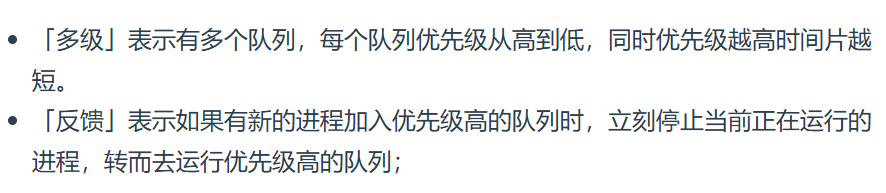

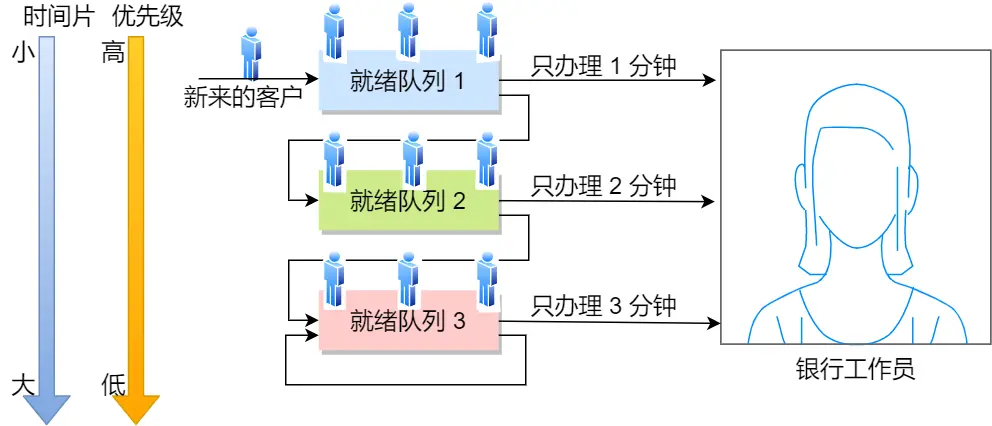

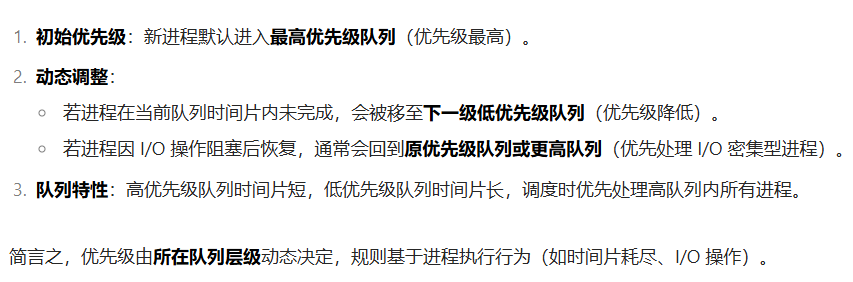

多级反馈队列(Multilevel Feedback Queue)调度算法是「时间片轮转算法」和「最高优先级算法」的综合和发展

具体就是:

- 设置了多个队列,赋予每个队列不同的优先级,每个队列优先级从高到低,同时优先级越高时间片越短

- 新的进程会被放入到第一级队列的末尾,按先来先服务的原则排队等待被调度,如果在第一级队列规定的时间片没运行完成,则将其转入到第二级队列的末尾,以此类推,直至完成;

- 当较高优先级的队列为空,才调度较低优先级的队列中的进程运行。如果进程运行时,有新进程进入较高优先级的队列,则停止当前运行的进程并将其移入到原队列末尾,接着让较高优先级的进程运行;

对于短作业可能可以在第一级队列很快被处理完。对于长作业,如果在第一级队列处理不完,可以移入下次队列等待被执行,虽然等待的时间变长了,但是运行时间也变更长了,所以该算法很好的兼顾了长短作业,同时有较好的响应时间。

简简单单结束,迷糊个JB,有啥迷糊的

小林那个例子真的罗里吧嗦的,图就太啰嗦了,简单copy一下流程 吧,感觉像是给心智不全的小孩讲东西

梳理:

办理业务的客户相当于进程,银行窗口工作人员相当于 CPU

先来先服务(FCFS),来了个办理贷款的大哥(长作业长业务),谈好几个小时,后面就遭殃了

改进,干脆优先给那些几分钟就能搞定的人办理业务,这就是短作业优先(SJF),但如果来了个协和4+4的京爷你还你能办业务?没钱没势的穷人乖乖滚犊子

改进,每个人都处理10min,也就是时间片轮转(RR),但银行客户也有优先级啊,

分为普通客户、VIP 客户、SVIP 客户。只要高优先级的客户一来,就第一时间处理这个客户,这就是最高优先级(HPF),但全是高级用户普通用户也得有活路不是?毕竟还要装装样子媒体报道领导视察啥的

,开始引出 多级反馈队列(MFQ)调度算法,它是时间片轮转算法和优先级算法的综合和发展,

- 这里设置了多个排队(就绪)队列,每个队列都有不同的优先级,各个队列优先级从高到低,同时每个队列执行时间片的长度也不同,优先级越高的时间片越短

- 新客户(进程)来了,先进入第一级队列的末尾,按先来先服务原则排队等待被叫号(运行)。如果时间片用完客户的业务还没办理完成,则让客户进入到下一级队列的末尾,以此类推,直至客户业务办理完成

- 当第一级队列没人排队时,就会叫号二级队列的客户。如果客户办理业务过程中,有新的客户加入到较高优先级的队列,那么此时办理中的客户需要停止办理,回到原队列的末尾等待再次叫号,因为要把窗口让给刚进入较高优先级队列的客户

可以发现:

对于要办理短业务的客户来说,可以很快的轮到并解决

对于要办理长业务的客户,一下子解决不了,就可以放到下一个队列,虽然等待的时间稍微变长了,但是轮到自己的办理时间也变长了,也可以接受,不会造成极端的现象

关于 多级反馈队列 我有几个问题:

首先,新来的默认最高优先级队列,那之前的排列是咋确定优先级的?

这里小林也没说,不想研究了,钻研这些细枝末节的狗屁玩意太傻逼了,好痛恨曾经那么执着的自己

进程通信

进程的用户地址是独立的,不能互相访问的,但内核空间是每个进程都共享的,所以进程之间要通信必须通过内核

Linux 内核提供了不少进程间通信的机制

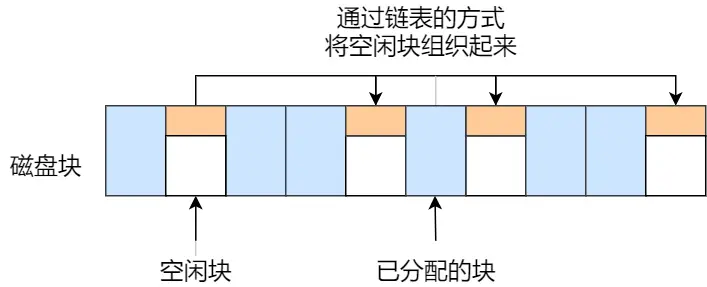

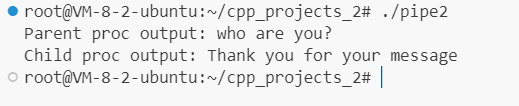

管道

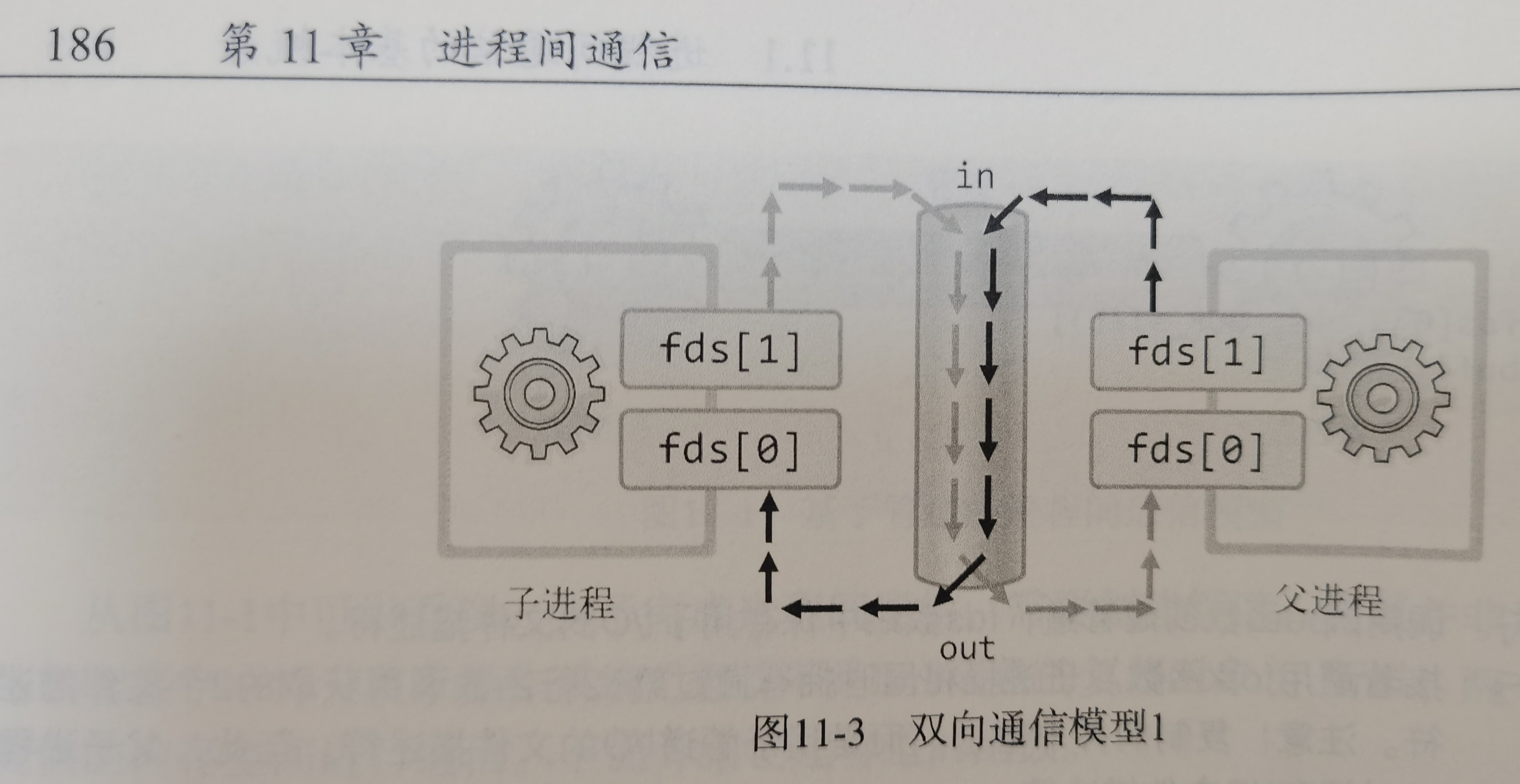

$ ps auxf | grep mysqlLinux命令,「|」竖线就是一个管道,它的功能是将前一个命令(ps auxf)的输出,作为后一个命令(grep mysql)的输入,从这功能描述,可以看出管道传输数据是单向的。如果想相互通信,我们需要创建两个管道才行

「|」表示的管道称为匿名管道,用完了就销毁

管道还有另外一个类型是命名管道,也被叫做 FIFO,因为数据是先进先出的传输方式

通过 mkfifo 命令来创建,并且指定管道名字:

$ mkfifo myPipe往 myPipe 这个管道写入数据

$ echo "hello" > myPipe // 将数据写进管道

// 停住了 ... 管道是写阻塞,没任何进程读取管道数据就会卡住,新开一个终端, cat < myPipe 作为读端连接管道,写端感知有读端存在,便会将数据写入管道,cat读后显示hello,管道数据就没了,就正常退出了

但效率太低了,不适合进程间频繁地交换数据

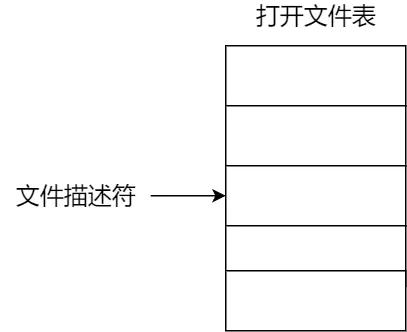

创建匿名管道

int pipe(int fd[2])这里表示返回两个描述符,一个管道读取fd[0],一个管道写入fd[1]

这个匿名管道是特殊的文件,只存在于内存,即管道是内核里的一串缓存,不存于文件系统中。管道传输的数据是无格式的流且大小受限

管道只能一端写一端读,父进程都有读写,所以一般就

- 父进程关闭读取的 fd[0],只保留写入的 fd[1];

- 子进程关闭写入的 fd[1],只保留读取的 fd[0];

TCPIP网络编程书里学过了,小林图画的太der了,我用书里的图吧

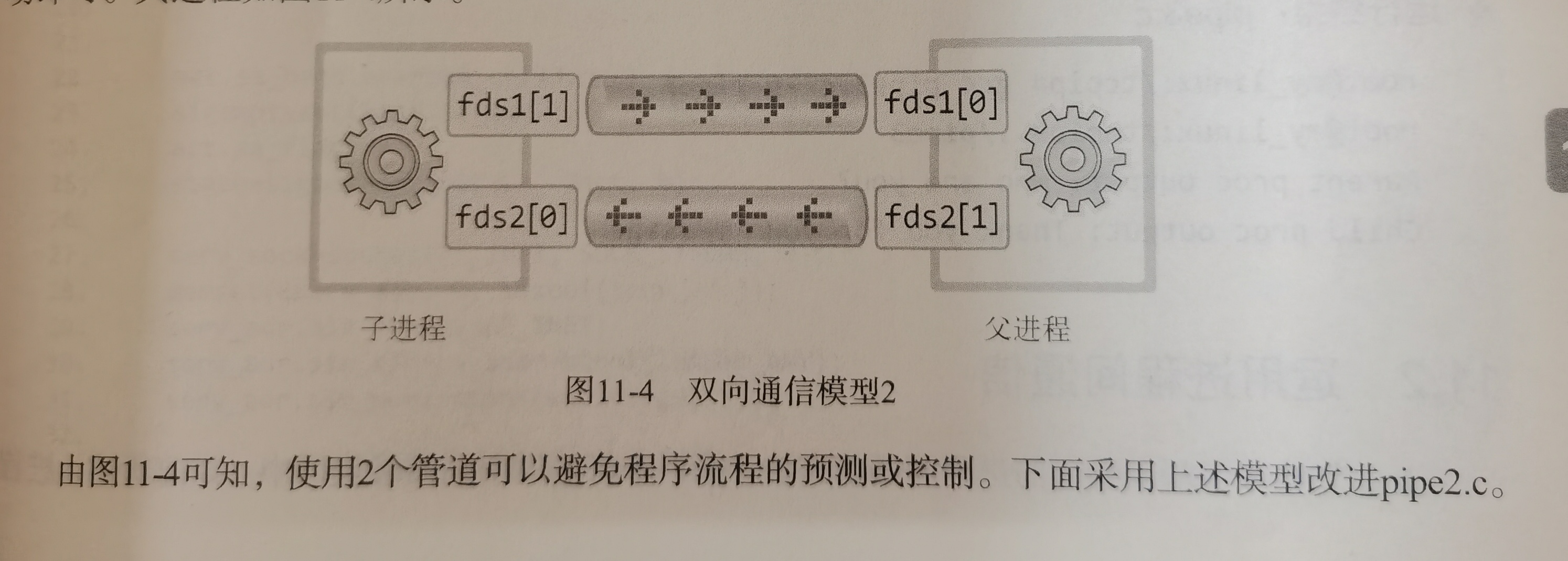

那如果我又想双向通信:

父进程写,子进程读,然后

子进程写,父进程读,可是不加限制容易父进程写完自己立马读,他以为这是子进程写的。那为了避免读写混乱,就这么搞两个管道

小林coding画的那个图实在太差劲了

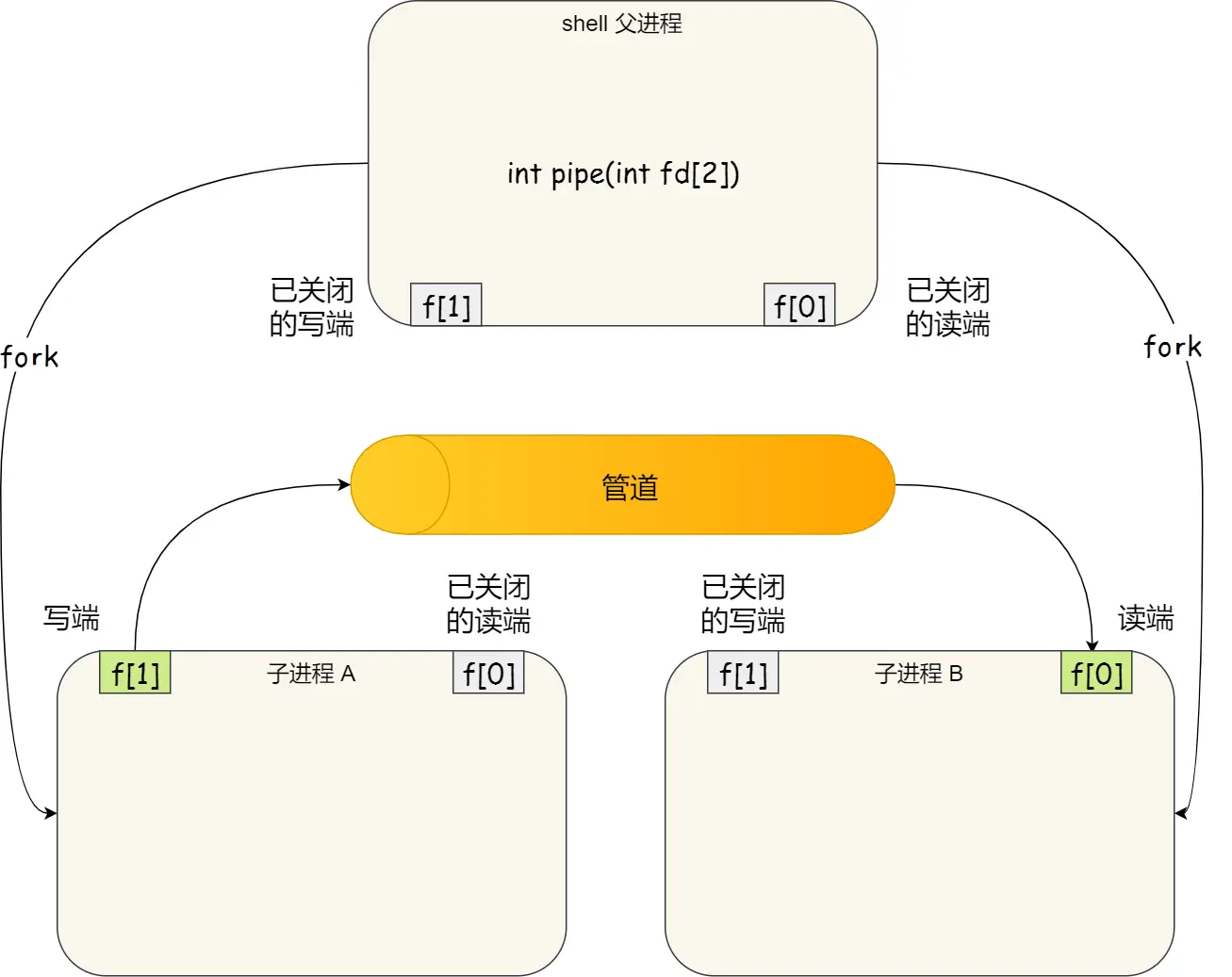

shell是命令行解释程序,Linux里用于用户和内核之间接收用户命令,解析后传给内核执行,自己追问豆包理解后,具体解释就是:

-

命令行里

ls是shell通过fork创建子进程执行,此时shell是父进程,ls是shell这个父进程fork了一个子进程进行查看操作 - C++代码里的fork是已经有的main这个父主进程来创建的子进程,但这个main父主进程究其本质,也是shell这个根父进程创建出来的子进程(只是我们一般讨论问题忽略shell这个,直接说成main就是主父进程, 且不确定有没有根父这种说法,只是经过豆包确认了他是main的父进程,为了方便表达和理解)

PS:自己手动添加配置的path环境变量就叫外部命令,是操作系统内核或 Shell 内置的命令,以独立可执行文件形式存在于系统特定目录

至此有了进一步了解了fork()本质是shell直接或间接创建fork父子进程

但目前又有好多疑惑,追问豆包才懂,再次觉得,你妈逼小林到底是不是自己理解了啊?咋写的这么烂呢?就是吧写的啥啥都不沾边,只有追问豆包懂了,才能勉强看懂他说的话,不懂的看的纯是狗屁不通

就比如这段句话:

没头没脑的

匿名知道了,fork知道了,啥区别?有了匿名为啥还有fork?或者有了fork为啥还有匿名?还是他俩等同?傻逼呵呵啥都没解释清楚

豆包重新来解释一遍吧:

先说

|这个东西,这玩意是在命令行里用的,我作为初学者就理解为Windows的那个cmd或者Linux的命令行,但钻牛角尖这些没啥意义,我就把自己给绕死了,目前姑且理解为:命令行本质就是shell,这是一个命令行解释器就行然后

ls | grep,这就是命令行匿名管道,但会报错,因为grep需要搜索模式PATTERN,ls | grep "目标关键词" # 例如搜索包含 "txt" 的文件名 ls | grep txt # 简化写法(关键词可不带引号) ls | grep cpp # 展示出所有cpp文件 ls | grep "" # 展示出所有文件,此时完全就是lsls有默认行为,可以不带参数

用

ls | grep这个错误的shell命令,来简单接地气的说说他的本质,看似输入

ls | grep cpp后会把所有cpp文件都列出来,但背后底层做的事是:

- shell 创建父子进程:shell先fork出子进程A,来执行ls,再fork出子进程B执行grep

- shell 建立管道:在内存中创建匿名管道,将子进程 A 的标准输出(stdout)重定向到管道写端,子进程 B 的标准输入(stdin)重定向到管道读端。这里AB是兄弟进程

数据流向:

ls的输出直接写入管道,grep从管道读取数据并过滤,最终结果显示在终端,仅存在于内存,随进程结束自动销毁- 手动用C++代码模拟shell背后的的底层行为

#include <unistd.h> #include <stdio.h> int main() { int fd[2]; pipe(fd); // 创建管道 if (fork() == 0) { // 子进程(ls) close(fd[0]); // 关闭读端 dup2(fd[1], STDOUT_FILENO); // stdout → 写端 execlp("ls", "ls", NULL); // 执行 ls } else { // 父进程(grep) close(fd[1]); // 关闭写端 dup2(fd[0], STDIN_FILENO); // stdin → 读端 execlp("grep", "grep", "txt", NULL); // 执行 grep } return 0; }- shell 通过

fork()+pipe()+dup2()组合,实现两个命令间的数据传输,无需用户手动调用系统 API理解之后总结

- 使用者是shell命令行,由 shell 自动创建并管理,用户只需用

|来操作,由 shell 自动创建临时管道连接两进程。- 特点:仅用于父子 / 兄弟这种亲缘关系使用的进程间通信,生命周期随进程结束。不存在于文件系统中

- 命令行创建:

mkfifo mypipe,生成磁盘文件(类型 p),这里也叫“在文件系统创建一个类型为 p 的设备文件”- 代码中使用:需手动

open()读写,不相关进程可通过文件名共享。- 特点:持久化存在,不依赖进程关系。通过文件系统共享,进程写入的数据缓存在内核中,另一个进程读取的数据也是从内核中读。作为特殊文件持久存在文件系统中,但里头的数据读完就没了。不需要亲缘关系,比如:不同应用程序进程通信、不同用户启动的进程通信。

- 程序员代码里手写的,灵活通过pipe、fork、dup啥的手动配置。

- 作用:创建新进程,使匿名管道的文件描述符能在进程间传递。创建新进程(子进程),父子进程通过

pipe()系统调用手动创建匿名管道通信。得用底层系统API操控,、read、write、close啥的。仅存在于当前进程的内存中。若要让其他进程使用,必须通过fork()将文件描述符复制给子进程(父子进程共享同一管道)。无进程关系的两个程序无法直接使用匿名管道(如 A 程序的pipe()生成的 fd 无法直接传递给 B 程序)。- 示例:

int fd[2]; pipe(fd); // 创建匿名管道 if (fork() == 0) { // 子进程写 close(fd[0]); write(fd[1], ...); } else { // 父进程读 close(fd[1]); read(fd[0], ...); }核心区别:

- 命令行管道(匿名 / 命名)由 shell 管理,代码中需手动调用系统 API。

- 匿名管道依赖进程关系,命名管道通过文件系统共享。

进程启动时,默认占用 3 个描述符:0 → STDIN_FILENO (标准输入) 1 → STDOUT_FILENO (标准输出) 2 → STDERR_FILENO (标准错误)dup:复制的是文件表项(即指向同一个文件/管道),非描述符数值int newfd = dup(STDOUT_FILENO); // 复制 stdout(1),newfd 可能为 3说人话就是比如0是输入,如果int haha=dup(0),haha文件描述符就是3,因为0输入1输出2错误都有了,最小可用的是3,就把3作为haha的文件描述符,然后干的事就是后面的赋值,一看dup里是0,就知道从此以后文件描述符3就是haha,haha就代表读,与0标准输入共享读权限

dup2:dup2(old,new)强制将new重定向为old(如dup2(fd, 1)让标准输出指向fd)int fd = open("log.txt", O_WRONLY | O_CREAT); dup2(fd, STDOUT_FILENO); // 此后printf()输出到log.txt而非屏幕 printf("Hello, log file!\n");我总结就是:

所以我理解匿名和fork代码是一样的

匿名管道本质是我们写代码用的fork的一个简单封装,即 shell 对

fork()+pipe()的封装,用于快速实现进程间临时通信(如ls | grep),实现内核内部管道通信而命名的是单独的,不依赖进程,只是创建简易的读写谁来读都行

消息队列

适合进程频繁交换数据,消息队列是保存在内核中的消息链表

为啥放在内核:

-

生命周期管理方便 :消息队列若放在用户空间,进程退出时消息队列可能跟着消

- 进程间共享容易:每个进程用户地址空间独立,不能直接互相访问,但都共享内核空间

用户自定义数据类型,跟接收方约定好后进行发送,这个数据类型叫消息体,发送数据时,会分成一个一个独立的数据单元,这个数据单元就是消息体(数据块)

每个消息体都是固定大小的存储块,不像管道是无格式的字节流数据

进程从消息队列中读取了消息体,内核就会把这个消息体删除

没有释放消息队列或者没有关闭操作系统,消息队列会一直存在,所以消息队列生命周期随内核,不像进程随进程

类似发邮件一样,但

-

通信不及时

-

附件大小有限制

-

内核中每个消息体都有一个最大长度的限制,所有队列所包含的全部消息体的总长度也是有上限,Linux内核里,会有两个宏定义

MSGMAX和MSGMNB,它们以字节为单位,分别定义了一条消息的最大长度和一个队列的最大长度 - 消息队列通信过程中,存在用户态与内核态之间的数据拷贝开销,因为进程写入数据到内核中的消息队列时,会发生从用户态拷贝数据到内核态的过程,同理另一进程读取内核中的消息数据时,会发生从内核态拷贝数据到用户态的过程

共享内存(最快的进程间通信方式)

为了解决了 用户态 和 内存态 之间的消息拷贝过程数据开销

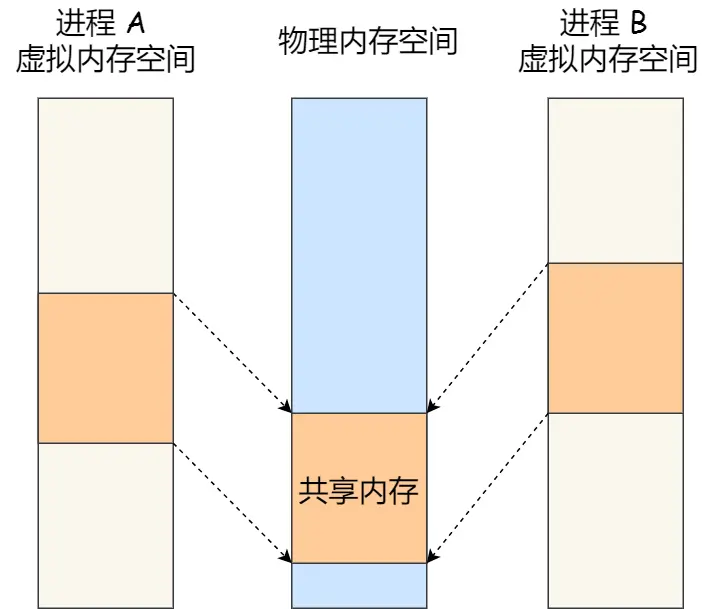

回顾下之前虚拟内存的事:

每个进程都有自己独立的虚拟内存空间,不同进程的虚拟内存映射到不同的物理内存中。所以,即使进程 A 和 进程 B 的虚拟地址是一样的,其实访问的是不同的物理内存地址,对于数据的增删查改互不影响

共享内存机制:拿出一块虚拟地址空间来,映射到相同的物理内存中。这样这个进程写入的东西,另外一个进程马上就能看到了,都不需要拷贝来拷贝去,传来传去,大大提高进程间通信的速度

再深入说下,怎么从消息队列过度来的,追问豆包学到的知识:

之前消息队列:

- 生命周期管理方便 :消息队列若放在用户空间,进程退出时消息队列可能跟着消

- 进程间共享容易:每个进程用户地址空间独立,不能直接互相访问,但都共享内核空间

共享内存需要借助内核创建,生命周期由内核控制的,但数据存放位置在用户空间,这样设计有 2 个关键原因:

速度快:数据直接在用户空间内存中,进程无需频繁 “进出内核” 搬运数据,通信效率极高(是最快的 IPC 方式)。

灵活控制:进程自己管理内存读写,不像消息队列等需通过内核中转,适合大量数据快速交换(如视频播放时的数据传输)。

总结:共享内存的 “内核创建 + 用户存储” 模式,平衡了 “系统管理” 和 “高效通信” 的需求。

内核管理生命周期

共享内存由内核创建后,会在内核中记录其存在(即使创建它的进程退出)。必须显式调用系统函数内核才会删除它

用户空间的 “关联” 与 “数据”

关联:进程通过内核 “挂载” 共享内存到自己的用户地址空间(shmat函数),相当于建立一个 “指针”

数据:内存中的数据本身在用户空间,但内核记录了 “这块内存属于谁、谁能访问”

进程退出影响:进程结束后,只是 “指针断开”(不再关联共享内存),但数据本身仍在内核管理的内存中,直到内核删除整个共享内存

- 比喻:进程就像不同的房间,每个房间有自己的储物架(用户地址空间)。

内核提前在公共仓库(内核管理的内存)里划出一块区域作为共享内存。

当某个进程想用这块共享内存时,需要告诉内核:“我要把公共仓库的 XX 区域连到我房间的储物架第 10 格”。

内核收到请求后,会在这个进程的储物架第 10 格做个标记:“这里的数据实际存在公共仓库 XX 区域”。

这个 “标记” 就是shmat函数的作用,进程后续读写储物架第 10 格时,实际操作的是公共仓库里的共享内存区域。对比理解(为什么和消息队列逻辑类似)

通信方式 数据存放位置 生命周期控制者 删除条件 消息队列 内核空间 内核 内核重启或显式删除 共享内存 用户空间(但由内核分配) 内核 内核重启、显式删除或内存不足 一句话总结

共享内存的数据存在用户空间,但‘生杀大权’在 Kernel 手里,进程退出只是 “断开连接”,不会直接删除内存块

至此清晰多了,开始引入信号量啥的,保护共享资源,以确保任何时刻只能有一个进程访问共享资源

信号量不仅可以实现访问的互斥性,还可以实现进程间的同步,

注意:多说几句追问豆包得到的知识,这些很多的名字起的真够傻逼的

关于同步:

这里的 “同步” 指的是多进程按规则有序访问资源,不是 “同时操作”

而信号是异步通信机制

关于异步:

豆包官方说法是:“可在任意时刻 “打断” 主流程,主流程无需等待事件处理完成,处理完后再回到主流程继续执行”,真他妈傻逼!!

说人话就是,异步没有什么等与不等的事!而是自己亲历其为去做!即异步就是被无法预知的,代码设定的诸如CTRL+C这种内核设置的信号打断立马执行

后面的信号里的代码,此文搜“书P168代码”:

timeout和keycontrol既不是新进程也不是新线程 。signal函数用于设置信号处理函数,当对应的信号(SIGALRM、SIGINT)发生时,程序的执行流程会跳转到相应的信号处理函数(timeout、keycontrol)去执行 。执行完信号处理函数后,再回到主流程(main函数里信号打断处)继续执行 。它是在当前进程内,通过改变执行流来处理信号的,没有创建新的进程或线程

异步中断:事件随机发生,强制打断任务(无法提前预知)

主动阻塞:任务主动暂停并等待(如程序中写死的

sleep())

信号本身是异步非阻塞的,即

- 信号的触发不会让进程 “卡住等待”,而是直接 “通知” 进程有事件发生,然后系统立即处理,立即亲自执行不用去等谁,涉及不到等的事,比如如终止进程,所以这不是阻塞,而是直接中断进程当前操作

后文说的

wait()不是信号,是系统调用,用于等待子进程结束的同步阻塞函数,即父进程阻塞自身信号处理也有阻塞机制,

sigprocmask()但只是临时屏蔽SIGINT信号,避免进程被Ctrl+C打断,直到允许处理该信号为止。这是进程主动设置的阻塞,信号的触发依然是异步的,只是处理被延迟了

好了,这些都是工作于同一台主机的通信机制,如果要与不同主机的进程间通信,就要socket了

至此是共享内存的事,而共享内存的后半部分又说了信号量、信号,其实都是下面文章的内容,这些信号量、信号都是我后更新的,即第二天又有了新的理解,重新加的,作为更好的衔接知识!看不懂可以先看下面的信号量、信号,然后再回过头来看

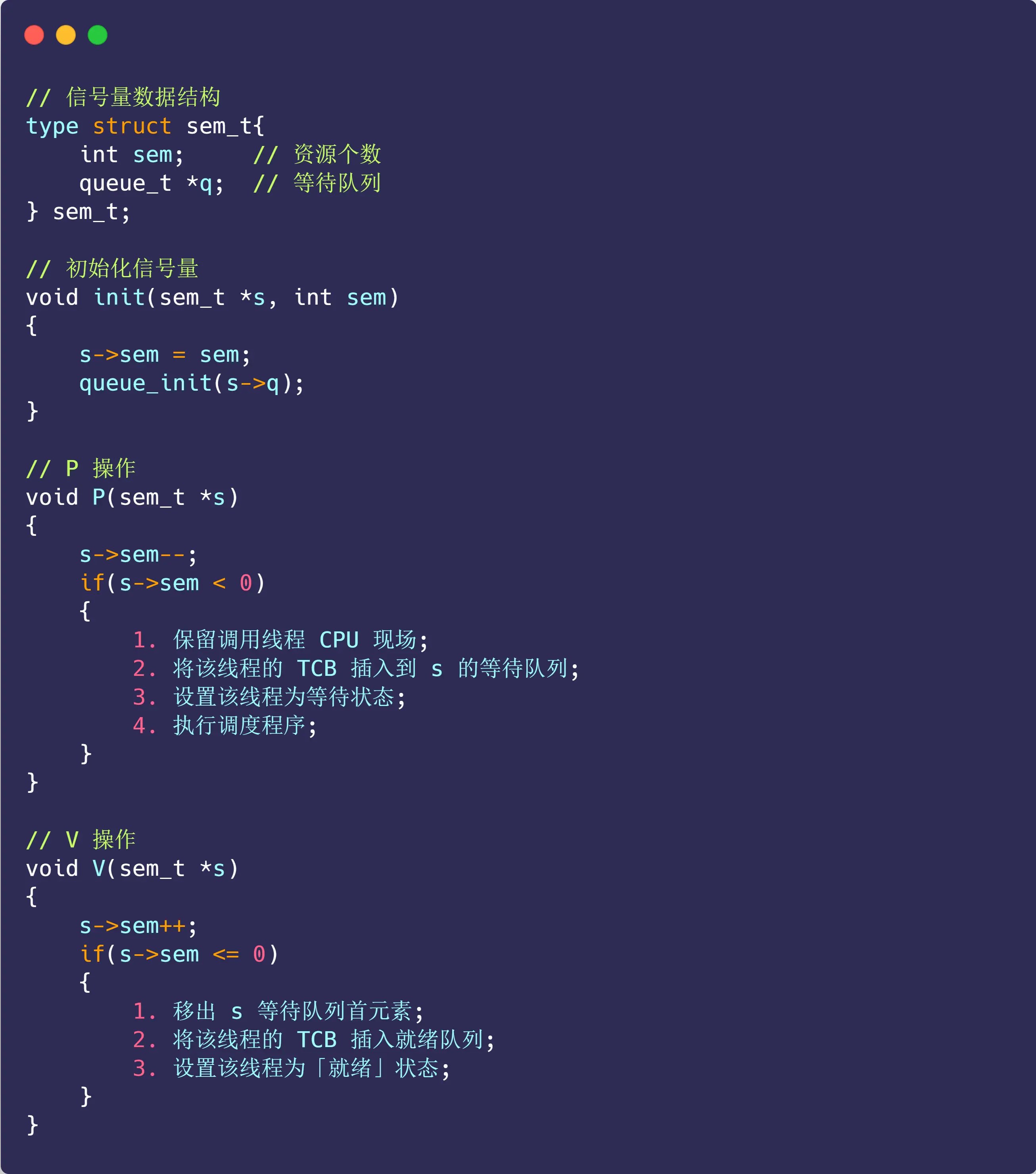

信号量

开始严谨了,共享内存通信会有新的问题,如果多个进程同时修改同一个共享内存,很有可能就冲突了

例如两个进程都同时写一个地址,那先写的那个进程会发现内容被别人覆盖了,引入信号量,本质:整型计数器

主要用于实现进程间的互斥与同步

PS:他不是像消息队列、共享内存等机制那样,存储进程之间实际要传递的数据,即不缓存进程间通信的数据,他只是做一个控制访问的作用

那么引出下面的知识之前说几个东西:

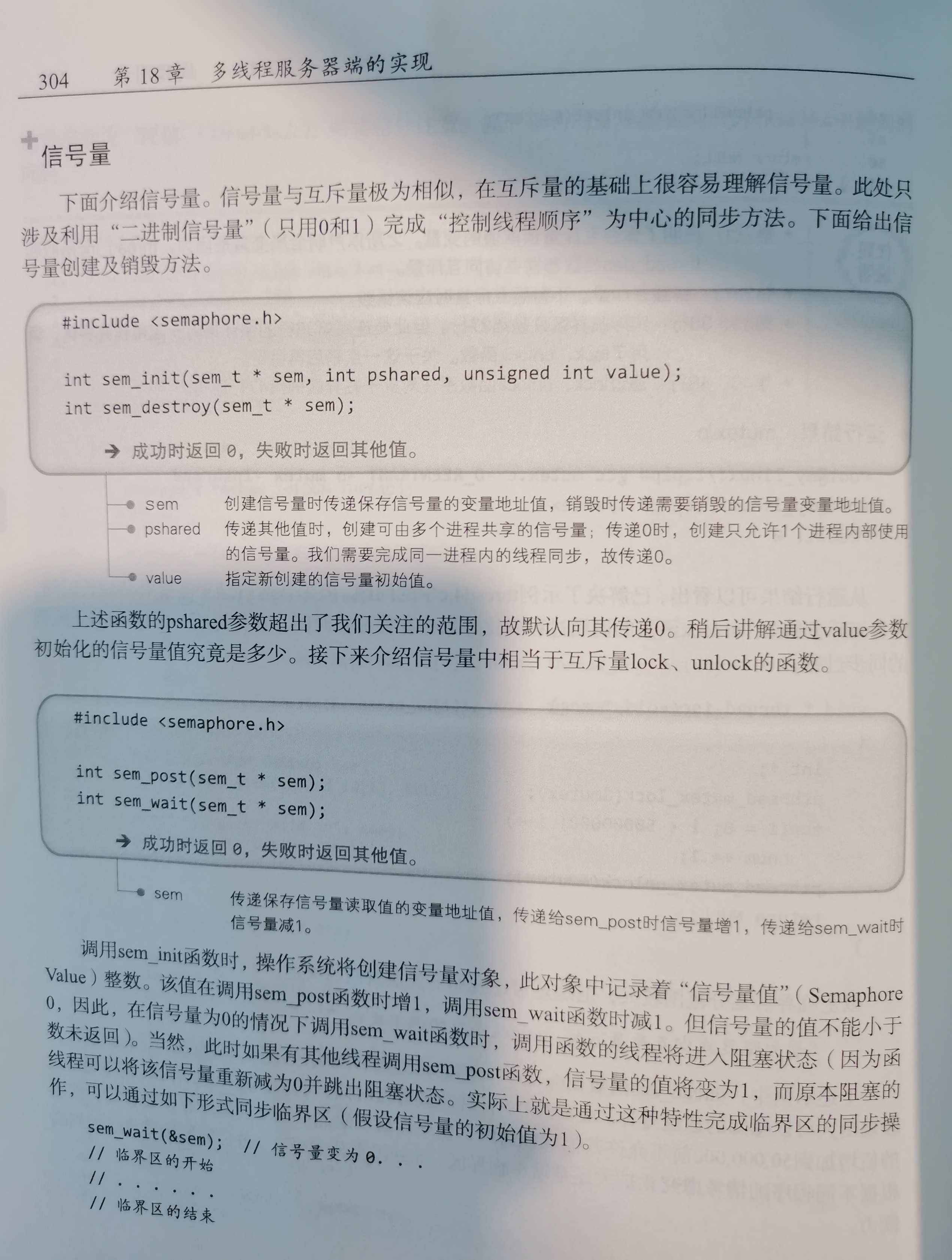

PV原语是理论概念,荷兰语Proberen阻塞和Verhogen提高的首字母,P操作减1,V操作加1,实际POSIX具体实现函数是sem_xxx也就是TCPIP网络编程书里的,POSIX是规范可移植操作系统的接口,Linux就采用这个标准,具体是:

P 操作(通常对应

sem_wait)用于申请资源,会将信号量的值减 1,当信号量的值小于 0 时,进程会被阻塞,以表示资源不可用V 操作(通常对应

sem_post)用于释放资源,会将信号量的值加 1,以唤醒可能被阻塞的进程,表明有资源可用了

大学教材上讲的是像这个小兄弟网站里写的(oier佬风格,如果不是为了找工作,我不会看小林这群应试垃圾狗的东西),即先检查资源是否充足,不充足即小于0,则阻塞,充足就减一,即先检查可不可用后减1,我记得自己学的时候考研的时候好像也是这么回事

而且,之前啃TCPIP网络编程的时候,这页附近讲的是信号量不可以小于0,即只有0和1,但好像没说先减还是先检查是否可用,只说“信号量为0的情况下调用sem_wait函数,调用函数的线程将阻塞”,好像怎么理解都可以(csdn也是这么说的,还有信号量能否小于0的讨论帖),小林coding里说可以小于0,尹圣雨TCPIP网络编程书里说不可以小于0

另外还有TCPIP网络编程书最后windows线程同步那说的,即P334页附近各种“基于互斥量对象的同步、基于信号量对象的同步、基于事件对象的同步”无尽梦魇黑暗之海痛苦不堪去你妈的吧

- 然后关于先判断还是先减,豆包大模型纯纯墙头草,我真的崩溃疯掉了,昨晚即2025/05/10路上语音问豆包,还说先判断后减的是理论模型,因为会出现同时判断觉得资源可用同时减的情况,而实际POSIX现代Linux是先减再判断,即减是原子操作可以保证不会出现这种情况,减后的结果被所有其他想访问的进程看到,结果刚才问豆包又说的完全反过来了!哎真的好心累啊~~~~(>_<)~~~~,我真的没力气去钻研了,真的看不到光亮,要死了~~~~(>_<)~~~~,(详见本章的豆包链接,跟前几章都是同一个豆包链接)。妈逼的问deepseek也说的矛盾

不再纠结这些,小林应试哥写啥看啥,饿太久肚子了

开始傻逼应试无脑看模式:(不管先判断还是先减了,不管信号量可不可以小于0了,也不管信号量0代表资源可不可用了,其实不断章取义的看,还是能看懂的)

设定为信号量 < 0阻塞,

- P 操作,信号量减 1,

- 如果 < 0,则资源已被占用,阻塞等待,

- 如果≥0,则可用

- V 操作,信号量加 1,

- 如果 ≤ 0,则表明在自己占用期间有进程要用才被P操成负的,所以加1后只要还 ≤ 0,就唤醒进程

- 如果> 0,则没阻塞的进程

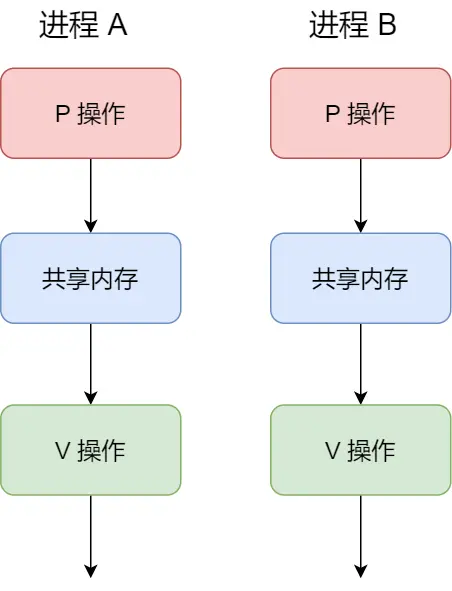

P 操作是用在进入共享资源之前,V 操作是用在离开共享资源之后,这俩成对

之前觉得“于是会将该进程唤醒运行”和“表示共享资源可用”这有问题,现在想通了,没问题

举个例子:

初始化信号量为1

具体流程:

以上是仅仅保证了同一时刻只有一个进程在访问资源,没顺序,很好的保护了共享内存。

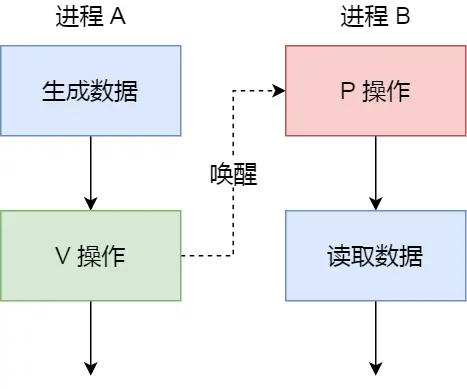

再说个有顺序的例子:(简称顺序例子,下面会用到)

初始信号量是0

- 如果进程 B 比进程 A 先执行了,那么执行到 P 操作时,由于信号量初始值为0,所以信号量变为-1,表示进程 A 还没生产数据,于是进程 B 就阻塞等待

-

A生完后,V操作,信号量变为0,唤醒阻塞在P操作的 B 进程,就开始读数据

至此小林coding信号量的讲解结束了,接下来该信号了。但一方面强迫症思考联想结合啃过的TCPIP网络编程,另一方面缅怀学过的知识,扩展下:(妈逼的估计又学深了,说真的如果侧重点,我真他妈早都腾讯 SP+ 的offer了)

首先说下前言,即为啥要有信号量这些东西

想个东西:(书P297)

num初始值是0

线程a对num做加1运算

线程b对num做减1运算

理论上:

线程1对num加1,的底层逻辑是,num不会自动加1,线程1取得num传递给CPU,CPU来加,变为1后,返回到num,num变为1,

接着线程2... ...

num最后依旧是0

但实际是:

线程1加1操作后,没来的及存回num,这时num还是0,此时线程2通过切换得到CPU资源,线程2就减1,num变为0了,这时候CPU切换到线程1,线程1把刚才加1后的值存回num。这样num最后就是1了,实际可能是1、-1、0

这就是所谓的线程会分时使用CPU,但依旧会“同时”访问全局变量num

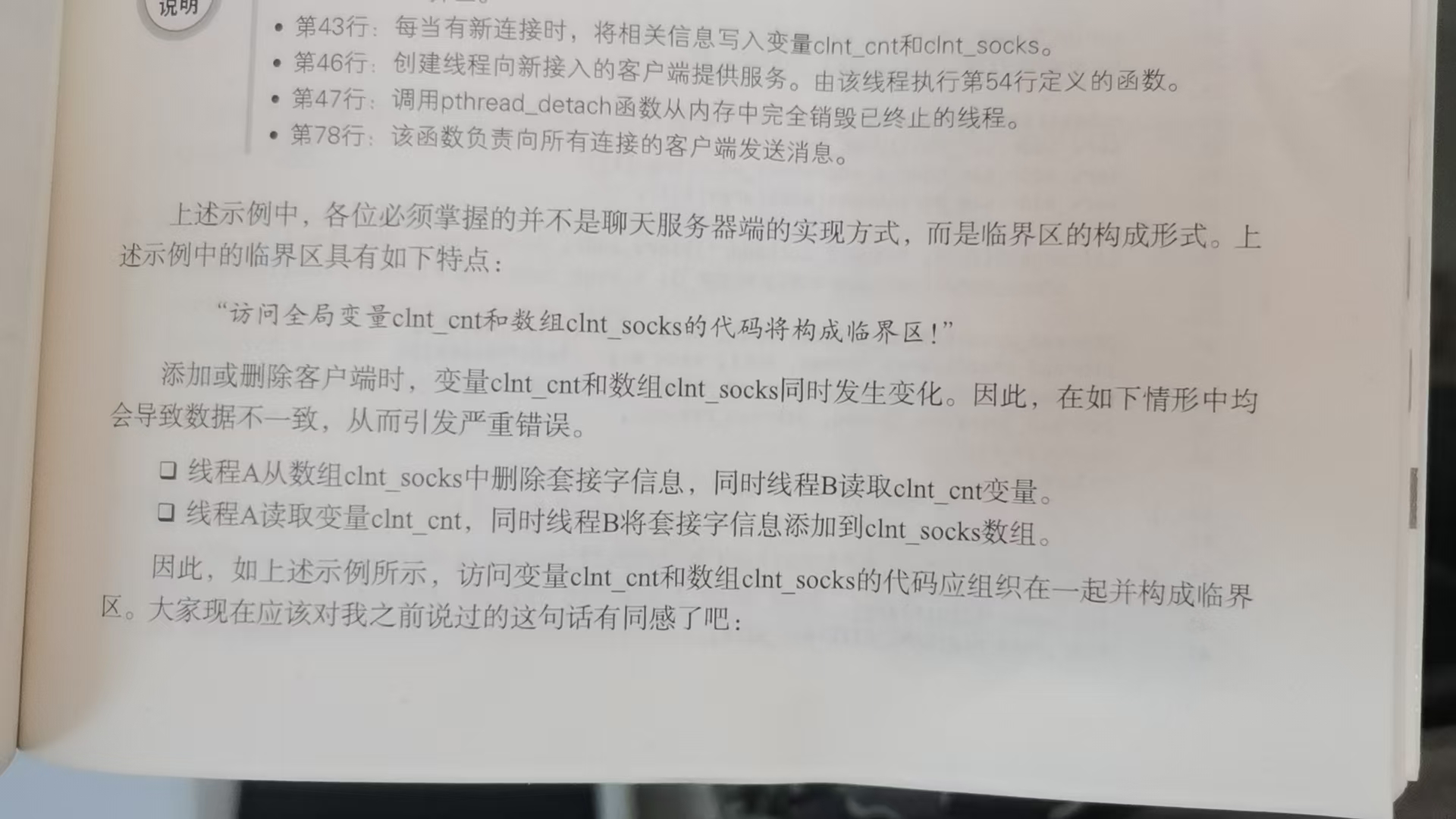

所以,“函数内同时运行多个线程时,引起问题的多条语句构成的代码块”就叫临界区

或者说“多线程执行操作共享变量的这段代码可能会导致竞争状态”

所以访问顺序导致的问题,为了解决,就引出了 线程同步 —— 互斥量 & 信号量 (TCPIP网络编程书P301)

互斥量(pthread_mutex_lock、pthread_mutex_unlock这都是书里介绍的最底层POSIX接口)

信号量(我学的是sem_post、sem_wait这种书里介绍的Linux用的底层POSIX接口,貌似现在主流是C++封装的标准库std::mutex)

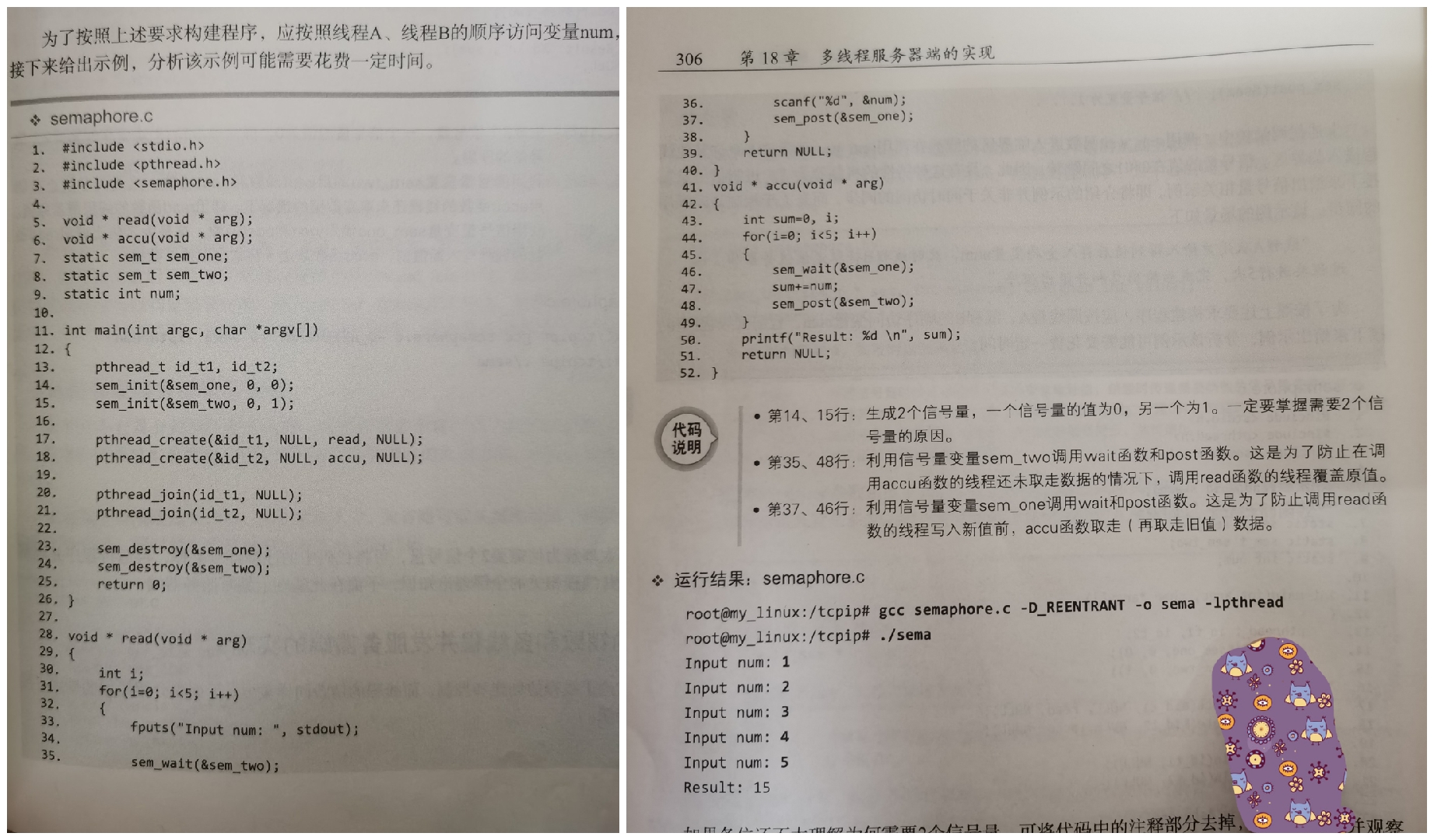

尹圣雨18章我追问豆包知道了信号量分为:(后来发现其实互斥量就可以认为是锁,本质是0和1的二元信号量。然后信号量分为计数信号量和二进制信号量)

计数信号量:可以多个资源

二进制信号量:只是0和1

书P304里说信号量不能小于0,说为0就阻塞,为1就跳出,没侧重说判断和减的顺序,

线程A接收用户输入存入num

线程B累加(不能先累加哈哈)

信号量创建sem_init(第一个参数:信号量变量地址值、第二个参数:为0表示只允许一个进程内部使用,其他数值的话可以多个使用、第三个参数:初始值)

我自己的思考是在read()、acc()里加一个sleep()比较好理解书里下面那个对35、48行的解释:

read线程每次输入num前先执行sem_wait(&sem_two),若accu线程未处理完数据(即未执行sem_post(&sem_two)释放信号量),read线程会阻塞,无法输入新num。只有accu线程处理完数据并执行sem_post(&sem_two)后,read线程才能继续输入,避免了accu未取走数据时read输入新值覆盖原值,确保每次输入的num都能被accu正确累加

这个例子也就跟小林那个顺序例子对上了,就是有点相互制,约左脚踩右脚的感觉

至此就是我补充的互斥量和信号量

那总结下,为啥小林没说互斥量?为啥这里叫进程通信?明明书里讲互斥、信号量的时候标题是线程同步啊!

豆包解释:

信号量既可用于线程同步(如同一进程内线程协作),也可用于进程通信(不同进程间同步互斥);

互斥量主要用于线程互斥(确保同一进程内共享资源一次仅一线程访问),也可用于进程(需共享互斥量对象,但这里书上和小林都没说,因为没fork来搞进程所以我也不钻研了)二者区别在于:

互斥量本质是锁,确保共享资源同一时间仅一个线程访问,如

pthread_mutex_t、std::mutex,用于解决线程间互斥访问问题,类似 “一次仅一人进入房间”。多为二元状态(0/1,强调互斥),并不是二进制信号量的那个东西,这里表达的是正反面,以一面能开另一面就锁着那种意思,而二进制信号量说的是只有一个资源,不是那种互斥的味道信号量可为非负整数(更灵活,用于同步或多资源互斥),是计数器,控制同时访问共享资源的线程数量(如

sem_t、std::counting_semaphore),可用于同步或互斥。例如初始值为1时类似互斥量(一次仅一线程访问),初始值大于1时允许一定数量线程同时访问,更灵活,如 “允许最多n人同时进入房间”小林未提互斥量,因该章节聚焦进程间通信方式,互斥量侧重同一进程内线程互斥,与进程间通信场景关联弱;

尹圣雨书在线程同步讲互斥量与信号量,因二者是线程间同步的常用机制。

关于接口函数是否过时:

sem_xxx(如sem_wait)、pthread_mutex_lock是POSIX 标准接口,属于底层 Linux(或支持 POSIX 的系统),非 C++ 专属(C++ 可封装调用)。这些函数是底层多线程 / 进程编程的基础工具,在 Linux 环境下开发,涉及同步互斥时仍主流且广泛使用,是理解并发编程的核心内容。尹圣雨书中的互斥量、信号量用于 同一进程内线程间同步,解决线程访问顺序等问题;小林图中是 不同进程(如进程 A、B)间用信号量协作,属于进程通信(进程间交互协调),两者作用范围不同。生产者是生成数据的进程(如进程 A),消费者是读取数据的进程(如进程 B)。这些场景中,若涉及不同进程(如进程 A 和进程 B 协作),用信号量协调动作属于 进程通信(进程间协作交互),而线程同步是同一进程内线程间的协调,范畴不同。

小林顺序例子里,进程 A 是生产者(生成数据),进程 B 是消费者(读取数据),通过信号量实现进程间同步协作,属于进程通信中的同步机制,与线程同步(同一进程内线程间)本质不同

以上就是信号量的引出原因

这个小林讲的逻辑和尹圣雨书不同:

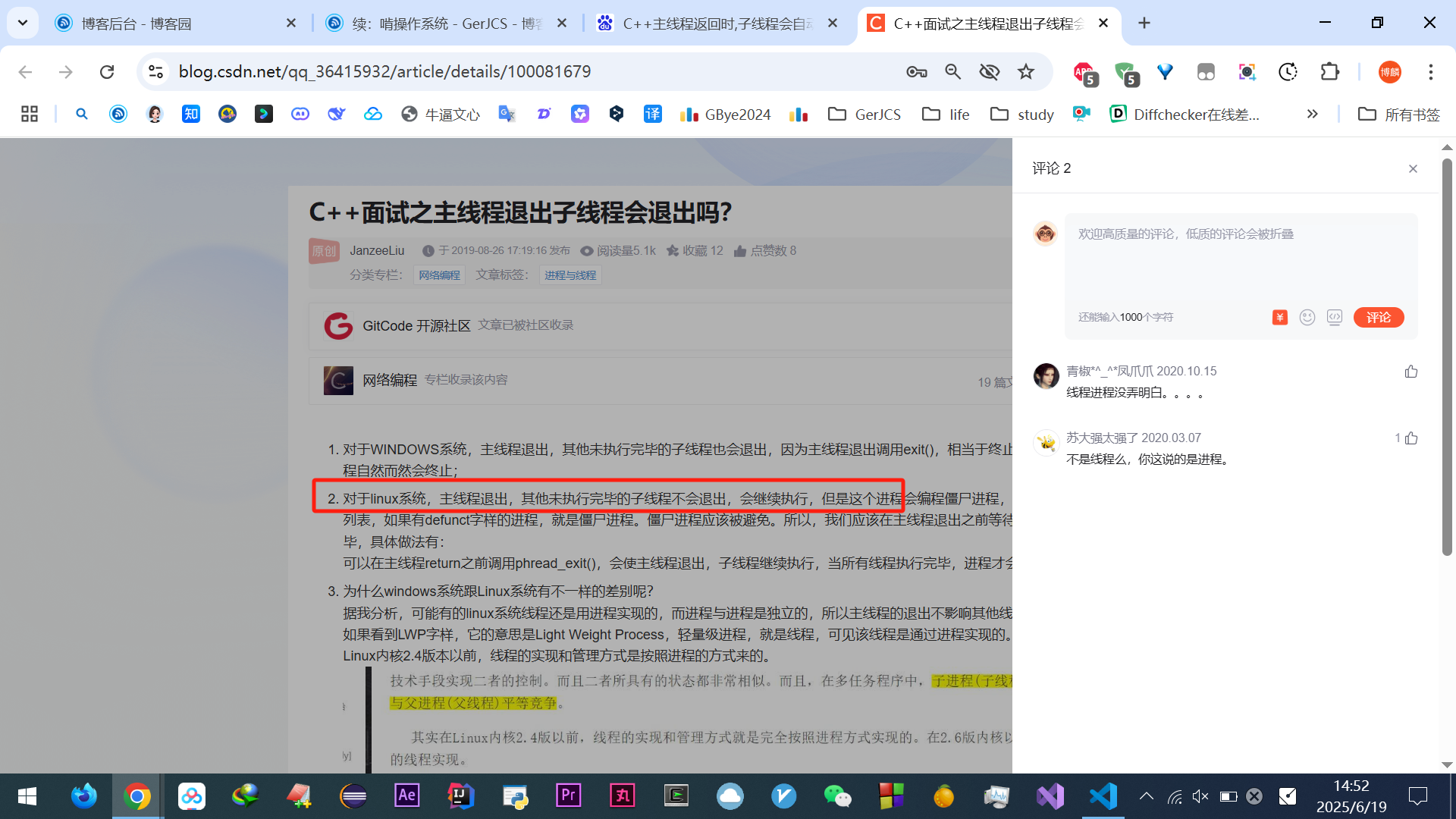

书里是把信号处理作为第10章多进程服务器里的(P165)

线程同步互斥量、信号量那些是第18章多线程服务器里的

再说下信号,小林把信号和信号量放在一起,感觉很混乱,没头没脑的,连个为啥引出信号都没说,就这你们这JB也能做程序员啊?咋串联的啊!真他妈一群水货。就这?

书里的信号讲的是:

跟进程有关的东西,

先追溯从父子进程开始说(同开始回顾啃的尹圣雨TCPIP网络编程书第10章,P158)

#include<unistd.h>

pid_t fork(void)成功返回进程ID,失败返回-1

父进程:fork()函数返回子进程ID

子进程:fork()函数返回0

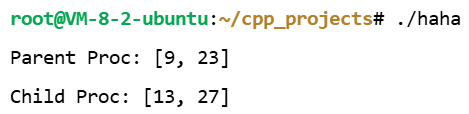

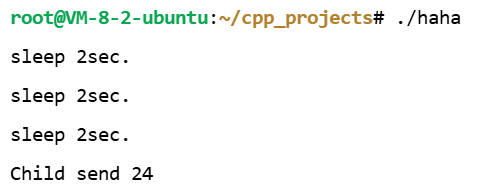

#include <stdio.h> #include <unistd.h> int main() { pid_t pid; int gval = 10; int lval = 20; gval++, lval += 5; pid = fork(); if (pid == 0) { gval += 2; lval += 2; } else { gval -= 2; lval -= 2; } if (pid == 0) { printf("Child Proc: [%d, %d] \n", gval, lval); } else { printf("Parent Proc: [%d, %d] \n", gval, lval); } }执行结果:

(./haha是在这个目录下,只haha的话会在path路径里执行)

这里就是父子进程的简单代码

好至此有个简单了解,那注意mian结束后,进程应该被销毁,但有时候会变成僵尸进程,占用系统资源

向exit函数传递参数值和main函数的return返回值,都会给操作系统,而os不会销毁子进程,也不会主动给父进程发,只有父进程主动发起请求调用函数时,os才会传递该返回值,那这种状态的进程就是僵尸进程,即将子进程变成僵尸的是os。

且实际父子进程谁先谁后执行是不可预测的,os自己来执行确定

先创建一个僵尸进程

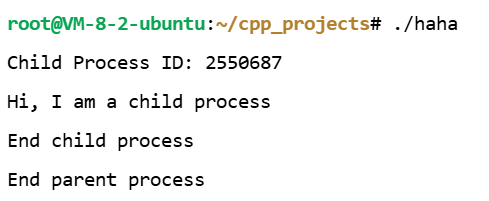

#include <stdio.h> #include <unistd.h> int main(int argc, char *argv[]) { pid_t pid=fork(); if(pid==0) // if Child Process { puts("Hi, I am a child process"); } else { printf("Child Process ID: %d \n", pid); sleep(30); // Sleep 30 sec. } if(pid==0) puts("End child process"); else puts("End parent process"); return 0; }

这里最后一句是30s后出现的,父进程在执行

sleep(30)处于睡眠状态 ,这里if(pid==0)有两句,是同一个子进程先后执行的这两句

30s期间,

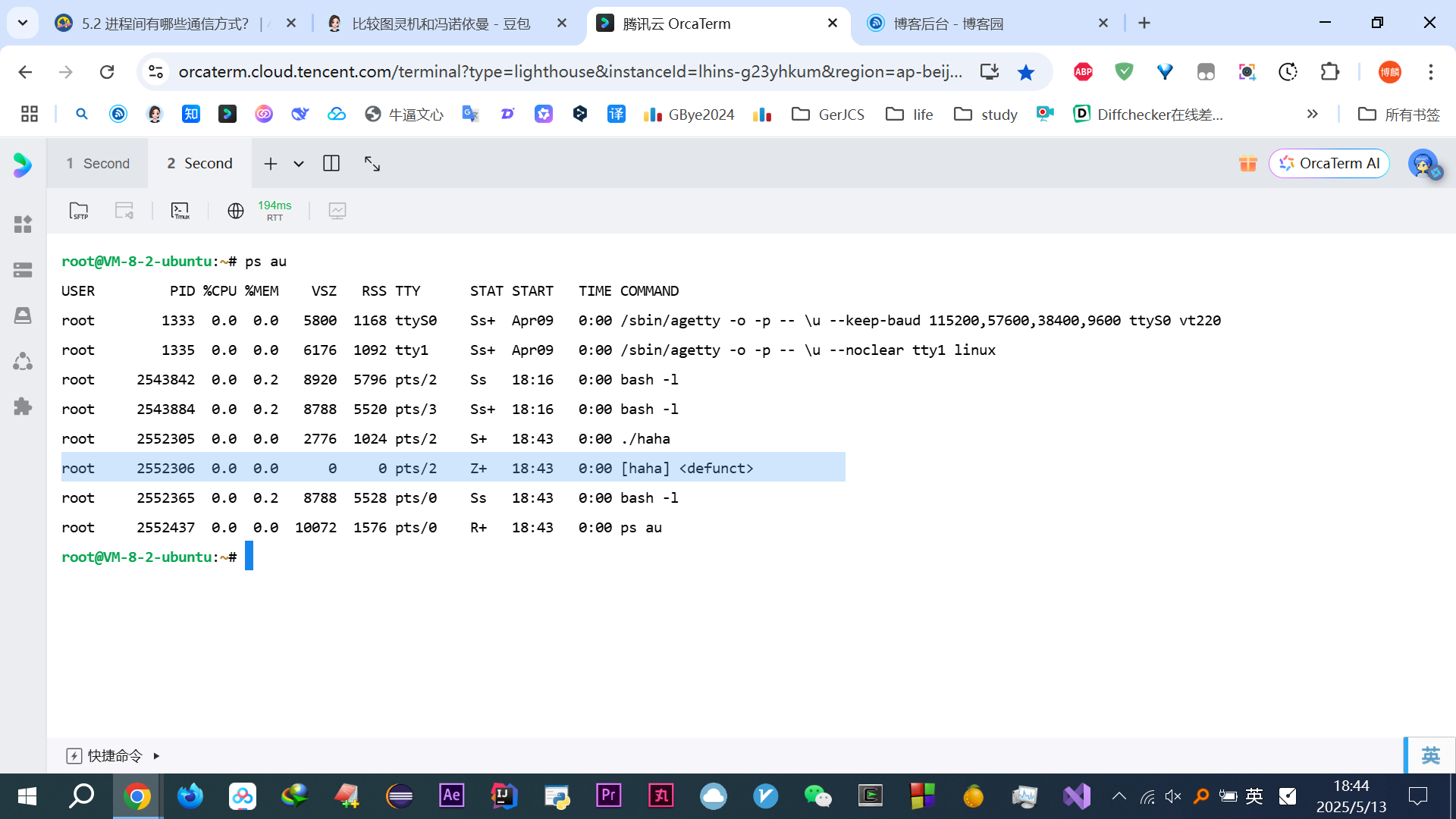

ps au可以看到Z+就是僵尸进程,尾号305是睡眠的父进程,306是没及时回收的僵尸子进程

30s后,僵尸和父进程都销毁了

另外执行的时候如果是,

./haha &就是后台执行,也就不用开新终端窗口来输入ps au了。只是前台执行的僵尸是Z+,后台执行的僵尸是Z,本质没差别不用理会开始说咋销毁僵尸进程:引入 wait 函数

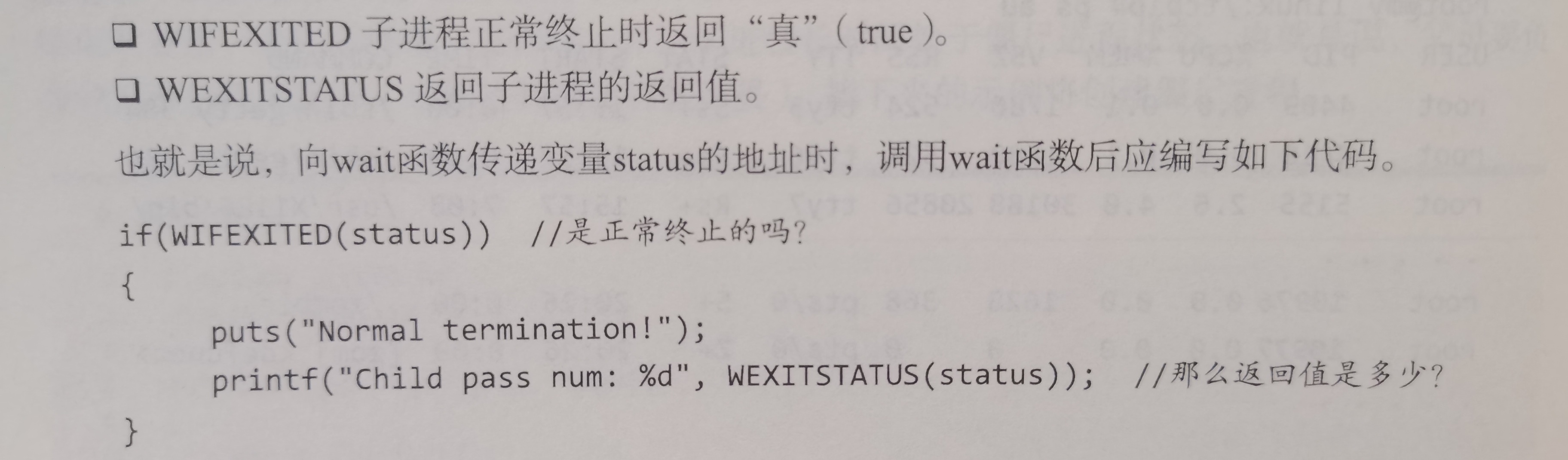

pid_t wait(int *statloc)成功返回终止的子进程ID,失败返回-1调用时如果已有子进程终止,则终止时传递的返回值(

exit或者main中return的返回值)将保存statloc指向的内存空间。但函数参数指向的内存单元中还包含其他信息,需要以下两个宏分离

来一个示例,这是书P162的代码,但不够我学的,感觉很多疑问,我自己加了很多语句

在此之前先科普基础知识:

给出我改进的代码:

PS:vim好tm难用,真他妈恶心,又没空捣鼓Linux软件,真是吐了

vim快捷键:按

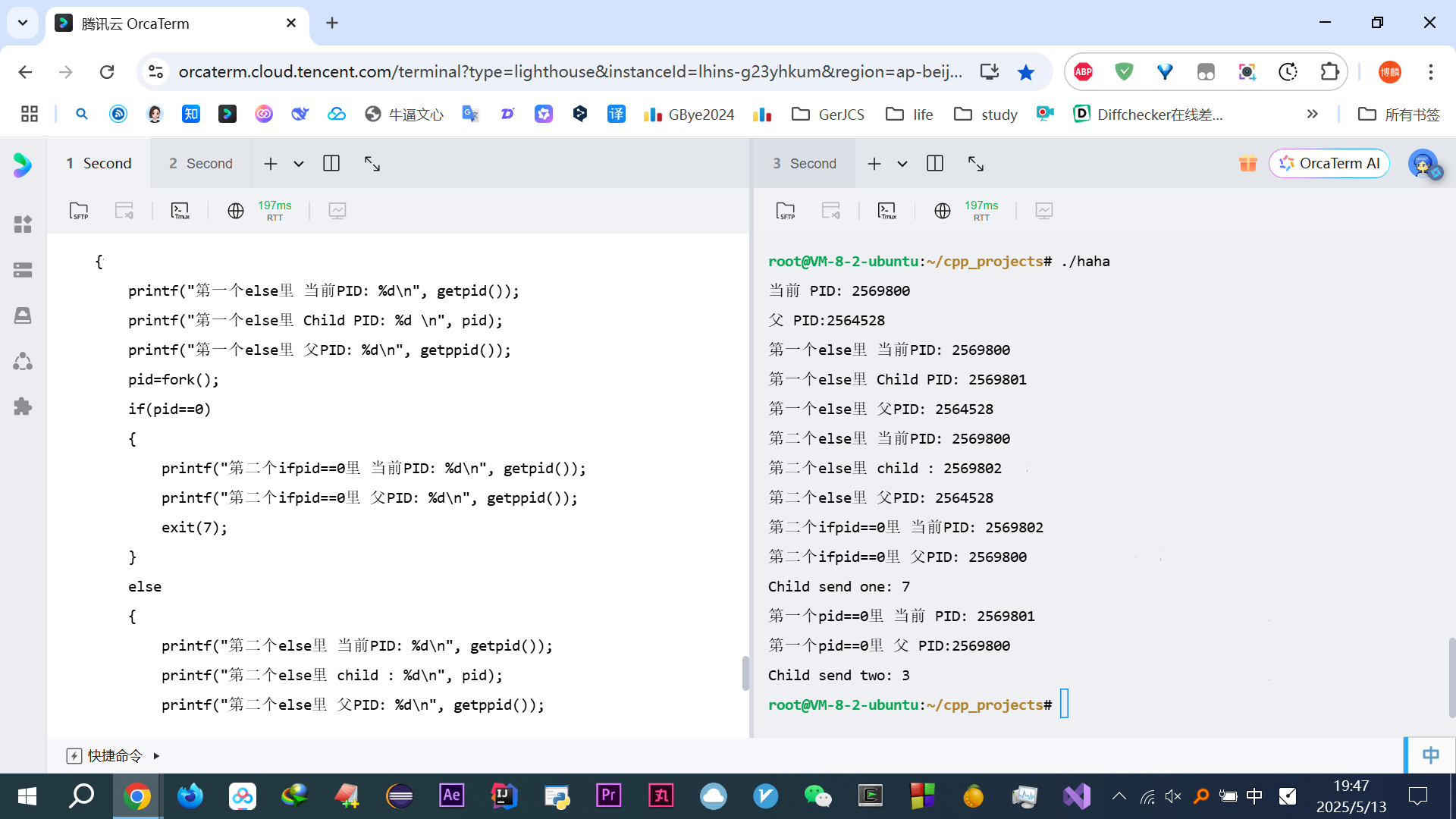

u是撤回,i编辑,v整个替换#include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <sys/wait.h> int main(int argc, char *argv[]) { printf("当前 PID: %d\n", getpid()); printf("父 PID:%d\n",getppid()); int status; pid_t pid=fork(); if(pid==0) { printf("第一个pid==0里 当前 PID: %d\n", getpid()); printf("第一个pid==0里 父 PID:%d\n",getppid()); return 3; } else { printf("第一个else里 当前PID: %d\n", getpid()); printf("第一个else里 Child PID: %d \n", pid); printf("第一个else里 父PID: %d\n", getppid()); pid=fork(); if(pid==0) { printf("第二个ifpid==0里 当前PID: %d\n", getpid()); printf("第二个ifpid==0里 父PID: %d\n", getppid()); exit(7); } else { printf("第二个else里 当前PID: %d\n", getpid()); printf("第二个else里 child : %d\n", pid); printf("第二个else里 父PID: %d\n", getppid()); wait(&status); if(WIFEXITED(status)) printf("Child send one: %d \n", WEXITSTATUS(status)); wait(&status); if(WIFEXITED(status)) printf("Child send two: %d \n", WEXITSTATUS(status)); sleep(30); // Sleep 30 sec. } } }运行结果:

这些算是我学习强迫症搞的东西吧,这个代码自己都不会再回看第二遍,但做个捋顺个总结吧,之前就是每次无数次这么弄,没总结代码,过后还是不懂,重新看还跟新的一样,浪费了好多时间~~~~(>_<)~~~~(这些话影响回顾的时候看重要知识才划掉的,并不是没用或者是错误!)

总结:

进程号本来想用行内代码的,但行内代码没法被ctrl+F搜到,不方便找相同进程

运行包含

main函数的程序时,它本质是被终端的 shell 进程启动的,main所在进程(假设 PID 为 888)的父进程就是启动它的那个进程(如 shell 进程),getppid就是用来获取这个启动它的父进程的 PID- 腾讯云服务器好像都是先执行父进程

用白话文口头语言代码梳理:

main(){

当前进程号:2569800

是由系统底层进程号为:2564528 这个shell启动搞出来的

pid_t pid=fork();后至此分两个岔,一个是父进程,一个是子进程,互不干扰

父进程:

进程号:2569800

子进程:2569801(这俩就是刚才fork()弄出来的)

父进程:2564528

pid=fork();这句导致又分出一个父子

父进程:

进程号:2569800

子进程:2569802

父进程:2564528

wait(&status); 等待任意子进程

如果正常返回

输出返回值

wait(&status); 等待任意子进程

如果正常返回

输出返回值

子进程:

进程号:2569802

父进程:2569800

exit(7);

子进程:

进程号:2569801

父进程:2569800

return 3;

}

然后这段代码实际没有我的printf测试语句,

第一个输出是:

Child send one: 7第二个输出是:

Child send two: 3这俩输出是不确定随机的

还有,30s内,

ps au是有./haha这个进程的,即主父进程:2569800,他的子进程都被回收了。30s后就都没了

wait的阻塞发生在子进程尚未终止时,父进程会暂停执行wait之后的代码。(wait是看有结束的就回收,没结束就阻塞父等待结束)

sleep的休眠发生在子进程已终止且被回收后,父进程主动暂停执行一段时间。所以都输出完,就代表回收了子进程,接下来的时间一直到30s,系统中都没有子进程的PID,只有父进程的,30s过了,连这父进程也没有了但我又有个疑问:

这里的俩wait为何放那了?else之外不行吗?就算要回收也应该一个放第一个else里,另一个放第二个else里啊,为啥俩wait都放第二个else里

无脑说肯定是为了回收,但仔细想想没搞懂啊

问豆包理解的详细分析,细节JB太多了艹:

没想到简简单单的嵌套会有真么大学完,之前刷算法题的时候,觉得没想到这些,主要那时候也用不到创建进程的事

首先说两个写法:

书里是嵌套(即我上面改进的代码,我依旧用的书里的逻辑,唯独加的是几个pirntf)

if (pid == 0) { // 第一个子进程 } else { // 父进程继续执行第二个 fork pid = fork(); if (pid == 0) { // 第二个子进程 } else { // 父进程:等待两个子进程 wait(&status); wait(&status); } }执行流程:

父进程 ── fork() ──┬── 第一个子进程(返回3) │ └── 父进程 ── fork() ──┬── 第二个子进程(返回7) │ └── 父进程(等待两个子进程)特点:

父子进程并发执行:第一个子进程创建后,父进程会立即创建第二个子进程,无需等待第一个子进程结束。

两个子进程是兄弟关系,它们的父进程相同。

而如果是分开,顺序fork

// 第一次 fork pid = fork(); if (pid == 0) { // 第一个子进程 } else { // 父进程:等待第一个子进程 wait(&status); } // 第二次 fork pid = fork(); if (pid == 0) { // 第二个子进程 } else { // 父进程:等待第二个子进程 wait(&status); }执行流程:

父进程 ── fork() ──┬── 第一个子进程(返回3) │ └── 父进程(等待第一个子进程结束) └── fork() ──┬── 第二个子进程(返回7) │ └── 父进程(等待第二个子进程结束)特点:

父子进程串行执行:父进程必须等待第一个子进程结束后,才会创建第二个子进程。

两个子进程是顺序执行的,第二个子进程的创建依赖于第一个子进程的终止。

核心区别

第一个

对比项 书中写法(嵌套) 顺序fork 子进程并发 ✅ 两个子进程可同时运行 ❌ 第二个子进程必须等第一个结束 僵尸进程风险 ❌ 无风险(父进程会 wait两次)❌ 无风险(每次 fork后立即wait)执行效率 更高(并行执行) 更低(串行执行) 代码复杂度 较高(嵌套结构) 较低(线性结构)

好了牵扯这么多,现在回答问题上,为啥俩wait必须放那!

如果两个wait,一个放到第一个else,另一个放到第二个else里?不行

if (pid == 0) { // 第一个子进程 } else { wait(&status); // 错误:父进程在此处等待第一个子进程 // 但此时第二个子进程还未创建! // 父进程继续创建第二个子进程 pid = fork(); if (pid == 0) { // 第二个子进程 } else { wait(&status); // 错误:父进程在此处等待第二个子进程 } }wait会阻塞父进程:

父进程在创建第二个子进程前,就调用

wait()等待第一个子进程结束。此时第二个子进程还未创建,父进程会一直阻塞,直到第一个子进程退出,这样就跟顺序fork一样了。违背了多进程并发的初衷

那如果将两个

wait都放在整个代码的外面?不行if (pid == 0) { // 第一个子进程 } else { // 父进程继续创建第二个子进程 pid = fork(); if (pid == 0) { // 第二个子进程 } else { // 父进程:不等待任何子进程,直接继续执行后续代码 } } // 错误:将 wait 放在整个代码块之后 wait(&status); wait(&status);

- 必须放在fork内,如果放在外头,由于父子ifelse执行没顺序,即也可能先执行的是else下的wait,那阻塞父进程就没意义,逻辑混乱

- 父进程可能先结束,因为没有这个wait阻塞,那父进程结束后子进程执行的时候,还未运行就被系统当孤儿收养

这些虽然废弃了(wait),但当值面面俱到事无巨细的心酸血泪一个字一个字啃下来的,还给书找勘误bug,有些代码逻辑写错了都,然后有不懂的拍下来问豆包,这都是相当简单的了,后面的最后一章节的windows API 根本啃不下去。何时能出头啊~~~~(>_<)~~~~

以上wait会阻塞,很不好

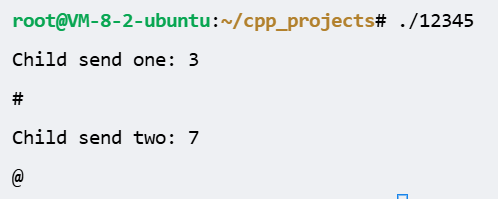

本身想写个代码验证没阻塞,结果歪打正着不仅看到是没阻塞,还是3s后同时输出的,即并行

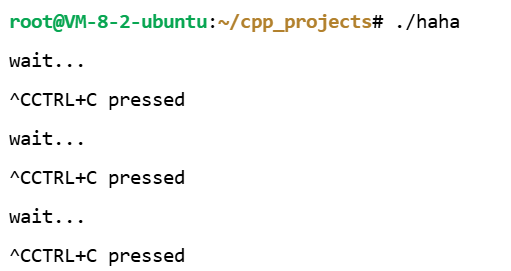

#include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <sys/wait.h> int main(int argc, char *argv[]) { int status; pid_t pid=fork(); if(pid==0) { sleep(3); return 3; } else { pid=fork(); if(pid==0) { sleep(3); exit(7); } else { wait(&status); if(WIFEXITED(status)) printf("Child send one: %d \n", WEXITSTATUS(status)); printf("#\n"); wait(&status); if(WIFEXITED(status)) printf("Child send two: %d \n", WEXITSTATUS(status)); printf("@\n"); } } }执行结果:

好了,现在开始引入waitpid,成功返回终止的子进程ID或者0,失败返回-1

pid_t waitpid(

第一个参数:等待终止的目标进程ID,如果-1,则与wait一样,等待任意进程、

第二个参数:statloc,跟wait一样、

第三个参数:sys/wait.h头文件声明的常量WNOHANG,表示没终止的返回0退出,不阻塞 )

书P164代码改了次数个时间:

#include <stdio.h> #include <unistd.h> #include <sys/wait.h> int main(int argc, char *argv[]) { int status; pid_t pid = fork(); if (pid == 0) { sleep(5); return 24; } else { while (!waitpid(-1, &status, WNOHANG)) { sleep(2); puts("sleep 2sec."); } if (WIFEXITED(status)) printf("Child send %d \n", WEXITSTATUS(status)); } }运行结果:

看出没阻塞

好了哔哔了这么多,开始引出信号处理

防止调用 waitpid 后无休止等待,需要向os求助

“嘿,父进程,你创建的子进程终止了”此时父进程放下手头的活,处理终止事宜,所以引入信号处理机制(signal handling)

唉,当时没总结,跟新学一样~~~~(>_<)~~~~,好痛苦,时间全浪费了

信号处理有俩函数:

先说signal函数(后来得知又是一个废弃的玩意)

但还要再先说函数指针,

即指向函数的指针,是一个变量,比普通指针更加灵活,用于传递函数的场景

拆分理解:

void (*ptr)(int) = &fun

void (*ptr)(int):声明一个名为

ptr的函数指针,它指向的函数需满足:

返回值类型:

void(无返回值)。参数列表:

(int)(接受一个int类型参数)。

= &fun:将函数

fun的地址赋值给ptr。&取地址符可省略,直接写fun也等效用法:

普通指针: // 定义函数 void fun(int x) { printf("Value: %d\n", x); } 函数指针: // 直接调用 fun(42); // 输出: Value: 42 // 声明并初始化函数指针 void (*ptr)(int) = &fun; // 或直接写 ptr = fun; // 通过指针调用函数 ptr(42); // 等价于 fun(42)signal原型:

void ( * signal (

int signo, void ( * func )( int )) ) ( int );函数名:signal

参数:

int signo,void ( * func )( int )返回值类型:参数类型int,返回void型函数指针

signo是信号编号(如

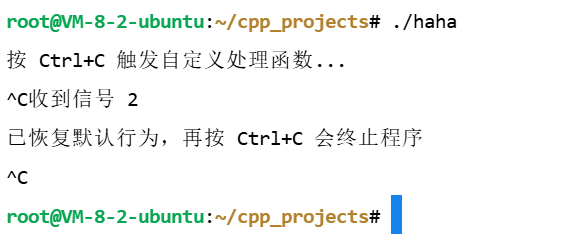

SIGINT、SIGTERM)。#include <signal.h> #include <stdio.h> #include <unistd.h> void my_handler(int signum) { printf("收到信号 %d\n", signum); } int main() { void (*old)(int) = signal(SIGINT, my_handler); printf("按 Ctrl+C 触发自定义处理函数...\n"); // 等待信号(使用 pause() 让程序暂停) pause(); // 程序会在此处阻塞,直到收到信号 signal(SIGINT, old); printf("已恢复默认行为,再按 Ctrl+C 会终止程序\n"); pause(); // 再次等待信号,验证恢复效果 }运行结果:(^C是我按下的CTRL+C)

以上这是连书上都没提到的东西,豆包妈逼的给我扯出来了,被迫学了下

signal函数的返回值是 之前的信号或者说原信号处理函数的指针,用于恢复默认行为

my_handler其实就是void( * func )( int ),麻痹的简简单单一个函数,写成原型就这么复杂,艹,早知道不去钻研理解原型这个破逼玩意了

上面的

void (*old)(int) = signal(SIGINT, my_handler);是义了一个函数指针变量,void (*old)(int)这部分代码声明了一个名为old的变量,它的类型是void (*)(int),即指向 “参数为int、返回值为void的函数” 的指针 。old用于接收signal函数返回的原信号处理函数指针,即终止进程执行并退出后面实际调用:

signal(SIGINT, old); // 恢复默认行为(正确方式)

上面的

signal本身是函数,用于注册信号处理函数,但返回值是指针,指向原信号处理函数

小知识:

// 定义了一个函数指针类型 SignalHandler,它指向的函数无返回值,接收一个int类型参数 typedef void (*SignalHandler)(int); // signal函数声明,它接收一个信号编号signum和一个SignalHandler类型(即函数指针类型)的参数handler SignalHandler signal(int signum, SignalHandler handler);在上述代码中,

typedef关键字用于给void (*)(int)这个函数指针类型起了个别名SignalHandler,后续使用SignalHandler就等同于使用void (*)(int)这种函数指针类型以上只是说函数指针这个东西

开始说

signal,说几个内核注册好的信号:SIGINT:输入CTRL+C

SIGCHLD:子进程终止

SIGALRM:已到通过调用alarm函数注册的时间,结合alarm用,alarm()是系统定义好的,传递

unsigned int seconds时间到了就产生SIGALRM信号书P168代码:

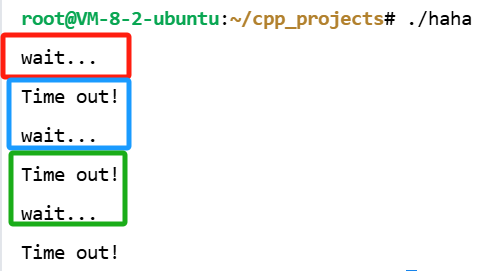

#include <stdio.h> #include <unistd.h> #include <signal.h> void timeout(int sig) { if(sig==SIGALRM) puts("Time out!"); alarm(2); } void keycontrol(int sig) { if(sig==SIGINT) puts("CTRL+C pressed"); } int main(int argc, char *argv[]) { int i; signal(SIGALRM, timeout); signal(SIGINT, keycontrol); alarm(2); for(i=0; i<3; i++) { puts("wait..."); sleep(100); } }运行结果:

代码里

signal的返回值(原处理函数指针)被隐式丢弃了,未赋值给变量解析代码:

先

alarm定时2s输出红框的,开始sleep100s,2s到了,就中断sleep,alarm发送SIGALRM信号,开始触发执行

timeout函数,输出蓝色框内容,然后

timeout里又定时2s,这时timeout函数执行完了,回到sleep那,但注意,sleep被中断后,再次回来是返回剩余未休眠的98s,但不继续sleep了,开始从sleep下一行代码执行!即for循环那所以又输出了wait,至此都是蓝色框的内容

然后2s再次触发,绿色框输出,至此for是最后一次循环了

sleep被唤醒后,time out,再回来就出for了,程序结束了

好了,这是啥也不干自己执行,但如果连续CTRL+C会连1s都不到就结束,如下

但这种代码过于傻逼,100s没意义,追问豆包给出的改进:

for(i=0; i<3; i++) { puts("wait..."); // 打印提示 alarm(2); // 设置2秒后触发 SIGALRM pause(); // 暂停程序,直到收到任意信号 }之前一直无脑用pause(),现在细致了解下:

pause()是一个系统调用,其作用是让进程暂停执行,进入睡眠状态,直到收到任意信号,这里输出wait后,定时2s,暂停程序(pause),2s后SIGALRM触发,timeout输出,又定时2s,

pause()返回(被信号中断,即不再暂停),继续下一轮循环注意:这里是先2s收到SIGALRM,然后pause就不再暂停了,本打算继续执行下面的for,但被拐去执行timeout了,等执行完回来就继续for

小知识:

errno是全局变量,存放错误码

EINTR是<errno.h>预定义的宏常量错误码,常见于pause()、sleep()、read()等阻塞函数被信号打断时当

pause()被信号中断,返回-1,errno被自动设为EINTRpause()暂停期间不返回,直到信号到达后恢复执行并返回 - 1,而中断指的是不再执行,比如不再sleep即不再睡眠,即唤醒,再比如pause()不再暂停pause()返回:

- 一旦信号被处理完毕,

pause()立即返回-1,并将errno设置为EINTR(表示被信号中断)。- 程序从

pause()语句的下一行继续执行(即跳出暂停状态)#include <stdio.h> #include <unistd.h> #include <signal.h> #include <errno.h> void timeout(int signum) { // 信号处理函数 printf("Time out!\n"); alarm(2); } int main() { int i; signal(SIGALRM, timeout); for (i = 0; i < 3; i++) { puts("wait..."); alarm(2); int ret = pause(); if (ret == -1 && errno == EINTR) { // 处理被信号中断的情况 printf("pause was interrupted by a signal.\n"); } } return 0; }

好了,再出第二个

sigaction函数这个可以完全代替前者:

singal在UNIX系列的不同os可能存在差别,sigaction完全相同。singal只用在旧程序的兼容上!

int sigacion(第一个参数:int signo传递信号信息比如:SIGALRM,第二个参数:对应第一个参数的信号处理函数信息,本质是指向

struct sigaction的结构体,第三个参数:获取之前注册的信号处理函数指针,不需要就写0)成功返回 0,失败返回 -1

声明初始化

sigaction结构体变量调用上述函数struct sigaction { void (*sa_handler)(int);//保存自定义函数指针 sigset_t sa_mask;//初始化为0即可 int sa_flags;//初始化为0即可 };书P170代码示例:

操作信号不用memset,

sigemptyset是信号集专用初始化函数,用于清空信号集,比memset更适配信号集且类型安全、可移植性好、语义清晰#include <stdio.h> #include <unistd.h> #include <signal.h> void timeout(int sig) { if(sig==SIGALRM) puts("Time out!"); alarm(2); } int main(int argc, char *argv[]) { int i; struct sigaction act; act.sa_handler=timeout; sigemptyset(&act.sa_mask); act.sa_flags=0; sigaction(SIGALRM, &act, 0); alarm(2); for(i=0; i<3; i++) { puts("wait..."); sleep(100); } }执行结果一样,很容易理解

再说下利用信号处理消灭僵尸进程

P170代码,看的我眼直花,

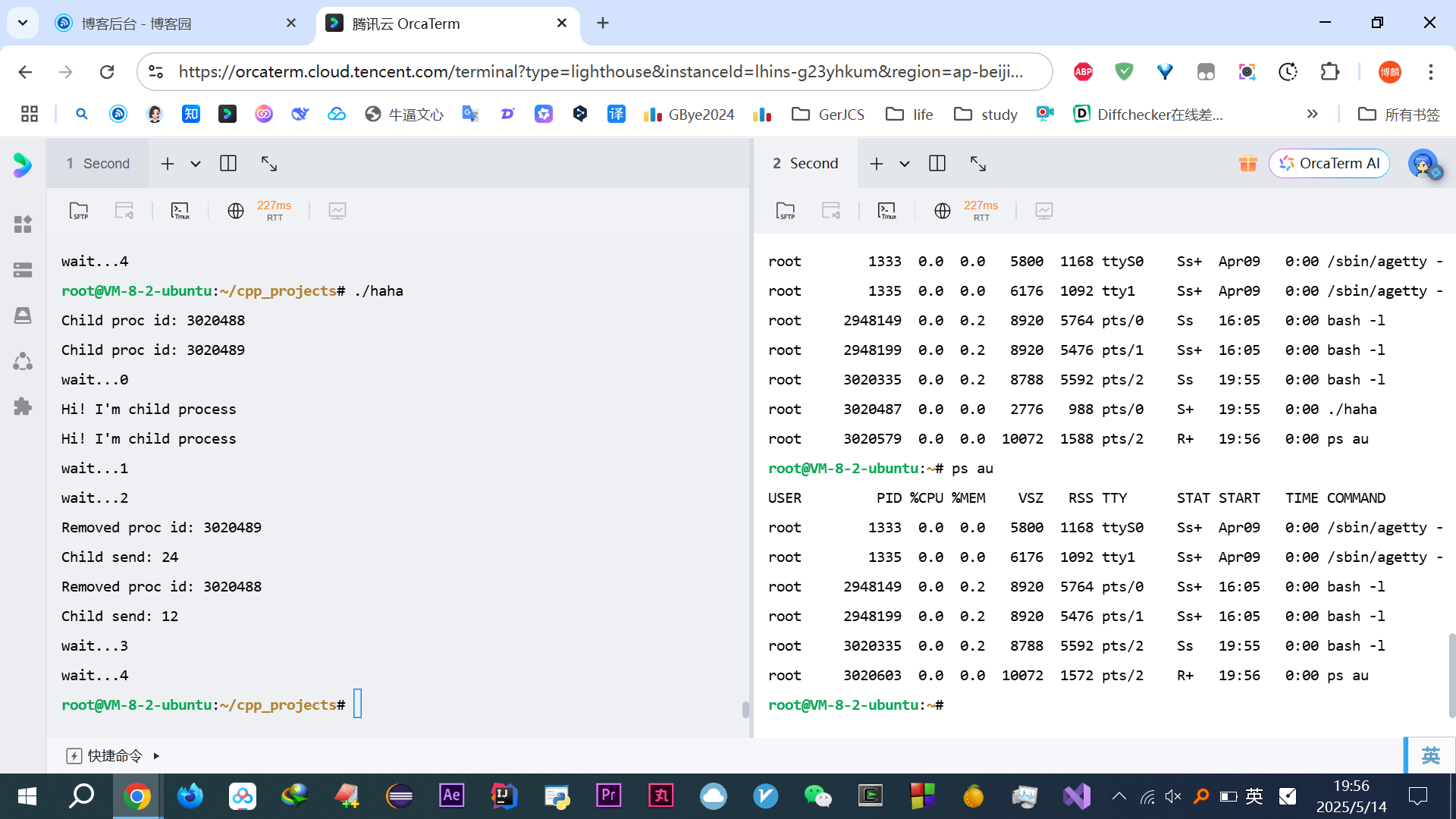

wait加了个序号,看着舒服多啦#include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <signal.h> #include <sys/wait.h> void read_childproc(int sig) { int status; pid_t id=waitpid(-1, &status, WNOHANG); if(WIFEXITED(status)) { printf("Removed proc id: %d \n", id); printf("Child send: %d \n", WEXITSTATUS(status)); } } int main(int argc, char *argv[]) { pid_t pid; struct sigaction act; act.sa_handler=read_childproc; sigemptyset(&act.sa_mask); act.sa_flags=0; sigaction(SIGCHLD, &act, 0); pid=fork(); if(pid==0) /*子进程执行区域*/ { puts("Hi! I'm child process"); sleep(10); return 12; } else /*父进程执行区域*/ { printf("Child proc id: %d \n", pid); pid=fork(); if(pid==0) /*另一子进程执行区域*/ { puts("Hi! I'm child process"); sleep(10); exit(24); } else { int i; printf("Child proc id: %d \n", pid); for(i=0; i<5; i++) { printf("wait...%d\n",i); sleep(5); } } } }没啥好说的,直接对着输出解释:

我输出的时候开了另一个终端,来在这运行期间不停的

ps au发现始终没Z僵尸,说明被回收了

运行结果:

PS:由于进程父子先后运行不确定,多核下并行

很多种输出,但掌握一个是中断再返回sleep就不再睡眠未睡眠的时间了,一个是信号处理,就都可以解释所有的输出结果

先是.

/haha,敲回车立马输出红框等待5s,立马输出黄框:wait...1

再等待5s(至此累计了10s了),立马输出蓝框

然后等待5s,结束

解释下为何蓝色框一下子输出这么多:

由于输出不确定,这个不确定指的是,多核运行的时候,代码写了10s子进程结束,一个返回12、一个返回24,

麻痹的知识点真他妈多,插一嘴return和exit(傻逼玩意豆包解释的一塌糊涂,等实际用到再说吧)

- 在

main函数中:return和exit都终止进程;在其他函数中:return返回调用点,exit直接终止进程继续解释,一个返回12、一个返回24,所以10s一到,同时输出,但显示屏依旧会有先有后,不可能重叠重影输出

所以5s一到,先来了个输出wait..2,这是sleep(5),本该睡眠的,但子进程24的那个,结束了,就去执行

read_childproc函数,再返回sleep就不继续后续的未睡眠的时间了,直接下一个for,所以又wait...3,但计算机执行这些都是很快的,目前依旧处于10s的时刻,继续该另一个子进程12的那个,结束就会执行read_childproc函数,所以输出Removed后,返回来sleep又不继续睡眠了,再次下一轮for,立马输出wait...4,此时睡眠5s,结束

妈逼的终于说完了好累~~~~(>_<)~~~

信号

现在再看小林coding,

kill -l 命令,查看所有的信号

用 kill 命令给进程发信号,比如:

kill -9 1050 ,表示给 PID 为 1050 的进程发送 SIGKILL 信号,用来立即结束该进程;

- 产生方式:

- SIGKILL:一般由

kill -9命令发送 。 - SIGINT:常通过在终端按

Ctrl + C产生 。 - SIGTSTP:通常由在终端按

Ctrl + Z触发 。

- SIGKILL:一般由

- 对进程的影响:

- SIGKILL:强制结束进程,进程无法捕获、忽略该信号,不能执行清理操作,直接终止 。

- SIGINT:请求进程终止,进程可捕获、忽略此信号,收到后一般会执行清理操作再退出 。

- SIGTSTP:使进程停止(挂起),进程可处理或忽略,挂起后进程可再恢复运行 。

- 使用场景:

- SIGKILL:用于进程无响应或存在安全威胁,需强行终止时 。

- SIGINT:手动中断前台运行任务 。

- SIGTSTP:想暂时停止进程,之后再继续运行的场景

所以,信号事件的来源主要有硬件来源(如键盘 Cltrr+C )和软件来源(如 kill 命令)

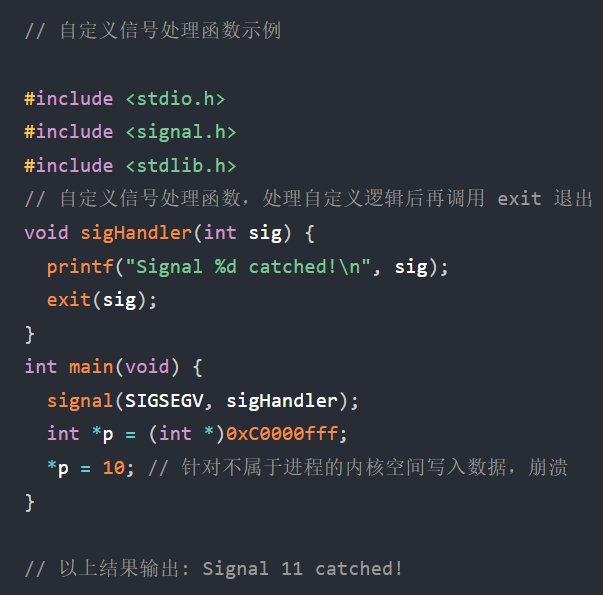

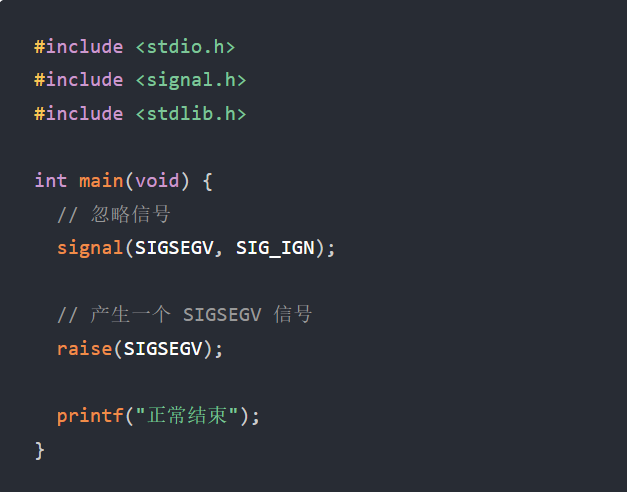

1.执行默认操作:Linux的规定的比如上面这些

2.捕捉信号:自定义的

3.忽略信号:但 SIGKILL 强制中止立即杀死进程、 SEGSTOP暂停进程,这俩应用进程无法捕捉和忽略的

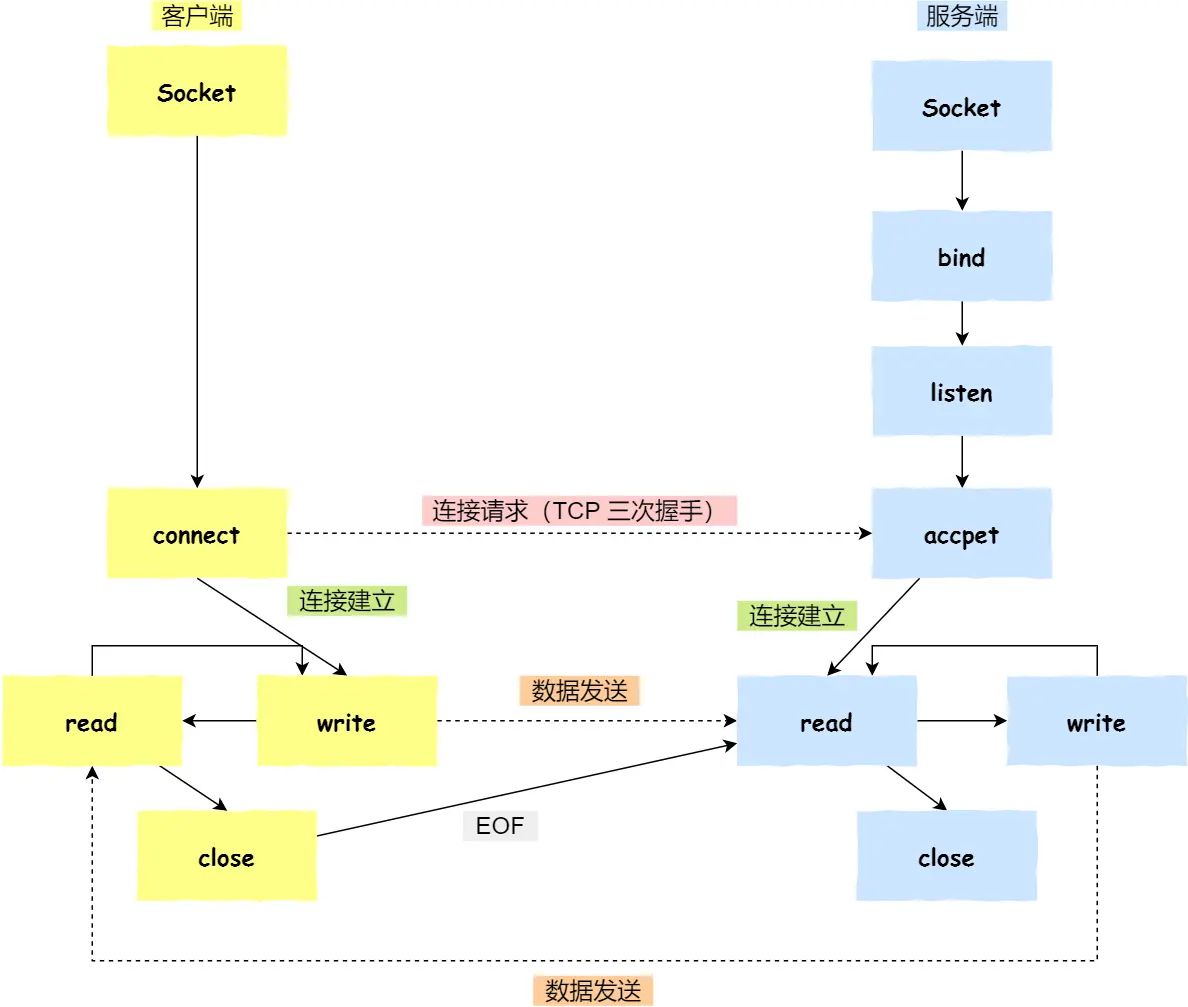

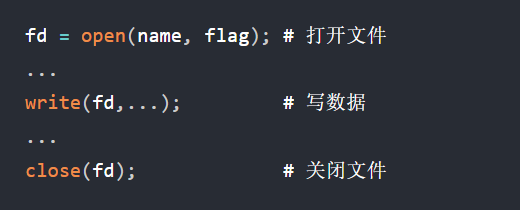

socket

这玩意TCPIP网络编程啃烂了都

Socket 通信不仅可以跨网络与不同主机的进程间通信,还可以在同主机上进程间通信

int socket(int domain, int type, int protocal)-

domain 参数用来指定协议族,比如 AF_INET 用于 IPV4、AF_INET6 用于 IPV6、AF_LOCAL/AF_UNIX 用于本机;

-

type 参数用来指定通信特性,SOCK_STREAM表示字节流(TCP),SOCK_DGRAM 表示的是数据报(UDP),SOCK_RAW 表示的是原始套接字;

-

protocal 参数原本是用来指定通信协议的,但现在基本废弃。写0

创建socket类型的不同,通信方式也不同:

-

实现 TCP 字节流通信: socket 类型是 AF_INET 和 SOCK_STREAM

-

实现 UDP 数据报通信:socket 类型是 AF_INET 和 SOCK_DGRAM

-

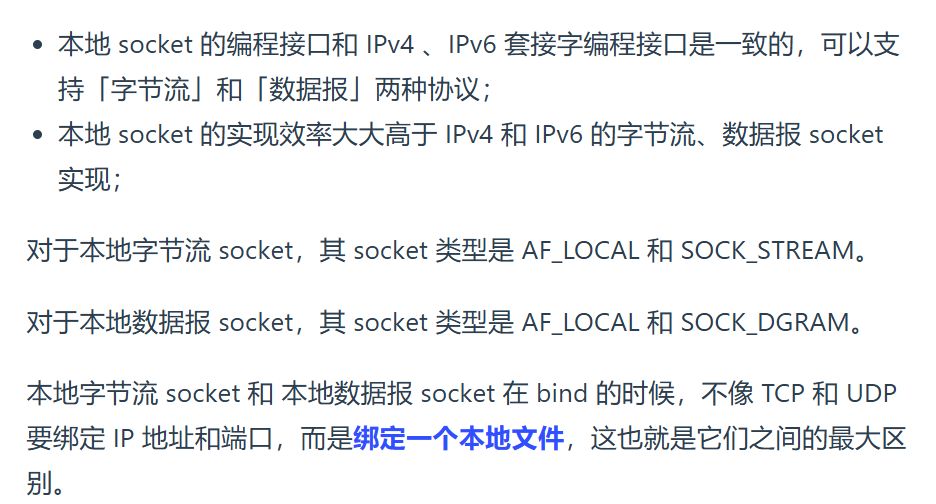

实现本地进程间通信:

「本地字节流 socket 」类型是 AF_LOCAL 和SOCK_STREAM

「本地数据报 socket 」类型是 AF_LOCAL 和SOCK_DGRAM

另外,AF_UNIX 和 AF_LOCAL 是等价的,所以 AF_UNIX也属于本地 socket;

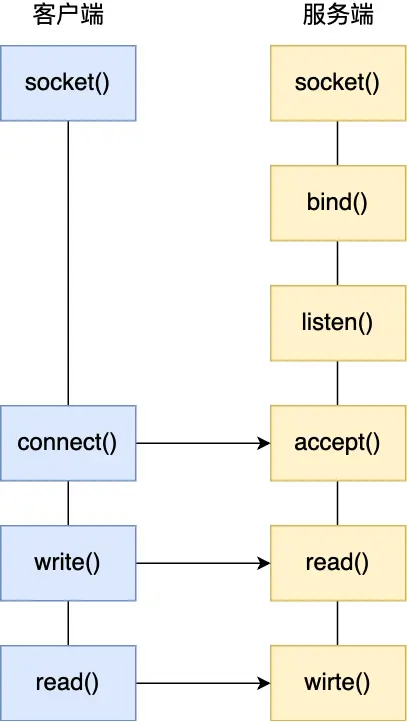

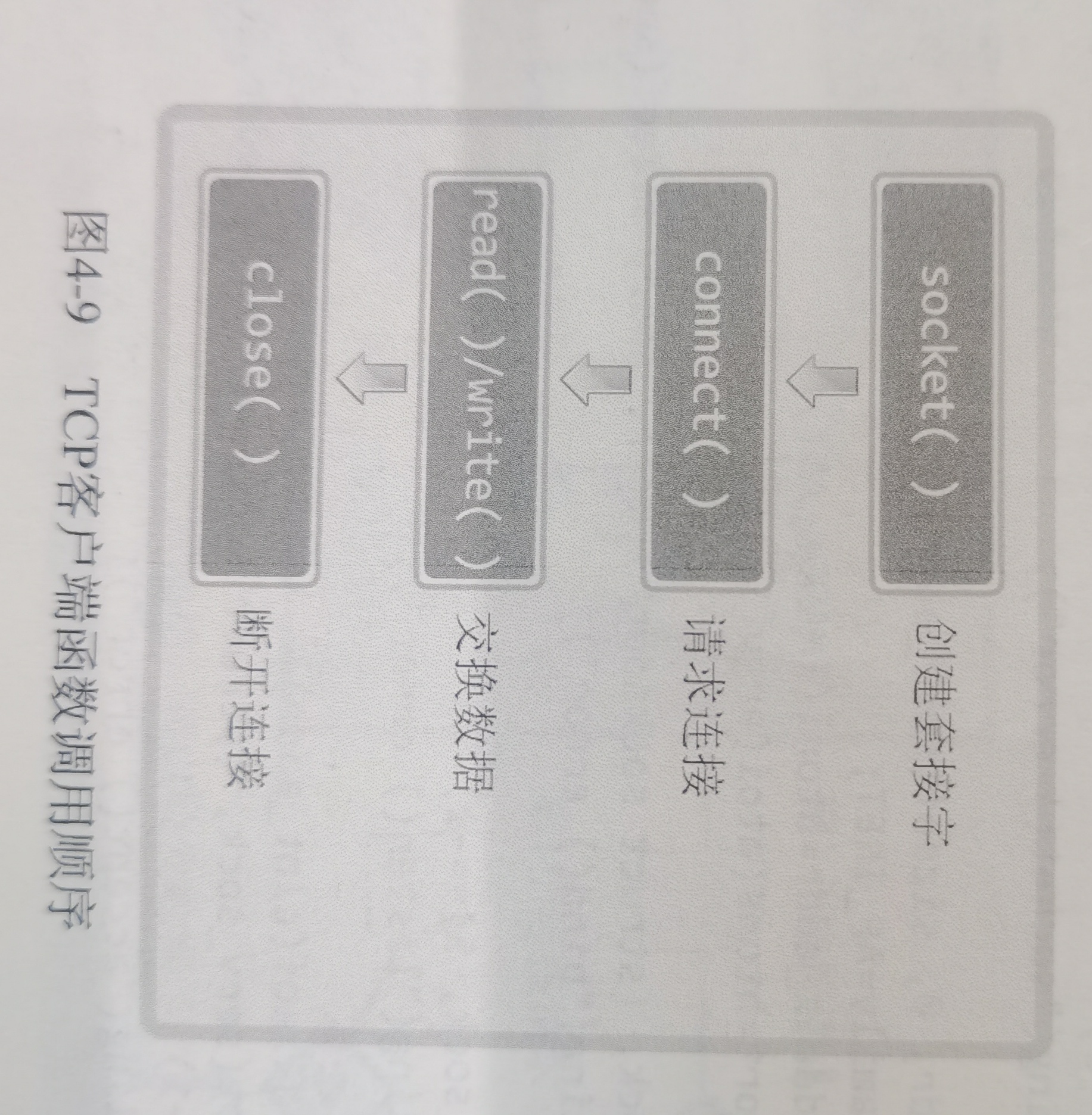

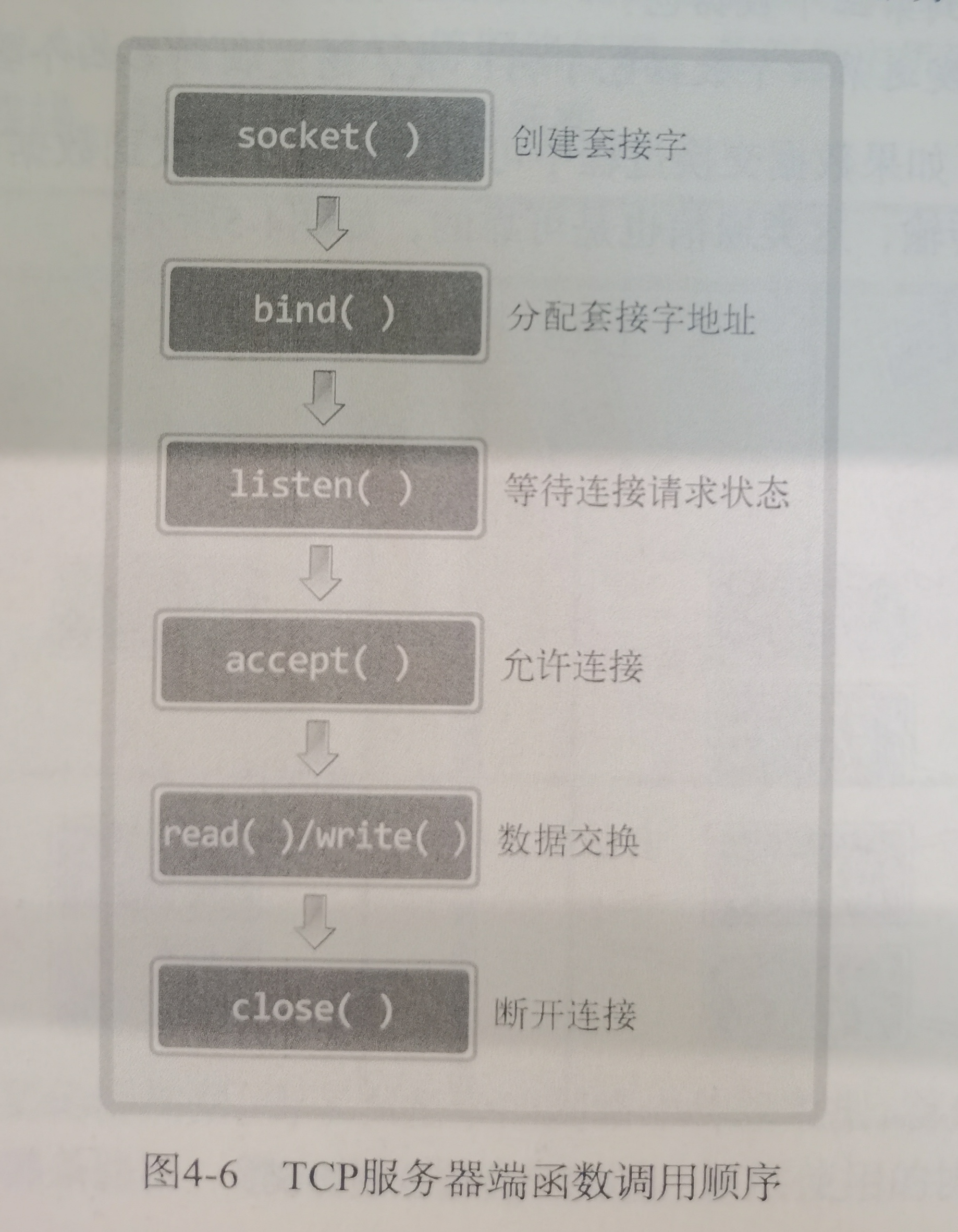

流程:

TCP 协议通信的 socket 编程模型

说实话这图挺傻逼,挺鸡巴智障太死板了

-

服务端和客户端初始化

socket,得到文件描述符 -

服务端调用

bind,将绑定在 IP 地址和端口; -

服务端调用

listen,进行监听;至此有了监听socket -

服务端调用

accept,等待客户端连接; -

客户端调用

connect,向服务器端的地址和端口发起连接请求,那这时候服务端的accept就返回了;至此有了已完成连接socket -

服务端

accept返回用于传输的socket的文件描述符 -

客户端调用

write写入数据;服务端调用read读取数据 -

客户端断开连接时,会调用

close,那么服务端read读取数据的时候,就会读取到了EOF,待处理完数据后,服务端调用close,表示连接关闭

总共俩socket

UDP 协议通信的 socket 编程模型

唉,真垃圾,我啃TCPIP网络编程白瞎了,没做整理总结~~~~(>_<)~~~~

算了吧,这再也不去回顾傻乎乎的啃书了,比如之前的wait各种都是废弃的,还强迫症的去研究,今天还二次研究,我只搞小林coding里的,没写就不弄了,毕竟这些应试垃圾狗最面向找工作了。之前吴师兄公众号:《大家刷题都是自己写出来的吗》?小林coding只思考10min,山理acm金牌金泽宇,辅导北邮L雪T也讲过,给北邮集训队那个之前说过贴吧的。唉,这一生

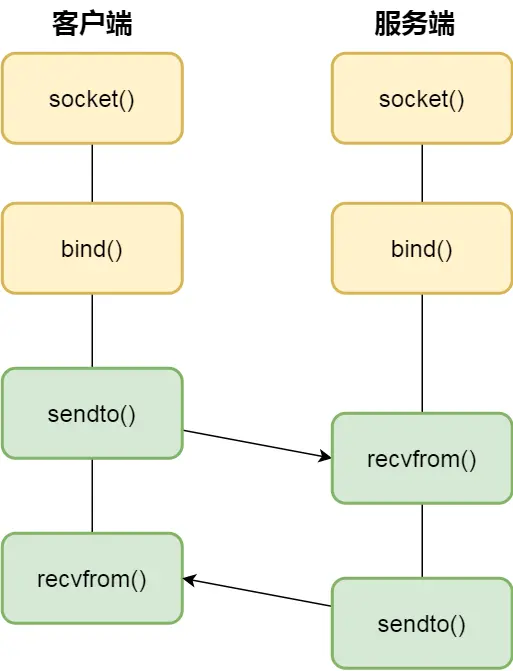

没客户端服务端概念,每一个 UDP 的 socket 都需要 bind

每次通信时,调用 sendto 和 recvfrom,都要传入目标主机的 IP 地址和端口

本地进程间通信的 socket 编程模型

同一台主机上进程间通信的场景

以上都是进程通信方式,而线程通信间的方式,即同个进程下的线程之间都是共享进程的资源,只要是共享变量都可以做到线程间通信,比如全局变量,所以对于线程间关注的不是通信方式,而是关注多线程竞争共享资源的问题,信号量也同样可以在线程间实现互斥与同步

- 互斥的方式,可保证任意时刻只有一个线程访问共享资源;

- 同步的方式,可保证线程 A 应在线程 B 之前执行;

如何解决多线程冲突(开始深入,会继续深入说互斥量、信号量、信号那些)

线程是调度的基本单位,进程则是资源分配的基本单位

所以,线程之间是可以共享进程的资源,比如代码段、堆空间、数据段、打开的文件等资源,但每个线程都有自己独立的栈空间

妈逼的看头的例子真的有病

妈逼的这块东西我在TCPIP网络编程都学完了,上一章互斥量5.2的时候就强迫回顾了TCPIP网络编程里的,包括了这块内容

这块不看了,快速无脑整理下吧,免得有遗漏

互斥:

解决了并发进程/线程对临界区的使用问题,只要一个进程/线程进入了临界区,其他试图想进入临界区的进程/线程都会被阻塞着,就像上面搜“想个东西:”里说的,

同步:

就是并发进程/线程在一些关键点上可能需要互相等待与互通消息,这种相互制约的等待与互通信息称为进程/线程同步,即有效秩序的唤醒

为了实现进程/线程并发执行协作的关系:互斥、同步,引入:锁头 & 信号量(PV操作)

先说锁:

根据锁的实现不同,分为「忙等待锁」和「无忙等待锁」

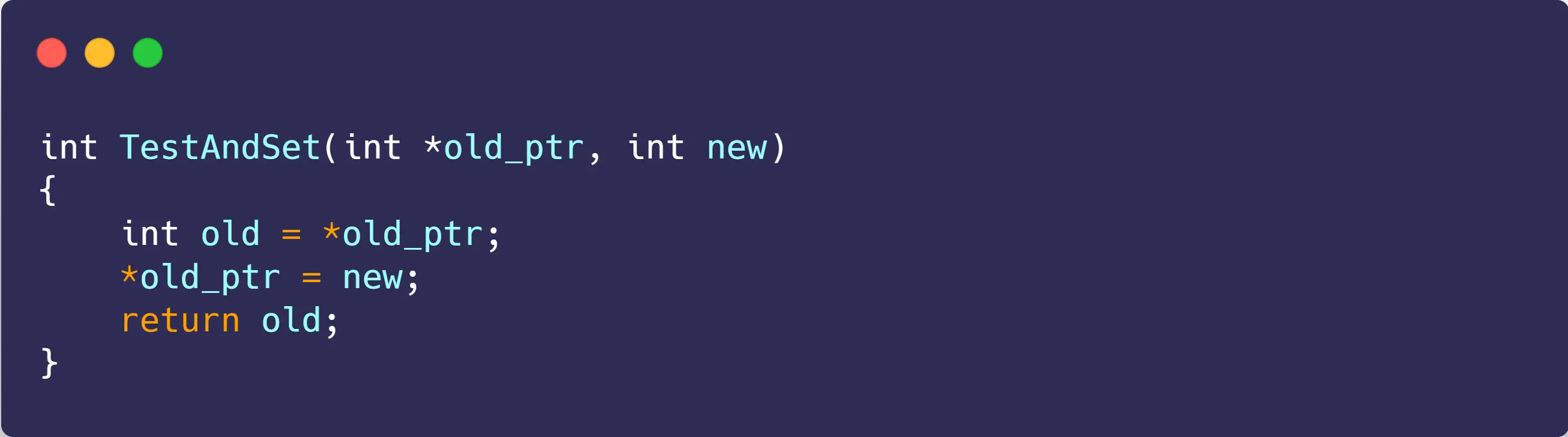

说之前先介绍现代CPU体系结构,提供的原子操作指令 —— 测试和置位指令(Test-and-Set)

- 把

old_ptr更新为new的新值 - 返回

old_ptr的旧值;

既可以测试旧值,也可以设置新值,原子操作

忙等待锁 —— 自旋锁(spin lock):

妈逼的开始再次了解指针

这群人写代码好像没有指针活不了,我最讨厌指针了!

解释指针:

init函数参数是结构体指针(lock_t *lock),而非结构体本身。这样设计的目的是直接修改原结构体的值,而非传副本。若传结构体,函数内操作的是副本,无法影响原结构体,指针传递可直接操作内存中的原始数据

关于

init函数里没有&在

init函数void init(lock_t *lock)中,lock本身已经是一个指针了,lock->flag意思是通过指针去访问结构体成员 。这里不需要再用&取地址,因为lock指针已经指向了结构体变量所在的内存地址,直接通过它就能定位到结构体及里面的成员变量flag,然后对flag赋值0

关于

&lock->flag中&的作用

&是取地址运算符 。在这里lock是指向lock_t结构体的指针,lock->flag访问结构体中的flag成员变量,&lock->flag就是获取flag这个变量在内存中的地址 。TestAndSet函数需要传入flag变量的地址,这样才能直接在内存中对flag的值进行操作(比如修改它的值等),实现原子操作功能

解释代码:

-

数据结构定义

-

typedef struct lock_t:定义了一个名为lock_t的结构体,包含一个整型成员flag,用于表示锁的状态(0 表示未锁定,1 表示已锁定)。

-

-

初始化函数

init-

void init(lock_t *lock):将锁的flag初始化为 0,表示锁处于未锁定状态。

-

-

加锁函数

lock-

void lock(lock_t *lock):通过while循环调用TestAndSet(&lock->flag, 1)进行加锁。-

TestAndSet将flag设置为 1 并返回其旧值。 -

若旧值为 1,说明锁已被占用,线程继续循环(忙等待);若旧值为 0,说明成功获取锁,退出循环。(0==1不成立所以退出循环的,一开始我在while循环这看懵了)

-

-

-

解锁函数

unlock-

void unlock(lock_t *lock):将flag设为 0,表示释放锁,其他等待的线程可尝试获取

-

自旋锁会一直自旋,利用 CPU 周期,直到锁可用

在单处理器上,需要抢占式的调度器(即不断通过时钟中断一个线程,运行其他线程)。否则,自旋锁在单 CPU 上无法使用,因为一个自旋的线程永远不会放弃 CPU。

这里“时钟中断停止线程” 指的是停止正在自旋(执行 lock 函数里 while 循环 )的线程 。这个 while 循环在持续占用 CPU 检查锁状态 ,若无时钟中断干预,它会一直执行。

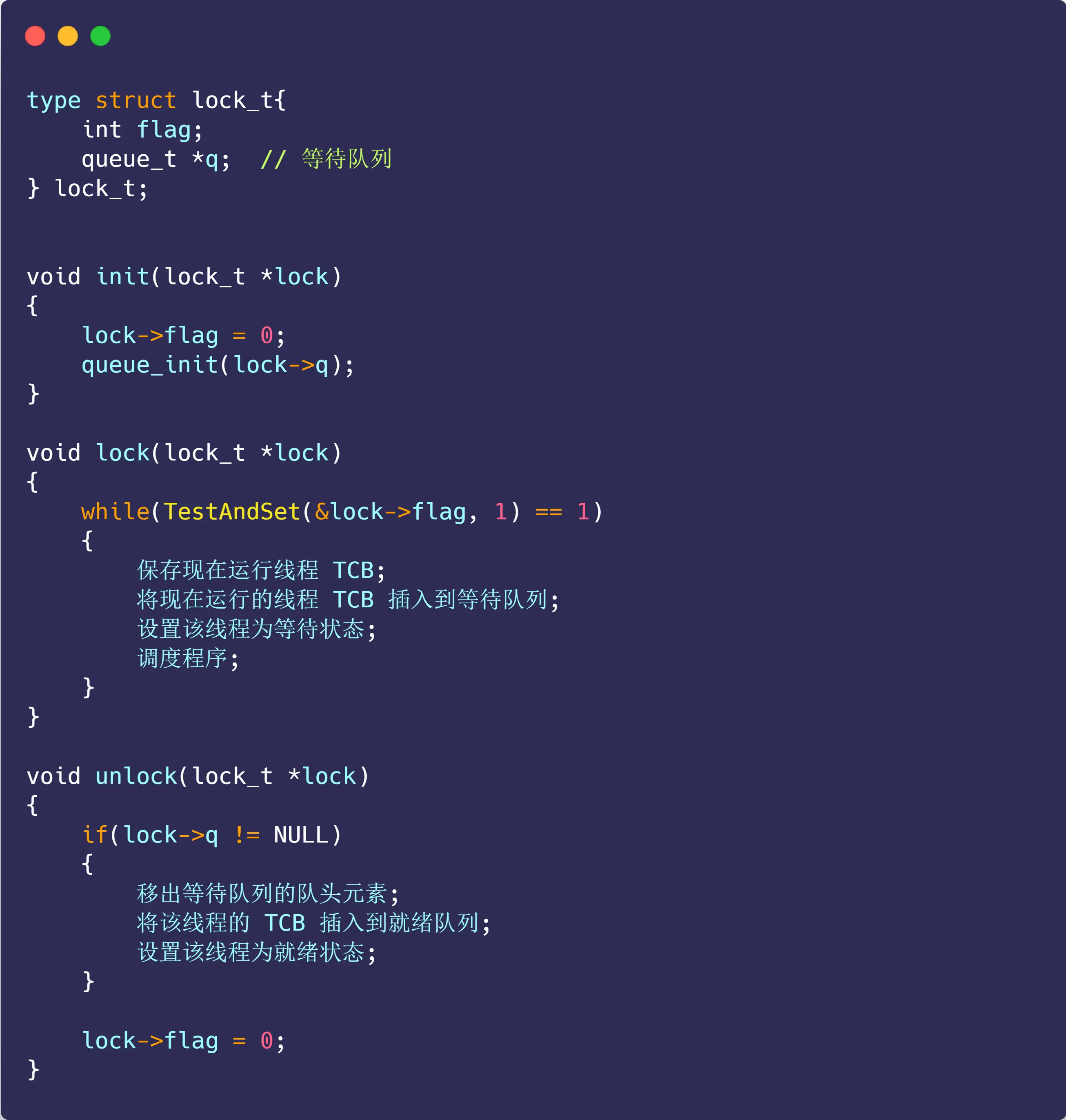

无等待锁:

当没获取到锁的时候,就把当前线程放入到锁的等待队列,然后执行调度程序,把 CPU 让给其他线程执行

好傻逼,比TCPIP网络编程里的还古老(是把TCPIP网络编程尹圣雨书里说的API底层实现展开出来了),而且这玩意豆包说不是无等待锁,只是优化版本的自旋锁

解释几个基础知识:

queue_init是队列初始化函数 。作用是初始化队列相关属性

queue_init(lock->q);是初始化lock_t结构体中名为q的等待队列

lock->q表示通过指针lock访问lock_t结构体中的q成员 。q是一个等待队列 ,用于存放等待获取锁的线程相关信息

if (lock->q != NULL)意图判断等待队列是否存在(不为空指针 )

再说下尹圣雨TCPIP网络编程书P300 介绍的互斥量:(正了八经的无等待锁)正儿八经,正经八百,正经八本

(注:互斥量和锁其实不用太区分,不严谨的说法但有助于理解的说法:互斥量就是一种锁机制实现)

PS:pthread_mutex_t 是 POSIX 线程库中用于定义互斥锁变量的类型

为了创建锁系统的互斥量,需要先声明个pthread_mutex_t型的变量:pthread_mutex_t mutex;

然后开始创建:pthread_mutex_init( &mutex,即互斥量变量的地制值, 传递属性,没有就传 NULL)。成功返回 0,失败返回其他值

pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER; 用这个宏自动初始化,等效 init函数

加锁:pthread_mutex_lock( & mutex)(看似是一个lock但底层实现复杂,不用一直while检查锁状态,不放弃 CPU,若锁可用,直接获取;不可用时,线程通常会进入睡眠状态放弃 CPU,由内核调度)。成功返回 0,失败返回其他值

for(循环10次)

num+=1;

解锁:pthread_mutex_unlock( & mutex)。成功返回 0,失败返回其他值

最后销毁:pthread_mutex_destroy( & mutex),成功返回 0,失败返回其他值

完整解决代码:

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <pthread.h>

#define NUM_THREAD 100

void * thread_inc(void * arg);

void * thread_des(void * arg);

long long num=0;

pthread_mutex_t mutex;

int main(int argc, char *argv[])

{

pthread_t thread_id[NUM_THREAD];

int i;

pthread_mutex_init(&mutex, NULL);

for(i=0; i<NUM_THREAD; i++)

{

if(i%2)

pthread_create(&thread_id[i], NULL, thread_inc, NULL);

else

pthread_create(&thread_id[i], NULL, thread_des, NULL);

}

for(i=0; i<NUM_THREAD; i++)

pthread_join(thread_id[i], NULL);

printf("result: %lld \n", num);

pthread_mutex_destroy(&mutex);

}

void * thread_inc(void * arg)

{

int i;

pthread_mutex_lock(&mutex);

for(i=0; i<5000000; i++)

num+=1;

pthread_mutex_unlock(&mutex);

return NULL;

}

void * thread_des(void * arg)

{

int i;

for(i=0; i<5000000; i++)

{

pthread_mutex_lock(&mutex);

num-=1;

pthread_mutex_unlock(&mutex);

}

return NULL;

}lock、unlock 花费时间比较长,所以尽量减少调用次数

临界区只有 num+=1、num-=1

但扩大为:

lock

for(i=0; i<5000000; i++)

num+=1;

unlock

可以减少调用次数,即 des 函数比 ins 多调用4 9 999 999 次,所以适当扩大临界区的锁范围,可以减少执行时间

但又有个问题,变量值增到 50 000 000 前,不允许其他线程访问,反而是缺点,所以要平衡

至此说的是互斥量,属于无忙等待锁

当线程调用

mutex_lock尝试获取已被占用的互斥量时,线程会被挂起阻塞(进入睡眠状态 ) ,线程此时不占用 CPU 资源等互斥量解锁后才被唤醒,和忙等待锁(如自旋锁,靠循环检查,一直占用 CPU )不同

- 自旋锁:忙等待(while 循环),占用 CPU

- 互斥量:阻塞线程(让出 CPU),依赖内核调度

- 自旋锁:临界区执行时间短、多核环境

- 互斥量:临界区长、单核 / 资源敏感场景

- 自旋锁:非阻塞同步

- 互斥量:阻塞同

说完了锁,再说信号量

信号量是操作系统提供的一种协调共享资源访问的方法

之前早就说过了,查缺补漏吧,搜“后面”

文中的这个TIP是不是来的太晚了些

实现:

基础知识解释:

假设有结构体struct Person { int age; };:

- 点表示法:当有结构体变量

struct Person p;,访问成员用p.age,用于直接访问结构体变量成员- 箭头表示法:当有结构体指针

struct Person *ptr = &p;,访问成员用ptr->age,用于通过指针访问其所指结构体的成员

void init(sem_t *s,int sem) { s->sem = sem; queue_init(s->q); }

s是指向sem_t结构体的指针,s->q是sem_t结构体中的等待队列成员 。queue_init(s->q)是调用queue_init函数,对这个等待队列进行初始化 ,让它能用于存放等待获取信号量的线程相关信息 ,为后续信号量的 PV 操作中管理等待线程做准备

发现从 测试和置位指令 开始,小林写的代码更底层的代码逻辑,TCPIP网络编程尹圣雨反而都是编程中创建销毁的API使用层面

说完了实现,说说信号量使用:

之前说可以为负,现在又说只能是0、1、-1,算了咋说咋是吧(此文搜“小林coding里说可以小于0,尹圣雨TCPIP网络编程书里说不可以小于0”)

再次说明:对于两个并发线程,互斥信号量仅取0、1、-1

基于这个规则开始理解(资源数量这豆包也没说清,但一下子悟了)

重点:咋确定资源数量这个事?

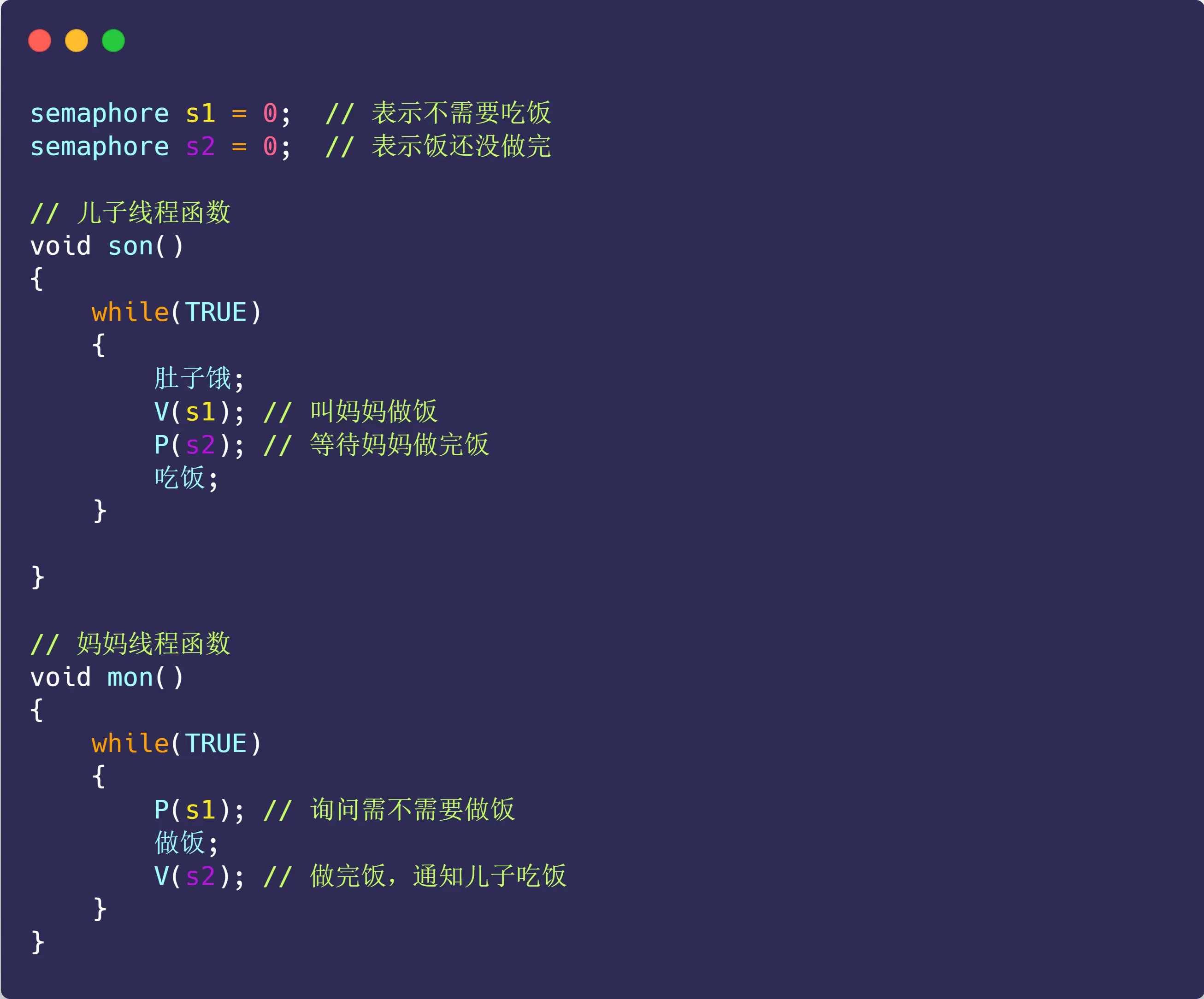

儿子吃饭问题:

儿子需要吃饭,那就得妈妈做,这里得到妈妈做的,就是资源

妈妈做饭,就得儿子喊饿,这里儿子喊饿就是资源

好了俩资源出来了

- 妈妈一直等待儿子喊饿,这资源出来,才能执行做饭动作

- 儿子一直等待妈妈做好饭,这资源出来,才能执行吃饭

听起来有点违和反人类,但就是这么回事

semaphore s1 = 0;//s1是“下达吃饭的指令”、“儿子喊饿”这个资源

semaphore s2 = 0;//s2是“饭做好”这个资源

流程:

妈妈执行 P(s1) ,相当于问儿子要不要吃饭,即想得到“儿子喊饿”这个资源,此时 s1 从 0 变成 -1,表明儿子不需吃饭,所以妈妈线程就进入等待状态

当儿子肚子饿时,执行了 V(s1),即下达“喊饿”指令,使得 s1 信号量从 -1 变成 0,表明此时儿子需要吃饭了,唤醒了阻塞中的妈妈线程,妈妈线程就开始做饭

接着,儿子线程执行了 P(s2),相当于询问妈妈饭做完了吗,想得到“饭做好”这个资源,由于 s2 初始值是0,则此时 s2 变成 -1,说明妈妈还没做好,儿子线程就等待状态

最后,妈妈终于做完饭了,于是执行 V(s2),s2 信号量从 -1 变回了 0,于是就唤醒等待中的儿子线程,唤醒后,儿子线程就可以进行吃饭了

多简单点事!

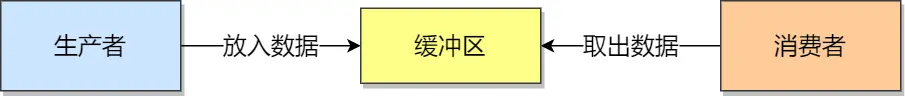

生产者-消费者问题:

-

生产者在生成数据后,放在一个缓冲区中;缓冲区满时,生产者必须等待消费者取出数据。

-

消费者从缓冲区取出数据处理;缓冲区空时,消费者必须等待生产者生成数据;

说明生产者和消费者需要同步

任何时刻,只能有一个生产者或消费者可以访问缓冲区。说明操作缓冲区是临界代码,需要互斥

思考:

-

互斥信号量

mutex:用于互斥访问缓冲区,初始化值为 1; -

资源信号量

fullBuffers:用于消费者询问缓冲区是否有数据,有数据则读取数据,初始化值为 0(表明缓冲区一开始为空); -

资源信号量

emptyBuffers:用于生产者询问缓冲区是否有空位,有空位则生成数据,初始化值为 n (缓冲区大小)

如果消费者线程一开始执行 P(fullBuffers),由于信号量 fullBuffers 初始值为0,则此时 fullBuffers 的值从 0 变为 -1,说明缓冲区里没有数据,消费者只能等待

接着,轮到生产者执行 P(emptyBuffers),表示减少 1 个空槽,如果当前没有其他生产者线程在临界区执行代码,那么该生产者线程就可以把数据放到缓冲区,放完后,执行V(fullBuffers) ,信号量 fullBuffers 从 -1 变成 0,表明有「消费者」线程正在阻塞等待数据,于是阻塞等待的消费者线程会被唤醒

消费者线程被唤醒后,如果此时没有其他消费者线程在读数据,那么就可以直接进入临界区,从缓冲区读取数据。最后,离开临界区后,把空槽的个数 + 1

经典同步问题:

引用小林的图:

这不是研究生操作系统书里经典题目吗,呵呵,一群垃圾(BUPT/HIT之下的 & 大厂程序员也很多水货,0基础的无脑刷学历的傻逼进去培养的),当然连题目都描述不清楚的面试官的表达能力在我眼里也就是个一坨屎的垃圾。~~~~(>_<)~~~~

一个19年大学毕业2次北邮网研14许长桥待业4年照顾家人脱不开身做了4年低贱刷盘子的我,23年开始第一份工作,0基础培训银行外包做了测试,大彻大悟绝境,开始离职自学开发的我

的扭曲压抑黑暗看不到任何希望和光亮,失去活下去的力气,一切事与愿违,一无是处穷途末路的内心

十二分的真诚换来职场背刺,和耗子住在一起没有法律可以维护我的权益,呵呵

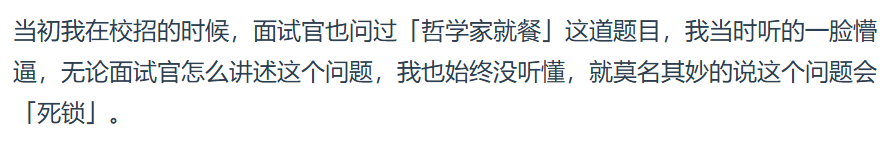

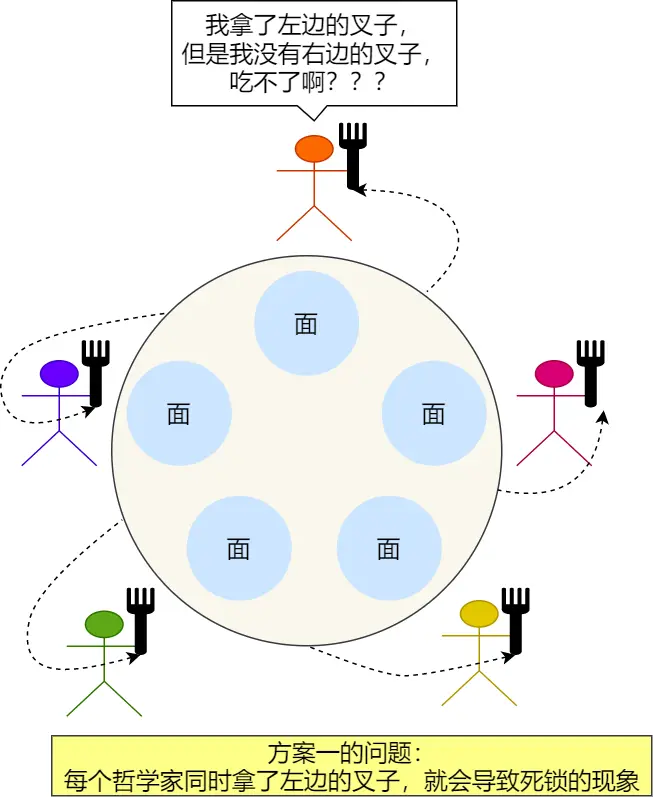

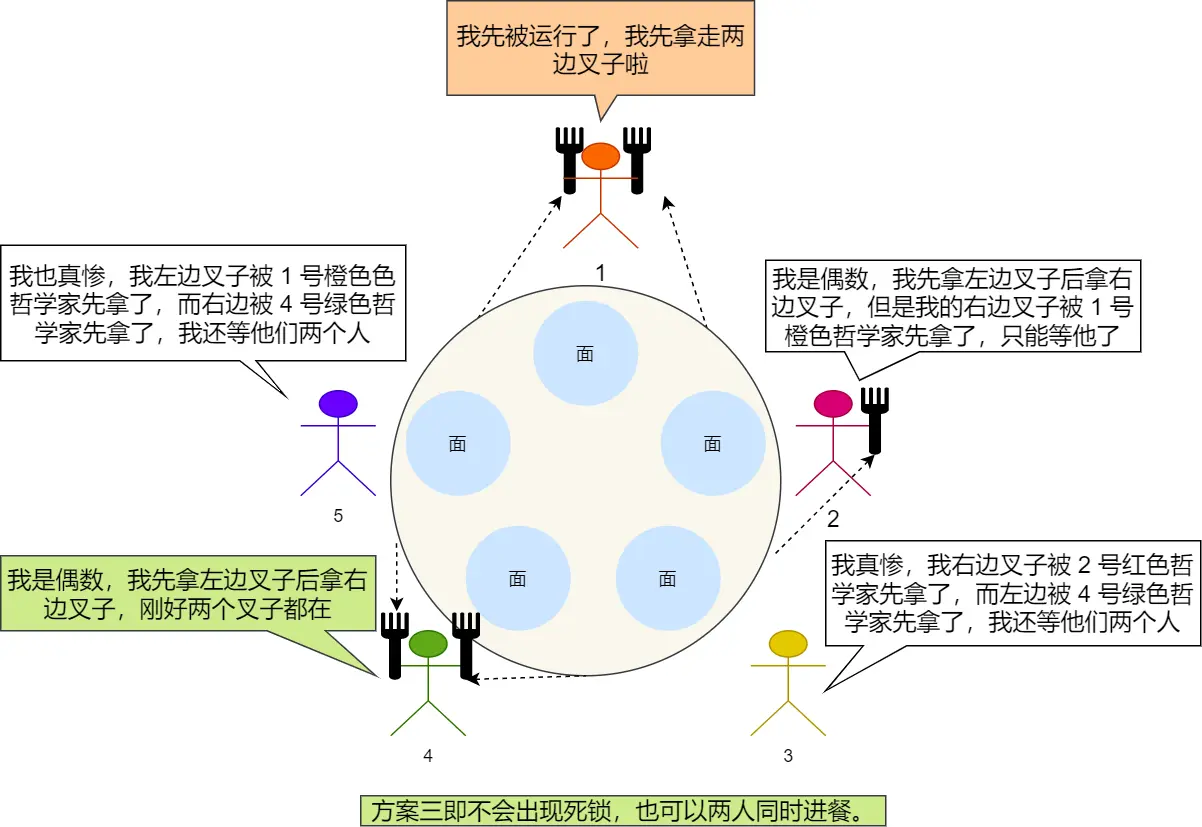

一、哲学家就餐问题(1/2)(这个也叫Dijkstra 哲学家问题,就是那个最短路的,都是一个人提出的)(算法做再多的动态图没有用,你得自己脑海里头脑风暴想问题解决问题,时而觉得算法是不是不对啊,时而觉得太妙了这才是曲折上升)(我自己加了序号,红色0~4是哲学家,蓝色0~4是叉子)

一切都在图中,需要补充的是,这人是哲学家,思考累了就吃面,吃面必须要两个叉子,吃饭放回原处,继续思考。咋保证动作有序进行,而不会出现有人永远拿不到叉子?

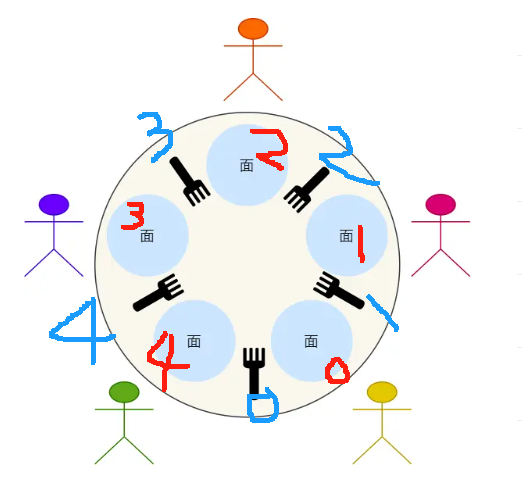

方案一:

没啥好解释的

致命问题是:

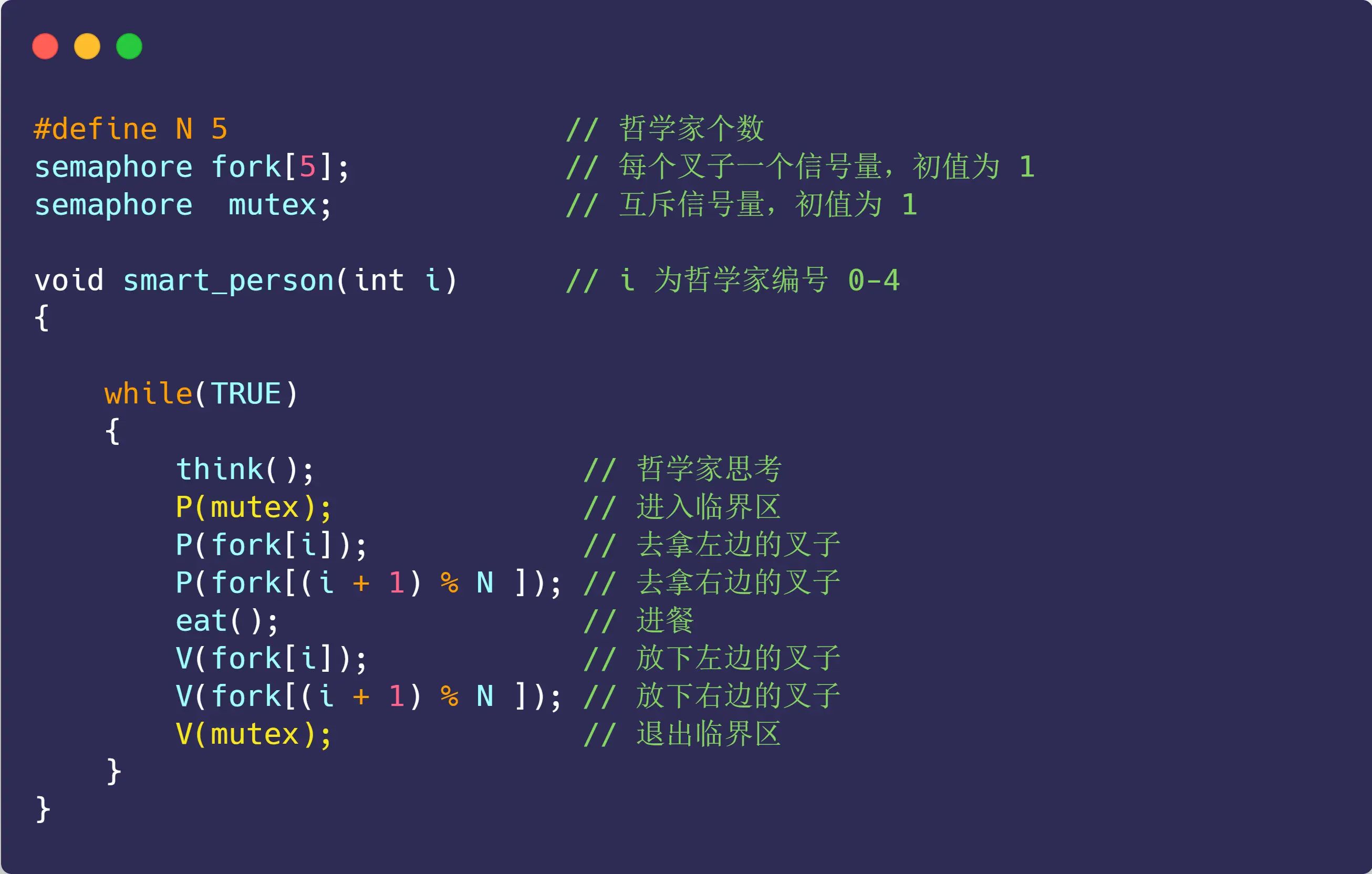

方案二:

在拿叉子前,加个互斥信号量

太鸡巴der了,超级低效率,只要有一个哲学家进入了「临界区」,即准备要拿叉子时,其他哲学家都不能动,只有这位哲学家吃完了,用完叉子了,才能轮到下一个哲学家进餐

至于为啥最下面的有俩叉子也不吃,因为mutex只有1个

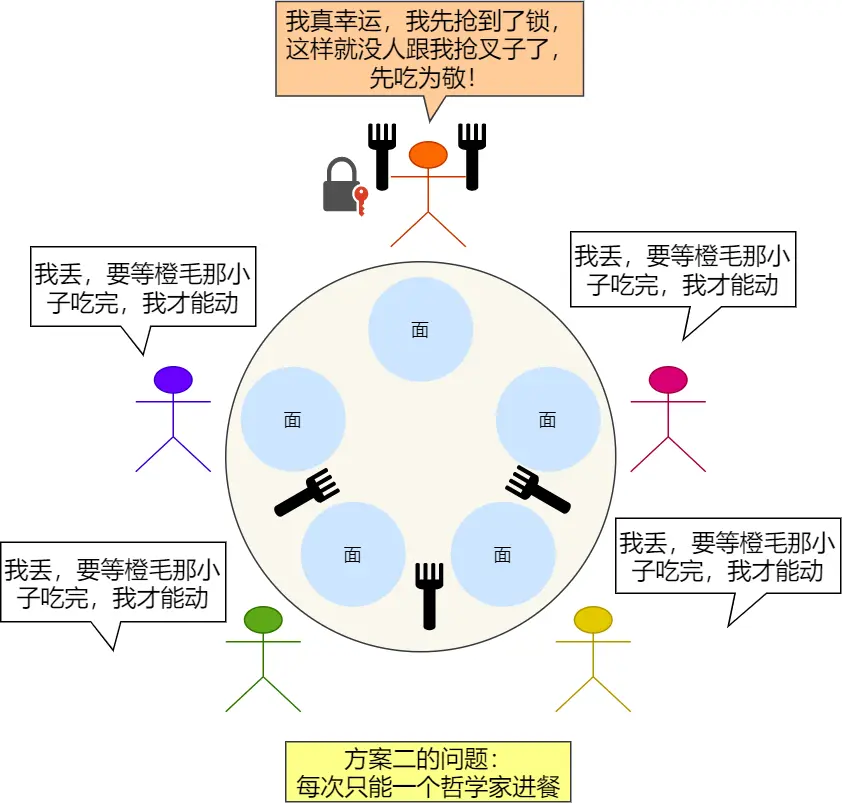

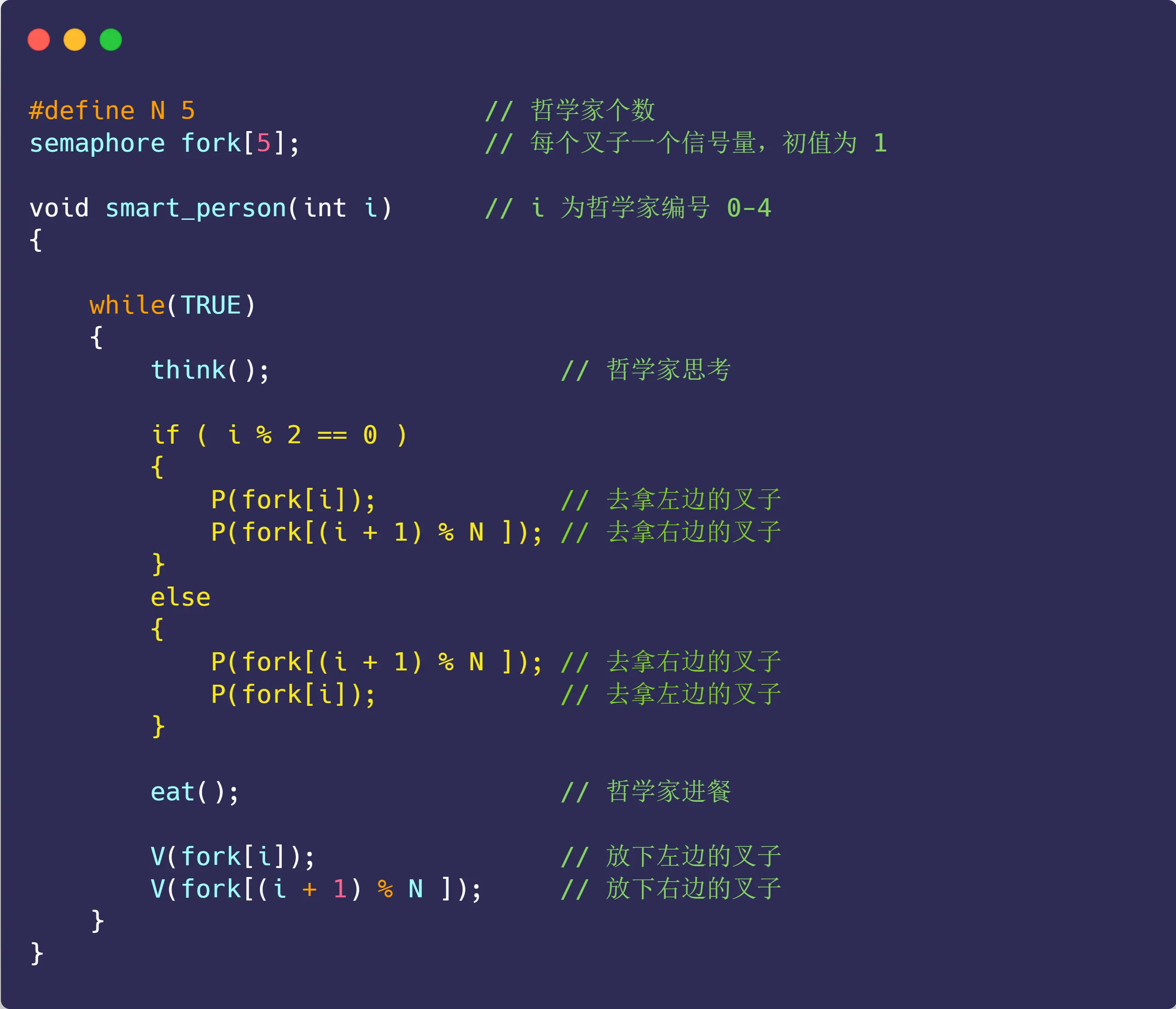

方案三:

使用互斥信号量,会导致只能允许一个哲学家就餐,那就不用它

避免哲学家可以同时拿左边的刀叉,采用分支结构,根据哲学家的编号的不同,而采取不同的动作

说下自己的思考经过了豆包确认

这里我起初觉得有点问题,因为既然方案一说了 同时 拿左,那这里就应该去继续用 同时 拿左这个事去验证是否解决了,而在自己思考了小一会儿发现其实多核也未必是绝对的并行。

单核确实必须是执行A进程1s,再去执行B进程1s,那宏观整体就是 “同时执行”,视为并发

多核就比如2个核心吧,可以同时执行,视为并行

但其实我发现对于这个例子,其实不是我一直以为的绝对的同时,因为访问的是同一个数组:

微观上,多个核心访问同一内存地址时需通过总线仲裁串行处理(同一时刻仅一核心读写),此时表现为串行;若访问不同内存地址,各核心可并行操作不同区域,无需等待

或者就拿方案一的同时拿起左叉子来说,看似是同时拿起了导致的阻塞,但仔细想想根本不是这么回事!因为这个同时很容易造成误解,而这个方案一的拿叉子问题又很简单,所以就潜意识没去深究,那带着这种误解,去理解其他问题,就会一直有一个错误的认知,可能到很久才能发现,但这个简单的方案一拿叉子恰恰因为简单,才最方便用来深究

先说方案一,其实并不是同时!因为是访问同一个地址空间,即semaphore fork[5];这个数组,初始值都似乎1,你如果同时了,那都P(fork[i]);,岂不是没法保证不竞争了!!比如都看到3号下标数组都有叉子,值是1,都去拿,都减1,都觉得变成0了,但实际是减少了2次,这也就是所谓的P原子操作没利用上,

原子操作本质是在硬件层面,可在单条指令周期内完成测试和设置操作;在软件层面,利用互斥锁等同步机制

那这里就不能说同时!哪怕你多核CPU,但都是访问这个数组,本质是访问同一块内存空间!

总线仲裁串行处理!所以应该说,最坏情况不是同时拿,而应该说成叫一个进程(哲学家)执行一条指令后就下一个进程执行。这么一看就是说1号哲学家拿左叉子,好结束,该2号哲学家了,代码依旧是和1号哲学家那个进程一样,那还是拿左叉子,结束,3号哲学家拿,左叉子... ...

那换到这个方案三也是,我起初觉得同时拿,应该会竞争啊或者错乱啥的,或者既然同时,为何会有1号先拿到、4号先拿到这种问题,现在懂了,其实还是有先后顺序,只不过用最坏情况去思考是可以解决方案一的那种竞争问题的,即1号先行动,后面就不用我说了

PS:同时、同步这些字眼终于懂了,哈哈,还真是有趣

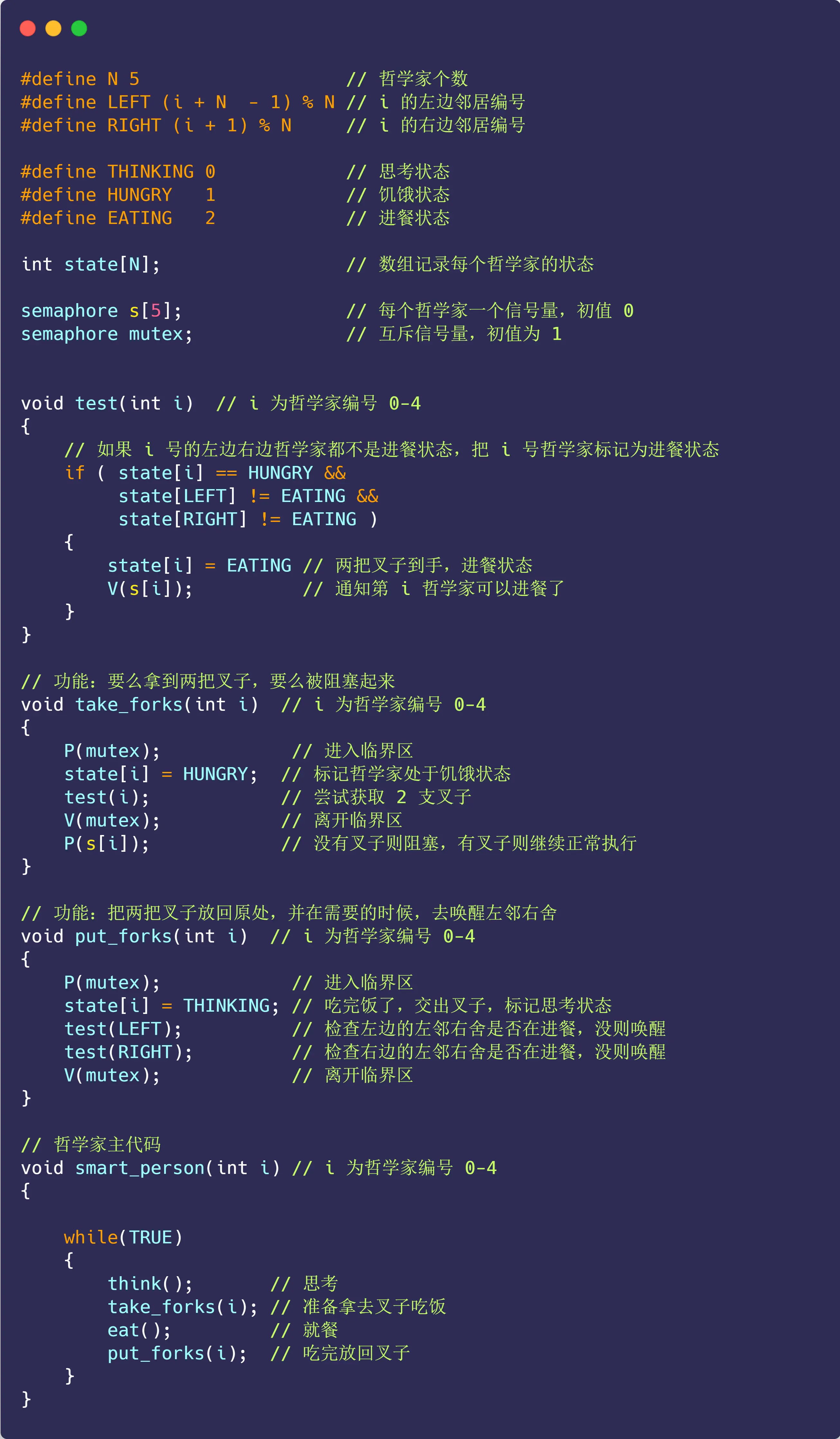

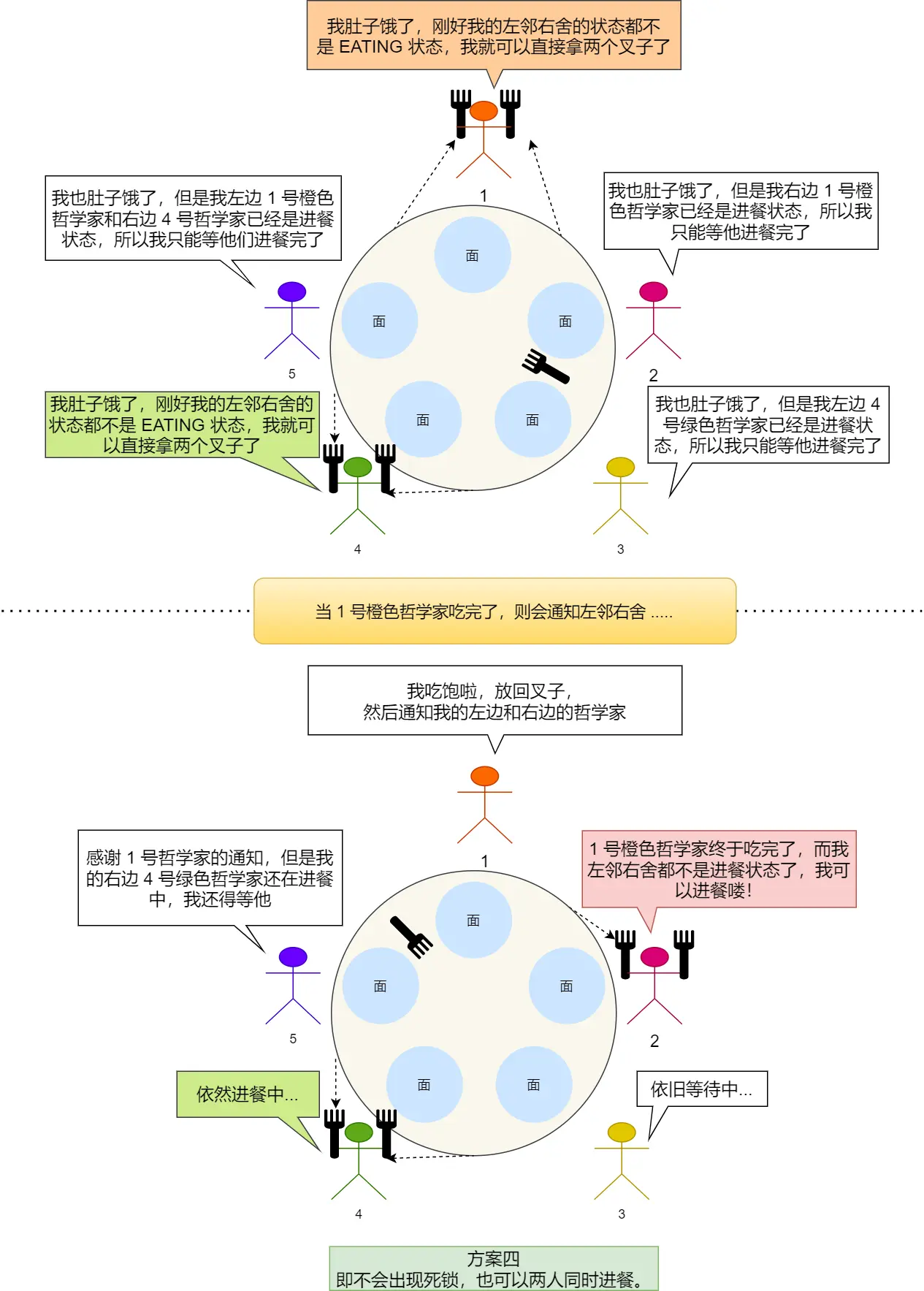

方案四:

再想另一个方案,用一个数组 state 来记录每一位哲学家的三个状态:

进餐状态、思考状态、饥饿状态(正在试图拿叉子)

哲学家只有在两个邻居都没有进餐时,才可以进入进餐状态

第 i 个哲学家的左邻右舍,则由宏 LEFT 和 RIGHT 定义:

- LEFT : ( i + 5 - 1 ) % 5

- RIGHT : ( i + 1 ) % 5

很容易理解

哈哈,这个代码好有趣,但对我刷算法的来说,看懂很容易。算法是代码看起来简单,但背后的思维量异常大,而这个看着绕来绕去,其实很清晰明了简单

解释代码:

take_forks里P(s[i])是干JB啥的?

take_forks里P(s[i])是因为s[i]初始为 0 ,test(i)若满足条件会V(s[i])唤醒,P(s[i])是在等待这个唤醒信号,确保拿到叉子才进餐,起同步阻塞作用 。

太JB玄妙了,继刷算法题后第一次有这种感觉O(∩_∩)O哈哈~

研究完就不想看他的图了,太繁琐冗余了,但为了以后回顾或者啥的,姑且贴上吧

我至此我懂了儿子吃饭问题、生产者-消费者问题、哲学家进餐问题,但咋感觉互斥量、信号量不好区分呢?

豆包回答:

儿子吃饭问题 和 哲学家进餐问题,主要体现信号量的同步功能 ,通过信号量协调线程执行顺序,像儿子饿了通知妈妈做饭,妈妈做完通知儿子吃;哲学家进餐时通过信号量判断是否能拿到筷子进餐生产者消费者 体现信号量的互斥与同步 ,

mutex作为互斥信号量防止生产者和消费者同时访问缓冲区(互斥 ),emptyBuffers和fullBuffers协调生产与消费节奏(同步 )互斥量本质是特殊的二元信号量,值通常为 0 或 1 ,专注解决互斥问题,保证同一时刻只有一个线程能进入临界区 ;信号量值可为任意非负整数,除互斥还能用于资源计数、线程同步等更复杂场景 。在哲学家进餐问题里,筷子可看作互斥量(每个筷子同一时刻只能被一个哲学家使用 ),整体资源分配和避免死锁的协调则是信号量思想的体现

互斥量:是一种锁机制,可简单理解为二元信号量 ,值一般为 0 或 1 ,主要解决互斥问题,保证同一时刻仅一个线程能访问临界区,像给临界区加把锁

信号量:值是非负整数,功能更丰富(但在实际操作系统实现中,当信号量值可以为负,绝对值表示进程因申请资源未成功而处于等待队列的个数)

锁:广义上互斥量属于锁,常见的锁还有读写锁、自旋锁等 。读写锁区分读操作和写操作,允许多个线程同时读,但写操作时需独占 ;自旋锁是线程获取不到锁时不放弃 CPU,而是不断尝试,适用于锁占用时间短的场景

我理解先是有锁的概念,为了弄懂保证互斥不竞争这个概念的底层实现,然后实际场景应用就是互斥量,但只有二元状态0和1还不够,就又有了信号量(可以有很多资源)

注:小林通篇没提到互斥量

至此也就释怀了,不用纠结那些各种名称上的、正负值限制这些小问题了

追问细节在豆包链接里的搜“但感觉互斥量、锁、二进制信号量都没差别”

但感觉互斥量、锁、二进制信号量都没差别 命名的专家们咋去普及的这个事啊?

至此好像更透彻了

说下面第二个经典同步问题前,强迫症插入TCPIP网络编程尹圣雨里的信号量吧,之前只在自旋锁那说了互斥量(注:小林代码里的P(mutex)都是伪代码,实际不识别P这个东西,具体如下)这就是书里 P304 说的信号量

PS:sem_t 是用于定义信号量变量的类型 ,本质为结构体,实际用的时候init初始化就行,感知不到是结构体

先声明个变量:set_t sem;

创建:

sem_init( & sem,传递 0 表示只允许 1 个进程内用、传递其他值表示可由多个进程共享的信号量,信号量初始值);

成功返回 0,失败返回其他值

销毁:sem_destroy( & sem);

成功返回 0,失败返回其他值

P操作:sem_post( & sem);,信号量 + 1

成功返回 0,失败返回其他值

V操作:sem_wait( & sem);,信号量 - 1

成功返回 0,失败返回其他值

实践代码此文搜“书P304”

再次写一下

#include <stdio.h>

#include <pthread.h>

#include <semaphore.h>

void * read(void * arg);

void * accu(void * arg);

static sem_t sem_one;

static sem_t sem_two;

static int num;

int main(int argc, char *argv[])

{

pthread_t id_t1, id_t2;

sem_init(&sem_one, 0, 0);

sem_init(&sem_two, 0, 1);

pthread_create(&id_t1, NULL, read, NULL);

pthread_create(&id_t2, NULL, accu, NULL);

pthread_join(id_t1, NULL);

pthread_join(id_t2, NULL);

sem_destroy(&sem_one);

sem_destroy(&sem_two);

}

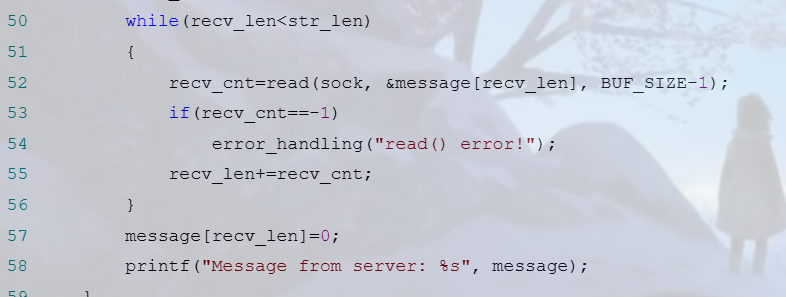

void * read(void * arg)

{

int i;

for(i = 0; i < 5; i++)

{

fputs("Input num: ", stdout);

sem_wait(&sem_two);

scanf("%d", &num);

sem_post(&sem_one);

}

return NULL;

}

void * accu(void * arg)

{

int sum = 0, i;

for(i = 0; i < 5; i++)

{

sem_wait(&sem_one);

sum += num;

sem_post(&sem_two);

}

printf("Result: %d \n", sum);

return NULL;

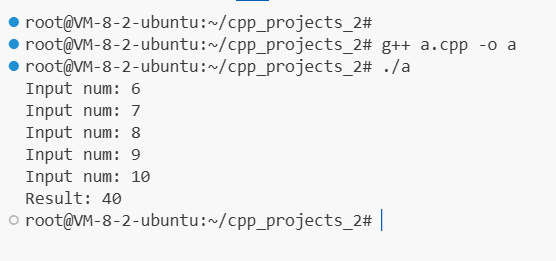

}运行结果:

插入个static 小知识:

1、无论在哪定义的,生命周期都是程序运行始终存在,但仅限定义它的函数内使用

2、仅限这个cpp内使用

重点是 当 sem_post 时,原本阻塞的线程就可以将该信号量重新减 1,并跳出阻塞状态,也是用这种方式完成临界区同步操作

代码通过信号量实现严格的交替执行:

-

read线程输入一个数后,必须等待accu取走并处理:sem_wait(&sem_two) -

accu处理完当前数后,释放信号允许read输入下一个:sem_post(&sem_two)

二、读者-写者问题(2/2)

「哲学家进餐问题」对于互斥访问有限的竞争问题(如 I/O 设备)一类的建模过程十分有用。

「读者-写者」,它为数据库访问建立了一个模型:

- 读者只读数据,不改

- 写者既可读也可改(勘误)

要求:

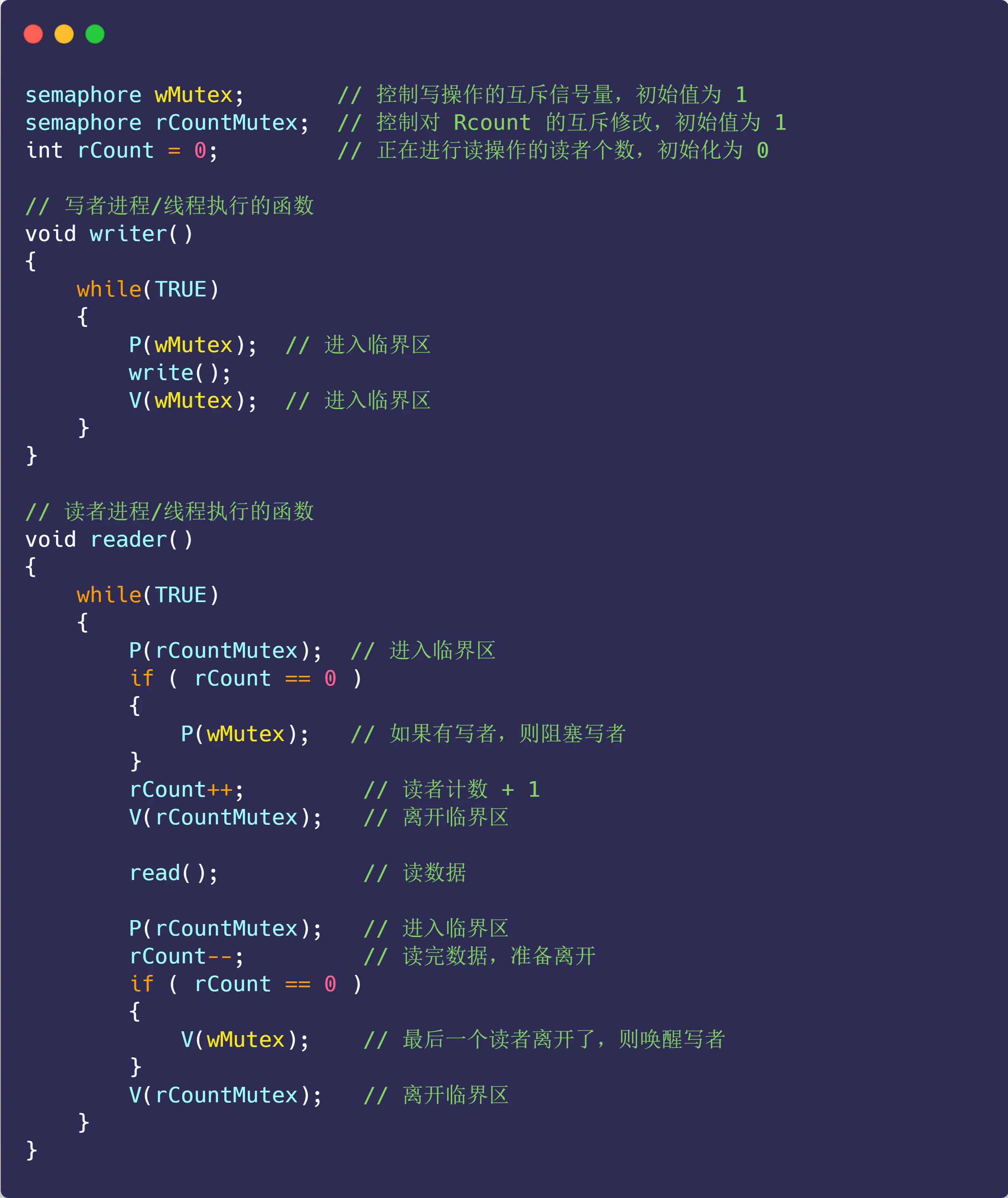

方案一:

都说了读禁止修改,但这里的rCountMutex起初半天没搞懂,其实就是rCount计数器修改的这个行为,用过rCountMutex控制。rCountMutex 保护的是 rCount 变量本身的修改

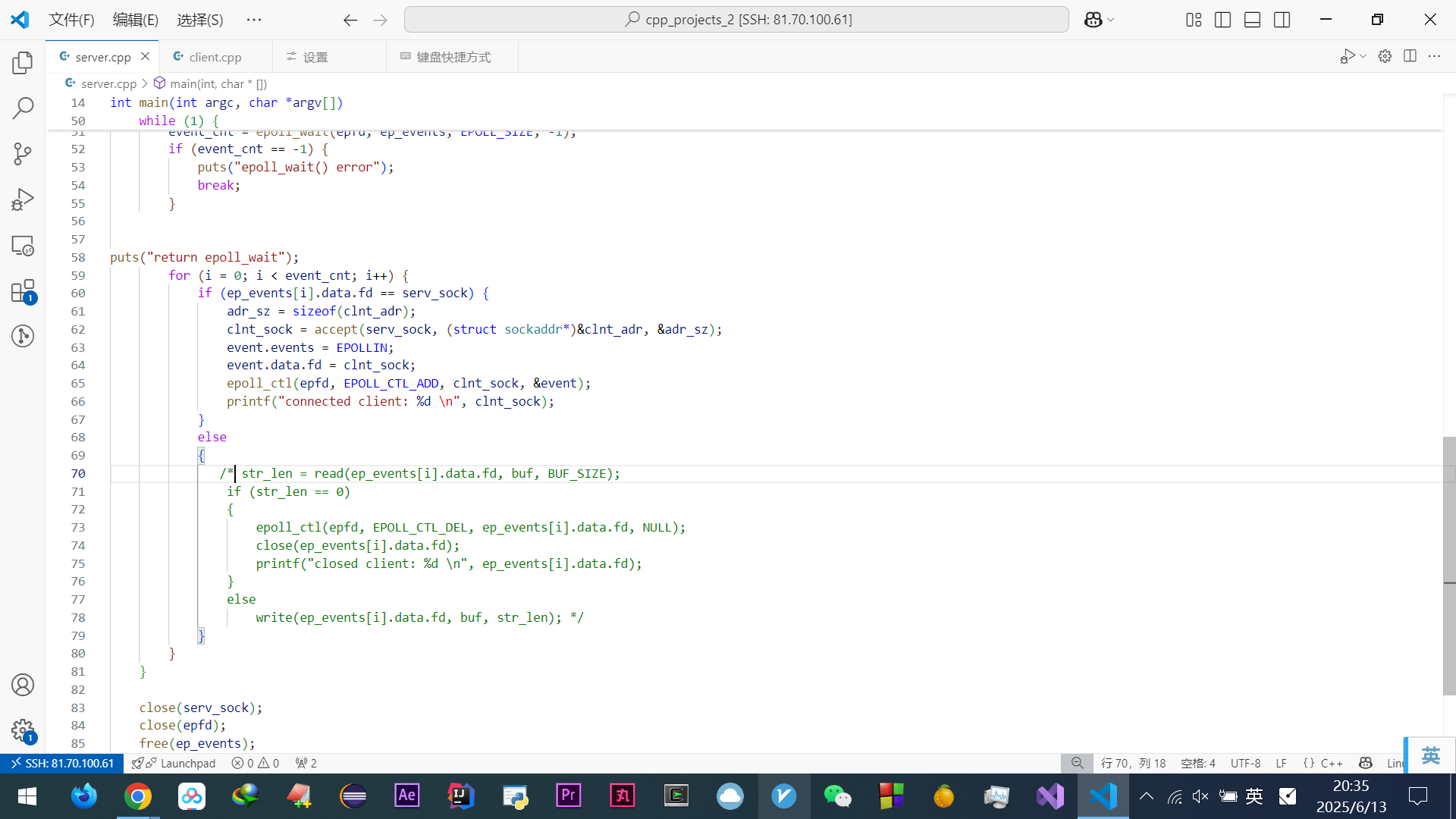

解释代码:

这里为啥

rCount==0就代表有写者?其实比较绕,就是

rCount==0代表没读者,这时候才可能发生写,所以读优先,直接阻塞读写资源wMutex,而如果rCount>0,则表示本身有读者正在读,就不可能有写者,则没必要P(wMutex),或者说wMutex已经是不可写的负数了。直接做rCount++就好了自己思想上的纠错:

writer()函数体现了多个写互斥,起初我以为没体现出来if(rCount==0){V(wMutex);}起初我以为是应该是rCount≤0做唤醒,毕竟多个写者嘛,但豆包解释说当rCount == 0时,意味着没有读者在读取数据,可以唤醒,就想懂了但此文搜“文中的这个TIP是不是来的太晚了些”,那个图就是资源非正,来判断唤醒的啊,豆包解释:

wMutex是互斥信号量(初始值 1),用P/V保证互斥,无需判断值;- “文中的这个TIP是不是来的太晚了些”那里的

s->sem是计数信号量(初始值为资源数),用≤0判断是否有线程等待,两者用途不同经过豆包认可的个人理解:

所以计数信号量可以这么用,而互斥信号量也叫01二进制或者二元信号量,直接用 P互斥V唤醒或者严谨说归还资源,谁要用就用(因为可能暂时没有写请求,就不需要唤醒,但资源是需要V的,即归还的),无需判断值

这个方案是读者优先,写者饥饿

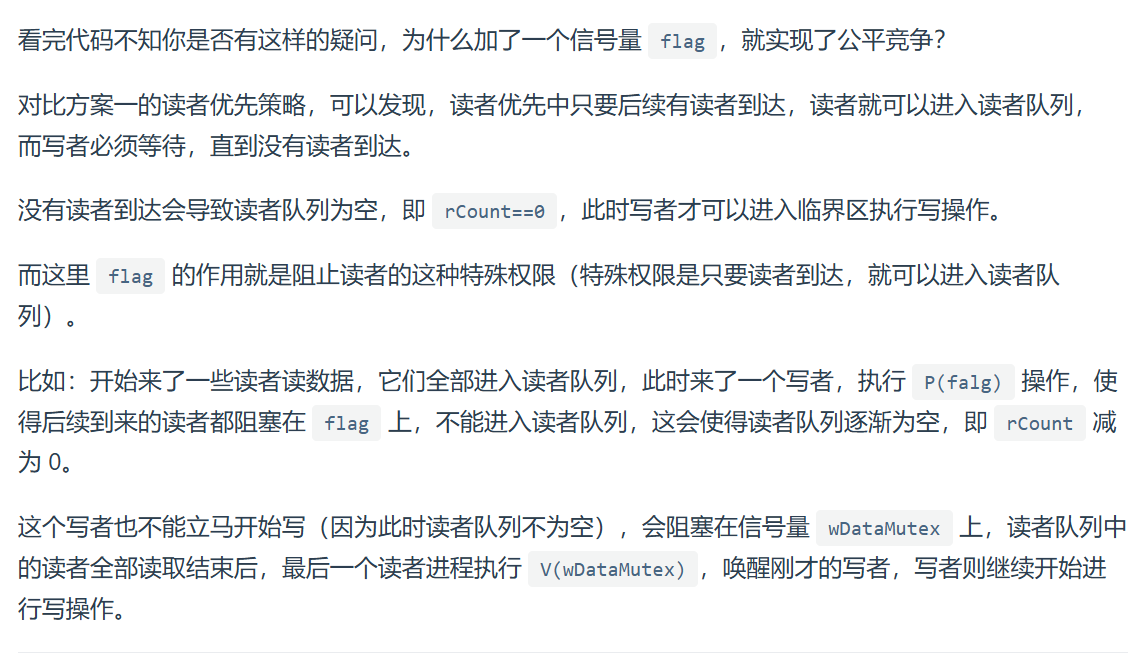

方案二:(发现小林coding代码命名还是挺好的哈哈O(∩_∩)O~)

写者优先,读者饥饿

-

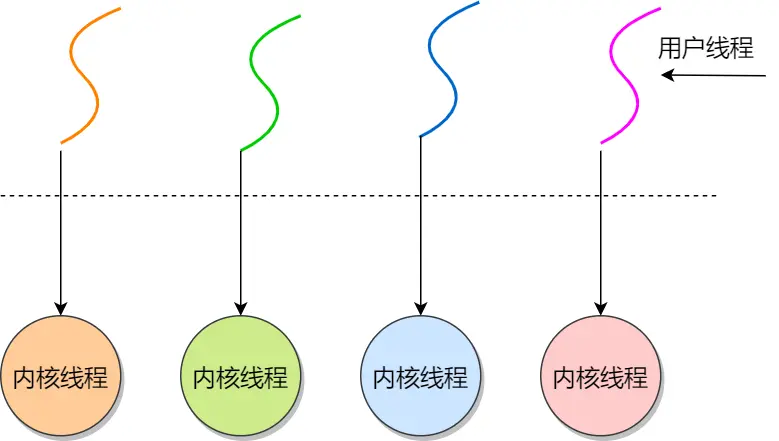

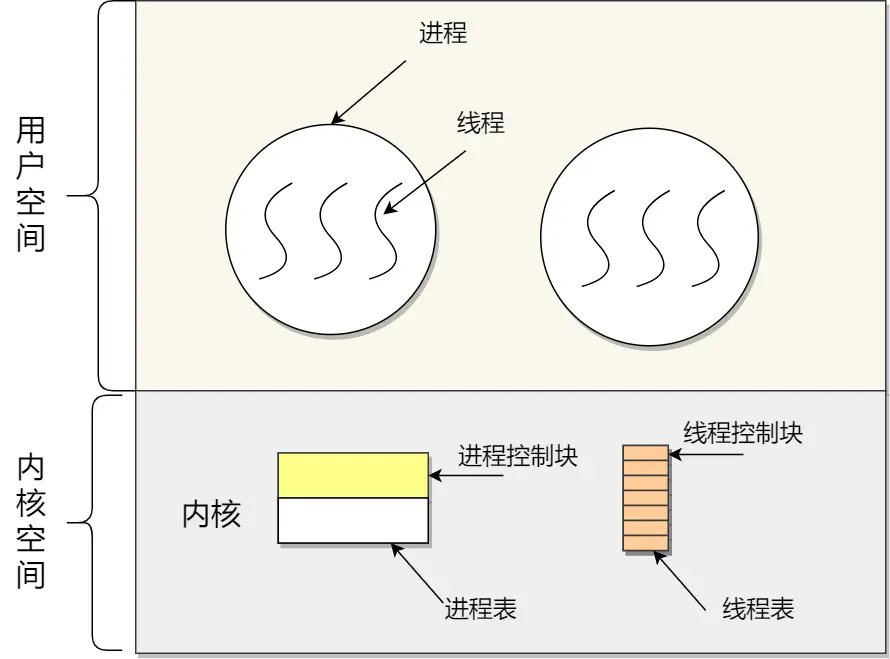

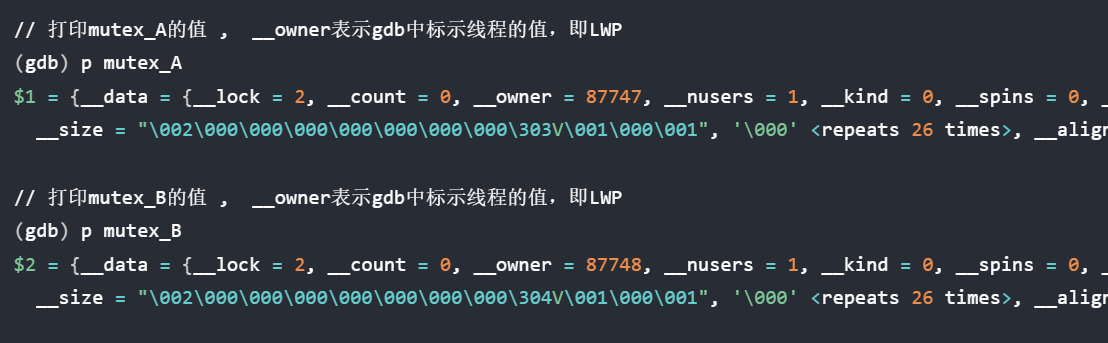

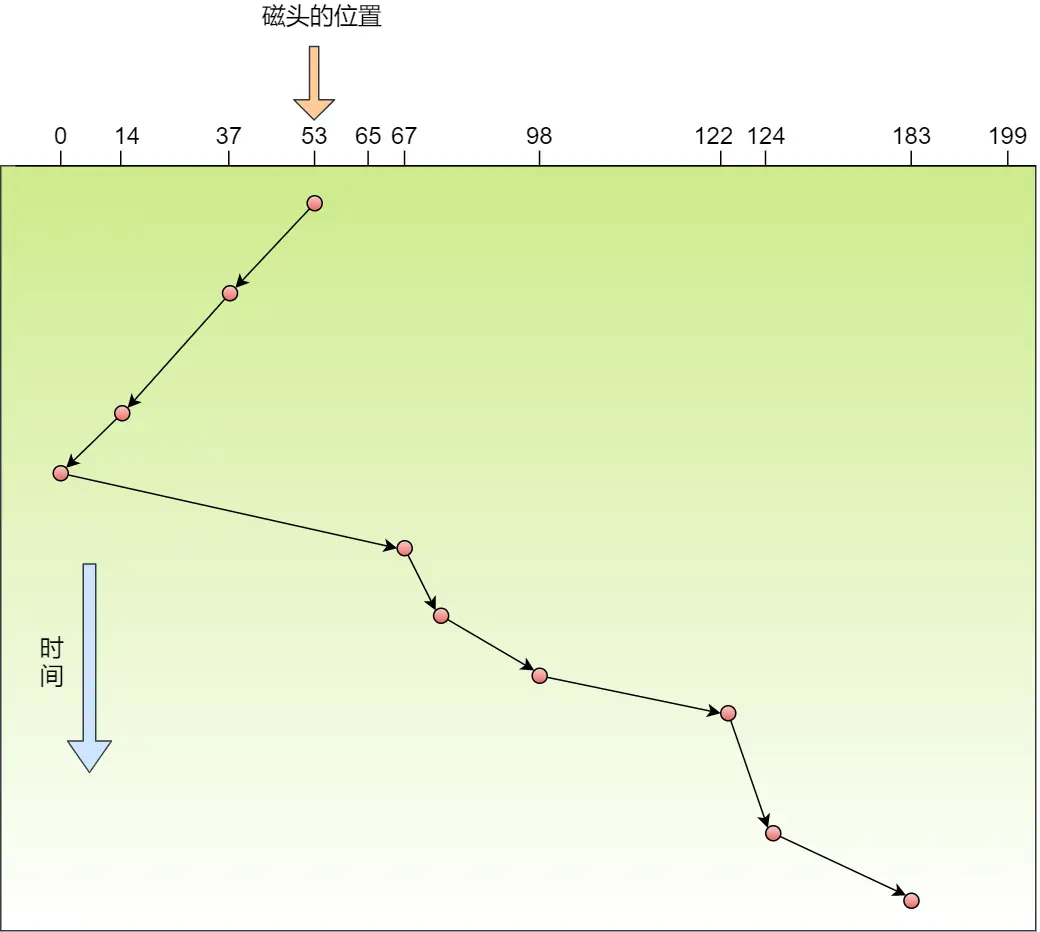

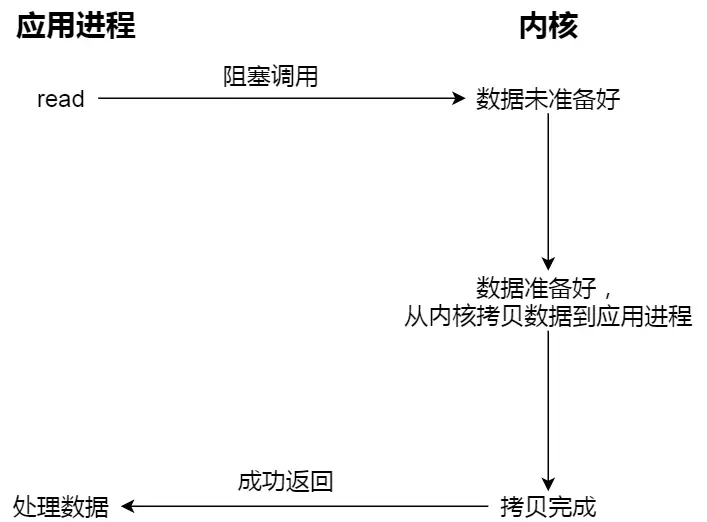

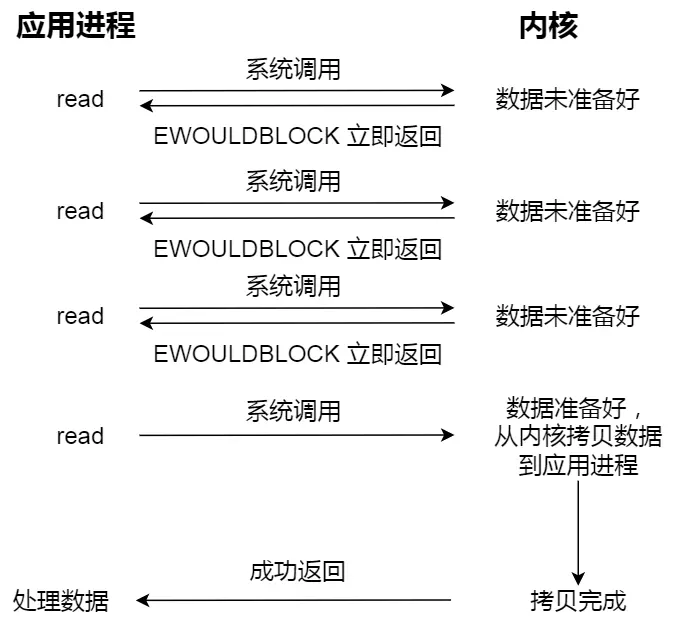

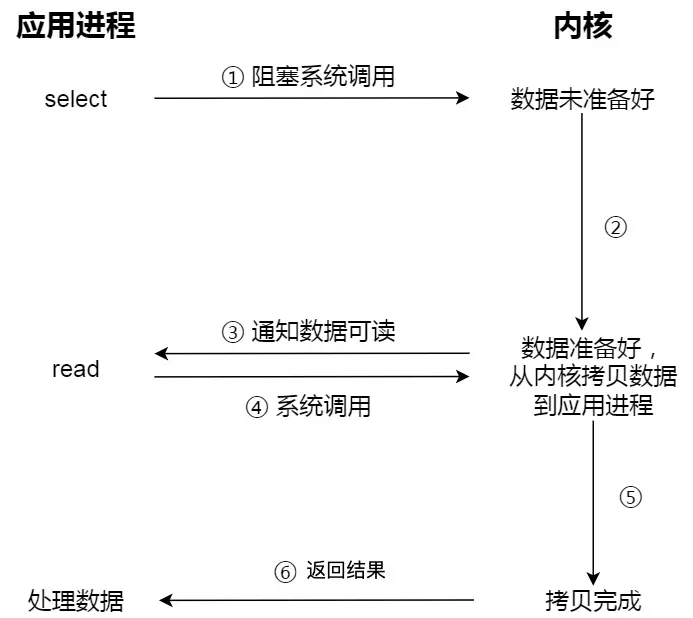

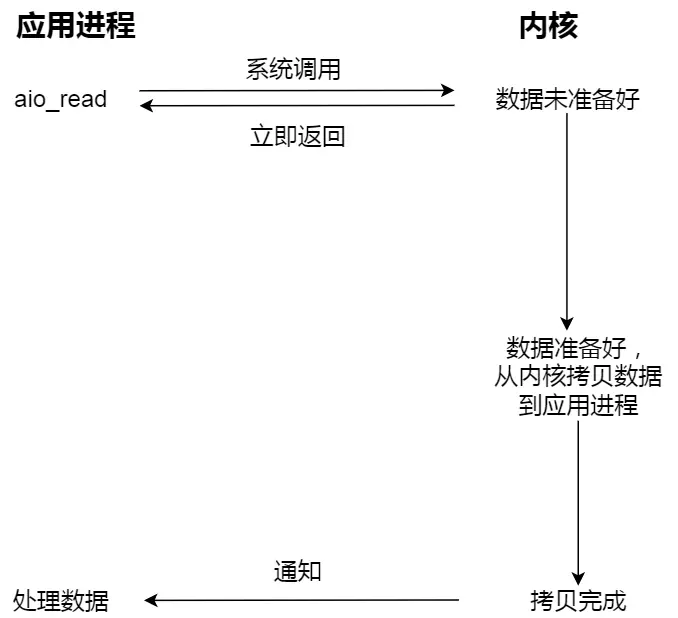

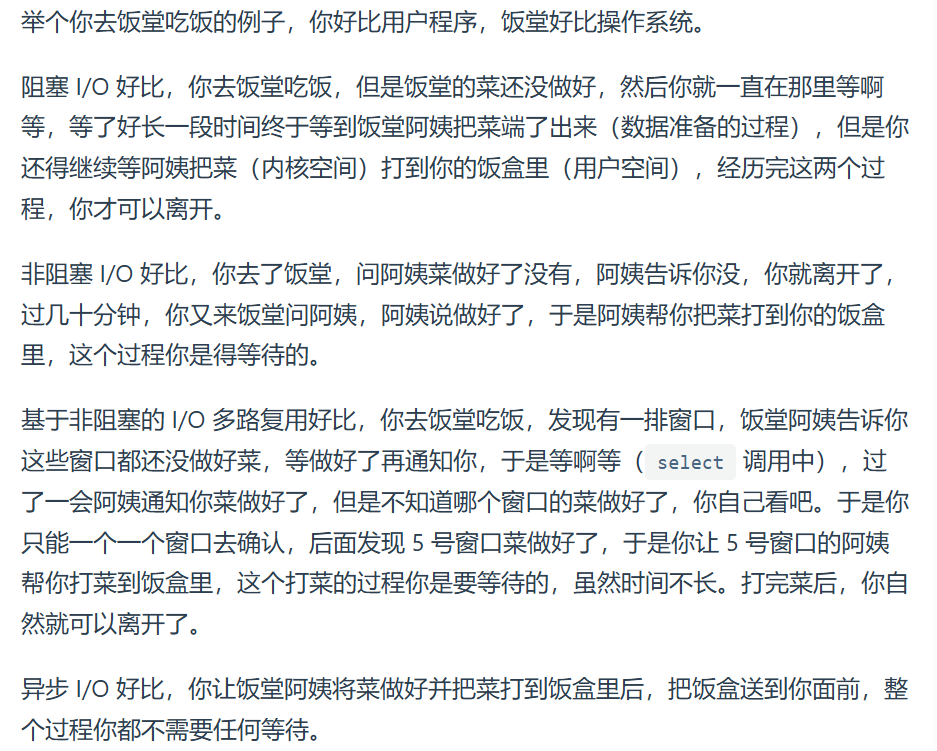

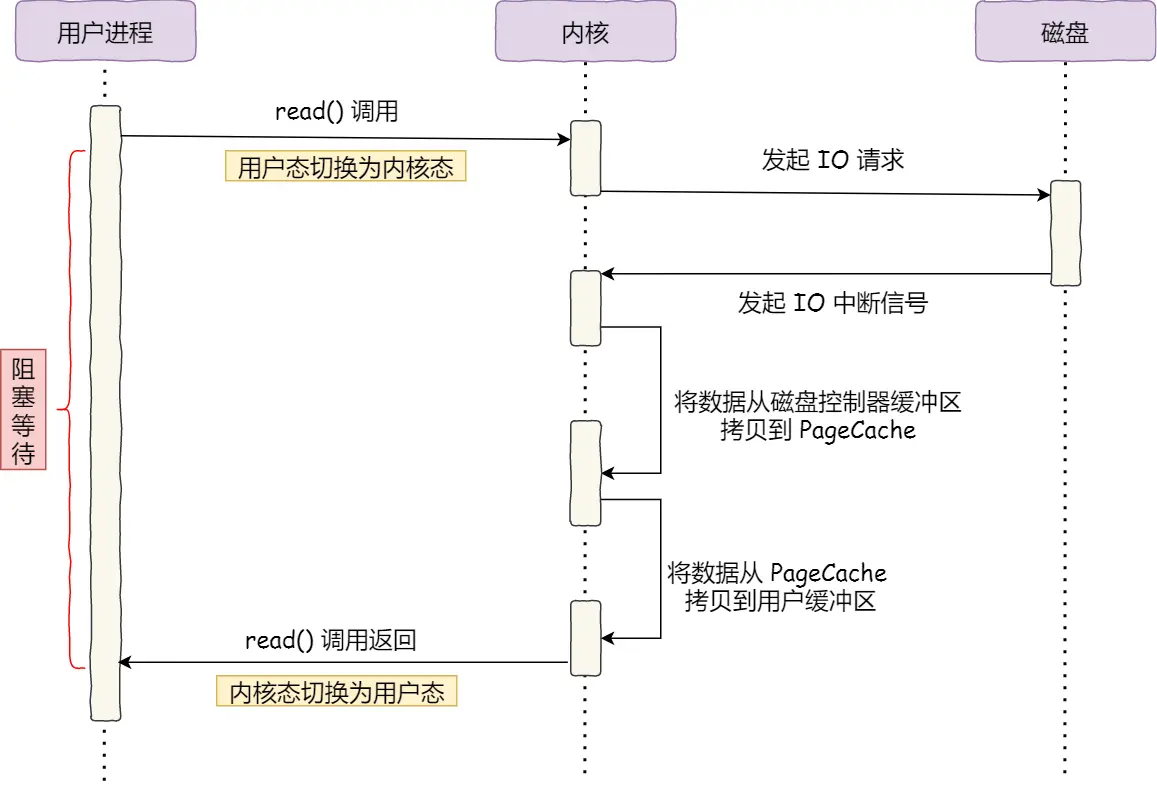

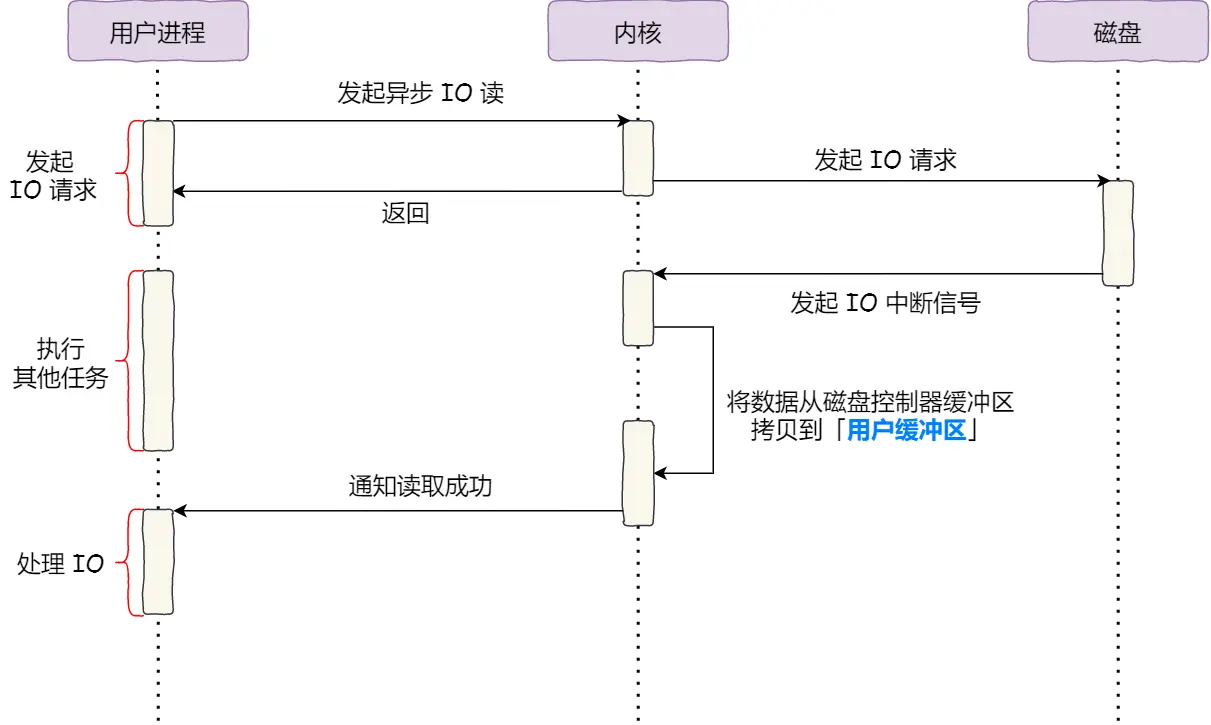

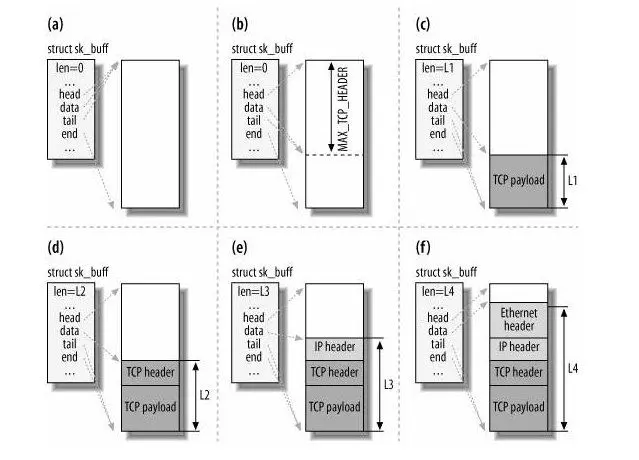

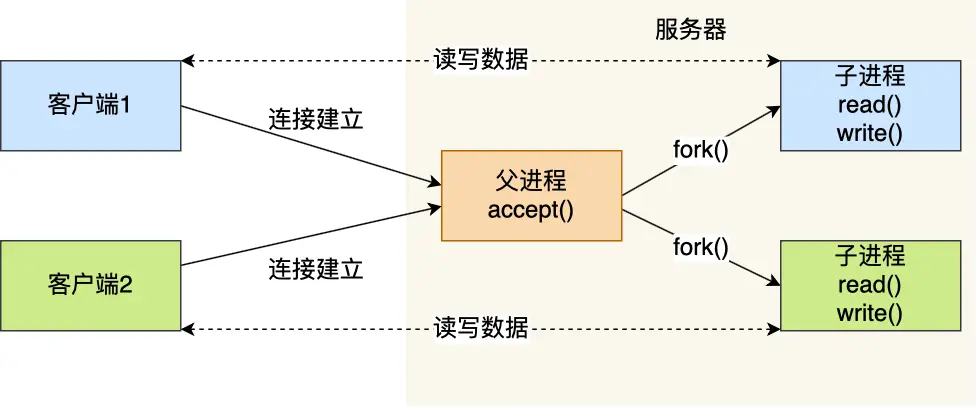

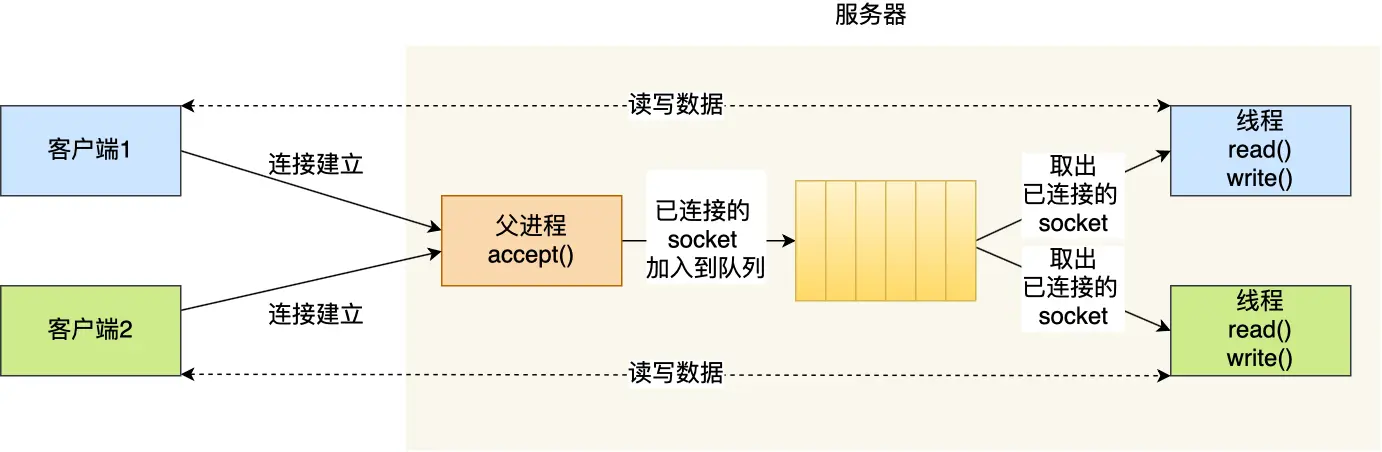

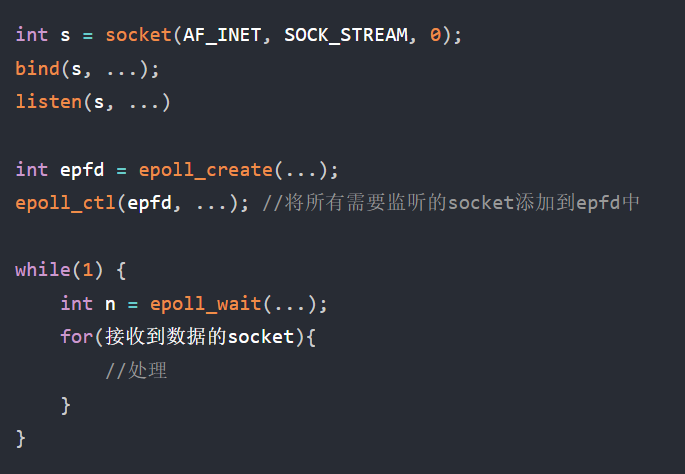

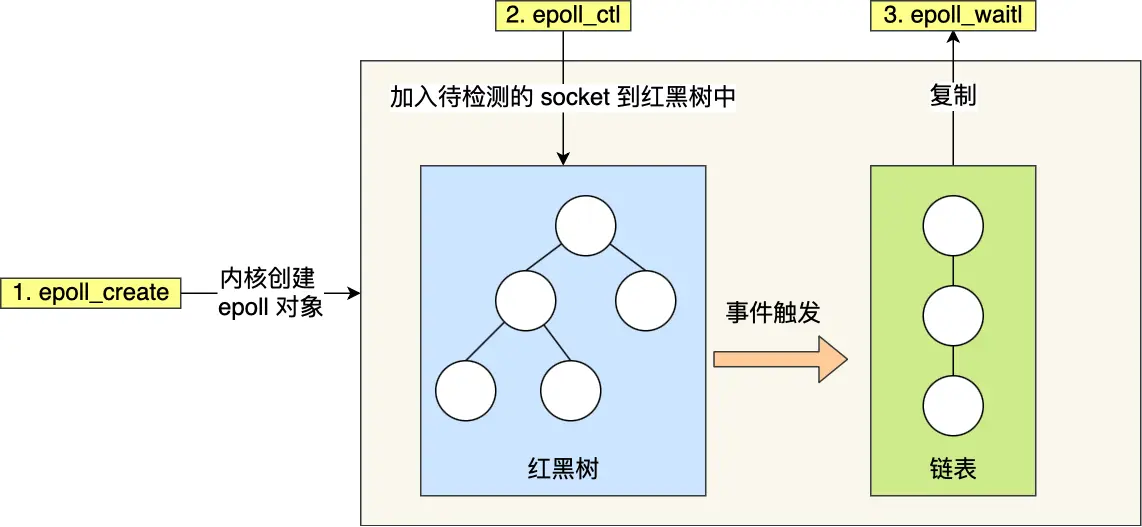

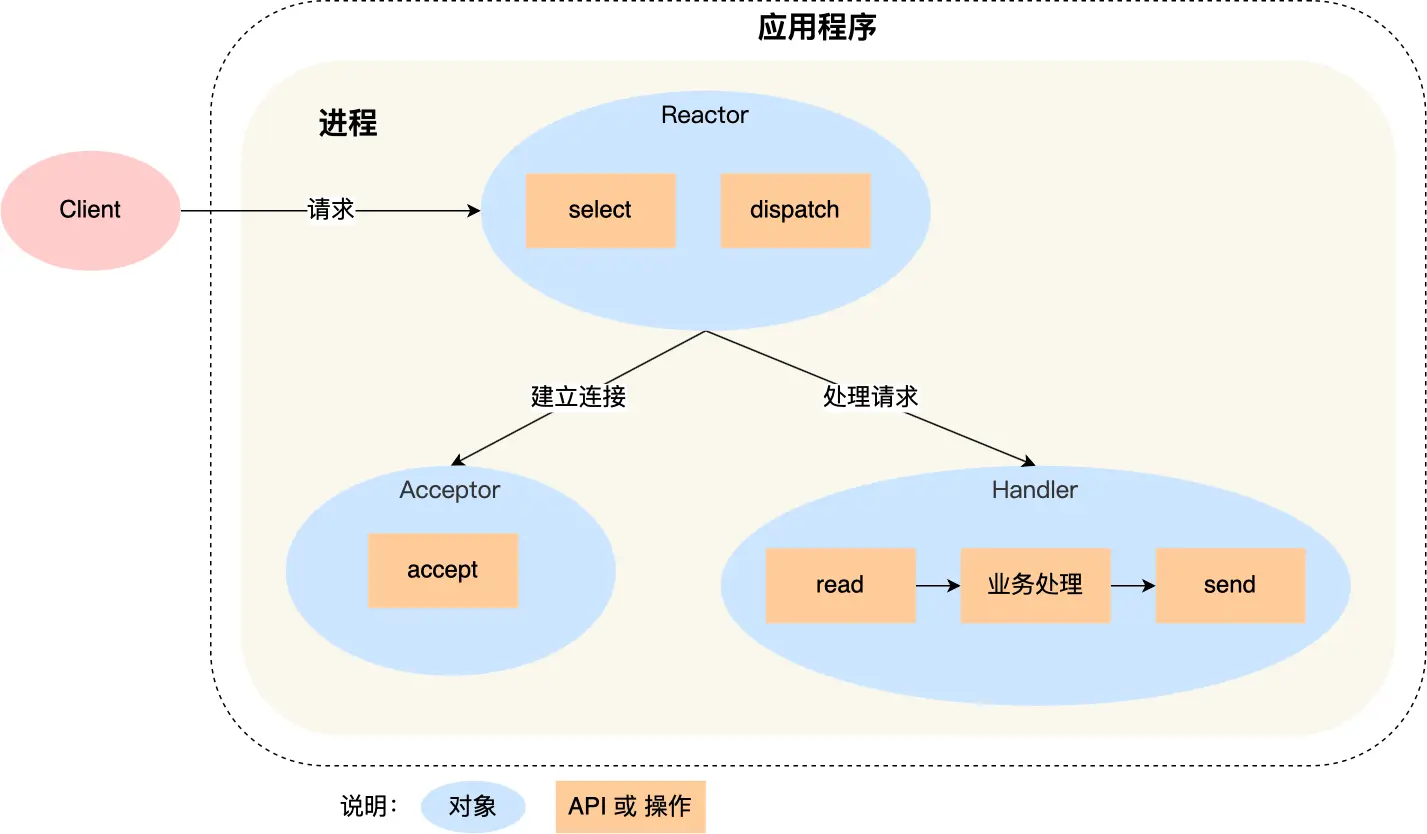

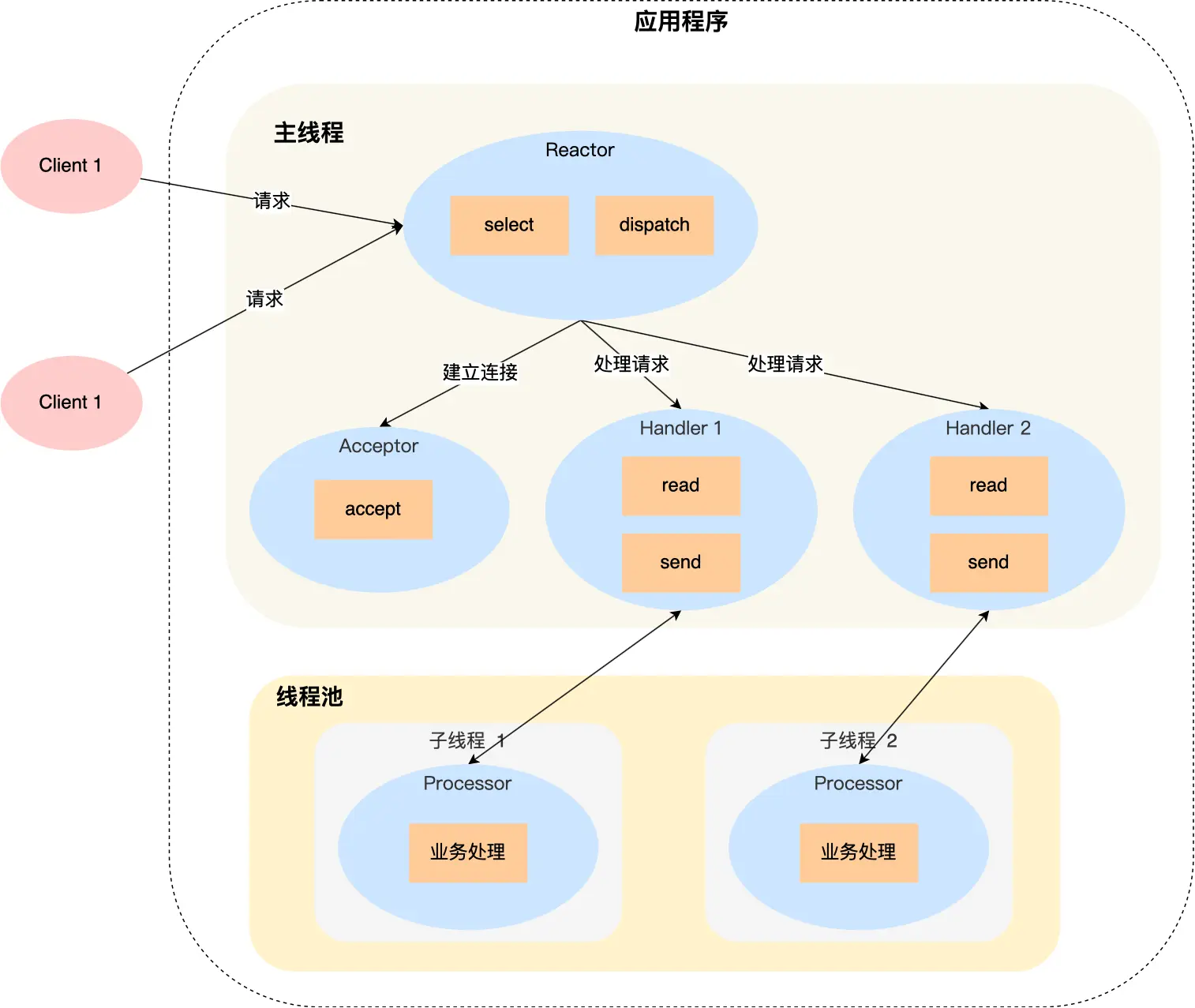

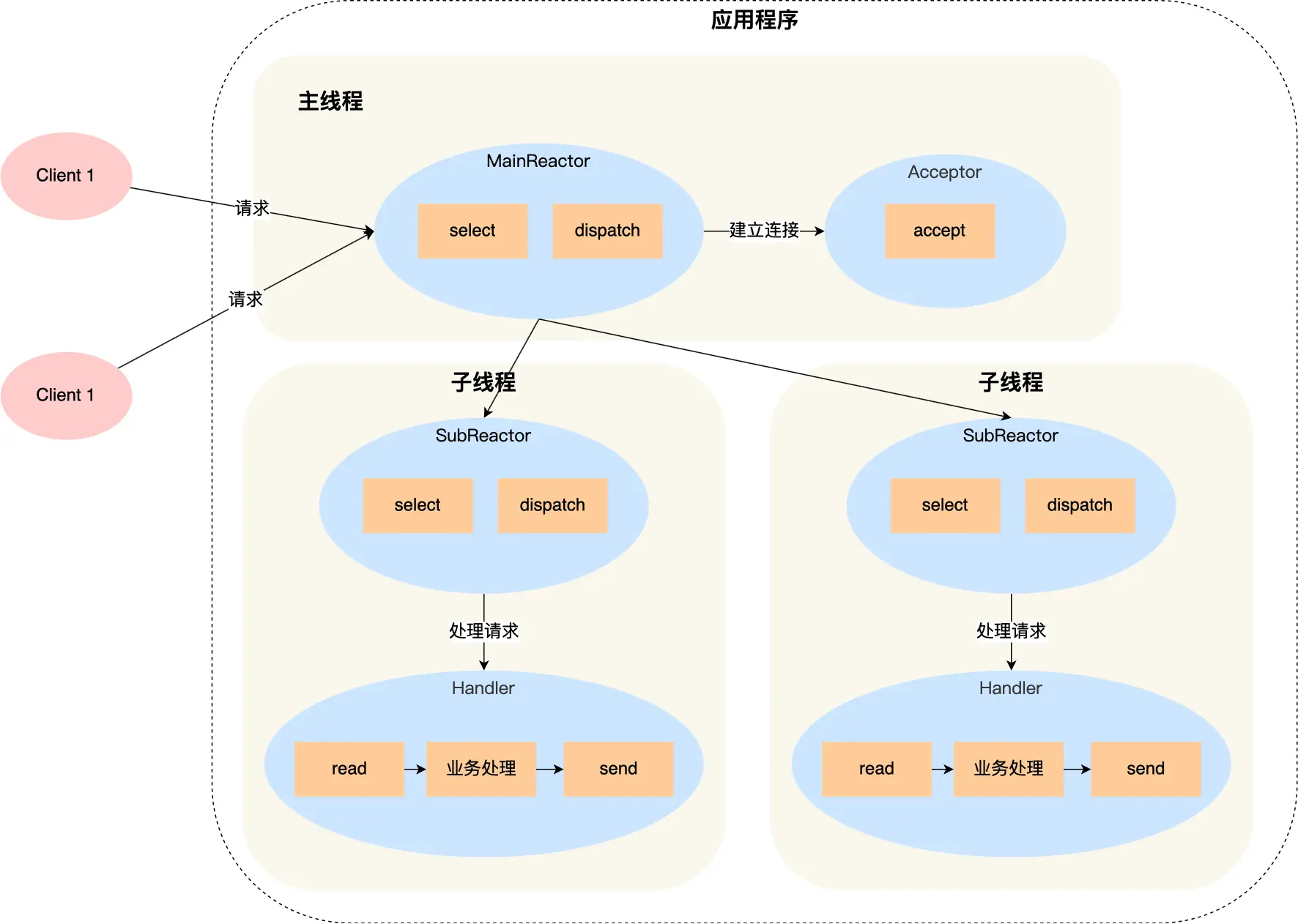

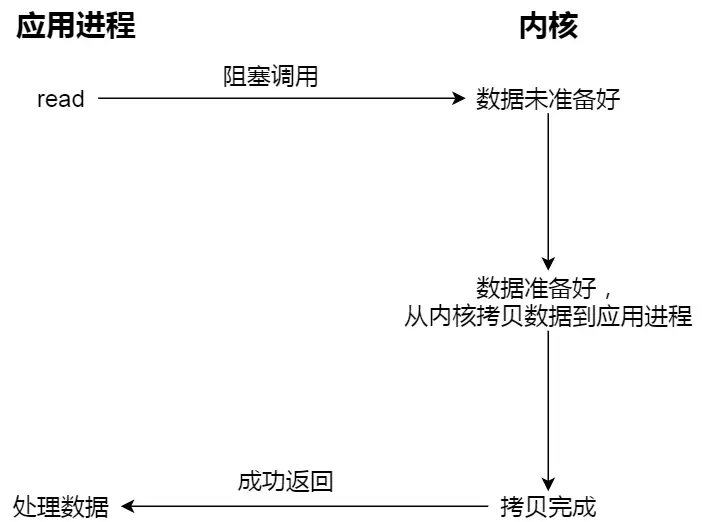

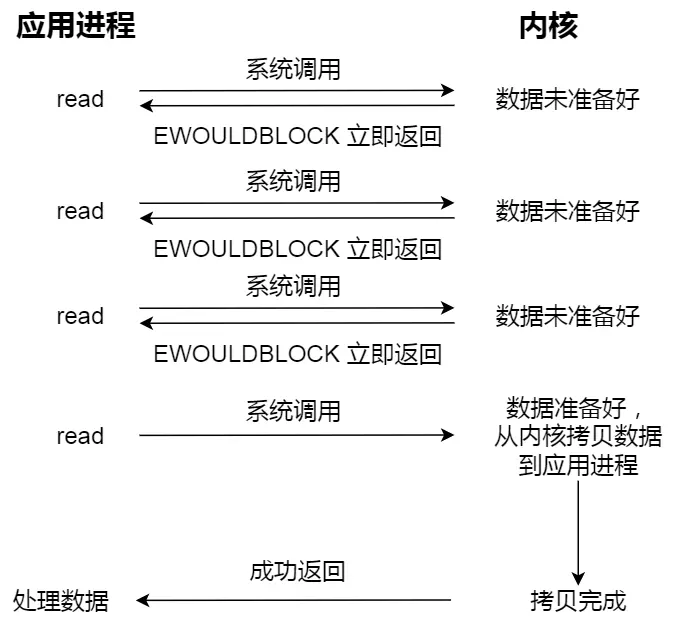

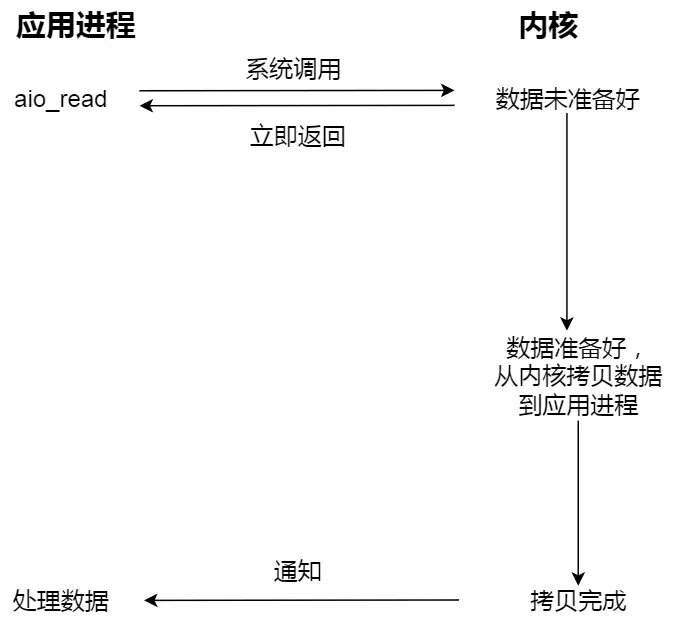

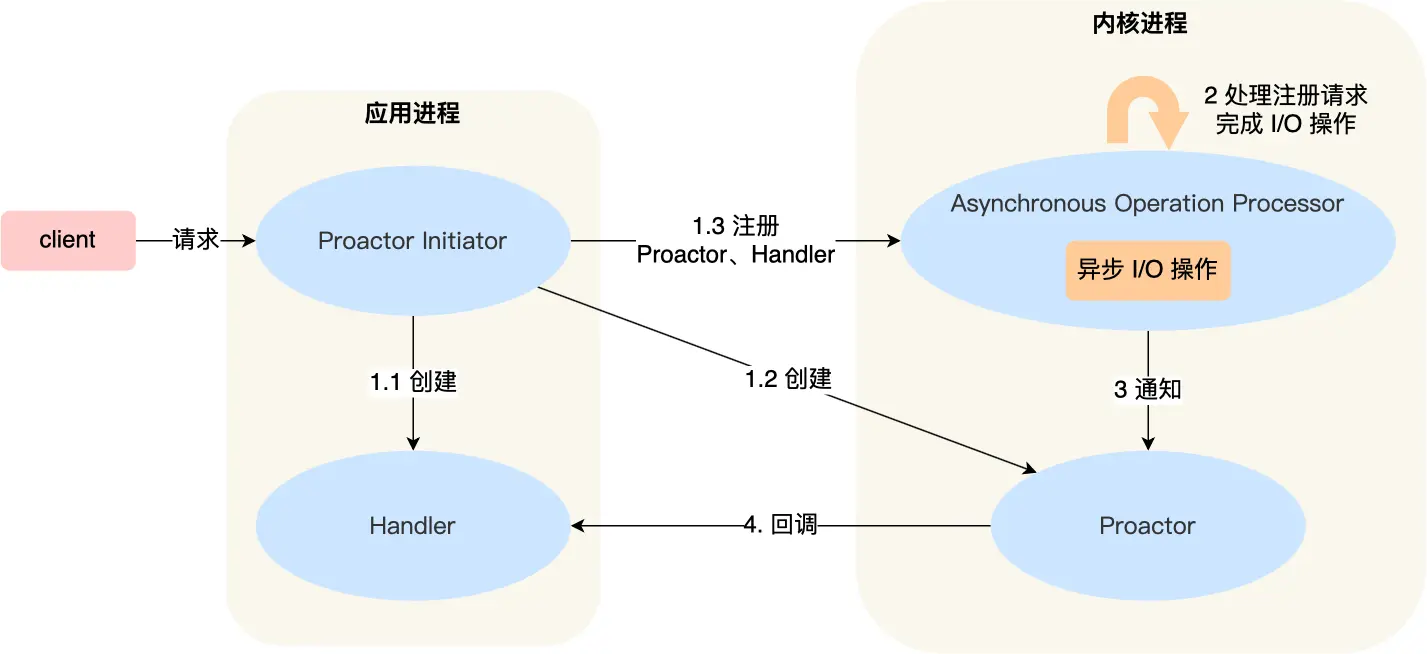

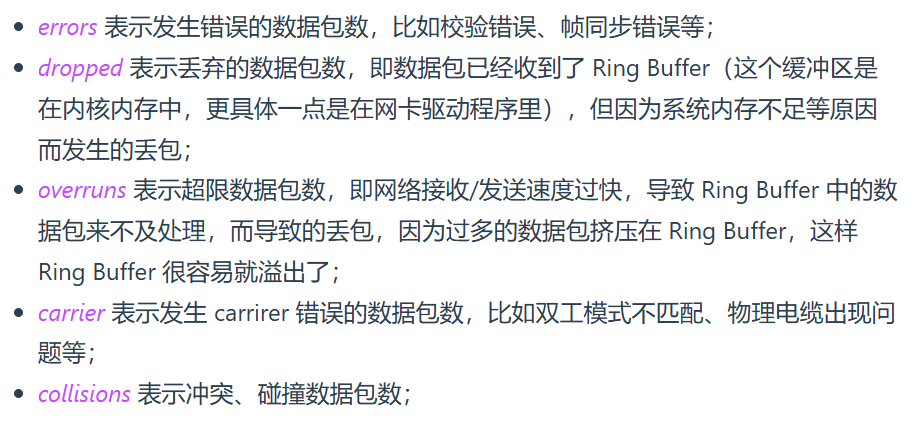

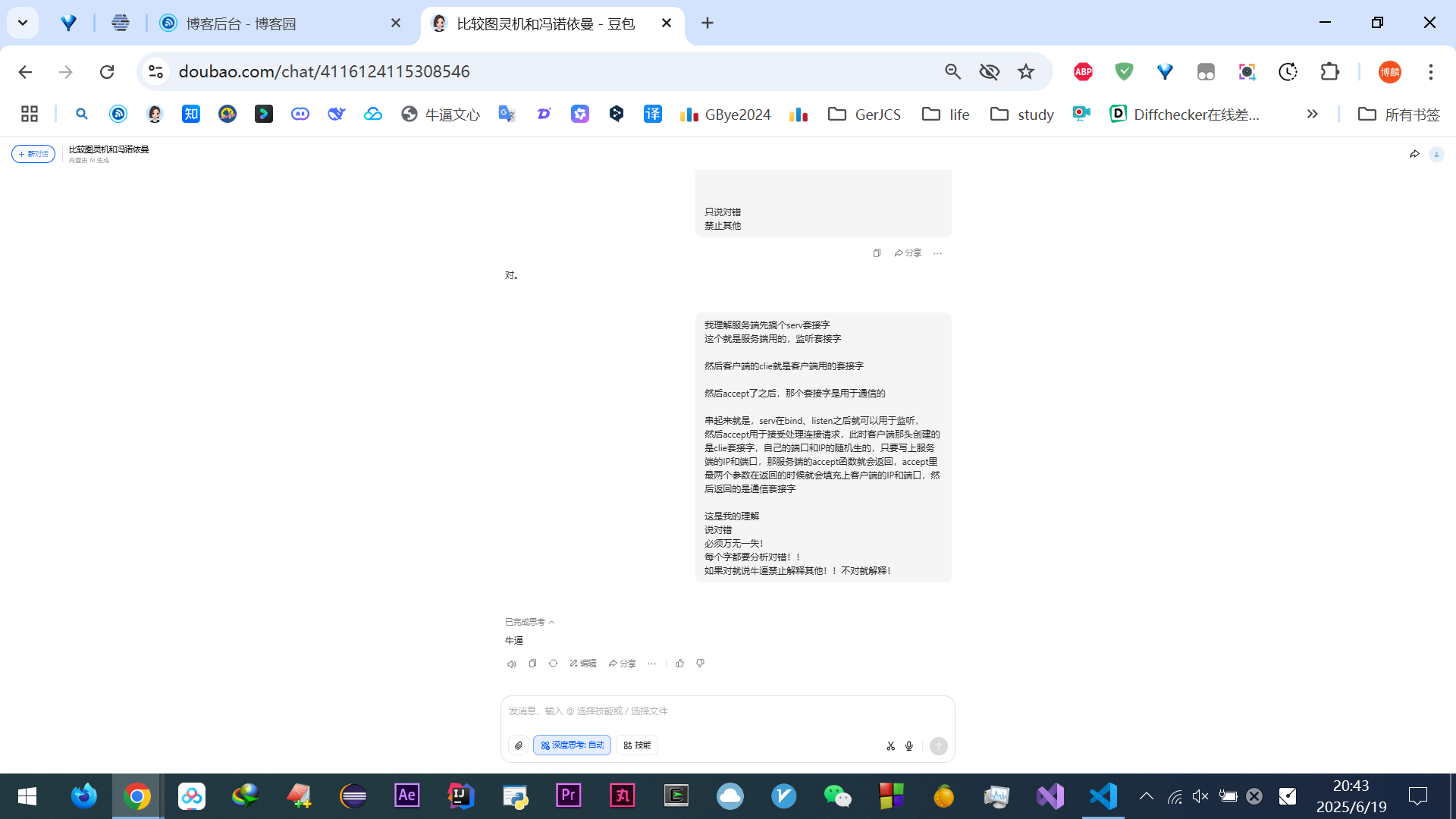

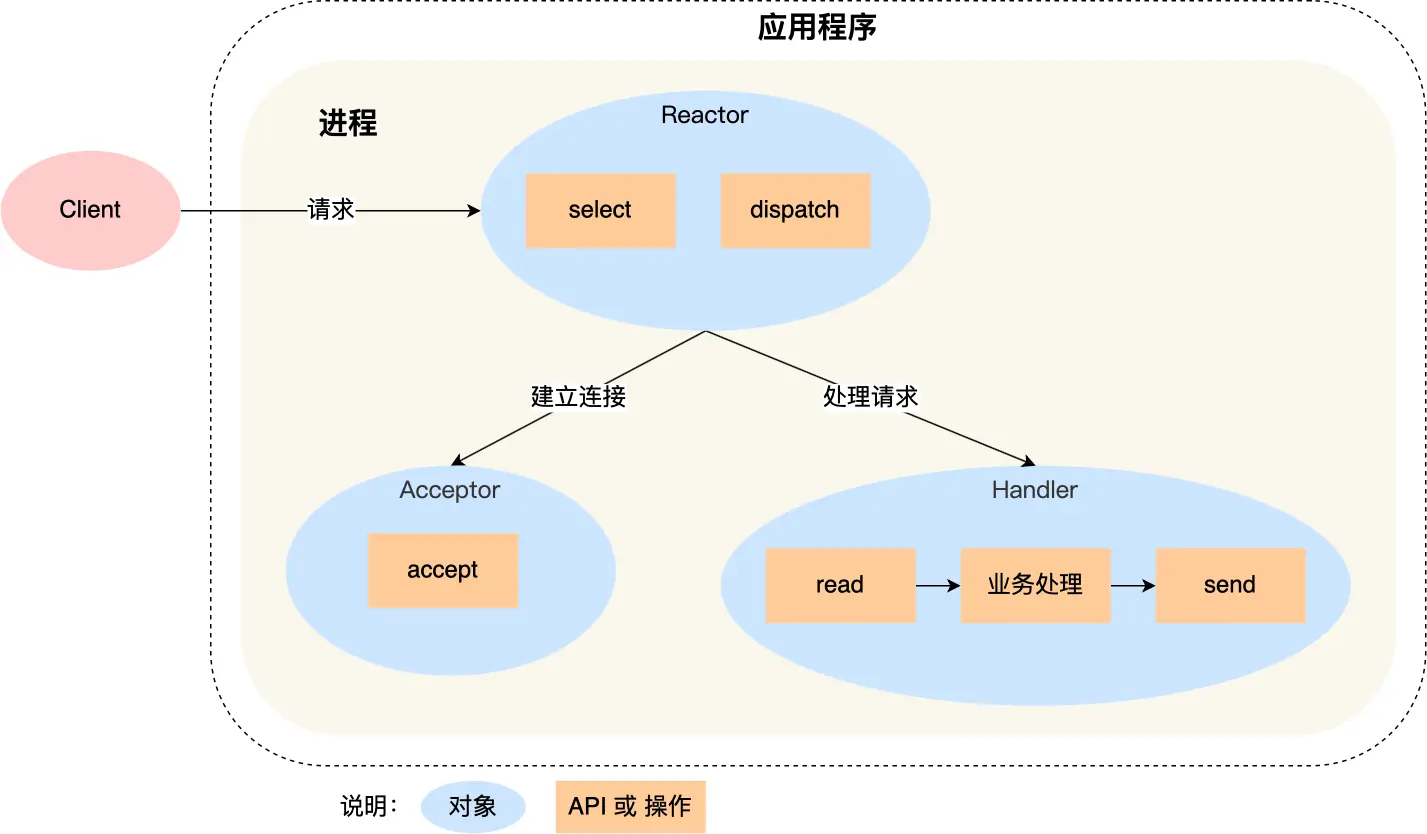

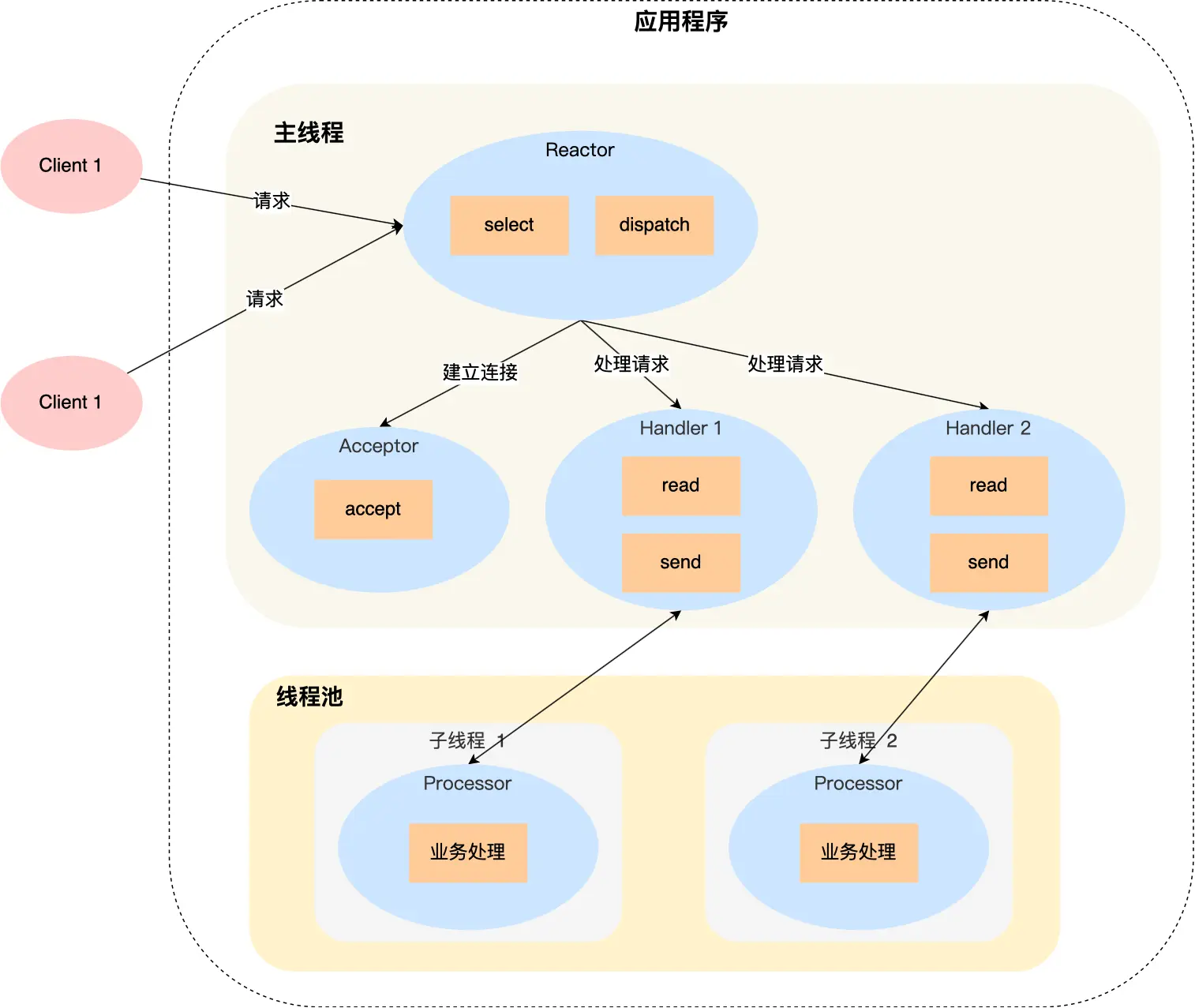

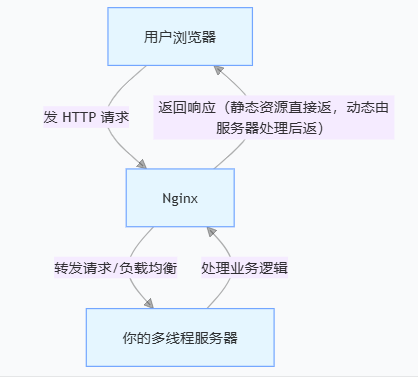

信号量