MateChat 智能应用:落地实践与创新探索 - 实践

引言:智能时代,前端如何拥抱 AI?

随着生成式人工智能(GenAI)技术的飞速发展,越来越多的企业和开发者开始思考:如何将 AI 能力无缝集成到现有产品中?尤其是在企业级 B 端应用、研发工具平台、云控制台等场景下,用户不仅需要功能强大的后端模型,更需要一个流畅、一致、可信赖的前端交互体验。

然而,直接调用大模型 API 并展示文本结果,远远不能满足真实业务需求。用户期望的是:

- 自然语言输入与结构化操作的融合

- 对话过程中的状态反馈(如“加载中”、“思考中”)

- 快捷指令引导(Prompt Suggestions)

- 多轮对话记忆与上下文管理

- 与原生业务流程深度耦合(如代码生成后自动插入编辑器)

这正是 MateChat 诞生的初衷。

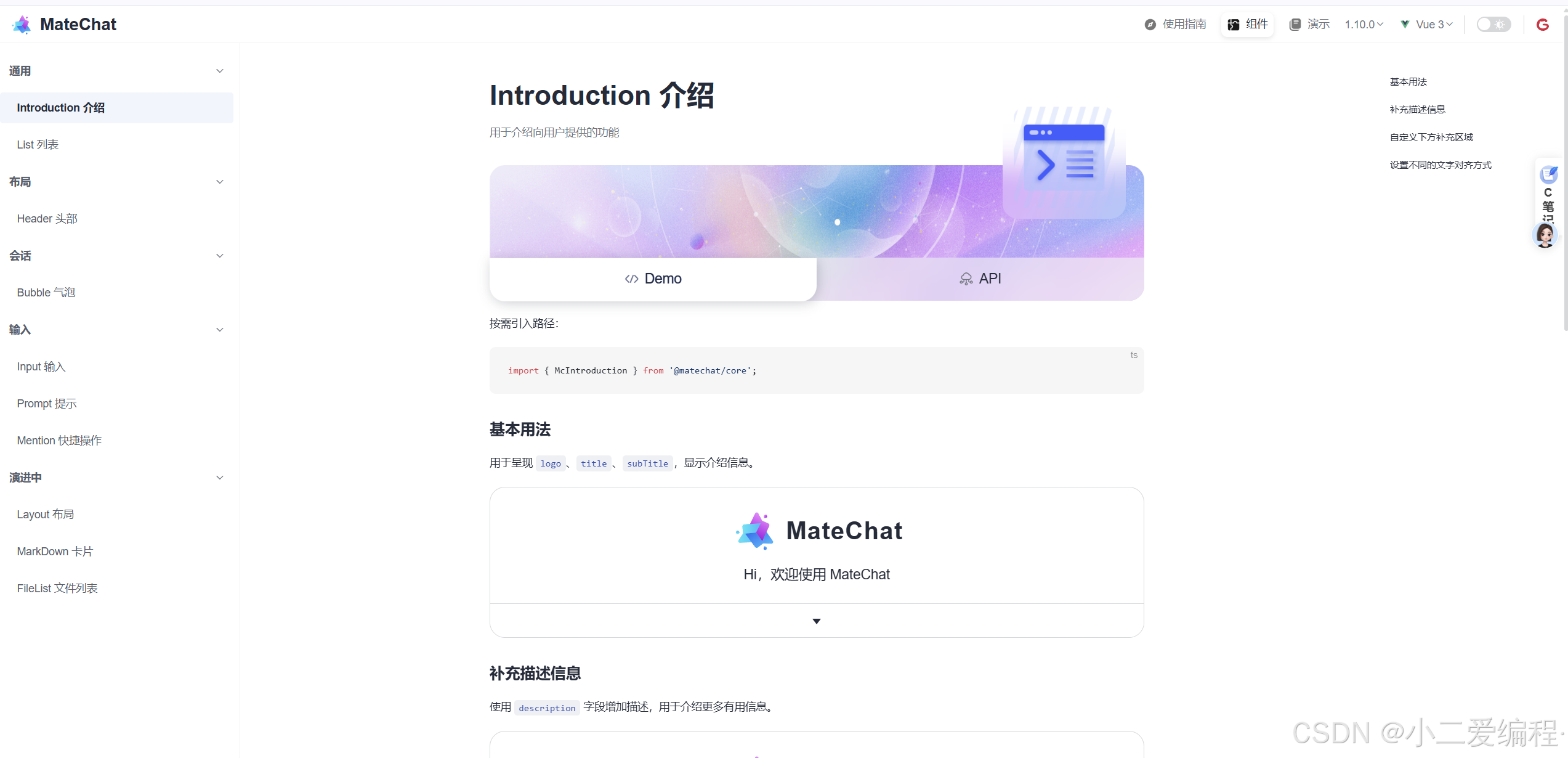

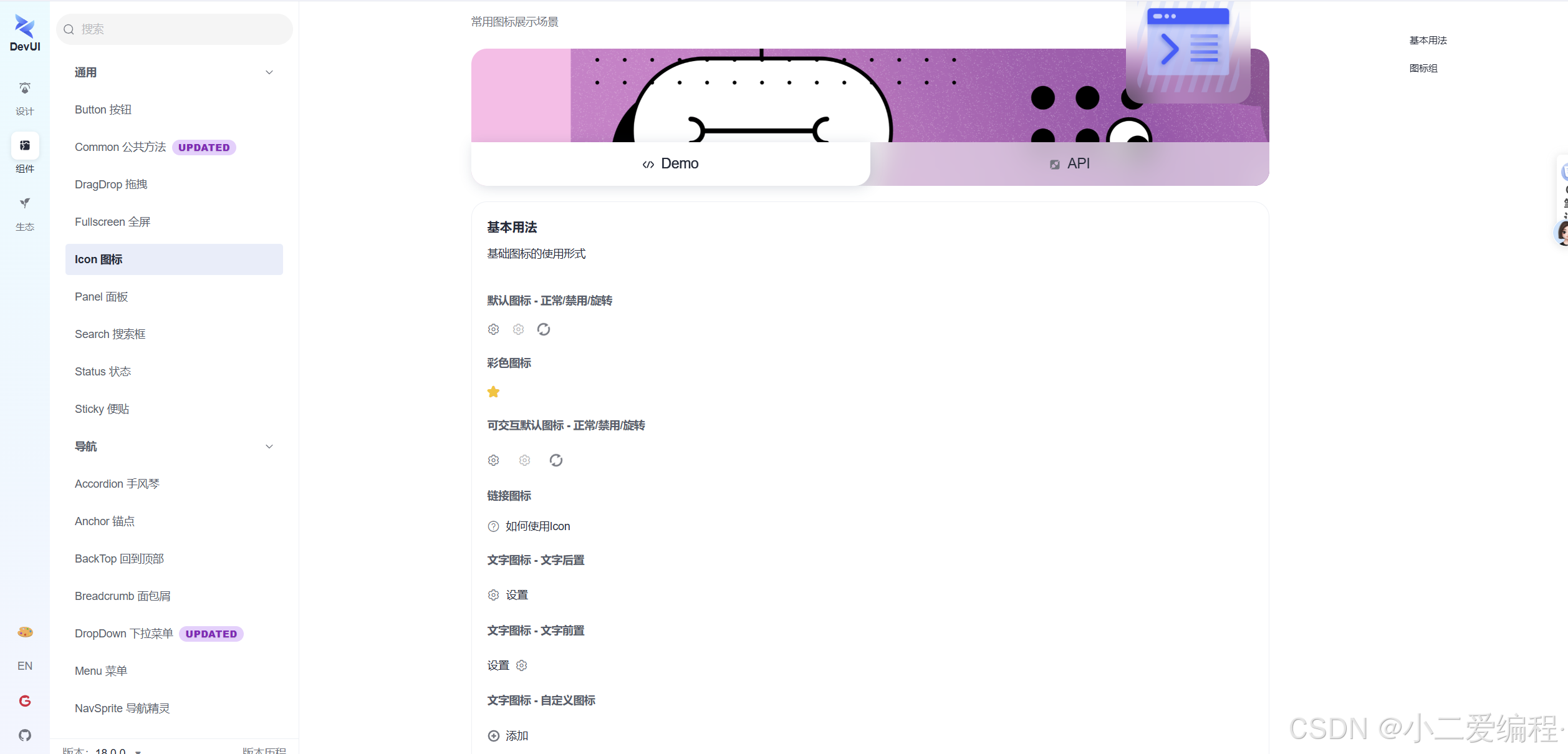

MateChat 是由华为 DevUI 团队打造的前端智能化场景解决方案 UI 库,专为构建 AI 应用而设计。它不仅提供开箱即用的对话组件(如气泡、输入框、快捷提示),还支持多主题适配、流式响应、自定义扩展,并已在 CodeArts 智能助手、InsCode AI IDE 等产品中成功落地。

本文将围绕 MateChat 的落地实践与创新探索,从零开始搭建一个完整的 AI 助手应用,并深入探讨其在智能体集成、知识检索、自然语言生成 UI、多模态交互等前沿方向的尝试,最后展望其未来潜力。

一、快速上手:5 分钟构建你的第一个 MateChat 应用

1.1 环境准备

我们使用 Vite + Vue 3 + TypeScript 作为基础框架:

npm create vite@latest my-matechat-app -- --template vue-ts

cd my-matechat-app

npm install安装 MateChat 及依赖:

npm install @matechat/core @devui-design/icons vue-devui注意:MateChat 基于 DevUI 组件库构建,因此需同时引入

vue-devui和图标库。

1.2 初始化应用

在 main.ts 中注册插件:

// main.ts

import { createApp } from 'vue'

import App from './App.vue'

import MateChat from '@matechat/core'

import '@devui-design/icons/icomoon/devui-icon.css'

import 'vue-devui/style.css'

const app = createApp(App)

app.use(MateChat)

app.mount('#app')1.3 编写基础对话界面

创建 App.vue,实现一个最简对话流:

<script setup lang="ts">

import { ref } from 'vue'

const inputValue = ref('')

const messages = ref>([])

const handleSubmit = async (content: string) => {

if (!content.trim()) return

// 用户消息

messages.value.push({ from: 'user', content })

inputValue.value = ''

// AI 正在思考(模拟加载)

messages.value.push({ from: 'ai', content: '', loading: true })

// 模拟 AI 响应(实际应调用模型 API)

setTimeout(() => {

const lastMsg = messages.value[messages.value.length - 1]

lastMsg.loading = false

lastMsg.content = `你刚才说:“${content}”。这是一个模拟回复。`

}, 800)

}

</script>

这就是 MateChat 的核心价值:你只需关注业务逻辑,交互细节由组件库处理。

二、落地实践:对接真实大模型(以 OpenAI 兼容 API 为例)

上述示例使用 setTimeout 模拟响应,实际项目需对接真实模型。我们以 盘古大模型 或 OpenAI 兼容接口 为例。

2.1 安装 OpenAI SDK

npm install openai2.2 实现流式响应(Streaming)

流式响应是 GenAI 应用的关键体验——用户希望看到 AI “逐字输出”,而非等待全部生成完毕。

// utils/aiClient.ts

import OpenAI from 'openai'

const client = new OpenAI({

apiKey: import.meta.env.VITE_AI_API_KEY,

baseURL: import.meta.env.VITE_AI_BASE_URL,

dangerouslyAllowBrowser: true,

})

export const streamCompletion = async (

messages: Array<{ role: string; content: string }>,

onChunk: (content: string, id: string) => void,

onComplete: (id: string) => void

) => {

const completion = await client.chat.completions.create({

model: import.meta.env.VITE_AI_MODEL || 'gpt-3.5-turbo',

messages,

stream: true,

})

let chatId = ''

for await (const chunk of completion) {

const content = chunk.choices[0]?.delta?.content || ''

chatId = chunk.id

onChunk(content, chatId)

}

onComplete(chatId)

}2.3 集成到 MateChat

修改 handleSubmit:

import { streamCompletion } from './utils/aiClient'

const handleSubmit = async (content: string) => {

if (!content.trim()) return

messages.value.push({ from: 'user', content })

inputValue.value = ''

// 添加 AI 加载态

const aiMessage = { from: 'ai', content: '', loading: true, id: '' }

messages.value.push(aiMessage)

try {

await streamCompletion(

[{ role: 'user', content }],

(delta, id) => {

aiMessage.content += delta

aiMessage.id = id

},

(id) => {

aiMessage.loading = false

aiMessage.id = id

}

)

} catch (error) {

console.error('AI 请求失败:', error)

aiMessage.content = '服务暂时不可用。'

aiMessage.loading = false

}

}关键点:

- 使用

ref引用的数组元素可直接修改(Vue 响应式)onChunk回调实时拼接内容,实现“打字机”效果- 错误处理提升鲁棒性

三、创新玩法探索

MateChat 不仅是一个 UI 库,更是智能化交互的基础设施。以下是我们团队在多个项目中验证的创新方向。

3.1 快捷指令(Prompt Suggestions)引导用户

新手用户常不知如何提问。MateChat 提供 <McPrompt> 组件,支持横向/纵向布局:

const onPromptClick = (item: { label: string; value: string }) => {

inputValue.value = item.label

handleSubmit(item.label)

}✅ 效果:降低使用门槛,提升首次交互成功率。

3.2 自然语言生成 UI(NL2UI)

设想:用户说“创建一个包含姓名、邮箱的表单”,AI 不仅返回文字,还生成可交互的表单组件。

实现思路:

- AI 返回结构化 JSON(描述 UI)

- 前端解析并动态渲染

// AI 返回示例

{

"type": "form",

"fields": [

{ "name": "name", "label": "姓名", "type": "text" },

{ "name": "email", "label": "邮箱", "type": "email" }

]

}在 McBubble 中扩展 content 类型,支持 VNode:

// 在 stream 完成后解析

if (isJson(msg.content)) {

const uiSpec = JSON.parse(msg.content)

if (uiSpec.type === 'form') {

msg.vnode = h(FormRenderer, { spec: uiSpec })

}

}意义:实现“所想即所得”的开发体验,极大提升生产力。

3.3 知识检索增强(RAG)

纯大模型存在幻觉问题。通过 检索增强生成(RAG),可让 AI 基于企业私有知识回答。

前端配合:

- 在输入框下方显示“引用来源”

- 点击跳转原文

MateChat 支持在 McBubble 中插入自定义 slot:

后端需在流式响应中携带

sources字段(可通过 SSE 扩展协议实现)。

3.4 多模态交互:图像、代码、表格

MateChat 内置对 Markdown 渲染 的优化,支持:

- 代码块(带复制按钮)

- 表格(自动适配宽度)

- 图片(点击放大)

但更进一步,可识别 AI 返回的特定标记,渲染富组件:

// 如果内容包含 标签,替换为 McImage

if (content.includes('

结合 DALL·E、Stable Diffusion 等模型,实现“文生图”闭环。

四、高级能力:记忆、智能体与工作流

4.1 对话记忆(上下文管理)

默认情况下,每次提问都是独立的。但真实场景需要多轮上下文。

实现方案:

前端维护完整对话历史每次请求携带最近 N 条消息

const conversationHistory = ref>([])

const handleSubmit = async (content: string) => {

// 添加用户消息

conversationHistory.value.push({ role: 'user', content })

// 构建上下文(保留最近 6 条)

const context = conversationHistory.value.slice(-6)

// 调用 AI

await streamCompletion(context, ...)

// 添加 AI 回复到历史

conversationHistory.value.push({ role: 'assistant', content: finalContent })

}

⚠️ 注意 token 限制,需动态裁剪。

4.2 智能体(Agent)集成

MateChat 可作为 Agent 的前端载体。例如:

用户问:“帮我部署这个服务”Agent 调用 CI/CD 工具 → 返回操作链接前端渲染“一键部署”按钮

这要求后端返回结构化动作指令(Action Schema)。

4.3 思维链(Chain-of-Thought)可视化

高级 AI 会“分步思考”。MateChat 可通过折叠面板展示推理过程:

// AI 返回

{

"final_answer": "答案是 42",

"reasoning_steps": [

"步骤1:解析问题...",

"步骤2:查询数据库...",

"步骤3:计算结果..."

]

}

前端渲染:

{{ finalAnswer }}

- {{ step }}

提升可信度,让用户理解 AI 如何得出结论。

五、性能与体验优化

5.1 流式响应防抖与合并

网络波动可能导致 chunk 过小(如每次只返回 1 个字符)。可设置缓冲区:

let buffer = ''

let timeoutId: NodeJS.Timeout | null = null

const onChunk = (delta: string) => {

buffer += delta

if (timeoutId) clearTimeout(timeoutId)

timeoutId = setTimeout(() => {

aiMessage.content += buffer

buffer = ''

}, 30) // 30ms 合并

}

5.2 主题定制与暗黑模式

MateChat 基于 DevUI,支持 CSS 变量主题切换:

:root {

--mc-bg-color: #ffffff;

--mc-text-color: #333333;

}

[data-theme='dark'] {

--mc-bg-color: #1e1e1e;

--mc-text-color: #e0e0e0;

}

在 McLayout 上绑定 class 或 data-theme 即可切换。

5.3 响应式布局

MateChat 组件默认适配移动端:

@media (max-width: 768px) {

.container {

width: 100%;

margin: 0;

border: none;

border-radius: 0;

}

}

六、未来展望:MateChat 的无限可能

MateChat 的定位不仅是“聊天 UI”,而是 GenAI 时代的前端操作系统。

6.1 低代码 + AI 融合

想象:在低代码平台中,拖拽一个 “AI 助手” 组件,配置模型和提示词,即可生成智能模块。

MateChat 提供的组件化能力,天然适合此类场景。

6.2 跨平台一致性

MateChat 正在推进 Angular 版本(@matechat/ng),未来将支持:

WebElectron 桌面应用移动 Hybrid 应用

确保同一套交互语言贯穿所有终端。

6.3 开放生态

我们计划开放:

插件机制(如翻译插件、代码解释器插件)社区组件市场可视化 Prompt 编排工具

让开发者像搭积木一样构建 AI 应用。

结语

从一个简单的对话气泡,到支撑企业级智能助手的完整解决方案,MateChat 正在重新定义前端在 AI 时代的角色。

它不是炫技的玩具,而是解决真实问题的工程化工具。无论你是想为内部系统添加智能客服,还是打造下一代 AI IDE,MateChat 都能让你聚焦业务,而非重复造轮子。

现在就访问 MateChat,开启你的智能化之旅!

相关链接:

MateChat:https://gitcode.com/DevCloudFE/MateChat

MateChat官网:https://matechat.gitcode.com

DevUI官网:https://devui.design/home

浙公网安备 33010602011771号

浙公网安备 33010602011771号