10秒开发一个基于字的3-gram的拼音输入法:魔改sunpinyin

apt source libsunpinyin3v5 下载到当前目录下。

src/sunpinyin-dictgen是个有shebang的Makefile:

#!/usr/bin/make -f

W3M = wget -q -O -

DL_LIST = https://sourceforge.net/projects/open-gram/files/

DL_HOST = https://jaist.dl.sourceforge.net

DL_ROOT = ${DL_HOST}/open-gram

DICT_PAT = 'dict\.utf8-[0-9]\+.tar.bz2'

SLM_PAT = 'lm_sc\.3gm\.arpa-[0-9]\+.tar.bz2'

DICT_AR = $(shell ${W3M} ${DL_LIST} | grep -o ${DICT_PAT} | sort -u | tail -n 1)

光腚make为了求变量DICT_AR的值也要联网,虽然比Android Studio快得多,我还是不喜欢。

此版本下载dict.utf8就够了。

写个小烂Python程序可从dict.utf8提取字,得到如下文件:

<unknown> 0 <unknown_cn> 2 <amigu> 9 <stok> 10 <Digit> 20 <Simbol> 21 <NONEWORD_ALLWORD> 69 , 70 。 71 ; 72 ? 73 ! 74 : 75 “ 76 ” 77 、 78 … 79 㐀 100 qiu ... 袏 26753 zuo 阼 26754 zuo

注意调整ID连续。while 1: input(),用<输入,split(), ' '.join(fields)...

语料用的《锦医卫》。

$ mmseg -d dict.utf8 corpus >ids

$ ids2ngram -n 3 -s /dev/shm/swap -o 3gram -p 1024000 ids # 用内存盘

$ slmbuild -l -n 3 -o all.slm -w 26700 -c 0,3,2 -d GT,8,0.9995 -d ABS -d ABS -b 10,11,12 -e 9 3gram

照抄光腚slmbuild的Example改了下文件名。

$ slmthread all.slm lm_sc.t3g

这步是必须的,因为它要浮点转整数等,online部分不接受all.slm,虽然不crash,但候选字的顺序都乱了。

Compressing pr values...13530 float values ==> 13530 values

Compressing bow values...17422 float values ==> 16384 values

Threading the new model...slmthread: src/slm/thread/slmthread.cpp:383: int main(int, char**): Assertion `bowit != bow_map.end()' failed.

已放弃

不放弃,改程序。:-)

// assert(bowit != bow_map.end()); if (bowit == bow_map.end()) { cerr << "val=" << val << endl; for (bowit = bow_map.begin(); bowit != bow_map.end(); ++bowit) if (fabs(bowit->first - val) < 1e4) break; assert(bowit != bow_map.end()); }

map<float, int>里查不到。作者预见了,注释里有// precision error,但没预见到这种情况。cerr...后代码为新增。没几个,一点不慢。

slmprune不是必须的,我们的模型小。

$ genpyt -i dict.utf -o pydict_sc.bin -l log -s all.slm -e le

Opening language model...done! Writing out...done! Printing the lexicon out to log_file...段错误

啊啊啊!最后一步啦!!原来是字典文件名输入错了。输入错LM文件名则:

Opening language model... open al.slm: 没有那个文件或目录 error!

然后换数据文件。建个符号链接 data -> /usr/lib/x86_64-linux-gnu/sunpinyin/data/ 不然敲得太烦了。

先备份原先的,不过就算坏了,可:apt reinstall sunpinyin-data

虽然mmseg.cpp里setlocale(LC_ALL, ""); 含义是用当前locale;但portability.cpp里MBSTOWCS里写死了iconv_open("UCS-4LE", "UTF-8"); 补充:还有fgetwc, setvbuf下?

语料其实是head -n 10000的1.7MB. 模型:915K lm_sc.t3g 449K pydict_sc.bin

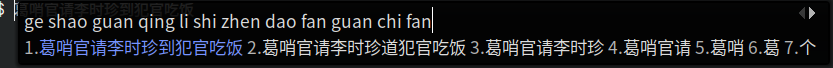

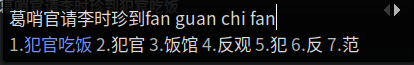

虽然是字,但可是tri-gram啊。张紫萱、葛哨官……都有。

本帖使用上述小模型和用户辞典输入。〔链接1〕〔链接2〕〔链接3〕

在Intel N100上,12M语料训练秒级,100M语料(wiki_zh/AA)训练分钟级。整句输入效果不太好,“蹦词”可以。

模型小不了,数据太稠密了:16000**3受不了。【改:可增加cutoff,小模型依然可用,token量大时太小的模型无用】【110MB字3-gram模型输入这些话很爽】

〔语料1〕〔语料2〕语料1删掉空格后45M,训练不到半分钟。

用高频短词+字应该效果更好。苍蝇拍打苍蝇比高射炮好。这算不算种更针对领域,效果更好的平滑算法?

google拼音:48,068词, 41,442 二三字词,哈哈哈 哦哦哦都是词。

输入zhang zi xuan,出来长子县。汉典:县 xuan 同 “悬” —— 名人写别字不算别字?!

mmseg不允许一个词有多个读音,正在试验系统词典和分词词典不同:[成功]

要是公安部把身份证上的人名和住址都dump出来当语料,就好了。分成两个文件乱下序,好象也没啥隐私问题。还有工商名录。

RIME (中州韵)是个开源的输入法引擎,有多种平台下的前端(client),Windows下的叫Weasel (小狼毫)。

pydict_sc.bin: lm_sc.t3g genpyt -e le -i sunzi -s $< -l /t/pydict_sc.log -o $@ lm_sc.t3g: all.slm slmthread $^ $@ all.slm: 3gram slmbuild -l -n 3 -o $@ -w 26700 -c 0,3,2 -d GT,8,0.9995 -d ABS -d ABS -b 10,11,12 -e 9 $< 3gram: mmseg -d sunzi jinyiwei >ids ids2ngram -n 3 -s /t/swap -o $@ -p 1024000 ids rm ids install: mv lm_sc.t3g data mv pydict_sc.bin data clean: rm -f ids 3gram all.slm

浙公网安备 33010602011771号

浙公网安备 33010602011771号