day11-本地部署千问大模型

今日内容

1 补充

1.1 dify服务开启和关闭

# 1 如果装在win上,mac上---》机器关闭---》服务自然也就停了

-win上,mac 重启,服务上不会自动重启,需要我们执行命令启动

-来到 dify的目录--》D:\dify\dify-1.11.4\dify-1.11.4\docker

-先启动:docker-destop

-执行命令:【一定要启动docker-destop】

docker compose up

-跑在本地

本机ip地址:其它设备必须用ip地址

127.0.0.1 都可以--》意思是访问自己

# 2 如果装在虚拟机上--》停止和启动

## 2.1 启动

- 开启你的机器:win,mac

- 开启虚拟机:可能ip地址会变

- 远程连接:finallshell

- 启动docker :没有图形化界面

systemctl start docker

-dify启动命令:对应目录

cd /root/dify-1.11.4/docker

docker compose up # 起过一次后,速度非常快

-浏览器访问即可

## 2.2 关闭(正常)

- 关闭dify

-ctrl +c

-来到dify的docker 目录--》命令:docker compose stop

- 关闭docker

systemctl stop docker

- 关闭虚拟机

shutdown now

或者:直接在vmware上点 X

- win、mac关机【直接关机可以的】

# 3 这个过程这么麻烦,公司中如何做?

- 公司中机器7*24*365天,从来不关机,一刻不停的运行

- 类比:支付宝,一直能用,如果某一天1分钟不能用了,也是个大新闻

1.2 本地服务和远程服务

# 1 本地,在dify的docker目录下,执行了 docker compose up 后,浏览器中就能访问dify 的服务

-只能我们直接访问使用,其它人都用不了?

-其实其他人能用:前提是你们要在同一个局域网中【连到同一个路由器上】

-dify 服务,在电脑上运行起来了

-电脑、手机也连了同一个路由器---》就可以通过ip地址直接访问到dify服务

-192.168.1.105

-每一个联网的设备,都会有自己的一个ip地址

-不是同一个局域网,能用吗? coze可以直接访问?

-不是同一个局域网,不能访问的

-coze服务部署在公网上:所有互联网用户都可以访问的地址

-我就想把dify部署了,大家都可以用,互联网用户都可以用---》部署在服务器上【有公网ip】

# 2 服务是什么?

-软件在服务器上运行,比如淘宝:不是一个程序,多个程序组成的:支付程序,商城的程序,下单程序

-这些程序,我们称之为服务---》一个淘宝:是由多个服务配合而成

-服务:运行在服务器上的软件

-coze:很多服务组成--》因为在公网,所以所有互联网用户都可以访问

-dify:很多服务组成--》没在公网--》只能局域网[自己],能用

# 3 本地服务和远程服务

-跑在本地机器win上的程序---》只能我们直接用--》叫本地服务

-跑在公网机器上【linux】上的程序---》互联网用户直接用--》叫远程服务

2 云服务器部署dify

已经讲完了:

win、mac本地部署dify

虚拟机linux中本地部署dify

----------只能本地玩------------------

---------想互联网用户都玩----云服务部署----

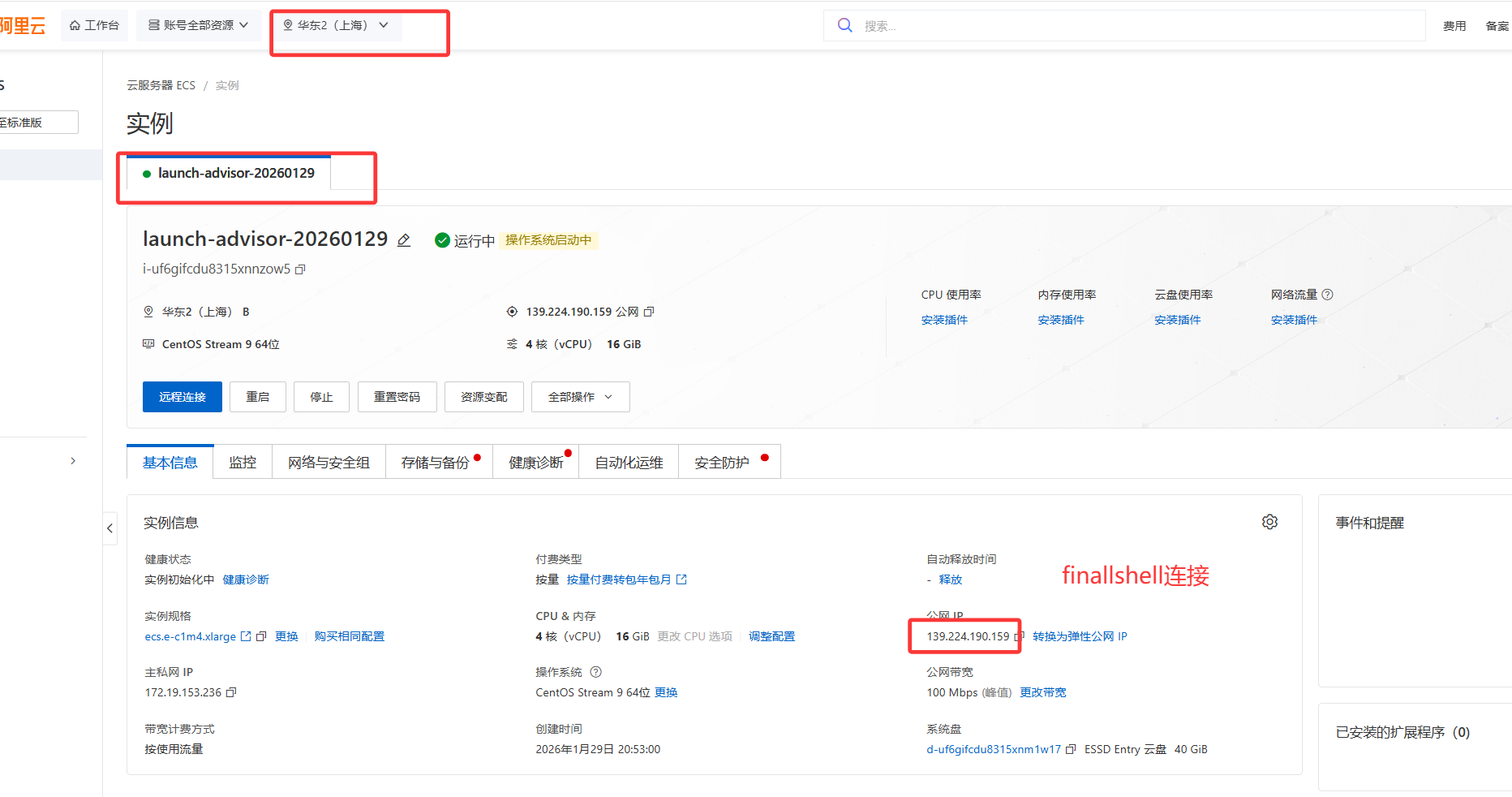

# 1 云服务器部署dify步骤

1 有一台云服务器---》购买

-有操作系统,肯定不会装win,上linux

2 在云服务器上安装docker

3 启动dify服务器即可

4 所有互联网用户通过ip就可以访问

#1 购买云服务器:类比成:去电脑市场配电脑——》内存多大,硬盘多大,cpu上什么,装什么操作系统?

-很多公司卖:阿里,腾讯,华为。。。。特别多

-以阿里云为例:花钱-----》新用户免费试用?新用户一年99活动?

-阿里服务器在哪?

全国各地都有机房,例如杭州西湖底下就有机房:恒温恒湿,上海,西藏。。。

相当于从它机房租了一台机器---》我们看不到--》只能远程连接使用【ip地址:公网】:电费他们出--》租用

# 2 建议:大家如果本地能跑dify,先不用买,因为需要花钱

# 3 购买云服务器[以阿里为例,大家可以自行选择其他便宜的]

https://ecs.console.aliyun.com/?spm=5176.12818093_47.resourceCenter.1.3be92cc9PrgvfE

-创建实例:租用服务器

# 4 选择配置,下单

-包年包月:买了一年,一年都是你用

-按量付费:按小时,按流量---》用多少花多少--》讲课用

-必须冲100及以上才行

-抢占式实例:便宜,相当于竞价--》别人出的价格高--》你的自动释放,给那个人用

租 ip17手机--》2块钱一小时--》打着王者

6 块钱一小时--》不通知你,直接夺过来,给别人了

# 5 购买完

-等同于之前在虚拟机上,安装好了centos9

-接下来只需要 远程连接操作即可,跟之前虚拟机操作完全一致

# 6 远程连接finallshell

# 7 安装docker

sudo dnf config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sudo dnf install docker-ce docker-ce-cli containerd.io docker-compose-plugin -y

vi /etc/docker/daemon.json # 可以不改--》如果是阿里云机器--》自动做docker加速

{

"registry-mirrors" : [

"https://docker.1ms.run",

"https://docker.kejilion.pro",

"https://docker-registry.nmqu.com",

"https://docker.xuanyuan.me",

"https://dockerproxy.net",

"https://docker.m.daocloud.io",

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc",

"https://do.nark.eu.org",

"https://dc.j8.work",

"https://dockerproxy.com",

"https://gst6rzl9.mirror.aliyuncs.com",

"https://registry.docker-cn.com",

"http://hub-mirror.c.163.com",

"http://mirrors.ustc.edu.cn/",

"https://mirrors.tuna.tsinghua.edu.cn/",

"http://mirrors.sohu.com/"

],

"insecure-registries" : [

"registry.docker-cn.com",

"docker.mirrors.ustc.edu.cn"

],

"debug": true,

"experimental": false

}

systemctl daemon-reload # 重新加载docker配置

systemctl restart docker # 重启docker

systemctl start docker # 启动docker

# 8 上传dify

-上传dify

-解压:unzip dify-1.11.4.zip

-进入目录:cd dify-1.11.4/docker

-复制配置文件 :cp .env.example .env

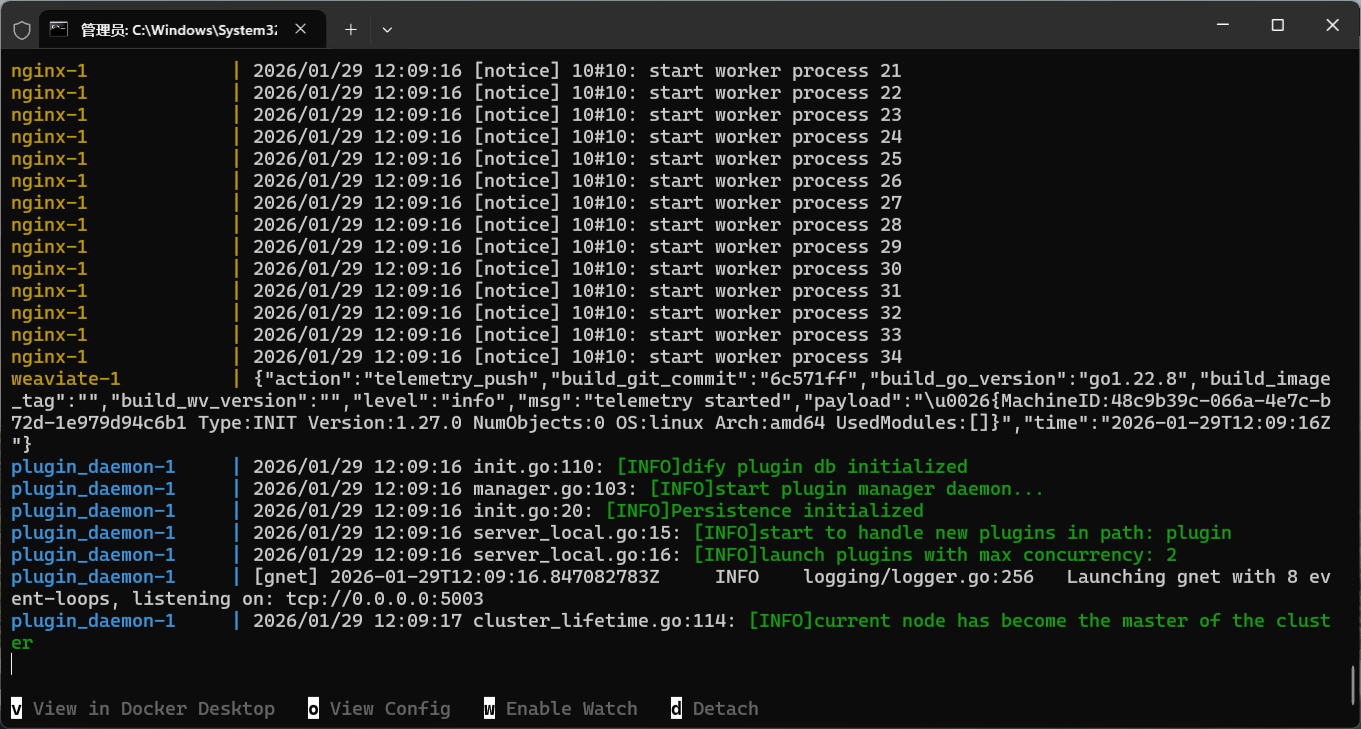

# 9 启动dify

docker compose up

# 10 你们如果拉取不了---》就按照之前学的配置国内镜像站

我用阿里云的加速:只能我用

vi /etc/docker/daemon.json

{

"registry-mirrors": ["https://x1566319.mirror.aliyuncs.com"]

}

systemctl daemon-reload # 重新加载docker配置

systemctl restart docker # 重启docker

# 11 浏览器访问:所有人

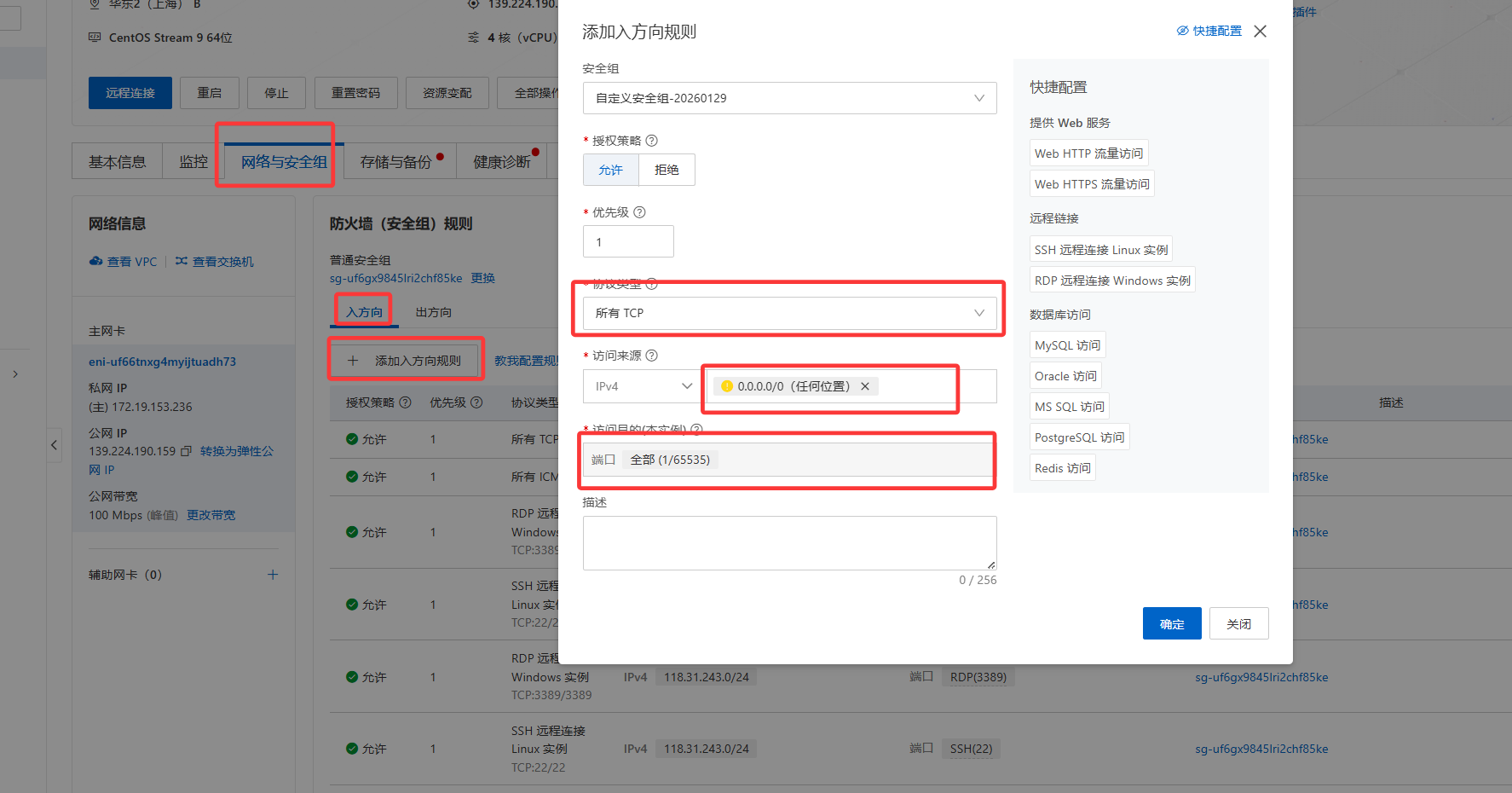

2.2 安全组

# 1 我们浏览器访问:

http://139.224.190.159/apps

实际上是我们机器--》向139.224.190.159地址的80端口访问呢

默认上不允许的

# 2 需要关闭防火墙:自己的虚拟机

# 3 云服务器:关闭防火墙--》等同于安全组

所有端口都打开了

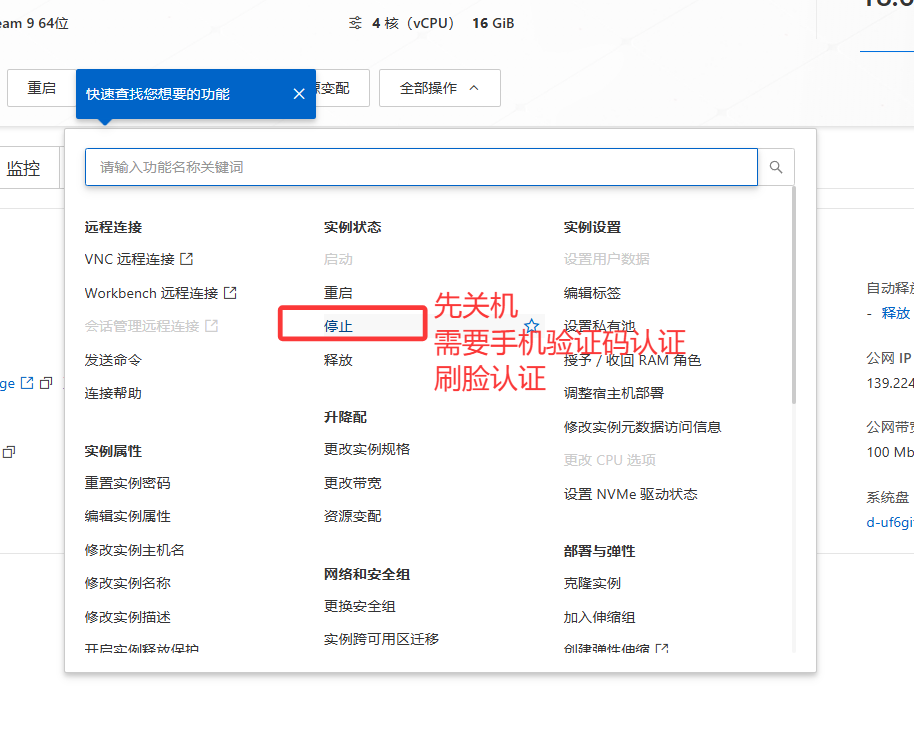

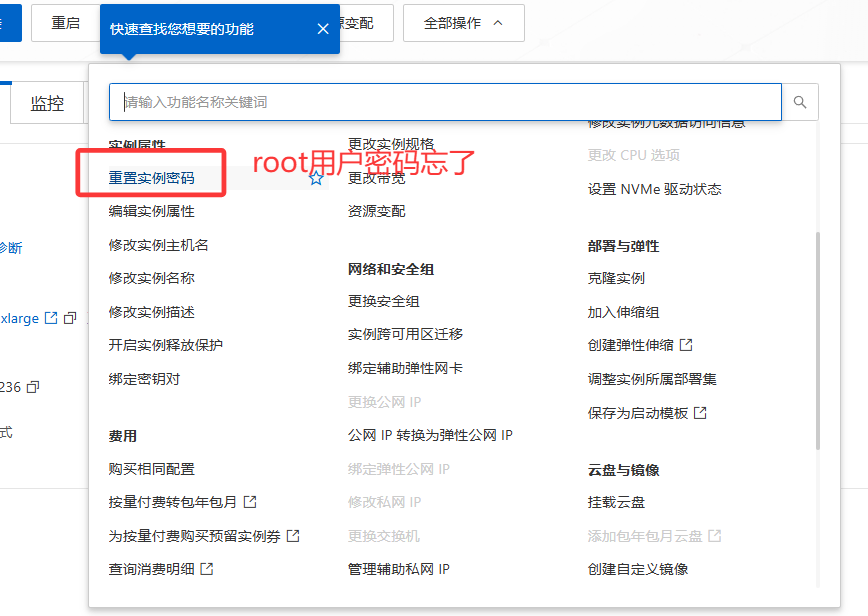

2.1 云服务的释放

# 1 买了按量服务--》按小时计费--》如果不释放--》只是关了机--》也收钱

# 2 练习完了--》就要释放服务器

-先关机

-释放

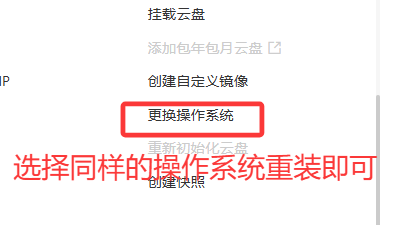

# 3 如果练出问题--》重装系统

# 4 重置密码

#1 如果买云服务器同学,建议dify学完后---》买个4,5个小时,练习完即可---》后续再用来赚外快,再说

#2 每次释放后,重新买---》又要装docker,dify

# 3 包年包月---》整个一年属于你,想什么时候用,就什么时候用

# 3 一定不要忘记释放--》一直扣钱

-

3 本地大模型部署

3.1 概念

# 1 之前学coze---》用豆包的大模型---》用的过程中--》扣资源点--》因为我们每次用,都在用人家的算力--》所以才会收你费--》这个算力其实很贵

# 2 dify 只是个软件---》大模型:可以对接任意厂商:DeepSeek,豆包,阿里千问,GPT

-对接他们的,还是用人家算力--》还要花钱买资源点

-如果我们机器性能不错:自己把大模型跑在本地--》无论coze,dify 都可以对接本地大模型

-使用大模型就免费了

-本地部署:对机器性能要求非常非常高---》部署时候要吃算力--》需要显卡

-一般显卡还不行

-99.5% 电脑不行---》台式机,目前行情--》2.5w以上机器能勉强跑个小模型

-消费级5090显卡:2w多,内存条128G:1w,2T 几千块

# 3 但是:使用ollama软件--》可以不用显卡,使用cpu + 内存 跑一般的大模型,企业中是不行的,我们用用可以

本地你要比肩豆包--》消费级的机器,基本不行

# 4 使用ollama这个软件,跑本地大模型---》因为大家电脑配置一般--》不要对他有太高希望

-给你回答一些简单问题

-陪你聊聊天

-图像识别--》也行---》对机器有要求

# 5 接下来步骤:

1 安装ollama

2 部署千问大模型

####################6 参数规模与模型大小######################################

1.5B-70B:参数量从15亿到700亿不等,模型大小约4GB至140GB 。

671B主模型:参数量最大(6710亿),模型大小约720GB,但实际部署多使用蒸馏后的子模型 。

## 性能差异

大模型(如70B):

准确性更高,适合复杂任务(如长文本理解、逻辑推理)

推理延迟较高,需高性能硬件(如NVIDIA A100)

小模型(如1.5B):

响应速度快,适合低延迟场景(如移动端)

准确性较低,复杂任务表现较差

## 部署成本

大模型:

需更高显存(如70B需140GB显存)和更强GPU(如A100) 。

训练和推理成本高 。

小模型:

显存需求低(如1.5B仅需4GB显存) 。

可部署在普通GPU(如RTX 3090) 。

## 适用场景

大模型:科研、企业级复杂任务(如知识库嵌入、多模态交互) 。

小模型:轻量级应用(如智能客服、文本生成工具) 。

## 显卡要求

### 1. 个人用户(入门 / 性价比)

需求:运行 7B 模型(量化后),做聊天、文档摘要、简单代码生成。

推荐显卡:RTX 3060(12GB)、RTX 4060(8GB),预算 3000-5000 元,完美适配 7B INT4/INT8,兼顾价格和性能。

兜底方案:若只有 RTX 3050(8GB)或 RTX 1660 Super(6GB),可运行 7B INT4,但长上下文(如 4096 token)需启用「分层卸载」(Ollama 自动支持),速度略慢但可用。

### 2. 个人用户(进阶 / 高性能)

需求:运行 13B 模型(量化后)或 7B FP16,做复杂推理、多模态图文理解、长文本处理(8192 token+)。

推荐显卡:RTX 3090(24GB)、RTX 4090(24GB),预算 8000-15000 元,24GB 显存可覆盖 13B INT8/FP16,甚至 30B INT4,是个人端 “性能天花板”。

### 3. 企业 / 开发者(专业级)

需求:运行 30B + 模型、多卡推理、微调训练、RAG 系统部署。

推荐显卡:

单卡:RTX A6000(48GB)、RTX 6000 Ada(48GB),支持 ECC 显存,稳定可靠。

多卡:A100(80GB)、H100(80GB),支持 NVLink,多卡协同可轻松运行 100B + 模型,适合大规模部署。

# 记住一句话:能用

花多少钱办多大事--》个人机器上的大模型--》不要有过高的期望即可

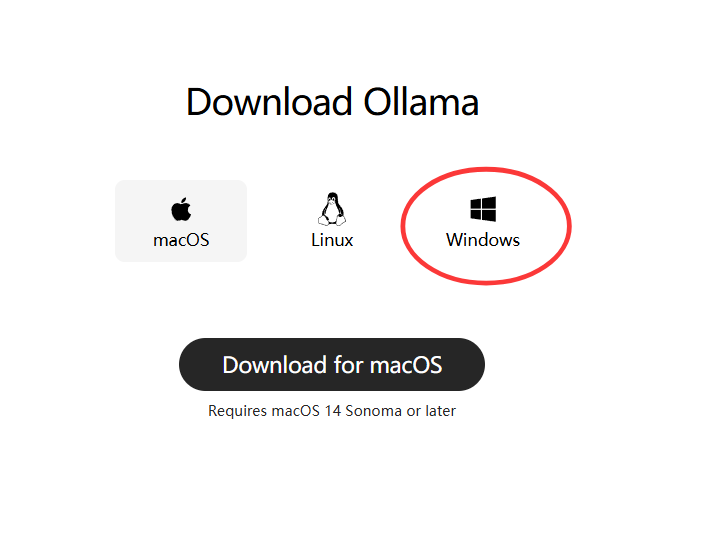

3.1 win/mac机器【不建议】

# 1 安装ollama

# 1 下载ollama:https://ollama.com/download

# 2 下载,一路下一步运行即可--》老师提供了

-默认装在c盘,到时候下载大模型:也非常占空间,所以建议大家装D盘

# 3 装在D盘【如果c盘比较大--》直接装即可】

## 3.1 创建文件夹

D:\ollama

D:\ollama\models

## 3.2 设置环境变量 cmd

setx OLLAMA_MODELS d:\ollama\models /M

## 3.3 安装把老师提供或自己下载的软件,放在 到D:\ollama,命令行执行

.\OllamaSetup.exe /dir=D:\ollama

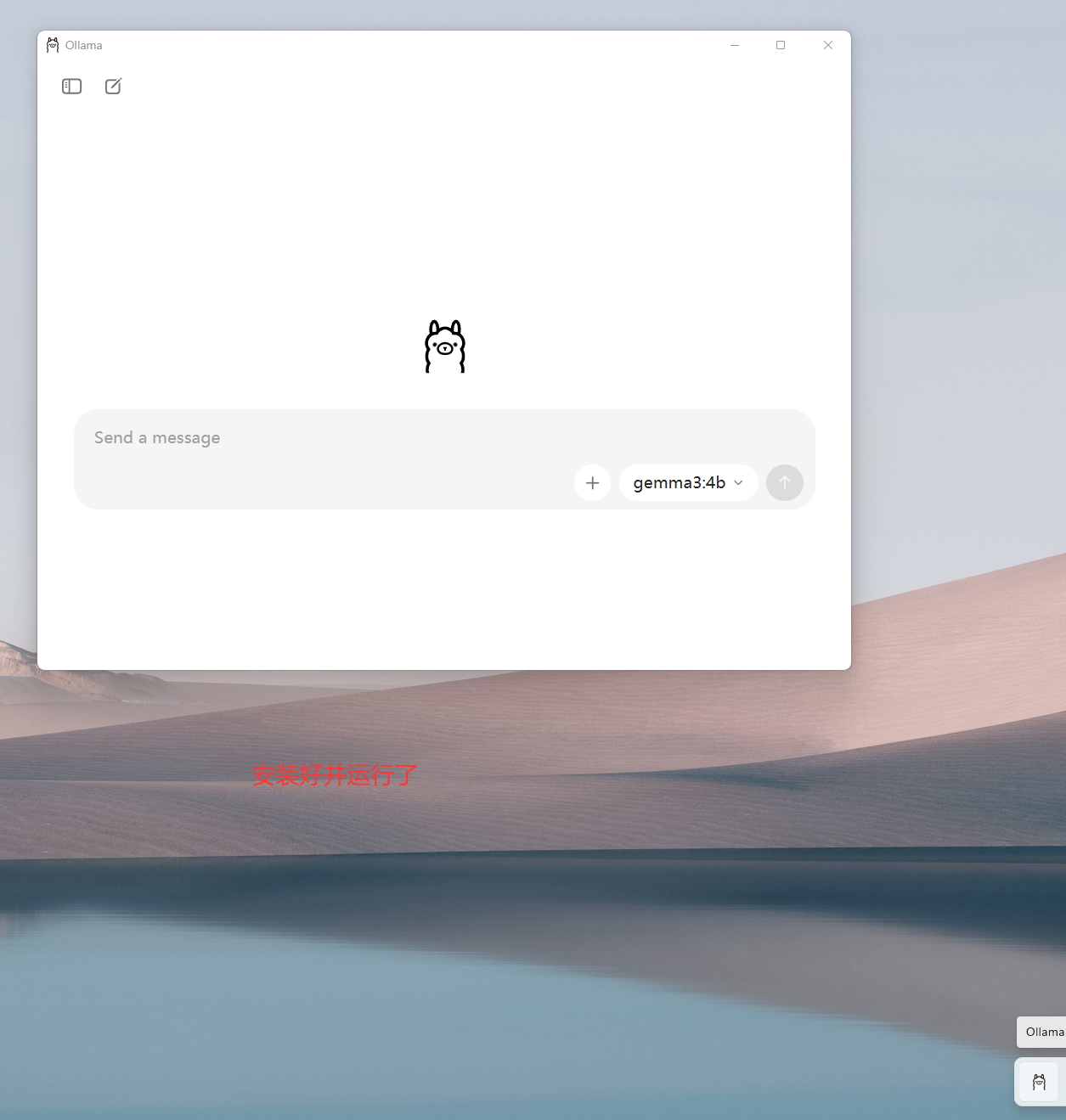

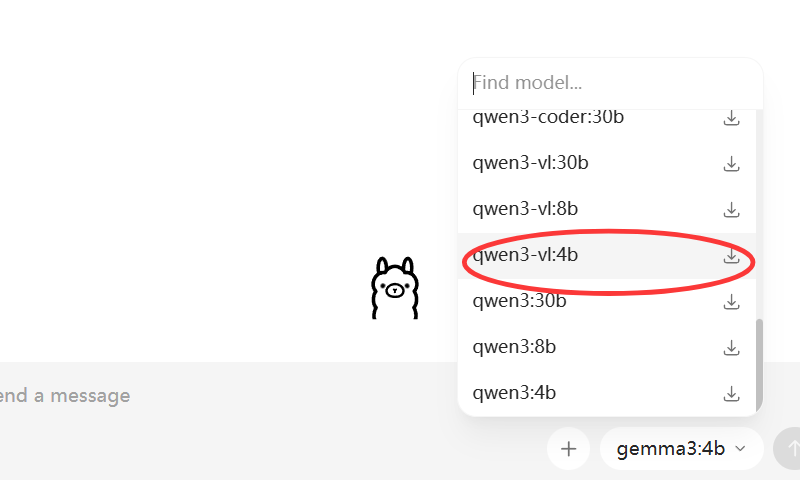

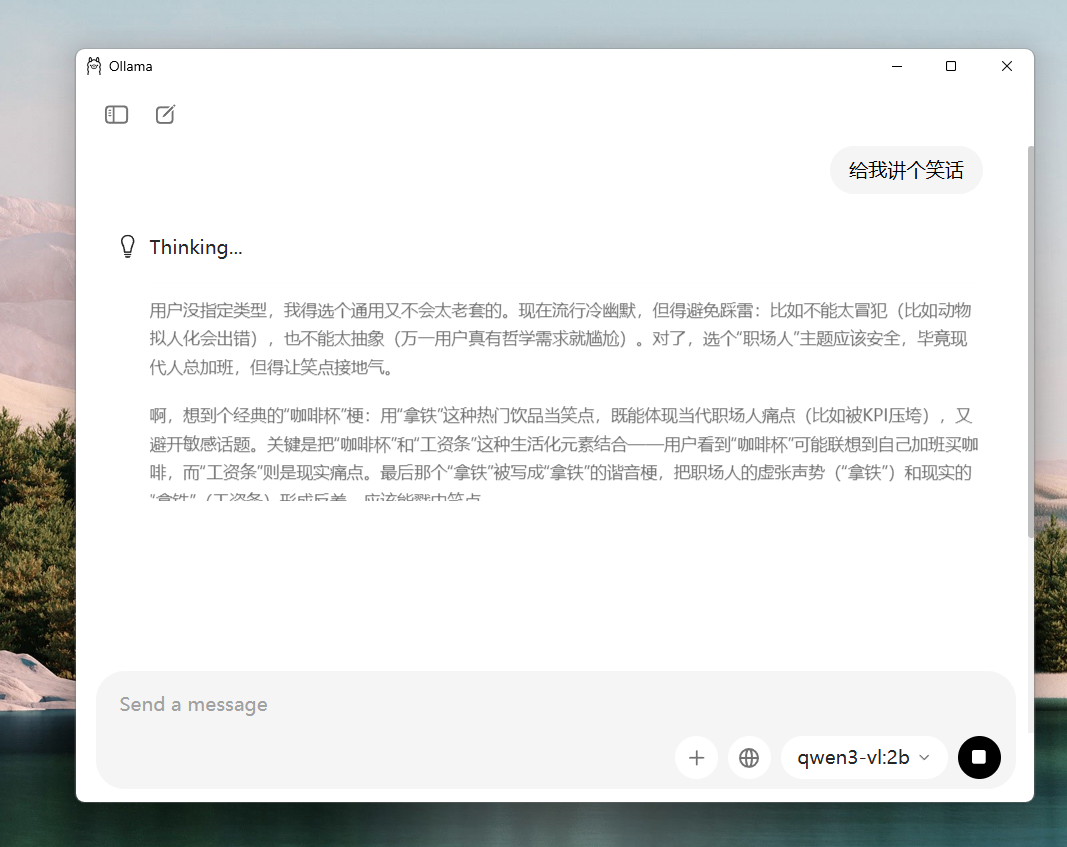

# 2 部署大模型:

-使用命令:先确定装哪个大模型 https://ollama.com/search

-https://ollama.com/library/qwen3-vl

命令行中运行:前提是ollama在运行

ollama run qwen3-vl:2b

ollama run deepseek-r1:1.5b

-图形化:

3.2 linux上[云服务器,虚拟机]-老师建议

# 1 在服务器或虚拟机上部署大模型---》好处上,机器可以上购买的云服务器,配置可能更高

# 2 老师以虚拟机为例--》跟云服务器没区别

-正常我们希望:

dify 一台机器

ollama一台机器

-同学不想克隆出一个虚拟机

-dify和ollama在一台机器

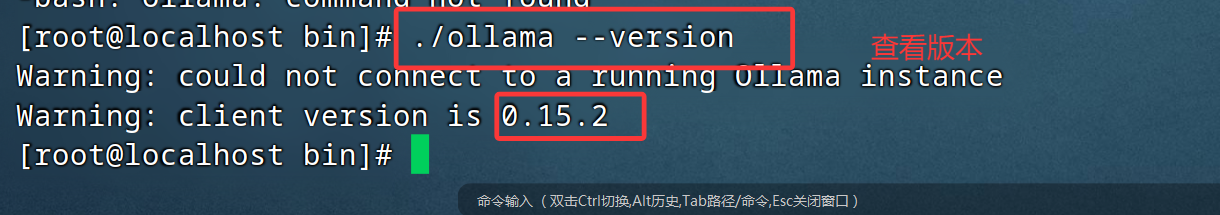

3.2.1 安装步骤

# 1 官方教的方式:

linux的命令行中敲:等--》下载约2g东西,又在国外,很慢

curl -fsSL https://ollama.com/install.sh | sh

# 2 大家用老师教的方式

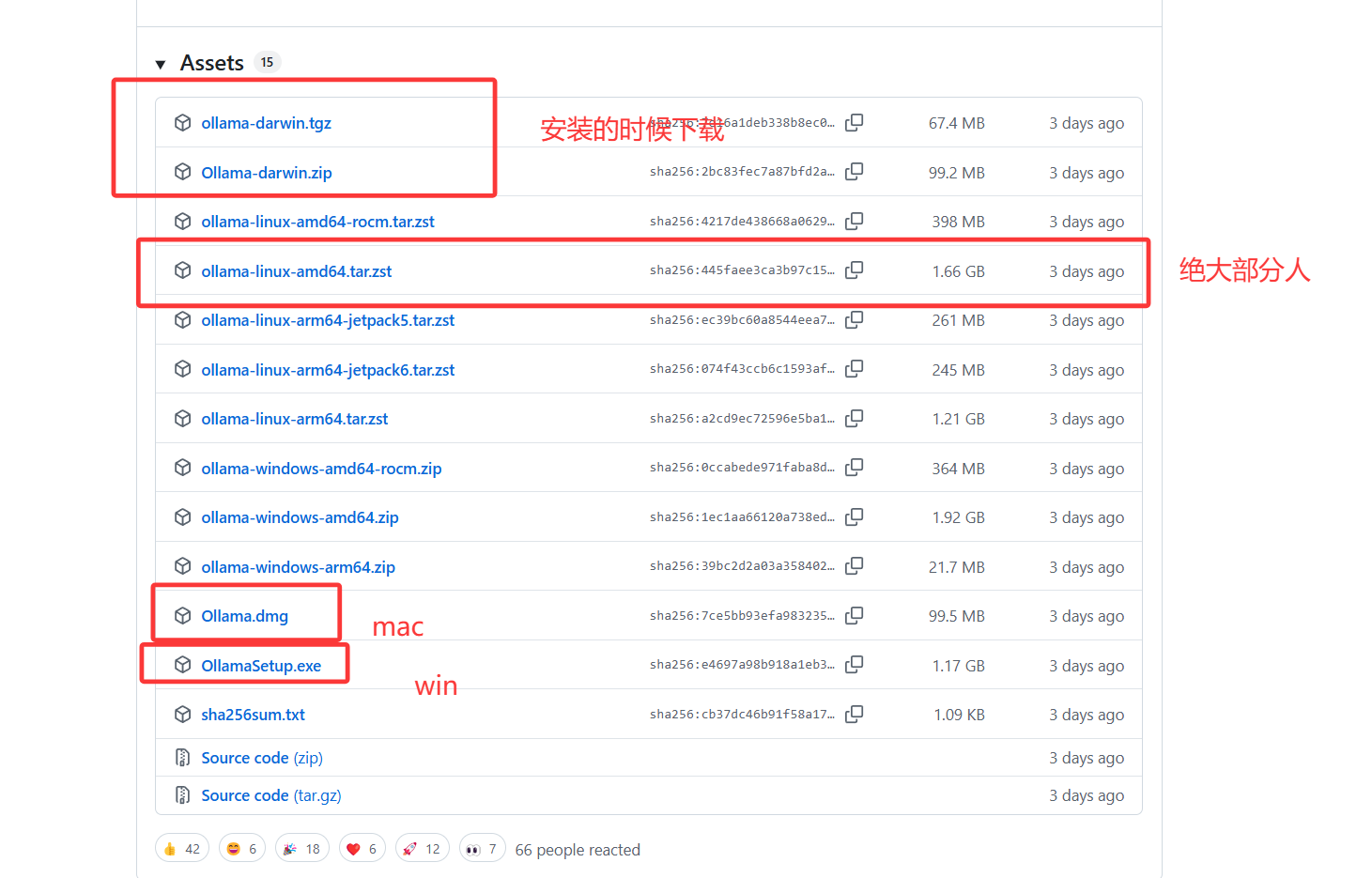

# 2.1 下载ollama的安装包:https://github.com/ollama/ollama/releases

# 2.2 老师提供了

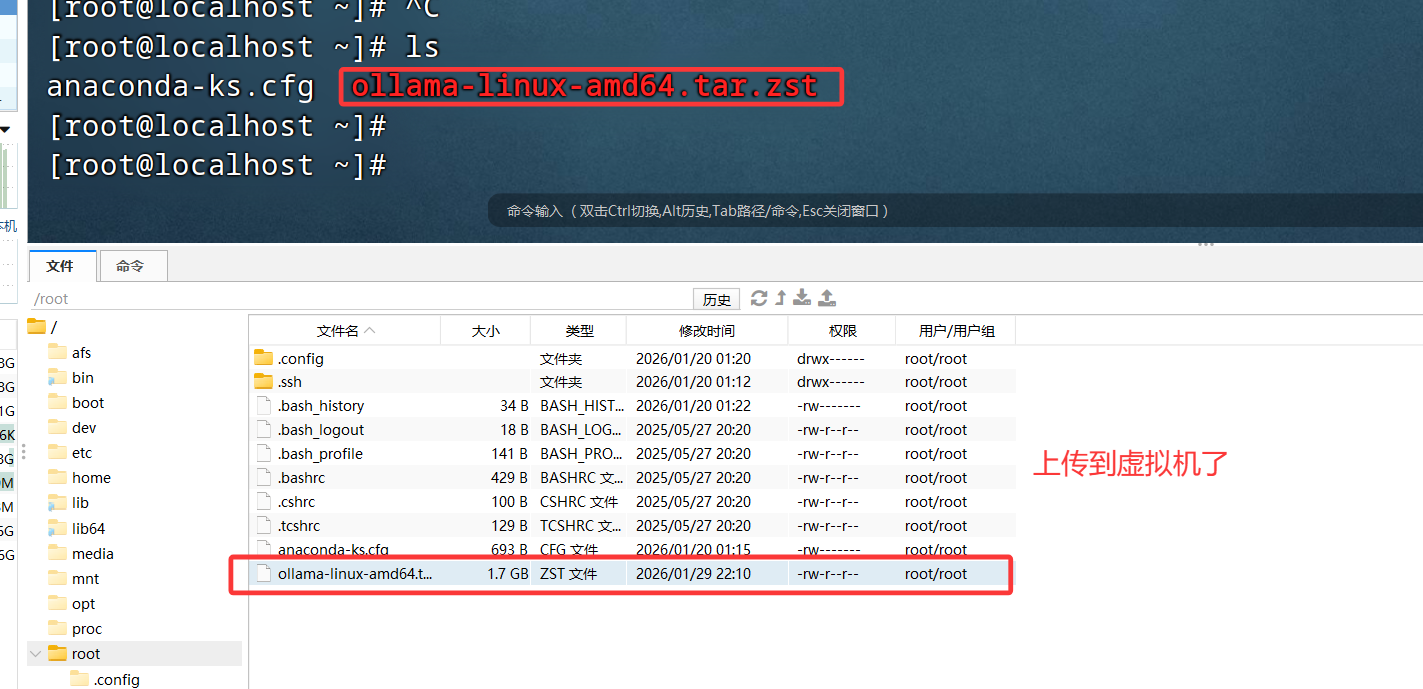

# 2.3 上传到虚拟机或服务器

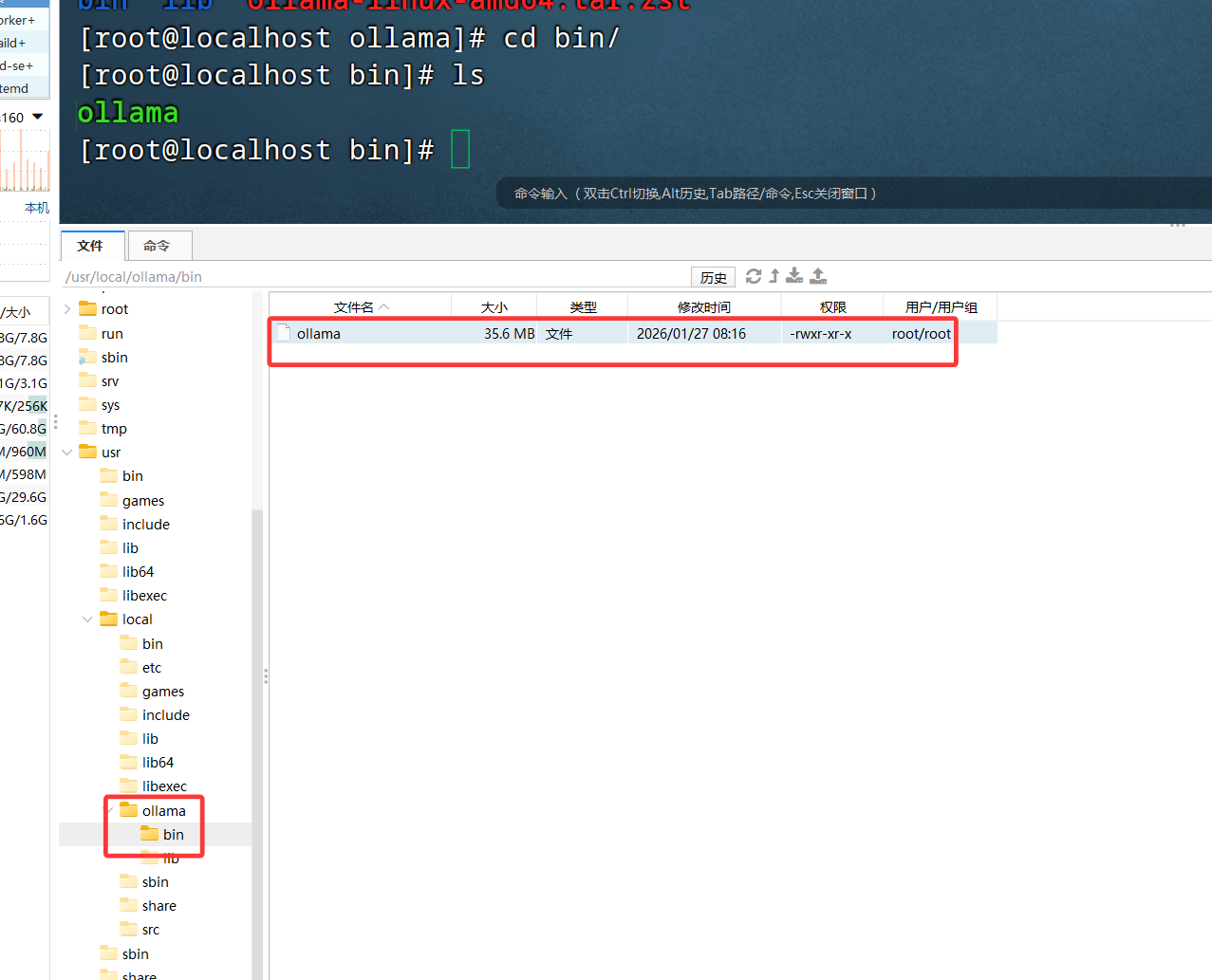

# 2.4 创建文件夹

mkdir /usr/local/ollama/

# 2.5 上传的压缩文件ollama-linux-amd64.tar.zs,mv 移动过来--》一定注意路径:在ollama所在路径

mv ./ollama-linux-amd64.tar.zst /usr/local/ollama/ollama-linux-amd64.tar.zst

# 2.6 解压 安装解压软件

cd /usr/local/ollama/

sudo dnf install -y zstd

tar --use-compress-program=unzstd -xvf ollama-linux-amd64.tar.zst

# 2.7 换到别的目录下,就不能执行ollama的命令--》创建软连接:以后任意路径敲ollama都有反应

ln -s /usr/local/ollama/bin/ollama /usr/bin/ollama

# 2.8 现在可以用了,但是我们希望使用systemctl 管理ollama服务

# 重新加载服务配置

systemctl daemon-reload

# 开机自启动

systemctl enable ollama

# 立刻启动

systemctl start ollama

# 停止

systemctl stop ollama

# 重启服务

systemctl restart ollama

# 查看状态

systemctl status ollama

# 2.9 必须配置完这个,才支持 systemctl 管理ollama服务

vi /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="PATH=$PATH"

Environment="OLLAMA_MODELS=/home/ollama/models"

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=default.target

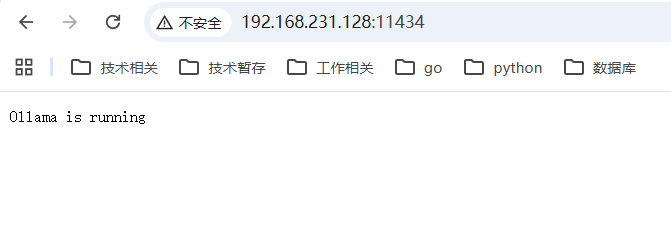

# 2.10 关闭防火墙 11434

systemctl stop firewalld # 停止

systemctl disable firewalld # 重启不再启动

# 2.11 浏览器访问

http://192.168.231.128:11434/

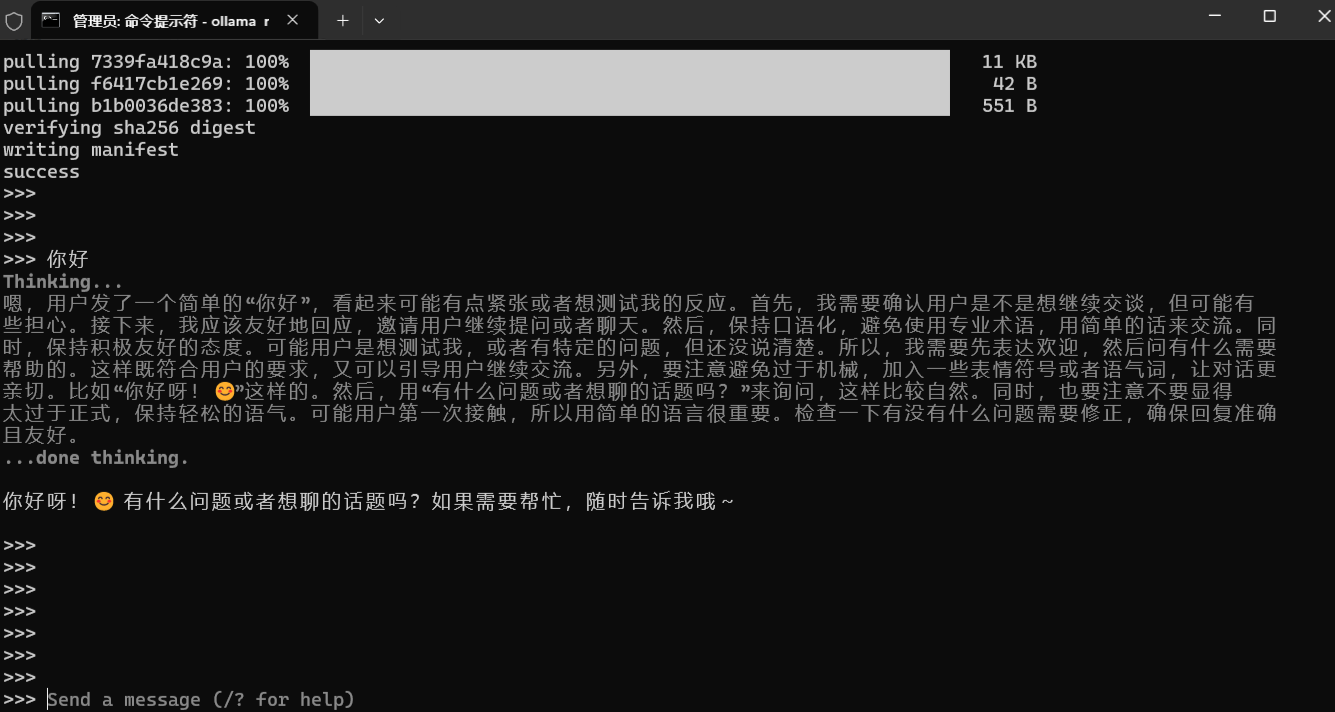

# 2.12 下载模型

ollama run deepseek-r1:1.5b

3.3 跟大模型对话

# 进入对话

ollama run qwen3-vl:2b

# 退出对话

ctrl + d

浙公网安备 33010602011771号

浙公网安备 33010602011771号