一期3.信息自动投递项目

第一章:项目背景与分析

1.1 项目背景介绍

信息自动投递项目背景介绍¶

学习目标¶

- 理解项目的开发背景.

- 熟悉相关数据的格式和样例.

投满分项目背景¶

- 对于字节跳动这家公司来说, 虽然产品线众多但是抖音, 今日头条是最大的两个王牌. 分别代表了基于短视频的推荐, 和基于短文本的推荐. 背后融合了众多CV, NLP, 推荐系统, 大数据等知识, 可以说是人工智能时代的集大成者.

- 针对于今日头条来说, 用户在众多新闻, 资讯中, 一定有更感兴趣的类别. 比如男生的历史, 军事, 足球等, 女生的财经, 八卦, 美妆等. 如果能将用户更感兴趣的类别新闻主动筛选出来, 并进行推荐阅读, 那么点击量, 订阅量, 付费量都会有明显增长.

- 基于上述原因, 字节内部今日头条的推荐系统中, 就需要内嵌一个子任务: 将短文本自动进行多分类, 然后像快递一样的"投递"到对应的"频道"中, 因此本项目应运而生.

项目数据概览¶

-

项目中的数据来源基本分为3大种类: - 第一类: 公司内部数据部门提供. - 情况1: 数据平台有预处理, 提供的是"成品数据".

-

情况2: 数据平台没有预处理, 只告诉开发人员"数据路径".

-

情况3: 原始数据就没有, 需要开发人员沟通不同部分, 获取"业务数据".

-

第二类: 甲方提需求, 并提供数据. - 情况1: 甲方有预处理数据, 提供的基本是"半成品数据".

- 情况2: 甲方只负责"埋点", 后续数据需要开发人员处理.

- 情况3: 甲方数据"匮乏", 甚至数据"缺失".

-

第三类: 需求画大饼阶段, 没有数据, 没有GPU, 只有"蓝图"和"展望".

-

-

本项目中的数据已经由字节预处理并完成了标注信息. 属于第一类中的情况1.

- 数据路径: /home/ec2-user/toutiao/data/data/

-

data文件夹内容展示:

-rw-r--r-- 1 ec2-user ec2-user 82 class.txt

-rw-r--r-- 1 ec2-user ec2-user 551313 dev.txt

-rw-r--r-- 1 ec2-user ec2-user 551596 test.txt

-rw-r--r-- 1 ec2-user ec2-user 9946122 train.txt

- 训练集数据: /home/ec2-user/toutiao/data/data/train.txt, 共180000条.

中华女子学院:本科层次仅1专业招男生 3

两天价网站背后重重迷雾:做个网站究竟要多少钱 4

东5环海棠公社230-290平2居准现房98折优惠 1

卡佩罗:告诉你德国脚生猛的原因 不希望英德战踢点球 7

82岁老太为学生做饭扫地44年获授港大荣誉院士 5

记者回访地震中可乐男孩:将受邀赴美国参观 5

冯德伦徐若�隔空传情 默认其是女友 9

传郭晶晶欲落户香港战伦敦奥运 装修别墅当婚房 1

《赤壁OL》攻城战诸侯战硝烟又起 8

“手机钱包”亮相科博会 4

上海2010上半年四六级考试报名4月8日前完成 3

李永波称李宗伟难阻林丹取胜 透露谢杏芳有望出战 7

3岁女童下体红肿 自称被幼儿园老师用尺子捅伤 5

金证顾问:过山车行情意味着什么 2

谁料地王如此虚 1

《光环5》Logo泄露 Kinect版几无悬念 8

海淀区领秀新硅谷宽景大宅预计10月底开盘 1

柴志坤:土地供应量不断从紧 地价难现07水平(图) 1

伊达传说EDDA Online 8

三联书店建起书香巷 4

宇航员尿液堵塞国际空间站水循环系统 4

研究发现开车技术差或与基因相关 6

皇马输球替补席闹丑闻 队副女球迷公然调情(视频) 7

北京建工与市政府再度合作推出郭庄子限价房 1

组图:李欣汝素颜出镜拍低碳环保大片 9

- 测试集数据: /home/ec2-user/toutiao/data/data/test.txt, 共10000条.

词汇阅读是关键 08年考研暑期英语复习全指南 3

中国人民公安大学2012年硕士研究生目录及书目 3

日本地震:金吉列关注在日学子系列报道 3

名师辅导:2012考研英语虚拟语气三种用法 3

自考经验谈:自考生毕业论文选题技巧 3

本科未录取还有这些路可以走 3

2009年成人高考招生统一考试时间表 3

去新西兰体验舌尖上的饕餮之旅(组图) 3

四级阅读与考研阅读比较分析与应试策略 3

备考2012高考作文必读美文50篇(一) 3

名师详解考研复试英语听力备考策略 3

热议:艺考合格证是高考升学王牌吗(组图) 3

研究生办替考网站续:幕后老板年赚近百万(图) 3

2011年高考文科综合试题(重庆卷) 3

56所高校预估2009年湖北录取分数线出炉 3

公共英语(PETS)写作中常见的逻辑词汇汇总 3

时评:高考应成为教育公平的“助推器” 3

九成外国人愿继续在日生活 六成留学生未返校 3

教育部回应“取消高考户籍限制” 3

2008年甘肃省高招不同于往年悬念叠出(图) 3

送考队伍成海 高考场外那些煎熬的心 3

09年小语种报考完全指南:仍须以高考为重(图) 3

四六级考前阅读冲刺:如何发挥正常水平 3

北京市海淀区09年高考第二次模拟考试题 3

倪震:我国首位参加GRE考试的盲人大学生 3

- 验证集数据: /home/ec2-user/toutiao/data/data/dev.txt, 共10000条.

体验2D巅峰 倚天屠龙记十大创新概览 8

60年铁树开花形状似玉米芯(组图) 5

同步A股首秀:港股缩量回调 2

中青宝sg现场抓拍 兔子舞热辣表演 8

锌价难续去年辉煌 0

2岁男童爬窗台不慎7楼坠下获救(图) 5

布拉特:放球员一条生路吧 FIFA能消化俱乐部的攻击 7

金科西府 名墅天成 1

状元心经:考前一周重点是回顾和整理 3

发改委治理涉企收费每年为企业减负超百亿 6

一年网事扫荡10年纷扰开心网李鬼之争和平落幕 4

2010英国新政府“三把火”或影响留学业 3

俄达吉斯坦共和国一名区长被枪杀 6

朝鲜要求日本对过去罪行道歉和赔偿 6

《口袋妖怪 黑白》日本首周贩售255万 8

图文:借贷成本上涨致俄罗斯铝业净利下滑21% 2

组图:新《三国》再曝海量剧照 火战场面极震撼 9

麻辣点评:如何走出“被留学”的尴尬 3

美股评论:SUN的苦涩曙光 2

拾荒男子捡到任命书假冒老总 连骗二十多位女子 5

英国夫妇再育“黑白”双胞胎 4

从跟班到战友 灵兽伴你畅游传奇世界 8

你有随身听 我有随身看:掌上故事会 8

一封1968年的平信45.92万元成交 0

女主人成功说服杀人躲避者自首 5

- 类别集合数据: /home/ec2-user/toutiao/data/data/class.txt, 共10条.

finance

realty

stocks

education

science

society

politics

sports

game

entertainment

小节总结¶

- 本小节介绍了投满分项目的背景, 是属于整个今日头条项目中的一个功能子集, 完成新闻, 咨询等短文本的多分类, 将各个子类的资料推送到对应的推荐流中.

- 对项目数据进行了介绍, 本项目拿到手的已经是数据平台部门处理好的"优质数据", 我们只需要将全部精力放在功能实现, 模型优化上即可.

1.2 baseline解决方案实现

随机森林的快速基线模型1.0¶

学习目标¶

- 掌握对数据进行快速分析的代码实现.

- 掌握利用随机森林快速实现并评估基线模型.

数据分析¶

-

数据分析代码位置: /home/ec2-user/toutiao/baseline/random_forest/analysis.py

- 第一步: 读数据并统计分类数量

- 第二步: 分析样本分布

- 第三步: 进行分词预处理

- 第四步: 处理验证集和测试集数据

-

第一步: 读数据并统计分类数量

import pandas as pd

from collections import Counter

import numpy as np

import jieba

content = pd.read_csv('./data/data/train.txt', sep='\t')

print(content.head(10))

print(len(content))

count = Counter(content.label.values)

print(count)

print(len(count))

print('***************************************')

- 调用:

python analysis.py

- 输出结果:

sentence label

0 中华女子学院:本科层次仅1专业招男生 3

1 两天价网站背后重重迷雾:做个网站究竟要多少钱 4

2 东5环海棠公社230-290平2居准现房98折优惠 1

3 卡佩罗:告诉你德国脚生猛的原因 不希望英德战踢点球 7

4 82岁老太为学生做饭扫地44年获授港大荣誉院士 5

5 记者回访地震中可乐男孩:将受邀赴美国参观 5

6 冯德伦徐若�隔空传情 默认其是女友 9

7 传郭晶晶欲落户香港战伦敦奥运 装修别墅当婚房 1

8 《赤壁OL》攻城战诸侯战硝烟又起 8

9 “手机钱包”亮相科博会 4

180000

Counter({3: 18000, 4: 18000, 1: 18000, 7: 18000, 5: 18000, 9: 18000, 8: 18000, 2: 18000, 6: 18000, 0: 18000})

10

***************************************

- 第二步: 分析样本分布

total = 0

for i, v in count.items():

total += v

print(total)

for i, v in count.items():

print(i, v / total * 100, '%')

print('***************************************')

content['sentence_len'] = content['sentence'].apply(len)

print(content.head(10))

length_mean = np.mean(content['sentence_len'])

length_std = np.std(content['sentence_len'])

print('length_mean = ', length_mean)

print('length_std = ', length_std)

- 输出结果:

180000

3 10.0 %

4 10.0 %

1 10.0 %

7 10.0 %

5 10.0 %

9 10.0 %

8 10.0 %

2 10.0 %

6 10.0 %

0 10.0 %

***************************************

sentence label sentence_len

0 中华女子学院:本科层次仅1专业招男生 3 18

1 两天价网站背后重重迷雾:做个网站究竟要多少钱 4 22

2 东5环海棠公社230-290平2居准现房98折优惠 1 25

3 卡佩罗:告诉你德国脚生猛的原因 不希望英德战踢点球 7 25

4 82岁老太为学生做饭扫地44年获授港大荣誉院士 5 23

5 记者回访地震中可乐男孩:将受邀赴美国参观 5 20

6 冯德伦徐若�隔空传情 默认其是女友 9 17

7 传郭晶晶欲落户香港战伦敦奥运 装修别墅当婚房 1 22

8 《赤壁OL》攻城战诸侯战硝烟又起 8 16

9 “手机钱包”亮相科博会 4 11

length_mean = 19.21257222222222

length_std = 3.863787253359747

- 第三步: 进行分词预处理.

def cut_sentence(s):

return list(jieba.cut(s))

content['words'] = content['sentence'].apply(cut_sentence)

print(content.head(10))

content['words'] = content['sentence'].apply(lambda s: ' '.join(cut_sentence(s)))

content['words'] = content['words'].apply(lambda s: ' '.join(s.split())[:30])

content.to_csv('./data/data/train_new.csv')

- 输出结果:

Building prefix dict from the default dictionary ...

Dumping model to file cache /tmp/jieba.cache

Loading model cost 0.908 seconds.

Prefix dict has been built successfully.

sentence label sentence_len words

0 中华女子学院:本科层次仅1专业招男生 3 18 [中华, 女子, 学院, :, 本科, 层次, 仅, 1, 专业, 招, 男生]

1 两天价网站背后重重迷雾:做个网站究竟要多少钱 4 22 [两天, 价, 网站, 背后, 重重, 迷雾, :, 做个, 网站, 究竟, 要, 多少, 钱]

2 东5环海棠公社230-290平2居准现房98折优惠 1 25 [东, 5, 环, 海棠, 公社, 230, -, 290, 平, 2, 居, 准现房, 9...

3 卡佩罗:告诉你德国脚生猛的原因 不希望英德战踢点球 7 25 [卡佩罗, :, 告诉, 你, 德国, 脚, 生猛, 的, 原因, , 不, 希望, 英德...

4 82岁老太为学生做饭扫地44年获授港大荣誉院士 5 23 [82, 岁, 老太, 为, 学生, 做饭, 扫地, 44, 年, 获授, 港大, 荣誉, 院士]

5 记者回访地震中可乐男孩:将受邀赴美国参观 5 20 [记者, 回访, 地震, 中, 可乐, 男孩, :, 将, 受邀, 赴美国, 参观]

6 冯德伦徐若�隔空传情 默认其是女友 9 17 [冯德伦, 徐若, �, 隔空, 传情, , 默认, 其是, 女友]

7 传郭晶晶欲落户香港战伦敦奥运 装修别墅当婚房 1 22 [传, 郭晶晶, 欲, 落户, 香港, 战, 伦敦, 奥运, , 装修, 别墅, 当婚, 房]

8 《赤壁OL》攻城战诸侯战硝烟又起 8 16 [《, 赤壁, OL, 》, 攻城战, 诸侯, 战, 硝烟, 又, 起]

9 “手机钱包”亮相科博会 4 11 [“, 手机, 钱包, ”, 亮相, 科博会]

- 第四步: 依次同样的代码处理验证集dev.txt, 测试集test.txt, 同一个文件夹下生成dev_new.csv, test_new.csv文件.

随机森林模型¶

- 编写代码实现随机森林的模型训练.

- 代码位置: /home/ec2-user/toutiao/baseline/random_forest/random_forest_baseline1.py

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

import pandas as pd

from icecream import ic

from sklearn.metrics import accuracy_score

from sklearn.metrics import recall_score

from sklearn.metrics import precision_score

from sklearn.metrics import f1_score

TRAIN_CORPUS = './data/data/train_new.csv'

STOP_WORDS = './data/data/stopwords.txt'

WORDS_COLUMN = 'words'

content = pd.read_csv(TRAIN_CORPUS)

corpus = content[WORDS_COLUMN].values

stop_words_size = 749

WORDS_LONG_TAIL_BEGIN = 10000

WORDS_SIZE = WORDS_LONG_TAIL_BEGIN - stop_words_size

stop_words = open(STOP_WORDS).read().split()[:stop_words_size]

tfidf = TfidfVectorizer(max_features=WORDS_SIZE, stop_words=stop_words)

text_vectors = tfidf.fit_transform(corpus)

print(text_vectors.shape)

targets = content['label']

x_train, x_test, y_train, y_test = train_test_split(text_vectors, targets, test_size=0.2, random_state=0)

print('数据分割完毕, 开始模型训练...')

model = RandomForestClassifier()

model.fit(x_train, y_train)

print('模型训练结束, 开始预测...')

accuracy = accuracy_score(model.predict(x_test), y_test)

ic(accuracy)

- 调用:

python random_forest_baseline1.py

- 输出结果:

(180000, 9251)

数据分割完毕, 开始模型训练...

模型训练结束, 开始预测...

ic| accuracy: 0.7989444444444445

- 结论: 随机森林构建模型简单, 训练快, 最终79.89%的准确率(可以视作80%)对于10分类任务来说也是不错的模型. 重要的是我们快速拥有了一个准确率达到80%的基线模型1.0

FastText的快速基线模型2.0¶

数据准备¶

-

首先明确fasttext所要求的数据格式:

- 文本: 正常的连续字符串即可.

- 标签: 采用__label__name的格式.

-

代码位置: /home/ec2-user/toutiao/baseline/fast_text/data/data/preprocess.py

import os

import sys

import jieba

id_to_label = {}

idx = 0

with open('class.txt', 'r', encoding='utf-8') as f1:

for line in f1.readlines():

line = line.strip('\n').strip()

id_to_label[idx] = line

idx += 1

print('id_to_label:', id_to_label)

count = 0

train_data = []

with open('train.txt', 'r', encoding='utf-8') as f2:

for line in f2.readlines():

line = line.strip('\n').strip()

sentence, label = line.split('\t')

# 1: 首先处理标签部分

label_id = int(label)

label_name = id_to_label[label_id]

new_label = '__label__' + label_name

# 2: 然后处理文本部分, 为了便于后续增加n-gram特性, 可以按字划分, 也可以按词划分

sent_char = ' '.join(list(sentence))

# 3: 将文本和标签组合成fasttext规定的格式

new_sentence = new_label + ' ' + sent_char

train_data.append(new_sentence)

count += 1

if count % 10000 == 0:

print('count=', count)

with open('train_fast.txt', 'w', encoding='utf-8') as f3:

for data in train_data:

f3.write(data + '\n')

print('FastText训练数据预处理完毕!')

- 调用:

python preprocess.py

- 输出结果: 查看train_fast.txt文件如下

__label__education 中 华 女 子 学 院 : 本 科 层 次 仅 1 专 业 招 男 生

__label__science 两 天 价 网 站 背 后 重 重 迷 雾 : 做 个 网 站 究 竟 要 多 少 钱

__label__realty 东 5 环 海 棠 公 社 2 3 0 - 2 9 0 平 2 居 准 现 房 9 8 折 优 惠

__label__sports 卡 佩 罗 : 告 诉 你 德 国 脚 生 猛 的 原 因 不 希 望 英 德 战 踢 点 球

__label__society 8 2 岁 老 太 为 学 生 做 饭 扫 地 4 4 年 获 授 港 大 荣 誉 院 士

__label__society 记 者 回 访 地 震 中 可 乐 男 孩 : 将 受 邀 赴 美 国 参 观

__label__entertainment 冯 德 伦 徐 若 � 隔 空 传 情 默 认 其 是 女 友

__label__realty 传 郭 晶 晶 欲 落 户 香 港 战 伦 敦 奥 运 装 修 别 墅 当 婚 房

__label__game 《 赤 壁 O L 》 攻 城 战 诸 侯 战 硝 烟 又 起

__label__science “ 手 机 钱 包 ” 亮 相 科 博 会

__label__education 上 海 2 0 1 0 上 半 年 四 六 级 考 试 报 名 4 月 8 日 前 完 成

__label__sports 李 永 波 称 李 宗 伟 难 阻 林 丹 取 胜 透 露 谢 杏 芳 有 望 出 战

__label__society 3 岁 女 童 下 体 红 肿 自 称 被 幼 儿 园 老 师 用 尺 子 捅 伤

__label__stocks 金 证 顾 问 : 过 山 车 行 情 意 味 着 什 么

__label__realty 谁 料 地 王 如 此 虚

__label__game 《 光 环 5 》 L o g o 泄 露 K i n e c t 版 几 无 悬 念

__label__realty 海 淀 区 领 秀 新 硅 谷 宽 景 大 宅 预 计 1 0 月 底 开 盘

__label__realty 柴 志 坤 : 土 地 供 应 量 不 断 从 紧 地 价 难 现 0 7 水 平 ( 图 )

__label__game 伊 达 传 说 E D D A O n l i n e

__label__science 三 联 书 店 建 起 书 香 巷

__label__science 宇 航 员 尿 液 堵 塞 国 际 空 间 站 水 循 环 系 统

__label__politics 研 究 发 现 开 车 技 术 差 或 与 基 因 相 关

__label__sports 皇 马 输 球 替 补 席 闹 丑 闻 队 副 女 球 迷 公 然 调 情 ( 视 频 )

__label__realty 北 京 建 工 与 市 政 府 再 度 合 作 推 出 郭 庄 子 限 价 房

__label__entertainment 组 图 : 李 欣 汝 素 颜 出 镜 拍 低 碳 环 保 大 片

- 同上处理测试集数据, 得到test_fast.txt; 同上处理验证集的数据, 得到dev_fast.txt

模型搭建¶

- 代码位置: /home/ec2-user/toutiao/baseline/fast_text/fast_text_baseline2.py

import fasttext

train_data_path = './data/data/train_fast.txt'

test_data_path = './data/data/test_fast.txt'

# 开启模型训练

model = fasttext.train_supervised(input=train_data_path, wordNgrams=2)

# 开启模型测试

result = model.test(test_data_path)

print(result)

- 调用:

python fast_text_baseline2.py

- 输出结果:

Read 3M words

Number of words: 4760

Number of labels: 10

Progress: 100.0% words/sec/thread: 1267929 lr: 0.000000 avg.loss: 0.279528 ETA: 0h 0m 0s

(10000, 0.9162, 0.9162)

- 结论: 在10000条测试集上, 我们的模型得到了0.9162的精确率, 0.9162的召回率. 相比较随机森林已经有了大幅度的提升.

模型优化¶

- 对于任意表现良好的模型, 优化的脚步都不能停止!

优化fasttest第一版¶

- 在真实的生产环境下, 对于fasttext模型一般不会采用费时费力的人工调参, 而都是用自动化最优参数搜索的模式. - 代码位置: /home/ec2-user/toutiao/baseline/fast_text/fast_text_baseline2.py

import fasttext

import time

train_data_path = './data/data/train_fast.txt'

dev_data_path = './data/data/dev_fast.txt'

test_data_path = './data/data/test_fast.txt'

# autotuneValidationFile参数需要指定验证数据集所在路径,

# 它将在验证集上使用随机搜索方法寻找可能最优的超参数.

# 使用autotuneDuration参数可以控制随机搜索的时间, 默认是300s,

# 根据不同的需求, 我们可以延长或缩短时间.

# verbose: 该参数决定日志打印级别, 当设置为3, 可以将当前正在尝试的超参数打印出来.

model = fasttext.train_supervised(input=train_data_path,

autotuneValidationFile=dev_data_path,

autotuneDuration=600,

wordNgrams=2,

verbose=3)

# 在测试集上评估模型的表现

result = model.test(test_data_path)

print(result)

# 模型保存

time1 = int(time.time())

model_save_path = "./toutiao_fasttext_{}.bin".format(time1)

model.save_model(model_save_path)

- 调用:

python fast_text_baseline2.py

- 输出结果:

Trial = 1

epoch = 5

lr = 0.1

dim = 100

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 2000000

dsub = 2

loss = softmax

Progress: 0.5% Trials: 1 Best score: unknown ETA: 0h 9m56scurrentScore = 0.9119

train took = 3.20856

Trial = 2

epoch = 2

lr = 0.169298

dim = 105

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 10000000

dsub = 16

loss = softmax

Progress: 1.4% Trials: 2 Best score: 0.911900 ETA: 0h 9m51scurrentScore = 0.906

train took = 5.66037

Trial = 3

epoch = 1

lr = 0.463758

dim = 52

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 1036295

dsub = 2

loss = softmax

Progress: 1.6% Trials: 3 Best score: 0.911900 ETA: 0h 9m50scurrentScore = 0.9053

......

......

......

train took = 102.365

Trial = 18

epoch = 29

lr = 0.100404

dim = 318

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 2932604

dsub = 16

loss = softmax

Progress: 94.0% Trials: 18 Best score: 0.913600 ETA: 0h 0m36scurrentScore = 0.9123

train took = 29.9363

Trial = 19

epoch = 61

lr = 0.230535

dim = 364

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 3220875

dsub = 8

loss = softmax

Progress: 100.0% Trials: 19 Best score: 0.913600 ETA: 0h 0m 0s

Training again with best arguments

Best selected args = 0

epoch = 100

lr = 0.173311

dim = 355

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 5091406

dsub = 16

loss = softmax

Read 3M words

Number of words: 4760

Number of labels: 10

Progress: 100.0% words/sec/thread: 571851 lr: 0.000000 avg.loss: 0.016739 ETA: 0h 0m 0s

(10000, 0.9173, 0.9173)

- 查看模型:

# 命令行直接ll可以查看保存后的模型详情

# 可以看到保存后的模型大小为4.95GB

# 说明fasttext虽然效果好, 速度快, 但是占用很大存储空间, 比BERT大得多!

-rw-rw-r-- 1 ec2-user ec2-user 4949204992 1月 9 02:25 toutiao_fasttext_1640744707.bin

- 结论: 经过参数的自动搜索, 得到了最好的一版模型, 主要参数包括词嵌入维度dim=355, wordNgrams=2等. 模型的最终表现精准率等于91.73%, 召回率也是91.73%, 相比较最初的91.62%有稍许提升但并不显著.

优化fasttext第二版¶

-

模型的优化不仅仅在架构上, 更要注意回溯到源头, 也就是数据端的优化.

- 第一步: 原始数据采用词向量级别.

- 第二步: 重新训练模型并评估.

-

第一步: 原始数据采用词向量级别.

- 代码位置: /home/ec2-user/toutiao/baseline/fast_text/data/data/preprocess1.py

import os

import sys

import jieba

id_to_label = {}

idx = 0

with open('class.txt', 'r', encoding='utf-8') as f1:

for line in f1.readlines():

line = line.strip('\n').strip()

id_to_label[idx] = line

idx += 1

# print('id_to_label:', id_to_label)

count = 0

train_data = []

with open('train.txt', 'r', encoding='utf-8') as f2:

for line in f2.readlines():

line = line.strip('\n').strip()

sentence, label = line.split('\t')

# 1: 首先处理标签部分

label_id = int(label)

label_name = id_to_label[label_id]

new_label = '__label__' + label_name

# 2: 然后处理文本部分, 区别于之前的按字划分, 此处按词划分文本

sent_char = ' '.join(jieba.lcut(sentence))

# 3: 将文本和标签组合成fasttext规定的格式

new_sentence = new_label + '\t' + sent_char

train_data.append(new_sentence)

count += 1

if count % 10000 == 0:

print('count=', count)

with open('train_fast1.txt', 'w', encoding='utf-8') as f3:

for data in train_data:

f3.write(data + '\n')

print('FastText训练数据预处理完毕!')

- 调用:

python preprocess1.py

- 输出结果(查看train_fast1.txt文件):

__label__education 中华 女子 学院 : 本科 层次 仅 1 专业 招 男生

__label__science 两天 价 网站 背后 重重 迷雾 : 做个 网站 究竟 要 多少 钱

__label__realty 东 5 环 海棠 公社 230 - 290 平 2 居 准现房 98 折 优惠

__label__sports 卡佩罗 : 告诉 你 德国 脚 生猛 的 原因 不 希望 英德 战 踢 点球

__label__society 82 岁 老太 为 学生 做饭 扫地 44 年 获授 港大 荣誉 院士

__label__society 记者 回访 地震 中 可乐 男孩 : 将 受邀 赴美国 参观

__label__entertainment 冯德伦 徐若 � 隔空 传情 默认 其是 女友

__label__realty 传 郭晶晶 欲 落户 香港 战 伦敦 奥运 装修 别墅 当婚 房

__label__game 《 赤壁 OL 》 攻城战 诸侯 战 硝烟 又 起

__label__science “ 手机 钱包 ” 亮相 科博会

__label__education 上海 2010 上半年 四六级 考试 报名 4 月 8 日前 完成

__label__sports 李永波 称 李宗伟 难 阻林丹 取胜 透露 谢杏芳 有望 出战

__label__society 3 岁 女童 下体 红肿 自称 被 幼儿园 老师 用 尺子 捅 伤

__label__stocks 金证 顾问 : 过山车 行情 意味着 什么

__label__realty 谁料 地 王 如此 虚

__label__game 《 光环 5 》 Logo 泄露 Kinect 版几无 悬念

__label__realty 海淀区 领秀新 硅谷 宽景 大宅 预计 10 月底 开盘

__label__realty 柴志坤 : 土地 供应量 不断 从 紧 地价 难现 07 水平 ( 图 )

__label__game 伊达 传说 EDDA Online

__label__science 三联书店 建起 书香 巷

__label__science 宇航员 尿液 堵塞 国际 空间站 水 循环系统

__label__politics 研究 发现 开车 技术 差 或 与 基因 相关

__label__sports 皇马 输球 替补席 闹 丑闻 队 副 女球迷 公然 调情 ( 视频 )

__label__realty 北京 建工 与 市政府 再度 合作 推出 郭 庄子 限价 房

__label__entertainment 组图 : 李欣汝素 颜 出镜 拍低 碳 环保 大片

- 测试集同样的方法进行处理, 得到结果文件test_fast1.txt; 验证集同样的方法进行处理, 得到结果文件dev_fast1.txt

- 模型训练, 代码位置: /home/ec2-user/toutiao/baseline/fast_text/fast_text_baseline3.py

import fasttext

import time

train_data_path = './data/data/train_fast1.txt'

dev_data_path = './data/data/dev_fast1.txt'

test_data_path = './data/data/test_fast1.txt'

# autotuneValidationFile参数需要指定验证数据集所在路径,

# 它将在验证集上使用随机搜索方法寻找可能最优的超参数.

# 使用autotuneDuration参数可以控制随机搜索的时间, 默认是300s,

# 根据不同的需求, 我们可以延长或缩短时间.

# verbose: 该参数决定日志打印级别, 当设置为3, 可以将当前正在尝试的超参数打印出来.

model = fasttext.train_supervised(input=train_data_path,

autotuneValidationFile=dev_data_path,

autotuneDuration=600,

wordNgrams=2,

verbose=3)

# 在测试集上评估模型的表现

result = model.test(test_data_path)

print(result)

# 模型保存

time1 = int(time.time())

model_save_path = "./toutiao_fasttext_{}.bin".format(time1)

model.save_model(model_save_path)

- 调用:

python fast_text_baseline3.py

- 输出结果:

al = 1

epoch = 5

lr = 0.1

dim = 100

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 2000000

dsub = 2

loss = softmax

Progress: 0.5% Trials: 1 Best score: unknown ETA: 0h 9m56scurrentScore = 0.9009

train took = 3.00675

Trial = 2

epoch = 2

lr = 0.169298

dim = 105

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 10000000

dsub = 16

loss = softmax

Progress: 1.4% Trials: 2 Best score: 0.900900 ETA: 0h 9m51scurrentScore = 0.9003

train took = 5.71447

Trial = 3

epoch = 1

lr = 0.463758

dim = 52

minCount = 1

wordNgrams = 2

minn = 0

maxn = 0

bucket = 1036295

dsub = 2

loss = softmax

Progress: 1.7% Trials: 3 Best score: 0.900900 ETA: 0h 9m49scurrentScore = 0.897

......

......

......

train took = 59.9728

Trial = 34

epoch = 52

lr = 0.0350906

dim = 57

minCount = 1

wordNgrams = 2

minn = 3

maxn = 6

bucket = 191750

dsub = 2

loss = softmax

Progress: 96.0% Trials: 34 Best score: 0.912800 ETA: 0h 0m24scurrentScore = 0.9066

train took = 19.7419

Trial = 35

epoch = 100

lr = 0.0425606

dim = 71

minCount = 1

wordNgrams = 2

minn = 2

maxn = 5

bucket = 152421

dsub = 2

loss = softmax

Progress: 100.0% Trials: 35 Best score: 0.912800 ETA: 0h 0m 0s

Training again with best arguments

Best selected args = 0

epoch = 11

lr = 0.0573768

dim = 64

minCount = 1

wordNgrams = 2

minn = 2

maxn = 5

bucket = 255766

dsub = 2

loss = softmax

Read 2M words

Number of words: 118456

Number of labels: 10

Progress: 100.0% words/sec/thread: 616381 lr: 0.000000 avg.loss: 0.296281 ETA: 0h 0m 0s

(10000, 0.9193, 0.9193)

- 查看模型:

# 命令行直接ll可以查看保存后的模型详情

# 可以看到保存后的模型大小为98MB, 相比于第一个模型小了太多, 同时效果反倒提升了!

# 参考与第一版优化中dim=355, 模型4.95GB, 此处最关键的参数dim=64, 是模型大幅度缩小的最重要原因.

-rw-rw-r-- 1 ec2-user ec2-user 97828230 1月 9 02:42 toutiao_fasttext_1640745760.bin

- 结论: 采用词为单位的模型效果又有一次提升, 精准率和召回率都达到了91.93%, 相比于初始的91.62%和第一版优化的91.73%又有稍许提升, 但效果依然不显著. 同时我们注意到, fasttext模型可大可小, 存储空间的占用范围相差极大!

模型部署¶

- 工业界中的AI是指"能落地的AI", 即指在生产环境中可以部署并提供在线, 或离线作业的模型. - 第一步: 编写主服务逻辑代码.

- 第二步: 启动Flask服务.

- 第三步: 编写测试代码.

- 第四步: 执行测试并检验结果.

- 第一步: 编写主服务逻辑代码. - 代码位置: /home/ec2-user/toutiao/baseline/fast_text/app.py

import time

import jieba

import fasttext

# 服务框架使用Flask, 导入工具包

from flask import Flask

from flask import request

app = Flask(__name__)

# 导入发送http请求的requests工具

import requests

# 加载自定义的停用词字典

jieba.load_userdict('./data/data/stopwords.txt')

# 提供已训练好的模型路径+名字

model_save_path = 'toutiao_fasttext_1640745760.bin'

# 实例化fasttext对象, 并加载模型参数用于推断, 提供服务请求

model = fasttext.load_model(model_save_path)

print('FastText模型实例化完毕...')

# 设定投满分服务的路由和请求方法

@app.route('/v1/main_server/', methods=["POST"])

def main_server():

# 接收来自请求方发送的服务字段

uid = request.form['uid']

text = request.form['text']

# 对请求文本进行处理, 因为前面加载的是基于词的模型, 所以这里用jieba进行分词

input_text = ' '.join(jieba.lcut(text))

# 执行预测

res = model.predict(input_text)

predict_name = res[0][0]

return predict_name

- 第二步: 启动Flask服务.

cd /home/ec2-user/toutiao/baseline/fast_text/

gunicorn -w 1 -b 0.0.0.0:5000 app:app

- 输出结果:

[2022-1-10 07:42:28 +0000] [24922] [INFO] Starting gunicorn 20.0.4

[2022-1-10 07:42:28 +0000] [24922] [INFO] Listening at: http://0.0.0.0:5000 (24922)

[2022-1-10 07:42:28 +0000] [24922] [INFO] Using worker: sync

[2022-1-10 07:42:28 +0000] [24928] [INFO] Booting worker with pid: 24928

Building prefix dict from the default dictionary ...

Loading model from cache /tmp/jieba.cache

Loading model cost 0.744 seconds.

Prefix dict has been built successfully.

FastText模型实例化完毕...

- 第三步: 编写测试代码. - 代码位置: /home/ec2-user/toutiao/baseline/fast_text/test.py

import requests

import time

# 定义请求url和传入的data

url = "http://0.0.0.0:5000/v1/main_server/"

data = {"uid": "AI-6-202104", "text": "公共英语(PETS)写作中常见的逻辑词汇汇总"}

start_time = time.time()

# 向服务发送post请求

res = requests.post(url, data=data)

cost_time = time.time() - start_time

# 打印返回的结果

print('输入文本:', data['text'])

print('分类结果:', res.text)

print('单条样本预测耗时: ', cost_time * 1000, 'ms')

- 第四步: 执行测试并检验结果.

cd /home/ec2-user/toutiao/baseline/fast_text/

python test.py

- 输出结果:

输入文本: 公共英语(PETS)写作中常见的逻辑词汇汇总

分类结果: __label__education

单条样本预测耗时: 4.739046096801758 ms

- 结论: 预测结果非常准确, 同时更重要的是预测时间仅仅不到5ms!!! 这是工业界场景下fasttext工具最大的意义!!!

第二章:迁移学习的优化

2.1 数据处理

基于BERT模型的数据处理¶

学习目标¶

- 掌握BERT模型的相关细节.

- 掌握数据处理的工具函数代码实现.

投满分项目数据预处理¶

- 本项目中对数据部分的预处理步骤如下:

- 第一步: 查看项目数据集

- 第二步: 查看预训练模型相关数据

- 第三步: 编写工具类函数

第一步: 查看项目数据集¶

- 数据集的路径: /home/ec2-user/toutiao/data/data/

- 项目的数据集包括5个文件, 依次来看一下:

- 标签文件/home/ec2-user/toutiao/data/data/class.txt

finance

realty

stocks

education

science

society

politics

sports

game

entertainment

- class.txt中包含10个类别标签, 每行一个标签, 为英文单词的展示格式.

- 训练数据集/home/ec2-user/toutiao/data/data/train.txt

中华女子学院:本科层次仅1专业招男生 3

两天价网站背后重重迷雾:做个网站究竟要多少钱 4

东5环海棠公社230-290平2居准现房98折优惠 1

卡佩罗:告诉你德国脚生猛的原因 不希望英德战踢点球 7

82岁老太为学生做饭扫地44年获授港大荣誉院士 5

记者回访地震中可乐男孩:将受邀赴美国参观 5

冯德伦徐若�隔空传情 默认其是女友 9

传郭晶晶欲落户香港战伦敦奥运 装修别墅当婚房 1

《赤壁OL》攻城战诸侯战硝烟又起 8

“手机钱包”亮相科博会 4

- train.txt中包含180000行样本, 每行包括两列, 第一列为待分类的中文文本, 第二列是数字化标签, 中间用\t作为分隔符.

- 验证数据集/home/ec2-user/toutiao/data/data/dev.txt

体验2D巅峰 倚天屠龙记十大创新概览 8

60年铁树开花形状似玉米芯(组图) 5

同步A股首秀:港股缩量回调 2

中青宝sg现场抓拍 兔子舞热辣表演 8

锌价难续去年辉煌 0

2岁男童爬窗台不慎7楼坠下获救(图) 5

布拉特:放球员一条生路吧 FIFA能消化俱乐部的攻击 7

金科西府 名墅天成 1

状元心经:考前一周重点是回顾和整理 3

发改委治理涉企收费每年为企业减负超百亿 6

- dev.txt中包含10000行样本, 每行包括两列, 第一列为待分类的中文文本, 第二列是数字化标签, 中

间用\t作为分隔符. - 测试数据集/home/ec2-user/toutiao/data/data/test.txt

词汇阅读是关键 08年考研暑期英语复习全指南 3

中国人民公安大学2012年硕士研究生目录及书目 3

日本地震:金吉列关注在日学子系列报道 3

名师辅导:2012考研英语虚拟语气三种用法 3

自考经验谈:自考生毕业论文选题技巧 3

本科未录取还有这些路可以走 3

2009年成人高考招生统一考试时间表 3

去新西兰体验舌尖上的饕餮之旅(组图) 3

四级阅读与考研阅读比较分析与应试策略 3

备考2012高考作文必读美文50篇(一) 3

- test.txt中包含10000行样本, 每行包括两列, 第一列为待分类的中文文本, 第二列是数字化标签, 中

间用\t作为分隔符.

第二步: 查看预训练模型相关数据¶

- 预训练模型相关数据的文件夹路径为/home/ec2-user/toutiao/data/bert_pretrain/

- 预训练模型相关数据共包含3个文件:

- BERT模型的超参数配置文件/home/ec2-user/toutiao/data/bert_pretrain/bert_config.json

{

"attention_probs_dropout_prob": 0.1,

"directionality": "bidi",

"hidden_act": "gelu",

"hidden_dropout_prob": 0.1,

"hidden_size": 768,

"initializer_range": 0.02,

"intermediate_size": 3072,

"max_position_embeddings": 512,

"num_attention_heads": 12,

"num_hidden_layers": 12,

"pooler_fc_size": 768,

"pooler_num_attention_heads": 12,

"pooler_num_fc_layers": 3,

"pooler_size_per_head": 128,

"pooler_type": "first_token_transform",

"type_vocab_size": 2,

"vocab_size": 21128

}

- BERT预训练模型文件/home/ec2-user/toutiao/data/bert_pretrain/pytorch_model.bin

-rw-r--r-- 1 root root 411578458 1月 9 11:50 pytorch_model.bin

- BERT预训练模型词典文件/home/ec2-user/toutiao/data/bert_pretrain/vocab.txt

[PAD]

[unused1]

[unused2]

[unused3]

[unused4]

[unused5]

[unused6]

[unused7]

[unused8]

[unused9]

[unused10]

......

......

......

[unused98]

[unused99]

[UNK]

[CLS]

[SEP]

[MASK]

<S>

<T>

!

......

......

......

第三步: 编写工具类函数¶

- 工具类函数的路径为/home/ec2-user/toutiao/src/utils.py

- 第一个工具类函数build_vocab(), 位于utils.py中的独立函数.

def build_vocab(file_path, tokenizer, max_size, min_freq):

vocab_dic = {}

with open(file_path, "r", encoding="UTF-8") as f:

for line in tqdm(f):

lin = line.strip()

if not lin:

continue

content = lin.split("\t")[0]

for word in tokenizer(content):

vocab_dic[word] = vocab_dic.get(word, 0) + 1

vocab_list = sorted(

[_ for _ in vocab_dic.items() if _[1]>=min_freq],key=lambda x:x[1],reverse=True)[:max_size]

vocab_dic = {word_count[0]: idx for idx, word_count in enumerate(vocab_list)}

vocab_dic.update({UNK: len(vocab_dic), PAD: len(vocab_dic) + 1})

return vocab_dic

- 第二个工具类函数build_dataset(), 位于utils.py中的独立函数.

def build_dataset(config):

def load_dataset(path, pad_size=32):

contents = []

with open(path, "r", encoding="UTF-8") as f:

for line in tqdm(f):

line = line.strip()

if not line:

continue

content, label = line.split("\t")

token = config.tokenizer.tokenize(content)

token = [CLS] + token

seq_len = len(token)

mask = []

token_ids = config.tokenizer.convert_tokens_to_ids(token)

if pad_size:

if len(token) < pad_size:

mask = [1] * len(token_ids) + [0] * (pad_size - len(token))

token_ids += [0] * (pad_size - len(token))

else:

mask = [1] * pad_size

token_ids = token_ids[:pad_size]

seq_len = pad_size

contents.append((token_ids, int(label), seq_len, mask))

return contents

train = load_dataset(config.train_path, config.pad_size)

dev = load_dataset(config.dev_path, config.pad_size)

test = load_dataset(config.test_path, config.pad_size)

return train, dev, test

- 第三个工具函数build_iterator(), 包括数据迭代器的类class DatasetIterater(), 位于utils.py中的独立函数和类.

class DatasetIterater(object):

def __init__(self, batches, batch_size, device, model_name):

self.batch_size = batch_size

self.batches = batches

self.model_name = model_name

self.n_batches = len(batches) // batch_size

self.residue = False # 记录batch数量是否为整数

if len(batches) % self.n_batches != 0:

self.residue = True

self.index = 0

self.device = device

def _to_tensor(self, datas):

x = torch.LongTensor([_[0] for _ in datas]).to(self.device)

y = torch.LongTensor([_[1] for _ in datas]).to(self.device)

# pad前的长度(超过pad_size的设为pad_size)

seq_len = torch.LongTensor([_[2] for _ in datas]).to(self.device)

if self.model_name == "bert" or self.model_name == "multi_task_bert":

mask = torch.LongTensor([_[3] for _ in datas]).to(self.device)

return (x, seq_len, mask), y

def __next__(self):

if self.residue and self.index == self.n_batches:

batches = self.batches[self.index * self.batch_size : len(self.batches)]

self.index += 1

batches = self._to_tensor(batches)

return batches

elif self.index >= self.n_batches:

self.index = 0

raise StopIteration

else:

batches = self.batches[self.index * self.batch_size : (self.index + 1) * self.batch_size]

self.index += 1

batches = self._to_tensor(batches)

return batches

def __iter__(self):

return self

def __len__(self):

if self.residue:

return self.n_batches + 1

else:

return self.n_batches

def build_iterator(dataset, config):

iter = DatasetIterater(dataset, config.batch_size, config.device, config.model_name)

return iter

- 第四个工具类函数get_time_dif(), 位于utils.py中的独立函数.

def get_time_dif(start_time):

# 获取已使用时间

end_time = time.time()

time_dif = end_time - start_time

return timedelta(seconds=int(round(time_dif)))

小节总结¶

- 本小节讲解了BERT模型的相关技术细节, 并实现了若干工具函数, 这些工具函数会在未来的项目代码中应用.

2.2 模型搭建与训练

BERT分类模型搭建¶

学习目标¶

- 掌握基于BERT的分类模型搭建的代码实现.

- 掌握迁移学习模型的训练, 测试, 评估的代码实现.

BERT模型搭建¶

- 本项目中BERT模型搭建的步骤如下:

- 第一步: 编写两个模型类的代码

- 第二步: 编写训练函数,测试函数,评估函数

- 第三步: 编写运行主函数

第一步: 编写两个模型类的代码¶

-

迁移学习预训练模型采用BERT, 类的代码路径为/home/ec2-user/toutiao/src/models/bert.py

- 第一步: 实现Config类代码.

- 第二步: 实现Model类代码.

-

第一步: 实现Config类代码.

# coding: UTF-8

import torch

import torch.nn as nn

import os

from transformers import BertModel, BertTokenizer, BertConfig

class Config(object):

def __init__(self, dataset):

self.model_name = "bert"

self.data_path = "/home/ec2-user/toutiao/data/data/"

self.train_path = self.data_path + "train.txt" # 训练集

self.dev_path = self.data_path + "dev.txt" # 验证集

self.test_path = self.data_path + "test.txt" # 测试集

self.class_list = [

x.strip() for x in open(self.data_path + "class.txt").readlines()

] # 类别名单

self.save_path = '/home/ec2-user/toutiao/src/saved_dict'

if not os.path.exists(self.save_path):

os.mkdir(self.save_path)

self.save_path += "/" + self.model_name + ".pt" # 模型训练结果

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu") # 设备

self.require_improvement = 1000 # 若超过1000batch效果还没提升,则提前结束训练

self.num_classes = len(self.class_list) # 类别数

self.num_epochs = 3 # epoch数

self.batch_size = 128 # mini-batch大小

self.pad_size = 32 # 每句话处理成的长度(短填长切)

self.learning_rate = 5e-5 # 学习率

self.bert_path = "/home/ec2-user/toutiao/data/bert_pretrain"

self.tokenizer = BertTokenizer.from_pretrained(self.bert_path)

self.bert_config = BertConfig.from_pretrained(self.bert_path + '/bert_config.json')

self.hidden_size = 768

- 第二步: 实现Model类代码.

class Model(nn.Module):

def __init__(self, config):

super(Model, self).__init__()

self.bert = BertModel.from_pretrained(config.bert_path, config=config.bert_config)

self.fc = nn.Linear(config.hidden_size, config.num_classes)

def forward(self, x):

# 输入的句子

context = x[0]

# 对padding部分进行mask, 和句子一个size, padding部分用0表示, 比如[1, 1, 1, 1, 0, 0]

mask = x[2]

_, pooled = self.bert(context, attention_mask=mask)

out = self.fc(pooled)

return out

第二步: 编写训练函数,测试函数,评估函数¶

- 这3个函数共同编写在一个代码文件中: /home/ec2-user/toutiao/src/train_eval.py - 第1步: 导入相关工具包.

- 第2步: 编写训练函数.

- 第3步: 编写测试函数.

- 第4步: 编写验证函数.

- 第1步: 导入相关工具包.

# coding: UTF-8

import numpy as np

import torch

import torch.nn as nn

import torch.nn.functional as F

from sklearn import metrics

import time

from utils import get_time_dif

from torch.optim import AdamW

from tqdm import tqdm

import math

import logging

- 第2步: 编写训练函数.

def loss_fn(outputs, labels):

return nn.CrossEntropyLoss()(outputs, labels)

def train(config, model, train_iter, dev_iter):

start_time = time.time()

param_optimizer = list(model.named_parameters())

no_decay = ["bias", "LayerNorm.bias", "LayerNorm.weight"]

optimizer_grouped_parameters = [

{

"params": [p for n, p in param_optimizer if not any(nd in n for nd in no_decay)],

"weight_decay": 0.01

},

{

"params": [p for n, p in param_optimizer if any(nd in n for nd in no_decay)],

"weight_decay": 0.0

}]

optimizer = AdamW(optimizer_grouped_parameters, lr=config.learning_rate)

total_batch = 0 # 记录进行到多少batch

dev_best_loss = float("inf")

last_improve = 0 # 记录上次验证集loss下降的batch数

flag = False # 记录是否很久没有效果提升

model.train()

for epoch in range(config.num_epochs):

total_batch = 0

print("Epoch [{}/{}]".format(epoch + 1, config.num_epochs))

for i, (trains, labels) in enumerate(tqdm(train_iter)):

outputs = model(trains)

model.zero_grad()

loss = loss_fn(outputs, labels)

loss.backward()

optimizer.step()

if total_batch % 200 == 0 and total_batch != 0:

# 每多少轮输出在训练集和验证集上的效果

true = labels.data.cpu()

predic = torch.max(outputs.data, 1)[1].cpu()

train_acc = metrics.accuracy_score(true, predic)

dev_acc, dev_loss = evaluate(config, model, dev_iter)

if dev_loss < dev_best_loss:

dev_best_loss = dev_loss

torch.save(model.state_dict(), config.save_path)

improve = "*"

last_improve = total_batch

else:

improve = ""

time_dif = get_time_dif(start_time)

msg = "Iter: {0:>6}, Train Loss: {1:>5.2}, Train Acc: {2:>6.2%}, Val Loss: {3:>5.2}, Val Acc: {4:>6.2%}, Time: {5} {6}"

print(msg.format(total_batch, loss.item(), train_acc, dev_loss, dev_acc, time_dif, improve))

# 评估完成后将模型置于训练模式, 更新参数

model.train()

# 每个batch结束后累加计数

total_batch += 1

if total_batch - last_improve > config.require_improvement:

# 验证集loss超过1000batch没下降,结束训练

print("No optimization for a long time, auto-stopping...")

flag = True

break

if flag:

break

- 第3步: 编写测试函数.

def test(config, model, test_iter):

# model.load_state_dict(torch.load(config.save_path))

# 采用量化模型进行推理时需要关闭

model.eval()

start_time = time.time()

test_acc, test_loss, test_report, test_confusion = evaluate(config, model, test_iter, test=True)

msg = "Test Loss: {0:>5.2}, Test Acc: {1:>6.2%}"

print(msg.format(test_loss, test_acc))

print("Precision, Recall and F1-Score...")

print(test_report)

print("Confusion Matrix...")

print(test_confusion)

time_dif = get_time_dif(start_time)

print("Time usage:", time_dif)

- 第4步: 编写验证函数.

def evaluate(config, model, data_iter, test=False):

# 采用量化模型进行推理时需要关闭

model.eval()

loss_total = 0

predict_all = np.array([], dtype=int)

labels_all = np.array([], dtype=int)

with torch.no_grad():

for texts, labels in data_iter:

outputs = model(texts)

loss = F.cross_entropy(outputs, labels)

loss_total += loss

labels = labels.data.cpu().numpy()

predic = torch.max(outputs.data, 1)[1].cpu().numpy()

labels_all = np.append(labels_all, labels)

predict_all = np.append(predict_all, predic)

acc = metrics.accuracy_score(labels_all, predict_all)

if test:

report = metrics.classification_report(labels_all,predict_all,target_names=config.class_list,digits=4)

confusion = metrics.confusion_matrix(labels_all, predict_all)

return acc, loss_total / len(data_iter), report, confusion

return acc, loss_total / len(data_iter)

第三步: 编写运行主函数¶

- 运行主函数依次调用前面的函数, 完成模型的训练和评估. - 代码位置: /home/ec2-user/toutiao/src/run.py

import time

import torch

import numpy as np

from train_eval import train, test

from importlib import import_module

import argparse

from utils import build_dataset, build_iterator, get_time_dif

parser = argparse.ArgumentParser(description="Chinese Text Classification")

parser.add_argument("--model", type=str, required=True, help="choose a model: bert")

args = parser.parse_args()

if __name__ == "__main__":

dataset = "toutiao" # 数据集

if args.model == "bert":

model_name = "bert"

x = import_module("models." + model_name)

config = x.Config(dataset)

np.random.seed(1)

torch.manual_seed(1)

torch.cuda.manual_seed_all(1)

torch.backends.cudnn.deterministic = True # 保证每次结果一样

print("Loading data for Bert Model...")

train_data, dev_data, test_data = build_dataset(config)

train_iter = build_iterator(train_data, config)

dev_iter = build_iterator(dev_data, config)

test_iter = build_iterator(test_data, config)

model = x.Model(config).to(config.device)

train(config, model, train_iter, dev_iter)

test(config,model, test_iter)

- 调用:

cd /home/ec2-user/toutiao/src/

python run.py --model bert

- 输出结果:

Loading data for Bert Model...

180000it [00:37, 4820.80it/s]

10000it [00:02, 4954.00it/s]

10000it [00:02, 4952.50it/s]

Epoch [1/3]

14%|█████████▉ | 200/1407 [02:06<13:26, 1.50it/s]Iter: 200, Train Loss: 0.3, Train Acc: 91.41%, Val Loss: 0.29, Val Acc: 90.86%, Time: 0:02:26 *

28%|███████████████████▉ | 400/1407 [04:44<11:46, 1.43it/s]Iter: 400, Train Loss: 0.34, Train Acc: 90.62%, Val Loss: 0.26, Val Acc: 92.10%, Time: 0:05:07 *

43%|█████████████████████████████▊ | 600/1407 [07:26<09:25, 1.43it/s]Iter: 600, Train Loss: 0.29, Train Acc: 91.41%, Val Loss: 0.25, Val Acc: 92.10%, Time: 0:07:49 *

57%|███████████████████████████████████████▊ | 800/1407 [10:08<07:06, 1.42it/s]Iter: 800, Train Loss: 0.15, Train Acc: 94.53%, Val Loss: 0.22, Val Acc: 92.85%, Time: 0:10:31 *

71%|█████████████████████████████████████████████████ | 1000/1407 [12:50<04:43, 1.44it/s]Iter: 1000, Train Loss: 0.17, Train Acc: 94.53%, Val Loss: 0.22, Val Acc: 93.00%, Time: 0:13:10

No optimization for a long time, auto-stopping...

Test Loss: 0.2, Test Acc: 93.64%

Precision, Recall and F1-Score...

precision recall f1-score support

finance 0.9246 0.9320 0.9283 1000

realty 0.9484 0.9370 0.9427 1000

stocks 0.8787 0.8980 0.8882 1000

education 0.9511 0.9730 0.9619 1000

science 0.9236 0.8950 0.9091 1000

society 0.9430 0.9270 0.9349 1000

politics 0.9267 0.9100 0.9183 1000

sports 0.9780 0.9780 0.9780 1000

game 0.9514 0.9600 0.9557 1000

entertainment 0.9390 0.9540 0.9464 1000

accuracy 0.9364 10000

macro avg 0.9365 0.9364 0.9364 10000

weighted avg 0.9365 0.9364 0.9364 10000

Confusion Matrix...

[[932 10 37 2 5 5 7 1 1 0]

[ 13 937 11 2 4 10 5 5 5 8]

[ 49 12 898 1 19 1 15 0 2 3]

[ 1 1 0 973 0 8 7 0 1 9]

[ 4 4 28 7 895 10 12 2 27 11]

[ 2 8 4 16 5 927 18 1 5 14]

[ 3 8 34 12 9 19 910 0 0 5]

[ 2 3 2 1 1 1 4 978 1 7]

[ 0 2 4 0 24 1 3 1 960 5]

[ 2 3 4 9 7 1 1 12 7 954]]

Time usage: 0:00:19

71%|█████████████████████████████████████████████████ | 1000/1407 [13:29<05:29, 1.24it/s]

- 结论: BERT模型在测试集上的表现是Test Acc: 93.64% , 对比于第一章的fasttext模型最好的表现91.93%, 有了1.71%的提升, 可以说是显著性提升了!

小节总结¶

- 本小节实现了基于BERT实现投满分分类的模型, 并完成了训练和测试评估.

第三章:模型的量化

3.1 模型量化概念和理论

模型量化的概念介绍¶

学习目标¶

- 理解什么是模型量化.

- 掌握BERT模型的量化操作.

- 掌握量化模型的性能测试.

什么是模型的量化¶

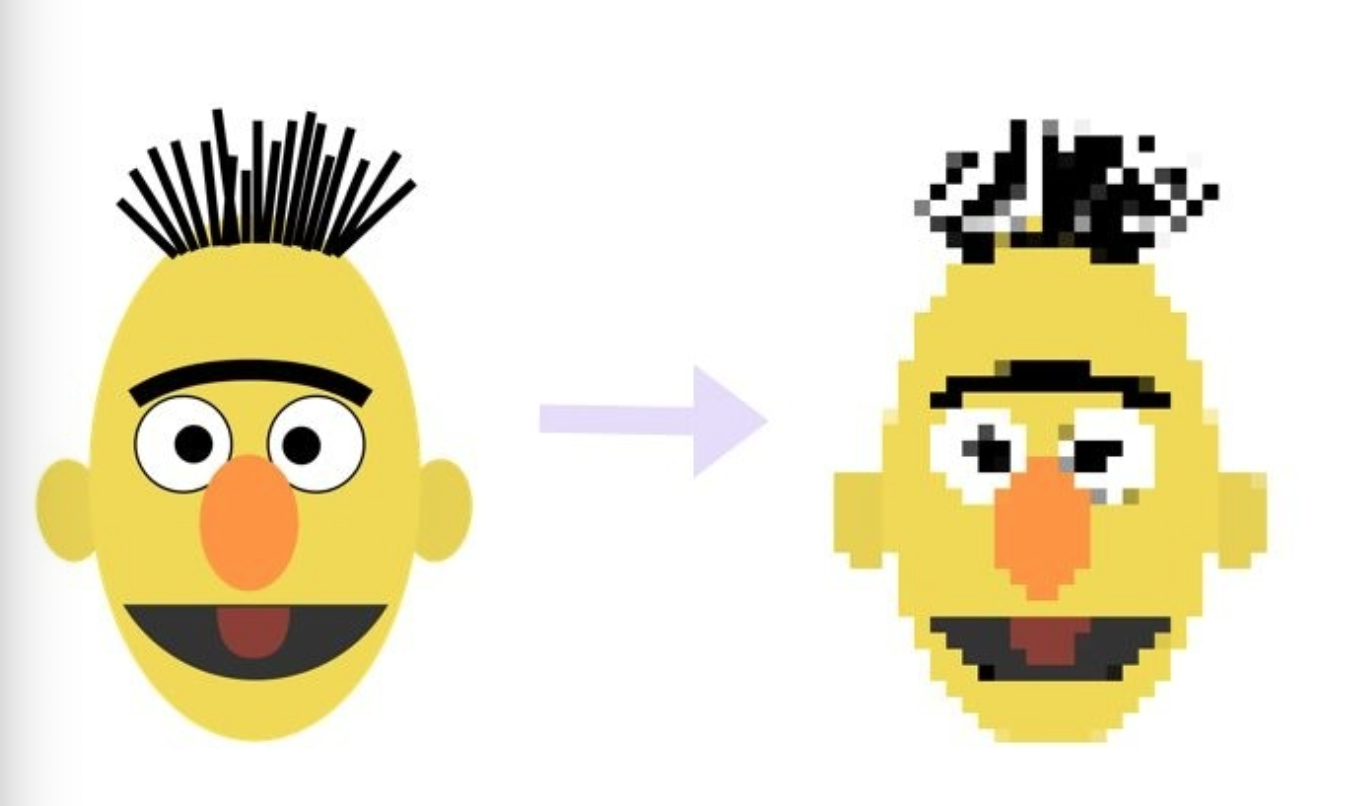

- 通俗的理解, 就是将模型的参数精度进行降低操作, 用更少的比特位(torch.qint8)代替较多的比特位(torch.float32), 从而缩减模型, 并加速推断速度.

- 如上图所示, 左侧的是原始模型拥有更高的参数精度(float32), 等效于像素高, 看的清晰; 右侧的是量化后的模型, 拥有较低的参数精度(int8), 等效于像素低, 看的模糊, 但依然可以准确的识别图像内容. - Pytorch的静态量化(Static Quantization).

- Pytorch的动态量化(Dynamic Quantization).

Pytorch的动态量化¶

- 保证Pytorch的版本在1.3.0以上, 支持动态量化.

- 直接使用torch.quantization.quantize_dynamic()来实现量化操作即可.

- 对于BERT模型的量化, 分2个步骤进行:

- 第一步: 对模型进行动态量化并评估

- 第二步: 对比模型压缩后的大小

第一步: 对模型进行动态量化并评估¶

- 首先需要修改配置类文件中的Config类.

- 代码位置: /home/ec2-user/toutiao/src/models/bert.py

# 在class Config中的__init__函数中修改下列代码部分

# 模型训练+预测的时候, 放开下一行代码, 在GPU上运行.

# self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu") # 设备

# 模型量化的时候, 放开下一行代码, 在CPU上运行.

self.device = 'cpu'

- 然后编写新的主函数代码文件run1.py

- 代码位置: /home/ec2-user/toutiao/src/run1.py

# coding: UTF-8

import time

import torch

import numpy as np

from train_eval import train, test

from importlib import import_module

import argparse

from utils import build_dataset, build_iterator, get_time_dif

parser = argparse.ArgumentParser(description="Chinese Text Classification")

parser.add_argument("--model", type=str, required=True, help="choose a model: bert")

args = parser.parse_args()

if __name__ == "__main__":

dataset = "toutiao" # 数据集

if args.model == "bert":

model_name = "bert"

x = import_module("models." + model_name)

config = x.Config(dataset)

np.random.seed(1)

torch.manual_seed(1)

torch.cuda.manual_seed_all(1)

torch.backends.cudnn.deterministic = True # 保证每次结果一样

# 数据迭代器的预处理和生成

print("Loading data for Bert Model...")

train_data, dev_data, test_data = build_dataset(config)

train_iter = build_iterator(train_data, config)

dev_iter = build_iterator(dev_data, config)

test_iter = build_iterator(test_data, config)

# 实例化模型并加载参数, 注意不要加载到GPU之上, 只能在CPU上实现模型量化

model = x.Model(config)

model.load_state_dict(torch.load(config.save_path))

# 量化BERT模型

quantized_model = torch.quantization.quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)

p

print(quantized_model)

# 测试量化后的模型在测试集上的表现

test(config, quantized_model, test_iter)

# 保存量化后的模型

torch.save(quantized_model, config.save_path2)

- 输出结果:

## 模型中的所有Linear层变成了DynamicQuantizedLinear层

Loading data for Bert Model...

180000it [00:42, 4212.75it/s]

10000it [00:02, 3893.41it/s]

10000it [00:02, 4367.20it/s]

Model(

(bert): BertModel(

(embeddings): BertEmbeddings(

(word_embeddings): Embedding(21128, 768, padding_idx=0)

(position_embeddings): Embedding(512, 768)

(token_type_embeddings): Embedding(2, 768)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

(encoder): BertEncoder(

(layer): ModuleList(

(0): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(1): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(2): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(3): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(4): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(5): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(6): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(7): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(8): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(9): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(10): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(11): BertLayer(

(attention): BertAttention(

(self): BertSelfAttention(

(query): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(key): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(value): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(dropout): Dropout(p=0.1, inplace=False)

)

(output): BertSelfOutput(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

(intermediate): BertIntermediate(

(dense): DynamicQuantizedLinear(in_features=768, out_features=3072, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

(output): BertOutput(

(dense): DynamicQuantizedLinear(in_features=3072, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(LayerNorm): LayerNorm((768,), eps=1e-12, elementwise_affine=True)

(dropout): Dropout(p=0.1, inplace=False)

)

)

)

)

(pooler): BertPooler(

(dense): DynamicQuantizedLinear(in_features=768, out_features=768, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

(activation): Tanh()

)

)

(fc): DynamicQuantizedLinear(in_features=768, out_features=10, dtype=torch.qint8, qscheme=torch.per_tensor_affine)

)

Test Loss: 0.25, Test Acc: 91.92%

Precision, Recall and F1-Score...

precision recall f1-score support

finance 0.9561 0.8490 0.8994 1000

realty 0.9499 0.9300 0.9399 1000

stocks 0.8478 0.8580 0.8529 1000

education 0.9740 0.9360 0.9546 1000

science 0.8407 0.9080 0.8731 1000

society 0.9173 0.9100 0.9137 1000

politics 0.8961 0.9230 0.9094 1000

sports 0.9836 0.9620 0.9727 1000

game 0.9562 0.9390 0.9475 1000

entertainment 0.8898 0.9770 0.9314 1000

accuracy 0.9192 10000

macro avg 0.9212 0.9192 0.9194 10000

weighted avg 0.9212 0.9192 0.9194 10000

Confusion Matrix...

[[849 9 99 0 8 14 14 2 2 3]

[ 7 930 15 0 8 13 8 1 3 15]

[ 26 18 858 0 54 1 35 1 3 4]

[ 1 3 1 936 15 17 11 1 0 15]

[ 1 2 15 2 908 12 8 1 28 23]

[ 0 13 1 14 11 910 27 1 4 19]

[ 3 2 18 5 31 13 923 0 0 5]

[ 1 2 2 0 3 5 0 962 1 24]

[ 0 0 3 1 37 4 0 3 939 13]

[ 0 0 0 3 5 3 4 6 2 977]]

- 结论: 经过量化后的BERT模型, F1=91.92%, 相比于量化前的F1=93.64%有比较显著的下降, 但还可以接受, 也说明BERT模型的鲁棒性非常高!

第二步: 对比模型压缩后的大小¶

# 首先查看量化前的BERT模型大小

cd /home/ec2-user/toutiao/saved_dic/

ll

-rw-rw-r-- 1 ec2-user ec2-user 409190601 1月 20 07:47 bert.pt

# 然后查看量化后的BERT模型大小

cd /home/ec2-user/toutiao/saved_dic1/

ll

-rw-rw-r-- 1 ec2-user ec2-user 152612233 Dec 30 10:20 bert_quantized.pt

- 对比结论:

## 模型参数文件大小缩减了256.6MB, 同时考虑到F1值仅仅下降了不到2个百分点, 效果非常优异!

BERT初始模型 Size (MB): 409.2MB

BERT量化模型 Size (MB): 152.6MB

- 注意: 如果将模型加载到GPU上直接量化, 会报错如下:

# 这说明动态量化目前在Pytorch平台上仅仅支持CPU上的操作!

RuntimeError: Could not run 'quantized::linear_prepack' with arguments from the 'UNKNOWN_TENSOR_TYPE_ID' backend. 'quantized::linear_prepack' is only available for these backends: [QuantizedCPU].

- 模型量化的硬件支持: PyTorch支持在具有AVX2支持或者更高版本的x86 CPU或者ARM CPU上运行量化运算符.

小节总结¶

- 本小节实现了对模型的动态量化, 并在CPU上测试了量化后的模型的表现, 验证了BERT模型具有良好的鲁棒性.

- 本小节对比了BERT模型量化前后的大小, 说明BERT模型的压缩率很高, 同时还能保持表现不会显著下降.

第四章:模型的剪枝

4.1 模型剪枝概念和理论

模型剪枝的概念和理论¶

学习目标¶

- 理解什么是模型剪枝.

- 掌握模型剪枝的基本操作.

什么是模型的剪枝¶

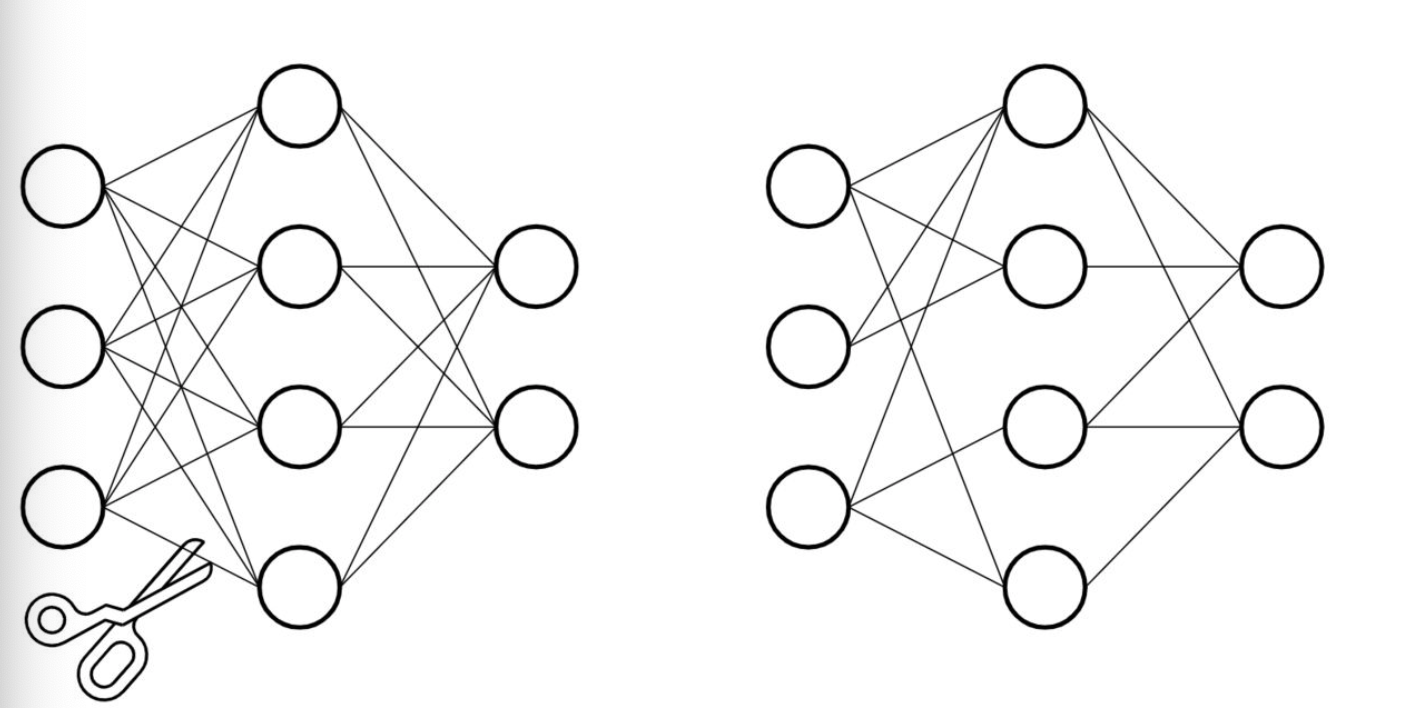

- 基于深度神经网络的大型预训练模型拥有庞大的参数量, 才能达到SOTA的效果. 但是我们参考生物的神经网络, 发现却是依靠大量稀疏的连接来完成复杂的意识活动.

- 仿照生物的稀疏神经网络, 将大型网络中的稠密连接变成稀疏的连接, 并同样达到SOTA的效果, 就是模型剪枝的原动力.

- Pytorch中对模型剪枝的支持在torch.nn.utils.prune模块中, 分以下几种剪枝方式:

- 对特定网络模块的剪枝(Pruning Model).

- 多参数模块的剪枝(Pruning multiple parameters).

- 全局剪枝(GLobal pruning).

- 用户自定义剪枝(Custom pruning).

Pytorch的模型剪枝实践¶

- 在这一小节中我们依次展示4种不同的剪枝方式, 并展示剪枝后的模型效果.

- 第一种: 对特定网络模块的剪枝(Pruning Model).

- 第二种: 多参数模块的剪枝(Pruning multiple parameters).

- 第三种: 全局剪枝(GLobal pruning).

- 第四种: 用户自定义剪枝(Custom pruning).

- 注意: 保证Pytorch的版本在1.4.0以上, 支持剪枝操作.

第一种: 对特定网络模块的剪枝(Pruning Model).¶

- 首先导入工具包:

import torch

from torch import nn

import torch.nn.utils.prune as prune

import torch.nn.functional as F

- 创建一个网络, 我们以经典的LeNet来示例:

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

class LeNet(nn.Module):

def __init__(self):

super(LeNet, self).__init__()

# 1: 图像的输入通道(1是黑白图像), 6: 输出通道, 3x3: 卷积核的尺寸

self.conv1 = nn.Conv2d(1, 6, 3)

self.conv2 = nn.Conv2d(6, 16, 3)

self.fc1 = nn.Linear(16 * 5 * 5, 120) # 5x5 是经历卷积操作后的图片尺寸

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = F.max_pool2d(F.relu(self.conv1(x)), (2, 2))

x = F.max_pool2d(F.relu(self.conv2(x)), 2)

x = x.view(-1, int(x.nelement() / x.shape[0]))

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

model = LeNet().to(device=device)

- 调用:

module = model.conv1

print(list(module.named_parameters()))

- 输出结果:

[('weight', Parameter containing:

tensor([[[[ 0.0853, -0.0203, -0.0784],

[ 0.3327, -0.0904, -0.0374],

[-0.0037, -0.2629, -0.2536]]],

[[[ 0.1313, 0.0249, 0.2735],

[ 0.0630, 0.0625, -0.0468],

[ 0.3328, 0.3249, -0.2640]]],

[[[ 0.1931, -0.2246, 0.0102],

[ 0.3319, 0.1740, -0.0799],

[-0.0195, -0.1295, -0.0964]]],

[[[ 0.3005, 0.2704, 0.3162],

[-0.2560, 0.0295, 0.2605],

[-0.1056, -0.0730, 0.0436]]],

[[[-0.3205, 0.1927, -0.0761],

[ 0.0142, -0.0562, -0.3087],

[ 0.1202, 0.1119, -0.1336]]],

[[[ 0.0568, 0.1142, 0.3079],

[ 0.2000, -0.1661, -0.2935],

[-0.1652, -0.2606, -0.0559]]]], device='cuda:0', requires_grad=True)), ('bias', Parameter containing:

tensor([ 0.1085, -0.1044, 0.1366, 0.3240, -0.1522, 0.1630], device='cuda:0',

requires_grad=True))]

- 再打印一个特殊的属性张量

print(list(module.named_buffers()))

- 输出结果

# 这里面打印出一个空列表, 至于这个空列表代表什么含义? 剪枝操作后同学们就明白了!

[]

- 直接调用prune函数对模型进行剪枝操作:

# 第一个参数: module, 代表要进行剪枝的特定模块, 之前我们已经制定了module=model.conv1,

# 说明这里要对第一个卷积层执行剪枝.

# 第二个参数: name, 指定要对选中的模块中的哪些参数执行剪枝.

# 这里设定为name="weight", 意味着对连接网络中的weight剪枝, 而不对bias剪枝.

# 第三个参数: amount, 指定要对模型中多大比例的参数执行剪枝.

# amount是一个介于0.0-1.0的float数值, 或者一个正整数指定剪裁掉多少条连接边.

prune.random_unstructured(module, name="weight", amount=0.3)

- 调用:

print(list(module.named_parameters()))

print(list(module.named_buffers()))

- 输出结果:

[('bias', Parameter containing:

tensor([ 0.1861, 0.2483, -0.3235, 0.0667, 0.0790, 0.1807], device='cuda:0',

requires_grad=True)), ('weight_orig', Parameter containing:

tensor([[[[-0.1544, -0.3045, 0.1339],

[ 0.2605, -0.1201, 0.3060],

[-0.2502, -0.0023, -0.0362]]],

[[[ 0.3147, -0.1034, -0.1772],

[-0.2250, -0.1071, 0.2489],

[ 0.2741, -0.1926, -0.2046]]],

[[[-0.1022, -0.2210, -0.1349],

[-0.2938, 0.0679, 0.2485],

[ 0.1108, -0.0564, -0.3328]]],

[[[-0.0464, 0.0138, 0.0283],

[-0.3205, 0.0184, 0.0521],

[ 0.2219, -0.2403, -0.2881]]],

[[[ 0.3320, -0.0684, -0.1715],

[-0.0381, 0.1819, 0.1796],

[-0.3321, -0.2684, -0.0477]]],

[[[-0.1638, -0.0969, 0.0077],

[ 0.0906, 0.2051, 0.2174],

[-0.2174, 0.1875, -0.2978]]]], device='cuda:0', requires_grad=True))]

[('weight_mask', tensor([[[[1., 0., 1.],

[1., 0., 1.],

[1., 0., 1.]]],

[[[0., 0., 0.],

[0., 1., 1.],

[0., 0., 1.]]],

[[[1., 1., 1.],

[0., 1., 1.],

[1., 1., 1.]]],

[[[1., 1., 1.],

[1., 1., 1.],

[1., 1., 1.]]],

[[[1., 1., 1.],

[1., 0., 1.],

[1., 1., 0.]]],

[[[1., 0., 1.],

[0., 0., 1.],

[1., 1., 0.]]]], device='cuda:0'))]

- 结论: 模型经历剪枝操作后, 原始的权重矩阵weight参数不见了, 变成了weight_orig. 并且刚刚打印为空列表的module.named_buffers(), 此时拥有了一个weight_mask参数.

- 这时打印module.weight属性值, 看看有什么启发?

print(module.weight)

- 输出结果:

tensor([[[[-0.1544, -0.0000, 0.1339],

[ 0.2605, -0.0000, 0.3060],

[-0.2502, -0.0000, -0.0362]]],

[[[ 0.0000, -0.0000, -0.0000],

[-0.0000, -0.1071, 0.2489],

[ 0.0000, -0.0000, -0.2046]]],

[[[-0.1022, -0.2210, -0.1349],

[-0.0000, 0.0679, 0.2485],

[ 0.1108, -0.0564, -0.3328]]],

[[[-0.0464, 0.0138, 0.0283],

[-0.3205, 0.0184, 0.0521],

[ 0.2219, -0.2403, -0.2881]]],

[[[ 0.3320, -0.0684, -0.1715],

[-0.0381, 0.0000, 0.1796],

[-0.3321, -0.2684, -0.0000]]],

[[[-0.1638, -0.0000, 0.0077],

[ 0.0000, 0.0000, 0.2174],

[-0.2174, 0.1875, -0.0000]]]], device='cuda:0',

grad_fn=<MulBackward0>)

- 结论: 经过剪枝操作后的模型, 原始的参数存放在了weight_orig中, 对应的剪枝矩阵存放在weight_mask中, 而将weight_mask视作掩码张量, 再和weight_orig相乘的结果就存放在了weight中.

- 注意: 剪枝操作后的weight已经不再是module的参数(parameter), 而只是module的一个属性(attribute).

- 对于每一次剪枝操作, 模型都会对应一个具体的_forward_pre_hooks函数用于剪枝.

print(module._forward_pre_hooks)

- 输出结果:

OrderedDict([(0, <torch.nn.utils.prune.RandomUnstructured object at 0x7f9c6a945438>)])

- 我们可以对模型的任意子结构进行剪枝操作, 除了在weight上面剪枝, 还可以对bias进行剪枝.

# 第一个参数: module, 代表剪枝的对象, 此处代表LeNet中的conv1

# 第二个参数: name, 代表剪枝对象中的具体参数, 此处代表偏置量

# 第三个参数: amount, 代表剪枝的数量, 可以设置为0.0-1.0之间表示比例, 也可以用正整数表示剪枝的参数绝对数量

prune.l1_unstructured(module, name="bias", amount=3)

# 再次打印模型参数

print(list(module.named_parameters()))

print('*'*50)

print(list(module.named_buffers()))

print('*'*50)

print(module.bias)

print('*'*50)

print(module._forward_pre_hooks)

- 输出结果

[('weight_orig', Parameter containing:

tensor([[[[-0.0159, -0.3175, -0.0816],

[ 0.3144, -0.1534, -0.0924],

[-0.2885, -0.1054, -0.1872]]],

[[[ 0.0835, -0.1258, -0.2760],

[-0.3174, 0.0669, -0.1867],

[-0.0381, 0.1156, 0.0078]]],

[[[ 0.1416, -0.2907, -0.0249],

[ 0.1018, 0.1757, -0.0326],

[ 0.2736, -0.1980, -0.1162]]],

[[[-0.1835, 0.1600, 0.3178],

[ 0.0579, -0.0647, -0.1039],

[-0.0160, -0.0715, 0.2746]]],

[[[-0.2314, -0.1759, -0.1820],

[-0.0594, 0.2355, -0.2087],

[ 0.0216, 0.0066, -0.0624]]],

[[[-0.2772, 0.1479, -0.0983],

[-0.3307, -0.2360, -0.0596],

[ 0.2785, 0.0648, 0.2869]]]], device='cuda:0', requires_grad=True)), ('bias_orig', Parameter containing:

tensor([-0.1924, -0.1420, -0.0235, 0.0325, 0.0188, 0.0120], device='cuda:0',

requires_grad=True))]

**************************************************

[('weight_mask', tensor([[[[0., 0., 0.],

[1., 1., 1.],

[1., 0., 1.]]],

[[[1., 0., 1.],

[1., 0., 1.],

[1., 0., 1.]]],

[[[1., 1., 0.],

[1., 1., 1.],

[1., 1., 1.]]],

[[[1., 1., 1.],

[1., 0., 0.],

[0., 1., 0.]]],

[[[1., 1., 1.],

[1., 1., 1.],

[0., 1., 1.]]],

[[[1., 1., 1.],

[0., 0., 1.],

[1., 1., 0.]]]], device='cuda:0')), ('bias_mask', tensor([1., 1., 0., 1., 0., 0.], device='cuda:0'))]

**************************************************

tensor([-0.1924, -0.1420, -0.0000, 0.0325, 0.0000, 0.0000], device='cuda:0',

grad_fn=<MulBackward0>)

**************************************************

OrderedDict([(0, <torch.nn.utils.prune.RandomUnstructured object at 0x7fd406b617f0>), (1, <torch.nn.utils.prune.L1Unstructured object at 0x7fd3aa9ba048>)])

- 结论: 在module的不同参数集合上应用不同的剪枝策略, 我们发现模型参数中不仅仅有了weight_orig, 也有了bias_orig. 在起到掩码张量作用的named_buffers中, 也同时出现了weight_mask和bias_mask. 最后, 因为我们在两类参数上应用了两种不同的剪枝函数, 因此_forward_pre_hooks中也打印出了2个不同的函数结果.

- 序列化一个剪枝模型(Serializing a pruned model):

# 对于一个模型来说, 不管是它原始的参数, 拥有的属性值, 还是剪枝的mask buffers参数

# 全部都存储在模型的状态字典中, 即state_dict()中.

# 将模型初始的状态字典打印出来

print(model.state_dict().keys())

print('*'*50)

# 对模型进行剪枝操作, 分别在weight和bias上剪枝

module = model.conv1

prune.random_unstructured(module, name="weight", amount=0.3)

prune.l1_unstructured(module, name="bias", amount=3)

# 再将剪枝后的模型的状态字典打印出来

print(model.state_dict().keys())

- 输出结果:

odict_keys(['conv1.weight', 'conv1.bias', 'conv2.weight', 'conv2.bias', 'fc1.weight', 'fc1.bias', 'fc2.weight', 'fc2.bias', 'fc3.weight', 'fc3.bias'])

**************************************************

odict_keys(['conv1.weight_orig', 'conv1.bias_orig', 'conv1.weight_mask', 'conv1.bias_mask', 'conv2.weight', 'conv2.bias', 'fc1.weight', 'fc1.bias', 'fc2.weight', 'fc2.bias', 'fc3.weight', 'fc3.bias'])

- 关键一步: 对模型执行剪枝remove操作. - 通过module中的参数weight_orig和weight_mask进行剪枝, 本质上属于置零遮掩, 让权重连接失效.

- 具体怎么计算取决于_forward_pre_hooks函数.

- 这个remove是无法undo的, 也就是说一旦执行就是对模型参数的永久改变.

- 执行remove操作的演示代码:

# 打印剪枝后的模型参数

print(list(module.named_parameters()))

print('*'*50)

# 打印剪枝后的模型mask buffers参数

print(list(module.named_buffers()))

print('*'*50)

# 打印剪枝后的模型weight属性值

print(module.weight)

print('*'*50)

# 打印模型的_forward_pre_hooks

print(module._forward_pre_hooks)

print('*'*50)

# 执行剪枝永久化操作remove

prune.remove(module, 'weight')

print('*'*50)

# remove后再次打印模型参数

print(list(module.named_parameters()))

print('*'*50)

# remove后再次打印模型mask buffers参数

print(list(module.named_buffers()))

print('*'*50)

# remove后再次打印模型的_forward_pre_hooks

print(module._forward_pre_hooks)

- 输出结果:

[('weight_orig', Parameter containing:

tensor([[[[ 0.1668, 0.0369, -0.2930],

[-0.2630, -0.1777, -0.1096],

[ 0.0481, -0.0898, 0.1920]]],

[[[ 0.0729, 0.1445, -0.0471],

[ 0.1525, 0.2986, 0.2602],

[-0.0929, -0.2725, -0.0069]]],

[[[-0.2006, -0.2577, 0.2754],

[ 0.0999, 0.2106, -0.0046],

[-0.2813, -0.2794, -0.0580]]],

[[[-0.2944, -0.2214, -0.0795],

[-0.0773, 0.2931, -0.2249],

[-0.0796, -0.2343, -0.0457]]],

[[[-0.1965, 0.2550, 0.2606],

[ 0.0213, -0.2839, 0.2037],

[-0.2068, -0.0507, -0.3097]]],

[[[ 0.0030, 0.2340, -0.1122],

[-0.0302, -0.0261, 0.1168],

[ 0.0927, 0.1553, 0.1167]]]], device='cuda:0', requires_grad=True)), ('bias_orig', Parameter containing:

tensor([ 0.1147, 0.2439, -0.1753, -0.2578, -0.0994, 0.0588], device='cuda:0',

requires_grad=True))]

**************************************************

[('weight_mask', tensor([[[[0., 0., 0.],

[1., 1., 1.],

[0., 1., 1.]]],

[[[1., 1., 1.],

[1., 0., 1.],

[1., 1., 1.]]],

[[[1., 1., 0.],

[1., 1., 1.],

[1., 0., 1.]]],

[[[0., 1., 1.],

[1., 1., 1.],

[1., 1., 0.]]],

[[[1., 0., 1.],

[0., 1., 0.],

[0., 1., 1.]]],

[[[1., 1., 1.],

[1., 0., 0.],

[0., 1., 1.]]]], device='cuda:0')), ('bias_mask', tensor([0., 1., 1., 1., 0., 0.], device='cuda:0'))]

**************************************************

tensor([[[[ 0.0000, 0.0000, -0.0000],

[-0.2630, -0.1777, -0.1096],

[ 0.0000, -0.0898, 0.1920]]],

[[[ 0.0729, 0.1445, -0.0471],

[ 0.1525, 0.0000, 0.2602],

[-0.0929, -0.2725, -0.0069]]],

[[[-0.2006, -0.2577, 0.0000],

[ 0.0999, 0.2106, -0.0046],

[-0.2813, -0.0000, -0.0580]]],

[[[-0.0000, -0.2214, -0.0795],

[-0.0773, 0.2931, -0.2249],

[-0.0796, -0.2343, -0.0000]]],

[[[-0.1965, 0.0000, 0.2606],

[ 0.0000, -0.2839, 0.0000],

[-0.0000, -0.0507, -0.3097]]],

[[[ 0.0030, 0.2340, -0.1122],

[-0.0302, -0.0000, 0.0000],

[ 0.0000, 0.1553, 0.1167]]]], device='cuda:0',

grad_fn=<MulBackward0>)

**************************************************

OrderedDict([(0, <torch.nn.utils.prune.RandomUnstructured object at 0x7f65b879e7f0>), (1, <torch.nn.utils.prune.L1Unstructured object at 0x7f655c5ebfd0>)])

[('bias_orig', Parameter containing:

tensor([ 0.1147, 0.2439, -0.1753, -0.2578, -0.0994, 0.0588], device='cuda:0',

requires_grad=True)), ('weight', Parameter containing:

tensor([[[[ 0.0000, 0.0000, -0.0000],

[-0.2630, -0.1777, -0.1096],

[ 0.0000, -0.0898, 0.1920]]],

[[[ 0.0729, 0.1445, -0.0471],

[ 0.1525, 0.0000, 0.2602],

[-0.0929, -0.2725, -0.0069]]],

[[[-0.2006, -0.2577, 0.0000],

[ 0.0999, 0.2106, -0.0046],

[-0.2813, -0.0000, -0.0580]]],

[[[-0.0000, -0.2214, -0.0795],

[-0.0773, 0.2931, -0.2249],

[-0.0796, -0.2343, -0.0000]]],

[[[-0.1965, 0.0000, 0.2606],

[ 0.0000, -0.2839, 0.0000],

[-0.0000, -0.0507, -0.3097]]],

[[[ 0.0030, 0.2340, -0.1122],

[-0.0302, -0.0000, 0.0000],

[ 0.0000, 0.1553, 0.1167]]]], device='cuda:0', requires_grad=True))]

**************************************************

[('bias_mask', tensor([0., 1., 1., 1., 0., 0.], device='cuda:0'))]

**************************************************

OrderedDict([(1, <torch.nn.utils.prune.L1Unstructured object at 0x7f655c5ebfd0>)])

- 结论: 对模型的weight执行remove操作后, 模型参数集合中只剩下bias_orig了, weight_orig消失, 变成了weight, 说明针对weight的剪枝已经永久化生效. 对于named_buffers张量打印可以看出, 只剩下bias_mask了, 因为针对weight做掩码的weight_mask已经生效完毕, 不再需要保留了. 同理, 在_forward_pre_hooks中也只剩下针对bias做剪枝的函数了.

第二种: 多参数模块的剪枝(Pruning multiple parameters).¶

model = LeNet().to(device=device)

# 打印初始模型的所有状态字典

print(model.state_dict().keys())

print('*'*50)

# 打印初始模型的mask buffers张量字典名称

print(dict(model.named_buffers()).keys())

print('*'*50)

# 对于模型进行分模块参数的剪枝

for name, module in model.named_modules():

# 对模型中所有的卷积层执行l1_unstructured剪枝操作, 选取20%的参数剪枝

if isinstance(module, torch.nn.Conv2d):

prune.l1_unstructured(module, name="weight", amount=0.2)

# 对模型中所有全连接层执行ln_structured剪枝操作, 选取40%的参数剪枝

elif isinstance(module, torch.nn.Linear):

prune.ln_structured(module, name="weight", amount=0.4, n=2, dim=0)

# 打印多参数模块剪枝后的mask buffers张量字典名称

print(dict(model.named_buffers()).keys())

print('*'*50)

# 打印多参数模块剪枝后模型的所有状态字典名称

print(model.state_dict().keys())

- 输出结果:

odict_keys(['conv1.weight', 'conv1.bias', 'conv2.weight', 'conv2.bias', 'fc1.weight', 'fc1.bias', 'fc2.weight', 'fc2.bias', 'fc3.weight', 'fc3.bias'])

**************************************************

dict_keys([])

**************************************************